1 引言

生物识别技术利用人体固有的生理特性和行为特征来进行个人身份鉴定,被广泛应用到金融、教育、医疗、社保等安全领域。指静脉识别技术通过红外线CCD摄像头获取手指图像,并提取指静脉的特征用于身份认证,具有隐秘性、安全性和便捷性等特点。指静脉识别流程通常分为图像采集、预处理、特征提取以及身份匹配四个阶段,在指静脉图像的采集过程中,由于噪声和光照等干扰,采集的指静脉图像往往质量较低,且手指存在一定的自由度,不同时刻采集到的同一用户的指静脉图像之间存在手指姿势的差异。因此,如何提取指静脉图像的鲁棒的描述子具有重要意义。

深度学习在图像识别领域表现出巨大的优势,通过卷积神经网络能学习到更深层次、更鲁棒的特征。近年来,在指静脉识别领域,Fang等人[1]使用双流网络,将两张待验证的图像合并成一个双通道图像,同时为了消除手指平面位移的影响,引入一种mini ROI算法来定位两张图像的比对区域后,输入卷积神经网络(Convolutional Neural Network,CNN)提取特征描述子,通过支持向量机(Support Vector Machine,SVM)做二分类进行指静脉验证,其效果优于传统方法;Hu等人[2]使用预训练的VGGFace-Net[3]的前面7层卷积再加上自己设计的3个卷积层,采用Large-Margin Softmax Loss[4]约束类间距离,提取来自卷积层的特征图,并配合提出的模板匹配策略进行指静脉身份匹配;文献[5]使用自编码器提取指静脉图像的特征描述子,同样通过SVM进行分类,具有更高的验证准确率。这些研究主要存在以下三个问题:(1)模型体积较大,模型训练仍使用分类损失函数,未考虑指静脉图像分辨率小、公开库小的特点;(2)提取到的指静脉描述子对手指姿势变化并未被证明具有鲁棒性;(3)在匹配阶段,需训练分类模型,或使用模板匹配方法,增加了识别系统的存储、时间开销,限制了描述子的应用场景。针对以上问题,本文通过缩减现有模型的卷积层数和通道数,来缩小模型体积;通过引入局部描述子无序编码方法来提高指静脉描述子对图像平移的鲁棒性;采用端到端提取得到指静脉描述子向量的方式,减少对匹配阶段的限制。

本文使用修改后的VGGFace-Net[3]提取指静脉图像的局部描述子,并创新性地引入VLAD编码[6]来对局部描述子进行聚合编码,提高指静脉描述子的表征能力和鲁棒性,且网络模型的参数量仅0.3M。此外,根据指静脉公开库的规模小的特点,基于三元组损失提出了一种样本对中心约束损失函数用于训练所提出的网络模型。采用本文的方法提取得到的描述子,可使用简单的向量相似性度量方法进行指静脉身份匹配,在三个公开数据库FV-USM[7],SDUMLA[8],MMCBNU[9]上的实验结果表明,所提取的描述子用于指静脉验证的结果优于现有方法。本文通过随机上下左右平移手指图像进行测试,进一步证明了描述子对手指平移具有更好的鲁棒性。

2 背景方法与理论

2.1 基于CNN的局部描述子学习

给定一个包含特征点的图像块q,特征描述的目的是找到q和它的表示d(q)之间的映射关系,d(q)就是一个局部描述子。近年来,随着深度学习的发展,CNN被用在学习这个映射d(q),且被证明得到的描述子优于手工设计的描述子。研究者们[10,12-14]设计3~5层的三胞胎网络结构、基于三元组的损失函数和样本挖掘策略,采用包含特征点的图像块进行训练,再通过训练好的模型得到图像块的描述子。

在网络结构方面,通过采用线上样本挖掘的方式[11],L2Net[12]将多路网络简化成一路直连的7层全卷积网络结构。在损失函数方面,文献[13]提出一种全局损失函数,如式(1),该损失函数基于以下假设:正样本对距离和负样本对距离服从两个独立的分布。损失函数的目的是减小两个分布的方差,和正样本对距离的均值;增大负样本对距离的均值。

L=σ2++σ2-+γmax(0,μ+-μ-+m)

(1)

式中σ2+,σ2-分别表示正样本对距离和负样本对距离这两个分布的方差,μ+,μ-则为均值,m是自定义的阈值,γ用来平衡方差和均值的权重。可用于双胞胎和三胞胎网络结构。

2.2 VLAD描述子编码方法

给定N个D维局部图像描述子{xi,i=1,2,…,N}作为输入,首先通过聚类算法对N个局部描述子进行聚类得到K个D维的类中心向量{ck,k=1,2,…,K},随后将N个局部描述子向量与聚类中心的差值做累加,得到图像的VLAD,用K×D维的矩阵V表示,V在(k, j)位置的元素为:

(2)

式中![]() 和

和![]() 分别表示第i个描述子xi的第j个分量、第k个聚类中心ck的第j个分量,ak(xi)表示描述子xi是否属于第k个聚类簇,即如果ck是最接近描述子xi的簇,ak(xi)为1,否则为0。将式(2)的矩阵扩展成向量并进行L2归一化,所得到的描述子向量即可用来表示对应的图像。

分别表示第i个描述子xi的第j个分量、第k个聚类中心ck的第j个分量,ak(xi)表示描述子xi是否属于第k个聚类簇,即如果ck是最接近描述子xi的簇,ak(xi)为1,否则为0。将式(2)的矩阵扩展成向量并进行L2归一化,所得到的描述子向量即可用来表示对应的图像。

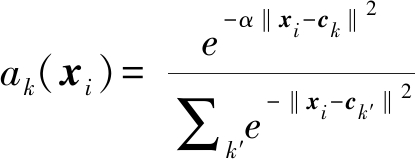

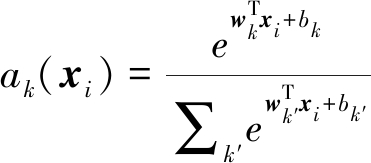

NetVLAD[15]是原始VLAD的可学习版本,描述子的聚类中心是可学习的参数,为了解决原始表达式(2)中ak(xi)不可导的问题,使用Softmax函数来软化,用式(3)来表示。即不直接判断描述子xi是否属于第k个聚类簇,而给出一个概率值,式中α是引入的控制学习率的参数,通常设为1。

(3)

上式进一步可展开成:

(4)

这里wk=2αck,bk=-α‖ck‖2,省略了-α‖xi‖2项,因为该项对于所有K个聚类中心的学习的影响是一致的。这样便可通过1×1的卷积核来实现ak(xi),包含两个可学习参数,其中wk表示卷积核的权重,bk表示卷积核的偏置。

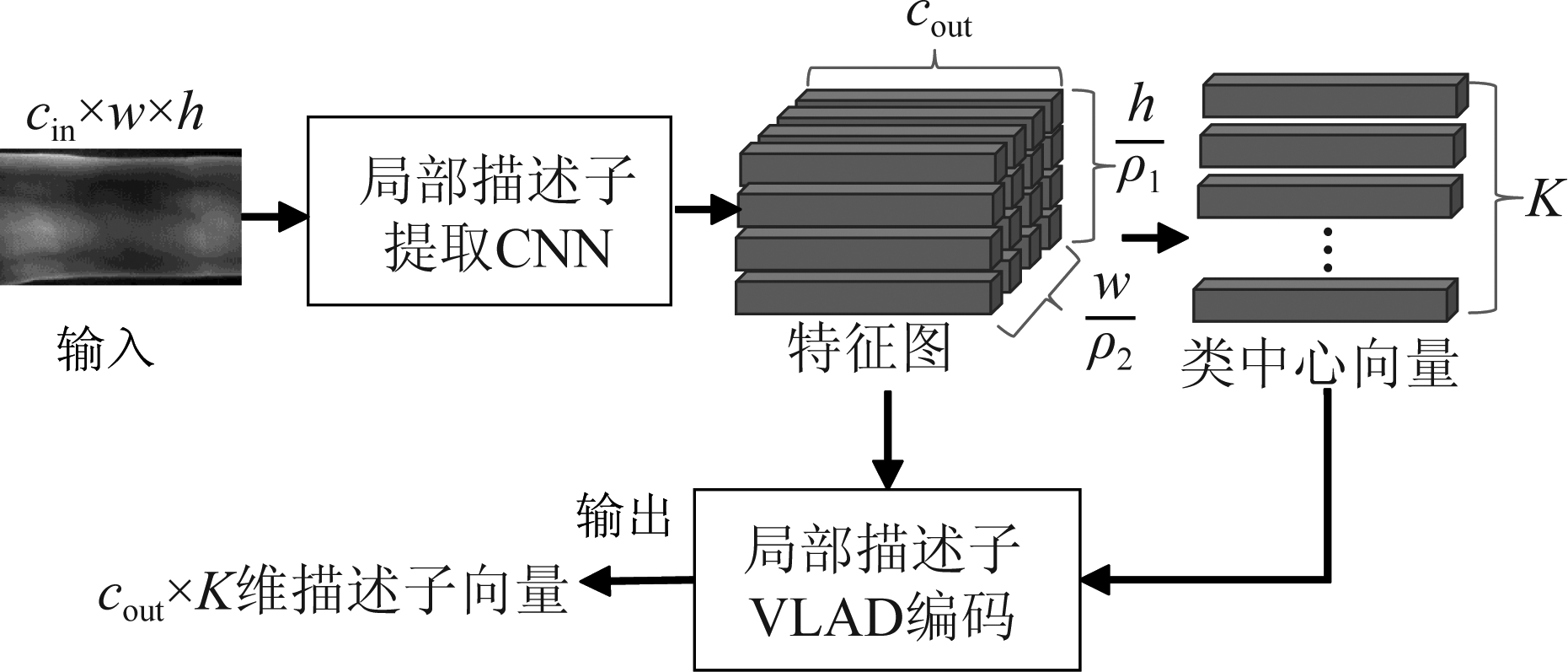

2.3 基于CNN的描述子学习与编码方法的应用

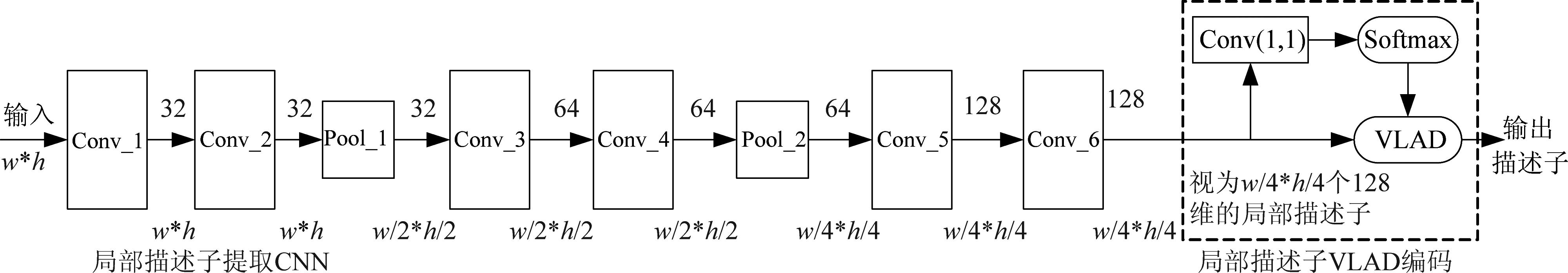

基于CNN的局部描述子学习方法的重点是解决如何描述给定的图像块(特征点),而训练卷积网络学习指静脉图像的描述子,是希望网络能够自动地学习到多个特征点的描述,从而得到整个图像的描述子。因此,可通过将描述子提取网络和编码网络串联在一起,即使用卷积网络稠密采样的局部描述子,再通过VLAD编码网络对局部描述子进行聚合编码,得到图像描述子,如图1所示。在效果上,作为一种弄无序编码方法,VLAD编码实现了局部描述子的聚类和重组,一方面能归一化最终描述子的维度,另一方面,能降低描述子对特征点位置的敏感性,即对图像的不同视角具有鲁棒性,这一定程度上能解决指静脉图像的手指姿势差异问题。对于网络的训练,则沿用基于CNN的局部描述子学习方法的思想,通过构造三元组作为网络的输入,计算三元组损失,原来多类别、少样本的问题转换成只有两类样本(正样本对和负样本对),每类样本有庞大样本量的情况,有助于解决指静脉识别公开库的样本量少的问题,同时提高描述子的区分性。

图1 融合CNN与VLAD的指静脉描述子提取网络框架

Fig.1 Finger vein descriptor extraction framework integrating CNN and VLAD

3 基于CNN和VLAD的指静脉鲁棒描述子提取方法

本文结合基于CNN的局部描述子提取和VLAD编码方法,提出了一种端到端的指静脉描述子提取网络,包括其结构、损失函数及训练方法。

3.1 网络结构

FV-Net[2]使用VGGFace-Net[3]的前7层卷积层作为特征提取网络,文中记为VGGFace7,取得了较好的指静脉验证效果。如图1所示,在多通道特征图中,由特定空间位置的值组成的向量,代表一个原始图像的局部描述子,若将VGGFace7作为图中的局部描述子提取网络,则得到的局部描述子的数量为原始图像的像素数的1/16,局部描述子的感受野是原始图像上40×40的局部区域。本文以VGGFace7为基础,进行如下改进,得到VGGFv:

a.在局部描述子的维度上,将256改为128以降低描述子的维度,即将后三层特征图的通道数设为128。同时,遵循VGG网络的设计原则,即如果特征图的尺寸减半,那么通道数应该增倍,具体做法为将前面层的特征图的通道数也由64和128改成32和64。

b.在输入图像的分辨率上,FV-Net[2]的输入图像的分辨率为128×192,占用了较多存储和内存资源,同时会导致特征提取时间较长。本文降低输入的分辨率为64×128,输入分辨率降低,对应的感受野也应该减小,故去掉最后一层卷积,感受野变为32×32的区域,同时也减少了网络的参数量,最终的局部描述子数量仍为原始图像像素数的1/16。

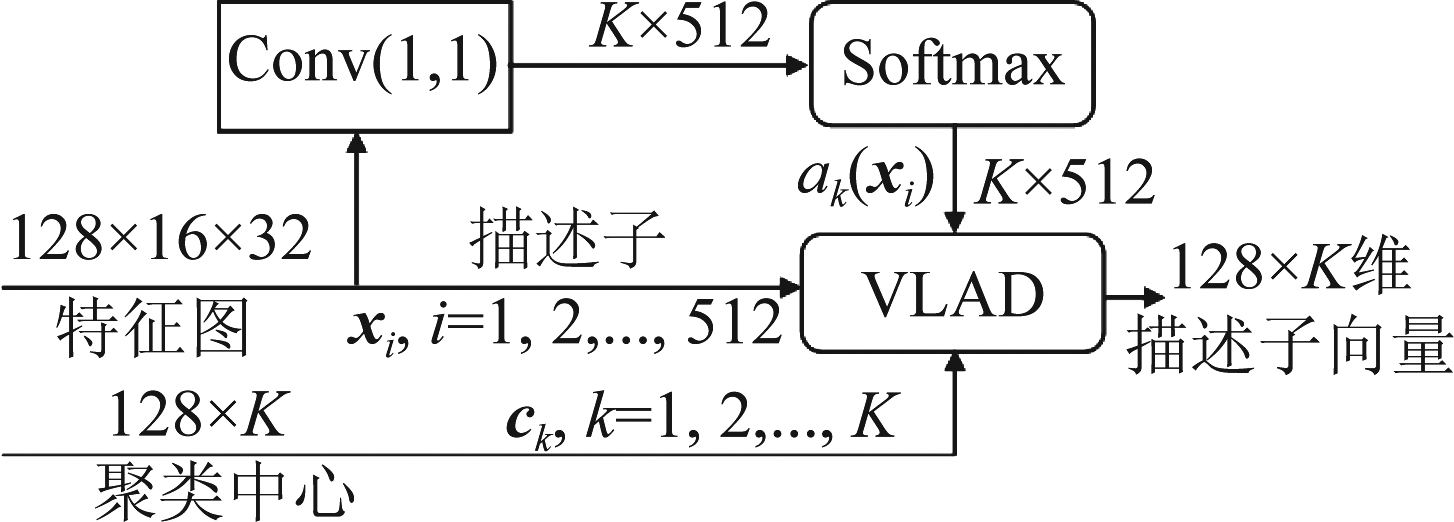

表1列出了VGGFv的具体参数,其中Conv层包括卷积、批归一化层(Batch Normalization,BN)和ReLU激活。通过上述CNN之后,得到16×32个128维的局部描述子,然后将描述子输入NetVLAD模块[15]进行VLAD编码,具体运算过程如图2所示。

表1 VGGFv结构详细参数表

Tab.1 Detailed parameters of VGGFv network structure

层核数量核尺寸步长填充特征图尺寸输入层----64×128Conv_1323×31164×128Conv_2323×31164×128Pool_1322×22032×64Conv_3643×31132×64Conv_4643×31132×64Pool_2642×22016×32Conv_51283×31116×32Conv_61283×31116×32

图2 NetVLAD编码方法示意图

Fig.2 Schematic diagram of NetVLAD encoding method

通过将聚类中心设置成可学习参数,在训练过程中自动对16×32个局部描述子进行聚类得到K个类中心向量ck,k=1,2,…,K,结合xi和ck根据式(2)和式(4)完成VLAD编码,得到128×K维局部聚合描述子,在网络结构上只包含一个1×1的卷积层。最终整个指静脉图像描述子提取网络如图3所示。

3.2 损失函数

基于三元组的损失函数中,最基本的是Triplet[11]损失,用正负样本对距离dap,dan来表示,可写成:

LTriplet=max(0,m+dap-dan)

(5)

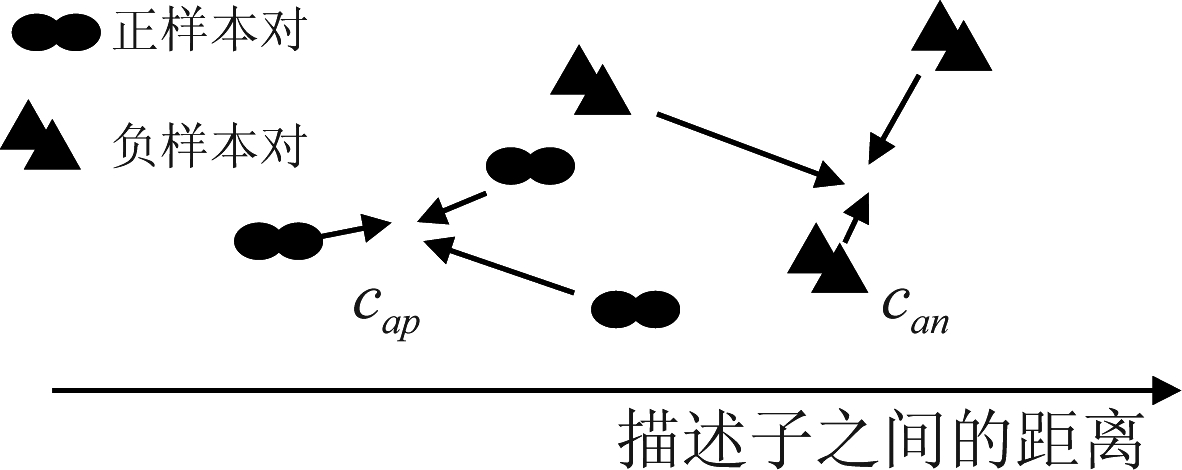

由公式(5)可知,Triplet损失考虑了dap和dan之差,希望其越接近所设置的阈值m越好,而未考虑dap和dan自身之间的紧密程度,这对于提取用于指静脉验证的描述子是不利的。指静脉验证的目标是使用一个固定的阈值将所有dap和dan区分开来,而使用Triplet损失训练网络时只要满足dan-dap>m,即0≤dap<m+Δ,2m+Δ≤dan<∝,损失就变成了0,其中Δ理论上可为任意实值。正是由于Δ的存在,dap和dan值域过大,用一个阈值来划分时会导致较大的误差。

为缓解上述问题,本文结合文献[13]的思想,设计如下样本对中心约束损失函数:

Loss=max(0,dap-dan)+(dap-cap)2+(dan-cap-m)2

(6)

其中,max(0,dap-dan)保证了损失函数使dap尽可能小、dan尽可能大,在实际中通过ReLU函数来实现max运算。(dap-cap)2+(dan-cap-m)2保证了dap接近cap,dan接近cap+m,其中cap表示所希望的正样本对之间的距离所靠拢的一个中心,将其设置成可学习参数,并用接近0的值初始化,m同样是正负样本对距离之差的期望值,距离均为欧氏距离。若将dap和dan视为两个类别,这样既保证了类间距离接近m,又使得类内更加紧凑。其物理意义如图4所示。

图3 结合CNN和VLAD的指静脉描述子提取网络(VGGFv+NetVLAD)

Fig.3 Finger vein descriptor extraction network combining CNN and VLAD (VGGFv+NetVLAD)

图4 基于距离约束的三元组损失函数示意图

Fig.4 Schematic diagram of the Pair-center- constrained loss function

3.3 训练方法

指静脉描述子提取网络的训练流程如下:

(1)对指静脉图像进行预处理。文中使用Wang[16]提出的感兴趣区域(Region of Interest,ROI)提取方法,并对ROI进行标准化处理,一定程度上消除因为过度曝光或者噪声等原因对在深度网络模型权重更新的影响。

(2)网络权重初始化及参数设置。文中将VGGFv的卷积层的权重用正交矩阵初始化,偏置固定为0,将Triplet损失函数的阈值m设为1;将学习率初始化为0.01,每100个epoch缩减为原来的0.1,采用Adam优化器,L2正则化的权重设为0.0001;NetVLAD模块中聚类中心通过随机初始化得到,剩下的两个可学习参数根据其与类中心的关系得到初始化。

(3)构造采样器,指定每一个batch输入的图像类别数n,每类图像的样本数m。文中n设为16,m设为3,即batch size为48。

(4)采用线上难分负样本挖掘策略来构造三元组,具体训练过程如下:

a.一个批次的图像经过网络前向传播后得到m×n个描述子xi,i=1,2,…,n×m;

b.计算欧氏距离矩阵,L=l2(XTX),矩阵大小为(m×n)2,用于后续样本挖掘时的距离比对;

c.对每一个类别,同类别样本对共![]() 对,对于其中每一对正样本{xa,xp},选取一个来自与xa不同类别的xn构成三元组{xa,xp,xn},其中xn使损失函数最大,最终一个批次中m×n张图像将得到

对,对于其中每一对正样本{xa,xp},选取一个来自与xa不同类别的xn构成三元组{xa,xp,xn},其中xn使损失函数最大,最终一个批次中m×n张图像将得到![]() 个三元组;

个三元组;

d.根据选择的三元组计算损失并反向传播;

e.进入下一个batch,继续训练至迭代结束,文中共训练200个epoch。

4 实验及结果

为了评估和验证所提出的网络结构和损失函数的有效性,我们在三个公开数据库上进行指静脉身份验证实验,使用公认的等错误率(Equal Error Rate,EER)来进行评价。

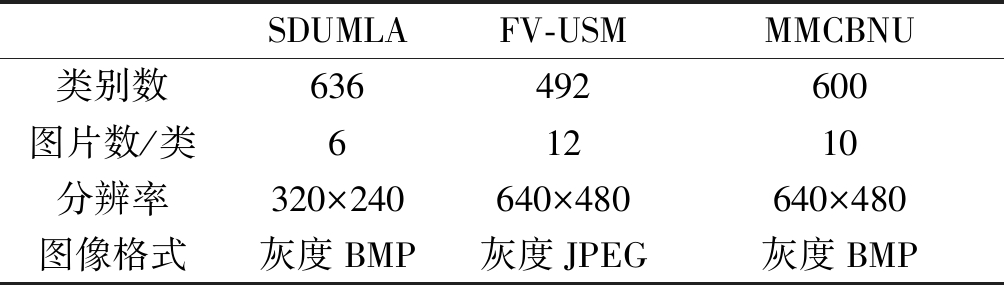

4.1 实验数据库与环境

文中实验使用的公开数据库为FV-USM[7],SDUMLA[8]和MMCBNU[9]。表2列出了以上三个公开数据库的相关统计数据和属性,后续实验结果中分别用其简写USM,SD,MCB表示。为与现有方法进行对比,在每个公开库上的实验在闭集协议(Close Set Protocol,CSP)和开集协议(Open Set Protocol,OSP)[2]下进行。

表2 三个公开数据库的基本情况

Tab.2 The outline of the three public databases

SDUMLAFV-USMMMCBNU类别数636492600图片数/类61210分辨率320×240640×480640×480图像格式灰度BMP灰度JPEG灰度BMP

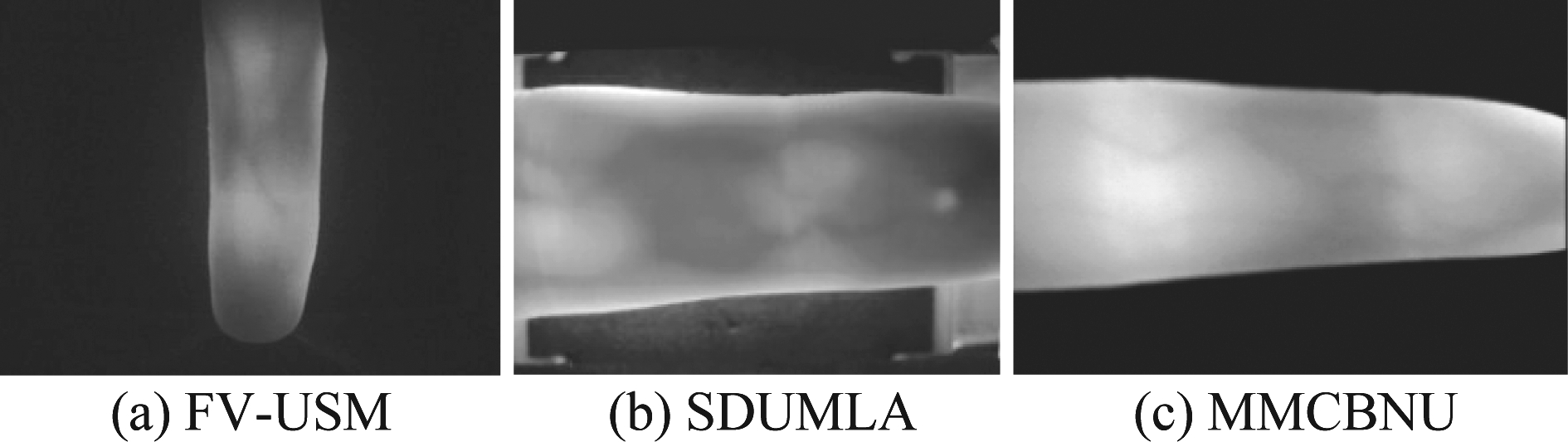

图5展示了三个公开中的指静脉图例。所有实验均在Ubuntu16.04系统上进行,其中CPU型号为Intel(R) Xeon(R) CPU E5-2683 v3@2.00GHz,GPU型号为GeForce GTX 1080 Ti,CUDA 版本为 10.2,所使用的深度学习框架为Pytorch的1.0.1.post2版本。

图5 公开数据库指静脉图像示例

Fig.5 Example of finger vein images in public database

4.2 网络结构的有效性验证

(1)超参数K的选择

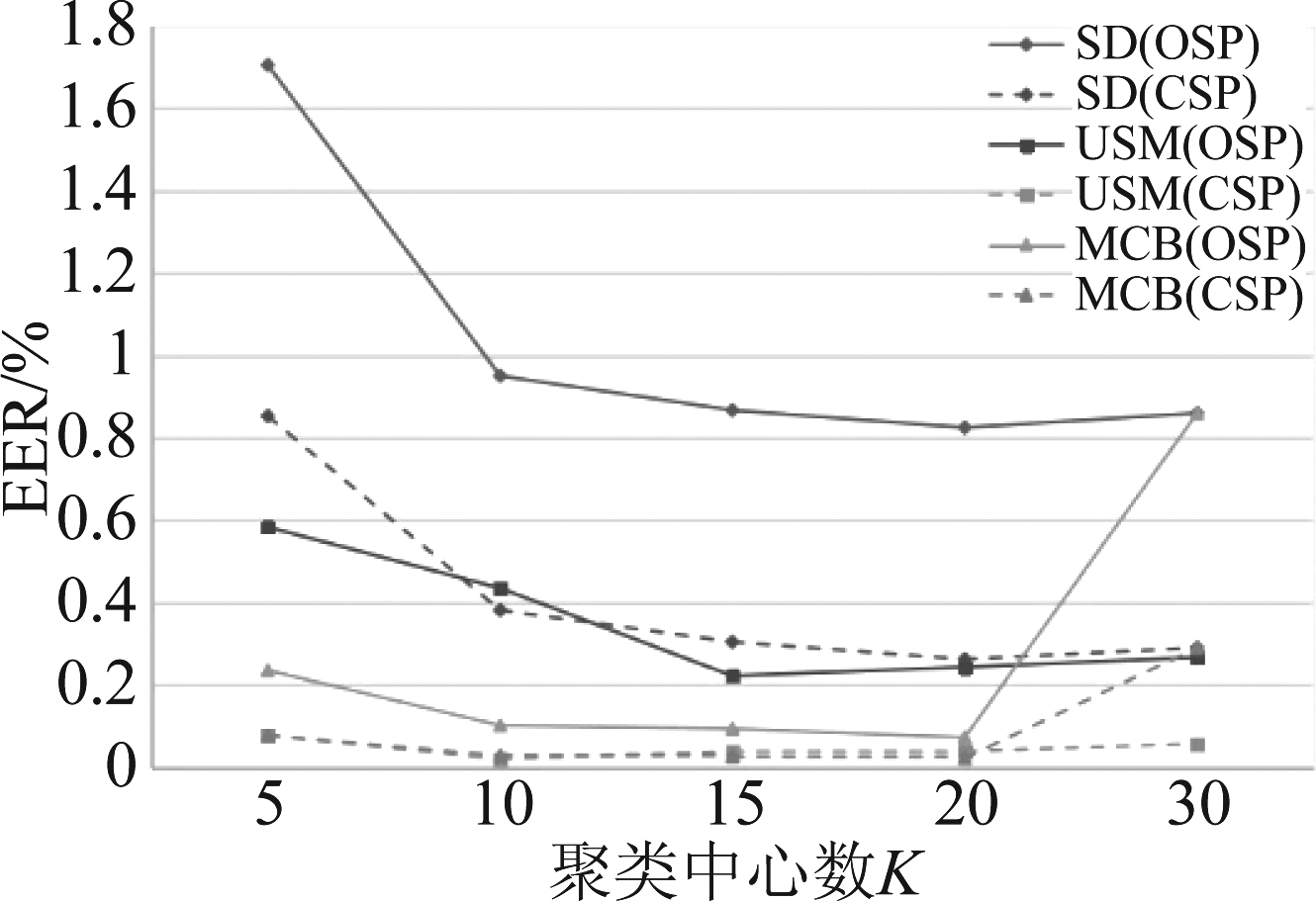

聚类中心的数量K表示图像中特征点的种类数。指静脉图像本身特征点种类较少,同时K决定了最终描述子的维度,因此适合取相对较小的值。为选择合适的K值,取5,10,15,20,30进行了实验,实验结果如图6所示。

图6 不同K值下的EER(%)

Fig.6 EER(%) under different K values

从整体上看,随着K值的增加,EER逐渐下降,然后趋于饱和甚至上升。具体来说,在MCB上,当K超过20时EER有明显上升,因为MCB公开库的图像质量较好,图像特征清晰且类别较少,当设置的聚类中心数量过多,多于其本身的特征点类别的时候,会使描述子的表征力下降,取K=10时便具有较好的效果,在USM和SD上,分别取K=15、20时得到最低的EER。考虑到描述子的维度与识别精度的平衡,本文在三个公开库上均选择K=10进行后续其他对比实验。

(2)网络结构的有效性验证实验

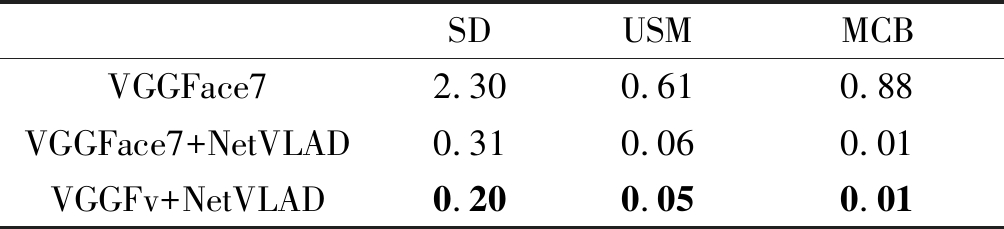

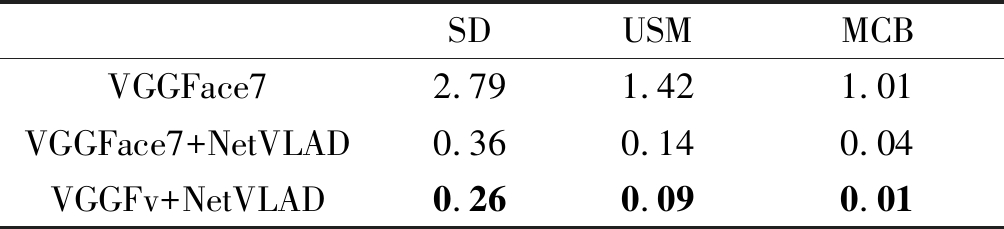

指静脉验证实验中,网络结构均使用Triplet损失函数进行训练,通过计算描述子的欧氏距离完成身份匹配,实验结果如表3、表4所示。

表3 闭集协议下不同网络结构对比结果(EER(%))

Tab.3 Results of different network structures under CSP(EER(%))

SDUSMMCBVGGFace72.300.610.88VGGFace7+NetVLAD0.310.060.01VGGFv+NetVLAD0.200.050.01

表4 开集协议下不同网络结构对比结果(EER(%))

Tab.4 Results of different network structures under OSP(EER(%))

SDUSMMCBVGGFace72.791.421.01VGGFace7+NetVLAD0.360.140.04VGGFv+NetVLAD0.260.090.01

对比使用VGGFace7提取特征图并展平得到的1536维描述子,和将VGGFace7提取的特征图进行VLAD编码后(VGGFace7+NetVLAD)得到的2560维描述子,数据表明加入VLAD之后,指静脉验证的错误率大幅降低,证明了文中引入VLAD编码模块的有效性;对比VGGFace7+NetVLAD和VGGFv+NetVLAD得到的1280维描述子,数据表明VGGFv+NetVLAD尽管得到的描述子在维度上降为原来的一半,但在指静脉验证的错误率上有大幅度的降低,说明了修改后的局部描述子提取网络VGGFv的有效性,也证明了对于指静脉图像而言,并不需要复杂的模型。

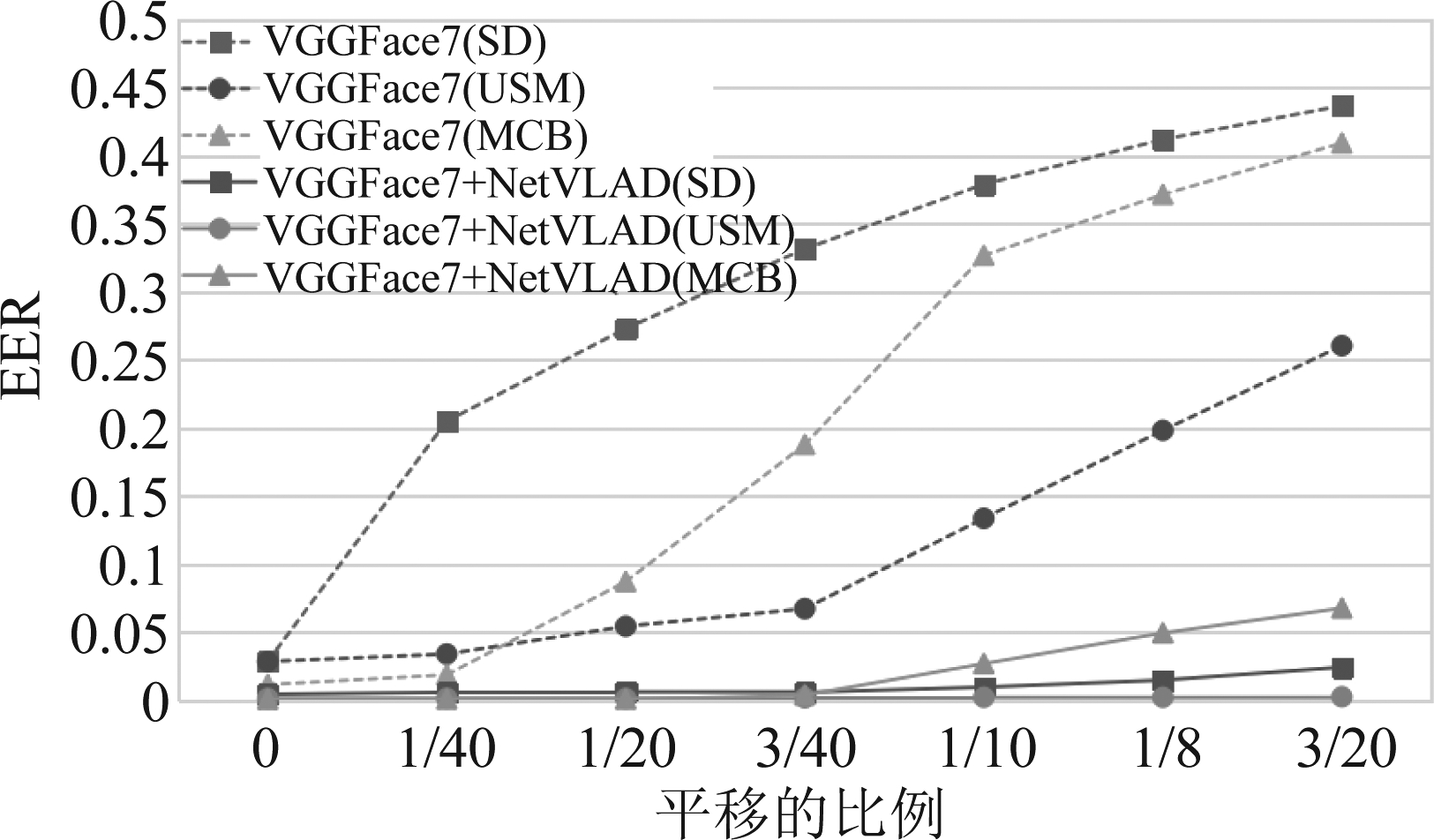

图7 图像随机平移导致EER的变化趋势图

Fig.7 The change trend of EER caused by random image shift

进一步地,模拟实际指静脉识别中的手指水平平移情况来测试描述子的鲁棒性。具体做法为:对测试集图像进行ROI提取,然后随机进行左右或上下平移,平移的距离占原始图像宽或高的比例为0%~15%,最后再将指静脉图像归一化,并输入到训练好的网络提取描述子,在测试集上测得验证系统的EER。当图像发生平移时,EER变化越小说明指静脉验证系统越稳定,在计算描述子欧氏距离进行指静脉匹配的情况下,也说明描述子对手指平移变化的鲁棒性越好。从图7中可看出,当输入图像发生微小幅度的平移时,使用VGGFace7的验证系统的EER便有明显升高。加入VLAD编码之后,在输入发生小幅度平移时,验证系统EER能基本保持稳定,随着平移幅度的增大,EER的上升也相对缓慢,证明在网络结构中加入VLAD后,得到的描述子对手指平移具有更好的鲁棒性。

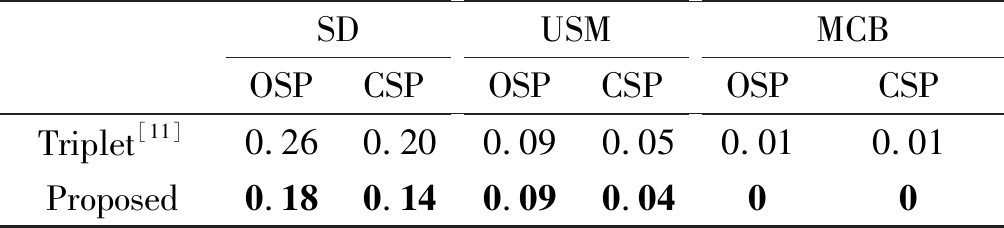

4.3 损失函数的有效性验证

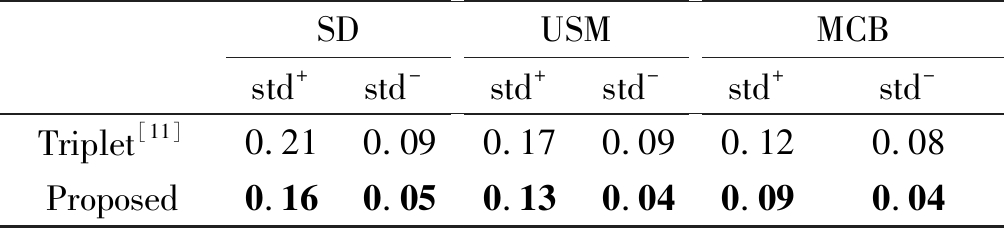

为了验证所提出的损失函数的有效性,使用3.2节中提出的VGGFv+NetVLAD网络结构,分别使用Triplet损失和提出的损失进行对比实验。计算测试集中正样本对距离的标准差std+和负样本对距离的标准差std-,如表5所示。表中三个公开库上的结果均显示,使用提出的损失函数相对于Triplet损失而言,std+和std-均有所降低,说明提出的损失函数增加了正样本对距离、负样本对距离这两类的类内紧凑程度。

表5 描述子间的距离的标准差对比

Tab.5 Standard deviations of distances between descriptors

SDstd+std-USMstd+std-MCBstd+std-Triplet[11]0.210.090.170.090.120.08Proposed0.160.050.130.040.090.04

表6 不同损失的指静脉验证实验结果(EER(%))

Tab.6 Results of finger vein verification experiments with different losses (EER(%))

SDOSPCSPUSMOSPCSPMCBOSPCSPTriplet[11]0.260.200.090.050.010.01Proposed0.180.140.090.0400

进一步地,指静脉验证对比实验如表6所示,在三个公开库上EER进一步降低或者得以保持,特别在SDUMLA公开库上,EER由原来的0.26%降至0.18%,说明使用所提出的损失函数训练指静脉描述子提取网络具有更好的效果。

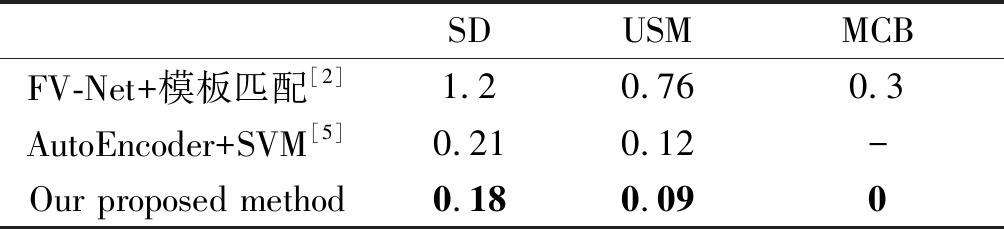

表7 不同算法的EER(%)

Tab.7 EER of different algorithms (%)

SDUSMMCBFV-Net+模板匹配[2]1.20.760.3AutoEncoder+SVM[5]0.210.12-Our proposed method0.180.090

此外,与现有方法对比,FV-Net使用3.9M参数量的CNN提取指静脉图像的特征图,在模型参数量上存在较多冗余;使用基于分类的损失进行网络训练,不利于提升模型的泛化能力;采用复杂的模板匹配策略进行指静脉图像的匹配,增加了整个系统的时间开销,不适合对速度要求更高的指静脉识别场景。表7显示,该方法在开集协议下的指静脉验证错误率仍然较高,特别是在SDUMLA公开库上;文献[5]使用参数量为0.6M的自编码器和基于均方误差的重建损失函数来训练,利用SVM分类来进行指静脉验证,虽然取得了优于FV-Net的验证效果,但是该方法还需额外训练SVM分类器。本文使用参数量仅0.3M的网络结构VGGFv+NetVLAD和提出的样本对中心约束损失函数进行网络训练,并通过计算欧氏距离来衡量描述子的相似性进行指静脉图像匹配,EER达到了最低,同时,简化了指静脉图像的匹配过程,扩展了描述子的应用场景,更适合实际工程上的应用。

5 结论

本文通过修改VGGFace-Net得到局部描述子提取网络,并引入VLAD编码来对局部描述子进行聚合编码,得到参数量仅0.3M的指静脉图像描述子提取网络。对于网络的训练,基于三元组损失提出样本对中心约束损失函数,并结合难分负样本挖掘策略进行训练。通过计算欧氏距离来衡量描述子的相似性,与现有方法相比,在三个公开数据库FV-USM,SDUMLA,MMCBNU上的指静脉验证错误率均达到了最低,同时,通过随机上、下、左、右方向的水平平移指静脉图像进行测试,证明了描述子对手指姿势变化具有更好的鲁棒性。总的来说,本文提出的基于CNN和VLAD的指静脉描述子提取方法降低了模型参数量、简化了指静脉的匹配、提高了描述子的鲁棒性、扩展了描述子的应用场景,并且证明了指静脉图像的特征提取并不需要参数量庞大的深度网络。

[1] Fang Y, Wu Q, Kang W. A novel finger vein verification system based on two-stream convolutional network learning[J]. Neurocomputing, 2018, 290: 100-107.

[2] Hu H, Kang W, Lu Y, et al. FV-Net: learning a finger-vein feature representation based on a CNN[C]∥2018 24th International Conference on Pattern Recognition (ICPR). IEEE, 2018: 3489-3494.

[3] Parkhi O M, Vedaldi A, Zisserman A. Deep face recognition[C]∥British Machine Vision Conference, 2015: 6.

[4] Liu W, Wen Y, Yu Z, et al. Large-margin softmax loss for convolutional neural networks[C]∥ICML, 2016, 2(3): 7.

[5] Hou Borui, Yan Ruqiang. Convolutional Auto-Encoder Model for Finger-Vein Verification[J]. IEEE Transactions on Instrumentation and Measurement, 2019, 69: 2067-2074.

[6] Jégou H, Douze M, Schmid C, et al. Aggregating local descriptors into a compact image representation[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. IEEE, 2010: 3304-3311.

[7] Asaari M S M, Suandi S A, Rosdi B A. Fusion of band limited phase only correlation and width centroid contour distance for finger based biometrics[J]. Expert Systems with Applications, 2014, 41(7): 3367-3382.

[8] Yin Y, Liu L, Sun X. SDUMLA-HMT: a multimodal biometric database[C]∥Chinese Conference on Biometric Recognition. Springer, Berlin, Heidelberg, 2011: 260-268.

[9] Lu Y, Xie S J, Yoon S, et al. An available database for the research of finger vein recognition[C]∥2013 6th International Congress on Image and Signal Processing (CISP). IEEE, 2013, 1: 410- 415.

[10]Balntas V, Johns E, Tang Lilian, et al. PN-Net: Conjoined triple deep network for learning local image descriptors[J]. arXiv preprint arXiv: 1601.05030 (2016).

[11]Schroff F, Kalenichenko D, Philbin J. Facenet: A unified embedding for face recognition and clustering[C]∥Proceedings of the IEEE Conference on Computer vision and Pattern Recognition, 2015: 815-823.

[12]Tian Y, Fan B, Wu F. L2-net: Deep learning of discriminative patch descriptor in euclidean space[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 661- 669.

[13]Kumar BG V, Carneiro G, Reid I. Learning local image descriptors with deep siamese and triplet convolutional networks by minimising global loss functions[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 5385-5394.

[14]Gu H, Wang Y. Learning local descriptors with latent hard sample mining[C]∥Eleventh International Conference on Graphics and Image Processing (ICGIP 2019). International Society for Optics and Photonics, 2020, 11373: 1137334.

[15]Arandjelovic R, Gronat P, Torii A, et al. NetVLAD: CNN architecture for weakly supervised place recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 5297-5307.

[16]Wang M, Tang D. Region of interest extraction for finger vein images with less information losses[J]. Multimedia Tools and Applications, 2017, 76(13): 14937-14949.