1 引言

行人重识别(Person Re-Identification, ReID)作为一个跨摄像机的特定行人检索问题得到了广泛的研究,其目的是匹配出现在不同摄像头视图中的人[1-2]。对于给定的待查询行人,我们需要匹配出在其他地点、时间段并由其他摄像头捕捉到相同的行人图片[3]。并且,待查询行人可以是图片、视频序列或者文字说明[4- 8]。作为一个复杂行人检索问题,ReID面临着许多挑战,即摄像机捕捉到的行人图像具有一系列的差异,包括视角、图像分辨率、光照变化、遮挡等问题,这对于进一步提高检索精度仍然是一个巨大的挑战[2]。

为了解决这个问题,一般来说,行人重识别的许多方法集中在训练出具有足够区分能力的特征,来表示多个摄像头捕捉到大规模的行人信息,这些特征往往需要包含局部信息和全局信息。在过去几十年中,深度卷积神经网络以其出色的特征提取和表达能力,在行人重识别领域获得了巨大的发展,大量的卷积神经网络被应用在行人重识别领域,如ResNet50[9],OSNet[10],HACNN[11]等。但是,这些网络不能够同时保持高效率、高性能,并且可扩展性不足。同时,由于行人重识别数据集类内的关系,单分支网络的全局信息检索性能非常有限。为了解决这个问题,许多方法被提出。相较于学习到全局轮廓的特征,部分级别的特性可能包含更细粒度的信息。当前利用部分级别特征做ReID的方法大致分为两类:一类是利用人体姿态估计[12-16]获取外部信息进行部分的分割,它们依赖于外部人体姿态估计数据集和复杂的姿态估计器。例如,基于姿态的ReID [17]利用姿态的关键点来划分身体不同的块,以增强待识别的特征表示;另一类[18-20]舍弃了这种方式,不使用额外的姿态估计器,而是采取水平分割的方式。例如,基于分块的ReID [21]将行人直接均匀分割(如头部、身体等)。多分支网络能够弥补单分支网络的不足,获取更多的特征。例如,基于多分支的ReID(MGN,ABD-NET,BDB)[22-24]通过分支结构,实现了性能的明显提升。基于关系网络的ReID [25-26]可以获取局部特征之间的关系。关系网络背后的基本思想是考虑所有实体对,并将所有这些关系整合。One-vs-Rest关系模块[25]它考虑了身体各个部位与身体其他部位之间的关系,使得每个部分级别特征都包含了相应部位本身以及身体其他部位的信息,使其更具识别性。以上提取部分特征的方法都采用多个ID Loss(Cross Entropy Loss),但这种方式可能会使不同部分特征在训练过程中相互影响。

被广泛使用的ResNet50骨架网络复杂度高,参数量大,而且扩展起来需要很大的参数代价。在本文中,我们引入EfficientNet系列网络[27]作为全新的网络主干。EfficientNet系列网络有着更为强大的分类能力,内部结构设计更加合理,运行更加高效。所以,总结我们的贡献如下:(1)我们将EfficientNet系列网络引入到ReID中,作为一个更加强大的骨干网基线方法,其运行更加高效,而且具有极其友好的扩展能力,极易扩展到EfficientNet系列其他网络,以适应大规模的数据要求;(2)我们在EfficientNet系列网络的基础上引入二分支结构,结合分支的局部特征和主干的全局特征,引入了相应的模型以及训练策略,并在基于EfficientNet-B4的二分支结构上获得进一步的性能提升。大量的实验表明,该结构在流行的ReID数据集上能够取得很好的成绩。

2 EfficientNet系列网络的引入

2.1 深度ReID主干模型的发展

大多数现有的深度ReID 模型是以ResNet50这个网络结构为主干来实现的,它存在一个显著缺点:深层网络通常需要较长的训练时间。因此,把它应用在实际场景的成本非常高。为此,也有一些轻量级的网络被设计出来。OSNet作为一个轻量级网络,具有多尺度和多流深度特征学习能力。但是受限于网络较小,可扩展性差,它无法适应大规模的数据要求;HACNN通过将注意力选择与特征表示进行联合学习,能够在不加预训练的情况下达到很好的成绩,但是性能上不及获得预训练的模型。

2.2 EfficientNet简介

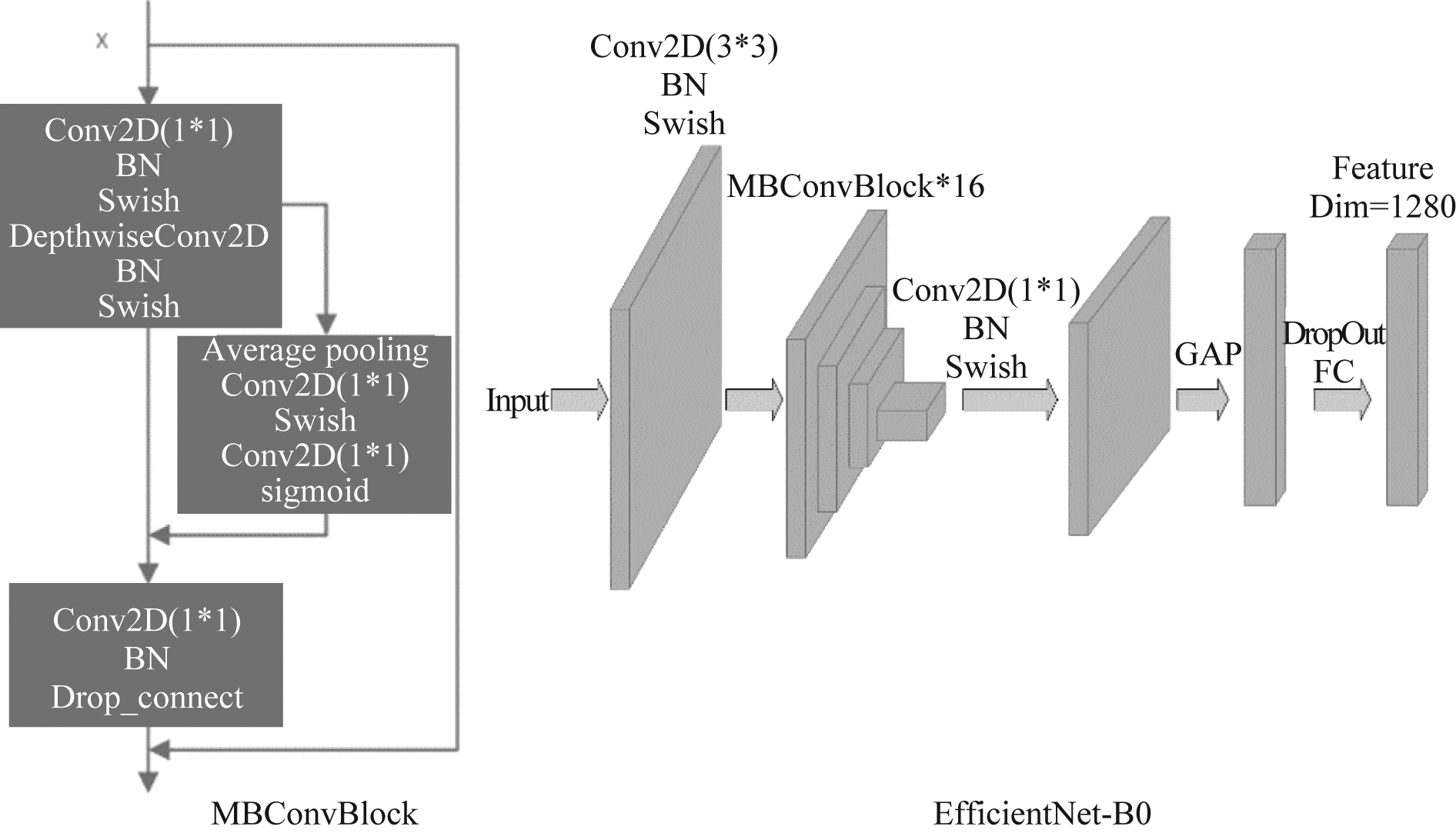

EfficientNet-B0[27]为强化学习算法实现的MnasNet模型所生成的基线模型,如图1(右)。然后,基于EfficientNet-B0这个基线模型,对其模型的深度、宽度(特征图的通道数)、分辨率(输入图片大小)这三个维度同时进行缩放,最终扩展形成了EfficientNet系列模型[27]。EfficientNet实现了深度、宽度、分辨率三个因素的综合考虑,内部采用MBConv块[27]堆叠而成,如图1(左)。相比于其他网络模型,EfficientNet系列网络能够在少量模型参数的情况下同时保持较高的分类准确率。并且,EfficientNet系列模型对比OSNet、HACNN,分类能力更强大,非常易于扩展到其他更大规模的EfficientNet系列模型,如B1、B2、B3等。

图1 MBConv块(左)和EfficientNet-B0骨架网络(右)

Fig.1 MBConv block (left) and EfficientNet-B0 skeleton network (right)

2.3 DropConnect、Dropout和Last Stride

为了降低过拟合风险,EfficientNet系列模型里面加入了大量的DropConnect。DropConnect与Dropout不同的地方在于训练神经网络模型过程中,它不是对隐层节点的输出进行随机的丢弃,而是对隐层节点的输入进行随机的丢弃。为了使EfficientNet系列模型更适应于ReID数据集,我们调整DropConnect、Dropout系数,并使DropConnect系数随着网络层数增加而逐步增大。更高的空间分辨率总是丰富了特征的粒度,Last Stride[28]表示删除了主干网络中的最后一次空间下采样操作,从而扩大最后输出特征图的大小。并且,这种操作不会额外增加训练参数量。

3 基于EfficientNet系列网络的二分支结构

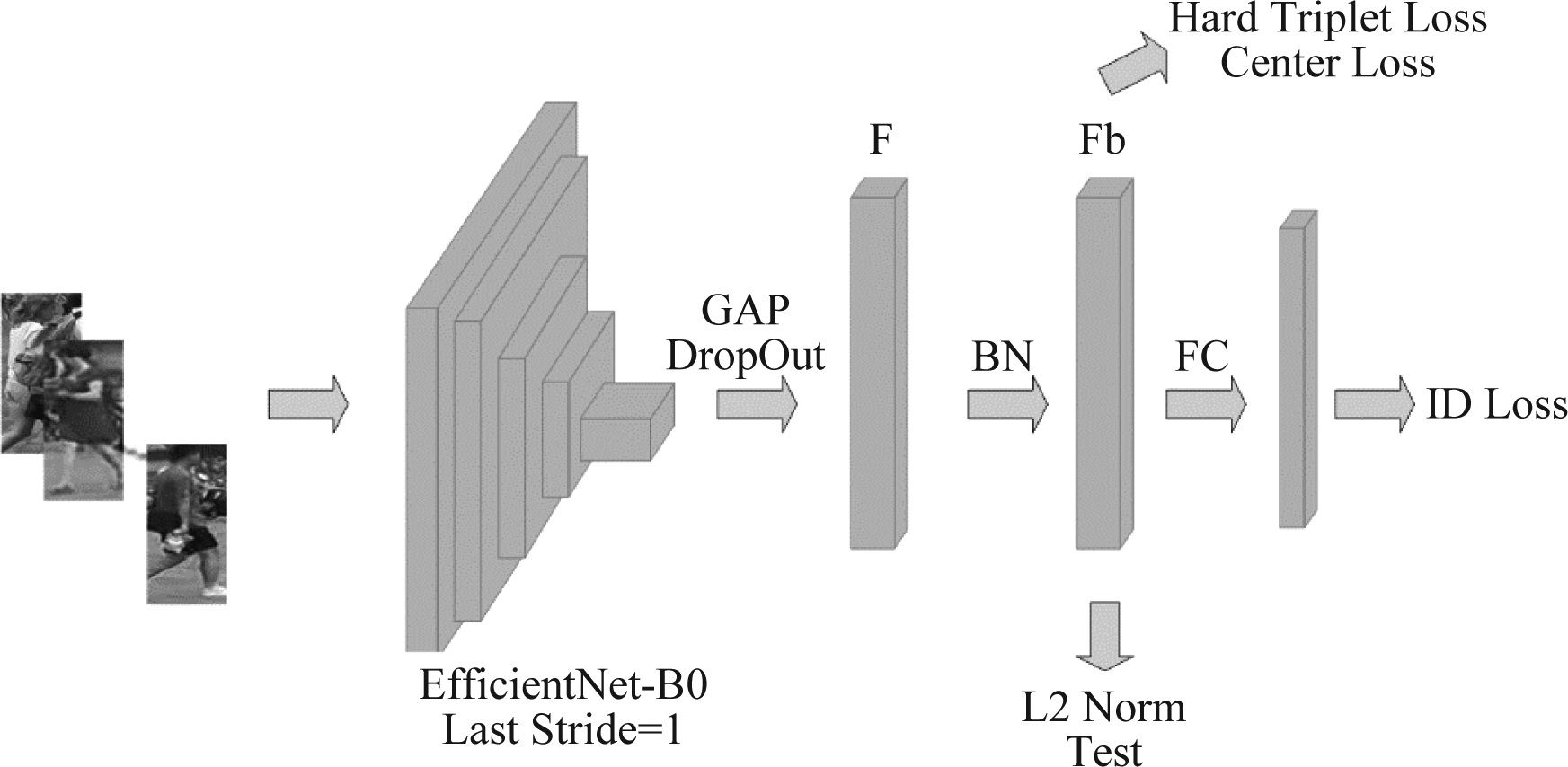

3.1 对EfficientNet-B0的改造

首先,我们引入EfficientNet-B0为主干网络,其大小为5M,是一个轻量级网络。我们主要的改进是在网络最后添加了BN(Batchnorm)层,将送入测试的数据进行二范数归一化,并删除了主干网络的最后一次空间下采样操作,图2中显示了相对于EfficientNet-B0骨架网络(图1右)的改造。实验结果如表1所示,可以看出,尽管EfficientNet-B0参数量为ResNet50网络参数(26M)的五分之一,但是其性能仍然超过了ResNet50(IDE)。

图2 改造后的EfficientNet-B0骨架网络

Fig.2 The reformed EfficientNet-B0 skeleton network

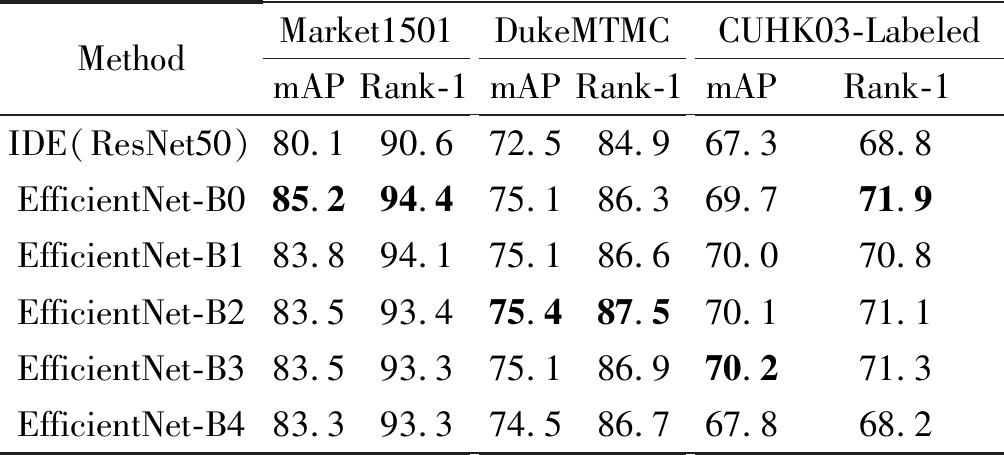

3.2 基于EfficientNet系列网络的二分支改造

如表1所示,尽管改造后的EfficientNet-B0有着较好的性能表现,但是将B0扩展到更大的单分支网络如B1、B2时,性能未见提升。这里我们引入一种二分支结构,结合了全局分支和局部分支,能够缓解由于网络过深而导致性能降低的影响,并且实现性能的进一步提升。

表1 EfficientNet系列网络单分支性能比较

Tab.1 The comparison of the performance of EfficientNet series network

MethodMarket1501mAPRank-1DukeMTMCmAPRank-1CUHK03-LabeledmAPRank-1IDE(ResNet50)80.190.672.584.967.368.8EfficientNet-B085.294.475.186.369.771.9EfficientNet-B183.894.175.186.670.070.8EfficientNet-B283.593.475.487.570.171.1EfficientNet-B383.593.375.186.970.271.3EfficientNet-B483.393.374.586.767.868.2

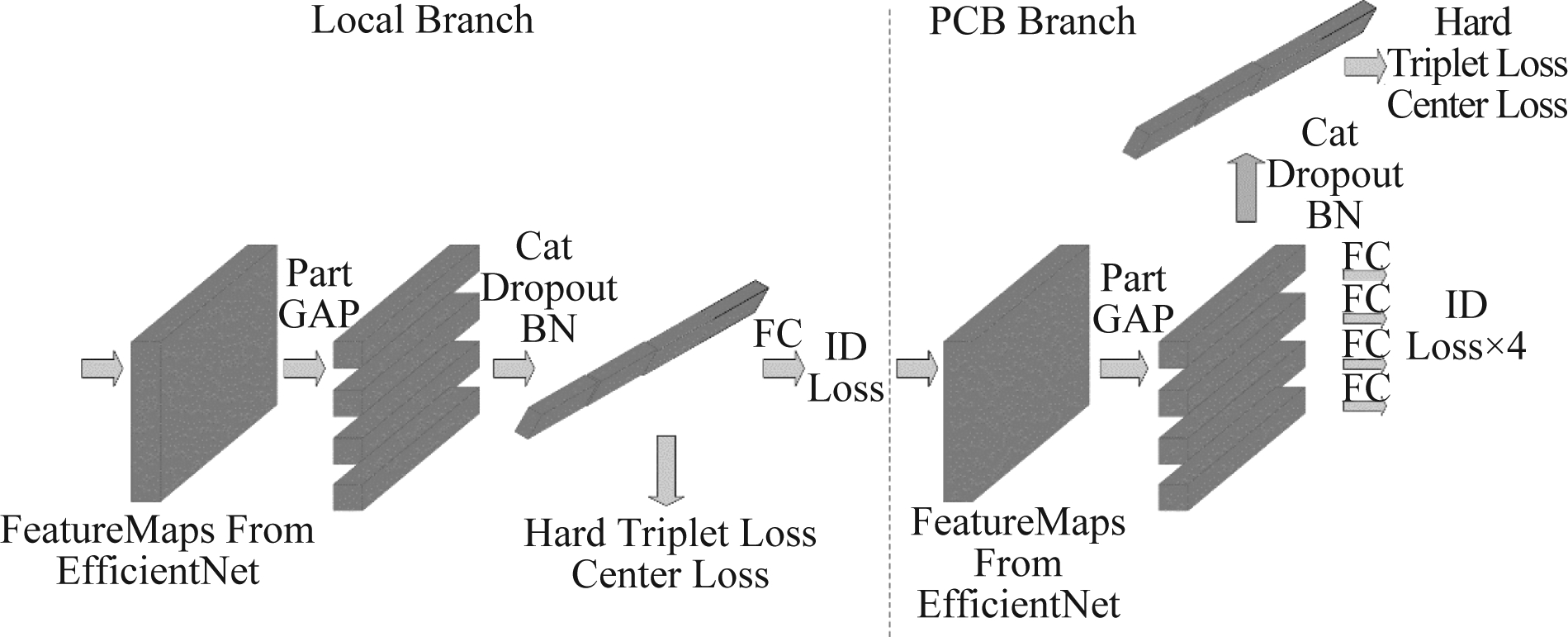

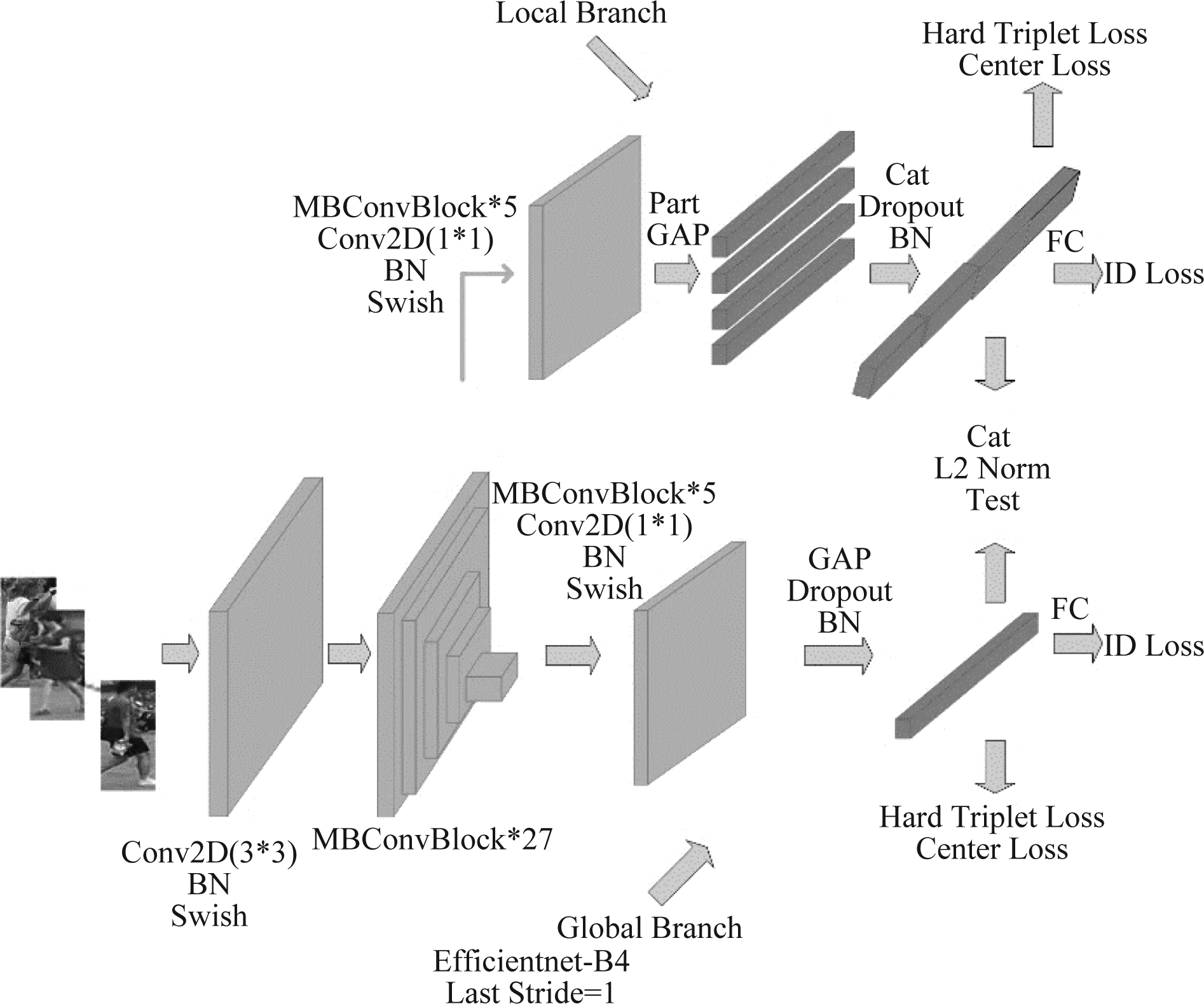

PCB[21]、One-vs-Rest以及MGN等结构在提取局部特征时,均是采用将特征图均匀分块的方式,使用多组ID Loss进行训练。实验结果显示,在分支结构中,这种方式并不一定能带来更好的效果,不同部分的训练结果并不会联合起来共同产生正向增益,而是会相互制约。为此,我们在分支结构中选用一种不同的局部特征提取方式。如图3所示,局部分支仍沿用PCB的分块思路,将分支网络的特征图进行水平均匀分割,获得p个部分特征。与PCB所显著不同的是,我们没有将p(图中p=4)个部分特征单独分解为p个支路,而是将p个部分级特征向量拼接成单个列向量用于1个Local Branch,最终在该Local Branch上只使用一个ID Loss训练,这与现有基于部分分割的方法形成了鲜明的对比。并且,实际方案中我们取p=4。

图3 局部分支(左)和PCB分支(右)

Fig.3 Local branch (left) and PCB branch (right)

图4 基于EfficientNet-B4的局部特征二分支结构

Fig.4 The local characteristic two-branch structure based on EfficientNet-B4

在基于EfficientNet的二分支结构中,我们仍选用EfficientNet系列网络为主干网络。在主干网络中,我们还是采用图2中改造后的EfficientNet-B0骨架网络的基本架构,在全连接层之前加入BN层,将最后Stride步长从2变为1。EfficientNet-B4相较于EfficientNet-B0,网络层数增多,从16个MBConv块变为32个,基本架构相同。图4显示的是基于EfficientNet-B4的二分支结构框图,其主干网络作为全局分支提取全局轮廓特征,并在第28个MBConv块开始展开局部分支提取局部特征。训练时,两个分支网络分别计算两组不同的损失函数值。测试时,将全局特征和拼接后的局部特征再次拼接作为最后判别的特征。并且,在多分支结构中,为了使分支结构学习到与主干网络不同的特征信息,我们在训练网络时,选择将主干网络载入预训练模型参数,而分支网络不载入预训练模型参数。

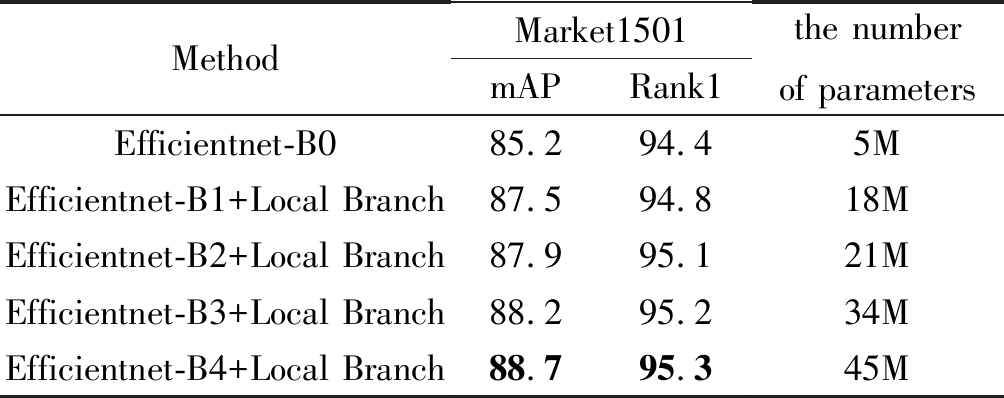

EfficientNet系列网络有极其友好的扩展性能,从B0到其他网络只需要改变MBConv块堆叠数目和相应通道宽度。我们对比了不同规模二分支结构网络的性能(见表2),并给出相应的网络参数量,得出基于EfficientNet-B4的二分支结构效果最好的结论。

表2 EfficientNet二分支网络性能对比及其参数量比较

Tab.2 The comparison of the performance of EfficientNet two-branch networks and its number of parameters

MethodMarket1501mAPRank1the number of parametersEfficientnet-B085.294.45MEfficientnet-B1+Local Branch87.594.818MEfficientnet-B2+Local Branch87.995.121MEfficientnet-B3+Local Branch88.295.234MEfficientnet-B4+Local Branch88.795.345M

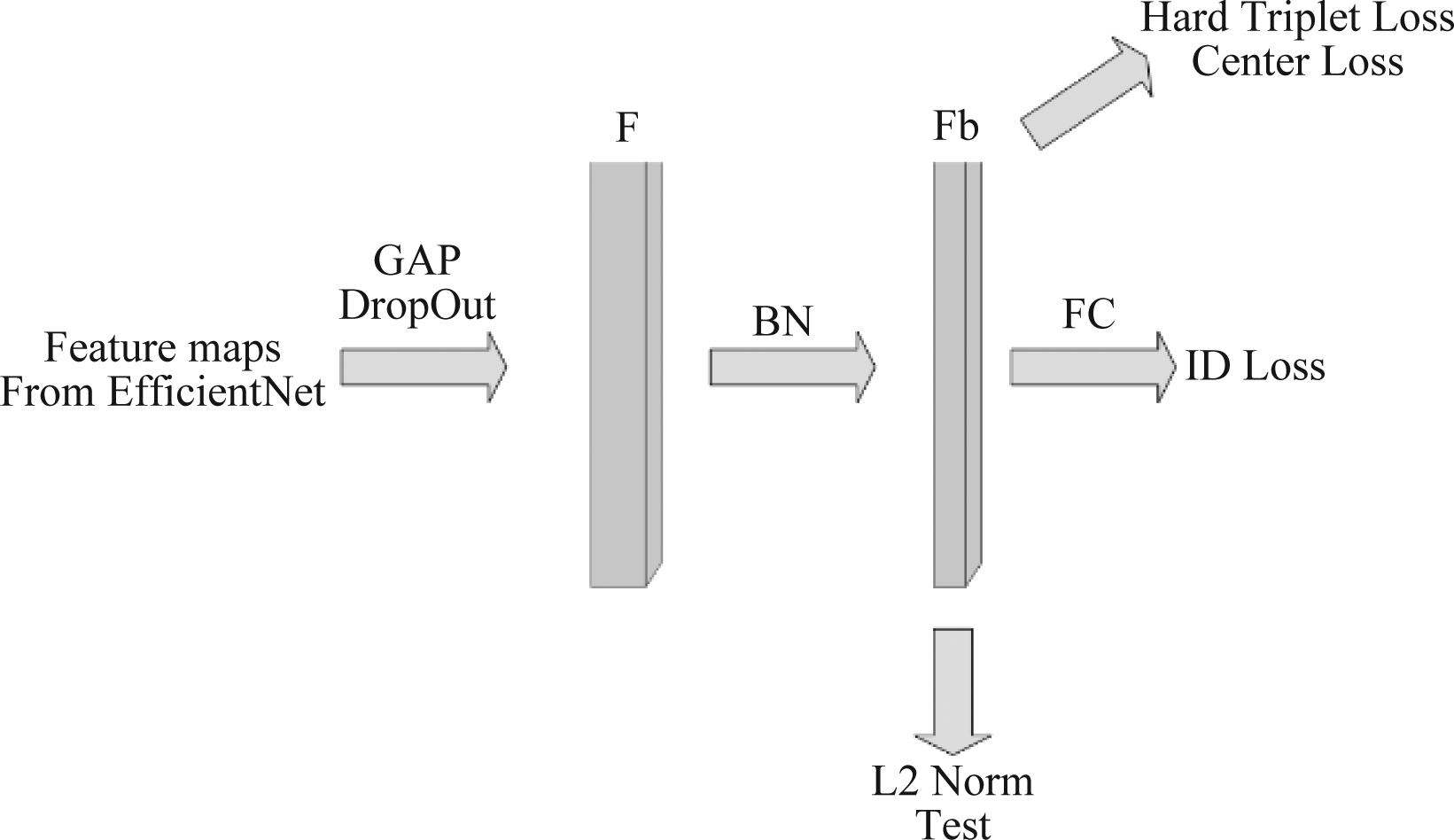

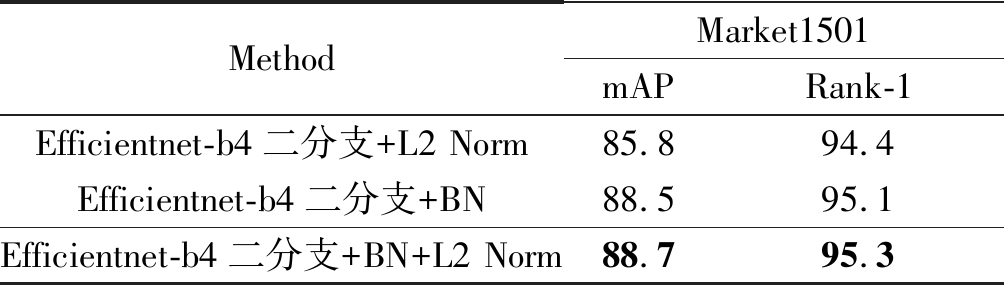

3.3 BN层的作用

值得注意的是,所有EfficientNet系列网络尾端添加的BN层跟Bag of Tricks[28]提出的BNNeck有所不同。BNNeck主要是解决ID Loss(Cross Entropy Loss)和Triplet Loss优化目标不一致的问题。实验证明,这种方法并不是在普遍的网络结构上都适用。这里我们将送入测试和训练的数据都进行BN的规整化操作(BNNeck中计算Triplet loss的特征未经过BN层),并将送入测试的特征进行二范数的归一化,具体如图5所示。

图5 BN层和L2 Norm

Fig.5 BN layer and L2 Norm

实验结果证明这种方式能够有效的提高实验效果,具体结果见表3。

表3 对比BN、L2 Norm的影响

Tab.3 The comparison of the influence of BN and L2 Norm

MethodMarket1501mAPRank-1Efficientnet-b4二分支+L2 Norm85.894.4Efficientnet-b4二分支+BN88.595.1Efficientnet-b4二分支+BN+L2 Norm88.795.3

3.4 损失函数

为了训练具有两个分支的网络,我们分开计算两组损失函数。Global分支和Local分支都需要计算一组ID Loss、Hard Triplet Loss和Center Loss[28]。最后,我们采用加权平均的方式获得最后损失值的总和,即:

(1)

ID Loss即为交叉熵损失函数,具体可以表达为:

(2)

其中,yi表示标签向量,pi表示fc层输出的概率值。

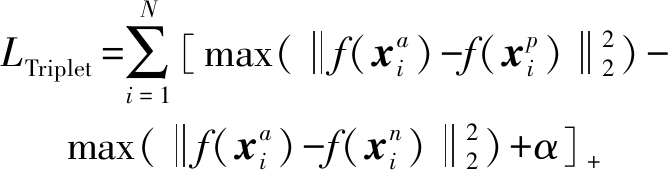

相较于Triplet Loss,Hard Triplet Loss能够形成更难训练的Triplet,加大训练难度,使得训练好的网络分类能力更强。所以,我们选用Hard Triplet Loss代替Triplet Loss。具体而言,我们在样本集中选取P种身份,每种身份选取K个样本,找到锚样本与正样本之间最大的距离,锚样本与负样本之间最小的距离,即形成最难训练的Triplet,具体可表示为:

(3)

其中![]() 分别为从锚样本、正样本和负样本中提取的特征,α是边缘超参数。在实验中,我们默认选用0.3。

分别为从锚样本、正样本和负样本中提取的特征,α是边缘超参数。在实验中,我们默认选用0.3。

为了使类内更加的紧凑,我们加入Center Loss。它在学习到一个类中心的同时会惩罚深度特征和其类中心的距离,这样就弥补了Triplet Loss的缺点,具体表示为:

(4)

其中,yj表示在一个数据块第j个图像的标签,而cyj表示yj所属类别的中心。

4 实验

4.1 数据集

本次实验主要在ReID三个比较流行的数据集上进行测试,分别是Market1501,DukeMTMC-reID[29] 和 CUHK03[30]。Market1501包含1501个行人,其中训练集包含751个行人,共12936张图片;测试集包含750个行人,共19732张图片。Duke包含1404个行人,其中训练集包含702个行人,共16522张行人图片,测试集包含702个行人,共17661张行人图片。CUHK03包含1467个行人,其中训练集包含767个行人,共7368张行人图片,测试集包含700个行人,共6728张行人图片。

4.2 训练细节

这里介绍基于EfficientNet系列网络的二分支结构训练细节。结合EfficientNet的特性,我们在训练和测试中,使输入图像尺寸为384×192;数据增强选用随机翻转、随机檫除[31]、随即裁剪;优化器选用Adam[32]优化器,设置动量为0.9,衰减为5e-04;调节DropConnect、DropOut系数。在训练期间,批次大小设置为64,Epoches的数量为160。每批包含16个行人身份,每个行人有4张样本图像;初始化学习率为0.00002,在训练过程中使用Warmup,使学习率呈线性增长,经过20个Epoch,学习率变化为0.0002;到达60个Epoch,学习率变化为0.00002;再到90个Epoch,学习率变化为0.000002;最后到达120个Epoch,学习率变化为0.0000002。所有EfficientNet二分支网络均是按照以上方法进行训练。在测试时,将具体EfficientNet二分支网络的全局分支和局部分支输出的特征拼接作为判别特征。所有的训练都是用PyTorch进行端到端的训练,具体实验结果见相应的表格。

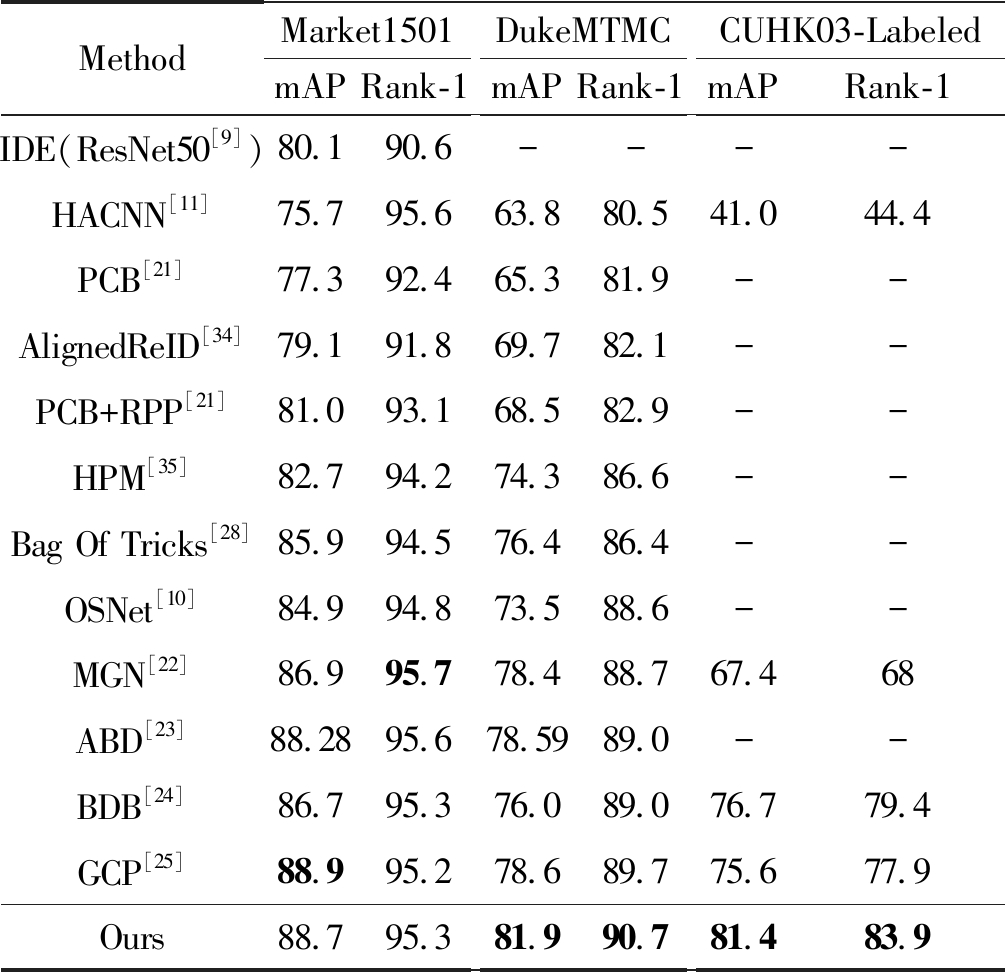

4.3 不同方法的性能比较

在表4中显示的是EfficientNet-B4二分支结构与不同方法的性能比较。需要注意的是,以上结果没有使用重新排序[33]或多查询融合技术,所有被用来比较的方法包括HA-CNN,AlignedReID[34],PCB, HPM[35],MGN,GCP,ABD,BDB,OSNet,可以看出EfficientNet-B4二分支结构具有很强的竞争力。

表4 B4二分支结构在数据集Market1501、 DukeMTMC-Reid和CUHK03与各种方法的比较。 其中,加粗部分表示各方法中最好的结果

Tab.4 Comparison of B4 two-branch structure with various methods in data sets Market1501, DukeMTMC-Reid and CUHK03,and the bold part represents the best result of each method

MethodMarket1501mAPRank-1DukeMTMCmAPRank-1CUHK03-LabeledmAPRank-1IDE(ResNet50[9]) 80.190.6----HACNN[11]75.795.663.880.541.044.4PCB[21]77.392.465.381.9--AlignedReID[34]79.191.869.782.1--PCB+RPP[21]81.093.168.582.9--HPM[35]82.794.274.386.6--Bag Of Tricks[28]85.994.576.486.4--OSNet[10]84.994.873.588.6--MGN[22]86.995.778.488.767.468ABD[23]88.2895.678.5989.0--BDB[24]86.795.376.089.076.779.4GCP[25]88.995.278.689.775.677.9Ours88.795.381.990.781.483.9

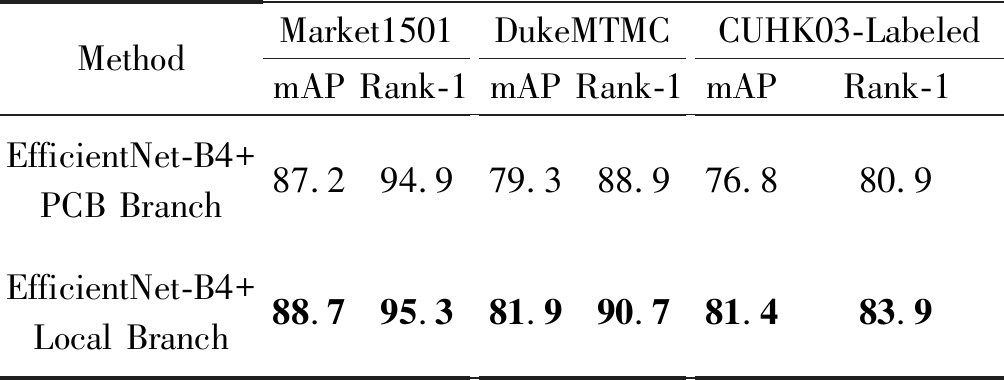

4.4 局部分支和PCB分支的效果对比

在B4的二分支结构中,我们尝试对比了PCB分支(图3右)和局部分支(图3左)的效果。实验结果(见表5)证明对不同部分计算多个ID Loss,会产生相互制约的作用,效果不如局部分支。

表5 局部分支和PCB分支的效果对比

Tab.5 The comparison of the performance of local branches and PCB branches

MethodMarket1501mAPRank-1DukeMTMCmAPRank-1CUHK03-LabeledmAPRank-1EfficientNet-B4+PCB Branch87.294.979.388.976.880.9EfficientNet-B4+Local Branch88.795.381.990.781.483.9

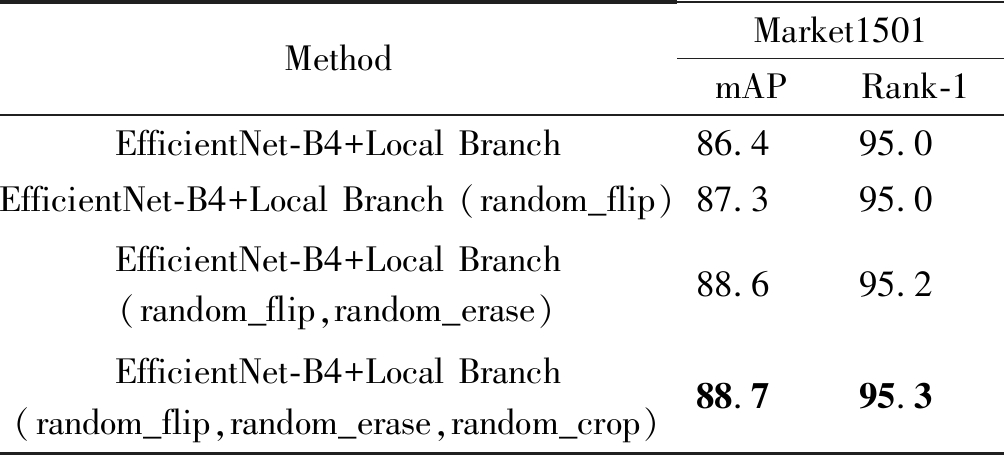

4.5 数据增强实验结果对比

一些数据增强技术能够明显的提高实验效果,这里我们引用了几种行之有效的数据增强技术,分别是随机翻转、随机檫除、随即裁剪。在表6中,我们给出了对比实验结果。

表6 对比数据增强的影响

Tab.6 The comparison of the influence of data augmentation

MethodMarket1501mAPRank-1EfficientNet-B4+Local Branch86.495.0EfficientNet-B4+Local Branch (random_flip)87.395.0EfficientNet-B4+Local Branch (random_flip,random_erase)88.695.2EfficientNet-B4+Local Branch (random_flip,random_erase,random_crop)88.795.3

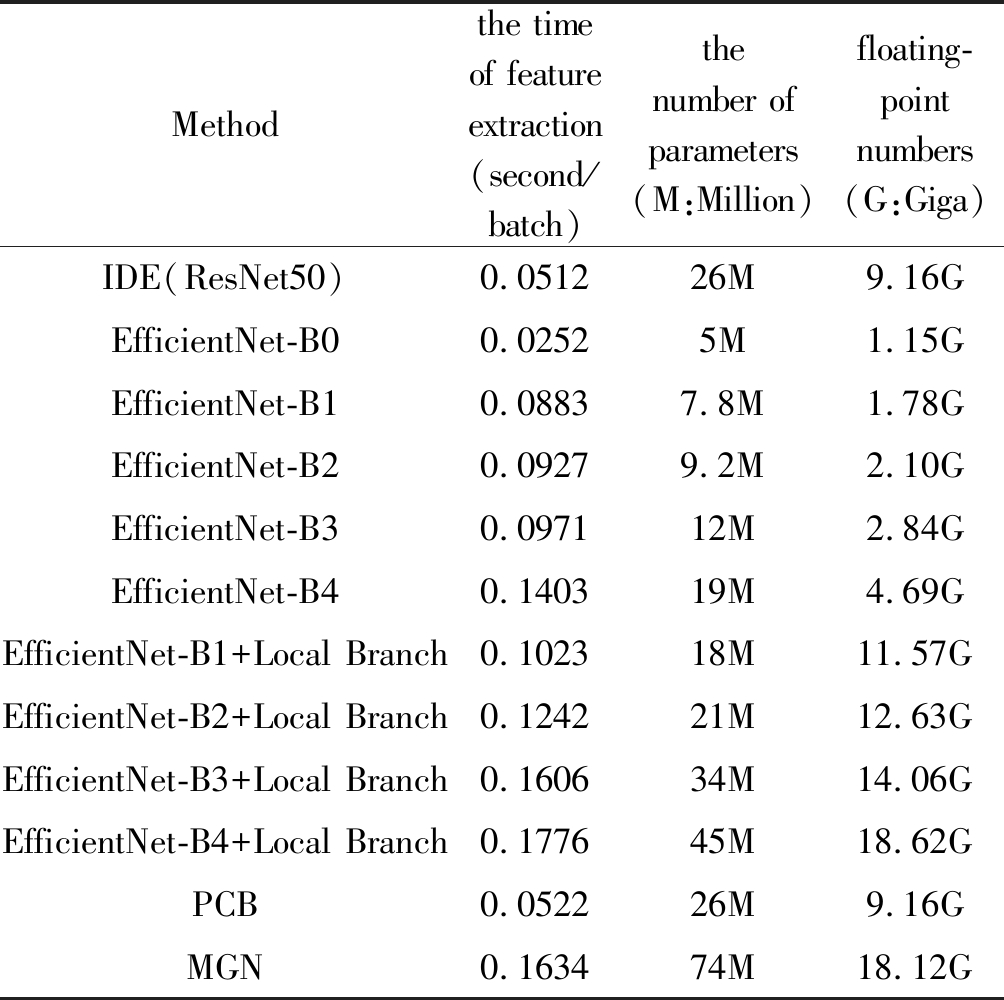

4.6 各网络执行效率对比

为了了解不同网络结构的执行效率,我们在表7中对比了各网络参数量、运算浮点数以及特征抽取时间。结合表1和表7可以得知,EfficientNet-B0无论是在实验结果上,还是在执行效率上,都比ResNet50网络表现得更好。另外,MGN网络也是沿用PCB分块思想而实现的多分支网络。可以看出,基于EfficientNet系列网络的二分支结构对比PCB、MGN结构,性能和效率上都有提升。

表7 各网络参数量、运算浮点数和特征抽取时间对比

Tab.7 The comparison of network parameters, floating-point numbers and the time of feature extraction

Methodthe time of feature extraction(second/batch)the number of parameters(M:Million)floating-point numbers(G:Giga)IDE(ResNet50)0.051226M9.16GEfficientNet-B00.02525M1.15GEfficientNet-B10.08837.8M1.78GEfficientNet-B20.09279.2M2.10GEfficientNet-B30.097112M2.84GEfficientNet-B40.140319M4.69GEfficientNet-B1+Local Branch0.102318M11.57GEfficientNet-B2+Local Branch0.124221M12.63GEfficientNet-B3+Local Branch0.160634M14.06GEfficientNet-B4+Local Branch0.177645M18.62GPCB0.052226M9.16GMGN0.163474M18.12G

5 结论

在本文中,我们引入了EfficientNet系列网络到ReID领域作为全新的骨干网,对比ResNet50,性能高效且可扩展性友好。在此基础上,我们引入了基于EfficientNet系列网络的二分支结构,能够更好的结合局部和全局的特征,并在EfficientNet-B4的二分支结构中实现了更好的性能。此外,各种适合EfficientNet系列网络的训练技巧被应用在训练当中,提高最终实验准确率,其中包括DropConnect、BN、二范数归一化和Last Stride等。

[1] Zhai Y, Chen L. Feature fusion and discriminative null space for person re-identification. J[J]. Signal Process, 2018, 34(4): 476- 485.

[2] Zheng L, Yang Y, Hauptmann A G. Person re-identification: Past, present and future[J]. arXiv preprint arXiv: 1610.02984, 2016.

[3] Gheissari N, Sebastian T B, Hartley R. Person reidentification using spatiotemporal appearance[C]∥2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR′06). IEEE, 2006, 2: 1528-1535.

[4] Gray D, Tao H. Viewpoint invariant pedestrian recognition with an ensemble of localized features[C]∥European Conference on Computer Vision. Springer, Berlin, Heidelberg, 2008: 262-275.

[5] Zheng L, Shen L, Tian L, et al. Scalable person re-identification: A benchmark[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 1116-1124.

[6] Wang T, Gong S, Zhu X, et al. Person re-identification by video ranking[C]∥European Conference on Computer Vision. Springer, Cham, 2014: 688-703.

[7] Ye M, Liang C, Wang Z, et al. Specific person retrieval via incomplete text description[C]∥Proceedings of the 5th ACM on International Conference on Multimedia Retrieval, 2015: 547-550.

[8] Li S, Xiao T, Li H, et al. Identity-aware textual-visual matching with latent co-attention[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 1890-1899.

[9] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770-778.

[10]Zhou K, Yang Y, Cavallaro A, et al. Omni-scale feature learning for person re-identification[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2019: 3702-3712.

[11]Li W, Zhu X, Gong S. Harmonious attention network for person re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 2285-2294.

[12]Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 3431-3440.

[13]Wei S E, Ramakrishna V, Kanade T, et al. Convolutional pose machines[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4724- 4732.

[14]Insafutdinov E, Pishchulin L, Andres B, et al. Deepercut: A deeper, stronger, and faster multi-person pose estimation model[C]∥European Conference on Computer Vision. Springer, Cham, 2016: 34-50.

[15]Newell A, Yang K, Deng J. Stacked hourglass networks for human pose estimation[C]∥European Conference on Computer Vision. Springer, Cham, 2016: 483- 499.

[16]Cao Z, Simon T, Wei S E, et al. Realtime multi-person 2d pose estimation using part affinity fields[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 7291-7299.

[17]Su C, Li J, Zhang S, et al. Pose-driven deep convolutional model for person re-identification[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 3960-3969.

[18]Yao H, Zhang S, Hong R, et al. Deep representation learning with part loss for person re-identification[J]. IEEE Transactions on Image Processing, 2019, 28(6): 2860-2871.

[19]Zhao L, Li X, Zhuang Y, et al. Deeply-learned part-aligned representations for person re-identification[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 3219-3228.

[20]Liu X, Zhao H, Tian M, et al. Hydraplus-net: Attentive deep features for pedestrian analysis[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 350-359.

[21]Sun Y, Zheng L, Yang Y, et al. Beyond part models: Person retrieval with refined part pooling (and a strong convolutional baseline)[C]∥Proceedings of the European Conference on Computer Vision (ECCV), 2018: 480- 496.

[22]Wang G, Yuan Y, Chen X, et al. Learning discriminative features with multiple granularities for person re-identification[C]∥Proceedings of the 26th ACM International Conference on Multimedia, 2018: 274-282.

[23]Chen T, Ding S, Xie J, et al. Abd-net: Attentive but diverse person re-identification[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2019: 8351- 8361.

[24]Dai Z, Chen M, Gu X, et al. Batch DropBlock network for person re-identification and beyond[C]∥Proceedings of The IEEE International Conference on Computer Vision, 2019: 3691-3701.

[25]Park H, Ham B. Relation Network for Person Re-identification[J]. arXiv preprint arXiv: 1911.09318, 2019.

[26]Santoro A, Raposo D, Barrett D G, et al. A simple neural network module for relational reasoning[C]∥Advances in Neural Information Processing Systems, 2017: 4967- 4976.

[27]Tan M, Le Q V. Efficientnet: Rethinking model scaling for convolutional neural networks[J]. arXiv preprint arXiv: 1905.11946, 2019.

[28]Luo H, Gu Y, Liao X, et al. Bag of tricks and a strong baseline for deep person re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, 2019: 0-0.

[29]Ristani E, Solera F, Zou R, et al. Performance measures and a data set for multi-target, multi-camera tracking[C]∥European Conference on Computer Vision. Springer, Cham, 2016: 17-35.

[30]Li W, Zhao R, Xiao T, et al. Deepreid: Deep filter pairing neural network for person re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 152-159.

[31]Zhong Z, Zheng L, Kang G, et al. Random Erasing Data Augmentation[C]∥AAAI, 2020: 13001-13008.

[32]Da K. A method for stochastic optimization[J]. arXiv preprint arXiv: 1412.6980, 2014.

[33]Zhong Z, Zheng L, Cao D, et al. Re-ranking person re-identification with k-reciprocal encoding[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 1318-1327.

[34]Luo H, Jiang W, Zhang X, et al. AlignedReID++: Dynamically matching local information for person re-identification[J]. Pattern Recognition, 2019, 94: 53- 61.

[35]Fu Y, Wei Y, Zhou Y, et al. Horizontal pyramid matching for person re-identification[C]∥Proceedings of the AAAI Conference on Artificial Intelligence, 2019, 33: 8295- 8302.