1 引言

目标再辨识[1-3](Object Re-identification)是指不同监控相机下的行人、车辆的检索问题。目标再辨识技术可用于目标图像检索和目标跟踪,在智能监控,智慧安防等领域具有重要的研究意义[4-5]。但是,由于监控摄像的视角变化、目标对象的姿态变化和外部环境的光照变化等不利因素,造成目标再辨识是一个极具挑战性的问题,受到学术界和工业界的普遍关注。

由于深度学习的迅速发展,目前的目标再辨识算法绝大多数是基于深度网络的。一般来说,目标再辨识网络由深度骨干(Backbone)网和全局特征池化层组成。在构造深度骨干网方面,很多现有的深度网络可以采用,例如ResNet[6], Res2Net[7], IBN-Net[8] 和DenseNet121[9]等。虽然,这些网络一开始都不是专门为目标再辨识设计的,但是由于其具有很强特征学习能力,在目标再辨识问题上也能取得良好的效果。特别是,ResNet[6]由于其残差结构具有优秀的特征学习能力,在目标再辨识中有极其广泛的应用[10-16]。

传统目标再辨识方法[ 10-14]使用全局平均池化,或者全局最大池化,或者广义均值池化来汇聚深度骨干网络提取的特征映射。例如,ResNet50(I+V)[10]和奇异值分解网络[14](SVDNet)等方法都使用全局池化层简单地计算特征映射全局的空间统计量(例如,均值或者最大值)作为目标的图像特征,并不能很好地考虑目标复杂的显著性。针对不同身份标签的目标对象,在全局特征方面,常常具有非常相似的外观和颜色,无法有效区别;反而是在一些局部区域,比如车辆前窗的年检标志、车灯,行人的发型、鞋子区域才具有区别。因此,如何挖掘目标的显著性以强调具有鉴别力的局部区域,对目标再辨识具有重要意义。

为了考虑目标的显著性,一种直接的方法是先将骨干网提取的特征映射等分为几个局部区域,然后独立地在各个区域上进行特征学习。例如,基于部件卷积的基线[15](Part-based Convolutional Baseline, PCB)行人再辨识方法和基于部件感知[16](Visibility-aware Part-level Model, VPM)的2种行人再辨识方法分别把ResNet50[6]提取的特征映射均匀地划分为6个局部区域和3个局部区域,然后在每个局部区域各自连接目标函数进行独立的特征学习。类似的,在车辆再辨识方面,简短密集连接的卷积神经网络[17](Shortly and Densely Connected Convolutional Neural Network, SDC-CNN)采用水平方向池化,相当于将特征映射地划分为4个局部区域进行特征学习。除了等分特征映射之外,多尺度上下文网络[18](Multi-scale Context-aware Network, MSCAN)通过在每一层堆叠多尺度卷积来学习局部性的上下文特征。但是,由于目标姿态变化、摄像头视角差异等因素,PCB[15], VPM[16], SDC-CNN[17]和MSCAN[18]等方法面临部件失准(Part Dis-alignment)问题,即不能准确地划分部件,限制了目标再辨识的准确性。

为了克服部件失准问题,最直观的方法是用姿态估计模型[19-21]和部件检测器[22-24]辅助目标再辨识。例如,部件对齐表征[19](Part-aligned Representations, PAR)方法用姿态估计模型对行人的部件对齐。轴网[20](Spindle Net)方法利用行人关键点来找出感兴趣区域(Region of Interest, ROI)。在车辆再辨识方面,为了解决部件失准问题,部件正则化[25](Part Regularization)方法使用了你只看一次[23]( You Only Look Once, YOLO)作为部件检测器。然而,姿态估计模型[19-21]和部件检测器[22-24]往往本身就是一个深度网络,常常是需要额外的姿态关键点或者部件标注信息、训练和测试运行成本的。因此,基于部件检测器和姿态估计模型辅助的目标再辨识方法也具有局限性。

除了上述方法,近年来对目标再辨识的研究还有采用目标属性信息辅助的再辨识[26-27]方法;时空信息的视觉时空路径提案[28](Visual-spatial-temporal Path Proposals, VST-PP)方法;从视角鲁棒性方面入手的多视角感知型的注意力推理[29](Viewpoint-aware Attentive Multi-view Inference, VAMI)方法和四重方向性深度学习特征[30](Quadruple Directional Deep Learning Feature, QD-DLF)方法;基于注意力模型的比较注意力网络[31](Comparative Attention Network, CAN)和协调性注意力网络[32](Harmonious Attention Network, HA-CNN)方法。总的说来,在现有目标再辨识的研究中,对如何挖掘目标的显著性以强调鉴别性局部区域的研究尚未引起足够的重视。

为了挖掘特征显著性以提升目标再辨识性能,本文提出一种空间和通道双重显著性挖掘(Spatial Channel Dual Significance Mining, SC-DSM)模块。首先,SC-DSM模块在骨干网所提取的特征映射上,利用空间显著性挖掘(Spatial Significance Mining, SSM)子模块和通道显著性挖掘(Channel Significance Mining, CSM)子模块,分别构建空间图(Spatial Graph, SG)和通道图(Channel Graph, CG)。其次,在SG和CG上,通过可学习参数对每个空间和通道上的元素学习权重来强调更具鉴别力的特征。最后,将重新加权后的特征映射再进行全局池化得到用于目标再辨识的特征。实验结果表明,所提出的方法能够优于现有的目标再辨识方法。

本文的主要创新在于设计了一种新颖的空间和通道双重显著性挖掘模块,在不需要任何额外部件检测器或姿态估计模型辅助的情况下,可以显著地提高目标再辨识的性能,并且优于已有的目标再辨识方法。本文的剩余部分安排如下:第2部分介绍本文提出的算法;第3部分为实验数据及其分析;第4部分为结论。

2 基于空间和通道双重显著性挖掘的目标再辨识算法

本节首先详细描述所提出的空间和通道双重显著性挖掘(Spatial Channel Dual Significance Mining, SC-DSM)模块的设计过程,再介绍如何基于SC-DSM模块构建完整的目标再辨识网络。

2.1 空间和通道双重显著性挖掘模块

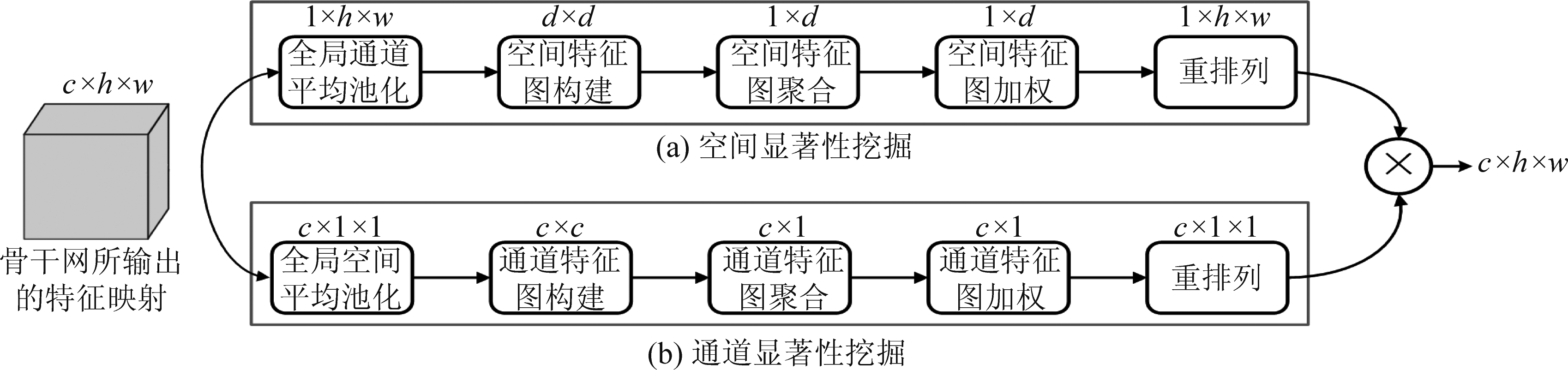

如图1所示,SC-DSM模块由空间显著性挖掘(Spatial Significance Mining, SSM)子模块和通道显著性挖掘(Channel Significance Mining, CSM)子模块组成,SSM和CSM分别用于从空间和通道两个维度上充分挖掘出骨干网络所输出的特征映射中的显著性信息。

2.1.1 空间显著性挖掘子模块

假设SSM子模块的输入特征映射为X∈Rc×h×w,其中c,h和w分别表示特征映射的通道数量,高度和宽度,则如图1(a)所示,SSM的具体运算步骤如下:

步骤1 全局通道平均池化:对特征映射X∈Rc×h×w进行全局通道平均池化(Global Channel Average Pooling, GCAP),GCAP的计算过程如公式(1)所示。

(1)

其中Xi, j,k表示在第k个通道上第i行,第 j列位置上的特征映射值,Si, j则表示GCAP后对应空间位置的特征映射值,所有Si, j构成GCAP后的特征映射S={Si, j|i=1,2,3,...,h, j=1,2,3,...,w}∈Rh×w。

图1 空间和通道双重显著性挖掘模块

Fig.1 Spatial channel dual significance module (SC-DSM)

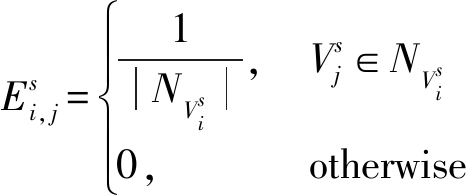

步骤2 空间特征图构建:将S∈Rh×w重新排列成d=h×w维的向量Vs,在其上构建空间图Gs={Vs∈Rd,Es∈Rd×d},即将向量Vs中每个元素指定为一个空间节点(Node),并根据公式(2)义节点之间的边(Edge)。

(2)

其中,![]() 表示空间节点

表示空间节点![]() 与空间节点

与空间节点![]() 之间的边,

之间的边,![]() 和

和![]() 分别表示空间节点

分别表示空间节点![]() 的邻居节点集合和该集合中节点的个数。本文简化边的定义,即

的邻居节点集合和该集合中节点的个数。本文简化边的定义,即![]() 根据空间四邻域(即上、下、左和右)来构建,且在边界处的节点其邻域节点相应减少。

根据空间四邻域(即上、下、左和右)来构建,且在边界处的节点其邻域节点相应减少。

步骤3 空间特征图聚合:对每个空间节点的特征按照公式(3)进行聚合(Aggregation),

Us=(Is+Es)Vs

(3)

其中Is∈Rd×d是单位矩阵,Us∈Rd则是空间节点聚合后的特征数据。

步骤4 空间特征图加权:根据公式(4),利用可学习权重参数φ对Us进行加权,挖掘空间维度上的显著性。

Os=Us⊙φ

(4)

其中,⊙表示点乘运算,φ∈Rd,d=h×w为可学习权重参数。

步骤5 重排列:将公式(4)学习到的空间显著性特征矩阵Os按照内存连续性重新排列为1×h×w 的矩阵。

2.1.2 通道显著性挖掘子模块

首先,如图1(b)所示,CSM子模块对特征映射X∈Rc×h×w进行全局空间平均池化(Global Spatial Average Pooling),GSAP的计算如公式(5):

(5)

其次,构建通道图Gc={Vc∈Rc,Ec∈Rc×c},其中节点集合Vc={Ck|k=1,2,3,...,c},边集合Ec的确定规则同公式(2)相似,通过k=3的滑动窗口来决定,且在边界处节点其邻域节点相应减少。Ec和Es之间的不同之处在于,前者是在通道维度上进行邻域确定,而后者是在空间维度上进行邻域确定。然后,在通道图Gc的基础上,对每个通道节点的特征进行聚合得到通道节点聚合的特征数据Uc=(Ic+Ec)Vc,其中Ic∈Rc×c是单位矩阵。进一步地,利用可学习权重参数φ对Uc进行加权,如公式(6)所示,以挖掘通道维度上的显著性。

Oc=Uc⊙φ

(6)

最后,将空间显著性挖掘子模块的输出Os和通道显著性挖掘子模块的输出Oc进行乘法运算,得到空间和通道双重显著性增强的特征映射Osc,如公式(7)所示:

Osc=OsOc

(7)

结合公式(4)和公式(6)可以发现,本文所提出的SC-DSM模块需要h×w个可学习参数进行空间显著性挖掘和c个可学习参数进行通道显著性挖掘,因此,SC-DSM模块一共仅仅只需要h×w+c个参数。此外,结合公式(4)、公式(6)和公式(7)可以发现,三者皆为线性运算。因此,为了引入非线性,并改善SC-DSM模块的收敛性,本文进一步对公式(7)进行如下改进:

U=LeakyReLU(BN(Osc))

(8)

其中,LeakyReLU是常见的非线性激活函数——带泄露的线性整流单元[33](Leaky Rectified Linear Unit),且设置其在负半轴上的斜率0.2;BN为批归一化[34](Batch Normalization)函数。最终,U∈Rc×h×w取代Osc,作为空间和通道显著性增强后的特征映射。

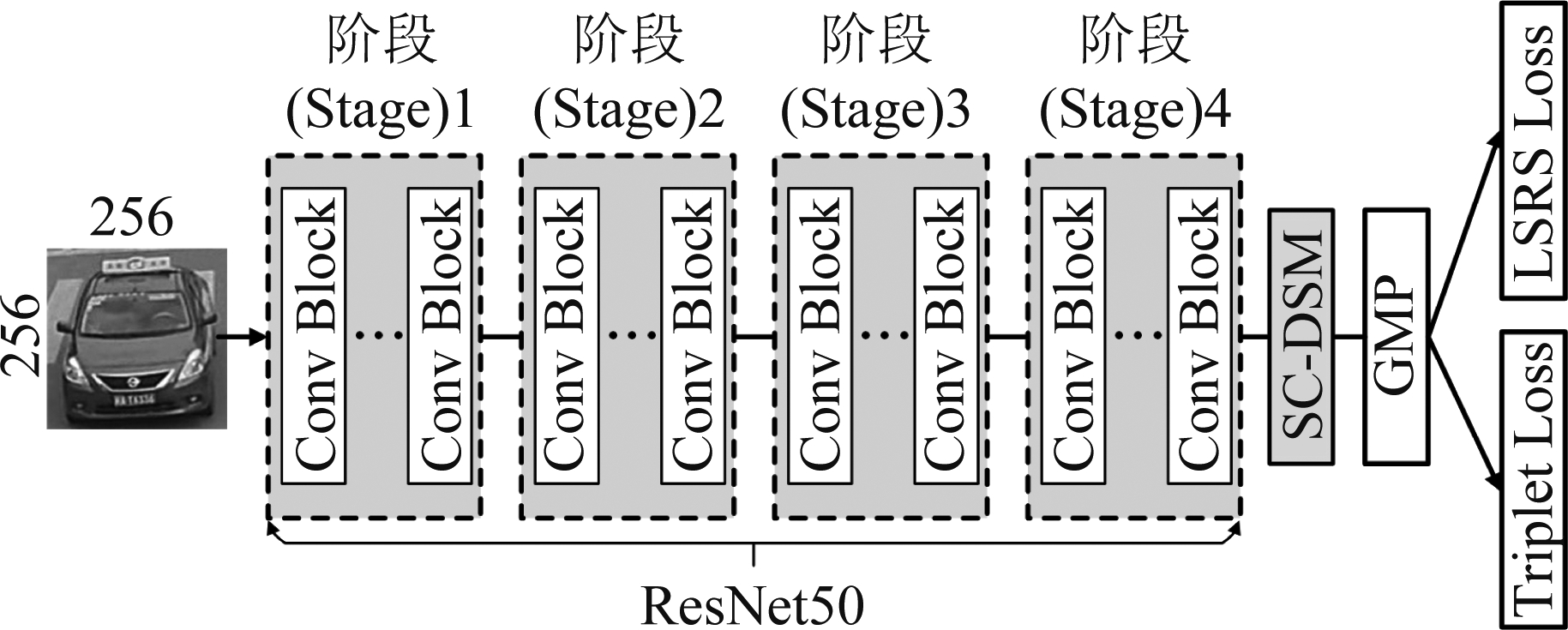

2.2 基于空间和通道双重显著性挖掘模块的目标再辨识网络

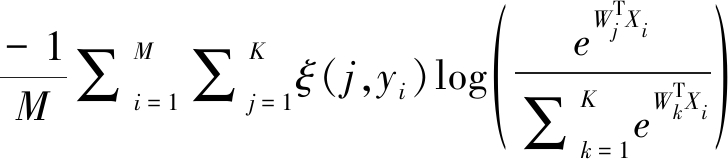

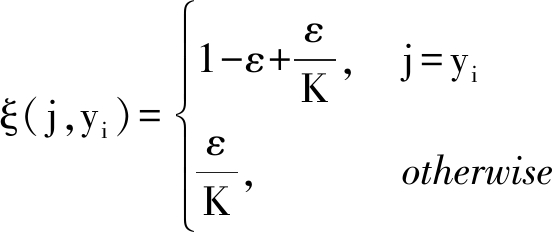

在所提出的SC-DSM模块的基础上,图2给出完整的目标再辨识网络结构。首先,采用ResNet50作为骨干网络,将SC-DSM模块置于骨干网末尾(即图2中的阶段4),挖掘骨干网所输出的特征映射中的显著性。其次,在SC-DSM模块后添加一个全局最大池化(Global Max Pooling, GMP)层进行特征汇聚,从而得到最终用于目标再辨识的图像特征。最后,如图2所示,在GMP输出的特征上联合采用标签平滑正则化(Label Smoothing Regularized Softmax, LSRS)损失函数[11]和三元(Triplet)损失函数[35]进行网络训练。LSRS损失函数的定义如下:

图2 基于空间和通道双重显著性模块的目标再辨识网络

Fig.2 Object re-identification network based on the spatial channel dual significance mining (SC-DSM) module

LLSRS(X,y)=

(9)

(10)

其中,X和y分别表示训练数据和类别标签信息;M是训练样本的数量;K是类别数量;(Xi,yi)是第i个训练样本且yi∈{1,2,...,K};W=[W1,W2,...,WK]是一个可学习参数矩阵;ε>0是一个用于控制标签平滑程度的常数,本文采用和文献[11, 36]相同的设定,将其设置为0.1。

Triplet损失函数定义如下:

Ltriplet(Xa,Xn,Xp)= ![]()

(11)

其中,(Xa,Xn,Xp)是三元组训练集合,T表示集合中的元素数量;对第t个三元训练样本来说,![]() 和

和![]() 分别表示不同标签的负样本对和相同标签的正样本对;m≥0是一个间隔(Margin)参数,本文设置其为1.2;||·||2表示L2范数计算。最后,结合公式(9)、公式(10)和公式(11),本文的目标再辨识网络的总体损失函数(Ltotal)定义如下:

分别表示不同标签的负样本对和相同标签的正样本对;m≥0是一个间隔(Margin)参数,本文设置其为1.2;||·||2表示L2范数计算。最后,结合公式(9)、公式(10)和公式(11),本文的目标再辨识网络的总体损失函数(Ltotal)定义如下:

Ltotal=Llsrs+αLtriplet

(12)

其中,α>0用于平衡两种损失函数的贡献,本文将其设置为0.5。本文采用小批量随机梯度下降[37](Mini-batch Stochastic Gradient Descent, Mini-batch SGD)方法对网络参数进行训练。

3 实验数据及其分析

为了验证所提出的基于空间和通道双重显著性挖掘的目标再辨识算法的优越性,本文采用常见的累计匹配特性(Cumulative Matching Characteristics, CMC)曲线[1-3]和平均精度均值[38-39](Mean Average Precision, mAP)作为性能指标,在车辆再辨识数据库VeRi776[38]和行人再辨识数据库Market1501[39],与最近的多种目标再辨识方法进行比较。

3.1 数据库

VeRi776[38]车辆再辨识数据库由20个摄像头在真实的交通场景下采集,其中每辆车平均由2~18个摄像头采集到。VeRi776的训练集包含576类的37746张车辆图像,测试集包括200类的1678张查询(Query)图像集和来自同样200类的11579张注册库(Gallery)图像集。另外,按照VeRi776的测试协议[38],只对跨摄像头车辆对进行评估,换言之,如果一张查询图像和一张注册库图像是由同一个摄像头拍摄的,那么在评估过程中会排除相应的结果。

Market-1501[39]行人再辨识数据库是在清华大学的一个超市门前收集,其收集过程总共涉及6台相机,包括5台高分辨率相机和一台低分辨率相机。该数据集包含了1501类行人的32668张图像,其中训练集由751类行人的12936张图像组成,而测试集由750类行人的3368张查询图像和19732张注册库图像构成。

3.2 算法软硬件配置

本文实验采用的操作系统是Ubuntu16.04,深度学习工具是Pytorch[40],算力为两块Titan 12GB GPU显卡。训练配置总结如下:(1)将图像分辨率统一调整为256×256,数据增强采用水平翻转,随机擦除和Z-score归一化。其中,水平翻转和随机擦除的概率都被设置为0.5。(2)采用Mini-batch SGD[37]进行参数训练,参数的权重衰减值(Weight Decay)设置为5×10-4,动量(Momentum)设置为0.9,训练一共进行了采用120轮(Epoch)。学习率初始化为3×10-4,在前10轮利用线性热启动[36](Linearly Warm Up)方法将学习率升高到3×10-2。热启动结束后,学习率在第11到第50轮之间维持为3×10-2;在第51~80轮学习率维持在3×10-3;在第81到第110轮学习率维持在3×10-4;在第111到第 120轮学习率保持为3×10-5。(3)SGD优化过程中每个小批(Mini-batch)数据包含32个类别,每个类别有4张图像。(4)按照文献[36]文中的训练技巧,将ResNet50骨干网络的最后滑动步长(Last Stride)设置为1。在测试阶段,将图2中GMP层所输出的2048维特征作为最终的图像特征,并利用余弦距离作为目标再辨识的相似度测量。

3.3 实验结果及其分析

3.3.1 与近几年的目标再辨识方法的性能比较

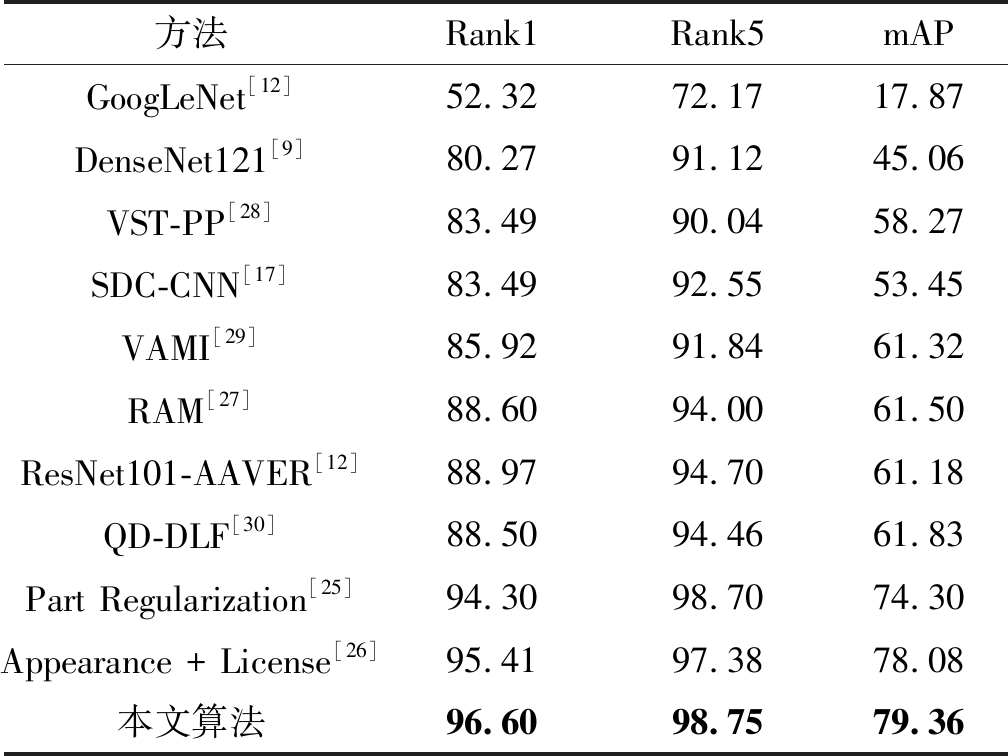

表1给出在VeRi776数据库上,本文所提出的算法在和近年来的车辆再辨识方法的性能比较结果。首先,可以发现本文算法获得最好的性能,即Rank1识别率和mAP分别达到了96.60%和79.36%。特别值得一提的是,在都使用ResNet50作为骨干网络的前提下,本文方法同使用部件检测器辅助Part Regularization方法[25]即和使用车牌信息辅助的Appearance + License[26]方法相比,本文方法在mAP上分别高出5.06%和1.28%。这些比较结果证明本文所提出的算法在不需要部件检测器和车牌信息辅助的情况下,通过充分挖掘特征映射在空间和通道上的显著性,能够取得优异的性能。

表1 在VeRi776上性能(%)比较

Tab.1 The performance (%) comparison on VeRi776

方法Rank1 Rank5mAPGoogLeNet[12]52.3272.1717.87DenseNet121[9]80.2791.1245.06VST-PP[28]83.4990.0458.27SDC-CNN[17]83.4992.5553.45VAMI[29]85.9291.8461.32RAM[27]88.6094.0061.50ResNet101-AAVER[12]88.9794.7061.18QD-DLF[30]88.5094.4661.83Part Regularization[25]94.3098.7074.30Appearance + License[26]95.4197.3878.08本文算法96.6098.7579.36

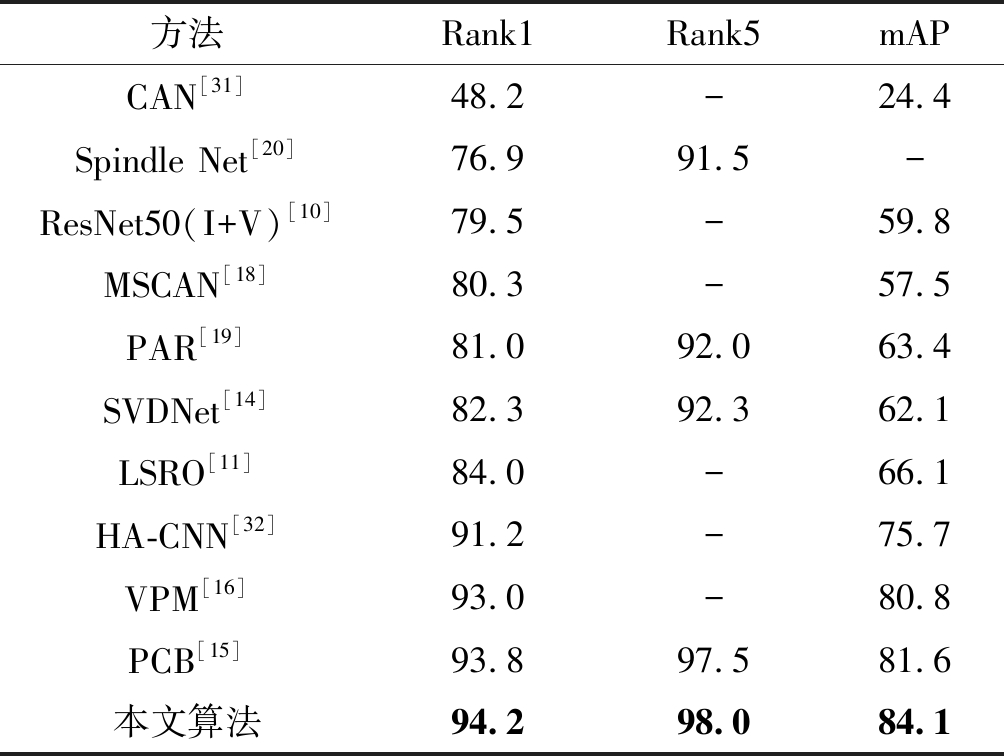

表2给出在Market-1501数据库上,本文所提出的算法和近几年行人再辨识方法的性能比较结果。首先,可以发现同VeRi776数据库上的比较结果类似,本文所提出的算法再次获得最好的性能表现,其Rank1识别率达到94.2%,mAP达到84.1%。其次,在都使用ResNet50作为骨干网络的前提下,与将特征映射划分并在各个分件上各自训练的两种方法VPM[16]和PCB[15]相比,本文算法在mAP上分别高出3.3%和2.5%。此外,与利用姿态估计模型辅助的两种方法PAR[19] 和Spindle Net[20]相比,本文算法在Rank1上分别高出13.2%和17.3%。由此,可以证明本文所提出的基于双重显著性挖掘模块目标再辨识算法具有优越性。

表2 在Market-1501上性能(%)比较

Tab.2 The performance (%) comparison on Market-1501

方法 Rank1Rank5mAPCAN[31]48.2-24.4Spindle Net[20]76.991.5-ResNet50(I+V)[10]79.5-59.8MSCAN[18]80.3-57.5PAR[19]81.092.063.4SVDNet[14]82.392.362.1LSRO[11]84.0-66.1HA-CNN[32]91.2-75.7VPM[16]93.0-80.8PCB[15]93.897.581.6本文算法94.298.084.1

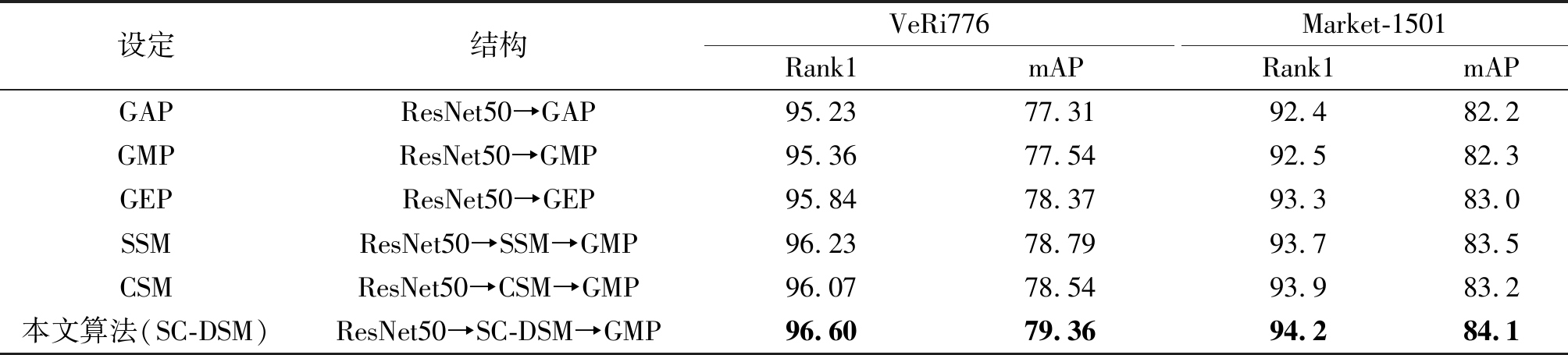

3.3.2 特征汇聚方法的比较与分析

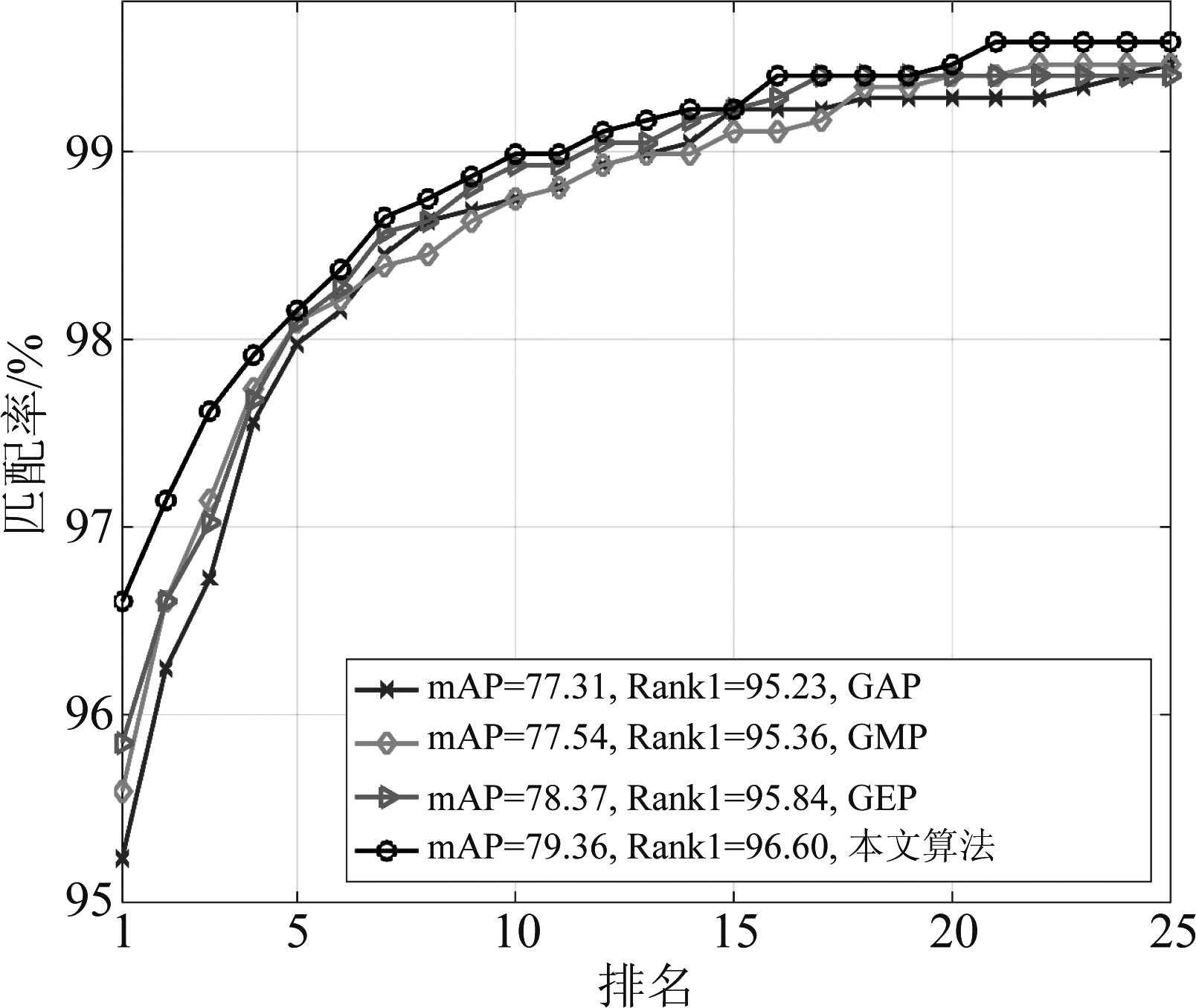

以ResNet50作为骨干网络提取特征映射,本文比较了全局平均池化(Global Average pooling, GAP)、全局最大池化(Global Max Pooling, GMP)和广义均值池化(Generalized-mean Pooling, GEP)三种不带显著性挖掘的特征池化方法,以及3种不同显著性挖掘的方法,即SSM, CSM和SC-DSM。其中,SSM表示仅使用空间显著性挖掘(Spatial Significance Mining, SSM)子模块进行显著性挖掘;CSM表示仅使用空间显著性挖掘(Channel Significance Mining, CSM)子模块进行显著性挖掘;本文算法表示使用空间和通道双重显著性挖掘(Spatial Channel Dual Significance Mining, SC-DSM)模块。

首先,从表3上,可以发现同三种不带显著性挖掘的池化方法(即GAP、GMP和GEP)相比,本文算法(SC-DSM)表现最佳。例如,在VeRi776数据库上,本文算法的mAP识别率比GAP方法和GMP方法分别高出2.05%和1.82%,而且比GEP方法的mAP识别率高出0.99%。此外,图3和图4进一步展示出了在各个排名(Rank)位置上本文算法(SC-DSM)同GAP、GMP和GEP的性能比较,可以看出,本文算法具有较明显的性能优势。

表3 不同的显著性挖掘设定之间的性能(%)比较

Tab.3 The performance (%) comparison of different significance mining settings

设定结构VeRi776Rank1mAPMarket-1501Rank1mAPGAPResNet50➝GAP95.2377.3192.482.2GMPResNet50➝GMP95.3677.5492.582.3GEPResNet50➝GEP95.8478.3793.383.0SSMResNet50➝SSM➝GMP96.2378.7993.783.5CSMResNet50➝CSM➝GMP96.0778.5493.983.2本文算法(SC-DSM)ResNet50➝SC-DSM➝GMP96.6079.3694.284.1

图3 在VeRi776上不同特征聚合方法的CMC曲线比较

Fig.3 The CMC curve comparison of different feature aggregation methods on VeRi776

图4 在Market-1501上不同特征聚合方法的CMC曲线比较

Fig.4 The CMC curve comparison of different feature aggregation methods on Market-1501

其次,从表3可以发现带显著性发掘方法(即SSM,CSM和本文算法(SC-DSM))都优于不带显著性挖掘的池化方法(即GAP、GMP和GEP)。这些结果表明无论是在空间维度上还是通道维度上进行显著性挖掘,都有利于提高目标再辨识的性能。进一步地,可以发现本文算法(SC-DSM)比SSM和CSM取得更好的性能。例如,本文算法SC-DSM在Market-1501数据库上的mAP分别比SSM和DSM高出0.6%和0.9%。这说明通过在空间维度和通道维度上同时进行显著性挖掘,有利于进一步提升目标再辨识的性能。

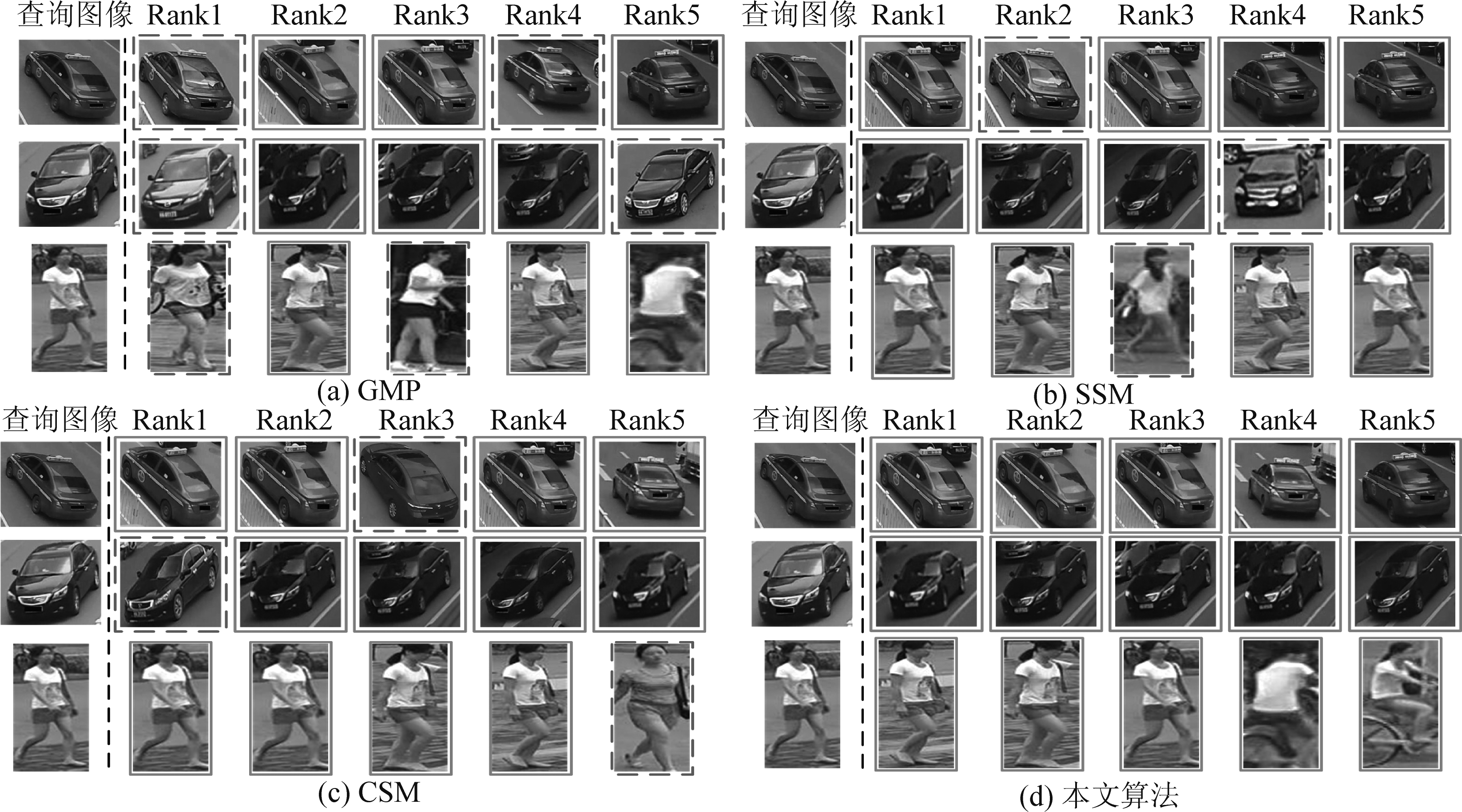

最后,图5展示了GMP、SSM、CSM和本文算法(SC-DSM)不同方法的查询结果。从图5可以看到,所有检索返回的图像都与输入的查询图像高度相似,仅在一些细微的局部区域上表现出差异,例如汽车车顶装饰、汽车车标区域和行人短裤区域等。此时,GMP、SSM和CSM都出现了错误匹配结果,仅本文算法全部正确匹配。这说明本文算法(SC-DSM)能够充分挖掘特征映射中的显著性,有利于强调有鉴别性的局部区域,从而改善目标再辨识性能。

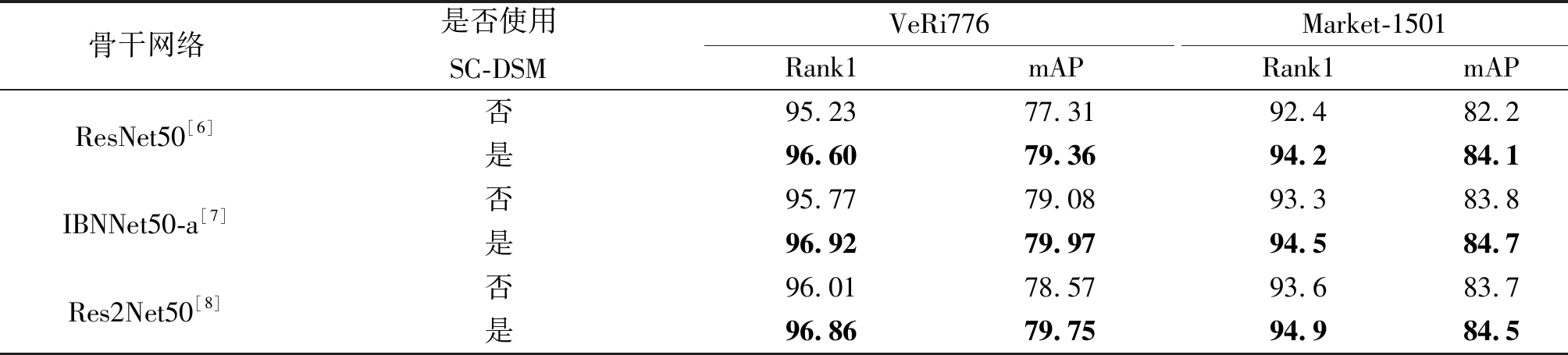

3.3.3 SC-DSM模块通用性的评估

为了验证所提出的双重显著性模块(SC-DSM)对不同的骨干网是否具有通用性,本文采用选取了3种常见的深度学习网络,即ResNet50[6],Res2Net50[7]和IBNNet50-a[8]作为骨干网,采用相同的实验配置(如3.2节所述)进行训练,所得实验结果如表4所示。

从表4可以看出,在VeRi776和Market-1501数据库上,尽管骨干网发生变化,使用SC-DSM模块的目标再辨识模型的Rank1识别率和mAP明显优于未使用SC-DSM的模型。例如,在Market-1501数据库上,同样采用IBNNet50-a作为骨干网,使用SC-DSM模块时比未使用SC-DSM模块时,Rank1识别率和mAP分别提高了1.2%和0.9%。类似地,在VeRi776上,当采用为Res2Net50作为骨干网时,使用SC-DSM模块比未使用SC-DSM模块的方法在Rank1和mAP上分别高出了0.85%和1.18%。因此,这些实验表明本文所提出的SC-DSM模块对不同骨干网具有一定的通用性。

图5 在VeRi776和Market-1501上不同方法的查询结果,绿色实线框和红色虚线框分别表示正确和错误匹配结果

Fig.5 The retrieval results of using different methods on VeRi776 and Market-1501, where the solid green boxes and the red dashed boxes indicate right and wrong matching results, respectively

表4 双重显著性挖掘模块对不同骨干网络通用性的评估(%)

Tab.4 The evaluation (%) of the generality of spatial channel dual significance mining (SC-DSM) module to different backbone networks

骨干网络是否使用SC-DSMVeRi776Rank1mAPMarket-1501Rank1mAPResNet50[6]否95.2377.3192.482.2是96.6079.3694.284.1IBNNet50-a[7]否95.7779.0893.383.8是96.9279.9794.584.7Res2Net50[8]否96.0178.5793.683.7是96.8679.7594.984.5

4 结论

本文提出了一种基于空间和通道双重显著性挖掘的目标再辨识算法,其主要创新在于设计出一个新颖的空间和通道双重显著性挖掘(Spatial Channel Dual Significance Mining, SC-DSM)模块,对骨干网提取的特征映射同时进行空间和通道的显著性挖掘,增强图像特征的鉴别力,提升目标再辨识的性能。实验结果表明,在目前最流行的车辆再辨识数据库VeRi776和行人再辨识数据库Market1501上的,所提出的方法能够优于现有的目标再辨识方法。此外,本文还比较与分析不同特征汇聚方法对目标再辨识性能提升的影响,并且验证了SC-DSM对不同骨干网络具有一定的通用性。

[1] Zhu Jianqing, Huang Jingchang, Zeng Huanqiang, et al. Object re-identification via joint quadruple decorrelation directional deep networks in smart transportation[J]. IEEE Internet of Things Journal, 2020, 7(4): 2944-2954.

[2] Bai Song, Tang Peng, Torr P H S, et al. Re-ranking via metric fusion for object retrieval and person re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 740-749.

[3] Zhu Jianqing, Zeng Huanqiang, Liao Shengcai, et al. Deep hybrid similarity learning for person re-identification[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2017, 28(11): 3183-3193.

[4] Zhu Jianqing, Zeng Huanqiang, Huang Jingchang, et al. Body symmetry and part locality guided direct nonparametric deep feature enhancement for person re-identification[J]. IEEE Internet of Things Journal, 2019: 2053-2065.

[5] 翟懿奎, 陈璐菲. 面向行人再识别的特征融合与鉴别零空间方法[J]. 信号处理, 2018, 34(4): 476-485.

Zhai Yikui, Chen Lufei. Feature fusion and discriminative null space for person re-identification[J]. Journal of Signal Processing, 2018, 34(4): 476-485.(in Chinese)

[6] He Kaiming, Zhang Xianyu, Ren Shaoqing, et al. Deep residual learning for image recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770-778.

[7] Gao Shanghua, Cheng Mingming, Zhao Kai, et al. Res2net: a new multi-scale backbone architecture[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence (Early Access), 2019.

[8] Pan Xingang, Luo Ping, Shi Jianping, et al. Two at once: enhancing learning and generalization capacities via IBN-Net[C]∥Proceeding of the European Conference on Computer Vision, 2018: 484-500.

[9] Huang Gao, Liu Zhuang, Maaten L, et al. Densely connected convolutional networks[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 2261-2269.

[10]Zheng Zhedong, Zheng Liang, Yang Yi. A discriminatively learned CNN embedding for person re-identification[J]. Proceedings of the ACM Transactions on Multimedia Computing, Communications, and Applications, 2018, 14(1): 1-20.

[11]Zheng Zhedong, Zheng Liang, Yang Yi. Unlabeled samples generated by GAN improve the person re-identification baseline in vitro[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 3754-3762.

[12]Khorramshahi P, Kumar A, Peri N, et al. A dual-path model with adaptive attention for vehicle re-identification[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2019: 6132- 6141.

[13]Zhong Zhun, Zheng Liang, Zheng Zhedong, et al. Camera style adaptation for person re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 5157-5166.

[14]Sun Yifan, Zheng Liang, Deng Weijiang, et al. SVDNET for pedestrian retrieval[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 3800-3808.

[15]Sun Yifan, Zheng Liang, Yang Yi, et al. Beyond part models: person retrieval with refined part pooling (and a strong convolutional baseline)[C]∥Proceedings of the European Conference on Computer Vision, 2018: 501-518.

[16]Sun Yifan, Xu Qin, Li Yali, et al. Perceive where to focus: learning visibility aware part-level features for partial person re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 393- 402.

[17]Zhu Jianqing, Zeng Huanqiang, Lei Zhen, et al. A shortly and densely connected convolutional neural network for vehicle re-identification[C]∥Proceedings of the International Conference on Pattern Recognition, 2018: 3285-3290.

[18]Li Dangwei, Chen Xiaotang, Zhang Zhang, et al. Learning deep context-aware features over body and latent parts for person re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 7398-7407.

[19]Zhao Liming, Li Xi, Zhuang Yueting, et al. Deeply-learned part-aligned representations for person re-identification[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 3219-3228.

[20]Zhao Haiyu, Tian Maoqing, Sun Shuyang, et al. Spindle net: person re-identification with human body region guided feature decomposition and fusion[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 1077-1085.

[21]Zheng Liang, Huang Yujia, Lu Huchuan, et al. Pose-invariant embedding for deep person re-identification[J]. IEEE Transactions on Image Processing, 2019, 28(9): 4500- 4509.

[22]Ren S, He K, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[23]Redmon J, Divvala S K, Girshick R, et al. You only look once: unified, real-time object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 779-788.

[24]Liu Wei, Anguelov D, Erhan D, et al. SSD: single shot multi-box detector[C]∥Proceedings of the European Conference on Computer Vision, 2016: 21-37.

[25]He Bing, Li Jia, Zhao Yifan, et al. Part-regularized near-duplicate vehicle re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 3997- 4005.

[26]He Yanguang, Dong Chenhe, Wei Ying, et al. Combination of appearance and license plate features for vehicle re-identification[C]∥Proceedings of the International Conference on Image Processing, 2019: 3108-3112.

[27]Liu Xiaobin, Zhang Shiliang, Huang Qingming, et al. RAM: a region-aware deep model for vehicle re-identification[C]∥Proceedings of International Conference on Multimedia and Expo, 2018: 1- 6.

[28]Shen Yantao, Xiao Tong, Li Hongsheng, et al. Learning deep neural networks for vehicle re-id with visual-patio-temporal path proposals[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 1918-1927.

[29]Zhou Yi, Shao Ling. Viewpoint-aware attentive multi-view inference for vehicle re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 6489- 6498.

[30]Zhu Jianqing, Zeng Huanqiang, Huang Jingchang, et al. Vehicle re-identification using quadruple directional deep learning features[J]. IEEE Transactions on Intelligent Transportation Systems, 2020, 21(1): 410- 420.

[31]Liu Hao, Feng Jiashi, Qi Meibin, et al. End-to-end comparative attention networks for person re-identification[J]. IEEE Transactions on Image Processing, 2017, 26(7): 3492-3506.

[32]Li Wei, Zhu Xiatian, Gong Shaogang. Harmonious attention network for person re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 2285-2294.

[33]Xu B, Wang N, Chen T, et al. Empirical evaluation of rectified activations in convolutional network. arXiv preprint arXiv: 1505.00853, 2015.

[34]Ioffe S, Szegedy C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]∥Proceedings of the International Conference on Machine Learning, 2015: 448- 456.

[35]Hermans A, Beyer L, Leibe B. In Defense of the Triplet Loss for Person Re-identification. arXiv preprint arXiv: 1703.07737, 2017.

[36]Luo Hao, Jiang Wei, Gu Youzhi, et al. A strong baseline and batch normalization neck for deep person re-identification[J]. IEEE Transactions on Multimedia (Early Access), 2019.

[37]Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[C]∥Proceedings of the Annual Conference on Neural Information Processing Systems, 2012: 1097-1105.

[38]Liu Xinchen, Liu Wu, Mei Tao, et al. A deep learning-based approach to progressive vehicle re-identification for urban surveillance[C]∥Proceedings of the European Conference on Computer Vision, 2016: 869- 884.

[39]Zheng Liang, Shen Liyue, Tian Lu, et al. Scalable person re-identification: a benchmark[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 1116-1124.

[40]Paszke A, Gross S, Massa F, et al. Pytorch: an imperative style, high-performance deep learning library[C]∥Proceedings of the Neural Information Processing Systems, 2019: 8024- 8035.