1 引言

随着搜索引擎和社交网络中多媒体数据的快速增长,从一个庞大的图像数据库中快速找到一个特定的图像是至关重要的。基于内容的图像检索(CBIR)是一项极具挑战的计算机任务,并且得到了长期的研究关注[1]。给定一个包含特定实例(例如特定目标、场景、建筑等)的查询图像,图像检索旨在从数据库图像中找到包含相同实例的图像[2]。传统的基于内容的图像检索系统主要使用颜色、形状、纹理等底层视觉特征。这些特征的最大问题是无法处理语义鸿沟[3] (即机器从低级视觉特征获得的相似性与人类从高级语义特征获得的相似性之间的差距)。即使在GIST、SIFT等人为特征上有所改进,仍不能很好地找到相似的语义图像。因此,尽管已经提出了一系列关于图像检索的技术,但是由于语义上的差距,它仍然是一个开放且具有挑战性的问题。随着深度学习[4]在计算机视觉领域取得的重大突破,基于深度卷积神经网络(convolutional neural network,CNN)的图像描述已经广泛应用于图像分类[5]、图像分割[6-7]、目标检测[8-9]和图像检索[10-11]等领域[12],且都取得了良好的效果。因此,近年来图像检索的研究主要是利用深度卷积神经网络进行图像表示。

近年来,哈希方法因其速度快和存储优势而被广泛应用于大规模图像检索。哈希是学习一种保留图像相似性的近位表示方法,使相似的图像可以用相似的二进制哈希码表示。在图像检索任务[13-14]中,现有的哈希方法大致可以分为两类:独立于数据的方法和依赖于数据的方法。局部敏感哈希(LSH)[15]是一种比较有代表性的独立于数据的方法,它利用随机线性投影将附近的数据映射成相似的二进制代码。由于数据独立哈希方法的局限性,近年来的哈希方法尝试利用各种机器学习技术,在给定数据集的基础上学习更有效的哈希函数。数据依赖方法的代表性工作包括迭代量化二进制自动编码哈希(BAE)[16],随机生成哈希(SGH)[17],非对称离散图哈希(ADGH)[18]等。哈希方法更注重计算效率,它将数据映射到一个汉明空间,在这个空间中,图像检索将是快速的。由于图像表示被编码为二进制代码,容易造成信息丢失,检索的准确性通常会略有下降。本文提出的方法是一种实值表示学习方法。

对于实值表示学习,传统的图像检索是在查询图像和数据库之间进行“点到点”(point-to-point,PTP)检索[19]。首先从查询图像和数据库图像中提取特征,分别生成图像的特征描述。然后利用距离度量测量特征之间的相似性,实现传统的图像检索。然而,单个图像包含较少的类别信息,也就是说,只有一个图像无法表示图像类别的特征。例如,办公室类别可能包含计算机、打印机、扫描仪、书桌、文件夹等。但是并非所有办公室图像都包含上述所有对象。因此,传统的PTP检索无法获得令人满意的性能。

为了解决这一问题,本文在传统PTP检索的基础上提出了一种新的图像检索方法——基于“点到面”(point-to-flat,PTF)策略的图像检索。该方法挖掘了查询图像的类别信息,实现了从单个图像到整个图像类别的语义扩展。除此之外,提出的PTF方法训练成本低,因此在实践中更有效。

2 基于“点到面”策略的图像检索

2.1 特征学习

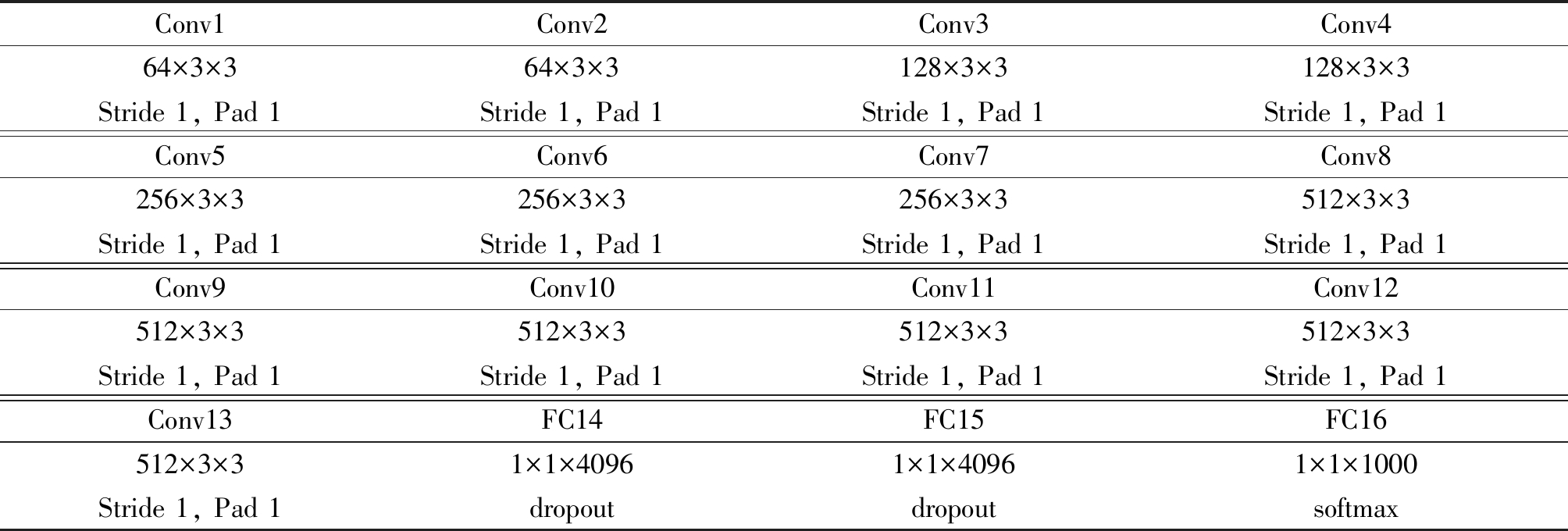

本文采用VGGNet-D网络结构作为算法的基本组成部分。表1显示了该网络的详细配置。

表1 VGGNet-D配置

Tab.1 VGGNet-D configurations

Conv1Conv2Conv3Conv464×3×364×3×3128×3×3128×3×3Stride 1, Pad 1Stride 1, Pad 1Stride 1, Pad 1Stride 1, Pad 1Conv5Conv6Conv7Conv8256×3×3256×3×3256×3×3512×3×3Stride 1, Pad 1Stride 1, Pad 1Stride 1, Pad 1Stride 1, Pad 1Conv9Conv10Conv11Conv12512×3×3512×3×3512×3×3512×3×3Stride 1, Pad 1Stride 1, Pad 1Stride 1, Pad 1Stride 1, Pad 1Conv13FC14FC15FC16512×3×31×1×40961×1×40961×1×1000Stride 1, Pad 1dropoutdropoutsoftmax

VGGNet通过反复叠加3×3个小卷积核和2×2个最大池化层,成功构建了一个16~19个深度层的卷积神经网络。具体来说,本文选择VGGNet-16 (VGGNet-D)模型提取图像特征。这个VGGNet-D模型由13个卷积层和3个全连通层组成。FC14或FC15的输出通常作为CNN的特征描述。本文的主要目的是使用深度神经网络进行特征学习,但是如何设计不同的神经网络并不是本文的重点。其他深度神经网络也可用于执行本文的PTF模型的特征学习,这里,本文只是用VGGNet-D来说明模型的有效性。

2.2 PTF算法实现

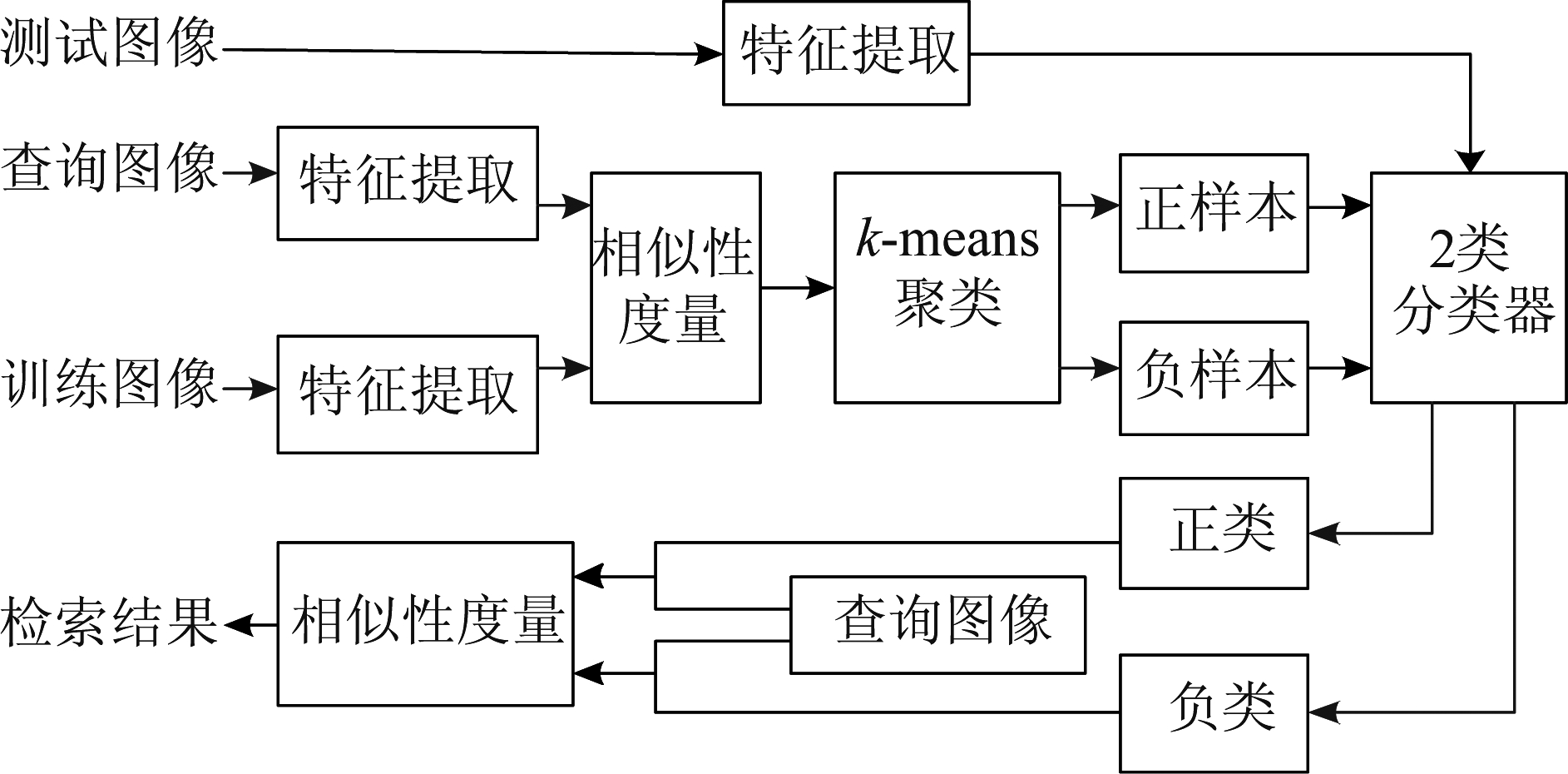

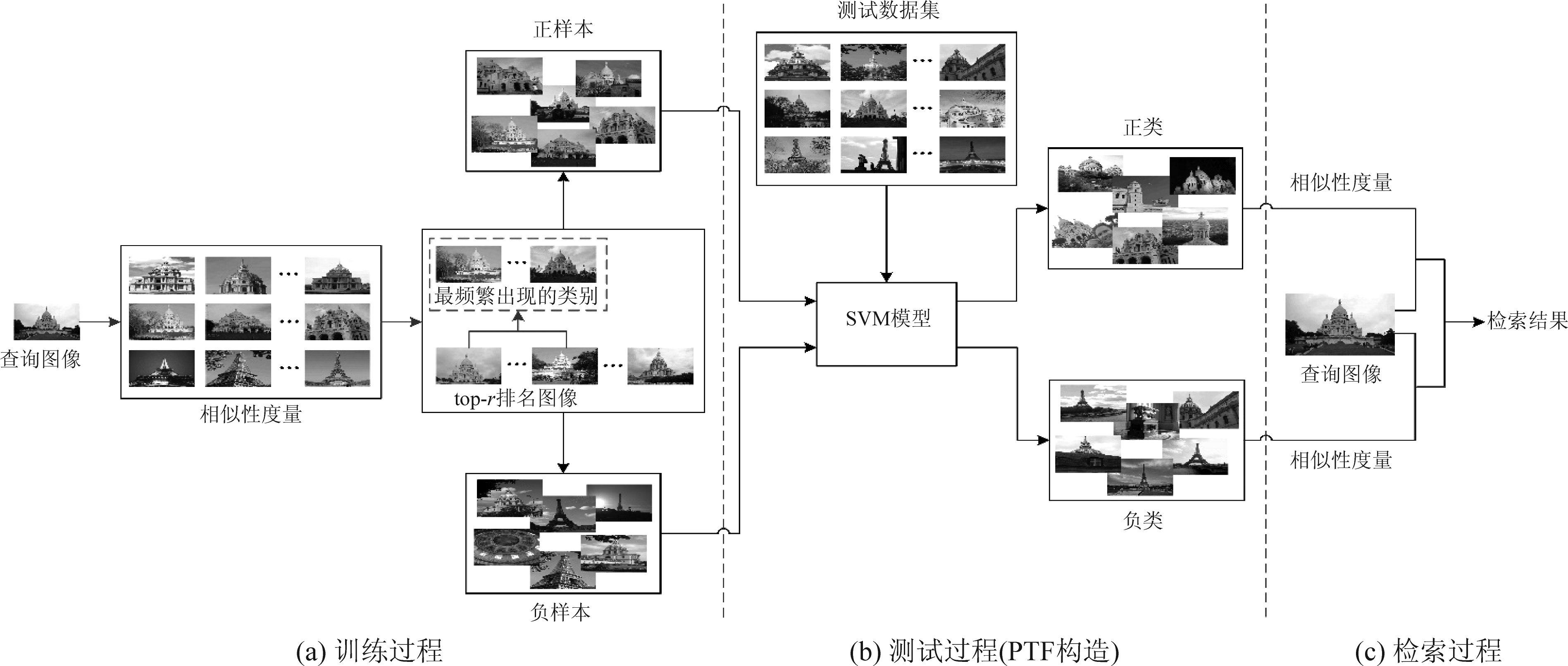

本文将提出的PTF策略分为两类:无监督PTF(N-PTF)和监督PTF。N-PTF没有监督信息来训练分类器。监督PTF仅使用类别标签进行简单分类,而在模型训练过程中没有使用任何监督信息。因此,称该方法为弱监督PTF(W-PTF)。提出的N-PTF的算法流程图如图1所示。

图1 N-PTF算法流程图

Fig.1 Flowchart of N-PTF algorithm

本文将两个图像之间的相似性度量定义为两个相应特征向量的距离度量。在图1中,特征提取是通过VGGNet-D模型执行的,而相似性度量是通过相关距离进行的。 距离越小意味着两个图像的相似度越高。该算法的具体步骤概述如下:

(1)首先,该算法利用VGGNet-D模型中的fc15层提取查询图像和训练图像的特征,因此每幅图像的特征都是一个4096维的向量。计算每个训练图像与查询图像之间的特征距离并进行排序。

(2)然后,在距离度量的前N个序列图像上进行k-means均值聚类,以便在同一聚类中收集相似的样本。计算查询图像与k个聚类中心之间的距离,并选取离查询图像最近的一簇聚类中心图像作为正样本(共有N1幅图像),从距离度量N+1序列之后的图像中随机选择N2个图像作为负样本,然后利用选取的正负样本来训练2类分类器。支持向量机(SVM)模型将区间最大化问题转换为凸二次规划问题。它可以解决一系列模式识别问题,例如小样本,非线性和高数据维度。因此,本文将SVM模型作为2类分类器。其他分类器模型也可以代替SVM模型,但对不同的分类器选择进行研究并不是本文的重点。

(3)最后,将测试样本通过训练好的2类分类器,可以将测试样本分为正类和负类。这样,分类后的正样本构成一个“面”,包含对应查询图像(“点”)所隐含的特定“类别信息”。也就是说,类别信息由与查询图像具有相同类别标签的多个图像表示。随后对分类后的正类图像和查询图像之间的特征相似性进行度量并排序,对分类后的负类图像也执行相同的操作。最终,将两个排序后的图像序列进行级联以获得图像检索结果。

本文提出的W-PTF方法是在N-PTF上进行改进的,它们的主要区别在于有无标签信息的使用。在W-PTF中,利用VGGNet-D模型提取特征后,计算每个训练图像与查询图像之间的特征距离,并对训练样本进行排序。由于训练集的类别标签是已知的,因此本文对排名前r(top-r)的图像进行计数以找到出现最频繁的类别标签。具有这种标签的训练图像被视为正样本,而其他图像则被视为负样本。接下来的算法流程与N-PTF方法一样。为了更直观地表达提出的W-PTF方法,图2展示了该方法的可视化过程。

从图1和图2可以清楚地看出,所提出的PTF方法将单个图像的查询信息丰富到查询图像所属的图像类别中。也就是说,将单一的基于图像的检索转换为基于语义分类的检索。基于语义分类的检索在图像检索任务中具有更大的意义,在接下来的实验中将验证该方法的有效性。

3 实验结果与分析

3.1 实验设置

本文在两个广泛使用的基准数据集上进行了实验:Caltech256[20]和Paris[21]。Caltech256数据集包含与256个对象类别相关联的30607个图像,每个类别包含至少80张图像,最多827张图像。原始的Caltech-101[22]是通过选择一组对象类别,从谷歌图像中下载示例,然后手动筛选不符合类别的所有图像来收集的。Caltech256分类数据集是从Caltech-101数据集开发的。

图2 W-PTF方法的可视化

Fig.2 Shows the W-PTF in visualization

Paris数据集包含来自Flickr的6412张高分辨率图像,这些图像是通过查询“巴黎埃菲尔铁塔”或“巴黎金字塔”等巴黎著名地标的相关文本标签获得的。原始的注释(标记)是手动执行的,由11个地面真实标签组成。给定一个地标查询图像,目标是检索描述相同地标的所有数据库图像。

对于Caltech256数据集,大多数类别包含的图像在80到150之间。为了增加每类图像的数量,我们对每个类别随机采样80张图像,然后翻转并裁剪这些图像以使每类图像数量达到320。对于Caltech256数据集的每个类别,随机选择10张图像作为查询图像,50张图像作为测试图像,其余260张图像作为训练图像。也就是说,查询集、测试集和训练集中分别有2560张图像、12800张图像和66560张图像。对于Paris数据集,类似于Caltech256数据集,我们从每个类别中随机抽取260张图像作为实验数据集,其中查询、测试和训练图像的数量分别选择为10、50和200。即,查询集、测试集和训练集中分别有110张图像550张图像和2200张图像。

所有实验均采用MatConvNet[23]实现。工具箱中有很多MatConvnet版本,本实验选用MatConvnet-1.0-beta25进行实验。所有实验重复五次,每次使用不同的随机选择的查询、训练和测试图像。报告的结果是五次实验的平均结果。

3.2 评估标准

图像检索的目的是找出与查询图像相似的图像,因此评价指标必须考虑检索到的相似图像的数量和排序水平。为了定量地测量所提出的方法和其他比较方法,本文采用两种广泛使用的评价指标来评价图像检索质量:不同比特数的平均准确率均值(mean average precision,mAP)和不同检索返回样本数的查准率-查全率(Precision-Recall)曲线,简称P-R曲线。

查准率反映了检索系统返回相关信息的正确能力。定义为:

(1)

其中tp为检索到的正样本总数,k为检索到的所有样本总数。

查全率反映了检索系统返回相关信息的完整性能力。定义为:

(2)

其中n为所有正样本的总数。

查准率仅考虑检索到的图像数量,而没有考虑其排名顺序。在图像检索系统中,检索到的图像的排序也是必要的。为了兼顾图像检索的精度和检索的先后顺序,我们还采用mAP来评估本文的实验。mAP计算如下:

(3)

其中q为查询图像的数量,ni为第i个查询图像返回的正类图像的总数。Rj表示所有返回图像的排序顺序中第j个正类图像的索引。

3.3 相似性度量分析

图像检索的两个关键问题是特征描述和相似性度量。对于特征描述,本文均采用VGGNet-D进行特征提取。对于相似度量问题,常见的距离度量包括欧氏距离、相关距离、切比雪夫距离、马氏距离、汉明距离等。为了比较各种相似性度量方法的准确性,本文分别采用相关距离,欧氏距离和切比雪夫距离在传统PTP方法上进行了实验。该实验分别从Caltech256和Paris数据集中为每个类别随机选择10张和50张图像作为查询和测试样本。表2显示了两个数据集上三种距离度量方法的mAP结果。

表2 两个数据集上三个距离度量的mAP结果

Tab.2 mAP results of three distance metrics on two databases

数据集切比雪夫距离欧氏距离相关距离Caltech25618.49%37.15%38.76%Paris34.73%43.11%44.35%

欧氏距离因其简单性而被广泛使用,但它不能反映高维空间中两个特征之间的相关性。切比雪夫距离是空间中两点之间的绝对距离,与该点的坐标直接相关,与各分量之间的相关性无关。而相关距离考虑了样本之间的相关性。表2中的实验结果也表明,相关距离优于其他两种方法。因此,在接下来的实验中,均选择相关距离进行距离度量。

3.4 N-PTF实验分析

对于N-PTF方法,首先对查询与训练图像之间的距离度量结果进行排序。对于Caltech256数据集,本文选取相似度最高的前260幅图像进行k-means聚类,得到k个特征中心。实验中算法的参数k设置为3。选择一组聚类中心距离查询图像最近的图像作为正样本,并从没有参与聚类的图像中随机选择另外260幅训练图像作为负样本。与Caltech256相似,对于Paris数据集,本文选取k-means聚类后相似度最高的200幅图像作为正样本,并从其余的训练图像中随机选取200幅图像作为负样本。

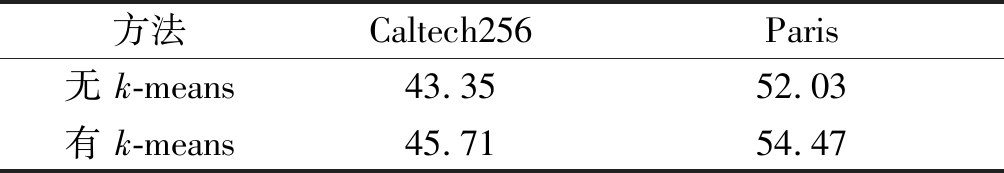

为了验证k-means的有效性,对是否使用k-means的效果进行了实验比较。该实验在不使用k-means的情况下,根据相似度排序,直接从训练图像中选取正样本和负样本。在Caltech256中,分别选取前40张训练图像和随机选取260张训练图像作为正样本和负样本来训练分类器模型。对于Paris数据集,选取的正样本和负样本数量分别为40和200张。表3显示了该实验在两个数据集上的mAP结果。

表3 N-PTF的mAP(%)结果

Tab.3 mAP (%) results for N-PTF

方法Caltech256Paris无 k-means43.3552.03有 k-means45.7154.47

聚类的目的是将相似的样本聚在一起,同时分离不同的样本。直观的想法是同一聚类中的相似度应该更高,而聚类之间的相似度应该更低,这提高了相似样本之间的相似度,使检索性能更好。从表3可以看出,使用k-means方法的N-PTF在Caltech256和Paris数据集上要比未使用k-means的mAP结果高大约2.4%。因此,在接下来的对比实验中,N-PTF方法采用k-means聚类的结果。

3.5 W-PTF实验分析

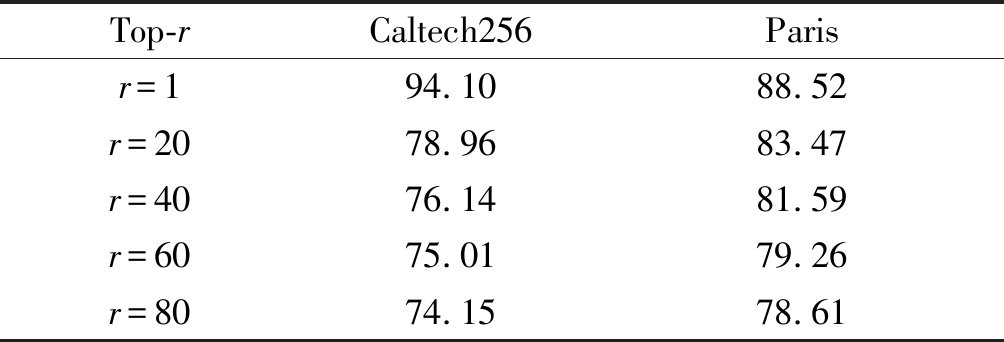

虽然N-PTF方法使用k-means聚类来提高同构聚类的准确性,但所选的正样本仍与一些负样本混合,因此训练的分类器也不是最优的。为了使模型训练更加准确,本文对N-PTF方法进行了优化,提出了W-PTF方法。在W-PTF方法中首先对查询图像和训练图像的相似性度量进行排序。然后选择前r个序列(top-r)图像中出现最频繁的一个图像类别作为正样本,而将其他类别的图像作为负样本。为了对参数r进行敏感度分析,该实验比较了不同top-r的检索结果。表4列出了W-PTF方法在Caltech256和Paris上的mAP结果。

表4 W-PTF的mAP(%)结果

Tab.4 mAP (%) results for W-PTF

Top-rCaltech256Parisr=194.1088.52r=2078.9683.47r=4076.1481.59r=6075.0179.26r=8074.1578.61

从表4可以看出,W-PTF方法的性能大大优于N-PTF方法。此外,如果r的值越小,则mAP结果越好。这表明,如果r越小,与查询图像具有相同类别标签的图像在top-r图像中出现的频率越高,这使分类器训练得更好,检索性能也就越好。特别是,当r=1时,mAP在Caltech256上可达到94.10%,在Paris上可达到88.52%,分别比N-PTF在Caltech256和Paris数据集上高48.4%和34.1%。

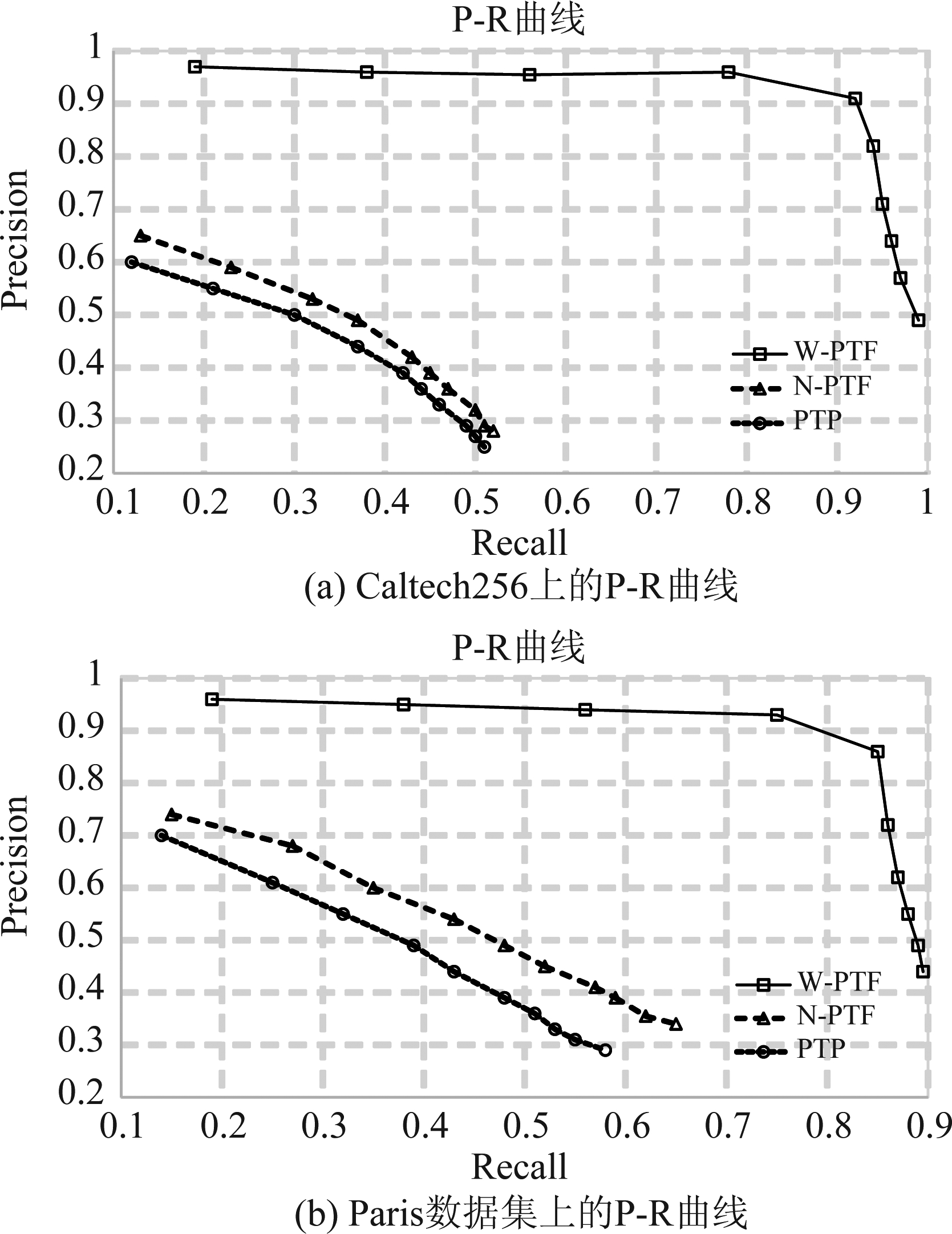

为了直观进行比较,本文将上述三种方法PTP,N-PTF和W-PTF的检索性能通过如图3所示的P-R曲线进行了评估。在实验中,将返回的检索图像数量设置为10到100,每次递增10,即[10,20,30,…,90,100]。这里的PTP和PTF方法都利用相关距离进行相似性度量。对于W-PTF方法,采用r=1的实验设置。

图3 两个数据集上的P-R曲线

Fig.3 Precision-Recall curves on two databases

从图3所示的P-R曲线结果可以很明显地得出结论,所提出的方法在两个数据集上的性能明显优于传统的PTP方法,这与实验在mAP上观察到的结果是一致的。由于单个查询图像中所表达的信息是不完整的,可能只包含部分信息,不能准确反映所检索图像的整体信息。因此,PTP方法的实验结果不尽如人意。在N-PTF和W-PTF实验中,使用SVM分类器将单个查询图像扩展为一组具有相同类别标签的图像,丰富了查询图像的语义信息。这里,分类器模型训练的性能在整个检索过程中起着至关重要的作用。对于N-PTF,为了提高SVM的性能,该算法在距离度量排序后加入k-means聚类,使输入分类器的正样本和负样本更加准确。在W-PTF中,利用数据集的标签信息用来选择正负样本。与N-PTF相比,W-PTF方法实现了更卓越的图像检索性能。这表明借助标签信息选择的正样本和负样本更接近真实的正样本和负样本。它进一步说明了本文提出的框架的优越性。

4 结论

在本文中,我们提出了一种新的“点到面”(PTF)策略进行图像检索,它将单个查询图像扩展到与查询图像具有相同标签的图像类别。该扩展丰富了查询图像的语义信息,提高了图像检索的性能。所提出的方法试图挖掘类别信息,并将基于图像的检索转换为基于类别的检索。在Caltech256和Paris数据集上的实验结果表明,所提出的PTF方法在图像检索任务上的性能优于其他方法。

[1] Zheng Liang, Yang Yi, Tian Qi. SIFT meets CNN: A decade survey of instance retrieval[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2018, 40(5): 1224-1244.

[2] Bhattacharyya S, Bhaumik H, De S, et al. Intelligent Analysis of Multimedia Information[M]. Hershey: IGI Global, 2017, 40(5): 143-180.

[3] Datta R, Joshi D, Jia L I, et al. Image Retrieval: Ideas, Influences, and Trends of the New Age[J]. ACM Computing Surveys, 2008, 40(2): 35-94.

[4] Hinton G E, Osindero S, Teh Y W. A fast learning algorithm for deep belief nets[J]. Neural Computation, 2006, 18(7): 1527-1554.

[5] Christian S, Liu Wei, Jia Yangqing, et al. Going deeper with convolutions[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA: IEEE, 2015: 1-9.

[6] Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA: IEEE, 2014: 580-587.

[7] Szegedy C, Toshev A, Erhan D. Deep Neural Networks for Object Detection[C]∥Advances in Neural Information Processing Systems. NIPS, 2013: 2553-2561.

[8] Li Haoxiang, Lin Zhe, Shen Xiaohui, et al. A convolutional neural network cascade for face detection[C]∥IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2015: 5325-5334.

[9] Sun Y, Wang X, Tang X. Deep Learning Face Representation by Joint Identification-Verification[J]. Advances in Neural Information Processing Systems, 2014, 27: 1966-1988.

[10]Cimpoi M, Maji S, Vedaldi A. Deep convolutional filter banks for texture recognition and segmentation[J]. International Journal of Computer Vision, 2016, 118(1): 65-94.

[11]Ghodrati A, Diba A, Pedersoli M, et al. DeepProposal: Hunting Objects by Cascading Deep Convolutional Layers[J]. International Journal of Computer Vision, 2017, 124(2): 115-131.

[12]Bruna J, Szlam A, Lecun Y. Signal Recovery from Pooling Representations[J]. Statistics, 2013: 307-315.

[13]Li Jinxing, Zhang Bob, Lu Guangming, et al. Dual Asymmetric Deep Hashing Learning[J]. IEEE Access, 2019, 7: 113372-113384.

[14]Munjal M N, Bhatia S. A Novel Technique for Effective Image Gallery Search using Content Based Image Retrieval System[C]∥International Conference on Machine Learning, Big Data, Cloud and Parallel Computing (COMITCon). Faridabad, India: IEEE, 2019: 25-29.

[15]Andoni A, Indyk P. Near-optimal hashing algorithms for approximate nearest neighbor in high dimensions[J]. Communications of the ACM, 2008, 51(1): 117-122.

[16]Carreira-Perpinan M A, Raziperchikolaei R. Hashing with binary autoencoders[C]∥IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA: IEEE, 2015: 557-566.

[17]Dai Bo, Guo Ruiqi, Kumar S, et al. Stochastic Generative Hashing[J]. Proceedings of the 34th International Conference on Machine Learning, 2017, 70: 913-922.

[18]Shi Xiaoshuang, Xing Fuyong, Xu Kaidi, et al. Asymmetric discrete graph hashing[C]∥In Proceedings of the AAAI Conference on Artificial Intellignece. AAAI, 2017: 2541-2547.

[19]Li Zhao, Lu Wei, Xing Weiwei, et al. Image retrieval based on CNN visual features[J]. Journal of Beijing University of Posts and Telecommunications, 2015, 38(B06): 103-106.

[20]Gregory G, Alex H, Pietro P. Caltech-256 object category dataset[R]. Technical Report 7694, California Institute of Technology, 2007.

[21]James P, Ondrej C, Michael I, et al. Lost in Quantization: Improving Particular Object Retrieval in Large Scale Image Databases[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2008: 1- 8.

[22]Li Feifei, Fergus R, Perona P. Learning Generative Visual Models from Few Training Examples: An Incremental Bayesian Approach Tested on 101 Object Categories[C]∥Conference on Computer Vision and Pattern Recognition Workshop. Washington, DC, USA: IEEE, 2004: 178-178.

[23]Vedaldi A, Lenc K. MatConvNet: Convolutional Neural Networks for MATLAB[J]. Proceedings of the 23rd ACM International Conference on Multimedia, 2015: 689- 692.