1 引言

实例分割是物体识别中的子任务,已有的工作通常可以在数据集[1- 4]上进行实验。现有的神经网络方法需要大量的训练数据。若使用ResNet模型[5-6]提取特征的话,所需要的数据量更大。现有的模型设计需要大量标注数据用于训练,但是标注的开销很大[1,3,7],尤其是在实例分割任务需要像素级别掩膜、类别标签和实例标签。

一种降低数据处理开销的方法是使用弱标注数据,该方法在弱监督的目标检测[8-10]和语义分割[7,11-15]任务中检验过。实例分割比上述任务更有挑战性的地方在于需要估计包围框(弱监督的语义分割不需要区分出实例)。实例分割的复杂性,使得现有方法必须将有效的数据标注和网络结构结合在一起。

现有的弱监督物体检测框架[9,12-13,16]遵循同一个流程,都是迭代地训练一个指定任务的网络,预测的中间结果(例如包围框、掩膜)可以作为下一步计算的监督信息。在这种流程中,候选物体[17-18]算法被广泛使用于收集一些可供训练的初始化信息。有趣的是,相同的操作在实例分割中并不能得到理想的结果。原因是网络依赖于高质量标注进行训练,在没有恰当的初始化信息的情况下采用这种策略让网络难以得到优化。本文的实验表明实例分割网络很容易陷入局部解中。

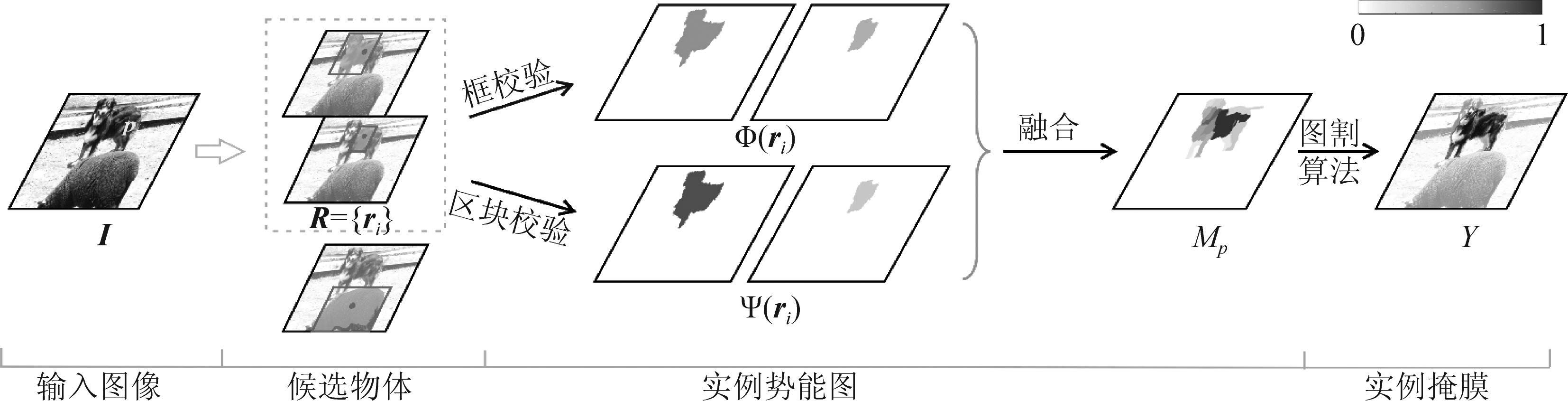

本文提出了一个不需要高质量标注的模型框架,且很好地保留模型预测实例掩膜的能力。本文的模型框架包括框校验和区块校验。一方面,框验证模块给出了标记物体位置的物体包围框,利用相邻包围框投票可以使预测更稳定。另一方面,区块校验提供了像素级别的分割结果,可以在不考虑物体形状的情况下预测像素级别的掩膜,这方面的有效性在其他工作已有验证[12-13,16]。在这一模块中,本文提出同时度量候选掩膜的外侧和内侧,这使得实例分割的衡量标准对边界更敏感。这两个模块互相提供了来自不同方面的信息,降低了单独训练其中一个模块的误差累积[19-20]。具体细节在第3节中展开。

本文提出了一个利用单点标注来推断实例掩膜的框架。基于点标注的方法在PASCAL VOC 2007[2]数据集上训练和验证了弱监督实例分割模型的有效性。同时,本文在VOC 2007[4]数据集上模拟了单点标注的情况,并在半监督情况下做了比较。该框架提升了实例分割的性能。

2 相关工作

为了解决实例分割问题,[21]使用了一种二分路网络来进行实例分割。网络将包围框中的图像和候选物体的前景裁剪出来以进行特征提取,从这两条路径中获得的特征会融合起来用于分类任务。为了提升效率,[22-23]研究了特征图上的特征提取问题。

为了更准确定位,最新的方法[23-25]借助CNN迭代地优化实例分割的掩膜。[23]通过整合包围框生成,候选掩膜生成和分类实现了端到端的训练。同时,文章还引入了一种级联式的结构来提升效率。基于MNC[23],引入可学习的高维度特征距离[26]能够有助于提升掩膜质量。 [24]提出递归地优化每个候选区域的包围框和掩膜,将之前推断出的数据作为输入并筛选出高质量的结果。为了使每个实例获得高质量的分割结果,[25]将预测分解为若干个步骤,每次推断都基于前一步骤的输出。[27-28]使用了CRF这种图模型以便从目标检测和语义分割系统得出的结果中推断出实例掩膜。

弱监督条件下的实例分割是相对较新的领域。最近,Khoreva等人[29]使用包围框标注来进行弱监督情况下的实例分割。与该方法不同,本文的框架属于利用点标注的弱监督学习方法,这种弱监督的设定更具有挑战性且只需更少的标注成本。已有的实例掩膜分割方法在弱监督情况下,因为这些方法难以由点生成它们依赖的精确的实例掩膜来进行深度网络的训练。本文对目标框进行检验并独立分割,再将它们聚合起来以推断实例掩膜。

近期关于弱监督语义分割的工作[14-15,30-32]也使用了由分割和局部分支组成的结构。区别在于,本文处理的任务更为复杂且结构有重要改变。然而这些方法不能直接应用于该任务,因为这些框架采用的K均值和池化操作会严重丢弃实例信息。

3 基于点标注的弱监督实例分割模型

本文应用点标注来生成了必要的实例掩膜以初始化实例分割网络的训练。为此,本文设计了框校验模块用来鲁棒地定位对象区域,区块校验模块通过提供像素级别的分类得分来帮助选择区块。这种结构适用于初始数据不完整的弱监督学习系统。两个组件协作生成实例掩膜,然后使用图形模型来完善实例掩膜,并重复这些步骤直到收敛。

3.1 框校验与区块校验的动机

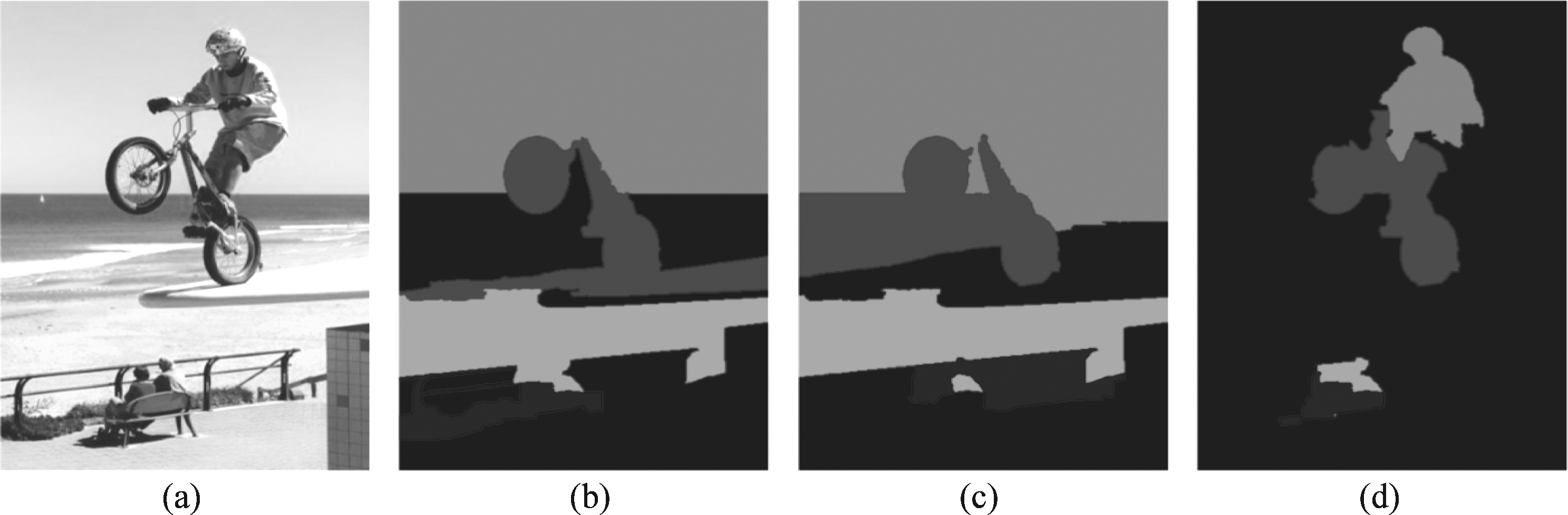

在像素级别标注下,实例掩膜是完整的。但是,当每个实例只有一个点标注时,则无法获得实例掩膜。如前文所述,直观的获取实例掩膜的方法是遵循标准框架[9,12-13,16]迭代训练实例分割网络[21-22,33]。每次迭代中,高置信度的区块被选为下一次迭代中新的标注数据。最终实例掩膜被用来训练实例分割网络。然而,这种方法不是最佳的,当单一点作为输入时,网络容易产生错误掩膜,导致此方法无法取得理想的实例分割结果。如图1所示,在单一点作为输入的条件下,现有实例分割算法依赖于高质量标注,在只有点标注的条件下无法正常工作。给定质量较差的初始数据,训练CFM[22]后给出的结果是错误的。

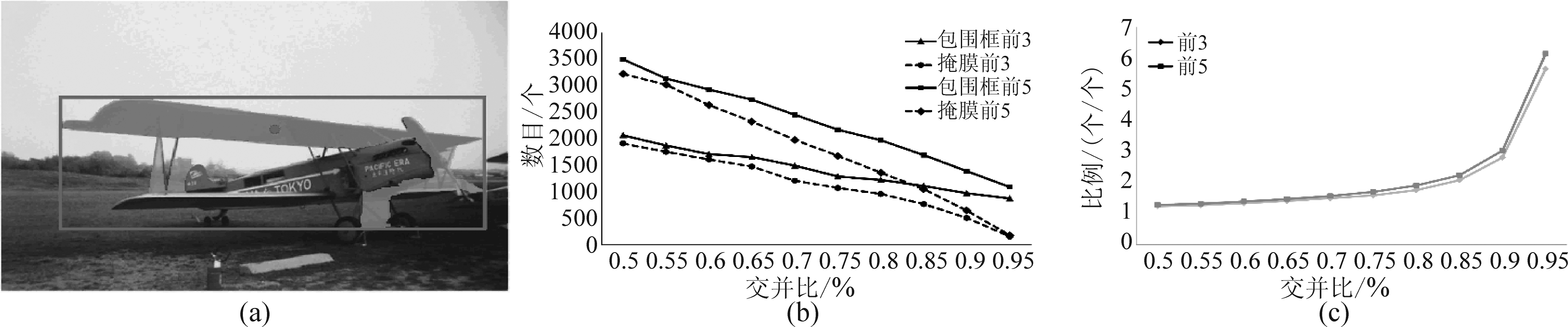

本文收集了由MCG[17]生成的PASCAL VOC 2007[2]中训练子集的候选物体,每个候选物体只有一个标注点。对于每一个点标注,本文收集了 MCG生成的物体分数前3名和前5名的候选物体。本文使用与标注信息的IoU来衡量候选区块和它们的紧密包围框的生成质量。如图2所示,图2(b)和(c)分别绘制了在不同IoU范围下被选中的候选区块的数量与比例。如图 4 所示,区块掩膜比包围框的召回率低得多,这说明包围框的召回率始终大于候选区块,尤其是在高 IoU 时。因此,一个候选区块紧密覆盖住物体实例的几率比包围框更小。换句话说,相比于应用包围框,使用候选区块来训练网络的可靠性非常低。如图2(a)中的示例,紧密包围框完美地覆盖了飞机,但候选区块则缺失了很大一部分。

因此,本文采用更可靠的包围框方案,而不是应用上述通用方法反复训练实例分割网络。本文引入了框校验与区块校验模块,以提供实例掩膜生成像素级分类分数。框校验模块提取实例概念,而区块校验模块负责生成像素级别掩膜。本文会评估这个框架,并将其与第4.2节中的通用方法进行比较。

图1 单点标注下迭代训练实例分割模型预测掩膜结果。(a)是原始图片,(b)是初始化图片, (c)是CFM[22]结果,(d)是本工作的结果。可以看出本工作的结果能产生较为理想的分割结果

Fig.1 Inferred masks by iteratively training the single instance segmentation model under the point-supervision setting. (a) is the original image. (b) is the initial image. (c) and (d) are inferring results by training CFM[22] iteratively and of our method

图2 (a)包含红色单点标注的最高得分候选分割区域(青色)和它的包围框(红色),(b)最高得分的前3和前5的不同IoU 范围下掩膜和包围框的数量。本文计算选定的候选区域和标注的IoU。每一个IoU区间长度为0.05,区间步长为0.05, 这样将所有掩膜和包围框按IoU划分进不同范围(c)以IoU为横坐标,纵坐标为高于IoU阈值的包围框和掩膜数量的比值

Fig.2 (a) Segment proposal (highlighted in cyan) and its tight bounding box in red that contains the red-point annotation with the highest objectness score. (b) Numbers of masks and boxes with top-3 and top-5 objectness scores in different IoU ranges. We calculate the mask/box IoU between selected proposals and ground-truth. We take 0.05 as the length of IoU range and 0.05 as the step size to slide the window to count the number of masks and boxes with IoUs falling into different ranges. (c) Ratio (# boxes / # masks) with respect to IoU. The numbers of boxes/masks are counted with IoU higher than a threshold

图3 本工作所用框架中是迭代的。框校验模块和区块校验模块被用来为每一个点单独产生一个实例势能图。 实例掩膜通过一个图模型产生。本文为了便于说明将候选的置信度归一化

Fig.3 Illustration of our framework for one iteration. Box and segment verification modules are used to produce the instance-potential map for each point independently. Instance masks are generated by a graphical model. Here we normalize the confidence scores of proposals for illustration

3.2 框校验

框校验模块采用物体候选[17-18]的紧密边界框作为输入,并根据外观和定位信息输出置信度分数。分数高表示候选框有很大概率紧密地覆盖物体。

本文基于物体候选算法和Fast RCNN[34] 构建此模块框校验模块。如图3 所示,给定训练图像I和点注释p,本文收集只包含点p的候选对象集R={ri},原因是其他候选物体更有可能位于背景上或与多个物体重叠。每个ri 都是一个二进制掩膜,其大小与输入图像相同,值为1的像素位于前景,而其他像素位于背景。本文将包含ri 前景区域的紧密边界框表示为B(ri),包含了其左上角和右下角的坐标。Fast RCNN输入和输出可以表述为以下函数:

{vi,bi}=f(Wb;B(ri),I)

(1)

其中vi∈RC为分类分数向量,C为种类数,bi为预测的回归包围框。包围框的角点坐标用bi记录,回归目标是上一次迭代中相对应的实例掩膜。Wb为Fast RCNN模型参数,该模型参数为R集合中每一个候选物体回归出一个分数向量与包围框。

给定点p与对应类别标签c,根据公式(1),框校验模块将候选区块ri的置信度分数Φ(ri)表示为:

(2)

其中![]() 为归一化因子。IoU(·,·)操作计算两个包围框之间的

为归一化因子。IoU(·,·)操作计算两个包围框之间的![]() 是B(rj)的类别c的回归边界框。

是B(rj)的类别c的回归边界框。![]() 与

与![]() 是类别c对应B(ri)与B(rj)的分类分数。

是类别c对应B(ri)与B(rj)的分类分数。

包围框投票 本文的评分方程(2)考虑对象外观以及框B(ri)的位置。按照惯例,本文使用公式(2)中的分类分数![]() 来分配B(ri)的外观似然度。由于没有真正的包围框标注,本文应用其他候选回归框对B(ri)进行投票。这个投票过程即为公式(2)中的第二项。因子

来分配B(ri)的外观似然度。由于没有真正的包围框标注,本文应用其他候选回归框对B(ri)进行投票。这个投票过程即为公式(2)中的第二项。因子![]() 可以看做回归框

可以看做回归框![]() 的置信度。

的置信度。![]() 计算

计算![]() 与B(ri)的IoU。与置信回归框高度重叠的框B(ri)将会获得高分。此投票过程利用了其他候选框中的信息以减少错误。

与B(ri)的IoU。与置信回归框高度重叠的框B(ri)将会获得高分。此投票过程利用了其他候选框中的信息以减少错误。

3.3 区块校验

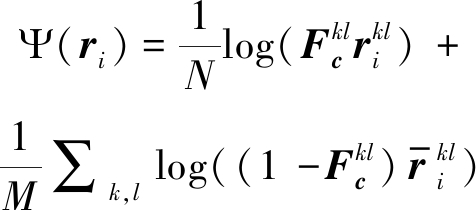

实例分割需要像素级别掩膜,它的计算是通过全卷积网络(FCN)[35]的区块验证完成的。具体内容包括利用候选区块内外的像素级分类分数,为每个候选区块生成权重。

使用训练图像 I,FCN 输出像素级分类分数:

F=g(Ws;I)

(3)

其中![]() 是与输入图像I有相同分辨率H×W的分类分数图。Ws为FCN的模型参数。使用 FCN输出的分数图,区块校验模块将分数Ψ(ri)分配给候选物体ri:

是与输入图像I有相同分辨率H×W的分类分数图。Ws为FCN的模型参数。使用 FCN输出的分数图,区块校验模块将分数Ψ(ri)分配给候选物体ri:

(4)

其中![]() 是类c的分数图。

是类c的分数图。![]() 为B(ri)中ri的补,即B(ri)中0,1互换。(k,l)用于元素对矩阵的访问。N为ri中1的个数,M为

为B(ri)中ri的补,即B(ri)中0,1互换。(k,l)用于元素对矩阵的访问。N为ri中1的个数,M为![]() 中1的个数。本文通过在所有候选物体中减去Ψ(ri)中的最小值对Ψ(ri)进行调整。

中1的个数。本文通过在所有候选物体中减去Ψ(ri)中的最小值对Ψ(ri)进行调整。

在公式(4)中,第一项倾向于掩膜中概率高的类别c,而第二项倾向于紧密包围框内的互补区域更可能是背景或其他类别的。第二项的结果是通过FCN计算得到。因此,确定适当的掩膜十分重要。没有它,区块校验模块倾向于对只覆盖高分区域的候选区域给予高分,而这通常只是实例的小部分。第二项惩罚这些候选区域,因为这些候选的互补区域![]() 也具有很高的属于类别c的概率。使用这两项能为紧密覆盖高质量区域的ri提供高置信度,有利于合理地识别候选掩膜。

也具有很高的属于类别c的概率。使用这两项能为紧密覆盖高质量区域的ri提供高置信度,有利于合理地识别候选掩膜。

3.4 实例势能图生成

在构造了这两个模块之后,本文生成了使用包含像素级别势能的像素势能图,它是由框校验与区块校验计算得出的。对于图像I中的每个点p,本文独立地生成实例势能图Mp。将框校验与区块校验的置信分数聚合,并从候选区块转移到每个像素。这个过程可表示为:

Mp=∑ri∈R(Φ(ri)+Ψ(ri))ri

(5)

其中Φ(ri)与Ψ(ri)为框校验与区块校验的分数。在这个过程中,本文只选取覆盖p点的候选区块。此外,实例势能图进行了归一化处理。示例如图3所示。

在式(5)中,本文将候选物体的加权求和结果作为势能图。由于权重在验证过程中确定,置信候选区块对实例出现的区域贡献更大的概率。

3.5 实例掩膜生成

最终,本文建立了一个图模型来推断实例掩膜。具体而言,本文基于由[17-18]中的方法产生的非重叠超像素{si}独立地推导出每个点标注的实例掩膜。本文把每个超像素看作一个顶点,把两个超像素的相似性看作一条边。本文推导出超像素s的二进制标签y(即0表示背景,1表示前景),它们构成了最终实例掩膜Y。图3展示了推断实例掩码的过程。目标函数定义为:

E(Y)=∑iEu(yi)+∑i,jEt(yi,yj)

(6)

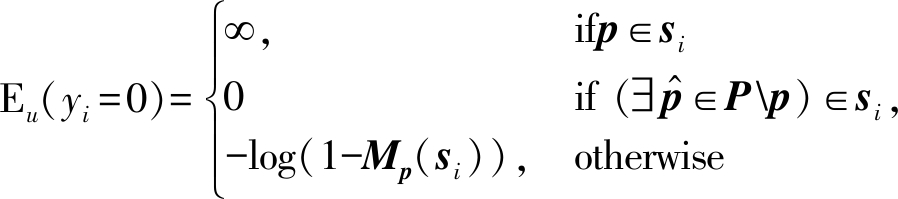

其中Eu(yi)为图像I的势能图Mp与点集P计算得到的一元项。二元项Et(yi,yj)模拟相邻超像素之间的相似性。本文将一元项Eu(yi)定义为:

(7)

(8)

其中Mp(si)是si在势能图Mp中的预测值。它是通过平均超像素si中所有像素的势能值来计算的。前两个条件对被点p标记的前景超像素以及被其他点标记为背景的部分赋值0损失。第三个条件定义了未被Mp定义的超像素的损失。

本文应用颜色和纹理直方图hc(si)和ht(si),构造二元项Et(yi,yj)为:

(9)

其中[·]为艾弗森括号,σc,σt分别设为0.1,0.2。

3.6 优化过程

根据[13,16]所报告的迭代是算法的有效性分析,本文采用一种迭代算法生成实例掩膜。在第i次迭代中,本文使用前一次迭代的中间实例掩膜{Y}i-1,并更新式(1)和(3)中的网络参数{Wb,Ws}。随着{Wb,Ws}的更新,本文将它们应用于训练集,并通过图模型生成的实例势能图,它被用于推断实例掩膜{Y}i。然后进入下一个迭代,进一步更新网络参数。图3展示了一次迭代中的推导过程,优化过程不断迭代直到收敛。本文应用最终推断出的目标掩膜训练实例分割模型并进行测试。

本文的优化从输入候选区块{Y}0开始训练网络。为了初始化实例掩码,本文以每个标记点为中心放置一个256×256锚定框,选择与标记的锚定框有最高IoU的候选区块作为初始掩膜。本文将{Y}0作为标记数据,在第一次迭代中训练网络{Wb,Ws}。

4 实验

在这一节,本文对系统进行了一系列消融实验,并展示了在弱监督和半监督环境下的主要结果。本文展示了弱监督物体检测任务的结果,以便进行广泛的比较。

4.1 实验设置

本文遵循[21-23,33]的设定,在PASCAL VOC 2007数据集[2]上进行了实验。训练集和验证集中分别包含5011和4952个图像。本文在“Allpoints”设置下应用[7]中提供的点标注方法,也就是全部使用点标注来进行网络训练。由于没有提供标准测试子集,本文展示了在val子集上的结果。本文使用标准评价指标mAPr与![]() 实验中,本文采用Deeplab-LargeFOV[37]网络结构作为区块校验模块。本文将批大小设置为12,学习率初始化为0.001,并每 2000次迭代缩小10倍。本文采用Fast RCNN作为框校验模块,将图像批大小设置为3,并在一个批中抽样192个候选区块。本文将学习率初始化为0.001,并在每20000次迭代后减小它。根据[13,16],本文应用VGG-16[38]在每次迭代开始时初始化模型。对于候选对象,本文使用MCG[17]和Selective Search(SS)[18]进行实验(其他基于区块的对象候选[39]也是可行的)。本文采用[40]的求解器对图模型进行优化,并在Caffe[41]上实现。模型的训练全部是在Titan XP(12GB显存,3840个核心)图形显卡。

实验中,本文采用Deeplab-LargeFOV[37]网络结构作为区块校验模块。本文将批大小设置为12,学习率初始化为0.001,并每 2000次迭代缩小10倍。本文采用Fast RCNN作为框校验模块,将图像批大小设置为3,并在一个批中抽样192个候选区块。本文将学习率初始化为0.001,并在每20000次迭代后减小它。根据[13,16],本文应用VGG-16[38]在每次迭代开始时初始化模型。对于候选对象,本文使用MCG[17]和Selective Search(SS)[18]进行实验(其他基于区块的对象候选[39]也是可行的)。本文采用[40]的求解器对图模型进行优化,并在Caffe[41]上实现。模型的训练全部是在Titan XP(12GB显存,3840个核心)图形显卡。

与[29,42- 43]相似,本文通过组合Fast RCNN[34]和DeepMask[44]来设计基准模型。Fast RCNN为每个候选区块分配检测分数。然后对包围框进行非极大值抑制(NMS),并利用DeepMask估计保留下的候选区块的物体掩膜。本文基于VGG-16上的DeepMask,下采样率为8。DeepMask经过ROI池化以及2个全连接网络对每一个候选区块输出一个48×48的掩膜。所有掩膜都将重新调整大小以匹配每个实例的候选区域。该基准模型与其他实例分割网络[22,33]相当。推断掩膜用于训练该基准网络,以便在下文的比较中进行测试和评估。这一基准结果使本文能够在弱监督和半监督环境下进行公平对比。同时,本文将Mask RCNN和本文的点监督方法结合在一起。具体步骤是:(1)将region proposal network所得到的候选包围框取代selective search得到的候选包围框;(2)将Mask RCNN取代Fast RCNN。其中,本文使用Mask RCNN分支结构得到的分类分数回归、包围框回归结果取代Fast RCNN的分类分数回归、包围框回归。同时,本文同时将Mask RCNN的掩膜回归结果来取代DeepMask的掩膜回归结果。

本文在训练的时候采用了迭代式的更新,具体的做法就是先使用点标注生成的实例分割掩膜来训练实例分割网络;训练完毕的网络模型用于输出实例分割掩膜的结果,这些结果会被用来重新生成一批实例分割掩膜用于新一轮的网络训练。的确迭代式的网络训练会带来更多的时间开销。考虑到优质的分割掩膜需要充分迭代才能得到,因此目前并没有十分有效的手段可以大规模地削减训练时间。不过,本文可以在每个迭代训练的过程中,用训练中期的模型(使用了10000个图像批来进行训练)来同步生成一批实例掩膜,并且将新生成混合到已有的数据中心来训练模型。这种做法可以加快模型训练的收敛速度,使得原本需要40000个图像批的训练过程,只需要30000个图像批即可取得不错的收敛效果,节省约四分之一的训练时间。在迭代式训练过程完毕之后,所得到的实例分割模型直接用于测试数据的实例分割,这个过程并不涉及迭代过程,没有增加额外的计算量。

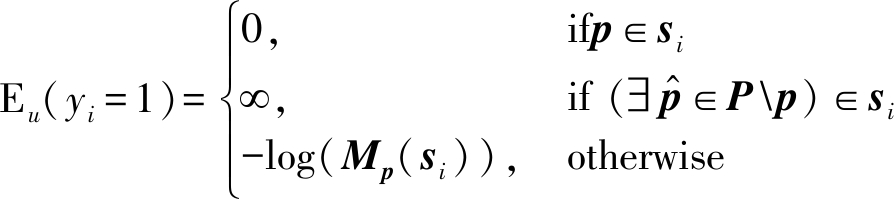

4.2 不同物体候选的影响

本文的框架通过验证候选物体迭代地生成中间结果,候选物体是本文方法的基础。本文首先研究不同的候选物体生成器对实例分割方法的影响。在表1中,本文比较了使用不同候选物体生成器时的性能,例如SS[18]和MCG[17]。从表中可以看出,本文的方法在不同条件下的性能变化不大。

尽管SS的质量不如MCG,但是SS的候选具有更高的方差,通过本文的方法可以捕捉到这些方差,从而产生合理的结果。它证明了本文的框架在推断实例掩膜方面是有效的。它也抑制了候选区块的不利影响。在下面的实验中,本文默认使用MCG。

表1 不同候选区域生成性能对比,以mAPr和 ![]() 为评价指标

为评价指标

Tab.1 Performance with different region proposals. It is measured by mAPr and ![]()

候选区域mAPrmAPrvolMCG34.533.3SS34.134.1

4.3 消融实验

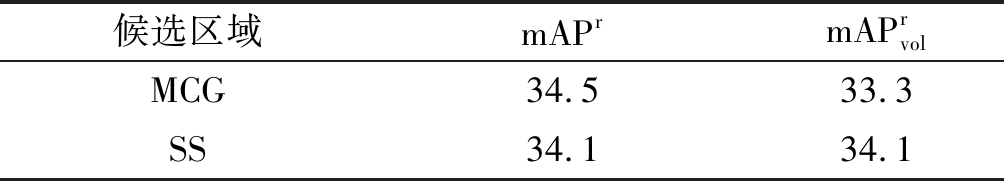

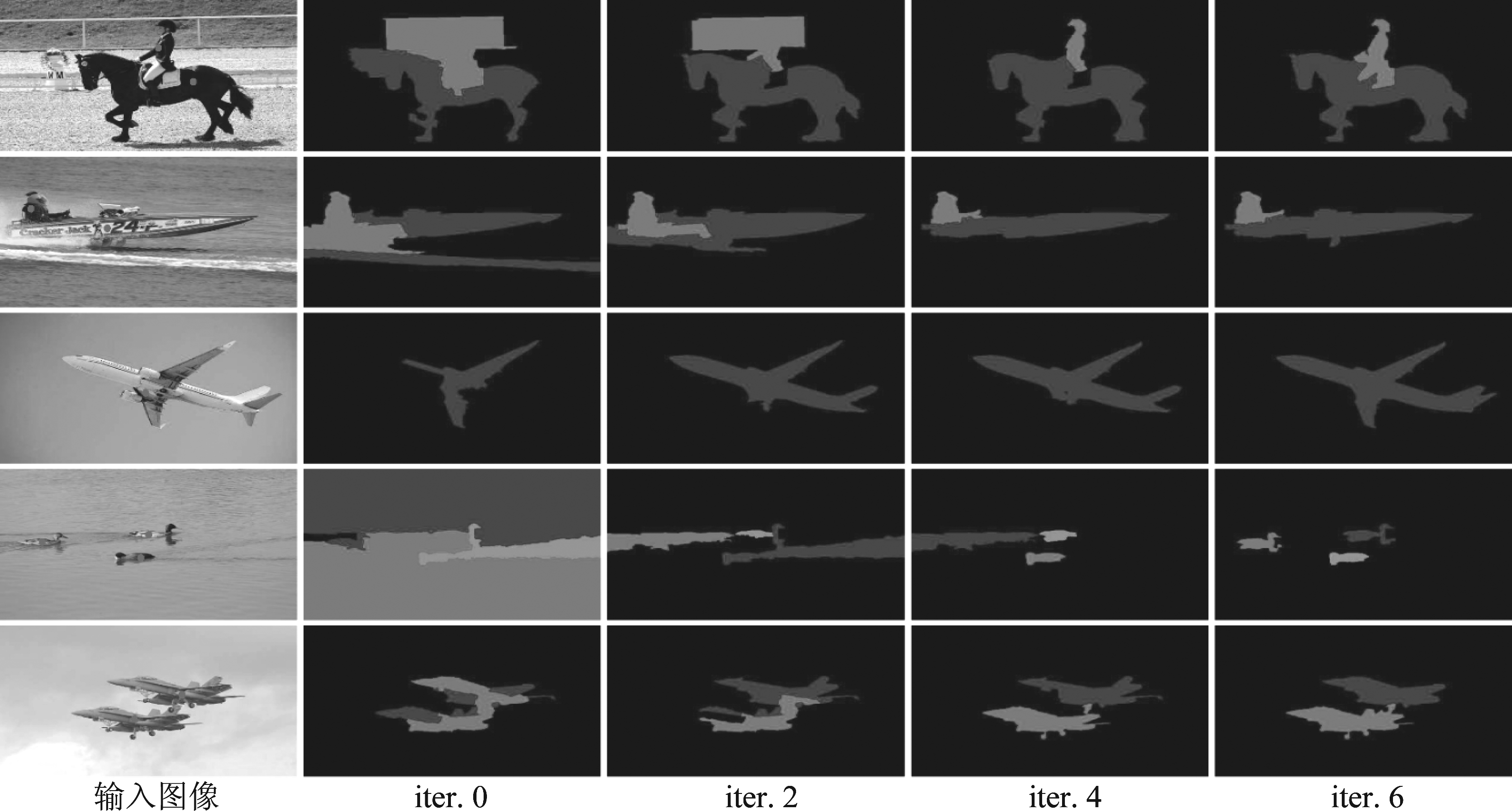

本文的框架改进了迭代的结果。本文将中间结果与图4中标注的实例掩码进行比较。“iter. 0”表示初始时选择候选物体的步骤。本文总共进行了6次迭代。

图4 三种评价指标下不同迭代次数对应的预测实例掩膜的 质量。图中,纵坐标“质量”指的是“recallb”(包围框 召回率)、“IoU”(交并比)和recallr(区块召回率)

Fig.4 Quality of our inferred instance masks in iterations evaluated by the three criteria. We report the quality in terms of “recallb”, “IoU” and “recallr”

本文用三个标准来衡量质量。第一个是通过训练好的实例分割模型推断得出的包围框的召回率(表示为recallb)。该评价指标衡量仅提供点注释时发现的正确包围框的百分比,它将影响框校验。第二个是IoU(用于语义分割的评价标准),它将推断掩膜放回图像并与标注进行对比。它是像素级的评价,影响区块校验性能。第三个标准是掩膜的召回率recallr。它直接从实例分割的角度衡量推断标注的质量。

如图4所示,本文展示了模型的表现随着迭代不断地提升。与第0次迭代时的包围框相比,掩膜的召回率极低。训练图像上实例掩膜的迭代如图5所示,即使是非常粗糙的初始输入数据也可以快速提升。

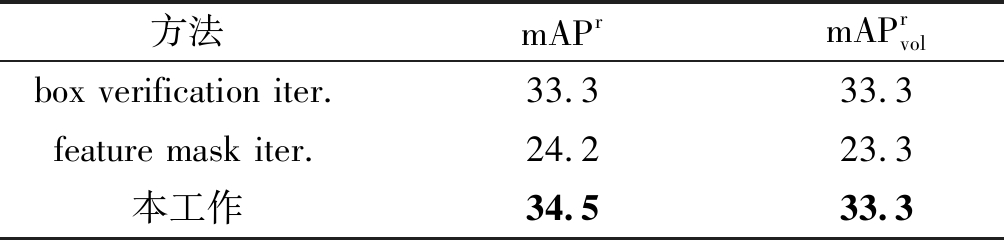

表2 不同框架设计性能对比,以mAPr和![]() 为评价指标。表现最佳的实验结果用黑体标出

为评价指标。表现最佳的实验结果用黑体标出

Tab.2 Performance of different designs in terms of mAPr and ![]() The entries with the best performance are bold-faced

The entries with the best performance are bold-faced

方法mAPrmAPrvolbox verification iter.33.333.3feature mask iter.24.223.3本工作34.533.3

本文在图5中展示了框架采用的掩膜推断过程。使用相同的初始化条件(“iter. 0”),本文完整的系统所推断出的掩膜比其他系统更好。粗糙的掩膜初始化会导致其他方法出现错误。最后,本文在等式(2)和等式(4)中去掉第二项的情况下进行实验。在mAPr和![]() 上,性能分别下降了2.1和1.8。这证实了这些子项的重要性。

上,性能分别下降了2.1和1.8。这证实了这些子项的重要性。

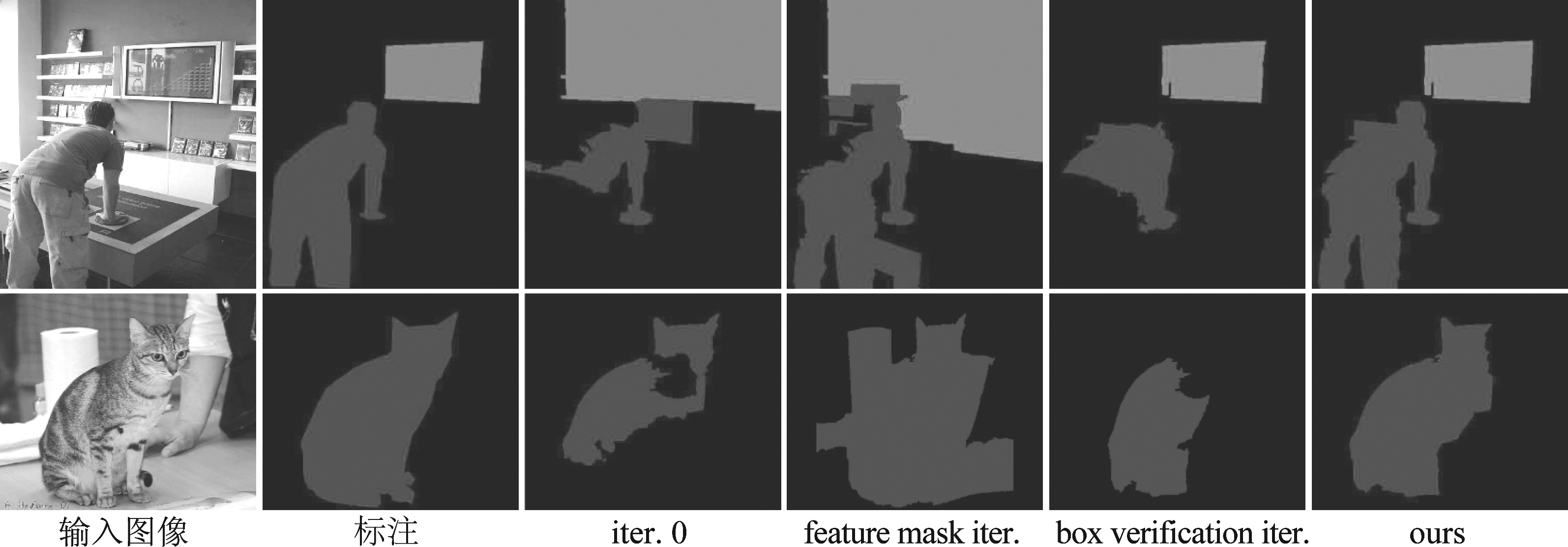

本文在另一个实验遵循标准的迭代框架,并用实例分割模块替换本文的两个模块。CFM[22]是一种具有代表性的方法,它应用物体候选取得了良好的效果。通过CFM,本文屏蔽了背景区域并迭代训练网络来推断物体。通过聚合候选物体与CFM输出的置信度生成实例势能图。为了证明区块校验的重要性,本文的框架只使用框校验进行迭代。此时模型(表2中的框校验“box verification iter.”)性能不如完整的系统。原因有两个。首先,框校验无法获得像素信息,这使得它在生成实例势能图时忽略了掩膜。其次,更新一个模块容易陷入局部极小值。区块校验模块能够补充这些信息。由于该系统依赖于高质量的训练数据,因此表2(区块校验“feature mask iter.”)所示的分数仍然低于本文的分数。如图6所示,本文展示了使用框校验和区块校验的迭代方法和本文的方法(“ours”)得出来的实例分割结果对比。

图5 推断实例掩膜的演化过程。图中,“iter.”指的是迭代过程的代编号。例如“iter.2”指的是第2代

Fig.5 Evolution of inferred instance masks. “iter.” means the epoch of the iteration. For example. “iter.2” means the second epoch

图6 不同框架设计下推断实例掩膜的比较。“feature mask iter.”和“box verification iter.” 指的是区块校验和框校验方法。“ours”指的是本文的方法

Fig.6 Comparison of inferred masks with different framework designs. “feature mask iter.” and “box verification iter.” means the segmentation verification and box verification approaches, respectively. “Ours” means our method

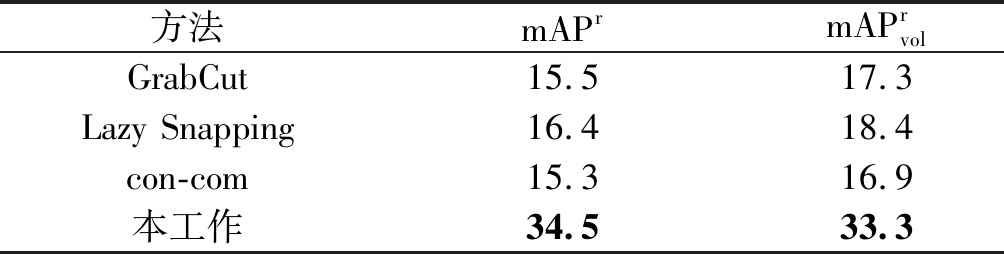

4.4 使用点标注的策略

本文与其他使用点标注的方法进行比较。GrabCut[45]和Lazy Snapping[46]可以从点标注中推断实例掩膜。对于这些方法,本文每次取一个点作为单个实例的前景种子,其他点作为背景种子。本文独立地为每个点推断实例掩膜,并使用它们来训练基准网络。如表3所示,本文的方法性能明显优于基准网络,因为GrabCut和Lazy Snapping仅利用低级特征。本文还设计了一个直观的策略,使用弱监督语义分割中的相连部分作为实例掩膜。结果(表3中的“con-com”条目)显示这导致了实例信息丢失与性能下降。

4.5 半监督环境

本文将系统扩展到半监督训练的设定。本文利用PASCAL VOC 2007[2]中的9963幅图像作为点标注数据,在PASCAL VOC 2007训练子集中使用了5623幅带完整掩膜的图像。由于PASCAL VOC 2007上只提供了包围框,因此本文通过从每个包围框的中心正方形采样像素来合成点注释。正方形的长度是相应边框较短边的五分之一。这个采样过程模拟了人的标注行为,即它并不总是位于对象的中心[7]。值得注意的是,这种简单的方案不可避免地存在噪声,特别是当对象具有非凸形状或遮挡时。

表3 不同方法使用标注点进行实例分割性能对比,以mAPr 和![]() 为评价指标。表现最佳的实验结果用黑体标出

为评价指标。表现最佳的实验结果用黑体标出

Tab.3 Performance of instance segmentation network trained with different ways to utilize labeled points in terms of mAPr and ![]() The entries with the best performance are bold-faced

The entries with the best performance are bold-faced

方法mAPrmAPrvolGrabCut15.517.3Lazy Snapping16.418.4con-com15.316.9本工作34.533.3

本文以如下方式扩展基于点标注的弱监督实例分割系统。对于只有点标签的图像,本文使用的方法迭代地推断实例掩膜,在表4中展示本文弱监督方法的结果。即使在目标检测中,弱监督方法[8-10]仍然难以超过最先进的完整标签输入系统的高精度。通过对VCO 2007中的注释进行扩充,本文的系统的性能已经比弱监督基准方法在![]() 上得到显著的提高。这证明了点标签在注释中的实用性和潜力。

上得到显著的提高。这证明了点标签在注释中的实用性和潜力。

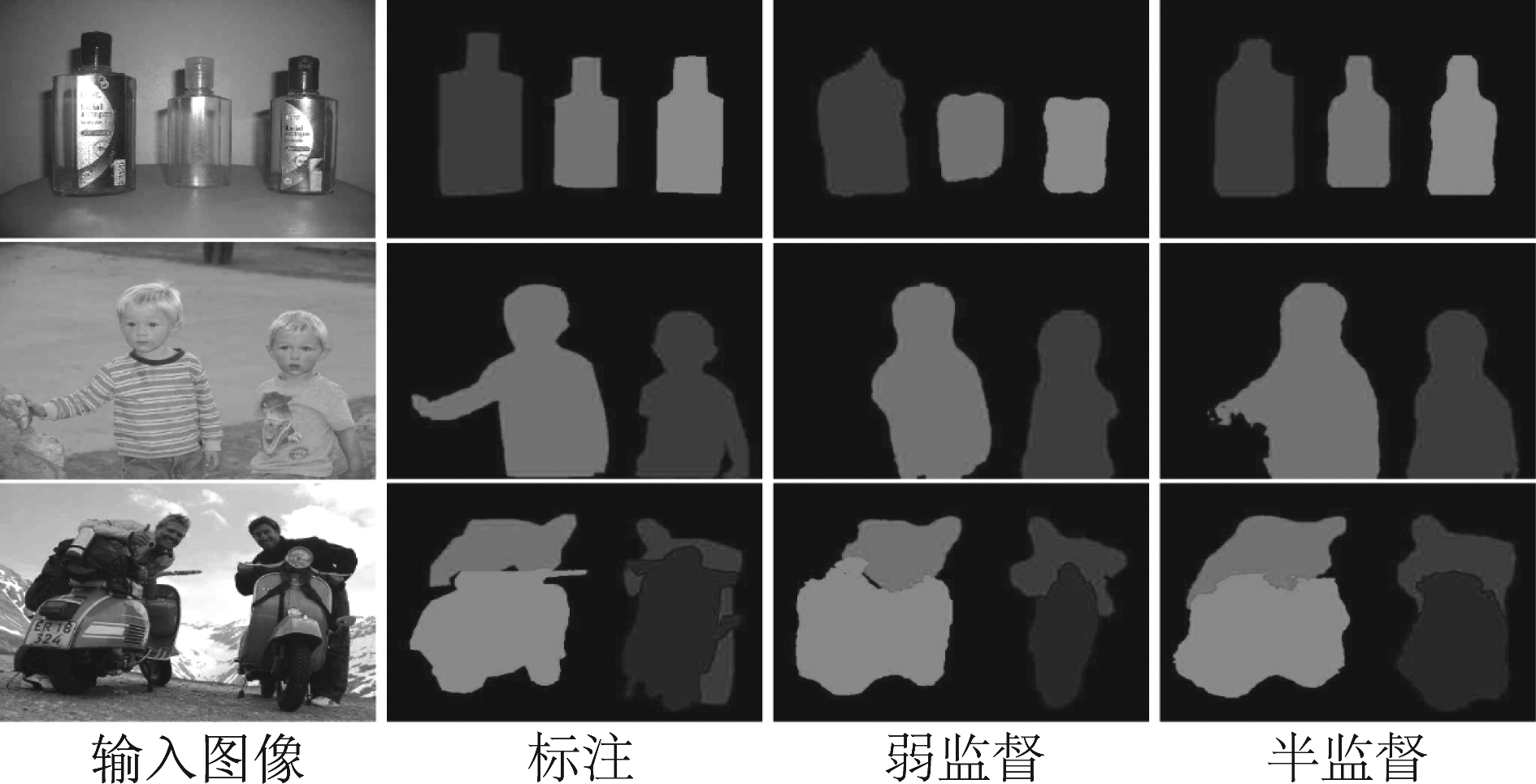

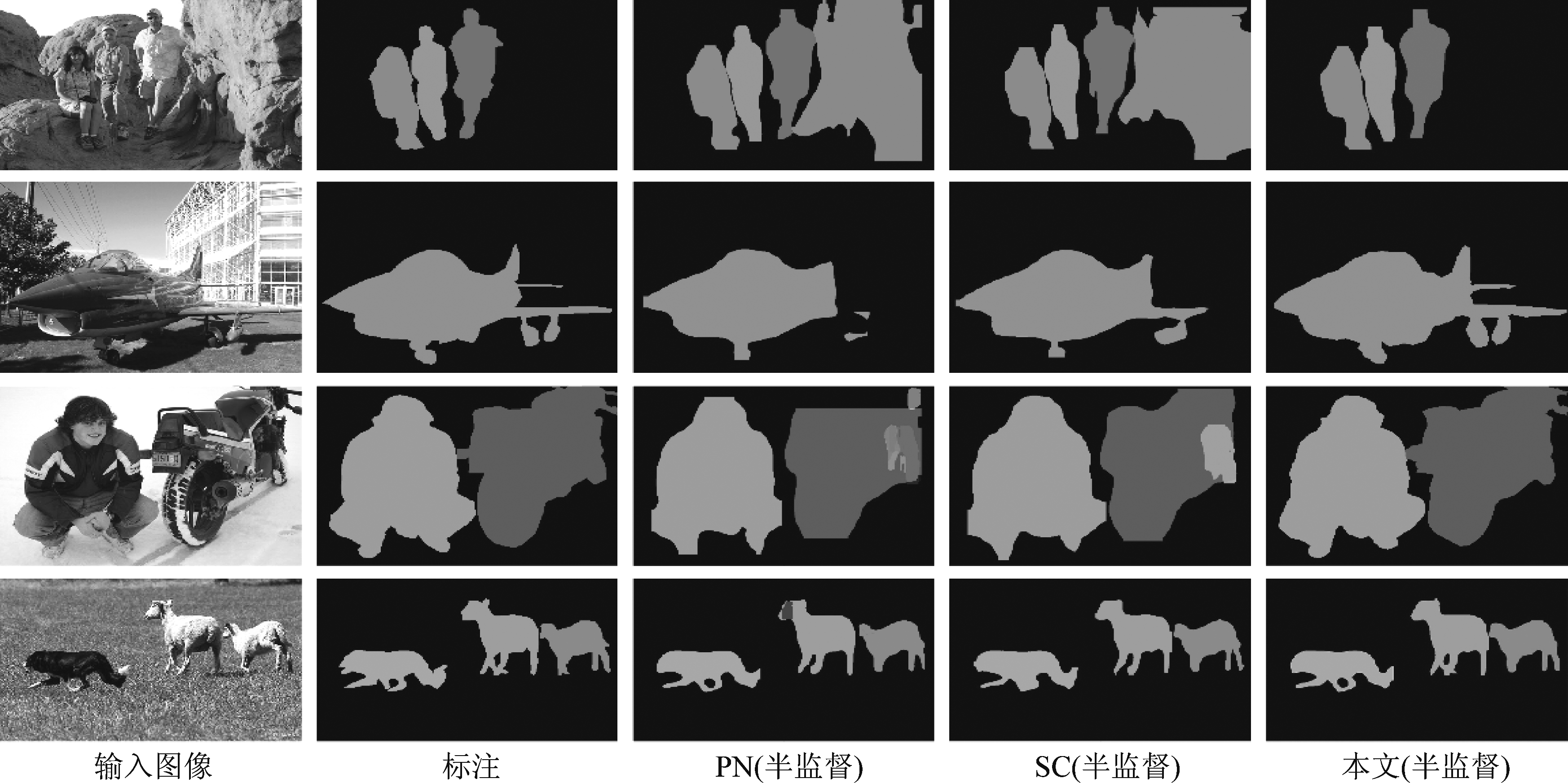

如图7所示,只需点标注的弱监督检测已经是合理的设置。它们与真实标注高度重叠。半监督模型通过预测更精确的边界进一步优化了掩膜。另外,本文提供了[31,47]这两种半监督实例分割方法的可视化结果(如图8)。这些结果包含大量的错分割实例。我们的方法能更有效利用点标注来扩展训练数据,从而抑制错分割例子,得到更好的半监督分割结果。

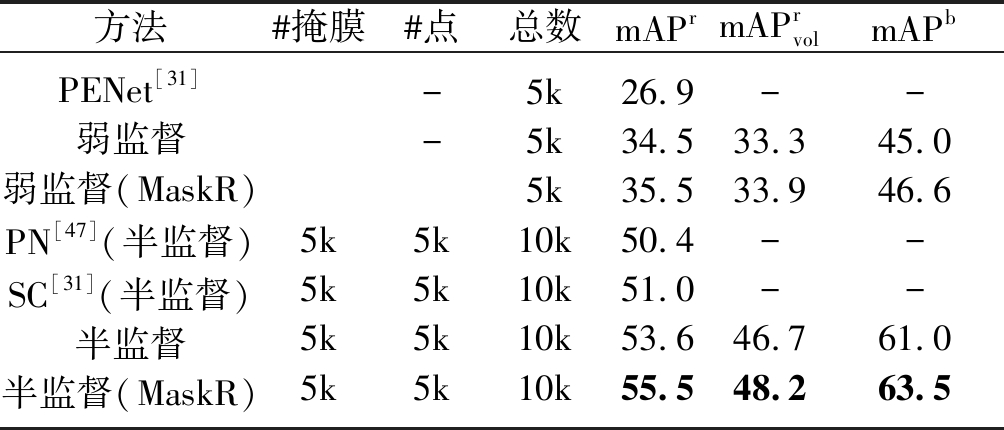

表4 PASCAL VOC 2007数据集中验证集实验结果展示,以 ![]() 和mAPb作为评价指标,“#掩膜”和“#点数”分别 表示掩膜和点的数量。“总数”表示用于训练的图片总数。“MaskR” 代表了使用Mask RCNN。表现最佳的实验结果用黑体标出

和mAPb作为评价指标,“#掩膜”和“#点数”分别 表示掩膜和点的数量。“总数”表示用于训练的图片总数。“MaskR” 代表了使用Mask RCNN。表现最佳的实验结果用黑体标出

Tab.4 Performance on val subset of SBD in terms of mAPr, ![]() and mAPb. “# masks” and “# points” give numbers of masks and points respectively. “total” refers to the number of images used for training. “MaskR” means that we use Mask RCNN. The entries with the best performance are bold-faced

and mAPb. “# masks” and “# points” give numbers of masks and points respectively. “total” refers to the number of images used for training. “MaskR” means that we use Mask RCNN. The entries with the best performance are bold-faced

方法#掩膜#点总数mAPrmAPrvolmAPbPENet[31]弱监督弱监督(MaskR)PN[47] (半监督)SC[31] (半监督)半监督半监督(MaskR)5k5k5k5k--5k5k5k5k5k5k5k10k10k10k10k26.934.535.550.451.053.655.5-33.333.9--46.748.2-45.046.6--61.063.5

图7 不同设置下实例分割结果的示例

Fig.7 Examples of instance segmentation results under different settings

图8 不同方法的半监督实例分割结果比较

Fig.8 Comparison of different approaches on the semi-supervised instance segmentation

5 结论

本文提出了一种利用易于获取的点标注进行实例分割任务的系统,该系统包含新颖的框校验和区块校验模块,以处理不完整的训练数据。本文的实验表明,点监督方法会有轻微的性能下降。在半监督的环境中,本文通过提供更多的训练数据显示出改进现有方法具有巨大的潜力。目标检测实验也给出了高质量的结果。

[1] Lin T Y, Maire M, Belongie S, et al. Microsoft coco: Common objects in context[C]∥2014 European Conference on Computer Vision. Springer, 2014: 740-755.

[2] Hariharan B, Arbel’aez P, Bourdev L, et al. Semantic contours from inverse detectors[C]∥2011 International Conference on Computer Vision. IEEE, 2011: 991-998.

[3] Cordts M, Omran M, Ramos S, et al. The cityscapes dataset for semantic urban scene understanding[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2016: 3213-3223.

[4] Everingham M, Van Gool L, Williams C K, et al. The pascal visual object classes (voc) challenge[J]. International Journal of Computer Vision, 2010, 88(2): 303-338.

[5] He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2016: 770-778.

[6] He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Identity mappings in deep residual networks[C]∥2016 European Conference on Computer Vision. Springer, 2016: 630- 645.

[7] Bearman Amy, Russakovsky Olga, Ferrari Vittorio, et al. What’s the point: Semantic segmentation with point supervision[C]∥2016 European Conference on Computer Vision. Springer, 2016: 549-565.

[8] Wang Chong, Ren Weiqiang, Huang Kaiqi, et al. Weakly supervised object localization with latent category learning[C]∥2014 European Conference on Computer Vision. Springer, 2014: 431- 445.

[9] Cinbis R G, Verbeek J, Schmid C. Weakly supervised object localization with multi-fold multiple instance learning[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 39(1): 189-203.

[10]Bilen H, Vedaldi A. Weakly supervised deep detection networks[C]∥2016 IEEE conference on Computer Vision and Pattern Recognition. IEEE, 2016: 2846-2854.

[11]Pathak D, Shelhamer E, Long J, et al. Fully convolutional multi-class multiple instance learning[C]∥2014 International Conference on Learning Representations, 2014.

[12]Papandreou G, Chen L C, Murphy K, et al. Weakly-and semi-supervised learning of a dcnn for semantic image segmentation[C]∥2015 International Conference on Computer Vision. IEEE, 2015: 1742-1750.

[13]Dai Jifeng, He Kaiming, Sun Jian. Boxsup: Exploiting bounding boxes to supervise convolutional networks for semantic segmentation[C]∥2015 IEEE International Conference on Computer Vision. IEEE, 2015: 1635-1643.

[14]Kolesnikov Alexander, Lampert Christoph H. Seed, expand and constrain: Three principles for weakly-supervised image segmentation[C]∥2016 European Conference on Computer Vision. Springer, 2016: 695-711.

[15]Qi Xiaojuan, Liu Zhengzhe, Shi Jianping, et al. Augmented feedback in semantic segmentation under image level supervision[C]∥2016 European Conference on Computer Vision. Springer, 2016: 90-105.

[16]Lin Di, Dai Jifeng, Jia Jiaya, et al. Scribblesup: Scribble-supervised convolutional networks for semantic segmentation[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2016: 3159-3167.

[17]Arbel’aez P, Pont-Tuset J, Barron J, et al. Multiscale combinatorial grouping[C]∥2014 IEEE conference on Computer Vision and Pattern Recognition, IEEE, 2014: 328-335.

[18]Uijlings J R, van de Sande K E, Gevers T, et al. Selective search for object recognition[J]. International Journal of Computer Vision, 2013, 104(2): 154-171.

[19]Blum Avrim, Mitchell Tom. Combining labeled and unlabeled data with co-training[C]∥1998 Annual Conference on Computational Learning Theory, 1998: 92-100.

[20]Sun Shiliang. A survey of multi-view machine learning[J]. Neural computing and applications, 2013, 23(7-8): 2031-2038.

[21]Hariharan B, Arbel’aez P, Girshick R, et al. Simultaneous detection and segmentation[C]∥2014 European Conference on Computer Vision. Springer, 2014: 297-312.

[22]Dai Jifeng, He Kaiming, Sun Jian. Convolutional feature masking for joint object and stuff segmentation[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition, IEEE, 2015: 3992- 4000.

[23]Dai Jifeng, He Kaiming, Sun Jian. Instance-aware semantic segmentation via multi-task network cascades[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2016: 3150-3158.

[24]Liang Xiaodan, Wei Yunchao, Shen Xiaohui, et al. Reversible recursive instance-level object segmentation[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2016: 633- 641.

[25]Li Ke, Hariharan B, Malik J. Iterative instance segmentation[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2016: 3659-3667.

[26]Hayder Z, He Xuming, Salzmann M. Shape-aware instance segmentation. CoRR, 2016.

[27]Arnab Anurag, Torr Philip H S. Pixelwise instance segmentation with a dynamically instantiated network[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition, IEEE, 2017: 441- 450.

[28]Arnab Anurag, Torr Philip H S. Bottom-up instance segmentation using deep higher-order crfs. CoRR, 2016.

[29]Khoreva Anna, Benenson Rodrigo, Hosang Jan, et al. Weakly supervised semantic labelling and instance segmentation. CoRR, 2016.

[30]Laradji J H, Rostamzadeh N, Pinheiro P O, et al. Instance segmentation with point supervision. CoRR, 2019.

[31]Ge Weifeng, Guo Sheng, Huang Weilin, et al. Label-PEnet: Sequential Label Propagation and Enhancement Networks for Weakly Supervised Instance Segmentation[C]∥2019 IEEE Conference on Computer Vision and Pattern Recognition, IEEE, 2019: 3345-3354.

[32]Ahn J, Cho S, Kwak S. Weakly supervised learning of instance segmentation with inter-pixel relations[C]∥2019 IEEE Conference on Computer Vision and Pattern Recognition, IEEE, 2019: 2209-2218.

[33]Hariharan Bharath, Arbelaez Pablo, Girshick Ross, et al. Hyper columns for object segmentation and  ne-grained localization[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition, IEEE, 2015: 447- 456.

ne-grained localization[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition, IEEE, 2015: 447- 456.

[34]Girshick R. Fast r-cnn[C]∥2015 International Conference on Computer Vision. IEEE, 2015: 1440-1448.

[35]Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition, IEEE, 2015: 3431-3440.

[36]Carreira J, Caseiro R, Batista J, et al. Semantic segmentation with second-order pooling[C]∥2012 European Conference on Computer Vision. Springer, 2012: 430- 443.

[37]Chen L C, Papandreou G, Kokkinos I, et al. DeepLab: Semantic image segmentation with deep convolutional nets and fully connected crfs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834- 848.

[38]Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[C]∥International Conference on Learning Representations, 2014.

[39]Krahenbuhl P, Koltun V. Geodesic object proposals[C]∥2014 European Conference on Computer Vision. Springer, 2014: 725-739.

[40]Boykov Y, Kolmogorov V. An experimental comparison of min-cut/max- ow algorithms for energy minimization in vision[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2004, 26(9): 1124-1137.

ow algorithms for energy minimization in vision[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2004, 26(9): 1124-1137.

[41]Jia Yangqing, Shelhamer E, Donahue J, et al. Caffe: Convolutional architecture for Fast feature embedding[C]∥2014 ACM International Conference on Multimedia. ACM, 2014: 675- 678.

[42]Zagoruyko S, Lerer A, Lin Tsung-yi, et al. A multipath network for object detection[C]∥2016 British Machine Vision Conference, 2016: 15.1-15.12.

[43]Pinheiro P H O, Lin Tsung-yi, Collobert R, et al. Learning to re ne object segments[C]∥2016 European Conference on Computer Vision. Springer, 2016: 75-91.

ne object segments[C]∥2016 European Conference on Computer Vision. Springer, 2016: 75-91.

[44]Pinheiro P H O, Collobert R, Doll’ar P. Learning to segment object candidates[C]∥2015 Advances in Neural Information Processing Systems, 2015: 1990-1998.

[45]Rother, Kolmogorov V, Blake A. “Grabcut”: interactive foreground extraction using iterated graph cuts[J]. ACM Transactions on Graphics, 2004, 23(3): 309-314.

[46]Li Yin, Sun Jian, Tang Chi-keung, et al. Lazy snapping[J]. ACM Transactions on Graphics, 2004, 23(3): 303-308.

[47]Tang Peng, Wang Xinggang, Wang Angtian, et al. Weakly supervised region proposal network and object detection[C]∥2018 European Conference on Computer Vision. Springer, 2018: 352-368.