1 引言

手语是聋哑人士与外界交流的桥梁,手语识别也成为了人机交互技术领域的研究热点之一。在传统的手语识别方法中,研究人员[1]使用隐马尔科夫[2](Hidden Markov Model,HMM)等模型进行时序建模与分类,这种方法严重依赖设计者的经验,而且所设计的特征往往是针对某一场景设计,其泛化能力和鲁棒性都不理想。

三维卷积神经网络[3](3D-Convolutional Neural Network,3D-CNN)能同时提取时空特征,在手语识别这类视频分类任务的短期时空特征提取方面效果显著;长短期记忆网络[4](Long Short Term Memory, LSTM)引入门限机制控制信息的积累进度,改进了循环神经网络[5](Recurrent Neural Network,RNN)易出现梯度爆炸或梯度弥散的缺点,提高了上下文语义的有效判断,凭借其强大的时序建模能力,在语音识别[6]等时序性问题上取得了更好的效果。与此同时,随着各种信息采集技术的进步,语音交互、行为识别等领域逐渐使用多模态融合[7]技术。如果以恰当的方式将彩色图像数据、深度图像数据和人体骨骼点坐标数据融合在一起,形成高辨识度的多模态特征,将有助于提高手语识别的准确率[8-10]。

在基于深度学习的手语识别方式中,文献[11]等人提出一种端对端的手势识别深层架构,将卷积神经网络与RNN结合,能够准确的预测手势的开始与结束帧,但是难以区分手指及手部位置的细微差别,以及上下文语义问题无法更好的解决。文献[7]提出一种双流RNN模型,先使用Fast-RCNN进行手部检测与分割,再用双流RNN识别每个孤立的手势,在CHALearn LAP连续手势识别挑战赛中取得了冠军,但在手语信息较复杂的情况下,难以提取视频中的关键信息。文献[4]提出一种将4个骨骼点轨迹作为输入,使用LSTM网络进行时序建模的手语识别系统,取得了较高的准确率,但该系统忽略了空间特征在手语识别中的重要性。

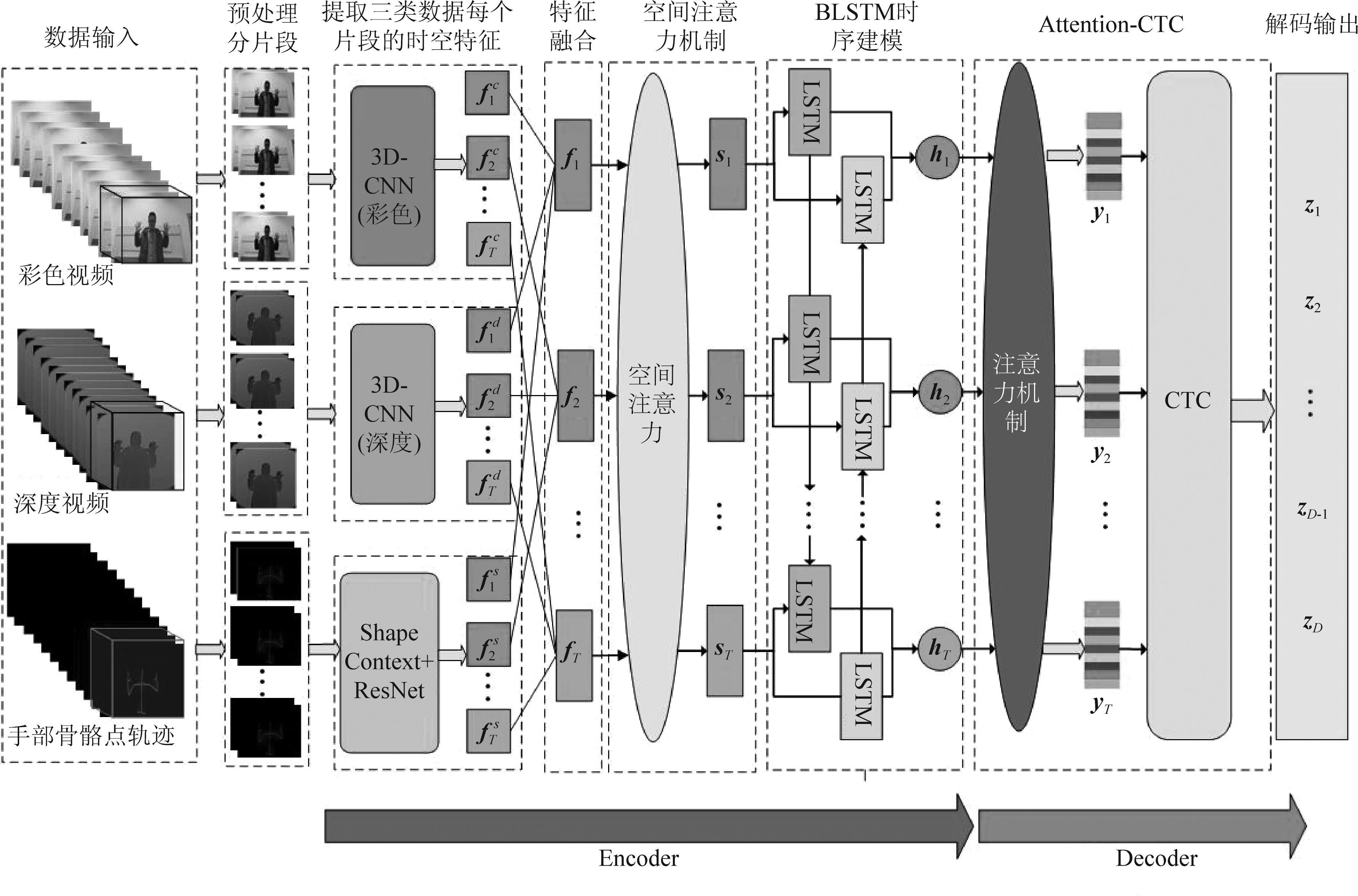

因此,本文提出一种融合注意力机制和连接时间分类的多模态手语语句识别模型,模型的输入是Kinect[12]采集的彩色视频、深度视频和骨骼点轨迹三种模态的数据,通过提取手语数据中彩色和深度视频片段的短期时空特征以及手部运动轨迹特征,将三种模态的特征融合后使用空间注意力加权并按照时间顺序输入到BLSTM中进行时序建模以获取区分性较高的长期时空特征,最后利用融合注意力机制和连接时间分类模型的解码网络,以端到端的方式实现连续手语的准确识别。本文在最后与多个手语识别模型进行对比实验,结果显示本文提出模型的准确率优于现存的一些手语识别模型。

2 融合注意力机制和连接时序分类的连续手语识别模型

2.1 特征提取与融合

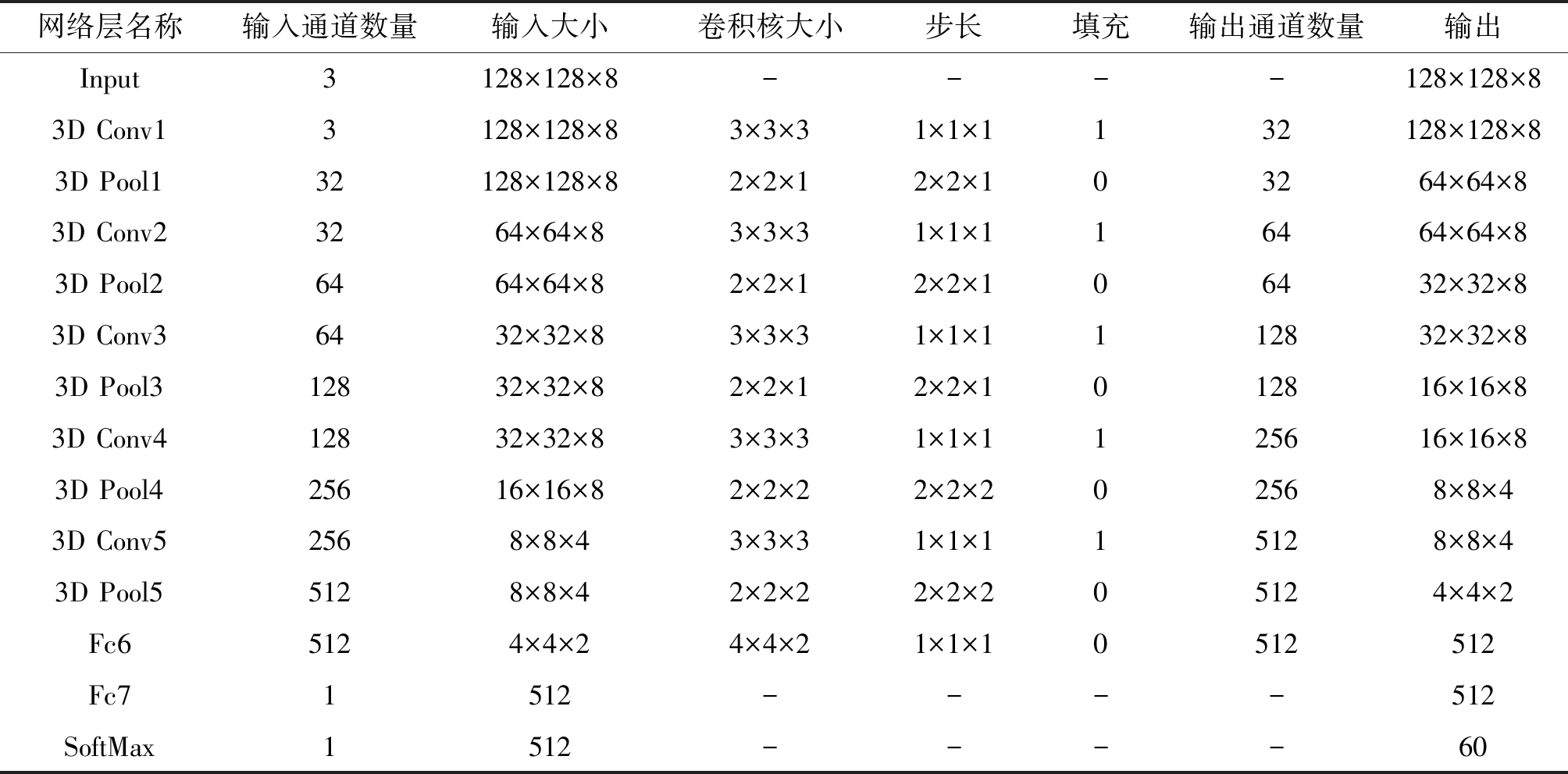

本文参照文献[13]设计了一种新颖的多通道3D-CNN,将Kinect采集到彩色和深度视频输入到3D-CNN中提取特征。采用3D-CNN网络结构[14]用于提取手语彩色视频和深度视频的时间和空间两个维度的高区分性特征。卷积核数量和这些卷积核得到的特征图通道数量等详细的网络参数见表1。

3D-CNN网络的输入是一个包含8帧图片的视频片段,图片尺寸为128×128。经过5次3D卷积和最大池化操作后输出512通道的尺寸为4×4×2的特征图,然后用尺寸为4×4×2的3D平均池化变换为512维的特征向量,最后将一个全连接层Fc7的特征向量作为视频片段的时空特征,手语样本彩色视频和深度视频中第t个片段的特征分别用![]() 和

和![]() 表示,特征维度为512维。提取手语样本中彩色视频

表示,特征维度为512维。提取手语样本中彩色视频![]() 和深度视频

和深度视频![]() 中的每一个视频片段ct的时空特征,就可以得到对应的彩色视频特征序列

中的每一个视频片段ct的时空特征,就可以得到对应的彩色视频特征序列![]() 和深度视频特征序列

和深度视频特征序列![]()

本文参照文献[15]中提出的方法,使用形状上下文[16]和ResNet网络[17]相结合的方式提取每一个数据片段的手部骨骼点轨迹特征。

本文用Kinect V2采集的手语数据集包含了人体上半身15个骨骼点的空间坐标,其中包括左右手、手肘、腕、拇指、指尖这10个与手部运动相关的骨骼点,将这些点的空间坐标按时间顺序连接起来可以反映手部的运动轨迹。本文首先使用文献[18]所述的方法对骨骼点坐标(xi,yi,zi)进行归一化,得到骨骼点轨迹表示:

表1 3D-CNN网络详细参数

Tab.1 Detailed parameters of 3D-CNN network

网络层名称输入通道数量输入大小卷积核大小步长填充 输出通道数量输出Input3128×128×8----128×128×83D Conv13128×128×83×3×31×1×1132128×128×83D Pool132128×128×82×2×12×2×103264×64×83D Conv23264×64×83×3×31×1×116464×64×83D Pool26464×64×82×2×12×2×106432×32×83D Conv36432×32×83×3×31×1×1112832×32×83D Pool312832×32×82×2×12×2×1012816×16×83D Conv412832×32×83×3×31×1×1125616×16×83D Pool425616×16×82×2×22×2×202568×8×43D Conv52568×8×43×3×31×1×115128×8×43D Pool55128×8×42×2×22×2×205124×4×2Fc65124×4×24×4×21×1×10512512Fc71512----512SoftMax1512----60

![]()

(1)

其中i用于区分不同的骨骼点,![]() 表示归一化后的骨骼点位置坐标,M表示该手语样本帧数。在得到归一化的骨骼点坐标数据后,对其进行序列长度归一化和片段划分。

表示归一化后的骨骼点位置坐标,M表示该手语样本帧数。在得到归一化的骨骼点坐标数据后,对其进行序列长度归一化和片段划分。

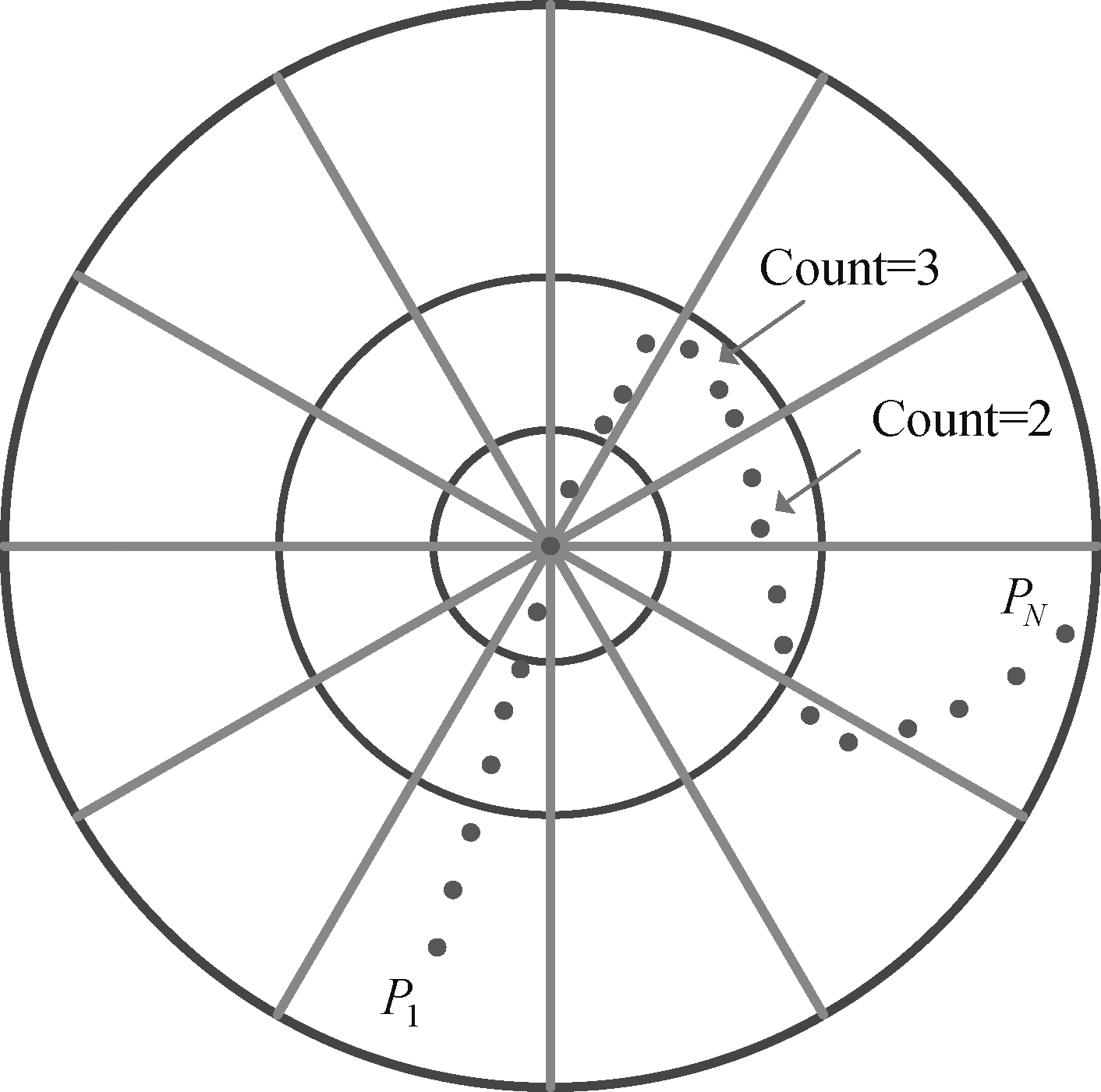

本文首先将手语样本中数据片段的骨骼点3D轨迹坐标分别投影到坐标平面XOY、XOZ和YOZ后得到3条2D曲线,每个3D轨迹点对应3个2D点,分别求解这3个2D点的形状上下文,以一点pi为圆心,R为半径的圆内,按对数距离建立K个同心圆,将该圆沿圆周方向等分为L个部分,如图1。对曲线上其他点在图中K*L个小区域的点数分布进行分别统计,可以得出pi的形状上下文特征(维度为K*L)。本文中,K和L分别取3和12,最终得到的每个3D轨迹点的形状上下文特征维度为108(3×3×12)。由于每个片段有8帧数据,骨骼点3D轨迹上也相应的有8个点,将8个点的形状上下文纵向拼接为一个8×108的矩阵,即该骨骼点轨迹的形状上下文特征。最后将10个与手部运动相关的骨骼点轨迹的形状上下文特征纵向拼接得到一个80×108的特征矩阵作为该数据片段的手部轨迹形状上下文特征。

图1 形状上下文求解示意图

Fig.1 Shape context solving diagram

本文将得到的手部轨迹形状上下文特征矩阵作为图片输入到ResNet[17]中进一步提取特征,将其全连接层激活值作为最终输出的手部轨迹特征,特征维度为512,分别提取手语数据中手部轨迹![]() 中的各个片段

中的各个片段![]() 的手部轨迹特征,就可以得到该手语数据的手部轨迹的特征序列

的手部轨迹特征,就可以得到该手语数据的手部轨迹的特征序列![]()

在特征融合阶段,本文将同一时序片段的彩色视频片段特征![]() 深度视频片段特征

深度视频片段特征![]() 和手部骨骼点轨迹片段特征

和手部骨骼点轨迹片段特征![]() 进行特征拼接,即:

进行特征拼接,即:

(2)

拼接后的特征包含三种数据的完整特征信息,使网络可以得到更加准确的目标分类结果。

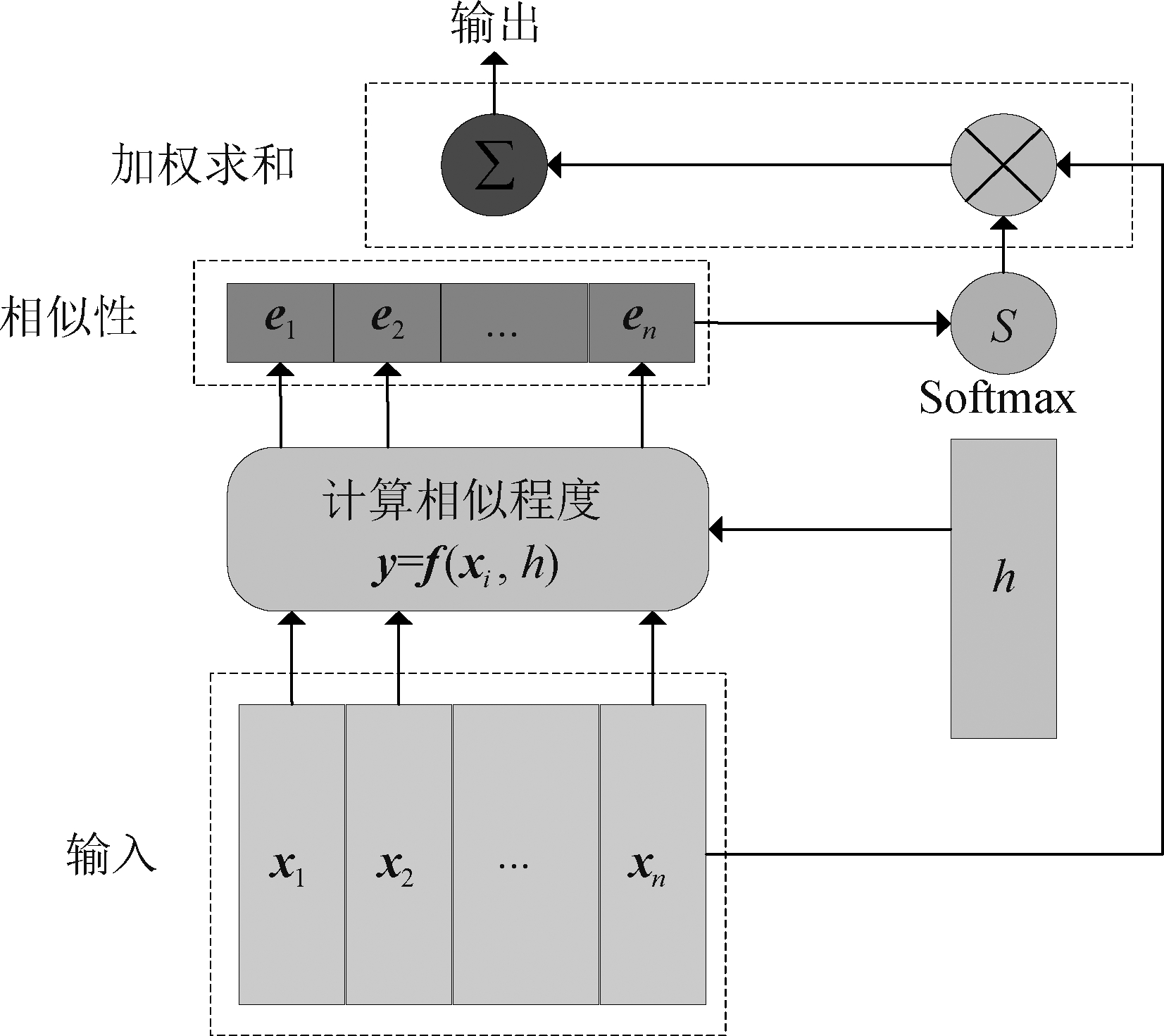

2.2 空间注意力模型

注意力机制[19-20]可以学习待输入特征的权重分布,赋予更重要的特征更大的权重。注意力机制的计算方法可以将待处理数据看作键值对储存在数据库中,给定与模型输出相关的Query,通过比较Query和Key的相似程度similarity(Query,Key)并对每个Value加权求和,得到该Query的Attention Value。本文采用多层感知机(MLP)的方法对相似度函数求解,如式(3)所示:

similarity(Query,Keyi)=MLP(Query,Keyi)

(3)

注意力机制结构如图2所示,X=(x1,x2,…,xn)为输入数据,注意力信号(Query)用h表示,ei为输入数据xi和注意力信号h之间的相似性。

图2 注意力机制模型

Fig.2 Attention mechanism model

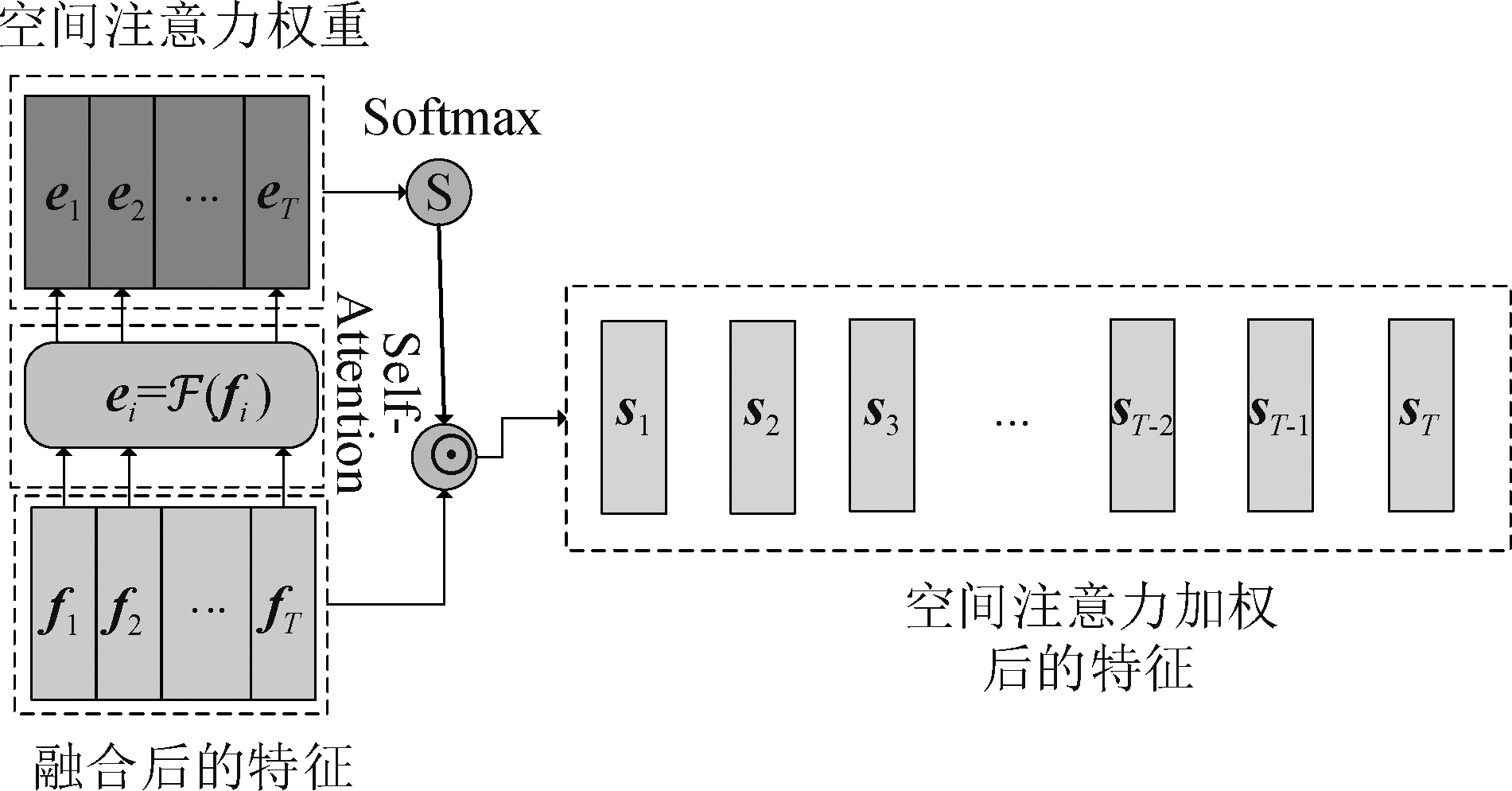

本文通过3D-CNN提取到的彩色与深度视频片段特征以及通过形状上下文和ResNet提取到骨骼点手部轨迹特征均为512维的特征向量,特征融合后得到1536维的特征向量。本文引入空间注意力关注这三个512维向量更好反应手语视频片段以及关节点轨迹中关键信息的特征维度,空间注意力模型结构如图3。

图3 空间注意力模型

Fig.3 Spatial attention model

本文采用自注意力机制网络来计算空间注意力,自注意力机制即Query和(Keys,Values)来自同一个数据源,根据其内部之间的关系计算每个数据的权重。公式表示为:

(4)

式中fi表示第i个视频片段融合后的特征, ei表示与fi有相同维度的权重向量。自注意力机制与注意力机制的区别即权重f(xi)只由输入数据决定,本文采用一个简单的两层全连接神经网络作为对齐方式,反映出X=(x1,x2,…,xn)中各数据的依赖关系,进而计算出xi自身的权重。![]() 表示相应的对齐计算,即:

表示相应的对齐计算,即:

(5)

其中,![]() 和bs为待学习参数。对齐计算可以理解为用一个神经网络学习输入向量不同维度特征值的重要程度。通过SoftMax函数对ei进行归一化后就可以得到fi各维度上特征的权重,并根据权重对fi的特征值进行加权,用公式表示为:

和bs为待学习参数。对齐计算可以理解为用一个神经网络学习输入向量不同维度特征值的重要程度。通过SoftMax函数对ei进行归一化后就可以得到fi各维度上特征的权重,并根据权重对fi的特征值进行加权,用公式表示为:

si=softmax(ei)⊙fi

(6)

si表示用空间注意力加权后的特征,⊙表示向量之间的按元素相乘运算。ei被SoftMax归一化后每个维度的取值范围为0~1,且所有维度的值和为1。用该方法可以得到各个片段的空间注意力加权特征,按上述方法计算手语样本中各片段空间加权特征,就可以得到该样本的空间加权特征序列S=(s1,s2,…,sT),T表示手语视频被分为T个片段。

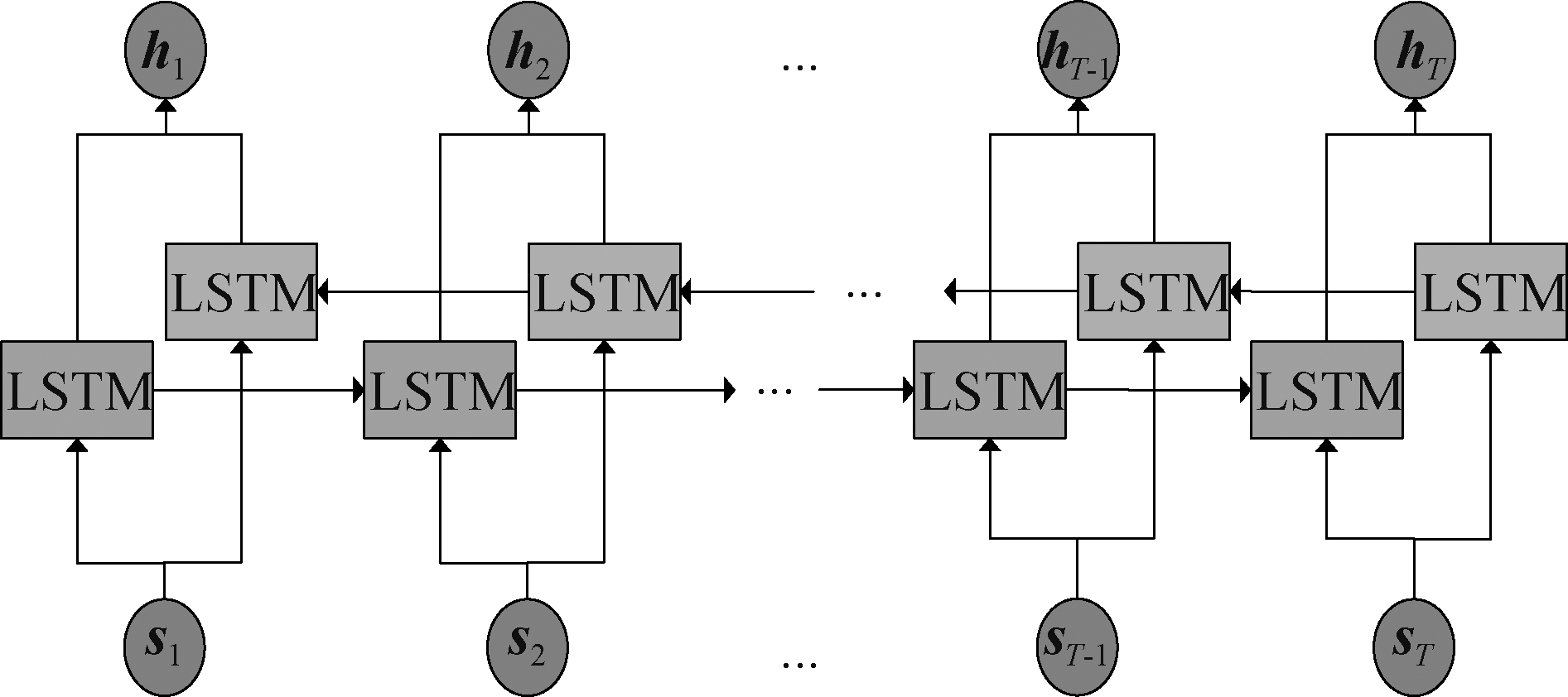

2.3 基于BLSTM的时序建模

本文选用双向长短时记忆网络(BLSTM)[21-22]来对特征融合后的视频片段特征序列进行时序建模和提取长期时空特征。BLSTM的网络结构如图4所示,它由一个前向和一个后向LSTM结合组成。计算方法如式(7):

ft=σ(Wf·[ht-1,xt]+bf)

it=σ(Wi·[ht-1,xt]+bi)

ot=σ(Wo·[ht-1,xt]+bo)

ht=ot*tanh(Ct)

(7)

式中σ表示sigmoid函数,ft、it和ot分别表示遗忘门、输入门、输出门,![]() 代表备选信息,Ct表示细胞状态,xt和ht分别为t时刻的输入和隐藏层的输出。Ct和ot共同决定ht。sigmoid函数把ft、it和ot都限制在0~1,用来描述有可以通过“门”的信息量。输出为0时表示无任何信息通过,输出为1表示全部信息通过。

代表备选信息,Ct表示细胞状态,xt和ht分别为t时刻的输入和隐藏层的输出。Ct和ot共同决定ht。sigmoid函数把ft、it和ot都限制在0~1,用来描述有可以通过“门”的信息量。输出为0时表示无任何信息通过,输出为1表示全部信息通过。

图4 双向长短时期网络模型

Fig.4 Bi-LSTM model

任意时刻t的输入st分别输入到前向和后向LSTM网络中按式(7)计算得到各自的输出,记为![]() 和

和![]() 然后将

然后将![]() 和

和![]() 组合成当前时刻的输出ht,用公式表示为:

组合成当前时刻的输出ht,用公式表示为:

(8)

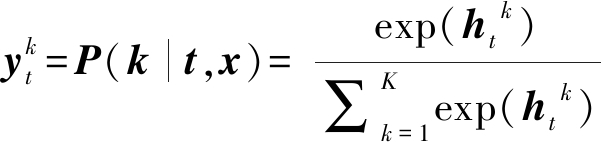

2.4 融合注意力机制和连接时序分类模型

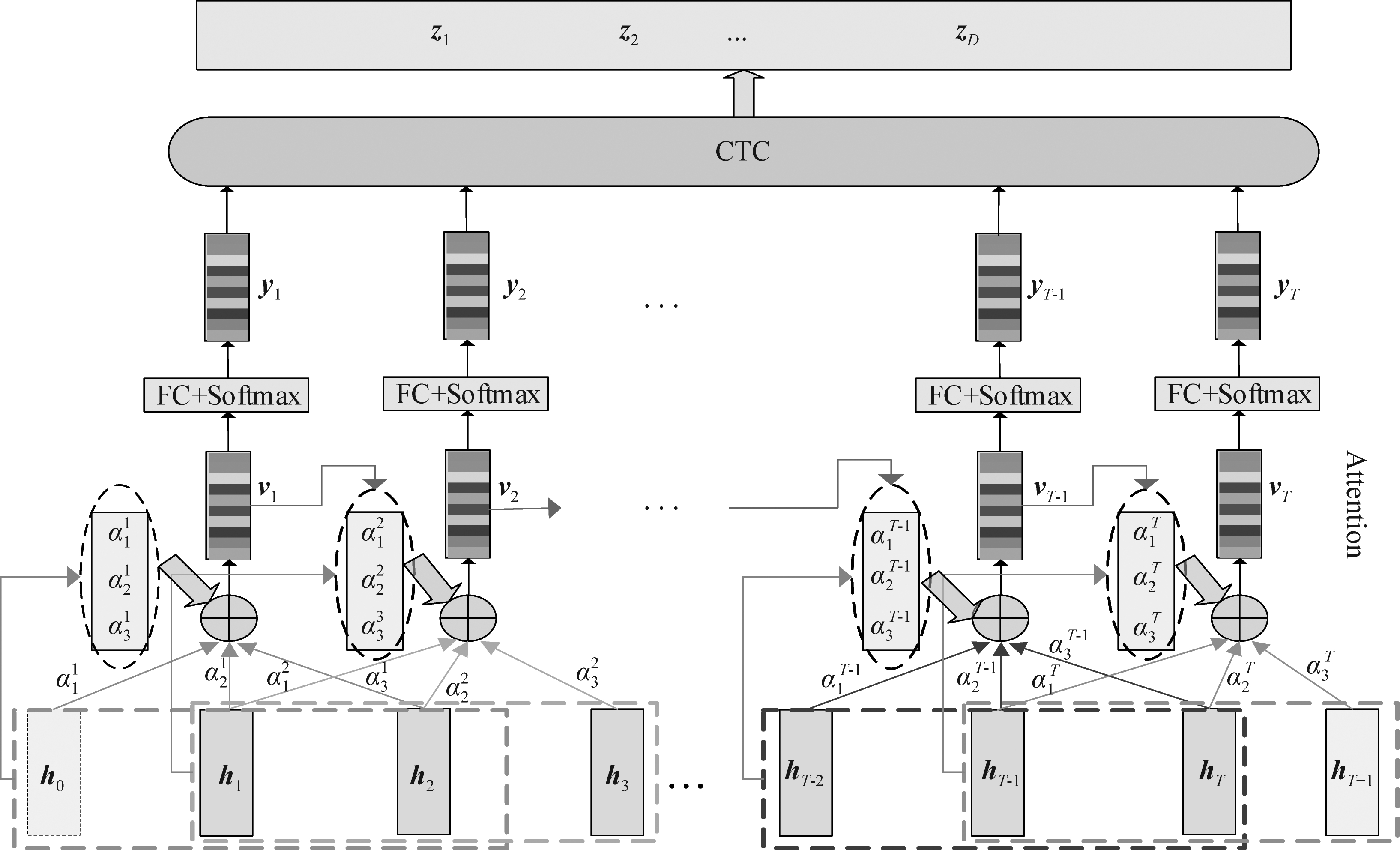

链接时序分类器(CTC)专门为时序分类任务而设计,通常和有时序建模能力的神经网络一起使用,链接时序分类器的训练准则是给定输入序列X=(x1,x2,…,xT),对LSTM内部参数进行调整得到输出标注序列的对数概率的最大值。

CTC网络先将X输入到LSTM,得到对应的隐藏层转台序列H=(h1,h2,…,hT),计算公式如(7)所示t时刻的隐藏层状态可表示为![]() 为对应的SoftMax层输出:

为对应的SoftMax层输出:

(9)

![]() 表示t时刻,输入x对应的输出标签为k的概率值,K为CTC网络输出节点的个数,也即所有标签的个数。然后求得yt的概率分布的最大值选择输出序列。概率分布如式:

表示t时刻,输入x对应的输出标签为k的概率值,K为CTC网络输出节点的个数,也即所有标签的个数。然后求得yt的概率分布的最大值选择输出序列。概率分布如式:

(10)

其中l=(l1,l2,…,lT)为标签序列。CTC损失函数为:

Lctc=-lnP(l|X)

(11)

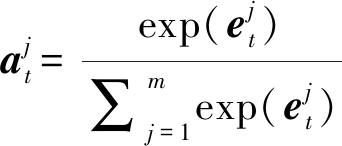

本文采用的融合注意力机制和连接时序分类模型的作用是对编码好的特征序列进行解码,在之前的编码网络中已采用双向长短时间记忆网络对特征序列进行时序建模,通过用注意力机制进一步整合输入特征的方式“强迫”连接时序分类器在解码时关注上下文信息。融合注意力机制和连接时序分类模型的结构如图5所示。

图5 Attention-CTC融合模型结构示意图

Fig.5 Attention-CTC fusion model structure diagram

本模型的输入是整个编码网络编码的特征序列H=(h1,h2,…,hT),先采用注意力机制将特征序列H转换为用相邻特征按重要程度加权求和后的特征序列V=(v1,v2,…,vT)。再采用一个沿特征序列的时间维度移动的滑动窗选取相邻的m个特征向量参与注意力计算,滑动窗的长度为m,滑动步长为1。在计算t时刻的输出特征向量vt时,H中参与计算的m个特征向量以ht为中心,包括ht前后各(m-1)/2 个特征向量。本文根据的长度m在特征序列V的首尾补零向量以保持V和H的长度一致,特征序列首尾补零的数量均为(m-1)/2。m的大小可以根据实际调整,m需为奇数,且满足1<m<T。图5中的示例m=3,因此在特征序列h首尾各补了一个零特征h0和hT+1。本文设计了一种特征重要程度评价方法,通过一个多层感知机根据特征本身(记为hi,i∈[t-(m-1)/2,t+(m-1)/2])和vt-1计算hi对当前时刻解码输出的重要性,用公式表示为:

(12)

式中![]() 和bc是模型待学习的参数。计算得到的

和bc是模型待学习的参数。计算得到的![]() 就是特征hi的重要性,其中j是t时刻用到的m个特征向量的排序,j∈[1,m],i 和j的关系可以表示为:

就是特征hi的重要性,其中j是t时刻用到的m个特征向量的排序,j∈[1,m],i 和j的关系可以表示为:

(13)

m个特征向量ht-(m-1)/2~ht+(m-1)/2对应的重要性评分为![]() 经过SoftMax函数归一化后就可以得到该特征的权重:

经过SoftMax函数归一化后就可以得到该特征的权重:

(14)

其中,![]() 满足

满足![]() 且

且![]() 在得到权重之后,就可以通过加权求和的方式计算上下文向量vt,用公式表示为:

在得到权重之后,就可以通过加权求和的方式计算上下文向量vt,用公式表示为:

(15)

得到上下文特征向量vt后,用一个全连接层将其映射到样本标记空间并用SoftMax函数计算概率分布后得到输出yt,用公式表示为:

yt=softmax(Wzvt+bz)

(16)

其中,![]() 表示网络输出节点的个数,

表示网络输出节点的个数,![]() 表示当前输出判断为词典中元素(手语词)k的概率,Wz和bz是全连接层的网络参数。

表示当前输出判断为词典中元素(手语词)k的概率,Wz和bz是全连接层的网络参数。

训练阶段得到输出序列Y=(y1,y2,…,yT)后,计算损失值和梯度,网络参数使用反向传播算法调整。在预测阶段,分别求出各个时刻的手语词类别后组成手语词序列W=(w1,w2,…,wT),其中:

wt=arg max(yt)

(17)

然后将w输入到CTC中解码,将连续相同的手语词压缩成一个,然后去掉所有的

2.5 基于Attention-CTC的手语识别整体框架

基于Attention-CTC融合模型的连续手语识别框架结构如图6所示,主要包括两个部分,第一部分是用于提取、融合手语数据特征的编码网络,对彩色、深度和手部骨骼点轨迹三种模态的手语数据,使用3D-CNN和基于形状上下文和ResNet相结合的方式对三类数据分别进行特征提取和融合,用空间注意力加权并按时间顺序输入的BLSTM中进行时序建模以获取手语数据的长期时空特征。第二部分是基于Attention-CTC模型的解码网络,首先利用注意力机制对第一部分提取到的手语数据特征进一步整合,从而使整合后的特征包含一定的上下文信息。最后将整合后的特征通过全连接层映射到分类空间并用SoftMax函数归一化后输入到CTC网络中进行训练或解码。

3 实验及结果分析

3.1 实验环境和数据集介绍

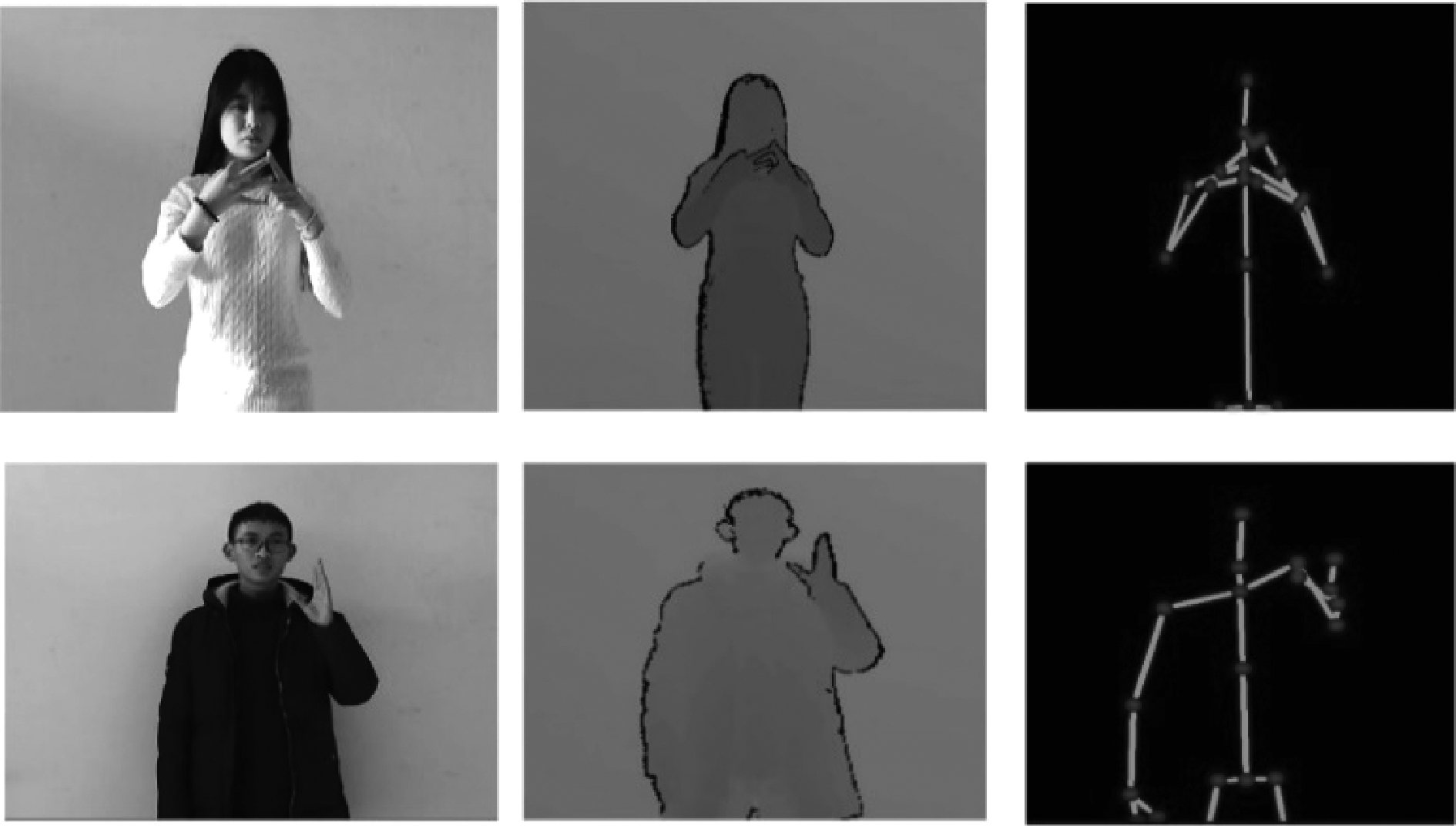

本文使用自行采集的一个中国日常手语数据集,由60个手语词以及30句手语词组成的连续手语语句构成,每个连续手语语句包含2~7个手语词。其中,每类手语词有1440个样本,每类连续手语语句有480个样本,每个手语样本都包含彩色、深度和骨骼点坐标三种数据,数据集中的部分样本如图7所示。随机选择样本的70%为训练集,其余为测试集。

图6 基于Attention-CTC的手语识别模型

Fig.6 Attention-CTC based sign language recognition model

图7 自采集数据集部分样本展示

Fig.7 Self-acquisition data set partial sample display

此外,本文在使用中国日常手语数据集训练手语识别模型之前,先用IsoGD (ChaLearn Looking At People Isolate Gesture Dataset)[23]数据集对模型中的各个主要网络进行预训练。IsoGD数据集样本如图8所示。

图8 IsoGD数据集样本展示

Fig.8 Sample display in IsoGD dataset

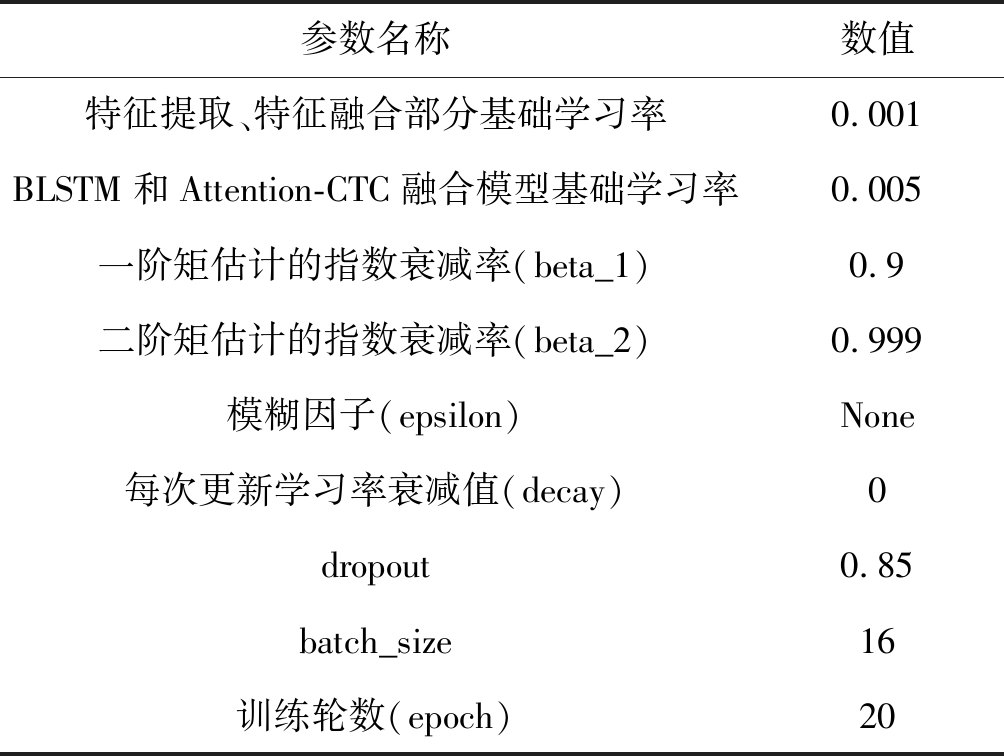

3.2 训练

本文输入数据为Kinect V2同步采集手语数据中的彩色视频、深度视频和手部骨骼点轨迹信息,在训练阶段需要保证输入序列有相同的长度,采用求均值及补位的方法将手语数据采样至N。根据所用3D-CNN的网络结构,把手语样本中的三类数据用一个滑动窗沿时间维度滑动的方法分别分成若干个片段,滑动窗的长度设置为8,这样每个片段就包含8帧数据,手语样本固定序列长度N也需要设置为8的整数倍。

本文采用分阶段的方式训练该模型。第一阶段训练注意力机制的手语识别模型,采用“先部分后整体”的训练策略:先分别训练模型中的3D-CNN、ResNet、空间注意力机制、特征融合等部分组成的编码网络,然后将整个模型融合起来训练。

其中,在分别训练两路3D-CNN时,引入迁移学习[24]的思想,先用IsoGD预训练3D-CNN,首先将IsoGD数据集中的彩色视频和深度视频都按照上述方法分为多个片段,同一个类别的视频划分出来的不同视频片段有相同的标签,将数据集中样本的标签编码成one-hot形式,再将这些带标签的视频片段输入到对应的3D-CNN中训练。最后使用中国日常手语数据集分别对两路3D-CNN进行微调,微调的方法和用IsoGD数据集训练相同。对于用于提取手部轨迹特征的ResNet网络,由于IsoGD数据集中仅有彩色图像和深度图像,采用中国日常手语数据集中的骨骼点坐标数据,按照本文2.1节所述的方法分片段求解形状上下文特征矩阵后直接训练即可。

第二阶段重点训练空间注意力模型,再在第一阶段模型的基础上加入空间注意力机制,将空间注意力加权后的特征求均值后输入到BLSTM网络,隐藏层节点数均设置为512,则其前向和后向隐藏层拼接后得到的输出状态ht为1024维,经全连接层映射后的模型输出为61维(词典大小),即yt为61维。第三阶段即在第二阶段模型的基础上再加入Attention-CTC融合模型并对整个网络进行端到端的训练,本文采用的梯度下降算法是Adam[25],训练参数的参数设置如表2所示。

表2 连续手语识别模型训练参数设置

Tab.2 Continuous sign language recognition model training parameter setting

参数名称数值特征提取、特征融合部分基础学习率0.001BLSTM和Attention-CTC融合模型基础学习率0.005一阶矩估计的指数衰减率(beta_1)0.9二阶矩估计的指数衰减率(beta_2)0.999模糊因子(epsilon)None每次更新学习率衰减值(decay)0dropout0.85batch_size16训练轮数(epoch)20

3.3 衡量指标

在本数据集中,一个手语语句由2~7个手语词组成,模型的输出结果与实际标签相比,存在多词、少词、替换三种情况的误差。例如:一个手语语句样本的标签为“很高兴认识你”,模型的输出可能为“很高兴能认识你”、“很高兴认识”、“很失望见到你”,这就是一种替换错误。考虑到识别结果的各种错误情况,参照文献[18]的标准,本文衡量识别准确率的标准如下:

accuracy= ![]()

(18)

其中,WordNum为实际标签中的手语词数,InsertNum表示模型输出的多余手语词数, FalseNum 是错误识别的手语词数,DelNum表示识别结果中缺少的手语词数。

3.4 分析与讨论

本文基于上述数据集和参数设置完成相关实验,并且通过不同角度进行对比实验。

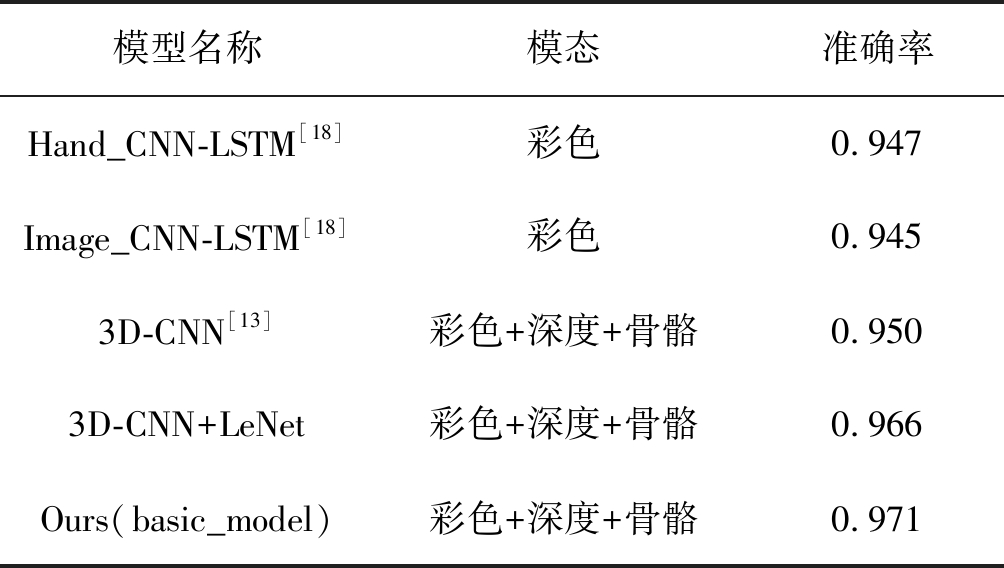

(1)不同特征提取方式

本文使用第一阶段训练好的3D-CNN、ResNet和特征融合模型,并移除模型中的注意力机制以及解码模块,使用LSTM对输出的多模态融合短期特征进行时序建模,对动态手语短词汇进行识别,设此模型为基础模型,具体参数设置与表2一致。并对比几种常见的手语识别模型,表3为对比结果。

表3 基础模型与其他手语词识别算法模型准确率

Tab.3 Accuracy of each sign language recognition algorithm

模型名称模态准确率Hand_CNN-LSTM[18]彩色0.947Image_CNN-LSTM[18]彩色0.9453D-CNN[13]彩色+深度+骨骼0.9503D-CNN+LeNet彩色+深度+骨骼0.966Ours(basic_model)彩色+深度+骨骼0.971

其中Hand_CNN-LSTM将彩色视频的手部区域分割出来后使用VGG-16提取特征,比相同网络仅输入原始彩色视频的Image_CNN-LSTM识别结果高出0.02,本文所提出的基础框架,将彩色与深度视频输入到3D-CNN,骨骼点轨迹特征通过形状上下文与ResNet结合的方式提取,准确率比三流均用3D-CNN的方法提升了0.16,比骨骼点轨迹特征使用形状上下文与LeNet网络结合提取提升了0.05。

(2)不同连续手语识别模型

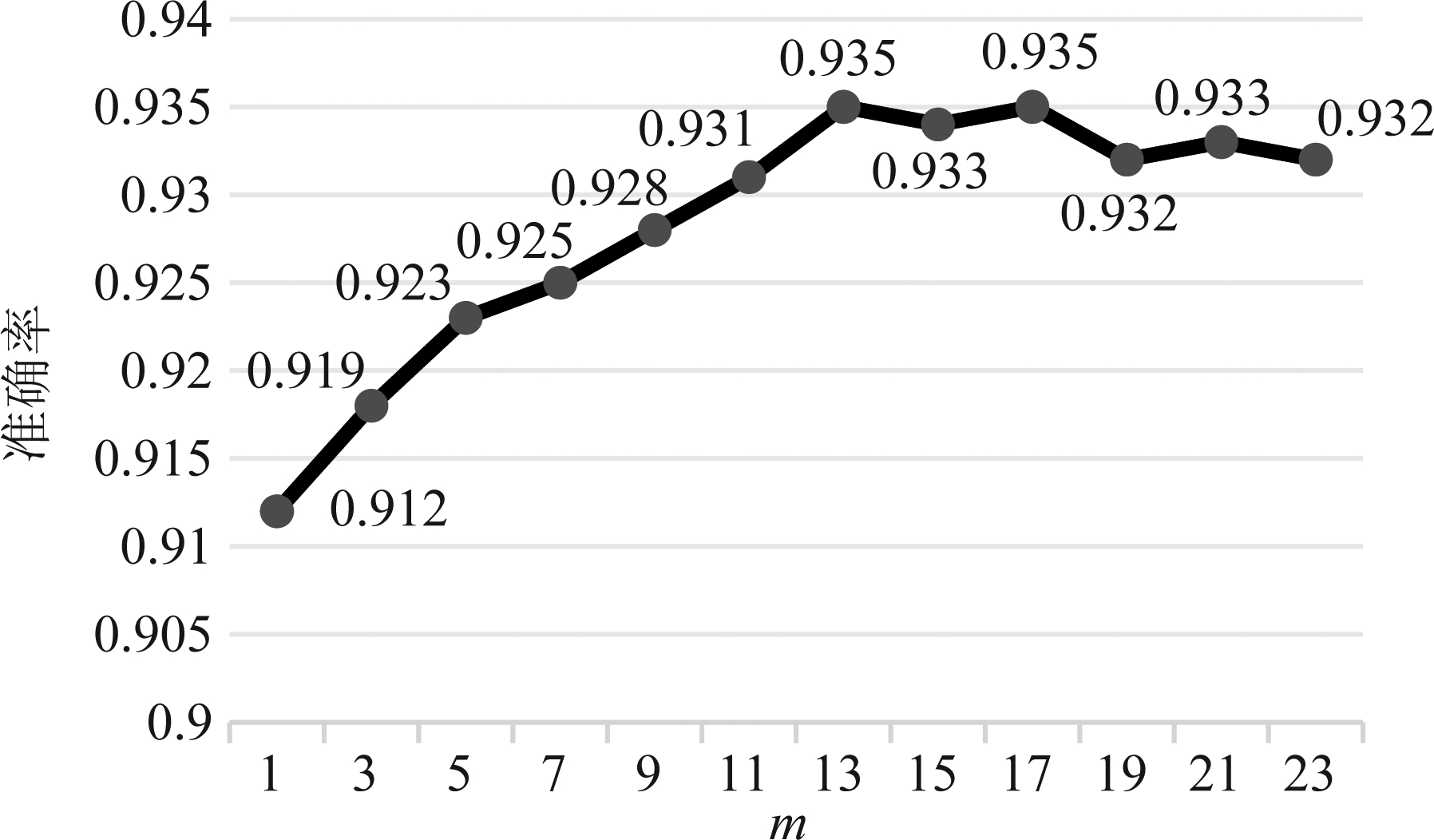

第二阶段的实验首先选取合适的滑动窗长度m,即可以使模型准确率最高的相邻片段数量。不同的m取值对应的模型识别结果如图9所示,X轴是m取值,Y轴为准确率。从图中可以看出, m<13 时,识别准确率随m的增长而增长,当m>13,模型的准确率停止增长并出现微降的情况,说明距离解码时刻较近的上下文特征对解码准确率帮助较大。与没有注意力机制相比(m=1),在CTC引入注意力机制(m>1)后,模型的准确率有不同程度的提高,从而证明了在CTC中引入注意力机制的有效性。

图9 模型准确率关于m的变化曲线

Fig.9 Model accuracy rate curve with respect to m

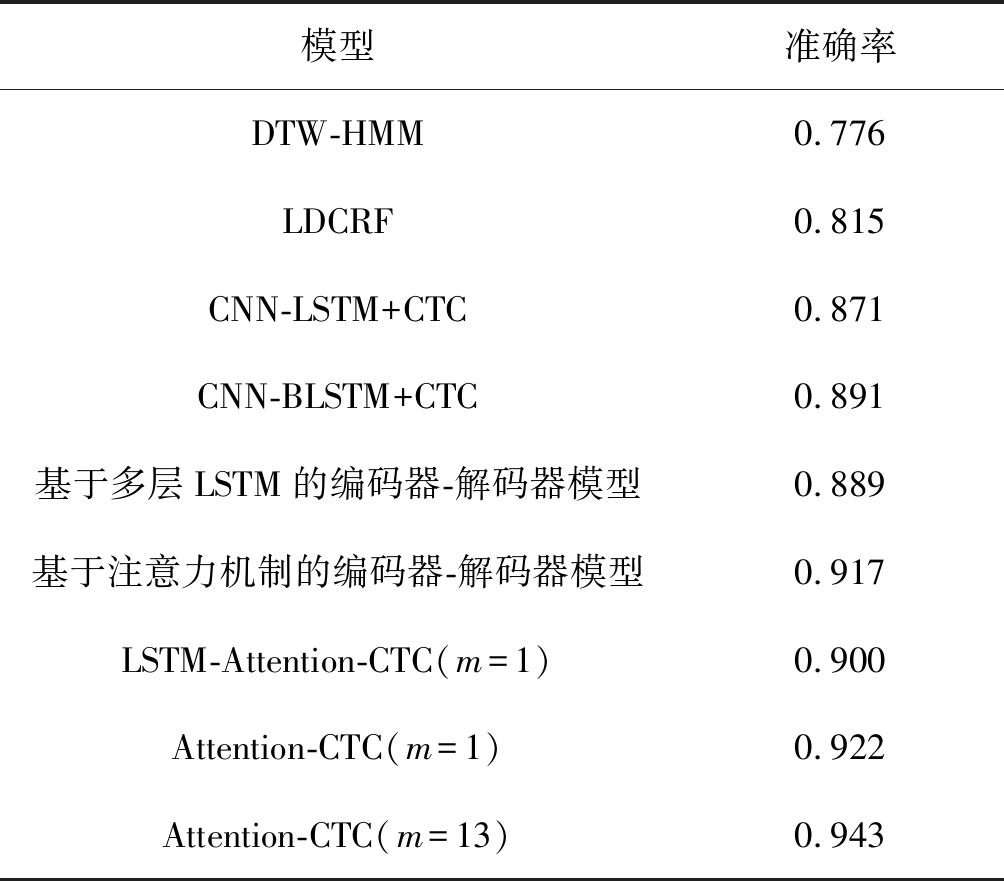

当m=13,即模型最优时,迭代了近60000次后模型趋于收敛。本文与经典的连续手语识别模型进行对比,其中包括动态时间规整-隐马尔可夫模型(DTW-HMM)[26]、潜在动态条件随机场(LDCRF)[27];基于CTC的CNN-LSTM网络[28-29]、基于多层LSTM的编-解码器框架[30]、基于注意力机制的编-解码器模型,各个模型在我们采集连续手语数据集上的识别结果如表4所示。其中Attention-CTC(m=1)和Attention-CTC(m=13)分别为本模型m=1和m=13时构成的具体框架,LSTM-Attention-CTC(m=1)是将Attention-CTC(m=1)的BLSTM换成LSTM形成的识别模型。

从识别结果来看,传统的分割后识别的方法(DTW-HMM和LDCRF)准确率都偏低,可以看出传统的识别方法在分割阶段容易出错,从而影响了识别结果。

表4 各模型连续手语识别结果

Tab.4 Continuous sign language recognition results of each model

模型准确率DTW-HMM0.776LDCRF0.815CNN-LSTM+CTC0.871CNN-BLSTM+CTC0.891基于多层LSTM的编码器-解码器模型0.889基于注意力机制的编码器-解码器模型0.917LSTM-Attention-CTC(m=1)0.900Attention-CTC(m=1)0.922Attention-CTC(m=13)0.943

CNN-LSTM+CTC比CNN-BLSTM+CTC的准确率高出0.02,以及从LSTM-Attention-CTC(m=1)和Attention-CTC(m=1)的准确率对比结果也可以看出,即使CTC存在条件独立性假设的缺陷,但BLSTM在时序建模时能够在一定程度上利用上下文信息提高识别准确率。而本文所用的Attention-CTC(m=1)在特征提取阶段使用了分片段多模态长短期时空特征融合的方法,准确率比CNN-BLSTM+CTC提高了0.031,证明多模态长短期时空特征融合方法的有效性。

实验中本文采用与Attention-CTC模型相同的分片段多模态长短期时空特征融合的方法对基于多层LSTM的编-解码器模型和基于注意力机制的编-解码器模型进行特征提取。从识别结果来看,基于注意力机制的编-解码器模型的识别效果优于基于多层LSTM的编-解码器模型,且稍好于本文提出的Attention-CTC(m=1),可见注意力机制对识别准确率的影响较大。而本文提出的Attention-CTC(m=13)的准确率比基于注意力机制的编-解码器模型提高了0.026,可见本模型可以使用CTC在一定程度上限制编-解码器模型的灵活性,从而减少输入序列和标签序列的不规则对齐现象,通过对比实验可见本文提出的Attention-CTC(m=13)是所有模型中效果最好的。

4 结论

根据手势复杂多变,手语信息冗杂性以及手语序列与标签序列对齐等手语识别中的难点,本文提出一种融合注意力机制和连接时序分类的多模态手语语句识别模型,先通过3D-CNN提取彩色和深度视频片段的短期时空特征,同时使用形状上下文和ResNet结合的方式提取短期手部运动轨迹特征,将三种模态的特征融合后通过空间注意力加权求和,输入到BLSTM中进行时序建模获取长期时空特征,最后利用注意力机制和连接时序分类融合模型的解码网络以端到端的方式实现连续手语的准确识别。本模型先在IsoGD数据集上进行预训练,在自行采集的中国手语数据集上进行测试,得到了0.935的准确率,通过与经典的手语识别模型进行对比,取得了较好的效果。

[1] Starner T, Weaver J, Pentland A. Real-time American sign language recognition using desk and wearable computer based video[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20(12): 1371-1375.

[2] Lee C, Xu Y. Online, interactive learning of gestures for human/robot interfaces[C]∥Proceedings of IEEE International Conference on Robotics and Automation. IEEE, 2002, 4: 2982-2987.

[3] Ji S, Xu W, Yang M, et al. 3D Convolutional Neural Networks for Human Action Recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(1): 221-231.

[4] Liu T, Zhou W, Li H. Sign language recognition with long short-term memory[C]∥2016 IEEE International Conference on Image Processing (ICIP). IEEE, 2016: 2871-2875.

[5] 冯天艺, 杨震. 采用多任务学习和循环神经网络的语音情感识别算法[J]. 信号处理, 2019, 35(7): 1134-1140.

Feng Tianyi, Yang Zhen. Speech Emotion Recognition Algorithm Based on Multi Task Learning and Recurrent Neural Network[J]. Journal of Signal Processing, 2019, 35(7): 1134-1140.(in Chinese)

[6] Dahl G E, Yu D, Deng L, et al. Context-Dependent Pre-Trained Deep Neural Networks for Large-Vocabulary Speech Recognition[J]. IEEE Transactions on Audio, Speech and Language Processing, 2012, 20(1): 30- 42.

[7] Chai X, Liu Z, Yin F, et al. Two streams recurrent neural networks for large-scale Continuous gesture recognition[C]∥∥23rd International Conference on Pattern Recognition (ICPR), 2016: 31-36.

[8] Ameen S, Vadera S. A convolutional neural network to classify American Sign Language fingerspelling from depth and colour images[J]. Expert Systems, 2017: e12197.

[9] Li S Z, Yu B, Wu W, et al. Feature learning based on SAE-PCA network for human gesture recognition in RGBDimages[J]. Neurocomputing, 2015, 151(151): 565-573.

[10]Koller O, Ney H, Bowden R. Deep Hand: How to Train a CNN on 1 Million Hand Images When Your Data is Continuous and Weakly Labelled[C]∥Computer Vision & Pattern Recognition. IEEE, 2016: 3793-3802.

[11]Pigou L, Dieleman S, Kindermans P J, et al. Sign Language Recognition Using Convolutional Neural Networks[C]∥Workshop at the European Conference on Computer Vision. Springer International Publishing, 2015.

[12]Zhang Z. Microsoft Kinect Sensor and Its Effect[J]. IEEE Multimedia, 2012, 19(2): 4-10.

[13]Huang J, Zhou W, Li H, et al. Sign Language Recognition using 3D convolutional neural networks[C]∥2015 IEEE International Conference on Multimedia and Expo (ICME). IEEE, 2015: 1- 6.

[14]Hu Z X, Hu Y M, Liu J, et al. 3D Separable Convolutional Neural Network for Dynamic Hand GestureRecognition[J]. Neurocomputing, 2018: S0925231218309925-.

[15]Pu J, Zhou W, Li H. Sign Language Recognition with Multi-modal Features[C]∥Pacific Rim Conference on Multimedia. Springer International Publishing, 2016: 252-261.

[16]Belongie S, Malik J, Puzicha J. Shape matching and object recognition using shape contexts[C]∥IEEE International Conference on Computer Science & Information Technology. IEEE, 2010: 471- 474.

[17]He K, Zhang X, Ren S, et al. Deep Residual Learning for Image Recognition[C]∥IEEE Conference on Computer Vision & Pattern Recognition. IEEE Computer Society, 2016.

[18]毛晨思. 基于卷积网络和长短时记忆网络的中国手语词识别方法研究[D]. 中国科学技术大学, 2018.

Mao Chensi. Chinese Sign Language Recognition based on Convolutional Network and Long Short Term Memory Network[D]. University of Science and Technology of China, 2018.(in Chinese)

[19]Bahdanau D, Chorowski J, Serdyuk D, et al. End-to-End Attention-based Large Vocabulary Speech Recognition[J]. Computer Science, 2016: 4945- 4949.

[20]Watanabe S, Hori T, Kim S, et al. Hybrid CTC/Attention Architecture for End-to-End Speech Recognition[J]. IEEE Journal of Selected Topics in Signal Processing, 2017, 11(8): 1240-1253.

[21]Liu Q, Zhou F, Hang R, et al. Bidirectional-Convolutional LSTM Based Spectral-Spatial Feature Learning for Hyperspectral Image Classification[J]. Remote Sensing, 2017, 9(12): 1330-1347.

[22]邱意, 贾桂敏, 杨金锋, 等. 民航陆空通话语音识别BiLSTM网络模型[J]. 信号处理, 2019, 35(2): 139-146.

Qiu Yi, Jia Guimin, Yang Jinfeng, et al. Speech Recognition Model of Civil Aviation Radiotelephony Communication Based on BiLSTM[J]. Journal of Signal Processing, 2019, 35(2): 139-146.(in Chinese)

[23]Wan J, Li S Z, Zhao Y, et al. ChaLearn Looking at People RGB-D Isolated and Continuous Datasets for Gesture Recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). IEEE, 2016: 761-769.

[24]Pan S J, Yang Q. A Survey on Transfer Learning[J]. IEEE Transactions on Knowledge & Data Engineering, 2010, 22(10): 1345-1359.

[25]Kingma D, Jimmy B. Adam: A method for stochastic optimization[J]. arXiv preprint arXiv:1412.6980, 2014.

[26]Zhang J H, Zhou W G, Li H Q. A Threshold-based HMM-DTW Approach for Continuous Sign Language Recognition[J]. ACM International Conference Proceeding Series, (2014): 237-240.

[27]Morency L P, Quattoni A, Darrell T. Latent-Dynamic Discriminative Models for Continuous Gesture Recognition[J]. IEEE Conference on Computer Vision and Pattern Recognition, 2007: 2526-2533.

[28]Cui R, Liu H, Zhang C. Recurrent Convolutional Neural Networks for Continuous Sign Language Recognition by Staged Optimization[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2017: 1610-1618.

[29]Camgoz N C, Hadfield S, Koller O, et al. SubUNets: End-to-End Hand Shape and Continuous Sign Language Recognition[C]∥IEEE International Conference on Computer Vision (ICCV), 2017. IEEE, 2017: 3075-3084.

[30]Guo D, Zhou W G, Li H Q, et al. Hierarchical lstm for sign language translation[C]∥AAAI Conference on Artificial Intelligence. 2018: 6845- 6852.