1 引言

目前,基于视频的动作识别是计算机视觉与多媒体信息处理领域的热门研究方向之一,在许多场合有着重要的应用,例如智能交互、视频监控、医疗健康等。尽管近年来学者与科研人员都对其进行广泛的研究[1- 4],但基于视频的动作识别仍然面临着众多的挑战。例如,动作场景的复杂性、动作视频内的差异性、动作类别之间的相似性等等。

随着大数据时代的不断发展,越来越多模态的视频被用于人体动作识别。例如:RGB、光流、深度(Depth)、红外、骨骼等数据。近年来,基于RGB视频的人体动作识别得到了广泛的研究,但是RGB数据存在对颜色、光照、视点等变化敏感的缺点,导致其在复杂动作识别的表现不好。消费级的深度传感器的普及,也使深度数据被大范围地用于复杂动作识别。相较于RGB模态,深度模态对这些变化不敏感。Zhang[4]等人使用多流的神经网络联合属性学习器来学习动作属性间的语义信息。Wang[6]等人提出从深度图中获取三种深度序列表示,捕获动作的时空特征。Sahoo[7]等人通过动作帧估计深度图来提取深度历史图,同时联合深度图的3D投影来进行动作识别。这些方法都是用了深度数据所提供的空间信息,但是动作的时间信息却没有被充分利用。此外,融合RGB与Depth模态的基于手工特征提取的传统动作识别算法[8-10]的研究结果表明,RGB融合深度数据能够减少背景影响,多模态信息互补能够整体上提升动作的识别率。特别地,多模态信息融合对于解决相似性动作的误判问题有很好的效果。但是传统的RGB与Depth融合依赖于人工设计的特征。

双流网络是基于卷积神经网络的动作识别方法,也是近些年来人体动作识别效果最好的方法之一。Simonyan[11]等人提出联合时间与空间的双流网络,时间网络与空间网络使用相同的卷积神经网络,分别处理单帧RGB和堆叠的连续几帧光流。为了解决双流网络无法利用视频长时间信息的缺点,Wang[12]等人提出一种长时间建模的时间分割网络(TSN)。然而,传统双流网络仅利用RGB视频数据以及从RGB中提取的光流数据,未能利用更多模态的数据(如深度数据)形成更多信息的互补融合。此外,传统双流网络在时间和空间流上所用的深度神经网络模型相同,而人体动作的时间与空间特征存在较大区别,需要根据时间流和空间流数据的特征分别寻找适合的网络模型进行分析处理。

本文针对以上问题,提出一种基于异构多流网络的多模态动作识别模型。该模型使用RGB和深度(Depth)传感器获取的视频数据,以及由RGB提取的RGB光流(Rflow)和从深度视频提取的深度光流(Dflow)共四路数据流作为网络输入,使用TSN模型中均匀时间分割策略进行视频帧分割采样,并且分别选取ResNeXt[13]和BN-Inception[14]作为空间和时间流数据的特征提取和识别网络,从而形成4路数据流的时空异构多流网络,最后通过加权融合的方式对识别结果进行融合。通过在相似性动作较多的大型数据集NTU RGB+D[15]上进行实验结果表明,多模态多流异构信息融合能较好提高动作识别准确率,对相似性动作产生的误判有较大的改善作用。下面首先介绍深度光流的提取方法,然后详细介绍异构多流网络的构成和基于TSN的视频帧数据抽取及长时间范围建模,最后给出实验结果和分析。

2 异构多流网络的多模态动作识别

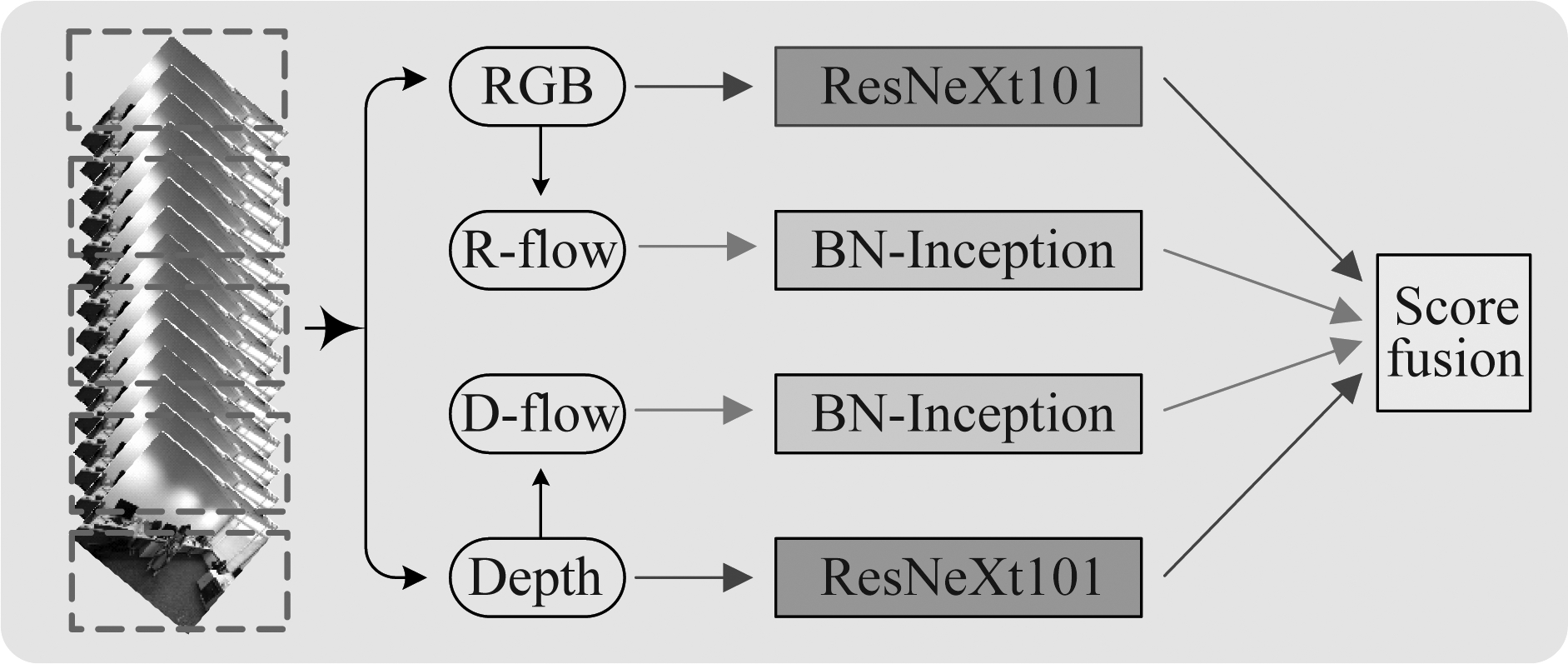

本文提出的多模态异构多流网络模型的结构如图1所示。对于给定的动作视频,将其均匀分段(本文将视频分为5段),抽取视频帧送入异构网络进行特征提取与分类,最后进行多模态的融合。本节首先给出深度光流的提取方法,然后介绍用于多模态融合的异构多流网络,最后给出本文处理视频的长时间建模方法。

图1 基于异构多流网络的多模融合模型

Fig.1 Multimodal fusion model based on heterogeneous networks

2.1 深度光流的提取

现有的基于深度视频的动作识别方法一般是通过从深度视频中获取物体定位,并提取运动历史图或者骨骼点信息作为动作特征进行识别。这样的操作更多利用深度数据中动作的空间信息,而缺乏对动作时间信息的利用。考虑到传统的从RGB数据提取光流的方法是先将RGB图像灰度化,然后使用光流提取算法从灰度图中提取光流。受到此启发,结合深度数据(也称Depth模态数据)的特征,本文提出一种从深度视频数据中提取深度光流的方法。

众所周知,深度视频帧的每个像素值代表的是物体距离深度传感器的距离,反映了目标的空间信息。通过对NTU RGB+D[15]数据集的分析,我们发现数据集深度图中大部分区域的像素值为0,仅产生动作的人周边有像素值变化。在运动目标检测过程中为了将运动目标检测出来常进行二值化操作,与此类似本文为了方便地从深度视频中获取深度光流信息,降低计算复杂度,首先我们将深度视频帧进行如式(1)所示的二值化操作:

(1)

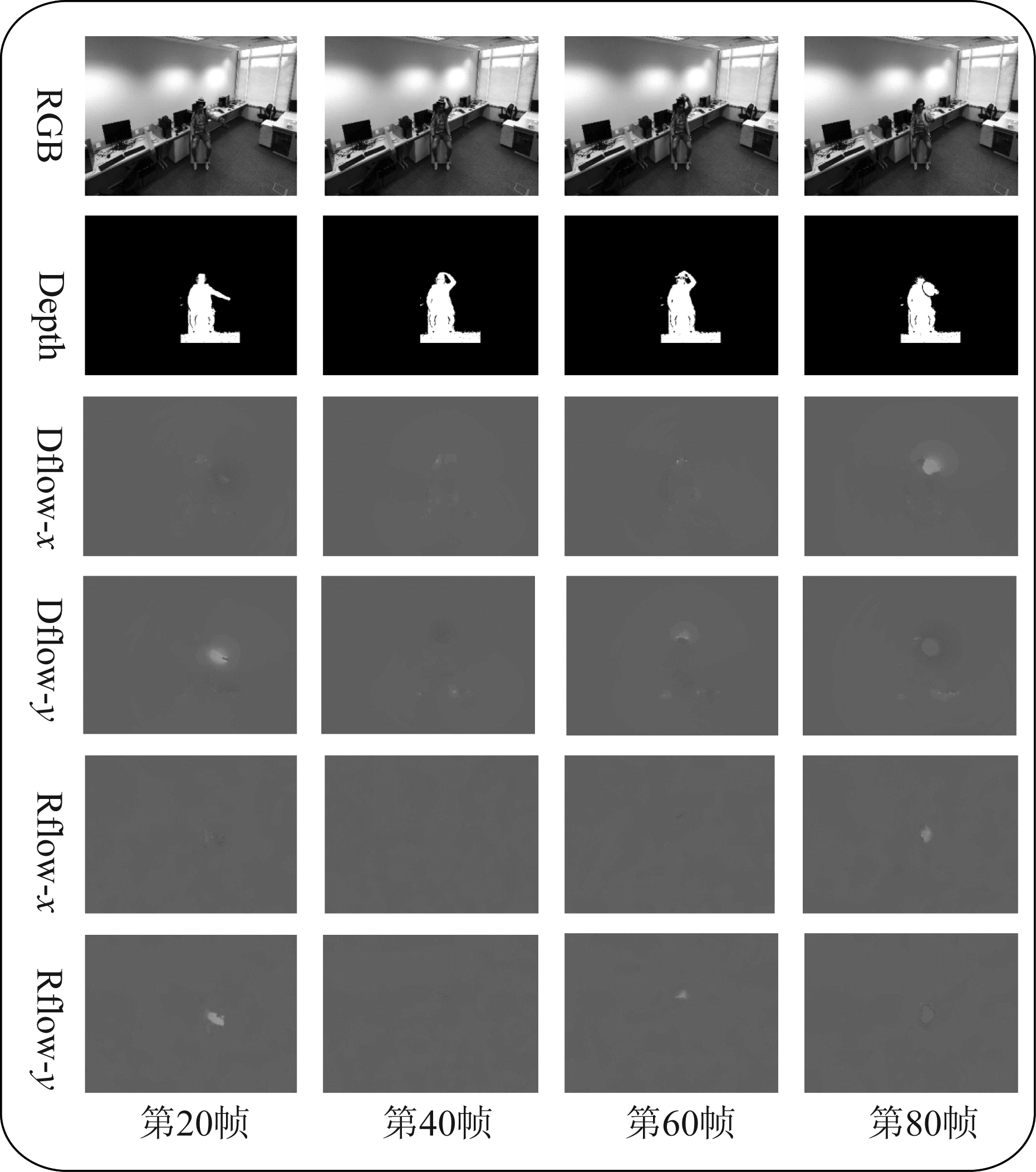

将深度视频二值化后便可以进行光流信息的提取。光流的提取方法有很多,这里我们采用文献[16]中所给出的TV-L1光流提取法。本文将RGB中提取的光流记为Rflow,Depth中提取的光流记为Dflow。以动作摘帽子为例,图2列出了该动作的RGB、Depth二值化、Rflow、Dflow四种数据的部分帧示意图,为了更清晰地展示,将两种光流的图像进行了伪彩色处理。图中可以看出,Dflow与Rflow在x、y方向上有些相似,实验结果也证实了Dflow在动作识别上的有效性。

图2 多模态动作视频部分帧示意图

Fig.2 A schematic diagram of multimodal action video frames

2.2 异构的多流网络

通常情况下,人们理解视频中动作的方式有两种,一种是通过视频帧提取空间信息,另一种是通过视频帧前后关系获取时间信息。基于此, Simonyan[11]等人提出了双流网络,即使用时间网络与空间网络来进行视频动作的识别。时间网络用来提取视频中的运动信息,空间网络获取物体的位置、形态以及结构等信息。大多数基于双流的方法对于空间与时间网络都采用相同的卷积神经网络框架,但是人类对目标形状与运动的观察与识别是两个截然不同的过程,因此本文采用时间与空间网络不同的卷积架构作为多流网络的基础架构。

下面针对相似性动作容易产生误判与多模信息利用不充分的问题,给出一种基于异构多流网络的多模态融合模型。该模型(如图1所示)分为三部分:视频分割、异构卷积神经网络、多模加权融合。对于视频分割部分,我们使用时间均匀分割策略对视频的长范围时间结构进行建模。在异构卷积神经网络部分,我们选取不同的卷积神经网络对时空数据流进行处理。大量的研究[17-18]表明,具有更多层数的卷积神经网络能够提取更多特征和高级语义信息。然而,随着BN-Inception[14]网络卷积层数的增加,网络性能可能下降,并且可能出现梯度消失和梯度爆炸的问题,这限制了BN-Inception的应用。He[17]等人提出的ResNet解决了网络退化和梯度消失的问题,可以使网络不断深化。Xie[13]等人提出了一种基于ResNet的ResNeXt网络。在相同的卷积层数下,ResNeXt比ResNet具有更好的性能与更少的参数。因此,本文通过实验选取ResNeXt网络作为两个空间卷积网络的基础架构,选取BN-Inception作为两个时间网络的基础架构。空间流网络分别单独处理RGB与Depth数据,时间流网络则分别单独处理RGB光流与Depth光流数据。这样,本文的异构多流网络实际上是对2种传感器(分别是普通RGB摄像头和深度摄像头)分别获得的RGB和深度数据,以及在此基础上提取的光流Rflow和Dflow数据进行融合。RGB、深度和光流数据(包含Rflow和Dflow)在本文中称之为三种模态的数据,RGB和深度模态的数据包含了动作的空间上的特征或者信息,而光流模态数据包含了动作的时间上的特征或信息。在多模加权融合部分,各模态视频数据送入各自训练好的网络中得到动作分类得分后,我们给每个模态的动作分类得分赋予一定的加权系数,进行多模态数据分类结果的加权融合。我们通过遍历搜索得到最优的加权系数。

使用多模态融合的异构多流网络进行动作识别的主要优势有二,第一:异构网络在进行多模融合时能够有效地减少冗余信息,提高网络的利用率;第二:多模态的特征存在互补性,对于相似性动作可以明显地减少误判。本文也通过后面的大量实验验证了多流网络采用异构模型相对比同构模型的优势。

2.3 长范围时间结构建模

对于传统的基于卷积神经网络的视频动作识别,通常将一帧视频帧或者堆叠的连续几帧视频帧作为整体输入卷积神经网络,这样将很难利用视频的长时间范围的信息。而现有的研究表明,视频的长时间范围信息对于视频动作的识别率有很大的影响。受TSN网络的时间分割方法的启发,本文采用时间分割策略来实现对整个动作的RGB、Depth和光流视频的时间结构建模。

以空间网络为例,对于给定的视频ν,我们先按照时间长度将其平均分为k段,用{ν1,...,νk}表示,然后从每段中随机抽取1帧,将k段的抽取结果组成短片段{s1,...,sk}(时间网络视频数据分段及抽取方式与此类似,只是在每段中抽取的不是1帧,而是连续5帧的光流)。将短片段中的si送入双流网络中得到该片段的动作分类得分。然后使用均值融合将短片段中s1到sk的动作类别得分进行融合。最后,基于融合结果,使用Softmax函数获取整个视频属于每个类别的概率。计算过程可由下式表示;

(2)

其中,F(si;W)表示参数为W的网络模型函数,该函数返回的是短片段si经过网络计算后得到的初始动作分类得分。M表示的是均值融合函数。S表示的是Softmax函数。这里对于M函数融合结果的损失函数定义如下:

(3)

其中,yi∈{0,1}表示的是第i类动作的真实标签值,n表示的是数据集的动作总类别数。mi表示第i类动作的预测得分,其通过均值融合函数M计算得到。误差反向传播时,可以推出损失函数L相对于网络参数W的梯度为:

(4)

模型训练过程中,将分割好的视频数据送入相应网络模型,并使用k个片段融合的结果通过误差反向传播可以更新优化网络参数,从而学习得到视频级别的网络参数值。模型训练结束后测试过程中,同样通过这种视频分割加异构多流网络分类识别的方式,将抽取的视频帧送入到异构网络之中,便可以得到视频级动作识别的效果。

3 实验分析

本节先介绍实验所用到的数据集,然后给出本文所提模型的训练与测试过程,最后验证所提方法的有效性,并与现有方法进行了比较。实验使用的硬件平台包括一个英特尔E5-2620 v4 CPU和2块英伟达Tesla k80 GPU,软件平台包括python开发环境和pytorch平台。

3.1 数据集

我们在NTU RGB+D[15]数据集上对所提算法进行了验证。NTU RGB+D数据集由Microsoft Kinect v2传感器所提供的RGB模态,Depth模态,3D骨骼模态和红外视频模态数据组成。我们仅使用了数据集中的RGB与Depth模态数据。

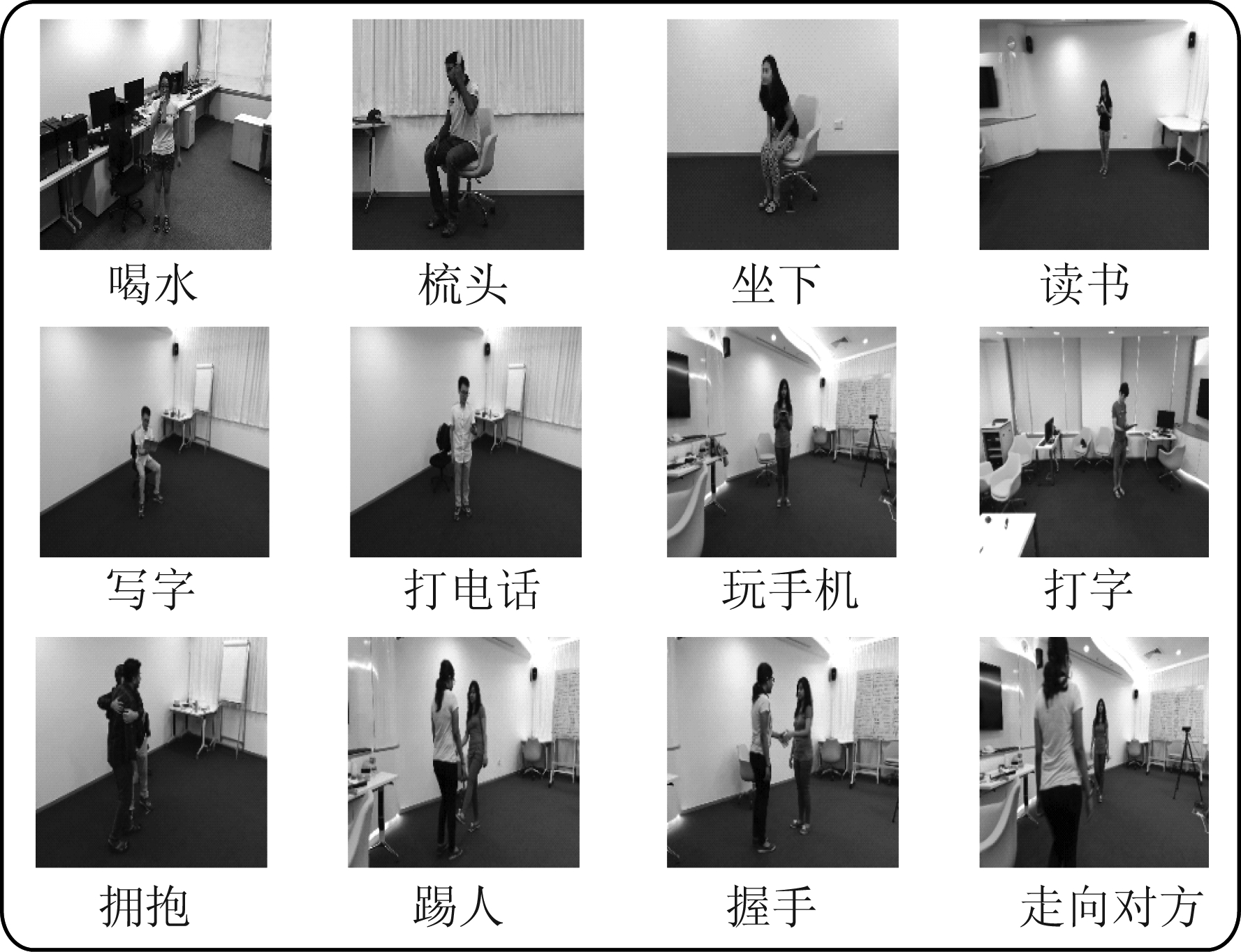

图3 NTU RGB+D部分动作示意图

Fig.3 Schematic diagram of some actions of the NTU RGB+D dataset

图3列出了NTU RGB+D数据的部分动作片段, 其中包含了数据集中比较难以区分的高度相似的动作:写字、读书、打电话、玩手机等。数据集是由40个不同实验者所获取的60类动作,其中有40类日常行为动作(玩手机、脱鞋和戴眼镜等),9种人类健康相关的动作(打喷嚏,呕吐和抚摸背部等),以及11种人与人之间的动作(踢、拥抱和握手等),共计56880个样本数据。实验中遵循文献[15]提供的cross-subject评估协议,将数据集划分为训练集和测试集。训练集与测试集分别包含20个不同实验者的数据,实验者编号1、2、4、5、8、9、13、14、15、16、17、18、19、25、27、28、31、34、35和38的数据用于训练,其余实验者的数据用于测试。

3.2 实验设置

预训练策略:大量的研究表明,使用在Imagenet[19]上进行预训练的网络参数可以加速卷积网络的收敛,提高卷积网络的识别率。本文使用在Imagenet上预训练的ResNeXt[13]与BN-Inception[14]网络参数去初始化所提出的异构多流网络。对于RGB模态数据,由于在Imagenet上预训练的模型第一个卷积层Conv1的卷积核尺寸为(64,3,7,7),卷积核是三通道的,所以可以直接使用预训练模型初始化RGB流网络的权重。但是对于Depth模态与两种光流模态的数据,由于它们的通道数不为3,所以需要对预训练模型的第一个卷积层Conv1的参数进行预处理。Depth数据是一通道的,可以将Conv1的卷积核的三通道取平均得到新的卷积核尺寸为(64,1,7,7)。光流数据分为水平方向与垂直方向,并且采用的是连续的5帧光流作为输入,所以将Conv1的卷积核三通道平均以后再复制成10份,得到新的卷积核尺寸(64,10,7,7)。然后使用这些修改后的权重模型去初始化异构多流网络。

训练:本文使用小批量梯度下降法来进行网络的训练,将空间流网络的mini-batch参数设置为16,时间网络的mini-batch参数设置为32。对于空间网络,将初始学习率设置为0.001,episode设置为110,并在episode为50和80时将学习率衰减为原来的1/10。对于时间流网络,本文同样将初始学习率设置为0.001,episode设置为140,在episode为60和100时将学习率衰减为初始的1/10。为了防止过拟合,分别将两种网络的dropout设置为0.8和0.7。此外,本文采用了数据增强等方法来防止过拟合,使模型更具有鲁棒性。

测试:在模型测试时,采用原双流网络的测试方法[11],对于RGB与Depth视频按照其时间长度均匀分为25段,取每段的中间帧作为测试帧,共计25帧;对于Dflow与Rflow按照时间长度均匀分25段,以每段的中间帧为起始点连续抽取5帧,x与y方向共计250帧。然后对采样得到的视频帧分别裁剪4个角与1个中心,再进行水平翻转,将处理后最终结果分别送入训练好的网络中。在特征融合阶段,我们采用的是均值融合方法,将25段测试帧得到的结果取平均作为最终的分类结果。在分数融合时,我们使用了加权融合的方法将两个时间网络与两个空间网络的结果进行融合。为了获得最优的性能,通过遍历的方法来获取多模融合的权重值。

3.3 实验比较分析

下面首先对不同卷积网络架构下网络的性能进行比较分析,然后给出不同模态数据融合对相似性动作的影响,最后将本文所提方法与目前的主流方法进行对比分析,验证所提方法的有效性。我们通过实验将视频分段数取值从1逐渐增加到9,发现分类准确率随分段数量增加逐渐增加。但当分段数大于5以后,随分段数继续增加时识别效果的增加不再明显,且趋于饱和。所以我们将视频分段数选择为5,下面的实验都是基于此种情况。

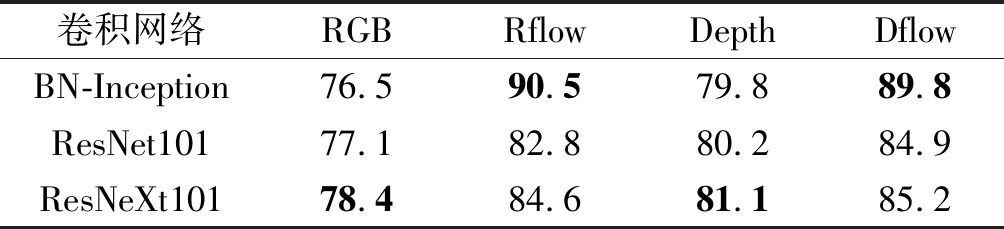

3.3.1 不同网络架构对比实验

为了更好地从视频帧中提取动作特征,本文将ResNeXt卷积架构引入到特征提取网络中。表1中列出了不同模态数据在三种卷积网络下的识别效果。从结果中可以看出,对于空间流网络,ResNeXt能得到更好的效果,所以本文将两个空间流的卷积网络固定为ResNeXt。而对于时间流网络,BN-Inception网络在两种光流数据集上获得了更好的识别率,因此本文将两个时间流的卷积网络固定为BN-Inception。通过此结果也可以发现,网络针对不同数据的特点采用不同的卷积网络架构将比采用同一卷积网络架构具有更好的性能表现。

表1 不同卷积网络架构的识别率(%)

Tab.1 Recognition accuracy of different convolutional network architectures (%)

卷积网络RGBRflowDepthDflowBN-Inception76.590.579.889.8ResNet10177.182.880.284.9ResNeXt10178.484.681.185.2

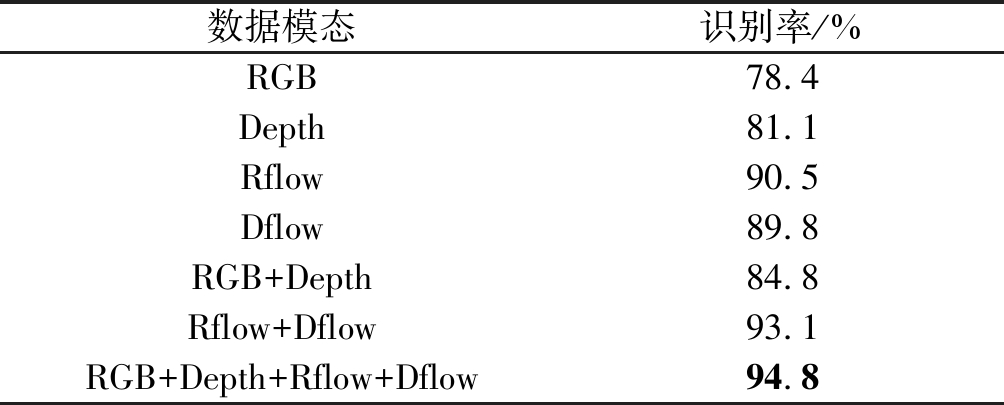

3.3.2 多模融合结果分析

为了证明RGB模态与depth模态动作特征的互补性,我们分别在空间流网络进行了RGB与Depth的融合和在时间流网络进行了Rflow与Dflow的融合实验,最后进行了RGB、Depth和光流(Rflow与Dflow)的三模态融合。我们通过使用加权分数融合来融合跨模态结果。对于RGB与Depth的融合,我们首先将融合权重设置为1∶1,然后按照步长0.05逐步增加Depth的权重,最后找到RGB与Depth的最优融合权重为1∶1.4。同理,我们获得Rflow与Dflow的融合权重比为1∶1.4,RGB、Depth、Rflow与Dflow的权重比为1∶1.4∶3.0∶4.2。

表2 多模态融合的识别率

Tab.2 Recognition accuracy of multimodal fusion

数据模态识别率/%RGB78.4Depth81.1Rflow90.5Dflow89.8RGB+Depth84.8Rflow+Dflow93.1RGB+Depth+Rflow+Dflow94.8

最终的融合结果总结在表2中。从表2中的结果可以看出,双模与三模态的识别结果都要优于单模态的识别结果。Depth的识别效果整体上要高于RGB,但是Dflow的效果却略低于Rflow,原因是深度视频存在背景噪声,而本文在提取Dflow时并没有进行预滤波操作。

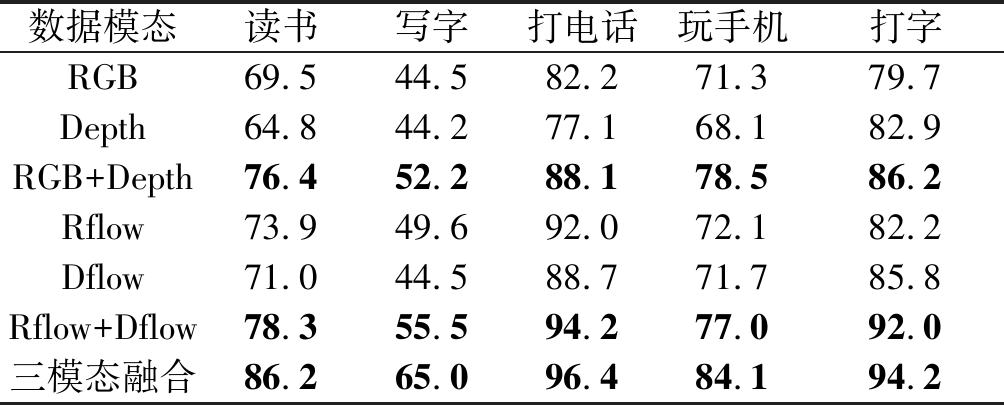

表3 部分相似性动作的识别率(%)

Tab.3 Recognition accuracy of partial similar actions (%)

数据模态读书写字打电话玩手机打字RGB69.544.582.271.379.7Depth64.844.277.168.182.9RGB+Depth76.452.288.178.586.2Rflow73.949.692.072.182.2Dflow71.044.588.771.785.8Rflow+Dflow78.355.594.277.092.0三模态融合86.265.096.484.194.2

表3列出了Depth与RGB融合对数据集中的几种相似性动作(如:读书、写字、打电话、玩手机、打字)识别性能改善的结果。这种相似性动作体现在空间与时间两个方面。在空间上,不同动作发生者与作用对象在空间中所处的相对位置具有相似性,以及不同动作的发生者与发生者、作用对象与作用对象的外观具有相似性。在时间上,不同动作的长时间持续状态具有相似性。相似性动作的存在是动作识别的一大挑战。从表中可以看出,深度与RGB融合,无论是空间流还是时间流网络都对相似性动作的误判有了很大的改善,融合结果比单模态提高了4%~20%。实验结果充分证明了多模态的融合对相似性动作误判有了明显地改善。

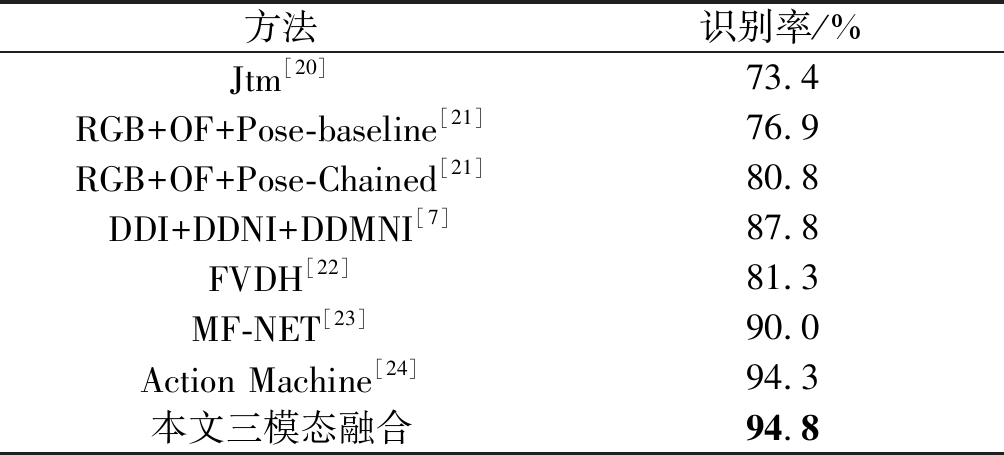

3.3.3 同主流方法的性能对比

下面将本文所提多模态方法与现有比较先进算法的性能进行比较,表4列出了这些算法在NTU RGB+D数据集上的准确率(评估协议为cross-subject)。

从表4中列出的识别率结果来看,本文所提方法优于大多数现有算法。与将骨骼数据转化为轨迹图的Jtm[20]算法相比提高了21.4%;与基于深度图的三种表示DDI、DDNI与DDMNI[7]融合的结果相比提高了7%;与三流网络[21]融合RGB、姿态与光流数据的结果相比提高14%;比人体与环境分离,融合RGB与姿态的Action Machine[24]方法提高了0.5%。实验结果证明了本文所提出方法的有效性。

表4 本文方法同现有方法对比

Tab.4 Comparison between the method proposed in this paper and existing methods

方法识别率/%Jtm[20]73.4RGB+OF+Pose-baseline[21]76.9RGB+OF+Pose-Chained[21]80.8DDI+DDNI+DDMNI[7]87.8FVDH[22]81.3MF-NET[23]90.0Action Machine[24]94.3本文三模态融合94.8

4 结论

本文提出一种基于异构多流网络的多模融合动作识别方法。首先给出一种从Depth模态数据中提取深度光流信息方法,以增加Depth模态的动作特征表示。同时,选取较适合空间特征的ResNeXt网络作为两个空间流网络的卷积架构、BN-Inception网络作为两个时间流网络的卷积架构,以充分发挥多流网络的性能,减少网络的冗余。最后,网络输出端融合三模态信息作为最终的识别结果,充分利用了多模态信息提高了动作识别准确率,并改善相似性动作的误判。在NTU RGB+D数据集上的测试实验结果证明了本文所提方法的有效性。当然,除了本文已经完成的工作,还有一些值得我们未来进一步研究的问题。如:视频的分割与视频帧的抽取能否更加关注视频中运动信息含量较多的帧?是否可以通过自适应或者强化学习的方法为多模态融合分配更合理的权重?这些也是下一步我们将要重点研究的内容。

[1] Ng J, Hausknecht M, Vijayanarasimhan S, Vinyals O, et al. Beyond short snippets: Deep networks for video classi cation[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), IEEE, 2015: 4694- 4702.

cation[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), IEEE, 2015: 4694- 4702.

[2] Gan C, Wang N, Yang Y, et al. Devnet: A deep event network for multimedia event detection and evidence recounting[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), IEEE, 2015: 2568-2577.

[3] Wang H, Schmid C. Action recognition with improved trajectories[C]∥2013 IEEE International Conference on Computer Vision (ICCV), IEEE, 2013: 3551-3558.

[4] 刘唐波, 杨锐, 王文伟, 等. 基于姿态估计的驾驶员手部动作检测方法研究[J]. 信号处理, 2019, 35(12): 2062-2069.

Liu Tangbo, Yang Rui, Wang Wenwei, et al. Driver’s Hand Motion Detection Based on Pose Estimation[J]. Journal of Signal Processing, 2019, 35(12): 2062-2069.(in Chinese)

[5] Zhang C, Tian Y, Guo X, et al. DAAL: Deep activation-based attribute learning for action recognition in depth videos[J]. Computer Vision and Image Understanding, 2018, 167: 37- 49.

[6] Wang P, Li W, Gao Z, et al. Depth Pooling Based Large-Scale 3-D Action Recognition With Convolutional Neural Networks[J]. In IEEE Transactions on Multimedia, 2018, 20(5): 1051-1061.

[7] Sahoo S P, Ari S. Depth Estimated History Image based Appearance Representation for Human Action Recognition[C]∥TENCON 2019-2019 IEEE Region 10 Conference (TENCON), IEEE, 2019: 965-969.

[8] Kong Y, Fu Y. Bilinear heterogeneous information machine for RGB-D action recognition[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), IEEE, 2015: 1054-1062.

[9] Kong Y, Satarboroujeni B, Fu Y. Learning hierarchical 3D kernel descriptors for RGB-D action recognition[J]. Computer Vision and Image Understanding, 2016, 144: 14-23.

[10]Chen L, Song Z, Lu J, et al. Learning principal orientations and residual descriptor for action recognition[J]. Pattern Recognition, 2017, 86: 14-26.

[11]Simonyan K, Zisserman A. Two-Stream Convolutional Networks for Action Recognition in Videos[C]∥Neural Information Processing Systems (NIPS), 2014: 568-576.

[12]Wang L, Xiong Y, Wang Z, et al. Temporal segment networks: Towards good practices for deep action recognition[C]∥European Conference on Computer Vision (ECCV), Springer, 2016: 20-36.

[13]Xie S, Girshick R, Doll r P, et al. Aggregated Residual Transformations for Deep Neural Networks[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), IEEE, 2017: 5987-5995.

r P, et al. Aggregated Residual Transformations for Deep Neural Networks[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), IEEE, 2017: 5987-5995.

[14]Sergey L, Christian S. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]∥Proceedings of 32nd International Conference on Machine Learning, 2015: 448- 456.

[15]Shahroudy A, Liu J, Ng T, et al. NTU RGB+D: A Large Scale Dataset for 3D Human Activity Analysis[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), IEEE, 2016: 1010-1019.

[16]Zach C, Pock T, Bischof H. A duality based approach for realtime TV-L 1 optical flow[C]∥Joint Pattern Recognition Symposium. Springer, 2007: 214-223.

[17]He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), IEEE, 2016: 770-778.

[18]Yu W, Yang K, Bai Y, et al. Visualizing and comparing AlexNet and VGG using deconvolutional layers[C]∥Proceedings of the 33 rd International Conference on Machine Learning (ICML), 2016.

[19]Deng J, Dong W, Socher R, et al. Imagenet: A large-scale hierarchical image database[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), IEEE, 2009: 248-255.

[20]Wang P, Li Z, Hou Y, et al. Action recognition based on joint trajectory maps using convolutional neural networks[C]∥Proceedings of the 24th ACM International Conference on Multimedia, ACM, 2016: 102-106.

[21]Zolfaghari M, Oliveira G, Sedaghat N, et al. Chained Multi-stream Networks Exploiting Pose, Motion, and Appearance for Action Classification and Detection[C]∥2017 IEEE International Conference on Computer Vision (ICCV), IEEE, 2017: 2923-2932.

[22]Han Y, Chung S, Chen S, et al. Two-Stream LSTM for Action Recognition with RGB-D-Based Hand-Crafted Features and Feature Combination[C]∥2018 IEEE International Conference on Systems, Man, and Cybernetics (SMC), IEEE, 2018: 3547-3552.

[23]Wang Y, Xu Z, Li L, et al. Robust Multi-Feature Learning for Skeleton-Based Action Recognition[J]. IEEE Access, 2019, 7: 148658-148671.

[24]Zhu J, Zou W, Xu L, et al. Action Machine: Toward Person-Centric Action Recognition in Videos[J]. IEEE Signal Processing Letters, 2019, 26(11): 1633-1637.