1 引言

数字视频通常被认为是对事件进行公正可靠记录的载体,被广泛应用于交通、医学、司法等领域以提供相关事实的基本证据。伴随着数字视频的蓬勃发展,视频处理技术和软件也在不断涌现。人们可以利用像Adobe After Effects、Mokey和proDAD Erazr等视频编辑软件轻而易举地对视频中的局部目标进行移除。被恶意篡改的视频如果被传播,将会对人们的日常生活和正常的政治、经济和社会秩序造成危害。因此,以验证视频的完整性和真实性为目标的视频取证技术[1-2]已成为多媒体内容分析和信息安全领域的重点研究问题。

现有的视频目标移除取证算法可以分为基于人工设计特征的取证算法和基于深度学习的取证算法。前者主要基于视频时空域的相关性分析来进行研究。与图像取证[3- 4]不同,视频取证可以通过对时域信息进行分析来发现视频篡改所带来的伪造痕迹。Hsu等人[5]利用基于块的噪声残差相关性来检测和定位视频中的伪造区域。该方法基于篡改区域中噪声残差的相关性与原始区域明显不同的观察结果,通过使用高斯混合模型(Gaussian Mixture Model,GMM)对真实区域和伪造区域中的噪声残差相关性分布进行建模,来检测和定位视频中的伪造区域。基于噪声残差特征的不足,Singh等人[6]提出了一种基于传感器模式噪声(Sensor Pattern Noise,SPN)的相关性检测方法。基于伪造视频和原始视频中前景区域的运动矢量分布有很大差异的观察结果,针对由静止相机拍摄的视频,Li等人[7]利用相邻两帧运动矢量的相关性来检测和定位伪造区域。Bestagini等人[8]通过计算相邻两帧之间相同位置像素残差的相关性系数,取视频三维空间上相关性最大的子块序列作为时空域内检测到的伪造区域。针对同一类型的伪造操作,Mathai等人[9]提出一种基于统计矩特征和归一化互相关系数的取证方法。Saxena等人[10]提出了一种基于光流一致性的视频目标移除伪造检测和定位算法。

此外,基于对视频目标移除后伪造痕迹的分析,Zhang等人[11]提出利用前景拼接图与图像累积差分得到的运动轨迹的不一致性,通过检测由于视频修复技术引入的“鬼影”痕迹来判断视频是否经过篡改。Chen等人[12]通过分析针对对象的局部区域移除和图像隐写分析两者之间的相近性,将基于局部区域的视频取证转化为对相邻两视频帧的运动残差中隐藏信息的检测。Su等人[13]引入能量因子(Energy Factor,EF)和基于自适应参数的视觉背景提取算法(Adaptive Parameter-Based Visual Background Extractor,AVIBE)来进行前景移除视频的伪造检测。

随着人工智能技术的发展和可用视频数据集的增加,深度学习技术被逐渐引入视频取证领域。深度学习技术具有从大量的训练数据集中提取最佳特征的能力,避免了人为设计特征的局限性。Yao等人[14]提出的方法利用卷积神经网络(Convolutional Neural Networks,CNN)从输入视频帧中自动提取高维特征。该方法在五层CNN模型之前设计了三个预处理层以提高算法的检测性能。此外,该方法还引入了一种基于视频帧剪裁的非对称数据增强策略,以便在网络训练之前获得相当数量的训练集,避免网络过拟合。Kono等人[15]提出将卷积神经网络和循环神经网络(Recurrent Neural Network,RNN)相结合来同时考虑视频的时空一致性。编解码器结构的引入使得该方法具有伪造区域的定位能力。

现有算法通常通过从视频帧中提取单一特征对篡改视频帧进行识别,使得伪造帧的识别准确率较低。为了能够多角度地对视频帧中的伪造痕迹进行分析,我们提出利用双通道卷积神经网络来同时提取视频帧中RGB通道和噪声通道的特征,以此来学习篡改视频帧中更加丰富的特征。其中,RGB通道能够发现绝对帧差图像中不自然的篡改边界和对比度,噪声通道能够发现原始区域和篡改区域之间噪声的不一致性。通过与现有视频目标移除取证算法和单通道网络结构进行对比,验证了本文所提的算法能够取得更好的检测性能。

2 双线性卷积神经网络

双线性卷积神经网络(Bilinear convolution neural network,B-CNN)[16]最初被用于进行图像细粒度分类,通过两路卷积神经网络模型组成的特征提取器,将一张图像表示为两组特征向量经过双线性池化后的图像描述子。一个用于图像分类的池化模型由四元组(fA,fB,P,C)构成,其中fA和fB为基于两个卷积神经网络的特征函数,P表示池化函数,C表示分类器。对于图片I和图片上的位置![]() 和fB的双线性融合表示为:

和fB的双线性融合表示为:

bilinear(l,I,fA,fB)=fA(l,I)TfB(l,I)

(1)

利用池化函数P将图像中所有位置的双线性融合进行整合,可以得到图片的全局表示:

(2)

将特征矩阵向量化后,对其进行矩归一化操作![]() 和l2归一化操作(z←y/||y||2),得到最终的融合特征。Zhou[17]等人首次将双线性卷积神经网络应用于图像取证领域。本文所提算法利用双线性卷积神经网络能够同时提取双通道特征的优势,分别从视频绝对帧差图像的RGB通道和噪声通道中提取特征,来对经过目标移除篡改的视频帧进行检测。

和l2归一化操作(z←y/||y||2),得到最终的融合特征。Zhou[17]等人首次将双线性卷积神经网络应用于图像取证领域。本文所提算法利用双线性卷积神经网络能够同时提取双通道特征的优势,分别从视频绝对帧差图像的RGB通道和噪声通道中提取特征,来对经过目标移除篡改的视频帧进行检测。

3 基于双通道卷积神经网络的视频目标移除取证算法

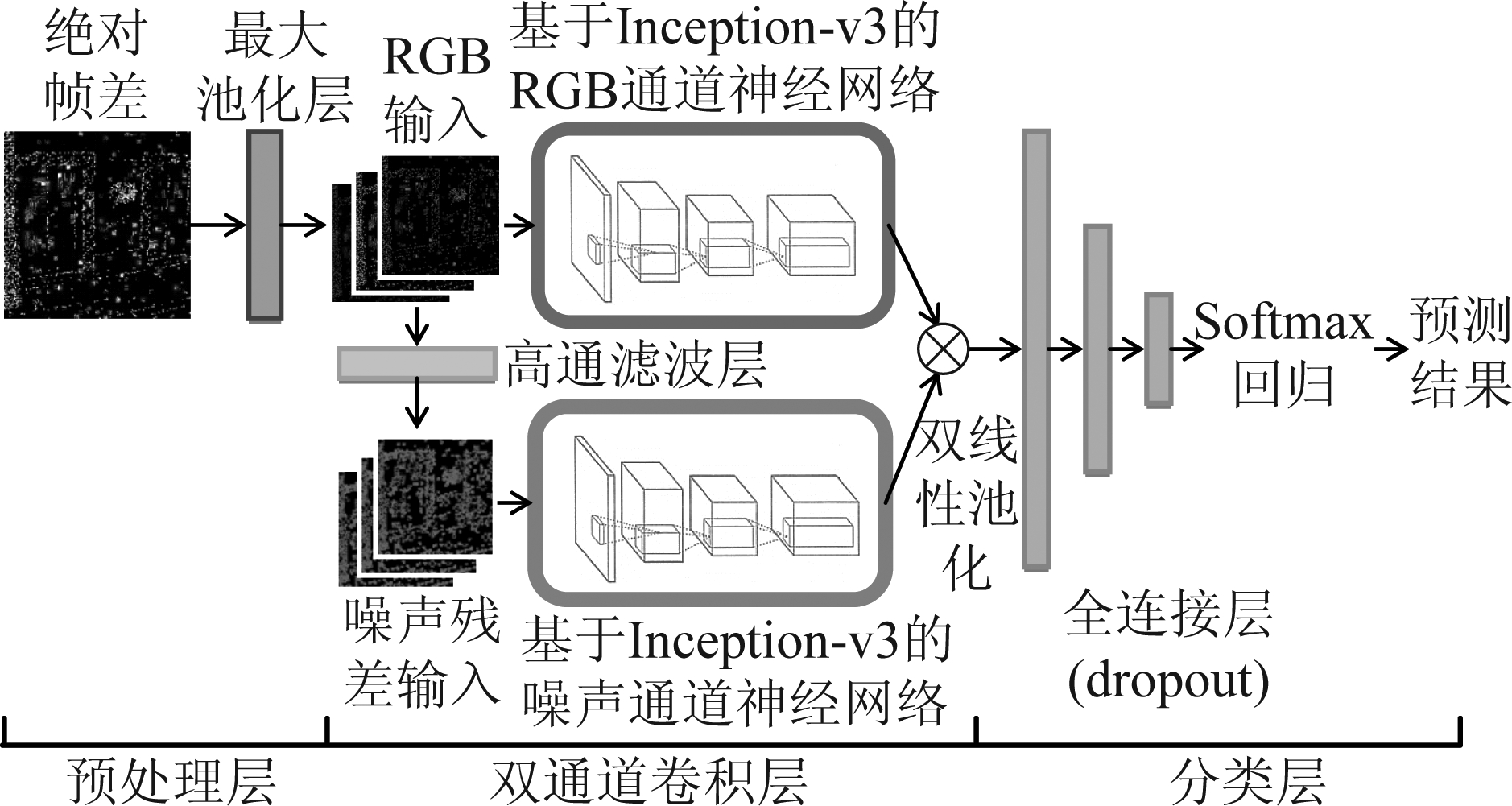

本文提出的基于双通道卷积神经网络的视频目标移除取证算法的整体网络框架如图1所示,主要结构包括:1)预处理层。通过提取相邻两视频帧的绝对帧差图像以减少视频帧之间的冗余信息,而后经过最大池化层进一步增强绝对帧差图像的运动残差信息。2)双通道卷积层。截取Inception-v3原始网络的部分结构,串联一层用于降维的卷积层作为提取RGB通道或噪声通道特征的网络结构。3)分类层。通过三个全连接层和Softmax回归对高维融合特征进行分类,得到视频帧的预测结果。

图1 算法的整体网络框架

Fig.1 The overall framework of the proposed method

3.1 预处理

3.1.1 绝对帧差

视频由一系列连续的图像帧组成,视频目标移除会不可避免地在这些图像帧之间留下一些伪造痕迹。为了提取视频在时域上的篡改痕迹,同时减少相邻两帧之间的冗余信息,首先在预处理阶段利用帧间差分法提取相邻两帧之间的绝对帧差图像。设长度为N的视频序列V表示为:

V={F1,F2,…,Fi,…,FN},i∈{1,…,N}

(3)

其中Fi表示第i个视频帧。则绝对帧差图像Dj的计算方式为:

Dj=abs(Fj-Fj-1), j∈{2,…,N}

(4)

其中abs(·)表示取绝对值的操作。通过计算得到的绝对帧差图像保存了帧差的颜色信息。

3.1.2 最大池化层

池化层即下采样层,通常用在连续的卷积层中间,用于降低特征图的维度,保留最能表达图像信息的特征,避免网络过拟合的发生。而最大池化层通过选取每个区域中的最大值作为池化结果,不仅可以降低输入图像块的分辨率以提高计算速度,同时增强了网络对于绝对帧差图像中运动残差的鲁棒性,放大了相邻两帧之间的运动残差信息。因此,我们在网络前端引入一个步长为3×3,滤波器大小为3×3的最大池化层。绝对帧差图像经过该最大池化层即得到双线性卷积神经网络RGB通道的输入。

3.2 基于Inception-v3的双通道卷积神经网络

对于输入的绝对帧差图像,为了学习到更加丰富的特征,提高算法的检测性能,本文提出的算法采用双通道卷积神经网络结构,分别对RGB通道和噪声通道提取特征。基于Inception-v3网络更强的特征表达能力和非线性拟合性能,我们截取其一部分网络结构作为骨干网络来分别提取两通道的特征。

3.2.1 RGB通道

视频目标移除通常是将其他视频帧中的背景区域复制粘贴到伪造区域来达到局部目标移除的目的。因此,在伪造区域的边缘通常会产生不自然的篡改痕迹。这里通过提取RGB通道的特征来发现篡改边界的不一致性。

预处理得到的视频绝对帧差图像是包含了颜色信息的RGB图像,经过最大池化操作即得到双线性网络的RGB通道输入。

3.2.2 噪声通道

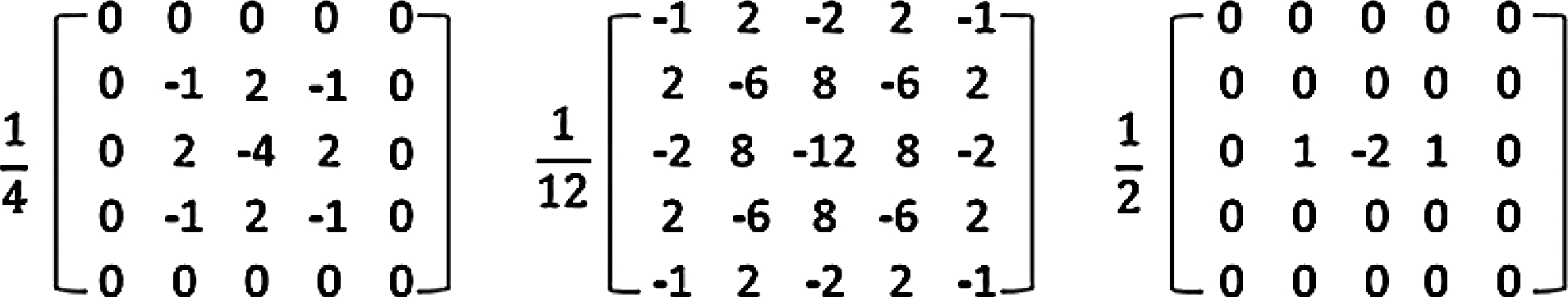

在卷积神经网络的预处理阶段增加一层高通滤波层,可以抑制图像内容所带来的影响,有助于网络学习到更加有效的特征。利用高通滤波器对视频绝对帧差图像进行处理可以减少视频对象的运动对视频帧的影响,增强残差信号,突出篡改痕迹。我们将灰度化后的RGB通道输入经过三个高通滤波层来获得噪声通道的输入。如图2所示为本文采用的用于提取噪声特征的三种滤波核[17]。

图2 用于提取噪声特征的三种滤波核

Fig.2 Three filter kernels used to extract noise features

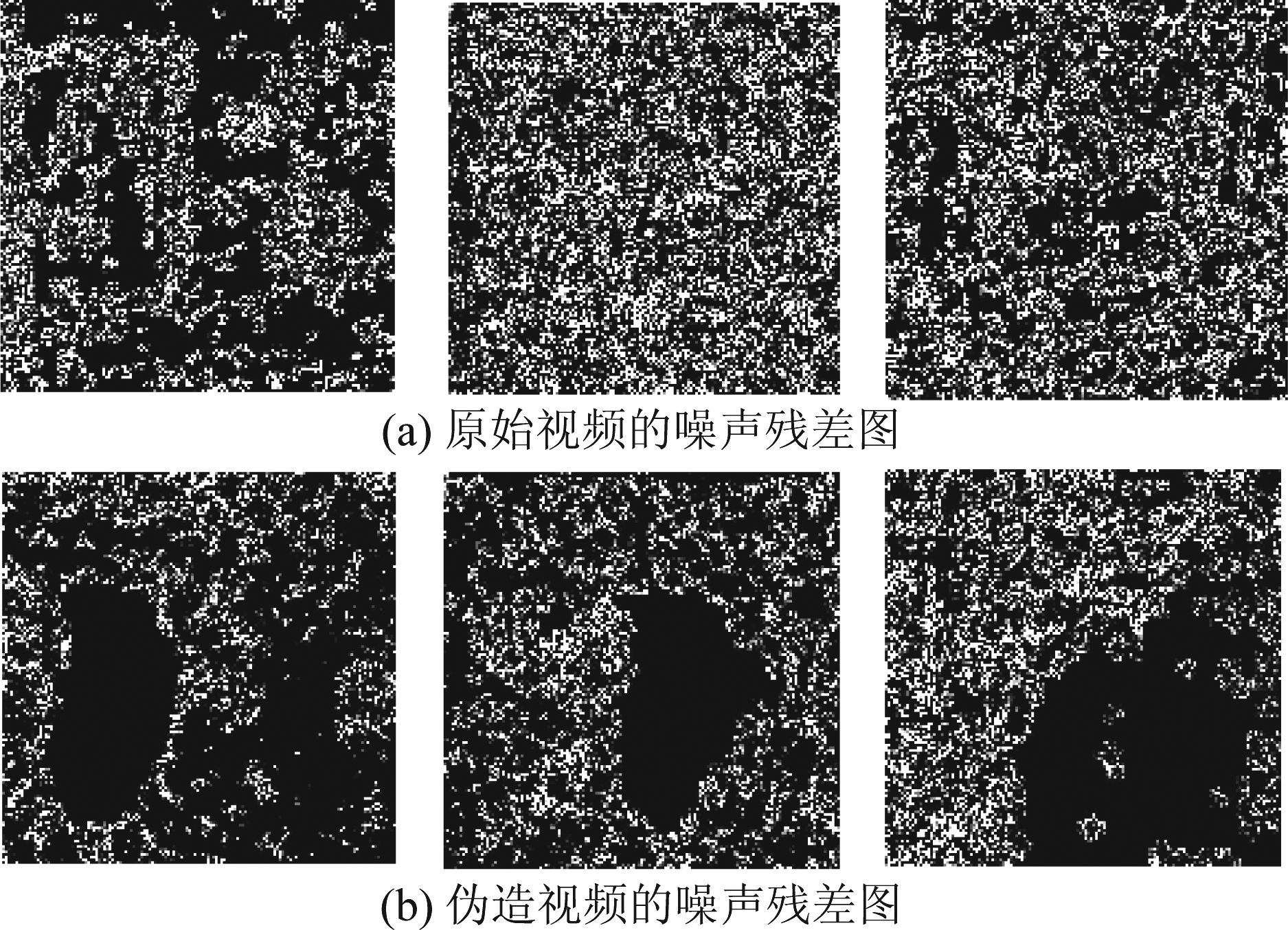

图3(a)和3(b)分别展示了原始视频和伪造视频的绝对帧差图像经过高通滤波层处理后的噪声残差图。可以看出,相对于原始视频绝对帧差图像的噪声残差图,经过目标移除的伪造视频的噪声残差图中会出现较大面积的孔洞。经过对比,这些区域即为经过伪造的区域,这是由于视频中被移除的区域通常是从同一位置处复制粘贴而来的,因此相比于原始区域,这些篡改区域在相邻视频帧中具有异常的高度相关性。由此可以证明提取噪声特征可以有效地帮助我们识别伪造的视频帧。

图3 噪声残差图

Fig.3 The noise residual images

3.2.3 网络结构

由于提取RGB通道和噪声通道特征的网络结构相同,因此为了方便我们对其进行介绍,这里称提取每一通道特征的网络结构为基于Inception-v3的单通道卷积神经网络。

Inception-v3网络由Szegedy等人[18]于2016年提出。该结构在之前的Inception结构的基础上提出了多种优化方法:包括将大尺度的卷积分解成多个小尺度的卷积来减少计算,使用非对称卷积提升分类效果,以及使用并行结构来优化池化等。多尺度卷积核并联的结构使其能够提取输入信息的多尺度特征,提高特征的表达能力。基于Inception-v3网络的优势,这里截取其一部分结构作为骨干网络来学习RGB通道和噪声通道的特征。

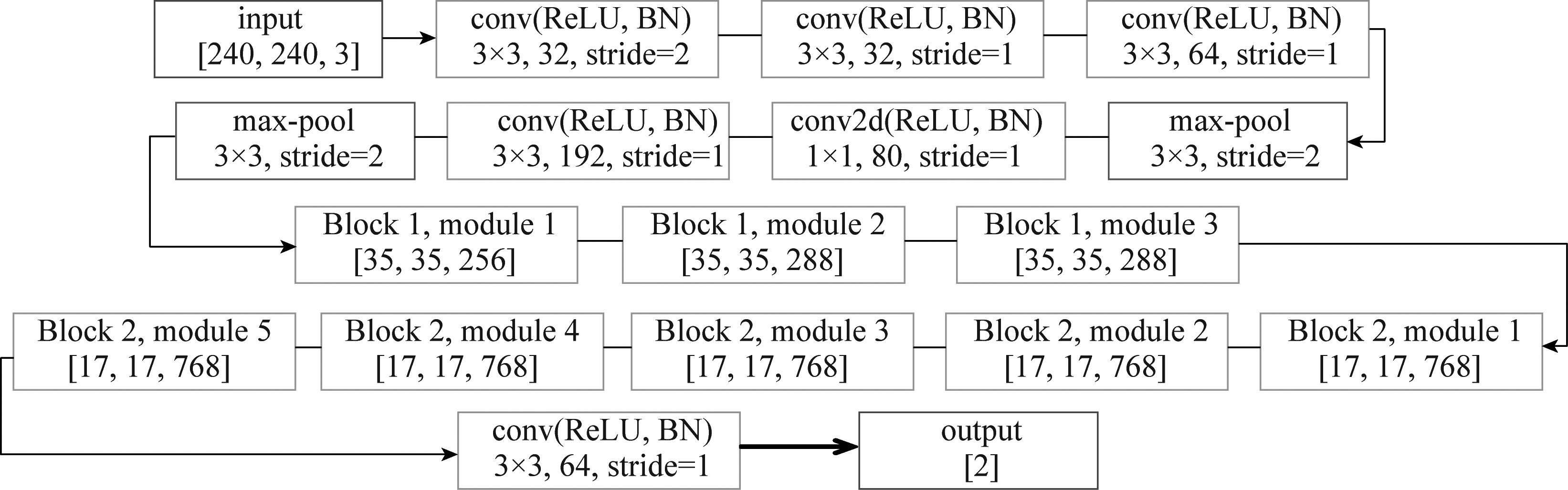

为了降低融合特征的维度,防止因为维度过高造成的特征冗余和噪声,这里只截取到原始Inception-v3网络结构的第二个模块,串联一层用于降维的卷积层,作为提取RGB通道和噪声通道特征的卷积网络。如图4所示为本文算法中提取RGB特征或者噪声特征的单通道网络结构图。网络首先通过五个卷积层和两个最大池化层来提取绝对帧差图像的低维特征,接着通过连续的8个Inception模块提取高维多尺度特征,最后通过一个卷积层对高维多尺度特征进行降维,得到从RGB通道或噪声通道的输入图像中提取的特征。其中,6层卷积层的卷积核大小分别为3×3×32、3×3×32、3×3×64、1×1×80、3×3×192以及3×3×64。对于噪声通道的输入,为了使其与该网络的输入要求相匹配,需要首先将其扩充为三通道再进行输入。

图4 提取单通道特征的网络结构图

Fig.4 The network structure of extracting single channel features

3.3 双线性池化

双线性池化主要被用于特征融合。从同一样本中提取出来的两个特征经过双线性池化后生成融合后的特征向量,进而被用来进行分类。经过双通道卷积神经网络提取的RGB特征和噪声特征通过双线性池化方法[16],被汇合为一个高维的融合特征。双线性池化层的输出为:

(5)

其中, fRGB为RGB通道的特征输出,fN为噪声通道的特征输出。对双线性池化层的输出进行矩归一化操作![]() 和l2归一化操作(z←y/||y||2),得到最终的融合特征。将该高维特征通过三层全连接层和Softmax回归即得到该视频帧的预测分类结果。

和l2归一化操作(z←y/||y||2),得到最终的融合特征。将该高维特征通过三层全连接层和Softmax回归即得到该视频帧的预测分类结果。

4 实验结果与分析

4.1 实验数据

本文所采用的测试视频来自SYSU-OBJFORG数据集[12]。SYSU-OBJFORG是目前最大的基于对象的伪造视频数据集,由100个原始视频序列和100个一一对应的伪造视频序列组成。所有视频采用H.264/MPEG- 4编码,帧率为25 fps,比特率为3 Mbps,分辨率为1280×720。原始视频序列是直接从使用静态摄像机拍摄的监控视频中剪切而来的,没有经过任何类型的篡改操作。伪造视频由原始视频经过目标移除处理得到。我们以4∶1∶5的比例将100对测试视频分为训练集、验证集和测试集。在网络训练的过程中,为了避免网络欠拟合,提高网络模型的泛化能力,我们采用数据增强策略[14]来生成数量更多的训练图像块。对于原始视频帧,每个1280×720大小的图像帧被切割为三个720×720大小的图像子块;对于伪造视频帧,每个图像帧以更稠密的方式被切割成720×720大小的图像子块,伪造区域被涵盖在各个图像子块中。另外,通过增加水平翻转的方式进一步增加训练图像块的数量。在测试过程中,所有的待测视频帧都按照训练数据集中原始视频帧的分割方式,将每帧切割成三个720×720大小的图像子块。若其中有一个图像子块被分类为伪造块,则该视频帧被判定为伪造视频帧,否则被判定为原始视频帧。

本文算法所提出的网络模型是基于PyTorch深度学习框架实现的。实验中的相关参数设置如下:每批次输入图像数量为64,采用Adam算法优化损失函数,初始学习率为0.001,每迭代10000次衰减为之前的0.9倍。

4.2 结果分析

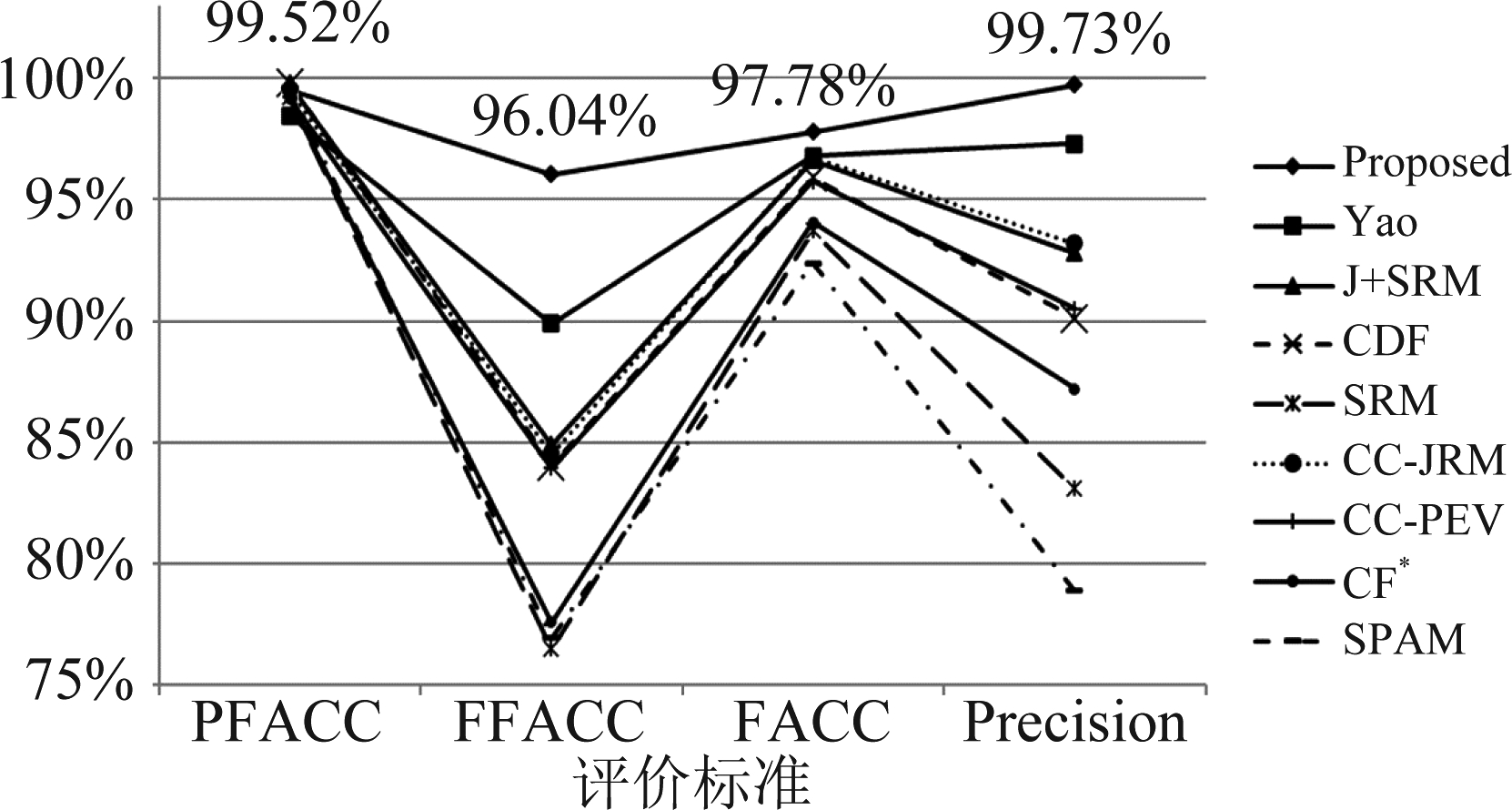

为了验证算法的检测性能,如图5所示,我们将该算法与Yao[14]和Chen[12]所提出的算法进行比较。在文献[12]中,作者采用了J+SRM、CDF、SRM、CC-JRM、CC-PEV、C![]() 、SPAM等7个典型的隐写分析特征来获得不同的检测性能。图中评价标准的计算方式如下:

、SPAM等7个典型的隐写分析特征来获得不同的检测性能。图中评价标准的计算方式如下:

(6)

(7)

(8)

(9)

其中,PFACC表示原始视频帧的检测准确率,FFACC表示伪造视频帧的检测准确率,FACC表示视频帧(包含原始视频帧和伪造视频帧)的检测准确率,Precision表示伪造视频帧的分类精度。

由图5的实验结果可以看出,本文所提算法在上述各项评价指标中,尤其是伪造视频帧的识别准确率(达到96.04%)上明显优于现有的两种方法。伪造视频帧的识别准确率体现了算法对于异常视频帧的判别能力,因此该算法对于帮助我们识别篡改视频更具优势。

图5 所提算法的检测性能

Fig.5 The detection performance of the proposed method

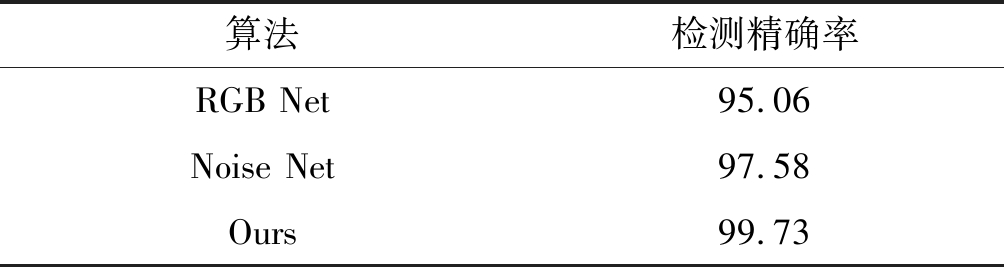

此外,我们将该算法与单通道网络的检测精确率进行比较以验证双通道网络结构以及RGB和噪声的融合特征的有效性,比较结果如表1所示。其中,RGB Net表示仅使用绝对帧差图像的RGB通道作为输入的卷积神经网络,Noise Net表示仅使用噪声通道作为输入的卷积神经网络。单通道网络结构同样截取到Inception-v3网络的第二个模块,并通过分类层输出分类结果。由表1的实验结果可以看出,与单通道网络结构的检测性能相比,采用双通道特征融合的方式能够有效地提高视频帧的检测精确度。

表1 双线性结构与单通道网络对比结果

Tab.1 Comparison of the bilinear structure and the single channel network %

算法检测精确率RGB Net95.06Noise Net97.58Ours99.73

5 结论

本文提出了一种基于双通道卷积神经网络的视频目标移除取证算法,该算法利用双通道结构对输入的图像块分别提取RGB特征和噪声特征,并利用双线性池化对二者进行特征融合得到高维特征,从而对视频帧是否经过目标移除进行检测。为了提高检测性能,算法通过获得相邻两视频帧的绝对帧差图像来提取视频在时域上的伪造痕迹,减少了相邻两帧之间的冗余信息;增加最大池化层,增强了绝对帧差图像中的运动残差信息。实验结果显示,本文所提算法有效地提高了伪造视频帧的识别准确率,且与单通道神经网络结构相比,这种双通道特征融合的方式能够有效地提高算法的检测性能。然而,该算法缺少对视频时域信息的分析,且无法对视频帧内的伪造区域进行定位,这些问题将是我们今后需要继续探索的方向。

[1] Mullan P, Cozzolino D, Verdoliva L, et al. Residual-Based Forensic Comparison of Video Sequences[C]∥2017 IEEE International Conference on Image Processing (ICIP). IEEE, 2017: 1507-1511.

[2] Yu Lifang, Yang Yiyuan, Li Zhaohong, et al. HEVC Double Compression Detection under Different Bitrates Based on TU Partition Type[J]. EURASIP Journal on Image and Video Processing, 2019, 2019(1): 1-12.

[3] Li Haodong, Huang Jiwu. Localization of Deep Inpainting Using High-Pass Fully Convolutional Network[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV). IEEE, 2019.

[4] Li Haodong, Luo Weiqi, Huang Jiwu. Localization of Diffusion-Based Inpainting in Digital Images[J]. IEEE Transactions on Information Forensics and Security, 2017, 12(12): 3050-3064.

[5] Hsu C C, Hung T Y, Lin C W, et al. Video Forgery Detection Using Correlation of Noise Residue[C]∥2008 IEEE 10th Workshop on Multimedia Signal Processing. IEEE, 2008: 170-174.

[6] Singh R D, Aggarwal N. Detection and Localization of Copy-Paste Forgeries in Digital Videos[J]. Forensic Science International, 2017, 281: 75-91.

[7] Li Leida, Wang Xuewei, Zhang Wei, et al. Detecting Removed Object from Video with Stationary Background[C]∥International Workshop on Digital Watermarking. Springer, Berlin, Heidelberg, 2012: 242-252.

[8] Bestagini P, Milani S, Tagliasacchi M, et al. Local Tampering Detection in Video Sequences[C]∥2013 IEEE 15th International Workshop on Multimedia Signal Processing (MMSP). IEEE, 2013: 488- 493.

[9] Mathai M, Rajan D, Emmanuel S. Video Forgery Detection and Localization Using Normalized Cross-Correlation of Moment Features[C]∥2016 IEEE Southwest Symposium on Image Analysis and Interpretation (SSIAI). IEEE, 2016: 149-152.

[10]Saxena S, Subramanyam A V, Ravi H. Video Inpainting Detection and Localization Using Inconsistencies in Optical Flow[C]∥2016 IEEE Region 10 Conference (TENCON). IEEE, 2016: 1361-1365.

[11]Zhang Jing, Su Yuting, Zhang Mingyu. Exposing Digital Video Forgery by Ghost Shadow Artifact[C]∥Proceedings of the First ACM workshop on Multimedia in forensics. 2009: 49-54.

[12]Chen Shengda, Tan Shunquan, Li Bin, et al. Automatic Detection of Object-Based Forgery in Advanced Video[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2015, 26(11): 2138-2151.

[13]Su Lichao, Luo Huan, Wang Shiping. A Novel Forgery Detection Algorithm for Video Foreground Removal[J]. IEEE Access, 2019, 7: 109719-109728.

[14]Yao Ye, Shi Yunqing, Weng Shaowei, et al. Deep Learning for Detection of Object-Based Forgery in Advanced Video[J]. Symmetry, 2018, 10(1): 3.

[15]Kono K, Yoshida T, Ohshiro S, et al. Passive Video Forgery Detection Considering Spatio-Temporal Consistency[C]∥International Conference on Soft Computing and Pattern Recognition. Springer, Cham, 2018: 381-391.

[16]Lin T Y, RoyChowdhury A, Maji S. Bilinear CNN Models for Fine-Grained Visual Recognition[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 1449-1457.

[17]Zhou Peng, Han Xintong, Morariu V I, et al. Learning Rich Features for Image Manipulation Detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 1053-1061.

[18]Szegedy C, Vanhoucke V, Ioffe S, et al. Rethinking the Inception Architecture for Computer Vision[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 2818-2826.