1 引言

目标检测作为计算机视觉领域的一个重要任务,旨在预测图像中目标的类别和位置。近年来,随着深度卷积神经网络的快速发展,目标检测领域也涌现了许多基于深度网络的优秀算法[1-3],在常用的数据集如PASCAL VOC[4], MS COCO[5]上取得了优秀的表现。但是这些算法在真实场景下仍面临着很大挑战。在某一含标注的数据集上训练的目标检测模型,当应用于其他模型未见过的数据集时,往往会由于数据集间的域间差异而对模型表现产生影响。对此,最直接的方法是广泛收集其他多源数据后进行标注,进而重新训练模型,但是显然时间成本和人工成本非常高。

为了在不进行额外标注的条件下,缩小不同数据集间的域间差异,研究者提出了许多域自适应的方法,将含有大量标注的数据集(源域)上学习到的信息迁移到没有标注的数据集(目标域)上。论文[6-8]从源域中筛选出与目标域数据相似度高的数据后重新分配权重,然后进行训练学习。论文[9-11]通过特征变换,将两个域的数据变换到同一特征空间,然后进行传统的机器学习。上述这些方法都是基于简单的分类任务设计的,在其他复杂的视觉任务如目标检测、语义分割上的研究相对较少,也是近年来的热点问题。Li等人整理了近期用深度网络来做自适应目标检测的一些方法[12],比如Cai等人用教师网络这种基于差异的方法做自适应目标检测[13],也有学者用基于重建的方法比如图像之间的转换来进行自适应目标检测[14-15]。另外,逐渐有学者受到生成对抗网络思想的启发,提出通过对抗的方法来进行域自适应检测[16-17],在车载图像数据集Cityscape[18]和FoggyCityscape[19]等数据集上达到了较好的效果。然而,当前的研究基本都是围绕自然图像、虚拟游戏图像、动漫图像等展开,主要解决不同源图像在光照、天气、风格下的差异带来的性能影响。在遥感图像领域尤其是遥感图像目标检测任务上还很少有成功的应用。

面向多源遥感图像的自适应目标检测是当下遥感领域的一个极具挑战性的实际任务。现有遥感公开数据集大部分来自谷歌图像,但随着我国卫星发射,各种型号的遥感图像数据越来越多,传统的方法需要将多源的数据进行重新标注,这将消耗大量人力和时间。因此,研究面向多源遥感图像的自适应目标检测在军用和民用领域均具有重要的应用前景和价值。由于多源遥感图像在分辨率、成像方式等方面存在特有的差异,因此相比于自然图像,实现多源遥感图像自适应检测需要面临特有的挑战和约束。

针对上述问题,本文提出了面向多源遥感图像的自适应检测网络(Adversarial Adaptive Detection Network, AADN),在图像级别和语义级别分别设计判别器,使网络在两个不同级别学习到多源遥感图像之间的公共信息。其中,我们在图像级别上设计两个判别器,用来学习多源遥感图像在不同成像方式、图像纹理等方面的公共信息;在语义级别设计判别器,用来学习多源遥感图像在高层语义级别的公共信息。随后我们采用多层环境感知模块,将这两个级别的信息输入到检测器中完成检测。同时,针对遥感图像典型的分辨率差异问题,我们引入超分辨率重建的思想,对低分辨率遥感图像进行超分辨,使多源遥感图像在分辨率上进一步对齐,并将超分辨率模块与AADN有效结合起来,进一步提升了目标域为低分辨率遥感图像的检测效果。

本文在两个成像方式、分辨率上存在差异的多源遥感图像数据集上进行双向自适应检测实验,并且对比了两种现有的自适应检测方法,实验结果表明本文方法有效地提升了在不含标注的目标域上的检测效果。

2 相关工作

2.1 目标检测方法

近年来,目标检测受益于卷积神经网络(Convolutional Neural Network, CNN)强大的特征提取能力,较传统方法来说,有了巨大的进步。由Girshick等人提出的R-CNN[20]将CNN用于目标检测,该方法在得到候选区域后用CNN提取特征进行精检测,极大提升了检测性能。Faster R-CNN[1],SSD[2]等方法采用了anchor机制,结合了候选区域的思想,在检测性能上有了进一步提升。近年来,一些不采用anchor的方法也相继出现并取得很好的效果[3]。在遥感图像目标检测领域,传统的方法也逐渐被基于深度学习的方法所取代。许多学者也将自然图像领域的一些方法应用到遥感目标检测中。Zou等人提出了一种随机接入记忆的方法对遥感目标进行检测,有效抑制了虚景[21]。Cheng等人提出一种新的旋转不变层,有效提升了遥感目标检测性能[22]。Ding等人改进了CNN的基础网络结构,以提高飞机和汽车的检测精度[23]。唐等人提出一种轻量化网络,在保持较高飞机目标检测精度的同时,又能具有较低的计算复杂度[24]。针对多源遥感图像目标检测,目前的研究还较少,业界普遍采用的方法是对不同源的数据进行重新标注后再训练,这样的方式需要每拿到某个源的数据后花费大量人力和时间进行标注,因此研究针对多源遥感图像的自适应目标检测显得尤为必要。

2.2 域自适应方法

由于源域数据和目标域数据上的数据分布不同,在源域上训练得到的模型直接应用于目标域上时,性能往往会降低。因此近年来大量学者对域自适应的方法展开研究。

Long等人首次提出了深度自适应网络(Deep Adaptation Networks, DAN)[25]用于学习迁移特征,并同时优化视觉任务以及域自适应的联合损失。为了更好地衡量域间差异,Long等人又提出了联合最大均值差异[26]。这类方法将深度网络的高层特征转化到再生核希尔伯特空间中,进而使用最大均值差异(Maximum Mean Discrepancy, MMD)作为损失来进行两个域的对齐。

随着生成对抗网络的提出与广泛应用,基于此,近年来学者们提出了一些基于对抗思想的方法。Ganin等人提出域对抗神经网络[27],该网络由特征提取器、分类器和域分类器三部分组成。与此同时,引入了梯度反向层(Gradient Reversal Layer, GRL)来实现域分类模块梯度的反向。Shen等人采用了Wasserstein距离来衡量域间差异[28]。

Chen等人则采用Faster R-CNN的基础框架[16],将对抗的方法成功应用于目标检测中,该方法设计了两个域判别器来实现图像级别和实例级别的对齐。Saito等人则在此基础上进一步提出强弱特征对齐的对抗自适应方法[17],作者同样设计两个判别器,将局部特征进行强对齐的同时对全局特征进行弱对齐,有效提升了目标域上的检测效果。本文的实验将主要与不进行自适应训练的Faster R-CNN和上述两种基于Faster R-CNN框架的自适应检测方法进行比较,对比算法的性能。

3 本文方法

给定含有标注信息的源域遥感图像数据以及不含标注的目标域遥感图像数据,我们的目标是缩小两个域在图像级别和语义级别上的差异,从而实现在目标域图像上的自适应检测。

本文提出的自适应检测网络(Adversarial Adaptive Detection Network, AADN)结构如图1所示。首先,我们分别在上述两个级别上进行对抗训练,并将这两个级别的信息通过多层环境感知模块输入检测器完成检测。目标域为低分辨率图像时,我们先让其通过一个超分辨网络,使其进一步在图像级别进行对齐。以下将详细说明我们的方法。

3.1 基于对抗的自适应检测网络

整体主干网络我们继承了Faster R-CNN的结构,在基础网络模块中,我们共享源域和目标域的网络参数。我们在图像级别采用两个图像级别判别器,在语义级别采用一个二分类判别器,从而进行对抗训练,促使多源遥感图像在两个级别上进行对齐。

首先,源域图像Is和目标域图像It分别通过第一个卷积核Conv0后得到首层的两个特征图![]() 与

与![]() 将两个特征图分别经过梯度反向层GRL,并训练一个全卷积网络

将两个特征图分别经过梯度反向层GRL,并训练一个全卷积网络![]() 作为判别器;同样,在经过Convs1的一系列卷积得到的4倍降采样特征层

作为判别器;同样,在经过Convs1的一系列卷积得到的4倍降采样特征层![]() 和

和![]() 处,训练图像级别判别器

处,训练图像级别判别器![]()

图1 本文提出的自适应检测网络AADN框架图

Fig.1 The proposed structure of adaptive object detection network, AADN

我们规定源域标签为0,目标域标签为1。两个图像级别判别器采用LSGAN[29]中的最小二乘损失。对两个图像级别判别器的损失求和得到:

(1)

其中i代表判别器序号,U、V表示判别器的输出尺寸,||Dimg(M)![]() 表示判别器的输出矩阵上每个点的平方和,即相当于判别器对输出矩阵上的每个点进行判断是否属于源域,并对所有点的结果求均值。判别器的输出经过Sigmoid激活后归一化至0~1。

表示判别器的输出矩阵上每个点的平方和,即相当于判别器对输出矩阵上的每个点进行判断是否属于源域,并对所有点的结果求均值。判别器的输出经过Sigmoid激活后归一化至0~1。

事实上,不同于天气情况存在差异的Cityscape等数据集,多源遥感图像由于成像方式差异,首先在图像通道上就存在差异。因此,基于图像级别的对齐在多源遥感图像中是很有必要的,后续的对抗学习也将依赖浅层特征的提取能力。

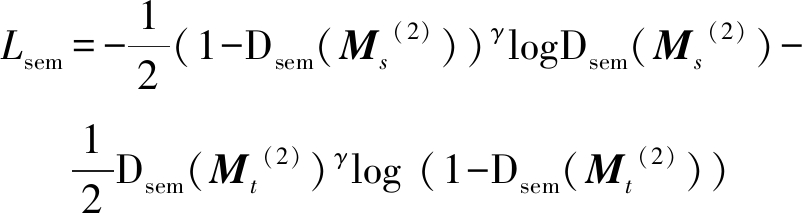

而后,在特征提取网络的最后一层,即卷积层Convs2后的16倍降采样特征层Ms(2)和Mt(2)处,用判别器Dsem来促使网络在高层的语义级别特征上也进行对齐。其中,区别于前两个判别器,判别器Dsem为三层卷积网络与一个全连接层的组合,使得输出为一个二分类的one-hot向量。损失函数采用二分类Focal Loss[30]的形式,具体表示为:

(2)

将图像级别和语义级别的损失统一起来得到对抗损失Ladv为:

Ladv=Limg+Lsem

(3)

我们的目的是训练特征提取网络,使得判别器无法分辨图像是源域还是目标域,同时训练判别器使其尽可能区分图像属于哪个域。因此,问题转化为以下的最优化问题:

(4)

其中E为特征提取网络,D为判别器。因此我们在判别器前加入梯度反向层GRL来优化特征提取网络。之所以这里要用梯度反向层GRL的意义在于,我们优化的目标是要让判别器区分源域和目标域的同时,让网络能尽可能地欺骗判别器,训练的目的在于使两者在对抗的过程中同时变得更好。因此两者的优化目标相反,使用GRL刚好解决了这个优化问题。

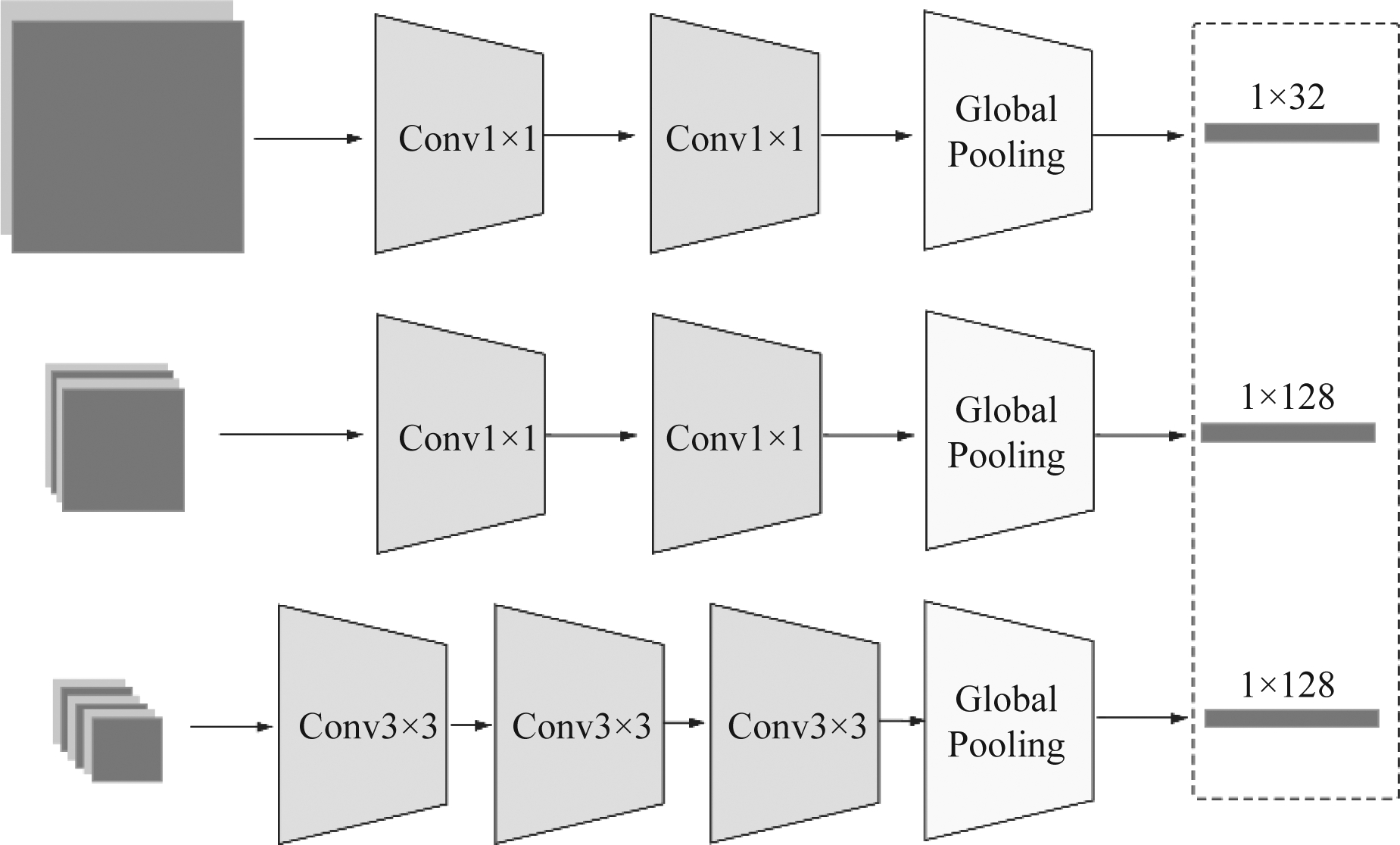

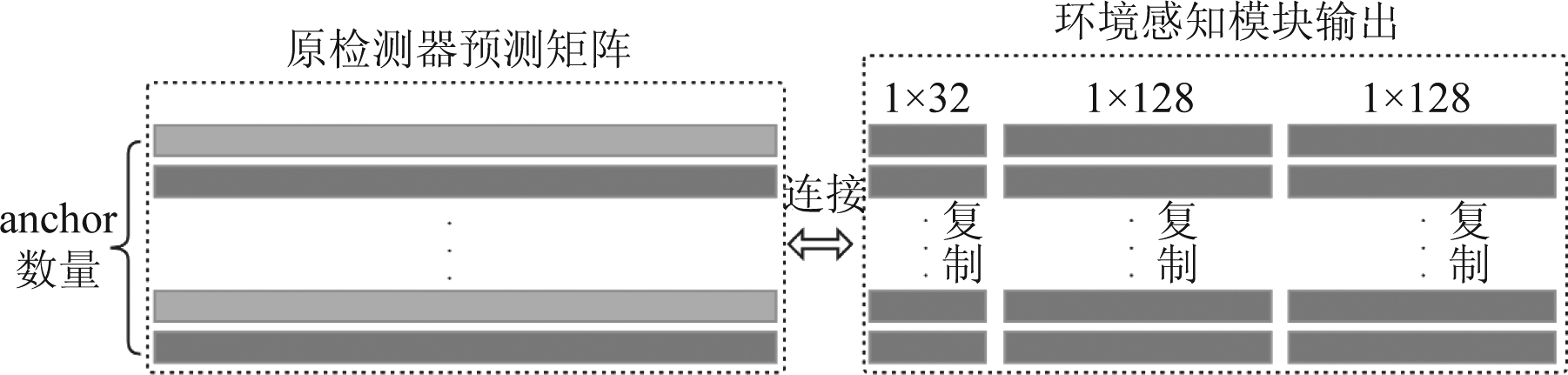

最后,我们将上述三个特征层输入多层环境感知模块,如图2所示,将得到的三个环境感知特征并联至网络最后的检测器中,进行分类和回归,如图3所示。由于遥感图像中目标较小,且尺寸不同,多尺度信息的融入实际上很有必要,浅层的信息更多关注的是目标细节纹理信息,深层的信息更多关注的是目标语义级别的信息,实验证明这些信息的融入会提升检测器的性能。

图2 多层环境感知模块

Fig.2 Multi-layer context awareness module

图3 最终检测器预测矩阵

Fig.3 Final prediction matrix of the detector

整个网络最终的损失函数为:

L=Ladv+Ldet

(5)

其中,Ldet为检测器的分类和回归损失。

3.2 面向低分辨率遥感图像的超分辨网络

我们上述的工作实质是在学习一个条件概率分布P(Y|M(0),M(1),M(2)),其中Y为检测结果,M(0),M(1),M(2)为上述三个特征层,这三者都是输入图像I的函数M(i)=fi(I),而判别器的作用在于优化函数fi,使得源域与目标域图像得到的M(i)尽可能服从相同的分布。但是,当源域Is为高分辨率图像而目标域It为低分辨率图像时,由于目标域上的目标较小,相对于高分辨率图像来说缺少了一些细节信息,判别器不能有效地工作。针对这样的问题,并受到[31-32]等工作的启发,我们这里引入超分辨网络,将低分辨率图像先经过超分辨率网络fSR,使网络在图像级别上进一步对齐,从而新的![]() 又可以进行对抗训练。

又可以进行对抗训练。

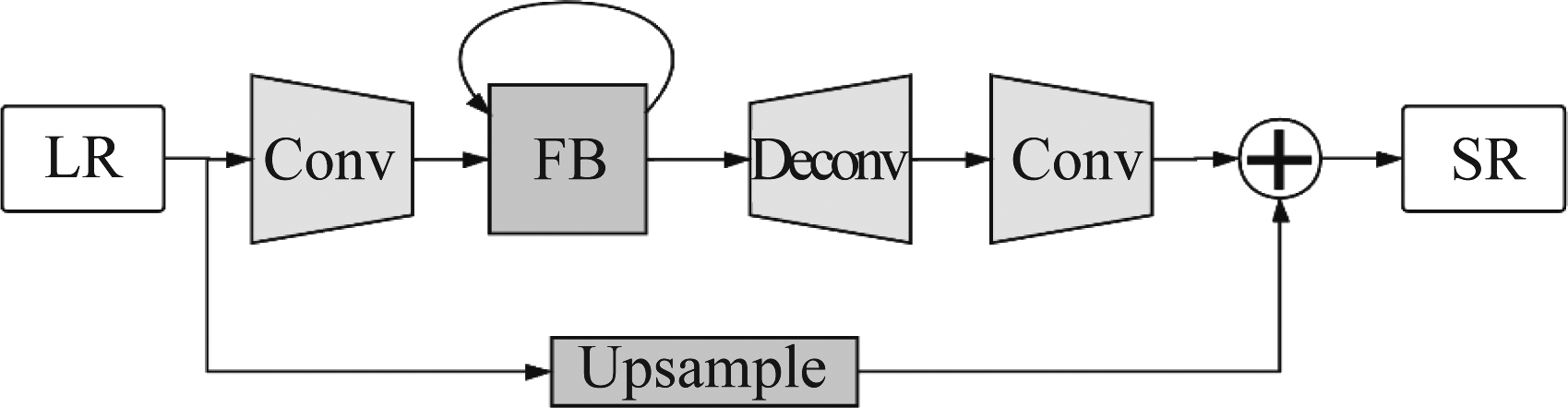

图4 超分辨网络示意图

Fig.4 Super-resolution network diagram

这里我们采用SRFBN[33]作为超分辨网络,SRFBN借鉴了循环神经网络的思想,采用反馈模块,将原来的低分辨率图像与上一时刻的超分辨输出作为下一时刻的输入,迭代地进行训练,如图4所示,其中FB模块即为反馈模块,Conv/Deconv模块为卷积/反卷积模块,LR对应低分辨率图像,SR对应高分辨率图像。重构的损失函数采用L1损失:

(6)

其中,T为每轮迭代的时间步总数,源域的高分辨率图像IHR为标签,将IHR降采样至目标域的低分辨率作为输入ILR,降采样方法选取双线性插值法,通过超分辨网络后的输出为ISR。

然后我们训练超分辨网络fSR,进而将超分辨后的目标域图像裁剪至源域图像大小后送入自适应检测网络。这样的方法一定程度上学习到了高分辨率图像的细节信息,并进一步缩小了两个域在图像级别的域间差异,有效提升了检测效果。

4 实验

4.1 实验数据集

由于本文的问题是针对遥感图像在成像方式和分辨率上的差异问题,因此选用的两个数据集应具有这样的特点。故本文采用两个遥感图像数据集分别作为源域和目标域数据进行验证实验,分别是高分一号卫星拍摄的全色波段遥感图像数据集(GF1-pan),以及高分二号卫星拍摄的RGB三通道融合图像数据集(GF2-rgb-fusion)。以下将对两个数据集进行简要介绍。

GF1-pan数据集是由高分一号卫星拍摄的全色波段图像,包含2855张含标注的图像,标注目标为飞机、舰船和油罐三类,标注格式采用PASCAL VOC格式,空间分辨率为2 m,尺寸为512×512。我们按5.6∶1.4∶3的比例将其随机划分为训练集(1598张),验证集(400张)和测试集(857张)。实验中为了匹配输入维度,我们将全色通道堆叠复制为3通道图像。

GF2-rgb-fusion数据集是由高分二号卫星拍摄的RGB融合图像,包含2273张含标注的图像,标注目标为飞机、舰船和油罐三类,标注格式采用PASCAL VOC格式,空间分辨率为1 m,尺寸为512×512。我们也按5.6∶1.4∶3的比例将其随机划分为训练集(1272张),验证集(319张)和测试集(682张)。

图5 数据集示例(GF1-pan左,GF2-rgb-fusion右)

Fig.5 Examples of the dataset (GF1-pan left,GF2-rgb-fusion right)

4.2 实验细节

训练时,网络输入为一对源域和目标域的图像,特征提取网络部分参数共享,并且采用在ImageNet数据集[34]上预训练的Resnet-101[35]模型。训练时初始学习率设为0.001,每轮迭代10000次,隔5轮降低一次学习率,降低倍数为0.1。当输入为目标域图像时,不计算检测器的损失,即不计算用于分类的交叉熵损失和回归的Smooth L1损失。判别器Dsem中,Focal loss的γ默认设置为5。由于本文采用的图像数据集分辨率为2倍关系,因此超分辨网络的倍数设置为2。当目标域为低分辨率图像时,我们先训练超分辨网络fsr,然后将其固定,进而训练其后的检测网络。

4.3 实验结果及分析

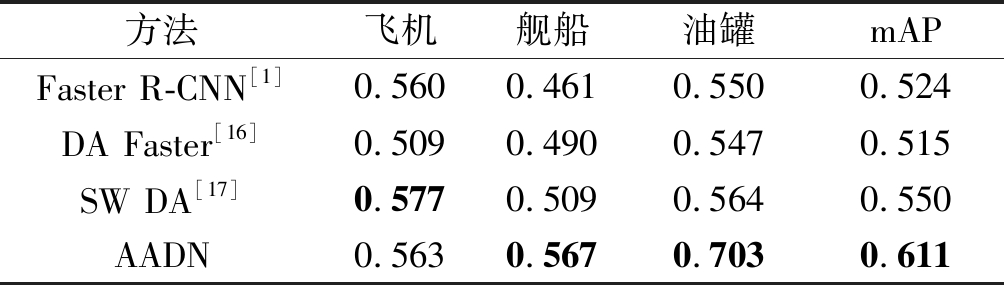

我们分别以高分辨率的GF2-rgb-fusion数据集和低分辨率的GF1-pan数据集作为目标域展开实验,并对比现有的两种自适应检测算法DA Faster[16]和SW DA[17],两者都是采用了对抗的思想并有效应用到了自适应目标检测场景下,具体介绍在相关工作中已经提到。各个方法在目标域上的结果如表1,表2所示。其中Faster R-CNN的结果为仅使用源域数据训练得到的。评估指标为目标检测中常用的平均精度(Average Precision, AP)和平均精度均值(mean Average Precision, mAP),每个目标类别的AP值的均值即为mAP。这里我们默认检测结果与真值框的交并比(Intersection over Union, IoU)大于0.5则认为是检测正确的结果。

表1 源域GF1-pan在目标域GF2-rgb-fusion上的检测结果

Tab.1 Detection results on the target domain GF2-rgb-fusion when the source domain is GF1-pan

方法飞机舰船油罐mAPFaster R-CNN[1]0.5600.4610.5500.524DA Faster[16]0.5090.4900.5470.515SW DA[17]0.5770.5090.5640.550AADN0.5630.5670.7030.611

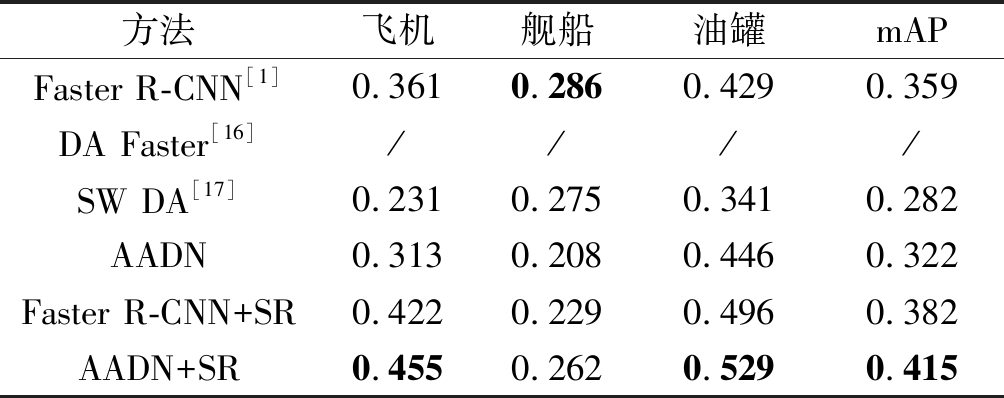

表2 源域GF2-rgb-fusion在目标域GF1-pan上的检测结果

Tab.2 Detection results on the target domain GF1-pan when the source domain is GF2-rgb-fusion

方法飞机舰船油罐mAPFaster R-CNN[1]0.3610.2860.4290.359DA Faster[16]////SW DA[17]0.2310.2750.3410.282AADN0.3130.2080.4460.322Faster R-CNN+SR0.4220.2290.4960.382AADN+SR0.4550.2620.5290.415

由表1所示,可以看到我们的方法明显优于Faster R-CNN未进行域自适应的结果。同时,我们的方法在面对多源遥感图像时也优于其他两种方法,说明该方法在多源遥感图像上有较好的自适应检测效果。由表2所示,当目标域为低分辨率遥感图像GF1-pan时,在源域上训练的高分辨率图像检测模型的效果骤降,DA Faster的方法模型并不收敛,而经过SW DA和本文方法进行域自适应训练后,检测结果有所降低,表明网络并没有有效学习到目标域的信息。正如我们之前分析的那样,由于低分辨率图像损失了空间细节信息,使得高分辨率图像训练的模型失效,需要在图像级别进一步降低域间差异才能继续对抗训练。在结合超分辨网络后,Faster R-CNN的检测结果得到提升,将本文方法与超分辨网络结合后,检测结果得到进一步提升。说明我们的方法依然是有效的,在目标域上的检测结果示例如图6所示。

图6 检测结果示例 (上两图为源域数据训练的模型直接在目标域上进行 检测的结果,下两图为本文方法在目标域上的检测结果)

Fig.6 Examples of the detection results (The above two figures are the detection results on the target domain of the model trained on the source domain, and the following two figures are the detection results on the target domain of the proposed method)

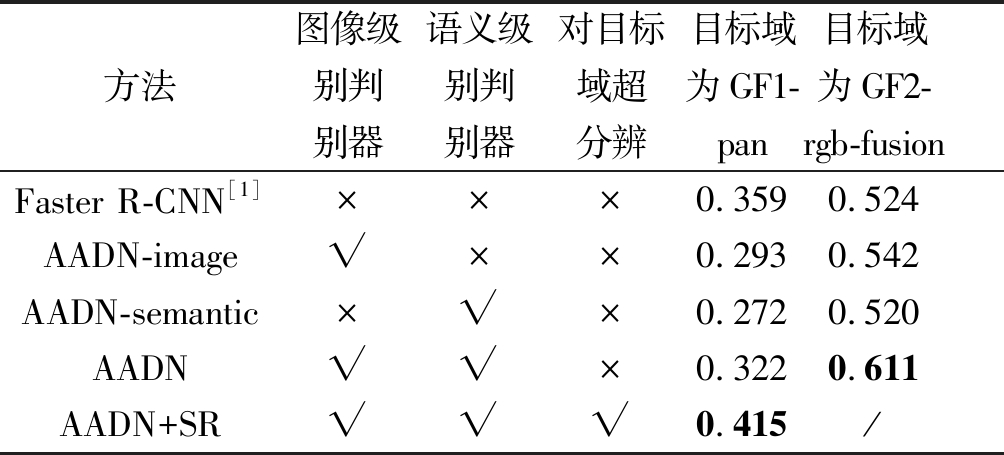

其次,我们也尝试了各个判别器和目标域为低分辨率图像时超分辨网络对检测性能的影响,如表3所示。可以看到,当我们将图像级别和语义级别判别器同时用于训练时,检测结果得到提升;另外,当目标域为低分辨率图像时,正如我们之前分析的那样,超分辨网络作为前缀加入到网络中显得非常必要,进一步降低了图像级别的差异从而让对抗训练起作用。

表3 消融实验(评估指标:mAP)

Tab.3 Ablation experiments (Evaluation index: mAP)

方法图像级别判别器语义级别判别器对目标域超分辨目标域为GF1-pan目标域为GF2-rgb-fusionFaster R-CNN[1]×××0.3590.524AADN-image√××0.2930.542AADN-semantic×√×0.2720.520AADN√√×0.3220.611AADN+SR√√√0.415/

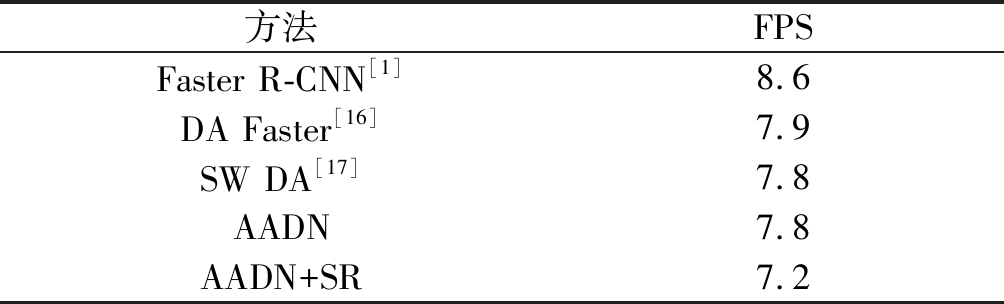

另外,我们验证了算法的时间性能,结果都为在单GPU(Nvidia 1080ti)和CPU(Intel-i7-7700K)上测得,如表4所示,用到的评估指标为每秒处理帧数FPS(Frames Per Second)。可以看到我们的方法并没有损失太多时间性能,但是提升了目标域上的检测性能。

表4 算法时效性

Tab.4 Time performance of the algorithms

方法FPSFaster R-CNN[1]8.6DA Faster[16]7.9SW DA[17]7.8AADN7.8AADN+SR7.2

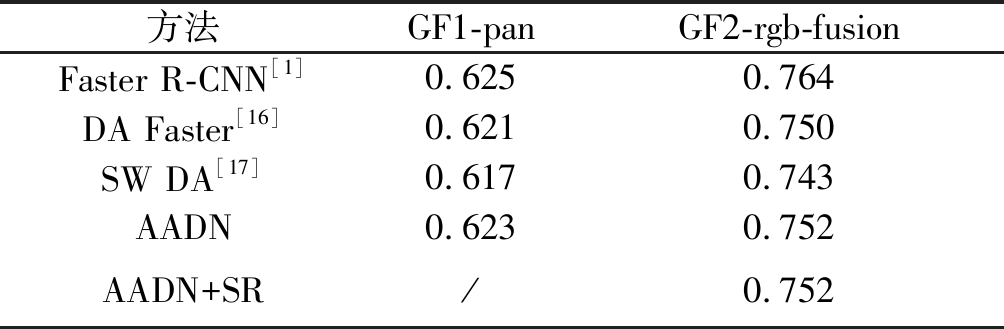

最后,我们也测试了本文方法在源域数据上的效果,如表5所示。与基线Faster R-CNN的效果相比,我们的方法在域自适应训练后,在源域上的检测结果并没有太大影响,说明网络在学习到目标域图像信息的同时,也尽量保留了源域上的检测效果,即网络倾向于学到了两个域中更一般的信息。

表5 在源域上的检测结果(评估指标:mAP)

Tab.5 Detection results on the source domain (Evaluation index: mAP)

方法GF1-panGF2-rgb-fusionFaster R-CNN[1]0.6250.764DA Faster[16]0.6210.750SW DA[17]0.6170.743AADN0.6230.752AADN+SR/0.752

5 结论

本文提出了面向多源遥感图像的自适应检测网络,于图像级别和语义特征级别分别进行域适应,利用多层环境感知模块输出域间信息,并结合超分辨率重建技术,有效提升了在不含标注的目标域遥感图像上的检测效果。我们构建了两个在成像方式和分辨率上存在差异的典型遥感数据集,并分别将两个数据集作为目标域进行双向域自适应实验,实验对比了两种自适应检测方法,验证了本文方法的有效性。未来的研究方向包括针对多源遥感图像的其他特性,如针对不同成像机理的遥感图像进行自适应检测等等。

[1] Ren S, He K, Girshick R, et al. Faster r-cnn: Towards real-time object detection with region proposal networks[C]∥Advances In Neural Information Processing Systems, 2015: 91-99.

[2] Liu W, Anguelov D, Erhan D, et al. Ssd: Single shot multibox detector[C]∥European Conference on Computer Vision. Springer, Cham, 2016: 21-37.

[3] Law H, Deng J. Cornernet: Detecting objects as paired keypoints[C]∥Proceedings of the European Conference on Computer Vision (ECCV), 2018: 734-750.

[4] Everingham M, Van Gool L, Williams C K I, et al. The pascal visual object classes (voc) challenge[J]. International Journal of Computer Vision, 2010, 88(2): 303-338.

[5] Lin T Y, Maire M, Belongie S, et al. Microsoft coco: Common objects in context[C]∥European Conference on Computer Vision. Springer, Cham, 2014: 740-755.

[6] Jiang J, Zhai C X. Instance weighting for domain adaptation in NLP[C]∥Proceedings of the 45th Annual Meeting of the Association of Computational Linguistics, 2007: 264-271.

[7] Dai W, Yang Q, Xue G R, et al. Boosting for transfer learning[C]∥Proceedings of the 24th International Conference on Machine Learning. ACM, 2007: 193-200.

[8] Huang J, Gretton A, Borgwardt K, et al. Correcting sample selection bias by unlabeled data[C]∥Advances In Neural Information Processing Systems, 2007: 601- 608.

[9] Pan S J, Tsang I W, Kwok J T, et al. Domain adaptation via transfer component analysis[J]. IEEE Transactions on Neural Networks, 2010, 22(2): 199-210.

[10]Gong B, Shi Y, Sha F, et al. Geodesic flow kernel for unsupervised domain adaptation[C]∥2012 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2012: 2066-2073.

[11]Long M, Wang J, Ding G, et al. Transfer feature learning with joint distribution adaptation[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2013: 2200-2207.

[12]Li W, Li F, Luo Y, et al. Deep Domain Adaptive Object Detection: a Survey[J]. arXiv preprint arXiv: 2002.06797, 2020.

[13]Cai Q, Pan Y, Ngo C W, et al. Exploring object relation in mean teacher for cross-domain detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 11457-11466.

[14]Arruda V F, Paixão T M, Berriel R F, et al. Cross-domain car detection using unsupervised image-to-image translation: From day to night[C]∥2019 International Joint Conference on Neural Networks (IJCNN). IEEE, 2019: 1- 8.

[15]Lin C T. Cross Domain Adaptation for on-Road Object Detection Using Multimodal Structure-Consistent Image-to-Image Translation[C]∥2019 IEEE International Conference on Image Processing (ICIP). IEEE, 2019: 3029-3030.

[16]Chen Y, Li W, Sakaridis C, et al. Domain adaptive faster r-cnn for object detection in the wild[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 3339-3348.

[17]Saito K, Ushiku Y, Harada T, et al. Strong-weak distribution alignment for adaptive object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 6956- 6965.

[18]Cordts M, Omran M, Ramos S, et al. The cityscapes dataset for semantic urban scene understanding[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 3213-3223.

[19]Sakaridis C, Dai D, Van Gool L. Semantic foggy scene understanding with synthetic data[J]. International Journal of Computer Vision, 2018, 126(9): 973-992.

[20]Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 580-587.

[21]Zou Z, Shi Z. Random access memories: A new paradigm for target detection in high resolution aerial remote sensing images[J]. IEEE Transactions on Image Processing, 2017, 27(3): 1100-1111.

[22]Cheng G, Zhou P, Han J. Learning rotation-invariant convolutional neural networks for object detection in VHR optical remote sensing images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(12): 7405-7415.

[23]Ding P, Zhang Y, Deng W J, et al. A light and faster regional convolutional neural network for object detection in optical remote sensing images[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2018, 141: 208-218.

[24]唐玮, 赵保军, 龙腾. 基于轻量化网络的光学遥感图像飞机目标检测[J]. 信号处理, 2019, 35(5): 768-774.

Tang Wei, Zhao Baojun, Long Teng. Aircraft detection in Remote Sensing image based on Lightweight Network[J]. Journal of Signal Processing, 2019, 35(5): 768-774.(in Chinese)

[25]Long M, Cao Y, Wang J, et al. Learning transferable features with deep adaptation networks[J]. Arxiv Preprint Arxiv: 1502.02791, 2015.

[26]Long M, Zhu H, Wang J, et al. Deep transfer learning with joint adaptation networks[C]∥Proceedings of the 34th International Conference on Machine Learning-Volume 70. JMLR. Org, 2017: 2208-2217.

[27]Ganin Y, Lempitsky V. Unsupervised domain adaptation by backpropagation[J]. Arxiv Preprint Arxiv: 1409.7495, 2014.

[28]Shen J, Qu Y, Zhang W, et al. Wasserstein distance guided representation learning for domain adaptation[J]. Arxiv Preprint Arxiv: 1707.01217, 2017.

[29]Mao X, Li Q, Xie H, et al. Least squares generative adversarial networks[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 2794-2802.

[30]Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 2980-2988.

[31]Shermeyer J, Van Etten A. The effects of super-resolution on object detection performance in satellite imagery[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, 2019: 0-0.

[32]Haris M, Shakhnarovich G, Ukita N. Task-driven super resolution: Object detection in low-resolution images[J]. Arxiv Preprint Arxiv: 1803.11316, 2018.

[33]Li Z, Yang J, Liu Z, et al. Feedback network for image super-resolution[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 3867-3876.

[34]Russakovsky O, Deng J, Su H, et al. Imagenet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252.

[35]He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770-778.