1 引言

目标检测即发现图像、视频中的特定类型目标对象,它是图像、视频高层语义理解的关键环节。近年来随着深度学习技术成功地应用于计算视觉领域,推动了很多视觉任务如模式分类、目标检测等的飞速发展。现有的目标检测算法主要分为两大类,分别是单阶段目标检测算法和两阶段目标检测算法。单阶段算法追求更快检测速度,如SSD系列[1-3]和YOLO系列[4- 6],两阶段算法则更加侧重检测精度,如Faster-RCNN系列[7-11]。此外还有很多目标检测算法尝试从不同的角度来改善目标检测的性能,如面向移动端目标检测的Pelee[12]算法,专门优化密集小目标的RetinaNet[13]算法,不需要候选框的CornerNet[14]算法等。随着CNN(Convolutional Neural Network)网络的不断优化,这些目标检测算法已经在通用目标检测数据集MSCOCO[15]上取得了良好的性能。

在一些特定应用领域,被关注的目标往往是某个类别中的一个子类。 因此有必要对目标检测结果进行更细致的区分。以体育视频为例,人体目标检测算法能够检测出运动员、裁判、观众等各种类型的人体,然而一般情况下,只有运动员的行为和比赛进程直接相关,我们更关注运动员的行为,观众的行为可以忽略甚至去除。目前的目标检测任务都是通用人体检测算法,检测出场景中的所有人包括观众和运动员,不能有效区分不同类型的人体。针对以上问题,常见做法是对运动员这个类别训练一个新的目标检测器[16],另一种则是基于通用检测器的人体检测结果,增加一个关注目标区分模块,实现运动员与非运动员的区分[17]。前者需要大量的训练和标注成本,训练特定模型,不容易借用已有的最先进的目标检测方法。另外由于运动员和观众属于不同的类别,却又有较大的相似性,因此容易形成干扰。如果能基于通用检测器的人体检测结果,通过增加一个关注目标区分模块,来实现体育视频中运动员的检测,便不用重新进行检测框定位,可以有效的减少训练成本,增加通用检测器的适用范围。

事实上无论运动员还是观众,甚至视频监控中的行人都属于人,他们有很大的相似性,都属于广义人体检测任务,也有一些很优秀的人体检测算法如HSFD[18]。但如果直接使用这些模型进行体育视频中运动员的检测会存在很多误检。因此在通用人体检测的基础上,进一步设计分类器将运动员和其人体对象进行区分,其难度远小于直接将运动员从复杂背景检测出来并与其他多种类型的人体进行有效区分。

基于以上分析,本文提出了一种基于多示例学习的目标检测方法。首先收集一些包含运动员的图片作为示例正样本,包含其他类型人体而非运动员的图片作为示例负样本,所有样本都无需标注目标框。然后基于通用人体检测方法进行人体检测,初始化一个特征向量表示运动员,接着训练一个线性变换模块将人体特征映射到运动员特征空间,最后通过度量人体特征与运动员特征之间的相似度,设定阈值实现运动员与非运动员的区分。算法采用多示例学习[19](MIL, Multiple Instance Learning)的方式,以弱监督的形式训练一个线性变换模块,无需目标边框的位置和运动员/非运动员类别标注。同时根据人体检测框在目标检测模型特征图上进行RoIAlign[10]得到人体特征,不需要额外的特征提取网络。

2 通用人体目标检测器的问题与分析

基于通用数据集MSCOCO训练的目标检测模型能够有效地检测图中人体,如果能将这些训练好的模型用于体育视频中运动员的检测,无疑可以降低大量训练和标注成本。但是直接基于这些模型不能有效区分运动员和观众,会给后续的视频分析带来困难。

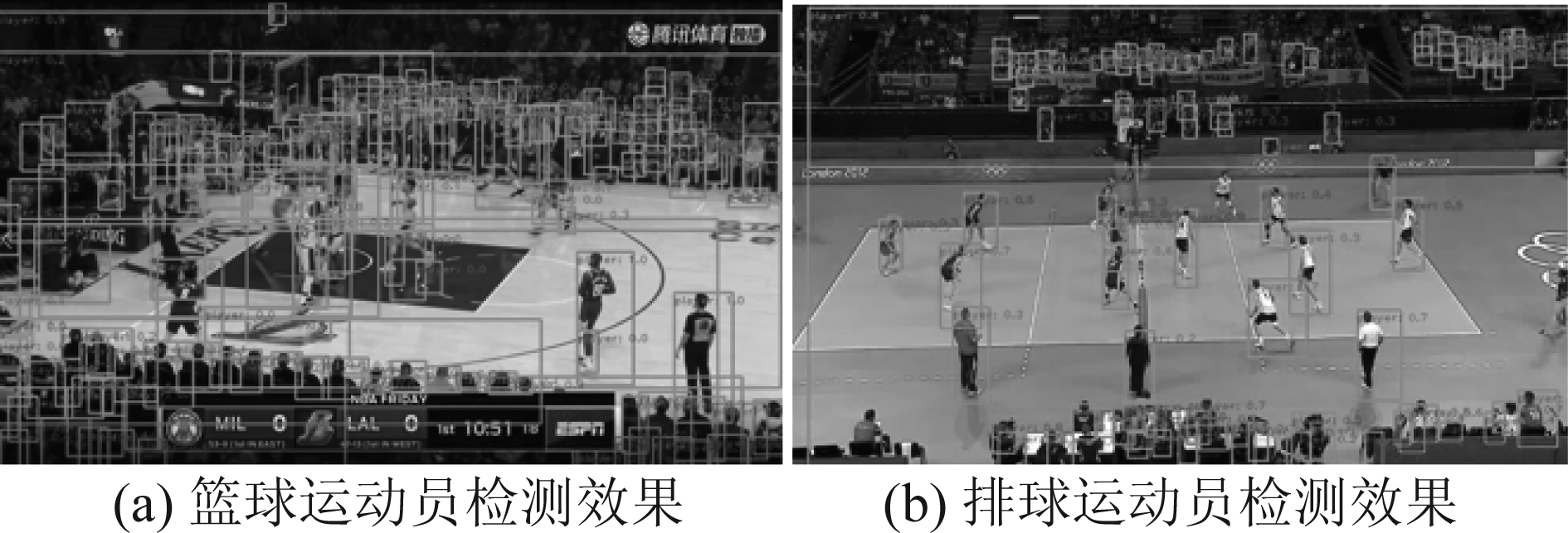

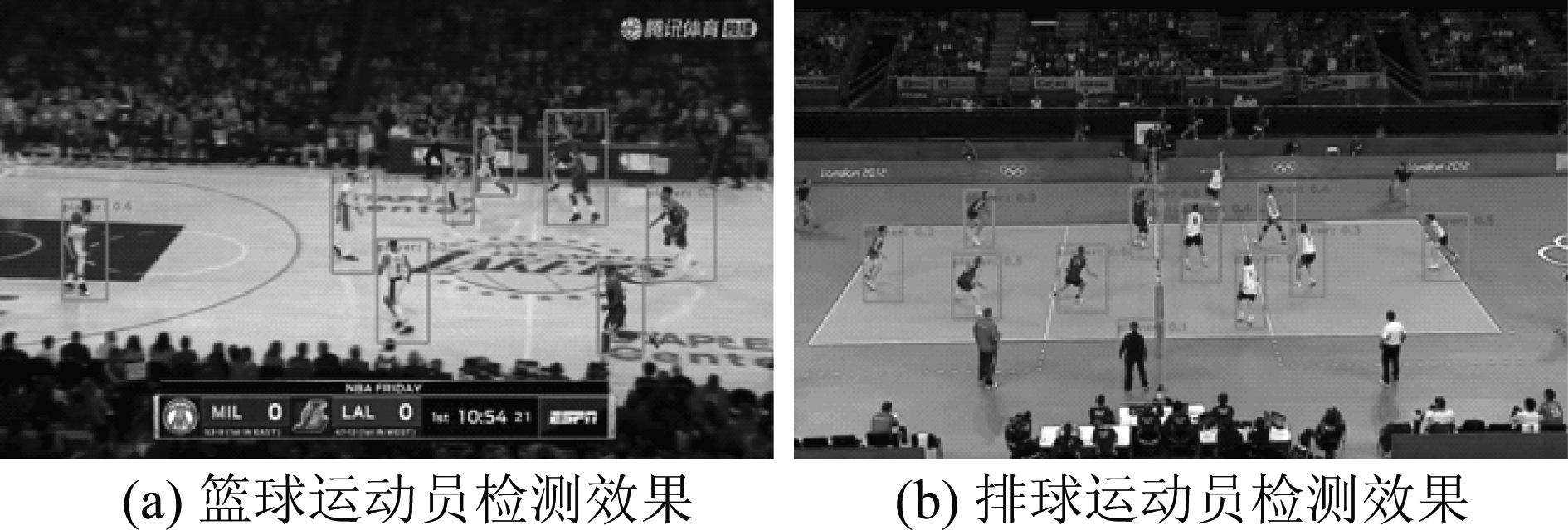

以基于通用数据集MSCOCO训练的Faster-RCNN[9]目标检测模型为例,该模型能在通用目标检测任务上达到35%的mAP,同时对人体的检测精度为83.4%,图1是其对篮球视频和排球视频中人的检测结果。从图中可以看出,虽然运动员都被检测了出来,但也检测出大量观众,可以说该模型缺乏分辨运动员/非运动员的能力。

图1 通用人体检测方法的检测效果

Fig.1 Detection results of common body detector

针对以上问题,需要赋予检测器分辨观众和运动员的能力。一个简单的思路就是基于卷积神经网络训练一个图片分类器。这要求人工标注大量的运动员作为正样本,且把观众和其他对象及背景标注为负样本,然后用这些带标记的数据训练一个图片分类器来检测运动员。这种方法固然可行,但是需要重新训练一个卷积神经网络,且要对大量的检测框进行类别标注,成本较高。

本文提出基于多示例学习的目标检测方法,拟在已有人体目标检测方法的基础上,进一步设计算法来区分运动员和非运动员。任务本质是区分运动员和非运动员,如果将目标检测器对图片中人的检测结果视为一个整体,将对包含运动员图片的检测结果视为正包,对不包含运动员的图片的检测结果视为负包,无需进行运动员和非运动员的标注,就可以通过多示例学习区分出检测框是运动员还是非运动员。多示例学习无需知道目标检测框及类别,只需要知道训练样本里是否包含运动员类别,用包的类别构建弱标签进行训练。由于其不需要对检测框进行人工标注,可以极大地降低标注成本。

3 基于多示例学习的运动员检测

3.1 算法整体框架

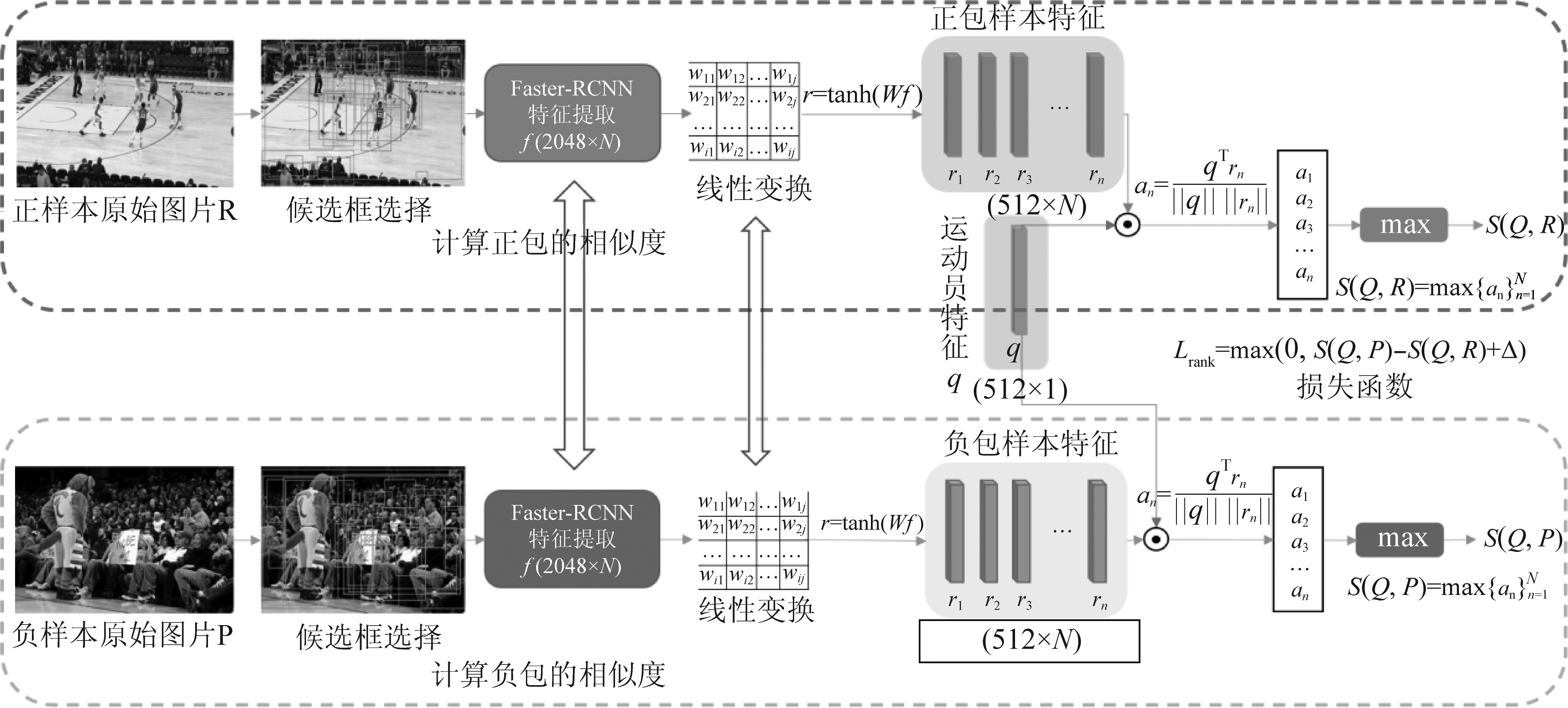

基于通用目标检测数据集训练的检测器已经具有将人从体育视频中检测出来的能力,剩下的问题就是在众多的检测结果中确定运动员。本文提出框架如图2所示。该方案将包含运动员的图片的检测结果作为正包,不包含运动员的图片的检测结果作为负包,然后对这些检测框进行特征提取,并将这些特征通过线性变换映射到同一个特征空间。初始化一个特征向量作为运动员特征,并计算所有检测框特征与运动员特征的相似度,取正包中检测框特征与运动员特征相似度的最大值作为正包相似度,同样取负包中相似度最大值作为负包相似度,依据正包相似度要大于负包相似度构建损失函数进行训练。训练完成后,计算检测结果对应的检测框特征与运动员特征的相似度,设定一个相似度阈值,将大于该阈值的检测结果作为运动员的检测结果。下面将从特征提取、网络构建、损失函数设计等几个方面对基于多示例学习的运动员检测算法进行详细描述。

3.2 候选框选择与特征提取

从图1中的检测结果可以看出,通用目标检测器对观众和运动员都有着一定的识别能力,为了保证运动员被检测的召回率,本文将阈值为0时通用目标检测器的所有检测框作为候选框。

提取检测框的特征,就是对检测框包含的图像内容进行特征提取。检测模型中的CNN网络已经提取了整幅图像的特征,依据检测框的位置,采用RoIAlign方法进行检测框特征的提取。

首先将特征图按双线性插值resize到原图大小,再根据检测框位置在特征图上进行crop,接着将检测框特征图max pooling到统一大小,最后将检测框特征图线性展开,得到一维检测框特征。Max pooling后的检测框特征图大小会根据不同的卷积神经网络而改变,使得一维检测框特征长度在1024到2048之间。

特别地,带RPN[9]结构的两阶段目标检测网络如Faster-RCNN,会对每一个检测框进行特征提取用于分类和边框回归,也就是说Faster-RCNN目标检测算法得到的每一个检测框都有一个唯一的深度特征与之对应,本文直接用这些特征来标识候选框,作为候选框的特征,本文所采用的Faster-RCNN模型提取的边框特征维度为2048维。

3.3 网络构建与损失函数设计

对运动员进行识别,也就是区分运动员和非运动员,本质就是根据候选框的特征对其进行分类。定义一个特征向量q表示运动员,让运动员的候选框特征与q距离近,非运动员候选框特征与q距离远,这样就可以设定一个阈值来区分运动员和非运动员。

基于Faster-RCNN目标检测模型,从候选框选择与特征提取模块,可以得到每个检测框对应的2048维深度特征,该特征可以用于区分不同的检测框,但不能区分运动员与非运动员,所以需要对这些特征进行一个线性变换,如图2所示,这个线性变换模块将2048维的候选框特征变换为512维的新特征。随机初始化一个512维的特征向量q表示运动员,通过不断优化这个线性变换模块的参数,可以使得运动员候选框的新特征与q相似度变大,非运动员候选框的新特征与q的相似度变小。该线性变换模块的计算公式为:

图2 基于多示例学习的运动员检测框架

Fig.2 The framework of player detection based on multiple instance learning

r=tanh (Wf )

(1)

其中f表示候选框原始的2048维特征,r表示线性变换后的512维新特征,tanh是该线性变换模块的激活函数,W则是该线性变换模块的权重参数。

如图2所示,先随机初始化一个512维的特征向量q表示运动员,然后对图片进行候选框选择和特征提取,得到N个2048维的候选框特征向量![]() 再对候选框特征进行线性变换让其与运动员特征具有相同的维度,得到N个512维的候选框特征

再对候选框特征进行线性变换让其与运动员特征具有相同的维度,得到N个512维的候选框特征![]() 候选框特征rn与运动员特征q的相似度计算如下:

候选框特征rn与运动员特征q的相似度计算如下:

(2)

将一张图片中所有的检测框看作一个包,计算候选框特征与运动员特征的相似度,并取相似度的最大值作为这个包与运动员特征的相似度。假设Q表示运动员,R表示包含运动员的图片,那么正包相似度可以表示为:

(3)

式中max是取最大值函数。同样的,令P表示不包含运动员的图片,那么得到负包相似度S(Q,P)。理论上有,包含运动员图片与运动员类别的相似度大于不包含运动员的图片,即S(Q,R)> S(Q,P)。于是该多示例学习模型的损失函数定义如下:

Lrank=max (0,S(Q,P)-S(Q,R)+Δ)

(4)

式中Δ表示相似度区分间隔。因为特征相似度是用余弦距离表示,所以S(Q,R)的取值范围为[-1,1],相似度区分间隔Δ的取值范围为[0,2],损失值的范围为[0,4]。当S(Q,R)> S(Q,P)+ Δ时,该损失函数损失为0,当S(Q,R)< S(Q,P)+ Δ时,该损失函数损失为S(Q,P)- S(Q,R)+ Δ,通过将该损失进行反向传播,不断地对线性变换模块的权重W进行梯度更新,使得运动员候选框的新特征与q相似度变大,非运动员候选框的新特征与q的相似度变小。

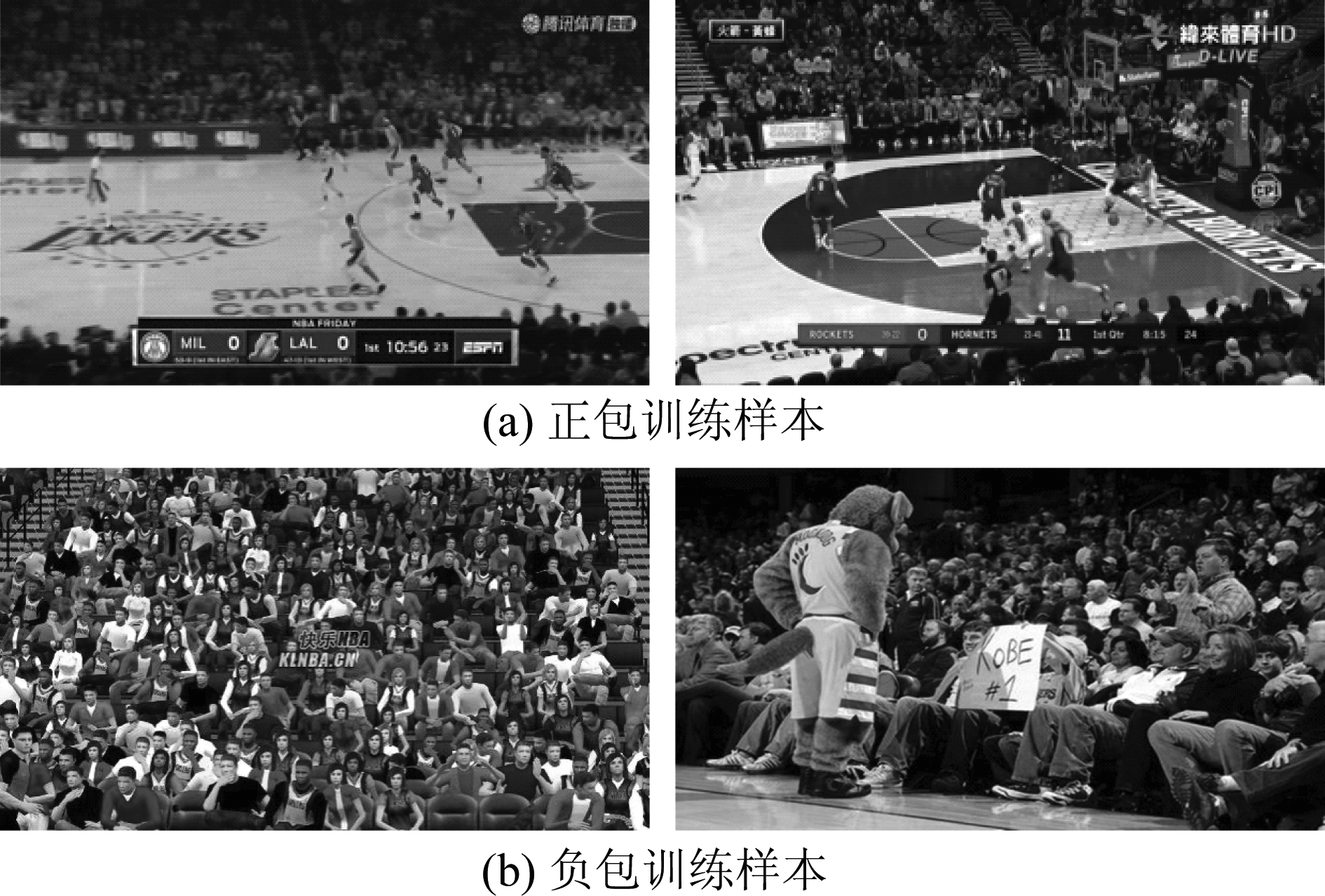

3.4 网络训练

以篮球视频数据集训练为例,从篮球视频数据集中抽取共2000张图片用于构建正包训练集,同时从网上爬取3000张不包含运动员的图片用于构建负包训练集,如图3所示。可以看出正包训练样本中包含运动员也包含非运动员,负包训练样本中包含的均为非运动员,两类训练样本均不需要进行目标框标注。

图3 训练样本示例

Fig.3 Example of training data

在本文中每张图片提取的候选框数量N=100,候选框特征和运动员特征统一映射到同一维度D=512,损失函数的相似度区分间隔Δ=0.2,基于Pytorch深度学习框架构建网络模型,采用Adam优化器以0.001的学习率进行训练。为了提高数据的使用效率和网络的泛化能力,每一组训练数据都分别由正负样本图片中随机抽取的10个候选框特征组成,训练的batch size为8。将正包训练集和负包训练集输入多示例学习模型,先计算候选框特征和运动员特征的相似度,接着计算正包相似度和负包相似度,然后通过损失函数得到网络模型的损失,依据该损失不断反向传播优化参数进行训练。随着训练的不断进行,损失函数值不断降低,也就表示运动员候选框特征与运动员类别的相似度越来越大,非运动员候选框特征与运动员类别相似度越来越小,当模型的训练逐渐稳定,损失函数值不再变化时,停止训练。

在对候选框类别进行预测时,只用将候选框特征输入模型就可以得到与运动员特征的相似度,将该相似度看作候选框的得分(取值区间为[-1,1]),然后设定候选框得分阈值来区分候选框,当候选框得分大于该阈值时就认为该候选框是运动员的检测结果,图4为检测效果示例。

图4 基于多示例学习的运动员检测结果示例

Fig.4 Player detection results of multiple instance learning

4 实验结果与分析

4.1 数据集

为了验证所提方法的有效性,本文基于篮球视频数据集和排球视频数据集进行实验。

1)篮球视频数据集

篮球视频为本文自行收集和整理的数据集,选取了10场完整的NBA篮球常规赛作为原始视频数据,视频总时长达到了1088分钟。采用不影响画质的视频编辑工具,对每一场完整的比赛视频进行片段截取,每场比赛截取10段,每段的时间在5~10秒,共得到100段视频,总时长653秒。接着对这些视频片段进行分帧,并设定尺寸为1000×600像素,共得到17650张图片。

对视频中运动员的边框标注如下,从100段视频中,按照1秒一帧的频率取出视频帧,然后对视频帧中的运动员进行边框标注,标注文件的数据格式与PASCAL VOC[20]数据集保持一致,共标注了650张图片,总计5368个边框。运动员的边框标注效果如图5所示。

2)排球视频数据集

本文使用的排球视频数据集是一个用于团体活动识别任务的公开数据集Volleyball[21], 数据集共收集了55场不同的排球视频,对其中4830个视频帧进行了运动员标注,有5万多个边框。该数据集运动员的边框标注效果如图6所示。

图5 篮球视频中运动员的边框标注 图6 排球视频中运动员的边框标注

Fig.5 Box annotations of player in basketball video Fig.6 Box annotations of player in volleyball video

本文以弱监督的形式完成运动员的检测,因此训练数据集中无需标注运动员的位置,上述标注数据主要用于算法结果的评价,其评价方式与通用目标检测的评估标准一样。本文通过计算检测边框与标注边框的联和交并比IoU(Interaction over Union)来进行评价,当IoU>0.5便认为这个运动员被正确检测,通过计算检测算法在测试集上的AP值来评价算法的性能。

4.2 不同迭代次数下模型性能变化

本文提出的多示例学习模型解决的是一个二分类问题,随着迭代次数的增加模型逐渐优化。本节通过分析中间迭代过程的模型结果,展现模型不断优化的过程。

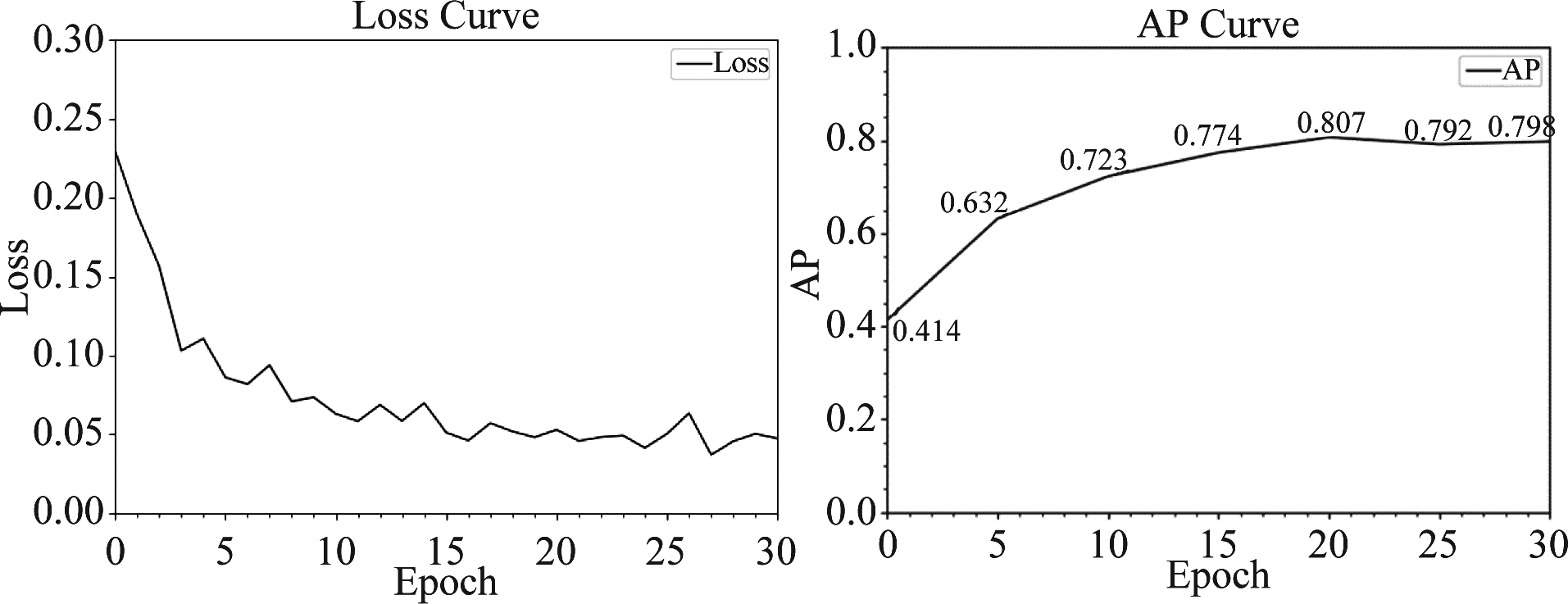

以Faster-RCNN模型为例,其在篮球视频数据集上的损失函数变化曲线如图7所示,可以看到,随着训练进程推进,模型损失函数值不断降低,在训练15个epoch时,模型已经基本收敛,在训练20个epoch以后损失值开始震荡。

同时,每训练5个epoch对模型进行一次保存,待训练完成后对不同模型进行测试得到不同训练阶段模型的AP值如图8所示,从中可以看到随着迭代轮数的增加,AP值逐渐上升,这表明模型渐渐有了区分运动员与非运动员的能力,当模型迭代20个epoch以后AP值变化较小,这说明此时模型已经基本稳定。

图7 损失函数值变化曲线 图8 AP曲线

Fig.7 Loss curve Fig.8 AP curve

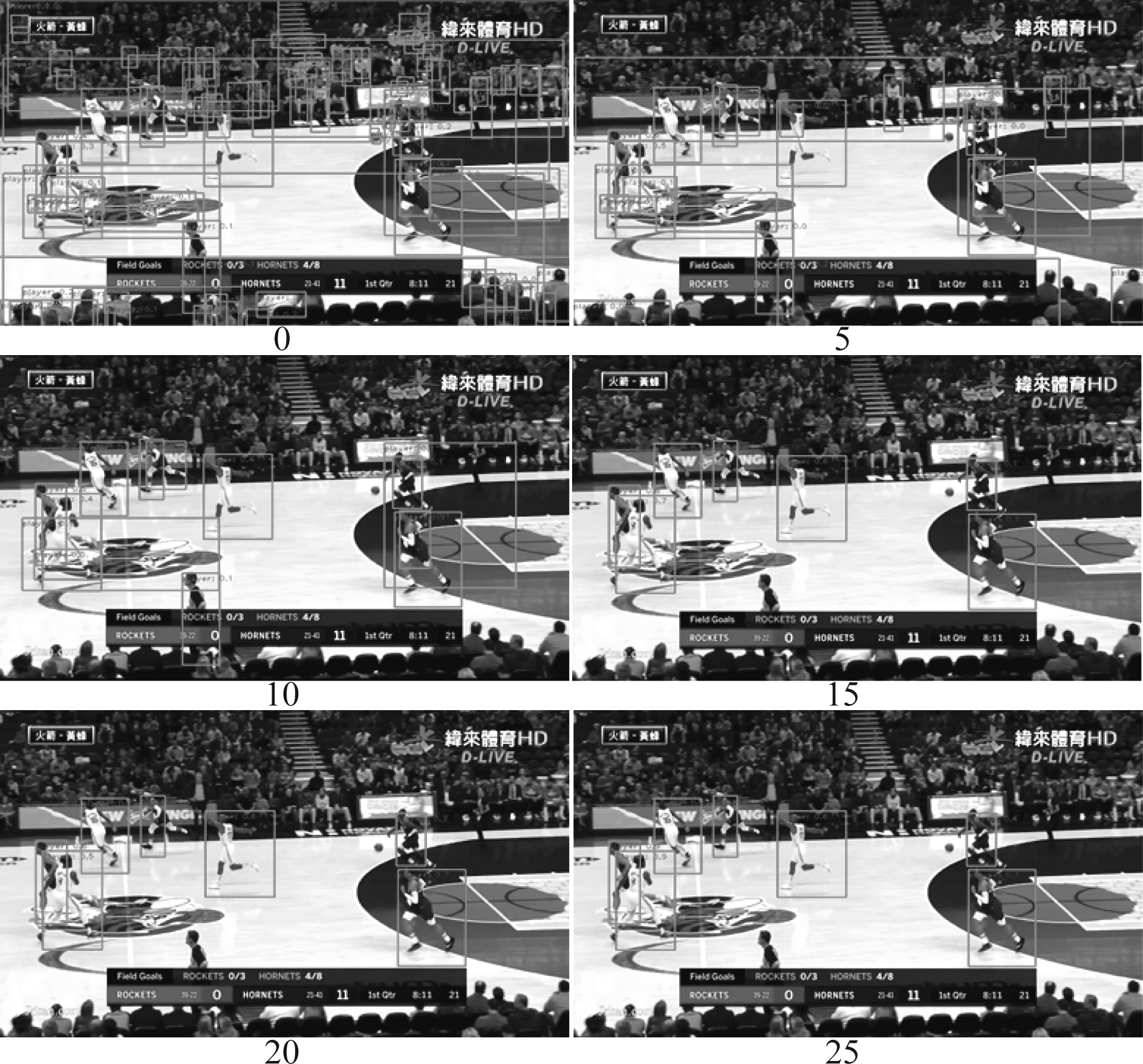

图9 不同epoch模型的检测效果(得分阈值=0)

Fig.9 Detection results of different epoch models (scoring threshold =0)

为了更直接的观察到不同训练时段模型的检测效果,我们进一步给出epoch分别为0(只完成了网络的参数初始化),5,10,15,20,25时模型在同一张图上的检测效果,如图9所示。可以看出,epoch为0时,初始检出的目标较多,包括大量运动员和观众,当epoch=5时,大量观众目标去掉,一些场边观众目标没去掉,另有多个运动员误检成一个目标没去掉。随着epoch的增长,非运动员的检测框在不断减少,最终只保留了运动员的检测框。

上述实验结果表明本文提出方法的模型训练过程本质上是一个迭代优化过程,随着迭代次数的增加,模型检测运动员的准确率不断提升,迭代30次后性能基本稳定。

4.3 多示例学习对检测结果的影响

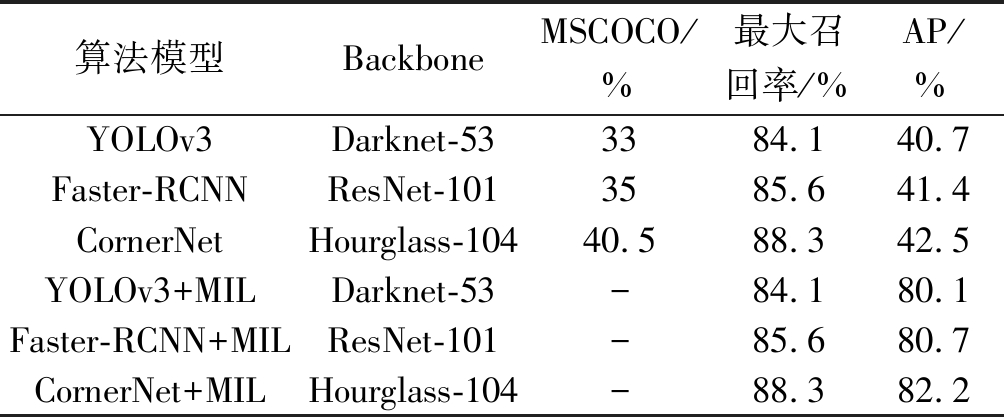

为了验证本文方法能够在通用人体检测结果中有效区分运动员与非运动员,首先直接使用基于MSCOCO数据集训练的通用人体检测模型对运动员进行检测。因为通用人体检测模型没有进一步区分人体类别的能力,因此,在以运动员为检测目标计算AP值的同时计算其对运动员检测的最大召回率来表示模型检测运动员的潜力。然后基于这些通用人体检测模型,引入本文基于多示例学习的运动员检测模块(MIL)对检测结果进行运动员识别,并计算此时对运动员检测的AP值,通过对比AP值的变化来验证本文方法区分运动员与非运动员的能力。

为了验证本文提出方法在不同通用目标检测模型中的有效性,分别从单阶段目标检测算法、两阶段目标检测算法和Anchor-free的目标检测算法中选出了代表性模型YOLOv3[6]、Faster-RCNN和CornerNet来进行对比实验。同时为了验证所提方法在不同体育场景下的泛化能力,分别在篮球视频数据集和排球视频数据集上进行实验。

为了对不同网络模型进行统一的比较,其中主要参数设置如下:NMS(Non-Maximum Suppression)阈值为0.7,每个网络模型统一取检测结果的前100作为检测候选框,Faster-RCNN用其RPN网络得到检测框特征,其余算法则采用RoIAlign的方式得到检测框特征,特别地,YOLOv3有多个尺度的特征图,本文依据其最大尺度的特征图进行特征提取。实验结果如下表所示,表1是篮球视频数据集的检测结果,表2是排球视频数据集的检测结果。

表1 篮球视频数据集的检测结果

Tab.1 Detection results of basketball video dataset

算法模型BackboneMSCOCO/%最大召回率/%AP/%YOLOv3Darknet-533384.140.7Faster-RCNNResNet-1013585.641.4CornerNetHourglass-10440.588.342.5YOLOv3+MILDarknet-53-84.180.1Faster-RCNN+MILResNet-101-85.680.7CornerNet+MILHourglass-104-88.382.2

从表1和表2中数据可以看到,不同目标检测模型虽然在MSCOCO数据集上的表现有一定差距,但是在运动员检测精度接近,对体育视频中运动员的最大召回率也比较接近。同时可以看到,直接使用这些通用检测器检测算法召回率还可以,但是平均精度较低,这是因为通用人体检测模型没有区分运动员的能力。在这些检测模型的基础上,引入本文基于多示例学习的目标检测方法后,对运动员的检测精度有了大幅度的提升。从表1的数据中可以看到,运动员的最大召回率约在84%到88%之间,而引入本文方法后,召回率保持不变,但是检测精度约为原算法的2倍,这表明本文方法能够较好区分运动员和非运动员。

表2 排球视频数据集的检测结果

Tab.2 Detection results of volleyball video dataset

算法模型BackboneMSCOCO/%最大召回率/%AP/%YOLOv3Darknet-533373.227.9Faster-RCNNResNet-1013575.428.1CornerNetHourglass-10440.577.831.2YOLOv3+MILDarknet-53-73.265.3Faster-RCNN+MILResNet-101-75.466.7CornerNet+MILHourglass-104-77.869.6

通过对比表1和表2中的结果可以看到,在排球视频数据集上的性能低于篮球视频数据集。对比分析这两个数据集,发现本文构建的篮球视频数据集在数据形式上比较统一,均是高清的NBA赛事广播视频,而排球视频数据集则来源于Youtube上各种不同的排球赛事,其视频在帧率、画质等方面有较大差异,其中存在一些模糊的视频帧,如图10所示,此时通用检测器不能有效检测人体目标。另外,篮球与排球虽然都存在一定的人员聚集和遮挡情况,但排球会因其运动特性导致长期存在多人聚集网前的情形,如图11所示,这时通用检测器的效果会受到影响。

图10 画质模糊的视频帧 图11 运动员聚集

Fig.10 Blurry video frame Fig.11 Player gathering

4.4 多示例学习对检测时间的影响

本文算法以通用检测模型对人的检测结果为基础,通过多示例学习进一步区分出运动员与非运动员,其耗时为通用检测模型检测时间加上MIL模块进行运动员识别的时间。本文基于GTX1060显卡和i7- 8750CPU得到的不同模型各模块单张图检测耗时如表3所示。

表3 不同模型的检测耗时

Tab.3 Time-consuming of different models

算法模型通用检测模块耗时/msMIL模块耗时/ms总耗时/msYOLOv3+MIL670.99668Faster-RCNN+MIL2531.076254CornerNet+MIL6821.002683

因为MIL模块的单张图耗时太短无法精确测量,所以先统计100次检测的总时间,再对总时间取均值作为各模块的检测耗时。MIL模块只需对提好的特征进行线性变换,不受通用模型的影响,其耗时是独立的,表中结果符合预期。从表中可以看出通用检测模型结构复杂、计算量大,耗时较多,而MIL模块只有两个简单的线性变换,计算量小,耗时较低,在整个通用检测模型+MIL的检测时间中占比很小。也就是说,本文算法在几乎不影响检测时间的情况下,提高了运动员的检测精度。

4.5 对比试验

为了更加准确的评价所提算法检测体育视频中运动员的性能,本文在SPIROUDOME[22]数据集上将本文算法与有监督运动员检测算法进行对比。SPIROUDOME是一个篮球视频数据集,但与本文构建的篮球数据集不同,它是固定视角的篮球监控视频,同时该数据集提供了丰富的边框标注,可以满足有监督训练的需要,图12为该数据集的四个视角示例。

本文将基于此数据集对以下三种运动员检测算法进行对比。1)基于MSCOCO训练的通用人体检测模型Faster-RCNN;2)通用人体检测模型Faster-RCNN与本文提出的多示例学习运动员检测模型相结合,Faster-RCNN+MIL;3)文献[16]基于SPIROUDOME数据集标注数据重新训练的Faster-RCNN模型Faster-RCNN(retraining)。对比实验结果如表4所示。

表4 SPIROUDOME数据集的检测结果

Tab.4 Detection results of SPIROUDOME dataset

算法模型最大召回率/%标注规模精度/%Faster-RCNN88.1-44.9Faster-RCNN+MIL88.18K84.6Faster-RCNN(retraining)[16]-100K85.4

从表4中的结果可以看到,与本文构建的篮球视频数据集相比,通用检测模型Faster-RCNN的最大召回率有一定的提升,这是因为本文构建的篮球视频数据集是NBA赛事广播视频,其中镜头变化较多背景复杂,而SPIROUDOME数据集是固定视角拍摄,其背景单一变化较小,此时通用检测模型往往能有较好的检测效果。可以看到,有监督运动员检测算法Faster-RCNN(retraining)在该数据集上精度为85.4%,本文Faster-RCNN+MIL算法在该数据集上精度为84.6%。虽然有监督算法在性能上略有提升,但是使用了10万规模的运动员边框标注,而本文方法只用了8000张图片的类别标注就能达到与之相当的精度,这说明本文提出的基于多示例学习的目标检测算法能够在通用人体检测器召回率足够时,以极低的训练成本达到有监督算法同样的水平。

图12 SPIROUDOME数据集示例

Fig.12 Example of SPIROUDOME dataset

5 结论

本文针对通用目标检测算法在体育视频中无法有效进行人体类别区分的问题进行了研究,提出了一种基于多示例学习的运动员检测方法。该方法基于通用检测器,基于图像级的弱标记数据,训练线性变换模块来度量运动员与非运动员之间的区别,实现了体育视频中运动员的检测。在篮球视频数据集和排球视频数据集上的实验结果表明,该方法以极低的训练成本实现了体育视频中运动员的检测,并且能达到与有监督目标检测模型相当的水平。论文提出方法的优点在于:一方面可以充分利用已有的通用目标检测模型,另一方面极大地降低了特定类型子目标检测的成本。

致谢:感谢北京-都柏林国际学院的张争妍同学帮忙完成了数据预处理、模型测试实验和实验结果整理。

[1] Liu W, Anguelov D, Erhan D, et al. Ssd: Single shot multibox detector[C]∥European Conference on Computer Vision. Springer, Cham, 2016: 21-37.

[2] Fu C Y, Liu W, Ranga A, et al. Dssd: Deconvolutional single shot detector[J]. arXiv preprint arXiv: 1701.06659, 2017.

[3] Li Z, Zhou F. FSSD: feature fusion single shot multibox detector[J]. arXiv preprint arXiv: 1712.00960, 2017.

[4] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 779-788.

[5] Redmon J, Farhadi A. YOLO9000: better, faster, stronger[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 7263-7271.

[6] Redmon J, Farhadi A. Yolov3: An incremental improvement[J]. arXiv preprint arXiv: 1804.02767, 2018.

[7] Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 580-587.

[8] Girshick R. Fast r-cnn[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 1440-1448.

[9] Ren S, He K, Girshick R, et al. Faster r-cnn: Towards real-time object detection with region proposal networks[C]∥Advances in Neural Information Processing Systems, 2015: 91-99.

[10]He K, Gkioxari G, Doll r P, et al. Mask r-cnn[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 2961-2969.

r P, et al. Mask r-cnn[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 2961-2969.

[11]Cai Z, Vasconcelos N. Cascade r-cnn: Delving into high quality object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 6154- 6162.

[12]Wang R J, Li X, Ling C X. Pelee: A real-time object detection system on mobile devices[C]∥Advances in Neural Information Processing Systems, 2018: 1963-1972.

[13]Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 2980-2988.

[14]Law H, Deng J. Cornernet: Detecting objects as paired keypoints[C]∥Proceedings of the European Conference on Computer Vision (ECCV), 2018: 734-750.

[15]Lin T Y, Maire M, Belongie S, et al. Microsoft coco: Common objects in context[C]∥European Conference on Computer Vision. Springer, Cham, 2014: 740-755.

[16]Lu K, Chen J, Little J J, et al. Light cascaded convolutional neural networks for accurate player detection[J]. arXiv preprint arXiv:1709.10230, 2017.

[17]Zheng L, Yang Y, Hauptmann A G. Person re-identification: Past, present and future[J]. arXiv preprint arXiv: 1610.02984, 2016.

[18]Liu W, Liao S, Ren W, et al. High-level semantic feature detection: A new perspective for pedestrian detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 5187-5196.

[19]Maron O, Lozano-Pérez T. A framework for multiple-instance learning[C]∥Advances in Neural Information Processing Systems, 1998: 570-576.

[20]Everingham M, Van Gool L, Williams C K I, et al. The pascal visual object classes (voc) challenge[J]. International Journal of Computer Vision, 2010, 88(2): 303-338.

[21]Ibrahim M S, Muralidharan S, Deng Z, et al. A hierarchical deep temporal model for group activity recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1971-1980.

[22]Spiroudome dataset. http:∥sites.uclouvain.be/ispgroup/index.php/Softwares/SPIROUDOME.[Online; accessed Mar.7th, 2017].