1 引言

遥感图像目标检测作为遥感图像分割、遥感信息自动提取的基础任务,重在实现的是在遥感图像中标记出目标的类别以及它的具体位置信息。研究遥感图像目标检测技术,能为军事和民用领域提供了重要的可利用信息。由此看来,遥感图像目标检测技术的应用前景将会越来越广阔,其应用范围也会不断扩大。

近年来卷积神经网络在目标检测技术中有着出色的表现,针对R-CNN 检测速度较慢的问题,2015年,He等人提出了SPP-Net(Spatial Pyramid Pooling Network)[9]目标检测算法,该模型仅对输入图像整体提取一次特征,再将推荐产生的候选区域映射到特征图,最后通过SVM分类器对特征表达识别结果。SPP-Net算法的检测速度较R-CNN提高了约24~102倍,且检测精度略高于R-CNN。同年,Ross等在SPP-Net 算法启发下,提出了Fast R-CNN算法。Fast R-CNN对检测图像进行一次卷积特征提取,通过感兴趣池化层(Region of Interest Pooling,ROI)将特征归一化为固定尺寸。Fast R-CNN检测速度较SPP-Net约快10倍,但推荐候选区域阶段依然采用SS算法,产生候选框步骤占据了大量时间。2017年,Ren等人提出的Faster R-CNN算法,采用卷积神经网络RPN(Region Proposal Network)推荐候选区域,而摒弃了之前的Selective Search算法,真正意义上实现了“端到端”的网络,该算法仅利用更少的候选区域,在PASCAL VOC2007[9]数据集上的平均检测精度即达到73.2%。

2016年,Redmon等人提出了无区域建议的方法YOLO,网络包含了24个卷积层和2 个全连接层,该算法不再推荐候选区域,而是将测试图像划分成S×S个网格,在每个网格位置上预测若干个边界框,这种预测方法检测速度非常快,但对于相邻目标检测的效果不好,检测精度不如之前的Fast R-CNN和Faster R-CNN方法。Liu等人提出的SSD方法,结合了 Faster R-CNN中的RPN的思想,在卷积网络的不同特征层的空间上,生成不同尺寸和比例的边界框。SSD算法在保证了检测精度的同时,速度较基于推荐区域的方法快得多。总的来说,SSD是目前主流目标检测算法中,在平衡检测速度和精度上表现最优的算法之一。CNN模型成功应用到自然场景图像的目标检测中,近年来研究学者们开始尝试在遥感图像目标检测任务中应用CNN模型。例如,Cao等人[9]在遥感图像目标检测任务中应用了R-CNN,Yao等人[11]将Faster R-CNN应用到了遥感图像目标检测任务中,大幅提高了遥感图像目标检测的精度,Tang等人[9]提出一种具有轻量化多尺度特点的深度学习飞机目标检测方法,它利用密集连接结构和双卷积通道构成基础骨干网络并连接一个多尺度特征融合检测模块,以提高飞机小目标的检测性能。以上例子都说明了在遥感图像目标检测任务中应用CNN模型的可行性,所以本文提出了一种改进Faster R-CNN的遥感图像目标检测技术。

2 深度可分离残差网络

2.1 深度可分离卷积

Sifre[12]等人提出了深度可分离卷积,并将其应用到了图像纹理分类上。在深度可分离卷积的基础上,为进一步降低模型参数,Chollet[13]提出了Xception,并应用到图像分类中。Howard[14]等人对深度可分离卷积做了进一步的研究,提出了MobileNets,这个网络模型能够运行在手机端,并且取了很好的效果。

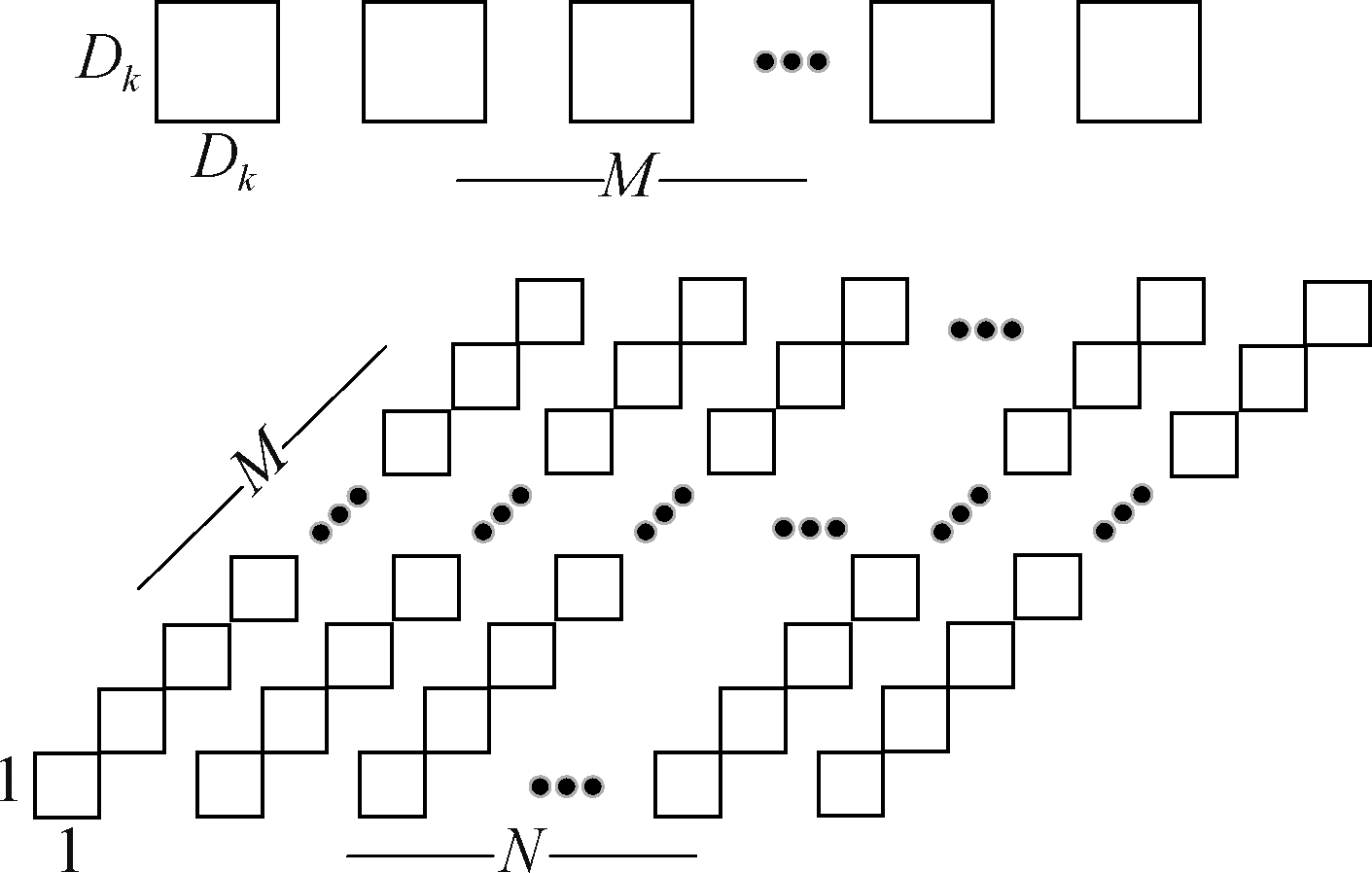

深度可分离卷积层[15]由深度卷积层和1×1的点卷积层组合而成,可以看做是对标准卷积层进行因式分解。深度可分离卷积的过程如图1所示,如果一个输入图像F的维度为DF×DF×M,想要通过深度可分离卷积层生成维度为DF×DF×N的输出图像G,这个任务的完成需要分为两个步骤完成。

图1 深度可分离卷积

Fig.1 Depth separable convolution

首先,输入图像F要经过深度卷积层![]() 由于输入图像对应的通道数为M,故

由于输入图像对应的通道数为M,故![]() 表示输入图像F的每一个通道所对应分配的一个卷积核,总共M个。为了方便计算,设置深度卷积层中卷积核的大小与要替换的标准卷积层中的卷积核的大小相同,用DK来表示,且其步长和填充都为1。设置深度卷积层的卷积核的大小后,进行卷积操作,得到维度为DF×DF×M的特征图

表示输入图像F的每一个通道所对应分配的一个卷积核,总共M个。为了方便计算,设置深度卷积层中卷积核的大小与要替换的标准卷积层中的卷积核的大小相同,用DK来表示,且其步长和填充都为1。设置深度卷积层的卷积核的大小后,进行卷积操作,得到维度为DF×DF×M的特征图![]() 完成这一过程,深度卷积层需要的参数数量具体计算如式(1)所示。

完成这一过程,深度卷积层需要的参数数量具体计算如式(1)所示。

DK×DK×M

(1)

从上式中可以看出,卷积核大小DK和输入图像F对应的通道数M会影响深度卷积层的参数数量。

然后,把第一步中输出的特征图![]() 输入到1×1的点卷积层中去,1×1的点卷积层会改变输入特征图的通道数,不会改变其大小,故点卷积层最终输出的特征图维度为DF×DF×N。完成这个过程,点卷积层需要的参数数量具体计算如式(2)所示。

输入到1×1的点卷积层中去,1×1的点卷积层会改变输入特征图的通道数,不会改变其大小,故点卷积层最终输出的特征图维度为DF×DF×N。完成这个过程,点卷积层需要的参数数量具体计算如式(2)所示。

M×1×1×N

(2)

故点卷积的输入特征图![]() 的通道数大小M和输出特征图

的通道数大小M和输出特征图![]() 的通道N会影响点卷积层的参数数量。

的通道N会影响点卷积层的参数数量。

综上可知,输入图像经过深度可分离卷积层需要的总的参数数量是以上两个步骤的总和,即深度卷积层需要的参数数量加上点卷积层需要的参数数量之和,具体的计算公式如式(3)所示。

DK×DK×M+M×N

(3)

如果输入图像F通过标准卷积层生成维度为DF×DF×N的输出图像G,只需一步完成,其所需的参数数量具体计算如式(4)所示。

DK×DK×M×N

(4)

根据式(3)和式(4)则可以计算出标准卷积层被深度可分离卷积层代替后,参数数量的减少比例,具体计算公式如式(5)所示。

(5)

从式(5)可知,如果深度可分离卷积核DK=3,则参数数量与标准卷积层相比会减少8~9倍。由此可见,在CNN模型中将标准卷积层用深度可分离卷积层替换,能够大幅度降低网络模型的参数数量,而且不会改变网络模型的性能。

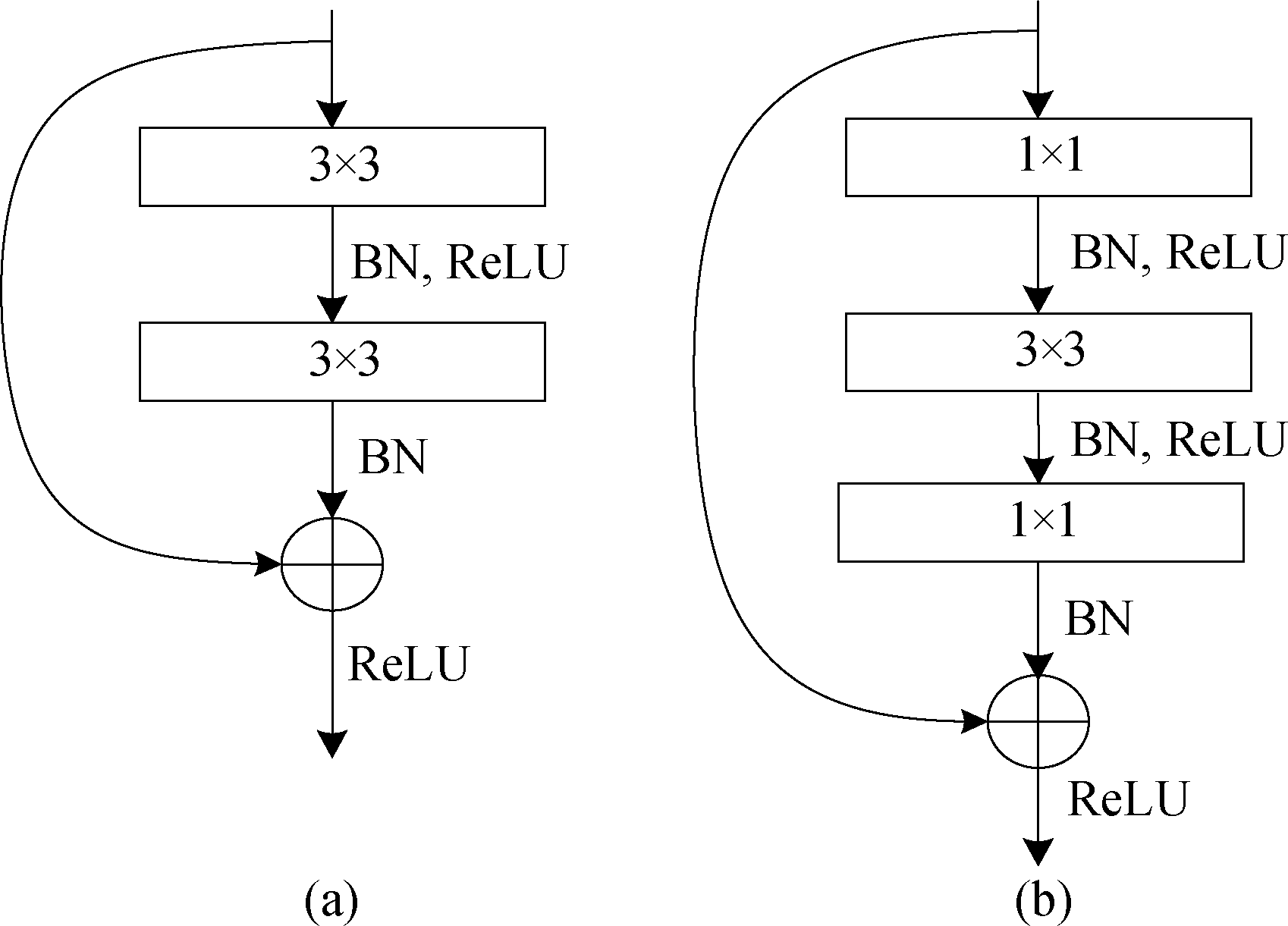

2.2 网络结构的设计

随着卷积神经网络的成熟发展,其结构也在不断加深,但也出现了一些问题。网络层数的不断增加,会导致准确率上升达到饱和之后出现下降的情况,即网络性能退化问题。为了能够有效解决网络性能的退化问题,ResNet模型应运而生,并成功解决了这个困扰研究学者们的问题。在ResNet模型中包含有多个残差模块,残差模块中采用残差连接的方式,保证了网络在增加深度的同时避免性能发生退化现象。常用的传统残差模块有两种,即无瓶颈残差模块和瓶颈残差模块,如图2(a)和图2(b)所示。

图2 传统残差模块

Fig.2 Traditional residual module

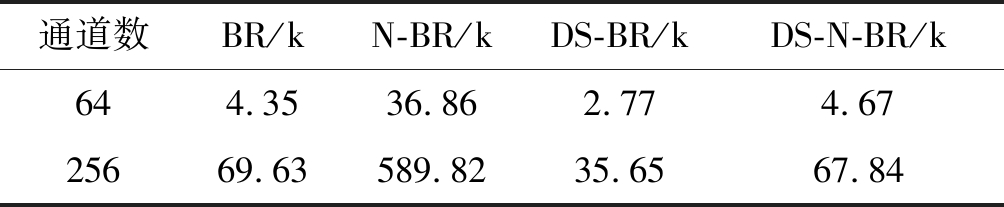

图2中的BN为归一化层,ReLU为激活函数,能够提高网络模型的训练速度,提高网络模型的泛化能力。当网络模型的层数较少时,在参数数量和检测精度上两种残差模块的表现几乎一样。但如果加深网络模型的层数,无瓶颈残差模块在提高检测精度上表现好,而瓶颈残差模块在时间运行效率上表现好。为了验证两种残差模块与深度可分离卷积相结合的优势,本文做了如下的计算。当残差模块的输入输出通道数为64和256时,计算各种残差模块所需要参数的数量并进行对比,如表1所示。

表1 不同残差模块的参数

Tab.1 Parameters of different residual modules

通道数BR/kN-BR/kDS-BR/kDS-N-BR/k644.3536.862.774.6725669.63589.8235.6567.84

在表1中,瓶颈残差模块为BR;无瓶颈残差模块为N-BR;深度可分离卷积与瓶颈残差模块结合的新模块为DS-BR,深度可分离卷积与无瓶颈残差模块结合的新模块为DS-N-BR。从表中可以看出,当输入输出通道数都为64时,DS-N-BR(4.67k)的参数数量是N-BR(36.86k)的12.66%,DS-BR(2.77k)的参数数量是BR(4.35k)的63.67%。当输入输出通道为256时,DS-N-BR(67.84k)的参数量是N-BR(589.82k)的11.50%,DS-BR(35.65k)的参数量是BR(69.63k)的51.19%。由此可知,在降低网络模型参数数量上,将深度可分离卷积与无瓶颈残差模块结合降低模型参数的幅度更大,而且输入输出通道数越大,降低模型参数的效果更加明显。因此,本文采用深度可分离卷积与无瓶颈残差模块结合,来构建可分离残差模块,其具体结构如图3所示。

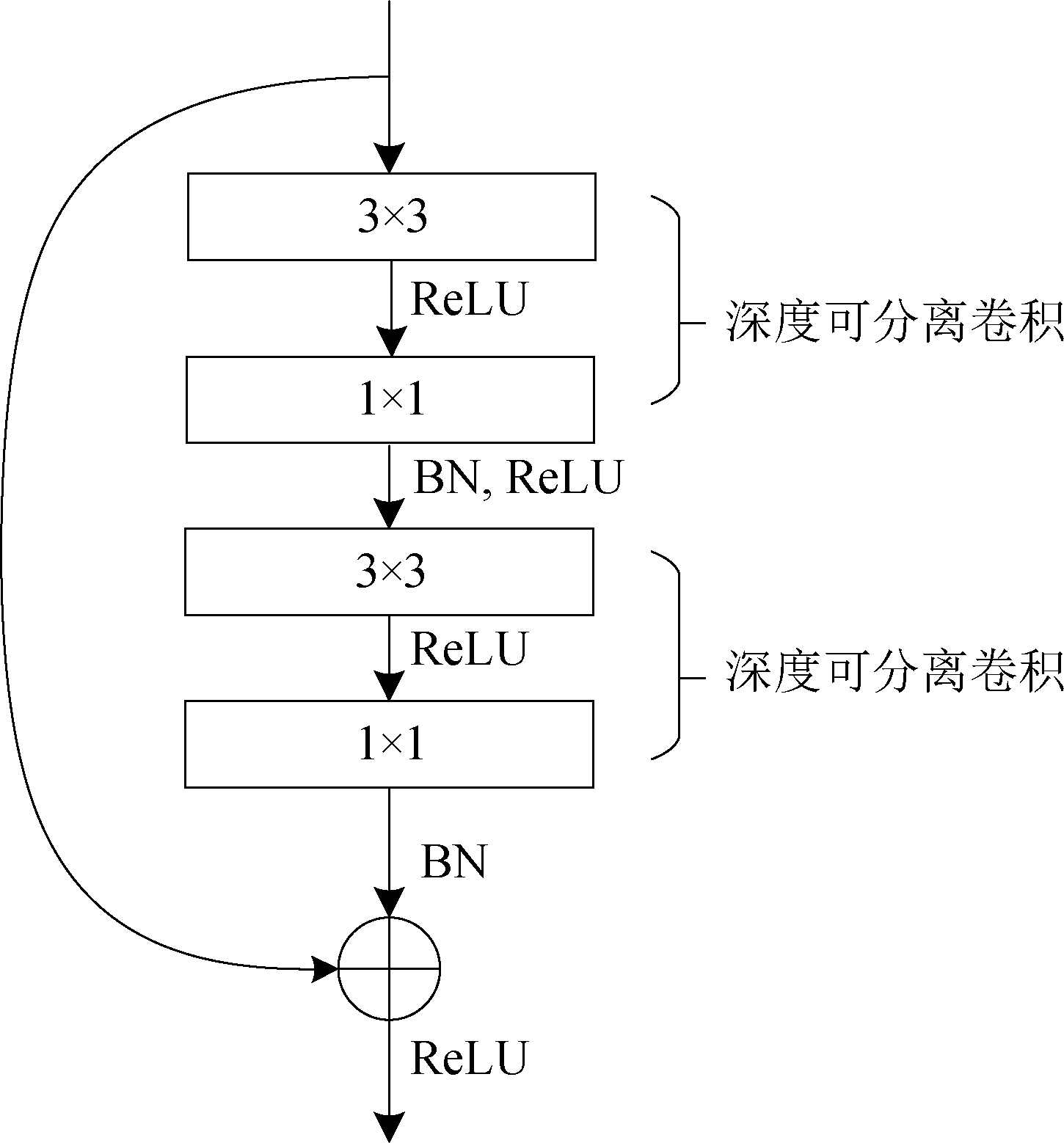

图3 可分离残差模块

Fig.3 Separable residual module

从图3可以看出,可分离残差模块以无瓶颈残差模块为基础,将标准卷积用逐通道的深度卷积层来替代,大小为3×3,然后用1×1大小的点卷积层对各个通道的信息进行压缩组合。这样能在网络层数加深时保持较低的参数数量,又能有效地提取图像的特征信息。为了保持网络模型在学习性能和学习效率间的良好平衡,可分离残差模块在3×3卷积层之前没有对特征图进行降维操作。

可分离残差模块,将深度可分离卷积与残差连接相结合,能够解决传统残差模块学习能力和计算效率低的问题。受ResNet结构的启发,本文基于可分离残差模块设计了深度可分离残差网络(DS-ResNet),能够解决现有目标检测技术不能同时满足高精度和高效率的问题,其具体结构如表2所示。

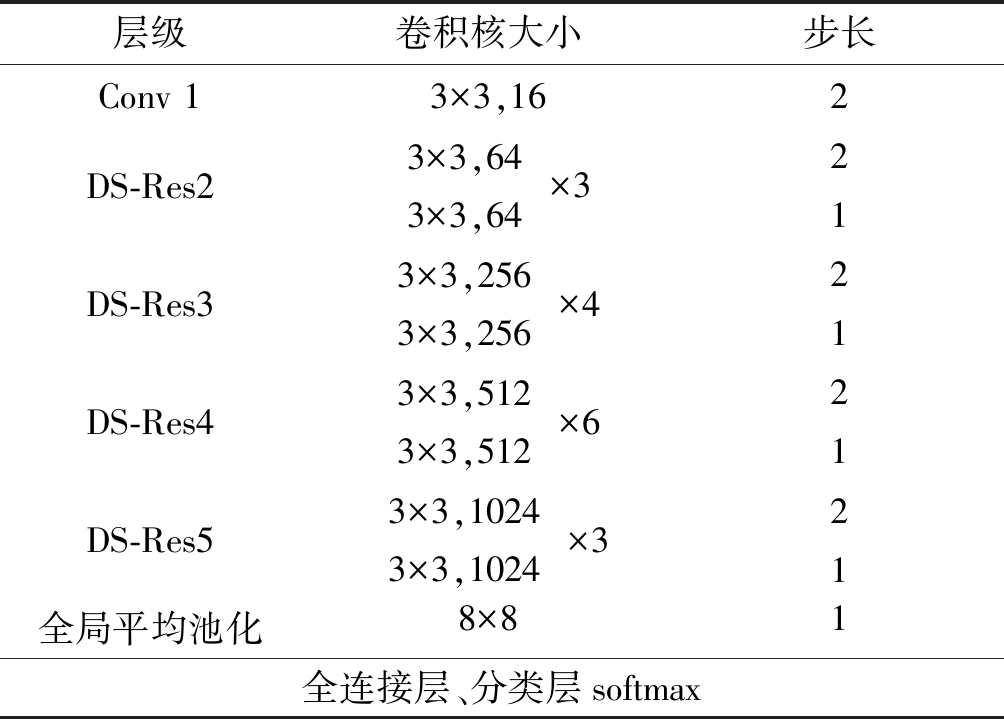

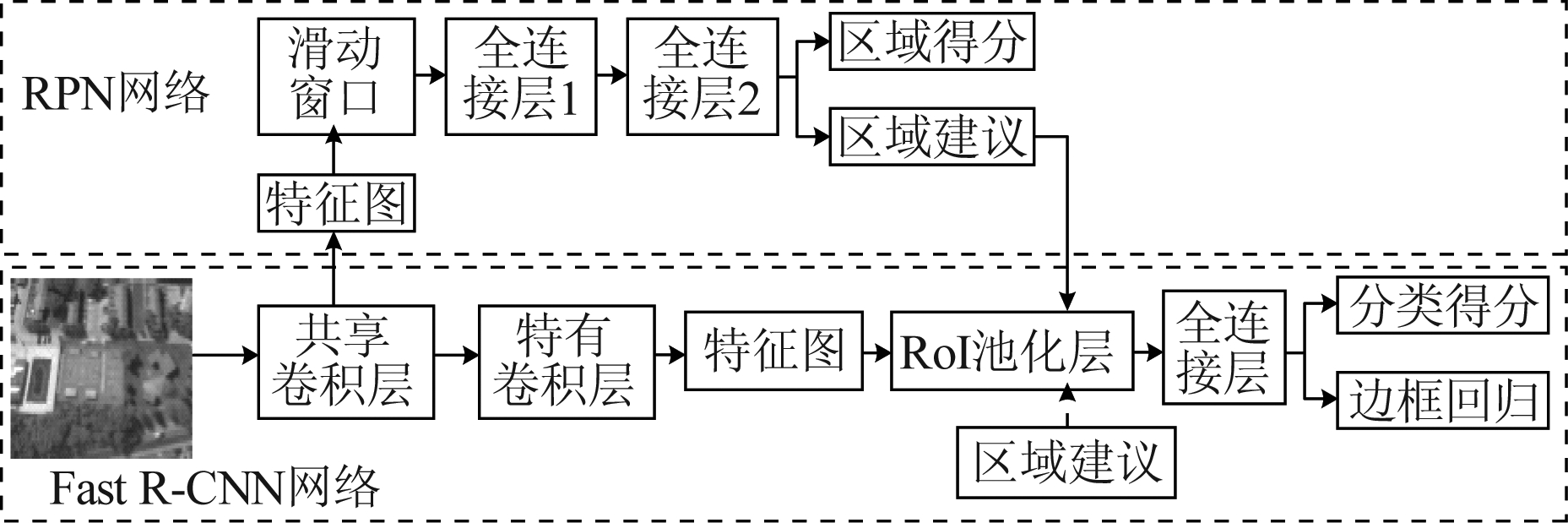

从表2可知,深度可分离残差网络由1个初始标准卷积层、4个深度可分离残差层、1个全局平均池化层、1个全连接层和1个softmax分类层组成。标准卷积层Conv1采用的是3×3尺寸、步长为2的卷积核;深度可分离残差网络从DS-Res2开始到DS-Res5结束,DS-Res的每一部分均由无瓶颈可分离残差块组成,依次包含的残差块的个数为3、4、6、3,残差块中卷积层卷积核的个数依次为64、256、512、1024,而且每个残差块中第一个卷积层的步长为2,其余的卷积层步长都为1;之后使用一个全局平均池化得到一个1024维度的深度特征,再连接一个全连接层之后,输入到softmax 分类层中。与最大池化相比,全局平均池化进一步降低了网络模型的参数数量,节约了网络模型的存储空间,缩短了网络模型的训练时间。

表2 深度可分离残差网结构

Tab.2 Depth separable residual network structure

层级卷积核大小步长Conv 13×3,162DS-Res23×3,643×3,64()×321DS-Res33×3,2563×3,256()×421DS-Res43×3,5123×3,512()×621DS-Res53×3,10243×3,1024()×321全局平均池化8×81全连接层、分类层softmax

如表3所示,对比选用不同卷积方式时,网络的计算复杂度及网络参数的变化,可以看出,深度可分离卷积在优化网络模型中具有很重要的作用。

表3 不同卷积方式网络计算复杂度及网络参数比较

Tab.3 Comparison of network computational complexity and network parameters in different convolution strategy

方法属性 标准卷积深度可分离卷积计算复杂度990 MFLOPS125 MFLOPS网络参数2.11 G0.27 G

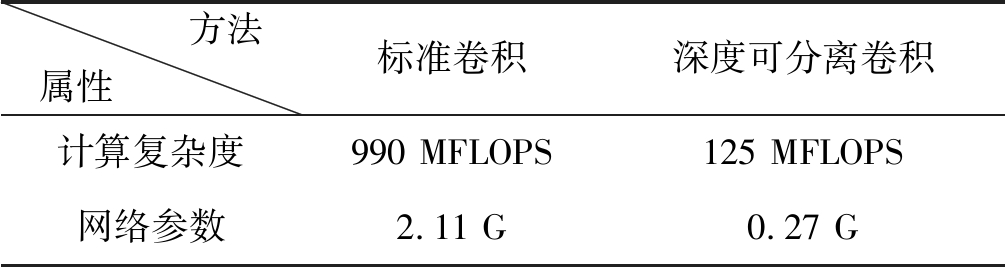

3 用于遥感图像目标检测的Faster R-CNN

在Fast R-CNN中,选择性搜索方法生成候选区域的过程耗费了大量时间。为了增强目标检测方法的实时性,提高检测方法的运行效率,Shaoqing Ren等人在Fast R-CNN的基础上提出了新的目标检测方法——Faster R-CNN[5],对候选区域的产生做出了改进,首次提出了叫做RPN(Region Proposal Network)的网络结构,即区域候选网络。将RPN与Fast R-CNN相结合就构成了Faster R-CNN,其具体结构如图4所示。

图4 Faster R-CNN结构

Fig.4 Faster R-CNN structure

3.1 基础网络轻量化

轻量化卷积神经网络模型设计,是指在借鉴现有卷积神经网络结构基础上,重新设计网络结构,以达到减少参数量,降低计算复杂度的目标。加深卷积神经网络模型的结构,能够使网络模型提取到丰富、准确的特征信息,从而可以提高目标检测的准确率。但卷积神经网络结构的加深也会带来一些问题,针对网络加深会带梯度消失和梯度扩散问题,本文选取了2.2节中提出的深度可分离残差网络来作为Faster R-CNN的基础网络对待检测图像进行特征提取。

3.2 多层卷积特征融合

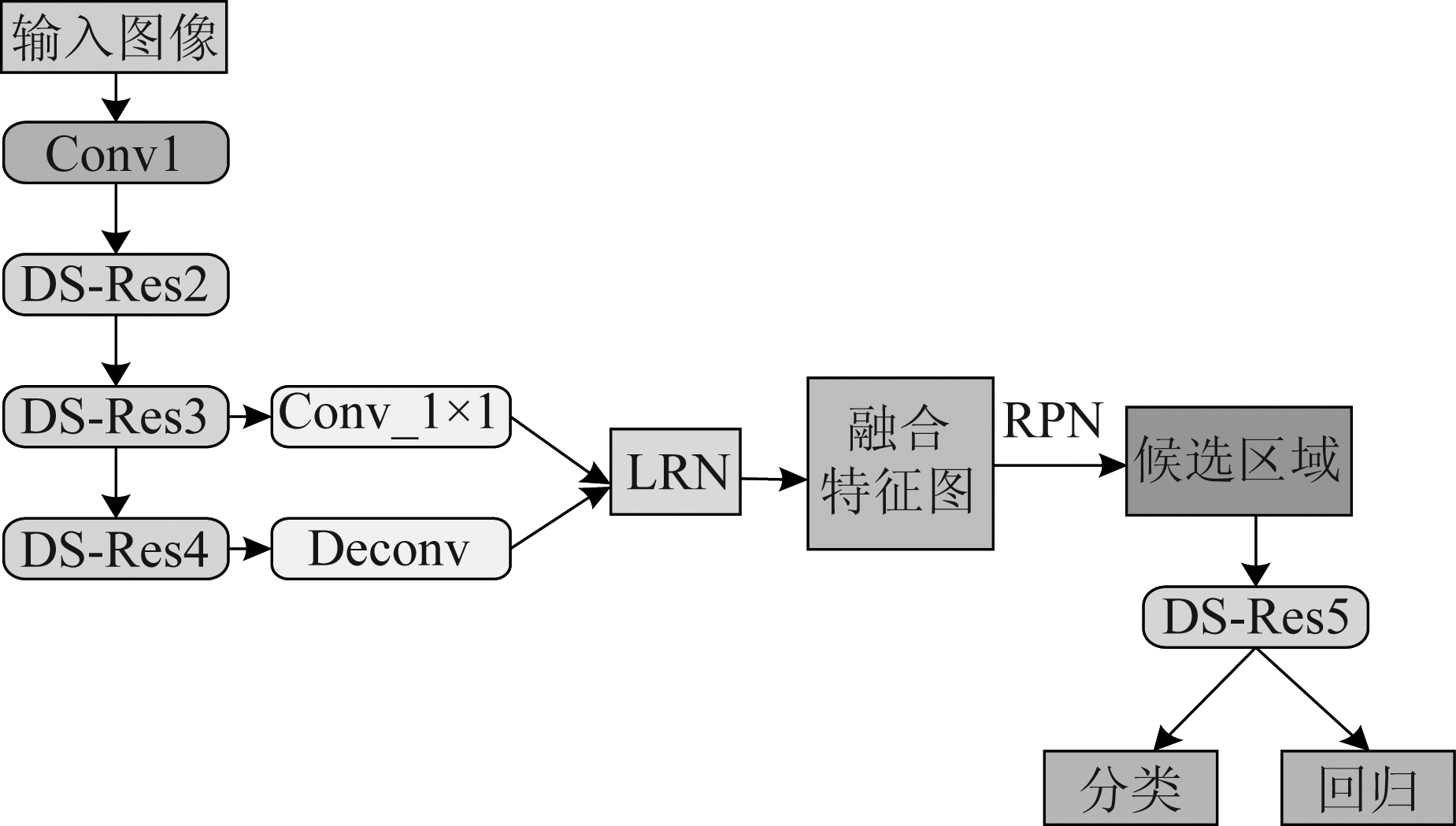

在Faster R-CNN中,RPN的输入是单层卷积特征图,缺少了图像中目标的细节特征信息,而且图像中的小目标在高层卷积层输出的特征图中尺寸比较小,这就使得小目标的特征信息不能得到充分的表示。在卷积层输出的特征图中,更多像素信息被包含在低层卷积层输出的特征图中,而且目标在低层卷积特征图中的轮廓也比较清晰,这有利于对小目标的检测;更多的语义特征信息被包含在高层卷积层输出的特征图中,这有利于对较大目标的检测。因此,本文提出了多层卷积特征融合,将不同卷积层输出的特征图进行融合后,输入到RPN网络中,这就对Faster R-CNN易漏检小目标的问题做出了改进。但各个卷积层输出的特征图大小都不一样,卷积层级越高,其输出特征图的大小越小。而本文将深度可分离残差网络中的DS-Res3层和DS-Res4层输出的特征图进行特征融合,具体流程如图5所示。

图5 多特征融合的Faster R-CNN结构

Fig.5 Multi-feature fusion of Faster R-CNN structure

3.3 损失函数优化

在Faster R-CNN 中,使用softmax 损失函数来训练网络模型。但是 softmax 损失函数会优化类别间的差异,忽略了内类紧凑性,从而使得分类误差较大。为了优化Faster R-CNN 的损失函数,本文在 Faster R-CNN 的原有损失函数的基础上加入中心损失函数,即将 softmax 损失函数和中心损失函数联合起来作为网络模型训练时的优化目标,这样能够使网络模型学习到更具差异性的深度特征,即缩小类内特征变化,增大类别间的特征差异,从而提高网络模型的泛化能力。

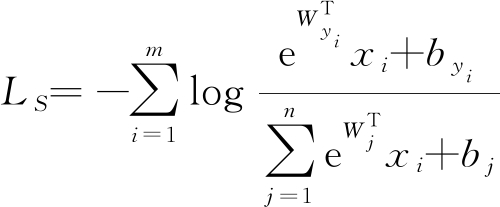

softmax 损失函数如式(6)所示:

(6)

其中,m是批处理的数量,d为特征维度,b∈Rn是偏置项,xi∈Rd为第yi类的第i个深度特征,W∈Rd×n是最后一个全连接层的权重,n是类别数量。

中心损失函数如式(7)所示:

(7)

其中,cyi∈Rd是第yi类的深度特征中心。中心损失函数能学习到每个类别的中心。联合后的损失函数如式(8)所示:

L=LS+λLC

(8)

其中,参数λ是中心损失函数的权重系数,当λ等于0时,没有加入中心损失函数来训练网络模型。损失函数的训练通过随机梯度下降法(Stochastic gradient descent, SGD)来进行。

4 实验结果与分析

4.1 实验环境和参数

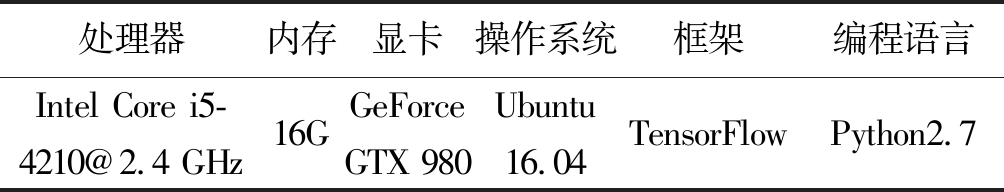

本文所用的实验软硬件平台配置如表4所示,在此环境下搭建Faster R-CNN 模型,来验证本文方法的有效性。

表4 实验环境参数

Tab.4 Experimental environment parameters

处理器内存显卡操作系统框架编程语言Intel Core i5-4210@2.4 GHz16GGeForce GTX 980Ubuntu 16.04TensorFlowPython2.7

为了避免在小数据集上训练产生过拟合问题,本文在遥感图像的目标检测中加入了迁移学习[16-17],选用在图像检测任务中应用最为广泛的COCO[18]数据集进行预训练,该数据集包含16万张图像,涵盖80个类别。

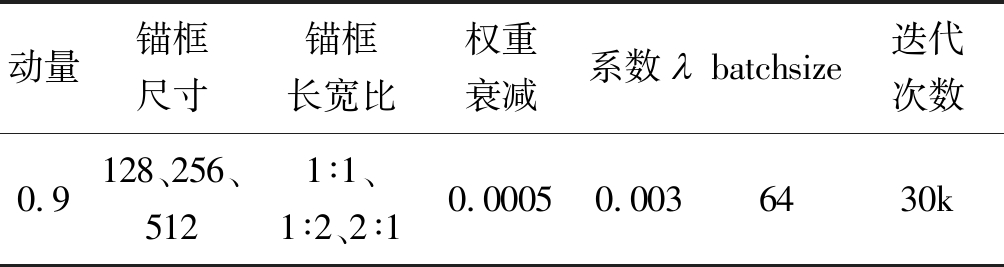

在COCO数据集上预训练得到的网络模型之后,对预训练模型进行参数初始化:锚框的三个尺寸设置为128、256、512,长宽比为1∶1、1∶2、2∶1,用于非极大值抑制的目标得分阈值设置为0.7,batchsize设置为64,网络训练时的初始学习率为0.001,使用SGD来对网络的损失函数进行优化时,其中动量项Momentum设置为0.9。最大迭代次数为30000,中心损失函数的中心学习率设置为0.5,其权重系数(经验值),主要的参数设置如表5所示。

表5 实验参数设置

Tab.5 Experimental parameter setting

动量锚框尺寸 锚框长宽比权重衰减系数㠲batchsize迭代次数0.9128、256、5121∶1、1∶2、2∶10.00050.0036430k

4.2 模型评价指标

在比较各个目标检测技术的有效性时,除了主观上的肉眼直接观察之外,常常会选取一些客观评价指标对目标检测的效果进行评价。一般情况下,常用的评价指标有平均精度(AP)、平均精度均值(mAP)和召回率(Recall rate),下面将对这些评价指标做详细的介绍。

假设检测结果只有两种,正样本和负样本,则检测结果可以分为4种情况,如表6所示。

表6 混淆矩阵

Tab.6 Confusion matrix

预测为正样本 预测为负样本实际为正样本TPFN实际为负样本FPTN

精度表示的是预测为正样本的结果中有多少是真正的真样本,它表示的是在对目标类别的判定能力上检测模型的表现,其计算公式如式(9)所示:

(9)

召回率表示的是样本中的正样本有多少被正确预测了,它衡量的是在识别目标的能力上检测模型的能力,其计算公式如式(10)所示:

(10)

将召回率作为横轴,准确率作为纵轴,就可以画出P-R曲线图,P-R曲线与坐标轴围成的面积即为平均精度。当检测任务中有多个目标时,各个目标的平均精度常常是不相同的,因此为了综合考虑检测效果,可以将各个目标的平均精度进行求均值的操作,得到平均精度均值(mAP)。

4.3 不同数据集实验对比

为了测试模型的泛化能力,实验分别选取了VEDAI、NWPU VHR-10、DOTA三个数据集进行测试,通过实验测试结果进行定量对比,检测本文算法的优越性。

4.3.1 VEDAI数据集上的结果

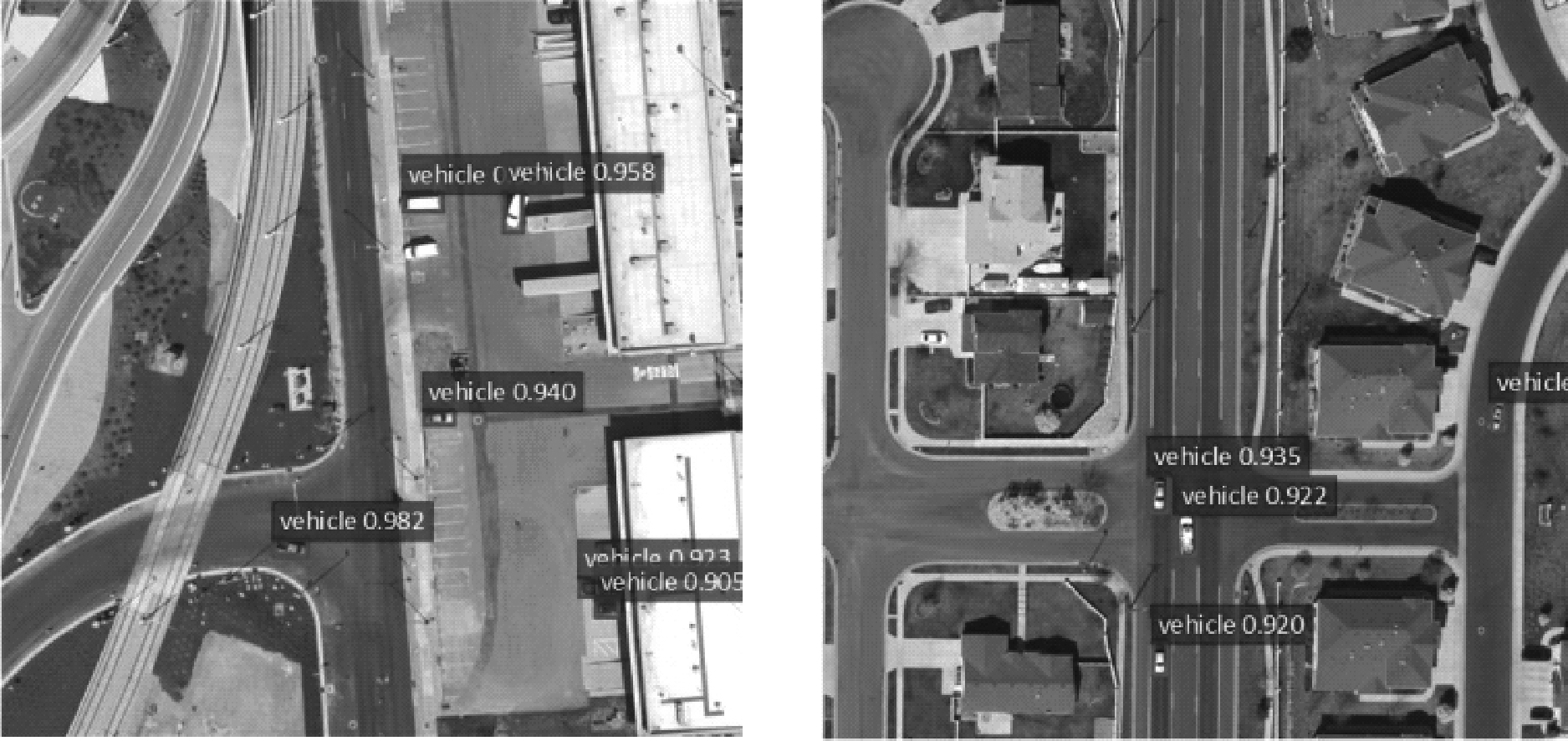

VEDAI数据集[26]中的图像均为卫星航拍图像,约由1240幅图像构成。图像像素为512×512,图像涵盖了居民区、城市街道、高速公路等场景下的车辆目标。平均每张图像中的车辆数量约为5.5个,目标像素占图像总像素 0.7%。VEDAI 数据集中的车辆目标尺寸大小约为40×20像素,且车辆目标在图像中的方向随机,图像光照变化大。图6为 VEDAI 数据集中的样本示例。

图6 VEDAI 数据集样本示例

Fig.6 Sample VEDAI dataset example

针对VEDAI数据集,设定训练集与测试集样本比例约为4∶1。训练阶段,本文随机选取数据集中的994张图像作为训练样本;测试阶段,选取数据集中剩余248张图像作为测试集。

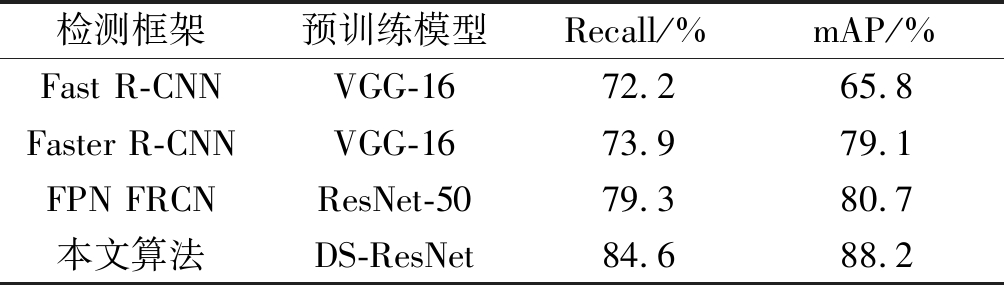

在VEDAI数据集中对比了几种主流的目标检测框架,包括基于候选区域的目标检测框架 Fast R-CNN,Faster R-CNN,和FPN FRCN(结合了FPN的Faster R-CNN)框架,具体实验结果如表7所示。

表7 不同检测模型在VEDAI数据集上的检测结果对比

Tab.7 Comparison of detection results of different models on VEDAI dataset

检测框架预训练模型Recall/% mAP/%Fast R-CNNVGG-1672.265.8Faster R-CNNVGG-1673.979.1FPN FRCNResNet-5079.380.7本文算法DS-ResNet84.688.2

由表7中对比可以看出,在VEDAI数据集中,本文提出的目标检测框架取得很好的检测效果,其平均检测精度达到88.2%,检测精度远超Fast R-CNN和Faster R-CNN。

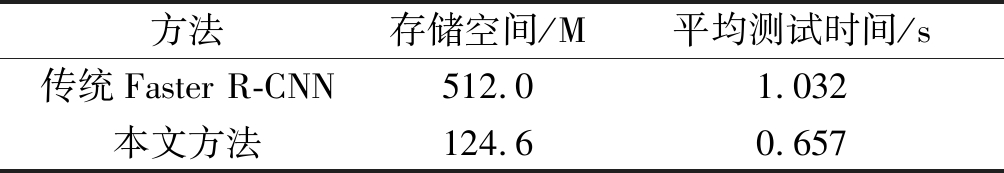

表8 在VEDAI数据集上存储空间和测试时间对比

Tab.8 Storage space and test time comparison on VEDAI dataset

方法存储空间/M平均测试时间/s传统Faster R-CNN512.01.032本文方法124.60.657

从表8可知,在VEDAI数据集上进行的实验中,本文方法的网络模型所需要的存储空间(124.6M)比传统Faster R-CNN(512.0M)网络模型所需的存储空间降低了4.1倍,而且本文方法检测一张测试图像需要的平均时间是0.657 s,而传统Faster R-CNN需要的平均时间是1.032 s,故本文方法在时间运行效率和节省存储空间上都要优于传统Faster R-CNN。

图7 在VEDAI数据集中的检测结果

Fig.7 Detection results on the VEDAI dataset

图7显示了在VEDAI数据集上的检测结果,从检测结果可以看出,本文方法在VEDAI数据集上能够有效检测出遥感图像中较小的目标,具有良好的检测性能,而且鲁棒性也较好,网络泛化能力强。

4.3.2 NWPU VHR-10数据集上的结果

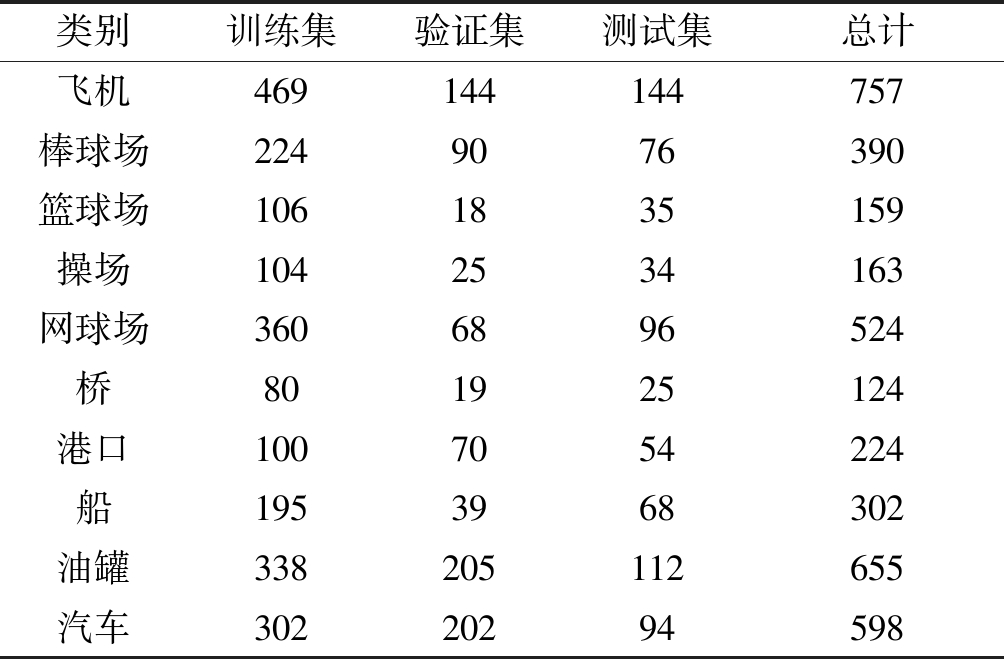

NWPU VHR-10[19-21]小目标数据集则由800幅图像构成(图像包含了不同地面场景下的车辆、飞机、油罐等共10个类别的目标)。数据集包含正负两个样本集,在半监督学习或弱监督学习中,才会用到负样本集。而本文采用的是监督学习,只使用正样本集。从数据集NWPU VHR-10的正样本集的每个类别中分别选择出的1张遥感图像。在实验之前,按照6∶2∶2的比例随机将NWPU VHR-10数据集的正样本集划分成训练集、验证集和测试集。由于该数据集的正样本集总共有650张图像,故训练集、验证集和测试集分别包含390、130、130张遥感图像。表9列出了训练集、验证集和测试集分别包含的各个类别目标的数量。

表9 数据集中包含目标的数量

Tab.9 Number of targets in each data set

类别训练集验证集测试集总计飞机469144144757棒球场2249076390篮球场1061835159操场1042534163网球场3606896524桥801925124港口1007054224船1953968302油罐338205112655汽车30220294598

表10列出了优化后的Faster R-CNN 架构在NWPU VHR-10数据集上进行目标检测的精度,选取传统的BoW[22] 特征检测方法、基于R-CNN 的T-CNN[23]和RICNN[21]、传统Faster R-CNN等算法进行对比,表中加粗部分为每个类别检测准确率的最高值。

从各类检测的总平均精度来看,本文方法(90.5%)均高于所对比的其他方法的准确率,传统的BoW特征检测方法的mAP最低(24.6%)、以及基于R-CNN的T-CNN、RICNN和SA-CNN、基于YOLO的OURS算法、传统Faster R-CNN和本文方法的mAP都大幅高于传统目标检测方法。从单类别的检测准确率来看,本文方法在飞机、桥梁、船、油罐、汽车五类目标中表现最好,尤其是船、油罐、汽车等小目标的检测准确率有明显提高;传统Faster R-CNN 在棒球场、篮球场、操场、网球场、港口五类目标中表现最好,同样的,每类目标的最低mAP值都出现在传统的目标检测方法中。通过将本文方法检测精度与其他的方法作对比,可以看出本文方法在小目标检测上表现的更好,在其他目标上的检测精度也和Faster R-CNN相近,同时本文的方法在总体也表现较好。

表10 NWPU VHR-10数据集上的各类别目标检测精度(%)

Tab.10 Target detection accuracy of each category on NWPU VHR-10 dataset (%)

类别BoWT-CNNRICNNOURSSA-CNNFaster R-CNN本文方法25.066.188.492.490.895.295.69.081.688.190.594.894.292.83.245.958.572.692.595.993.57.880.286.792.195.999.795.84.735.045.876.090.593.593.112.245.361.594.868.066.986.453.062.068.688.692.898.894.158.556.977.386.477.678.085.963.281.180.359.467.251.383.29.142.371.164.575.160.384.7mAP24.659.772.681.784.583.490.5

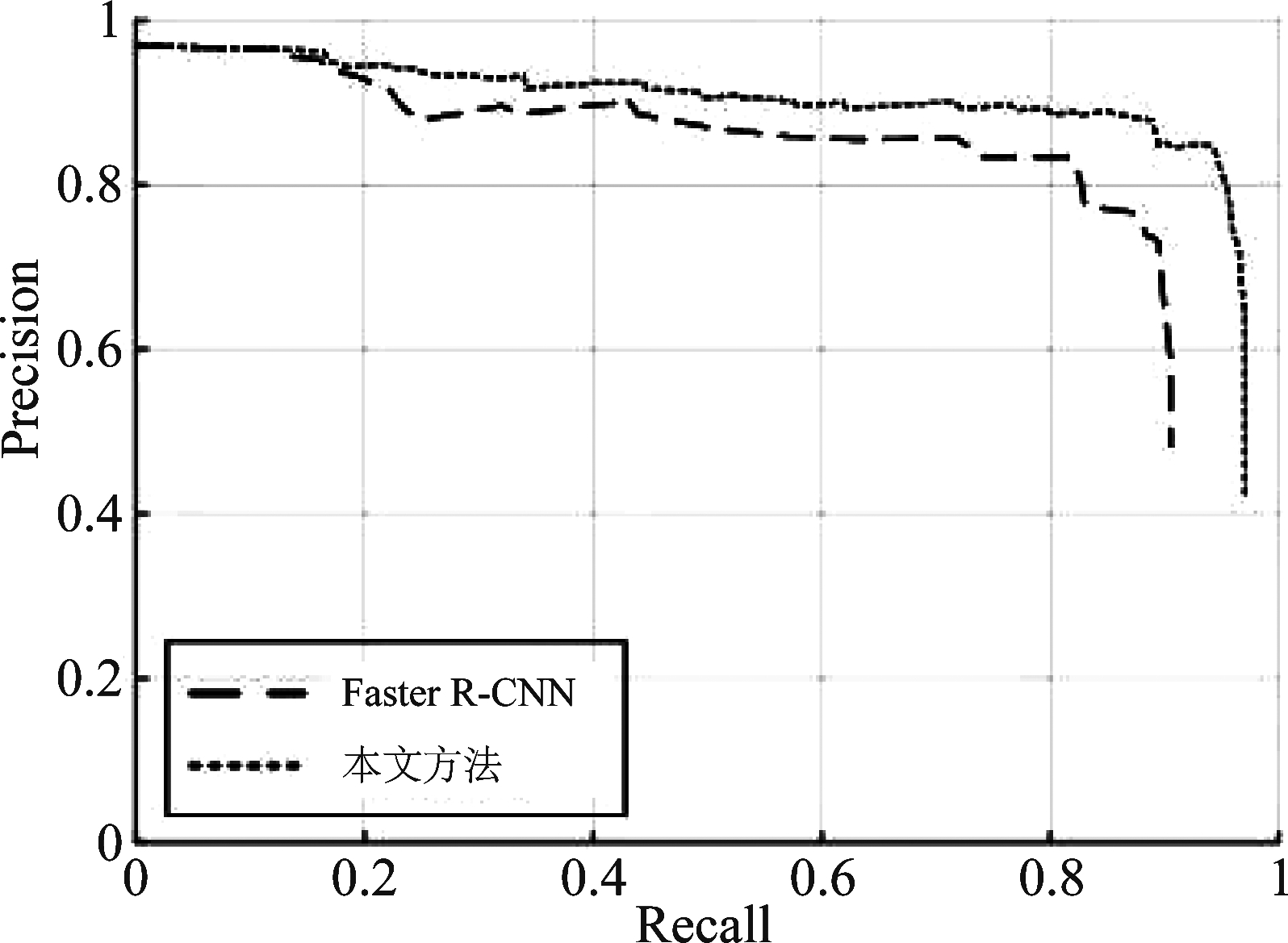

除了用检测精度来评价目标检测方法的有效性之外,本文还针对数据集中出现的汽车、船、油罐三个小目标,绘制了PR曲线图。PR曲线是检测精度关于召回率的函数,它的横坐标召回率,纵坐标是检测精度。是准确率关于召回率的函数,函数曲线与坐标轴之间的面积AP可以更直观地表现分类器性能。

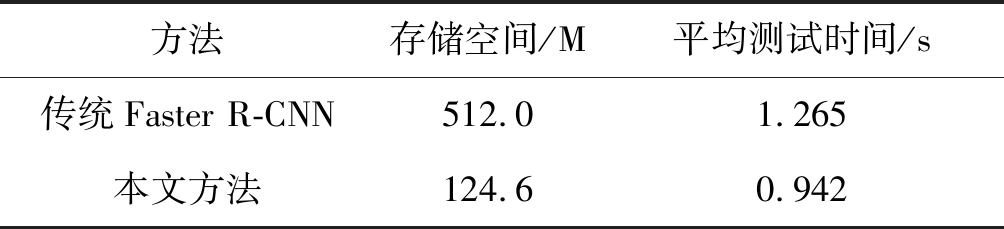

从图8也可以直观的看出,在遥感图像检测的精度上,本文方法优于传统Faster R-CNN。为了验证本文方法在节省存储空间和提高模型运行效率上的有效性,表11给出了本文方法与传统Faster R-CNN在存储空间和平均测试时间上的对比。

图8 PR曲线对比

Fig.8 PR curve comparison

表11 在NWPU VHR-10数据集上存储空间和测试时间对比

Tab.11 Storage space and test time comparison on NWPU VHR-10 dataset

方法存储空间/M平均测试时间/s传统Faster R-CNN512.01.265本文方法124.60.942

从表11可知,在相同的实验环境下,存储空间降低了4.1倍,而且本文方法在NWPU VHR-10数据集上检测一张测试图像需要的平均时间是0.942 s,而传统Faster R-CNN 需要的平均时间是

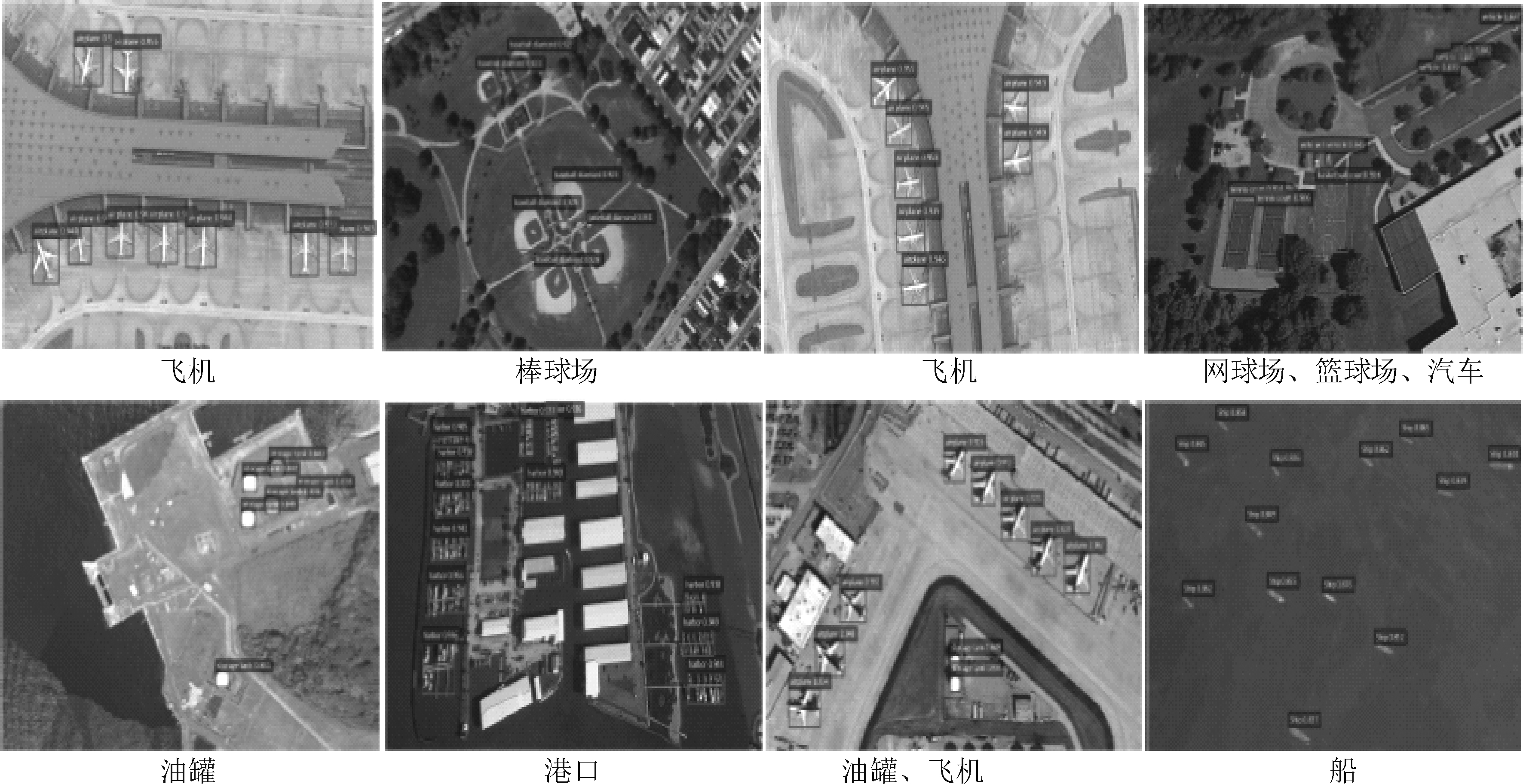

1.265 s,所以本文方法在时间运行效率和节省存储空间上都要优于传统Faster R-CNN。图10显示了本文方法的部分检测结果,检测结果中涵盖了NWPU VHR-10数据集中的所有类别。从检测结果可以看出,本文方法能够有效检测出遥感图像中较小的目标,具有良好的检测性能,而且鲁棒性也较好,网络泛化能力强。

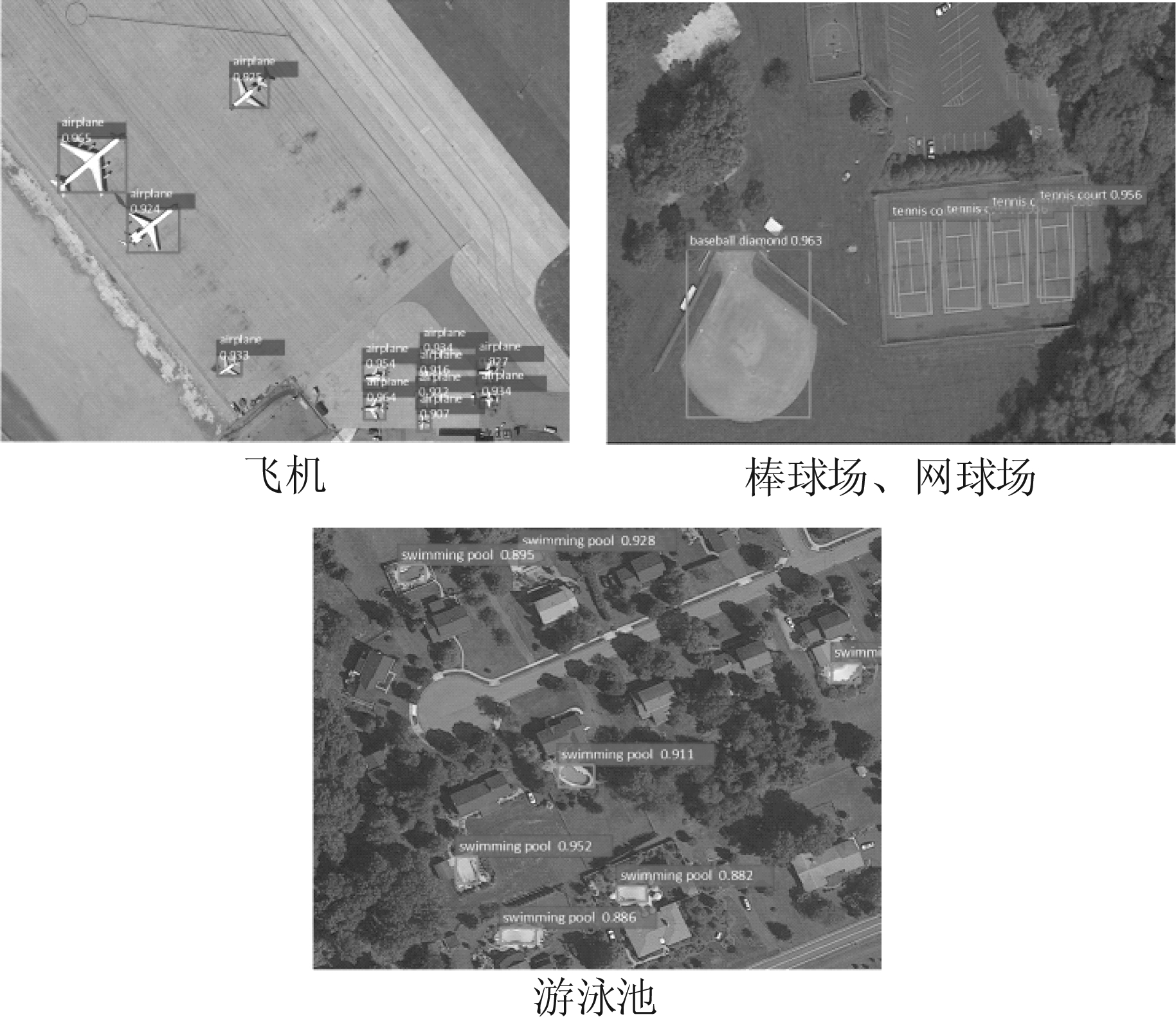

4.3.3 DOTA数据集上的结果

DOTA数据集[27]的影像主要来源为Google Earth,部分数据来源于吉林一号和高分二号影像。该数据集主要应用于目标检测领域,共包含了2806幅遥感影像,遥感影像的尺度范围为800到4000像素;这些影像中包含的检测目标具备不同的尺度、方位、形状,数据集共标注了188282个目标位置信息,目标类别为15类:飞机、船、集装箱、棒球场、网球场、篮球场、操场、港口、桥梁、大型车辆、小型车辆、直升机、环形交叉路口、足球场和游泳池,图10为DOTA数据集样本示例。

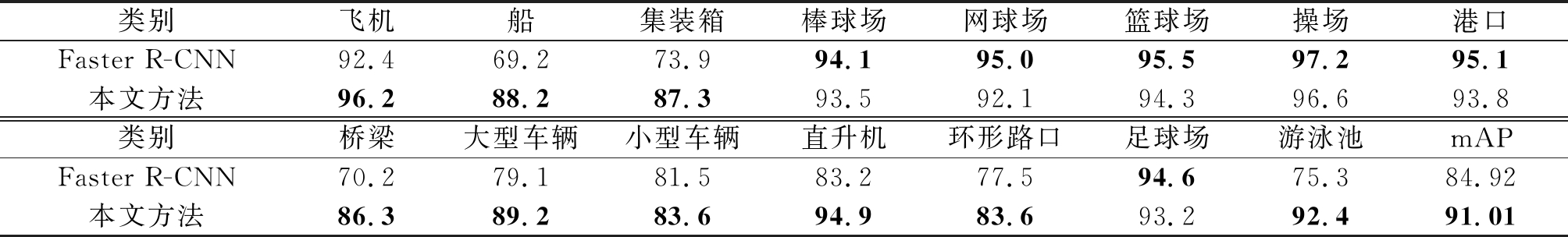

表12列出了在DOTA数据集上,本文优化后的Faster R-CNN 架构的目标检测的精度,选取传统Faster R-CNN算法进行对比,表中加粗部分为每个类别检测准确率的最高值。

图9 在NWPU VHR-10数据集中的检测结果

Fig.9 Detection results on the NWPU VHR-10 dataset

图10 DOTA数据集样本示例

Fig.10 Sample DOTA dataset example

表12 DOTA数据集上的各类别目标检测精度(%)

Tab.12 Target detection accuracy of each category on DOTA dataset (%)

类别飞机船集装箱棒球场网球场篮球场操场港口Faster R-CNN92.469.273.994.195.095.597.295.1本文方法96.288.287.393.592.194.396.693.8类别桥梁大型车辆小型车辆直升机环形路口足球场游泳池mAPFaster R-CNN70.279.181.583.277.594.675.384.92本文方法86.389.283.694.983.693.292.491.01

从表12可以看出,和传统Faster R-CNN算法相比,本文提出的方法在总精确度上有着更好的效果(91.01%)。相比Faster R-CNN提高了6.09%。从单类别看本文方法在飞机、船、集装箱、桥梁、汽车、直升机等几类小目标检测中表现的更好,对于棒球场、篮球场、网球场、操场、港口、足球场几类中传统Faster R-CNN表现更好,本文算法精确度和Faster R-CNN相差不大。下表显示了本文算法在DOTA数据集上存储空间和平均测试时间的对比数据。

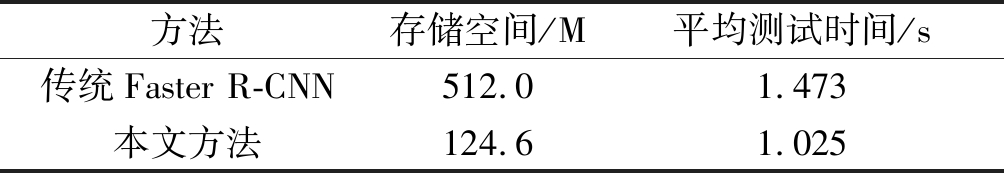

表13 在DOTA数据集上存储空间和测试时间对比

Tab.13 Storage space and test time comparison on DOTA dataset

方法存储空间/M平均测试时间/s传统Faster R-CNN512.01.473本文方法124.61.025

表13可以进一步验证,在相同的实验环境下,存储空间降低了4.1倍,本文在DOTA数据集上对于时间运行效率和节省存储空间上同样都要优于传统Faster R-CNN。图11显示了本文方法在DOTA训练集上的部分检测结果,检测涵盖了DOTA训练集的所有类别。从检测结果可以看出,本文方法能够有效检测出遥感图像中较小的目标,具有良好的检测性能。

图11 DOTA数据集上的检测结果

Fig.11 Detection results on the DOTA dataset

5 结论

本文从现有目标检测技术不能兼顾检测速度与精度的角度出发,研究了Faster R-CNN检测技术。首先设计了能够作为基础网络的深度可分离残差网络,降低基础网络模型的参数数量。然后,将多层卷积特征图经过局部归一化后进行融合,提高小目标的检测精度。最后,在原有softmax损失函数的基础上加入中心损失函数,使网络模型能够学习到更具有差异性的深度特征,提高网络模型的泛化能力。将改进后的Faster R-CNN应用于遥感图像的目标检测任务中,用各种数据集进行实验,并与其他方法作对比,验证了本文方法在遥感图像目标检测任务中具有较好的表现。

[1] Cha Y J, Choi W. Deep learning-based crack damage detection using convolutional neural networks[J]. Computer-Aided Civil and Infrastructure Engineering, 2017, 32(5): 361-378.

[2] Girshick R, Donahue J, Darrell T, et al. Region-Based Convolutional Networks for Accurate Object Detection and Segmentation[J]. IEEE Transcations on Pattern Analysis and Machine Intelligence, 2015, 38(1): 142-158.

[3] Uijlings J R R, Van De Sande K E A, Gevers T, et al. Selective Search for object recognition[J]. International Journal of Computer Vision, 2013, 104(2): 154-171.

[4] Girshick R. Fast r-cnn[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 1440-1448.

[5] Ren S, He K, Girshick R, et al. Faster r-cnn: Towards real-time object detection with region proposal networks[C]∥Advances in Neural Information Processing Systems, 2015: 91-99.

[6] 唐玮, 赵保军, 龙腾. 基于轻量化网络的光学遥感图像飞机目标检测[J]. 信号处理, 2019, 35(5): 768-774.

Tang Wei, Zhao Baojun, Long Teng. Aircraft Detection in Remote Sensing Image Based on Lightweight Network[J]. Journal of Signal Processing, 2019, 35(5): 768-774.(in Chinese)

[7] He K, Gkioxari G, Dolldr P, et al. Mask r-cnn[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 2961-2969.

[8] He K, Zhang X, Ren S, et al. Spatital Pyramid Pooling in Deep Convolutional Networks for Visual Recognition[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2014, 37(9): 1904-1916.

[9] Everingham M, Winn J. The PASCAL Visual Object Classes Challenge 2007 (VOC2007) Development Kit[J]. International Journal of Computer Vision, 2006, 111(1): 98-136.

[10]Cao Y S, Niu X, Dou Y. Region-based convolutional neural networks for object detection in very high resolution remote sensing images[C]∥2016 12th International Conference on Natural Computation, Fuzzy Systemsand Knowledge Discovery (ICNC-FSKD). IEEE, 2016: 548-554.

[11]Yao Y, Jiang Z, Zhang H, et al. Ship detection in optical remote sensing images based on deep convolutional neural networks[J]. Journal of Applied Remote Sensing, 2017, 11(4): 042611.

[12]Sifre L, Mailat S. Rigid-Motion Scattering Texture Classification[J]. Computer Science, 2014, 3559: 501-515.

[13]Chollet F, Xception. Deep Learning with Depthwise Separable Convolutions[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2017.

[14]Howard A G, Zhu M, Chen B, et al. MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications[J]. arXiv: 1704.04861.2017.

[15]陈鹏飞, 应自炉, 朱健菲, 等. 面向手写汉字识别的残差深度可分离卷积算法[J]. 软件导刊, 2018, 17(11): 68-72.

Chen Pengfei, Ying Zilu, Zhu Jianfei, et al. Residual Depthwise Separable Convolution Algorithm for Handwritten Chinese Character Recognition[J]. Software Guide, 2018, 17(11): 68-72.(in Chinese)

[16]Aytar Y, Zisserman A. Tabula rasa: Model transfer for object category detection[C]∥2011 International Conference on Computer Vision. IEEE, 2012.

[17]Tommasi T, Orabona F, Caputo B. Safety in Numbers: Learning Categories from Few Examples with Multi Model Knowledge Transfer[C]∥The Twenty-Third IEEE Conference on Computer Vision and Pattern Recognition, CVPR 2010, San Francisco, CA, USA, 13-18 June 2010. IEEE, 2010.

[18]Lin T Y, Michael Maie, Serge Belongie, et al. Microsoft COCO: Common Objects in Context[J]. arXiv: 1405.0312.2015.

[19]Cheng G, Han J, Zhou P, et al. Multi-class geospatial object detection and geographic image classification based on collection of part detectors[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 98(1): 119-132.

[20]Cheng G, Han J. A survey on object detection in optical remote sensing images[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2016, 117: 11-28.

[21]Cheng G, Zhou P, Han J. Learning Rotation-Invariant Convolutional Neural Networks for Object Detection in VHR Optical Remote Sensing Images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016: 1-11.

[22]Xu Sheng, Fang Tao, Li Deren, et al. Object classification of aerial images with bag-of-visual words[J]. IEEE Geoscience and Remote Sensing Letters, 2010, 7(2): 366-370.

[23]Krizhevsy A, Sutskever I, Hinton G E. IamgeNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2012, 60(60): 84-90.

[24]Liu W, Anguelov D, Erhan D, et al. Ssd: Single shot multibox detection[C]∥European Conference on Computer Vision. Springer, Cham, 2016: 21-37.

[25]Redmon J, Diwala S Girshick R, et al. You only look once: Unified, real-time object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 779-788.

[26]Razakarivony S, Jurie F. Vehicle detection in aerial imagery: A small target detection benchmark[J]. Journal of Visual Communication and Image Representation, 2016, 34.

[27]Xia G S, Bai X, Ding J, et al. DOTA: A Large-scale Dataset for Object Detection in Aerial Images[J]. arXiv preprint arXiv:1711.10398, 2017.