1 引言

行人重识别(ReID)任务依赖于具有识别能力的特征,一种新颖的轻量级深度卷积网络OSNet[1]被提出以学习全尺度特征,包括同构和异构尺度。设计由多个卷积特征流组成的残差块来检测一定尺度的特征,并在统一聚合门根据依赖于输入的每个通道权重来进行动态多尺度的特征融合。由于使用了pointwise和depthwise卷积替代传统的卷积操作,整个OSNet[1]是非常轻量级的,参数量只有2.2M。在行人重识别数据集Market1501,Duke和CUHK03_Detected上取得了84.9%,73.5%和67.8%的mAP。

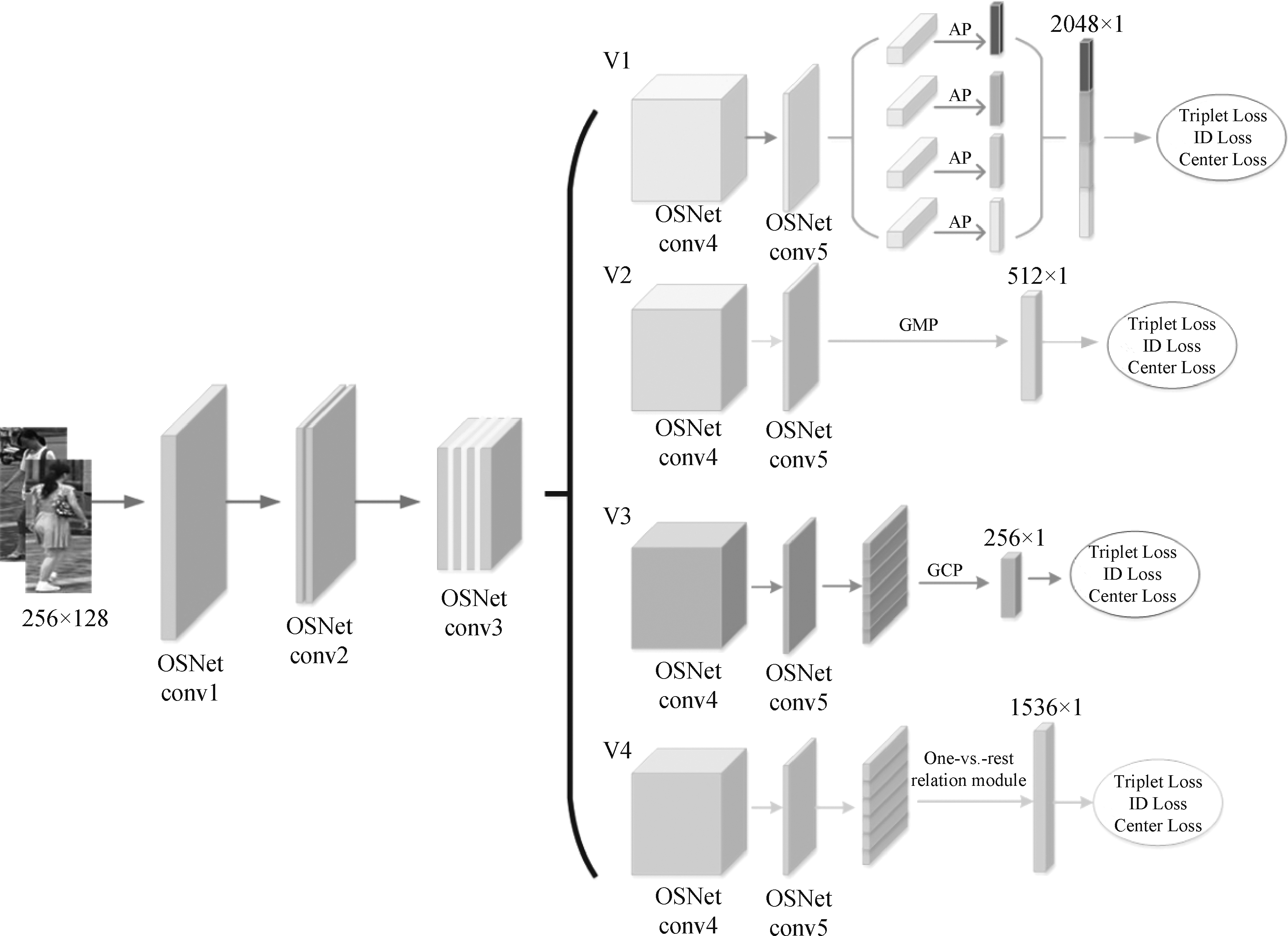

多分支协作网络BC-OSNet[2]以OSNet为主干,在conv4后分为四个分支来学习丰富且有区别的特征。全局分支通过最大池化学习全局信息;局部分支水平切分特征图(feature map)学习更加细粒度的特征;关联分支利用relation module[4]学习水平切分后特征之间的关联信息;对比分支利用Global Contrastive Pooling(GCP)[3]学习行人与背景之间的对比信息。通过增加多分支结构提升了OSNet的性能,网络结构的参数量为8.2M,仍保持着轻量化的结构优势。在行人重识别数据集Market1501,Duke,CUHK03_Labeled和CUHK03_Detected上的mAP达到了89.3%,80.7%,83.1%和79.8%。

各类深度学习[4-5]文献中有很多行之有效的微结构,本文主要收集了其中的一些,并经过实验在行人ReID数据集中评估了它们在BC-OSNet[2]中的实际影响。经过比较,本文选用四个微结构和一个数据增强策略,包括用于数据增强的CutMix[6],Global Average Pooling(GAP)[7]和Global Max Pooling(GMP)的通用形式Generalized-mean(GeM)pooling[8],过拟合抑制算法Gaussian continuous dropout(GCDropout)[9]和注意力学习模块Batch DropBlock(BDB)[10]/Relation-Aware Global Attention (RGA)[11],调整到BC-OSNet中作为修改后的baseline,在四个行人重识别数据集Market1501,Duke,CUHK03_Labeled和CUHK03_Detected上的mAP分别达到了89.9%,82.1%,84.2%和81.5%,与如今主流的行人重识别方法相比,本文修改后的baseline取得了有竞争力的性能。

2 网络结构

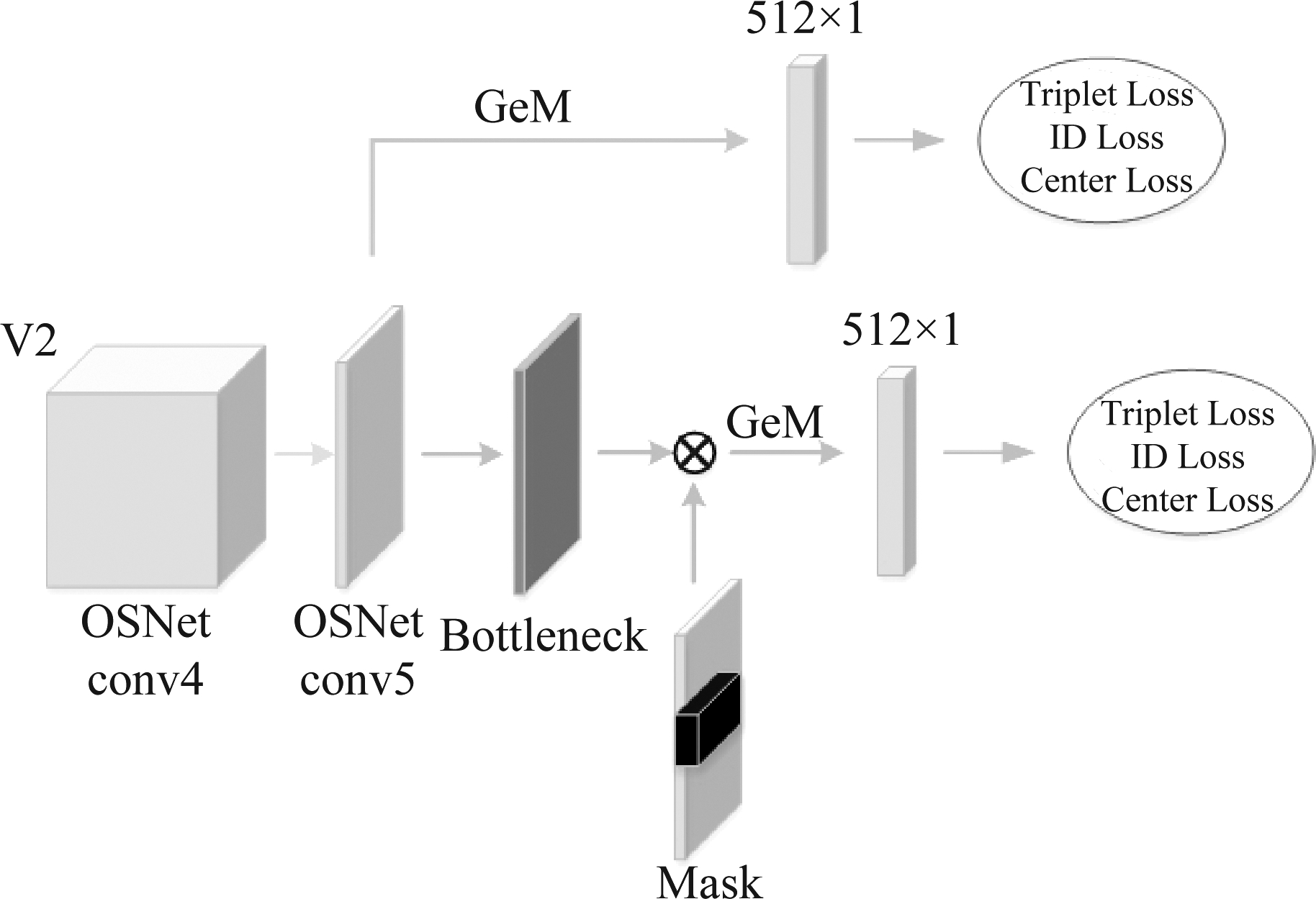

BC-OSNet的整体网络结构如图2所示。 OSNet的前三个卷积(convolution)层和两个过渡(transition)层作为BC-OSNet的共享网络。然后,采用四个协作分支进行特征提取,分别包括局部分支(v1),全局分支(v2),对比分支(v3)和关联分支(v4)。使用四个分支是为了学习丰富但有区别的特征。

3 微结构优化

这一节主要介绍并讨论一些用于骨干网络的微结构优化及策略,其中的大部分都可以扩展到其他标准的基线而不需要改变网络结构。

3.1 CutMix[6]

在行人重识别中,数据的获取是十分关键的,模型中使用的基本数据增强方法有random flip和random erase[12],以一定的概率随机翻转和随机擦除图像来处理图像的数量和遮挡问题,以提高ReID模型的泛化能力。

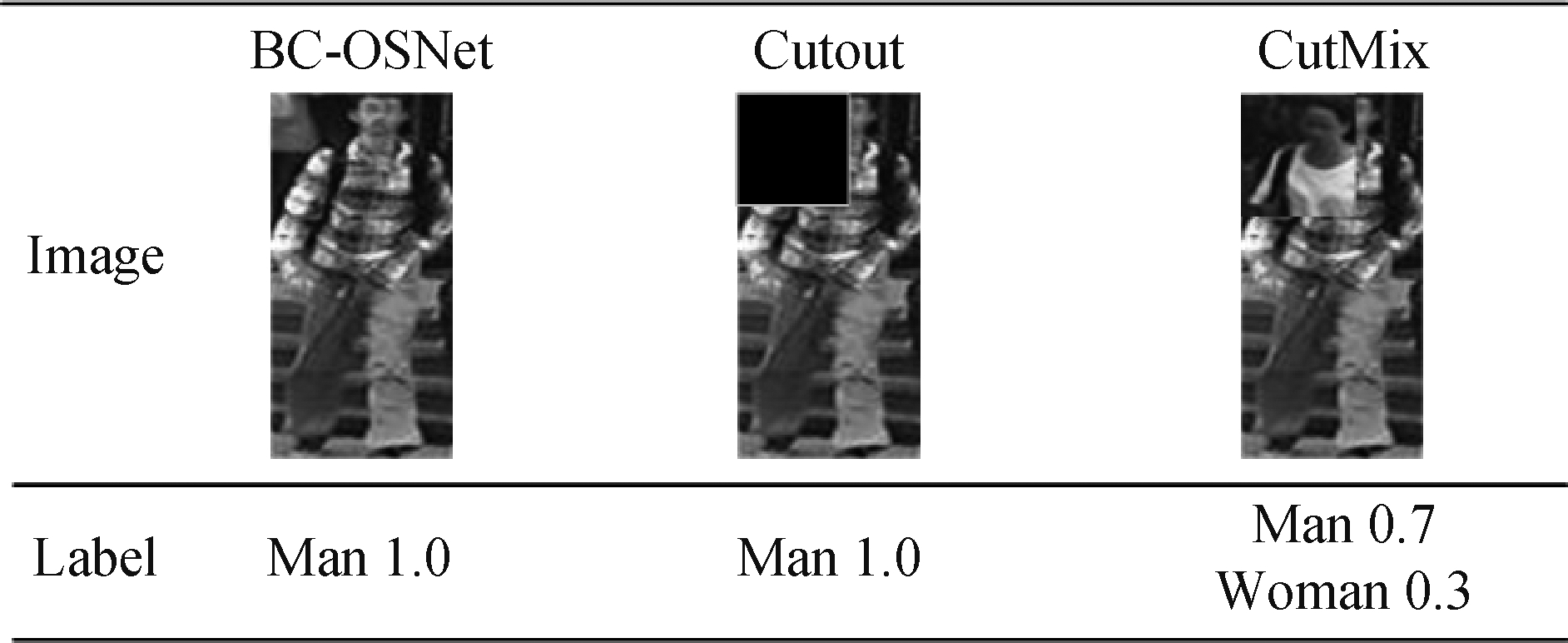

除此之外,[6]提出了一种新的正则化策略CutMix来辅助强有力的分类算法以抑制过拟合,如图1所示。在[6]中,CutMix被证明在ImageNet分类,ImageNet定位和Pascal VOC 07检测任务中是有明显的效果的。但是CutMix还未被使用于行人重识别任务中,经过分析及实验验证,数据增强方法CutMix确实是有一定的效果的,在Duke数据集上的mAP和Rank-1分别达到了82.3%和91.3%,比初始网络分别提高了1.6%和1.3%。

图1 Cutout[13]和CutMix的结果实例

Fig.1 Examples of Cutout and CutMix results

令![]() 为训练图片和标签。CutMix旨在结合两个训练样本(xA,yA)和(xB,yB)以生成一个新的训练样本

为训练图片和标签。CutMix旨在结合两个训练样本(xA,yA)和(xB,yB)以生成一个新的训练样本![]() 结合的操作如下[6]:

结合的操作如下[6]:

(1)

(2)

其中M∈{0,1}W×H,即二进制掩码来决定图像的丢失与保留,⊙为element-wise乘法,即对应元素相乘。结合的比率因子λ服从Beta(α,α)分布,实验中设α=1,此时λ~U(0,1)。

CutMix就是用其他训练图像的patch替换此图像区域来生成更多的局部自然图像。为了采样二进制掩码M,首先采样边界框坐标B=(rx,ry,rw,rh)来决定xA和xB的裁剪区域。移除xA的B区域,然后裁剪xB的B区域填充到xA的B区域中。实验中矩形掩码M的长宽比与原始图像成比例,边界框坐标按以下方式均匀采样[6]:

(3)

(4)

其中裁剪区域比![]() 裁剪区域B中的M=0,其他区域M=1。训练时,每个iteration中的

裁剪区域B中的M=0,其他区域M=1。训练时,每个iteration中的![]() 由一个minibatch中随机选取的样本产生。

由一个minibatch中随机选取的样本产生。

如图1所示,Cutout能够使得模型更专注于目标较难区别的区域,但是被擦除的区域是没有任何信息的,这会影响训练的效率。CutMix使得模型能够从一幅图片的局部视图上识别出两个身份,这让CutMix既能专注区域信息,也提高了训练效率。

Cutmix替换的区域及大小比例都是固定的参数,但是图片都是各不相同的,这样设置难免会导致其在泛化性上的困难。所以,使得网络自学习替换的区域位置和大小的比例对于泛化性的研究很有必要。

3.2 高斯连续Dropout[9]

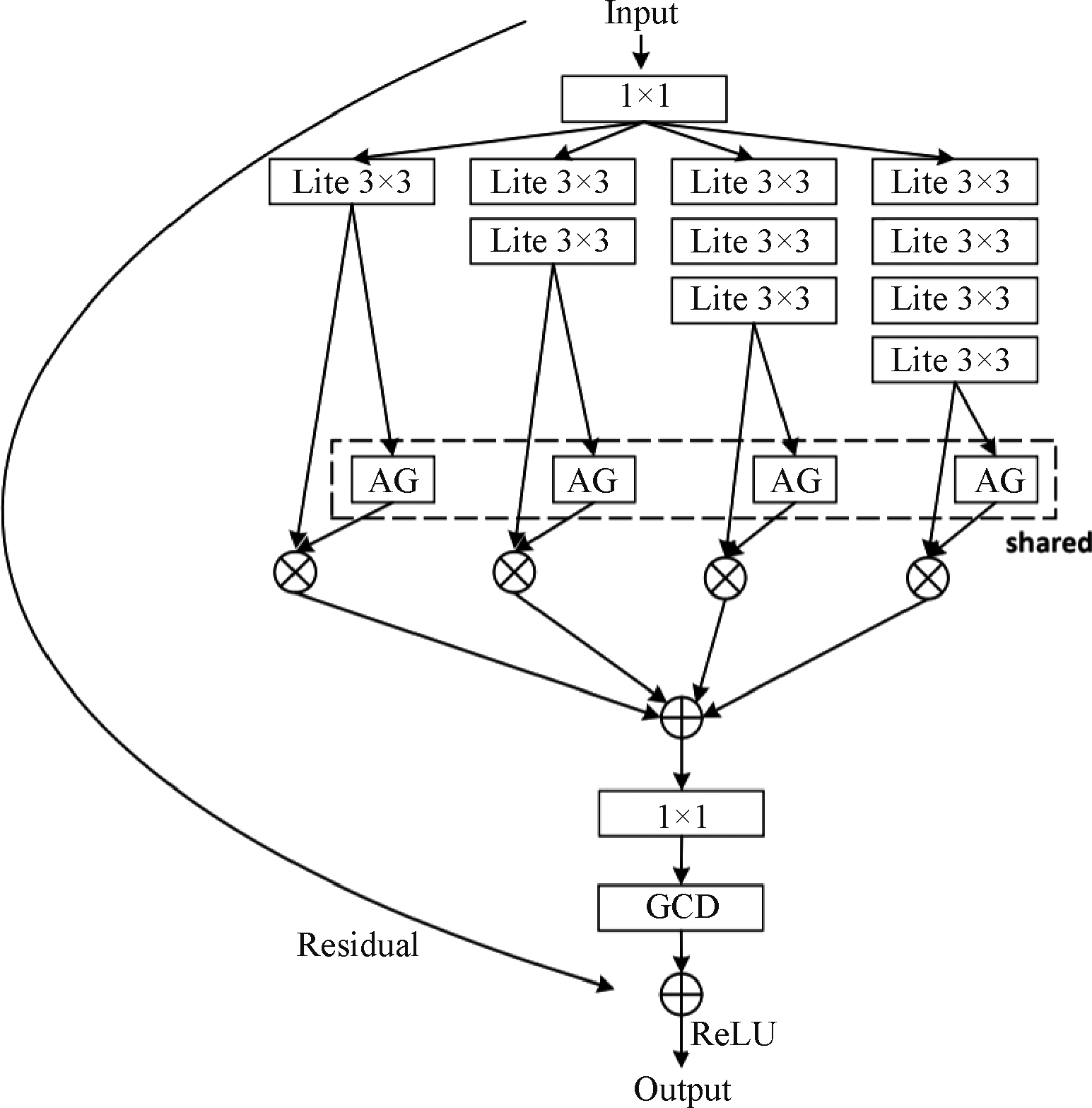

传统的Dropout变量服从离散分布,即Bernoulli分布,这与模拟的人类大脑中神经元的激活特性是有差异的,[9]提出连续Dropout,其中丢弃掩码(dropout masks)取值服从高斯分布,即高斯连续Dropout (GCD)。使用时将网络的神经元随机与连续的丢弃掩码(continuous dropout masks)相乘。连续Dropout被证明具有避免特征检测器同适应的特性,这表明可以提取更多独立的特征检测器用于测试阶段的模型平均,在子网的多样性和独立性之间取得良好的平衡[9]。

图3为OSNet中提出的bottleneck,实验中,GCD被添加到用于恢复特征维度的最后一个1*1卷积之后,这能够在保持方差的同时减少共适应[9]。其中,Lite 3×3表示将标准的3×3卷积分为点卷积(pointwise convolution)和深度卷积(depthwise convolution)。AG表示聚合门(Aggregation Gate),bottlenck中每个流都提供了特定尺度的特征,通过AG来实现动态尺度融合,以学习全尺度特征。

目前GCD还很少被应用于行人重识别任务中,通过分析GCD比伯努利dropout要更加鲁棒,实验验证得到,使用GCD在CUHK03_Labeled和CUHK03_Detected数据集上的mAP和Rank-1比初始网络分别提高了0.3%,0.6%和1.0%,0.4%。

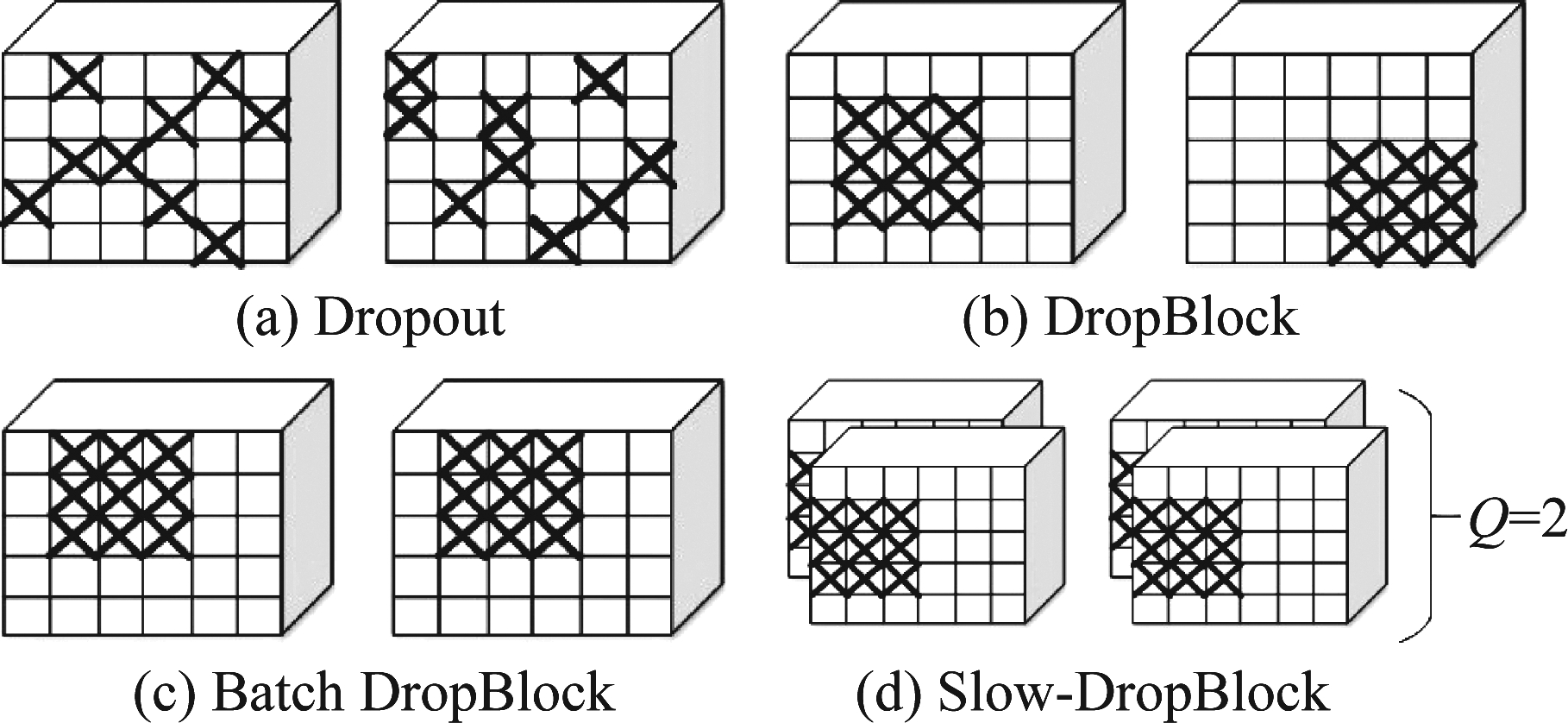

3.3 Dropout及其变种

当一个复杂的前馈神经网络被用于训练小数据集时,Dropout[14]可以通过在训练时忽略一定比例的隐藏层节点来抑制过拟合。由于Dropout的成功,几种变体被陆续提出,例如Batch Dropout和DropBlock[15]等。经过比较,在本文的网络结构中使用Batch DropBlock[10]。 与一般的DropBlock不同,Batch DropBlock是用于度量学习任务的特征学习模块,该模块在训练过程中将一个批量(batch)中所有特征图(feature map)的同一区域随机丢弃,并加强剩余部分的特征学习。

图2 网络结构

Fig.2 The structure of network

图3 GCD在OSNet中bottleneck的应用

Fig.3 GCD in the bottleneck of OSNet

如图4所示,我们提出在ν2分支上引入一个特征丢弃分支(feature dropping branch),另外在OSNet的第五个卷积层(conv5)后,先经过一个bottleneck,再引入一个掩码(mask)来裁剪掉一个区块(block),其中每个批次(batch)所裁剪的区域相同。

图4 Batch DropBlock结构

Fig.4 The Structure of Batch DropBlock

实验中,我们发现在[10]中使用的方法是将裁剪区域的值置为零,此时在擦除的比率增大时会因为信息损失过多而导致性能有所下降。如果将裁剪区域的值改为当前裁剪区域的平均值,这会有效缓解上面的问题。

基于Batch DropBlock,[16]提出了同时随机擦除Q个batches中连续的block,即Slow-DropBlock,其中Q≥1,与上述类似,擦除的区域同样可以置零或者设为擦除区域值的平均。当Q=1时,Slow-DropBlock等同于Batch DropBlock。

然而,这种随机擦除的方法擦出的很有可能是有用的信息而保留信息量不足的特征,我们需要让模型重点学习到有区分度的特征,如何让网络自学习擦除的区域而保留更加值得注意的区域是值得研究的问题。

图5 不同的Dropout方法的比较

Fig.5 The Comparison with Dropout Methods

3.4 其他的微结构与策略3.4.1 Generalized-mean Pooling[8]

原理上Global Average Pooling(GAP)[7]重视整体信息,而Global Max Pooling(GMP)更注重显著特征。目前,GAP和GMP都得到了广泛应用,具体使用时无法知道哪种池化方法更好。Generalized-mean(GeM) Pooling[8]是一种更为一般的池化方法,GAP和GMP可以看作是GeM的特例。它可以用来缩小两者之间的差距。可使用GeM Pooling来替换BC-OSNet中v1的AP和v2的GMP。[8]给出:

(5)

其中fk是一个特征图(feature map),当pk→ 时,GeM pooling等同于GMP,当pk=1时,GeM pooling等同于GAP。

时,GeM pooling等同于GMP,当pk=1时,GeM pooling等同于GAP。

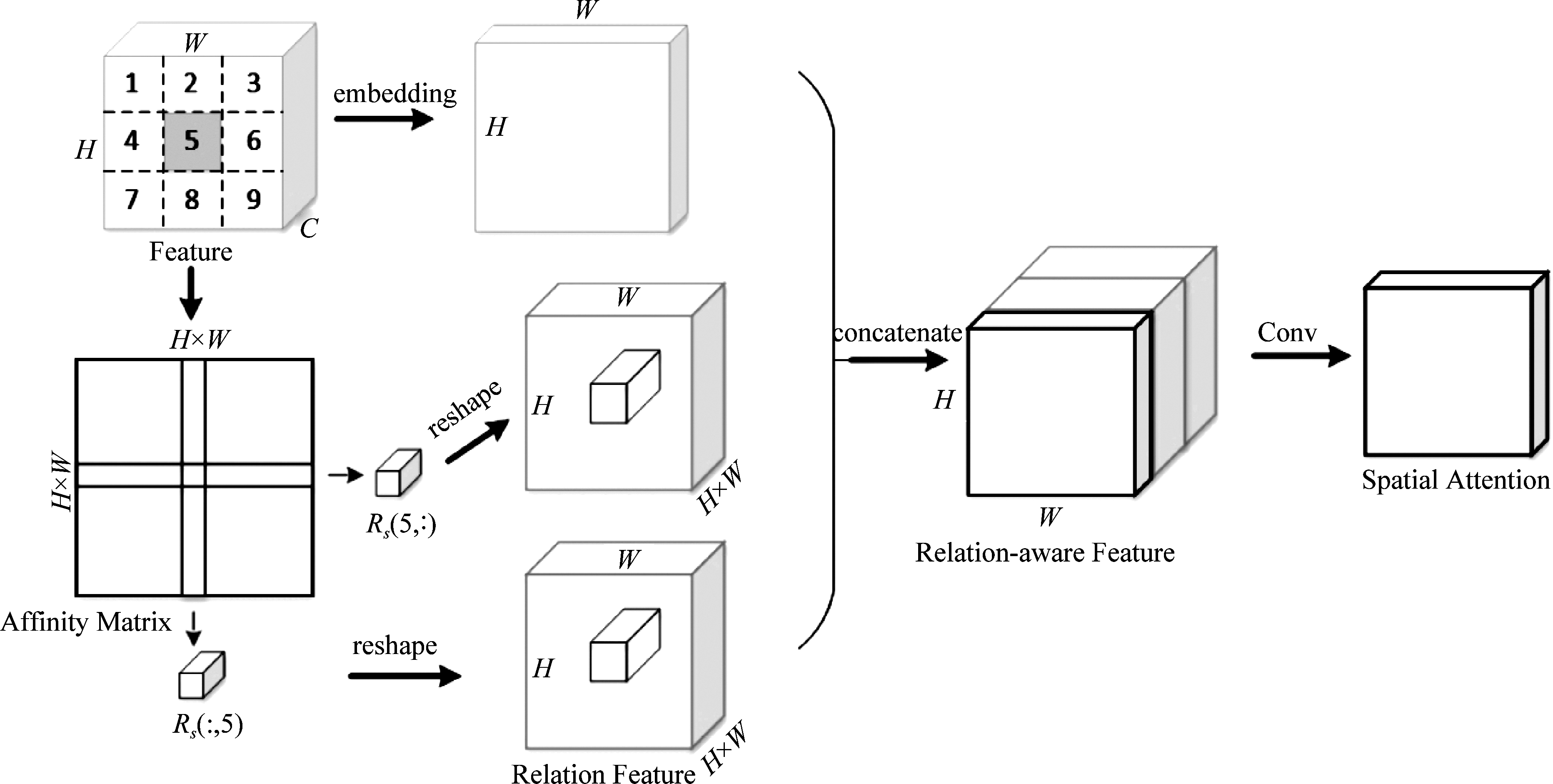

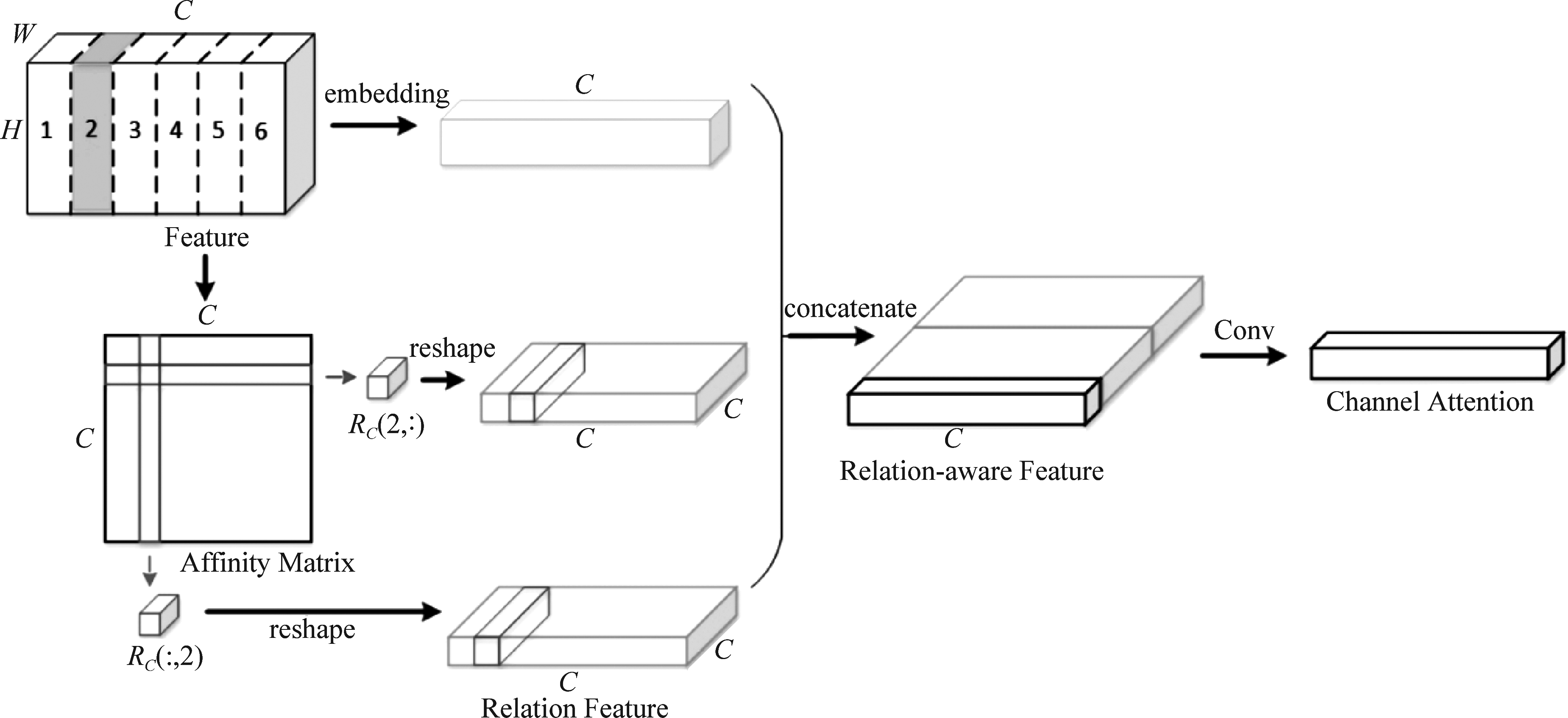

3.4.2 空间和通道关系感知全局注意力[11]

一般的注意力模块往往会忽略全局结构的信息,特征图中空间位置之间的关联性提供了类似聚类的信息,这有助于推断语义信息。[11]提出了Relation-Aware Global Attention(RGA)模块,它可以捕获全局结构信息来更好的进行注意力学习。如图6和图7所示,对应地堆叠relation feature,并与原来的特征结合来获取全局结构信息和局部外观信息。

对于图6 Spatial Relation-Aware Global Attention(RGA-S)[11],给定一个中间特征![]() 其中C,H和W分别表示通道数,高度和宽度。将feature map按空间像素分为H×W个C维的特征向量,然后通过1×1空间卷积层,batch normalization (BN)和ReLU激活函数映射为H×W个特征节点,通过点乘得到长宽都为H×W的Affinity Matrix,然后通过各行和各列分别reshape成Relation Feature,与特征图(feature map)映射后的特征图按通道进行连接后卷积得到Spatial Attention。

其中C,H和W分别表示通道数,高度和宽度。将feature map按空间像素分为H×W个C维的特征向量,然后通过1×1空间卷积层,batch normalization (BN)和ReLU激活函数映射为H×W个特征节点,通过点乘得到长宽都为H×W的Affinity Matrix,然后通过各行和各列分别reshape成Relation Feature,与特征图(feature map)映射后的特征图按通道进行连接后卷积得到Spatial Attention。

对于图7 Channel Relation-Aware Global Attention(RGA-C)[11],令中间输入特征![]() 其中C,H和W分别表示通道数,高度和宽度。将feature按通道分为C个H×W维的feature map,与Spatial Attention相似得到Channel Attention。RGA-SC是指先进行RGA-S操作,后进行RGA-C操作。

其中C,H和W分别表示通道数,高度和宽度。将feature按通道分为C个H×W维的feature map,与Spatial Attention相似得到Channel Attention。RGA-SC是指先进行RGA-S操作,后进行RGA-C操作。

3.4.3 通用的tricks

学习率的设置对于ReID模型的性能有很重要的影响,本文的实验中采用的warmup[17]策略,初始学习率设为3.5e-05,然后在40个epoch内逐渐提升到3.5e-04,然后每60个epoch下降一次学习率。多分类问题通常把向量转换为one-hot-vector,而拟合one-hot-vector的真实概率函数易导致过拟合和模型过于相信预测结果的问题,标签平滑(label smoothing)被提出缓解上述问题。[17]中提出的BNNeck就是在feature map之后的全连接层之前加一个batch normalization(BN)层,可以使得triplet loss能够在欧式空间里约束feature。

图6 空间关系感知全局Attention

Fig.6 Spatial Relation-Aware Global Attention

图7 通道关系感知全局Attention

Fig.7 Channel Relation-Aware Global Attention

4 实验结果分析与讨论

4.1 数据集

Market1501数据集由6台摄像机拍摄的32668张行人图像组成,共1501个类别。 Train set包含751个身份的12936个图像,query set包含750个身份的3368个图像,gallery set包含751个身份的15013个图像。 DukeMTMC-reID数据集由8个摄像头捕获,其中包括702个身份的16522张训练图像,702个身份的2228张query图像和1110个身份的17661张gallery图像。 根据不同的标注方法,将CUHK03数据集分为CUHK03_labeled和CUHK03_detected,其中分别有14096张图像和14097张图像,由两个摄像机捕获。对于训练集,CUHK03_labeled有7368张图像,CUHK03_detected有7365张图像,两种都有1400张query图像。 对于gallery集,CUHK03_labeled有5328张图像,CUHK03_detected有5332张图像。

4.2 实验环境及参数配置

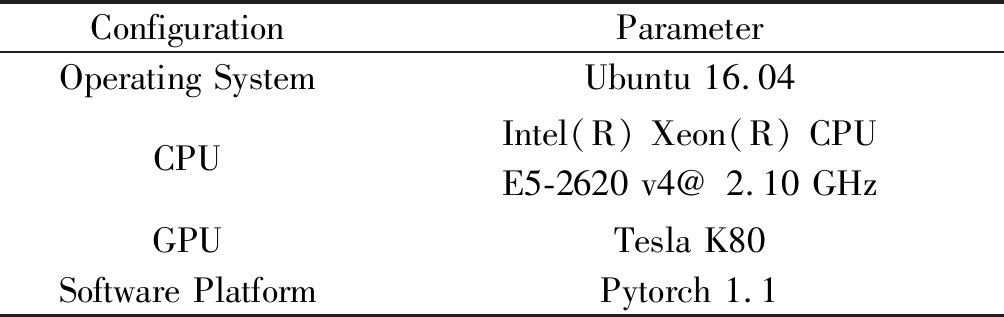

本文实验采用的硬件和软件仿真环境如表1所示。

表1 实验平台参数

Tab.1 Experimental platform parameters

ConfigurationParameterOperating SystemUbuntu 16.04CPUIntel(R) Xeon(R) CPU E5-2620 v4@ 2.10 GHzGPUTesla K80Software PlatformPytorch 1.1

训练时采用了在ImageNet上的预训练模型,用于训练和测试的输入图像大小调整为256×128。 基本数据增强方法包括随机翻转和随机擦除。 优化器是Adam[18],其momentum为0.9,weight decay为5e-04。 在训练过程中,batch size设置为64,并且epoch数量为200。每个batch包含16个身份,每个身份包含4张图像。 在训练期间使用warmup策略,所有网络都使用PyTorch进行了端到端的训练。Rank-1准确率和mean Average Precision(mAP)是主要的评估指标。

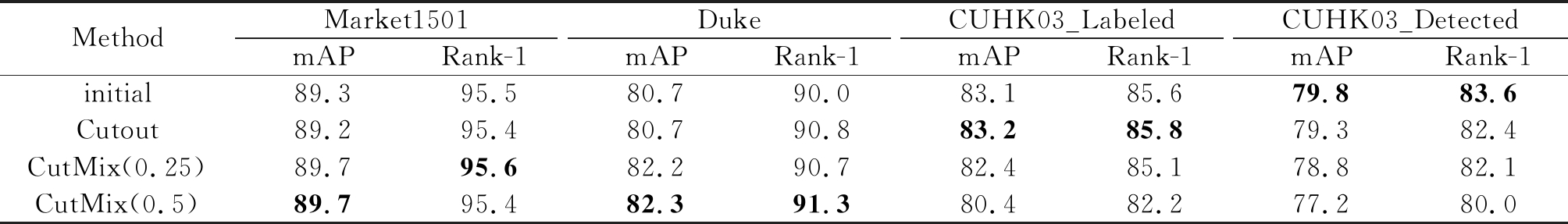

4.3 不同数据增强方法影响

Cutout[13]和CutMix[6]都是数据增强方法,Cutout随机裁剪图像,CutMix随机将两张图像的相同区域互换。‘CutMix(0.25)’是指有25%的概率进行CutMix数据增强,‘CutMix(0.5)’即有一半的概率。表2可以看到Cutout的使用在并没有有效的性能提升,但也没有过多的性能损失。CutMix在Market1501和Duke数据集上数据增强的效果相对明显,尤其是对Duke数据集有1.5个百分点的提升。但是同时也可以看到,在CUHK03数据集上,CutMix反而造成了信息的过多损失,从而影响了模型性能,当CutMix发生的概率降低时,CUHK03数据集上的性能有所提升,这表明减少了信息的损失,这可能与数据集的大小有关,在小数据集上进行此类的数据增强所带来的信息损失要大于增强。

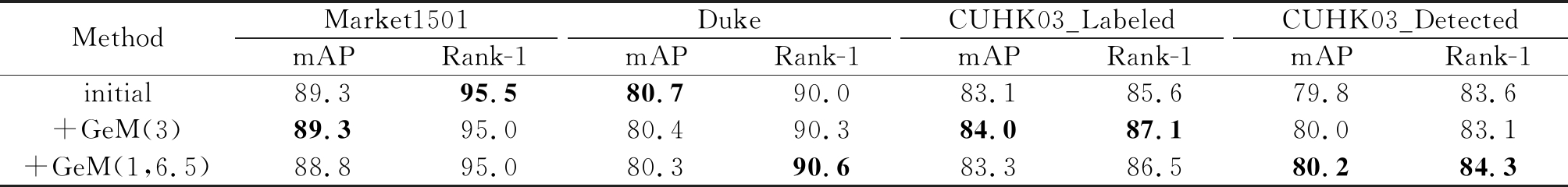

4.4 不同pk值对GeM的影响

[8]提出的GeM Pooling是池化更通用的形式,在有不同的参数pk值时会有不同的表现。表3中的initial是指图1中的v1和v2分支分别使用AP和GMP;‘+GeM(3)’是指将v1和v2分支中的AP和GMP操作都替换为GeM Pooling,其中参数pk设为3;‘+GeM(1,6.5)’是指将v1中的AP操作替换为pk=1的GeM Pooling,将v2中的GMP替换为pk=6.5的GeM Pooling。可以看出,GeM Pooling要略优于常规的最大池化和平均池化。实验中使用的pk值是固定的,也可以自适应学习pk值。[8]中指出学习共享参数比学习多个参数要好一些,共享的学习参数要比共享的固定参数要稍好一些,但这要根据不同的网络结构而看,在此次实验中,不同的参数效果要略好一些。

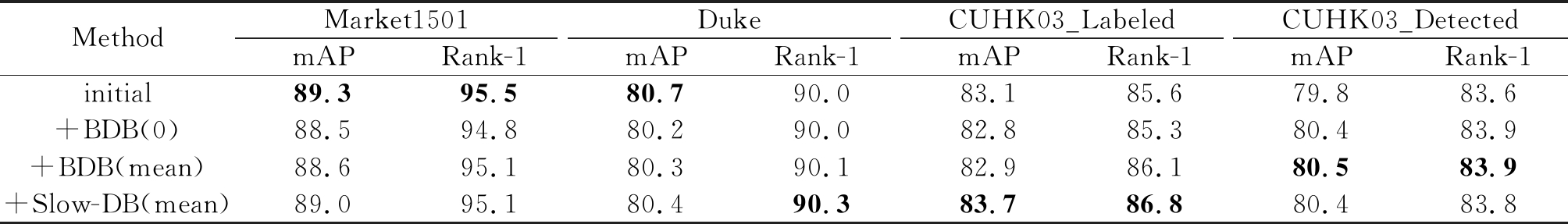

4.5 不同DropBlock方法的影响

对feature map进行随机遮挡能够让网络不去注意那些显而易见的特征,而强迫模型在余下的未擦除的区域中学习更细节的特征。[10]提出的Batch DropBlock(BDB)就是DropBlock的一种改进,实验中把它融进v2分支中可以有效补充v1分支学习到细节特征。表4中initial与4.4节中的一致,‘+BDB(0)’指的是在v2分支中加入BDB微结构,其中擦除的区域值置为0。‘+BDB(mean)’是指擦除的区域值改为擦除区域值的平均。‘+Slow-DB(mean)’是指使用Slow-DropBlock[18]微结构,这是BDB的一种改进,即在指定数量的batches中随机擦除相同的连续的区域,实验中Q=5。表4可以看出‘+BDB(0)’只在CUHK03_detected上有小幅的提升,在其他数据集上效果并不太好,但是经过改进后的‘Slow-DB(mean)’有较好的性能提升。

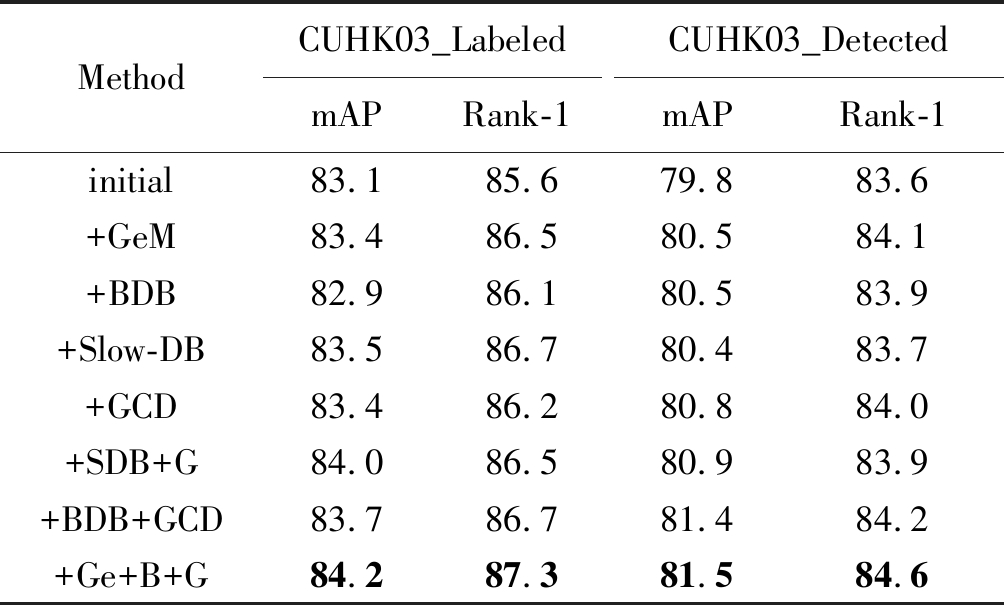

4.6 微结构的影响

图2的初始网络能够在CUHK03_Labeled和CUHK03_Detected数据集上分别取得85.6%和83.6%的Rank-1准确率。在此基础上,实验了GeM,Batch DropBlock(BDB),Slow-DropBlock(Slow-DB)和Gaussian continuous dropout(GCD),单独去看,Slow-DB的性能可能略优于BDB,但是在微结构结合上来看,BDB与其他微结构融合的更好。此次实验中,如表5所示,可以看出结合GeM(此时GeM的参数pk=2.32,对比试验的参数值一致),BDB和GCD时可以获得最优的性能,其中CUHK03_Labeled的mAP可以达到84.2%,Rank-1达到87.3%。

表2 不同数据增强方法实验

Tab.2 Experiments with different data augmentation methods %

MethodMarket1501mAPRank-1DukemAPRank-1CUHK03_LabeledmAPRank-1CUHK03_DetectedmAPRank-1initial89.395.580.790.083.185.679.883.6Cutout89.295.480.790.883.285.879.382.4CutMix(0.25)89.795.682.290.782.485.178.882.1CutMix(0.5)89.795.482.391.380.482.277.280.0

表3 不同pk值的GeM实验

Tab.3 GeM with differentpk %

MethodMarket1501mAPRank-1DukemAPRank-1CUHK03_LabeledmAPRank-1CUHK03_DetectedmAPRank-1initial89.395.580.790.083.185.679.883.6+GeM(3)89.395.080.490.384.087.180.083.1+GeM(1,6.5)88.895.080.390.683.386.580.284.3

表4 不同BDB方法的实验

Tab.4 Experiments with different BDB methods %

MethodMarket1501mAPRank-1DukemAPRank-1CUHK03_LabeledmAPRank-1CUHK03_DetectedmAPRank-1initial89.395.580.790.083.185.679.883.6+BDB(0)88.594.880.290.082.885.380.483.9+BDB(mean)88.695.180.390.182.986.180.583.9+Slow-DB(mean)89.095.180.490.383.786.880.483.8

表5 不同Tricks下CUHK03实验

Tab.5 CUHK03 with different tricks %

MethodCUHK03_LabeledmAPRank-1CUHK03_DetectedmAPRank-1initial83.185.679.883.6+GeM83.486.580.584.1+BDB82.986.180.583.9+Slow-DB83.586.780.483.7+GCD83.486.280.884.0+SDB+G84.086.580.983.9+BDB+GCD83.786.781.484.2+Ge+B+G84.287.381.584.6

其中,“+SDB+G”表示“+Slow-DB+GCD”,“+Ge+B+G”表示“+GeM+BDB+GCD”。

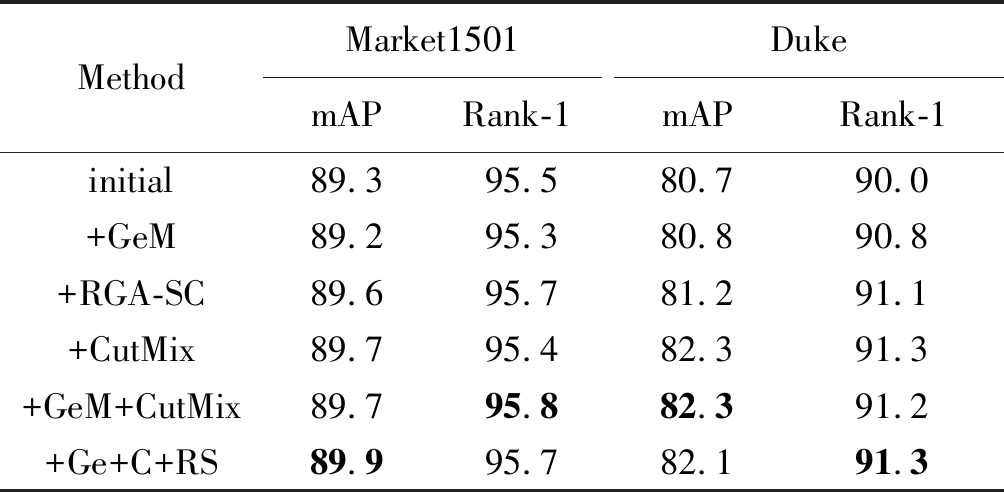

由表2可以看出CutMix在Market1501和Duke数据集上有较好的表现,所以这里主要采取了其他微结构与CutMix相结合的方式。对于mAP而言,图2的初始网络在Market1501和Duke上分别可以获得89.3%和80.7%的结果。在表6中,GeM,RGA-SC和CutMix的添加相比初始网络而言在性能上都会有一定的提升,表6最后结果可以看出,将这三种策略结合在一起并没有相互排斥的表现,但是在性能上没有单独使用各个策略提升的那么明显。结合GeM,RGA-SC和CutMix(此时GeM的参数![]() 对比试验的参数值一致)后的结果是在Market1501数据集上取得89.9%的mAP,在Duke数据集上取得82.1%的mAP。

对比试验的参数值一致)后的结果是在Market1501数据集上取得89.9%的mAP,在Duke数据集上取得82.1%的mAP。

表6 不同Tricks下Market1501和Duke实验

Tab.6 Market1501 and Duke with different tricks %

MethodMarket1501mAPRank-1DukemAPRank-1initial89.395.580.790.0+GeM89.295.380.890.8+RGA-SC89.695.781.291.1+CutMix89.795.482.391.3+GeM+CutMix89.795.882.391.2+Ge+C+RS89.995.782.1 91.3

其中,“+Ge+C+RS”表示“+GeM+CutMix+RGA-SC”。

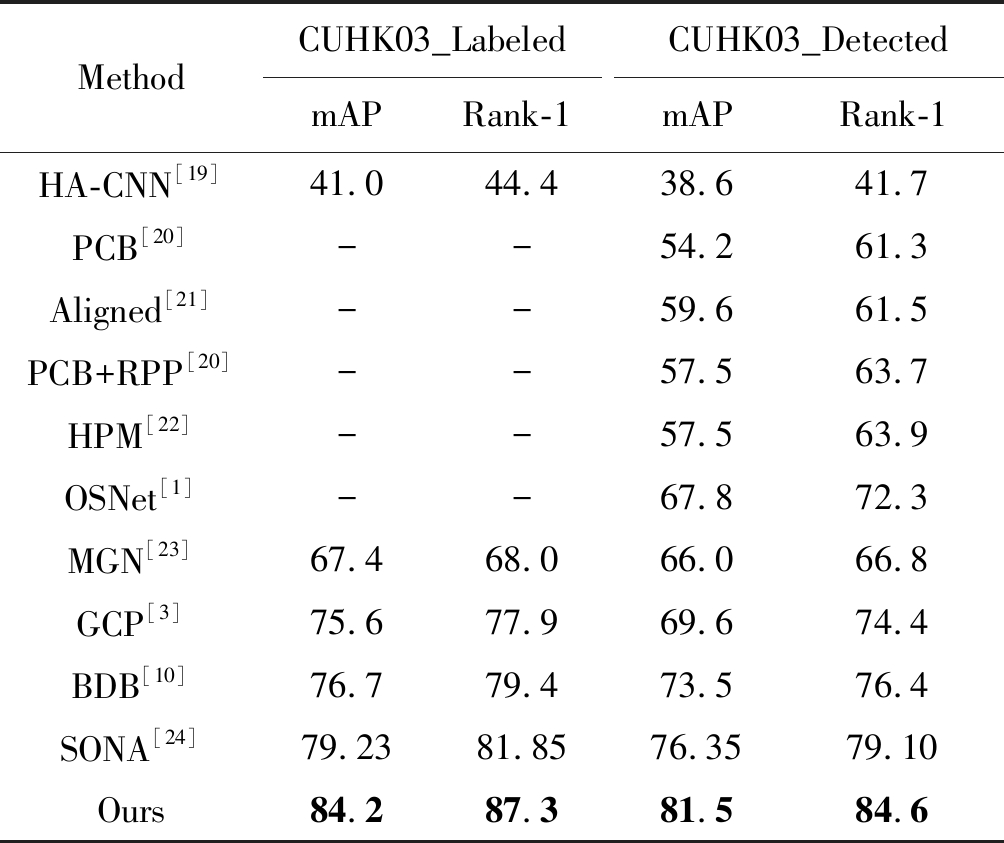

4.7 实验结果与主流方法的比较

本节比较了一些主流的网络和本文提出的BC-OSNet及一些微结构的应用,表7给出了在CUHK03_Labeled和CUHK03_Detected数据集上的结果。可以看到本文提出的网络及微结构在CUHK03上有较好的性能。CUHK03_Labeled的mAP为84.2%,Rank-1为87.3%;CUHK03_Detected的mAP为81.5%,Rank-1为84.6%。四个实验结果都比SONA提升了5个百分点左右。

表7 在CUHK03数据集上的结果对比

Tab.7 Comparison of results on CUHK03 %

MethodCUHK03_LabeledmAPRank-1CUHK03_DetectedmAPRank-1HA-CNN[19]41.044.438.641.7PCB[20]--54.261.3Aligned[21]--59.661.5PCB+RPP[20]--57.563.7HPM[22]--57.563.9OSNet[1]--67.872.3MGN[23]67.4 68.066.066.8GCP[3]75.677.969.674.4BDB[10]76.779.473.576.4SONA[24]79.2381.8576.3579.10Ours84.287.381.584.6

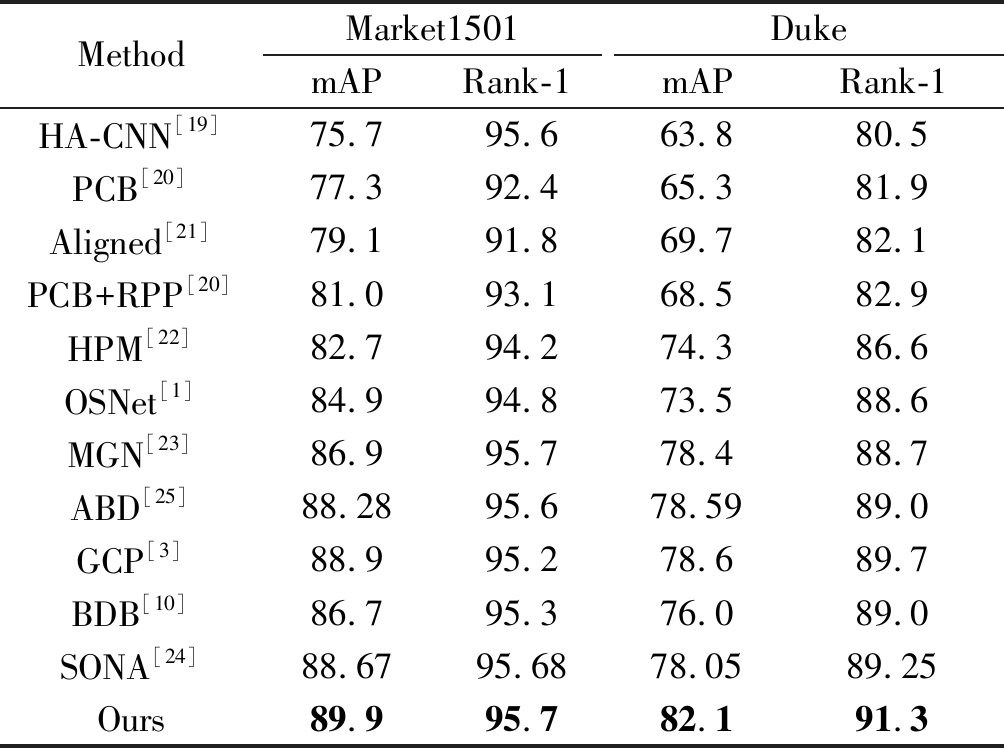

表8给出了在Market1501和Duke数据集上的实验结果,实验表明本文提出的网络及微结构在Duke上性能提升的较好。Market1501的mAP为89.9%,Rank-1为95.7%;Duke的mAP为82.1%,Rank-1为91.3%,与SONA相比,其mAP提升了有4个百分点。

表8 在Market1501和Duke数据集上的结果对比

Tab.8 Comparison of results on Market1501 and Duke %

MethodMarket1501mAPRank-1DukemAPRank-1HA-CNN[19]75.795.663.880.5PCB[20]77.392.465.381.9Aligned[21]79.191.869.782.1PCB+RPP[20]81.093.168.582.9HPM[22]82.794.274.386.6OSNet[1]84.994.873.588.6MGN[23]86.995.778.488.7ABD[25]88.2895.678.5989.0GCP[3]88.995.278.689.7BDB[10]86.795.376.089.0SONA[24]88.6795.6878.0589.25Ours89.995.782.191.3

5 结论

本文在BC-OSNet网络的基础上,分析了各种微结构优化对于该行人重识别网络模型的性能影响。实验结果表明:通过本文的微结构优化,优化后的BC-OSNet在公开的行人重识别数据集上相比原有的BC-OSNet有明显的性能提升,这说明微结构优化在行人重识别网络设计中的有效性。

[1] Zhou K, Yang Y, Cavallaro A, et al. Omni-scale feature learning for person re-identification[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2019: 3702-3712.

[2] Zhang L, Wu X, Zhang S, et al. Branch-Cooperative OSNet for Person Re-Identification[J]. arXiv preprint arXiv: 2006.07206, 2020.

[3] Park H, Ham B. Relation Network for Person Re-identification[J]. arXiv preprint arXiv: 1911.09318, 2019.

[4] 甄俊杰, 应自炉, 赵毅鸿, 等. 深度学习和迭代量化在图像检索中的应用研究[J]. 信号处理, 2019,35(5): 919-925.

Zhen Junjie, Ying Zilu, Zhao Yihong, et al. Application research of deep learning and iterative quantization in image retrieval[J]. Journal of Signal Processing, 2019, 35(5): 919-925.(in Chinese)

[5] 李翌昕, 邹亚君, 马尽文. 基于特征提取和机器学习的文档区块图像分类算法[J]. 信号处理, 2019,35(5): 747-757.

Li Yixin, Zou Yajun, Ma Jinwen. Document region image classification via feature extraction and machine learning algorithms[J]. Journal of Signal Processing, 2019, 35(5): 747-757.(in Chinese)

[6] Yun S, Han D, Oh S J, et al. Cutmix: Regularization strategy to train strong classifiers with localizable features[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2019: 6023- 6032.

[7] Lin M, Chen Q, Yan S. Network in network[J]. arXiv preprint arXiv: 1312.4400, 2013.

![]() F, Tolias G, Chum O. Fine-tuning CNN image retrieval with no human annotation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 41(7): 1655-1668.

F, Tolias G, Chum O. Fine-tuning CNN image retrieval with no human annotation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 41(7): 1655-1668.

[9] Shen X, Tian X, Liu T, et al. Continuous dropout[J]. IEEE Transactions on Neural Networks and Learning Systems, 2017, 29(9): 3926-3937.

[10]Dai Z, Chen M, Gu X, et al. Batch DropBlock network for person re-identification and beyond[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2019: 3691-3701.

[11]Zhang Z, Lan C, Zeng W, et al. Relation-Aware Global Attention for Person Re-Identification[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 3186-3195.

[12]Zhong Z, Zheng L, Kang G, et al. Random erasing data augmentation[J]. arXiv preprint arXiv: 1708.04896, 2017.

[13]DeVries T, Taylor G W. Improved regularization of convolutional neural networks with cutout[J]. arXiv preprint arXiv: 1708.04552, 2017.

[14]Hinton G E, Srivastava N, Krizhevsky A, et al. Improving neural networks by preventing co-adaptation of feature detectors[J]. arXiv preprint arXiv: 1207.0580, 2012.

[15]Ghiasi G, Lin T Y, Le Q V. Dropblock: A regularization method for convolutional networks[C]∥Advances in Neural Information Processing Systems, 2018: 10727-10737.

[16]Wu X, Xie B, Zhao S, et al. Diversity-Achieving Slow-DropBlock Network for Person Re-Identification[J]. arXiv preprint arXiv: 2002.04414, 2020.

[17]Luo H, Gu Y, Liao X, et al. Bag of tricks and a strong baseline for deep person re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, 2019: 0-0.

[18]Kingma D P, Ba J. Adam: A method for stochastic optimization[J]. arXiv preprint arXiv: 1412.6980, 2014.

[19]Li W, Zhu X, Gong S. Harmonious attention network for person re-identification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 2285-2294.

[20]Sun Y, Zheng L, Yang Y, et al. Beyond part models: Person retrieval with refined part pooling (and a strong convolutional baseline)[C]∥Proceedings of the European Conference on Computer Vision (ECCV), 2018: 480- 496.

[21]Luo H, Jiang W, Zhang X, et al. AlignedReID++: Dynamically matching local information for person re-identification[J]. Pattern Recognition, 2019, 94: 53- 61.

[22]Fu Y, Wei Y, Zhou Y, et al. Horizontal pyramid matching for person re-identification[C]∥Proceedings of the AAAI Conference on Artificial Intelligence, 2019, 33: 8295- 8302.

[23]Wang G, Yuan Y, Chen X, et al. Learning discriminative features with multiple granularities for person re-identification[C]∥Proceedings of the 26th ACM International Conference on Multimedia, 2018: 274-282.

[24]Xia B N, Gong Y, Zhang Y, et al. Second-Order Non-Local Attention Networks for Person Re-Identification[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2019: 3760-3769.

[25]Chen T, Ding S, Xie J, et al. Abd-net: Attentive but diverse person re-identification[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2019: 8351- 8361.