1 引言

人们认为美是一种主观的感知活动,各主体对美的评价标准各不相同。现阶段,多数研究都将人脸美丽预测作为特征分类或回归问题。早期人脸美丽预测研究方法大多基于人脸图像的几何特征和纹理特征进行分类[1-2]。随着深度学习的发展,从卷积神经网络中学习深度特征来研究人脸美丽预测成为主流方法[3- 8]。2015年,Xu等[4]提出一种级联微调深度学习模型,用多通道输入图像(RGB人脸图像、细节层图像、亮度层图像)对基础网络进行多次微调,得到0.88的预测相关度;2017年,Xu等[5]再次提出一种心理启发的卷积神经网络(Psychologically Inspired Convolutional Neural Network,PI-CNN)实现自动人脸美丽预测;同年,Liu等[6]为解决人脸美丽预测标签数据和区分性特征缺乏的问题,提出一种结合深度卷积神经网络和几何特征的标签分布学习结构;2019年,Shi等[7]针对人脸缺乏精准的表达,提出使用像素级别的标签作为人脸表征信息,结合共同注意力学习机制定位影响人脸吸引力的人脸区域。

现阶段对人脸美丽预测的研究都是基于单任务进行训练的,忽略了任务之间的关联性。多任务学习通过挖掘任务间的关系获得额外的有用信息,从而提高网络泛化能力和学习效率。2018年,Gao等[8]用深度多任务学习方法构建一个包含人脸美丽吸引力分数预测和人脸关键点检测的模型,在SCUT-FBP5500数据库上相关度达0.92。知识蒸馏的概念首次由Hinton[9]等提出,它可以将教师模型中提取的部分知识迁移到简单的学生模型,再让学生模型结合原始训练集和教师模型中提取的知识进行训练,达到复杂教师模型相似的性能。随后,很多研究者从不同方面对蒸馏方式、蒸馏的有效性进行了研究[10-11]。

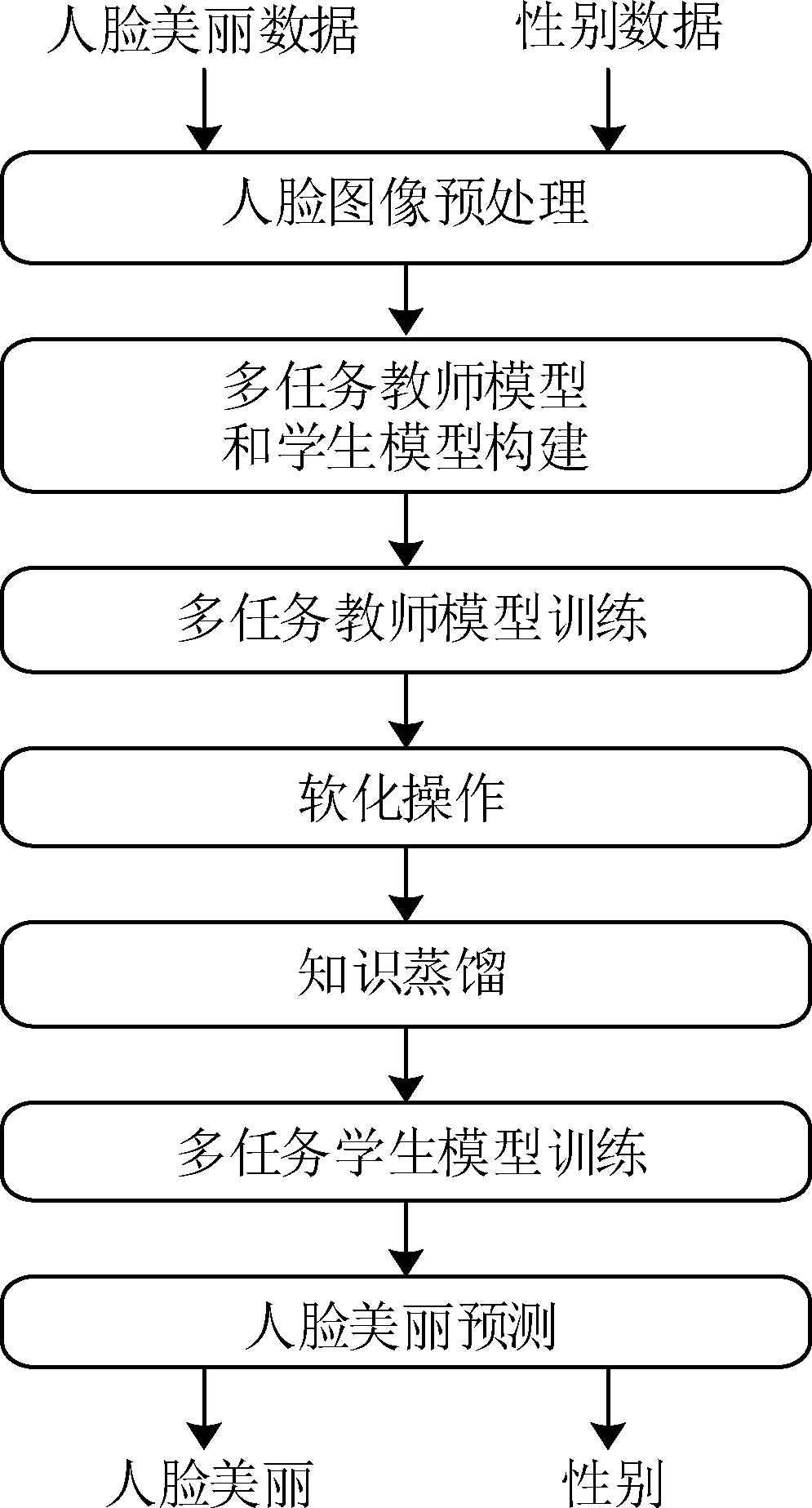

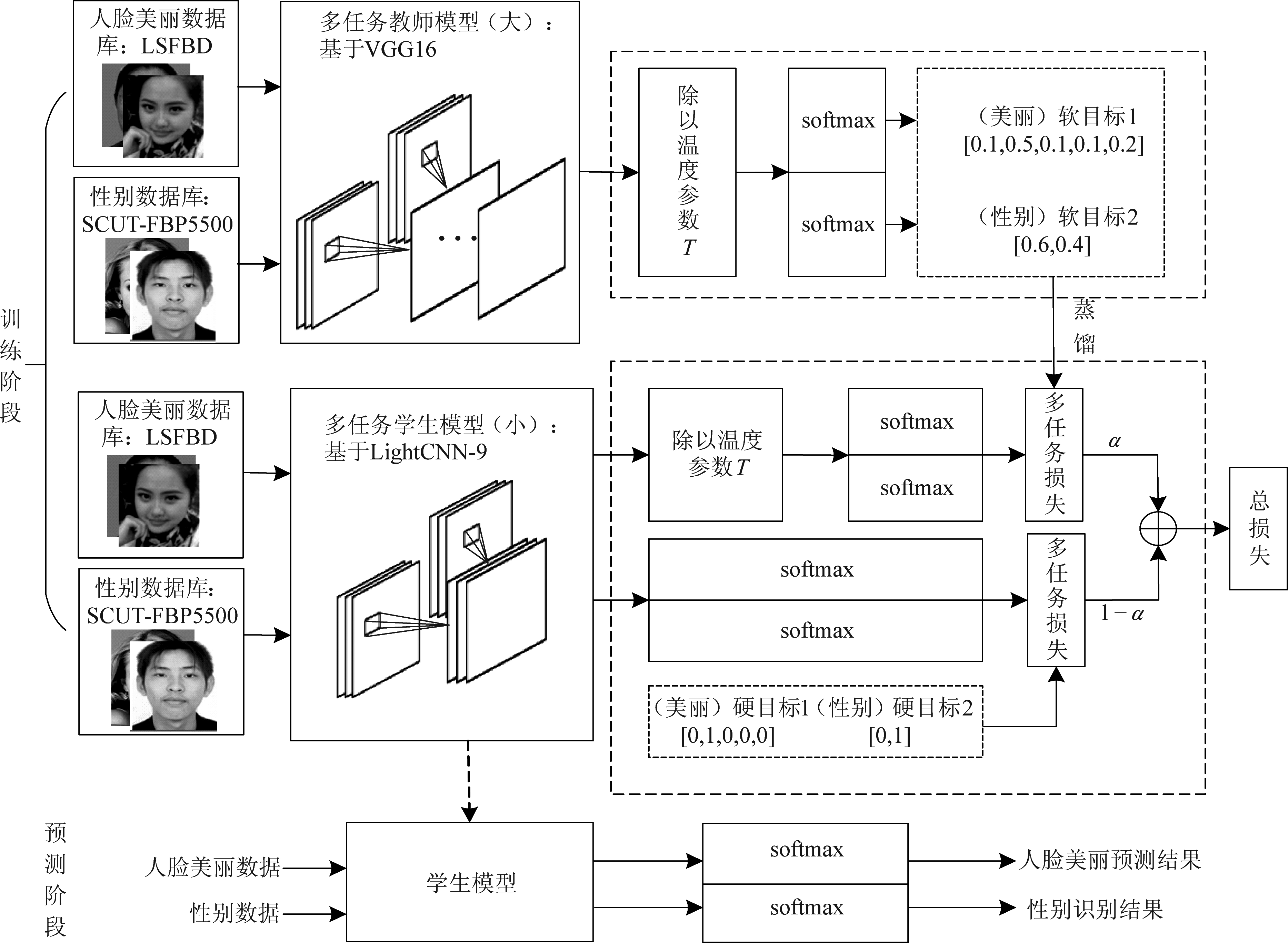

心理家认为一个人对美的评价往往受性别、年龄、发型和社会地位等因素的影响,微笑的人脸更具吸引力[2, 12]。因此,本文考虑人脸美丽预测相关的人脸属性任务,构建多输入多任务人脸美丽预测模型。知识蒸馏可将教师模型的部分知识蒸馏到学生模型,降低模型复杂性和大小,本文提出结合多任务迁移学习与知识蒸馏的人脸美丽预测方法。首先,构建多输入多任务的人脸美丽预测教师模型和学生模型;其次,训练多任务教师模型并计算其软目标(“软化”后softmax输出);最后,进行知识蒸馏,让多任务学生模型用计算得到的软目标联合原始多任务数据集进行训练,使学生模型具有教师模型的性能,从而降低了人脸美丽预测模型的复杂度和大小。

2 本文的人脸美丽预测模型

多任务学习可利用相关任务的辅助信息提高任务性能,相关任务的输入数据一定程度上丰富了数据量,有助于主任务提取丰富的浅层特征。另外,SCUT-FBP5500数据库的图像质量较高,只含有正面人脸图像,更有利于人脸特征的提取。为利用人脸属性和人脸美丽之间的相关性,本文以LSAFBD中的人脸美丽预测为主任务、SCUT-FBP5500数据库中的性别识别为辅任务,构建多输入多任务的人脸美丽教师网络,解决了不同数据库、不同任务进行多任务训练时不能迁移预训练好的网络参数问题。同时,结合多任务损失权重自动学习策略[13]和随机森林提高模型性能。但该多任务教师模型结构复杂、参数量较多。为此,本文结合多任务迁移学习与知识蒸馏人脸美丽预测模型,在保证多任务性能的同时使模型更简单、参数量更少。结合多任务迁移学习与知识蒸馏的人脸美丽预测流程图如图1所示。

图1 本文人脸美丽预测流程图

Fig.1 Our Proposed Facial Beauty Prediction Flow Diagram

2.1 多任务迁移学习

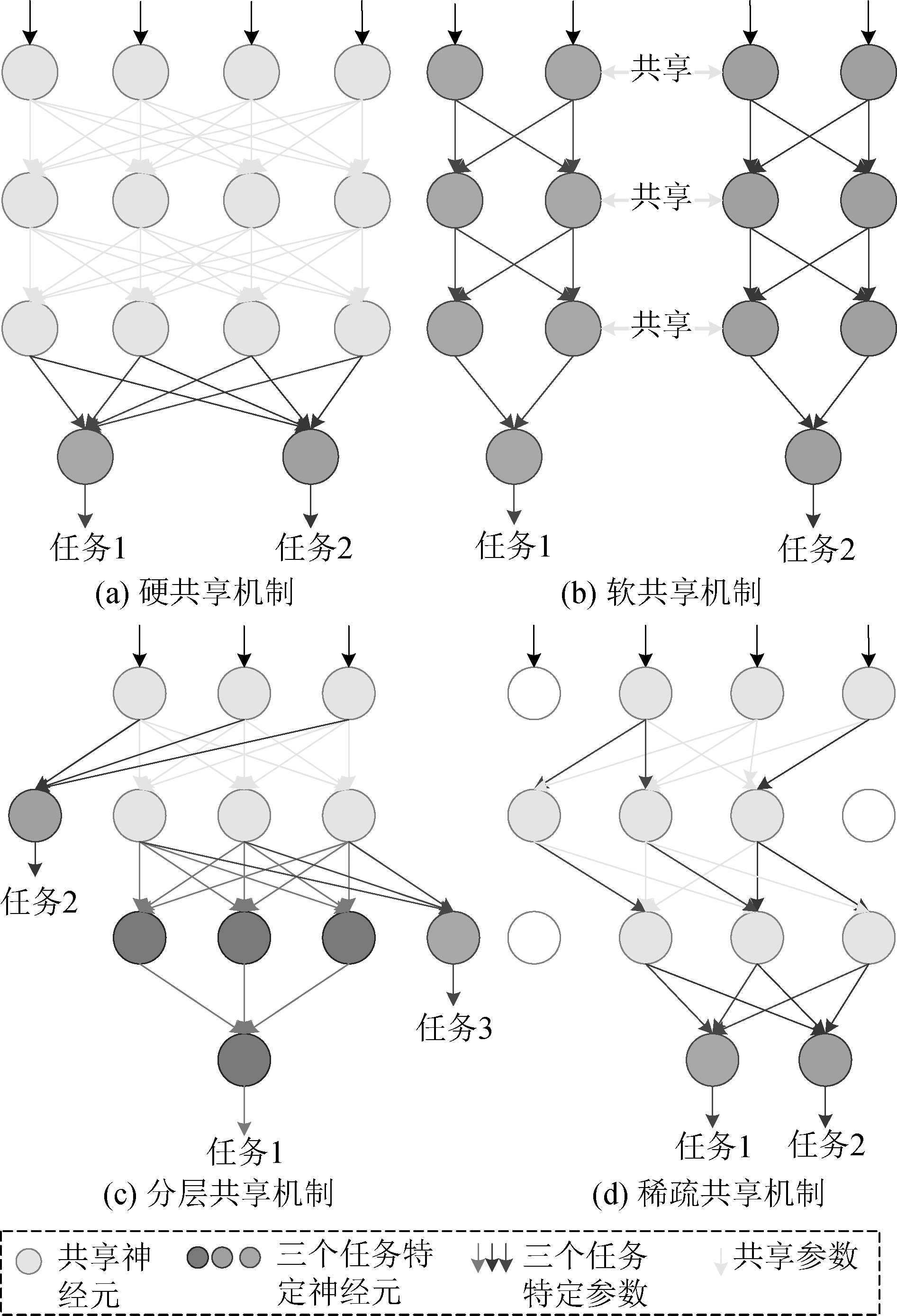

多任务学习可视为归纳迁移的一种方法,利用相关任务之间的共享信息去提高模型的泛化能力、学习效率和预测准确率。在深度多任务学习中,多任务学习通常在隐藏层之间共享参数,其共享机制可分为硬共享、软共享、分层共享和稀疏共享。硬共享是深度学习中应用最广泛的机制,所有任务共享网络结构和参数,再为每个任务设定特定任务层获取任务的特定表示;Baxter等[14]证明了硬共享机制可有效地降低过拟合的风险,但处理弱相关任务时表现较差。软共享机制中,每个任务都学习自己的网络结构和参数,任务之间可以通过对模型参数距离进行正则化来保障参数的相似性[15];软共享机制的约束很大程度上受传统多任务学习中正则化技术的影响且其参数量较多。分层共享即网络底层学习简单任务、高层学习较困难任务,从底层和高层中共享信息,其所需参数少但分层结构设计需要大量经验人工设计。稀疏共享利用剪枝技术共享多任务之间的参数,不仅能减少参数,还能避免负迁移,但其训练时间长[16]。图2为硬共享、软共享、分层共享和稀疏共享的多任务网络结构示意图。

图2 多任务学习共享结构示意图

Fig.2 The Schematic Diagram of Multi-Task Learning Sharing Structure

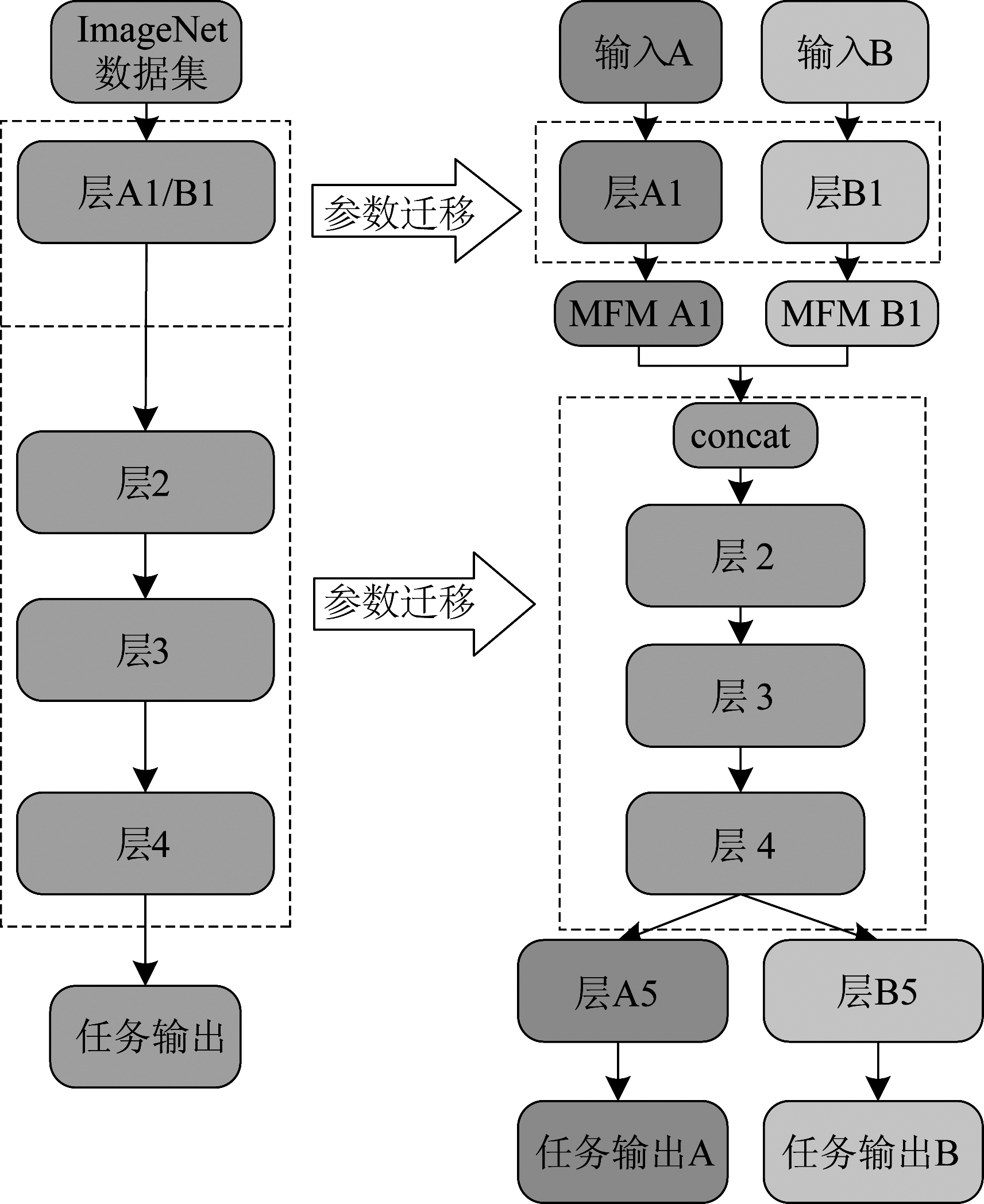

目前,大部分多任务学习网络结构都是单输入多输出,一幅图像对应多种属性标签进行联合训练。由于LSAFBD人脸美丽数据库只包含人脸美丽程度单个标签,不适合用单输入多输出的网络结构进行多任务研究。另外,人脸美丽数据库样本数较少,训练深度网络容易过拟合,若用多输入多任务的网络结构,相关任务的输入数据一定程度上弥补了训练样本数不足的缺陷。本文提出一种多输入多任务的网络结构用于人脸美丽预测。该网络结构主要由MFM层将2个任务支路的维度降为各自一半,再由cancat层实现两个支路维度的拼接,便于后续多任务迁移训练。例如,支路A和支路B的输出维度均为64,经过MFM层降维后维度均为32,为了进行多任务迁移训练,用cancat层将两支路的维度拼接为64。此结构优点是可对不同数据库、不同的相关任务进行多任务训练,还可利用预训练的网络参数,实现多任务迁移,其网络结构示意图如图3所示。

图3 多输入多任务网络结构示意图

Fig.3 The Schematic Diagram of Multi-Input Multi-Task Network Structure

2.2 知识蒸馏

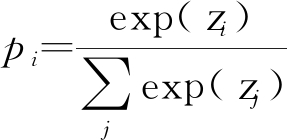

知识蒸馏通过引入教师网络和学生网络的概念,将复杂、学习能力强的教师网络中学习的知识蒸馏到简单、参数量小的学生网络。“softmax”输出层是将神经网络产生的每类值zi进行归一化处理,最后得到正确分类的概率pi。概率越大即分类到该类的可能性就越大,每类的概率表示为

(1)

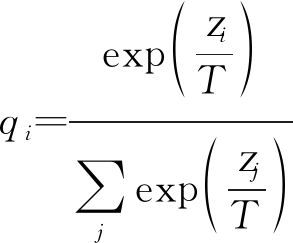

知识蒸馏核心思想是用软目标辅助硬目标进行训练。先计算教师网络“软化”的概率分布,再将其作为总损失的一部分去诱导学生网络训练。其中,“软化”的概率分布计算方式是在“softmax”基础上,引入一个温度参数T得到“软化”后的概率分布为

(2)

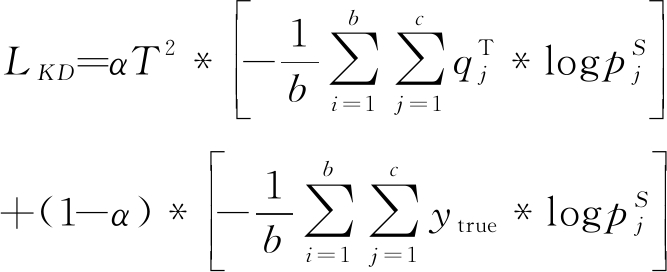

当T=1时,为常见的softmax输出概率。若T越大,则分类概率分布越缓和;若T越小,则错误分类的概率会放大,容易引入不必要的噪声。经过软化后的错误分类概率小,隐含的知识更容易被蒸馏到学生网络。通过最小化知识蒸馏损失,得

(3)

其中,b表示训练的batch-size数,c表示类别数。![]() 和

和![]() 分别表示教师网络和学生网络的软目标,即通过相同的温度参数T软化后得到的概率分布。ytrue为学生网络的硬目标,即原始训练集以独热码(one-hot)形式呈现的真实标签。α为超参数,调节蒸馏损失的两个部分之间的加权平均数。蒸馏损失的第一部分迫使学生网络朝着相似的软目标进行优化,而第二部分则仅使用蒸馏知识和原始训练数据来进行学生网络训练。

分别表示教师网络和学生网络的软目标,即通过相同的温度参数T软化后得到的概率分布。ytrue为学生网络的硬目标,即原始训练集以独热码(one-hot)形式呈现的真实标签。α为超参数,调节蒸馏损失的两个部分之间的加权平均数。蒸馏损失的第一部分迫使学生网络朝着相似的软目标进行优化,而第二部分则仅使用蒸馏知识和原始训练数据来进行学生网络训练。

2.3 结合多任务迁移学习与知识蒸馏的人脸美丽预测模型

本文方法在文献[17]提出的多任务迁移学习人脸美丽预测的基础上,结合多任务迁移学习与知识蒸馏的人脸美丽预测模型,将人脸美丽预测作为主任务,性别识别作为辅任务。利用2.1节提出的多输入多任务网络,构建以VGG16为基础的多任务教师模型和以CNN-5、Vgg-11[18]和LightCNN-9[19]为基础的多任务学生模型。多任务教师模型对应图3中的结构详细如下:层A1和层B1对应VGG16中第一块(2个卷积层和1个池化层);层2对应一个卷积核为1的卷积层;层3至层5对应于VGG16的后四块结构加一个全局平均池化层(Global Average Pooling,GAP);层A5和层B5分别对应两个分类层。在进行多任务教师模型训练时,迁移在ImageNet上训练好的权重参数,充分利用源域信息。同时,结合多任务损失权重自动学习策略和随机森林提高模型性能。进一步,多任务教师模型中的部分知识通过软目标指导学生模型训练蒸馏到多任务学生模型,在保证多任务性能的同时使模型更简单、参数量更少。首先,构建多输入多任务教师模型和学生模型;其次,计算教师模型的软目标;最后,用软目标指导学生网络训练原始多任务数据集,使学生模型具有教师模型的性能。结合多任务迁移学习和知识蒸馏的人脸美丽预测模型如图4所示。

图4 结合知识蒸馏和多任务学习的人脸美丽预测模型

Fig.4 Facial Beauty Prediction Model Combining Multi-Task Learning and Knowledge Distillation

3 实验结果与分析

本文实验的配置为i3-7350k的CPU,48G的内存和GTX1080的GPU;实验平台搭建在Ubtuntu18.04上;深度网络模型基于Pytorch实现;所有实验均是基于多任务进行的,采用多任务损失权重自动学习策略。蒸馏过程中初始学习率为0.001,batch-size为64,epochs为60。超参数α和温度参数T的取值要合理,若取较大的α则需要更大的T去软化教师模型。通常T的范围取1到20之间,本文实验取α=0.8,T=10。

3.1 数据库及人脸图像预处理

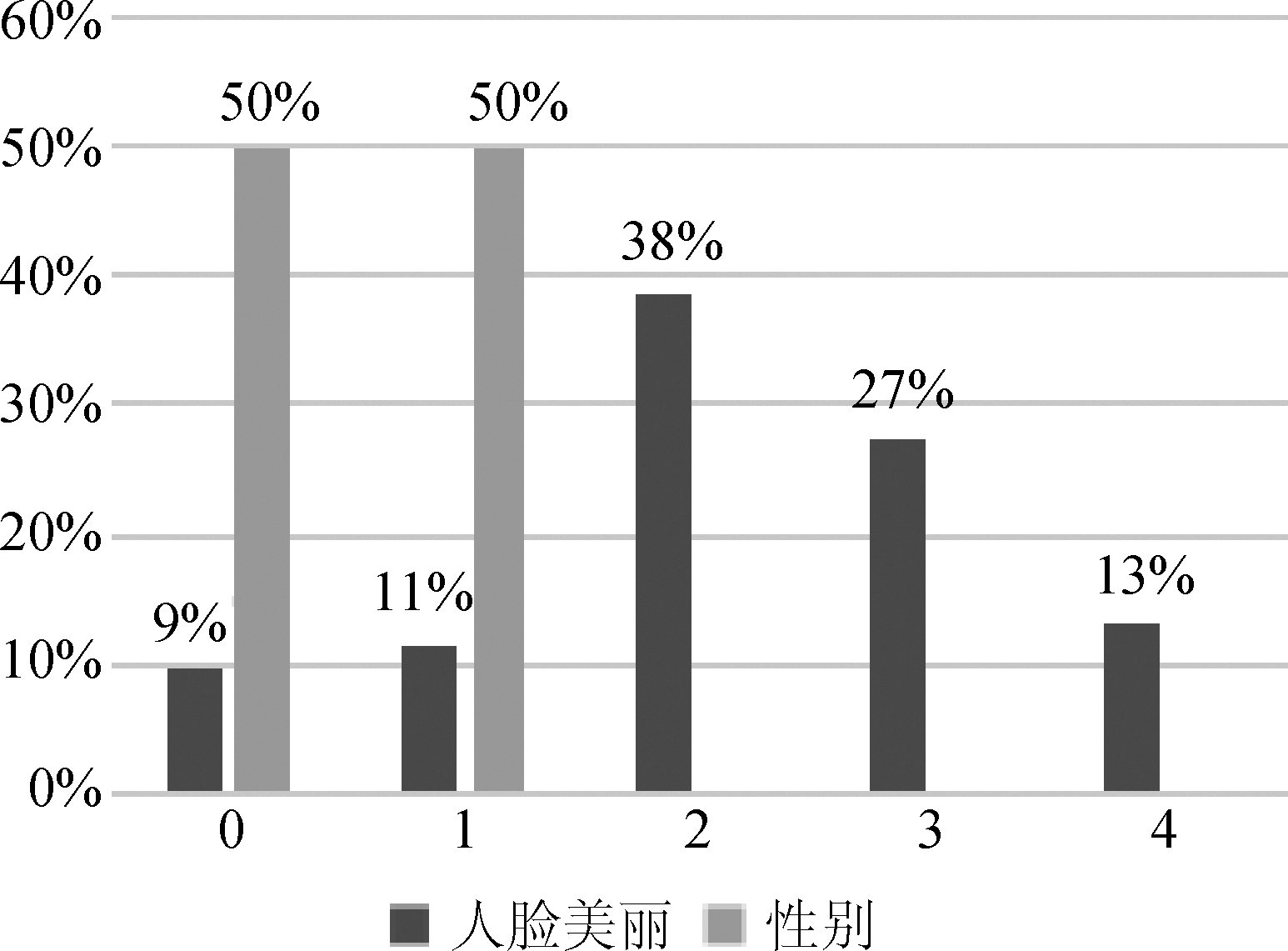

LSAFBD数据库包括有标签图像10000张、无标签图像80000张,图像尺寸为144×144;大多数正面图像包括背景、姿态和年龄的变化;数据库中每张图像对应的美丽程度为五个等级0、1、2、3、4,美丽程度依次增加;其中,“0”类有948张,“1”类有1148张,“2”类有3846张,“3”类有2718张,“4”类有1333张。

SCUT-FBP5500数据库包含5500张高分辨率的正面人脸图像,包含不同种族(亚洲人/白种人)、不同性别(女性/男性)、不同年龄(15~60岁)。该数据库以不同命名方式来命名男性和女性、亚洲人和白种人的人脸图像,由60个志愿者对人脸美丽评分,分数范围为1~5,分数越大代表人脸更美丽。因此,本文可通过分析每张图像的命名获取性别标签,用“0”表示男性,“1”表示女性。该数据库的人脸图像质量较好,有助于多任务的共享特征学习。因此,本文用该数据库作为性别识别的输入数据,两数据库的标签分布如图5所示。

图5 数据库标签分布图

Fig.5 Database Label Distribution

3.2 结果与分析

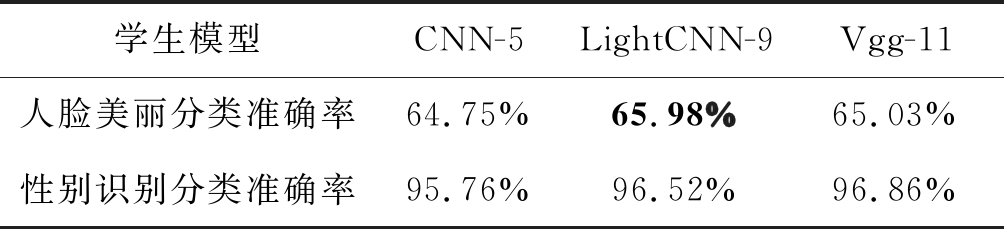

3.2.1 不同规模学生模型对比实验

本实验将对比不同规模的多任务学生模型蒸馏后的人脸美丽和性别识别的分类准确率。多任务学生模型分别以CNN-5、Vgg-11和LightCNN-9为基础构建的图1中多输入多任务网络结构。CNN-5中层A1和层B1分别由1个卷积层和1个池化层组成;层2至层4由4个卷积层和对应的池化层及一个GAP组成;层A5和层B5为2个softmax层。Vgg-11中层A1和层B1分别由原始Vgg-11的第一块构成;层2至层4由剩余卷积块及1个GAP组成;层A5和层B5为2个softmax层。LightCNN-9中层A1和层B1分别由原始LightCNN-9的第一块构成;层2至层4由剩余4个卷积块及一个GAP组成;层A5和层B5为两个softmax层。教师模型用GAP代替了全连接层,本文三个学生网络结构均延用此方法。这样不仅能降低参数量,还能在结构上起正则化的作用。从表1可知,较浅和较深的多任务学生模型蒸馏后的人脸美丽分类准确率均比LightCNN-9略低。太简单的网络结构使得任务在用硬目标进行训练时不能学到更深的知识。

表1 经过知识蒸馏后的多任务学生模型对比

Tab.1 Comparison of Multi-Task Student Models after Knowledge Distillation

学生模型CNN-5LightCNN-9Vgg-11人脸美丽分类准确率64.75%65.98%65.03%性别识别分类准确率95.76%96.52%96.86%

3.2.2 教师模型与蒸馏后学生模型对比实验

此部分实验以VGG16为基础构建多输入多任务教师模型,将其部分知识蒸馏到以LightCNN-9为基础构建的多输入多任务学生模型上。此处对比实验中的两个人脸美丽分类准确率均是未采用随机森林,而是直接经过softmax进行分类的结果。从表2可知,多任务学生模型虽损失不到1%的分类准确率,但减少了约90%的参数量。大大降低了网络模型的大小,便于用更轻量级的模型进行人脸美丽预测。

表2 教师模型与蒸馏后学生模型对比实验结果

Tab.2 Comparison Multi-Task Teacher Models with Student Model after Knowledge Distillation

模型模型大小人脸美丽分类准确率教师模型14793K66.82%学生模型1366K65.98%

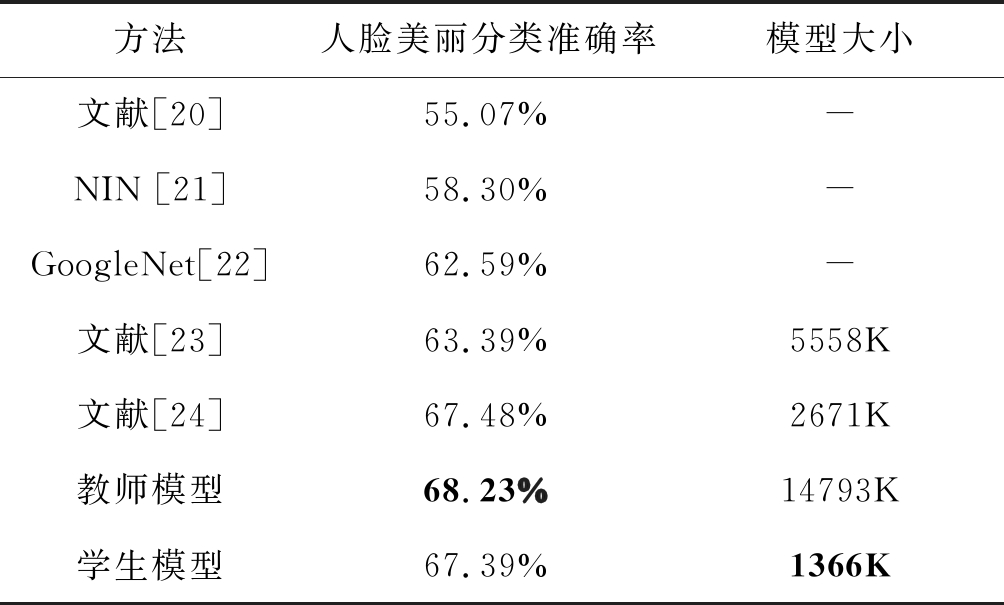

3.2.3 其他对比实验

为了证明所提方法在人脸美丽预测中的有效性,本文将对比不同方法在LASFBD人脸美丽数据库上的性能,各方法的分类结果如表3所示。表3中最后两行为本文多任务教师模型和多任务学生模型的实验结果,该实验均采用了多任务损失权重自动学习策略和随机森林。从表3可知,多任务教师模型的人脸美丽预测目前取得了最高的准确率,但其模型的参数量最多。而多任务学生模型在其基础上,利用知识蒸馏降低了模型的复杂性和参数量。

表3 不同人脸美丽预测方法的对比结果

Tab.3 Comparison Between Different Facial Beauty Prediction Methods

方法人脸美丽分类准确率模型大小文献[20]55.07%-NIN [21]58.30%-GoogleNet[22]62.59%-文献[23]63.39%5558K文献[24]67.48%2671K教师模型68.23%14793K学生模型67.39%1366K

4 结论

本文结合多任务迁移学习与知识蒸馏的人脸美丽预测方法,提出一种新的多输入多任务网络结构,适用于对不同数据库的不同任务进行多任务训练。本文最终以VGG16和LightCNN-9为基础分别构建了一个多输入多任务教师模型和多任务学生模型。其中,多任务教师模型在人脸美丽预测上取得68.23%的分类准确率;结合知识蒸馏将多任务教师模型中的部分知识蒸馏到多任务学生模型,在保证准确率在较小波动范围内大大较低了人脸美丽预测模型的大小,相比于教师模型参数量减少90%。更有利于在人脸美丽数据量少的情况下,用更轻量的网络模型进行人脸美丽预测。后续工作将继续对多任务迁移学习和知识蒸馏方法进行人脸美丽预测研究。首先,研究人脸美丽和其他人脸属性的关联性并进行量化分析;其次,研究不同多任务共享机制对人脸美丽及其相关任务的影响。

[1]Eisenthal Y, Dror G, Ruppin E. Facial Attractiveness: Beauty and the Machine [J]. Neural Computation, 2006, 18(1): 119-142.

[2]Gray D, Yu K, Xu W, et al. Predicting facial beauty without landmarks [C]∥European Conference on Computer Vision. Springer, Berlin, Heidelberg, 2010: 434- 447.

[3]Liu X, Li T, et al. Understanding Beauty via Deep Facial Features[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2019: 1-11.

[4]Xu J, Jin L, Liang L, et al. A New Humanlike Facial Attractiveness Predictor with Cascaded Fine-Tuning Deep Learning Model [J]. Computer Science, 2015, 70(1): 45-79.

[5]Xu J, Jin L, Liang L, et al. Facial attractiveness prediction using psychologically inspired convolutional neural network (PI-CNN) [C]∥IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2017: 1657-1661.

[6]Liu S, Li B, Fan Y Y, et al. Facial Attractiveness Computation by Label Distribution Learning with Deep CNN and Geometric Features[C]∥IEEE International Conference on Multimedia and Expo (ICME), 2017: 1344-1349.

[7]Shi S, Gao F, Meng X, et al. Improving Facial Attractiveness Prediction via Co-attention Learning[C]∥IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2019: 4045- 4049.

[8]Gao L, Li W, Huang Z, et al. Automatic Facial Attractiveness Prediction by Deep Multi-Task Learning[C]∥International Conference on Pattern Recognition (ICPR), 2018: 3592-3597.

[9]Hinton G, Vinyals O, Dean J. Distilling the knowledge in a neural network[C]∥Neural Information Processing Systems, 2014.

[10]Kecin C, Minh T L, Urvashi K, et al. BAM! Born-Again Multi-Task Networks for Natural Language Understanding [C]∥Association for Computational Linguistics (ACL), 2019: 5931-5937.

[11]Phuong M, Lampert C. Towards Understanding Knowledge Distillation [C]∥International Conference on Machine Learning, 2019: 5142-5151.

[12]Hassin R, Trope Y. Facing Faces: Studies on the Cognitive Aspects of Physiognomy [J]. Journal of Personality and Social Psychology, 2000, 78 (5): 837- 852.

[13]Kendall A, Gal Y, Cipolla R. Multi-task Learning Using Uncertainty to Weigh Losses for Scene Geometry and Semantics[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018: 7482-7491.

[14]Baxter J. A Bayesian/Information Theoretic Model of Learning to Learn via Multiple Task Sampling [J]. Machine Learning, 1997, 28(1): 7-39.

[15]Yang Y, Hospedales T M. Trace Norm Regularized Deep Multi-Task Learning[C]∥International Conference on Learning Representations (ICLR), 2017.

[16]Sun T, Shao Y, Li X, et al. Learning Sparse Sharing Architectures for Multiple Tasks[C]∥Association for the Advancement of Artifificial Intelligence, 2019.

[17]Gan J, Xiang L, Zhai Y, et al. 2M BeautyNet: Facial Beauty Prediction Based on Multi-Task Transfer Learning[J]. IEEE Access, 2020, 8(1): 20245-20256.

[18]Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[C]∥International Conference on Pattern Recognition (ICPR), 2015.

[19]Wu X, He R, Sun Z, et al. A Light CNN for Deep Face Representation with Noisy Labels [J]. IEEE Transactions on Information Forensics and Security, 2018, 13(11): 2884-2896.

[20]Zhai Y, Huang Y, Xu Y, et al. Benchmark of a Large Scale Database for Facial Beauty Prediction[C]∥International Conference on Intelligent Information Processing, 2016: 131-135.

[21]Lin M, Chen Q, Yan S. Network in Network[C]∥International Conference on Learning Representations (ICLR), 2014: 14-16.

[22]Szegedy C, Liu W, Jia Y, et al. Going Deeper with Convolutions[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2015: 1-9.

[23]甘俊英, 谭海英, 项俐, 等. 结合局部二值模式和卷积神经网络的人脸美丽预测[J]. 信号处理, 2019, 35(1): 150-158.

Gan Junying, Tan Haiying, Xiang Li, et al. Facial Beauty Prediction Combined Local Binary Pattern and Convolution Neural Network [J]. Journal of Signal Processing, 2019, 35 (1): 150-158.(in Chinese)

[24]Zhai Y, Cao H, Deng W, et al. BeautyNet: Joint Multiscale CNN and Transfer Learning Method for Unconstrained Facial Beauty Prediction[C]∥Computational Intelligence and Neuroscience, 2019: 1-14.