1 引言

X 光安检是公共安全防御的一道重要防线,通过对物品进行透视扫描,进而发现隐藏在行李中的违禁品。民航领域中,航空事故原因大多是由于人的不安全行为导致,机场安检仍需安检人员通过肉眼对X光安检图像里的违禁品进行识别[1]。安检人员作为一个压力密集型的职业长期处于高压的工作环境会造成工作上的差错从而影响航空运行安全[2]。在人工智能快速发展的今天,由机器辅助人工实现智能安检对提高安检员的工作效率具有重要意义。

X光安检图像违禁品的检出实际上是完成对违禁品的定位与分类,即用目标检测算法判断安检图片中是否有违禁品,并在安检图片中标记出它的位置及类别。X光安检图像存在以下特点:(1)背景杂乱:由于X光成像色彩与材质相关,背景与违禁品厚度和密度相近时,会干扰违禁品的特征学习;(2)重叠现象严重:物品形状在射线投影下严重失真,且随机放置会带来物品间的遮挡导致违禁品识别难度增大;(3)违禁品多尺度:即使在同一安检图像中违禁品尺寸大小不一且同一类别违禁品在不同图像中相对大小也存在变化。因此,背景干扰、多尺度/遮挡违禁品检测成为X光安检图像目标检测的难点。

传统目标检测算法的思路为区域选择—特征提取—分类器,通过提前设置不同尺度的滑动窗口对整幅图像进行遍历,再根据经验设计具有一定鲁棒性的特征,最后使用分类器对目标进行分类。传统目标检测算法普遍存在特征提取层次低,不稳定;鲁棒性差;无实用性。然而深度学习算法网络层数较深,满足层与层之间不同的特征学习需求,有利于多尺度违禁品识别,实现智能安检。

本文主要针对X光安检图像检测难点,基于SSD[3](Single Shot MultiBox Detector)经典模型,结合其他检测算法的诸多优点,本文提出了适合于安检图像违禁品检测的网络框架——非对称卷积多视野神经网络ACMNet(Asymmetrical Convolution Multi-View Neural Network),设计出小卷积非对称模块ATM(Asymmetrical Tiny Convolution Module)、空洞多视野卷积模块DCM(Dilated Convolution Multi-View Module)和多尺度特征图融合策略MF(Fusion strategy of multi-scale feature map):

(1)MF解决复杂背景下的特征干扰问题,通过交叉融合高低层特征图学习多尺度特征,利用共享参数进行不同通道的信息交融,充分学习背景特征与违禁品特征,有效提高背景干扰情况下的违禁品检测精度;

(2)DCM解决透视遮挡问题,利用违禁品之间的位置相互关系对被遮挡部分进行预测,采用空洞卷积无偿扩大视野,用多尺度视野兼顾全局定位与局部分类的任务,建立全局与局部的联系,有效提高遮挡违禁品的检出率;

(3)ATM解决小目标漏检问题,用小卷积和非对称卷积学习不同尺度的违禁品局部特征,采用空洞卷积捕捉小目标在全局视野下的位置,降低小目标的漏检率。

实验结果表明,ACMNet能有效应对背景干扰下多尺度违禁品检测问题,取得了84.3%的检测精度值,单张安检图像检测速度达0.015 s,这将有助于解决当前安检行业内所面临的违禁品检测问题。

2 相关工作

2.1 传统安检图像处理算法

X光机通过对初始成像中像素点的恢复形成X光RGB彩色图像[4],图像中只含有颜色信息而含有较少的纹理信息,利用传统的分类方法,例如:Cascade+HOG+Haar[5],很难对违禁品进行定位与分类。在一个装有多种类金属违禁品和其他金属材质非违禁品的行李里,传统的X光机检测系统只能根据像素值在物品所在处恢复成不同深浅的蓝色,检测出物品为金属材质,但无法判断行李中是否有违禁品、违禁品所属种类以及位置。

随着算法的发展与工业落地的需求,应用于传统安检图像处理的算法,主要是对行李里的危险物品进行分类与检测。文献[6]通过多视图投影的方法,利用KNN[7]分类器对2D关键点进行物品分类;文献[8]利用结构估计和跟踪算法,实现对X射线零件的分类;文献[9]提出多视图目标检测的分支定界算法,在具有SVM(Support Vector Machine)[10]的BoVW[11](Bag of Visual Word)框架上,利用双能X射线图像中的补充信息,检测X射线货物图像中的危险物品;文献[12]中提到一种新型X光图像民航违禁品分类方法,通过X光安检图像提取Contourlet变换后的共生矩阵特征和Tamura纹理特征,以及X光图像的直方图特征,串联得到联合特征向量对违禁品图像分类。

传统安检图像处理算法捕捉特征能力差,难提取到目标的纹理细节信息,对遮挡和方向变化的违禁品目标分类与检测效果不理想。深度学习技术则通过对图像进行多通道学习,完成对目标的分类与定位,以求在目标的检测精度和不同数据集的泛化能力上表现更优。

2.2 深度学习技术的发展

计算机视觉就是利用相机和算法,让计算机感知周边环境。深度学习引入“端到端学习”的概念,给计算机视觉和人工智能领域带来了革命性的突破。自AlexNet[13]赢得2012届图像识别大赛的冠军,卷积神经网络(Convolutional Neural Networks, CNN)便成为图像分类中的核心算法模型,也让深度学习技术走进计算机视觉领域。空洞卷积[14]的出现,在保持参数量不变的情况下增大了卷积核的感受野,有利于输出更全局的特征信息,帮助其他算法学习全局语义信息。Lin, Tsung-Yi等人提出FPN[15]网络,将提供位置信息的低层信息与提供目标特征的高层信息进行融合,在不降低运行效率的同时以增加模型对不同尺度目标检测的鲁棒性。Inception结构最早出自GoogleNet[16],在每层卷积中采用不同尺寸的卷积核进行多尺度学习,用增加网络的宽度的方式提高网络运行效率。Inception-v3[17]更是通过 1×1卷积处理通道关系映射,然后通过n×1和1×n的非对称卷积处理独立空间之间的关系。由于卷积神经网络对目标特征有强大的特征提取能力,因此更多的研究从简单的分类任务转向目标检测任务。

基于卷积神经网络的目标检测算法主要分为一阶段和两阶段算法。一阶段目标检测网络,例如:YOLO-v3、SSD、FSSD,在特征抽取、分类、定位回归之后输出检测结果。两阶段目标检测网络,如:Faster-rcnn[18],需要在特征抽取之后生成区域候选框,将生成的定位框映射到特征层的区域,最后输入到全连接层进行分类和回归。Faster-rcnn两阶段算法在精确度上占据优势,但是速度和对多尺度物品的检测精度还有很大的提升空间;YOLO-v3算法[19]检测精度远超两阶段算法,还新添多尺度特征图层,唯一不足即不能在同一个学习单元格识别出两个类别,对目标之间存在局部遮挡的情况存在高危漏检率;SSD算法在VGG-16[20]的基础网络后形成一个类金字塔形的特征图结构,实现对目标局部特征的有效学习,但缺乏全局语义信息。FSSD[21]算法将SSD中conv4_3和FC7之间进行特征融合,获得精度提升,但是新增的大尺寸卷积操作会降低运行效率。

2.3 深度学习技术在安检图像处理中的应用

深度学习技术在安检图像处理中的应用主要分为:监督式分类、检测、分割和无监督异常检测。

最早,文献[22]将CNN应用于X射线安全图像,实现对枪支的二分类,实验效果完胜BoVW传统分类方法;由于深度学习需要大量数据样本,后来Yang 等人在文献[23]中采用GAN生成违禁品进行数据增强以提高分类精度;然而违禁品在实际场景中的出现具有偶然性,导致类别不平衡,文献[24]中通过提取不同图层特征,加强对违禁品的分类。

“检测”是深度学习技术落地工业的必然趋势。文献[25]中通过提取前景特征,然后利用F-RCNN检测违禁品;文献[26]基于物体方向变化提取结构张量,通过级联多尺度结构张量生成感兴趣区域(Region of Interest,RoI)以便进行违禁品检测; 然而,监督式的深度学习需要处理大量的数据标签,文献[27]采用弱监督方式利用注意力机制对违禁品进行分类与定位,实现无标签信息的检测;后来,多视角的检测方法得到发展,文献[28]中提到一种基于CNN的多视角X射线图像数据的物体检测方法,对行李进行多个角度的透视成像,进行行李的 3D重建,并完成对其中违禁品的检测。

特定应用场景下,需要对安检图像进行像素级的识别,文献[29]提出一种“三阶段”方法,通过使用Mask RCNN[30]实现对象级分割,并用超像素分割完成子区域分割,最终实现像素级分类;文献[31]则通过在编码器-解码器分割网络中利用双重注意力机制的分割模型,完成对对象定位与分类;文献[32]通过添加上下文并建立迁移模型,提出了一种基于颜色信息的前景-背景分割方法。

为了减轻数据的预处理工作,深度学习技术在安检图像处理中出现了无监督式“异常检测”的应用,通过对只含正常物品的数据集训练用以检测未知/不可见的异常情况。文献[33]利用条件生成对抗网络,联合学习高维图像空间的生成和潜在空间的推理,检出与正常数据分布相差较大的违禁品异常值。

实际上,单一的深度学习模型总是不能完全满足安检图像违禁品检测的需求,主要表现为:对安检图像中小尺寸违禁品目标存在漏检;对存在相互遮挡的多个违禁品目标产生漏检/误检;对背景与违禁品密度相近的安检图像泛化性差。

3 安检图像违禁品检测网络

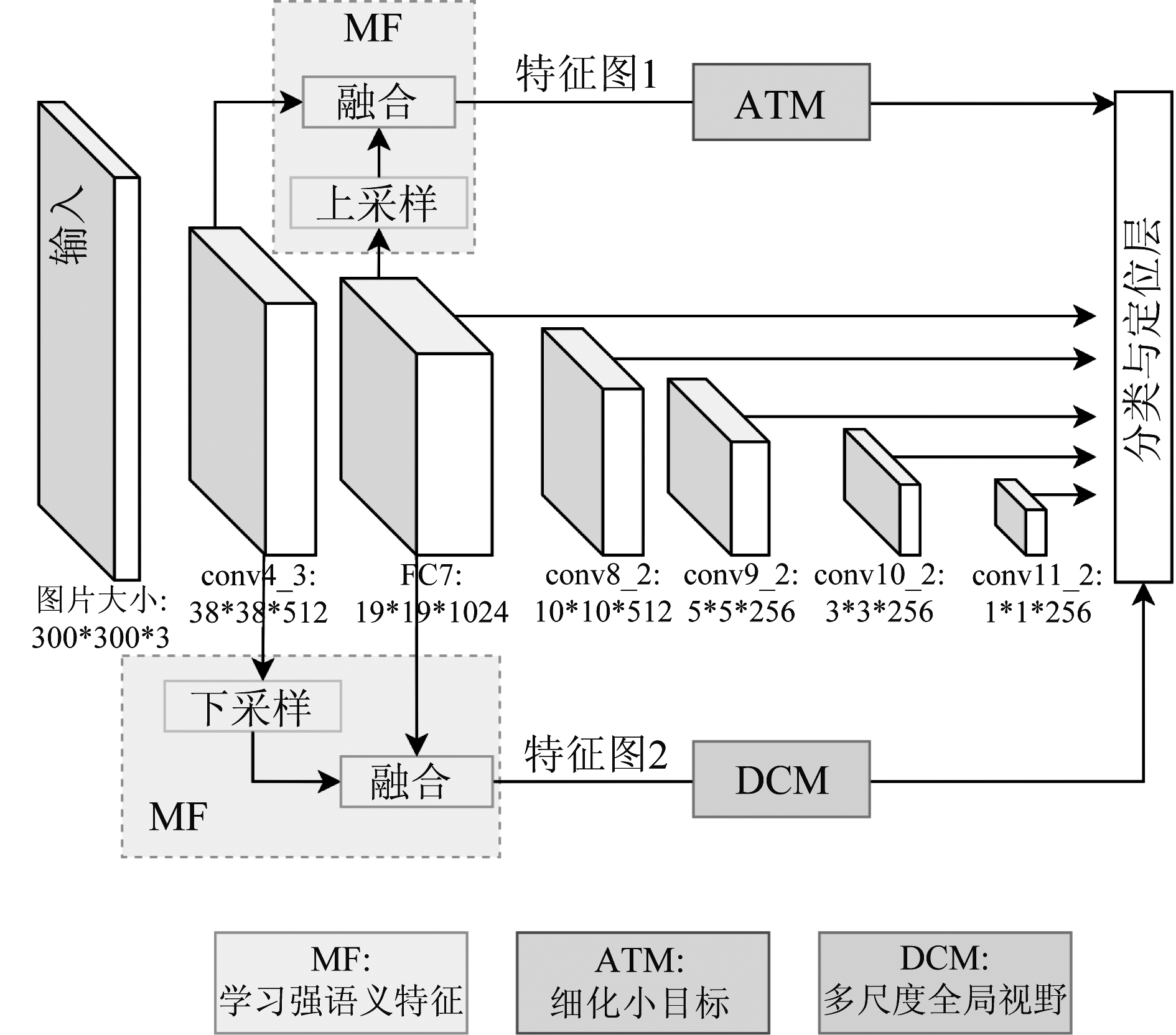

为解决以上问题,本文提出适用于X光安检图像违禁品检测的网络ACMNet,网络结构如图1。

图1 ACMNet网络结构

Fig.1 The structure of ACMNet network

ACMNet通过在SSD模型的底层特征图之间加入MF,学习浅层特征中的强语义信息,从而提高检测器对安检图像中背景和多尺度违禁物品之间的甄别能力;通过对conv4_3低层目标特征的抽取,特征图1之后设计并添加了ATM,专注于提高小目标的检测精确度;通过对FC7高层轮廓信息的保留,特征图2之后加入DCM,专注于局部细节与全局视野的兼容,帮助违禁品在遮挡情形下学习更全面的局部特征,从全局的角度判断违禁品的类型并完成违禁品的定位。

新增的模块采用轻量化设计:(1)并行的分组网络提高效率:对纵向网络进行分组,使其横向连接,以加深网络深度,提高运行效率。(2)善用卷积:用1×1、3×3、5×5小卷积降低由加深大尺度卷积网络带来的计算量;1×3和3×1非对称卷积将通道与空间关系解耦,学习抽象高层特征,并将网络参数从n×n减少至2×n,提高运算效率。

3.1 MF融合策略

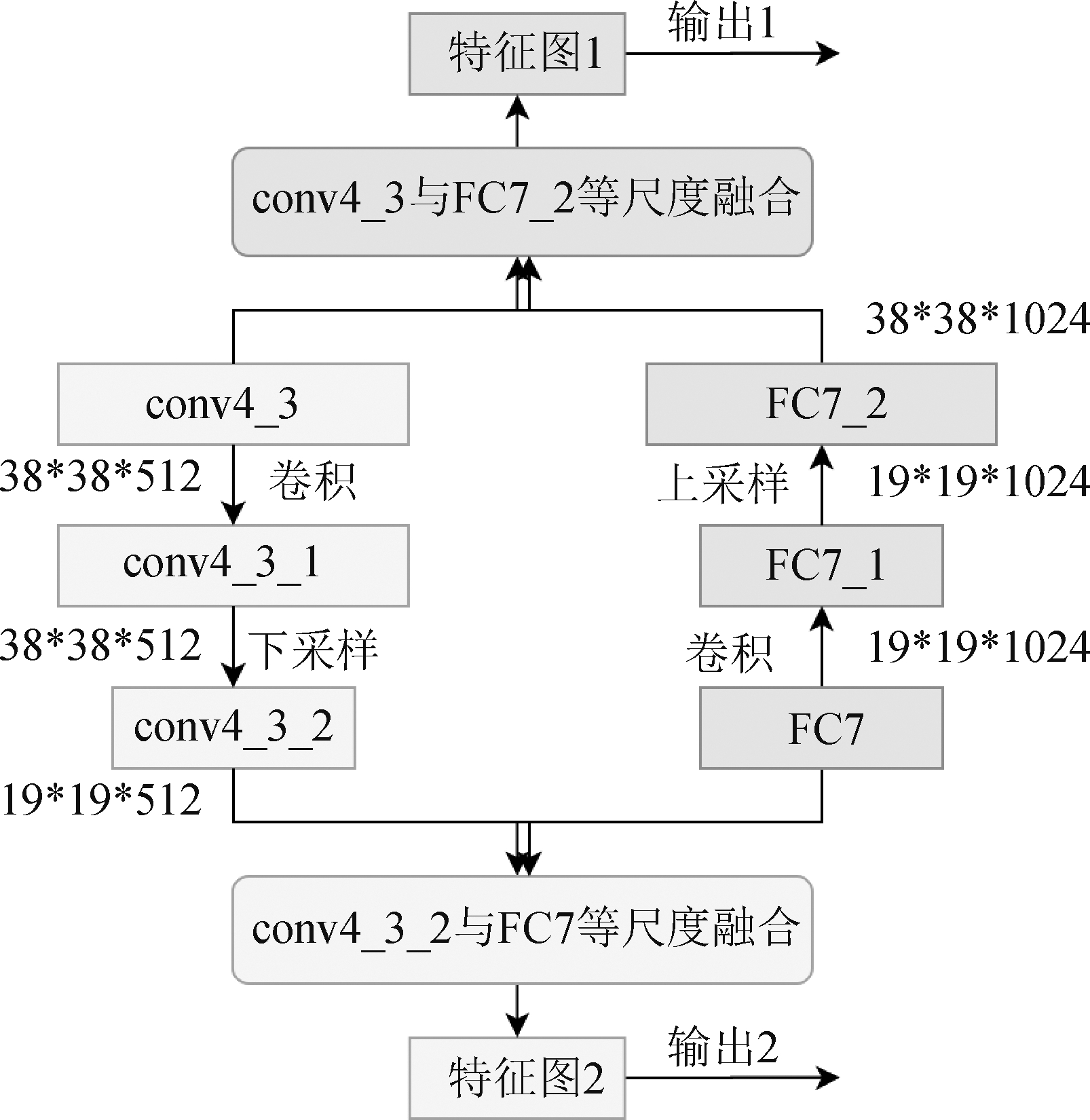

浅层特征只能帮助模型识别未被干扰的违禁品,当非违禁品背景对违禁品目标存在特征学习干扰时,需要添加深层的强语义特征才能更好地完成检测任务。原SSD模型直接将各层特征单独送入分类与定位层,信息得不到交融。借鉴FSSD的融合思想和FPN的基础网络架构进行特征图间融合,将不同尺度的特征图进行参数共享,充分学习安检图像背景特征与违禁品前景特征,设计出MF,图2为MF结构。

图2 MF结构

Fig.2 The structure of MF

在原SSD模型基础上,对高层语义特征FC7层进行卷积与上采样(上采样方式:双线性插值法),将其获得的特征图与conv4_3进行融合形成特征图1,学习低层关联特征;对低层特征信息conv4_3层进行卷积与下采样(下采样方式:3×3卷积),与FC7层特征融合形成特征图2,补充语义信息。本文的消融实验中,验证了MF设计能有效提高背景干扰下违禁品的检测精度。

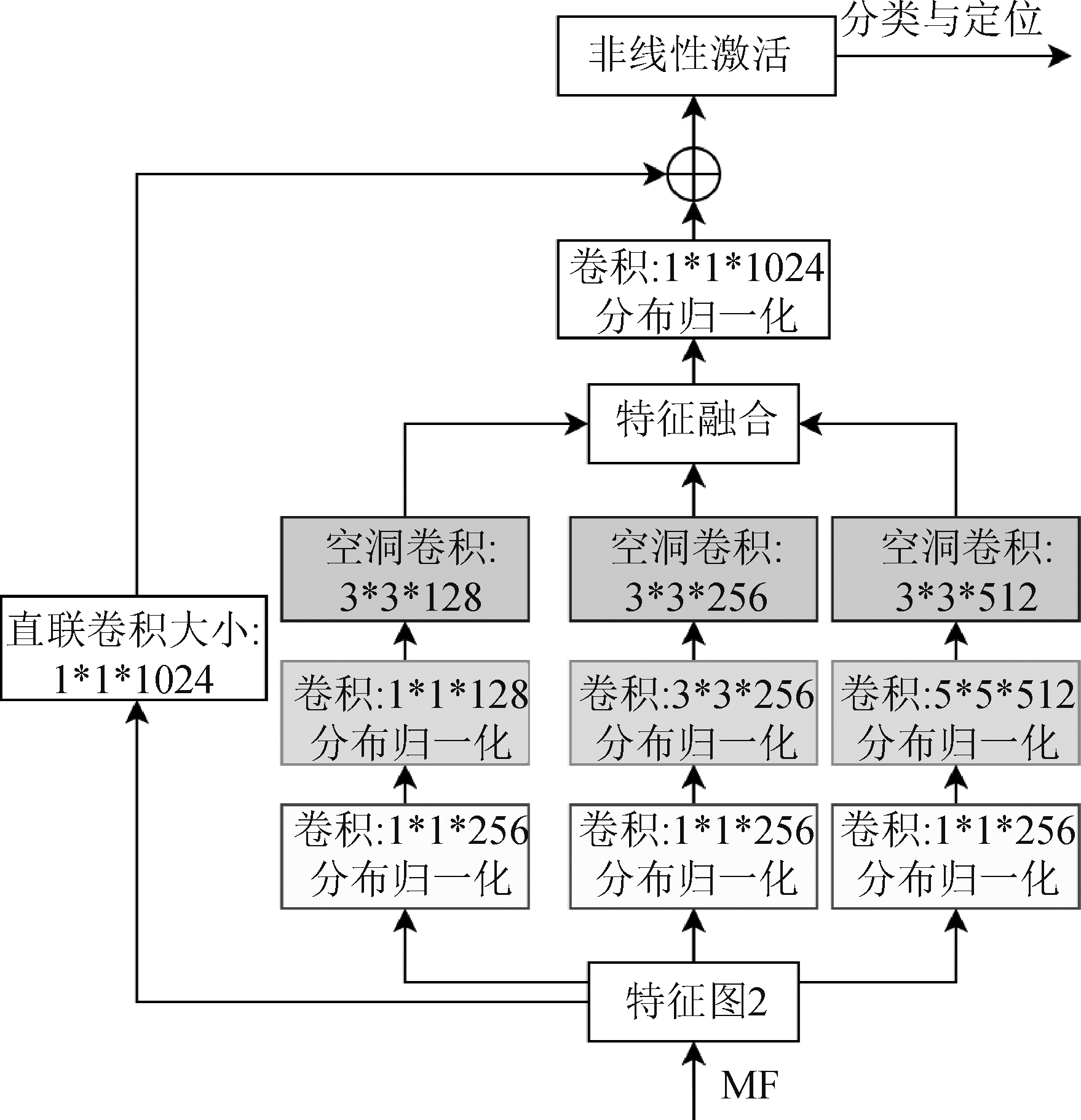

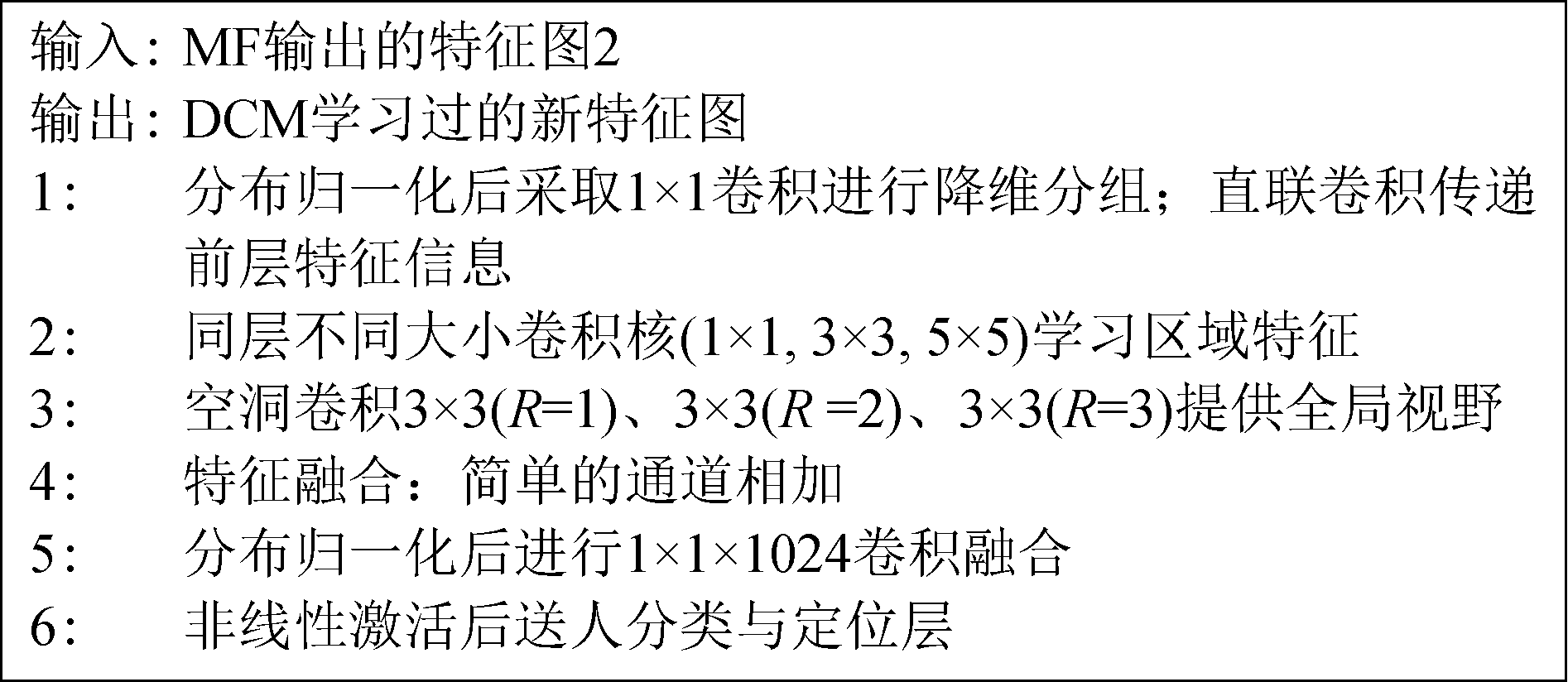

3.2 DCM模块

由于X光成像颜色受原子核数量的影响,颜色深浅受密度影响,高密度金属呈现较深的蓝色,低密度金属呈现较浅的蓝色,塑料质地的刀柄呈现橘黄色。当不同质地的违禁品之间存在遮挡关系时,高密度违禁品会遮盖低密度违禁品导致算法模型漏检;当相近质地的违禁品存在遮挡关系时,两者变得不易区分,造成模型误检。传统卷积神经网络对局部特征敏感,无法考虑目标在全局中的位置关系。本文设计出DCM,有效解决传统卷积中出现的视野缺陷,提高对遮挡违禁品的检测精度。DCM第一层采取1×1卷积将特征学习任务进行分组;第二层采用不同尺寸的卷积对较低层像素特征中不同质地的违禁品特征进行学习;第三层加入同卷积核不同膨胀率的空洞卷积3×3(R=1)、3×3(R=2)、3×3(R=3),获得3×3,7×7,11×11的学习视野,编码特征空间中长距离语义信息,从全局的语义信息对质地相近的违禁品轮廓信息进行判断;利用直联卷积保留前层特征,最后,将各通道特征融合,完成对MF输出的特征图2在全局视野下遮挡违禁品的特征学习。图3是DCM网络结构。图4是DCM伪代码图。

图3 DCM网络结构图

Fig.3 The structure of DCM

图4 DCM伪代码图

Fig.4 Pseudo code diagram of DCM

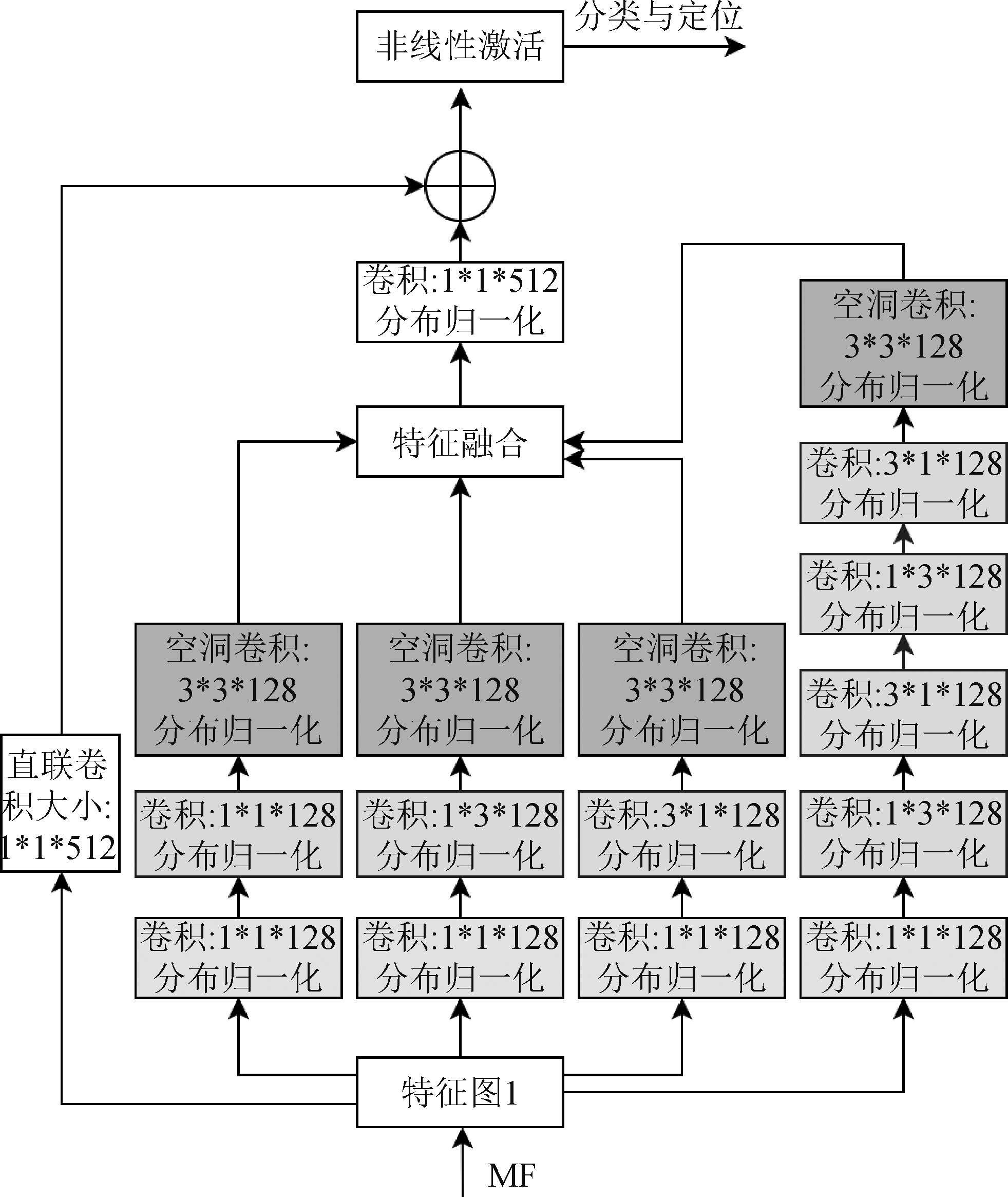

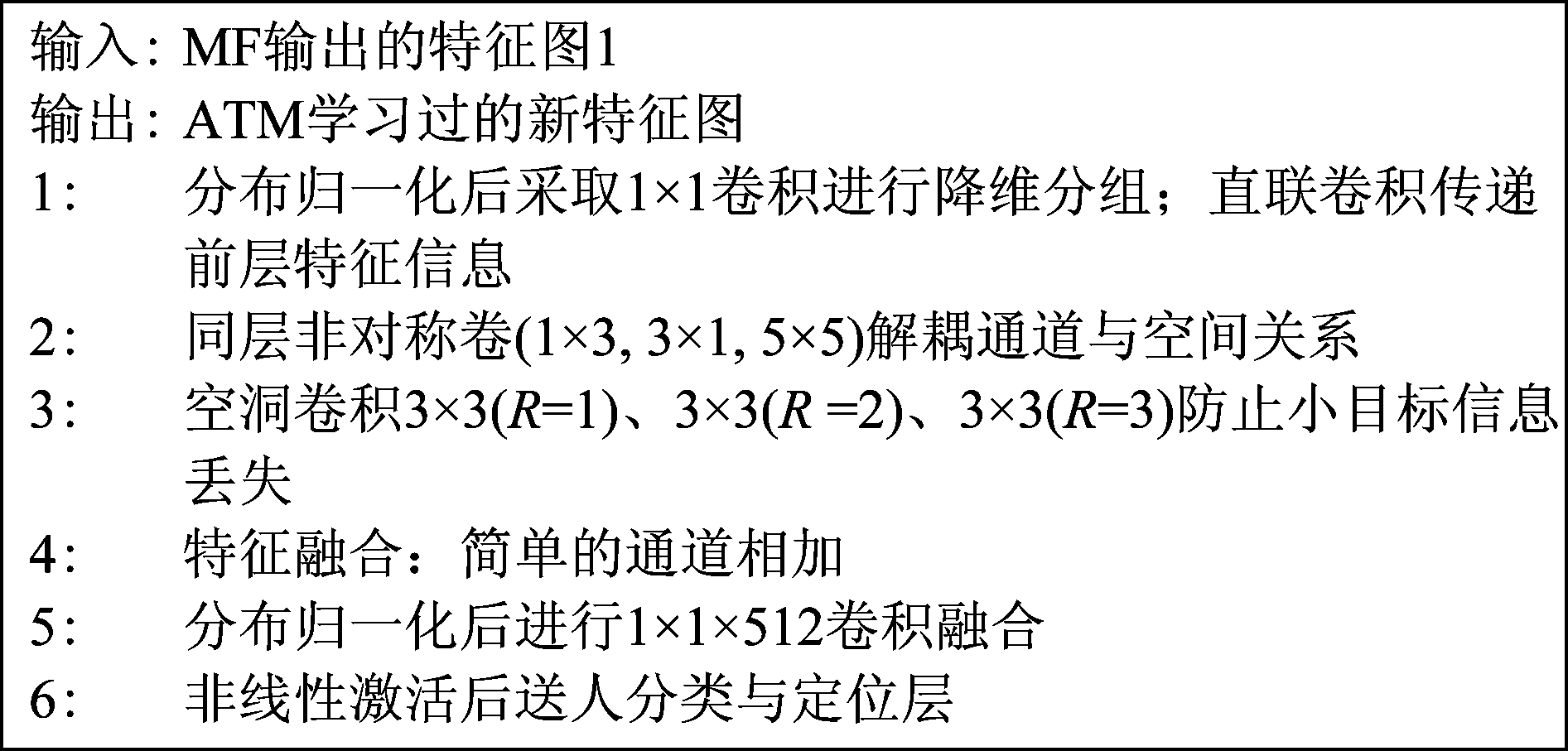

3.3 ATM模块

小目标检测问题主要是来源于(1)大尺度卷积核无法细致学习小尺度目标特征;(2)随着网络的加深,全局视野下的局部小目标信息丢失。本文设计ATM,采用非对称小卷积核进行多尺度违禁品识别,保证安检图像中小目标在被检测时在网络的最高层依旧保持较高的分辨率;采用空洞卷积捕捉小目标在全局视野下的位置,降低小目标的漏检率。ATM第一层采取1×1卷积进行分组卷积;第二层采取1×3、3×1非对称卷积核将通道关系和空间关系解耦,学习多尺度多方向的违禁品信息,补充小目标的局部特征;第三层采用膨胀率分别为R=1、R=2、R=3且卷积核为3×3的空洞卷积,在前一层的局部特征上关联到更广的视野,防止小目标在信息传递时特征丢失;利用直联卷积保留前层特征,最后,将各通道特征融合,完成对MF输出的特征图1在全局视野下小目标违禁品的特征学习。图5是ATM网络结构。图6是ATM伪代码图。

图5 ATM网络结构

Fig.5 The structure of ATM

图6 ATM伪代码图

Fig.6 Pseudo code diagram of ATM

4 实验

在本节中,主要分为数据集构建、对比实验、消融实验三部分,通过一些对比实验验证了上述改进方案的有效性,针对待解决的安检图像违禁品检测问题对模型进行消融实验。实验结果表明,本文提出的方法在X光安检图像违禁品检测上取得令人较为满意的结果。

4.1 数据集构建

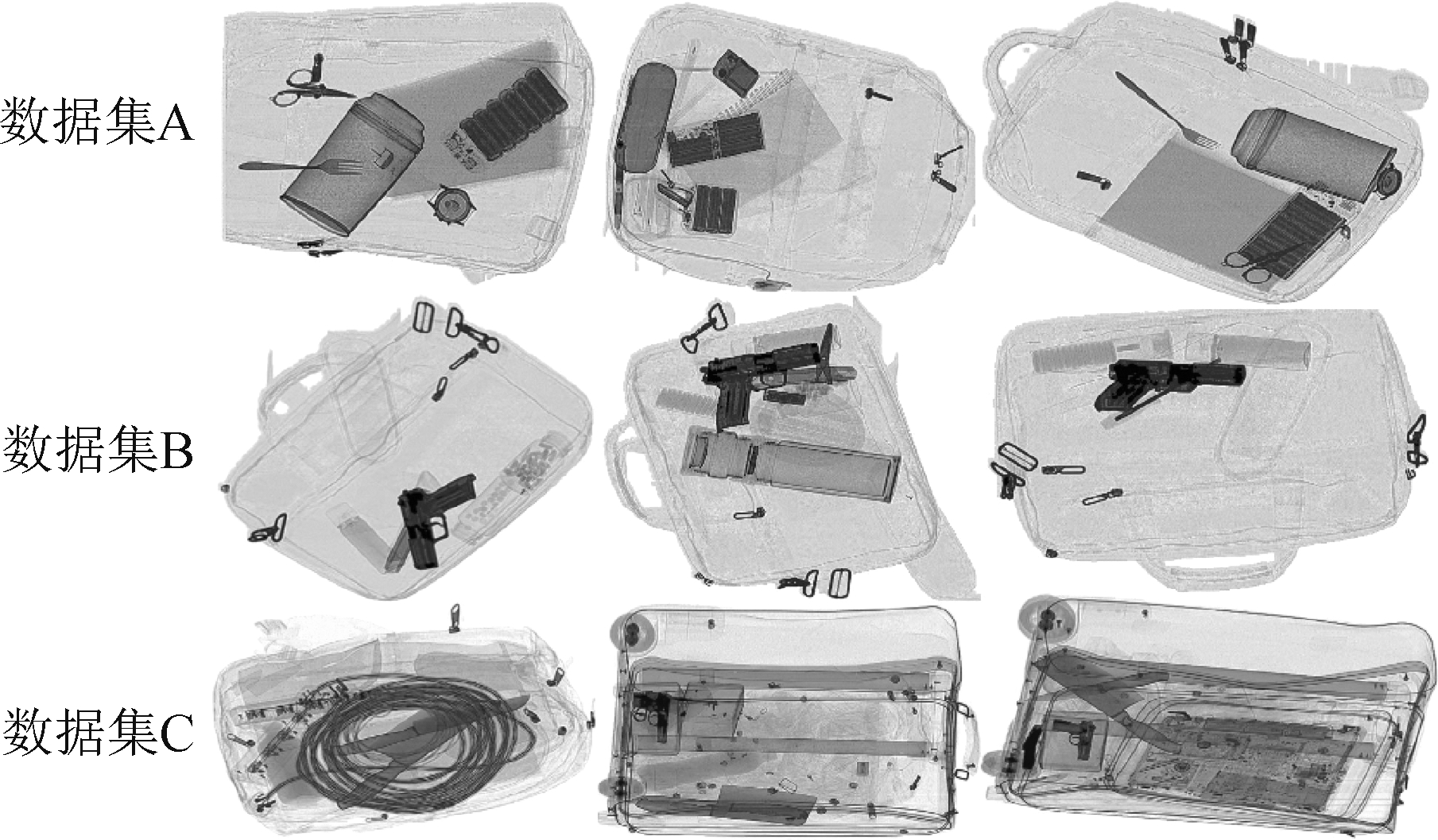

针对X光安检图像违禁品检测的常见问题构建了极具特征的三个数据集:

数据集A:简单背景安检图像2000张。

主要特征:背景结构简单,内含待检测的多尺度违禁品。

作用:叉子、小剪刀、打火机等小尺寸违禁品用以检测模型对小目标的鲁棒性。

数据集B:遮挡违禁品安检图像2000张。

主要特征:背景结构简单,内含不同尺度违禁品且存在超过30%比例的局部遮挡。

作用:用于训练与测试模型对遮挡违禁品的检测性能。

数据集C:复杂背景安检图像8700张来自于开源的地铁站安检数据集[24]。

主要特征:非违禁品中金属材质含量较多,对高密度金属违禁品的检出干扰较大。

作用:用于检测在背景干扰严重时,模型对此类数据集的泛化性。

如图7为数据集样本。

图7 数据集样本

Fig.7 The samples of the data sets

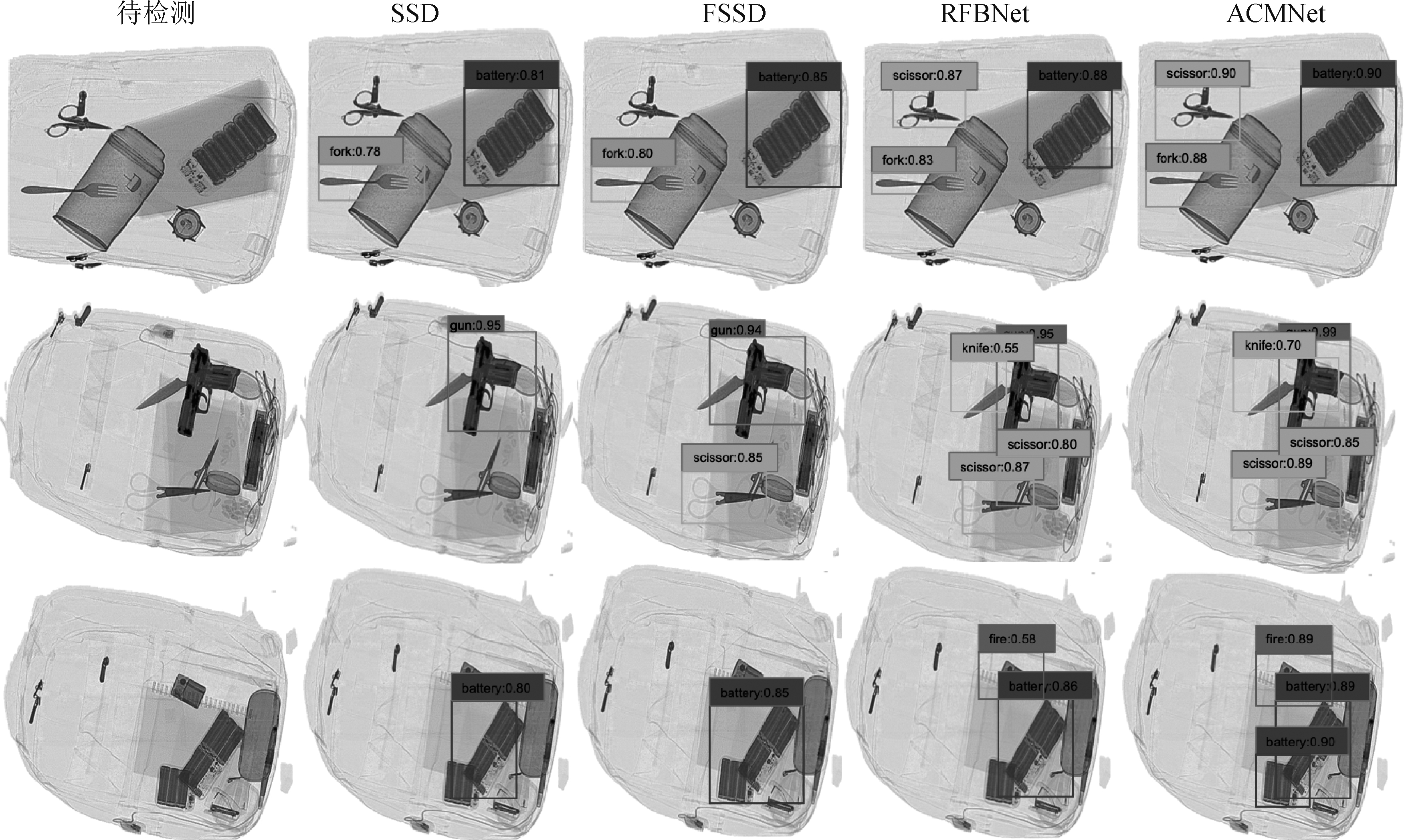

4.2 对比实验

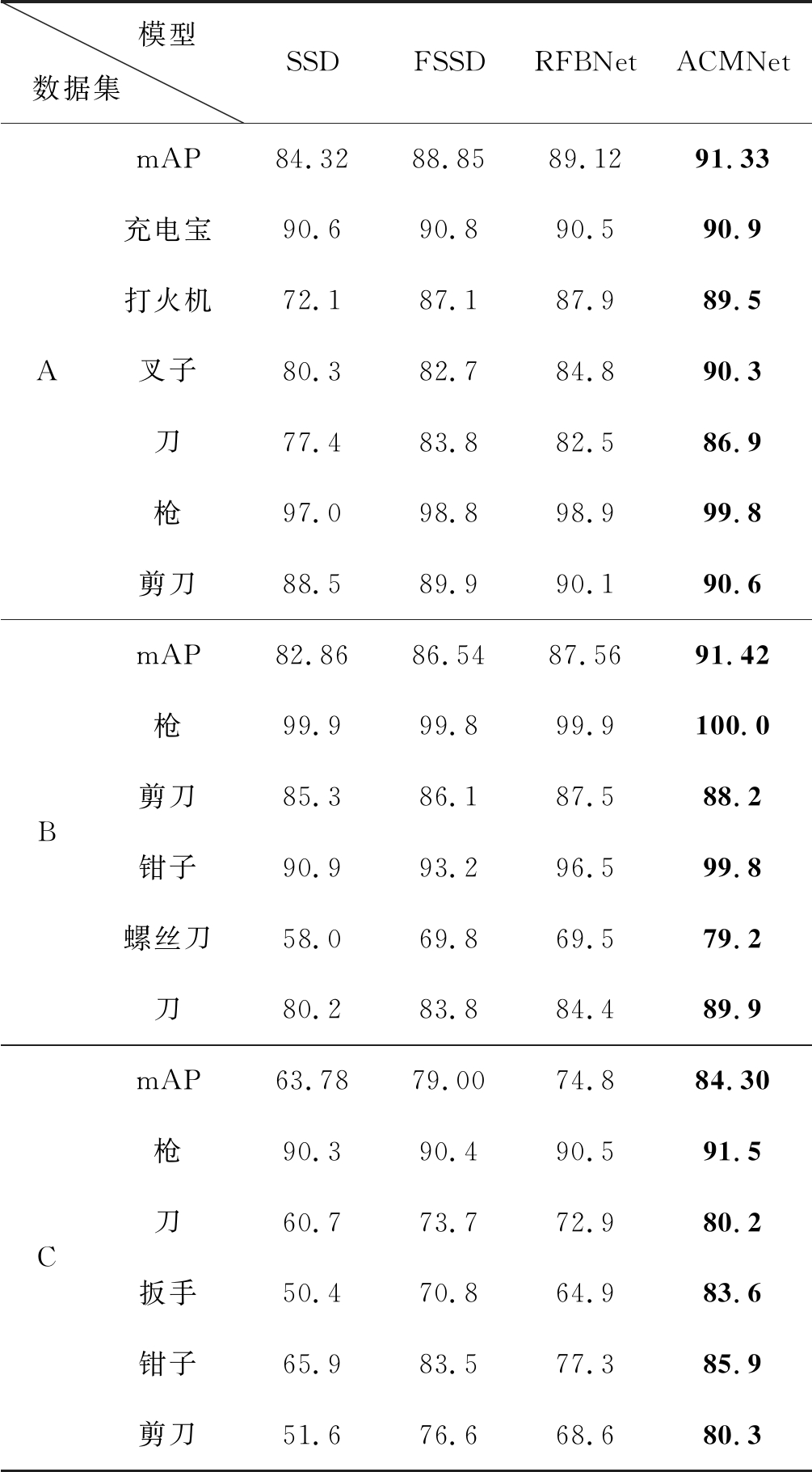

本论文将SSD作为基本架构,将MF生成的新特征图送入ATM和DCM,新的网络模型ACMNet,有效提高了背景干扰下的多尺度违禁品的检测性能。对比模型FSSD在底层特征之间进行简单融合,泛化性更好;对比模型RFBNet[34]则在SSD上加入空洞卷积大大提高了目标检测的精度。为了证明各功能模块设计的有效性,我们在数据集A、B、C上做出关于模型SSD、FSSD、RFBNet、ACMNet的对比实验,训练集与测试集比例为3∶1, 采用平均精度(mean Average Precision,mAP)作为评估检测准确度的指标。实验的软硬件环境为深度学习框架 Pytorch,ubuntu16.04 系统,GPU 显卡型号为 NVIDIA 1080Ti。实验参数batch_size:16,learning-rate:4e-3,momentum:0.9,Weight_decay:5e- 4,Gamma:0.1。在各数据集中的安检违禁品的检测精度如表1所示。

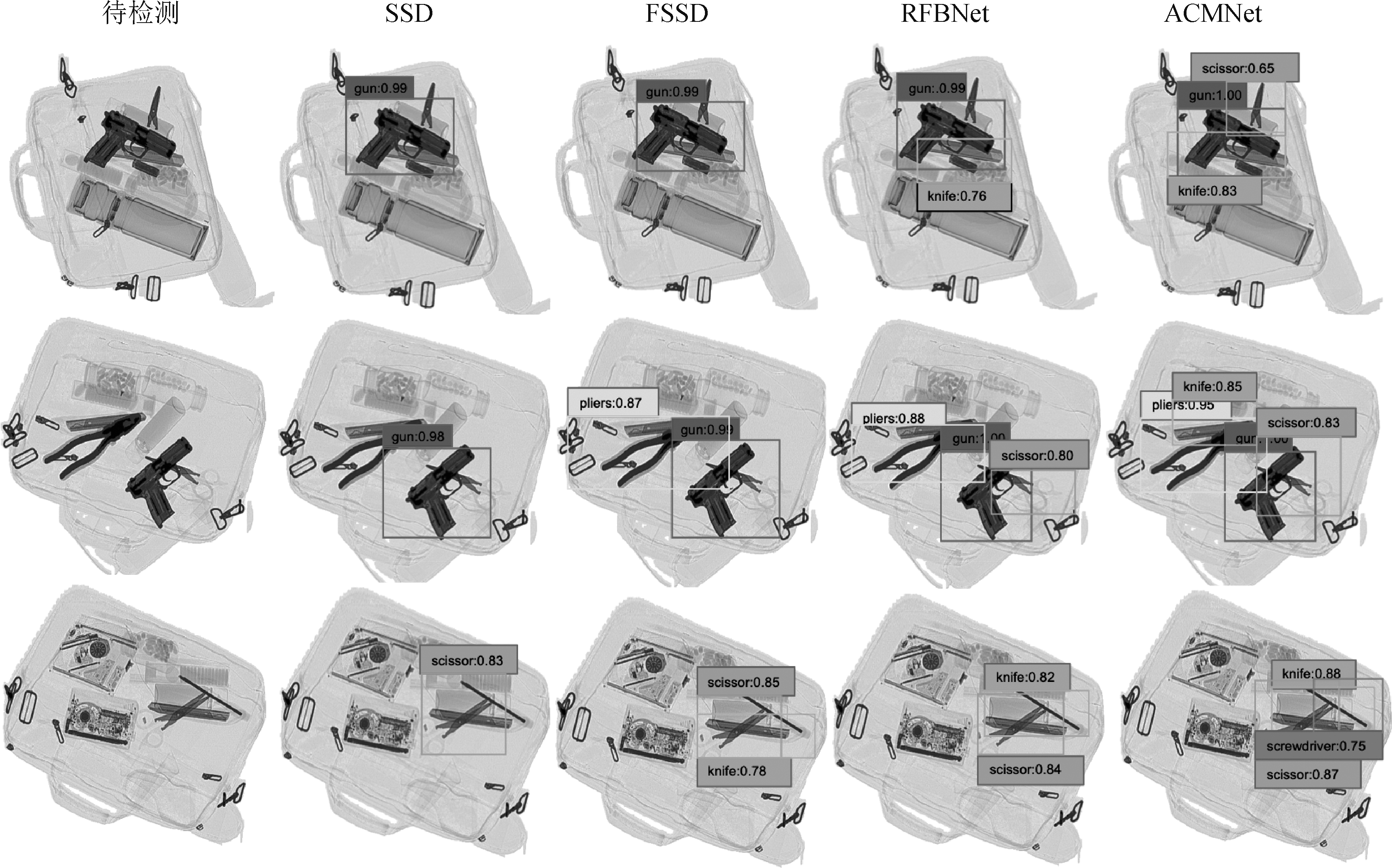

从表1可知,关于数据集A,对照模型FSSD和RFBNet对大尺度目标如充电宝、枪有90%以上的高精度,但对小尺寸目标例如打火机、刀、叉子的检测结果却不尽人意。对于上述小目标,ACMNet较SSD提升了17.4%、9.5%、10%,较FSSD提升了2.4%、3.1%、7.6%,较RFBNet提升了1.6%、4.4%、5.5%。图8为数据集A不同模型测试结果。可见,SSD和FSSD存在小剪子、水果刀、打火机漏检的情况,RFBNet虽然表现出不错的检出率,但是定位框的尺度仍存在不稳定的表现,而ACMNet则在定位准确的情况下表现出较高检出率,证明ACMNet有效解决X光安检图像中多尺度违禁品检测问题。

图8 数据集A不同模型测试结果

Fig.8 Test results of different models on dataset A

表1 各数据集安检违禁品的检测精度

Tab.1 Detection accuracy of prohibited items in each dataset

模型数据集 SSDFSSDRFBNetACMNetAmAP84.3288.8589.1291.33充电宝90.690.890.590.9打火机72.187.187.989.5叉子80.382.784.890.3刀77.483.882.586.9枪97.098.898.999.8剪刀88.589.990.190.6BmAP82.8686.5487.5691.42枪99.999.899.9100.0剪刀85.386.187.588.2钳子90.993.296.599.8螺丝刀58.069.869.579.2刀80.283.884.489.9CmAP63.7879.0074.884.30枪90.390.490.591.5刀60.773.772.980.2扳手50.470.864.983.6钳子65.983.577.385.9剪刀51.676.668.680.3

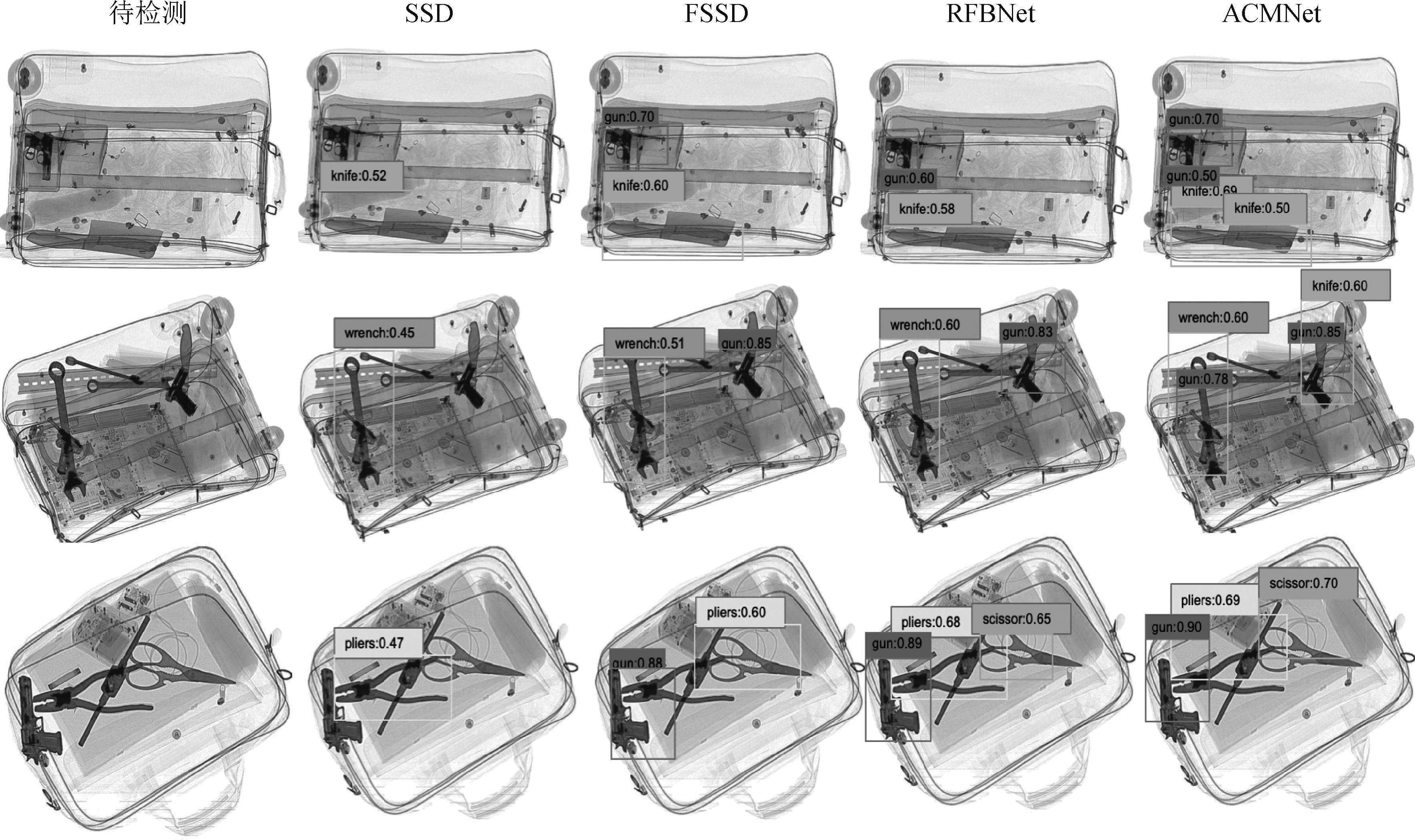

关于数据集B,ACMNet在SSD模型基础上 mAP提升8.56%,较FSSD 和RFBNet 模型分别提高4.88%和3.86%。图9为数据集B不同模型测试结果。由测试结果可知, FSSD和RFBNet对能检测出的违禁品精度并不低,但是在低密度物品被高密度物品遮挡和相近密度物品相互遮挡两种情况下容易产生漏检,改进后的ACMNet却表现出较低的漏检率与误检率,证明ACMNet有效解决X光安检图像中遮挡违禁品检测问题。

图9 数据集B不同模型测试结果

Fig.9 Test results of different models on dataset B

关于数据集C,ACMNet在mAP上获得84.30%的精度,较SSD提升20.52%,较FSSD、RFBNet模型分别提高 5.3%和9.5%,相比于文献[24]中获得的最高mAP值79.56%,有效验证ACMNet对背景干扰下的违禁品检测精度有明显的提升。图10为数据集C不同模型测试结果。SSD在该数据集上检测违禁品的效果稳定性差;FSSD 和RFBNet虽在检出率和检出精度上有一定提升,但仍不满足安检行业的需求;实验结果证明ACMNet已能较好地解决背景干扰情况下的违禁品漏检问题。

图10 数据集C不同模型测试结果

Fig.10 Test results of different models on dataset C

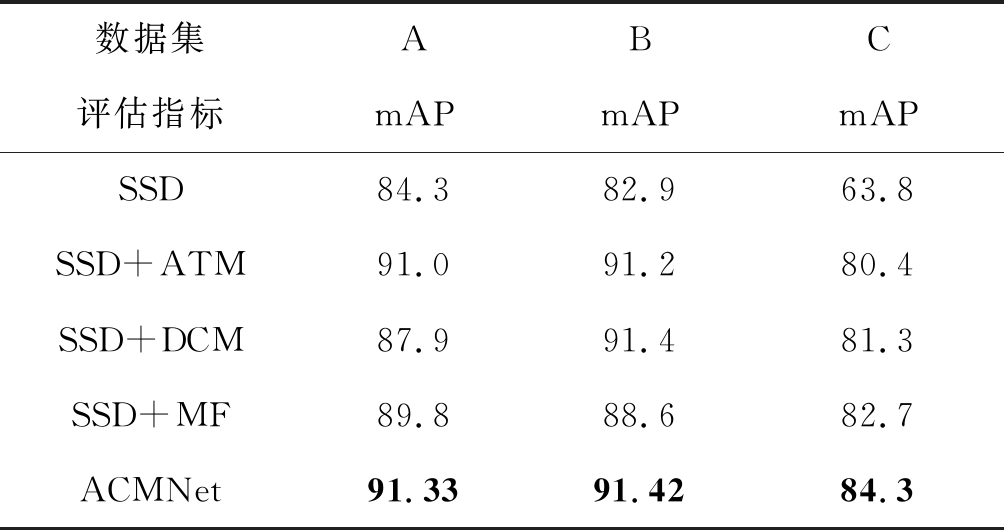

4.3 消融实验

此部分设计以SSD为基础模型的消融实验,能更直观地展示ATM、DCM和MF对ACMNet检测效果的影响。实验参数设置与对比实验一致。消融实验结果如表2所示。

表2 消融实验结果

Tab.2 The results of ablation experiment

数据集ABC评估指标mAPmAPmAPSSD84.382.963.8SSD+ATM91.091.280.4SSD+DCM87.991.481.3SSD+MF89.888.682.7ACMNet91.3391.4284.3

可以看出ATM对数据集A的作用效果更为显著,表明非对称小卷积对小目标检测精确度影响更大;在数据集B下,拥有空洞卷积的ATM和DCM能带来局部与全局视野的兼容性,有助于解决遮挡违禁品检测问题;MF在数据集C下检测精度明显提升,表明特征图间融合得到的强语义特征更能影响背景干扰下的违禁品检出率。在测试时,ACMNet检测单张安检图片仅需0.015 s,满足智能安检的检测需求。

5 结论

本文采用SSD模型作为基本框架,在此基础上添加了ATM、DCM和MF模块,形成非对称卷积多视野检测神经网路ACMNet,有效解决X光安检图像对含有背景干扰/随机遮挡的多尺度违禁品检测问题。灵活的非对称小卷积核加上空洞卷积带来的多视野角度,学习小尺度违禁品的细节特征,在多尺度违禁品数据集A上取得了91.33%的检测精度; 在全局与局部之间建立联系,在遮挡违禁品数据集B上取得了91.42%的检测精度;在底层特征之间进行多尺度特征图融合,在背景干扰较大的数据集C上取得了84.3%的检测精度,较改进前的SSD算法提升了20.5%。ACMNet在SSD的基础上大幅提升了检测精度,在X光图像多尺度违禁品检测上表现出不错的鲁棒性。

[1]Mery D, Svec E, Arias M, et al. Modern Computer Vision Techniques for X-Ray Testing in Baggage Inspection[J]. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2017, 47(4): 682- 692.

[2]侯彦伊. 机场安检人员工作压力与安全绩效关系研究[D]. 北京: 北京交通大学, 2018.

Hou Yanyi. Research on the Relationship between WorkStress and Safety Performance of Airport Security Inspectors[D]. Beijing: Beijing Jiaotong University, 2018.(in Chinese)

[3]Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector[C]∥European Conference on Computer Vision. Springer, Cham, 2016: 21-37.

[4]夏颖瑛. 安检联网系统设计与安检图像压缩技术研究[D]. 南京: 东南大学, 2015.

Xia Yingying. Design of Networking System of Security Check Equipment and Research on Image Compression Technology[D]. Nanjing: Southeast University, 2015.(in Chinese)

[5]Govardhan P, Pati U C. NIR image based pedestrian detection in night vision with cascade classification and validation[C]∥2014 IEEE International Conference on Advanced Communications, Control and Computing Technologies. IEEE, 2014: 1435-1438.

[6]Domingo Mery. Automated detection in complex objects using a tracking algorithm in multiple X-ray views[C]∥CVPR 2011 WORKSHOPS. IEEE, 2011: 41- 48.

[7]Cover T, Hart P. Nearest neighbor pattern classification[J]. IEEE Transactions on Information Theory, 1967, 13(1): 21-27.

[8]Domingo Mery, German Mondragon, Vladimir Riffo, et al. Detection of regular objects in baggage using multiple X-ray views[J]. Insight-Non-Destructive Testing and Condition Monitoring, 2013, 55(1): 16-20.

[9]Bastan M, Byeon W, Breuel T M. Object recognition in multi-view dual energy x-ray images[C]∥BMVC, 2013, 1(2): 11.

[10]Hearst M A, Dumais S T, Osuna E, et al. Support vector machines[J]. IEEE Intelligent Systems and Their Applications, 1998, 13(4): 18-28.

[11]Muhammet Ba, stan, Mohammad Reza Yousefifi, and Thomas M. Visual words on baggage X-ray images[C]∥International Conference on Computer Analysis of Images and Patterns. Springer, Berlin, Heidelberg, 2011: 360-368.

[12]苏冰山, 陈继光, 陈雨. 基于联合特征的X光图像违禁品分类方法[J]. 数字技术与应用, 2019(5): 76-77.

Su Bingshan, Chen Jiguang, Chen Yu. X-ray Image Contraband Classification Method Based on Joint Feature[J]. Digital Technology & Application, 2019(5): 76-77.(in Chinese)

[13]Krizhevsky A, Sutskever I, Hinton G E. Imagenet classification with deep convolutional neural networks[C]∥Advances in Neural Information Processing Systems, 2012: 1097-1105.

[14]Yu F, Koltun V. Multi-scale context aggregation by dilated convolutions[J]. arXiv preprint arXiv: 1511.07122, 2015.

[15]Lin T Y, Doll r P, Girshick R, et al. Feature pyramid networks for object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 2117-2125.

r P, Girshick R, et al. Feature pyramid networks for object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 2117-2125.

[16]Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 1-9.

[17]Szegedy C, Ioffe S, Vanhoucke V, et al. Inception-v4, inception-resnet and the impact of residual connections on learning[C]∥Thirty-first AAAI Conference on Artificial Intelligence, 2017.

[18]Ren S, He K, Girshick R, et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 39(6): 1137-1149.

[19]Redmon J, Farhadi A. Yolov3: An incremental improvement[J]. arXiv preprint arXiv: 1804.02767, 2018.

[20]Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[J]. arXiv preprint arXiv: 1409.1556, 2014.

[21]Li Z, Zhou F. FSSD: feature fusion single shot multibox detector[J]. arXiv preprint arXiv: 1712.00960, 2017.

[22]Akçay S, Kundegorski M E, Devereux M, et al. Transfer learning using convolutional neural networks for object classification within x-ray baggage security imagery[C]∥2016 IEEE International Conference on Image Processing (ICIP). IEEE, 2016: 1057-1061.

[23]Yang Jinfeng, Zhao Zihao, Zhang Haigang, et al. Data augmentation for X-ray prohibited item images using generative adversarial networks[J]. IEEE Access, 2019, 7: 28894-28902.

[24]Miao C, Xie L, Wan F, et al. SIXray: A large-scale security inspection x-ray benchmark for prohibited item discovery in overlapping images[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 2119-2128.

[25]Liu J, Leng X, Liu Y. Deep Convolutional Neural Network Based Object Detector for X-Ray Baggage Security Imagery[C]∥2019 IEEE 31st International Conference on Tools with Artificial Intelligence (ICTAI). IEEE, 2019: 1757-1761.

[26]Hassan T, Khan S H, Akcay S, et al. Deep CMST Framework for the Autonomous Recognition of Heavily Occluded and Cluttered Baggage Items from Multivendor Security Radiographs[J]. arXiv preprint arXiv: 1912.04251, 2019.

[27]Xu M, Zhang H, Yang J. Prohibited item detection in airport X-Ray security images via attention mechanism based CNN[C]∥Chinese Conference on Pattern Recognition and Computer Vision (PRCV). Springer, Cham, 2018: 429- 439.

[28]Steitz J M O, Saeedan F, Roth S. Multi-view X-Ray R-CNN[C]∥German Conference on Pattern Recognition. Springer, Cham, 2018: 153-168.

[29]Bhowmik N, Gaus Y F A, Akcay S, et al. On the Impact of Object and Sub-component Level Segmentation Strategies for Supervised Anomaly Detection within X-ray Security Imagery[J]. arXiv preprint arXiv: 1911.08216, 2019.

[30]He Kaiming, Gkioxari Georgia,Dollar Piotr, et al. Mask r-cnn[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 2961-2969.

[31]An Jiuyuan, Zhang Haigang, Zhu Yue, et al. Semantic Segmentation for Prohibited Items in Baggage Inspection[C]∥International Conference on Intelligent Science and Big Data Engineering. Springer, Cham, 2019: 495-505.

[32]Liu Jinyi,Leng Jiaxu, Liu Ying. Deep Convolutional Neural Network Based Object Detector for X-Ray Baggage Security Imagery[C]∥2019 IEEE 31st International Conference on Tools with Artificial Intelligence (ICTAI). IEEE, 2019: 1757-1761.

[33]Akcay Samet, Atapour-Abarghouei Amir, Breckon Toby P. Ganomaly: Semi-supervised anomaly detection via adversarial training[C]∥Asian Conference on Computer Vision. Springer, Cham, 2018: 622- 637.

[34]Liu S, Huang D. Receptive field block net for accurate and fast object detection[C]∥Proceedings of the European Conference on Computer Vision (ECCV), 2018: 385- 400.