1 引言

手势分割的实质就是将手势区域与背景分离。有效可靠的手势分割是手势追踪[1]、手势估计[2]、手势识别[3]等任务的前提与保障。

为了实现手势分割,研究者们相继提出许多有价值的手势分割方法[4-11]。从目前的手势分割研究成果来看,有基于运动信息与肤色特征相结合的手势分割方法[4- 8],该类方法利用手势运动的特点,先通过帧差、光流、背景减除等方法检测出运动区域并排除一部分类肤色区域的干扰,然后采用一个由历史肤色数据构建的肤色模型进一步分割出手势;有基于深度图像的手势分割[9-10],该类方法利用手势距离深度摄像头的距离信息,选择一个合适的深度阈值从深度图像中分割手势;还有基于语义分割模型的手势分割[11],该类方法是将语义分割神经网络模型应用于手势分割任务当中。

基于运动信息与肤色特征相结合的手势分割方法有机结合了手势运动和肤色两个显著特征用于手势分割,如文献[4]提出了一种基于肤色和运动检测技术的单目视觉分割方法,文献[5]提出了一种结合三帧差分和肤色椭圆模型的动态手势分割方法,该类方法能达到较好的分割效果,也是目前手势分割最为主流的方法,但这类方法易受光照变化、背景变化、运动轨迹重合等因素的影响并且对于静态图像因条件不满足无法分割。此外这类方法采用的肤色模型的参数是固定的,对不同人种之间存在的肤色差异不具有很好的适应性,仅对某些肤色取得了较好的手势分割效果。基于深度图像的手势分割方法,如文献[10]提出的一种基于3D传感器的手势分割方法,深度信息提升了手势分割的有效性,但额外增加的距离传感器不仅增加了手势系统的成本还占据了手势系统的一部分空间。随着深度学习的发展,一些学者将语义分割神经网络模型应用于手势分割任务当中,如文献[11]提出了HRG-Net用于手势分割,而该类方法在分割准确率和实时性之间难以达到平衡。

为解决目前手势分割方法存在的局限,本文采用先检测手势再分割手势的思路,提出了一种融合SSD目标检测的自适应手势分割方法,先采用基于改进型SSD的手势检测模型从图像中初步分割出手势ROI,然后以手势ROI中的手势肤色样本构建高斯肤色模型来自适应分割手势。

文章接下来的安排如下:在第2节,设计了一种基于空洞卷积的主干网络和一套Anchor机制将SSD目标检测模型改进为手势检测模型来获取手势ROI。在第3节,先在手势ROI内对手势肤色样进行肤色采样,然后利用肤色样本构建自适应的YCrCb高斯肤色模型,最后利用自适应YCrCb对手势ROI中的手势进行分割。在第4节,对本文提出的相关算法进行了对比实验,并对实验结果进行了分析。在第5节,对本文工作做了总结并展望了该课题的未来研究方向。

2 手势检测

文献[12]提出的SSD目标检测模型具有实时性好,检测准确率高的优秀性能。但将SSD应用到手势检测任务中需要考虑两方面问题:一方面,SSD自身存在的缺陷限制了手势检测准确率;另一方面,将SSD应用到手势检测任务中需结合手势检测任务的特点。

2.1 SSD简介

SSD的基本思想是从一个主干网络中自底向上的获取不同层次语义的特征图作为检测特征图,较低语义层次的检测特征图用于较小目标的检测,较高语义层次的检测特征图用于较大目标的检测。在获得检测特征图之后,SSD先为不同语义层次的特征图设置了相应长宽比和基本尺寸的Anchor作为目标尺寸和位置的先验边界框,然后将检测特征图送入到检测层,在一系列Anchor中检测出含有目标的Anchor,最后通过分类层对这些Anchor内的目标进行识别并通过回归层将这些Anchor调整到目标的真实边界框来达到目标检测的目的,SSD的模型结构如图1所示。

图1 SSD模型结构[12]

Fig.1 Structure of SSD model

2.2 基于空洞卷积的主干网络设计

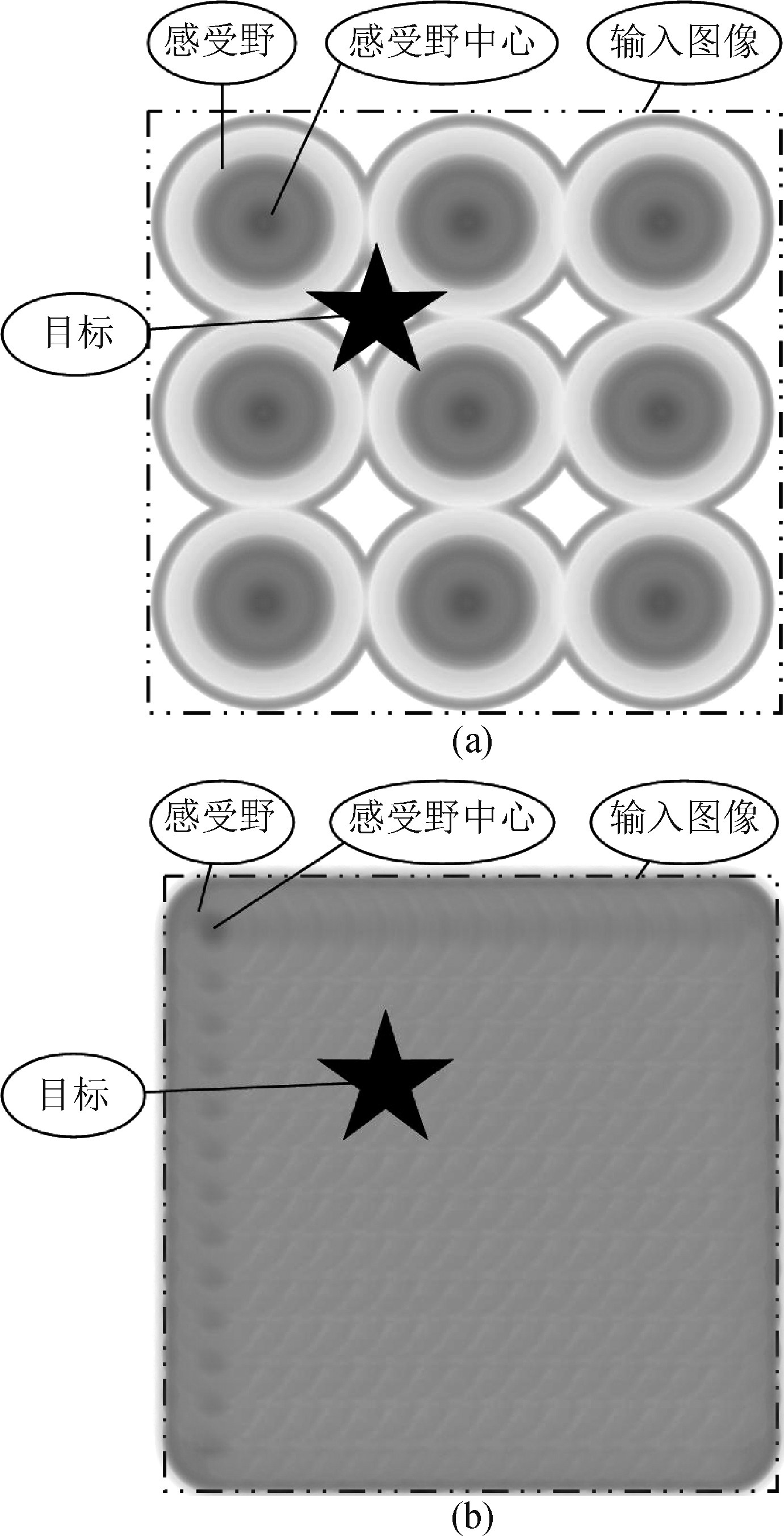

在一个卷积神经网络(Convolutional neural network,CNN)中,特征图的每个特征元素有一个感受野,感受野是特征元素映射到输入图像的区域。由于CNN中卷积的堆叠,感受野中的像素对特征元素的贡献并不相同,呈现一种二维高斯分布:越是靠近感受野中心的像素对特征元素的贡献越大[13]。

SSD第4,5,6张检测特征图的感受野数量分别为![]() 5、

5、![]() 3、

3、![]() 1,这意味着SSD的后边几张检测特征图的感受野数量太少。当一个检测特征图感受野数量太少时,输入图像中存在许多偏离感受野中心的区域,当目标处于这些区域时,特征元素从目标获取的特征质量就得不到保障,从而限制了目标检测的准确率(如图2(a)所示)。通过增加检测特征图感受野的数量,可以有效减少输入图像中偏离感受野的区域,使得特征元素从目标获取的特征质量得到保障(如图2(b)所示)。

1,这意味着SSD的后边几张检测特征图的感受野数量太少。当一个检测特征图感受野数量太少时,输入图像中存在许多偏离感受野中心的区域,当目标处于这些区域时,特征元素从目标获取的特征质量就得不到保障,从而限制了目标检测的准确率(如图2(a)所示)。通过增加检测特征图感受野的数量,可以有效减少输入图像中偏离感受野的区域,使得特征元素从目标获取的特征质量得到保障(如图2(b)所示)。

图2 感受野在输入图像上的分布

Fig.2 Distribution of receptive field on the input image

设计主干网络时,为了使各层卷积能够学习到更加复杂的特征,卷积核的等价尺寸S相对前层特征图的感受野尺寸Srf不能过小,一般应该满足下式:

(1)

S=Sc·step

(2)

step表示特征图的下采样倍数,Sc表示当前卷积核大小。

一般的主干网络是通过池化层增加step来满足公式(1)。池化操作会使后层特征图的尺寸减小,并且会丢失一部分对后层检测特征图有用的信息。

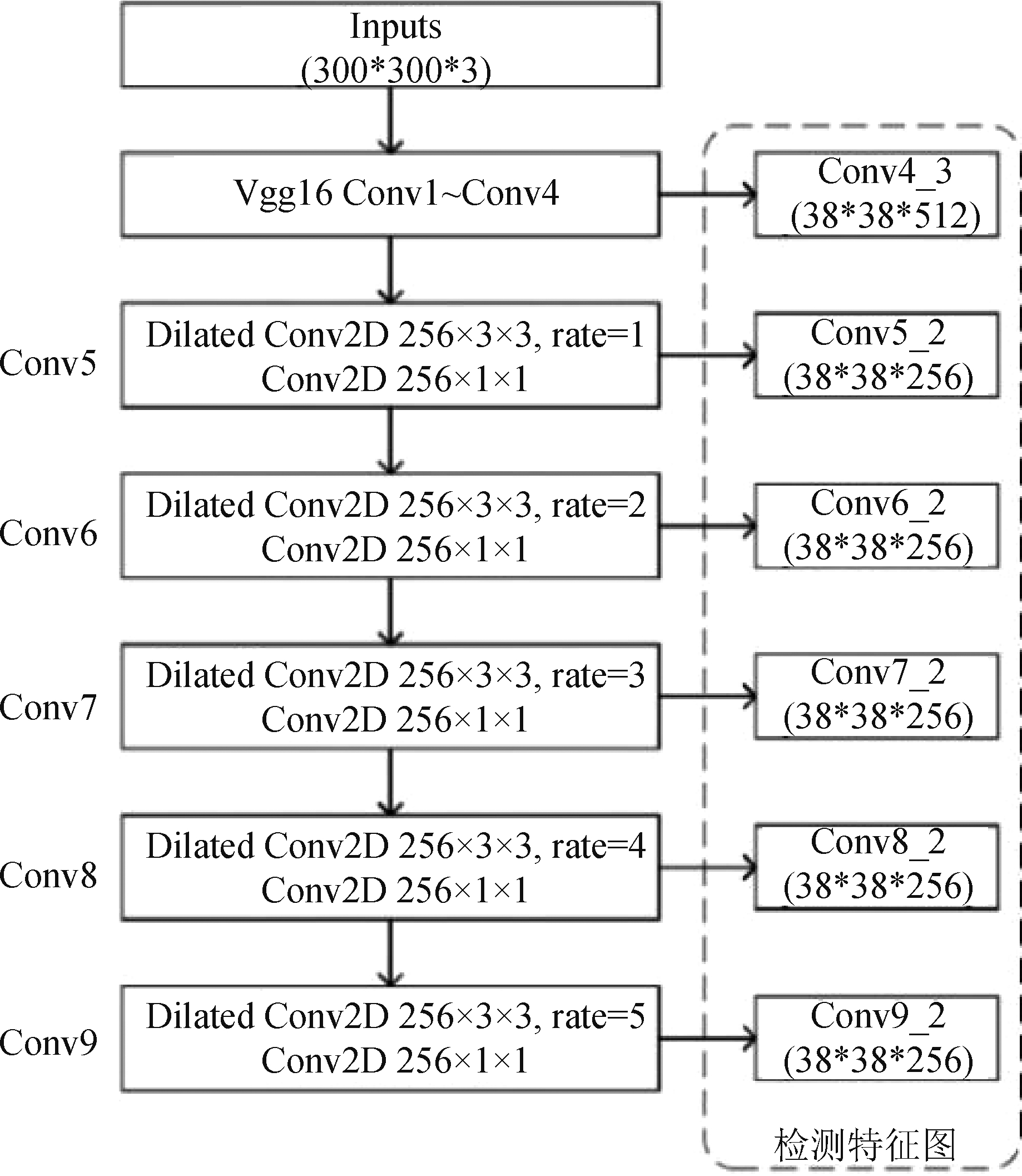

本文采用了空洞卷积来设计主干网络,采用空洞卷积可以通过增大Sc来满足公式(1),同时采用空洞卷积可以保持特征图的分辨率,进而保证了特征图中感受野的数量。在空洞卷积中:

Sc=k(r-1)+1

(3)

k表示空洞卷积的卷积核大小,r表示空洞卷积的空洞率。

图3为本文的基于空洞卷积的主干网络结构示意图,本文保留了VGG16的Conv1~Conv4结构,并在Conv4后边增加了5个空洞卷积结构Conv5~Conv9。每个空洞卷积结构由一个![]() 3的空洞卷积层和一个

3的空洞卷积层和一个![]() 1的普通卷积层构成,每层的卷积核个数均为256个。Conv5~Conv9中空洞卷积的空洞率逐渐增加,分别为1,2,3,4,5。通过空洞卷积代替了卷积-池化结构,使得Conv5~Conv9中的特征图分辨率始终保持在3

1的普通卷积层构成,每层的卷积核个数均为256个。Conv5~Conv9中空洞卷积的空洞率逐渐增加,分别为1,2,3,4,5。通过空洞卷积代替了卷积-池化结构,使得Conv5~Conv9中的特征图分辨率始终保持在3![]() 38大小,从而保证了特征图感受野的数量。每个空洞卷积后的

38大小,从而保证了特征图感受野的数量。每个空洞卷积后的![]() 1的普通卷积用于促进空洞卷积输出特征图通道之间的信息充分融合。

1的普通卷积用于促进空洞卷积输出特征图通道之间的信息充分融合。

图3 基于空洞卷积的主干网络结构

Fig.3 Backbone network based on dilated convolution

将本文主干网络的Conv4_3、Conv5_2、Conv6_2、Conv7_2、Conv8_2、Conv9_2层作为6张检测特征图用于检测层的手势检测。本文检测特征图与SSD检测特征图的感受野数量对比如表1所示。由表1可知,本文的主干网络获得的检测特征图相比SSD具有更多的感受野数量。由于本文主干网络的各检测特征图的感受野数量得到保证,手势目标则有很大的概率处于感受野中心位置,检测特征图则易获取到高质量的手势特征,从而提高手势检测准确率。

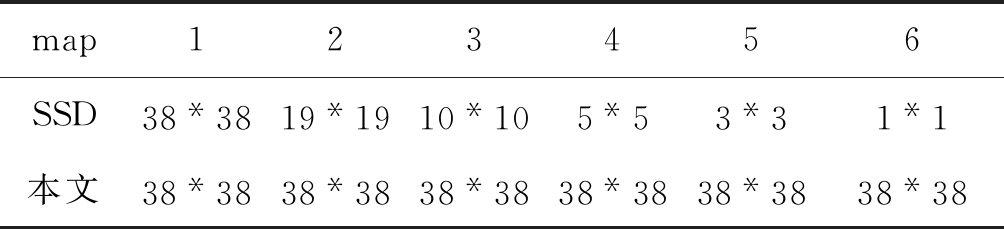

表1 感受野数量对比

Tab.1 Comparison of receptive field number

map123456SSD38*3819*1910*105*53*31*1本文38*3838*3838*3838*3838*3838*38

2.3 Anchor设置方案

SSD是一种多目标检测模型,待检测目标尺寸的长宽比分布比较广泛,而手势目标的长宽比分布相对集中。考虑到手势目标的长宽比主要分布在[0.5,2]之间,本文去掉与手势目标匹配度不高的长宽比,在设置Anchor时,将SSD的5种长宽比ar={1/3,1/2,1,2,3}缩减为3种长宽比ar={1/2,1,2}。

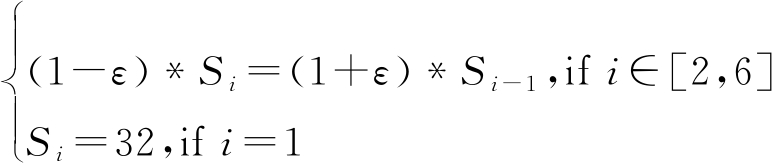

此外,为使Anchor的基本尺寸与本文的检测特征图相适应,按照以下3条原则来设置Anchor的基本尺寸:

1)Anchor的基本尺寸应该略小于检测特征图的有效感受野[13],以便检测特征图的特征元素能准确获取目标特征。

2)每个Anchor回归到手势目标真实尺寸时的跨度不超过自身尺寸的±25%,以便回归层的回归压力均衡的分散到各个检测特征图上。

3)上层检测特征图Anchor的回归上界应略高于下层检测特征图Anchor的回归下界,以保证两层特征图之间回归框尺寸的连续性。

因此,按照下式来设置各检测特征图Anchor 的基本尺寸Si:

(4)

±ε表示Anchor的回归跨度,这里取ε=20%。

当ar=1时,w=h=Si;

当ar=1/2时,w=0.5*Si,h=Si;

当ar=2时,w=Si,h=0.5*Si。

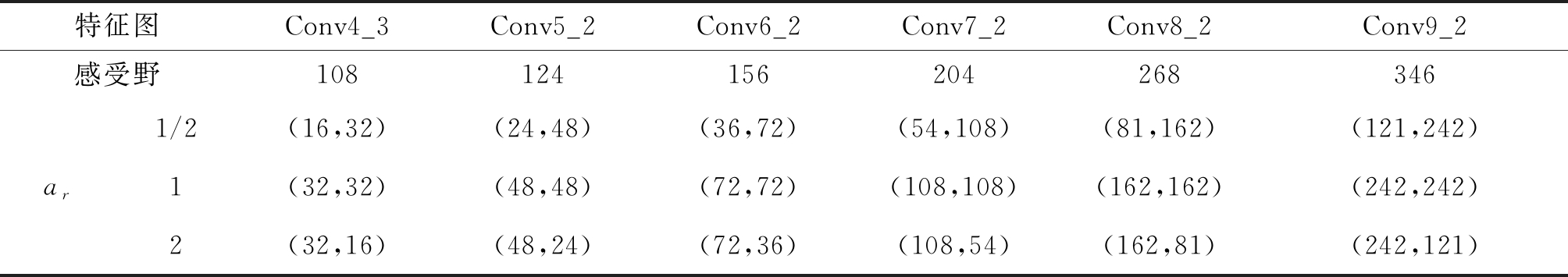

各个检测特征图Anchor的设置方案如表2所示。

2.4 基于改进型SSD的手势检测模型

图4展示了本文提出的基于改进型SSD的手势检测模型。待检测手势的图像首先经过本文基于空洞卷积主干网络进行特征提取。接着将Conv4_3、Conv5_2、Conv6_2、Conv7_2、Conv8_2、Conv9_2层的特征图作为检测特征图并按表2所示的 Anchor设置方案为每个检测特征图设置了相应的Anchor。然后将6张检测特征图送入到检测层进行手势检测。检测层的结构与SSD的检测层结构一致,检测层包括分类层和回归层,分类层利用检测特征图的特征将各个Anchor分类为手势或背景。回归层将被分类为手势的Anchor回归到手势目标的真实边界框。一个手势目标通常会被预测出多个边界框,通过极大值抑制层保留置信度最高的手势边界框,去除重叠的且置信度低的手势边界框。

表2 各层特征图的Anchor设置方案

Tab.2 Anchor set plan on each layer feature map

特征图Conv4_3Conv5_2Conv6_2Conv7_2Conv8_2Conv9_2感受野108124156204268346ar1/2(16,32)(24,48)(36,72)(54,108)(81,162)(121,242)1(32,32)(48,48)(72,72)(108,108)(162,162)(242,242)2(32,16)(48,24)(72,36)(108,54)(162,81)(242,121)

图4 基于改进型SSD的手势检测模型结构

Fig.4 Gesture detection model structure based on the improved SSD

3 自适应手势分割

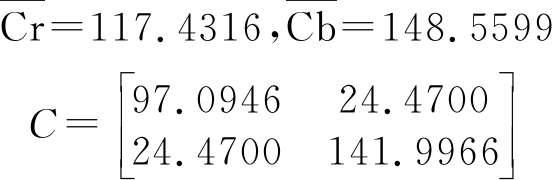

通过本文基于改进型SSD的手势检测模型可以获得手势ROI,如图5所示。由于不同人的手势肤色之间存在着差异,传统的YCrCb高斯、YCrCb椭圆等肤色模型的参数固定,无法对不同肤色的手势均获得好的分割效果。因此本文先从当前的手势ROI中采集手势肤色样本,然后通过手势肤色样本构建YCrCb高斯肤色模型,最后通过该YCrCb高斯肤色模型对手势ROI中的手势进行自适应分割。

图5 手势ROI获取过程

Fig.5 Diagram of get gesture ROI

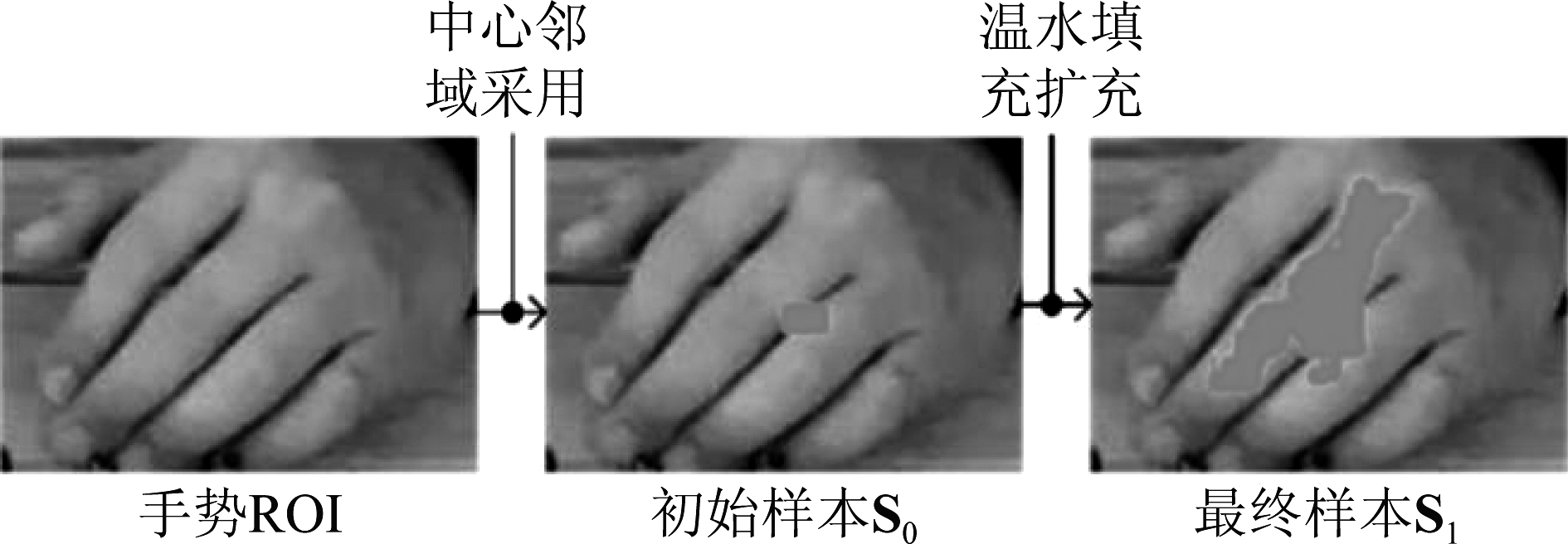

3.1 YCrCb高斯肤色模型介绍

YCrCb高斯肤色模型的原理是在YCrCb颜色空间下,忽略亮度Y的影响,首先以色度值Cr、Cb为样本特征建立一个高斯混合模型,然后以历史肤色作为样本集对这个高斯混合模型进行训练得到YCrCb高斯肤色模型:

(5)

(6)

其中![]() 分别为样本集Cr、Cb的均值。C为样本集的协方差矩阵,通常

分别为样本集Cr、Cb的均值。C为样本集的协方差矩阵,通常![]() 的取值如下:

的取值如下:

P(Cr,Cb)反映一个像素是肤色的概率,通常在进行肤色分割时会设置一个阈值T,当P(Cr,Cb)>T时,则判定该像素属于肤色区域,否则判定该像素不属于肤色区域。

3.2 肤色样本采样

图6为手势肤色采样过程,假设手势ROI的中心坐标为(xc,yc),宽与高分别为w,h,首先在手势ROI的中心邻域内采集初始肤色样本集S0:

图6 肤色样本采集过程

Fig.6 Diagram of collect skin color sample

![]()

(7)

O={(x,y)||x-xc|<0.1*h,|x-yc|<0.1*w}

(8)

![]() 表示手势ROI中(x0,y0)处像素的色度值(Cr,Cb),O表示手势ROI的中心邻域。

表示手势ROI中(x0,y0)处像素的色度值(Cr,Cb),O表示手势ROI的中心邻域。

然后通过普通的高斯肤色模型去除S0内的非肤色样本:

S0={(Cr,Cb)|P(Cr,Cb)>0.2,(Cr,Cb)∈S0}

(9)

P(Cr,Cb)表示由公式(5)描述的普通高斯肤色模型的。

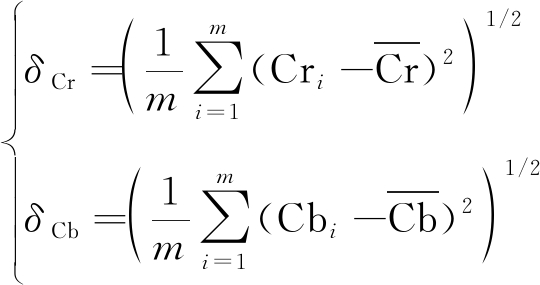

最后以S0内的肤色样本所处位置为种子点,通过在手势ROI内进行漫水填充来获得一个更大的肤色样本集S1,漫水填充的上下阈值分别为:

(10)

δCr,δCb分别表示S0中Cr与Cb的标准差,假设S0中有m个样本,则:

S0=[(Cr1,Cb1),…,(Crm,Cbm)]

(11)

(12)

(13)

3.3 建立自适应YCrCb高斯肤色模型

通过肤色采样获得了肤色样本集S1,通过肤色样本集S1可按照下式建立YCrCb高斯肤色模型:

(14)

(15)

![]() 分别表示样本集S1中Cr,Cb的均值,C表示肤色样本集S1的协方差矩阵,假设S1中有n个样本

分别表示样本集S1中Cr,Cb的均值,C表示肤色样本集S1的协方差矩阵,假设S1中有n个样本

S1=[(Cr1,Cr1),…,(Crn,Crn)]

(16)

(17)

(18)

(19)

(20)

(21)

3.4 手势分割

图7为手势分割过程,将手势ROI的像素色度值(Cr,Cb)带入到公式(14)描述的自适应YCrCb高斯肤色模型中就能判断该像素属于手势肤色区域的概率。因此将YCrCb颜色空间下的手势ROI各像素色度值(Cr,Cb)带入公式(14)可获得手势ROI的手势肤色概率图:

图7 手势分割过程

Fig.7 Diagram of segment gesture

![]()

(22)

![]() 表示YCrCb颜色空间下的手势ROI在(x,y)处的色度值;Proroi(x,y)表示手势ROI在(x,y)处的肤色概率值。

表示YCrCb颜色空间下的手势ROI在(x,y)处的色度值;Proroi(x,y)表示手势ROI在(x,y)处的肤色概率值。

最后采用最大类间方差阈值法从手势肤色概率图分割出手势区域:

(23)

TOtsu表示通过最大类间方差法获得的阈值。

4 实验结果与分析

在Ego Hands[14], Oxford Hand[15], VIVA Hand[16]数据集下,分别进行了手势检测与手势分割实验。软件测试环境为Pycharm2019.1.4版本,编程语言为Python3.5,深度学习框架为tensorflow,硬件测试环境为Intel(R) Core i5-2450 CPU @3.30GHz,8GB内存,Nvidia GeForce GTX 1080 Ti GPU。

4.1 手势检测模型实验与分析

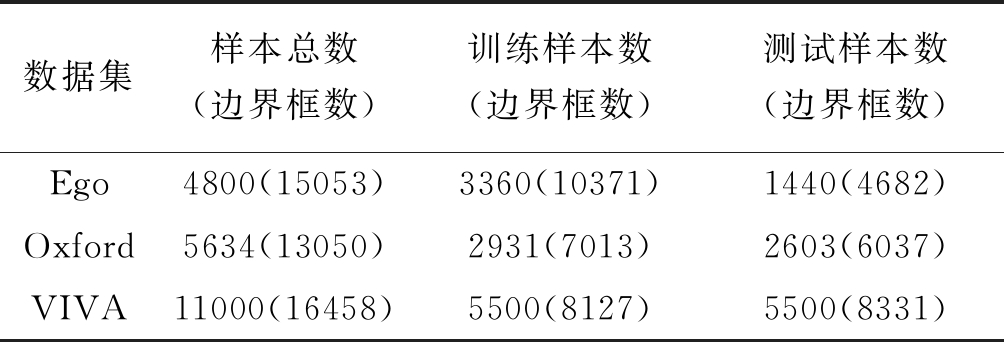

为了评估本文手势检测模型的性能,本文将Ego、Oxford、VIVA手势检测数据集按表3所示的分配方案划分为训练集与测试集对模型进行训练和测试。

表3 数据集划分方案

Tab.3 Scheme to allocate data set

数据集样本总数(边界框数)训练样本数(边界框数)测试样本数(边界框数)Ego4800(15053)3360(10371)1440(4682)Oxford5634(13050)2931(7013)2603(6037)VIVA11000(16458)5500(8127)5500(8331)

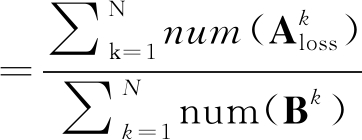

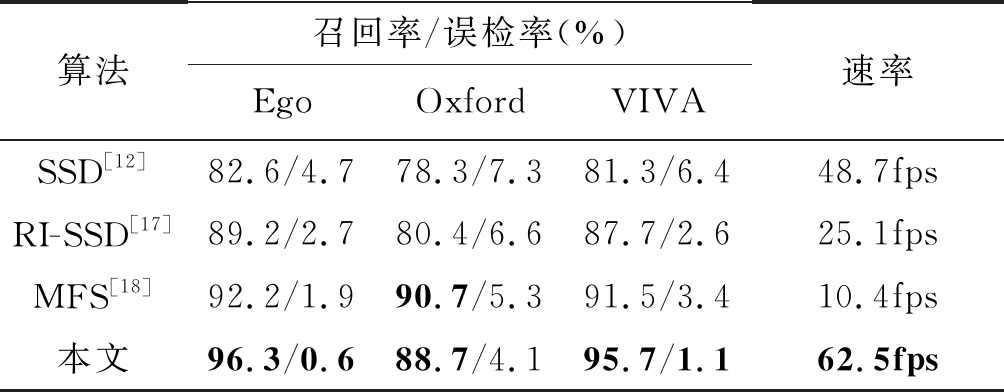

在三个数据集下,本文以召回率,误检率,运行时间作为评估标准对本文的手势检测模型进行了测试并与SSD以及另外两种手势检测算法RI-SSD[17]、MFS[18]模型进行了对比。

在测试时,对于第k幅测试图像,模型给出的边界框集合记为![]() 为模型给出的边界框数,测试图像的标准框集合记为

为模型给出的边界框数,测试图像的标准框集合记为![]() 为测试图像的标准框数。对于

为测试图像的标准框数。对于![]() 若Bk中存在

若Bk中存在![]() 使

使![]() 与

与![]() 的IOU>0.6则判定

的IOU>0.6则判定![]() 为正确检测,存入集合

为正确检测,存入集合![]() 并从Bk中去除

并从Bk中去除![]() 若不存在,判定Ai为误检。最后将Bk中剩下的标准框判定为漏检,记录为

若不存在,判定Ai为误检。最后将Bk中剩下的标准框判定为漏检,记录为![]() 则:

则:

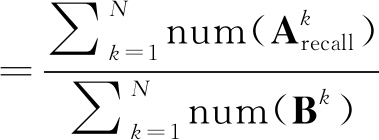

召回率

(24)

误检率

(25)

速率![]()

(26)

其中N表示测试集的样本数量,num(·)用于计算集合中的元素个数。模型测试结果如表4。

表4 模型测试结果

Tab.4 Results of model tests

算法召回率/误检率(%)EgoOxfordVIVA速率SSD[12]82.6/4.778.3/7.381.3/6.448.7fpsRI-SSD[17]89.2/2.780.4/6.687.7/2.625.1fpsMFS[18]92.2/1.990.7/5.391.5/3.410.4fps本文96.3/0.688.7/4.195.7/1.162.5fps

三个数据集下的实验结果表明,本文的手势检测模型相比其他方法检测效率更高。这得益于本文采用了基于空洞卷积的主干网络来保证每个检测特征图感受野的数量,使手势目标处于特征元素的感受野中心附近,检测层获取了高质量的特征,有效降低了误检和漏检概率;本文结合了手势检测任务的特点,所设置Anchor与手势目标匹配更高效,使Anchor回归到目标实际边界框跨度更小;在保证Anchor与有效感受野匹配的同时,约束了Anchor的回归跨度,回归层的压力被各个检测层均匀分摊,使得边界框的回归更加准确;与SSD相比,本文的主干网层数更少,特征图的通道数更少,因此时间复杂度更小,保证了模型的实时性。

4.2 手势ROI分割实验与分析

分别采用YCrCb椭圆肤色模型,YCrCb高斯肤色模型和本文的自适应YCrCb高斯肤色模型对手势ROI进行了手势分割实验,实验结果如图8所示。

图8 手势ROI内手势分割实验对比

Fig.8 Comparison of segmentation within gesture ROI

实验表明,自适应YCrCb高斯肤色模型相比参数固定的YCrCb高斯肤色模型、YCrCb椭圆肤色模型分割手势ROI的效果更好,不仅将手势完整分割出来,同时还保留了手势的更多细节信息。通过图9所示的三种手势分割模型的概率图对比可以看出,通过ROI内的肤色样本构建的自适应YCrCb高斯模型的概率图相比另外两种肤色模型更符合手势ROI的肤色分布,因此能更准确的从手势ROI中分割出手势。

图9 三种肤色模型的概率图对比

Fig.9 Comparison of probability graphs of three models

为验证自适应YCrCb高斯肤色模型对不同肤色手势的适应性,本文用各模型对白种人、黄种人、黑种人的手势进行了分割实验,实验结果由表5展示。

由表5的实验结果可以发现:YCrCb高斯肤色模型、YCrCb椭圆肤色模型仅对白种人的手势取得了较好的分割结果,而对于黄种人及黑种人的手势分割结果则较差。而本文的自适应YCrCb高斯肤色模型对白种人、黄种人及黑种人三种不同肤色手势都取得了非常好的分割结果。手势分割结果是由手势肤色概率图阈值化处理得到的,因此肤色概率图能更直接地反映出肤色模型的好坏。由于YCrCb高斯肤色模型、YCrCb椭圆肤色模型的参数是固定的,它们只能容纳有限的肤色范围。从它们的手势肤色概率图可以看出,对于三种不同的手势肤色,虽然都能区分出手势区域,但对每种手势肤色都区分的不够明显。而本文的自适应YCrCb高斯肤色模型的参数由手势ROI内的手势肤色样本计算得到,随手势ROI内手势肤色的变化,肤色模型的参数也随之变化,对于不同肤色的手势,肤色概率图均能明显的区分出手势区域,从而获得了更准确的肤色概率图,因此对不同肤色均有较好的适应性。

表5 各肤色模型对不同肤色手势的分割结果

Tab.5 Segmentation results of different skin color gestures by different skin color models

手势ROI 结果模型 白种人肤色概率图分割结果黄种人肤色概率图分割结果黑种人肤色概率图分割结果YCrCb椭圆肤色模型YCrCb高斯肤色模型 本文

4.3 本文手势分割算法实验与分析

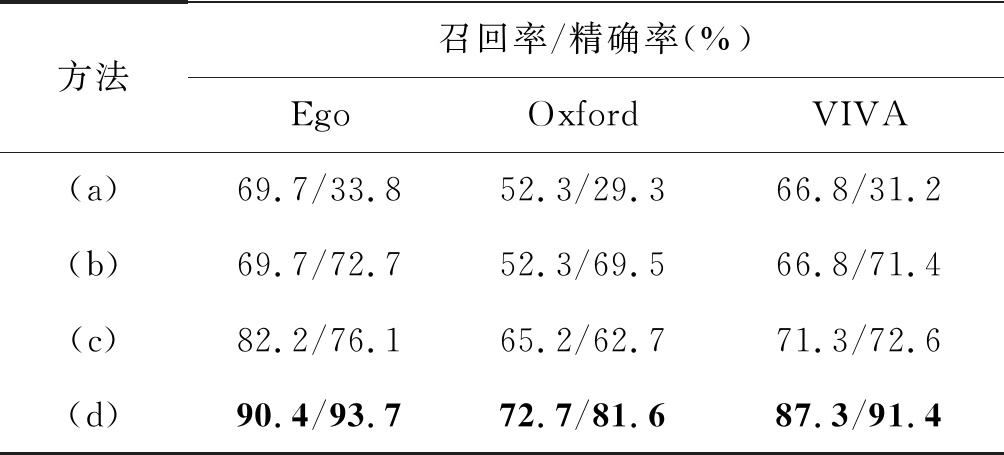

为验证本文手势分割方法的性能,将本文算法在Ego、Oxford、VIVA三个数据集下进行了手势分割实验。为客观评价本文算法性能,以召回率及精确率作为指标来评价本文算法的手势分割效果,形成了(a)、(b)、(c)、(d)4组对比实验结果。(a)为直接采用YCrCb椭圆肤色模型进行分割手势;(b)为先采用本文基于改进型SSD手势检测模型获得手势ROI,再通过YCrCb椭圆肤色模型对手势ROI中的手势进行分割;(c)为基于语义分割网络的手势分割方法HGR-Net[11];(d)为本文手势分割方法,即先采用本文基于改进型SSD手势检测模型获得手势ROI,再通过本文自适应YCrCb高斯肤色模型对手势ROI中的手势进行分割,实验对比结果如表6所示。为更直观展现本文手势分割效果,在三个数据集下各选取一幅手势分割结果,由图10展示。

由表6的实验结果,对比方法(a)、(b)可知由于采用的先检测手势,再分割手势的策略,手势分割的精确率有了明显的提升;对比方法(b)、(d)可知,由于采用了本文的自适应YCrCb高斯肤色模型从手势ROI中分割手势,手势分割的召回率有了明显的提升;对比方法(c)、(d)可知,本文手势分割在三个数据集下的分割结果在召回率与精确率两个评价指标上均优于HRG-Net方法。由图10(a)可知,当背景中存在类手势肤色区域时,YCrCb椭圆肤色模型会误分割出大量的非手势区域,并且从图10(b)的分割结果可以看到YCrCb椭圆肤色模型并不能分割出完整的手势区域;由图10(c)可知,HGR-Net模型虽能比较准确的分割手势,但还是受到了人脸影响,分割出一些非手势区域;由图10(d)可知,本文方法先采用手势检测获得了手势ROI以避免环境干扰,然后在手势ROI中构建自适应YCrCb高斯肤色模型以增强模型对手势肤色的容纳性,最终达到更好的分割准确率。

图10 分割结果对比

Fig.10 Comparison of segmentation results

表6 基于评价指标的算法对比

Tab.6 Algorithm comparison based on evaluation indicators

方法召回率/精确率(%)EgoOxfordVIVA(a)69.7/33.852.3/29.366.8/31.2(b)69.7/72.752.3/69.566.8/71.4(c)82.2/76.165.2/62.771.3/72.6(d)90.4/93.772.7/81.687.3/91.4

5 结论

本文提出了一种融合SSD目标检测的自适应手势分割方法,该方法先通过一个手势检测模型获得手势ROI,再从手势ROI中自适应的分割手势。针对手势检测,本文设计了一种基于空洞卷积的主干网络和一套Anchor设置方案将SSD改进为一种手势检测模型,该模型在Ego Hands 数据集上达到96.3%的召回率和0.6%的误检率。针对手势分割,本文首先在当前手势ROI中进行手势肤色采样构建一个肤色样本集,然后通过肤色样本集训练一个YCrCb高斯肤色模型对手势ROI进行分割,达到自适应手势分割的目的。本文提出的手势分割方法的优势在于:通过手势ROI避免了人脸、手臂、近肤色物体等因素对手势分割的影响;通过在手势ROI中采集手势肤色样本建立自适应的YCrCb高斯肤色模型,对各种肤色的手势具有适应性,并且能够达到非常好的分割效果。在今后的研究过程中,还需要对手势检测模型进行轻量化设计,在保证手势检测准确率的同时,减少模型的时间复杂度,使其应用到无GPU的设备当中。此外在手势ROI的分割过程中,本文通过Otsu法对手势肤色概率图进行阈值分割来得到手势分割结果,这会丢失一部分手势细节,将来还需要探索更加有效的手势肤色概率图分割方式。

[1]Yao H, Yuan M, Qin C, et al. Gesture tracking using improved linear extrapolation predictor[J]. Journal of Applied Sciences, 2017, 35(1): 81- 89.

[2]Ge L, Liang H, Yuan J, et al. Robust 3D Hand Pose Estimation from Single Depth Images using Multi-View CNNs[J]. IEEE Transactions on Image Processing, 2018, 27(9): 4422- 4436.

[3]Li J, Huai H, Gao J, et al. Spatial-temporal dynamic hand gesture recognition via hybrid deep learning model [J]. Journal on Multimodal User Interfaces, 2019, 13(4): 363-371.

[4]曹昕燕, 赵继印, 李敏. 基于肤色和运动检测技术的单目视觉手势分割[J]. 湖南大学学报(自然科学版), 2011, 38(1): 78- 83.

Cao Xinyan, Zhao Jiyin, Li Min. Monocular visual gesture segmentation based on skin color and motion detection technology[J]. Journal of Hunan University(Natural Science), 2011, 38(1): 78- 83.(in Chinese)

[5]袁敏, 姚恒, 刘牮. 结合三帧差分和肤色椭圆模型的动态手势分割[J]. 光电工程, 2016, 43(6): 51-56.

Yuan Min, Yao Hen, Liu Jian. Dynamic gesture segme- ntation combining three frame difference and skin color ellipse model [J]. Optoelectronic Component, 2016, 43 (6): 51-56.(in Chinese)

[6]Liao Y, Li G, Sun Y, et al. Static hand gesture segmentation: Comparison and selection of existing methods[C]∥2017 32nd Youth Academic Annual Conference of Chinese Association of Automation (YAC). 2017, 2017: 889- 894.

[7]Liu C, Wang J, Zhang T, et al. Adaptive Threshold Ges- ture Segmentation Algorithm Based on Skin Color[C]∥2nd International Conference on Advances in Mechanical Engineering and Industrial Informatics (AMEII), 2016, 2016: 1619-1622.

[8]Ghotkar A, Kharate K. Hand segmentation techniques to hand gesture recognition for natural human computer interaction[J]. Human Computer Interact, 2012, 1(3): 15-25.

[9]Han J, Shao L, Xu D, et al. Enhanced computer vision with microsoft kinect sensor: A review[J]. IEEE Trans. Cybern, 2013, 43(5): 1318-1334.

[10]Chen D, Li G, Sun Y, et al. Fusion hand gesture segme- ntation and extraction based on CMOS sensor and 3D sensor[J]. International Journal of Wireless and Mobile Computing, 2017, 12(3): 305-312.

[11]Dadashzadeh A, Targhi A T, Tahmasbi M, et al. HGR-Net: A Fusion Network for Hand Gesture Segmentation and Recognition[J]. IET Computer Vision, 2019, 13(8):700-707.

[12]Liu W, Anguelov D, Erhan D, et al. SSD: single shot multibox detector[C]∥European Conference on Computer Vision (ECCV), 2016, 2016: 21-37.

[13]Luo W, Li Y, Urtasun R, et al. Understanding the Effective Receptive Field in Deep Convolutional Neural Net- works[C]∥Advances in Neural Information Processing Systems (NIPS), 2016, 2016: 4898- 4906.

[14]Bambach S, Lee S, Crandall D J, et al. Lending A Hand: Detecting Hands and Recognizing Activities in Complex Egocentric Interactions[C]∥2015 IEEE International Conference on Computer Vision (ICCV), 2015, 2015: 1949-1957.

[15]Mittal A, Zisserman A, Torr P. Hand detection using multiple proposals[J]. British Machine Vision Conferen-ce, 2011, (40)75: 68-75.

[16]Martin S, Ohn-Bar E, Tawari A, et al. The vision for intelligent vehicles and applications Challenge[OL]. http:∥cvrr.ucsd.edu/vivachallenge, 2019.

[17]Feng G, Hong W, Jin G, et al. Dual-Hand Detection for Human-Robot Interaction by a Parallel Network Based on Hand Detection and Body Pose Estimation[J]. Access IEEE, 2019, 66(12): 9663-9672.

[18]Wang Q, Zhang G, Yu S. 2D Hand Detection Using Multi-Feature Skin Model Supervised Cascaded CNN[J]. Journal of Signal Processing Systems, 2018, 91(10): 1105-1113.