1 引言

随着人工智能技术的飞速发展,智能机器人、智能车载、智能电视和音箱等智能语音交互产品逐渐兴起。智能设备中同时存在扬声器和麦克风,扬声器播放的信号经过房间反射后被麦克风采集,从而产生回声。进而智能设备的使用者所发出的语音控制指令往往淹没在其回声中,严重影响了识别结果。

传统的声学回声消除(Acoustic Echo Cancellation,AEC)是通过自适应滤波算法[1-4]估计出扬声器和麦克风之间的声学冲激响应(Acoustic Impulse Response,AIR),进而实现回声消除。然而,在目标语音信号和回声信号同时存在(即双语时)、背景噪声(尤其是非平稳噪声)和非线性失真的情况下,这些算法的回声消除性能降低。

文献[5]通过使用双端检测器,使其在双语期间禁止自适应滤波器系数更新,减轻学习算法发散问题。文献[6-7]应用后置滤波器抑制AEC系统输出后的背景噪声。文献[8]将自适应算法与基于短时谱衰减的噪声抑制技术相结合,也获得了较好的回声消除效果。这些研究均将回声路径建模为线性系统。然而,由于功率放大器和扬声器等组件的限制,实际情况往往是AEC中由于扬声器信号而引入了非线性失真。

有学者们提出采用残余回声抑制[9-10]算法来抑制由于非线性失真引起的残留回声。有学者陆续将深度学习[11-14]应用到AEC中,文献[15]使用深度神经网络(Deep Neural Network,DNN)来估计残余回声抑制的增益,以消除回声信号的非线性分量。文献[16]提出了BLSTM神经网络的回声消除的算法。文献[17]提出一种基于DNN的回声消除算法来提高算法的运算速度。文献[18]提出了基于多任务深度门控递归单元神经网络的回声消除算法。这些算法在双语和非线性的情况下都具有很好的性能,且不再需要双端检测器和残留回声抑制。然而,这些基于深度学习的方法都是在高斯白噪声条件下训练的,但在实际生活中的噪声多种多样,每一种都呈现出不同的特性,且多为如鸡尾酒会噪声、空调噪声、餐厅噪声和车载噪声等的非平稳噪声,所以基于白噪声训练的算法在实际情况下的鲁棒性较差。

针对非线性回声和非平稳噪声的实际声学环境,论文利用有监督深度学习语音分离思想,提出一种基于BLSTM神经网络的联合去除回声和噪声的算法(Multiple Target Preprocessing-Acoustic Echo Cancellation-Noise Suppression,MTP-AEC-NS),其训练阶段包括多目标预处理模型(简记为MTP模型)与回声和噪声抑制模型(简记为AEC-NS模型)。两个模型均使用BLSTM神经网络作为学习器,从提取的声学特征中来预测理想比率掩模(Ideal Ratio Mask,IRM),并将两个模型联合训练。在消除阶段,通过训练好的模型便可直接得到目标语音信号,从而实现了联合去除回声和噪声。由于深度学习在复杂非线性关系建模中的强大能力,它可以对非线性回声和非平稳噪声有很高的鲁棒性。该算法不再需要单独的双端检测器、噪声抑制器和残留回声抑制模块。有效避免了双端检测器检测不准确、噪声与残留回声估计过高引起的问题。联合去除回声和噪声可以减少目标语音失真现象,较好的保留语音信号的频域信息,提高语音可懂度。

2 智能设备环境下的声学模型

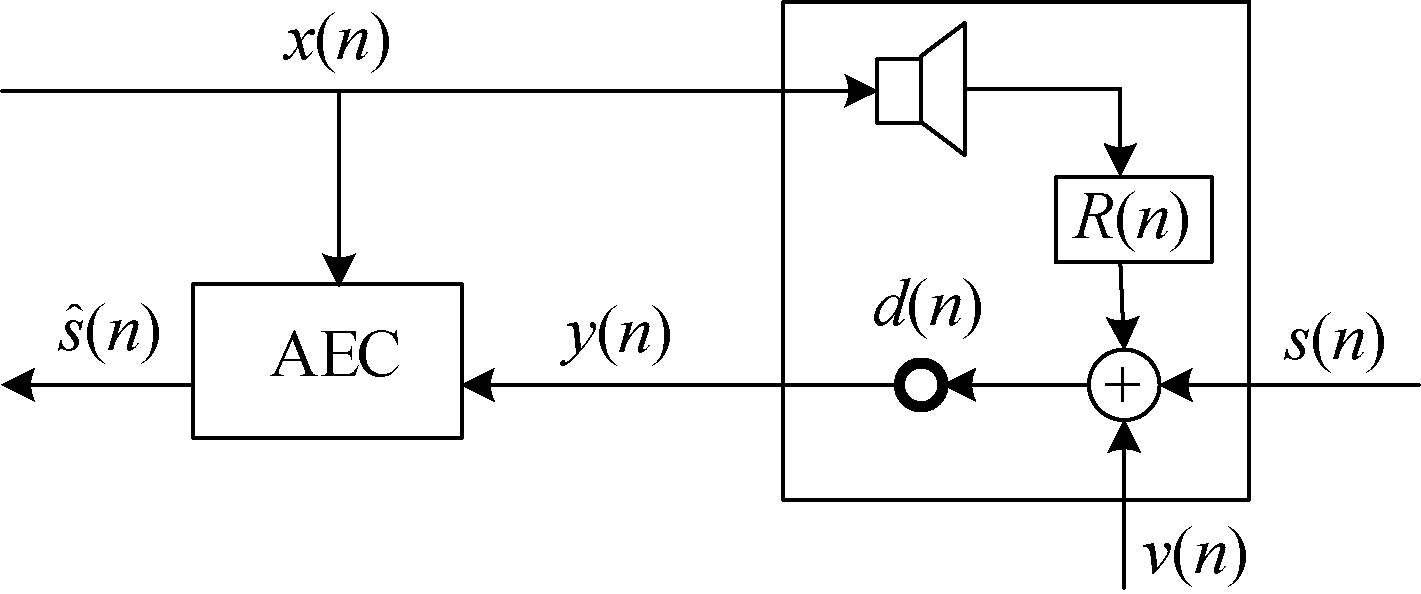

智能设备环境下的声学模型如图1所示。

图1 智能设备环境下的声学模型

Fig.1 Acoustic models in smart device environment

图1中扬声器播放信号为x(n),在线性情况下,回声信号de(n)表示为x(n)与智能设备声学冲激响应R(n)的卷积,即

de(n)=R(n)*x(n)

(1)

目标语音信号为s(n),背景噪声为ν(n),麦克风接收信号y(n)由非线性回声信号d(n)、背景噪声和目标语音信号混合而成,即

y(n)=s(n)+d(n)+ν(n)

(2)

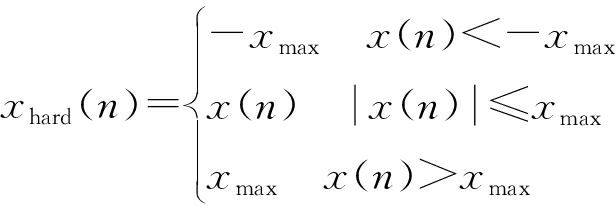

通过以下两个步骤对x(n)引入非线性失真。首先,对x(n)采用硬限幅[19]来模拟功率放大器的特性,表达式为

(3)

然后采用无记忆sigmoid函数[20]来模拟扬声器的非线性特性,表达式为

(4)

式中,b(n)的表达式为

(5)

则非线性回声信号d(n)表示为xNL(n)与R(n)的卷积,即

d(n)=R(n)*xNL(n)

(6)

3 MTP-AEC-NS模型

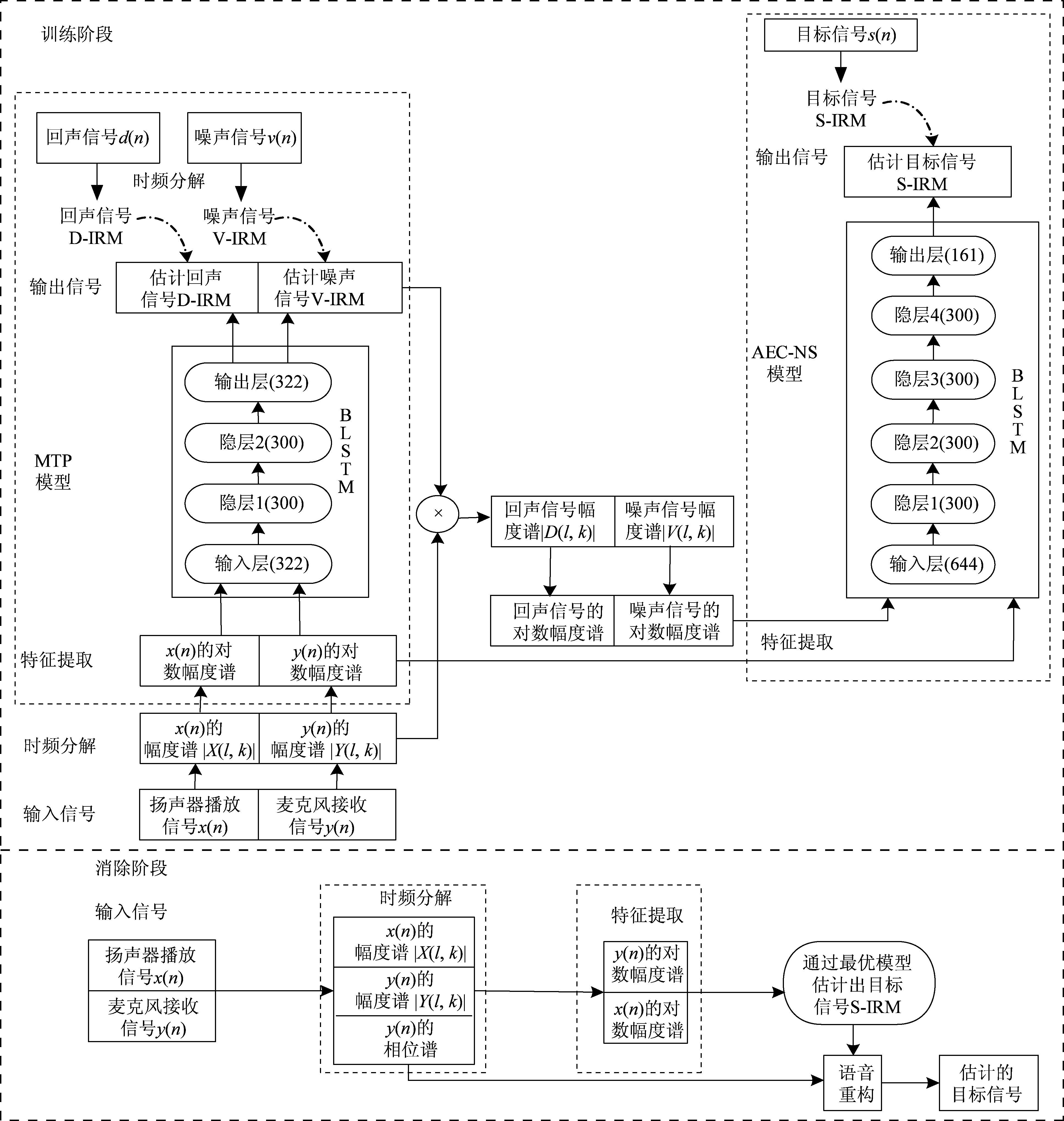

如图2为论文提出的MTP-AEC-NS算法框图,该算法分为训练阶段与消除阶段,其中训练阶段包括MTP模型与AEC-NS模型。

3.1 前端处理时频分解模块

采用短时傅里叶变换(Short Time Fourier Transform,STFT)来进行时频分解,它是模型的前端处理模块。在训练阶段,将全部信号首先进行分帧加窗处理,然后对信号的每帧进行320点的STFT,进而计算出其幅度谱,由于STFT的对称特性,通常取161个频点即可。

图2 MTP-AEC-NS算法框图

Fig.2 MTP-AEC-NS framework

3.2 MTP模型

有监督训练模型需要考虑输入特征、训练目标与学习器三个方面,下面对MTP模型这三个方面进行详细介绍。

相对于语音分离系统,回声消除系统不仅可以采集到y(n),还可以得到x(n),且这两个信号均包含d(n)的成分,因此论文分别提取出这两个信号的对数幅度谱L_|X(l,k)|和L_|Y(l,k)|,将其串联作为该模型的输入特征,进而输入的维数是161×2=322。

采用IRM[21]作为训练目标,它表示训练目标的能量在混合的s(n)、d(n)和ν(n)中所占的比例。则回声信号理想比例掩模D_IRM(l,k)和噪声信号理想比例掩模V_IRM(l,k)分别表示为

(7)

(8)

式中:S2(l,k)、D2(l,k)和V2(l,k)分别表示s(n)、d(n)和ν(n)的短时谱能量。

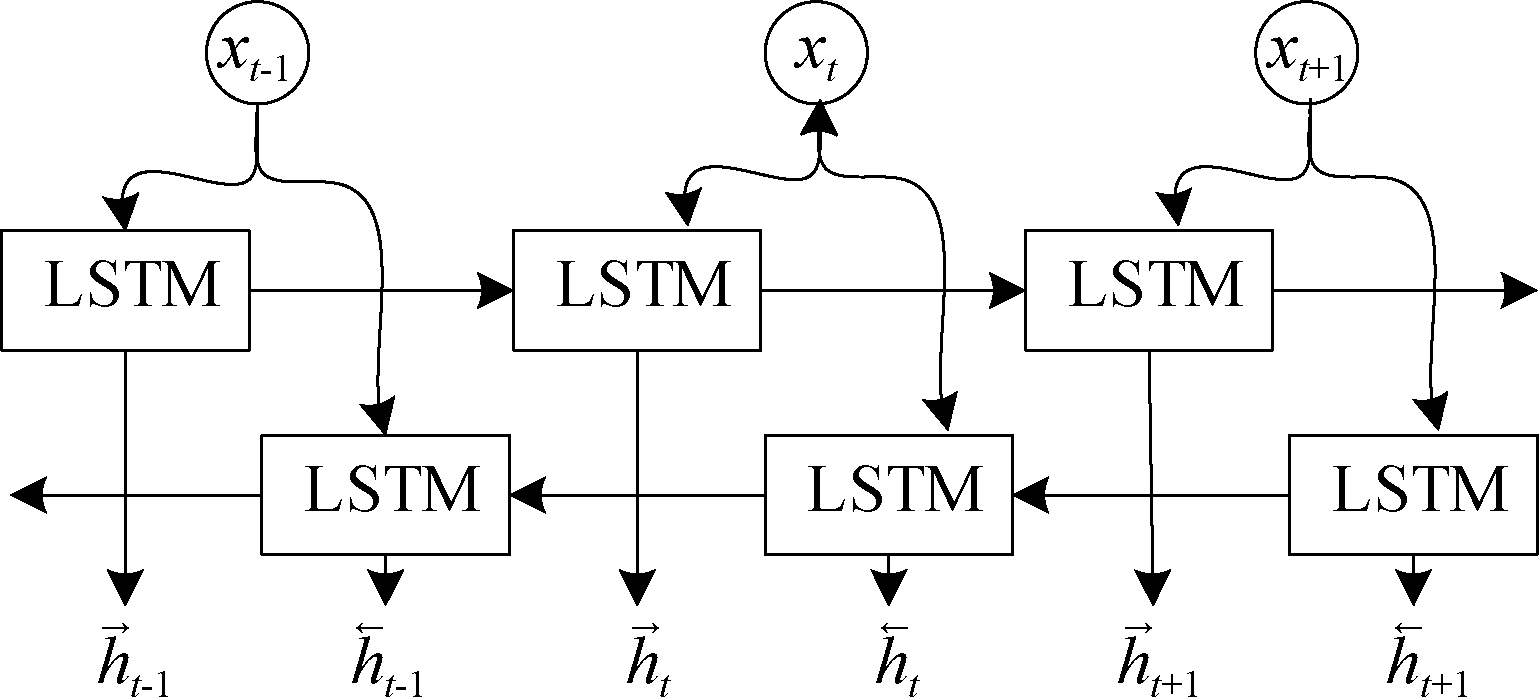

论文采用BLSTM[22]神经网络作为学习器,如图3所示,它包含两个单向长短时记忆(Long Short Term Memory,LSTM)神经网络[23],LSTM是循环神经网络(Recurrent Neural Network,RNN)的一种变体,可以解决传统RNN梯度消失和爆炸的缺陷,它通过在记忆单元中引入门控机制,进而可以选择性地保留上下文的记忆数量,减少网络深度和缓解梯度消失现象。

图3 BLSTM神经网络框图

Fig.3 BLSTM neural network framework

LSTM包括记忆细胞单元ct与遗忘门ft、输入门it和输出门ot,其计算公式如下:

it=σ(Wixxt+Wihht-1+bi)

ft=σ(Wfxxt+Wfhht-1+bf)

ot=σ(Woxxt+Wohht-1+bo)

zt=g(Wzxxt+Wzhht-1+bz)

ct=ftot-1+itzt

ht=otg(ct)

(9)

式中:xt,zt,ht分别表示t时刻的输入信号、输出信号和隐层输出;σ,g分别表示sigmoid激活函数和tanh激活函数;W,b表示连接两层的权重和偏置。

在t时刻下,BLSTM的输出为两个单向LSTM输出的直接拼接,即

(10)

式中:![]() 表示前向LSTM的输出,

表示前向LSTM的输出,![]() 表示反向LSTM的输出。

表示反向LSTM的输出。

该算法通过MTP模型,将输入的声学特征共享底层网络,同步估计出回声信号理想比例掩模![]() 和噪声信号理想比例掩模

和噪声信号理想比例掩模![]() 即

即

(11)

(12)

式中,α,θ表示学习器参数, f表示学习器。并将其分别与y(n)的幅度谱逐点相乘,进而估计出回声信号幅度谱![]() 和噪声信号幅度谱

和噪声信号幅度谱![]() 即

即

(13)

(14)

3.3 AEC-NS模型

AEC-NS模型同样包括输入特征、训练目标和学习器。

该模型首先将MTP模型输出的![]() 与

与![]() 归一化后提取对数幅度谱L_|D(l,k)|与L_|V(l,k)|;再与MTP模型提取的特征L_|X(l,k)|与L_|Y(l,k)|串联起来作为该模型的输入特征,因此其的输入维数是161×4=644;然后采用目标语音信号理想比率掩模S_IRM(l,k)作为该模型的训练目标,表示为

归一化后提取对数幅度谱L_|D(l,k)|与L_|V(l,k)|;再与MTP模型提取的特征L_|X(l,k)|与L_|Y(l,k)|串联起来作为该模型的输入特征,因此其的输入维数是161×4=644;然后采用目标语音信号理想比率掩模S_IRM(l,k)作为该模型的训练目标,表示为

(15)

最后采用BLSTM作为学习器。该模型通过输入的声学特征直接得到估计的目标语音信号理想比率掩模![]() 实现联合抑制回声和噪声。

实现联合抑制回声和噪声。

3.4 模型训练

论文将两个模型看作一个整体神经网络,首先通过联合训练两个模型使其向着一个方向优化,并消除模型分别训练过程中产生不一致的问题,进而得到最优回声和噪声抑制模型;然后对网络的中间层也添加训练目标约束,使计算速度加快,并且避免梯度消失现象;最后采用Adam优化器[24]和均方误差损失函数训练网络,损失函数表示为

![]()

![]()

![]()

(16)

式中:N是训练样本的个数。

3.5 消除和抑制阶段

将扬声器播放信号xc(n)和麦克风接收信号yc(n)进行STFT,得到幅度谱|Xc(l,k)|和|Yc(l,k)|,并提取yc(n)的相位信息ej∠Yc(l,k);再分别提取对数幅度谱L_|Xc(l,k)|和L_|Yc(l,k)|作为特征输入到训练好的模型中,进而得到估计的目标语音信号理想比率掩模![]() 即

即

![]()

f(α(L_|Xc(l,k)|,L_|Yc(l,k)|),θ)

(17)

通过与|Yc(l,k)|逐点相乘来获得估计的目标语音信号幅度谱

(18)

采用麦克风接收信号的相位谱ej∠Yc(l,k)近似目标语音信号的相位谱,进而得到估计的目标语音信号频谱为

(19)

最后,应用逆短时傅里叶变换重新合成估计的时域目标语音信号![]()

4 实验结果与分析

4.1 实验参数设定

模拟一个智能设备的运行环境,设置房间大小为(4,4,3) m,中度混响时间为0.35 s,AIR的长度为1536点。麦克风固定在(2,2,1.5) m的位置,智能设备中麦克风与扬声器之间的间距设为0.015 m。扬声器放置在7个随机位置,从而产生7个不同位置的AIR。

信号采样率设为16 kHz,帧长设为20 ms,帧移设为10 ms,窗函数采用汉明窗。

将MTP模型中的BLSTM设置两个隐层,AEC-NS模型中的BLSTM设置四个隐层,其中每个隐层均有300个节点,并在每个模型后均添加一个全连接层作为输出层。由于IRM的范围在[0,1]之间,因此选用sigmoid函数作为输出层的激活函数,学习率设定为0.0003,训练批次样本数设定为30。

从TIMIT数据集中630名说话者中随机选择50名男说话者和50名女说话者作为扬声器播放源;另随机选择50名男说话者和50名女说话者作为目标语音源;其中每名说话者分别说10句话,即1000句原始扬声器播放信号和1000句原始目标语音信号。

4.1.1 目标语音信号

首先将原始1000句目标语音信号均截断为2 s,若不足2 s,则在其后面补零;再将每句信号的起始点前均填补4 s的零数据,进而产生1000句6 s的目标信号;最后从每一名目标语音源产生的十句语音中随机选择七句语音,划分为700句训练目标语音信号s(n)和300句验证目标语音信号。

4.1.2 扬声器播放信号

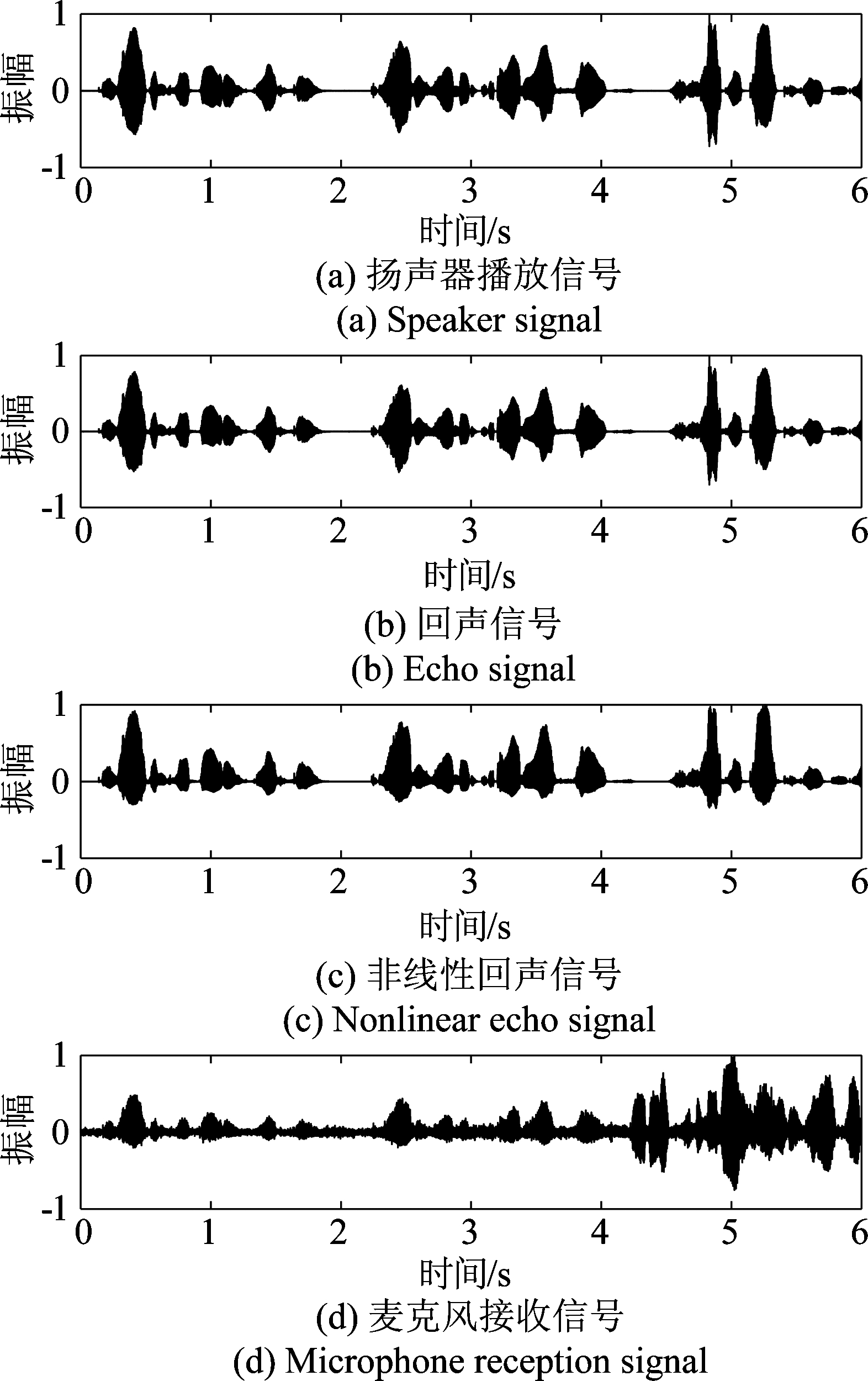

随机选择同一扬声器播放源的六句语音将其串联并均截断为6 s,产生100句扬声器播放信号x(n),如图4(a)所示。

图4 各语音时域信号波形

Fig.4 Each speech time-domain signal waveform

并对扬声器信号引入非线性失真,得到100句xNL(n),其中xmax设置为信号最大幅值的80%,增益γ设置为4,如果b(n)>0,则斜率a设置为4,否则设置为0.5。

4.1.3 回声信号

在前6个AIR中随机选择一个AIR,并随机选择一个x(n)与其卷积产生3500句回声信号de(n),如图4(b)所示,并与一个xNL(n)卷积产生3500句非线性回声信号d(n),如图4(c)所示。

从{-6,-3,0,3,6} dB随机选择一个信回比(Signal Echo Ratio,SER),重新生成3500句回声信号和3500句非线性回声信号。

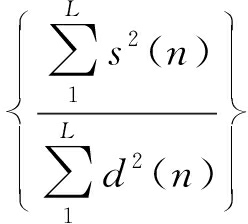

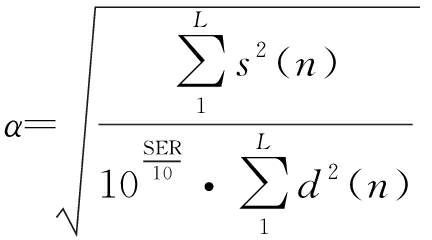

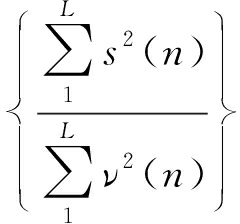

信回比表示为

SER =10log10

(20)

式中,L为信号的总采样点数,为了生成具有指定SER的混合信号,需要调整回声信号的能量大小,即调整后的回声信号为αd(n)

(21)

4.1.4 噪声信号

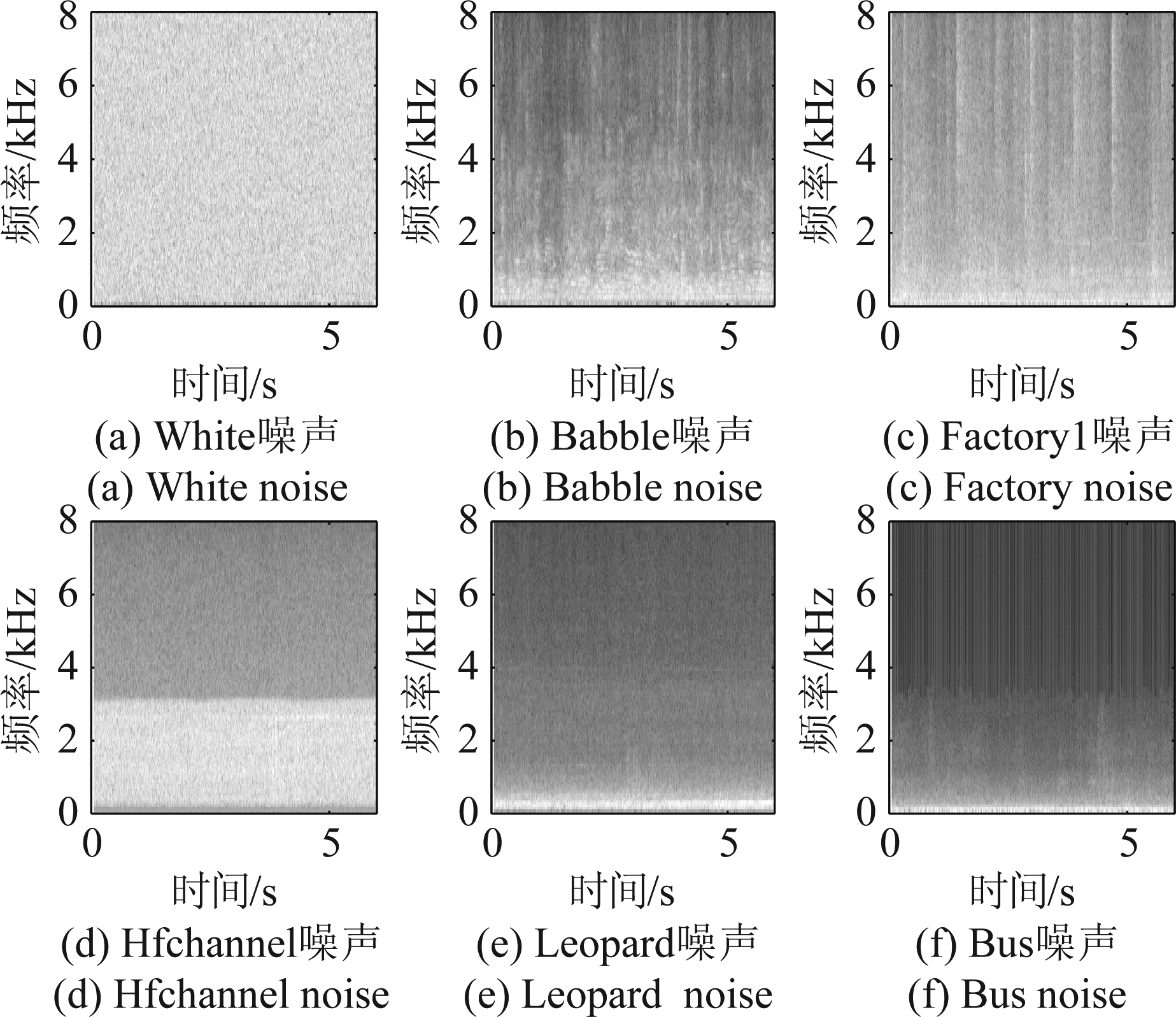

在Noisex-92噪声库中选取Babble餐厅噪声、Factory1工厂车间噪声1、Hfchannel高频信道噪声和Leopard军用车辆噪声四种非平稳噪声,组成840 s的噪声训练信号。四种噪声的语谱图如图5(b)~(e)所示,从图中可以看出,Babble、Factory1和Leopard噪声的频率主要分布在低频段,而Hfchannel噪声主要分布在中低频段,并且Babble噪声频谱与语音信号频谱极为相似。

图5 各噪声频谱图

Fig.5 Each noise spectrum

在噪声训练信号随机截取6 s信号作为一句噪声信号,并在{8,10,12,14} dB随机选择一个信噪比(Signal Noise Ratio,SNR),重新生成3500句非平稳噪声信号ν(n)。信噪比表示为

SNR =10log10

(22)

4.1.5 训练数据集

700句目标语音信号分别与随机选取的5句不同的回声信号de(n)进行混合,并添加白噪声信号,如图5(a)所示,产生3500句麦克风接收信号作为训练数据集1。

700句目标语音信号分别与随机选取的5句不同的非线性回声信号d(n)和一句非平稳噪声信号进行混合产生3500句麦克风接收信号作为训练数据集2。如图4(d)所示。

将每句验证目标语音信号分别与一句回声信号(非线性回声信号)按照SER为3.5 dB和一句噪声信号按照SNR为10 dB进行混合产生300句验证数据集。

4.1.6 测试数据集

从TIMIT数据集中剩下的430名说话者中随机选择另外5名男说话者和5名女说话者作为扬声器播放源和5名男说话者和5名女说话者作为实际目标语音源。产生目标语音信号10句,扬声器播放信号10句。将扬声器播放信号与最后一个AIR卷积产生10句回声信号,添加非平稳噪声信号,按照指定SER和SNR进行混合生成100句未经训练的混合信号作为消除数据集1。在非平稳噪声信号下,将扬声器播放信号引入非线性失真,并产生10句非线性回声信号,生成消除数据集2;在非线性回声信号下,添加未经训练过的bus汽车噪声,如图5( f ),生成消除数据集3;非平稳噪声信号下,将扬声器播放信号改成音乐信号,生成非线性音乐回声信号,生成消除数据集4;在非线性音乐回声信号下,添加未经训练过的bus汽车噪声,生成消除数据集5。

4.2 实验结果与分析

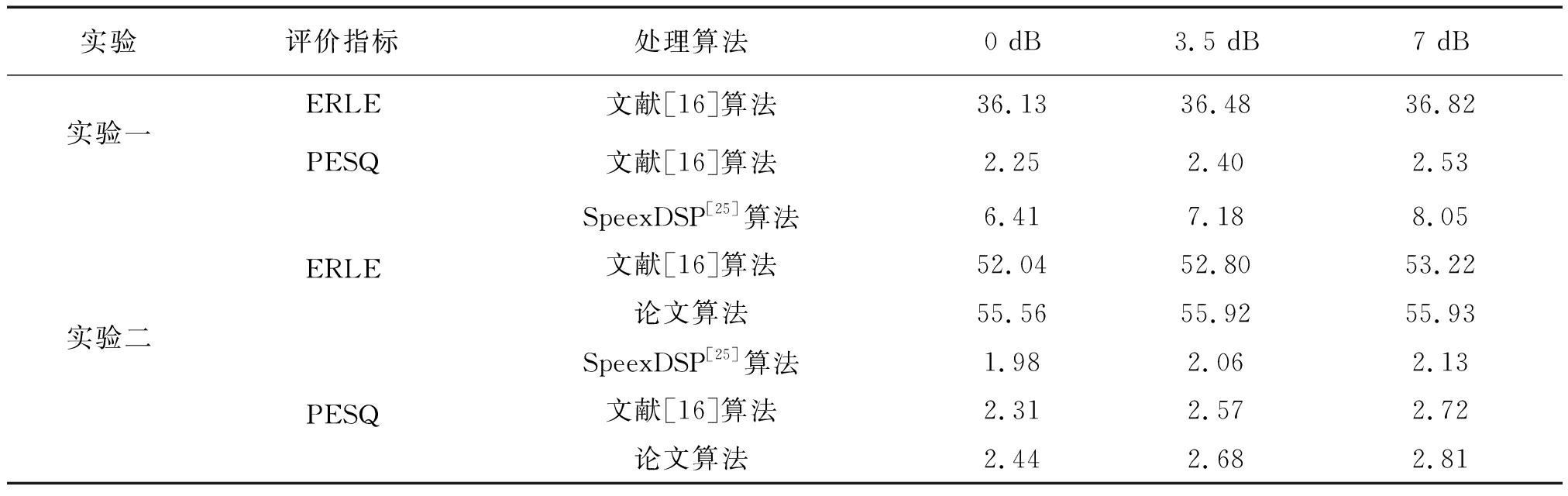

4.2.1 实验一

首先选用训练数据集1,利用文献BLSTM算法[16]训练网络;然后选用消除数据集1进行算法性能验证。如图6(a)和(b)为目标语音信号的时域波形和频谱图,如图6(c)与(d)是SNR为10 dB与SER为3.5 dB时通过BLSTM模型估计出的目标语音信号时域波形图和语谱图。由图6(c)与(d)可知,在白噪声条件下训练的BLSTM模型应用在实际情况的非平稳噪声中,目标语音高频部分能量较浅,语音失真较严重。因此基于白噪声训练的BLSTM算法[16]在实际情况下鲁棒性较差。

图6 时域波形图和语谱图

Fig.6 Time domain waveform and spectrum

4.2.2 实验二

选用训练数据集2和消除数据集2来验证开源SpeexDSP算法[25]、文献BLSTM算法[16]与论文MTP-AEC-NS算法在非线性失真回声与非平稳噪声情况下的性能。SpeexDSP算法是一种利用自适应滤波算法来消除回声的传统算法,在工程上被广泛使用;文献BLSTM算法[16]仅使用了一个BLSTM网络,而论文MTP-AEC-NS算法添加了一个预处理模型,来同步估计出回声和噪声信号的幅度谱;然后将其作为回声和噪声抑制模型的输入特征,进而估计出目标语音信号的理想比例掩模。

从表1中的实验二结果可以得出,SpeexDSP算法的ERLE和PESQ值均较低,这是由于在非线性情况下自适应算法的鲁棒性较差,并且在双语的情况下自适应滤波会存在不收敛的现象,同样会影响算法性能。对比表1中的实验一和实验二结果,可以得出,在不同SNR情况下,基于白噪声训练的BLSTM算法均比基于非平稳噪声训练的BLSTM算法和论文MTP-AEC-NS算法得出的ERLE和PESQ值略低,其中论文提出的算法两个指标的数值均比BLSTM算法高。

如图7(a)和(b)给出了SNR为10 dB与SER为3.5 dB时通过SpeexDSP算法估计出的目标语音信号时域波形图与语谱图;如图7(c)和(d)给出了SNR为10 dB与SER为3.5 dB时通过BLSTM算法估计出的目标语音信号时域波形图与语谱图;图7(e)和( f )给出了SNR为10 dB与SER为3.5 dB时通过论文MTP-AEC-NS算法估计出的目标语音信号时域波形图与语谱图。可以看出,SpeexDSP算法存在较高的残留回声和噪声,这是由于自适应滤波算法收敛需要一定的时间。BLSTM算法与MTP-AEC-NS算法估计出的时域波形图均接近真实的目标语音信号时域波形图,但BLSTM算法在语音能量较小段会将其误认为噪声段,过度的去除回声和噪声,使一些频点丢失,导致语音失真。论文MTP-AEC-NS算法通过联合模型来去除回声和噪声,保证在去除回声和噪声的情况下,频点不丢失,因此,论文提出算法可以有效地减少目标语音失真,提高回声和噪声抑制的能力。

表1 各算法ERLE和PESQ值

Tab.1 ERLE and PESQ values for each algorithm

实验评价指标处理算法0 dB3.5 dB7 dB实验一ERLE文献[16]算法36.1336.4836.82PESQ文献[16]算法2.252.402.53实验二ERLEPESQSpeexDSP[25]算法6.417.188.05文献[16]算法52.0452.8053.22论文算法55.5655.9255.93SpeexDSP[25]算法1.982.062.13文献[16]算法2.312.572.72论文算法2.442.682.81

图7 时域波形图和语谱图

Fig.7 Time domain waveform and spectrum

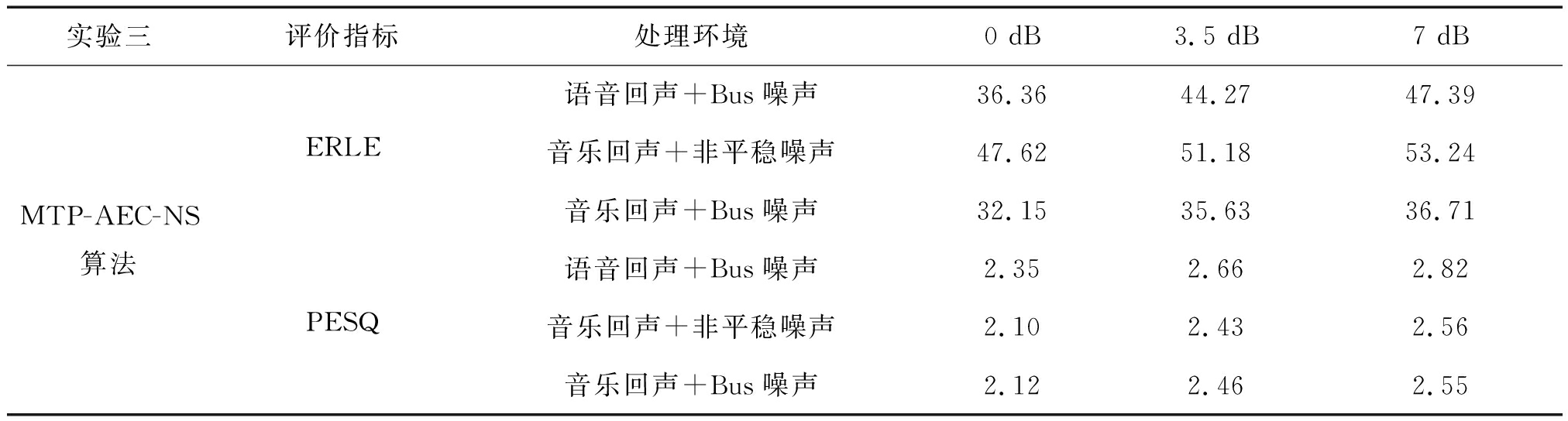

4.2.3 实验三

在实验二训练好的MTP-AEC-NS模型基础下,分别选用不用的消除数据集来验证论文MTP-AEC-NS算法性能。表2分别给出了不同消除数据集在SNR为10 dB不同SER条件下ERLE和PESQ值。

首先,选用消除数据集3来验证在未经训练的Bus噪声下论文MTP-AEC-NS算法性能,从表2的结果可以看出,在未经训练的Bus噪声下,论文MTP-AEC-NS算法的评价指标较高,这说明该算法对非平稳噪声有很好的鲁棒性。

然后,选用消除数据集4来验证非线性音乐回声信号下论文MTP-AEC-NS算法性能,从表2的结果可以看出,在低SER下ERLE和PESQ值略低,这是由于音乐信号与语音信号频谱上有很大差异,并且有些音乐伴奏类似于非平稳噪声。但在较高SER下,论文MTP-AEC-NS算法同样可以适用于未经训练的非线性音乐回声信号。

最后,选用消除数据集5来验证在均未经训练的音乐回声和Bus噪声共同存在时论文MTP-AEC-NS算法性能,从表2的结果可以看出,ERLE值相对其他条件下略低,但相对传统自适应滤波算法,性能依然提高。在较高SER下,PESQ值较高。若在均未经训练的条件下,论文MTP-AEC-NS算法在回声音量较小时,也可以去除音乐回声和噪声。

表2 ERLE和PESQ值

Tab.2 ERLE and PESQ values

实验三评价指标处理环境0 dB3.5 dB7 dBMTP-AEC-NS算法ERLEPESQ语音回声+Bus噪声36.3644.2747.39音乐回声+非平稳噪声47.6251.1853.24音乐回声+Bus噪声32.1535.6336.71语音回声+Bus噪声2.352.662.82音乐回声+非平稳噪声2.102.432.56音乐回声+Bus噪声2.122.462.55

5 结论

考虑到非线性回声和非平稳噪声对智能设备回声消除算法的影响,论文提出一种基于BLSTM神经网络的联合去除回声和噪声的算法。该算法不再需要单独的双端检测器、噪声抑制器和残留回声抑制模块,有效避免了双端检测器检测不准确、噪声与残留回声估计过高引起的问题,且听音测试也证明了语音失真较小。未来可以将深度学习回声消除算法应用到多通道中。

[1] Schmidt G, Eberhard H. Acoustic echo and noise control: a practical approach[M]. Wiley-Interscience, 2004: 163-218.

[2] Gupta V K, Chandra M, Sharan S N. Acoustic echo and noise cancellation system for hand-free telecommunication using variable step size algorithms[J]. Radioengineering, 2013, 22(1): 200-207.

[3] Mayyas, Khaled. A variable step-size selective partial update LMS algorithm[J]. Digital Signal Processing, 2013, 23(1): 75- 85.

[4] Benesty J, Rey H, Vega L R, et al. A nonparametric VSS NLMS algorithm[J]. IEEE Signal Processing Letters, 2006, 13(10): 581-584.

[5] Hamidia M, Amrouche A. A new robust double-talk detector based on the stock well transform for acoustic echo cancellation[J]. Digital Signal Processing, 2016, 60: 99-112.

[6] Djendi M, Henni R, Djebari M. A new adaptive solution based on joint acoustic noise and echo cancellation for hands-free systems[J]. International Journal of Speech Technology, 2019, 22(2): 407- 420.

[7] Habets E A P, Gannot S, Cohen I, et al. Joint dereverberation and residual echo suppression of speech signals in noisy environments[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2008, 16(8): 1433-1451.

[8] Ykhlef F, Ykhlef H. A post-filter for acoustic echo cancellation in frequency domain[C]∥In World Conference on Complex Systems (WCCS). Agadir: IEEE, 2014: 446- 450.

[9] Kallinger M, Kammeyer K D, Bitzer J. Multi-microphone residual echo estimation[C]∥In International Conference on Acoustics, Speech and Signal Processing (ICASSP). Piscataway: IEEE, 2003: 584-588.

[10] Lee S Y, Kim N S. A statistical model-based residual echo suppression[J]. IEEE Signal Processing Letters, 2007, 14(10): 758-761.

[11] Salazar J, Kirchhoff K, Huang Z. Self-attention networks for connectionist temporal classification in speech recognition[C]∥In International Conference on Acoustics, Speech and Signal Processing (ICASSP). Brighton, United Kingdom, United Kingdom: IEEE, 2019: 7115-7119.

[12] 张晖. 基于深度学习的语音分离研究[D]. 内蒙古: 内蒙古大学, 2017.

Zhang Hui. Research on sound separation based on deep learning[D]. Inner Mongolia: Inner Mongolia University, 2017.(in Chinese)

[13] Erdogan H, Hershey J R, Watanabe S, et al. Phase-sensitive and recognition-boosted speech separation using deep recurrent neural networks[C]∥In International Conference on Acoustics, Speech, and Signal Processing (ICASSP). Brisbane, QLD, Australia: IEEE, 2015: 708-712.

[14] 袁文浩, 梁春燕, 夏斌, 等. 一种融合相位估计的深度卷积神经网络语音增强方法[J]. 电子学报, 2018, 46(10): 2359-2366.

Yuan Wenhao, Liang Chunyan, Xia Bin, et al. A deep convolutional neural network based speech enhancement approach incorporating phase estimation[J]. Acta Electronica Sinica, 2018, 46(10): 2359-2366.(in Chinese)

[15] Chul M L, Jong W S, Nam S K. DNN-based residual echo suppression[C]∥In Interspeech. Dresden, Germany: ISCA, 2015: 1775-1779.

[16] Zhang Hao, Wang Deliang. Deep learning for acoustic echo cancellation in noisy and double-talk scenarios[C]∥In Interspeech. Hyderabad, India: ISCA, 2018: 3239-3243.

[17] Lei Qinhui, Chen Hang, Hou Junfeng, et al. Deep neural network based regression approach for acoustic echo cancellation[C]∥In International Conference on Multimedia Systems and Signal Processing (ICMSSP). Guangzhou, China: ICBN, 2019: 94-98.

[18] Amin F, Mostafa E K Jungwon L. Deep multitask acoustic echo cancellation[C]∥In Interspeech. Graz, Austria: ISCA, 2019: 4250- 4254.

[19] Malik S, Enzner G. State-space frequency-domain adaptive filtering for nonlinear acoustic echo cancellation[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2012, 20(7): 1-1.

[20] Comminiello D, Scarpiniti M, Azpicueta R L A, et al. Functional link adaptive filters for nonlinear acoustic echo cancellation[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2013, 21(7): 1502-1512.

[21] Wang Yuxuan, Narayanan Arun, Wang Deliang. On training targets for supervised speech separation[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2014, 22(12): 1849-1858.

[22] Xue Shaofei, Yan Zhijie. Improving latency-controlled BLSTM acoustic models for online speech recognition[C]∥In International Conference on Acoustics, Speech and Signal Processing (ICASSP). New Orleans, LA, USA: IEEE, 2017: 5340-5344.

[23] Chen Jitong, Wang Deliang. Long short-term memory for speaker generalization in supervised speech separation[J]. The Journal of the Acoustical Society of America, 2017, 141(6): 4705- 4714.

[24] Kingma D, Ba J. Adam: a method for stochastic optimization[J]. Computer Science, 2014.

[25] Valin J M. On adjusting the learning rate in frequency domain echo cancellation with double-talk[J]. IEEE Transactions on Audio Speech, and Language Processing, 2007, 15(3): 1030-1034.