1 引言

随着语音识别技术的成熟,自动语音识别(Automatic Speech Recognition,ASR)技术在计算机辅助发音系统(CAPT)中的应用受到了大量关注。CAPT从反馈的形式上可分为两种,一种是基于发音良好度(GOP)的方法,该方法用于计算发音的置信分数,最后通过预定义阈值实现发音错误检测。这种方法基于ASR框架,适应性和稳定性强。GOP算法及其改进算法在发音偏误检测中被广泛使用[1-2],但是分数只能做优劣判断,不能让学习者获得直接的改进方法。所以有一些学者研究了提供偏误类型的反馈,这种方法是在检测结果中给出正误判断的同时指出发音的具体错误类型,如“t”音错发成了“d”音。其结果提供的信息量更大,为发音纠正训练模块提供了更多的参考信息[3-7]。上述的两种方法主要用到声学模型和解码两个部分。

早期的声学模型是基于混合高斯结合隐马尔科夫模型(Gaussian Mixture Model-Hidden Markov Model,GMM-HMM)结构[8],随着深度神经网络的提出,研究发现深度神经网络具有更强的建模能力。在对比了GMM-HMM和深度神经网络(Deep Neural Network, DNN)结合隐马尔科夫模型(DNN-HMM)结构后,Gao[9]等人发现在偏误检测领域,DNN结构优于传统的GMM结构。DNN训练需要大量数据,早期研究者通过用母语者数据训练的模型去识别二语者的发音,但是其中存在不匹配的问题,所以准确率不高。Hu[10]通过汉语母语者数据结合二语者数据训练出来的模型做二语者语音声韵母的识别,检测二语者替换错误。而Huang[11]用迁移学习的思想,DNN隐层用汉语母语者数据进行训练。输出层用二语者数据训练,结果有一定的提升。Gao等人[9, 12]结合不同的语音特征,同时完全使用二语者数据进行训练。在二语者容易错的前16(top16)个声韵母上做评估,这种方法无法评估除top16以外的错误类型。

除声学模型外,一些学者也在研究解码部分,以期提供更准确的反馈信息。Kim等人[13]比较了基于HMM结构的语音识别分数值:音素的对数似然值,后验概率的对数值和发音时长。实验结果表明,在音素发音质量评估中后验概率的对数值与人工打分有最好的相关性。早期的偏误检测直接采用自由音素识别网络[22],但是这种方法会包含很多的插入删除错误。Harrison等人[15-17]将扩展识别网络应用于发音偏误检测,在解码时加入先验知识。通过已知发音文本,选取与发音文本易错的音素作为解码网格候选项,找最优路径。这种方式将偏误类型限制在了先验知识内,对先验知识的准确性要求较高。Huang[18]算GOP的过程中引入易混淆对来进行计算。Kyriakopoulos[19]通过孪生网络加入母语者数据进行分数计算。Lin等人[20]通过改进扩展识别网络,在汉语声调识别中不需要很强的先验知识,直接通过语法规则来做解码。李[21]等人通过在循环神经网络语言模型中加入词向量来提高识别准确率。

前人提出的拓展识别网络,把人为定义好的规则加入发音词典中,进行英语以及汉语的发音的偏误检测。这种方法需要从很多错误样例中总结出易混淆音素,进行解码路径的约束,所以人力成本较高。本文在语音识别的框架上,通过使用DNN作为声学模型,解码时只结合声韵母交替以及字数限制规则的扩展识别网络并且对比了GOP的方法。 该方法不需要大量的标注文本去总结易混淆音素,对于机器辅助语料标注或者小语料中文偏误检测任务有一定的帮助。实验结果表明声韵母约束扩展识别网络(constrained Extended Recognition Network, cERN)的方法在挑错的任务上要优于GOP方法。

论文后续内容安排如下:第2部分介绍两种偏误检测方法的模型及系统结构,第3部分介绍本次实验的语料以及实验设置,第4部分是结果介绍与分析,第5部分是总结与展望。

2 偏误检测系统

2.1 基于DNN的GOP框架

基于DNN的GOP方法是通过声学模型分类的后验概率来进行计算,可以用来表示二语者与母语者发音的相似度。后验概率越高表示分类的置信度越高,也就表示二语者与母语者的发音越相似。

2000年Witt等人[22]在做发音偏误检测时,提出了发音质量评估(GOP)算法,该方法的使用需要知道发音对应的文本。对于给定的语音段X,其目的发音音素p的GOP定义为:

(1)

其中,d为发音持续时间,P(q)为音素q的先验概率。P(X|q)为语音特征相对于q的似然函数值,它是在时间段d内所有帧的后验概率加和,Q为所有音素的集合。在计算过程中,假设所有音素的先验概率是相同的。并且为了将GOP的值映射到0到1的范围内,本文采用的GOP计算公式[10]为:

(2)

在计算完GOP的值后,通过设定一个阈值k,用来决定发音的对错,

(3)

前人通过实验发现,一般发音较差的音素会对周围的音素的GOP产生影响。为了减少这类影响,在本文对GOP的计算中,对音素相同但是上下文不同的senones进行了加和。同一个音素各帧后验概率相加的时候,需要提前得到音素边界,所以GOP的计算对强制对齐的结果要求较高。本文采用两种计算边界的方法,一种是直接将DNN模型的对齐结果作为音素的边界信息,另一种是通过每帧后验概率最大时声母还是韵母相加。

2.2 基于DNN的扩展识别网络框架

全音素识别网络会包含很多的插入删除错误。所以研究者通过结合偏误检测任务的特点,研究者将扩展识别网络(Extended Recognition Network, ERN)应用于二语者说汉语的发音偏误检测。与语音识别不同的是,发音偏误检测任务是可以提前知道发音文本的。通过提前知道发音文本,然后基于一定的知识,在解码时可以将解码候选项缩小。如图1所示。

图1 传统扩展识别网络‘nihao’

Fig.1 Traditional extended recognition network ‘nihao’

通过对比发现,在解码部分是用文本的音节数来限制解码网格的长度的,并且汉语中拼音是声韵母交替的。这样的约束相较于传统的扩展识别网络,不需要很强的先验知识。汉语中零声母或者没有声母的音节,通过扩展声母来代替其声母位置,这种方法的好处是减少了普通的音素识别中的插入删除错误。

这种方法与传统的方法类似,不同在于把先验知识进行了变化。例如,在解码时声母n在原本的扩展网格里的候选项可能是l和n。按声韵母交替规则,将其候选项变为所有声母,韵母位置候选项同样扩展为所有韵母。如图2。

图2 声韵母约束扩展识别网络‘nihao’

Fig.2 Extended recognition network with Initials and finals constraint ‘nihao’

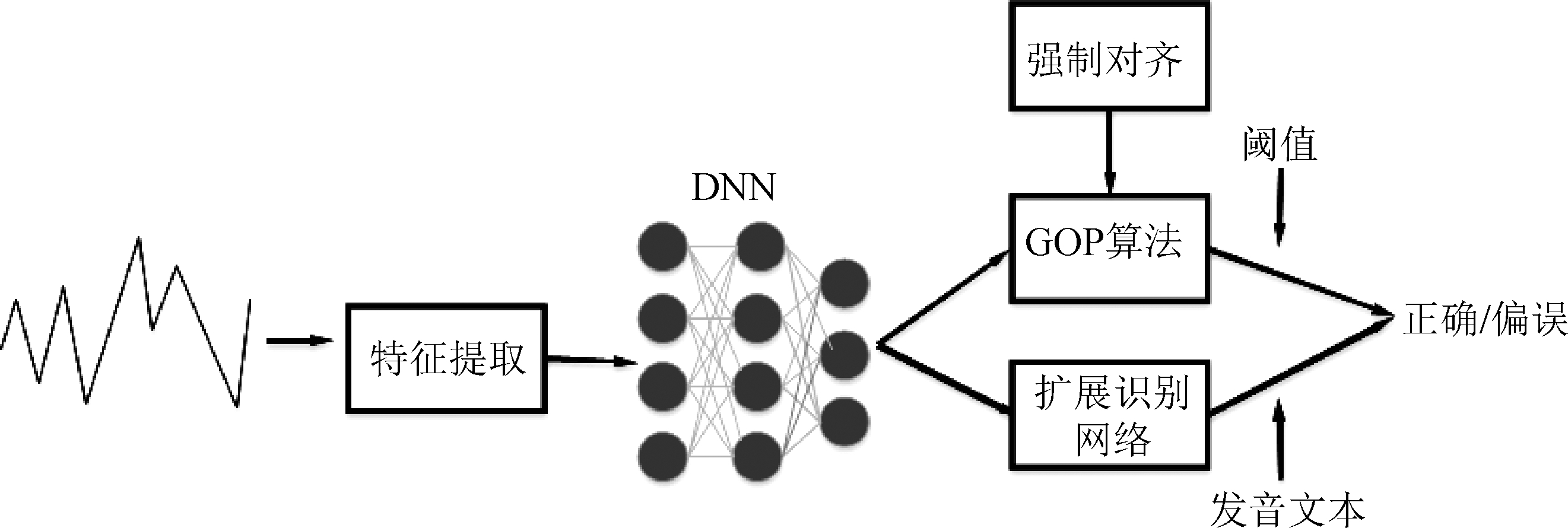

对于一些没有声母的音节,为其扩展了声母。这种方法相对于前人的方法较少依赖先验知识,在机器辅助的语料标注中可以发挥较大作用。整体发音偏误检测框架如图3。

首先将语音文件提取声学特征,然后训练声学模型。训练好后,后端可分别采用GOP算法或者扩展识别网络的方法进行偏误检测。

2.3 人工标注实验

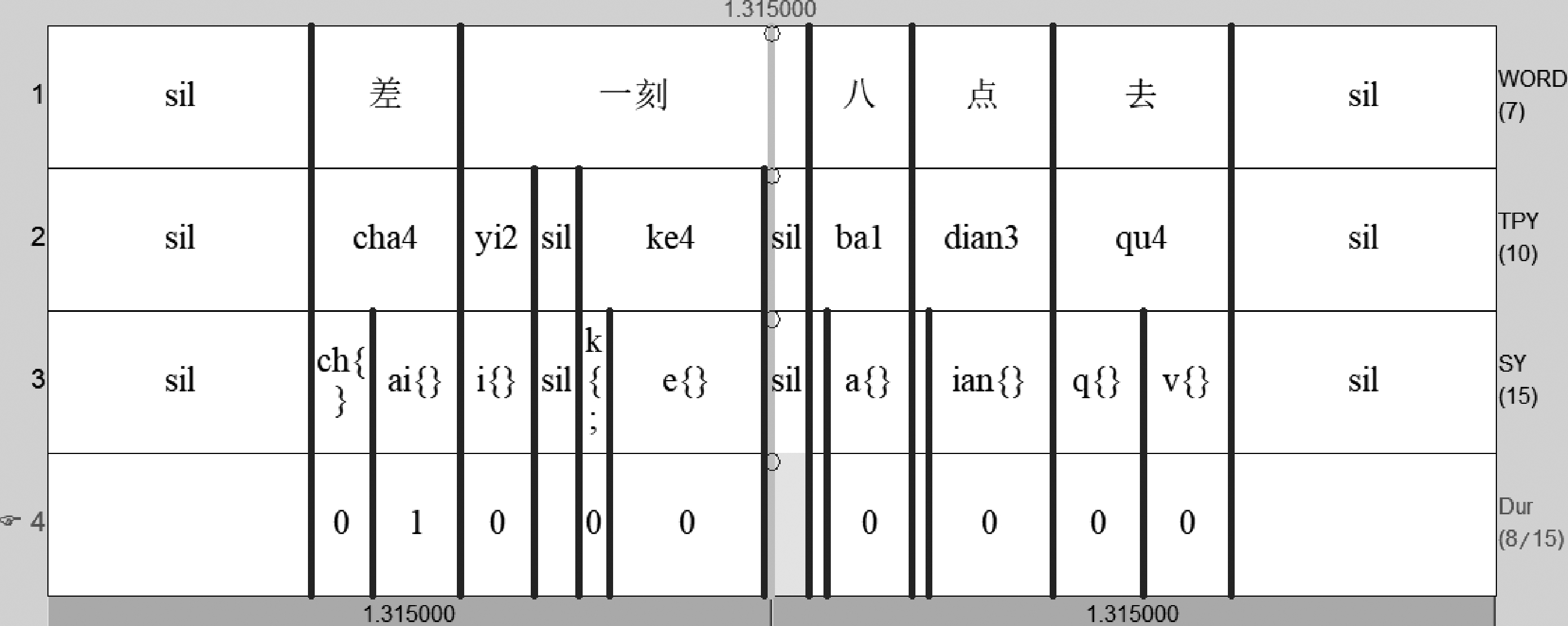

为了对比机器偏误检测结果的水平,本研究在前面实验的基础上,用无标注经验的汉语母语者以及Praat软件进行了相同语料的声韵母发音对错判断实验。标注时要求标注者听到的声韵母与母语者发音有差别即标为错。标注示例如图4。

图4中,第一层为语音对应的汉语,第二层为拼音,第三层为声韵母,最后一层是人工标注层。标注人听到语音后,在认为发音有偏误的音素下面标1,其余标0。

图3 发音偏误检测框架

Fig.3 The framework of mispronunciation detection

图4 人工标注示例

Fig.4 The example of annotation

3 实验

3.1 实验语料

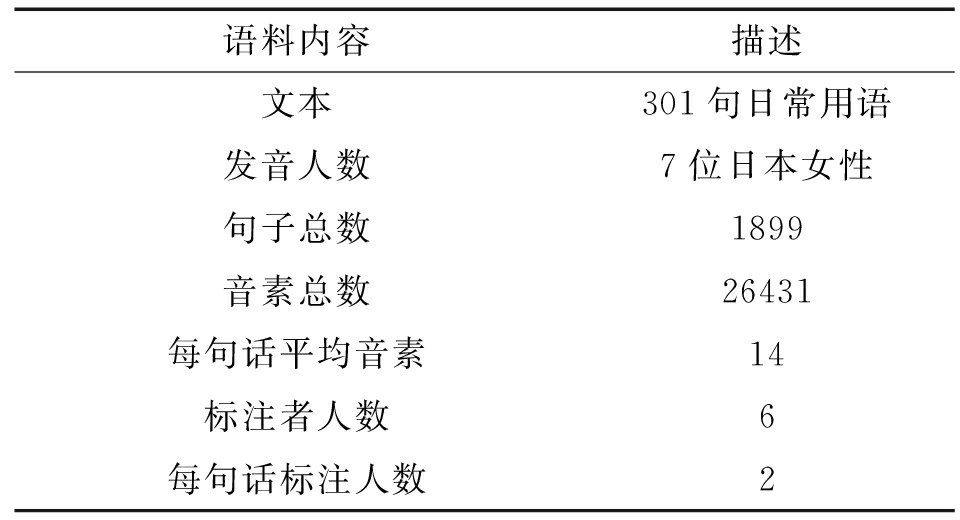

本次实验室使用的DNN模型是由视源科技公司(CVTE)开源的模型,其训练语料大约2000小时,对各种场景都具有较好的鲁棒性,测试用的中介语语料来自北京语言大学中介语语料库[23]。本实验选取了7位日本女性发音人,每人约301句话。由6位语音学研究生进行交叉标注,出现不一致时,由语音学专家进行判定,实验语料统计如表1所示。

表1 汉语中介语语料库

Tab.1 Japanese L2 inter-Chinese corpus

语料内容描述文本301句日常用语发音人数7位日本女性句子总数1899音素总数26431每句话平均音素14标注者人数6每句话标注人数2

3.2 评价指标

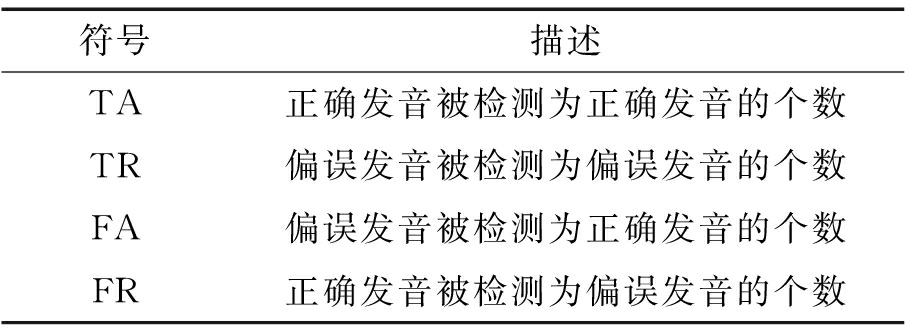

实验的检测结果有4种:正确接受(True Acceptance, TA),正确拒绝(True Rejection, TR),错误接受(False Acceptance, FA)和错误拒绝(False Rejection, FR)如表2所示。

1) 错误接受率(False Acceptance Rate,FAR):错误发音被检测为正确发音的百分比。

表2 四种检测结果

Tab.2 Four kinds of evaluation metrics

符号描述TA正确发音被检测为正确发音的个数TR偏误发音被检测为偏误发音的个数FA偏误发音被检测为正确发音的个数FR正确发音被检测为偏误发音的个数

2) 错误拒绝率(False Rejection Rate, FRR):正确发音被检测为错误发音的百分比。

3) 诊断正确率(Diagnosis Rate, DA):正确发音被检测为正确,错误发音被检测为错误的百分比。

4) 检测代价(Detection Cost Function, DCF):错误拒绝率和错误接受率调和均值。

DCF(τ)=CMISSPMISSPTarget+CFAPFA(1-PTarget)

(4)

其中CMISS是错误拒绝的检测代价,CFA是错误接受的检测代价,本实验中设置为1。PTarget先验知识的错误拒绝率和错误接收率的占比,本实验中设置为0.5。 PMISS(τ)为阈值为τ时的错误拒绝率, PFA(τ)阈值为τ时的错误接受率。

3.3 实验配置

DNN模型提取FBank特征进行训练,并做了归一化。模型的特征输入维数是40维,采用了5层的DNN,采用Relu激活函数,模型的输出为6508类HMM聚类的三元音素后验概率。GOP和扩展网络的实验采用相同的模型,测试语料也相同。

4 实验结果与分析

4.1 GOP框架的偏误检测结果

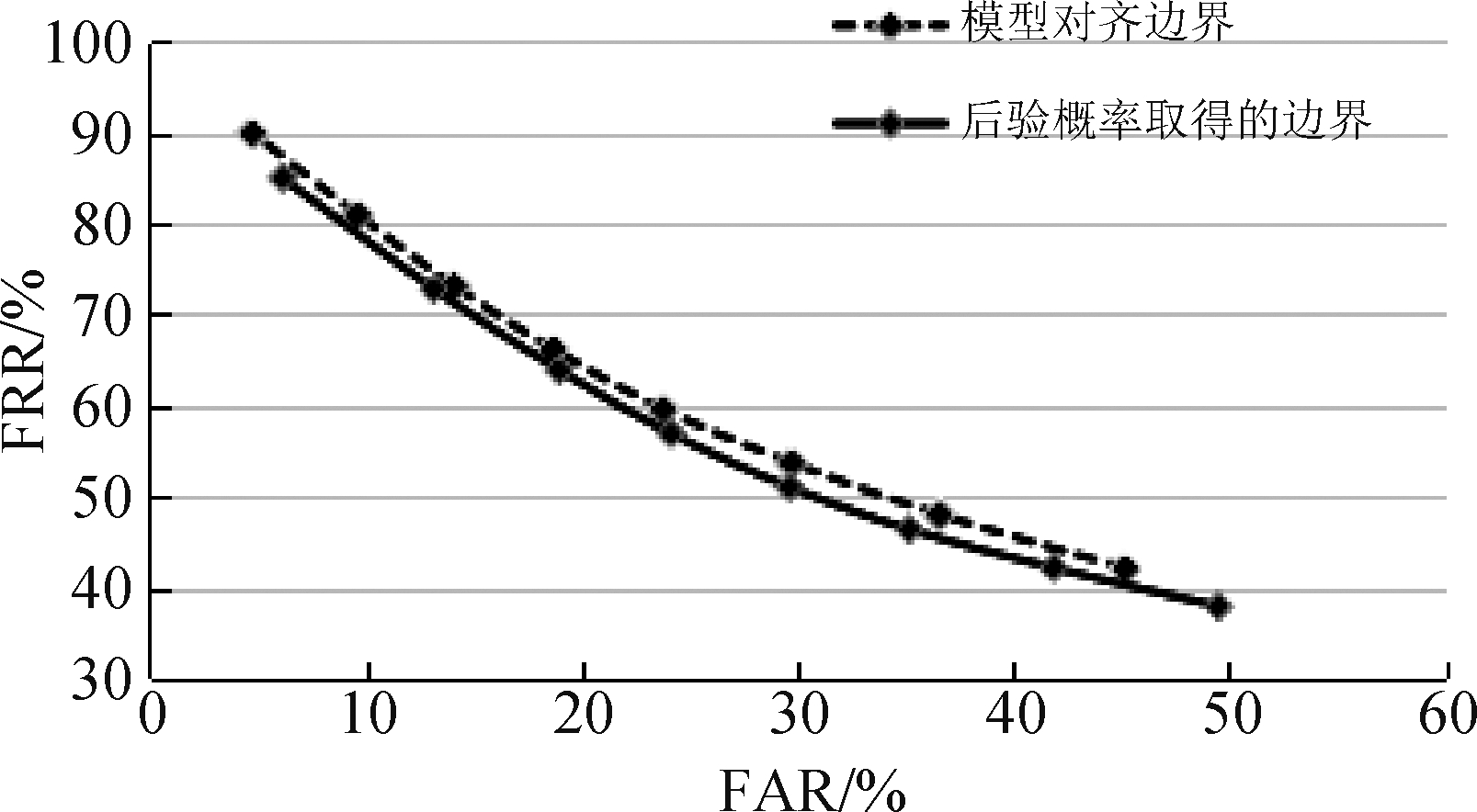

由于GOP的计算受音素强制对齐结果的影响较为严重,因此本文在计算GOP时,采用了两种方法:方法一是直接用DNN的对齐结果来进行GOP计算,将边界内的后验概率相加求平均,作为一个音素的后验概率。方法二不采用模型输出的对齐结果,而是通过找每帧的后验概率最大的是声母还是韵母来合并。汉语的声韵母在语音中是交替存在的,对于零声母或者是没有声母的音节,CVTE模型也扩展了声母,所以可以依据每帧语音后验概率最大是声母还是韵母来进行帧合并。两者的FAR与FRR的接受者操作特性曲线(receiver operating characteristic curve, ROC曲线)如图5所示。

图5 FAR与FRR的ROC曲线

Fig.5 The ROC curve of FAR and FRR

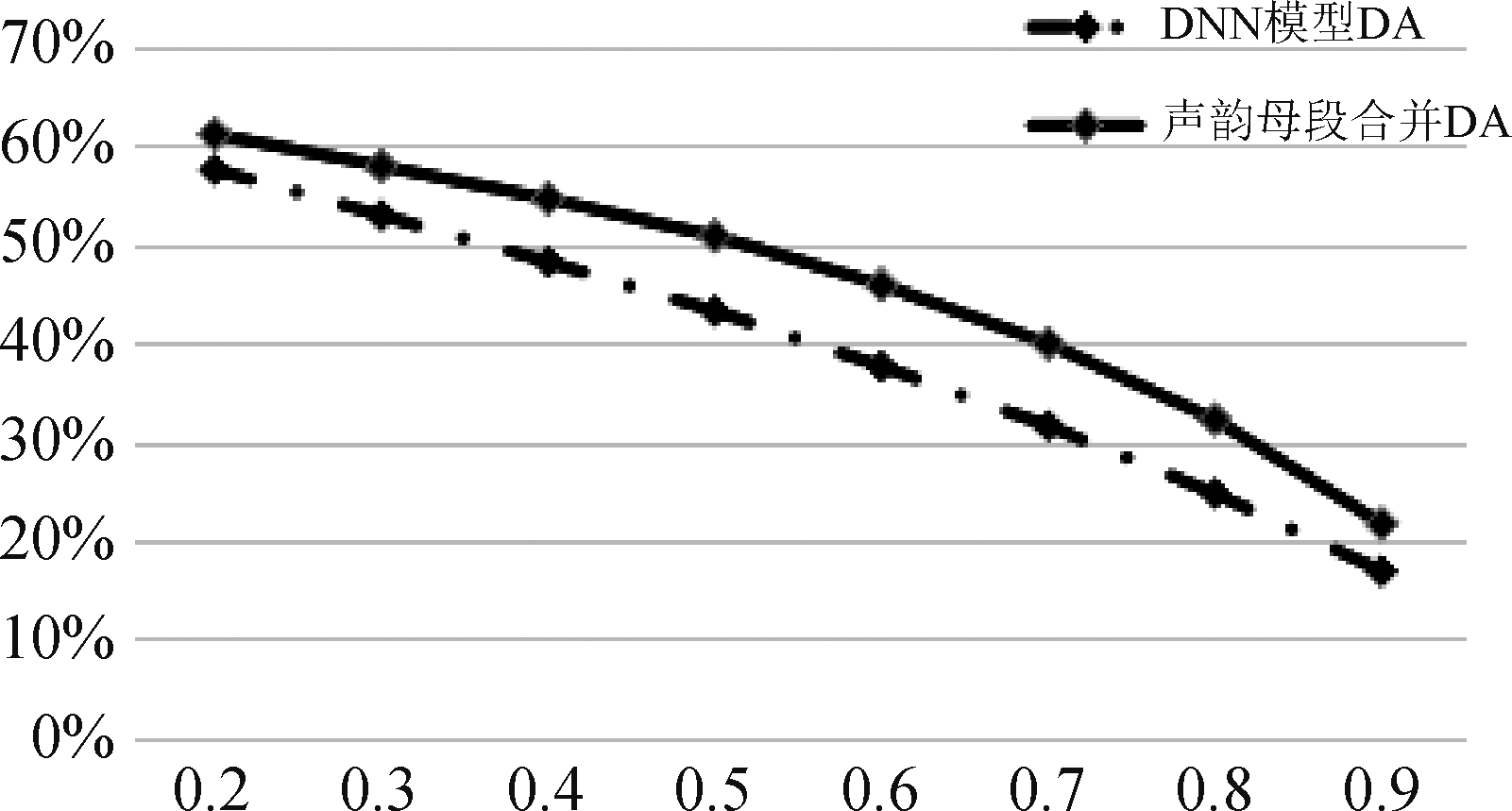

由上图可见,在对错判断的任务上,由于GOP对模型的后验概率比较敏感。当模型出现几帧的偏差时,对应音素的GOP就会受到很大的影响。而方法二,不依赖于模型输出边界,后验概率相加的方法对于方法一有较好的提升。对于偏误检测任务来说,一般采用母语者语料训练对齐模型。 而二语者语料用其对齐的时候,由于具有偏误所以文本和说话内容有一定的偏差。方法二在一定程度上弥补了这种偏差。 以上两种方法的DA如图6所示。

图6 不同计算边界的DA曲线

Fig.6 The DA of different align methods

由图6来看方法二相较于方法一在DA上同样有一定的提升。

4.2 声韵母约束扩展识别网络框架下偏误检测结果

由于声韵母约束扩展识别网络是在解码中输出模型解码的最优路径。在判断发音正误的任务上,当模型的识别结果和发音文本不一致并且对应的标注文本标注为偏误时,就可认为成功检测出了偏误。实验结果为 FAR=29.2%,FRR=22.9%,DA=76.6%。

4.3 无标注经验汉语母语者标注结果

本实验中让一位汉语母语者通过听语料,在Praat中标注二语者汉语发音中声韵母是否偏误。实验结果为 FAR=69.9%, FRR=2.9%, DA=84.5%。

4.4 实验结果对比分析

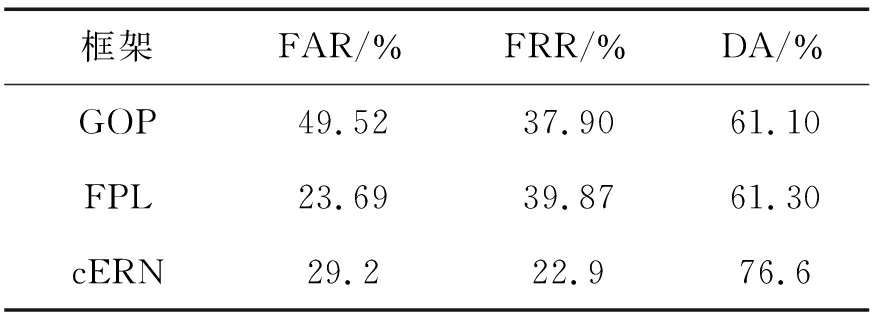

针对FAR,FRR,DA这三个评价指标,取GOP的DA最大时的阈值,同时在本实验中我们对比了全音素识别(free phone loop, FPL)的语言模型、GOP方法以及本文提示的声韵母约束扩展识别网络(cERN)。三个实验的结果如表3。

表3 GOP方法与不同的识别网络检测结果

Tab.3 The result of GOP and different network

框架FAR/%FRR/%DA/%GOP49.5237.9061.10FPL23.6939.8761.30cERN29.222.976.6

GOP由于是通过阈值来判断发音的对错,所以对后验概率较为敏感。而扩展识别网络是经过了解码网格找最优路径,他不会受到音素边界的影响,也减少了普通语音识别的插入删除错误。所以就判断发音对错的任务而言,对比二者的DA,扩展识别网络的偏误检测结果要优于GOP偏误检测结果。通过对比全音素识别网络和扩展识别网络,我们发现,在加入字数约束和声韵母交替的规则后,DA提升了15.3%。

表4 Gao的方法与声韵母约束扩展识别网络(cERN)对比结果

Tab.4 The result of Gao and cERN

框架FAR/%FRR/%DCF/%Gao6.735.921.3cERN29.623.626.6

Gao[9]的方法和本文采用相同结构的声学模型,在解码时将易错音素的混淆对的扩展识别网络。相对于原本的音素识别模型,对解码的候选路径进行了裁剪。只将和目标音素易混淆的音素加入候选序列。

表4是与Gao在相同的测试集下,top16的对比,其采用二语者语料训练和测试模型。语料训练集测试集相对接近,可以看到本实验模型在FRR上要优于Gao的模型,并且在集外的语音,全音素识别的检测代价(DCF)只提高了5.3%。

表5 无经验标注员与声韵母约束扩展识别网络(cERN)对比结果

Tab.5 The result of untrained annotator and cERN

框架FAR/%FRR/%DCF/%无经验69.92.936.4cERN29.623.626.6

由表5可知无经验标注员漏标率在69.9%,这表示其将大部分的错误发音认为是正确的。挑错能力是低于扩展识别网络框架的,扩展识别网络的错误率的DCF低于无经验标注员9.8%。此实验表明普通汉语母语者对于外国人的汉语发音偏误检测较为宽容,很多错误不会指出所以FAR会很高,机器相对较为公正。但是相对于人工,机器的判断会出现误判(FRR)较高,在实际的使用中可以结合两者进行学习。

5 结论

为了准确检测二语者的发音偏误,本文对比了GOP方法和声韵母约束的扩展识别网络的方法。在计算GOP的过程中,采用了两种计算音素边界的方法。一种是通过DNN模型的输出的音素边界来计算GOP,另一种是本文提出的直接通过后验概率,找声韵母段后验概率的方法来计算GOP。实验结果表明,相较于前者,直接找声韵母段可以弥补一定的由于二语者发音的文本和语音不匹配而对应的对齐错误。在两种GOP的计算方法中,本文提出的对齐方法在DA上要优于模型输出的边界方法。本文进一步实验了使用汉语声韵母交替以及发音字数的规则改进的扩展识别网络。实验表明声韵母约束的扩展识别网络的方法要优于GOP方法,其错误拒绝率为22.9%,错误接受率为29.2%,诊断正确率为76.6%。并且在全音素检测的任务上虚报要低于Gao的方法。进一步对比无标注经验的汉语母语者的挑错能力。结果表明机器的挑错能力要优于人工。未来会进一步探究结合人工以及机器的学习模式,以及探究减少音素对齐对于GOP偏误检测能力的影响。

[1] Luo D, Zhang Chunxiao, Xia Linzhong, et al. Factorized Deep Neural Network Adaptation for Automatic Scoring of L2 Speech in English Speaking Tests[C]∥Interspeech, 2018: 1656-1660.

[2] Yoon S Y, Hasegawa-Johnson M, Sproat R. Automated pronunciation scoring using confidence scoring and landmark-based SVM[C]∥Tenth Annual Conference of the International Speech Communication Association, 2009.

[3] Li Wei, Li Kehuang, Siniscalchi S M, et al. Detecting Mispronunciations of L2 Learners and Providing Corrective Feedback Using Knowledge-Guided and Data-Driven Decision Trees[C]∥Interspeech, 2016: 3127-3131.

[4] Nicolao M, Beeston A V, Hain T. Automatic assessment of English learner pronunciation using discriminative classifiers[C]∥2015 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2015: 5351-5355.

[5] Truong K P, Neri A, Cucchiarini C, et al. Automatic pronunciation error detection: an acoustic-phonetic approach[J]. NLP and Speech Technologies in Advanced Language Learning Systems,2004.

[6] Xie Yanlu, Hasegawa-Johnson M, Qu Leyuan, et al. Landmark of Mandarin nasal codas and its application in pronunciation error detection[C]∥2016 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2016: 5370-5374.

[7] Niu Chuanying, Zhang Jinsong, Yang Xuesong, et al. A study on landmark detection based on CTC and its application to pronunciation error detection[C]∥Asia-Pacific Signal and Information Processing Association Annual Summit and Conference (APSIPA ASC), 2017. IEEE, 2017: 636- 640.

[8] Gales M J F. Maximum likelihood linear transformations for HMM-based speech recognition[J]. Computer Speech & Language, 1998, 12(2): 75-98.

[9] Gao Yingming, Xie Yanlu, Cao Wen, et al. A study on robust detection of pronunciation erroneous tendency based on deep neural network[C]∥Sixteenth Annual Conference of the International Speech Communication Association, 2015.

[10] Hu Wenping, Qian Yao, Soong F K, et al. Improved mispronunciation detection with deep neural network trained acoustic models and transfer learning based logistic regression classifiers[J]. Speech Communication, 2015, 67: 154-166.

[11] Huang Hao, Xu Haihua, Hu Ying, et al. A transfer learning approach to goodness of pronunciation based automatic mispronunciation detection[J]. The Journal of the Acoustical Society of America, 2017, 142(5): 3165-3177.

[12] 张劲松, 高迎明, 解焱陆. 基于dnn的发音偏误趋势检测[J]. 清华大学学报:自然科学版, 2016, 56(11): 1220-1225.

Zhang Jinsong, Gao Yingming, Xie Yanlu. Mispronunciation tendency detection using deep neural network[J]. Journal of Tsinghua University: Science and Technology, 2016, 56(11): 1220-1225.(in Chinese)

[13] Kim Y, Franco H, Neumeyer L. Automatic pronunciation scoring of specific phone segments for language instruction[C]∥Fifth European Conference on Speech Communication and Technology, 1997.

[14] Kaplan R M, Kay M. Regular Models of Phonological Rule Systems[J]. Computational Linguistics, 1994, 20(3): 331-378.

[15] Harrison A M, Lo W K, Qian X, et al. Implementation of an extended recognition network for mispronunciation detection and diagnosis in computer-assisted pronunciation training[C]∥International Workshop on Speech and Language Technology in Education. 2009.

[16] Lee A, Chen N F, Glass J. Personalized mispronunciation detection and diagnosis based on unsupervised error pattern discovery[C]∥2016 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2016: 6145- 6149.

[17] Qian Xiaojun, Soong F K, Meng H. Discriminative acoustic model for improving mispronunciation detection and diagnosis in computer-aided pronunciation training (CAPT)[C]∥Eleventh Annual Conference of the International Speech Communication Association, 2010.

[18] Huang Guimin, Ye Jing, Sun Zhenglin, et al. English mispronunciation detection based on improved GOP methods for Chinese students[C]∥2017 International Conference on Progress in Informatics and Computing (PIC). IEEE, 2017: 425- 429.

[19] Kyriakopoulos K, Knill K, Gales M. A Deep Learning Approach to Assessing Non-native Pronunciation of English Using Phone Distances[C]∥Interspeech 2018, 2018.

[20] Lin Ju, Li Wei, Gao Yingming, et al. Improving Mandarin tone recognition based on DNN by combining acoustic and articulatory features using extended recognition networks[J]. Journal of Signal Processing Systems, 2018, 90(7): 1077-1087.

[21] 李华, 屈丹, 张文林, 等. 结合全局词向量特征的循环神经网络语言模型[J]. 信号处理, 2016, 32(6): 715-723.

Li Hua, Qu Dan, Zhang Wenlin, et al. Recurrent Neural Network Language Model with Global Word Vector Features[J]. Journal of Signal Processing, 2016, 32(6): 715-723.(in Chinese)

[22] Witt S M, Young S J. Phone-level pronunciation scoring and assessment for interactive language learning[J]. Speech Communication, 2000, 30(2-3): 95-108.

[23] Cao Wen, Wang Dongning, Zhang Jinsong, et al. Developing a Chinese L2 speech database of Japanese learners with narrow-phonetic labels for computer assisted pronunciation training[C]∥Eleventh Annual Conference of the International Speech Communication Association, 2010.