1 引言

视频,图像以及音乐等多媒体数据(多媒体数据是多种信息的传递媒介,一般包括文本,声音和图像等多种媒体形式)作为传达信息的媒介,充斥着我们的日常生活。而近几十年中,在相关领域的研究[2,23,27,31]也取得了很大的进展,然而,就目前所流行的一些与探究视听之间匹配关系相关的各种方法[7,26,30]而言,其共同点是过分依赖元数据(例如关键字,标题或描述),通常基于元数据的方法或系统需要为每个数据项单独编写对应的元信息,这对于大规模数据集而言是不切实际的。而且,在这种情况下,一些冷门的多媒体数据的相关元信息往往难以获得。其次,基于元数据的方法通常采用的映射函数较为生硬和死板,使用的是硬编码机制,这往往使得该方法无法被广泛应用。

因此本文提出了一种基于内容的音视频跨模态检索的方法,仅利用从音乐或视觉数据本身所派生的基于内容的信息,实现了为给定视频匹配相应的合适音乐的任务。研究的关键在于,首先,设计一个不需要元数据和硬编码映射函数的跨模态检索模型。其次,获得包含成对的匹配好的视频和音乐的数据库,这对需要学习大量数据的神经网络模型非常重要。第三,视频和音乐之间的匹配标准比其他跨模态任务(例如图像到文本的检索)的标准更加模糊。首先必须获得大规模的视频-音乐的数据集,这样便可以将数据输入深度神经网络,学习视频和音乐之间的对应关系。主要从以下两个方式获得相关数据:1.从视频网站下载包含背景音乐的视频,并通过分轨得到视频和音频的匹配参考标准(ground truth),再对这些数据进行人工标注;2.从被用于分类任务的视频数据库和音乐数据库中下载数据,本文所下载的视频和音乐数据分别来自Youtube- 8M[1]和MER31K[13],直接利用这些数据库自带的类别信息作为标签,并邀请具有相关专业背景的老师为视频和音乐进行匹配,匹配的视频和音乐共用一个类别标签,以此作为参考标准。具体而言,该方法主要有以下几个创新点:

1)特征选择。在长短时记忆网络和inception卷积神经网络的基础上引入注意力机制,对提取的音乐和视频帧的特征数据进行打分,选出s个具有代表性的音频和视频数据块,用该模型所选择的特征数据进行后续的训练,减少冗余数据,提高训练效率。

2)样本挖掘。在利用损失函数对数据进行训练之前,针对相应的样本对的数据集合进行结构优化,因为大多数样本对或者样本三元组的信息量是很小的,若不做任何针对性的优化,模型无法收敛,训练效率低,且容易过拟合。

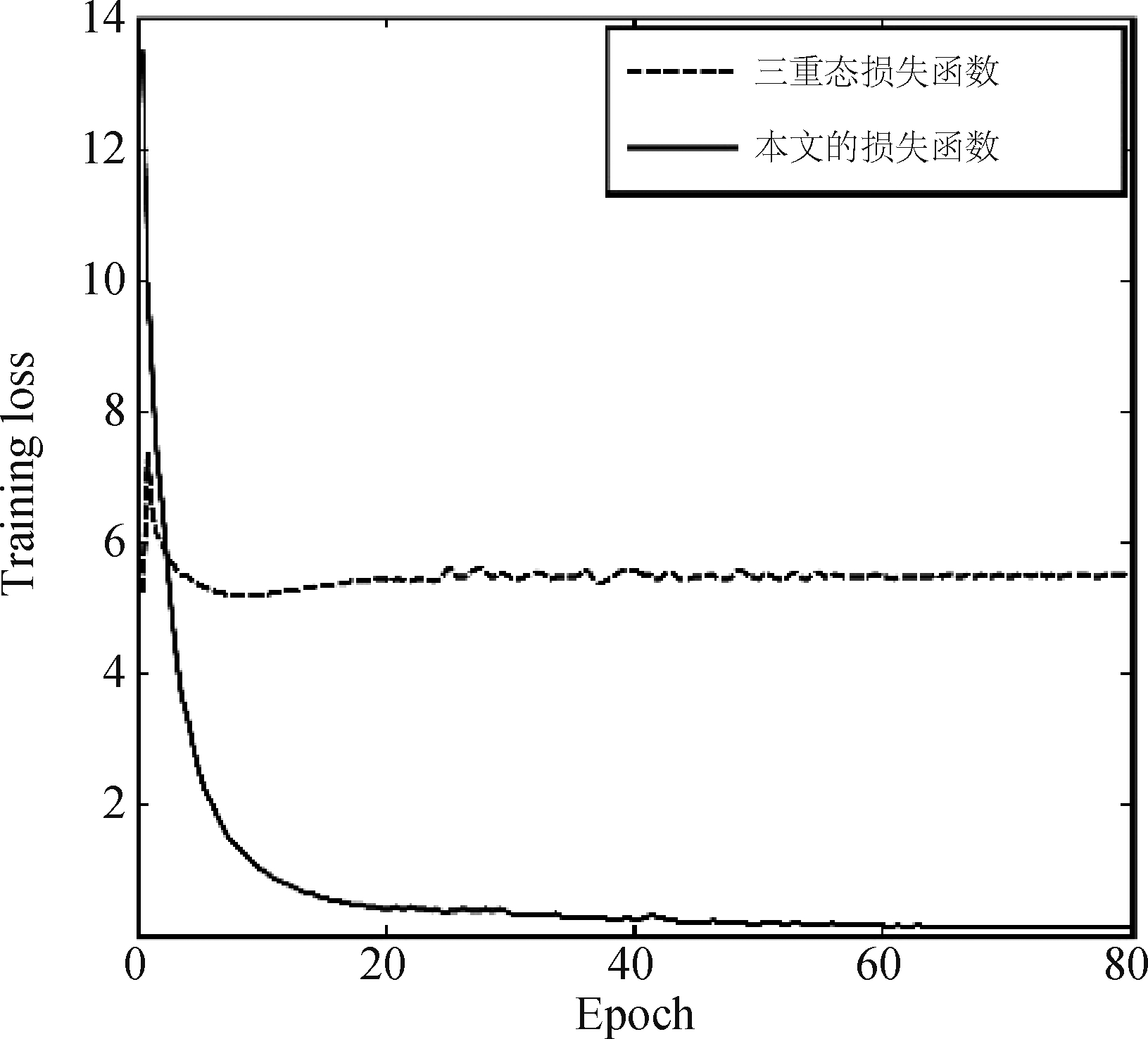

3)损失函数的应用。摒弃了传统的用于计算模态间相似性的三重态损失函数,采用了效果更好的模态间相似度排位损失函数。实验证明该损失函数的效果优于三重态损失函数。

2 相关研究

Libeks[16]等研究者针对音乐分类的任务提出了一个框架,该框架提取音乐专辑封面的颜色和纹理等基于内容的图像特征来分析并预测音乐类型,结合从音乐视频中提取的颜色和情感特征共同用于实现音乐流派的分类[29]。为了实现图像与音乐的匹配,Yu Yi[21]等人将音乐中的歌词用作中间媒体(即元数据)并应用典型相关性分析(CCA)。Yipin[8]通过使用效价-唤醒平面(valence-arousal planet)提出了一种单向视频到音乐推荐。

近些年许多跨模态相关任务也开始使用神经网络的方法[9,11-13,19]。从模型结构的角度来看,我们的方法类似于图文检索中常用的双分支神经网络。早期的图文跨模态匹配的研究都是在MSCOCO[10]和Flickr30K[32]这两个数据库上进行的,数据集中的每个图像都有五句独立的描述。他们使用相应的损失函数学习模态数据在公共嵌入空间的线性关系。为了更好地理解视觉和文本模态之间的关系,与神经网络相关的方法开始流行。由于神经网络能够学习模态间的非线性关系使得模型效果有了更好的提升。其中,Acar[7]等人的模型与本文的方法相关。他们提出了基于音乐视频情感标签的框架,并利用卷积神经网络从低级视听特征中学习了更高级的非线性特征表达。但是,与本文模型不同,仅将深度网络结构用作音乐和图像的中级特征提取器,而非学习模态数据间的关系。

3 方法模型

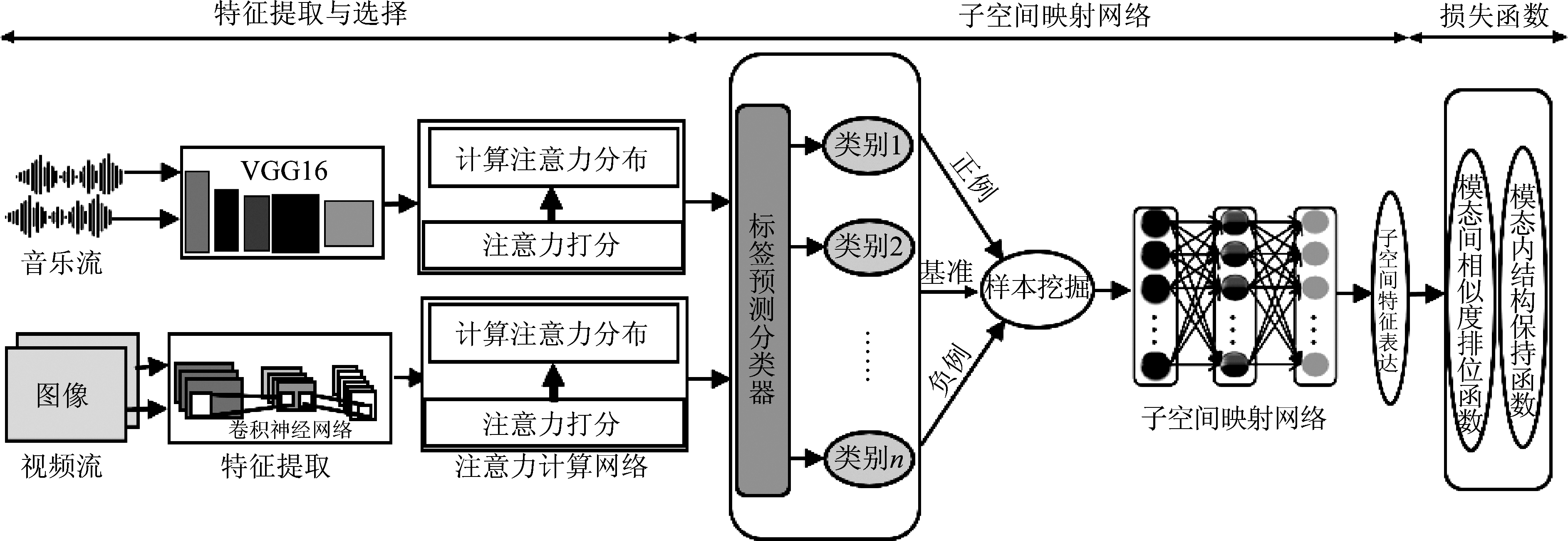

本文所提出的模型利用深度神经网络学习视频和音乐之间存在的潜在对应关系,从而通过视频-音乐跨模态检索的方式实现了为特定视频匹配相应的音乐的任务。框架结构如下图1所示,根据各部分的功能,将整体分为特征提取,嵌入网络,以及训练过程中所用到的损失函数三个部分。

3.1 特征的选择

音乐特征 首先介绍音乐特征选择模型。输入一段音乐信号后,以每秒一帧的速度由VGG网络计算并提取音乐的每一帧的特征。通常认为连续的音频片段具有共同的属性[28],例如情感属性。将所得到的音频特征序列平均分为相同长度的t个数据块,并计算每个数据块的情感信息,对比选出音频数据块中情感属性最强的s个,代表整段音频特征数据用来进行后续的训练。

该模型可以分为具有双向扩展的长短时记忆(LSTM)网络具体的计算公式如下和基于注意力的计算层两部分。LSTM模型包含自循环,可以长时间保持梯度流动。自循环中的权重根据上下文信息进行更新,并且可以根据输入顺序由LSTM结构的四节点进行动态更新:

1)输入单元将根据输入向量xi和隐藏状态单元ht-1进行状态更新,计算公式如下:

st=σ(bi+Wxixt+Whiht-1+Wcict-1)

(1)

2)细胞单元ct状态更新的计算公式如下

ct=ftct-1+ittanh(Wxcxt+Whcht-1+bc)

(2)

3)失忆单元对上一个节点ct-1传进来的输入信息进行控制,决定哪些需要保留哪些需要舍弃:

ft=σ(bf+Wxf xt+Whf ht-1+Wcf ct-1)

(3)

4)输出单元的计算公式如下:

ot=σ(Wxoxt+Whoht-1+Wcoct+bo)

(4)

ht=ottanh(ct)

(5)

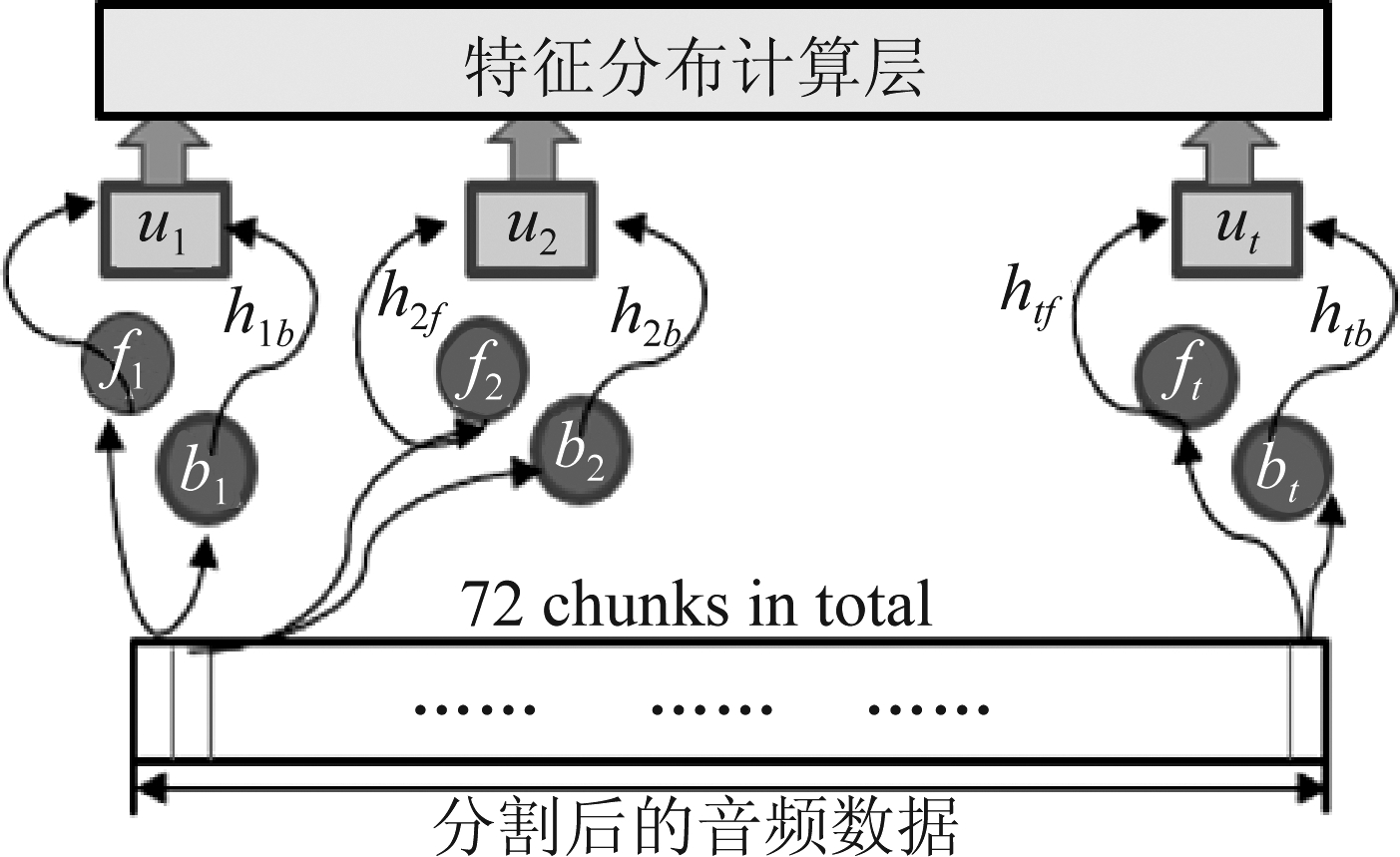

公式中的xt表示此刻的输入向量,ht-1表示前一时刻的隐状态,W和b分别为权重和偏置矩阵。在本文中,音乐的特征数据被分割为t个数据块,每个数据块包含等量的音乐帧特征数据。将数据输入特征选择模型后,先通过LSTM网络,得到了相应的特征信息,再输入注意力计算层,以此来分析每个数据块的特征分布情况。注意力计算层由双层的神经网络构成,结构如图2所示。

图1 模型的整体框架

Fig.1 Framework of the proposed method

图2 注意力计算网络层

Fig.2 The structure of neural attention computation layer

第一层网络的激活函数为输入的特征进行“打分”,输出的分值可以视作该部分数据的特征集中度,因此也可以称之为打分函数,具体的计算公式如下:

ut=WTtanh(Wf htf+Wbhtb+β)

(6)

式中的htf和htb分别为LSTM网络的前向和后向输出向量,WT,Wf,Wb和β为打分函数的权重参数。第二层使用softmax函数,将对应的分数转化为(0,1)区间中的值,作为最终衡量各数据块的特征集中度的标准,挑选出那些特征分布最为集中的数据块,提高实验的准确度。

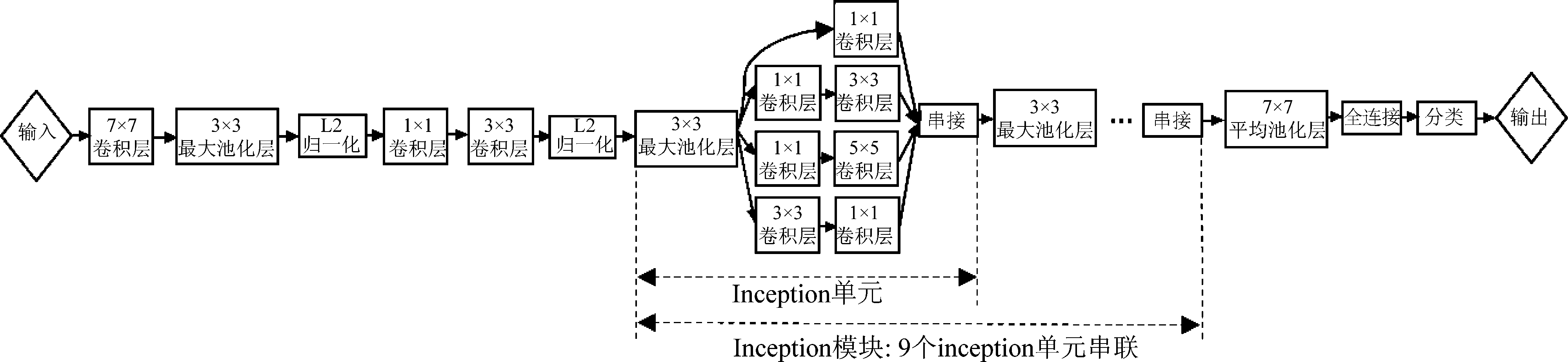

视频特征 本文所采用的视觉特征提取网络是名为inception[15]的神经卷积网络模型。Inception模型广泛用于图像识别任务中,可以在ImageNet数据集上达到较高精度,是近来用于视频特征提取的常用方法。在本文中,将预处理视频输入Inception模型,输出的是每一帧的视频特征。首先模型将会以每秒一帧的速度对每个视频进行解码,这些解码后的视频数据将被馈送到Inception网络,并在到达预测输出层之前的最后一个隐藏层中采用ReLU激活函数进行计算。最终输出的每个视频帧的特征向量为2048维。之后,使用PCA[6]的方法,通过量化计算将每帧的特征维度减小到1024,模型结构如图3所示。

而视频的特征选择模型在inception网络的基础上叠加了注意力计算机制,区别主要有以下两点:首先,模型在数据预处理阶段将连续的视频帧分割为固定长度的数段,与上述的音乐数据预处理相同。其次,模型将原本inception网络的平均池化层的输出作为注意力机制层的输入来为每一段数据块赋予相应的权重。改进后的模型结构如下图4所示,所采用的注意力计算机制与音乐部分的相似,在功能上也是一致的。注意力机制的第一层所采用的激活函数为:

uν=WTtanh(Wnvtn+θ)

(7)

式中vtn代表第n段视频数据块经过平均池化层计算得到的输出,WT,Wn和θ为打分层函数的权重参数,uν表示注意力打分层的输出,将分数uν输入注意力分布计算层,经过softmax函数的计算,得到了注意力分布:

α=softmax(uν)

(8)

最终的特征分布预测结果:

(9)

式中,oc代表全连接网络层经过分类层计算后的输出,αc代表注意力分布计算层的输出,![]() 代表最终的视频特征分布输出。

代表最终的视频特征分布输出。

经过模型的筛选得到特征集中度较高的数据后,应用特征聚合以及全局归一化的方法,该过程从所有特征向量中减去均值。最后,利用L2归一化的方法获得视频的全局特征。

3.2 嵌入网络

通过上述的特征选择模型提取出音乐和视频各自的特征数据后,为了能够对两种不同模态的数据进行对比和学习,故而设计了嵌入网络,其目的是将音乐和视频的特征向量通过神经网络计算并映射进同一个公共特征空间,也可称之为嵌入空间。

图3 inception网络结构

Fig.3 Structure of inception network

图4 视频特征选择网络

Fig.4 Visual feature selection model

这样便使得跨模态数据得以在同一特征空间中进行比较。该部分主要由标签预测分类器,样本挖掘网络,以及特征映射网络组成。

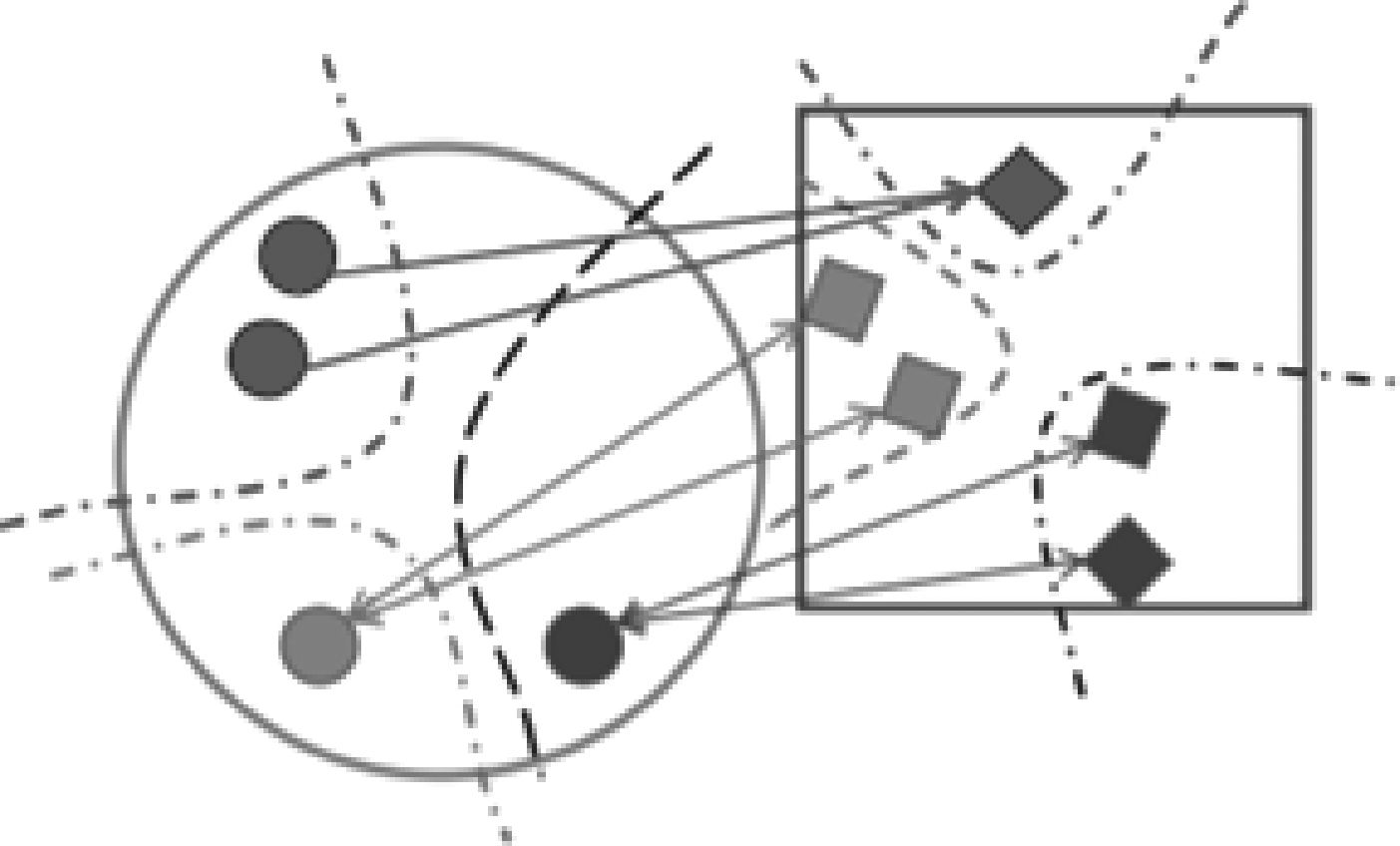

标签预测分类器 为了确保两模态的数据在被映射到公共子空间中进行比较时能够尽量实现“同近异远”,即相似的两模态数据在子空间中的距离相近,而相异的距离远,在设计嵌入网络时考虑加入一个类似分类器的标签预测网络,目的是使得各模态数据能够在公共空间中依旧具备各自的语义信息(如图5),保持语义判别性,使得子空间中的跨模态数据可以在同类内互相匹配,不同类内之间也可以对差异性进行比较,在保证匹配准确度的同时,使得匹配结果更加灵活和多样。

图5 模态特征被映射到子空间内

Fig.5 Illustration of label prediction

在子空间嵌入网络中加入分类器网络,其结构实质上为以softmax作为激活函数的前馈网络。该分类器将提取的音乐和视频特征作为输入的训练数据,并生成每项数据的语义类别的概率分布作为输出。下式为训练分类器所用的模态内语义判别损失函数:

(10)

Llp表示这个语义分类模型的多分类交叉熵,n代表每一批次训练的样本个数,yi指样本的标签信息,![]() 表示模型输出的概率,即类别为i的概率。

表示模型输出的概率,即类别为i的概率。

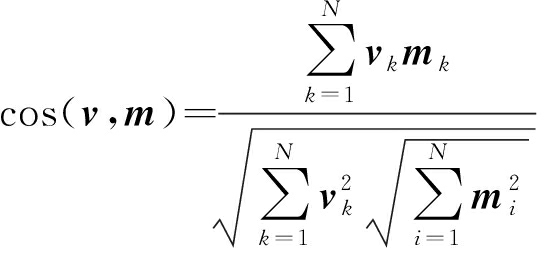

样本挖掘 在解释样本挖掘之前不得不谈到度量学习(metric learning)这一研究方法。度量学习具体就是利用合适的距离函数来优化一些采用了近邻思想的算法。而深度度量学习(deep metric learning)[14,17-18,24]是度量学习方法中的一种,与嵌入网络的学习联系紧密。对象被映射进嵌入空间的同时,距离函数(常用欧式或者cosine距离)训练子空间的所有样本,使得相似的对象在子空间的分布集中,相异的对象互相远离。故而深度度量学习的关键是合适的损失函数,通常,设计对应的损失函数需要结合具体的样本信息,比如样本对(pair)或者样本三元组(triplet)。但是往往在训练过程中构建的样本对数量特别大,会给数据的训练造成很大的负担,且样本对集合中也存在大量的无用样本,它们的信息量很小,在梯度上的贡献值几乎为0,因此需要针对这一情况进行优化,否则函数的收敛速度会很慢,且易陷入局部最优。

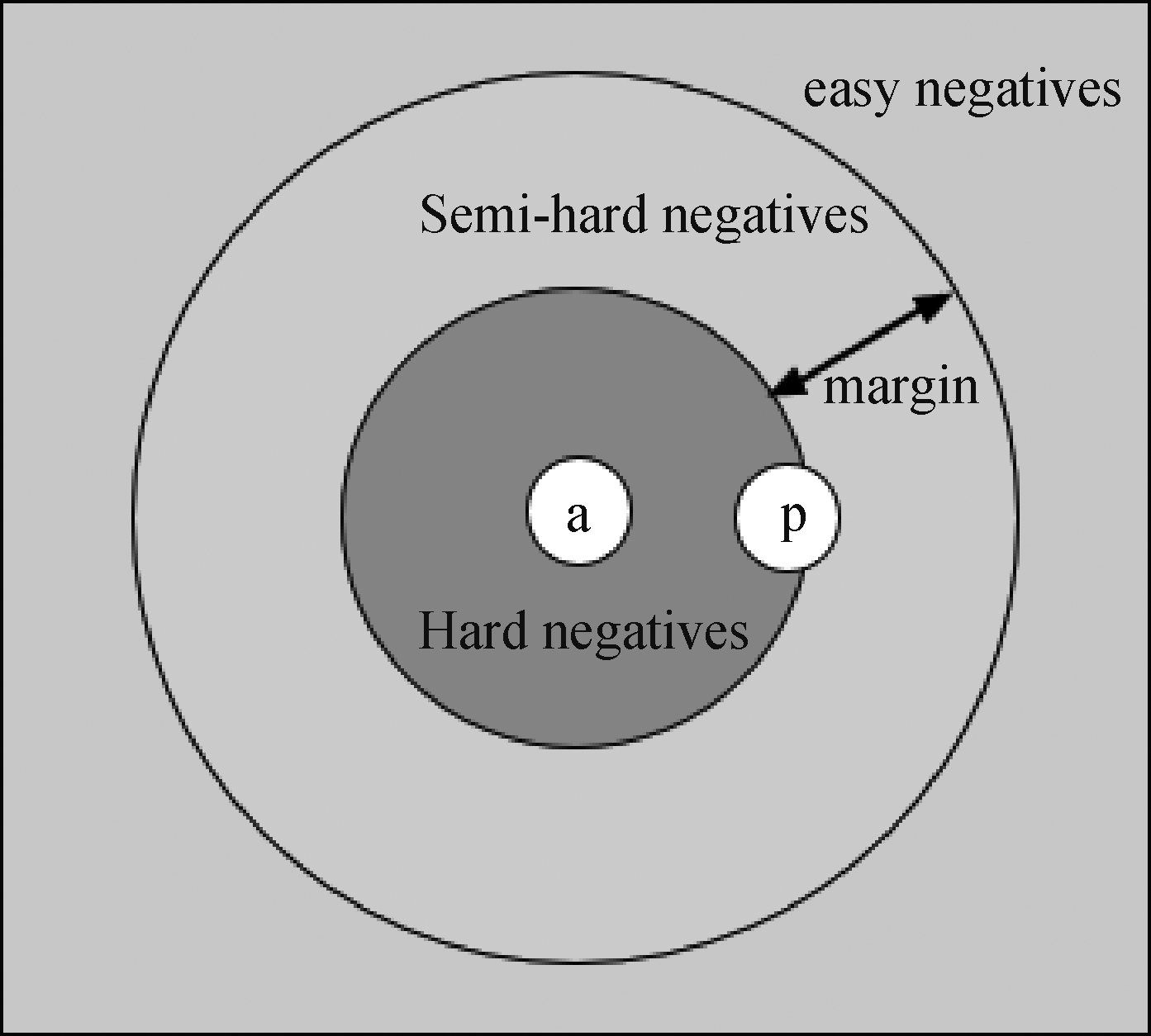

因此为了提高训练的效率,提高模型精度,本文在进行映射计算之前,使用了困难样本挖掘的方法,该方法加快了算法的收敛速度,提高了学习的效率。本文中,将每组的视频-音乐参考标准经过特征筛选和分类器的分类后,以所得到的视频特征表达为基准(anchor),与其同类的音频特征表达为正例(positive),不同类别的则为负例(negative)。在以基准和正负例组成的三元组中,根据样本空间中负例与基准间的关系,存在三种不同类型:简易(easy)、半困难(semi-hard)和困难(hard)三元组,距离关系见图6。简易三元组因为可以轻易被识别所以包含的信息量很少,所以本文将训练的重心放在了困难和半困难三元组上,因而本文所采用的困难挖掘策略就是剔除简易三元组,留下半困难和困难三元组样本进行训练,最终通过损失函数对样本空间的训练,使基准与正例在新的编码空间里相距很近,而基准与负例在新的编码空间里很远。本文中样本挖掘的具体做法就是将所有的训练数据输入神经网络,得到每一个训练样本的编码,根据编码计算得到基准与负例和基准与正例之间的距离,根据这个距离判断三元组的类型。计算公式如下:

(11)

L=max{0,m+cos(ψν,ψm+)-cos(ψν,ψm-)}

(12)

图6 三元组之间的位置关系

Fig.6 Illustration of triplet location

3.3 损失函数

从特征提取到特征映射,跨模态数据从原本各自的特征空间转移到了公共空间中。那么接下来要做的就是设计相应的度量学习损失函数对子空间中的数据进行训练。在对损失函数进行设计时考虑了两个方面。首先是模态间的相似性,其次是模态内的不变性。模态间相似性是我们实现跨模态匹配的理论基础,而模态内不变性需要确保子空间中的特征数据维持在原本各自的特征空间中的结构不变。倘若只考虑模态间的关系,会使得特征数据在训练过程中丢失各自模态内的特性,比如音乐中的节奏韵律以及视频画面中的亮度纹理。接下来将从模态间和模态内两个角度对损失函数进行介绍。

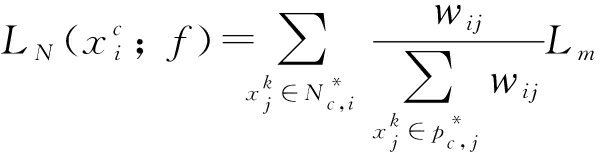

模态间相似度排位损失函数 三重态损失函数(triplet loss)[33]是此类任务中比较常用的函数。但是在实验的过程中,也发现了该函数的一些缺点。首先是训练时收敛速度慢的问题,这主要是因为构建的样本对集合中存在冗余信息,这些冗余样本对模型的训练毫无贡献。其次三重态损失函数在参数的更新迭代过程中,在每个三元组中只比较了一个负样本,忽略了大部分来自其他类别的负样本。因而,无法保证基准向量与尽可能多的负样本保持较大的距离,无法获得较高的准确率。所以本文中的损失函数对此进行了优化。

引入![]() 来表示训练样本集合,集合中的(xi,yi)表示样本和与之对应的标签信息。样本总共有c类,即

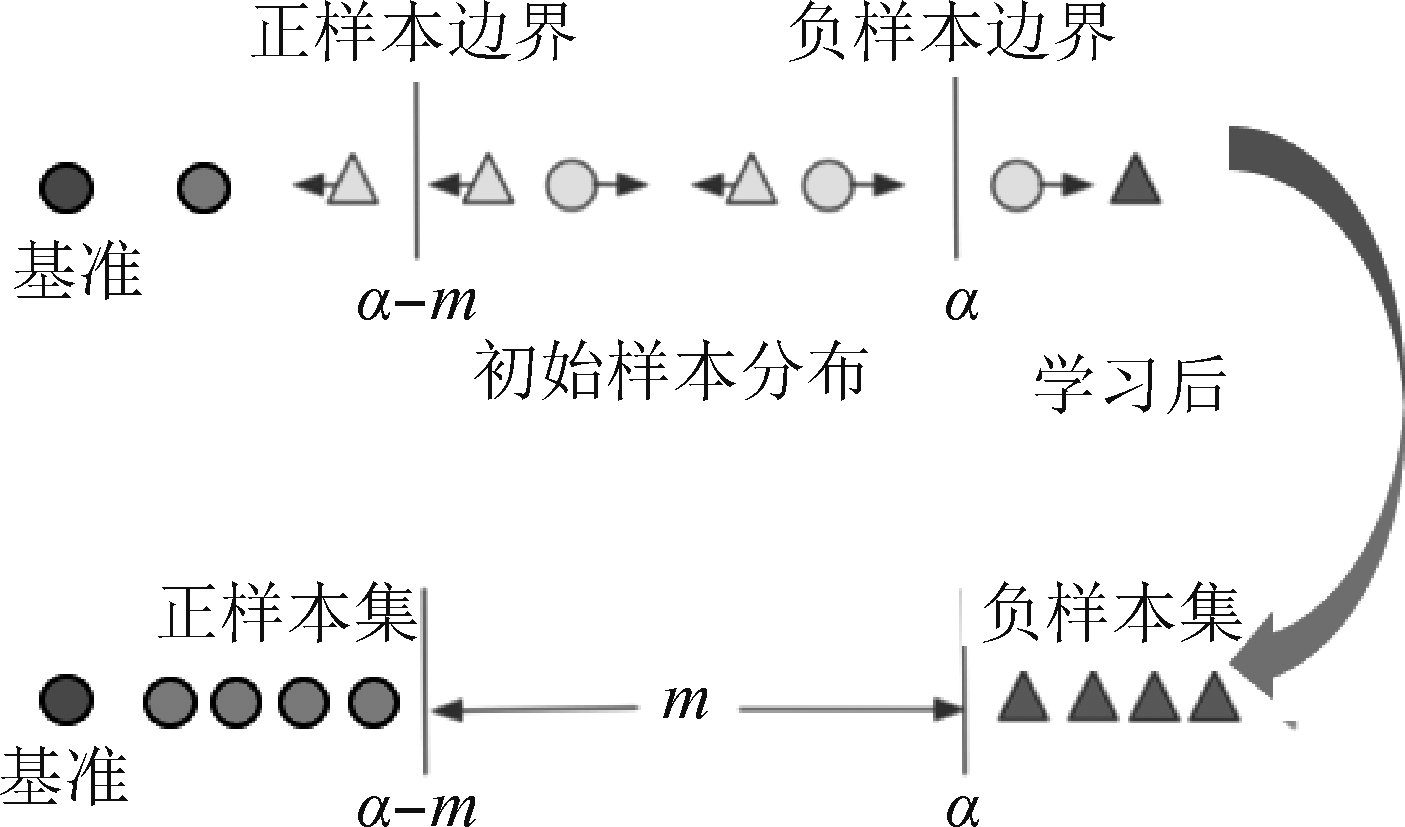

来表示训练样本集合,集合中的(xi,yi)表示样本和与之对应的标签信息。样本总共有c类,即![]() 代表所有样本。为了尽可能使正负样本分得开,令基准向量与负例之间的距离大于阈值α,且与正例之间的距离不超过α-m,即正负样本间距至少为m。因此需要设计相应的函数f,并通过训练使得正负样本在子空间的分布满足上述的距离关系。因此最大阈值损失函数定义如下:

代表所有样本。为了尽可能使正负样本分得开,令基准向量与负例之间的距离大于阈值α,且与正例之间的距离不超过α-m,即正负样本间距至少为m。因此需要设计相应的函数f,并通过训练使得正负样本在子空间的分布满足上述的距离关系。因此最大阈值损失函数定义如下:

Lm=(1-yij)[α-dij]+yij[α-m]

(13)

其中,当yi=yj时, yij=1,否则yij=0,dij表示f(xi), f(xj)之间的欧氏距离。

该损失函数通过使用这样的采样策略使得正样本被聚集在一个半径大小为α-m的球体内,而负样本与正样本间隔m,如下图7所示。给定一个基准向量![]() 并根据相似度对其他样本进行排序。在这个排序结果中,有Nc-1个正样本,负样本个数为

并根据相似度对其他样本进行排序。在这个排序结果中,有Nc-1个正样本,负样本个数为![]() 每个基准与正样本集的距离越近越好,并且与负样本集之间存在着m的间隔,同时也希望anchor与负样本的距离大于边界α,因此,对于正样本损失函数为:

每个基准与正样本集的距离越近越好,并且与负样本集之间存在着m的间隔,同时也希望anchor与负样本的距离大于边界α,因此,对于正样本损失函数为:

(14)

对于负样本:

(15)

而整个损失函数定义为:

(16)

图7 损失函数训练后特征空间的结构变化

Fig.7 Feature distribution after training

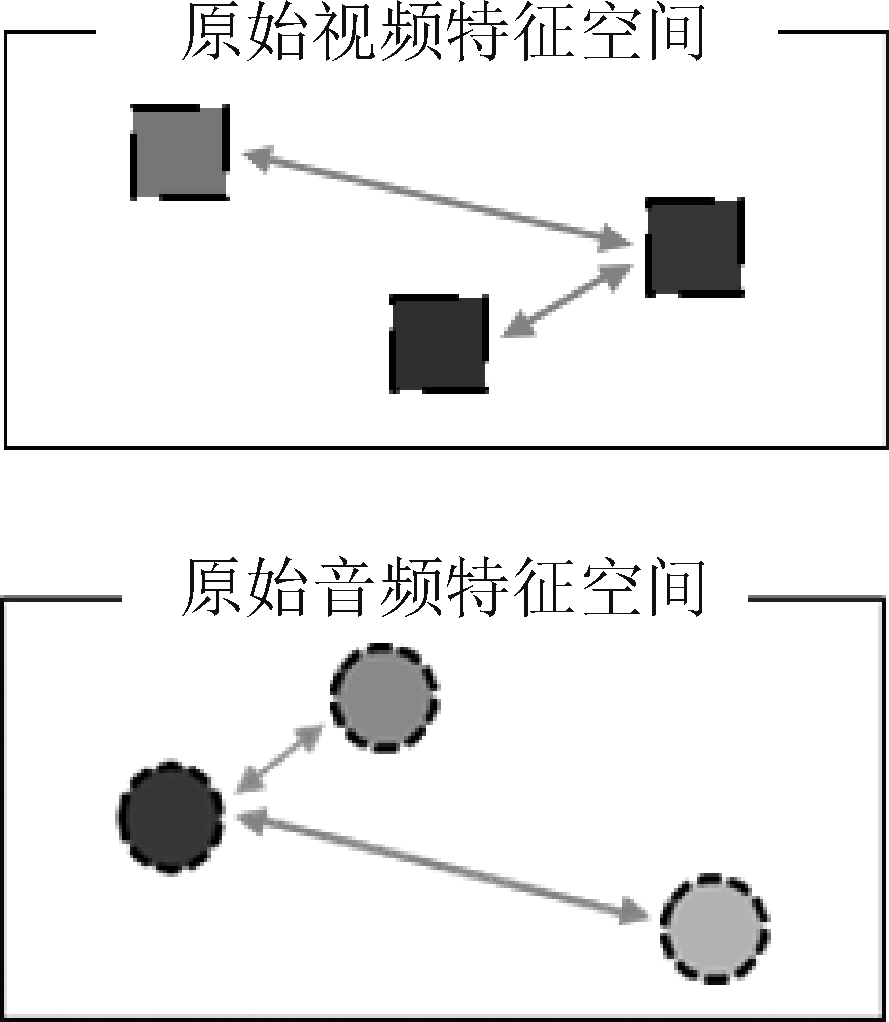

模态内结构保持函数 通常认为模态的特征数据在各自的特征空间中有不同的分布结构,如下图8所示,在视频特征空间内,相似的特征数据间距较近,而相异的则远。为了在训练过程中不至于丢失这些特性,导致实验准确度降低,引入了模态内结构保持损失函数。

图8 模态数据在原始特征空间内的分布

Fig.8 Feature distribution in original feature space

以音乐这一模态为例,既然要保持其模态内结构不变,那么特征数据应该满足以下关系:

d(mi,mj)<d(mi,mk),

(17)

式中mi,mj和mk分别代表子空间中的音乐特征数据。![]() 和

和![]() 表示未经映射前的音乐特征。但是考虑到视频和音乐它们之间的匹配关系是更加灵活的,所以本文并未直接使用基于最大阈值的距离损失函数,因此本文将损失函数表达式定义如下:

表示未经映射前的音乐特征。但是考虑到视频和音乐它们之间的匹配关系是更加灵活的,所以本文并未直接使用基于最大阈值的距离损失函数,因此本文将损失函数表达式定义如下:

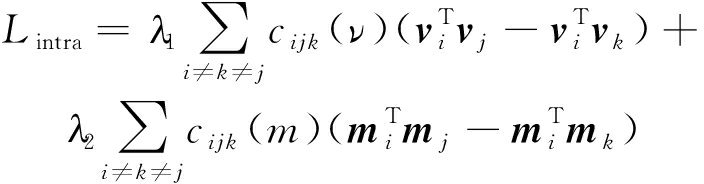

(18)

(19)

为了使得损失函数的约束更加灵活,引入了符号函数。xi,xj和xk分别为公共子空间中的特征数据,![]() 和

和![]() 表示未映射前的特征数据。而符号函数的特性可以避免因为使用基于欧式距离损失函数所导致的匹配结果死板单一的问题。

表示未映射前的特征数据。而符号函数的特性可以避免因为使用基于欧式距离损失函数所导致的匹配结果死板单一的问题。

最终,将模态间与模态内的损失函数结合在一起,形成了用来训练子空间样本数据的损失函数。在特征数据经过嵌入网络的映射后,样本数据互相结合为三元组的形式,进行训练。在这个过程中,构建出四种形式的三元组(νi,mi,mj),(mi,νi,νj),(νi,νj,νk)和(mi,mj,mk)。总的多模态训练损失函数定义为:

Lmulti-modal=λ1Linter+λ2Lintra

(20)

4 实验结果

4.1 数据集和实验评估标准

数据集的搜集和整理是本文工作的重点,因为本文所采用的深度学习方法需要大量数据对模型进行训练。在跨模态检索的相关任务中,与图文检索相关的数据集有很多,但是关于音乐与视频的跨模态检索数据集很少,因为数据集中需要建立对视频和音乐较为精准的匹配关系。目前能够找到并在上面进行了相关实验的数据集是VEGAS[8],该数据集包含28103个视频-音乐对,由相关研究者从YouTube- 8M[1]挑选相关视频下载,并将视频分轨,得到了训练所用的参考标准。但是该数据集的缺点是每个视频只有一首音乐与之匹配,使神经网络无法充分学习视频和音乐的对应关系。所以本文借鉴了该数据集的建设经验,建立了新的音乐视频跨模态匹配的数据集,一共包含7353个视频-音乐对。为了建立视频和音乐的对应关系,邀请有相关专业背景的老师和同学进行标注,在这个过程中,参考了图文检索的数据库FLICKR30K[32]的结构,给每一段视频帧标注五首音乐,每一组匹配的视频-音乐对共用一个类别标签,本文中共设置了10个类别标签,分别为愤怒、温柔、痛苦、振奋、滑稽、光明、快乐、焦虑、平静和温暖,并为了后续评估实验结果,按照视频和音乐的匹配度为每一首乐曲依次分配相应的权值p(0.45,0.25,0.15,0.1,0.05)。因为关于音视频跨模态检索的相关研究较少,所以目前并没有一个标准的评估方式,所以我们参考了一些相关文献,决定采用的评估标准为召回率(Recall K)和平均准确度(Mean Average Precision)。

召回率:召回率通常是图文检索中的实验评估标准,表示在用所有测试集数据进行实验时,利用每个视频进行查询并检索得到的前k个结果中至少包含一对参考标准的视频数量占总量的比率。

平均准确度:平均准确度与召回率不同的一点,在于该标准的计算方式综合考虑了所有的检索结果,其计算公式如下:

(21)

式中pj为考虑了音乐质量的权值,N表示与检索视频相关的同类音乐个数,rel(j)代表二值函数,当第j个音乐落在标注范围内则为1,否则为0。

4.2 相关参数与设置

为了验证模型效果,本文分别在VEGAS和自建数据集上进行模型的训练和测试。数据集按90%和10%的比例划分为训练集和测试集,再将训练集5等分,按照5-fold交叉验证法对模型的性能进行评估,分别进行五次实验,每次实验都取训练集中不同的一份作为验证集,直到所有5份都做过1次验证集,交叉验证的过程结束。验证集和训练集同时输入模型进行训练,并根据它们在训练过程中的表现,判断是否过拟合(验证集表现稳定后,若继续训练,训练集表现上升,但若验证集出现不升反降的情况,表示发生了过拟合)为了防止过拟合,本文采用了提前终止的方法,先记录下目前为止最高验证正确率,再进行10次Epoch的训练,验证集正确率没有达到最佳,此时停止迭代。实验的计算由英伟达GTX 1080 GPU完成,以五次实验结果的平均值作为模型评估标准,并在数据预处理阶段将音频和视频数据(长度在210~223 s的区间内)分割成每段等长的数据块,输入特征选择模型进行筛选。特征数据在分类器、样本挖掘和映射网络的共同作用下进入公共子空间,再由损失函数进行训练和调参。最后利用测试集来对模型效果进行评估,在输入视频后,系统将生成一个列出了对应音乐的列表文档,该文档即为检索结果,并根据结果计算召回率与平均准确率各自的均值。

实验中的一些参数:

1)网络参数:从特征选择模型中提取了高级特征后,在双流处理网络的视频端设置了两层全连接网络,分别包含2048和512节点。在音频端设置了三层全连接网络,分别有2048、1024和512个节点,使用的激活函数为sigmoid和tanh。在视频和音频数据输入损失函数网络层之前采取L2归一化的方法,以此解决音乐和视频特征之间数量比例的平衡问题并缓解过拟合。

2)实验参数:经过训练阶段的调试,为了平衡训练效率和结果的准确度,最优batch为550,epoch为40。

3)该方法使用学习速率为0.001的ADAM优化器,随即失活的概率为0.2。

4.3 实验结果分析

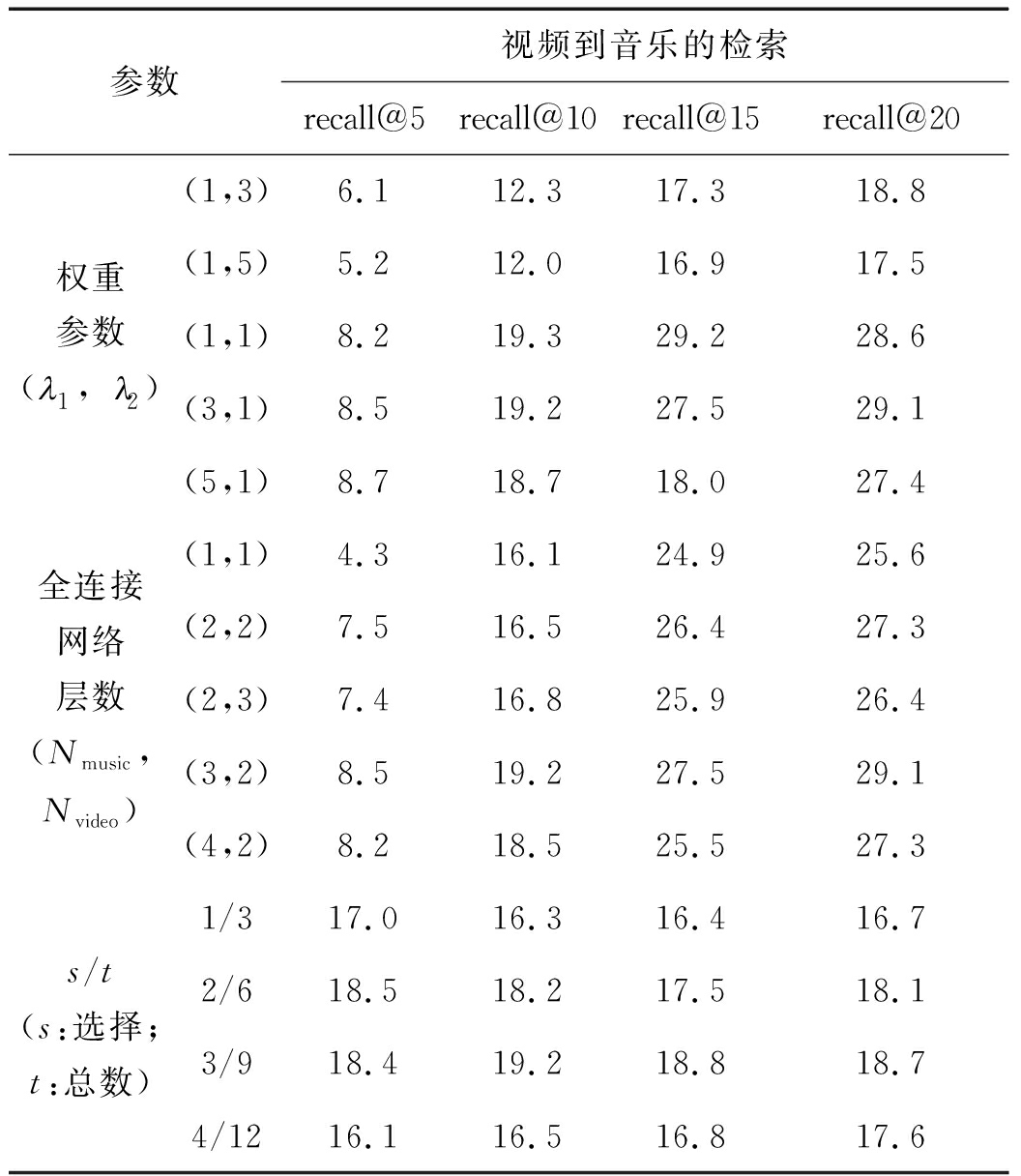

实验1 为了探究一些关键参数对于模型结果的影响,在训练模型的同时进行了相关的实验,结果如表1所示。实验设置了损失函数权重、全连接层数以及特征选择模型s/t值(s表示所选择的特征数据的个数,t代表特征分割的总数)三个变量,并且在对每个变量进行调整的同时保证另外两个变量不变。首先保持全连接层数(1,1)和s/t为1/3(表示将模态特征数据分割3段,选择其中1段)不变,调整损失函数的权重参数并记录模型的表现情况,发现如果令λ1的值高于λ2,模型的准确度会更高,但是λ1的值不能大于5,否则会使模型的表现会变差。

表1 参数对检索结果的影响

Tab.1 Retrieval results with respect to the key factors

然后改变嵌入网络中全连接层数,保持损失函数权重(1,1)和s/t为1/3不变,观察实验结果。如果只设置1层全连接网络,会使模型效果变差,这也证明较深的网络结构有助于提高实验准确度。并且随着网络层的加深,模型的表现越来越好。但是通过实验也可以得知,当模型的视频处理端全连接层数超过3层,训练将无法收敛,这也是网络过深容易导致的模型表现退化的情况。

最后为了探究特征选择模型中,所分割的数据总量t与选择的数据量s之间的关系对模型的影响,做了相关实验,同样保持权重(1,1)和全连接层数(2,2)不变。在实验过程中保持s/t不变,增加s和t的数量,在一定范围内可使模型的表现得到提高,但当s增加到12,实验结果未得到提升。通过实验1得到的最优参数配置为:损失函数权重(1,1),全连接层数(3,2),s/t值为3/9。

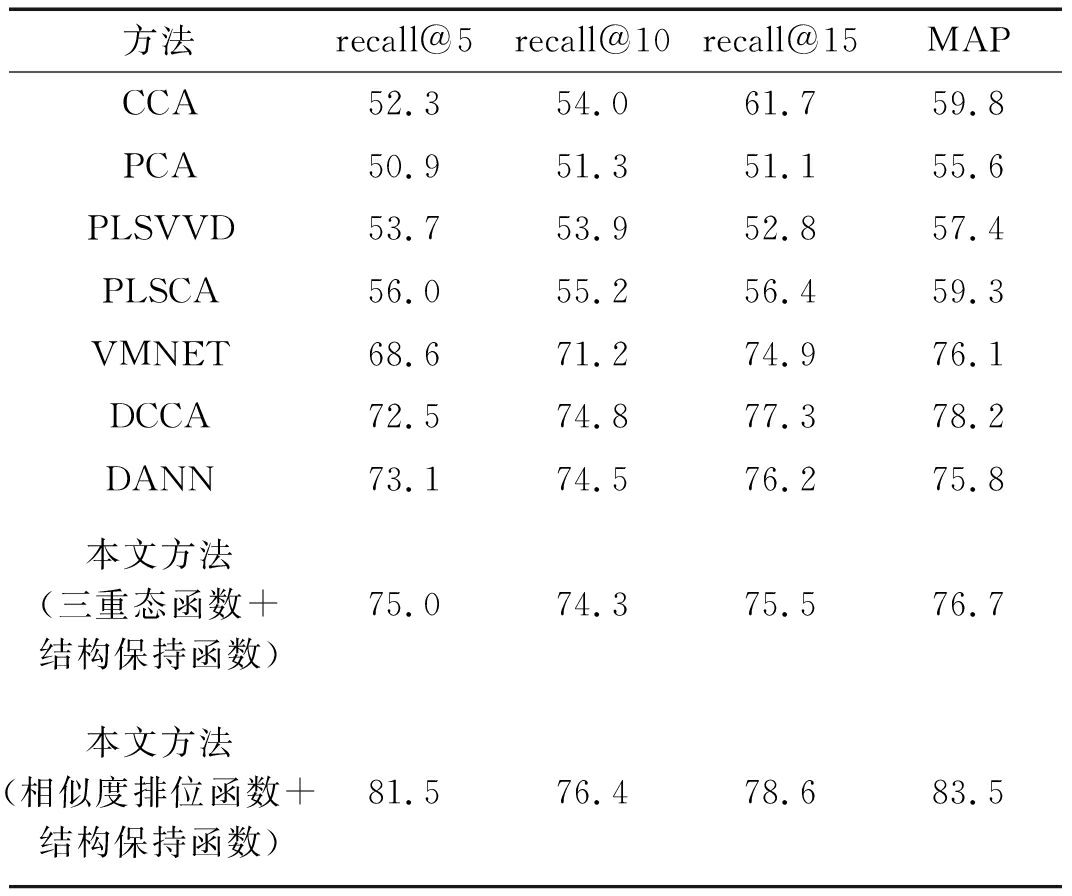

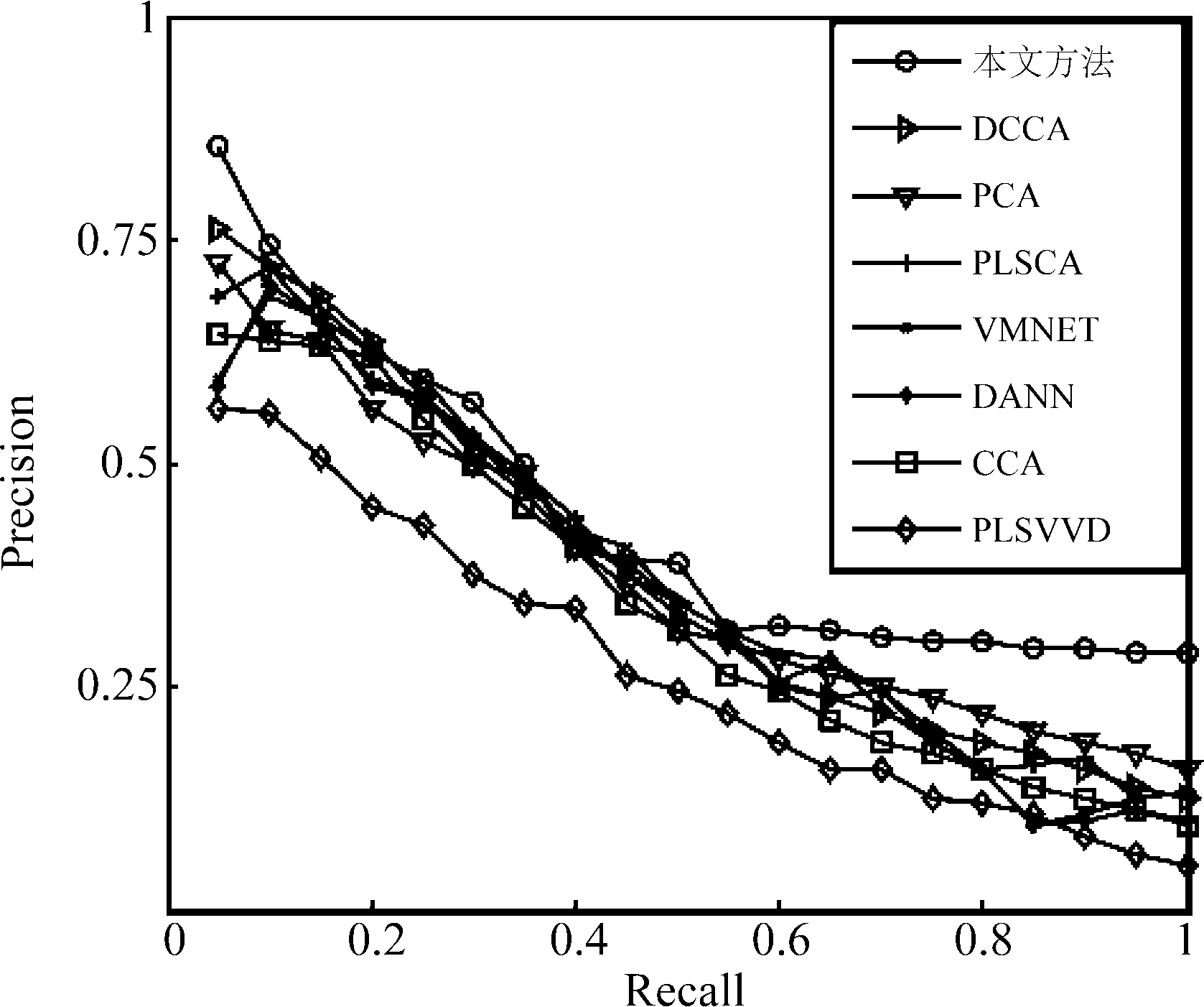

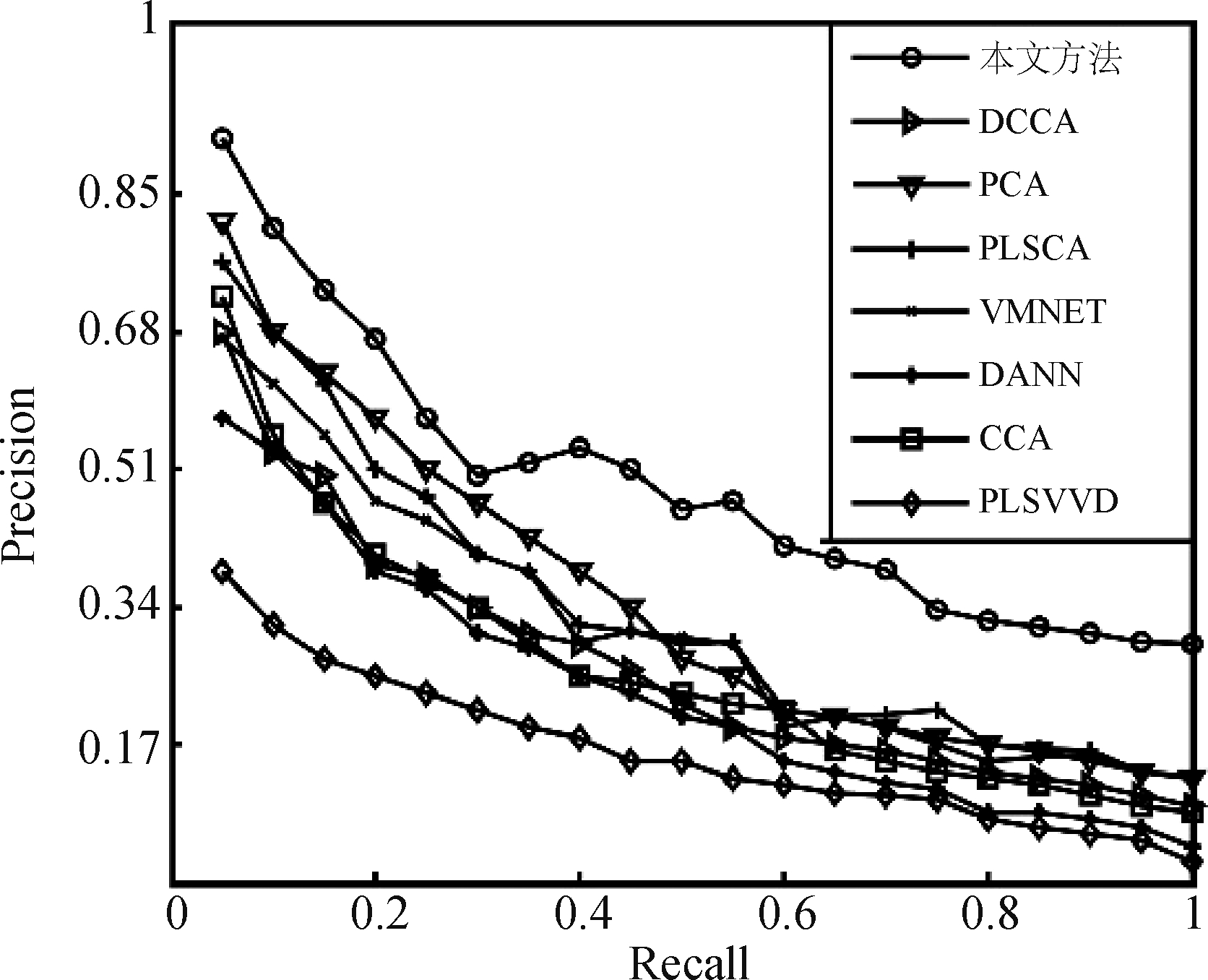

实验2 将本文中的模型与目前常用的几种音乐与视频跨模态检索的模型相对比,分别在两个数据库上都进行了实验。表2所示为不同模型在自建数据库上的召回率和平均准确度。这些模型大致可以分为线性与非线性两类,其中线性方法有PCA[6],PLSCA[3,20]和CCA[4],这些方法学习的都是模态间的线性关系。非线性方法有VMNET[5],DCCA[22]和DANN[25]。其中DCCA的模型架构与本文类似,也是双流的网络结构,不过该方法在相关文献中被用来实现图文检索,本文使用该模型来实现音乐和视频的跨模态任务,依旧取得了较为出色的表现。通过在数据集上的实验结果对比不同模型的性能,可以发现,传统的线性模型在跨模态检索中的表现不够好,而基于神经网络的非线性模型在跨模态任务中有着较为出色的表现,本文的相似度损失函数比传统的三重态函数效果更好,且相似度损失函数在训练阶段更容易收敛。图9和图10所示的PR曲线刻画了八种模型在两个数据集上的表现,直观地展现出不同模型之间的性能优劣,本文的模型在自建数据集和标准数据集VEGAS上都取得了更好的表现。图11为三重态函数与相似度损失函数在训练过程中的表现。

表2 不同模型的对比实验

Tab.2 Comparison of results using different methods

方法recall@5recall@10recall@15MAPCCA52.354.061.759.8PCA50.951.351.155.6PLSVVD53.753.952.857.4PLSCA56.055.256.459.3VMNET68.671.274.976.1DCCA72.574.877.378.2DANN73.174.576.275.8本文方法(三重态函数+结构保持函数)75.074.375.576.7本文方法(相似度排位函数+结构保持函数)81.576.478.683.5

图9 不同模型在VEGAS数据集的PR曲线

Fig.9 Precision-recall curves of different models on VEGAS dataset

图10 不同模型在自建数据集的PR曲线

Fig.10 Precision-recall curves of different models on self-established dataset

图11 两种损失函数在训练时的表现情况

Fig.11 The performance of two loss function during training process

5 结论

本文中提出了一种基于双流神经网络的音乐视频跨模态检索的框架模型,实现了为给定视频匹配对应音乐的任务。本文从两个方面对双流网络进行了改进。首先是特征提取阶段,本文在原有的特征提取网络上加入了注意力机制,通过注意力网络层的计算,对特征数据进行筛查对比,用部分特征代替整体特征进行训练,减少冗余数据,提高训练效率和实验准确度。再者是根据模态间和模态内的性质,使用了效果更好的损失函数。实验结果证明本文的方法达到了较高的准确度。目前实验采用的视频和音乐长度都很短,在未来的研究中会继续探究长视频和音乐的跨模态检索。

[1] Sami Abu-El-Haija, Nisarg Kothari, Joonseok Lee, et al. Youtube- 8m: A large-scale video classification benchmark[J]. arXiv preprint arXiv: 1609.08675, 2016.

[2] 张昕然, 巨晓正, 宋鹏, 等. 用于跨库语音情感识别的DBN特征融合方法[J]. 信号处理, 2017, 33(5): 649- 660.

Zhang Xinran, Ju Xiaozheng, Song Peng, et al. Feature Fusion Based on DBN for Cross-corpus speech emotion recognition[J]. Journal of Signal Processing, 2017, 33(5): 649- 660.(in Chinese)

[3] Hair, Joseph F, G Tomas M Hult, et al. A Primer on Partial Least Squares Structural Equation Modeling (PLS-SEM)[M]. US: SAGE Publications Inc, 2013.

[4] David R Hardoon, Sandor Szedmak, John Shawe-Taylor. Canonical correlation analysis: An overview with application to learning methods[J]. Neural Computation, 2004, 12(16): 2639-2664.

[5] Surís, Didac, Amanda Duarte, et al. Cross-modal Embeddings for Video and Audio Retrieval[J]. ArXiv preprint arXiv: 1801.02200, 2018.

[6] Lu Canyi, Feng Jiashi, Chen Yudong, et al. Tensor Robust Principal Component Analysis with a New Tensor Nuclear Norm[C]∥IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018: 925-938.

[7] Esra Acar, Frank Hopfgartner, Sahin Albayrak. Understanding affective content of music videos through learned representations[C]∥In International Conference on Multimedia Modeling. Springer, Cham, 2016: 303-314.

[8] Zhou Yipin, Wang Zhaowen, Fang Chen, et al. Visual to sound: Generating natural sound for videos in the wild[C]∥In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 3550-3558.

[9] Shoto Sasaki, Tatsunori Hirai, Hayato Ohya,et al.Affective Music Recommendation System Based on the Mood of Input Video[C]∥International Conference on Multimedia Modeling. Springer. 2015:299-302.

[10] Tsung-Yi Lin, Michael Maire, Serge Belongie, et al. Microsoft coco: Common objects in context[C]∥In European Conference on Computer Vision. Springer, 2014: 740-755.

[11] Wang Liwei, Li Yin, Huang Jing, et al. Learning two-branch neural networks for image-text matching tasks[C]∥IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018: 210-223.

[12] Kuang-Huei Lee, Chen Xi, Hua Gang, et al. Stacked Cross Attention for Image-Text Matching[J]. arXiv preprint arXiv: 1803.08024, 2018.

[13] Yi-Hsuan Yang, Jen-Yu Liu. Quantitative study of music listening behavior in a social and affective context[C]∥IEEE Transactions on Multimedia, 2013: 1304-1315.

[14] Wang Xinshao, Hua Yang, Elyor Kodirov, et al. Deep metric learning by online soft mining and class-aware attention[C]∥Association for the Advance of Artificial Intelligence (AAAI), 2019: 207-244.

[15] Christian Szegedy, Liu Wei, Jia Yangqing, et al. Going deeper with convolutions[C]∥In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 1-9.

[16] Janis Libeks, Douglas Turnbull. You can judge an artist by an album cover: Using images for music annotation[C]∥IEEE MultiMedia, 2011, 4(18): 30-37.

[17] Ge Weifeng, Huang Weilin, Dong Dengke, et al. Deep metric learning with hierarchical triplet loss[C]∥European Conference on Computer Vision (ECCV), 2018: 124-139.

[18] Duan Yueqi, Lu Jiwen, Zheng Wenzhao, et al. Deep adversarial metric learning[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018: 653- 660.

[19] Andrej Karpathy, Armand Joulin, Li Feifei. Deep fragment embeddings for bidirectional image sentence mapping[J]. In Advances in Neural Information Processing Systems, 2014: 1889-1897.

[20] Jacob A Wegelin. A survey of Partial Least Squares (PLS) methods, with emphasis on the two-block case[R]. University of Washington, Department of Statistics, Tech. Rep, 2000.

[21] Yu Yi, Tang Suhua, Kiyoharu Aizawa, et al. Category-based deep CCA for fine-grained venue discovery from multimodal data[C]∥IEEE Transactions on Neural Networks and Learning Systems, 2018, 9(9): 1-9.

[22] Galen Andrew, Raman Arora, Jeff Bilmes, et al. Deep canonical correlation analysis[C]∥International Conference on Machine Learning, 2013: 1247-1255.

[23] Sangeun Kum, Changheun Oh, Juhan Nam. Melody Extraction on Vocal Segments Using Multi-Column Deep Neural Networks[J]. In the International Society for Music Information Retrieval (ISMIR), 2016: 566-572.

[24] Michael Opitz, Georg Waltner, Horst Possegger, et al. Deep Metric Learning with BIER: Boosting Independent Embeddings Robustly[C]∥IEEE Transactions on Pattern Analysis and Machine Intelligence (PAMI), 2018: 560-572.

[25] Yaroslav Ganin, Evgeniya Ustinova, Hana Ajakan, et al. Domain-adversarial training of neural networks[J]. Journal of Machine Learning Research, 2016, 9(7): 1-35.

[26] Wu Xixuan, Qiao Yu, Wang Xiaogang, et al. Bridging Music and Image via Cross-Modal Ranking Analysis[C]∥IEEE Transactions on Multimedia, 2016, 7(18): 1305-1318.

[27] Yu Yi, Tang Suhang, Francisco Raposo, et al. Deep cross-modal correlation learning for audio and lyrics in misic retrieval[C]∥ACM Transactions on Multimedia Computing, Communications, and Applications (TOMM), 2019, 1(15): 1-20.

[28] Yu-Siang Huang, Szu-Yu Chou, Yi-Hsuan Yang. Music thumbnailing via neural attention modeling of music emotion[C]∥Asia-Pacific Signal and Information Processing Association Annual Summit and Conference, 2017: 347-350.

[29] Alexander Schindler, Andreas Rauber. An audio-visual approach to music genre classification through affective color features[C]∥European Conference on Information Retrieval, 2015: 61- 67.

[30] Chao Jiansong, Wang Haofen, Zhou Wenlei, et al. Tunesensor: A semantic-driven music recommendation service for digital photo albums[C]∥In Proceedings of the 10th International Semantic Web Conference, 2011.

[31] Gwangbeen Park, Woobin Im. Image-Text Multi-Modal Representation Learning by Adversarial Backpropagation[J]. arXiv preprint arXiv: 1612.08354, 2016.

[32] Peter Young, Alice Lai, Micah Hodosh, et al. From image descriptions to visual denotations: New similarity metrics for semantic inference over event descriptions[C]∥Transactions of the Association for Computational Linguistics, 2014: 67-78.

[33] Kilian Q Weinberger, Lawrence K Saul. Distance metric learning for large margin nearest neighbor classification[J]. Journal of Machine Learning Research, 2009, 2(10): 207-244.