1 引言

在现代通信系统(例如电话会议及免提通话)中,由于室内混响以及扬声器与麦克风之间声耦合的存在,对端听众往往会听到一种混合信号,其中既有滞后的对端听众的语音(即回波),又有带混响的本端语音。回波与混响都会严重降低目标语音的质量[1],去除它们一直是语音信号处理领域的重要挑战[2- 3],因而催生了声学回波消除(Acoustic Echo Cancellation, AEC)与语音去混响技术。用于语音通信的AEC与去混响的目标是在保证目标语音的质量下,将回波信号与晚期混响彻底消除。

在过去的几十年间,为了能够将混响与回波一起消除,研究者们付出了诸多的努力。Habets等人提出一种基于后滤波的算法。他们在传统单通道回波消除器之后放置了一个后滤波器,用于同时抑制近端说话人的混响、残余回波以及背景噪声[4]。然而,在系统的工作过程中,线性的单通道回波消除器并未与后滤波器联动,影响了系统整体的语音增强效果。Togami和Kawaguchi提出了一种基于语音源的时变概率模型的算法。他们利用两个线性滤波器与一个非线性后滤波器,将去混响、噪声抑制与回波消除结合在一起进行优化,并在一个多通道的高斯结构下,对目标信号与残余信号进行建模[5]。但是,Togami等人并没有对目标与残余信号的短时谱进行建模,这间接导致了对线性滤波器与非线性后滤波器的估计不够准确。

近几年,基于深度学习的方法已广泛应用于语音信号处理中,如基于深度学习的语音分离与语音增强。诸多研究表明,基于深度学习的算法可以获得比传统信号处理方法更优异的处理效果[6-9]。目前已经有大量的研究在利用深度学习进行回波消除或去混响。在回波消除任务上,Schwarz等人利用神经网络估计残余回波的幅度谱,并用其进行残余压缩[10]。Carbajal在Schwarz的工作基础上,将神经网络的输入从单独的远端参考信号扩展为多路信号,并采用了与相位有关的损失函数来优化神经网络[11]。Lee使用神经网络估计残余回波压缩器的压缩增益,从而去除非线性回波成分[12]。在去混响任务上,Roman等人在利用深度学习去混响时,将直达声与早期混响作为目标信号,将晚期混响作为干扰信号,从而成功将理想二值掩蔽(ideal binary mask, IBM)应用到混响条件下,并取得了不错的效果[13]。进一步地,Li等人使用理想比率掩蔽(ideal ratio mask, IRM)实现了更好的去混响结果[14]。相较于传统的信号处理算法,基于神经网络的算法性能在单独回波消除或去混响任务上都有了极大的提高。然而这些算法仅仅考虑了环境中单独存在回波或混响时的情况,因此当两种干扰同时存在时,以上算法并不能很好的对麦克风拾取信号进行增强。

本文的研究旨在利用神经网络对同时受回波与混响干扰的语音信号进行增强,据我们所知,截至目前在该场景下还没有基于深度学习的相关研究公开发表。鉴于回波信号与混响的特性不同,即对于目标语音,回波干扰为加性过程、混响的产生为卷积过程,本文提出了一种两阶段的深度学习系统。在第一阶段,所提系统利用基于掩蔽的方法,对与目标语音不相关的加性回波信号进行消除;对于剩余的与目标语音高度相关的混响干扰,在第二阶段系统使用基于“隐掩蔽”的谱映射方法对其进行去除。所提出系统的两阶段首先逐步各自单独训练,之后进行联合训练以提升两阶段的耦合度,从而获得更好的回波消除与去混响效果。在各种回波和混响干扰下的实验证明,本文所提系统可以取得更好的性能。

2 信号模型

在远场拾音场景中,近端说话人离麦克风的距离往往很远,此时混响将不可忽视,因此必须同时考虑回波信号与近端说话人的混响在通信过程中的影响。此时的信号模型为

Y(n, f)=H1(n, f)S(n, f)+

H2(n, f)X(n, f)=R(n, f)+D(n, f)

(1)

其中,Y(n, f)为麦克风接收信号的时频域表示,这里n为帧索引、 f为频率索引。S(n, f),X(n, f)分别为近端语音与远端信号的时频域表示。H1(n, f)表示近端说话人与麦克风之间的房间冲激响应(Room Impulse Response, RIR),H2(n, f)则描述了回波的传输函数。R(n, f),D(n, f)分别为混响语音与回波信号的时频域表示。本文的任务是从麦克风接收信号Y(n, f)中,将回波干扰与晚期混响干扰一并去除,最终得到带有早期混响的近端信号![]()

值得注意的是,在上述信号模型中,有个理想的假设:扬声器输出信号与远端信号(即扬声器输入信号)之间是线性关系,回波干扰为线性回波。事实上,由于扬声器内部的放大器的功率限制以及扬声器的工艺缺陷,远端信号在经过扬声器播放后,会受到非线性扭曲,进而产生非线性回波干扰,此时,信号模型应为

Y(n, f)=H1(n, f)S(n, f)+

H2(n, f)Xdistort(n, f)=R(n, f)+Ddistort(n, f)

(2)

其中,Xdistort(n, f)为远端信号x(t)经过扬声器非线性扭曲后产生的扭曲信号xdistort(t)的时频域表示,Ddistort(n, f)为非线性回波干扰的时频域表示。通过以下三个步骤来模拟放大器与扬声器的非线性扭曲函数。

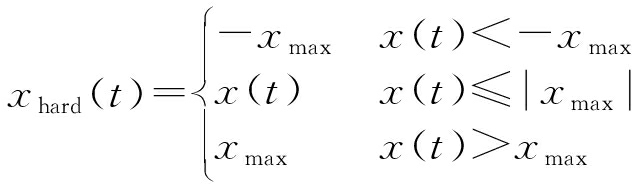

首先,将一个限幅函数(hard clipping function)[15]作用到远端信号x(t)上,用来模拟功率放大器的特性:

(3)

其中xmax为远端信号x(t)的最大值的80%。

之后,为了模拟扬声器的非线性特性,使用了一个无记忆的sigmoid函数[16],作用在被限幅的远端信号上:

(4)

其中,sigmoid增益γ等于4,b(t)与a的定义如下:

(5)

(6)

最后,用一个均值为0,方差为1的高斯概率密度函数来调整扭曲信号xdistort(t),使其不再严格遵照扭曲函数分布,增加了其的不确定性。

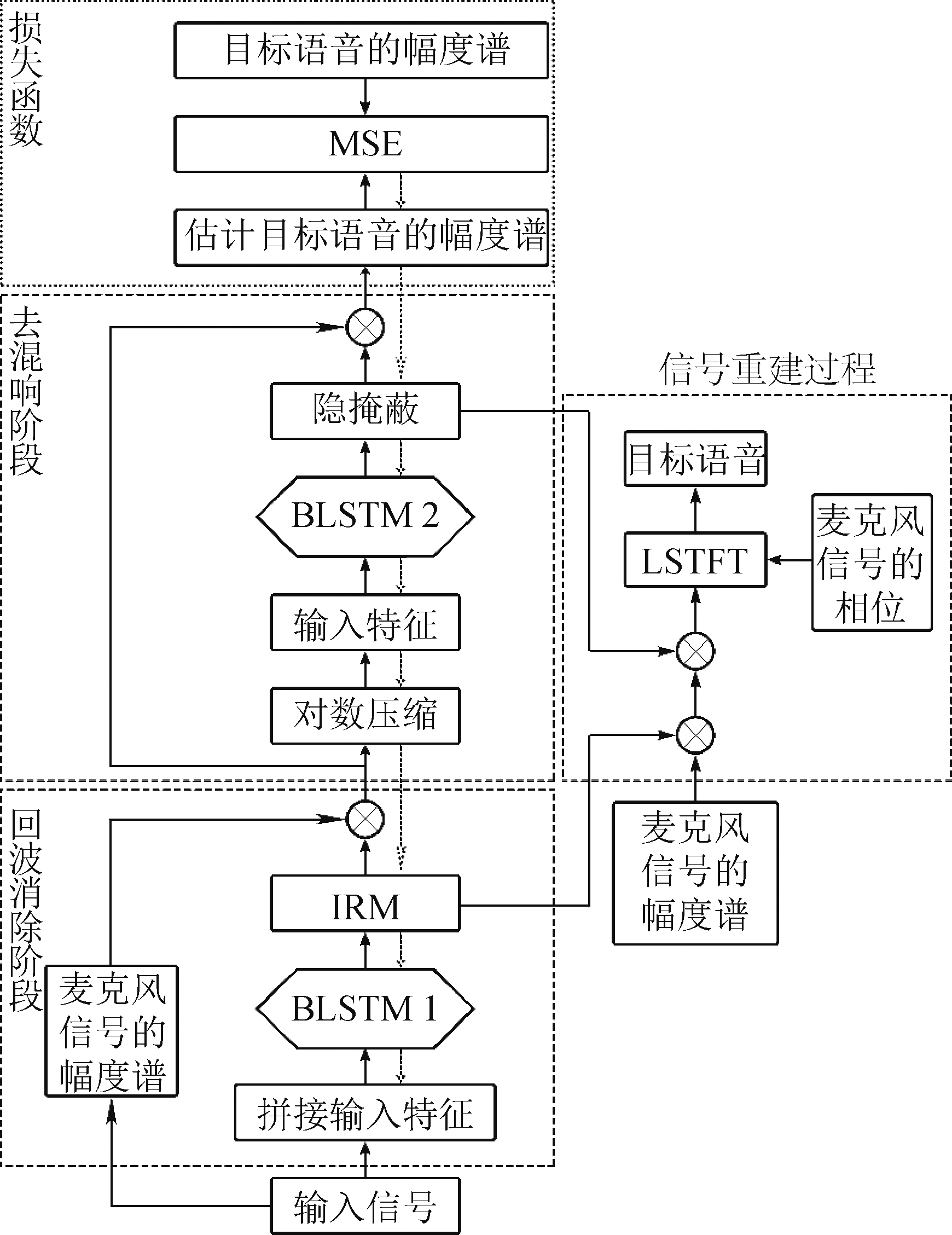

3 联合声学回波和混响抑制系统

一般认为,信号模型中回波信号H2(n, f)X(n, f)与近端语音S(n, f)之间不相关,回波是一种加性干扰信号;而混响语音H1(n, f)S(n, f)与近端语音S(n, f)之间是一种卷积关系,不满足不相关性。因此,回波消除是一个去除加性干扰的过程,而去混响则是一个解卷积的操作,试图仅用一个神经网络同时实现这两个过程不尽合理。鉴于此,本文没有采用单阶段系统的形式,而是用一个两阶段系统,分步地消回波与去混响,本文提出的基于深度学习的联合声学回波和混响抑制系统框图如图1所示。在回波消除阶段,根据回波为加性干扰这一特点,用基于掩蔽的增强模型对其进行去除。这一阶段利用神经网络估计时频掩蔽,并将其应用到回波消除过程,最终从麦克风接收信号Y(n, f)中恢复出带有混响的近端语音。在去混响阶段,由于混响干扰与目标信号的强相关性,我们提出一种基于“隐掩蔽”的谱映射模型,同时结合掩蔽模型与谱映射模型的优点,以期从回波消除阶段的输出中更好的恢复出目标信号![]()

图1 两阶段联合训练系统的结构框图

Fig.1 Diagram of the proposed two-stage joint-training system

3.1 回波消除阶段

回波消除阶段的作用为从麦克风接收信号Y(n, f)中彻底去除回波信号D(n, f),但不进行去混响操作,即这一阶段的目标信号为无回声的混响语音R(n, f)。在这一阶段中,先用神经网络估计出表示每个时频点处目标信号占主导概率的时频掩蔽M(n, f),再利用该掩蔽从麦克风接收信号中恢复出无回声的混响语音R(n, f)。

相关研究[17]指出基于掩蔽的训练目标在去除加性干扰信号时可以为系统带来更加显著的性能提升。并且Wang等人指出,在语音可懂度及语音质量增强任务上,利用以掩蔽为训练目标的神经网络处理得到的信号要优于经过以幅度谱为训练目标的网络处理后的信号[18]。因此,本文选用基于掩蔽的模型对加性回波干扰进行去除,此时神经网络的目的为估计每个时频点处目标信号占主导概率。这里,这一主导概率可定义为IRM[18]:

(7)

麦克风接收信号Y(n, f)中包含的回波信号D(n, f)与远端信号X(n, f)高度相关,为了给神经网络提供与回波信号相关的先验信息,本文同时使用麦克风信号和远端信号作为此阶段神经网络的输入。更为具体的,回波消除阶段神经网络在每个时间n时的输入特征由麦克风信号与远端信号拼接而成:

IAEC(n)=[log(|Y(n,1)|),...,log(|Y(n,F)|),

log(|X(n,1)|),...,log(|X(n,F)|)]

(8)

这里,log( )为取对数操作,其目的为在不改变数据的性质和相对关系的同时,压缩数据的尺度,以便神经网络进行训练。

)为取对数操作,其目的为在不改变数据的性质和相对关系的同时,压缩数据的尺度,以便神经网络进行训练。

由于语音信号具有较强的时序性,且双向长短时记忆网络[19-20](Bidirectional Long Short-Term Memory, BLSTM)能够很好地追踪上下文关联信息,因此本文采用BLSTM从输入特征中估计每个时频点中目标信号占主导的概率。并且BLSTM非线性运算能力较强,因此利用BLSTM也可以比其他的神经网络更好的对非线性的回波进行建模。神经网络的优化目标为其输出![]() 与理想掩蔽值M(n, f)之间的均方误差,即训练过程中优化的损失函数为:

与理想掩蔽值M(n, f)之间的均方误差,即训练过程中优化的损失函数为:

(9)

利用BLSTM估计出的时频掩蔽![]() 在回波消除阶段最终恢复出无回声的混响语音的幅度谱为:

在回波消除阶段最终恢复出无回声的混响语音的幅度谱为:

(10)

3.2 去混响阶段

在去混响阶段的目标为从混响语音SREV(n, f)中恢复仅带有早期混响的近端信号![]() 在这一阶段,采用了基于“隐掩蔽”的谱映射模型对卷积而来的混响干扰进行处理。利用神经网络,直接由混响语音SREV(n, f)的幅度谱映射到目标信号的幅度谱。

在这一阶段,采用了基于“隐掩蔽”的谱映射模型对卷积而来的混响干扰进行处理。利用神经网络,直接由混响语音SREV(n, f)的幅度谱映射到目标信号的幅度谱。

对于混响而言,其是由近端语音与RIR卷积生成的,混响与近端语音有较强关联性,因此掩蔽并不适合用来作为去混响阶段的训练目标。故这一阶段遵循谱映射的方法来训练神经网络,即这一阶段神经网络的训练目标为最小化输出幅度谱与目标信号幅度谱之间的差异,此时用于训练网络的损失函数为:

(11)

其中,![]() 为去混响阶段估计的带有早期混响的近端语音信号的幅度谱,为去混响阶段的最终输出。相较于传统的谱映射,本文提出了一种基于“隐掩蔽”的谱映射方法。如前所述,使用基于掩蔽的训练目标在语音可懂度及语音质量增强问题上要优于使用基于谱映射的训练目标,所以尝试通过一个“隐掩蔽”,将掩蔽的思想融入谱映射模型中。因此,去混响阶段神经网络的输出结果将不再是目标语音的幅度谱,而是一个掩蔽值

为去混响阶段估计的带有早期混响的近端语音信号的幅度谱,为去混响阶段的最终输出。相较于传统的谱映射,本文提出了一种基于“隐掩蔽”的谱映射方法。如前所述,使用基于掩蔽的训练目标在语音可懂度及语音质量增强问题上要优于使用基于谱映射的训练目标,所以尝试通过一个“隐掩蔽”,将掩蔽的思想融入谱映射模型中。因此,去混响阶段神经网络的输出结果将不再是目标语音的幅度谱,而是一个掩蔽值![]() 但与传统的基于掩蔽的模型不相同的是,该“隐掩蔽”并没有明确的定义,其值由神经网络自学习而得到。

但与传统的基于掩蔽的模型不相同的是,该“隐掩蔽”并没有明确的定义,其值由神经网络自学习而得到。

为了在回波消除阶段与去混响阶段之间构建一种更密切的耦合关系,这里用回波消除阶段处理后的幅度谱来训练以BLSTM作为监督学习机的去混响模型。由于此时远端信号X(n, f)已无法提供与目标信号相关的信息,所以这一阶段的输入仅包含来自回波消除阶段的增强后的幅度谱|SREV(n,f)|。即,用于去混响阶段的神经网络的输入特征为:

IDEV(n)=[log(|SREV(n,1)|),...,

log(|SREV(n,F)|)]

(12)

最终,利用BLSTM从|SREV(n,f)|中估计出的隐掩蔽![]() 可以得到估计的只含早期混响的近端语音的幅度谱:

可以得到估计的只含早期混响的近端语音的幅度谱:

(13)

3.3 训练过程

本文提出的基于深度学习的联合声学回波和混响抑制系统训练过程分为两步骤:1)首先回波消除阶段与去混响阶段分别进行训练;2)对训练好的两阶段的神经网络进行联合训练以提升系统的耦合度。

在两阶段分别训练的过程中,为了能够使所提系统可以简单地顺序执行去回波与去混响,回波消除阶段的神经网络首先进行训练,紧接着利用回波消除阶段处理后的训练数据训练去混响阶段的神经网络。在回波消除阶段与去混响阶段的训练过程中,其优化目标分别为最小化损失函数LAEC与LDEV。

训练完成后的两阶段系统级联后即可实现联合声学回波和混响抑制的效果,但是由于回波消除阶段与去混响阶段是分开进行训练的,所以两阶段之间的耦合度仍然较低,这将直接导致级联系统在实际使用时无法达到期望的处理效果。因此本文在此基础上提出使用联合训练以进一步提升系统的耦合度。在联合训练的过程中,系统的优化目标为最终输出的估计信号幅度谱与![]() 之间的均方误差。本文第5部分进一步通过实验证明了联合训练的有效性。

之间的均方误差。本文第5部分进一步通过实验证明了联合训练的有效性。

4 实验设置

4.1 实验数据

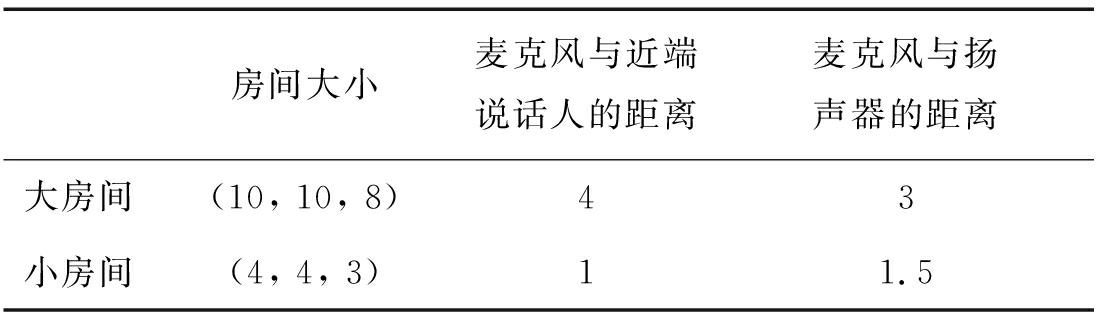

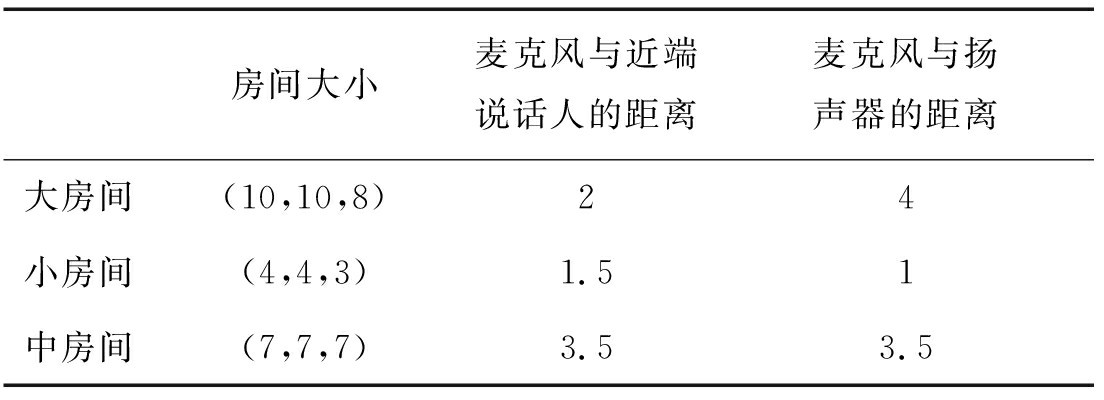

由于混响与回波都被包含在研究之中,所以实验过程使用Image法[21]生成了两组RIR,一组用于生成回波信号,另一组用于生成近端语音。对于近端RIR,采用一个固定的50 ms为阈值,进行区分早期混响与晚期混响。

如表1所示,训练过程所用的数据在2个不同的模拟房间中生成。每个房间中模拟了三种混响时间(T60)对应的RIR,三种T60分别为0.3 s,0.6 s和0.9 s。如表2所示,测试过程所用的数据在3个不同的模拟房间中生成。为了评估训练好的网络对于不同的T60值的泛化程度,测试集中采用的T60值分别为0.4 s,0.5 s,0.7 s及0.8 s。RIR生成过程中近端说话人与扬声器的位置是随机设定的,但是麦克风与扬声器以及近端说话人之间的距离固定不变,以确保直达声与混响的能量比(direct to reverberant ratio, DRR)在每个T60下不会有过大的变化[22]。

表1 训练集中的模拟房间

Tab.1 Simulated rooms in training set m

房间大小麦克风与近端说话人的距离麦克风与扬声器的距离大房间(10, 10, 8)43小房间(4, 4, 3)11.5

表2 测试集中的模拟房间

Tab.2 Simulated rooms in test set m

房间大小麦克风与近端说话人的距离麦克风与扬声器的距离大房间(10,10,8)24小房间(4,4,3)1.51中房间(7,7,7)3.53.5

从TIMIT语料库[23]中随机选择100对说话人作为训练集的远端说话人与近端说话人。从每一个远端说话人的10条语料中,随机选择出其中的3条,将这3条语料拼接在一起,作为1个远端信号。对于近端信号,将近端语料通过前后补零的方式,将其扩展为与远端信号相同的长度。最终共得到43200条麦克风信号(3个远端RIR×3条远端信号×2个近端RIR×4条近端语音×3个T60×2个房间×100对说话人)作为训练数据。

为了探究提出的方案对说话人的泛化程度,从TIMIT语料库中剩余的说话人里,随机选取10对说话人作为测试集。使用同样的方法,最终共得到1200条麦克风信号(1个远端RIR×1条远端信号×1个近端RIR×1条近端语音×10组信号×4个T60×3个房间×10对说话人)。

为了生成训练集的麦克风信号,回波信号与混响语音按照一定的信回比(signal-to-echo ratio, SER)进行混合。SER随机取值自{-6,-3,0,3,6}dB。为了检验训练系统的泛化程度,每一个测试集的麦克风信号随机按照SER=3.5 dB或者7 dB进行混合。在研究中,SER仅在双讲区间进行计算,它的定义如下所示:

(14)

其中,![]() 为带有早期混响的近端信号的时域表示,d(t)为回波干扰信号的时域表示。

为带有早期混响的近端信号的时域表示,d(t)为回波干扰信号的时域表示。

4.2 系统参数设置

实验过程中所有的信号的采样率均为16 kHz。系统的输入信号在进行分帧时,帧长为20 ms,帧移为10 ms,窗函数使用Blackman窗。之后对每一帧都进行320阶的快速傅里叶变换(fast Fourier transform, FFT)。这样,就得到了输入信号的时频域表示,其中每一帧都有161个频点。因此输入特征的维度即为161×2=322维。

对于实验过程中使用的BLSTM,其输入层与输出层均为全连接层。在回波消除阶段,输入层有322个节点,而在去混响阶段,输入层有161个节点。每个BLSTM都有4个隐含层,每层包含300个节点。由于两个阶段的BLSTM的输出均为掩蔽值,范围在0到1之间,所以各个BLSTM的输出层的激活函数均为sigmoid函数。使用Adam优化器[24]来训练BLSTM,MSE作为损失函数,学习率为0.0003,对所有训练样本最多训练30次。

4.3 对比系统

实验评估的对比系统主要有以下几种。第一种是由两个BLSTM构成的级联系统,分别用于去回波与去混响,这两个网络是分别训练的,且没有进行联合训练,将该系统记作“Cascade”。该系统用于通过对比证明联合训练的优越性。第二种系统是由一个单独的BLSTM构成。在该系统中使用了一个有8个隐含层的BLSTM以保持网络深度的一致性。由于该系统由一个网络同时实现回波与混响的消除,所以这里分别使用了两种训练目标,即IRM和与隐掩蔽相结合的幅度谱。将这两种方法分别记作“Single-IRM”和“Single-MAG”。这两种方法是为了证明依据回波与混响的不同特性而选择两个网络的级联结构的正确性。除此之外,为了验证是否带有隐掩蔽的谱映射算法能够获得更优的结果,还在对比系统中加入了一个基于传统谱映射算法的联合训练系统,将该系统记作“Joint-Mapping”。最后,本文所提出的系统记作“Joint”。

5 实验结果

提出的系统将会在两种情况下进行评估,分别为仅包含混响与线性回波的情形及包含混响与非线性回波的情形。实验的评价指标分别为回波损失增益(Echo return loss enhancement, ERLE),语音质量感知评估(perceptual evaluation of speech quality, PESQ)和信号失真比(signal-to-distortion ratio, SDR)。

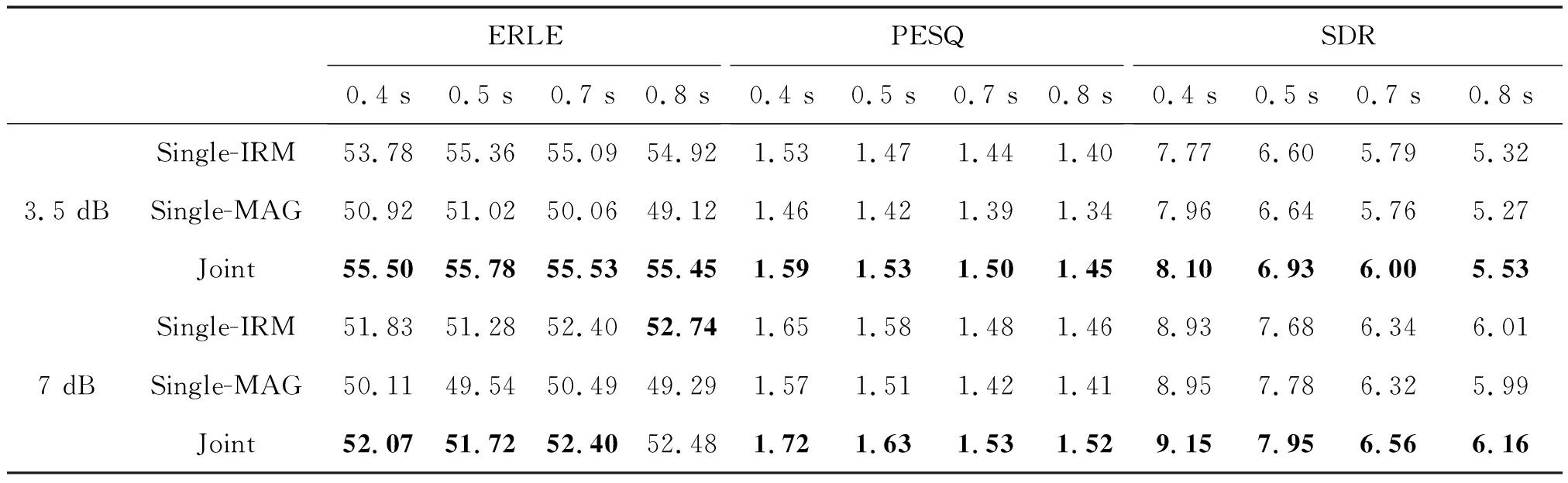

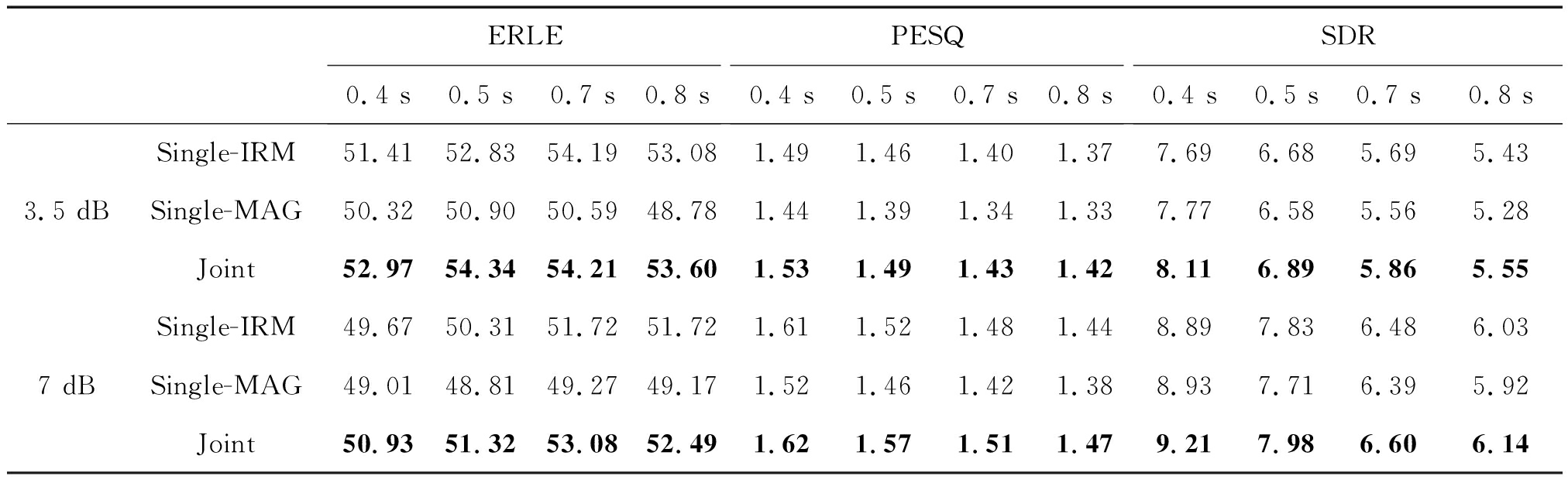

5.1 与Single-IRM及Single-MAG系统的对比

Joint系统与Single-IRM及Single-MAG系统的实验结果如表3及表4所示。从结果可知,无论是在线性回波还是非线性回波环境中,Joint系统几乎都取得了最佳的处理结果。由此可得出结论,两阶段联合训练系统相比于单阶段系统可以获得更加稳定的回波消除与去混响表现。

表3 Joint、Single-IRM及Single-MAG在混响与线性回波环境下的平均结果

Tab.3 Average results of Joint, Single-IRM and Single-MAG under reverberation and linear echo

ERLE0.4 s0.5 s0.7 s0.8 sPESQ0.4 s0.5 s0.7 s0.8 sSDR0.4 s0.5 s0.7 s0.8 s3.5 dBSingle-IRM53.7855.3655.0954.921.531.471.441.407.776.605.795.32Single-MAG50.9251.0250.0649.121.461.421.391.347.966.645.765.27Joint55.5055.7855.5355.451.591.531.501.458.106.936.005.537 dBSingle-IRM51.8351.2852.4052.741.651.581.481.468.937.686.346.01Single-MAG50.1149.5450.4949.291.571.511.421.418.957.786.325.99Joint52.0751.7252.4052.481.721.631.531.529.157.956.566.16

表4 Joint、Single-IRM及Single-MAG在混响与非线性回波环境下的平均结果

Tab.4 Average results of Joint, Single-IRM and Single-MAG under reverberation and non-linear echo

ERLE0.4 s0.5 s0.7 s0.8 sPESQ0.4 s0.5 s0.7 s0.8 sSDR0.4 s0.5 s0.7 s0.8 s3.5 dBSingle-IRM51.4152.8354.1953.081.491.461.401.377.696.685.695.43Single-MAG50.3250.9050.5948.781.441.391.341.337.776.585.565.28Joint52.9754.3454.2153.601.531.491.431.428.116.895.865.557 dBSingle-IRM49.6750.3151.7251.721.611.521.481.448.897.836.486.03Single-MAG49.0148.8149.2749.171.521.461.421.388.937.716.395.92Joint50.9351.3253.0852.491.621.571.511.479.217.986.606.14

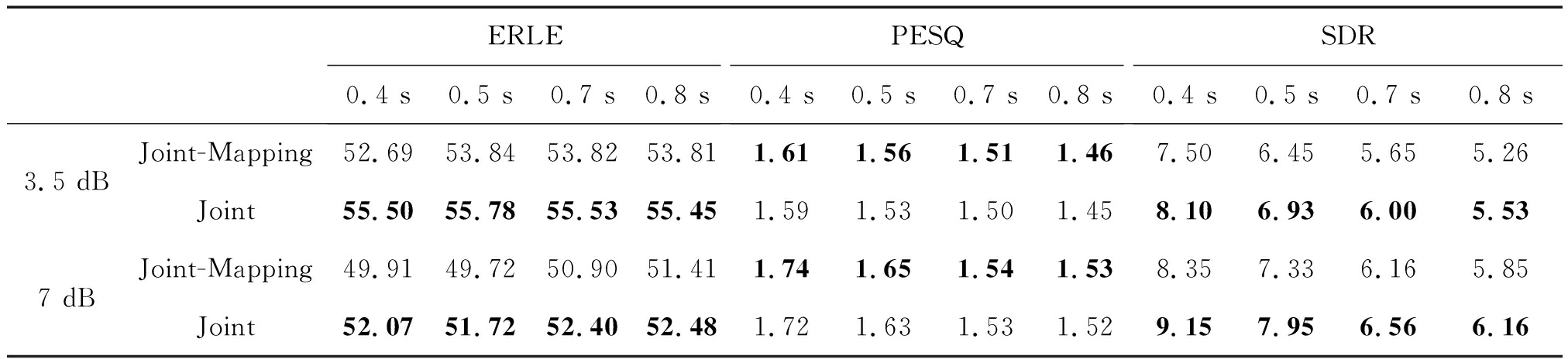

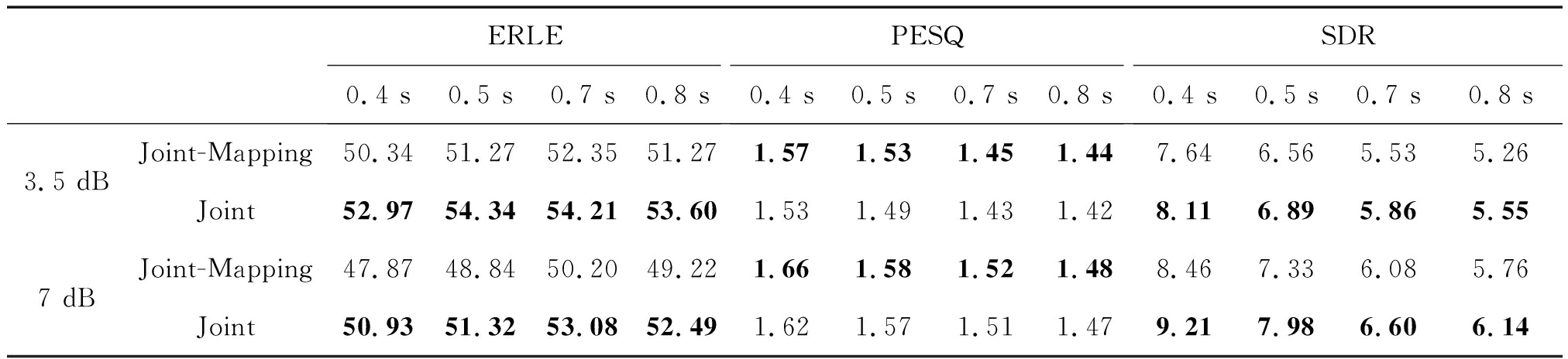

5.2 与Joint-Mapping系统的对比

Joint系统与Joint-Mapping系统在各个条件下测得的三个房间的ERLE,PESQ以及SDR的平均值如表5与表6所示。从表中可以看出,在ERLE这一指标上,Joint系统相比于Joint-Mapping系统取得了持续的性能提升,平均提高了1.8 dB。Joint系统的PESQ指标略微少于Joint-Mapping。究其原因可能是由于混响是一个卷积过程,掩蔽的思想不能很好地适用于混响的去除,而相比之下,传统的谱映射方法就会适合得多。然而,Joint-Mapping系统的总体失真要比提出的方法严重得多。事实上,Joint-Mapping系统与Joint系统的PESQ值相差无几(少于1%),这一微弱差距几乎可以忽略不计。又考虑到Joint系统在ERLE与SDR这两指标上的显著提升,可以推论结合了“隐掩蔽”的谱映射方法要优于传统的谱映射算法。

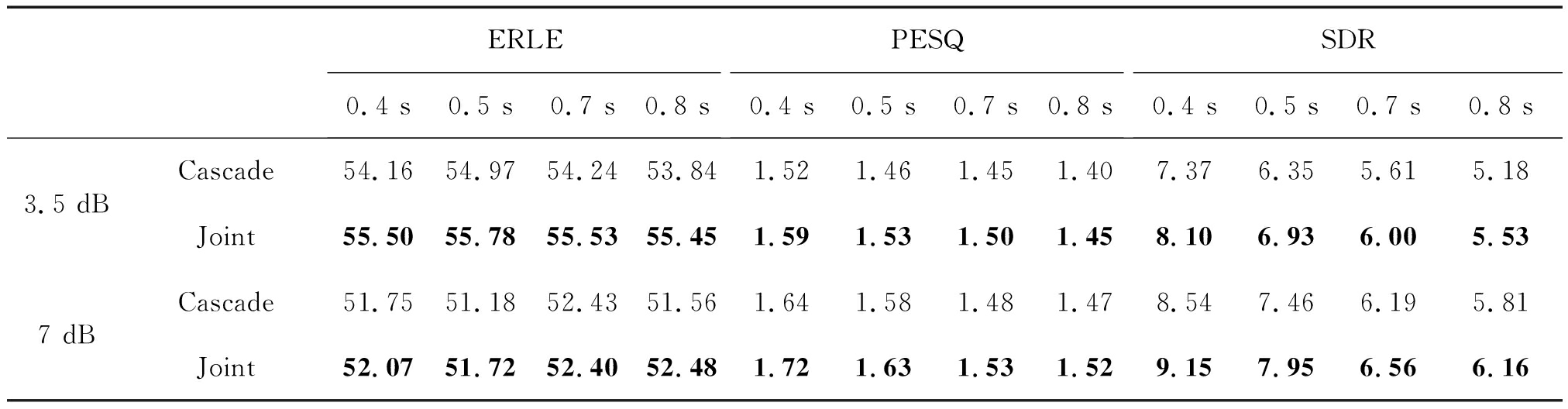

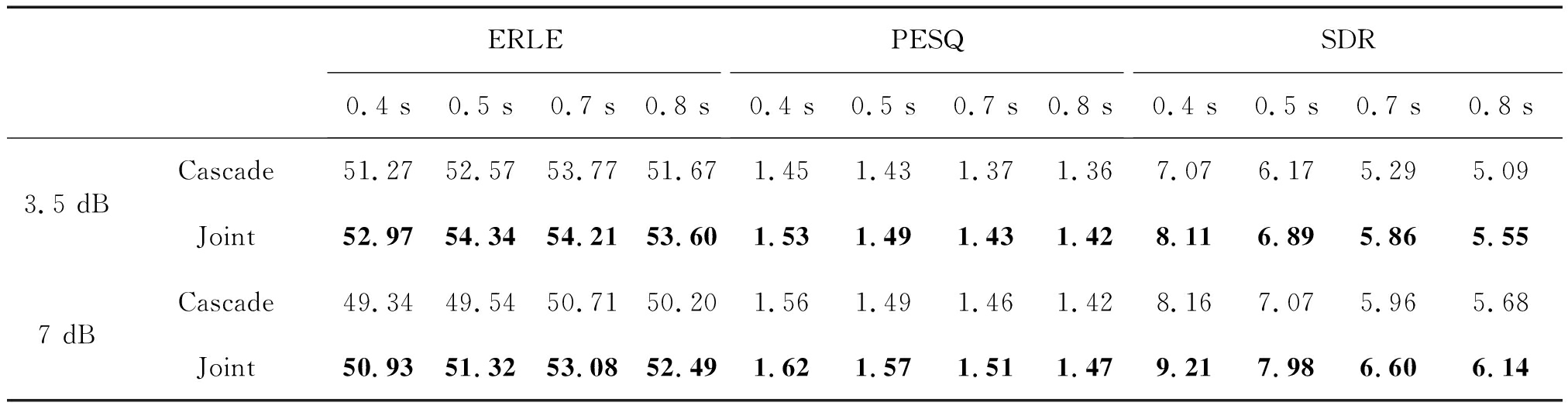

5.3 与Cascade系统的对比

Cascade系统与Joint系统在混响与线性回波环境下及混响与非线性回波环境下的实验结果如表7与表8所示。从表中可以看出,在任一条件下,Joint系统的三个指标均要明显高于Cascade系统,从而证明了联合训练确实提高了两个子系统之间的耦合度,实现了更好的处理效果。

表5 Joint与Joint-Mapping在混响与线性回波环境下的平均结果

Tab.5 Average results of Joint and Joint-Mapping under reverberation and linear echo

ERLE0.4 s0.5 s0.7 s0.8 sPESQ0.4 s0.5 s0.7 s0.8 sSDR0.4 s0.5 s0.7 s0.8 s3.5 dBJoint-Mapping52.6953.8453.8253.811.611.561.511.467.506.455.655.26Joint55.5055.7855.5355.451.591.531.501.458.106.936.005.537 dBJoint-Mapping49.9149.7250.9051.411.741.651.541.538.357.336.165.85Joint52.0751.7252.4052.481.721.631.531.529.157.956.566.16

表6 Joint与Joint-Mapping在混响与非线性回波环境下的平均结果

Tab.6 Average results of Joint and Joint-Mapping under reverberation and non-linear echo

ERLE0.4 s0.5 s0.7 s0.8 sPESQ0.4 s0.5 s0.7 s0.8 sSDR0.4 s0.5 s0.7 s0.8 s3.5 dBJoint-Mapping50.3451.2752.3551.271.571.531.451.447.646.565.535.26Joint52.9754.3454.2153.601.531.491.431.428.116.895.865.557 dBJoint-Mapping47.8748.8450.2049.221.661.581.521.488.467.336.085.76Joint50.9351.3253.0852.491.621.571.511.479.217.986.606.14

表7 Cascade与Joint在混响与线性回波环境下的平均结果

Tab.7 Average results of Joint and Cascade under reverberation and linear echo

ERLE0.4 s0.5 s0.7 s0.8 sPESQ0.4 s0.5 s0.7 s0.8 sSDR0.4 s0.5 s0.7 s0.8 s3.5 dBCascade54.1654.9754.2453.841.521.461.451.407.376.355.615.18Joint55.5055.7855.5355.451.591.531.501.458.106.936.005.537 dBCascade51.7551.1852.4351.561.641.581.481.478.547.466.195.81Joint52.0751.7252.4052.481.721.631.531.529.157.956.566.16

表8 Cascade与Joint在混响与非线性回波环境下的平均结果

Tab.8 Average results of Joint and Cascade under reverberation and non-linear echo

ERLE0.4 s0.5 s0.7 s0.8 sPESQ0.4 s0.5 s0.7 s0.8 sSDR0.4 s0.5 s0.7 s0.8 s3.5 dBCascade51.2752.5753.7751.671.451.431.371.367.076.175.295.09Joint52.9754.3454.2153.601.531.491.431.428.116.895.865.557 dBCascade49.3449.5450.7150.201.561.491.461.428.167.075.965.68Joint50.9351.3253.0852.491.621.571.511.479.217.986.606.14

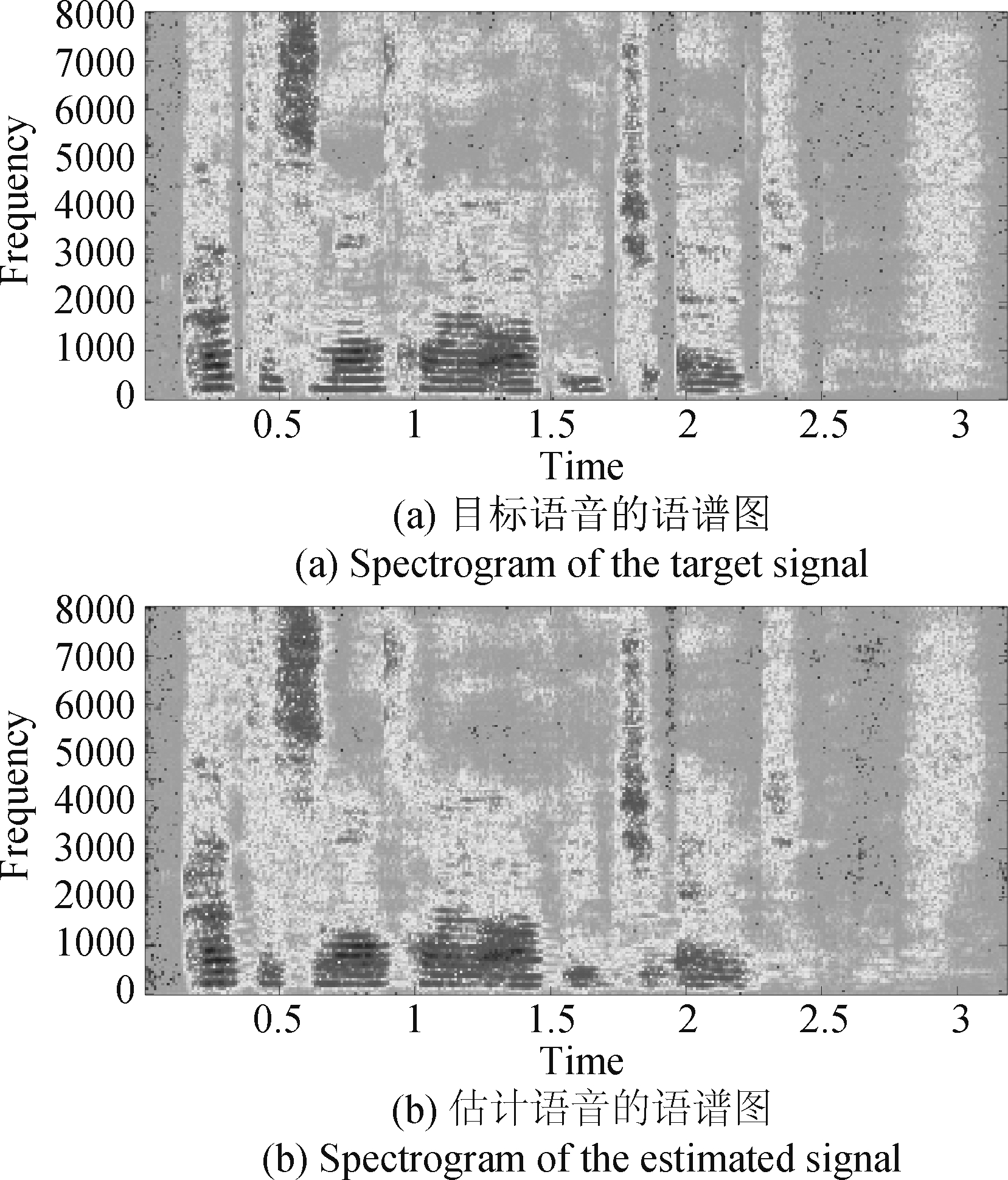

5.4 估计语音与目标语音的对比

图2展示了在混响与非线性回波环境下,目标语音非静音段与Joint系统估计语音非静音段的语谱图,从图中可以看出估计语音与目标语音的语谱图极度相似。所以可以得出结论,提出的系统可以在去除回波与混响的同时很好地保留目标语音,并且即使是在有非线性回波的复杂场景下,依然可以保持一个稳定的回波消除与去混响表现。

图2 目标语音与估计语音的语谱图

Fig.2 Spectrogram of the target signal and estimated signal

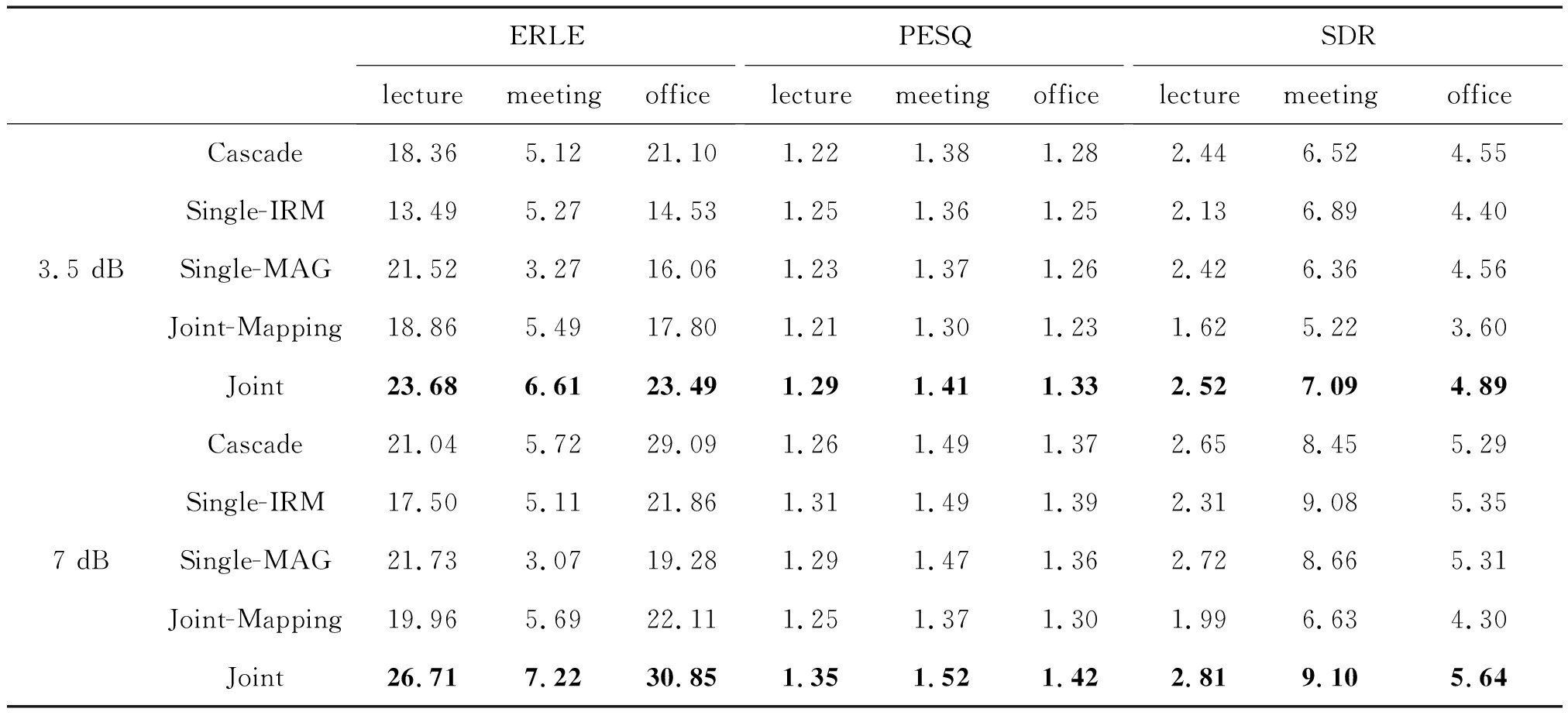

5.5 实录RIR下的结果对比

为了演示提出的模型在真实环境中的潜在优越性,我们还使用了Aachen Impulse Response (AIR) 数据库中演讲室(lecture)、会议室(meeting)和办公室(office)的实录RIR,依据上述规则合成仿真数据,用于神经网络的训练与测试。实验结果如下表所示。从中可以看出,虽然较之上述实验,Joint系统的处理结果有所变差,但在实录RIR条件下,Joint系统依然取得了所有模型中最佳的回波消除与去混响表现。因此也在某种程度上证明了,我们提出的基于深度学习的两阶段联合训练系统在真实环境下,依然有着潜在的性能优越性。

表9 各个系统在实录RIR下的结果

Tab.9 Results of every system under recorded RIR

ERLElecturemeetingofficePESQlecturemeetingofficeSDRlecturemeetingoffice3.5 dBCascade18.365.1221.101.221.381.282.446.524.55Single-IRM13.495.2714.531.251.361.252.136.894.40Single-MAG21.523.2716.061.231.371.262.426.364.56Joint-Mapping18.865.4917.801.211.301.231.625.223.60Joint23.686.6123.491.291.411.332.527.094.897 dBCascade21.045.7229.091.261.491.372.658.455.29Single-IRM17.505.1121.861.311.491.392.319.085.35Single-MAG21.733.0719.281.291.471.362.728.665.31Joint-Mapping19.965.6922.111.251.371.301.996.634.30Joint26.717.2230.851.351.521.422.819.105.64

6 结论

在本研究中,为了解决回波与混响的组合干扰,提出了一个基于深度学习的联合声学回波和混响抑制系统。由于回波与混响的特性不同,所以先用基于IRM的掩蔽模型处理与目标信号不相关的加性声学回波;再结合掩蔽与谱映射模型的优点,使用基于隐掩蔽的谱映射算法消除与目标信号强相关的混响干扰,最终从麦克风接收信号中恢复带有早期混响的近端语音。回波消除阶段与去混响阶段首先分别训练,接着联合训练以增强系统的耦合度,从而获取更好的声学回波与混响抑制性能。在不同场景下进行的一系列系统实验表明,提出的方法不仅能提高去回波与去混响的表现,对恢复出的目标语音还可以整体上得到更好的语音质量与可懂度。

[1] George E L J, Goverts S T, Festen J M, et al. Measuring the effects of reverberation and noise on sentence intelligibility for hearing-impaired listeners[J]. Journal of Speech, Language, and Hearing Research, 2010.

[2] Flanagan J L, Johnston J D, Zahn R, et al. Computer-steered microphone arrays for sound transduction in large rooms[J]. The Journal of the Acoustical Society of America, 1985, 78(5): 1508-1518.

[3] Duttweiler D. A twelve-channel digital echo canceler[J]. IEEE Transactions on Communications, 1978, 26(5): 647- 653.

[4] Habets E A P, Gannot S, Cohen I, et al. Joint dereverberation and residual echo suppression of speech signals in noisy environments[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2008, 16(8): 1433-1451.

[5] Togami M, Kawaguchi Y. Simultaneous optimization of acoustic echo reduction, speech dereverberation, and noise reduction against mutual interference[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2014, 22(11): 1612-1623.

[6] Huang P S, Kim M, Hasegawa-Johnson M, et al. Joint optimization of masks and deep recurrent neural networks for monaural source separation[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2015, 23(12): 2136-2147.

[7] Wang Yuxuan, Wang Deliang. Towards scaling up classification-based speech separation[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2013, 21(7): 1381-1390.

[8] Weninger F, Hershey J R, Le Roux J, et al. Discriminatively trained recurrent neural networks for single-channel speech separation[C]∥2014 IEEE Global Conference on Signal and Information Processing (GlobalSIP). IEEE, 2014: 577-581.

[9] Xu Yong, Du Jun, Dai Lirong, et al. An experimental study on speech enhancement based on deep neural networks[J]. IEEE Signal Processing Letters, 2013, 21(1): 65- 68.

[10] Schwarz A, Hofmann C, Kellermann W. Spectral feature-based nonlinear residual echo suppression[C]∥2013 IEEE Workshop on Applications of Signal Processing to Audio and Acoustics. IEEE, 2013: 1- 4.

[11] Carbajal G, Serizel R, Vincent E, et al. Multiple-input neural network-based residual echo suppression[C]∥2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2018: 231-235.

[12] Lee C M, Shin J W, Kim N S. DNN-based residual echo suppression[C]∥Sixteenth Annual Conference of the International Speech Communication Association. 2015.

[13] Roman N, Woodruff J. Intelligibility of reverberant noisy speech with ideal binary masking[J]. The Journal of the Acoustical Society of America, 2011, 130(4): 2153-2161.

[14] Li Xu, Li Junfeng, Yan Yonghong. Ideal Ratio Mask Estimation Using Deep Neural Networks for Monaural Speech Segregation in Noisy Reverberant Conditions[C]∥Interspeech, 2017: 1203-1207.

[15] Malik S, Enzner G. State-space frequency-domain adaptive filtering for nonlinear acoustic echo cancellation[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2012, 20(7): 2065-2079.

[16] Comminiello D, Scarpiniti M, Azpicueta-Ruiz L A, et al. Functional link adaptive filters for nonlinear acoustic echo cancellation[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2013, 21(7): 1502-1512.

[17] Zhao Yan, Wang Deliang, Merks I, et al. DNN-based enhancement of noisy and reverberant speech[C]∥2016 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2016: 6525- 6529.

[18] WangYuxuan, Narayanan A, Wang Deliang. On training targets for supervised speech separation[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2014, 22(12): 1849-1858.

[19] Graves A, Schmidhuber J. Framewise phoneme classification with bidirectional LSTM and other neural network architectures[J]. Neural Networks, 2005, 18(5- 6): 602- 610.

[20] Graves A, Mohamed A, Hinton G. Speech recognition with deep recurrent neural networks[C]∥2013 IEEE International Conference on Acoustics, Speech and Signal Processing. IEEE, 2013: 6645- 6649.

[21] Allen J B, Berkley D A. Image method for efficiently simulating small-room acoustics[J]. The Journal of the Acoustical Society of America, 1979, 65(4): 943-950.

[22] Zhao Yan, Wang Zhongqiu, Wang Deliang. Two-stage deep learning for noisy-reverberant speech enhancement[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2018, 27(1): 53- 62.

[23] Lamel L F, Kassel R H, Seneff S. Speech database development: Design and analysis of the acoustic-phonetic corpus[C]∥Speech Input/Output Assessment and Speech Databases, 1989.

[24] Kingma D P, Ba J. Adam: A method for stochastic optimization[J]. ArXiv Preprint ArXiv: 1412.6980, 2014.