1 引言

长期以来,语音增强都是学术界和工业界所关注的焦点。语音增强技术在信号处理领域是一个重要地研究方向。在许多应用中,如视频会议、语音识别、生物医学工程(助听器)、移动通信,由于受到环境噪声地干扰,导致了语音质量地下降和可懂度地降低。因此,语音增强可以减少带噪语音中的噪声,在提高语音质量的同时提升了人耳感知的舒适度、可懂度。根据语音和噪声的分布特性,许多学者提出了不同的语音增强方法。具有代表性的维纳滤波[1-2]、谱减法[3-5]、子空间法[6]等被广泛应用于工程实践中。虽然这一类传统的语音增强方法在平稳的噪声环境能够取得良好的效果,但是在非平稳的噪声环境下,其处理结果却不尽人意。因此,在非平稳噪声环境下,实现良好的语音增强成为了语音信号处理的难点。

近年来,随着计算机技术的高速发展,人们拥有了大规模高质量的计算能力。有监督的深度神经网络(Deep Neural Network,DNN)语音增强方法引起了人们的兴趣。与上述传统的语音增强方法相比较,基于神经网络模型的语音增强方法[7-12]能够很好地对带有非平稳噪声的语音进行语音增强。从而弥补了传统语音增强方法的不足。Xu等[13]提出了基于深度神经网络的语音增强方法,实现带噪语音的对数功率谱到降噪语音的对数功率谱地映射。该方法能够降低带有平稳噪声和非平稳噪声的语音中的噪声成分,弥补了传统方法的不足。尽管如此,如何更好减少带噪语音的背景噪声仍然是当前学术研究的热点、难点。

为了有效地解决上述问题,本文引入奇异谱分析算法。根据Golyandina等人发表了时间序列的奇异谱分析(Singular Spectrum Analysis for Time Series)[14]一文可知。奇异谱分析(Singular Spectrum Analysis,SSA)是基于时间序列上的轨迹矩阵的奇异值分解(Singular Value Decomposition,SVD)[15],是一种时间序列的分析和预测技术。奇异谱分析有着广泛的适用性,对于时间序列而言,既不需要假设参数模型,也不需要假设平稳的条件,其目标是将原始序列分解成一小部分可以解释的成分。因为语音信号是时间序列,故奇异谱分适用于语音信号处理。通过分析带噪语音的频谱容易得知,噪声的频谱和语音的频谱可能存在部分重叠的情况,尤其是在低信噪比的情况下最为明显。而奇异谱分析算法能利用语音信号与噪声在能量上的差异,将带噪语音预分离成语音信号分量与噪声分量,完成带噪语音的预处理。接着需要对语音信号分量与噪声分量提取对数功率谱作为训练集的特征,对纯净的语音直接提取对数功率谱作为训练集的标签。然后使用深度神经网络,训练得到一个能够将特征映射为标签的模型,使用该模型,预测得到相应的对数功率谱。为了得到更高质量的干净语音,提升本文方法有效性,因此本文在干净语音重建环节,同时在使用估计得到的对数功率谱和带噪语音的对数功率谱,并加入权重系数,使得用于重建干净语音的幅度谱同时具有二者的信息,因而本文提出的方法可以适应不同信噪比的情形,有效的去除背景噪声,降低语音信号的失真。其详细过程将在后文阐述。

本文内容安排如下:第2节阐述奇异谱分析的数学理论,第3节说明本文提出的基于奇异谱分析的深度神经网络语音增强新方法的整体实现框架,实验仿真结果将在第4节中给出,第5节总结全文。

2 奇异谱分析

奇异谱分析较奇异值分解存在一定的差异,奇异值分解是针对二维信号的主成分提取。若要对一维信号进行奇异值分解,需要先引入hankel矩阵实现一维信号到二维信号的变换,再进行奇异值分解。将一维信号变换为二维信号后再进行奇异值分解,这一过程被称之为奇异谱分析。

对时间序列进行奇异谱分析主要分为三个步骤,首先通过引入hankel矩阵构造一个轨迹矩阵。然后对轨迹矩阵进行奇异值分解得到若干个奇异值和对应的特征向量,将奇异值和对应的特征向量相乘得到若干个初等矩阵。最后对每一个初等矩阵进行对角平均并重建为多个时间序列分量。其数学推导将在接下来的文章中阐述。

2.1 构造轨迹矩阵

选择适当的窗口长度L(2≤L≤K/2),将一维的时间序列x=(x1,x2,…,xK)转化为多维序列,并定义为轨迹矩阵X:

(1)

2.2 轨迹矩阵X的奇异值分解

X=U![]() VT

VT

(2)

其中U是一个L×L的酉矩阵,它的列向量是由轨迹矩阵X的左奇异向量的正交集所构成。V是一个K×K的酉矩阵,它的列向量是由轨迹矩阵X的右奇异向量的正交集所构成。![]() 一个L×K的矩形对角阵,它包含了L个从大到小排列的轨迹矩阵X的奇异值。

一个L×K的矩形对角阵,它包含了L个从大到小排列的轨迹矩阵X的奇异值。

因此使用奇异值分解可以将轨迹矩阵X重写为:

(3)

其中σi是第i个奇异值,Ui和Vi分别是矩阵U和矩阵V的第i列向量。d是轨迹矩阵X的秩,满足d ≤ L。并且![]() 是轨迹矩阵X的第i个初等矩阵。{Ui,σi,Vi}表示了奇异值分解的第i组特征值。

是轨迹矩阵X的第i个初等矩阵。{Ui,σi,Vi}表示了奇异值分解的第i组特征值。

2.3 语音分量的重建

由初等矩阵重建时间序列,我们将采取对角平均。这里定义重建时间序列![]() 是矩阵Xi对应的反对角的平均值。在形式上,引入汉克化运算符来表示。

是矩阵Xi对应的反对角的平均值。在形式上,引入汉克化运算符来表示。![]() 作用于L×K的矩阵Xi,给出了一个Hankel矩阵

作用于L×K的矩阵Xi,给出了一个Hankel矩阵![]() 如下:

如下:

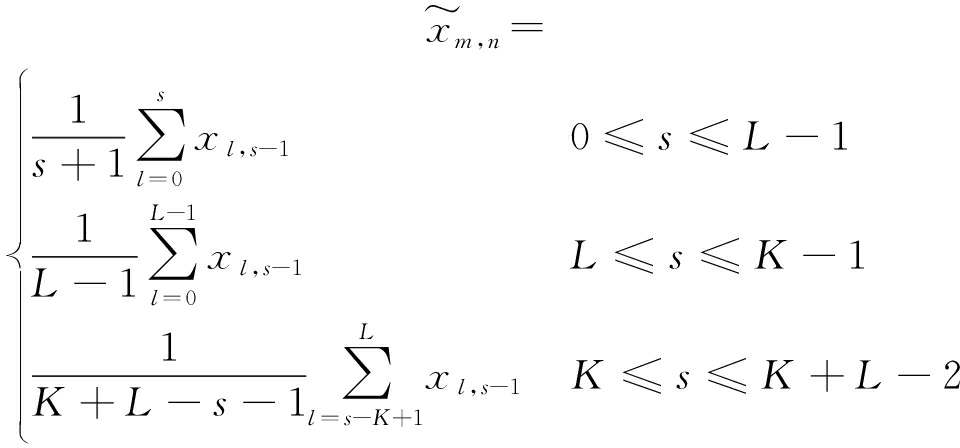

(4)

![]() 为

为![]() 的元素且s=m+n给出条件等式:

的元素且s=m+n给出条件等式:

(5)

由于Hankel矩阵是线性的,那么有![]() 又因为X已经是Hankel矩阵,那么有

又因为X已经是Hankel矩阵,那么有![]() 即可以得到:

即可以得到:

(6)

由于时间序列可以从Hankel矩阵中确定唯一,因此可以推出时间序列x由子序列![]() 组成。

组成。

3 基于奇异谱分析的深度神经网络语音增强方法

一般而言,在处理语音信号时,通常需要将其变换到时频域来进行处理。由于语音信号是非平稳的,那么需要对其加窗分帧,通常一帧信号可以选择在5 ms到20 ms之间,窗长设定为N,帧移设定为N/2。然后对每一个重叠的帧进行短时傅里叶变换获得该信号得短时频谱。而本文需要先对带噪语音进行奇异谱分析(SSA),得到语音分量。然后再将各个分量进行短时傅里叶变换(Short Time Furious Translate,STFT)并取对数得到对数功率谱作为数据集使用。本节将详细说明语音增强的全部流程。

3.1 带噪语音的奇异谱分析

本文的第2小节详细推导了奇异谱分析算法的数学公式,因此在本小节中将详细阐述如何将奇异谱分析应用于本文的语音增强方法。

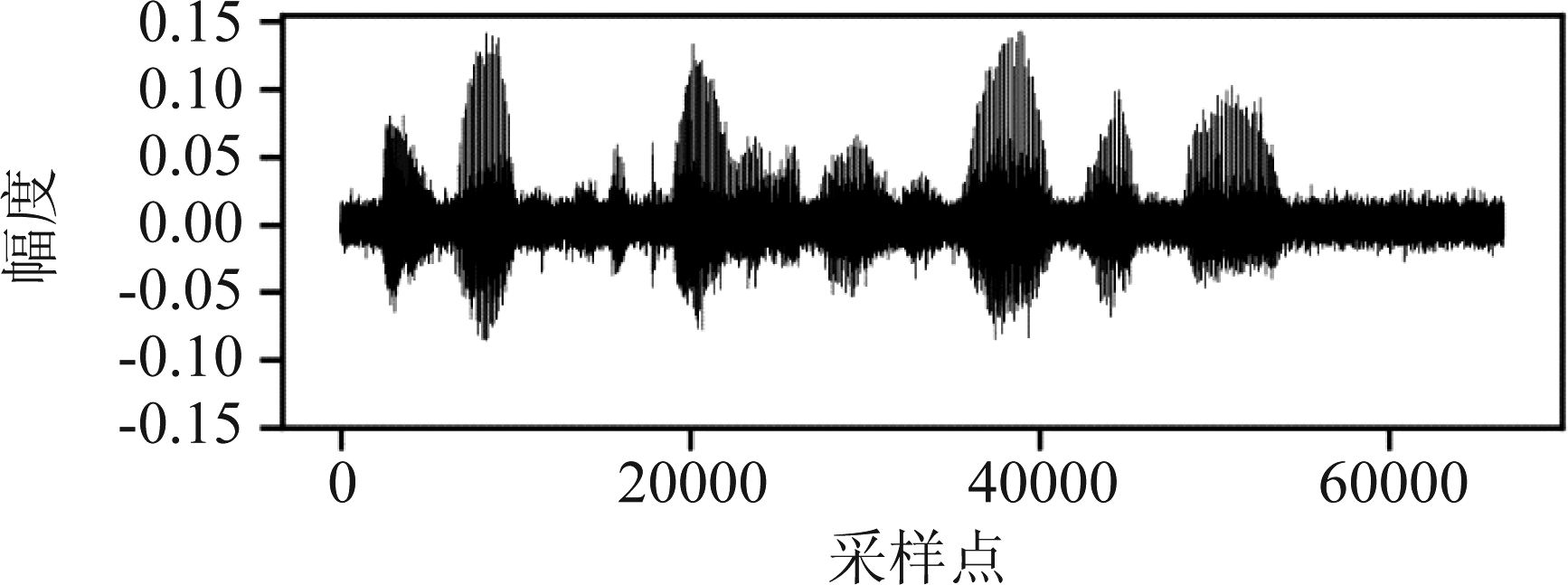

从频域分析带噪语音不难得知,噪声和语音信号的频谱可能存在重叠的情况,使用一般的语音增强方法无法将噪声和语音分开处理。因此,在对带噪语音进行语音增强时,可以使用奇异谱分析算法将带噪语音预分离成若干个语音和噪声分量。对图1(a)中信噪比为5 dB的带噪语音进行加窗分帧,帧长为20 ms,在16 kHz采样率的情况下,一帧信号包含320个采样点。由于需要分解成4个分量,故先构造出一个轨迹矩阵。然后对该矩阵进行奇异值分解并得到4个奇异值和对应的特征向量,将奇异值和对应特征向量相乘得到初等矩阵。最后对4个初等矩阵采用对角平均,恢复成时序信号。对每一帧信号重复上述步骤。即可将带噪语音分解成4个语音分量,如图1(b)所示。在图1(b)中我们可以清晰的辨识,前两个语音分量中语音成分占主导,而在后两个语音分量中则主要是噪声成分。

图1(a) 信噪比为5 dB的带噪语音

Fig.1(a) Noisy speech with SNR of 5 dB

图1(b) 使用奇异谱分析算法后的4个语音分量

Fig.1(b) Four speech components after using singular Spectrum Analysis algorithm

使用奇异谱分析算法将语音和噪声预分离之后,对全部分量进行短时傅里叶变换,得到幅度谱,平方后取对数得到对数功率谱。为后续的神经网络过程做准备。

3.2 整体实现框架

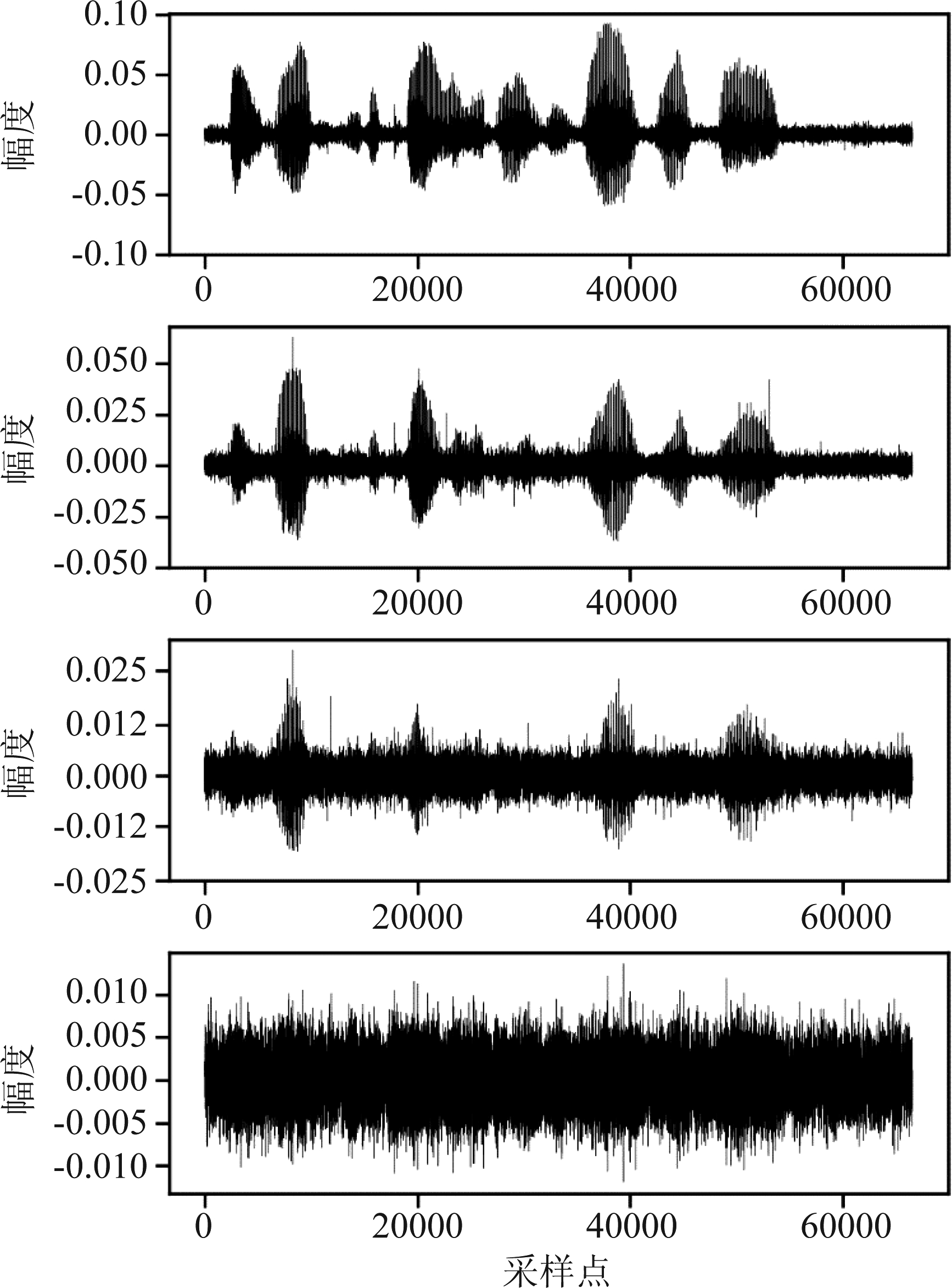

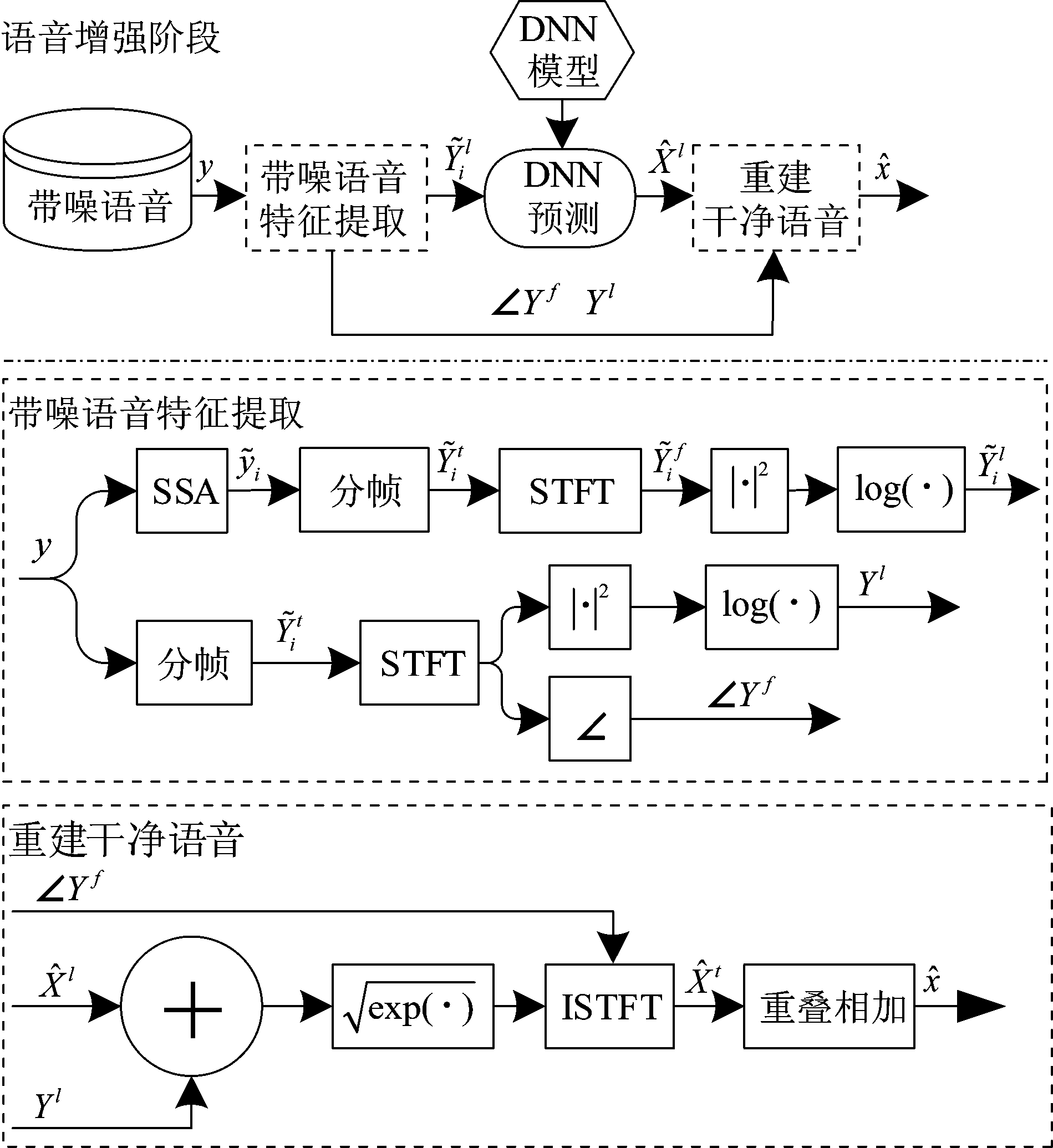

本文提出的语音增强方法分为两阶段。图2为深度神经网络地训练阶段流程框图,神经网络通过拟合特征数据和标签数据完成监督学习,获得神经网络模型。

图2 训练阶段的流程框图

Fig.2 The flow chart of the training stage

在对带噪语音样本(Noisy samples)的特征提取时,首先需要对带噪语音样本进行奇异谱分析(SSA):

(7)

其中y为带噪语音样本,![]() 为奇异谱分析后的语音分量,m指分解成语音分量的数目。对全部语音分量

为奇异谱分析后的语音分量,m指分解成语音分量的数目。对全部语音分量![]() 加窗分帧(Framing)并做短时傅里叶变换(STFT)得到时频谱

加窗分帧(Framing)并做短时傅里叶变换(STFT)得到时频谱![]() 接着对其平方后取对数得到对数功率谱

接着对其平方后取对数得到对数功率谱![]() 作为训练特征。

作为训练特征。

对纯净语音样本(Clean samples)的特征提取和对带噪语音样本特征提取大致相同,只是不再进行奇异谱分析,而是直接加窗分帧做短时傅里叶变换得到时频谱Xf,平方后取对数得到对数功率谱Xl作为训练集的标签。

图3为语音增强阶段的流程框图。在增强阶段,对带噪语音样本的特征提取和训练阶段大致相同,需要将带噪语音样本进行奇异谱分析后加窗、分帧并做短时傅里叶变换,然后平方并取对数得到对数功率谱。使用已经训练好的神经网络模型对估计的短时频谱进行估计得到![]() 与此同时,还需要获取带噪语音y的对数功率谱Yl和相位∠Yf,将用于干净语音的重建。

与此同时,还需要获取带噪语音y的对数功率谱Yl和相位∠Yf,将用于干净语音的重建。

图3 语音增强阶段的流程框图

Fig.3 Flow chart of speech enhancement phase

在得到预测的对数功率谱![]() 后,需要按照公式(8)重建干净语音:

后,需要按照公式(8)重建干净语音:

(8)

其中,![]() 为本文方法估计得到的对数功率谱,

为本文方法估计得到的对数功率谱,![]() 为原始带噪语音的对数功率谱,α为权重系数,

为原始带噪语音的对数功率谱,α为权重系数,![]() 为时域信号矩阵,∠Yf为原始带噪语音的相位谱。在考虑到重建干净语音时,仅使用

为时域信号矩阵,∠Yf为原始带噪语音的相位谱。在考虑到重建干净语音时,仅使用![]() 会导致在信噪比较高的情况下,对语音信号有比较大的失真。所以本文通过结合

会导致在信噪比较高的情况下,对语音信号有比较大的失真。所以本文通过结合![]() 和

和![]() 使得用于重建干净语音的幅度谱同时具有二者的信息。对时域信号矩阵

使得用于重建干净语音的幅度谱同时具有二者的信息。对时域信号矩阵![]() 进行滑动重叠生成干净的语音

进行滑动重叠生成干净的语音![]() 从公式中可知,使用了估计得到的对数功率谱和原始带噪语音的对数功率谱并加入权重系数,使得用于重建干净语音的幅度谱包含更多的信息,重建出的干净语音质量也更好。从而使得本文提出的方法能够适应不同信噪比的各种情况。

从公式中可知,使用了估计得到的对数功率谱和原始带噪语音的对数功率谱并加入权重系数,使得用于重建干净语音的幅度谱包含更多的信息,重建出的干净语音质量也更好。从而使得本文提出的方法能够适应不同信噪比的各种情况。

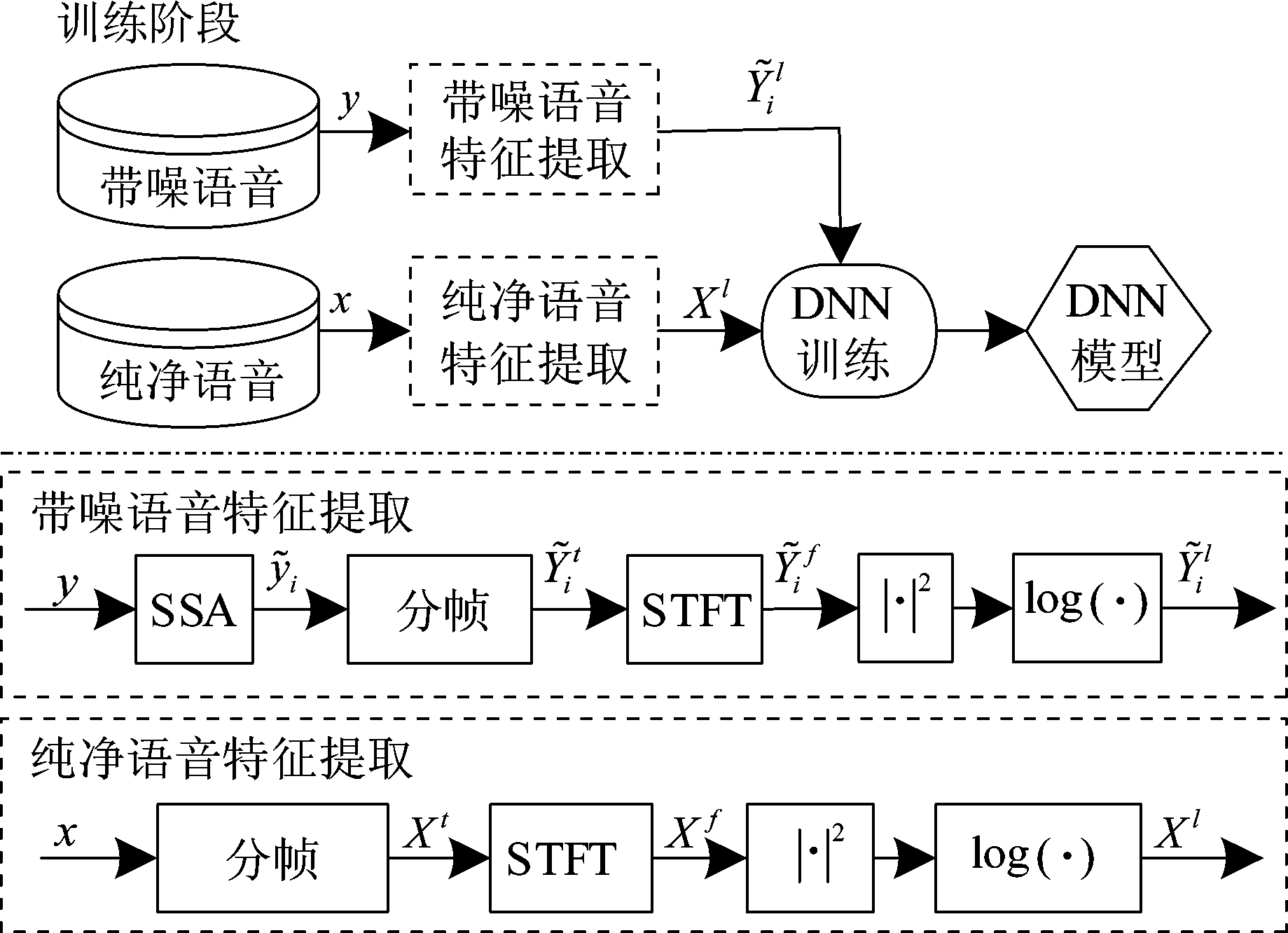

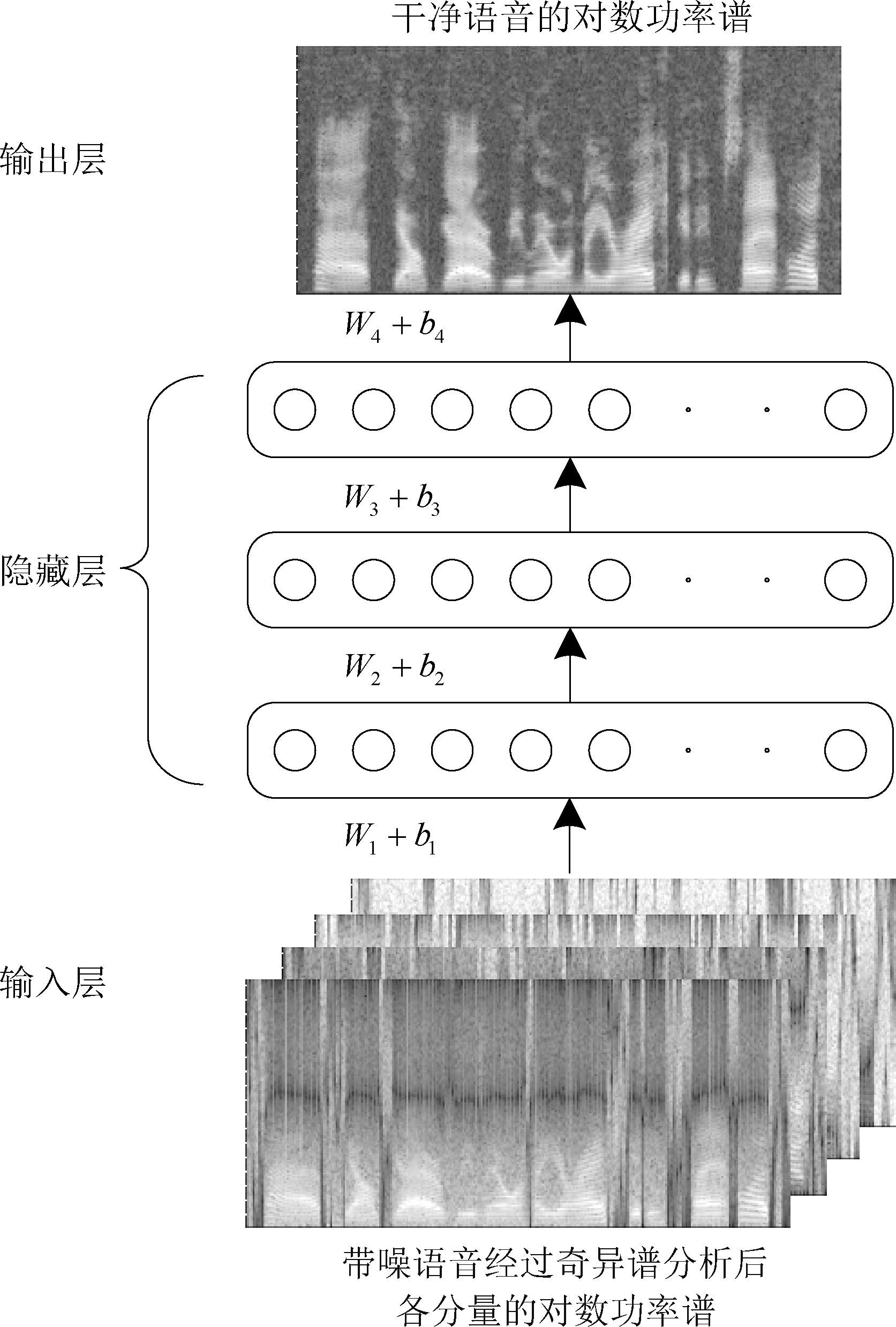

3.3 深度神经网络的训练

本文方法所使用的DNN网络结构如图4所示。其中(W1,b1),(W2,b2),(W3,b3),(W4,b4)分别是各层的权重和偏置。本文提出的深度神经网络(DNN)包含了输入层、三层隐藏层和输出层。使用双曲正切函数(tanh)作为隐藏层的激活函数,使用线性函数(linear)作为输出层的激活函数。整个深度神经网络(linear)可以被看作为一个非线性的回归函数,具有将奇异谱分析后的语音分量的对数功率谱映射到纯净语音对数功率谱的能力。本文使用对数双曲余弦作为损失函数,并采用Adam(Adaptive Moment Estimation)作为深度神经网络(DNN)的优化器,通过反向传播误差更新网络参数,从而使损失函数loss值达到最小,如公式(9)所示。

图4 基于奇异谱分析的DNN语音增强的微调过程描述

Fig.4 Fine-tuning process description of DNN speech Enhancement based on singular Spectrum Analysis

![]()

(9)

其中![]() 是训练集特征通过DNN网络估计得到的对数功率谱,Xl是训练集的标签。loss是双曲余弦的对数值。

是训练集特征通过DNN网络估计得到的对数功率谱,Xl是训练集的标签。loss是双曲余弦的对数值。

综上所述,在已知DNN网络能够学习带噪语音样本和纯净语音样本之间的非线性关系的情况下。

4 实验仿真及性能评价

本文设置了两组不同情况的实验。第一组对纯净语音添加单一噪声,第二组则是对纯净语音添加多种噪声。分别用3种不同的语音增强方法对上述两组语音去噪,并采用图表的方式记录数据,得出客观结论。

在后文将简称本文提出的基于奇异谱分析的深度神经网络语音增强新方法为SDN。将谷歌开源的webrtc中语音增强方法简称为WNS。将Valin[17]提出的一种DSP与深度学习相结合的实时全频带语音增强方法(A Hybrid DSP-Deep Learning Approach to Real-Time Full-Band Speech Enhancement)简称为HDL。

本文中用于对比的数据为测试集数据,不会被用于本文方法模型的训练,因此对本文方法的语音增强阶段和两种参考方法而言,对比数据均是全新数据。为了保证参考方法性能最佳,本文不再重新训练参考方法的模型,而是直接使用现有最优模型和本文方法在同一测试集上进行比较。

4.1 数据集设定

对于单种噪声情况,本文从TIMIT语音库[18]训练集中选取380条纯净语音,从测试集中选取20条纯净语音用于验证。选用NOISEX-92标准噪声库[19]中的15类噪声作为噪声样本。本文按照-5 dB至10 dB随机产生信噪比,合成5700条带噪语音作为神经网络的训练。按照-10 dB、-5 dB、0 dB、5 dB、10 dB、15 dB、20 dB合成共计2100条带噪语音作为测试集。

对于多种噪声的情形,在测试带噪语音含有5种噪声的情况时,按照信噪比为-10 dB、-5 dB、0 dB、5 dB、10 dB,同时添加babble、buccaneer2、destryerops、volvo和white等5种噪声到20条纯净语音上,构造出100条带噪语音。在测试带噪语音含有15种噪声的情况时,按照上述信噪比,同时添加Noisex-92中的15种噪声到20条纯净语音上,构造出100条带噪语音。

4.2 评价指标

感知语音质量(Perceptual evaluation of speech quality,PESQ)[20]和短时客观可懂度(Short-time objective intelligibility,STOI)[21]通常被用于衡量语音质量的客观指标。PESQ得分情况与人对语音听觉的主观评价,具有很高的相似度。而STOI则是用于评价语音的客观可懂度。并且这两者指标数值越大均代表语音质量越高。

为了更加直观地对比语音增强前后的数据结果,本文对PESQ和STOI加权归一化得出一个新的分数(Weighted Score Value,WSV),其公式如下:

(10)

其中PESQ和STOI分别是使用主观语音质量评估和短时客观可懂度所得到的分数,根据PESQ值的范围为1到4.5,STOI值的范围为0~1,使用公式(10),加权得到WSV的值,其范围在0.1到1之间,得分越高代表语音质量越好。

4.3 给纯净语音添加单种噪声

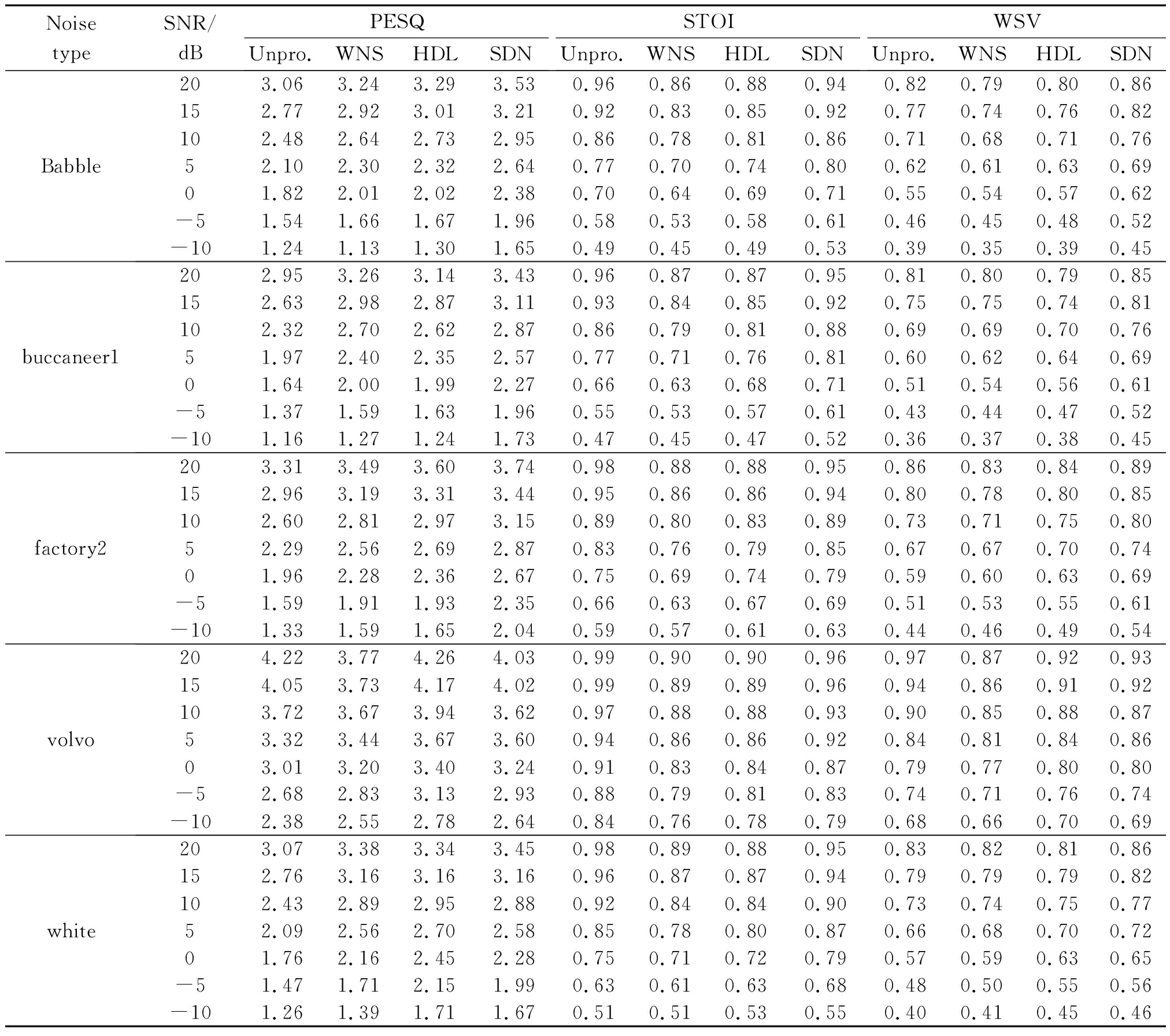

因为本文篇幅有限,故在表1中仅反映5种不同的噪声情况。表1使用了三种指标(PESQ、STOI和WSV)反映三种不同的语音增强算法(WNS、HDL和SDN)的性能。表1中的数值越大表示该方法的性能越好。

根据表1中的数据可知,在非平稳噪声情况下,本文提出方法大幅优于WNS和HDL。而在平稳噪声的情况下,SDN仍然比WNS更好。在对比所有噪声情况后,根据WSV数据,可以得出本文方法(SDN)对语音信号的质量的提升高于WNS与HDL。本文方法对语音信号造成的失真最低。

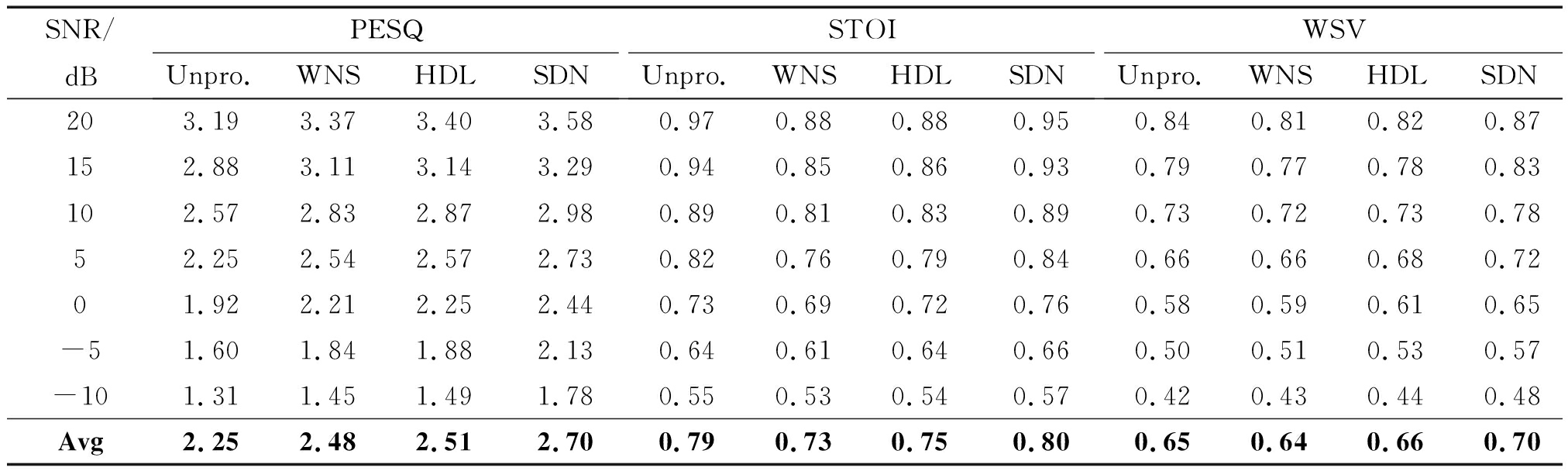

表2给出了2100条测试语音(15种噪声类型,每种噪声140条)经三种不同的语音增强方法后,按照相同信噪比、相同噪声类型取均值后得到的三种指标(PESQ、STOI、WSV)。分析PESQ得分可知,SDN优于WNS和HDL,并且随着信噪比的降低,SDN提升语音质量的幅度不断增加。分析STOI得分情况可知,WNS和HDL会较大幅度地降低语音短时客观可懂度。而本文提出的语音增强方法会提升信噪比低于10 dB的语音信号的短时客观可懂度。虽然本文方法会降低信噪比高于10 dB的语音信号的短时客观可懂度,但降低的幅度小于WNS与HDL。通过分析WSV指标可知,本文提出的语音增强方法可以适应不同信噪比的情况,能够有效的提升带噪语音的质量和可懂度。

表1 不同方法在不同SNR下的PESQ、STOI、WSV值

Tab.1 PESQ, STOI and WSV values of different methods under different SNRs

Noise typeSNR/dBPESQUnpro.WNSHDLSDNSTOIUnpro.WNSHDLSDNWSVUnpro.WNSHDLSDNBabble203.06 3.24 3.29 3.53 0.96 0.86 0.88 0.94 0.82 0.79 0.80 0.86 152.77 2.92 3.01 3.21 0.92 0.83 0.85 0.92 0.77 0.74 0.76 0.82 102.48 2.64 2.73 2.95 0.86 0.78 0.81 0.86 0.71 0.68 0.71 0.76 52.10 2.30 2.32 2.64 0.77 0.70 0.74 0.80 0.62 0.61 0.63 0.69 01.82 2.01 2.02 2.38 0.70 0.64 0.69 0.71 0.55 0.54 0.57 0.62 -51.54 1.66 1.67 1.96 0.58 0.53 0.58 0.61 0.46 0.45 0.48 0.52 -101.24 1.13 1.30 1.65 0.49 0.45 0.49 0.53 0.39 0.35 0.39 0.45 buccaneer1202.95 3.26 3.14 3.43 0.96 0.87 0.87 0.95 0.81 0.80 0.79 0.85 152.63 2.98 2.87 3.11 0.93 0.84 0.85 0.92 0.75 0.75 0.74 0.81 102.32 2.70 2.62 2.87 0.86 0.79 0.81 0.88 0.69 0.69 0.70 0.76 51.97 2.40 2.35 2.57 0.77 0.71 0.76 0.81 0.60 0.62 0.64 0.69 01.64 2.00 1.99 2.27 0.66 0.63 0.68 0.71 0.51 0.54 0.56 0.61 -51.37 1.59 1.63 1.96 0.55 0.53 0.57 0.61 0.43 0.44 0.47 0.52 -101.16 1.27 1.24 1.73 0.47 0.45 0.47 0.52 0.36 0.37 0.38 0.45 factory2203.31 3.49 3.60 3.74 0.98 0.88 0.88 0.95 0.86 0.83 0.84 0.89 152.96 3.19 3.31 3.44 0.95 0.86 0.86 0.94 0.80 0.78 0.80 0.85 102.60 2.81 2.97 3.15 0.89 0.80 0.83 0.89 0.73 0.71 0.75 0.80 52.29 2.56 2.69 2.87 0.83 0.76 0.79 0.85 0.67 0.67 0.70 0.74 01.96 2.28 2.36 2.67 0.75 0.69 0.74 0.79 0.59 0.60 0.63 0.69 -51.59 1.91 1.93 2.35 0.66 0.63 0.67 0.69 0.51 0.53 0.55 0.61 -101.33 1.59 1.65 2.04 0.59 0.57 0.61 0.63 0.44 0.46 0.49 0.54 volvo204.22 3.77 4.26 4.03 0.99 0.90 0.90 0.96 0.97 0.87 0.92 0.93 154.05 3.73 4.17 4.02 0.99 0.89 0.89 0.96 0.94 0.86 0.91 0.92 103.72 3.67 3.94 3.62 0.97 0.88 0.88 0.93 0.90 0.85 0.88 0.87 53.32 3.44 3.67 3.60 0.94 0.86 0.86 0.92 0.84 0.81 0.84 0.86 03.01 3.20 3.40 3.24 0.91 0.83 0.84 0.87 0.79 0.77 0.80 0.80 -52.68 2.83 3.13 2.93 0.88 0.79 0.81 0.83 0.74 0.71 0.76 0.74 -102.38 2.55 2.78 2.64 0.84 0.76 0.78 0.79 0.68 0.66 0.70 0.69 white203.07 3.38 3.34 3.45 0.98 0.89 0.88 0.95 0.83 0.82 0.81 0.86 152.76 3.16 3.16 3.16 0.96 0.87 0.87 0.94 0.79 0.79 0.79 0.82 102.43 2.89 2.95 2.88 0.92 0.84 0.84 0.90 0.73 0.74 0.75 0.77 52.09 2.56 2.70 2.58 0.85 0.78 0.80 0.87 0.66 0.68 0.70 0.72 01.76 2.16 2.45 2.28 0.75 0.71 0.72 0.79 0.57 0.59 0.63 0.65 -51.47 1.71 2.15 1.99 0.63 0.61 0.63 0.68 0.48 0.50 0.55 0.56 -101.26 1.39 1.71 1.67 0.51 0.51 0.53 0.55 0.40 0.41 0.45 0.46

表2 不同方法在不同SNR下的PESQ、STOI、WSV的平均值

Tab.2 The average value of PESQ, STOI and WSV of different methods under different SNRs

SNR/dBPESQUnpro.WNSHDLSDNSTOIUnpro.WNSHDLSDNWSVUnpro.WNSHDLSDN203.193.373.403.580.970.880.880.950.840.810.820.87152.883.113.143.290.940.850.860.930.790.770.780.83102.572.832.872.980.890.810.830.890.730.720.730.7852.252.542.572.730.820.760.790.840.660.660.680.7201.922.212.252.440.730.690.720.760.580.590.610.65-51.601.841.882.130.640.610.640.660.500.510.530.57-101.311.451.491.780.550.530.540.570.420.430.440.48Avg2.252.482.512.700.790.730.750.800.650.640.660.70

4.4 对纯净语音添加多种噪声

本小节将讨论语音信号叠加多种噪声的情况。采用PESQ和STOI作为评价指标,对比三种语音增强方法的得分情况,给出客观结论。

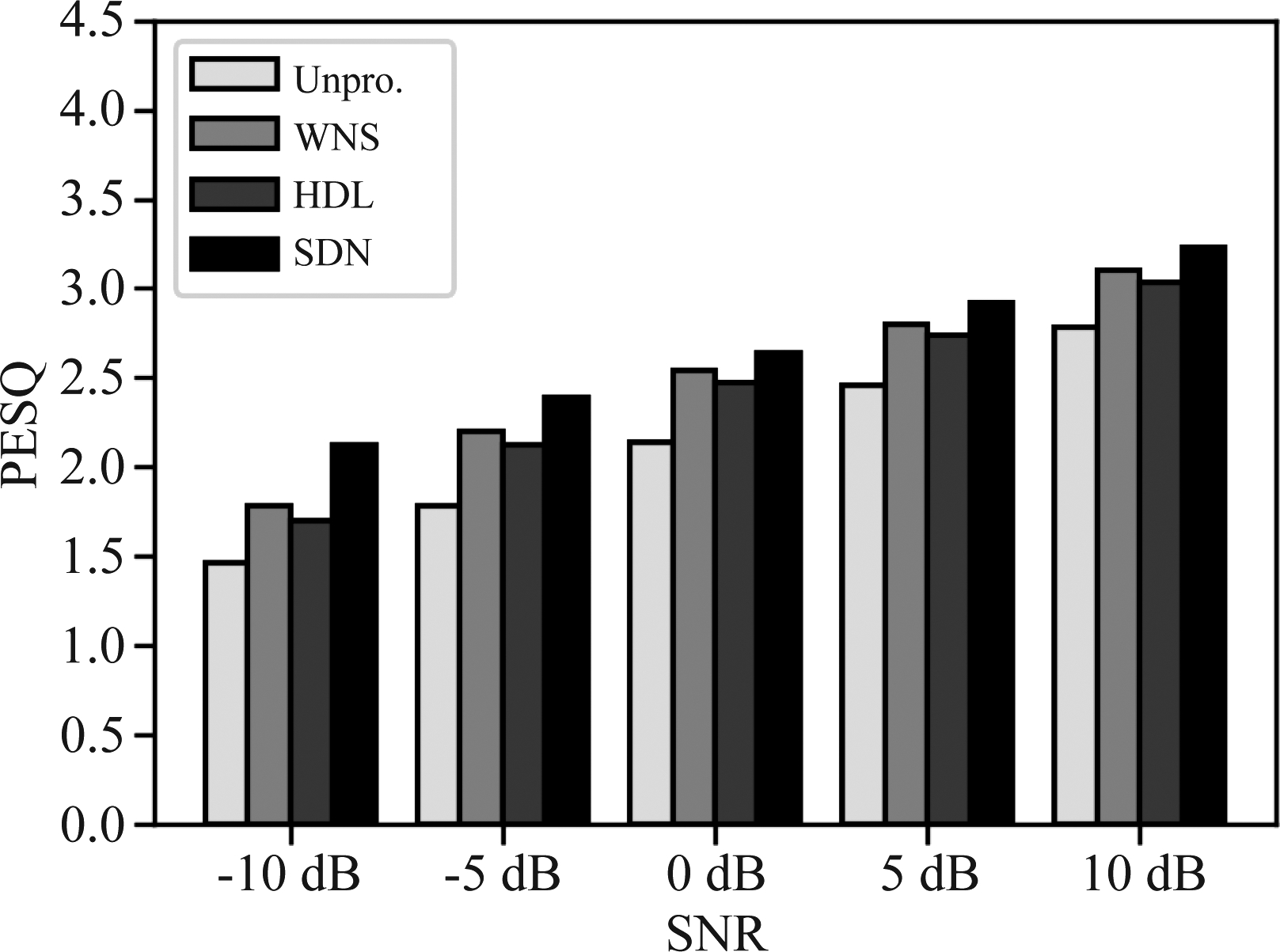

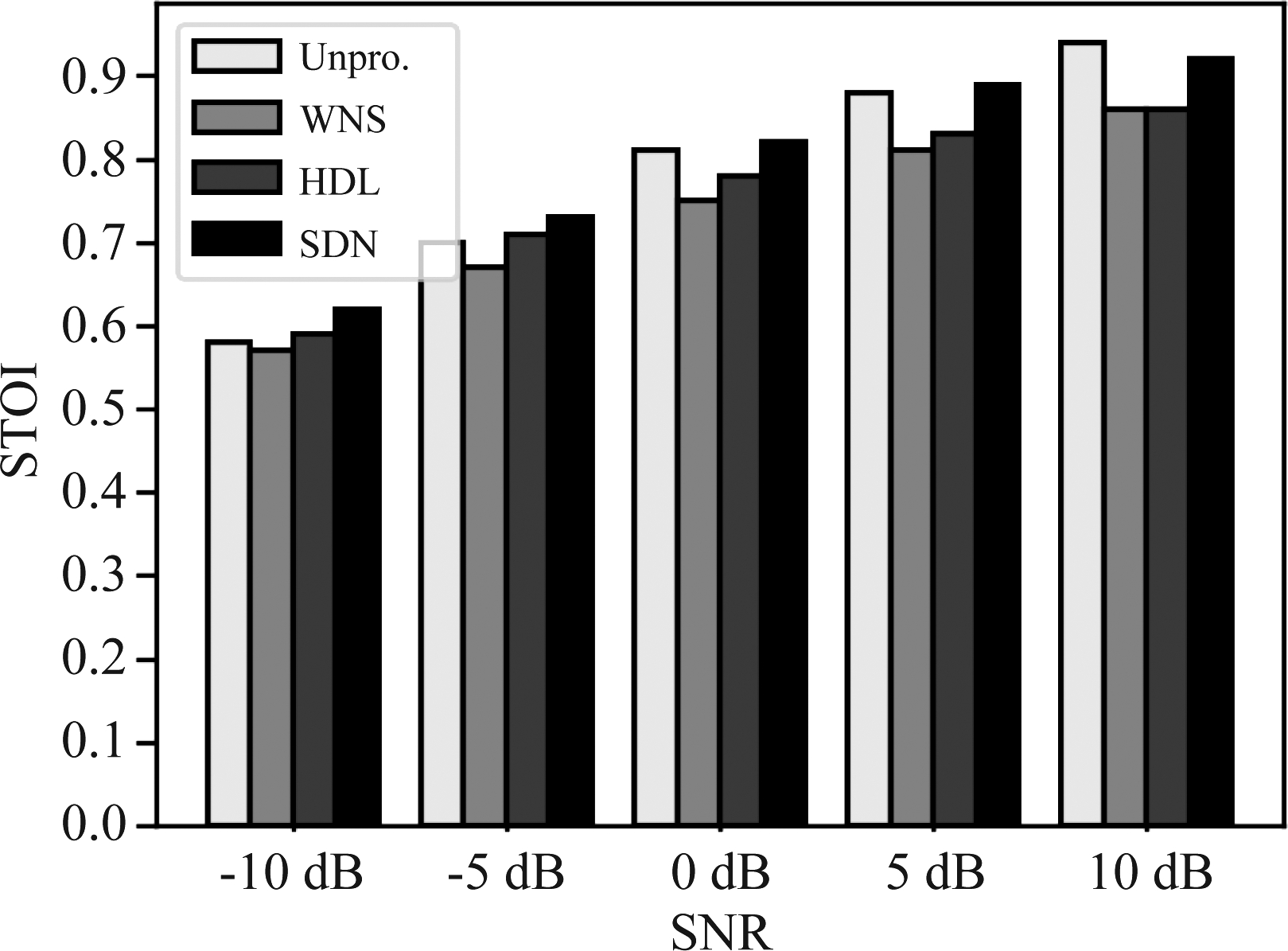

图5和图6分别表示三种语音增强方法(SDN、WNS和HDL)对添加5种噪声的语音信号进行语音增强的PESQ和STOI得分。从PESQ得分情况可知,WNS与HDL两种方法仅能小幅度提升低信噪比的语音信号的质量。而SDN方法能够较大幅度提升低信噪比语音信号的质量。从STOI得分情况可知,WNS会降低语音信号的短时客观可懂度,HDL仅能小幅度提升信噪比小于-5 dB的语音信号的短时客观可懂度,对信噪比高于-5 dB的语音信号则是起反作用。SDN对信噪比低于5 dB的语音信号的短时客观可懂度有提升作用,对信噪比高于5 dB的语音信号有轻微的反作用。由此看来,本文提出的语音增强方法优于WNS和HDL。

图5 不同方法在不同信噪比下对叠加5种噪声的语音信号进行语音增强后PESQ的平均值

Fig.5 The average values of PESQ after speech enhancement of speech signals superimposed with 5 kinds of noises by different methods under different SNRs

图6 不同方法在不同信噪比下对叠加5种噪声的语音信号进行语音增强后的STOI的平均值

Fig.6 The average values of STOI after speech enhancement of speech signals superimposed with 5 kinds of noises by different methods under different SNR

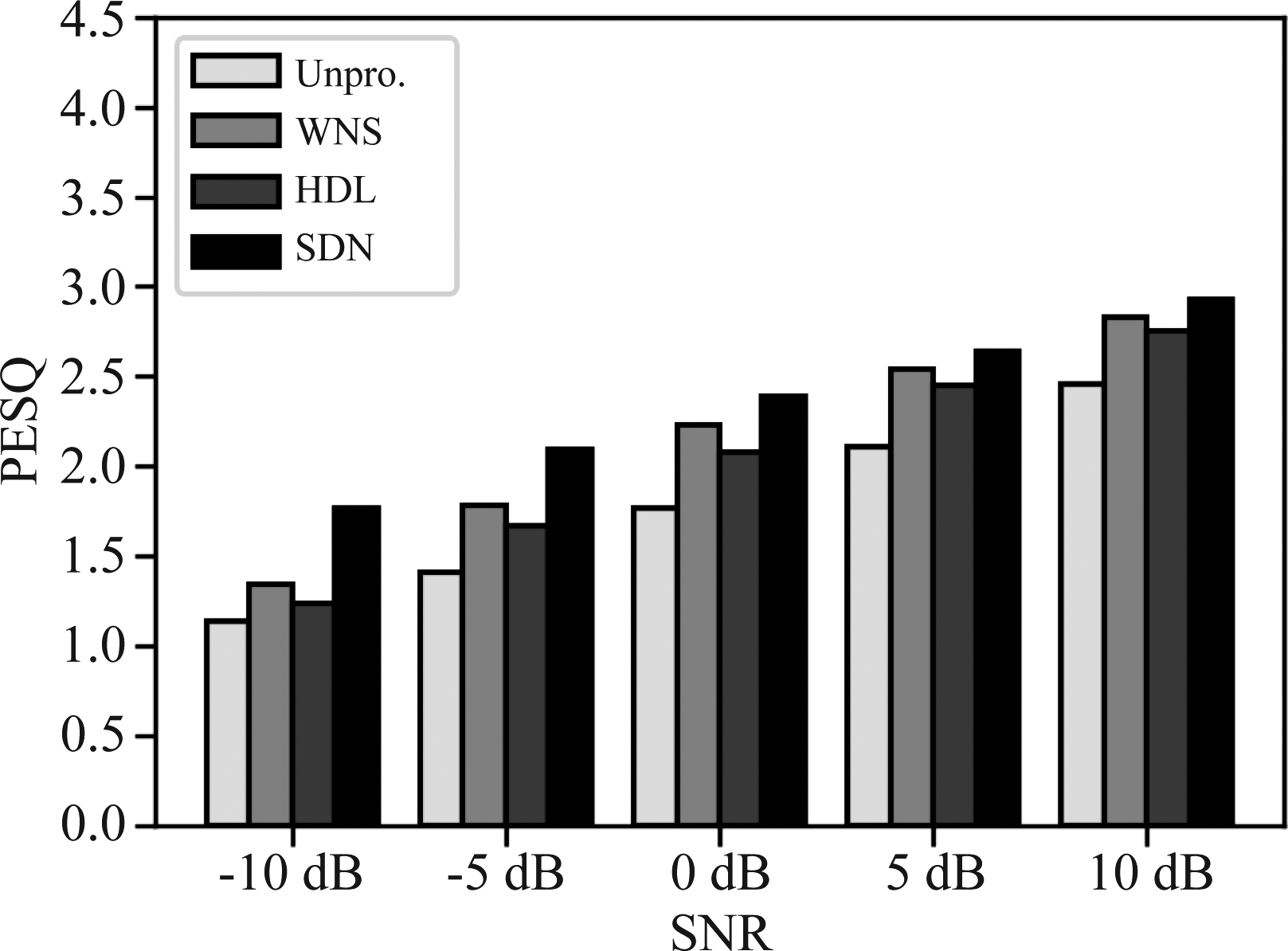

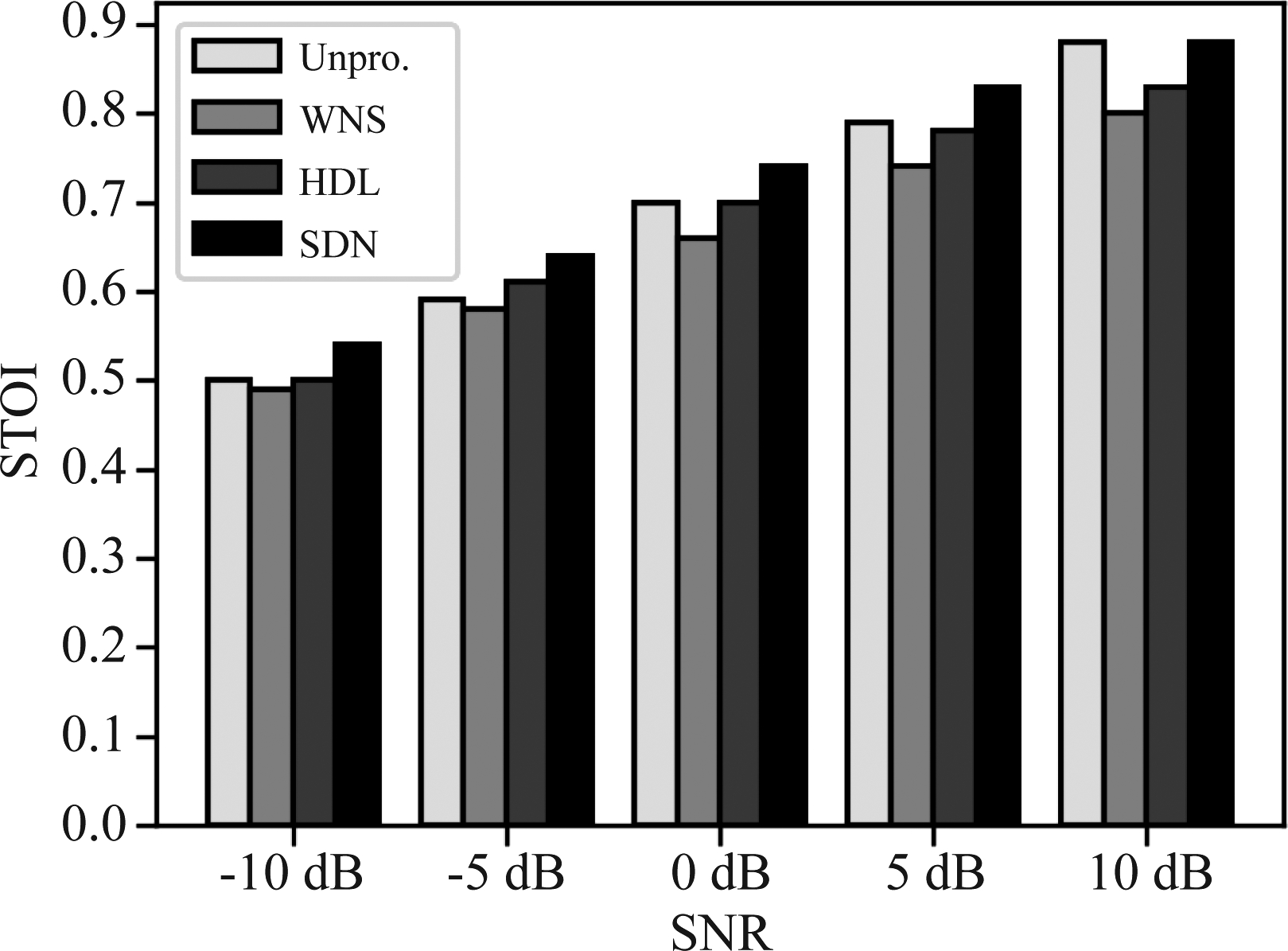

图7和图8表示三种语音增强方法(SDN、WNS和HDL)对添加15种噪声的语音信号进行语音增强的PESQ和STOI得分。分析PESQ得分情况可知, WNS与HDL对信噪比为-10 dB的语音信号质量的改善十分有限,几乎不能提升,而SDN能够较大幅度的提升语音质量。且在信噪比高于-5 dB的情况,SDN提升语音质量的幅度均高于WNS与HDL。从STOI得分情况分析可知,SDN能够提高-10 dB到10 dB语音信号的短时客观可懂度,而WNS与HDL均是对语音信号造成失真,降低了语音信号的短时客观可懂度。由此看来,纯净语音在叠加15种噪声的情况下,本文提出的基于奇异谱分析的深度神经网络新方法的语音增强性能优于WNS与HDL。

图7 不同方法在不同信噪比下对叠加15种噪声的语音信号进行语音增强后PESQ的平均值

Fig.7 The average values of PESQ after speech enhancement of speech signals superimposed with 15 kinds of noises by different methods under different SNRs

图8 不同方法在不同信噪比下对叠加15种噪声的语音信号进行语音增强后STOI的平均值

Fig.8 The average values of STOI after speech enhancement of speech signals superimposed with 15 kinds of noises by different methods under different SNRs

4.5 仿真实验的总结

本节主要完成了对叠加单种噪声、多种噪声的语音信号的语音增强实验。从叠加单种噪声的语音信号的语音增强实验可知,本文提出的语音增强方法能够较大幅度提升低信噪比语音信号的质量,降低对语音信号造成的失真。从叠加多种噪声的语音信号的语音增强实验可知,当叠加了15种噪声时,WNS和HDL两种方法几乎不能提升信噪比为-10 dB的语音信号,而本文提出的方法依然能够较大幅度改善语音质量。在多噪声情况下,WNS和HDL方法大多降低了语音信号的短时客观可懂度,SDN方法能够有效地提升带噪语音短时客观可懂度。由此可见,本文提出的语音增强方法能够有效的提高语音信号的可懂度,降低语音信号的失真。

5 结论

针对现有方法的局限性,本文提出了一种基于奇异谱分析的深度神经网络语音增强新方法。本文使用奇异谱分析算法将带噪语音预处理,以初步分离成语音信号与噪声,并将分离得到的语音信号及噪声用于神经网络模型的训练。从而得到了性能更优的模型。本文在干净语音重建环节,同时在使用估计得到的对数功率谱和带噪语音的对数功率谱,并加入权重系数,使得用于重建干净语音的幅度谱同时具有二者的信息,因而本文提出的语音增强方法具有适应不同信噪比情况的能力。根据仿真实验所示,有效地提升了语音信号的质量,减少对语音信号造成的失真。验证了本文方法有效性、鲁棒性。

[1] Lim J S, Oppenheim A V. Enhancement and bandwidth compression of noisy speech[J]. In Proceedings of the IEEE, 1979, 67(12): 1586-1604.

[2] Arslan L M. Modified Wiener filtering[J]. Signal Processing, 2006, 86(2): 267-272.

[3] Hasan M K, Salahuddin S, Khan M R. A modified a priori SNR for speech enhancement using spectral subtraction rules[J]. IEEE Signal Processing Letters, 2004, 11(4): 450- 453.

[4] Boll S. Suppression of acoustic noise in speech using spectral subtraction[J]. IEEE Transactions on Acoustics, Speech, and Signal Processing, 1979, 27(2): 113-120.

[5] Ephraim Y, Malah D. Speech enhancement using a minimum-mean square error short-time spectral amplitude estimator[J]. IEEE Transactions on Acoustics, Speech, and Signal Processing, 1984, 32(6): 1109-1121.

[6] Ephraim Y, Van Trees H L. A signal subspace approach for speech enhancement[J]. IEEE Transactions on Speech and Audio Processing, 1995, 3(4): 251-266.

[7] Kang T G, Shin J W, Kim N S. DNN-based monaural speech enhancement with temporal and spectral variations equalization[J]. Digital Signal Processing, 2018, 74(2): 102-110.

[8] Liu D, Smaragdis P, Kim M. Experiments on deep learning for speech denoising[C]∥In INTERSPEECH-2014: 2685-2689.

[9] Lee J, Kim K, Shabestary T, et al. Deep bi-directional long short-term memory based speech enhancement for wind noise reduction[C]∥2017 Hands-free Speech Communications and Microphone Arrays (HSCMA), 2017: 41- 45.

[10] Xu Y, Du J, Dai L R, et al. A Regression Approach to Speech Enhancement Based on Deep Neural Networks[J]. IEEEACM Transactions on Audio, Speech, and Language Processing, 2015, 23(1): 7-19.

[11] 鲍长春, 项扬, 基于深度神经网络的单通道语音增强方法回顾[J]. 信号处理, 2019, 35(12): 1931-1941. DOI:10.16798/j.issn.1003-0530.2019.12.001.

Bao Changchun, Xiang Yang. Review of Monaural Speech Enhancement Based on Deep Neural Networks[J]. Journal of Signal Processing, 2019, 35(12): 1931-1941. DOI:10.16798/j.issn.1003-0530.2019.12.001.(in Chinese)

[12] 时文华, 张雄伟, 邹霞, 等. 利用深度全卷积编解码网络的单通道语音增强[J]. 信号处理, 2019, 35(4): 631- 640. DOI:10.16798/j.issn.1003-0530.2019.04.014.

Shi Wenhua, Zhang Xiongwei, Zou Xia, et al. Single Channel Speech Enhancement Based on Deep Fully Convolutional Encoder-Decoder Neural Network[J]. Journal of Signal Processing, 2019, 35(4): 631- 640. DOI:10.16798/j.issn.1003-0530.2019.04.014.(in Chinese)

[13] Xu Y, Du J, Dai L R, et al. An Experimental Study on Speech Enhancement Based on Deep Neural Networks[J]. IEEE Signal Processing Letters, 2014, 21(1): 65- 68.

[14] Golyandina N, Zhigljavsky A. Singular Spectrum Analysis for Time Series[M]. Germany: Springer Science & Business Media, 2013: 1-118.

[15] Doclo S, Moonen M. GSVD-based optimal filtering for single and multimicrophone speech enhancement[J]. IEEE Transactions on Signal Processing, 2002, 50(9): 2230-2240.

[16] Cui X Y, Chen Z, Yin F. Speech enhancement based on simple recurrent unit network[C]∥Applied Acoustics, 2020, 157(1): 107019.

[17] Valin J. A Hybrid DSP/Deep Learning Approach to Real-Time Full-Band Speech Enhancement[C]∥2018 IEEE 20th International Workshop on Multimedia Signal Processing (MMSP), 2018: 1-5.

[18] Zue V, Seneff S, Glass J. Speech database development at MIT: TIMIT and beyond[J]. Speech Commun., 1990, 9(4): 351-356.

[19] Varga A, Steeneken H J M. Assessment for automatic speech recognition: II[J]. NOISEX-92: A database and an experiment to study the effect of additive noise on speech recognition systems. Speech Communication, 1993, 12(3): 247-251.

[20] Rix A, Beerends J, Hollier M P, et al. Perceptual evalulation of speech quality (PESQ): An objective method for end-to-end speech quality assessment of narrowband telephone networks and speech codecs[C]∥Proceedings of the 26th IEEE International Conference on Acoustics, Speech, and Signal Processing. Piscataway, NJ: IEEE, 2001: 749-752.

[21] Taal C H, Hendriks R C, Heusdens R, et al. A short-time objective intelligibility measure for time-frequency weighted noisy speech[C]∥2010 IEEE International Conference on Acoustics, Speech and Signal Processing, Dallas, TX, 2010: 4214- 4217.

[22] Seke E, Ozkan K. A new speech signal denoising algorithm using common vector approach[J]. International Journal of Speech Technology, 2018, 21(7): 659- 670.