1 引言

语音增强的目的是把纯净语音信号从含有噪声的语音中分离出来,在移动语音通信、助听设备和语音识别等系统中具有广泛的应用前景。整体而言,语音增强算法可以分为无监督学习和有监督学习两类。无监督学习的语音增强算法如谱减法、统计模型法和子空间法等在设计时往往需要对信号做出很多假设,因此在实际应用中效果经常不如预期。而有监督学习的方法需要使用大量数据训练得到从带噪语音到纯净语音的映射关系,且不需要对信号做任何假设,所以更符合真实的应用场景,但对设备计算能力和数据量要求较高。近年来随着设备计算能力的提升和国内外深度学习技术的发展,基于深度学习的有监督语音增强算法已经成为主流。

基于深度学习的有监督语音增强算法由Wang等于2012年首次提出[1],将语音增强作为分类问题,使用子带深度神经网络(Subband Deep Neural Networks)对带噪语音的时频单元进行分类,计算出其理想二值掩蔽(Ideal Binaural Mask, IBM)从而恢复出纯净语音。这种DNN算法对带有非稳定噪声的语音信号产生显著的可懂度和语音质量的改善。Y. Wang等将语音信号使用64通道的Gammatone滤波器获得64个子带信号[2],并从中提取声学特征以估计IBM,这种方式证明可以使DNN学习到更多的特征,并带来了语音可懂度的显著改善。在2014年Yong Xu等人的研究中[3- 4],使用多层感知机(Multilayer Perception, MLP)对含噪语音的对数功率谱(Log-Power Spectral,LPS)进行预测,直接得到纯净语音的LPS。MLP可以看成是由全连接层构成的深度神经网络,该算法在训练阶段分别提取含噪语音和纯净语音的LPS作为MLP的训练特征(Features)和训练目标(Labels),利用反向传播算法(Back Propagation,BP)来计算特征与目标之间的映射关系。使用MLP预测输出的LPS以及含噪语音的相位信息进行波形重构,从而得到增强后的语音信号。在训练完成后,使用未经训练的含噪语料测试网络性能及泛化能力。实验结果表明,经过训练的MLP的增强效果实现了对未知语料0.4~0.5的PESQ分数的提升,优于传统的典型增强方法。而上述工作也奠定了基于深度学习的语音增强这一领域的雏形,很多后续的研究也都针对神经网络的三个重要组成:输入特征、训练目标和网络模型进行改进和优化。卷积神经网络(Convolutional Neural Network, CNN)是在图像处理领域取得广泛应用的神经网络,其通过使用卷积核(Kernel)的结构对特征图进行局部采样,并通过增加模型深度即卷积层层数的方法提取到更加抽象的特征。由于语音的时频特征图可以表示为二维图像,因此很适合利用CNN进行语音增强任务。如Park 等人于2016年提出了一种全卷积网络[5]来计算含噪语音频谱到纯净语音频谱之间的映射关系(mapping)。相比全连接网络,CNN可以更准确地获取输入语音的局部特性,从而在语音增强中有利于信号高频成分的恢复,提高语音质量及可懂度[6]。此外,由于全连接或卷积神经网络进行语音增强都是对输入的二维时频特征图进行处理,并没有考虑到语音帧与帧之间的联系,这对于具有时序特性的语音信号来说,帧与帧之间的相关性就被网络忽略了。因此循环神经网络(Recurrent Neural Network,RNN)被应用于语音处理的任务中。RNN在预测当前时刻的信息时,同时考虑到了其在之前各个时刻所输出的信息,并通过时序反向传播算法(Back Propagation Through Time, BPTT)来计算误差函数。长短时记忆网络(Long Short Term Memory, LSTM)是一种广泛应用的RNN网络,可以有效解决RNN普遍存在的梯度消失或梯度爆炸的问题。LSTM的细胞模块(cell)可以充分利用长期和短期的时序信息,从而更好的计算带噪语音和纯净语音的时序相关信息,提升语音增强的性能。Lei Sun等人在2017年的研究中[7],提出了使用LSTM-RNN进行语音增强的方法。他们使用含噪语音的LPS作为输入特征,并分别使用LSTM模型预测了纯净语音的LPS和理想比值掩模(Ideal Ratio Mask,IRM)。结果表明相比DNN模型,LSTM可以有效提升语音增强的语音质量(PESQ)和可懂度(STOI)。由于MLP,CNN,LSTM等模型在语音增强任务中都表现出了各自的优势,因此当前深度学习领域存在的研究趋势是将上述模型作为基础模块,构建更深、更复杂的网络模型,来达到更好的语音增强性能,并兼顾性能与效率。

U-Net是一种最先用于图像分割的新型网络模型[8],由编码层,中间层,解码层三部分构成。编码层与解码层一般由相同层数的卷积层构成,且对应卷积层之间存在“跳跃连接”(Skip connection)来进行特征传递,由于在图像分割任务中性能优异,因而也开始为语音信号处理领域所重视。Wave-U-Net由Daniel等人提出[9],用于声源分离任务中。Wave-U-Net采用了全卷积U-Net结构,且不同于基于时频特征的模型,其可以直接在时域对语音信号进行一维卷积,不需进行时频变换,而且在音乐人声分离任务中达到了目前最佳的性能,显示出很强的特征提取与信号恢复的能力。Tan等人于2018年提出了卷积循环网络(Convolutional Recurrent Neural Network,CRNN)[10],以LSTM模块作为U-Net模型的中间层,来实现对语音信号时序相关信息的计算。并且在编码层和解码层使用因果卷积来保证实时语音处理中的因果性。该模型直接使用信号的时频幅度谱作为特征和标签,相比于多层LSTM,在减少了训练参数的同时提高了增强语音的质量和可懂度。2019年相似的卷积循环网络结构被进一步推广至双通道信号[11]和时域信号的语音增强中[12],表现出很大的潜力。在目前对卷积循环网络的研究中,中间层主要起到了计算时序相关性并将编码层提取到的抽象特征传递给解码层的作用。

由于对于卷积层,训练过程是通过固定形状的卷积核以固定步长遍历特征图完成的,这对于图像处理来说可以很好的提取相邻像素区域的相关性。然而语音的语谱图是以时间和频率两个不同的尺度为坐标轴,因此对于卷积循环网络这种以卷积层的堆叠来提取语音语谱特征的方式,可以很有效的提取语谱图的邻域相关性(Neighbor Correlation),即相邻采样范围的相关性。由于人类发声器官的共振特性,语音的语谱图具有天然的谐波特性(Harmonic),即在语谱图上,基因频率(Pitch)整数倍的位置都存在共振峰,且这一特性在一定的频率范围内都存在,因此我们称之为频率维度上的“全局相关性”(Global Correlation)。而卷积网络并不能很好的考虑到语音谐波的全局相关性,这在一定程度上会导致增强后的语音失真和语音可懂度的降低。最近,Yin等人[15]提出了一种同时预测语音幅度谱和相位谱的双流网络,其中对应幅度谱的网络分支使用了时频注意力机制(Time-Frequency Attention Mechanism)模块来提取特征的时间-频率相关性。相比于多层卷积网络,时频注意力机制的引入可以使网络更好地提取谐波在频率维度的相关特性,从而在语音增强时有利于重构出被噪声淹没的高次谐波,使得恢复出的语音频谱更加完整,有利于整体音质的改善以及可懂度的提升。由于时频注意力机制具有上述优点,我们将其引入了卷积神经网络中,使其参与网络编码层的特征提取工作。另外,由于时频注意力模块只包含两个卷积层以及必要的维度变换、跳跃连接操作,对网络整体计算量和参数量的影响并不大,而且输入、输出特征图张量的维度保持一致,因此也可以很好的进行在其他网络中的扩展工作。

在下文中,第2节详细阐述了卷积循环网络基线(Baseline)模型和时频注意力机制的模型结构,并提出了结合时频注意力机制的卷积循环网络;第3节详细描述了实验设置和实验过程,并提供了根据主流评估指标的实验结果;第4节总结了全文并提出了进一步的研究思路。

2 算法提出

2.1 卷积循环网络

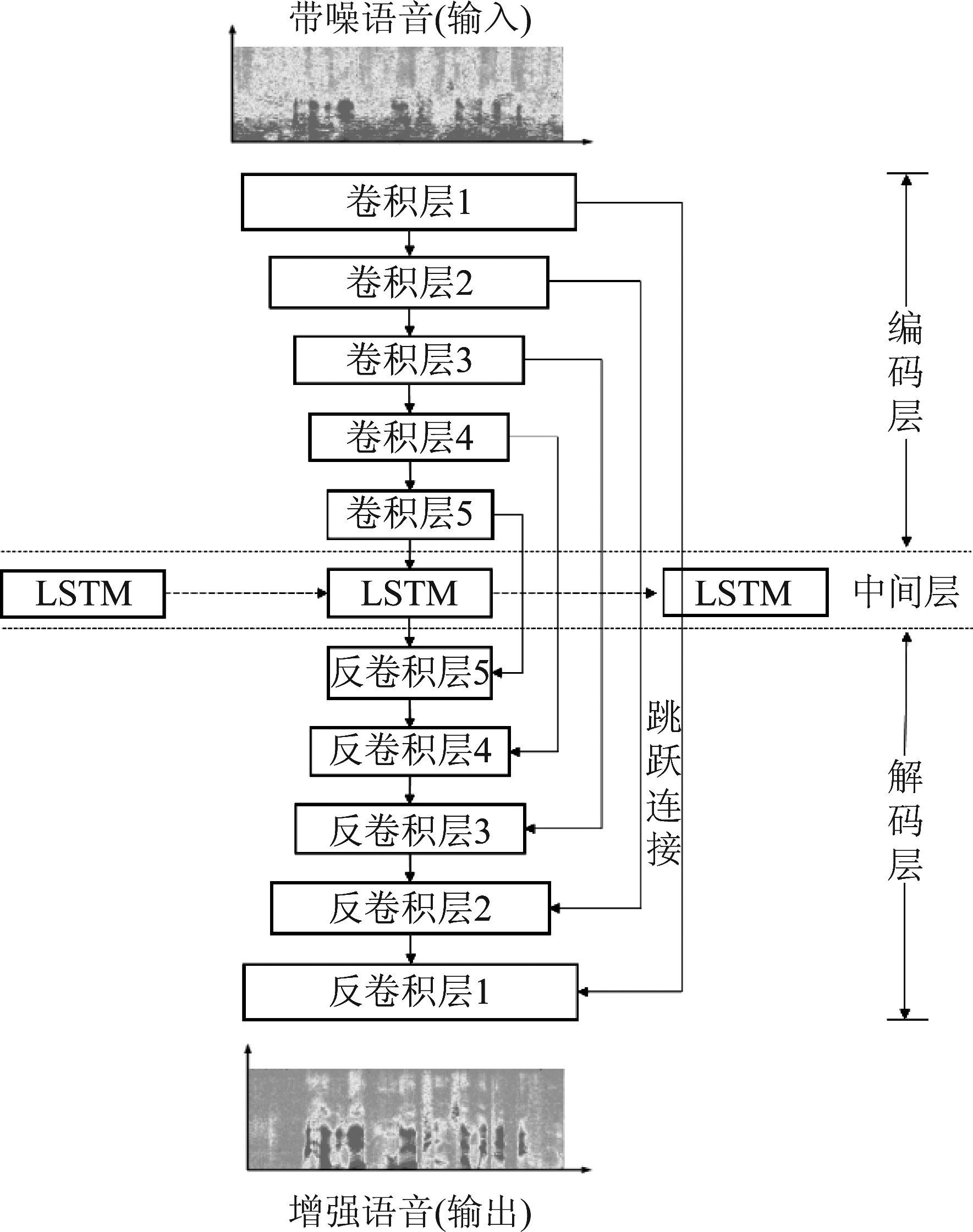

本文所采用的基线卷积循环网络模型如图1所示。其中,输入信号为带噪语音的幅度谱,即以时间和频率为尺度的二维特征图,经过训练网络输出增强语音的幅度谱,并使用带噪语音的相位重构波形信号。网络编码层包含5层卷积层,每层卷积层都由二维卷积层(2D Convolution)、批标准化层(Batch Normalization,BN)和激活函数组成。批标准化的作用是在神经网络训练过程中,保持卷积层的输出的数据满足独立同分布假设。相关工作表明,批标准化的引入可以有利于网络误差函数的收敛,加快训练效率。BN层之后的激活函数使用了含参修正线性单元(Parametric Rectified Linear Unit, PReLU)。在此模型中,多个编码层逐层对信号提取信号的抽象特征,对应的是每层使用的卷积核(Kernel)数量成倍增加,而每层输出的特征图在频率维度减少,而时间维度保持不变。这是通过控制参与训练的卷积核的大小、数量和步长来实现的。通过编码层后,输出特征图在时间维度和输入信号一致,这一特性带来了该模型实时处理语音信号的能力,即输入信号可以为任意长度(即语音的帧数),卷积层的处理不会对语音带来帧数上的变化,并且由于没有全连接层的设置,因此不存在超参数不匹配的问题,从而每一批(Batch)的训练语料不必保证相同的长度。中间层采用了一层LSTM的设置,由于LSTM只能处理二维特征图,因此经编码层输出的多维特征张量(Tensor)需通过维度调整(Reshape)操作降低维度满足LSTM的要求,来使网络完成对信号时序特性的学习,相应的,也需要将LSTM输出的张量重构来增加维度。另外LSTM层横向的虚线表示在前后时序状态下LSTM元胞状态的传递过程。对应于编码层,解码层的设置可以视为其逆过程,每个反卷积层由二维反卷积(2D Deconvolution)、批标准化和PReLU组成,其中反卷积层可以视为卷积层的逆过程,通过卷积核特定步长的移动将特征图扩大。需要注意网络中跳跃连接的设置,每个卷积层输出的特征都同时被输入了对应的一个反卷积层,并与上一个反卷积层输出的特征相拼接,从而将特征图扩大了一倍,这一操作有利于解码层对信号的恢复。

图1 卷积循环网络模型流程图

Fig.1 Convolutional recurrent network structure

2.2 时频注意力机制

由于语音语谱的时频特征图不仅包含局部相关的特征,还包含在频率轴延伸的多次谐波的相关性,这一特性是非局部的,而堆叠的二维卷积层很难有全局的感受野(Receptive Field)。因此我们引入时频注意力机制来给神经网络在频率维度全局观察的特性。图2表示了本文所应用的时频注意力机制的主要构成,其输入信号到输出信号的映射可由下列各式表出:

S′=Conv1×1(Sin)

(1)

Satten=Conv1d(reshape(S′))

(2)

So=Satten⊗S′

(3)

图2 时频注意力机制流程图

Fig.2 Time-frequency attention mechanism structure

各层输入的张量维度如图所示,C表示特征图的通道数,可以通过卷积层卷积核的数量进行调整;T表示输入语谱特征图的帧数,即时间维;F则表示输入语谱特征的频点数,即频率维。

式(1)表示输入特征Sin经过使用1×1卷积核的二维卷积层,来适当增加或减少输入特征图的通道数Ci至C′,得到特征图S′;

式(2)表示注意力机制对特征图的处理,reshape和Conv1d分别表示时频注意力中的维度重整和一维卷积操作,目的是预测一个“注意力映射图”(Attention Map),其特征点对应于输入特征图各个特征点的权重,其维度和输入特征Sin的维度保持一致;

式(3)表示注意力映射图Satten与通过跳跃连接传递过来的原始特征图Sin进行点对点相乘(Point-wise Multiply),得到加权后的输入特征。将输入特征加权后,需要经过频域的线性层或称全连接层(Fully Connected Layer, FC),每帧语音信号对应一个在频率维的线性变换矩阵(Transformation Matrix),由于训练时所有语料的频率分辨率相同,因此该线性层的输入特征维度保持不变。即:

Sout(i)=Xtr·So(i)

(4)

式中Xtr表示线性层对应的变换矩阵,是一个F × F维度的方阵;So(i)的维度为Ci×F,其中参数i = 0, 1, …, T-1,依次对应T个语音帧序列。由于模块中的线性层不对特征维度进行调整,因此Sout(i)的维度为Ci×F。将所有语音帧变换后的特征沿时间维拼接,即可得到完整的频域加权特征Sout。且经过线性层后的输出特征Sout中的每帧语音的特征点都包含了来自输入特征图Sin中对应语音帧完整频带的相关信息,即包含全局频带相关信息的特征流,继续进入后续网络的特征提取过程。在这一模块中,每个卷积层后都带有批标准化层BN和ReLU激活函数层,以保证训练过程中网络的收敛。

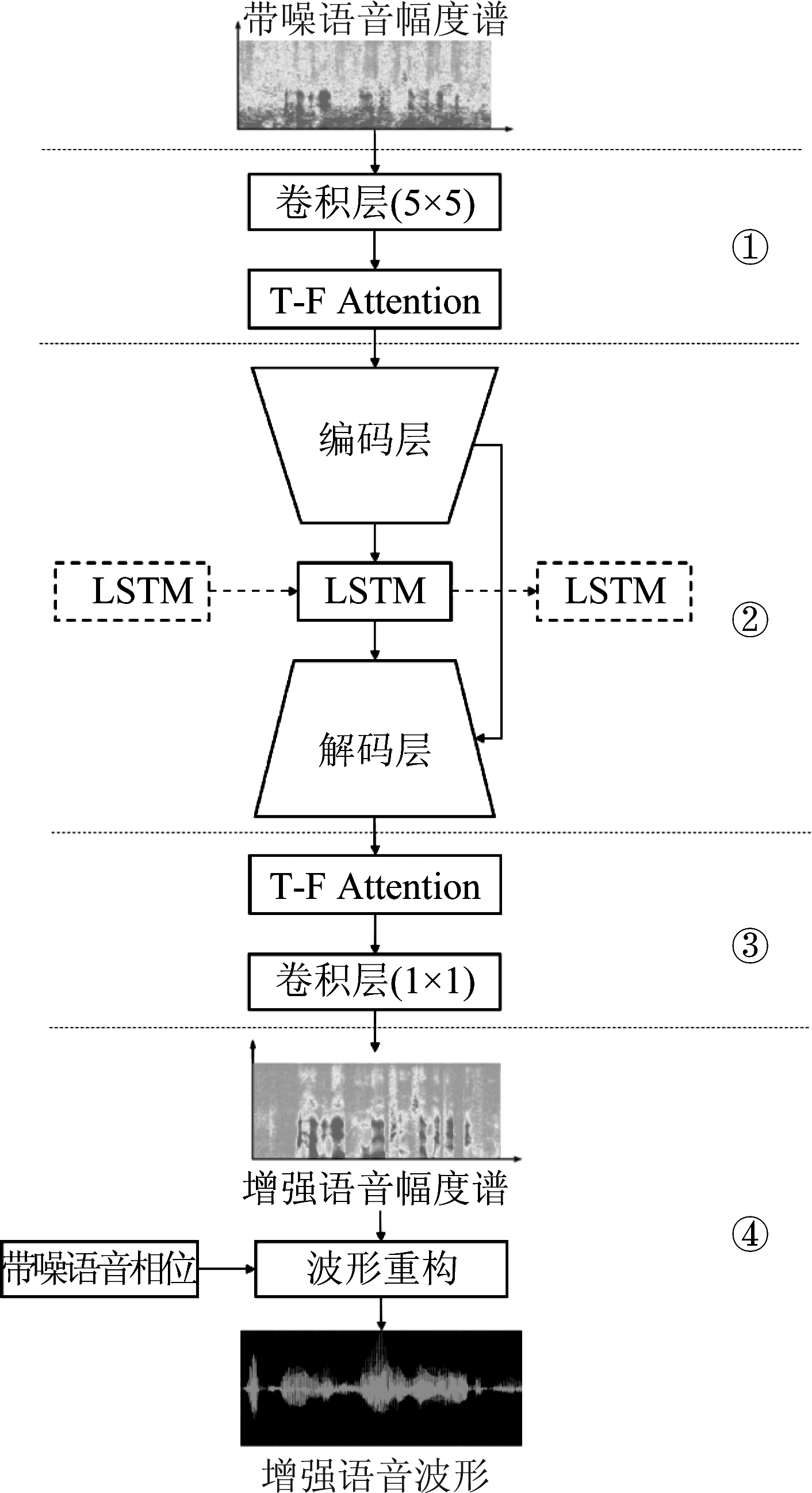

2.3 引入时频注意力机制的卷积神经网络

图3为结合时频注意力机制的卷积神经网络的主要结构流程图,可以划分为四部分。其中①,③表示加载在CRNN前后的时频注意力模块,其结构和2.2节所述保持一致,并添加了二维卷积层以进行数据预处理和后处理,并通过补零(same-padding)操作使得特征图在通过卷积层前后维度保持一致。②表示2.1节所述卷积循环网络模块,图中对编码层和解码层做了一定的简化。主要网络模块的输入、输出维度和超参数设置如表1所示。

图3 引入时频注意力机制的卷积循环网络流程图

Fig.3 Convolutional Recurrent Network with time-frequency attention mechanism

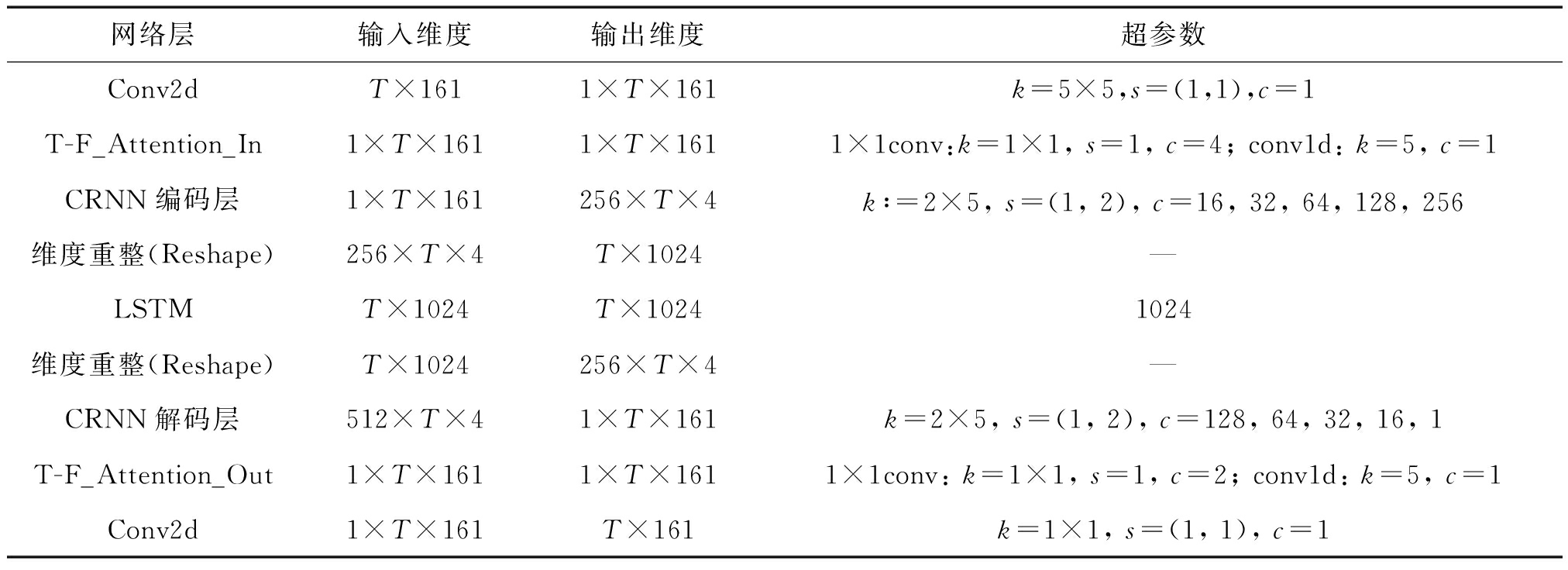

表1 网络特征维度及参数设置

Tab.1 Feature size and parameter settings

网络层输入维度输出维度超参数Conv2dT×1611×T×161k=5×5,s=(1,1),c=1T-F_Attention_In1×T×1611×T×1611×1conv:k=1×1, s=1, c=4; conv1d: k=5, c=1CRNN编码层1×T×161256×T×4k:=2×5, s=(1, 2), c=16, 32, 64, 128, 256维度重整(Reshape)256×T×4T×1024—LSTMT×1024T×10241024维度重整(Reshape)T×1024256×T×4—CRNN解码层512×T×41×T×161k=2×5, s=(1, 2), c=128, 64, 32, 16, 1T-F_Attention_Out1×T×1611×T×1611×1conv: k=1×1, s=1, c=2; conv1d: k=5, c=1 Conv2d1×T×161T×161k=1×1, s=(1, 1), c=1

整体上,网络输入输出特征维度均为T×161,T表示每批语料的帧数,幅度谱的频率维度为161维,通过补0的方式将所有语料长度与Batch中最长语料一致。在表中超参数一列,k表示卷积核大小,其维度由卷积层决定;s表示卷积核沿特征图移动的步长(Stride),设某一维步长为N,特征图在该维的长度为L,则卷积后输出特征图该维的长度为L/N;c表示卷积层的通道数,可以由此调整输出特征图的通道数。经最后一层卷积层输出后,将特征图进行降维,得到T × 161维的输出特征图,并在训练过程中与训练标签进行回归拟合,从而完成完整的训练过程。

3 实验设置

在由语音波形计算幅度谱的过程中,需要对语音信号进行短时傅里叶变换(Short Time Fourier Transform,STFT)。为此需要对语音进行分帧、加窗操作,以获得由特定频率分辨率的语音语谱。实验中语料采样率均为16 kHz,语音帧长设置为20 ms,即320个采样点,帧移设为10 ms并加汉明窗(Hamming window)减少频谱泄露。逐帧进行STFT后需要取幅度谱(Amplitude),由于STFT频谱的共轭对称特性,我们可以获得161维的STFT幅度谱作为含噪语音的输入特征以及纯净语音的训练目标。

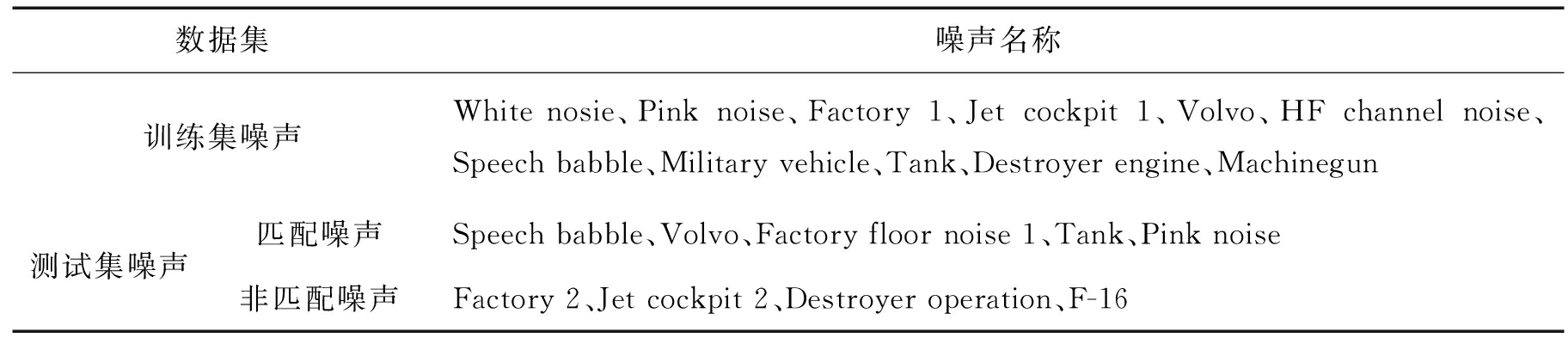

实验中使用的纯净语音随机选取自TIMIT数据库[12],其中训练集包含1000条语料,测试集包含200条语料。使用的噪声来自NoiseX-92数据集[13],共15类不同的环境噪声。带噪语音需要将纯净语音和噪声在特定信噪比下进行混合,混合方式是随机选取语料和噪声,使用不同信噪比进行叠加。其中选取的信噪比为-5 dB,0 dB,5 dB,10 dB,15 dB,并将噪声划分为匹配噪声(即训练集所用噪声)和非匹配噪声(即集外噪声),以测试网络在不同噪声和不同信噪比下的泛化能力,划分方式如表2所示。最后我们混合生成了40000条训练集语料和3000条测试集语料(包含2000条匹配噪声语料和1000条非匹配噪声语料)。

本文的训练模型均使用PyTorch搭建,网络迭代训练过程需要使用误差函数(Loss function)计算网络的输入特征和标签之间的误差,误差通过反向传递的方式更新网络各层中所有节点的权值,并通过选择合适的优化器(Optimizer)在特定学习率(Learning rate)使误差以梯度下降的方式逐渐降低,最终完成特征到标签映射关系的学习。在这里我们设置进入网络的每批语料数量(Batch Size)为32,使用均方差(Mean Square Error,MSE)误差函数计算误差,并使用Adam优化器[16]来优化网络参数,Adam的参数设置为β1=0.9,β2=0.999,学习率设置为0.002。

我们使用相同的训练集分别训练基线CRNN模型(Baseline CRNN)和本文提出的包含注意力机制的CRNN模型(Attention CRNN),网络收敛即误差函数下降至基本稳定后停止训练,并使用测试集语料测试模型的增强效果。

4 结果分析

我们使用了如下三种客观评估指标评估网络训练结果:

PESQ:语音感知质量评估,分值-0.5~4.5,分数越高表示语音主观感受越好;

STOI:语音短时客观可懂度,分值0~1,分数越高表示语音可懂程度越高;

SegSNR:分段信噪比,即对语音按帧计算信噪比后求均值,单位为分贝值,分贝数越大表示语音中的残留噪声越少,噪声抑制能力越强。

表2 数据集噪声划分方式

Tab.2 Noise division mode of datasets

数据集噪声名称训练集噪声White nosie、Pink noise、Factory 1、Jet cockpit 1、Volvo、HF channel noise、Speech babble、Military vehicle、Tank、Destroyer engine、Machinegun测试集噪声匹配噪声Speech babble、Volvo、Factory floor noise 1、Tank、Pink noise非匹配噪声Factory 2、Jet cockpit 2、Destroyer operation、F-16

表3 算法客观指标评估结果对比

Tab.3 Objective evaluation results of proposed method and baseline

噪声类型信噪比/dB匹配噪声-5051015平均值非匹配噪声-5051015平均值PESQ带噪语音1.4031.7122.0312.3892.7551.9851.4241.6882.1122.3502.7671.972基线CRNN2.0852.4372.7032.9433.0452.6921.9772.1322.5632.6702.8932.424Atten-CRNN2.2132.5332.7962.9653.0342.7681.9682.2402.5742.6812.9022.439STOI带噪语音0.5620.6460.7750.8640.9050.7340.5570.6500.7620.8310.8900.722基线CRNN0.7030.8030.8110.8860.9190.8210.7110.7920.8070.8660.9120.816Atten-CRNN0.7140.8070.8270.8909.9230.8350.7200.7840.8140.8710.9210.818SegSNR带噪语音-4.900.134.899.9214.987.34-5.030.054.9710.1015.017.55基线CRNN4.336.798.6512.3015.1910.544.286.467.9811.7215.199.63Atten-CRNN4.406.889.0312.7515.1211.074.326.588.1512.2415.159.66

我们比较了基线CRNN与Attention CRNN在三个指标下测试语料的三项客观评估指标,并按不同平均信噪比进行区分,如表2所示。表中列出了混合匹配噪声和非匹配噪声的测试语料的原始指标和经两网络模型增强后的指标。与基线CRNN模型相比,引入注意力机制的CRNN模型在对于匹配噪声的抑制能力方面有所提升,其中PESQ相较基线平均提升0.076(2.82%),STOI相较基线平均提升0.014(1.72%),分段信噪比相较基线平均提升0.53 dB;从不同信噪比的增强效果来看,应用时频注意力机制的CRNN对于信噪比较低的语料相对基线CRNN有更好的增强效果,高信噪比如10 dB和15 dB语料二者表现相当,这可能是由于高信噪比语料被噪声淹没谐波较少使得注意力模块的作用不再显著。在对非匹配噪声的抑制方面,两个模型的增强效果均不及各自在匹配噪声上的降噪性能,但注意力机制模型也都略优于基线模型的表现。相较基线,PESQ平均提升0.015(0.6%),STOI平均提升0.002(0.2%),分段信噪比平均提升0.03 dB。这说明对于训练集未包含的非匹配噪声,两个网络虽然也有一定的噪声抑制效果,但并未表现出足够的泛化能力,从而无法达到和匹配噪声相近的水平,因此我们可以通过后续不断扩大训练噪声数据集的方式来优化模型的泛化性能。

在图4中,我们提取了信噪比为10 dB的一条测试语料及其纯净语音和经基线CRNN、Attention CRNN处理后的语音局部语谱图。从语谱图可以看出,低频部分的部分谱线(白框标示区域)存在被噪声淹没的情况,两个模型都可以去除大部分噪声,且二者相对来说Attention CRNN对于加噪语谱谐波的恢复效果优于基线CRNN网络,对于被噪声淹没的部分语音谐波的恢复效果更好。

图4 模型增强效果对比

Fig.4 Illustration of the results using two networks

经以上分析,我们使用三个不同的客观指标讨论了时频注意力机制对于基线CRNN网络的提升作用,在各个指标上均可以有不同程度的提高,我们也从模型的实际增强效果上观察了时频注意力机制对于被噪声淹没的语音谐波的恢复作用。整体而言,时频注意力机制在并未增加很大计算量的情况下提高了模型性能。

5 结论

基于对卷积循环网络的深入研究,并考虑到语音语谱在频率维表现出的谐波相关特性,本文将时频注意力机制引入了卷积神经网络中,使得卷积循环网络能够提取语音谐波的相关信息,并输出增强后的幅度谱。通过三种客观指标的评估和对测试语料语谱图的观察,我们认为时频注意力机制对于卷积神经网络整体噪声抑制能力和对被噪声淹没语谱谐波的恢复有一定程度的提高作用。另外,对于非匹配噪声的抑制能力该模型尚存在很大改进空间,可以通过扩大训练噪声数据来增强模型对不同噪声的泛化能力。

[1] Wang Yuxuan, Wang Deliang. Boosting Classification Based Speech Separation Using Time Dynamics[J]. Interspeech, 2012: 1528-1531.

[2] Wang Yuxuan, Wang Deliang. Cocktail Party Processing via Structured Prediction[J]. Advances in Neural Information Processing Systems, 2014: 224-232.

[3] Xu Yong, Du Jun, Dai Lirong, et al. An Experimental Study on Speech Enhancement Based on Deep Neural Networks[J]. IEEE Signal Processing Letters, 2014, 21(1): 65- 68.

[4] Xu Yong, Du Jun, Dai Lirong, et al. A regression approach to speech enhancement based on deep neural networks[J]. IEEE/ACM Transactions on Audio Speech & Language Processing, 2015, 23(1):7-19.

[5] Park S R, Lee J. A Fully Convolutional Neural Network for Speech Enhancement[C]∥Interspeech2017, Stockholm, Sweden, August 20-24, 2017: 1465-1468.

[6] 鲍长春, 项扬. 基于深度神经网络的单通道语音增强方法回顾[J]. 信号处理, 2019, 35(12): 1931-1941. DOI: 10.16798/j.issn.1003-0530.2019.12.001.

Bao Changchun, Xiang Yang. Review of Monaural Speech Enhancement Based on Deep Neural Networks[J]. Journal of Signal Processing, 2019, 35(12): 1931-1941. DOI: 10.16798/j.issn.1003-0530.2019.12.001.(in Chinese)

[7] Sun Lei, Du Jun, Dai Lirong, et al. Multiple-target deep learning for LSTM-RNN based speech enhancement[C]∥2017 Hands-free Speech Communications and Microphone Arrays (HSCMA), San Francisco, CA, United States, March 1-3, 2017: 136-140.

[8] Ronneberger O, Fischer P, Brox T. U-Net: Convolutional Networks for Biomedical Image Segmentation[C]∥International Conference on Medical Image Computing & Computer-assisted Intervention. Springer International Publishing, 2015.

[9] Stoller D, Ewert S, Dixon S. Wave-U-Net: A Multi-Scale Neural Network for End-to-End Audio Source Separation[J]. 2018.arXiv:1806.03185.

[10] Tan Ke, Wang D L. A Convolutional Recurrent Neural Network for Real-Time Speech Enhancement[C]∥Interspeech 2018: 1405-1408.

[11] Tan Ke, Xueliang Zhang, DeLiang Wang. Real-time Speech Enhancement using an Efficient Convolutional Recurrent Network for Dual-Microphone Mobile Phones in Close-talk Scenarios[C]∥Proceedings of ICASSP 2019: 5751-5755.

[12] Pandey A., Wang Deliang. TCNN: Time convolutional neural network for real-time speech enhancement in the time domain[C]∥Proceedings of ICASSP 2019: 6875- 6879.

[13] Yin Dacheng, Luo Chong, Xiong, Zhiwei, Zeng Wenjun. PHASEN: A Phase-and-Harmonics-Aware Speech Enhancement Network[C]∥Conference on Artificial Intelligence 2020 (AAAI2020) arXiv:1911.04697.

[14] Garofolo J S, Lamel L F, Fisher W M, et al. Darpa Timit Acoustic-Phonetic Continuous Speech Corpus CD-ROM[J]. NASA STI/Recon technical report n, 1993, 93.

[15] Varga A, Steeneken H. Assessment for automatic speech recognition: II. NOISEX-92: A database and an experiment to study the effect of additive noise on speech recognition systems[J]. Speech Communication, 1993, 12(3): 247-251.

[16] Kingma D P, Ba J. Adam: A Method for Stochastic Optimization[J]. arXiv preprint arXiv:1412.6980, 2014.