1 引言

脑机接口(Brain-computer Interface,BCI)是一种不依赖于正常的由外周神经和肌肉组成的输出通路的通讯系统[1-2],其直接将人或动物的大脑与外接的设备相连,通过对脑活动信号的采集与处理实现对设备机器的控制[3]。脑机接口技术的出现为那些无法通过言语或肢体动作进行交互控制(如语音控制,按键控制等)的病人带来了极大的便利[4-5],病人可以通过BCI系统实现对屏幕光标[6]、机械假肢[7]和轮椅[8]等的控制。常见的BCI系统有基于稳态视觉诱发电位(Steady-State Visual Evoked Potentials, SSVEP)、基于P300成分和基于运动想象的BCI系统等[9]。稳态视觉诱发电位指的是人眼注视持续的视觉刺激时在枕叶区域产生的与刺激频率一致的脑电信号[10-11],通过设计不同频率的视觉刺激,基于稳态视觉诱发电位的BCI系统可以让使用者通过注视相应的刺激输出不同的指令完成对设备的操控[12]。P300成分指的是被试在靶刺激比例较少的刺激序列中,脑电信号在靶刺激出现之后300毫秒左右产生的正向波形[13],基于P300成分的BCI系统通过分析该成分可以实现字符拼写与外界交流[14]。基于运动想象的BCI系统利用感觉运动皮层节律(Sensorimotor Rhythm,SMR)在真实运动或运动想象期间的变化,具体为事件相关去同步/事件相关同步(Event-related Desynchronization,ERD/Event-related Synchronization,ERS)的电生理现象对设备进行控制[15]。通过区分不同运动想象任务(如想象左手或右手的抬起)的电生理活动,BCI系统可以实现有限个数的输出指令,基于运动想象的BCI系统广泛应用于对假肢、轮椅等的操控[16-18]和脑卒中患者的神经康复[19]。

除运动想象以外,与运动想象类似的发音想象在生活中使用的程度也较高,譬如阅读文章、刊物时的默读,大脑内回忆他人说过的话语等。基于发音想象的BCI系统通过提取使用者想象发出语音(但是不产生声音和脸部器官活动)[20]时的脑活动信号,对数据分析和分类后可实现一定个数的输出指令。基于发音想象的BCI系统与基于运动想象的BCI系统较为相似,两者提取和分析的信号是来自大脑思维意识活动时自发产生的脑活动信号,该信号的产生无需外部设备的刺激。与之不同的是,基于稳态视觉诱发电位的BCI系统和基于P300成分的BCI系统需要产生刺激的额外设备去诱发大脑生理活动,所以该类BCI系统的设计成本和维护成本较高,而且被试注视刺激过久之后容易感到疲劳困倦,影响使用体验。基于发音想象的BCI系统的优势在于发音想象是一个直觉的自发的过程,它是最为接近日常生活中口头交流的一种形式,BCI使用者将会感到更为自然舒适和简单易用,能够帮助患有语言障碍、闭锁综合征、肌萎缩性侧索硬化症等疾病的病人与外界进行更为直接有效的交流[21];而且语音中包含着大量丰富的信息,通过解码想象的不同语音可以产生种类丰富的输出指令。此外,对发音想象进行研究有可能可以通过提取的脑活动信号直接地重建还原想象的语音[22],产生言语有困难的患者无需低效率地如其他BCI系统逐个地键入字符,而是可以通过发音想象进行语音合成与外界更加高效地交流。发音想象可能是最接近人类思维产生的一种形式[23],对发音想象的研究有利于深入对脑科学的理解,进一步探究人类思考时的一系列脑活动过程。

基于发音想象的BCI系统是一个较新的研究领域,相对于基于稳态视觉诱发电位/P300成分的BCI系统,其研究工作还在不断发展中,对发音想象的原理也尚未探究清楚,但是发音想象BCI系统有着众多的优势和巨大的潜在应用价值和研究意义,因此,基于发音想象的BCI系统将成为未来BCI系统的一个十分有潜力的新研究方向。

本文的结构如下:首先介绍基于发音想象BCI系统所用的几种脑活动信号采集技术的原理及优缺点,然后介绍现有文献中发音想象BCI系统的相关神经机制、研究内容和相关信号处理算法,最后讨论发音想象BCI系统现存的问题,并对未来的发展进行展望。

2 脑活动信号采集技术

基于发音想象的BCI系统可根据脑活动信号采集技术的不同分为两类,一类是侵入式BCI系统,另一类是非侵入式BCI系统[3]。侵入式BCI系统利用的信号采集技术有皮层脑电图(Electrocorticography,ECoG)等;非侵入式BCI系统利用的信号采集技术有功能性近红外光谱技术(functional Near-infrared Spectroscopy,fNIRS),脑电(Electroencephalography,EEG),功能性磁共振成像(functional Magnetic Resonance Imaging,fMRI),脑磁图(Magnetoencephalography,MEG)等。下面依序介绍各脑活动信号采集技术的原理、优缺点,及基于该技术的发音想象BCI系统的相关研究。

2.1 皮层脑电图

皮层脑电图(Electrocorticography,ECoG)由Penfield和Jasper提出,最初被用于在神经外科手术前定位癫痫病人的病灶[24],其利用直接放置于大脑皮层表面的电极记录大脑的电信号[25]。ECoG信号的强度较高,受到运动和肌电伪迹的影响较小,信号信噪比较高;记录ECoG的电极栅格排布密度高,各个电极间的距离通常小于10 mm,故ECoG具有毫米级别的空间分辨率[26-27]。然而,几乎所有利用ECoG的BCI系统的被试均为患有癫痫的病人,他们植入电极的最初目的是为了定位癫痫病灶而非脑机交互[28],所以不同个体植入电极的位置和型号均存在差异,这使得实验常常难以控制这些变量。此外,ECoG电极栅格覆盖范围较小,无法覆盖全脑皮层,具有一定局限性。由于ECoG具有侵入性的特点,电极需要通过开颅手术进行植入,利用该技术的BCI系统只能适用于小部分特定人群。

Leuthardt等人基于元音发音想象的ECoG信号,实现了一个控制一维屏幕鼠标移动的BCI系统。元音发音想象和不做任何想象任务分别代表“左”“右”的两个鼠标移动方向,患有难治性癫痫的2名被试使用该系统的最终命中准确率达到69%~73%[29]。Pei等人的研究记录被试想象36个单音节单词的发音时的ECoG信号,区分想象的不同元音和辅音。元音的平均分类准确率达到37.5%,辅音的平均分类准确率达到36.3%,均高于25%的机会水平[30]。该研究表明利用ECoG解码想象的语音是可行的。Ikeda等人记录被试想象日语中/a/、/i/、/u/三个元音的发音时的ECoG信号,实现了42.2%~46.7%的分类准确率[31]。Martin等人记录被试想象6个单词时的ECoG信号对BCI系统进行操控,配对分类准确率最高达到88.3%[32]。这些研究进一步证明了利用ECoG信号的发音想象BCI系统的可靠性。

2.2 功能性近红外光谱技术

功能性近红外光谱技术(functional Near-infrared Spectroscopy,fNIRS)是一种监测脑中血红蛋白变化状况的脑功能成像技术。近红外波段的光会被血红蛋白吸收,而不会被骨头、皮肤、肌肉等生物组织吸收。利用这一特点,将光发射器和光探测器放置于头皮表面,通过测量光吸收量的多少间接测量脑中血红蛋白浓度可反映脑区活动情况[33]。与fMRI相比,fNIRS设备低廉,体积轻巧,易于携带,维护成本低,具有非侵入性,对被试的头部移动较不敏感[34];与EEG相比,fNIRS有着较高的空间分辨率,可以清晰地分辨并分析来自不同脑区的信号,然而,fNIRS的时间分辨率不够高。

近年来,有研究尝试利用fNIRS构建发音想象的BCI系统。Hwang等人通过记录被试默读“yes”或“no”的fNIRS信号,设计的BCI系统实现了二分类下最高75.9%准确率[35]。Sereshkeh等人使用相似的实验范式,实现了平均64.1%的分类准确率,超过了33%的机会水平[36]。通过将fNIRS和EEG两个模态结合,Sereshkeh等人进一步提升了发音想象BCI系统的分类准确率,达到了平均70.5%的分类准确率[37]。

2.3 脑电

脑电(Electroencephalogram,EEG)是一种使用电生理指标记录大脑活动的方法[38], 它通过头皮上放置的电极来测量同时放电的大量神经元的总电位[39]。EEG的相关研究十分广泛,其应用于神经科学、心理学、认知科学和临床诊断等众多领域。其优点部分与fNIRS一样,如设备低廉,体积轻巧,易于携带,维护成本低,具有非侵入性[40];相较于其他技术,EEG具有较高的时间分辨率;然而由于头骨及头皮层的滤波作用,其空间分辨率较低,信号较为微弱;另外EEG容易受到眼动、肌动、心电伪迹的干扰,导致EEG信号的信噪比较低;相较于ECoG,EEG信号的频率范围较窄。

现有文献中的发音想象BCI系统,利用EEG的发音想象BCI系统占了大多数。基于实验范式中分类目标的不同,可分为音位分类、音节分类和单词分类共三类。音位分类可进一步分为元音分类和辅音分类两类,由于元音是最为重要的一类音位,元音分类占了目的为音位分类的BCI系统的大多数。目的为音节分类的BCI系统的相关研究相对较少,其主要利用EEG信号研究对不同单个想象音节进行分类[41- 42]或是用表示不同方位的单词中的单个可区分的音节作为发音想象的材料以实现方位操控[43]。目的为单词分类的BCI系统中,基于脑机接口面对残障人士或言语能力丧失的人士的设计需求,以方位操控[44- 45]和“是否”二元回答[37,46- 47]为分类目的发音想象BCI系统是当下的研究热点。

2.4 其他

除了上述三种较常见的应用于发音想象BCI系统的脑活动信号采集技术外,也有作者利用功能性磁共振成像(functional Magnetic Resonance Imaging, fMRI)和脑磁图(Magnetoencephalography,MEG)技术进行相关研究。

功能性磁共振成像(functional Magnetic Resonance Imaging,fMRI)是一种基于脑区血红蛋白的磁敏感效应的磁共振成像技术[48]。当大脑产生脑活动时,相应脑区的氧合血红蛋白和脱氧血红蛋白的浓度随之变化,氧合血红蛋白浓度越高表明该脑区的脑活动越活跃,对氧气的需求量越大[49]。由于氧合血红蛋白和脱氧血红蛋白具有不同的磁敏感效应,fMRI利用血红蛋白的这一特性生成反映脑活动的神经影像。fMRI的优点是在覆盖所有脑区的范围内有着较高的空间分辨率[50];由于无放射性和非侵入性的特点,该技术是神经影像相关研究的首选。但是由于进行实验时需要保持被试头部保持静态,其设备价格昂贵,体积巨大且难以移动,基于fMRI的发音想象BCI系统的发展十分受限,利用fMRI实现发音想象BCI系统的相关研究较少。Yoshimura等人通过记录被试的fMRI影像和EEG信号估计脑电皮层电流,被试默读日语中/a/和/i/两个元音,该系统实现了二分类下87.7%的平均准确率[51]。

脑磁图(Magnetoencephalography,MEG)是一种记录大脑中与突触后神经元电流相关的脑磁场活动的神经影像技术[52],其通过灵敏的磁力计测量大脑中神经元的微弱脑磁场信号,反映大脑的神经活动和确定各个脑区的状态及功能。与fMRI一样,MEG具有无放射性、非侵入性和覆盖所有脑区的特点。此外,MEG具有高空间分辨率的同时,也具有较高的时间分辨率[53]。但是由于其设备体积庞大、价格昂贵、维护费用高,基于脑磁图的脑机接口目前很难普及。Dash等人通过记录8名健康被试默读后朗读5个句子的MEG信号,用小波变换对信号进行分析提取特征,然后用卷积神经网络的算法对发音想象的句子分类,该BCI系统实现了93%的平均准确率[53]。

由于设备昂贵,体积巨大和采集环境要求高,利用功能性磁共振成像和脑磁图构建发音想象BCI系统的研究较少,但是这两种技术可覆盖所有脑区并有着较好的空间分辨率,它们对发音想象的脑区分工和神经机制的研究具有重大帮助和作用。

3 基于发音想象的脑机接口的国内外研究现状

现有文献中基于发音想象的BCI系统的实验范式基本上如下:系统先给出被试需执行的发音想象任务的提示,然后被试执行相应的发音想象任务,同时脑活动信号在发音想象期间被提取。但是不同BCI系统中的实验范式不尽相同,在本章第一部分将会对发音想象BCI系统的实验范式进行归纳总结。

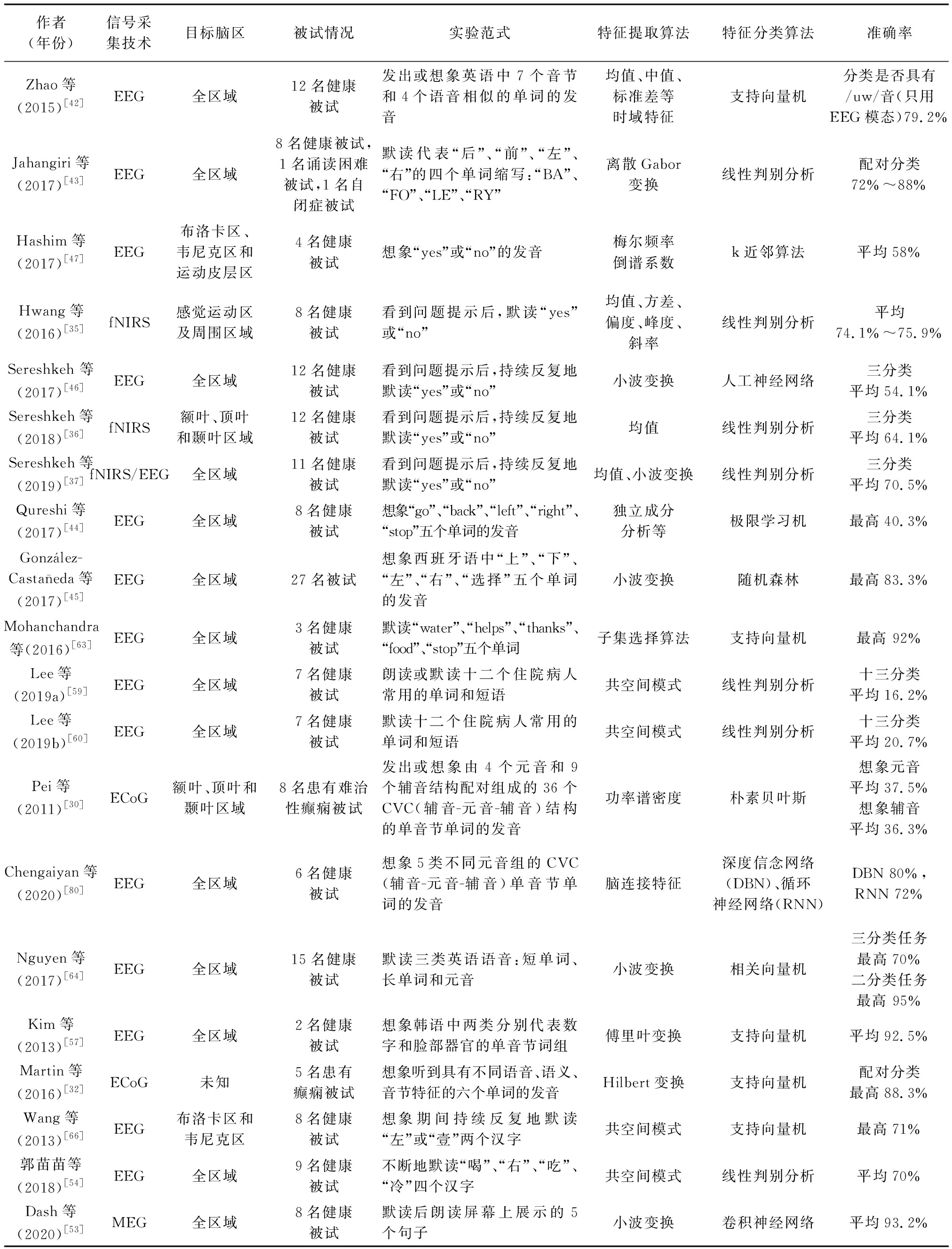

由于基于发音想象的BCI系统还是一个较新的研究领域,目前对于发音想象的神经机制的相关研究还不够全面,在本章第二部分将主要介绍已有文献中与发音想象有关的脑区和发音想象时脑活动信号中携带信息的频段。目前基于发音想象的BCI系统依据其实验范式中的分类目标,大致可以分为三类:音位发音想象、音节发音想象和单词发音想象,本文下面依照该分类依序介绍这三类发音想象BCI系统的相关研究,具体研究结果如表1所示。

表1 基于发音想象的脑机接口的研究综述。该表显示了所用的信号采集技术、目标脑区、被试情况、实验范式、特征提取算法、特征分类算法和分类准确率

Tab.1 Overview on studies of brain-computer interface for speech imagery, including signal acquisition technology, targeted brain areas, subject information, experiment paradigm, extracted features, classifiers, and classification accuracy

作者(年份)信号采集技术目标脑区被试情况实验范式特征提取算法特征分类算法准确率DaSalla等 (2009)[56]EEG全区域3名健康被试 想象/a/和/u/两个英语元音的嘴型和发音共空间模式支持向量机平均68%~78%Riaz等(2014)[58]EEG左侧额颞区和感觉运动区2名健康被试想象/a/,/i/,/e/,/o/,/u/五个元音的发音梅尔频率倒谱系数隐马尔可夫模型配对分类 最高91%Sarmiento(2014)[77]EEG布洛卡区和韦尼克区5名健康被试不断地想象开元音(/a/,/o/),中元音(/e/),闭元音(/i/,/u/)的发音功率谱密度支持向量机二分类84%~94%Matsumoto等(2014)[61]EEG全区域5名健康被试顺序或乱序想象日语中/a/,/i/,/u/,/e/,/o/五个元音的发音共空间模式支持向量机(SVM)、相关向量机(RVM)SVM平均77%RVM平均79%(机会水平50%)Min等(2016)[62]EEG全区域5名健康被试想象/a/,/e/,/i/,/o/,/u/五个韩语中的元音均值、方差、标准差、偏度极限学习机配对分类 最高99.3%Yoshimura等(2016)[51]EEG/fMRI全区域10名健康被试默读日语中/a/和/i/两个元音脑电皮层电流逻辑回归平均87.7%Ikeda等(2014)[31]ECoG额叶、顶叶和颞叶区域4名患有难治性癫痫被试想象日语中/a/、/i/、/u/三个元音的发音傅里叶变换支持向量机42.2%~46.7%杨晓芳等(2014)[55]EEG全区域3名健康被试想象汉语中4个元音音位和4个辅音音位的发音部位及语音发音共空间模式支持向量机配对分类最高83%D’Zmura等(2009)[41]EEG全区域4名健康被试在三种节律下默读/ba/和/ku/两个音节包络提取匹配滤波最高 62%~87%(机会水平17%)

续表1

作者(年份)信号采集技术目标脑区被试情况实验范式特征提取算法特征分类算法准确率Zhao等(2015)[42]EEG全区域12名健康被试发出或想象英语中7个音节和4个语音相似的单词的发音均值、中值、标准差等时域特征支持向量机分类是否具有/uw/音(只用EEG模态)79.2%Jahangiri等(2017)[43]EEG全区域8名健康被试,1名诵读困难被试,1名自闭症被试默读代表“后”、“前”、“左”、“右”的四个单词缩写:“BA”、“FO”、“LE”、“RY”离散Gabor变换线性判别分析配对分类 72%~88%Hashim等(2017)[47]EEG布洛卡区、韦尼克区和运动皮层区4名健康被试想象“yes”或“no”的发音梅尔频率倒谱系数k近邻算法平均58%Hwang等(2016)[35]fNIRS感觉运动区及周围区域8名健康被试看到问题提示后,默读“yes”或“no”均值、方差、偏度、峰度、斜率线性判别分析平均74.1%~75.9%Sereshkeh 等(2017)[46]EEG全区域12名健康被试看到问题提示后,持续反复地默读“yes”或“no”小波变换人工神经网络三分类 平均54.1%Sereshkeh等 (2018)[36]fNIRS额叶、顶叶和颞叶区域12名健康被试看到问题提示后,持续反复地默读“yes”或“no”均值线性判别分析三分类 平均64.1%Sereshkeh等(2019)[37]fNIRS/EEG全区域11名健康被试看到问题提示后,持续反复地默读“yes”或“no”均值、小波变换线性判别分析三分类 平均70.5%Qureshi等(2017)[44]EEG全区域8名健康被试想象“go”、“back”、“left”、“right”、“stop”五个单词的发音独立成分分析等极限学习机最高40.3%Gonzlez-Castañeda等(2017)[45]EEG全区域27名被试想象西班牙语中“上”、“下”、“左”、“右”、“选择”五个单词的发音小波变换随机森林最高83.3%Mohanchandra等(2016)[63]EEG全区域3名健康被试默读“water”、“helps”、“thanks”、“food”、“stop”五个单词子集选择算法支持向量机最高 92%Lee等(2019a)[59]EEG全区域7名健康被试朗读或默读十二个住院病人常用的单词和短语共空间模式线性判别分析十三分类 平均16.2%Lee等(2019b)[60]EEG全区域7名健康被试默读十二个住院病人常用的单词和短语共空间模式线性判别分析十三分类 平均20.7%Pei等(2011)[30]ECoG额叶、顶叶和颞叶区域8名患有难治性癫痫被试发出或想象由4个元音和9个辅音结构配对组成的36个CVC(辅音-元音-辅音)结构的单音节单词的发音功率谱密度朴素贝叶斯想象元音 平均37.5%想象辅音 平均36.3%Chengaiyan等(2020)[80]EEG全区域6名健康被试想象5类不同元音组的CVC(辅音-元音-辅音)单音节单词的发音脑连接特征深度信念网络(DBN)、循环神经网络(RNN)DBN 80%, RNN 72%Nguyen等(2017)[64]EEG全区域15名健康被试默读三类英语语音:短单词、长单词和元音小波变换相关向量机三分类任务最高70%二分类任务最高 95%Kim等(2013)[57]EEG全区域2名健康被试想象韩语中两类分别代表数字和脸部器官的单音节词组傅里叶变换支持向量机平均92.5%Martin等(2016)[32]ECoG未知5名患有癫痫被试想象听到具有不同语音、语义、音节特征的六个单词的发音Hilbert变换支持向量机配对分类最高88.3%Wang等(2013)[66]EEG布洛卡区和韦尼克区8名健康被试想象期间持续反复地默读“左”或“壹”两个汉字共空间模式支持向量机最高71%郭苗苗等(2018)[54]EEG全区域9名健康被试不断地默读“喝”、“右”、“吃”、“冷”四个汉字共空间模式线性判别分析平均70%Dash等(2020)[53]MEG全区域8名健康被试默读后朗读屏幕上展示的5个句子小波变换卷积神经网络平均93.2%

由于BCI系统的设计中,特征提取和特征分类是决定BCI系统的分类准确率和性能的两个重要步骤,不少研究着力于使用和开发适用于发音想象BCI系统的相关算法,在本章最后一部分将简述这些算法。

3.1 发音想象的实验范式

现有文献中的实验范式不尽相同,但是总体而言,发音想象BCI系统中的单个试次按照时序一般可分为三个时期:空闲期、提示期和想象期。

被试在空闲期被要求不做任何想象任务,目的是让脑活动信号返回基线水平[36],防止对随后想象期的神经数据记录造成干扰。部分研究中,被试在该段时间内被要求注视屏幕上的固定符号[54-58]。

在提示期,系统会给出被试需执行的发音想象任务的提示。根据提示展示类型的不同,提示可分为听觉提示[32,44,51,59- 62]、视觉提示[43,46- 47,56-57,63- 64]和视听结合提示[65]三类。在听觉提示下,系统会通过耳机或扬声器播放被试要求想象发音的声音。在视觉提示下,系统一般会在屏幕上直接显示要求想象语音所对应的音标或单词。在Sereshkeh等人的研究中[36-37],视觉提示以问题的形式在屏幕上呈现:屏幕上出现关于呈现的单词是否大小写的问题,被试要求在之后的想象期不断想象问题所对应的答案(即“yes”或“no”)的发音。Zhang等人[65]的对普通话声调的研究中的实验范式利用了视听结合提示,也就是被试在提示期同时看到需想象语音的拼音和听到相对应的声音。其实验结果显示,在声调想象的BCI系统中,利用视听结合提示的BCI系统比仅利用视觉提示的BCI系统的分类准确率要高。

在想象期,被试要求想象提示期所对应的语音的发音,保持不发出声音的同时面部器官也不活动。在部分实验范式中,被试要求在想象期不断重复地想象语音的发音直至想象期结束[30,36,54,66]。在另一类实验范式中,被试则要求按照固定的节律想象语音的发音,即被试在想象期会听到固定周期性的提示音(一般是短促的蜂鸣声),被试需要在每次提示音响起后且立即进行一次发音想象,提示音消失后的一段时间内被试也需按照相同的节律进行发音想象[41,44,63- 64]。少部分实验范式中,提示期和想象期重合,也就是被试要求在提示持续出现的时间段内进行发音想象[56,64]。由于部分实验在研究想象语音的同时还对真实发出的语音的相关神经数据进行研究,在这些实验的实验范式中,在想象期之前或之后还会有一段发音期[41- 42]。实验中为了提醒被试不同时期的切换,一般通过屏幕上内容的变化或是提示音来实现。

3.2 发音想象神经机制的相关研究

一系列研究显示,大脑的左额下回区域是产生发音想象这一现象的神经解剖学基础[67]。McGuire等人通过正电子发射型断层显像(Positron Emission Tomography,PET)发现当想象句子或单个单词的语音时,左额下回区域有激活[68]。Shergill等人通过fMRI也发现当想象句子语音的发音时左额下回区域有激活[69]。在该作者的另一篇研究中,发现当想象句子发音的速度变快时,左额下回区域的激活程度也会随之增加[70]。Aleman等人通过fMRI发现在想象语音的语音加工过程中左额下回区域有激活[71]。

除左额下回区域之外,研究显示发音想象的产生与辅助运动区[68- 69]、皮质运动前区[71]、颞上回[72]和颞中回[73]有关。Bocquelet等人认为想象语音的高级加工过程与左半脑有关[74]。

在构建基于发音想象的BCI系统时,部分研究依据解码想象语音的效果对采集脑活动信号的目标脑区进行探究。Wang等人设计了记录脑电信号两种不同电极排布的BCI系统,一种是利用全脑所有的头皮电极的通道信息,另一种是仅利用左半脑覆盖布洛卡区和韦尼克区处的头皮电极的通道信息。研究表明,仅利用左半脑通道信息的BCI系统的性能不差于利用全脑通道信息的BCI系统,利用左半脑通道的信息足够可以提取出汉字发音想象的脑电特征[66]。Hashim等人的研究显示对于利用EEG信号的二分类的单词发音想象BCI系统,利用运动皮层区、布洛卡区和韦尼克区的通道信息的BCI系统的分类准确率要高于仅利用布洛卡区和韦尼克区的通道信息的BCI系统[47]。Sereshkeh等人的研究显示左颞叶皮层和左颞顶皮层区域的脑电通道为BCI系统的分类提供了最有区分度的特征信息[36]。Ikeda等人的实验指出,元音发音想象可由大脑前运动区皮层和颞上回区域的ECoG信号进行解码预测,另外,布洛卡区可能不参与单个元音发音想象的加工过程[31]。

为了探究不同频段的信号携带的特征信息和对BCI系统的性能的影响,部分构建基于发音想象的BCI系统的文献进行了相关研究。Ikeda等人对元音发音想象的ECoG信号进行研究,发现alpha波段(8~13 Hz)和beta波段(14~30 Hz)可能包含解码单个元音发音想象的信息[31]。Sereshkeh等人利用EEG信号进行的研究显示,在发音想象期间,布洛卡区20到30 Hz频段和韦尼克区15 Hz以下的频段的EEG通道激活程度上升[75]。

总体而言,目前对于发音想象神经机制的研究还不够深入,为了全面地理解发音想象,还需要探究并建立发音想象的理解及产生的模型,同时还需要更多的神经数据的分析总结和更深层次的相关研究[76]。

3.3 音位发音想象

音位发音想象基本上可分为元音发音想象和辅音发音想象两类。由于元音是语音中最为基本且常见的一类音位,大部分有意义的词句的产生都需要包含元音,所以基于元音发音想象的BCI系统占了大多数。DaSalla等人的研究是首次尝试构建基于发音想象的BCI系统的研究之一,其招募3名健康被试进行研究,在随机展示代表元音/a/和元音/u/的口型的图像后,被试被要求立即执行相应的任务:想象英语中元音/a/或/u/的口型和发音。此外,展示中心为十字的图像后不执行任何想象任务被设置为控制组。研究者提取执行想象任务期间被试的EEG信号进行分类,各被试的配对分类的平均准确率达到68%~78%。该研究结果表明,基于元音发音想象的BCI系统具有重要的潜在应用前景[56]。Riaz等人的研究的实验范式与DaSalla等人相似,2名健康被试被要求想象/a/,/i/,/e/,/o/,/u/五个元音的发音,对提取的EEG信号进行分类后,配对分类的准确率最高为91%[58],研究拓展了元音发音想象的分类类别。Sarmiento等人对5名健康被试进行研究,被试要求想象开元音(/a/,/o/)、中元音(/e/)和闭元音(/i/,/u/)共五个元音的发音,对提取的EEG信号做二分类(开-中元音和闭元音),BCI系统的分类准确率达到84%~94%[77]。Matsumoto等人的研究中招募了5名被试,其建立了一个以EEG信号为基础的日语元音音位想象BCI系统。被试在顺序或乱序呈现听觉提示后,被要求想象相对应的日语中/a/,/i/,/u/,/e/,/o/五种元音的发音。研究分别利用了支持向量机(Support Vector Machine,SVM)和相关向量机(Relevance Vector Machine,RVM)两种特征分类算法,分别实现了77%和79%的平均分类准确率(机会水平为50%)[61]。Min等人的研究记录5名健康被试想象韩语中/a/,/i/,/u/,/e/,/o/五种元音的发音时的EEG信号,使用极限学习机(Extreme Learning Machine,ELM)的特征分类算法,其配对分类的准确率最高达到了93.3%[62]。Yoshimura等人的研究则利用EEG和fMRI两个模态的信息估计脑电皮层电流。10名健康被试被要求在听到两个日语元音/a/和/i/的语音提示后,在脑内默读对应元音的发音。不做任何想象任务作为控制组。该研究表示,其二分类的平均准确率可达到87.7%,利用脑电皮层电流的分类准确率要高于单独利用EEG信号的分类准确率[51]。Ikeda等人对4位患有难治性癫痫并植入硬膜下电极的被试进行研究,被试被要求在屏幕展示日语的/a/,/i/,/u/三个元音后想象对应的元音发音,利用被试发音想象期间的ECoG信号,该BCI系统的分类准确率达到42.2%~46.7%[31]。

杨晓芳等人的研究进一步将元音发音想象拓展至辅音发音想象。试验过程中,3名健康被试被要求想象屏幕上出现的汉语音位的发音部位和语音发音。提示材料由四个元音音位和四个辅音音位组成。四个元音音位代表普通话的四呼的一类,即开口呼(/a/)、齐齿呼(/i/)、合口呼(/u/)和撮口呼(/y/)。四个辅音音位是鼻辅音(/m/,/n/,/ /)和摩擦音(/f/)。屏幕中央呈现“#”图标不执行想象任务作为控制组。研究对提取的EEG信号进行了频域分析、时域分析和空域分析,配对分类准确率最高达到83%。该研究指出,音位发音想象任务可被视为复杂的发音器官运动想象任务,并且可由感觉运动皮层区域的EEG信号进行解码和分类[55]。

/)和摩擦音(/f/)。屏幕中央呈现“#”图标不执行想象任务作为控制组。研究对提取的EEG信号进行了频域分析、时域分析和空域分析,配对分类准确率最高达到83%。该研究指出,音位发音想象任务可被视为复杂的发音器官运动想象任务,并且可由感觉运动皮层区域的EEG信号进行解码和分类[55]。

此外,在诸如普通话的声调语言中,不同的声调会赋予单个音节截然不同的含义[78]。Zhang等人对普通话中的四个声调进行了发音想象的相关研究,通过提取被试在两种测试条件下想象普通话中“ba”的四个声调的发音的EEG信号,该BCI系统实现了在视觉提示条件下67.7%的分类准确率,在视听结合的提示条件下的分类准确率进一步提升至80.1%[65],这表明普通话的声调信息可有效地从发音想象时的EEG信号中所提取。

3.4 音节发音想象

基于音节发音想象的BCI系统的相关研究相对较少,目前的研究可分为两类,一类是基于无语义信息的音节的发音想象[41- 42],另一类是如Jahangiri等人研究的基于有语义信息的音节的发音想象[43]。

D’Zmura等人研究4名被试在三种不同节律下默读/ba/和/ku/两个音节,提取默读时的EEG信号,位于theta(3~8 Hz)、alpha(8~13 Hz)、beta(13~18 Hz)波段的EEG信号波形包络分别被用作特征进行分类。研究结果表明,对beta波段的EEG信号分类可产生最高的分类准确率,其分类准确率达到62%~87%(机会水平为17%)[41]。

Zhao等人对12名健康被试进行研究,实验材料为/iy/,/uw/,/piy/,/tiy/,/diy/,/m/,/n/ 7个英语音节或音位和“pat”,“pot”,“knew”,“gnaw”4个语音相近的单词。当屏幕上出现单个实验材料并通过扬声器传出相对应的声音时,被试需要先在一段时间内在脑内想象所呈现的实验材料的发音,然后再大声发出该实验材料的发音。被试的EEG信号、大声发音时的语音音频和大声发音时的口型变化视频作为三个模态的信息被记录下来。该研究考虑5种二分类任务:只有元音或者存在辅音;是否存在鼻音;是否存在双唇音;是否存在/iy/音;是否存在/uw/音。研究结果表明,在只有EEG信号的单个模态信息的情况下,二分类任务的分类准确率最高的分类任务是否存在/uw/音,其准确率达到79.2%;然而,对于只有元音或者存在辅音的分类任务,其准确率却低达18.1%[42]。

Jahangiri等人的研究中,8名健康被试、1名诵读困难被试和1名自闭症被试一共10名被试参与了实验。实验材料为英文中“后”、“前”、“左”、“右”的4个单词缩写:“BA”、“FO”、“LE”、“RY”4个音节,且被试在实验前已经被告知这些单词缩写相对应的单词含义。这四个音节在语音上互不相似,而且4个音节所代表的方位非常适用于用鼠标进行屏幕控制的BCI系统。被试被要求当屏幕上出现音节试验材料后立即默读相应的音节,同时EEG信号被记录下来,10名被试的六个组别的配对分类准确率在72%到78%之间[43]。

3.5 单词发音想象

由于“是”和“否”是BCI系统使用者中高频使用的两个单词,不少研究致力于开发出基于“是否”二元回答发音想象的BCI系统。Hashim等人利用14通道的EEG装置对4名健康被试进行研究,当屏幕随机出现“yes”或“no”时,被试要求重复想象所对应的单词,对EEG信号进行分类处理后,其平均准确率为58%,仅在50%的机会水平以上[47]。Hwang等人对8名健康被试进行研究,提取被试看到问题提示后默读“yes”或“no”的fNIRS信号,其分类的平均准确率为74.1%~75.9%[35]。Sereshkeh等人使用相似的实验范式,利用人工神经网络对发音想象产生的EEG信号分类,其平均分类准确率达到54.1%,所有被试的分类准确率均超过机会水平[46]。Sereshkeh等人对12名健康被试的fNIRS信号提取并分类,实现了平均64.1%的分类准确率[36]。通过将fNIRS和EEG两个模态结合,Sereshkeh等人进一步提升了发音想象BCI系统的分类准确率,达到了平均70.5%的分类准确率[37]。

BCI系统使用者中另一类常用的指令是诸如“前”、“后”、“左”、“右”的方位词。Qureshi等人的研究记录8名健康被试想象“go”、“back”、“left”、“right”、“stop”五个单词的发音时的EEG信号,五分类准确率最高达到40.3%[44]。Gonz lez-Casta

lez-Casta eda等人对27名被试研究,被试被要求想象西班牙语中“上”、“下”、“左”、“右”、“选择”五个单词的发音并被提取EEG信号,五分类准确率最高达到83.3%[45]。

eda等人对27名被试研究,被试被要求想象西班牙语中“上”、“下”、“左”、“右”、“选择”五个单词的发音并被提取EEG信号,五分类准确率最高达到83.3%[45]。

由于BCI使用者有一大部分是住院的病人,一些住院病人常用的单词也成为了发音想象BCI系统的分类任务的研究目标。Mohanchandra等人提取3名健康被试默读“water”、“helps”、“thanks”、“food”、“stop”五个单词的EEG信号,达到了最高92%的五分类准确率[63]。Lee等人提取并分类被试默读十二个住院病人常用的单词和短语的EEG信号,实现了十三分类平均16.2%的准确率[59]。在其之后的研究中,作者进一步提升了准确率达到20.7%[60]。

Pei等人对8名患有难治性癫痫的被试进行研究,被试需要发出或想象由4个元音和9个辅音结构配对组成的36个CVC(辅音-元音-辅音)结构的单音节单词的发音,在这一过程中被试的ECoG信号被提取,实验结果显示,想象元音的平均分类准确率是37.5%,想象辅音的平均分类准确率是36.3%(机会水平均为25%)。该研究表明从想象发音单词时的ECoG信号中区分不同的元音和辅音成分是可行的[30,79]。Chengaiyan等人的研究换了另一种实验材料,利用EEG信号对6名健康被试进行研究。被试被要求想象5类不同元音组的CVC(辅音-元音-辅音)单音节单词的发音,使用深度信念网络和循环神经网络的分类准确率分别达到80%和72%[80]。

Nguyen等人的研究选取了3个短单词、2个长单词和3个元音作为研究材料,通过提取被试的发音想象期间的EEG信号,BCI系统实现了对3个短单词最高55%的分类准确率,2个长单词最高70%的分类准确率;在其对长单词和短单词进行二分类时,其准确率最高可达95%。研究表明,复杂程度越高的单词越容易从EEG信号中分辨,同时,不同复杂程度的单词组有利于提高分类效果[64]。

Kim等人对被试想象韩语中两类分别代表数字和脸部器官的单音节词组时的EEG信号进行研究,其平均分类准确率达到92.5%,该研究说明以不同词义的单词组为基础的发音想象BCI系统是可行的[57]。Yamaguchi等人对被试想象日语中“石头”、“剪刀”、“布”和“春”、“夏”、“秋”、“冬”四个季节的发音时的EEG信号进行分析与分类,其BCI系统的分类准确率为20%~100%[81]。Martin等人的研究中,5名患有癫痫的被试想象听到具有不同语音、语义、音节特征的六个单词的发音,对其ECoG信号进行处理并分类,配对分类的最高准确率达到88.3%[32]。

基于汉字发音想象的BCI系统的相关研究较少。Wang等对8名健康被试进行研究,当屏幕上呈现“左”或“壹”两个汉字其中之一时,被试被要求在随后的想象期间持续反复地默读相应汉字的发音,对被试的 EEG信号进行提取和处理后,其分类准确率最高达到71%[66]。郭苗苗等人提取9位被试不断地默读“喝”、“右”、“吃”、“冷”4个汉字时的EEG信号,其BCI系统的对4个汉字的平均分类准确率达到70%[54]。

3.6 特征提取和特征分类算法

BCI系统由信号预处理、特征提取和特征分类等多个环节构成,其中特征提取和特征分类是最为关键的两个步骤[82],其算法的优劣直接决定了BCI系统的性能与表现。

特征提取是在对采集到的脑活动信号进行预处理之后,从预处理的信号中提取特征向量的过程。虽然预处理后的信号已经滤除噪声且较为纯净,可是由于其数据量巨大,存在冗余信息,从中提取表征源信号的特征向量十分有必要。特征提取算法可基于其提取的特征的形式分为三类:空域特征、频域特征和时域特征。

常见的空域特征的特征提取算法是共空间模式(Common Spatial Patterns,CSP),其常用于基于EEG信号的发音想象BCI系统中[54-55,58- 61,65- 66]。该算法的目的是设计一种空间滤波器,使一类信号的方差最大而另一类信号的方差最小,从而得到具有最大分辨能力的特征向量[83]。该算法优点在于不需要预先选择特异性频带,缺点是算法对噪声敏感且依赖于多通道分析[84]。频域特征的特征提取算法则是抽取信号的频域特征向量对源信号做表征。在基于EEG和ECoG信号的发音想象的BCI系统中,常用的频域特征提取算法有傅里叶变换[31,57]、小波变换[20,46,64,75,85- 86]、离散Gabor变换[43]、Hilbert变换[32]、功率谱密度[30,77]和梅尔频率倒谱系数[47,58,87]等。特别的,在对ECoG信号进行频域特征提取前,一般会滤波保留High-gamma波段即频率范围在70到150 Hz的信号[30-32],因为一系列研究显示High-gamma波段的ECoG信号与听觉感知和语音产生有关[30-31,88- 89]。时域特征的特征提取算法常用于基于EEG和fNIRS信号的发音想象BCI系统中,一般选取信号各通道的均值、方差、标准差和偏度等特征中单个或多个作为特征向量[35-37,42,44,87]。亦有文献结合多种特征提取算法得到特征向量,以提高BCI系统的性能[64]。

在脑活动信号经过预处理和特征提取后,得到的特征向量需要进行特征分类以达到BCI系统实现判别或预测的目的。基于现有的发音想象BCI系统的文献,其特征分类算法可分为两种:基于机器学习的特征分类算法和基于深度学习的特征分类算法。

由于基于机器学习的特征分类算法计算量相对较小,数学模型直观易理解,所以该类算法在发音想象的BCI系统中应用广泛,在基于EEG、ECoG和fNIRS信号的发音想象BCI系统中,最为常用的两类基于机器学习的特征分类算法是线性判别分析[35-37,62,59- 60]和支持向量机[31-32,65,75,87,90]。线性判别分析是一种经典且应用广泛的模式分类的线性学习方法。其基本思想是将高维空间的特征向量投影至低维的子空间,并且找到使得同类的投影后的向量尽可能靠近并且不同类的投影后的向量尽量分隔开的最佳投影方向。当线性判别分析分类器完成训练后,分类器将无标签的特征向量按最佳投影方向投影至低维子空间上进行分类。支持向量机是一种通过寻找特征空间上最大间隔超平面对数据进行分类的方法,相较于线性判别分析,支持向量机可以应用核函数的办法对非线性可分的数据实现分类。支持向量机的扩展算法还可解决对数据进行多分类的问题。 此外,基于机器学习的特征分类算法还有k近邻算法[46,58,91]、朴素贝叶斯[30,85,92]、决策树[87]、随机森林[20,60,85]、相关向量机[61,64]和极限学习机[44,62]等。Min等人的研究指出,对发音想象相关的EEG信号分类时,极限学习机的分类效果要优于线性判别分析和使用径向基核函数 (Radial Basis Function)的支持向量机[62]。Matsumoto等人的研究则表明当训练数据较少时,相关向量机的分类准确率低于支持向量机的分类准确率[61]。由于近些年来深度学习算法的迅猛发展,有不少研究利用深度学习的特征分类算法对神经数据进行分析和分类[94]。在发音想象的BCI系统中,常见的算法有深度信念网络(Deep Belief Network,DBN)[42,80]、卷积神经网络(Convolutional Neural Networks,CNN)[53,94-96]、循环神经网络(Recurrent Neural Network,RNN)[80]和长短记忆网络(Long Short Term Memory Network,LSTM)[96]等。深度学习模型的优点在于其模型拟合能力强,部分情况下无需手工提取特征向量,但是其缺点在于可解释性不强,计算量巨大,难以用于在线BCI系统,故该类算法用于发音想象BCI系统具有一定局限性。

4 讨论

目前,基于发音想象的BCI系统的研究还处于发展的阶段,相关研究还具有一些待解决的问题和挑战,BCI系统有进一步可提升的空间和可探究的研究方向。

(1)现有的基于发音想象的BCI系统的相关文献中,大部分研究的被试都是健康被试。但是由于BCI系统的最终目标人群是患有语言障碍、闭锁综合征等疾病的病人,对健康被试的发音想象任务的解码方式可能与这类病人的解码方式并不一样,所以利用健康被试的脑活动信号构建的BCI系统可能无法适用于目标人群。因此,在未来的研究中需要更多地招募患有语言障碍、闭锁综合征等疾病的病人作为被试进行构建和测试BCI系统。

(2)目前绝大部分的基于发音想象的BCI系统是对采集到的脑活动信号进行离线分析和分类,仅有少数研究实现了在线BCI系统[36,75]。为了让发音想象BCI系统能够真正地应用于目标人群,相关研究应着力于开发出可以实时地对数据进行采集、分析、分类及做出相应指令的在线BCI系统。此外,目前文献中对基于发音想象的BCI系统的性能评估指标基本上只有分类准确率一种,还需要综合信息传输率、误动作率、响应时间等其他指标对BCI系统的性能进行整体全面的评估。

(3)到目前为止,发音想象的原理仍未探究清楚,所以不同的发音想象BCI系统对于目标脑区的选取不尽相同,发音想象在脑区内的解码信息也难以充分地利用,现有的BCI系统只能对不同的发音想象任务进行分类而无法完全还原脑内想象的语音。因此,对于发音想象原理的研究还需要进一步深入,基于发音想象的BCI系统才能让加速发展。

(4)现有文献中,基于发音想象的BCI系统的分类任务主要可根据其发音想象的任务分为音位、音节、单词三类,而以句子为分类目标的相关研究尚未广泛开展[53],由于人们在日常生活中基本上是以句子为单位进行交流,基于句子发音想象的BCI系统对于使用者来说更为自然流畅。此外,句子所携带的信息远大于单词所携带的信息,研究句子发音想象有利于探究大脑处理发音想象语义信息的加工过程。因此,开发并研究基于句子发音想象的BCI系统具有重要的应用价值和研究意义。

(5)目前,大部分基于发音想象的BCI系统是针对英语使用者开发的,对于汉语使用者的发音想象BCI系统相关的研究较少,仅有少数对普通话声调、汉语音位和汉字发音的发音想象的研究[54-55,65- 66]。汉语作为全世界使用人数最多的语言之一,汉语使用者对BCI系统的需求也是巨大的,所以更多的研究需要致力于开发基于汉语的发音想象BCI系统。

(6)有研究显示,多模态的发音想象BCI系统的分类准确率要高于仅利用单模态的发音想象BCI系统[37,51]。现有的发音想象BCI系统大多数都是单模态的BCI系统,少有多模态的BCI系统。通过整合不同模态的信息,不同模态的脑活动信号可以互补其优势,进而提升发音想象BCI系统的性能和可靠性。故而,多模态的发音想象BCI系统是领域发展的一个方向。

5 结论

本文综述了现有基于发音想象的BCI系统的研究结果,从系统信号采集技术、相关神经机制、实验范式、分类目标、相关信号处理算法及系统性能等多个方面对相关研究进行了归纳总结。众多研究致力于利用脑活动信号对脑内想象的语音进行分类,证明基于发音想象的BCI系统的可行性。但是,现有的研究仍有一些待解决的问题和可以提升的空间,相关研究需要更进一步的深入。

[1] Vaughan T M, Heetderks W J, Trejo L J, et al. Brain-computer interface technology: a review of the second international meeting[J]. IEEE Transactions on Neural Systems & Rehabilitation Engineering, 2003, 11(2): 94-109.

[2] Putze F, Schultz T. Adaptive cognitive technical systems[J]. Journal of Neuroscience Methods, 2014, 234: 108-115.

[3] 于淑月, 李想, 于功敬, 等. 脑机接口技术的发展与展望[J]. 计算机测量与控制, 2019, 27(10): 5-12.

Yu Shuyue, Li Xiang, Yu Gongjing, et al. Development and prospect of brain computer interface technology[J]. Computer Measurement & Control, 2019, 27(10): 5-12.(in Chinese)

[4] Birbaumer N, Murguialday A R, Cohen L. Brain-computer interface in paralysis[J]. Current Opinion in Neurology, 2008, 21(6): 634- 638.

[5] Lin S, Liu J, Li W, et al. A flexible, robust, and gel-free electroencephalogram electrode for noninvasive brain-computer interfaces[J]. Nano Letters, 2019, 19(10): 6853- 6861.

[6] Kübler A, Kotchoubey B, Hinterberger T, et al. The thought translation device: a neurophysiological approach to communication in total motor paralysis[J]. Experimental Brain Research, 1999, 124(2): 223-232.

[7] Yahud S, Osman N A A. Prosthetic hand for the brain-computer interface system[C]∥Kuala Lumpur International Conference on Biomedical Engineering. Springer, 2007: 643- 646.

[8] Rebsamen B, Burdet E, Guan C, et al. Controlling a wheelchair indoors using thought[J]. IEEE Intelligent Systems, 2007, 22(2): 18-24.

[9] Wierzga a P, Zapa

a P, Zapa a D, Wojcik G M, et al. Most popular signal processing methods in motor-imagery BCI: a review and meta-analysis[J]. Frontiers in Neuroinformatics, 2018, 12: 78.

a D, Wojcik G M, et al. Most popular signal processing methods in motor-imagery BCI: a review and meta-analysis[J]. Frontiers in Neuroinformatics, 2018, 12: 78.

[10] Lee P L, Yeh C L, Cheng Y S, et al. An SSVEP-based BCI using high duty-cycle visual flicker[J]. IEEE Transactions on Biomedical Engineering, 2011, 58(12): 3350-3359.

[11] Zhang D, Hong B, Gao X, et al. Exploring steady-state visual evoked potentials as an index for intermodal and crossmodal spatial attention[J]. Psychophysiology, 2011, 48(5): 665- 675.

[12] Zhang D, Hong B, Gao S, et al. Exploring the temporal dynamics of sustained and transient spatial attention using steady-state visual evoked potentials[J]. Experimental Brain Research, 2017, 235(5): 1575-1591.

[13] 郭士杰. 基于P300的脑机接口指令识别[D]. 杭州电子科技大学, 2018.

Guo Shijie. Recognition of brain computer interface instruction based on P300[D]. Hangzhou Dianzi University, 2018.(in Chinese)

[14] Lenhardt A, Kaper M, Ritter H J. An adaptive P300-based online brain-computer interface[J]. IEEE Transactions on Neural Systems and Rehabilitation Engineering, 2008, 16(2): 121-130.

[15] 徐舫舟. 基于运动想象的脑机接口相关算法研究[D]. 山东大学, 2014.

Xu Fangzhou. Research on relative algorithms of motor imagery based brain computer interface[D]. Shandong University, 2014.(in Chinese)

[16] Murguialday A R, Aggarwal V, Chatterjee A, et al. Brain-computer interface for a prosthetic hand using local machine control and haptic feedback[C]∥International Conference on Rehabilitation Robotics. IEEE, 2007: 609- 613.

[17] Zhang X, Wang Y, Cheng Z. An EEG based approach for pattern recognition of precise hand activities with data fusion technology[C]∥IECON 2007-33rd Annual Conference of the IEEE Industrial Electronics Society. IEEE, 2007: 2423-2428.

[18] 周光省. 基于多种运动想象组合的脑电控制电动轮椅方法研究[D]. 杭州电子科技大学, 2014.

Zhou Guangsheng. EEG power wheelchair control method of multiple motion based on combination of imagination[D]. Hangzhou Dianzi University, 2014.(in Chinese)

[19] 张桃, 杨帮华, 段凯文, 等. 基于运动想象脑机接口的手功能康复系统设计[J]. 中国康复理论与实践, 2017, 23(1): 4-9.

Zhang Tao, Yang Banghua, Duan Kaiwen, et al. Development of hand function rehabilitation system based on motor imagery brain-computer interface[J]. Chinese Journal of Rehabilitation Theory and Practice, 2017, 23(1): 4-9.(in Chinese)

[20] Torres-García AA, Reyes-García C A, Villase or-Pineda L, et al. Implementing a fuzzy inference system in a multi-objective EEG channel selection model for imagined speech classification[J]. Expert Systems with Applications, 2016, 59: 1-12.

or-Pineda L, et al. Implementing a fuzzy inference system in a multi-objective EEG channel selection model for imagined speech classification[J]. Expert Systems with Applications, 2016, 59: 1-12.

[21] 阮盛捷, 谢宏. 基于功能近红外信号的脑机接口(BCI)在肌萎缩性侧索硬化症(ALS)患者交流中的研究[J]. 现代计算机(专业版), 2018(17): 3-7.

Ruan Shengjie, Xie Hong. Research on simultaneous fNIRS based brain computer interface(BCI) for communication in amyotrophic lateral sclerosis(ALS) patients[J]. Modern Computer, 2018(17): 3-7.(in Chinese)

[22] Anumanchipalli G K, Chartier J, Chang E F. Speech synthesis from neural decoding of spoken sentences[J]. Nature, 2019, 568(7753): 493- 498.

[23] Van Gerven M, Farquhar J, Schaefer R, et al. The brain-computer interface cycle[J]. Journal of Neural Engineering, 2009, 6(4): 041001.

[24] Palmini A. The concept of the epileptogenic zone: a modern look at Penfield and Jasper’s views on the role of interictal spikes[J]. Epileptic Disorders, 2006, 8(2): 10-15.

[25] Makin J G, Moses D A, Chang E F, et al. Machine translation of cortical activity to text with an encoder-decoder framework[J]. Nature Neuroscience, 2020, 23: 575-582.

[26] Chakrabarti S, Sandberg H M, Brumberg J S, et al. Progress in speech decoding from the electrocorticogram[J]. Biomedical Engineering Letters, 2015, 5(1): 10-21.

[27] Herff C, Schultz T. Automatic speech recognition from neural signals: a focused review[J]. Frontiers in Neuroscience, 2016, 10: 429.

[28] Freudenburg Z V, Branco M P, Leinders S, et al. Sensorimotor ECoG signal features for BCI control: a comparison between people with locked-in syndrome and able-bodied controls[J]. Frontiers in Neuroscience, 2019, 13: 1058.

[29] Leuthardt E C, Gaona C, Sharma M, et al. Using the electrocorticographic speech network to control a brain-computer interface in humans[J]. Journal of Neural Engineering, 2011, 8(3): 036004.

[30] Pei X, Barbour D L, Leuthardt E C, et al. Decoding vowels and consonants in spoken and imagined words using electrocorticographic signals in humans[J]. Journal of Neural Engineering, 2011, 8(4): 046028.

[31] Ikeda S, Shibata T, Nakano N, et al. Neural decoding of single vowels during covert articulation using electrocorticography[J]. Frontiers in Human Neuroscience, 2014, 8: 125.

[32] Martin S, Brunner P, Iturrate I, et al. Word pair classification during imagined speech using direct brain recordings[J]. Scientific Reports, 2016, 6: 25803.

[33] 焦学军, 姜劲, 潘津津, 等. 基于fNIRS技术的脑机接口研究[J]. 天津大学学报:自然科学与工程技术版, 2017, 50(5): 527-535.

Jiao Xuejun, Jiang Jin, Pan Jinjin, et al. Investigation of brain-computer interface using functional near-infrared spectroscopy[J]. Journal of Tianjin University: Science and Technology, 2017, 50(5): 527-535.(in Chinese)

[34] Hong K S, Ghafoor U, Khan M J. Brain-machine interfaces using functional near-infrared spectroscopy: a review[J]. Artificial Life and Robotics, 2020: 1-15.

[35] Hwang H J, Choi H, Kim J Y, et al. Toward more intuitive brain-computer interfacing: classification of binary covert intentions using functional near-infrared spectroscopy[J]. Journal of Biomedical Optics, 2016, 21(9): 091303.

[36] Sereshkeh A R, Yousefi R, Wong A T, et al. Online classification of imagined speech using functional near-infrared spectroscopy signals[J]. Journal of Neural Engineering, 2018, 16(1): 016005.

[37] Sereshkeh A R, Yousefi R, Wong A T, et al. Development of a ternary hybrid fNIRS-EEG brain-computer interface based on imagined speech[J]. Brain-Computer Interfaces, 2019, 6(4): 128-140.

[38] Cohen M X. Where does EEG come from and what does it mean?[J]. Trends in Neurosciences, 2017, 40(4): 208-218.

[39] 张海军, 王浩川. 多导联EEG信号分类识别研究[J]. 计算机工程与应用, 2008, 44(24): 228-230.

Zhang Haijun, Wang Haochuan. Research on classification and recognition of multi-channel EEG Signal[J]. Computer Engineering and Applications, 2008, 44(24): 228-230.(in Chinese)

[40] Parvinnia E, Sabeti M, Jahromi M Z, et al. Classification of EEG signals using adaptive weighted distance nearest neighbor algorithm[J]. Journal of King Saud University-Computer and Information Sciences, 2014, 26(1): 1- 6.

[41] D’Zmura M, Deng S, Lappas T, et al. Toward EEG sensing of imagined speech[C]∥International Conference on Human-Computer Interaction. Springer, 2009: 40- 48.

[42] Zhao S, Rudzicz F. Classifying phonological categories in imagined and articulated speech[C]∥International Conference on Acoustics, Speech and Signal Processing. IEEE, 2015: 992-996.

[43] Jahangiri A, Sepulveda F. The contribution of different frequency bands in class separability of covert speech tasks for BCIs[C]∥Annual International Conference of the IEEE Engineering in Medicine and Biology Society. IEEE, 2017: 2093-2096.

[44] Qureshi M N I, Min B, Park H, et al. Multiclass classification of word imagination speech with hybrid connectivity features[J]. IEEE Transactions on Biomedical Engineering, 2017, 65(10): 2168-2177.

[45] Gonz lez-Casta

lez-Casta eda E F, Torres-García A A, Reyes-García C A, et al. Sonification and textification: proposing methods for classifying unspoken words from EEG signals[J]. Biomedical Signal Processing and Control, 2017, 37: 82-91.

eda E F, Torres-García A A, Reyes-García C A, et al. Sonification and textification: proposing methods for classifying unspoken words from EEG signals[J]. Biomedical Signal Processing and Control, 2017, 37: 82-91.

[46] Sereshkeh A R, Trott R, Bricout A, et al. EEG classification of covert speech using regularized neural networks[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2017, 25(12): 2292-2300.

[47] Hashim N, Ali A, Mohd-Isa W N. Word-based classification of imagined speech using EEG[C]∥International Conference on Computational Science and Technology. Springer, 2017: 195-204.

[48] 孙莉敏, 吴毅, 尹大志, 等. 运动想象训练促进脑卒中患者上肢运动功能恢复的功能磁共振研究[J]. 中国康复医学杂志, 2015, 30(12): 1217-1222.

Sun Limin, Wu Yi, Yin Dazhi, et al. The effects of motor imagery training on upper-extremity functional reorganization in stroke patients: a fMRI study[J]. Chinese Journal of Rehabilitation Medicine, 2015, 30(12): 1217-1222.(in Chinese)

[49] Schultz T, Wand M, Hueber T, et al. Biosignal-based spoken communication: a survey[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2017, 25(12): 2257-2271.

[50] Li D, Gao Q, Lyu W, et al. fMRI-BCI: a review[J]. Journal of Electronic Science and Technology of China, 2009, 7(1): 78-81.

[51] Yoshimura N, Nishimoto A, Belkacem A N, et al. Decoding of covert vowel articulation using electroencephalography cortical currents[J]. Frontiers in Neuroscience, 2016, 10: 175.

[52] Cohen D, Cuffin B N. Demonstration of useful differences between magnetoencephalogram and electroencephalogram[J]. Electroencephalography and Clinical Neurophysiology, 1983, 56(1): 38-51.

[53] Dash D, Ferrari P, Wang J. Decoding imagined and spoken phrases from non-invasive neural(MEG) signals [J]. Frontiers in Neuroinformatics, 2020, 14: 290.

[54] 郭苗苗, 齐志光, 王磊, 等. 语言脑机接口康复系统中的参数优化研究[J]. 信号处理, 2018, 34(8): 974-983.

Guo Miaomiao, Qi Zhiguang, Wang Lei, et al. Research on parameter optimization in speech rehabilitation system based on brain computer interface[J]. Journal of Signal Processing, 2018, 34(8): 974-983.(in Chinese)

[55] 杨晓芳, 江铭虎. 基于汉语音位发音想象的脑机接口研究[J]. 中文信息学报, 2014, 28(5): 13-23.

Yang Xiaofang, Jiang Minghu. Study on brain-computer interface based on Chinese phoneme imagery[J]. Journal of Chinese Information Processing, 2014, 28(5): 13-23.(in Chinese)

[56] DaSalla C S, Kambara H, Sato M, et al. Single-trial classification of vowel speech imagery using common spatial patterns[J]. Neural Networks, 2009, 22(9): 1334-1339.

[57] Kim T, Lee J, Choi H, et al. Meaning based covert speech classification for brain-computer interface based on electroencephalography[C]∥International IEEE/EMBS Conference on Neural Engineering. IEEE, 2013: 53-56.

[58] Riaz A, Akhtar S, Iftikhar S, et al. Inter comparison of classification techniques for vowel speech imagery using EEG sensors[C]∥International Conference on Systems and Informatics. IEEE, 2014: 712-717.

[59] Lee S H, Lee M, Lee S W. EEG representations of spatial and temporal features in imagined speech and overt speech[C]∥Asian Conference on Pattern Recognition. Springer, 2019: 387- 400.

[60] Lee S H, Lee M, Jeong J H, et al. Towards an EEG-based intuitive BCI communication system using imagined speech and visual imagery[C]∥International Conference on Systems, Man and Cybernetics. IEEE, 2019: 4409- 4414.

[61] Matsumoto M, Hori J. Classification of silent speech using support vector machine and relevance vector machine[J]. Applied Soft Computing, 2014, 20: 95-102.

[62] Min B, Kim J, Park H, et al. Vowel imagery decoding toward silent speech BCI using extreme learning machine with electroencephalogram[J]. BioMed Research International, 2016: 2618265.

[63] Mohanchandra K, Saha S. A communication paradigm using subvocalized speech: translating brain signals into speech[J]. Augmented Human Research, 2016, 1(1): 3.

[64] Nguyen C H, Karavas G K, Artemiadis P. Inferring imagined speech using EEG signals: a new approach using Riemannian manifold features[J]. Journal of Neural Engineering, 2017, 15(1): 016002.

[65] Zhang X, Li H, Chen F. EEG-based classification of imaginary Mandarin tones[C]∥Annual International Conference of the IEEE-EMBS(EMBC). IEEE, 2020.

[66] Wang L, Zhang X, Zhong X, et al. Analysis and classification of speech imagery EEG for BCI[J]. Biomedical Signal Processing & Control, 2013, 8(6): 901-908.

[67] Cooney C, Folli R, Coyle D, et al. Neurolinguistics research advancing development of a direct-speech brain-computer interface[J]. iScience, 2018: 103-125.

[68] Mcguire P, Silbersweig D, Wright I C, et al. The neural correlates of inner speech and auditory verbal imagery in schizophrenia: relationship to auditory verbal hallucinations[J]. British Journal of Psychiatry, 1996, 169(2): 148-159.

[69] Shergill S S, Bullmore E T, Brammer M, et al. A functional study of auditory verbal imagery[J]. Psychological Medicine, 2001, 31(2): 241-253.

[70] Shergill S S, Brammer M, Fukuda R, et al. Modulation of activity in temporal cortex during generation of inner speech[J].Human Brain Mapping,2002,16(4): 219-227.

[71] Aleman A, Formisano E, Koppenhagen H, et al. The functional neuroanatomy of metrical stress evaluation of perceived and imagined spoken words[J]. Cerebral Cortex, 2004, 15(2): 221-228.

[72] Mcguire P, Silbersweig D, Murray R M, et al. Functional anatomy of inner speech and auditory verbal imagery[J]. Psychological Medicine, 1996, 26(1): 29-38.

[73] Shuster L I, Lemieux S K. An fMRI investigation of covertly and overtly produced mono- and multisyllabic words[J]. Brain and Language, 2005, 93(1): 20-31.

[74] Bocquelet F, Hueber T, Girin L, et al. Key considerations in designing a speech brain-computer interface[J]. Journal of Physiology-Paris, 2016, 110(4): 392- 401.

[75] Sereshkeh A R, Trott R, Bricout A, et al. Online EEG classification of covert speech for brain-computer interfacing[J]. International Journal of Neural Systems, 2017, 27(8): 1750033.

[76] Martinezmanrique F, Vicente A. The activity view of inner speech[J]. Frontiers in Psychology, 2015: 232-232.

[77] Sarmiento L C, Lorenzana P, Cortes C J, et al. Brain computer interface (BCI) with EEG signals for automatic vowel recognition based on articulation mode[C]∥ISSNIP-IEEE Biosignals and Biorobotics Conference. IEEE, 2014: 1- 4.

[78] Si X, Zhou W, Hong B, et al. Cooperative cortical network for categorical processing of Chinese lexical tone[J]. Proceedings of the National Academy of Sciences of the United States of America, 2017, 114(46): 12303-12308.

[79] Pei X, Hill J, Schalk G. Silent communication: toward using brain signals[J]. IEEE Pulse, 2012, 3(1): 43- 46.

[80] Chengaiyan S, Retnapandian A S, Anandan K. Identification of vowels in consonant-vowel-consonant words from speech imagery based EEG signals[J]. Cognitive Neurodynamics, 2020, 14(1): 1-19.

[81] Yamaguchi H, Yamazaki T, Yamamoto K, et al. Decoding silent speech in Japanese from single trial EEGs: preliminary results[J]. Journal of Computer Science & Systems Biology, 2015, 8(5): 285-291.

[82] Wolpaw J R, Birbaumer N, McFarland D J, et al. Brain-computer interfaces for communication and control[J]. Clinical Neurophysiology, 2002, 113(6): 767-791.

[83] 陈泽龙, 谢康宁. 基于脑电EEG信号的分析分类方法[J]. 中国医学装备, 2019, 16(12): 151-158.

Chen Zelong, Xie Kangning. A review of EEG-based analysis and classification methods[J]. China Medical Equipment, 2019, 16(12): 151-158.(in Chinese)

[84] 裴一飞, 杨淑娟. 运动想象脑电信号算法研究进展[J]. 北京生物医学工程, 2018, 37(2): 208-214.

Pei Yifei, Yang Shujuan. Research progress on motor imagery EEG signals[J]. Beijing Biomedical Engineering, 2018, 37(2): 208-214.(in Chinese)

[85] García A A T, García C A R, Pineda L V. Toward a silent speech interface based on unspoken speech[C]∥International Conference on Bio-inspired Systems and Signal Processing. 2012: 370-373.

[86] Idrees B M, Farooq O. Vowel classification using wavelet decomposition during speech imagery[C]∥International Conference on Signal Processing and Integrated Networks. IEEE, 2016: 636- 640.

[87] Cooney C, Folli R, Coyle D. Mel frequency cepstral coefficients enhance imagined speech decoding accuracy from EEG[C]∥Irish Signals and Systems Conference. IEEE, 2018: 1-7.

[88] Crone N E, Hao L, Hart J, et al. Electrocorticographic gamma activity during word production in spoken and sign language[J]. Neurology, 2001, 57(11): 2045-2053.

[89] Edwards E, Soltani M, Deouell L Y, et al. High gamma activity in response to deviant auditory stimuli recorded directly from human cortex[J]. Journal of Neurophysiology, 2005, 94(6): 4269- 4280.

[90] Iqbal S, Khan Y U, Farooq O. EEG based classification of imagined vowel sounds[C]∥International Conference on Computing for Sustainable Global Development. IEEE, 2015: 1591-1594.

[91] Bakhshali M A, Khademi M, Ebrahimi-Moghadam A, et al. EEG signal classification of imagined speech based on Riemannian distance of correntropy spectral density[J]. Biomedical Signal Processing and Control, 2020, 59: 101899.

[92] García-Salinas J S, Villase or-Pineda L, Reyes-García C A, et al. Transfer learning in imagined speech EEG-based BCIs[J]. Biomedical Signal Processing and Control, 2019, 50: 151-157.

or-Pineda L, Reyes-García C A, et al. Transfer learning in imagined speech EEG-based BCIs[J]. Biomedical Signal Processing and Control, 2019, 50: 151-157.

[93] Livezey J A, Bouchard K E, Chang E F, et al. Deep learning as a tool for neural data analysis: speech classification and cross-frequency coupling in human sensorimotor cortex[J]. PLOS Computational Biology, 2019, 15(9): 1-29.

[94] Saha P, Abdul-Mageed M, Fels S. SPEAK YOUR MIND! Towards imagined speech recognition with hierarchical deep learning[C]∥Annual Conference of the International Speech Communication Association. 2019: 141-145.

[95] Saha P, Fels S. Hierarchical deep feature learning for decoding imagined speech from EEG[C]∥AAAI Conference on Artificial Intelligence. 2019, 33: 10019-10020.

[96] Saha P, Fels S, Abdul-Mageed M. Deep learning the EEG manifold for phonological categorization from active thoughts[C]∥IEEE International Conference on Acoustics, Speech and Signal Processing. IEEE, 2019: 2762-2766.