1 引言

日常生活环境中充斥着各种各样的声音,而声音信号包含了大量丰富的有效信息,这些信息是我们不可忽视的数据。目前,在声音事件识别领域已有了大量的研究,并广泛应用于机器人导航、无人机感知、情景感知[1]和安防监控[2]等。其中,关于环境声音识别的研究也越来越多。传统的声音识别方法首先对采集到的声音信号数据进行预处理,然后提取声音信号的特征参数,最后将特征参数输入分类器进行分类识别。在以往研究中,通常选择和提取的特征有Mel频率倒谱参数(Mel Frequency Cepstrum Coefficient,MFCC)、短时能量(Short-Term Energy,STE)、线性预测倒谱系数(Linear Prediction Cepstrum Coefficient,LPCC)、过零率(Zero-Crossing Rate,ZCR)和自相关函数(Autocorrelation Function,ACF)等,其中最常用的是MFCC[3]。文献[4- 8]均提取MFCC特征参数作为异常声音信号特征。常用的分类器模型有:动态时间规整(Dynamic Time Warping,DTW)、矢量量化(Vector Quantization,VQ)、高斯混合模型(Gaussian Mixture Model,GMM)和隐马尔科夫模型(Hidden Markov Model,HMM)等。很多学者将机器学习算法应用到声音识别分类器模型中,如:Phan等人提出了使用随机森林算法[9],Zieger等人提出使用支持向量机的方法[10],Barchiesi等人则采用了高斯混合模型[11]。随着深度学习的发展与兴起,Gencoglu等人通过将深度神经网络的算法应用于声音事件识别中,并取得了相较机器学习算法更高的识别率[12]。

以上声音识别的方法虽然在不同领域得到了较好的应用,但同时也存在着一定的局限性:在声音信号数据噪声较大的数据集上,随机森林算法在完成分类或回归问题时容易出现过拟合的现象,且随机森林会因为属性取值划分较多而导致在处理分类或回归问题时对结果产生较大的不良影响[13]。支持向量机(Support Vector Machine,SVM)算法难以应用在数据量较大的训练集上,且当分类较多时也很难有较好的识别效果,此外,SVM算法对参数和核函数选择也相当的敏感[13];深度神经网络(Deep Neural Networks,DNN)虽然使识别率得到了一定程度的提高,但模型在训练时需要巨大的计算量,且所需要的学习时间也相对较长,同时还存在参数数量膨胀的问题[14]。由于环境声音数据中往往存在较多的噪声,且这些噪声具有随机性及非平稳性,传统的机器学习分类算法在这种复杂噪声及数据量较大的情况下很难达到理想的分类结果。因此,Ossama等人提出了用卷积神经网络作为语音识别中的分类器[15],相较以往的方法在识别效果上更佳。

本文在研究环境声音识别技术的基础上,以美尔谱系数(Mel-frequency spectral coefficient,MFSC)作为特征参数进行特征提取[16],然后构建卷积神经网络模型进行分类,实现对环境声音的识别。同时,通过对比实验验证了卷积神经网络在环境声音识别上的泛化能力。此外,考虑到不同模型在不同数据集上表现不同,为了实验的严谨性,所有实验均在ESC-10数据集上进行实验。相比传统声音识别方法,本方法在环境声音识别率上取得了更好的效果。

2 环境声音识别技术

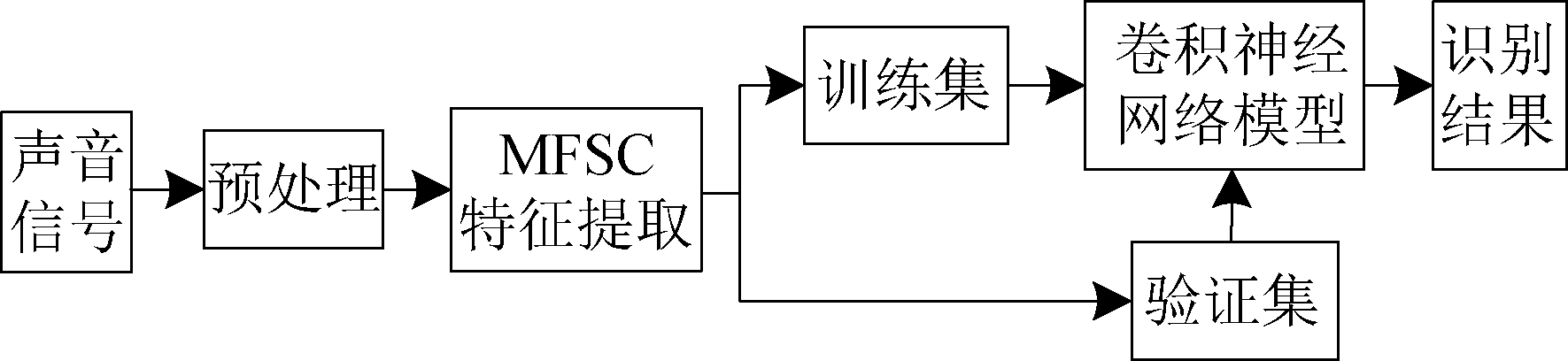

美尔谱系数与卷积神经网络(Convolutional Neural Networks,CNN)相组合的环境声音识别流程如图1所示:首先,将声音信号进行预处理,然后提取其MFSC特征参数,并将提取的特征与对应的数据标签形成声音数据样本;其次,将声音数据样本分为训练集和验证集为之后训练模型和测试模型做准备;接着将训练集输入构建好的卷积神经网络模型中进行训练;最后输出验证数据集在模型上的泛化表现。

2.1 预处理

预处理包括滤波、A/D转换、预加重、分帧加窗及端点检测。其中预加重处理是用来优化和提升整个声音信噪比和数据高频的部分,使得声音信号数据的频谱和信噪比变得较为平缓[17-18]。预加重处理保证了声音信号在整个频率范围内具有相同的信噪比。预加重的传递函数定义为:

H(z)=1-μz-1

(1)

其中μ的取值在0.9~1.0的范围之内,本文取值为0.97。

经过预加重处理之后需要对数据进行分帧与加窗,将声音数据分成一个个很小的时间段,即帧。然后对分帧的声音信号进行加窗处理,从而维持声音信号的短时平稳性,同时降低Gibbs效应。本文中帧长设置为20 ms,帧移设置为20 ms的0.3倍。并且选用汉明窗,其函数表达式如(2)所示,其中N为等于帧长的窗长度。

图1 美尔谱系数与卷积神经网络相组合的环境声音识别流程示意图

Fig.1 Schematic diagram of the environmental sound recognition process combining Meir spectral coefficients and convolutional neural networks

图2 MFSC特征提取过程

Fig.2 MFSC feature extraction process

w(n)=![]()

(2)

2.2 特征提取

由于在不同频率上人耳的声音灵敏度是不一样的,感知到的声音频率与音调高低具有非线性, 通过仿照人的听觉系统提出了梅尔频率,产生了MFCC的声音信号特征提取方法。然而,通过对MFSC与MFCC进行比较发现,由于MFCC对特征进行了去相关和压缩,因而更合适使用高斯混合模型的建模方式。其次,MFCC数据量较少,虽然大大降低了运算时间,但在采用神经网络的训练方式时使用MFSC相较于MFCC具有更高的维度和相关性,主要表现在频谱上较为平滑[19]。本文通过构建卷积神经网络模型,将两种特征提取方法在同样的数据集下进行对比实验。实验结果与预期的结果一致,在使用MFSC时模型具有更高的识别率。

MFSC特征提取过程如图2所示,具体步骤为:

(1)首先对输入信号x(n)进行离散傅里叶变换,获得信号的频谱分布信息:

(3)

式中,x(n)为输入的经过预处理的音频信号,N为傅里叶变换的点数,本文取512。

(2)然后通过一组Mel尺度的三角形滤波器组,实现了在Mel域上对声音信号的感知分析。

(3)计算每个滤波器输出的能量。

(4)

式中,Xa(k)是音频信号的能量谱,Hm(k)是滤波器组的传输函数,M为滤波器个数,本文采用20,S(m)是能量。

(4)经离散余弦变换得到MFSC系数。

(5)

式中,C(n)为MFSC系数。

2.3 卷积神经网络

卷积神经网络模型体系结构由以下几层组成。

(1)输入层,将预先处理好的数据样本输入到神经网络模型中。

(2)卷积层,通过卷积运算对不同特征进行提取,在模型的第一层或者前几层中提取较小的局部模式,随着层数的增加,后一层提取由前一层特征组成的更大的模式。这样虽然使得卷积神经网络模型的复杂度越来越高,但其效果是使模型可以更有效的处理复杂问题。

(3)池化层又叫做下采样技术,通过下采样将特征的元素数量减少,使得模型学习到更重要的特征。最大值池化比均值池化可以给出更多的有效信息,因此本文采用最大值池化,不仅训练时间较短且效率更高。

(4)全连接层根据不同的问题设置不同的结构,得出所需结果,其功能类似于分类器。

(5)输出层将神经网络模型训练或测试的结果输出,使模型与数据直观化,同时可以根据结果通过调整模型参数、更换损失函数、调整优化器和模型结构等手段来重新构建训练模型。

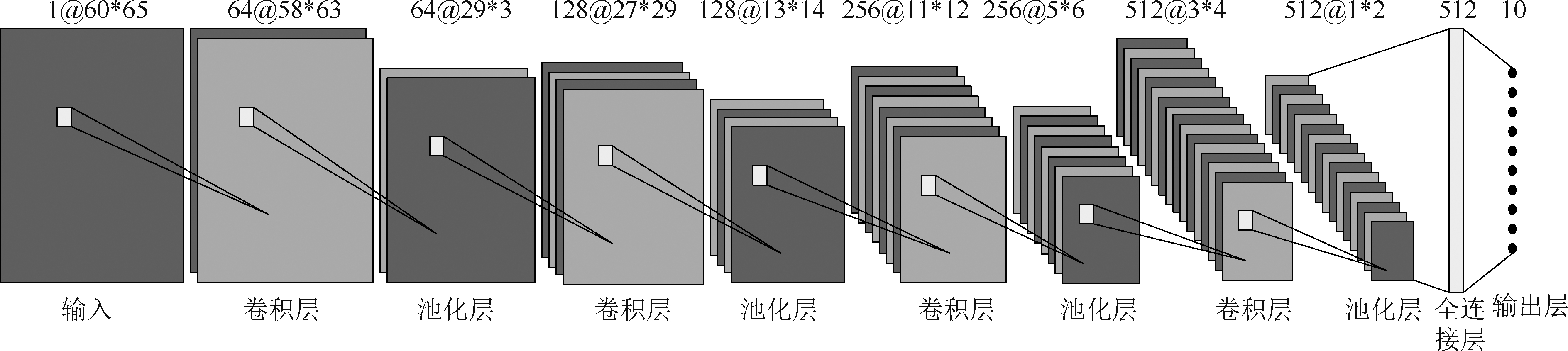

图3 卷积神经网络模型结构

Fig.3 Convolutional neural network model structure

本文所构建的模型结构如图3所示,包括卷积层、池化层、全局平均池化和全连接层。提取的MFSC特征参数作为输入层的输入,将其转化为矩阵,使用卷积核对其进行卷积,从而得到卷积之后的特征。本模型中第l层卷积层的第i个特征图是![]() 前一层卷积层的第j个特征图为

前一层卷积层的第j个特征图为![]() 的计算如公式(6)所示:

的计算如公式(6)所示:

(6)

式中,![]() 为偏置项,

为偏置项,![]() 表示卷积核,Mi表示第l-1层卷积层与第l层卷积层的第i个单元连接的特图的特征图数量。

表示卷积核,Mi表示第l-1层卷积层与第l层卷积层的第i个单元连接的特图的特征图数量。

经过卷积层卷积之后采取批量归一化操作,不仅可以获得更高的学习率,还可以提高模型训练的速度。选择公式(7)所示的带泄露修正线性单元(Leaky ReLU)[20]作为激活函数:

(7)

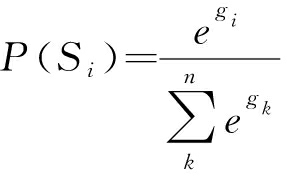

相较于修正线性单元没有半数梯度值是0的情况。经过激活函数进入池化层,池化通过滑动的核在特征矩阵中取出最大值作为输出,也叫做最大池化。通过全局平均池化替代展开层,全局平均池化在特征矩阵与最终的分类间转换显得更加简单自然,且不需要大量训练调优的参数,降低了空间参数的同时使模型更加健壮,抗过拟合效果更佳。最后进入全连接层,并使用公式(8)所示的激活函数归一化指数(softmax)对结果进行分类。

(8)

式中,有n个数值表示的分类Sk,k∈(0,n],其中n表示分类的个数。i表示k中的某个分类,gi表示使用Dropout[21]可以比较有效的缓解过拟合的发生,在一定程度上达到正则化的效果。选择自适应力矩估计(Adaptive moment estimation,Adam)优化器,并采用默认参数进行实验。通过使用固定的衰减来限制学习率,避免在模型拟合到最优值点时来回往复。

3 实验方法

本文采用ESC-10数据集,ESC-10数据集包含有400条标记的环境声音数据,这些数据共有10个类别,每个类别的环境声音数据量为40个,且单个环境声音时长不超过5秒,不足5秒的环境声音数据将会默认补足至5秒。环境声音样本被重新转换为统一格式(44.1 kHz,单通道,Ogg Vorbis压缩速度为192 kbit/s)[22]。由于ESC-10中的环境声音数据量较小,在数据预处理和特征提取之后将数据样本分为5份,为后续实验训练卷积神经网络模型进行五折交叉验证做准备。实验设备为NVIDIA GeForce RTX 2080显卡(8G显存)以及Intel COREi7 9thgen处理器。

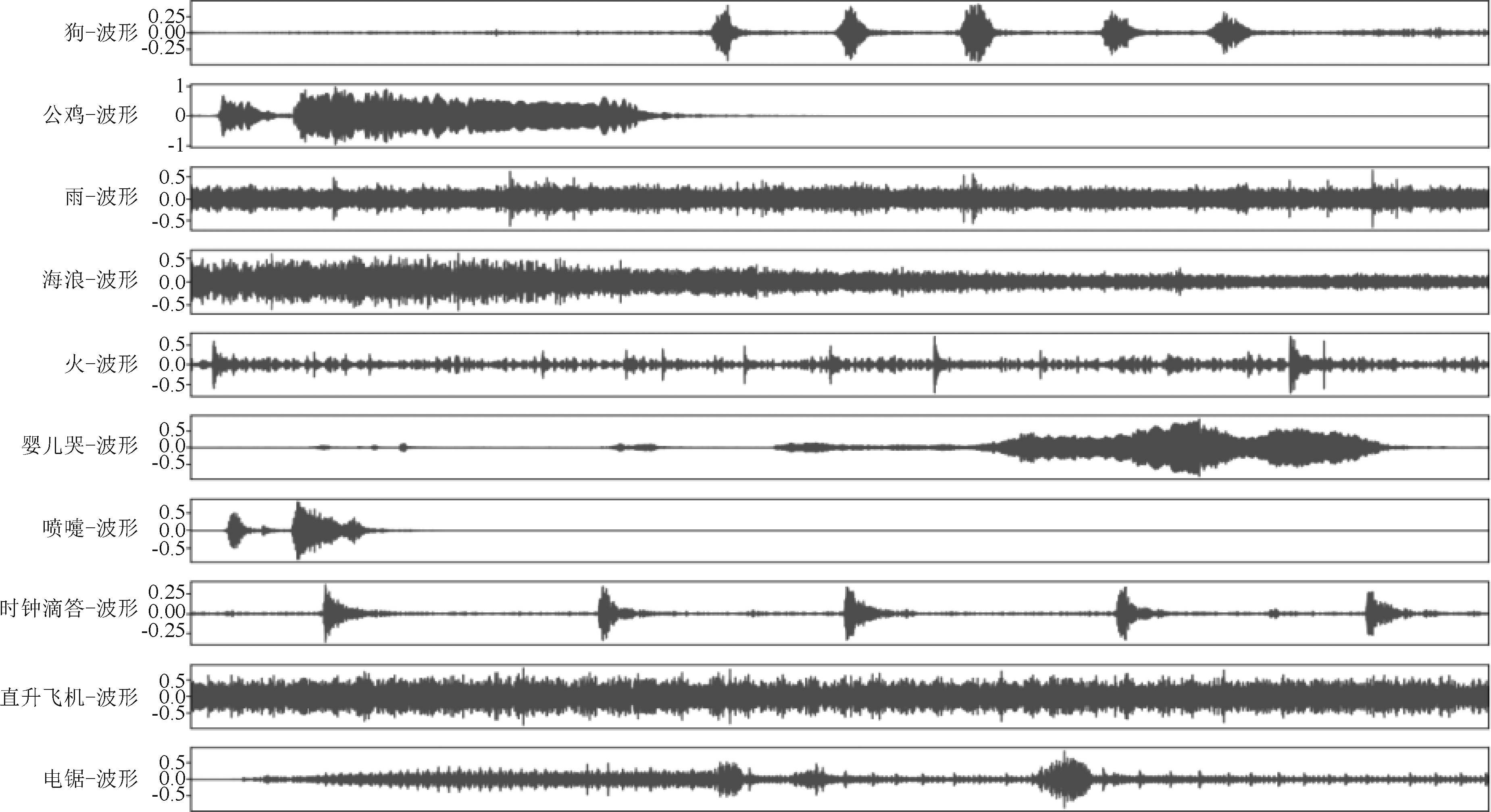

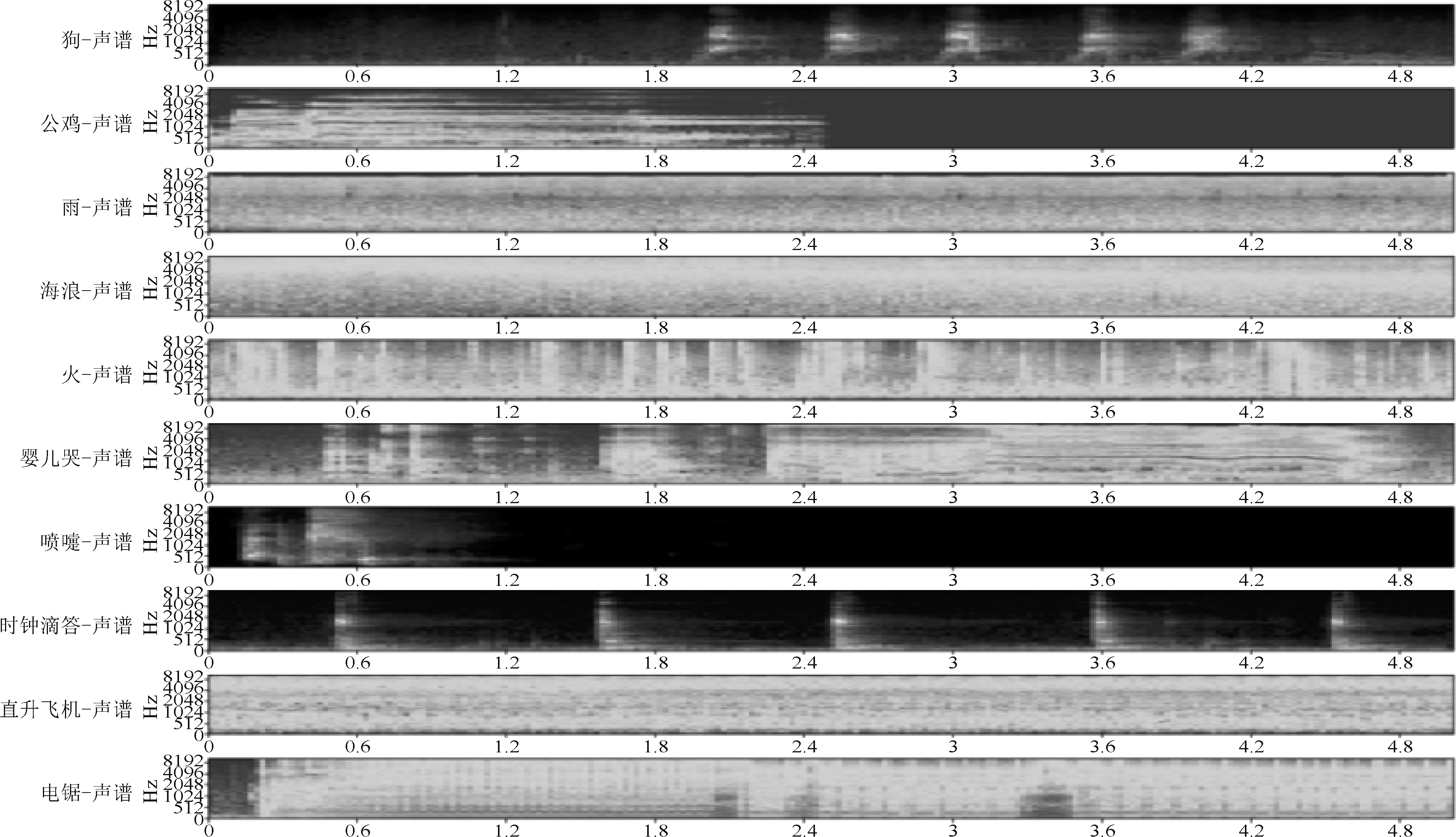

ESC-10的部分声音数据样本的时域波形图与声谱图如图4和图5所示。每个类别的声音数据抽取一个数据生成时域波形图和频谱图,从图中可以很容易看出,婴儿哭声,打喷嚏声,公鸡啼叫,狗叫和时钟滴答声因时域波形、频谱差别较大,所以提取的特征也相对容易且易于模型学习和分类。而雨、海浪、火焰噼啪声、直升机、电锯声音的时域波形、频谱相似处较多,因此提取的特征也会有较多相似之处,从而导致模型在学习和分类时相对困难,影响了模型整体的识别率。

图4 环境声音时域波形图

Fig.4 Ambient sound time-domain waveform

图5 环境声音声谱图

Fig.5 Ambient sound spectrum

在对数据预处理之后通过MFSC来提取特征参数,将提取的特征作为输入对卷积神经网络进行训练,使用一个3×3的卷积核进行卷积,步幅为1。池化层滑动窗口的大小设置为2×2,步幅为2。在构建卷积神经网络模型时每层卷积层之后都添加批量归一化操作和一层池化层。激活函数选择Leaky ReLU,其负斜率系数设置为0.05。使用全局平均池化替代展开层,通过第一层全连接层的512个神经元之后再通过第二层全连接层,并使用激活函数softmax对结果进行分类。因为数据共有十个类别,所以将分类的类别设置为10。在四层卷积层中,随着层数的增加卷积核的数量也在不断的增加。将128个卷积核设置在第一层神经网络中,在第二层网络中卷积核的数量是在第一层的基础上增加了128个,第三层的卷积核数量与第二层的卷积核数量一致,最后一层的卷积核在第三层的基础上再增加256个。

实验中模型共迭代70次,此外将批处理个数设置为32,使用学习率衰减策略,当迭代到第20、40和60次时进行一次迭代衰减,且每次衰减后将会变为原有学习率的十分之一。在全连接层中使用Dropout正则化并设置其值为0.5。选择Adam优化器,其中学习率为0.001,一阶与二阶矩估计的指数衰减率分别是0.9,0.999。考虑到ESC-10数据集数据量较小难以训练出稳定的模型,因此选择将模型进行五折交叉验证。通过交叉验证的方法可以在数据量较少时更多的学习到可用的数据信息,从而降低了模型过拟合的情况。

4 实验结果及分析

4.1 实验设置

通过进行各种参数,优化器和模型结构等对比实验构建卷积神经网络模型,并选择合适的模型参数,优化器和模型结构。同时在对比实验中为保证模型参数的可比性,除所需实验对比的参数外,其他的参数与模型结构要保持完全一致。经过实验选取合适的模型参数,完善卷积神经网络模型,并将卷积神经网络模型与传统的声音识别算法在同一数据集下训练比较分类结果。

在相同结构和参数的卷积神经网络模型中,对MFCC与MFSC两种不同的特征提取方法做对比实验,同时对随机梯度下降(Stochastic Gradient Descent,SGD)和Adam两种不同的优化器做对比实验,形成了四种组合方案。实验结果如表1所示。

表1 不同特征提取和不同优化器下的准确率

Tab.1 Accuracy under different feature extraction and different optimizers

MFCCMFSCSGD81.00%85.25%Adam80.00%86.50%

由表1可知在特征提取方法选用MFCC的情况下,优化器选用SGD有相对更好的识别效果。而在选用MFSC作为特征参数的情况下,优化器选用Adam时模型识别率明显会更高。换一个思路,在考虑先选择优化器的情况下,优化器无论是选择SGD还是Adam,选用MFSC作为特征参数时模型识别率都会更高,且相对选用MFCC作为特征参数时模型的识别率有4%~5%的提升。

优化器Adam理论上在小数据集上相对SGD有较好的表现,但是在实验中优化器SGD与Adam在实验中对模型识别率的影响差别不大,甚至可以忽略不计。而在特征提取方面,MFSC的表现相对MFCC更好。批处理数量一般选用16,32,64,128等,由于所使用的数据较小,所以选择使用的批处理个数为32,这一点也通过了实验进行了验证。

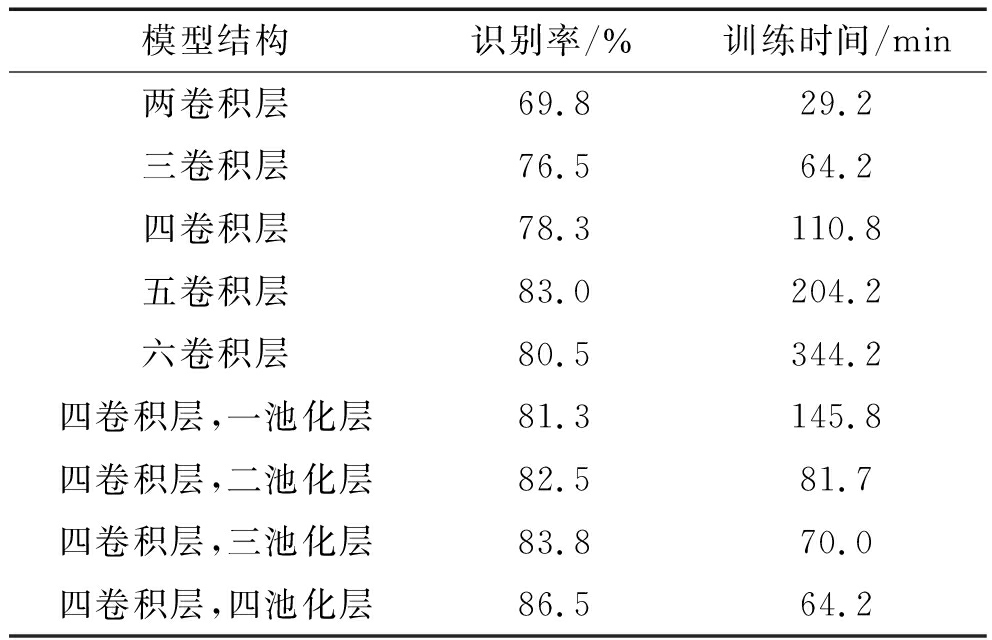

通过以上实验得出的结果,模型最终采用MFSC作为特征提取,优化器选择Adam,迭代次数为70次,批处理个数为32。卷积神经网络模型的构建是通过卷积层和池化层的随机叠加,找到识别率最好的叠加方式。对卷积层数量,池化层数量和之间的先后关系进行实验,并记录了训练模型所需的时间。相关的数据如表2所示。

表2 不同模型下识别率和训练时间

Tab.2 Recognition rate and training time under different models

模型结构识别率/%训练时间/min两卷积层69.829.2三卷积层76.564.2四卷积层78.3110.8五卷积层83.0204.2六卷积层80.5344.2四卷积层,一池化层81.3145.8四卷积层,二池化层82.581.7四卷积层,三池化层83.870.0四卷积层,四池化层86.564.2

由表2可知,在不加入池化层的神经网络模型中,逐层的添加卷积层层数会逐渐增加模型的复杂度。模型这样的改变使得模型识别率得到不断的提高,与此同时训练模型所需的时间也随之增加。当卷积层增加至第六层时,因模型的复杂度过高导致模型过拟合,影响了模型的识别率。在加入了池化层之后,随着池化层层数的增加模型的识别率不断提高,而训练模型所需时间却在不断减少。由此可见池化层筛选出了关键信息,降低了模型训练的计算量,使得训练模型所需时间减少并提高了模型识别率。经过对实验结果的分析,再根据奥卡姆剃刀原则最终确定实验模型结构。

表3 单样本统计

Tab.3 Single sample statistics

个案数平均值标准偏差标准误差平均值准确率2586.5000%2.84129%0.56826%

表4 单样本检验

Tab.4 Single sample test

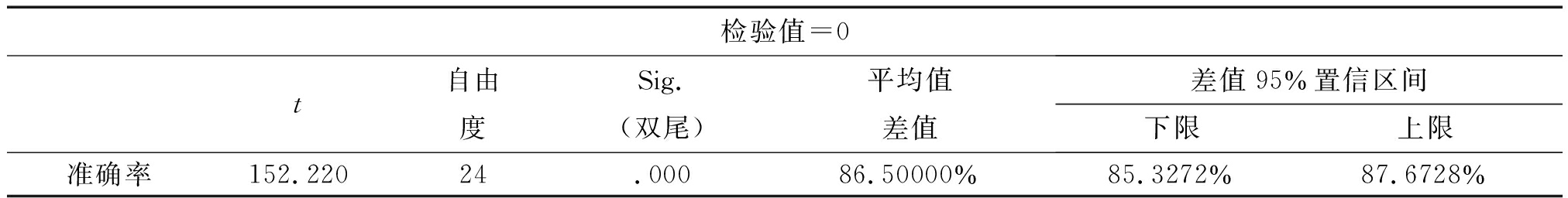

检验值=0t自由度Sig.(双尾)平均值差值差值95%置信区间下限上限准确率152.22024.00086.50000%85.3272%87.6728%

4.2 结果与分析

(1)数据量与准确率关系

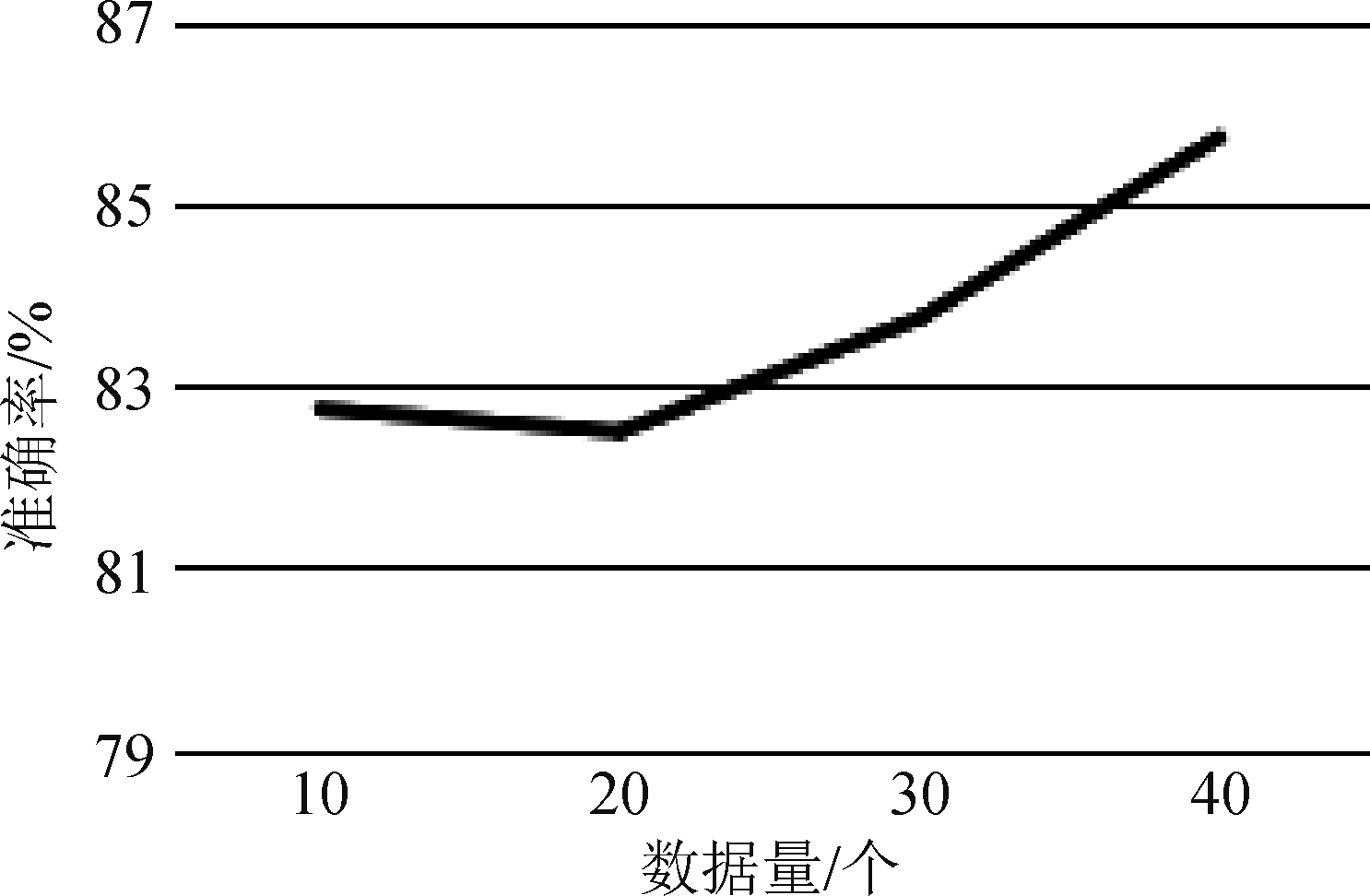

在使用相同参数、优化器和特征提取方法的情况下对不同数据量进行了实验。原数据集中拥有400个声音数据,一共分为十个类别,每一个类别有40个声音数据。考虑到卷积神经网络在大数据量情况下训练将会有更好的识别效果,因此预期模型将会随着数据量的增加使得模型识别率得到逐步提升。将每个类别的数据量减少至30,20,10分别进行实验得到如图6所示结果。

图6 数据量与准确率关系

Fig.6 Relationship between data volume and accuracy

实验所得结果与预期基本相符,从折线图中可以看出随着数据量的增加,模型的识别率也在不断的提高,说明卷积神经网络在通过数据特征学习之后,不断的对模型中的权重值进行优化。由于数据较少时模型学习得到的数据特征不全面,导致获得的权重值无法满足测试集上部分数据的识别分类,使得模型在测试集上的识别率较低。随着数据量的逐步增加,模型学习得到的数据特征也逐渐全面,从而获得更优的权重值使得模型具有更好得到识别效果,这也体现了模型具有较好的泛化能力。

(2)统计T检验

通过对准确率的统计T检验,得出如表3的单样本统计和表4的单样本检验数据。

由表3和表4中的结果可知,本文所构建的模型识别率实验结果较为可靠。

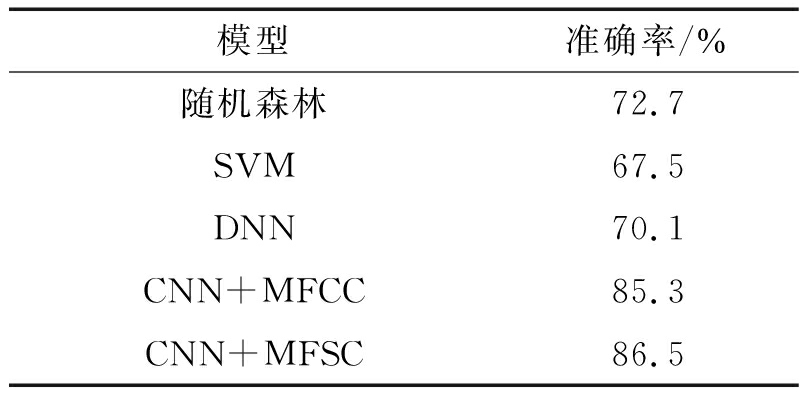

(3)与传统的识别模型进行对比

在本模型及数据集基础上,与传统的声音识别方法进行对比实验结果如表5所示。

表5 与传统声音识别模型识别准确率对比结果

Tab.5 Comparison of recognition accuracy with traditional voice recognition models

模型准确率/%随机森林72.7SVM67.5DNN70.1CNN+MFCC85.3CNN+MFSC86.5

从表中可以看出,在同样的数据集下,相较于传统的机器学习算法对环境声音的识别,卷积神经网络模型具有更高的识别率,尤其是MFSC作为特征参数时的识别效果更佳。MFSC与CNN相组合的环境声音识别方法与随机森林、SVM、DNN在相同数据集下分别进行实验,在识别率上分别有13.1%,18.3%,15.7%的提升,从而证实了卷积神经网络模型在对数据的学习能力和泛化能力上的优异。因此MFSC与CNN相组合的环境声音识别方法在相较传统的声音识别方法更具有优势。

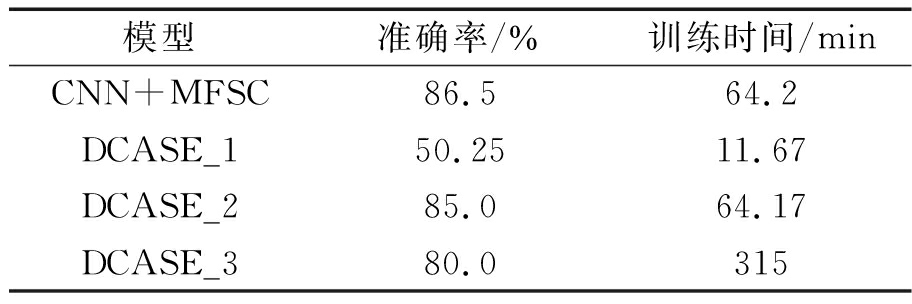

(4)与DCASE比赛中的常用识别模型对比

在DCASE比赛中常用卷积神经网络作为识别分类的模型。DCASE2019 Challenge任务1中,Ning FangLi和Duan Shuang[23]提出了多次使用Dropout的卷积神经网络模型DCASE_1;Yang Haocong、 Shi Chuang和Li Huiyong[24]提出了在每个卷积层之后添加批归一化操作的卷积神经网络模型DCASE_2;Shengwang Jiang,Chuang Shi和Huiyong Li[25]提出了多层次卷积池化叠加的卷积神经网络模型DCASE_3。将本文设计模型与DCASE比赛中三种不同结构的卷积神经网络模型进行比较,识别准确率与训练时间如表6所示。

表6 与DCASE主流模型的对比

Tab.6 Comparison with the DCASE mainstream model

模型准确率/%训练时间/minCNN+MFSC86.564.2DCASE_150.2511.67DCASE_285.064.17DCASE_380.0315

由于DCASE比赛中所使用的数据集较本文所使用的数据集更大,且数据采集条件和数据种类不同,导致数据特征分布有所差异。由表6实验结果可知,DCASE_1模型训练时间较短,效率较高,但其识别准确率较低。这是由于DCASE_1模型使用了多次Dropout,使得模型在训练时丢失了较多的数据特征信息,该方法在大数据集上能够得到较好的识别效果,但在小数据上就会因丢失过多的数据而无法得到较好的识别准确率。DCASE_2模型和本文模型的结构有很多相同之处,且模型复杂度也相似,所以无论是在准确率还是训练时间上都很接近。但是本文所设计模型是针对本文所采用的小数据集进行了调整及设计,因此在准确率上更高一些。DCASE_3模型由于较复杂,因此,其训练时间较长,效率较低,同时由于易出现过拟合现象,准确率也相对较低。综上所述,在本文数据集上从识别准确率和识别效率进行分析,本文所设计模型具有更优的效果。

5 结论

针对环境声音,通过设计卷积神经网络模型及相应实验的方法,提出了MFSC与CNN相组合的环境声音识别方法。在相同数据集下,与以往传统的机器学习算法和DCASE比赛中常用模型进行比较,取得了更高的识别率和识别效率。此外还验证了卷积神经网络在环境声音上的学习和泛化能力。今后将会通过循环神经网络、胶囊网络和生成对抗网络继续优化训练模型。同时结合数据增强、知识图谱等相关技术,对环境声音识别技术作进一步探索。

[1] Tang Baolong, Li Yuanqing, Li Xuesheng, et al. Deep C-NN Framework for Environmental Sound Classification sing Weighting Filters[C]∥IEEE International Conferene on Mechatronics and Automation, IEEE, 2019: 2297-2302.

[2] 胡涛, 张超, 程炳, 等. 卷积神经网络在异常声音识别中的研究[J]. 信号处理, 2018, 34(3): 357-367.

Hu Tao, Zhang Chao, Cheng Bing, et al. Research on Abnormal Audio Event Detection Based on Convolutional Neural Networks[J]. Journal of Signal Processing, 2018, 34(3): 357-367.(in Chinese)

[3] Ieee S B D M. Comparison of Parametric Representations for Monosyllabic Word Recognition in Continuously Spo-ken Sentences[J]. Readings in Speech Recognition, 1990, 28(4): 65-74.

[4] Nan M K, Zia A. Robust unsupervised detection of hum-an screams in noisy acoustic environments[C]∥IEEE International Conference on Acoustics, Speech & Signal Processing (ICASSP), 2015: 161-165.

[5] Kucukbay S E, Sert M. Audio-based event detection in office live environments using optimized MFCC-SVM approach[C]∥ IEEE International Conference on Semantic Computing (ICSC), 2015: 475- 480.

[6] Li Q, Liu X M, Yang X Y. Abnormal event detection method in multimedia sensor networks[C]∥International Journal of Distributed Sensor Networks, 2015(4): 1- 8.

[7] Zaheer M Z, Kim J Y, Kim H G, et al. A Preliminary studay on deep-learning based screaming sound detction[C]∥2015 5th International Conference on IT Convergence and Security (ICITCS), 2015: 1- 4.

[8] 栾少文, 龚卫国. 公共场所典型异常声音的特征提取[J]. 计算机工程, 2010, 36(7): 208-210.

Luan Shaowen, Gong Weiguo. Feature extraction of typical abnormal sounds in public places[J]. Computing Mechanical Engineering, 2010, 36(7): 208-210.(in Chinese)

[9] Phan H, MaaB M, Mazur R, et al. Random regression forests for acoustic event detection and classification[J]. IEEE/ACM Transactions on Audio Speech & Language Processing, 2015, 23(1): 20-31.

[10] Zieger C, Omologo M. Acoustic event classification using a distributed microphone network with a GMM/SVM co-mbined algorithm[C]∥INTERSPEECH 2008, Conferen-ce of the International Speech Communication Association, Brisbane, Australia, September. DBLP, 2008: 115-118.

[11] Barchiesi D, Giannoulis D, Dan S, et al. Acousticlion Scene Classification[J]. IEEE, Signal Processing Magazine, 2014, 32(3): 16-34.

[12] Gencoglu O, Virtanen T, Huttunen H. Recognition of acoustic events using deep neural networks[C]∥Signal Processing Conference(EUSIPCO), 2014 Proceedings of the 22nd European. IEEE, 2014: 506-510.

[13] Piczak K J. Environmental sound classification with conv-olutional neural networks[C]∥Machine Learning for Sig-nal Processing(MLSP), 2015 IEEE 25th International Workshop on. IEEE, 2015: 1- 6.

[14] 王诗佳. 基于深度学习的声音事件识别研究[D]. 南京: 东南大学, 2018.

Wang Shijia. Research on sound event recognition based on deep learning[D]. Nanjing: Southeast University, 2018.(in Chinese)

[15] Mohamed A R, Jiang H, et al. Convolutional Neural Networks for Speech Recognition[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2014, 22(10): 1533-1545.

[16] Ahmad Jamal, Hayat Maqsood. MFSC: Multi-voting based feature selection for classification of Golgi proteins by ad-opting the general form of Chou’s PseAAC components[J]. Journal of Theoretical Biology, 2018, 463.

[17] 曾剑飞. 低信噪比条件下的语音端点检测算法研究[D]. 华南理工大学, 2019.

Zeng Jianfei. Research on Speech Endpoint Detection Algorithm under Low SNR[D]. South China University of Technology, 2019.(in Chinese)

[18] 陈旺. 语音端点检测的鲁棒性研究[D]. 广州大学, 2019.

Chen Wang. Research on Robustness of Speech Endpoint Detection[D]. Guangzhou University, 2019.(in Chinese)

[19] Mohamed, Abdel-rahman. Deep Neural Network Acoustic Models for ASR[J]. Speech Communication, 2019, 110: 56- 63.

[20] Xu B, Wang N, Chen T, et al. Empirical Evaluation of Rectified Activations in Convolutional Network[J]. Computer Science, 2015.

[21] Srivastava N, Hinton G E, Krizhevsky A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. Journal of Machine Learning Research, 2014, 15(1): 1929-1958.

[22] Piczak K J. ESC: Dataset for Environmental Sound Class-ification[J]. IEEE Transactions on Wireless Communications, 2015, 9(2): 1015-1018.

[23] Ning FangLi, Duan Shuang. ACOUSTIC SCENE CLASSIFICATION BASED ON THE DATASET WITH DEEP CONVOLUTIONAL GENERATED AGAINST NETWORK[EB/OL]. chrome-extension:∥ibllepbpahcoppkjjllbabhnigcbffpi/http:∥dcase.community/documents/challenge2019/technical_reports/DCASE2019_Li_12.pdf, 2020.4.27/2020.4.27.

[24] Yang Haocong, Shi Chuang, Li Huiyong. ACOUSTIC SCENE CLASSIFICATION USING CNN ENSEMBLES AND PRIMARY AMBIENT EXTRACTION[EB/OL]. chrome-extension:∥ibllepbpahcoppkjjllbabhnigcbffpi/http:∥dcase.community/documents/challenge2019/technical_reports/DCASE2019_Yang_22.pdf, 2020.4.27/2020.4.27.

[25] Jiang Shengwang, Shi Chuang, Li Huiyong. ACOUSTIC SCENE CLASSIFICATION USING ENSEMBLES OF CONVOLUTIONAL NEURAL NETWORKS AND SPECTROGRAM DECOMPOSITIONS[EB/OL]. chrom e-extension:∥ibllepbpahcoppkjjllbabhnigcbffpi/http:∥dcase.community/documents/challenge2019/technical_reports/DCASE2019_Jiang_32.pdf, 2020.4.27/2020.4.27.