1 引言

随着我国民航业的迅猛发展,机场规模越来越大。机场内部各种工具车辆繁多,对车辆自动管理系统提出了巨大的挑战,车牌检测是车辆自动管理系统的重要环节。当前国内已经有很多车牌检测系统投入商用。但是,由于机场内部车辆车牌规格与民用车牌规格不同,经过调研发现目前尚无能够检测民航车牌的车牌检测方法,基于上述情况和相关需求,本文提出了一种能够同时检测民用车牌和民航车牌的车牌检测方法。国内外车牌检测方法可以分为两种:一种是基于先验信息的传统车牌检测方法,另一种是基于深度学习的检测方法。传统车牌检测方法主要是利用车牌的轮廓、纹理和颜色等特征对车牌进行建模[1-3]。这些传统方法的特点是计算量小,但是准确率低,鲁棒性差。基于深度学习的目标检测网络主要分为两步检测网络和单步检测网络。两步检测网络主要包括R-CNN系列,如R-CNN[4]、SPP-NET[5]、Fast R-CNN[6]、Faster R-CNN[7]等,这些网络的特征是把目标检测任务分成两步:首先检测出疑似目标候选边界框(Region Proposal),然后提取这些候选框的特征,推断出这些候选框属于各个目标的置信度,从而检测出目标在图片中的相对位置和种类。单步检测网络则通过一次特征提取,直接得出目标的类别概率和位置,这种方法比两步检测法更快。比较典型的单步检测法有YOLO[8]、YOLO9000[9]、YOLOv3[10]、SSD[11]。其中,YOLOv3网络直接用回归的方式输出预测目标物体的类别和边界框,其特点是检测速度非常快,但是对小目标群检测效果较差。而车牌检测中车牌目标较大,没有小目标群的情况,因此本文采用YOLOv3作为车牌检测的基础网络。

基于深度学习的目标检测方法在车牌检测中的应用,使车牌检测的准确率提高到了前所未有的高度。但是基于深度学习的目标检测网络在雾霾环境下,车牌检测准确率仍然较低。这主要是因为雾霾天气时,空气中悬浮的水滴或灰尘等微粒增多,这些微粒产生的光线折射和漫反射导致采集到的图像中车牌目标特征发生改变[12],从而使无雾霾情况下车牌图片训练的模型不能很好地检测出雾霾环境中的车牌。近年来我国雾霾天气情况严重,抗雾霾成了车牌检测不得不面对的挑战。

针对上述问题,本文在检测车牌之前,对图片做了去雾预处理。在车牌检测网络的前端,加入了GCANet[13]作为图片去雾预处理模块,该模块是一种基于卷积神经网络的去雾模块,能够去除单幅图片中的雾霾,且对无雾霾图片几乎不产生影响。选用了速度较快的 YOLOv3网络作为车牌检测网络,并对YOLOv3网络做了修改:使用层次聚类设置更为合理的锚盒数量和初始簇中心;优化了多尺度特征融合过程,得到了PLATE-YOLO网络。上述两种改进使PLATE-YOLO车牌检测网络检测速度更快。

2 模型介绍

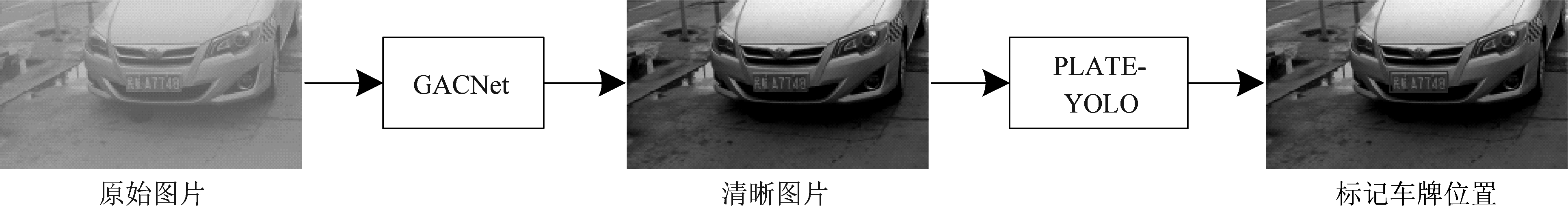

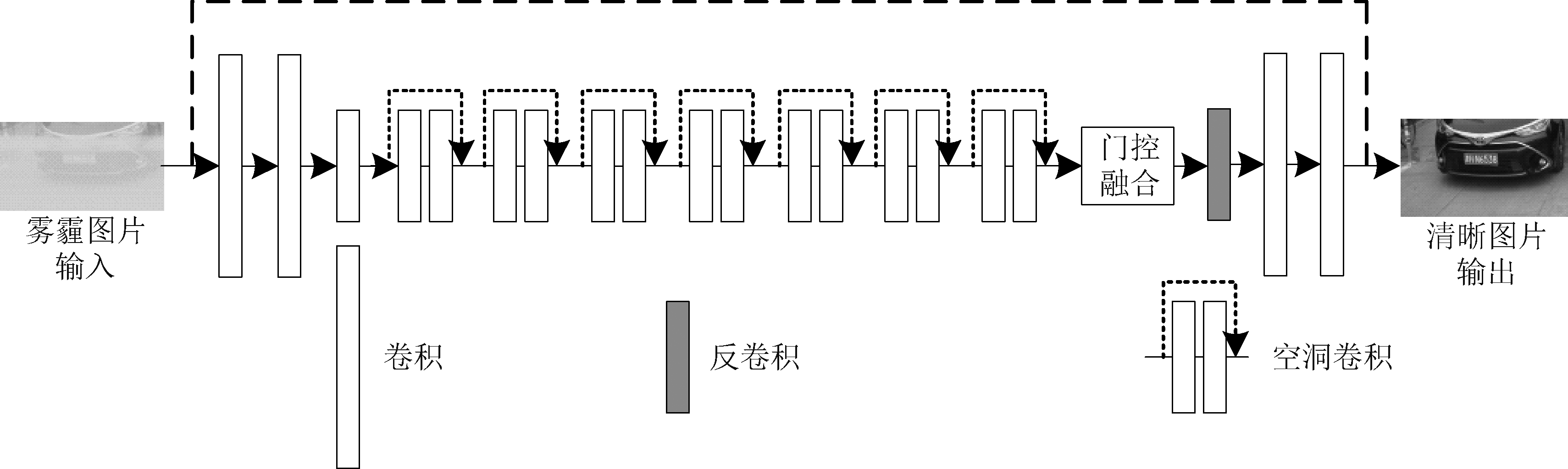

车牌检测整体流程如图1所示,含有车牌的待测图片经GCANet去雾预处理后得到无雾霾的图片,无雾霾的图片经本文优化的PLATE-YOLO网络处理后,输出车牌的位置。

3 数据预处理

3.1 车牌检测数据集制作

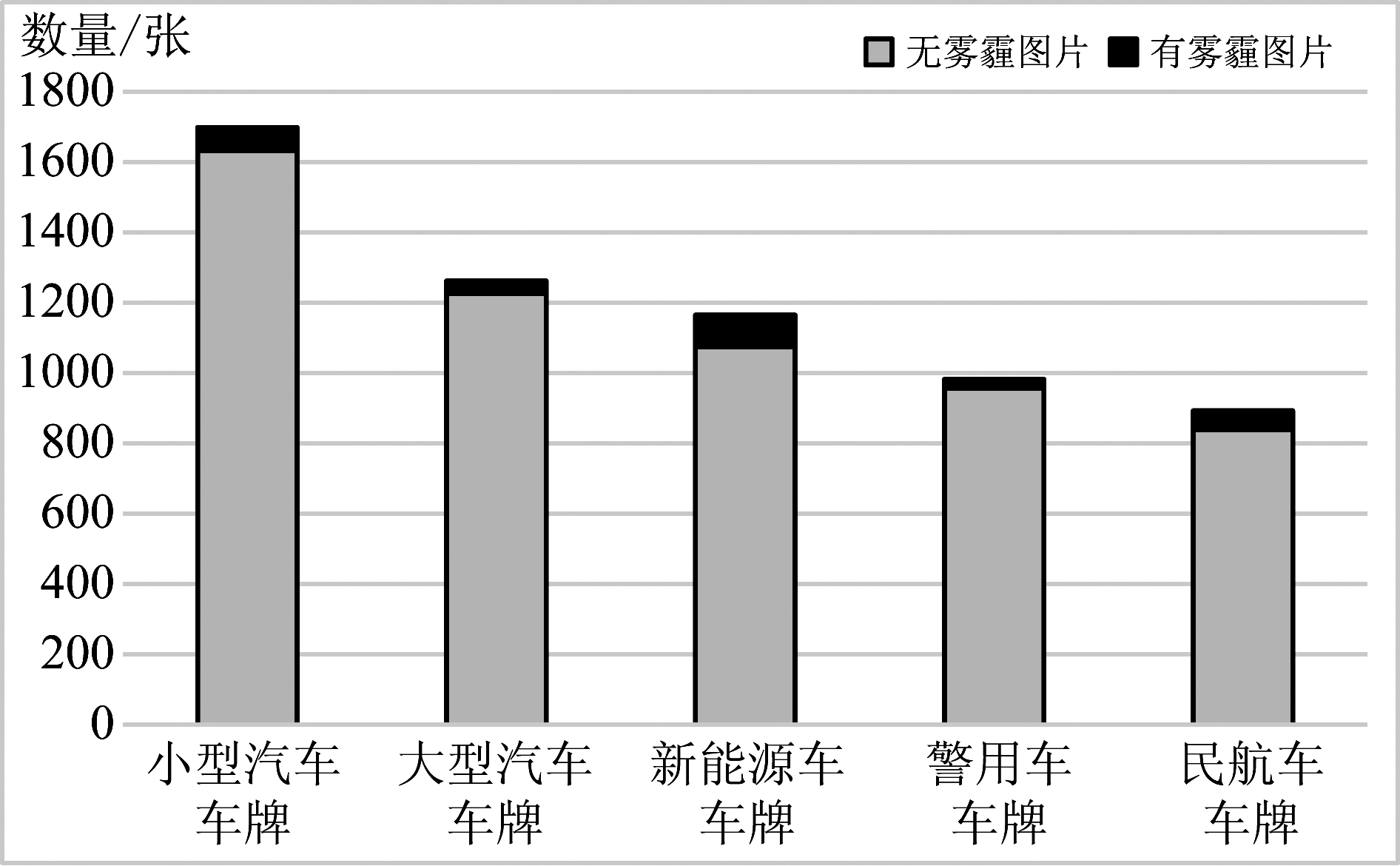

本文整理了6000张含有车牌的图片,经手工标记为PASCAL VOC格式的车牌检测数据集。经统计,数据集中雾霾图片的数量仅有272张。由于雾霾图片样例太少的数据不均衡问题,导致车牌检测网络不能充分地学习雾霾环境下车牌的特征,因此对含有雾霾的图片检测准确率降低。为了解决这一问题,实验中在车牌检测网络前端加入了去雾预处理模块。将所有272张有雾霾的图片挑出组成雾霾图片测试集,另外随机抽取的328张无雾霾图片组成了无雾霾测试集,用来检测去雾处理后的车牌检测效果。下图2为车牌检测数据集的构成。下图3中(a)为有雾霾图片的样例,(b)为无雾霾图片样例。本数据集包含了893张民航机场车辆专用车牌,如下图3中(a)、(b)最后一张车牌样例所示,民航车辆车牌采用浅绿色底色,车牌字符前两位为“民航”,其规格与民用车牌不同。

图1 车牌检测整体流程图

Fig.1 License plate inspection overall flow chart

图2 车牌检测数据集构成

Fig.2 License plate detection data set

3.2 去雾预处理

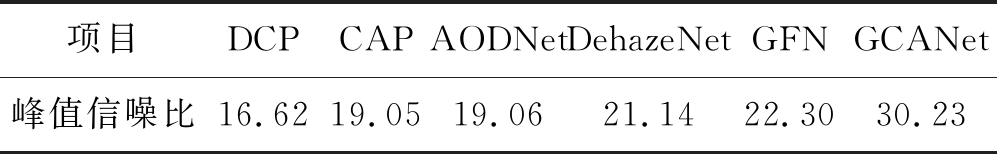

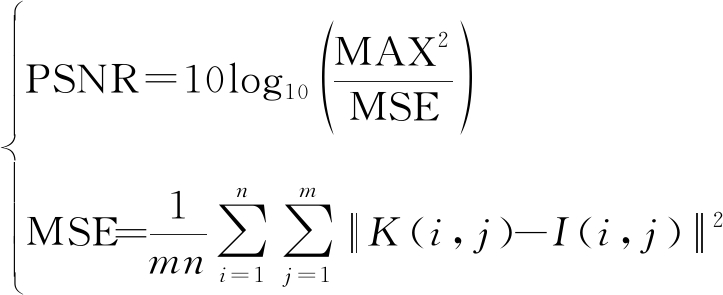

现有的图像去雾算法可以分为图像增强和图像复原两类。图像增强类算法主要是通过综合运用去除图像噪声、提高对比度和调整颜色通道等手段减少雾霾的影响,如暗通道先验算法(DCP:Dark Channel Prior)[12]、颜色衰减先验算法(CAP:Color Attenuation Prior)[14]等。图像复原类算法则是用神经网络提取雾霾特征,用有雾霾图像减去雾霾特征,从而恢复出清晰图像,如一体化去雾法(AODNet:Allin-One Dehazing Network)[15]、DehazeNet[16]、GFN(Gated Fusion Network)[17]、GCANet等。下表1统计了目前具有代表性的图像去雾算法的性能。

表1 去雾算法的性能对比

Tab.1 Performance comparison of defogging algorithm

项目DCPCAPAODNetDehazeNetGFNGCANet峰值信噪比16.6219.0519.0621.1422.3030.23

上表中数据是在数据集RESIDE[18]的验证集上测得的。数据集RESIDE中包含雾霾图片和对应的清晰图片,其中有雾霾图片由对应清晰图片和该清晰图片的景深模板生成[18]。对比指标峰值信噪比(PSNR:Peak Signal to Noise Ratio)定义如下:

(1)

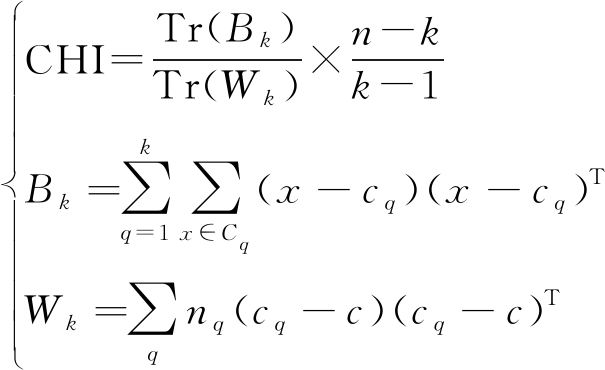

其中MAX表示通颜色颜色最大值,如8 bit精度图像中,MAX值为255。K和I分别表示经过去雾处理得到的图片和数据集中该图片对应的无雾霾图片。m和n表示图片的长和宽。峰值信噪比越大,表示图片K和I越相似,即去雾效果越好[18]。从上表中可见,现有去雾算法中,GCANet的峰值信噪比值最高。因此,本文采用GCANet作为图片去雾处理网络。GCANet由陈冬冬等[13]提出,该方法不依赖于先验信息[12]去除单幅图像中的雾霾。GCANet利用空洞卷积提取图像特征,计算清晰图像特征与雾霾图像特征的残差,用以去除雾霾。GCANet具体结构如图4所示,使用三个卷积层将输入的雾霾图片编码,其中第三个卷积层将特征图1/2下采样。中间7个空洞卷积[13]用来提取图像特征。门控融合模块的功能是计算有雾霾图像和无雾霾图像之间的残差,在去雾处理过程中根据输入图片中雾霾的不同浓度,自适应地调整残差。接着用一个反卷积把特征图上采样到原始分辨率的特征图,最后利用两个卷积层将特征图转换到图像空间。

图3 车牌检测测试集图例

Fig.3 License plate detection data set legend

图4 GCANet 的结构

Fig.4 Structure of GCANet

4 YOLOv3网络及优化

4.1 锚盒先验参数计算

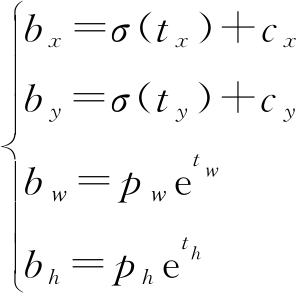

YOLOv3属于单步目标检测算法,通过在图片中不同位置抽样的方法获得目标候选框。这些抽样的形状是长宽不同的矩形,这些矩形的形状是根据超参数设置中不同锚盒参数而变化的。具体的,YOLOv3将输入图像分成s×s的网格,每个网格根据锚盒参数及特征图多尺度缩放预测出n个候选框的位置及其对应的目标种类置信度:(tx,ty,tw,th,to)。其中(tx,ty)表示候选框中心坐标,(tw,th)表示候选框的宽和高,to表示目标种类置信度。由锚盒参数获得目标候选框位置的方法如下式(2)所示:

(2)

上式(2)中,cx、cy表示网格位置。如下图5所示,网格位置由该网格左上角坐标表示,虚线框表示锚盒,灰色线框表示目标候选框相对锚盒的偏移量。目标候选框位于网格(cx,cy)中,ph、pw表示锚盒的高和宽,锚盒中心为网格中心,bh、bw表示目标候选框相对锚盒的长宽偏移量,bx、by表示中心偏移量,σ为逻辑回归函数,![]()

图5 由锚盒参数获得目标候选框位置示意图

Fig.5 The target candidate frame position is obtained by the anchor box parameter

锚盒参数的设置主要依据对数据集中车牌目标边界框的统计。Joseph Redmon等[10]提出了维度聚类方法,利用K-means算法对数据集中标记好的目标边界框进行统计,从而得到合适的锚盒参数。K-means属于快速聚类算法,具有计算效率高的优点,但是需要根据经验预先指定锚盒的个数,不合理的锚盒个数不能很好地匹配数据集,且初始簇中心随机选取,聚类结果受不同的初始簇中心选取差异较大。为了获得合理的锚盒个数和初始簇中心,本文提出了一种改进的层次聚类法。用改进的层次聚类法计算锚盒个数和初始簇中心后,再用K-means算法统计具体的锚盒参数。改进后由于有合理的初始簇中心,避免了原方法用多次统计求平均值的繁琐步骤。

层次聚类可以展现数据的结构层次[19],可以基于真实数据情况设置锚盒的个数。本文改进的核心思想是:记录层次聚类过程中的每次合并后各簇间的相似度,并计算这些相似度的均值和方差。认为聚类过程中的每次合并后簇之间的相似度的均值和方差最小时,各个簇之间差异化最大,簇内差异化最小。计算此时各簇内元素的均值,并将其作为K-means方法的初始簇中心。本文提出的基于层次聚类法获得车牌检测数据集锚盒个数的具体步骤如下表2所示。

表2 本文改进的层次聚类法步骤

Tab.2 Improved hierarchical clustering method steps

输入:车牌目标边界框集合D=(d1,…,di,…,dn)。1.将D中的每个元素作为一个簇,形成D的一个聚类集合C=(c1,…,ci,…,cn);2.计算C中的每个聚类对(ci,cj)之间的相似度sim(ci,cj)=(ci.cj)/(cicj);其中ci.cj=∑nk=1cikckj,ci=∑nk=1cikcik,cj=∑nk=1cjkcjk;3.统计出sim(ci,cj)值最大的两个聚类(ci,cj)并将其合并,构成D的一个新的聚类集合C=(c1,…,ci,…,cn-1),新聚类集合内每个聚类簇的聚类中心为该簇内元素的平均值;4.重复上述步骤,直至所有类合并成一类;5.统计上述n-1个相似度sim(ci,cj)的平均值m和方差d,f=m+d。输出:f最小时对应的簇个数k和k个簇中心。

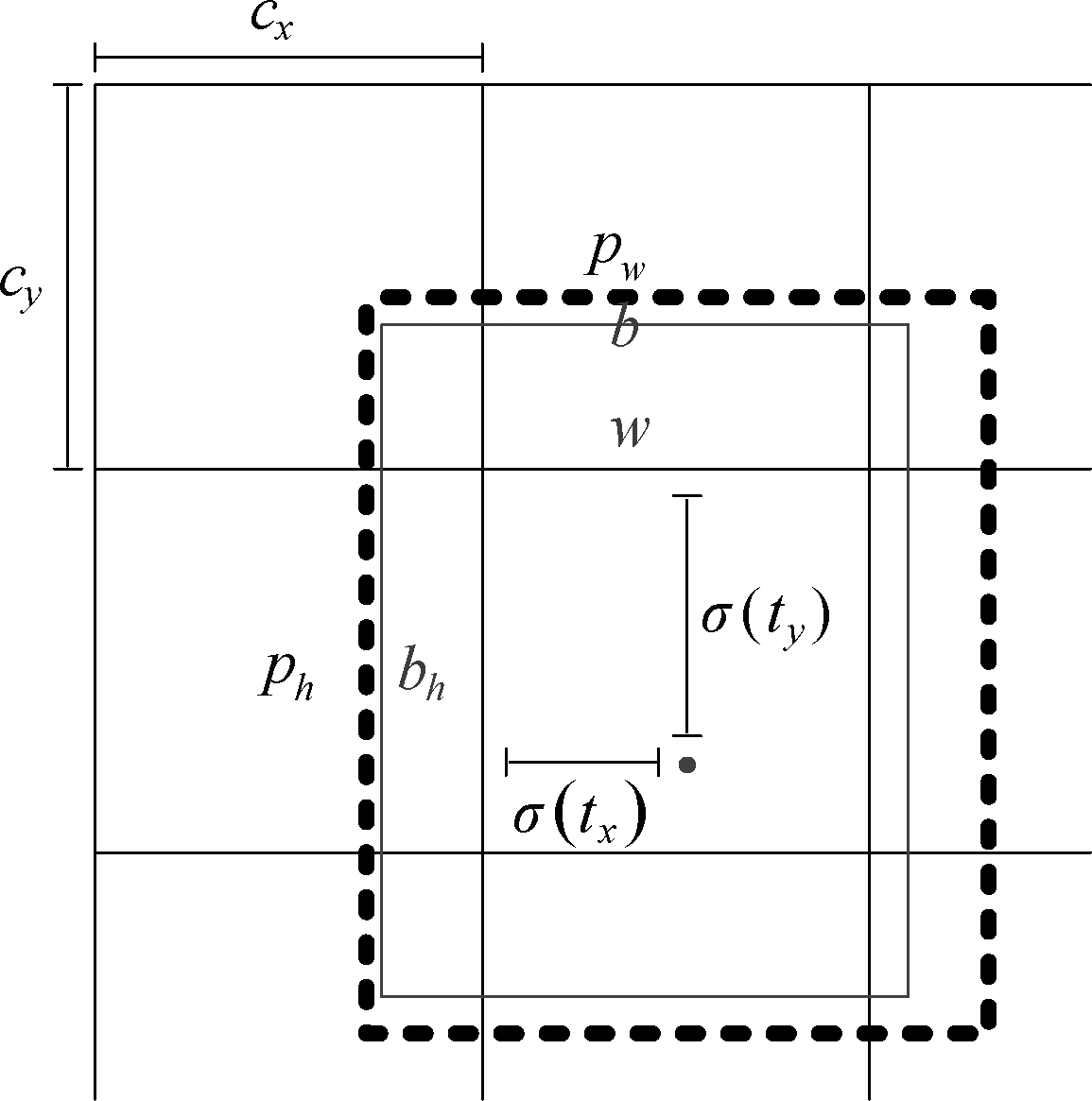

用上述改进的层次聚类法统计本文所用车牌数据集,结果显示当簇个数为3时簇之间差异度最大,簇内差异度最小,此时各簇内元素平均值为(3.7,1.4)、(13.1,7.4)、(19.6,13.5)。再利用K-means方法,设置锚盒个数为3,初始簇中心为(3.7,1.4)、(13.1,7.4)、(19.6,13.5)。经计算,将锚盒设置为(3,1)、(14,5)、(21,17)。为了评价用上述方法计算的锚盒参数的合理性,这里引入了协方差比(CHI,Calinski Harabaz Index)[20]。CHI是衡量聚类效果的指标,定义为簇间数据协方差与簇内数据协方差的比值,当簇内数据协方差越小,簇间数据协方差越大时, CHI 越大。CHI 的数学定义如下式(3):

(3)

其中,k表示锚盒的个数,n表示数据集中标记的车牌目标边界框总数,Bk表示簇之间的协方差,Wk表示簇内数据的协方差,Tr表示矩阵的迹,Cq表示单个簇q的集合,cq表示单个簇q的中心点,nq表示单个簇q包含车牌目标边界框的个数。

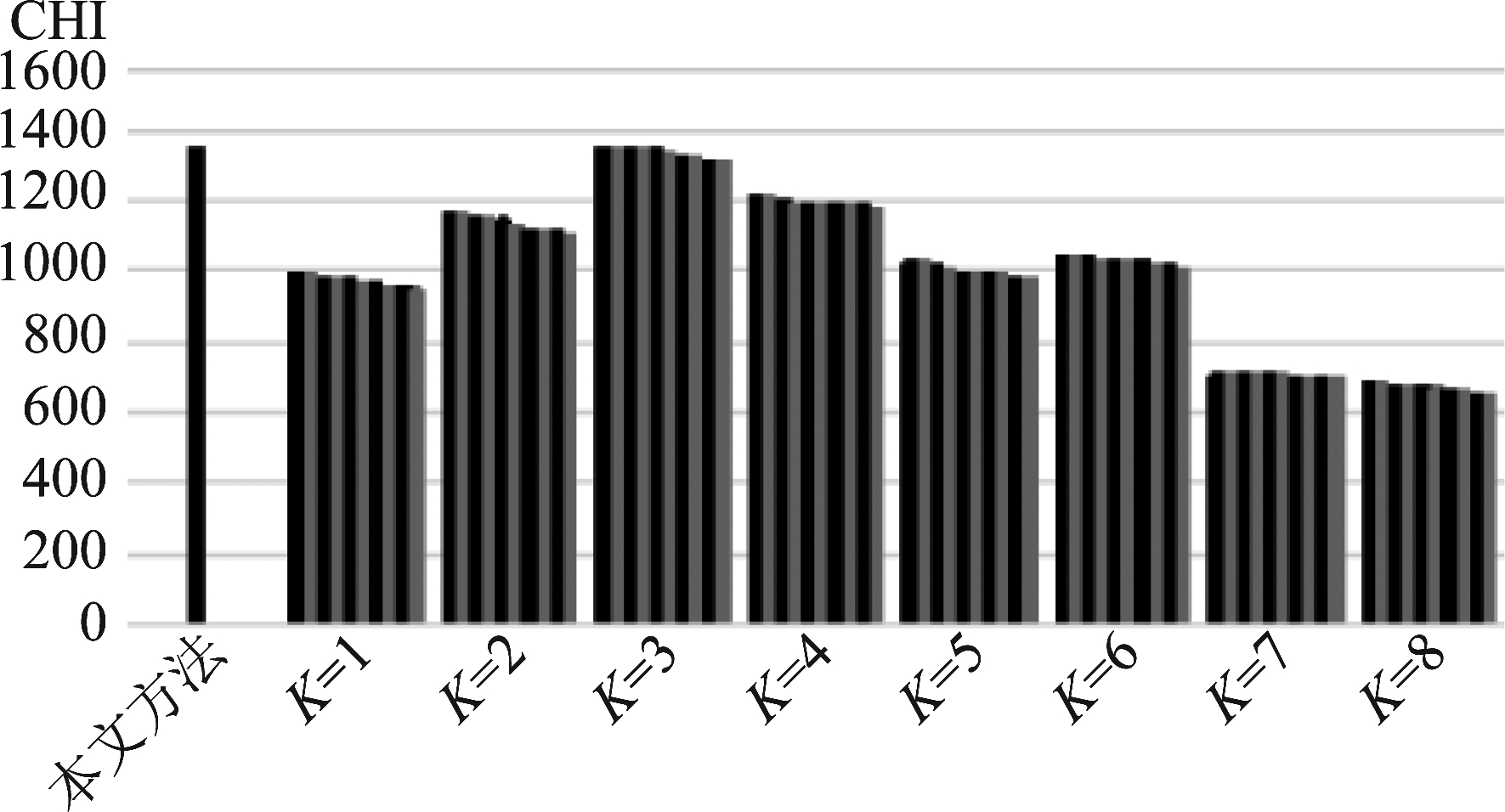

下图6是用本文方法计算的锚盒参数的CHI值和只用K-means方法计算锚盒参数的CHI值的对比。由于K-means方法初始簇中心的设置是随机的,每次计算结果根据选取的初始簇中心不同而有所变化,图6中单纯用K-means方法时,对于每个K分别做了10次试验,对应的CHI值从大到小排序。从图中可见,K=3时,CHI值最大,与本文提出的计算锚盒参数的方法结果一致。本文指定初始簇中心方法计算的锚盒参数的CHI与K=3时随机初始簇中心计算的10组锚盒参数的CHI相比也是最高的,这验证了本文指定初始簇中心方法的有效性。

图6 CHI值对比

Fig.6 Calinski Harabaz index comparison

4.2 多尺度特征融合

YOLOv3模型采用Darknet-53作为骨架网络,Darknet-53包含53个卷积层,每两个卷积层之间以残差结构相连接组成残差层,多个残差层组成残差块,以便增加网络深度。最后三个卷积块的输出分别经上采样、张量拼接和卷积后得到三组不同尺度的特征图后,经逻辑回归,输出目标种类和位置。YOLOv3的具体结构图如图7所示。

图7 YOLOv3的多尺度融合

Fig.7 Multi-scale fusion of YOLOv3

上图7中n为每次输入批大小(Batch Size),YOLOv3经两次上采样,共得到三种不同的特征图:特征图1、特征图2、特征图3,特征图大小分别为:(13,13,75)、(26,26,75)、(52,52,75)。分析本文车牌检测应用场景,采集到图像分辨率为1280×720像素,图像中车牌占像素面积在300×120像素至500×200像素之间,车牌目标较大。用来检测小目标的特征图3对车牌检测影响不大,因此本文去掉了特征图3。即去掉了上图7中灰色区域内的结构,得到了PLATE-YOLO。PLATE-YOLO网络中,Darknet-53的第三个残差层的输出直接传递给下一个残差层,而不再上采样后做多尺度预测。回归的输入改为两个75通道的特征图。PLATE-YOLO 在车牌检测准确率基本不变的前提下,减少了计算量,以提高车牌检测的速度。

4.3 算法复杂度理论分析

神经网络的算法复杂度包含空间复杂度和时间复杂度两部分。空间复杂度指网络运行过程中占用储存空间的大小,主要包括两部分:1)网络所有带参数的层的权重参数总量;2)网络在运行过程中每层计算所输出的特征图。时间复杂度指用网络预测一张图片中车牌位置时所需要的浮点运算次数。参数量和计算量的计算公式如下:

P=Kh×Kw×Cin×Cout+Cout

(4)

F=(Kh×Kw×Cin×Cout+Cout)×W×H

(5)

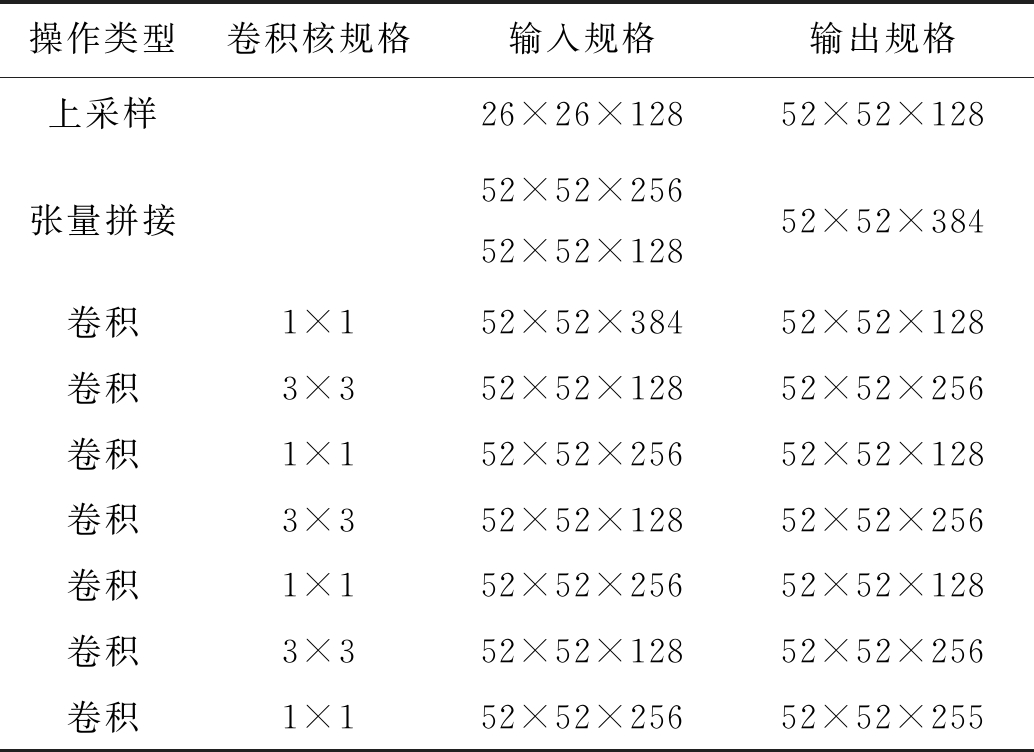

其中,P为参数量,F为计算量,Kh为卷积核高,Kw为卷积核宽,Cin为输入通道数,Cout为输出通道数,W和H分别为输出特征图的宽和高。理论上,PLATE-YOLO较YOLOv3减少了一次上采样、一次张量拼接和一组卷积层,具体减少的操作如下表3所示。

表3 PLATE-YOLO较YOLOv3减少的操作

Tab.3 PLATE-YOLO reduces the number of operations compared to YOLOv3

操作类型卷积核规格输入规格输出规格上采样26×26×12852×52×128张量拼接52×52×25652×52×12852×52×384卷积1×152×52×38452×52×128卷积3×352×52×12852×52×256卷积1×152×52×25652×52×128卷积3×352×52×12852×52×256卷积1×152×52×25652×52×128卷积3×352×52×12852×52×256卷积1×152×52×25652×52×255

5 实验与结果分析

5.1 实验环境与方法

本实验计算机硬件配置为Inter®Xeon 处理器,16 GB内存,GPU 显卡为NVIDIA Tesla P-100。软件运行环境为64位Ubuntu16.04操作系统下搭建的Pytorch0.4深度学习框架及OpenCV3.4。

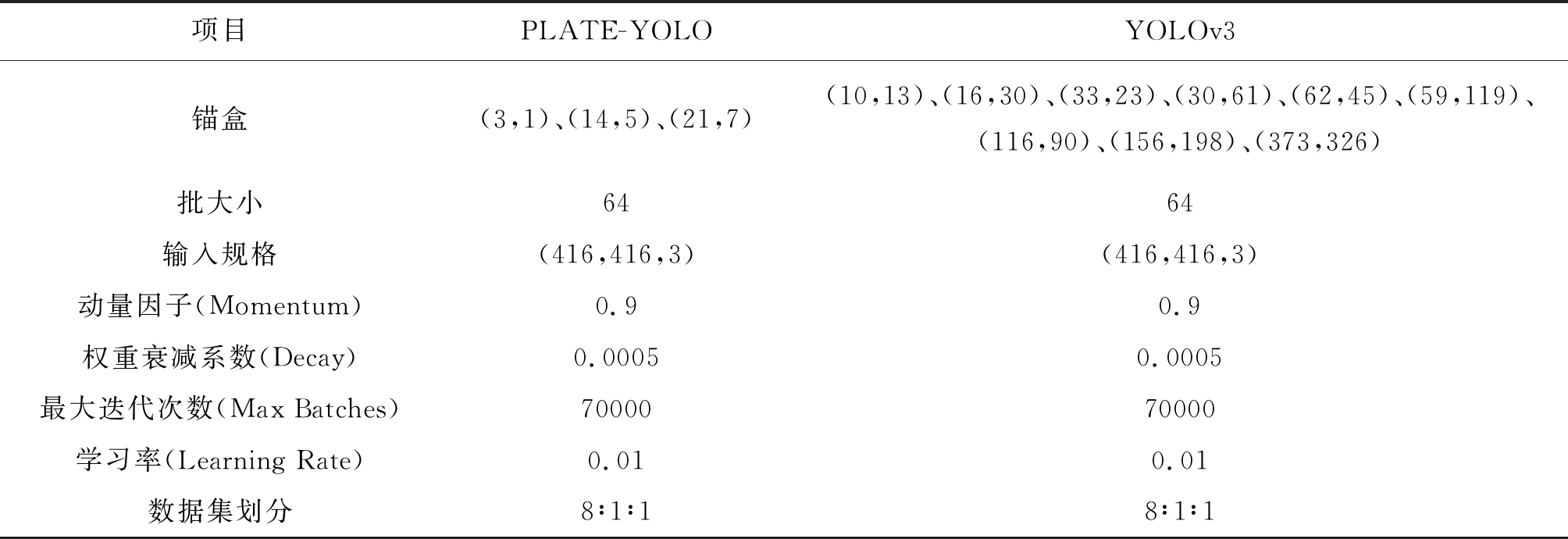

在超参数设置方面,PLATE-YOLO模型与 YOLOv3的不同之处主要在于锚盒设置方面,本文用层次聚类法预先统计了数据集的锚盒种类和初始簇中心,设置了更适合于车牌检测的锚盒参数。具体配置如下表4所示。

5.2 指标介绍

下面实验中涉及速度、准确率(Accuracy)、召回率(Recall)三个指标。速度指标用来衡量模型加载后,一张图片从输入到完成预测所需要的时间。图像处理中常用FPS(Frames Per Second)来衡量速度,FPS代表每秒钟处理图片的张数。

准确率的计算公式为:

(6)

召回率的计算公式为:

(7)

其中,TP表示真实车牌目标被模型预测为车牌目标的数量;TN表示车牌目标被模型预测为非车牌目标的数量;FP表示非车牌目标被模型预测为车牌目标的数量;FN表示非车牌目标被模型预测为非车牌目标的数量。准确率表示模型检测正确的样本数量占总样本数量的比重。召回率表示模型检测为车牌的样本数量中真正为车牌的比重。准确率和召回率越高,说明模型的性能越好。

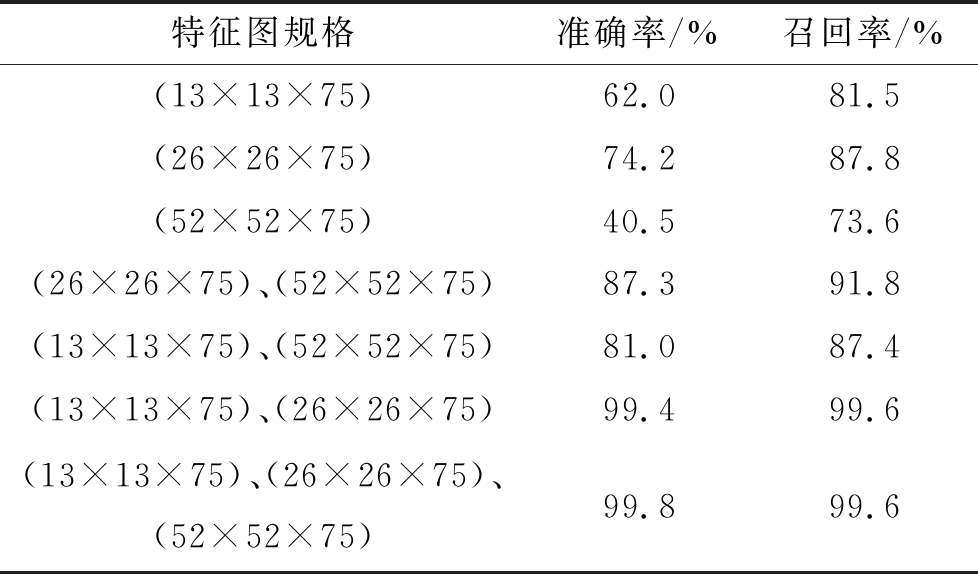

5.3 多尺度特征消融实验

YOLOv3在三个不同尺度的特征图上做检测,本文为了提高车牌检测的速度,删减了一次多尺度特征预测。为了验证YOLOv3中三种缩放尺度的特征图对于车牌检测的有效性,在这里分别删去不同大小的特征图后,重新训练并检测其检测的准确率。实验结果如下表5所示,表5中左起第一列表示删去不同的特征图后剩余的特征图规格。由于大尺寸特征图是较小尺寸特征图上采样后与 Darknet-53网络对应输出特征图的张量拼接,为保证实验的单一变量,实验中较小特征图的生成并未真正删除,只是在回归部分没有接收相应的特征图。从表5中可见规格为(52×52×75)的特征图对车牌检测准确率贡献最小,规格为(26×26×75)的特征图对车牌检测准确率贡献最大,去除规格为(52×52×75)的特征图对车牌检测准确率影响最小。

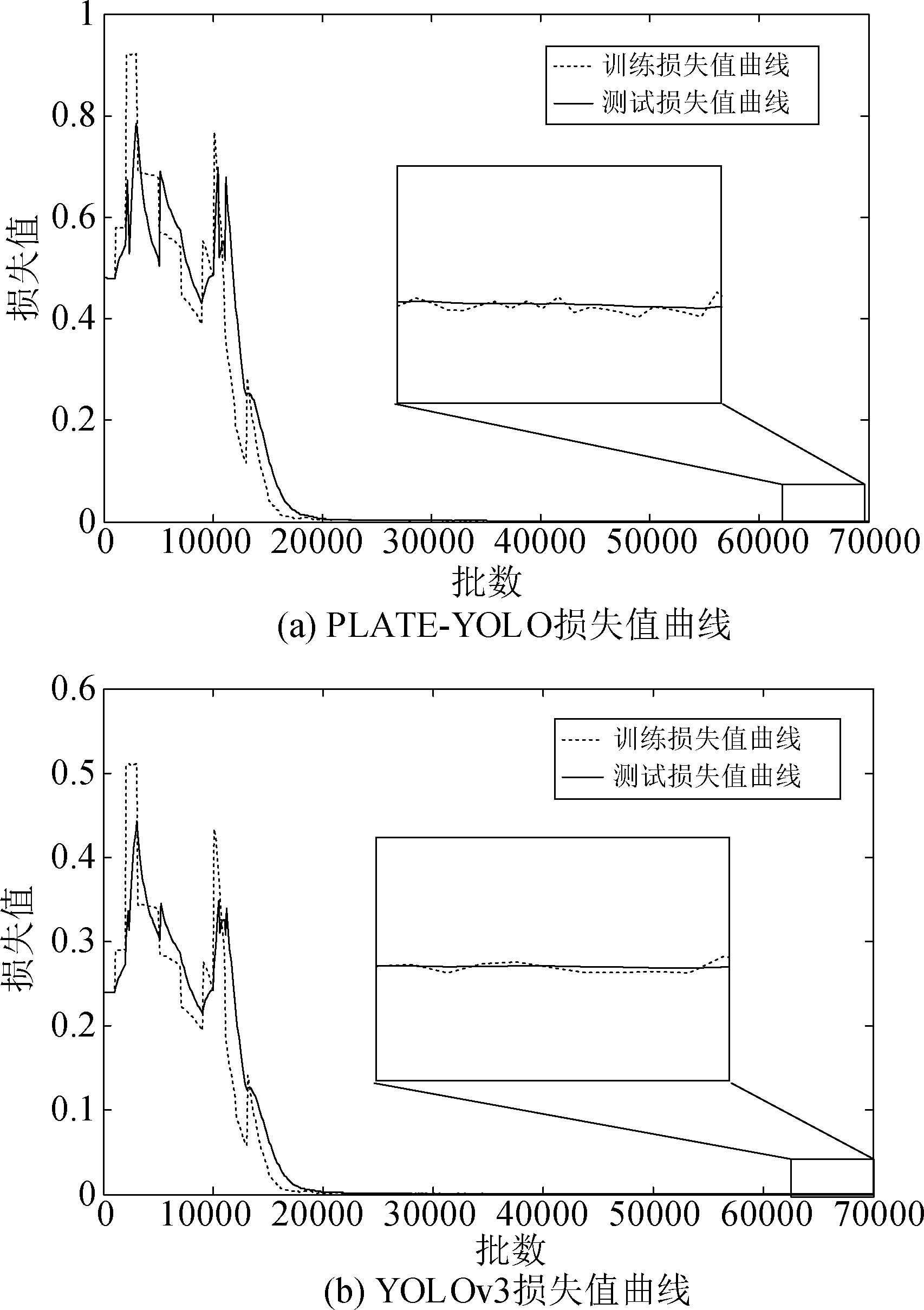

模型的训练可以通过损失值的趋势来判断是否收敛。训练过程中,训练集和验证集会给出两个不同的损失值曲线。训练集损失值越小,说明模型对训练集拟合的越好,网络收敛。测试集损失值越小,说明模型的泛化性能越好,在训练集图片之外的其他数据集上也能很好地检测出车牌位置。而如果测试集的损失值明显高于训练集的损失值,则说明模型过拟合了。下图8中的(a)为 PLATE-YOLO的训练集损失值曲线、测试集损失值曲线,(b)为YOLOv3的训练集损失值曲线、测试集损失值曲线。

表4 网络超参数设置

Tab.4 Network hyperparameter setting

项目PLATE-YOLOYOLOv3锚盒(3,1)、(14,5)、(21,7)(10,13)、(16,30)、(33,23)、(30,61)、(62,45)、(59,119)、(116,90)、(156,198)、(373,326)批大小6464输入规格(416,416,3)(416,416,3)动量因子(Momentum)0.90.9权重衰减系数(Decay)0.00050.0005最大迭代次数(Max Batches)7000070000学习率(Learning Rate)0.010.01数据集划分8∶1∶18∶1∶1

表5 消融实验

Tab.5 Ablation study

特征图规格准确率/%召回率/%(13×13×75)62.081.5(26×26×75)74.287.8(52×52×75)40.573.6(26×26×75)、(52×52×75)87.391.8(13×13×75)、(52×52×75)81.087.4(13×13×75)、(26×26×75)99.499.6(13×13×75)、(26×26×75)、(52×52×75)99.899.6

从图8可见,上述4个损失值最终都稳定在0.006附近并保持稳定,说明两个模型的训练程度都比较合适。

图8 损失值曲线

Fig.8 The loss value curve

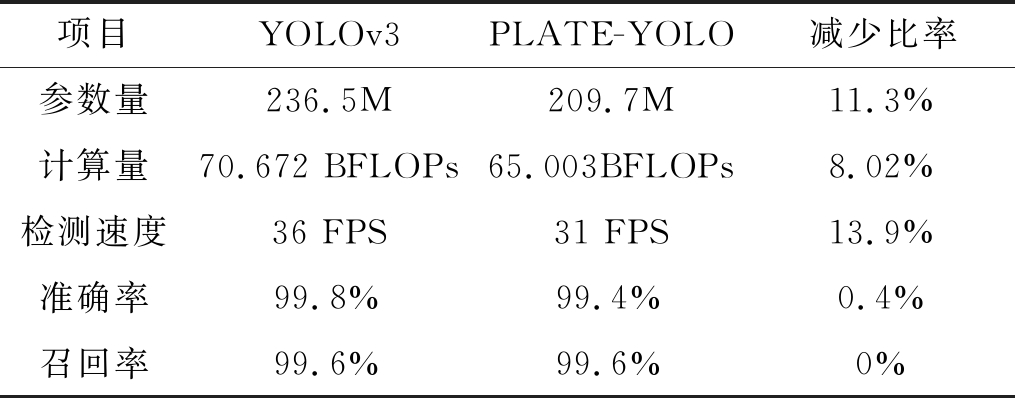

下表6展示了YOLOv3网络改进前后的性能指标。其中参数量和计算量由PyTorch自带函数统计,计算速度为输入64张分辨率为1280×720像素图片的平均检测速度。从实验结果可见,优化后模型召回率不变,仅准确率下降了0.4%,而计算速度由31 FPS提升到了36 FPS,说明本文的优化效果明显。

表6 PLATE-YOLO和YOLOv3性能对比

Tab.6 PLATE-YOLO and YOLOv3 performance comparison

项目YOLOv3PLATE-YOLO减少比率参数量236.5M209.7M11.3%计算量70.672 BFLOPs65.003BFLOPs8.02%检测速度36 FPS31 FPS13.9%准确率99.8%99.4%0.4%召回率99.6%99.6%0%

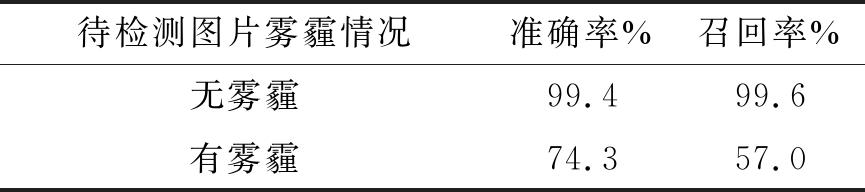

5.4 加去雾预处理与不加去雾预处理的实验对比

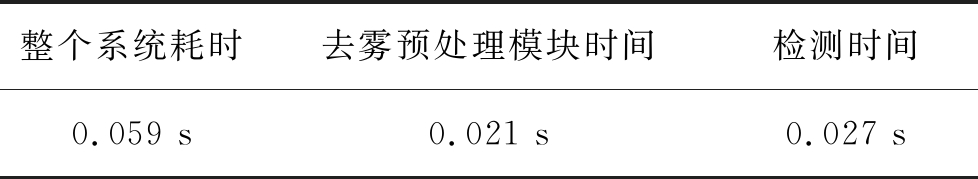

这里用了上述PLATE-YOLO网络训练的权重来做测试。为了统计去雾预处理模块对车牌检测系统检测速度的影响,分别统计了系统中去雾预处理模块所需时间、PLATE-YOLO网络检测车牌所需时间(以下简称检测时间)以及整个车牌检测系统所需时间。其中去雾预处理模块所需时间定义为:从系统读取图片并解析为三维数组后开始,到去雾预处理完成,输出三维矩阵结束的时间差(不含系统读取和解析图片时间)。检测时间定义为:从PLATE-YOLO网络接收到去雾预处理模块输出的三维矩阵开始,到网络输出车牌位置及类别信息结束的时间差。整个车牌检测系统所需时间定义为整个系统从读取图片到输出检测结果所需时间。下表7记录了64张含车牌图片的平均时间,图片规格为1280×720像素的JPG格式图片。

表7 去雾预处理对车牌检测系统速度的影响

Tab.7 Effect of defog preprocessing on speed of license plate detection system

整个系统耗时去雾预处理模块时间检测时间0.059 s0.021 s0.027 s

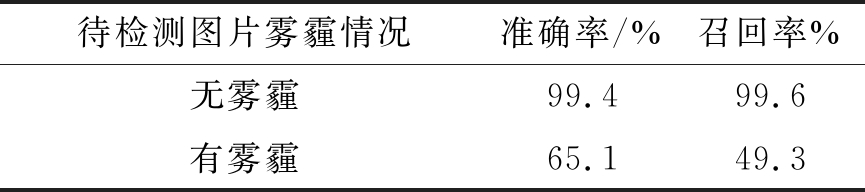

为了测试去雾预处理模块的效果,做了两组实验加以对比。第一组实验不加去雾预处理的图片直接送入PLATE-YOLO网络检测。第二组实验把图片做去雾处理后再送入PLATE-YOLO网络检测。下表8记录了未加去雾处理PLATE-YOLO模型的车牌检测结果,下表9记录了对图片做去雾处理后再检测车牌位置的实验结果。下图9展示了进行去雾预处理的PLATE-YOLO模型检测车牌位置的检测结果,图9中(a)为无雾霾图片原图,(b)为无雾霾图片检测结果,(c)有雾霾图片原图,(d)有雾霾图片检测结果。

表8 无去雾预处理的PLATE-YOLO车牌检测实验

Tab.8 PLATE-YOLO license plate detection experiment without defogging pretreatment

待检测图片雾霾情况准确率/%召回率%无雾霾99.499.6有雾霾65.149.3

表9 加入去雾预处理的PLATE-YOLO车牌检测

Tab.9 Adding defogging pretreatment to PLATE-YOLO license plate detection

待检测图片雾霾情况准确率%召回率%无雾霾99.499.6有雾霾74.357.0

由实验结果可见,在无雾霾环境下,未加入去雾霾处理和加入去雾霾处理的车牌检测试验结果基本相同,说明去雾处理对无雾霾环境下的车牌检测的准确率没有负面影响。在有雾霾情况下,加入去雾处理的车牌检测准确率提升9.2%,召回率提升7.7%,说明对图片进行去雾预处理的车牌检测方法有效。

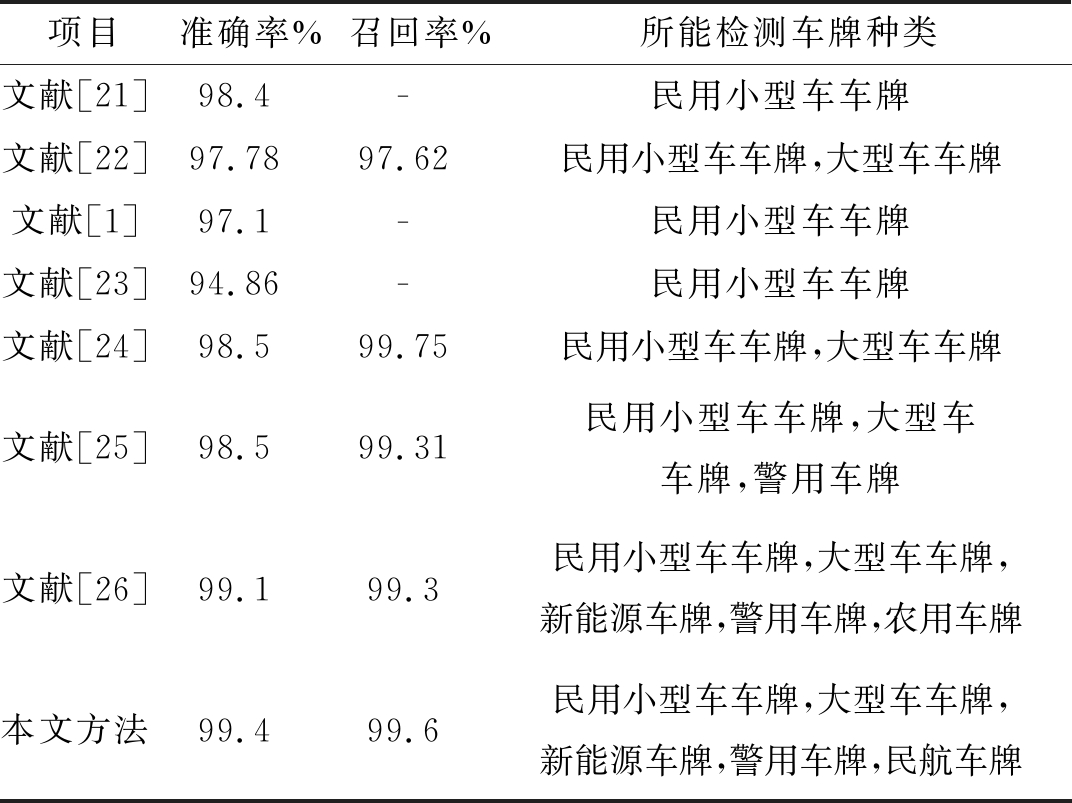

5.5 本文提出车牌检测算法与其他车牌检测算法的对比

为了对比本文车牌检测方法与其他车牌检测算法的性能,本文调研了近两年公开出版的文献资料中的车牌检测算法。下表10列举了部分车牌检测算法性能。表中列举了各车牌检测算法的准确率、召回率和所能检测车牌的种类,部分文献没有将召回率作为指标。由于不同文献的实验环境不同,所以表中未列出各方法的检测耗时。从调研情况可见,近两年来车牌检测算法准确率整体较高,但现有文献中尚无可以检测机场民航车辆车牌的车牌检测算法。本文根据实际需求提出的车牌检测算法,扩展了车牌检测在机场领域的应用。

表10 车牌检测算法横向对比

Tab.10 Horizontal comparison of license plate detection algorithms

项目准确率%召回率%所能检测车牌种类文献[21]98.4-民用小型车车牌文献[22]97.7897.62民用小型车车牌,大型车车牌文献[1]97.1-民用小型车车牌文献[23]94.86-民用小型车车牌文献[24]98.599.75民用小型车车牌,大型车车牌文献[25]98.599.31民用小型车车牌,大型车车牌,警用车牌文献[26]99.199.3民用小型车车牌,大型车车牌,新能源车牌,警用车牌,农用车牌本文方法99.499.6民用小型车车牌,大型车车牌,新能源车牌,警用车牌,民航车牌

图9 车牌检测结果

Fig.9 License plate test result

6 结论

本文提出了一种实用化的针对雾霾环境下的车牌检测方法,并且通过实验验证了该方法的有效性,得出如下结论:首先,用改进的层次聚类算法得出合理的锚盒个数和聚类初始簇中心的方法计算锚盒参数,聚类结果更优。其次,针对车牌目标在图像中面积占比较大的特点,修改了多尺度特征融合部分,使模型参数量和计算量都有所减少,最终检测速度提升了5 FPS,并且车牌检测准确率和召回率没有明显下降。最后,实验说明对于含有雾霾的图片,加入去雾处理模块的车牌检测网络比不加去雾预处理模块的车牌检测网络准确率提升9.2%,召回率提升7.7%。在车牌检测的网络前端,加入对图片的去雾模块,可以提高雾霾环境下车牌检测的准确率。

[1] 郑贵林, 吴黄子桑. 基于MSER与边缘投影的车牌定位算法[J]. 计算机工程与设计, 2019, 40(1): 241-244.

Zheng Guilin, Wuhuang Zisang. License Plate Location Algorithm Based on MSER and Edge Projection[J]. Computer Engineering and Design, 2019, 40(1): 241-244.(in Chinese)

[2] 牛博雅, 黄琳琳, 胡健. 自然场景下的车牌检测与识别算法[J]. 信号处理, 2016, 32(7): 787-794.

Niu Boya, Huang Linlin, Hu Jian. Detection and Recognition Algorithm for License Plate in Natural Scene[J]. Journal of Signal Processing, 2016, 32(7): 787-794.(in Chinese)

[3] 童璟芸, 李雅雯, 张弛斌, 等. 基于车牌颜色特征的车牌识别系统[J]. 中国科技信息, 2018(22): 85- 87.

Tong Jingyun, Li Yawen, Zhang Chibin, et al. License Plate Recognition System Based on License Plate Color Characteristics[J]. China Science and Technology Information, 2018(22): 85- 87.(in Chinese)

[4] Ross Girshick, Jeff Donahue, Trevor Darrelland, et al. Rich Feature Hierarchies for Object Detection and Semantic Segmentation[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2014: 580-587.

[5] He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.

[6] He Kaiming, Georgia Gkioxari, Piotr Doll r, et al. Mask R-CNN[C]∥2017 IEEE International Conference on Computer Vision (ICCV). IEEE Computer Society, 2017: 1440-1448.

r, et al. Mask R-CNN[C]∥2017 IEEE International Conference on Computer Vision (ICCV). IEEE Computer Society, 2017: 1440-1448.

[7] Ren Shaoqing, He Kaiming, Ross Girshick, et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[8] Joseph Redmon, Santosh Divvala, Ross Girshick, et al. You Only Look Once: Unified, Real-time Object Detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Los Alamitos: IEEE Computer Society Press, 2016: 779-788.

[9] Joseph Redmon, Ali Farhadi. YOLO9000: Better, Faster, Stronger[J]. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 6517- 6525.

[10] Joseph Redmon, Ali Farhadi. YOLOv3: An Incremental Improvement[EB/OL]. arXiv: 1804.02767, 2018.4.

[11] Liu Wei, Dragomir Anguelov, Dumitru Erhan, et al. SSD: Single Shot Multibox Detector[C]∥Proceedings of European Conference on Computer Vision. Heidelberg: Springer, 2016: 21-37.

[12] He Kaiming, Sun Jian, Tang Xiaoou. Single Image Haze Removal Using Dark Channel Prior[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(12): 2341-2353.

[13] Chen Dongdong, He Mingming, Fan Qingnan, et al. Gated Context Aggregation Network for Image Dehazing and Deraining[EB/OL]. arXiv: 1811.08747, 2018.12.

[14] Zhu Qingsong, Mai Jiaming, Shao Ling, et al. A fast single image haze removal algorithm using color attenuation prior[J]. IEEE Trans. Image Processing, 2015, 24(11): 3522-3533.

[15] Li Boyi, Peng Xiulian, Wang Zhangyang, et al. Aod-net: Allin-one dehazing network[C]∥2017 IEEE International Conference on Computer Vision (ICCV). IEEE, 2017 (1): 7-19.

[16] Cai Bolun, Xu Xiangmin, Jia Kui, et al. Dehazenet: An end-to-end system for single image haze removal[J]. IEEE Transactions on Image Processing, 2016, 25(11): 5187-5198.

[17] Ren Wenqi, Ma Lin, Zhang Jiawei, et al. Gated fusion network for single image dehazing[EB/OL]. arXiv: 1804. 00213[cs. CV]. 2018, 04.

[18] Li Boyi, Ren Wenqi, Fu Dengpan, et al. Benchmarking Single Image Dehazing and Beyond[EB/OL]. arXiv: 1712.04143[cs.CV].2017, 12.

[19] 陈黎飞, 姜青山, 王声瑞. 基于层次划分的最佳聚类数确定方法[J]. 软件学报, 2008(1): 62-72.

Chen Lifei, Jiang Qingshan, Wang Shengrui. Method for Determining Optimal Cluster Number Based on Hierarchical Partition[J]. Journal of Software, 2008(1): 62-72.(in Chinese)

[20] Kwon Bum Chul, Eysenbach Ben, Verma Janu, et al. Clustervision: Visual Supervision of Unsupervised Clustering[J]. IEEE Transactions on Visualization and Computer Graphics, 2018, 24(1).

[21] 赵伟, 张南楠. 深度学习在复杂环境下车牌定位算法中的应用[J]. 现代电子技术, 2019, 42(17): 38- 42, 48.

Zhao Wei, Zhang Nannan. Application of deep learning in license plate locating algorithm in complicated environment[J]. Modern Electronics Technique, 2019, 42(17): 38- 42, 48.(in Chinese)

[22] 李祥鹏, 闵卫东, 韩清, 等. 基于深度学习的车牌定位和识别方法[J]. 计算机辅助设计与图形学学报, 2019, 31(6): 979-987.

Li Xiangpeng, Min Weidong, Han Qing, et al. License Plate Location and Recognition Based on Deep Learning[J]. Journal of Computer-Aided Design & Computer Graphics, 2019, 31(6): 979-987.(in Chinese)

[23] 王艳, 谢广苏, 沈晓宇. 一种基于MSER和SWT的新型车牌检测识别方法研究[J]. 计量学报, 2019, 40(1): 82-90.

Wang Yan, Xie Guangsu, Shen Xiaoyu. A New Vehicle Licence Plate Recognition Method Based on MSER and SWT[J]. Acta Metrologica Sinica, 2019, 40(1): 82-90.(in Chinese)

[24] 邝先验, 杨柳, 李洪伟. 基于AdaBoost与CNN结合的车牌检测识别系统研究[J]. 科学技术创新, 2019(10): 81- 83.

Kuang Xianyan, Yang Liu, Li Hongwei. Research on Li-cense Plate Detection and Recognition System Based on AdaBoost and CNN[J]. Scientific and Technological Innovation, 2019(10): 81- 83.(in Chinese)

[25] 向函. 复杂交通场景下车牌检测算法的研究[D]. 贵阳市: 贵州大学, 2019.

Xiang Han. Research on License Plate Detection Algorithms in Complex Traffic Scene[D]. Guiyang: Guizhou University, 2019.(in Chinese)

[26] Xu Zhenbo, Yang Wei, Meng Ajin, et al. Towards End-to-End License Plate Detection and Recognition: A Large Dataset and Baseline[J]. 15th European Conference, 2018(13): 8-14.