1 引言

目标跟踪在计算机视觉中是一个热门的研究课题,在视频监控、视觉导航、人机交互等领域都有着广泛的应用。由于存在背景干扰、尺度变化、光照变化、物体形变、物体遮挡等多种复杂的情况,目标跟踪又是一个极具挑战性的问题。特别是在物体遮挡的情况下,目标容易被跟丢。

现有的目标跟踪方法主要分成两大类,分别是生成模型跟踪和判别模型跟踪。生成模型跟踪主要通过提取目标的外观特征建立模型,并在下一帧中进行搜索,匹配与其最相似的区域所在的位置完成目标的定位。判别模型主要是利用目标和背景的差异,分别提取其信息用作训练分类器,使得目标和背景区分开从而定位目标的位置。生成类跟踪方法有Bradski[1]提出Camshift,将视频中的所有帧作运算,并将前一帧的位置作为后一帧搜索的初始位置,然后进行迭代运算。Vojir[2]基于mean shift加入正则项解决尺度估计问题并进行前后尺度一致性检查。判别类跟踪方法由于利用了背景信息,并将其用到了训练分类器中,因此判别类跟踪方法跟踪效果较生成类方法好,适用性更强。判别类跟踪算法主要有基于相关滤波的目标跟踪算法。最早由Hester[3]提出利用相关滤波在频域中学习模板,后来Bolme[4]开创性地将相关滤波用于目标跟踪,提出了最小平方误差输出和相关滤波器算法,速度达到600多帧每秒,并且具有较好的鲁棒性。这一高效稳健的基于相关滤波的目标跟踪方法,引起了许多研究人员的关注,因此越来越多基于相关滤波的改进算法被提出。Henriques[5]在文献[4]的基础上加入了正则项,并引入了循环矩阵实现了样本的密集采样用于训练相关滤波器,同时利用傅里叶变换和核函数的特点,使得算法的精度和速度都有所提高。Henriques[6]在文献[5]的基础上加入了多通道特征,将HOG特征作为学习特征,对刚体运动有较好的鲁棒性。Danelljan[7]则在文献[5]的基础上加入了颜色特征作为学习特征,对于跟踪形变的物体也有较好的性能。Possegger[8]利用贝叶斯学习的方法,更加精准地学习颜色特征并结合相关滤波器达到了较好的跟踪效果。Bertinetto[9]在相关滤波的基础上将特征和颜色特征相结合,跟踪效果鲁棒性更强。张能波[10]提出了一种利用 Lasso 约束并融入光流信息的目标跟踪算法以解决运动目标模糊的问题。

随着深度学习的发展,Bertinetto[11]提出了SiamFC目标跟踪算法,利用全卷积孪生神经网络的特性,实现了目标跟踪的高精度和高速度跟踪,引起了研究人员的关注。在此基础上,Li[12]提出了SiamVGG算法,利用修改后的VGG16网络替代了原网络结构并增加了训练样本的数据,达到了较高的跟踪精度。Li[13]在SiamFC的基础上,提出了SiamRPN网络的目标跟踪算法,将目标检测的候选区域生成网络与其相结合,对目标进行分类和回归,在跟踪精度提升的同时速度也得到了提升。Wang[14]在SiamRPN的基础上,添加了一个掩模分支,实现了对目标的精确分割,达到了像素点级别的分割,使得目标跟踪的精度又有了较大的提升。

针对目标跟踪过程中的存在的遮挡问题,研究人员提出了各种算法[15-24]。Kalal[15]将目标跟踪算法和检测算法相结合,以解决目标被遮挡或者丢失时重新对目标进行检测,但跟踪的精度不高。李俊[16]在文献[15]的基础上,提出了一种基于空时线索的 TLD算法,更加有效处理遮挡的问题。Zhang[17]提出了一种基于时空上下文信息的目标跟踪算法,利用了目标位置所在的背景信息,当目标被遮挡时使用背景信息进行跟踪,避免目标被跟丢,但其对于完全遮挡的情况下跟踪鲁棒性不强。Ma[18]一方面加入了上下文信息,另一方面采用在线随机蕨分类器以便在跟踪失败情况下重新检测目标。Ma[19]在文献[18]的基础上,训练了一个在线SVM分类器。Wang[20]提出了利用SVM结构化进行跟踪,结合多模态检测避免在目标遮挡时模板过拟合。Ma和Wang方法在对于附近目标的跟丢鲁棒性较好,但对于目标超出视野范围后重新出现的情况无法再重新定位目标。Nebehay[21]融合光流和特征点匹配进行目标跟踪,能适应遮挡、目标跟丢的情况,但当目标发生形变时容易造成跟踪算法漂移。Hong[22]提出了结合相关滤波和特征点匹配的方法进行跟踪,当目标发生遮挡时利用特征点进行匹配跟踪。Guan[23]实现了一种事件触发框架,避免了模型漂移和目标跟丢的情况。Zhu[24]针对文献[13]的SiamRPN深度网络进行了改进并且能对跟丢目标重新检测。

为了更精准、更加稳健地跟踪目标,本文提出了引入抗遮挡机制的SiamVGG网络的目标跟踪算法。基于SiamVGG网络的目标跟踪算法对一些遮挡情况下的跟踪鲁棒性较低,会出现目标跟丢的情况。针对这一问题,通过分析网络输出的置信图的峰值大小Fmax和连通域大小R,针对遮挡问题设计了四种不同的策略,分别是正常跟踪、部分遮挡、完全遮挡和遮挡丢失,有效避免遮挡情况下目标跟丢的情况,增强了算法的鲁棒性。

本论文主要分为4个章节,第1节为引言,第2节为本文算法的介绍,第3节为在本文算法在OTB基准数据集上的实验结果及分析,第4节为全文结论。

2 方法介绍

2.1 基本框架

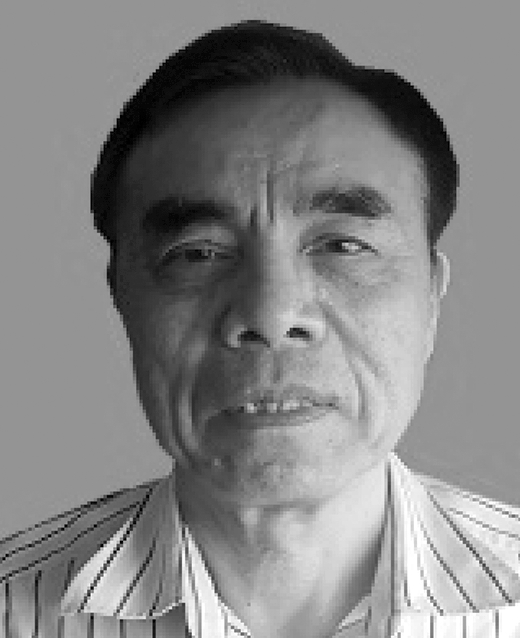

如图1所示,SiamVGG的网络结构主要由孪生网络组成,网络的输入由初始帧的模板z和视频序列x组成,中间部分在SiamVGG中利用修改后的VGG-16网络组成,目标模板z和视频图像x经过神经卷积网络后互相关,进行双三次插值后得到一个置信图。由置信图可定位目标所在位置,黄色边框表示定位出的目标位置和大小。其中置信图f(z,x)可由式(1)得出

f(z,x)=φ(z)*φ(x)+b

(1)

φ表示神经网络卷积函数,在SiamVGG网络结构中使用修改后的VGG-16网络作为此处的神经网络卷积函数。φ(z)和φ(x)分别表示对输入的跟踪视频图像x进行卷积运算和对目标模板z进行卷积运算,b表示偏差值,*表示互相关操作。

图1所示的是在置信图(score)中设置了一个阈值Ts

Ts=(max(score)-min (score))×α

(2)

max表示取最大值函数,min表示取最小值函数,将阈值α设置为0.9。阈值将置信图分割,将上半部分投影到二维平面上,投影置信图的黄色部分表示三维置信图上半部分的连通域大小R,蓝色部分表示其他区域。本文在SiamVGG网络的基础上,增加了一个遮挡判断机制,通过分析置信图的峰值大小Fmax和连通域大小R,将跟踪分成正常跟踪、部分遮挡、完全遮挡和遮挡丢失四个部分。通过采取不同的跟踪策略,使得算法对物体遮挡具有更强的鲁棒性。

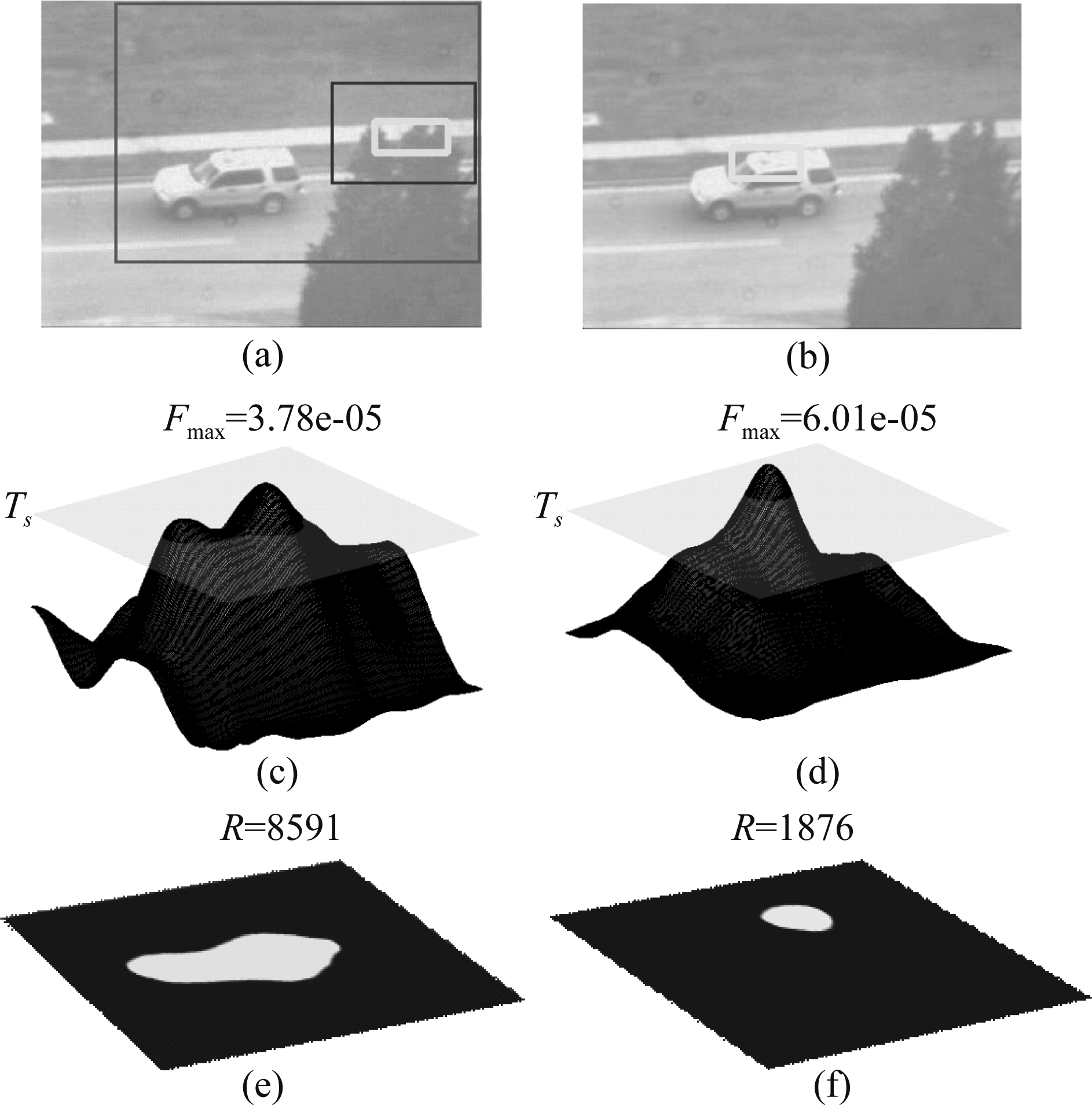

2.2 部分遮挡

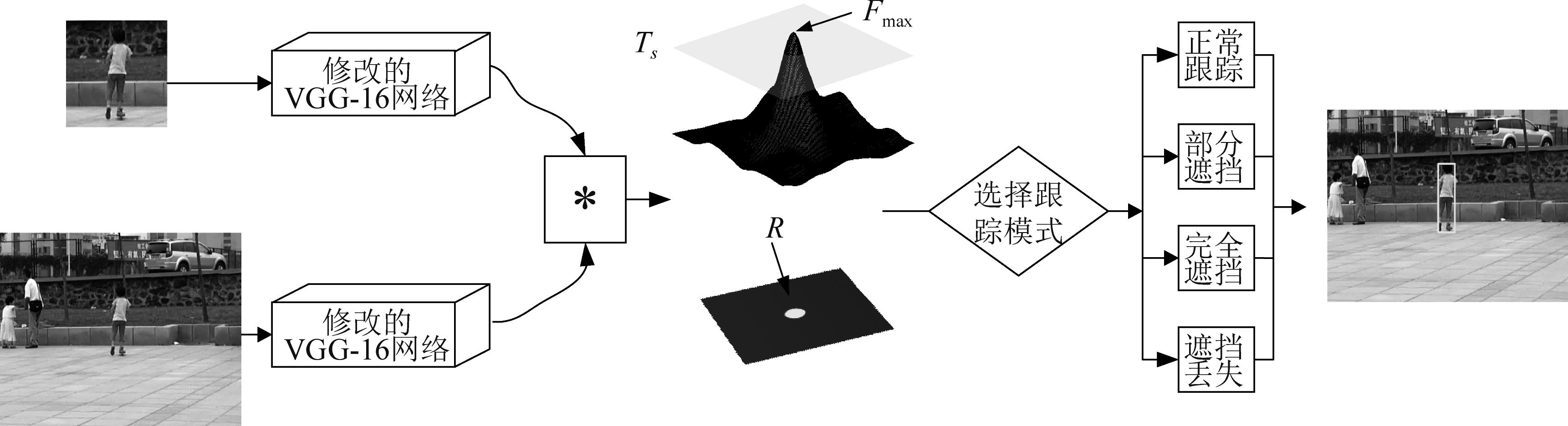

如图2所示,图2(a)为基于SiamVGG网络目标跟踪的结果,图2(b)为本文目标跟踪的结果,图2(c)、(e)为基于SiamVGG网络跟踪对应的置信图,图2(d)、( f )为本文跟踪对应的置信图。在图2(a)中,当出现相似物部分遮挡时,基于SiamVGG网络的跟踪算法将相似物判别为目标,导致目标跟丢,而本文改进的抗遮挡算法避免了相似物体部分遮挡导致的目标跟丢。由图2(c)可知,当基于SiamVGG网络的跟踪算法存在相似物遮挡时,置信图出现了两个峰值,最大峰值位于相似物所在位置,导致目标跟丢,并且从图2(e)看到此时存在两个连通域。

通过分析视频序列前后帧的置信图,可知目标运动是一条连续的轨迹,置信图峰值Fmax和连通域R都处于一定范围内。定义d=||dt-dt-1||为当前帧dt和前一帧dt-1置信图峰值Fmax之间的距离。定义Td为前后帧置信图峰值之间距离的阈值,若连续10帧前后帧置信图峰值之间的距离d<Td,则建立一条稳定的轨迹。如图2(c)所示,在目标轨迹稳定的前提下,若根据最大峰值Fmax1计算得到的前后帧置信图峰值之间的距离d1>Td,根据次峰值Fmax2计算得到的前后帧置信图峰值之间的距离d2<Td,并且连通域R1<Trp,次峰值Fmax2>Tfp,则抑制最大峰值Fmax1选择次峰值Fmax2。其中Trp和Tfp分别为在部分遮挡模式下,满足被部分遮挡后重新找回目标的连通域和峰值的阈值大小。如图2(d)所示,图2(c)中的最大峰值Fmax1被抑制,此时最大峰值为图2(c)的次峰值Fmax2。在图2(b)中,目标被正确跟踪,有效避免了相似物部分遮挡的干扰。

图1 引入抗遮挡机制的SiamVGG网络目标跟踪算法框架

Fig.1 The framework of SiamVGG network target tracking algorithm with anti-occlusion mechanism

图2 目标被相似物部分遮挡

Fig.2 The target is partially obscured by similar object

2.3 完全遮挡

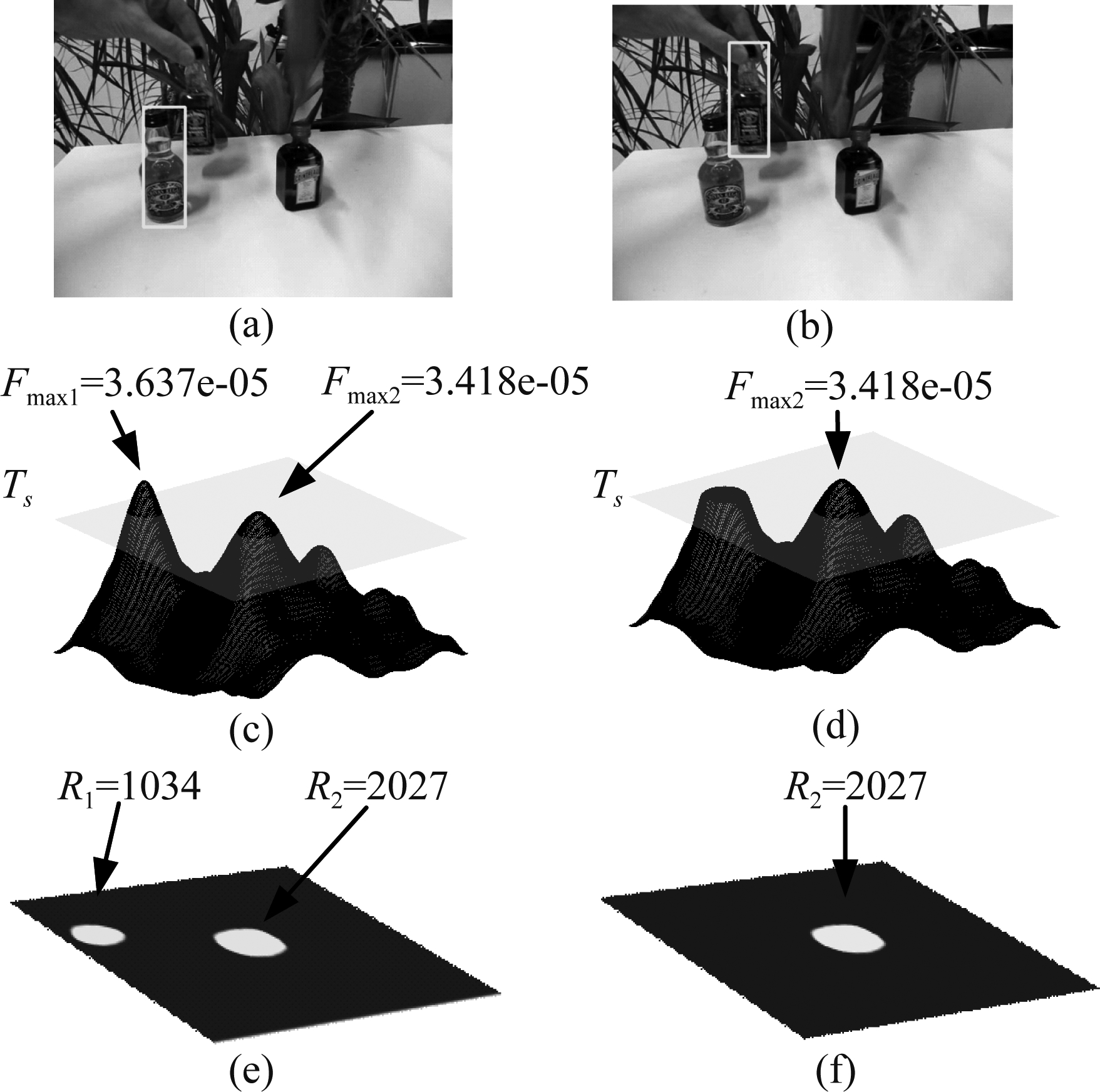

如图3所示,图3(a)为目标被相似物完全遮挡的情况,图3(b)绿色边框是基于SiamVGG网络跟踪所定位的物体。其将相似物判别为目标,黄色边框是基于本文算法跟踪所定位的目标,本文算法在当目标被相似物完全遮挡时能够重新定位目标位置。基于SiamVGG网络的跟踪算法在目标物体被完全遮挡时,由于目标和背景相似,导致跟踪偏移。图3(c)、(e)为目标被完全遮挡时的置信图,由图可知目标被完全遮挡时置信图的连通域较大并且峰值较高,图3(d)、( f )为目标正确被跟踪的置信图,此时置信图的连通域较小并且峰值较高。

图3 目标被相似物完全遮挡

Fig.3 The target is completely obscured by similar object

定义当连续5帧以上峰值Fmax>Tfa1且连通域R>Tra1,则判别相似物完全遮挡,触发完全遮挡模式。在目标原来未被遮挡的位置上,创建跟踪器,形成双跟踪器并行模式进行跟踪检测。其中Tra1和Tfa1分别为在完全遮挡模式下,触发完全遮挡条件时的连通域和峰值的阈值大小。如图3(c)、(e)所示,满足完全遮挡触发条件后,同时对目标原位置和被遮挡物进行检测跟踪。若在目标原位置上检测到峰值Fmax>Tfa2并且连通域R<Tra2,如图3(d)、( f )所示,表明目标是被相似物完全遮挡,其中Tra2和Tfa2分别为在完全遮挡模式下,满足被完全遮挡后重新找回目标的连通域和峰值的阈值大小。如图3 (b)所示,当相似物离开后,本文算法采用抗遮挡策略后跟踪框重新定位到目标上,黄色边框表示正确跟踪到的目标位置。

2.4 遮挡丢失

如图4(a)所示,目标在被长时间遮挡后,基于SiamVGG网络的跟踪算法将目标跟丢,错误定位到了其他位置,图4(c)、(e)为图4(a)对应的置信图。如图4(a)红色框所示,算法通过扩大对目标搜索的范围,将目标重新定位;而基于SiamVGG网络的跟踪算法搜索范围为图中蓝色框所示,此时目标在搜索范围以外,因此无法再重新定位目标。通过分析目标的置信图峰值和连通域大小,如图4(c)、(e)所示,当目标长时间遮挡跟丢后,由于背景干扰,置信图的连通域较大并且峰值较低。如图4(d)、( f )所示,在目标被正常跟踪的情况下,置信图的连通域较小并且峰值较高。

图4 目标被遮挡后丢失

Fig.4 The target is lost after being occluded

定义峰值和连通域连续10帧R>Trl1且Fmax<Tfl1,判断为目标跟丢,触发遮挡丢失模式,在图中重新搜索目标,并在每帧中逐步扩大搜索区域的范围。其中Trl1和Tfl1分别为在完全遮挡模式下,触发遮挡丢失条件时的连通域和峰值的阈值大小。如图4(d)、( f )所示,如果检测到R<Trl2并且Fmax>Tfl2,则重新定位到目标,其中Trl2和Tfl2分别为在遮挡丢失模式下,满足遮挡丢失后重新找回目标时的连通域和峰值的阈值大小。如图4(b)所示,本文算法采用遮挡丢失策略,跟踪框重新定位到目标位置,图中黄色框表示正确跟踪到的目标位置。

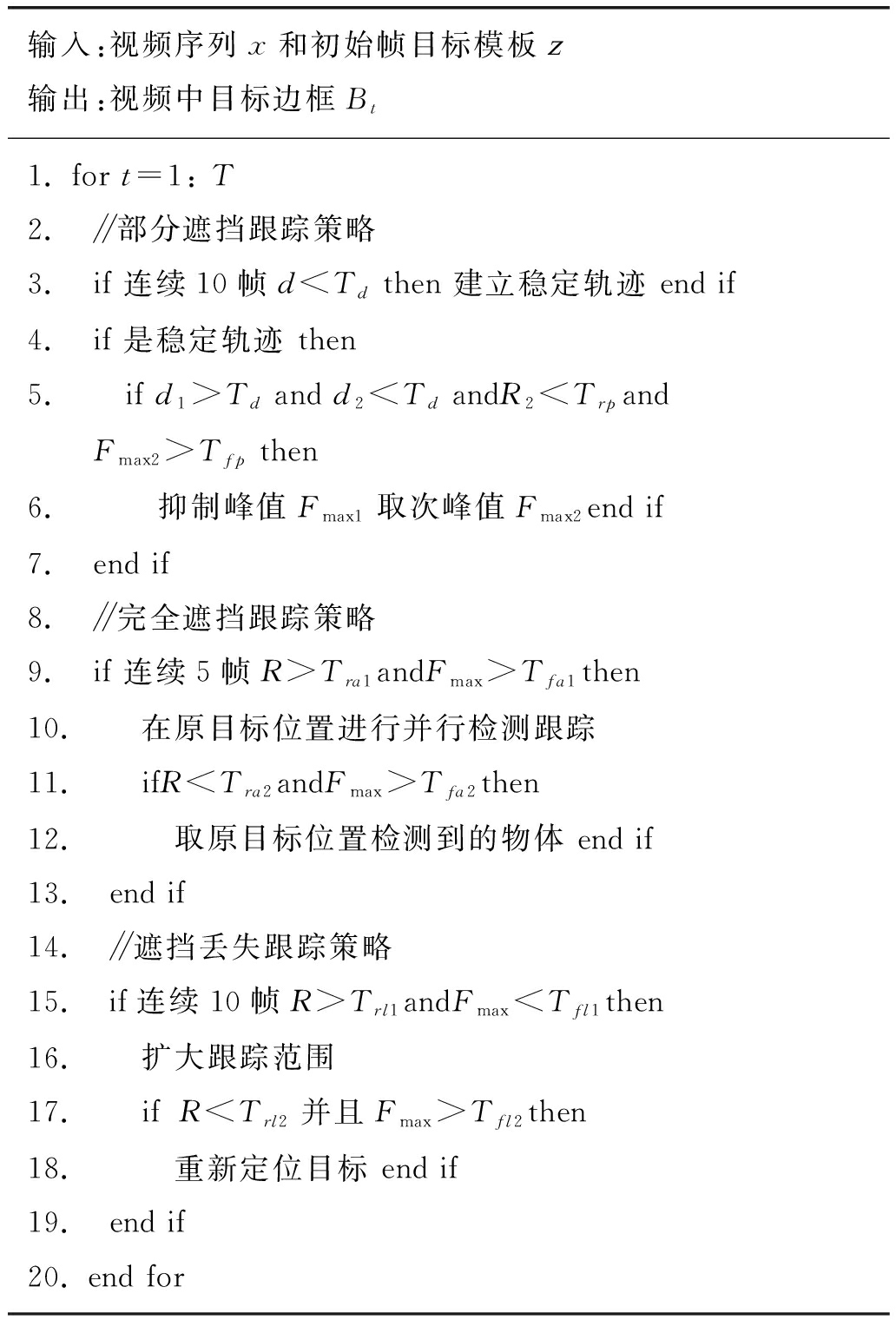

2.5 算法伪代码

引入抗遮挡机制的SiamVGG网络目标跟踪算法的伪代码如表1所示,算法对遮挡处理主要分成部分遮挡、完全遮挡和遮挡丢失三个部分。每部分根据SiamVGG网络输出置信图的峰值Fmax和连通域大小R进行分析判断,根据不同的情况采取不同的跟踪策略,从而使得本文算法对物体遮挡的情况有较强的鲁棒性。

表1 引入抗遮挡机制的SiamVGG网络目标跟踪算法伪代码

Tab.1 Pseudo code of SiamVGG network target tracking algorithm with anti-occlusion mechanism

输入:视频序列x和初始帧目标模板z输出:视频中目标边框Bt1. for t=1: T2. ∥部分遮挡跟踪策略3. if 连续10帧d

3 实验结果及分析

3.1 评估方法

为了验证算法的精度和鲁棒性,选择OTB大型基准数据集,数据集包含了目标运动过程中存在光照变化、目标形变、物体遮挡、快速移动等情况。其中,OTB-2013[25]包含51个视频序列,OTB-100[26]对OTB-2013数据集做了扩充,包含了100个视频序列。OTB-50是从OTB-100中选取了50个具有挑战性的视频序列作为数据集,和OTB-2013所包含的51个视频数据集不同。

本文使用重叠成功率和距离精度作为评价的标准[29]。首先定义重叠分数S为

(3)

Bt表示预测的边框,Bgt表示标注的边框,∩和∪表示的是交和并操作。|·|表示计算这个区域的像素点数量。

重叠成功率是指在所有的视频序列中,当算法预测边框Bt和真实标注边框Bgt之间的重叠分数S大于阈值u∈[0,1]的视频帧数占总帧数的比率,重叠成功率fs由式(4)可得

(4)

中心位置误差是指算法预测的中心(xt,yt)标注的中心(xgt,ygt)的差值Perr,由式(5)可得

(5)

距离精度是指算法预测的中心和标注的中心的差值小于阈值p的相对帧数,其定义如下

(6)

其中Nt表示Perr小于阈值p的帧数,Nsum表示视频序列中的总帧数。

本文使用成功重叠率和距离精度作为一次通过评估(one-pass evaluation(OPE))的跟踪指标。一次通过评估在运行跟踪算法时,用标注的第一帧的初始位置作为起始帧进行跟踪。一次通过评估的成功图中的跟踪算法排名是根据重叠成功率进行排名,其重叠分数设置为S>0.5,而距离精度图中的跟踪算法排名是根据预测中心和标注中心的误差Perr<p=20个像素大小进行排名。

3.2 参数设置

当目标被相似物部分遮挡时,设置距离阈值Td=50,连通域阈值Trp=2500,峰值阈值Tfp=3000。当目标被相似物完全遮挡时,设置连通域阈值Tra1=3800和Tra2=2500,峰值阈值Tfa1=4.0e-5和Tfa2=5.5e-5。当遮挡丢失时,设置连通域阈值Trl1=6000和Trl2=2500,峰值阈值Tfl1=4.0e-5和Tfl2=5.5e-5。

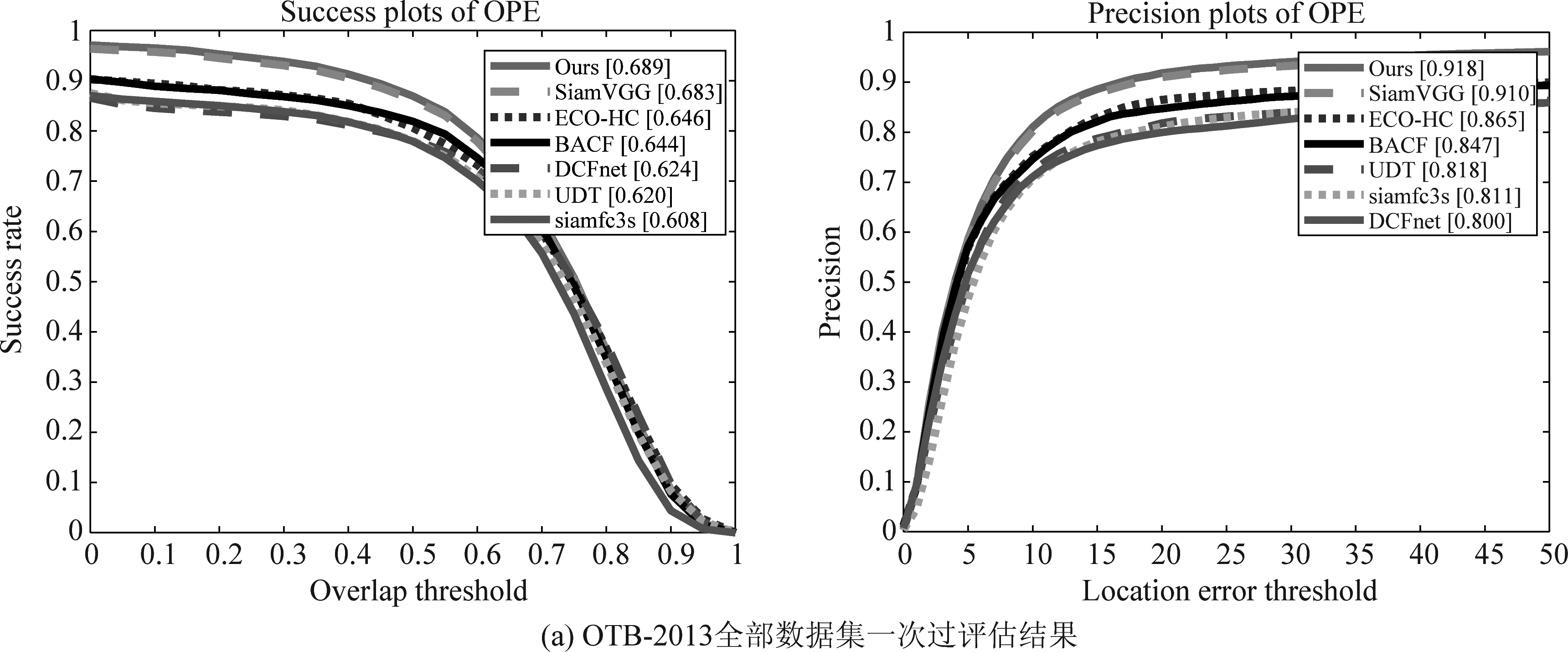

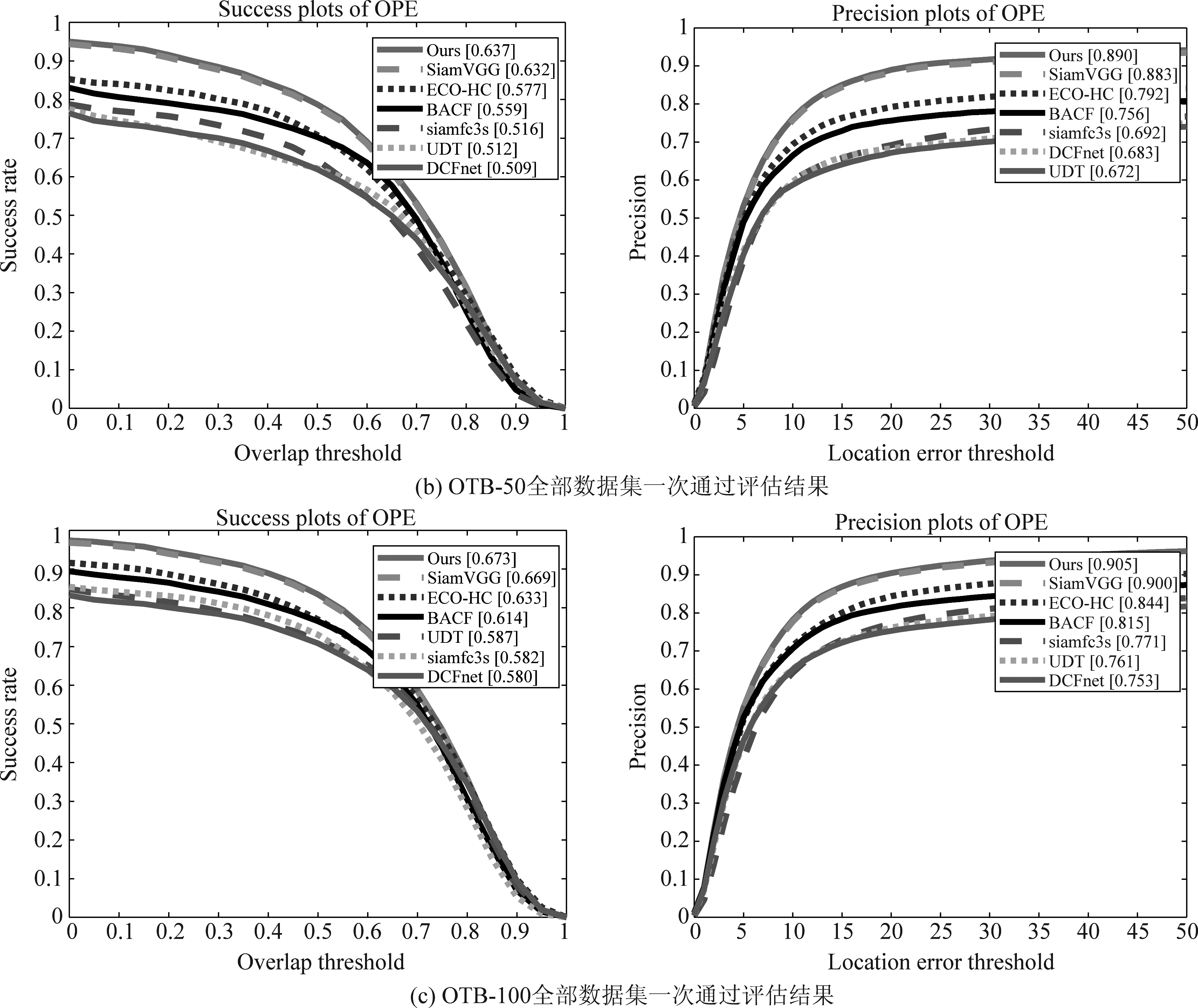

3.3 OTB数据集评估

本文将一些先进的相关滤波器BACF[27],ECO-HC[28]和基于深度学习的算法siamfc3s[11],DCFnet[29],UDT[30],SiamVGG[12]在OTB大型基准数据集上进行了对比。本文的算法基于MATLAB 2017a实现,所用的实验设备配置是8GB的RAM和英特尔i5- 83002.3 GHz的CPU。

如图5所示的是各跟踪算法在OTB-2013,OTB-100和OTB-50三个大型基准数据集上重叠成功率和距离精度的曲线下面积(area under curve,AUC)图,在每个成功图和距离精度图中都对应着不同的跟踪算法。由图5可知本文算法在OTB-2013、OTB-100和OTB-50三个大型基准数据集上的重叠成功率和距离精度都优于其他算法,表明本文算法在复杂的场景下有着更好的跟踪精度和鲁棒性。

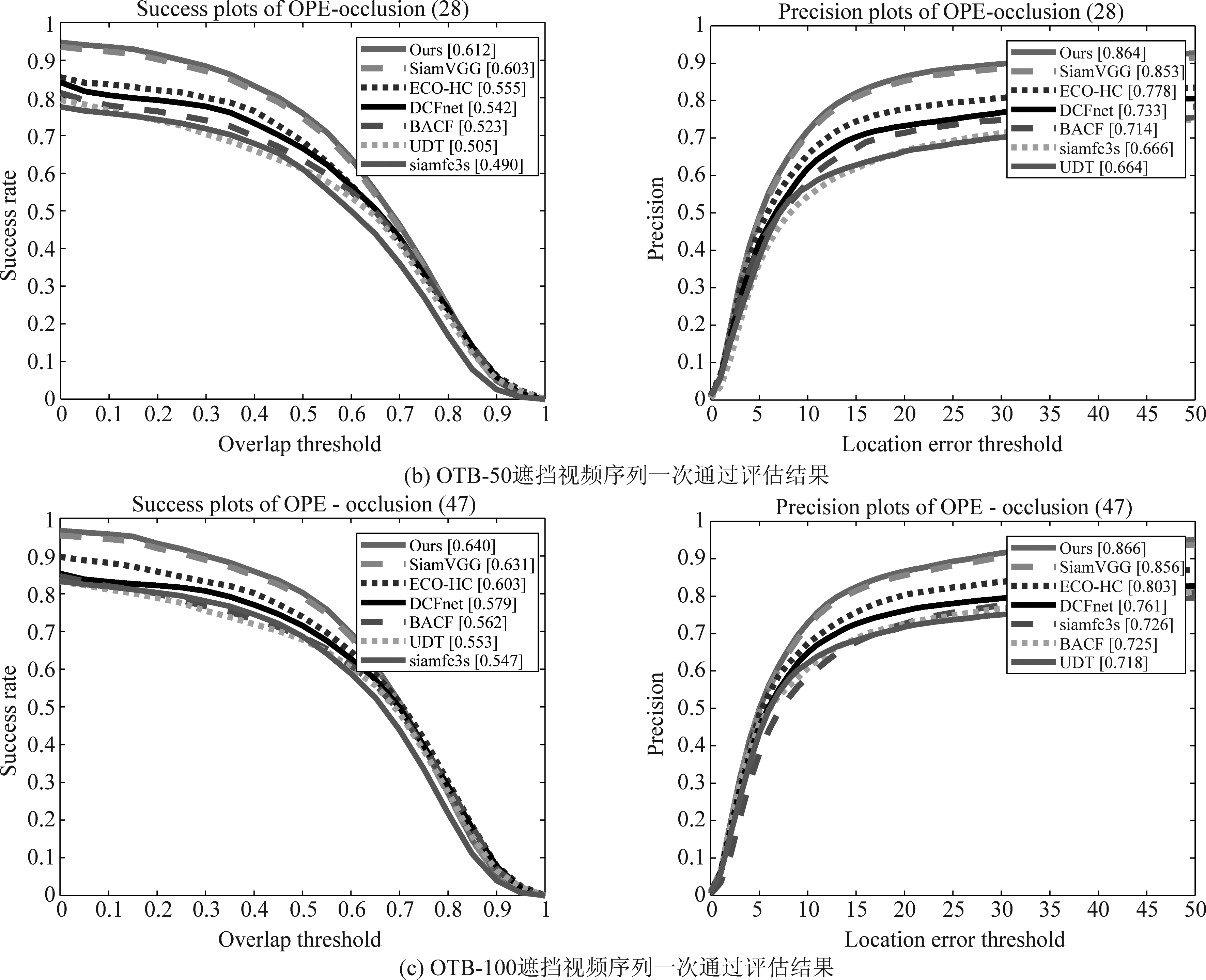

在OTB数据集中包含有光照变化、目标形变、物体遮挡等不同类型的视频序列。图6所示的是分别在OTB-2013、OTB-100和OTB-50选取遮挡数据集进行重叠成功率和距离精度评估的结果。相比基于SiamVGG网络的跟踪算法或其他的跟踪算法,本文算法在遮挡的视频序列中有着更突出的表现,说明本文算法通过采用不同的遮挡跟踪策略,能够精确地判别目标遮挡和目标跟丢的情况,从而更好地跟踪目标,提高目标跟踪的重叠成功率和距离精度。

图5 OTB全部数据集重叠成功率和距离精度评估结果

Fig.5 Evaluation results of overlap success rate and distance accuracy in OTB dataset

3.4 视频序列分析

我们从OTB大型数据集中挑选了有关遮挡的6个视频序列,分别是basketball,Girl,Girl2,Liquor,Skating2-2和Suv视频序列。本文算法将这6个视频序列与其他跟踪算法进行定性分析比较。

如图7(a)、(d)、(e)所示,在Basketball、Liquor和Skating2-2视频序列中,都存在相似物部分遮挡的情况,基于SiamVGG网络的跟踪算法都因将相似物判别为目标而跟丢了目标。本文算法在Basketball,Liquor和Skating2-2视频序列中仍能准确得到

图6 OTB遮挡视频序列重叠成功率和距离精度评估结果

Fig.6 Evaluation results of overlap success rate and distance accuracy in OTB occlusion video sequence

图7 本文算法在Basketball,Girl,Girl2,Liquor,Skating2-2和Suv视频序列中与其他跟踪算法进行对比

Fig.7 The algorithm is compared to other trackers in the Basketball, Girl, Girl2, Liquor, Skating2-2 and Suv video sequences

目标的位置。由于本文算法通过使用相似物部分遮挡策略,在目标发生相似物遮挡时不会被相似物干扰,因此较之其他算法,其在处理相似物部分遮挡时的鲁棒性更强。

如图7(b)、(c)所示,在对于目标被完全遮挡的情况下,如Girl和Girl2视频序列都被相似物完全遮挡,特别是在Girl2视频序列,在第110帧目标被完全遮挡后,当在第123帧目标重新出现时,此时其他跟踪算法都被相似物干扰发生严重偏移,本文算法仍旧能够很好地重新跟踪目标。本文算法在目标被完全遮挡时开启并行检测跟踪策略,当检测到目标时,在目标跟丢的位置检测目标,重新定位到目标位置。

如图7( f )Suv视频序列所示,由于第775帧发生遮挡时,第797帧目标重新出现,基于SiamVGG网络算法将目标跟丢后不能重新定位目标位置,而本文算法通过扩大搜索范围,重新定位目标位置从而再次跟踪目标。

本文算法可以根据不同的遮挡情况使用不同的遮挡策略,因此算法有助于提高目标抗遮挡处理的精度,具有较好的鲁棒性。

4 结论

针对视觉目标跟踪过程中存在遮挡而导致目标跟丢的问题,本文提出了引入抗遮挡机制的SiamVGG网络目标跟踪算法,该算法利用SiamVGG高精度的跟踪网络,将目标跟踪分成正常跟踪、部分遮挡、完全遮挡和遮挡丢失四种情况,然后通过对网络输出的置信图的峰值大小和连通域大小进行判断,选择不同的跟踪策略,使得本文所提算法对于目标跟踪的遮挡情况具有较高的精度和较强的鲁棒性。实验结果表明,本文算法在目标被遮挡的情况下能重新定位目标并对其跟踪,有效避免目标跟丢的发生,同时在跟踪精度上优于其他的算法。后续可针对小目标的遮挡问题继续进行分析和改进,以提高算法的抗遮挡性能。

[1] Bradski G R. Real Time Face and Object Tracking as a Component of a Perceptual User Interface[C]∥4th IEEE Workshop on Applications of Computer Vision (WACV’98). IEEE, 1998.

[2] Vojir T, Noskova J, Matas J. Robust scale-adaptive mean-shift for tracking[J]. Pattern Recognition Letters, 2014, 49: 250-258.

[3] Hester C F, Casasent D. Multivariant technique for multiclass pattern recognition[J]. Applied Optics, 1980, 19(11): 1758-1761.

[4] Bolme D S, Beveridge J R, Draper B A, et al. Visual object tracking using adaptive correlation filters[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. IEEE, 2010: 2544-2550.

[5] Henriques J F, Caseiro R, Martins P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]∥European conference on computer vision. Springer, Berlin, Heidelberg, 2012: 702-715.

[6] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 37(3): 583-596.

[7] Danelljan M, Shahbaz Khan F, Felsberg M, et al. Adaptive color attributes for real-time visual tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 1090-1097.

[8] Possegger H, Mauthner T, Bischof H. In defense of color-based model-free tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 2113-2120.

[9] Bertinetto L, Valmadre J, Golodetz S, et al. Staple: Complementary learners for real-time tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1401-1409.

[10] 张能波, 苏振斌, 谢维信. Lasso约束下融和光流信息的DCF目标跟踪算法[J]. 信号处理, 2019, 35(5): 911-918.

Zhang Nengbo, Su Zhenbin, Xie Weixin. DCF Visual Object Tracking Algorithm with Lasso Constraints and Fusion Optical Flow[J]. Journal of Signal Processing, 2019, 35(5): 911-918.(in Chinese)

[11] Bertinetto L, Valmadre J, Henriques J F, et al. Fully-convolutional siamese networks for object tracking[C]∥European conference on computer vision. Springer, Cham, 2016: 850- 865.

[12] Li Yuhong, Zhang Xiaofan. SiamVGG: Visual Tracking using Deeper Siamese Networks[J]. arXiv preprint arXiv: 1902.02804, 2019.

[13] Li Bo, Yan Junjie, Wu Wei, et al. High performance visual tracking with siamese region proposal network[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 8971- 8980.

[14] Wang Qiang, Zhang Li, Bertinetto L, et al. Fast online object tracking and segmentation: A unifying approach[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 1328-1338.

[15] Kalal Z, Mikolajczyk K, Matas J. Tracking-learning-detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 34(7): 1409-1422.

[16] Zhang Kaihua, Zhang Lei, Liu Qingshan, et al. Fast visual tracking via dense spatio-temporal context learning[C]∥LNCS 8693: Proceedings of the 13th European Conference on Computer Vision, Zurich, Sep 6-12. Berlin, Heidelberg: Springer, 2014: 127-141.

[17] 李俊, 谢维信, 李良群. 基于空时线索的TLD视频跟踪算法[J]. 信号处理, 2015, 31(10): 1287-1293.

Li Jun, Xie Weixin, Li Liangqun. TLD Visual Target Tracking Algorithm based on Spatio-Temporal Cues[J]. Journal of Signal Processing, 2015, 31(10): 1287-1293.(in Chinese)

[18] Ma Chao, Yang Xiaokang, Zhang Chongyang, et al. Long-term correlation tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2015: 5388-5396.

[19] Ma Chao, Huang Jiabin, Yang Xiaokang, et al. Adaptive correlation filters with long-term and short-term memory for object tracking[J]. International Journal of Computer Vision, 2018, 126(8): 771-796.

[20] Wang Mengmeng, Liu Yong, Huang Zeyi. Large margin object tracking with circulant feature maps[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 4021- 4029.

[21] Nebehay G, Pflugfelder R. Clustering of static-adaptive correspondences for deformable object tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 2784-2791.

[22] Hong Zhibin, Chen Zhe, Wang Chaohui, et al. Multi-store tracker (muster): A cognitive psychology inspired approach to object tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 749-758.

[23] Guan Mingyang, Wen Changyun, Shan Mao, et al. Real-time event-triggered object tracking in the presence of model drift and occlusion[J]. IEEE Transactions on Industrial Electronics, 2018, 66(3): 2054-2065.

[24] Zhu Zheng, Wang Qiang, Li Bo, et al. Distractor-aware siamese networks for visual object tracking[C]∥Proceedings of the European Conference on Computer Vision (ECCV), 2018: 101-117.

[25] Wu Yi, Lim J, Yang M H. Online object tracking: A benchmark[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2013: 2411-2418.

[26] Wu Yi, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[27] Kiani Galoogahi H, Fagg A, Lucey S. Learning background-aware correlation filters for visual tracking[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 1135-1143.

[28] Danelljan M, Bhat G, Shahbaz Khan F, et al. Eco: Efficient convolution operators for tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 6638- 6646.

[29] Wang Qiang, Gao Jin, Xing Junliang, et al. Discriminant correlation filters network for visual tracking[J]. arXiv 2017, arXiv preprint arXiv: 1704.04057.

[30] Wang Ning, Song Yibing, Ma Chao, et al. Unsupervised Deep Tracking[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019: 1308-1317.

SiamVGG Network Target Tracking Algorithm with Anti-occlusion Mechanism

Reference format: Chen Fujian, Xie Weixin. SiamVGG Network Target Tracking Algorithm with Anti-occlusion Mechanism[J]. Journal of Signal Processing, 2020, 36(4): 562-571. DOI: 10.16798/j.issn.1003- 0530.2020.04.010.

陈富健 男, 1995年生, 广东四会人。深圳大学电子与信息工程学院硕士研究生, 主要研究方向为智能信息处理、图像处理。

E-mail: chen_fujian@qq.com

谢维信 男, 1941 年生, 广东广州人。深圳大学教授、博士生导师, 深圳大学信号与信息处理学科学术带头人, 国家级有突出贡献专家, 主要研究方向为智能信息处理、模糊信息处理、雷达目标识别等。

E-mail: wxxie@szu.edu.cn