1 引言

以人工为主导的现代安检在各种公共场所中起着重要作用。通过X光安检机生成的图像,安检人员可以了解民众行李中携带的物品。由此可以预防大量恐怖袭击和其他恶性安全事件的发生。但因为工作的特殊性,安检人员普遍面临着高压和疲劳的工作状态,这极易造成漏检和误检。而此类单一枯燥的比对、识别工作反而更适合计算机来处理,人类可以从这项繁重的工作中解放出来。

利用计算机实现违禁品的自动识别是未来智能化安检的核心,也是计算机视觉技术的实际应用范畴。针对安检违禁品识别问题,2017年Mery[1]等人对比了10种基于计算机视觉的检测方法,发现基于深度学习的算法优于其他方法。此外Roomi[2]及Turcsany[3]等人通过手动提取特征的方法来检测违禁品。2018年Akcay[4]等人研究了卷积神经网络(Convolutional Neural Network, CNN)在安检图像的分类和检测任务中的使用。2019年Liu[5]等人提出一种基于深度卷积神经网络的X光安检违禁品检测器,用于违禁品识别任务中。这些目标检测算法可以获取违禁品的位置及类别信息,却无法获取目标物的形状信息。2014年,全卷积神经网络FCN[6](Fully Convolutional Networks, FCN)的诞生标志着语义分割算法兴起。2018年Xu[7]等人针对安检违禁品识别问题,将传统图像分割技术与空间注意力机制相结合,提出了一种违禁品识别算法,实现对违禁品位置、类别、形状三种信息的提取。2019年An[8]等人首次将语义分割技术引入安检违禁品识别领域,提出了一种高精度的单目标违禁品识别算法。对比可知,在安检违禁品识别领域,大量的研究人员专注于目标检测算法的研究,而该类算法只能获取违禁品的部分信息。以An为代表的研究人员虽然开创了语义分割技术在该领域的使用,但是针对多目标违禁品识别问题的研究依旧是十分稀少。

针对上述问题,本文提出了一种基于语义分割技术的多目标违禁品识别算法。首先,采用编码解码的模型架构,考虑到安检图像色彩单调且表面纹理缺失的特点,浅层特征对于分割结果的作用更大,本文采用类VGG16(Visual Geometry Group Network)这种浅层结构用以特征提取。其次,设计ASPC模块替代VGG16中前四层的卷积操作,多尺度卷积操作可以提升模型多尺度信息的挖掘能力。同时引入注意力机制对ASPC模块进行监督,进一步提高模块特征提取的能力。最后,模型采用与U-Net[9]相似的逐级上采样操作,并受Lin[10]等人的启发,引入1×1卷积用以减少计算量。针对多目标安检图像的处理,研究者可以从模型最终输出的语义分割图中获取违禁品的位置、大小及形状三类信息。

2 算法介绍

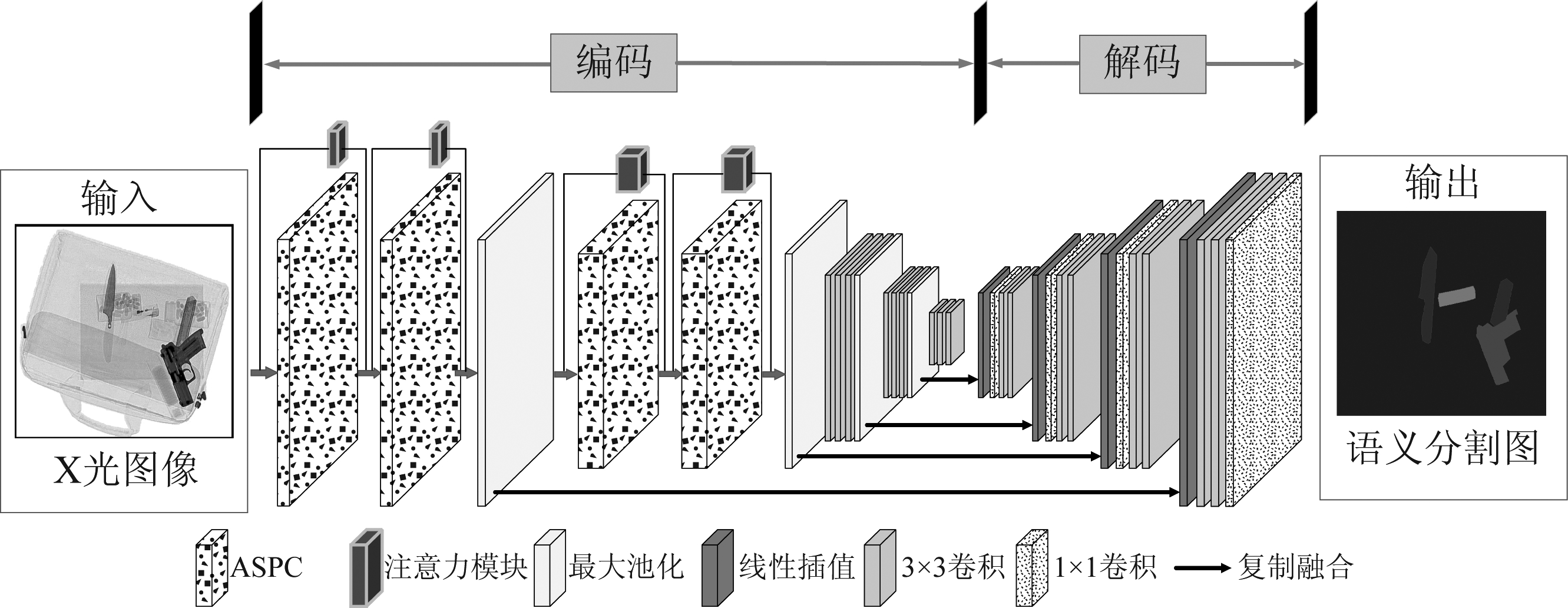

本文提出的算法模型如图1所示,由编码及解码两部分组成。编码部分用于特征提取,采用设计的ASPC模块与普通3×3卷积混合处理,使用最大池化操作逐渐缩小特征图尺寸。解码部分用于尺寸复原,采用双线性插值方法逐级恢复特征图大小,同时为了充分利用下采样阶段的语义信息,引入特征图复制融合的操作,提升分割精细度。

图1 多目标违禁品识别模型

Fig.1 The multi-object prohibited items identification model

2.1 ASPC模块多尺度特征提取

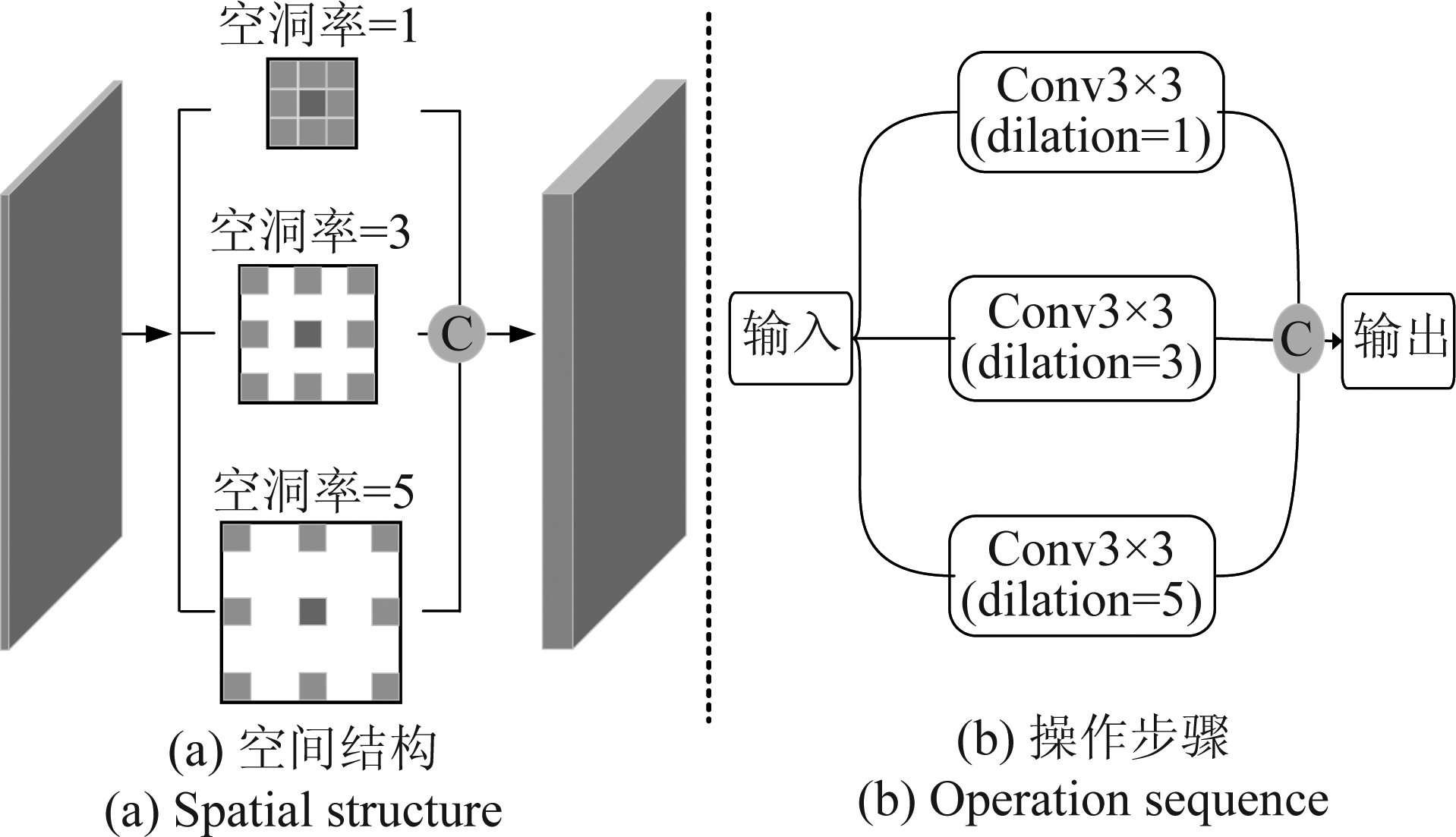

多目标安检图像中违禁品的种类多样且尺寸大小不一,细节信息和区域信息都很重要。此时多目标违禁品识别的核心在于对多尺度信息的挖掘,所以编码器在设计时需兼顾细节和区域两部分语义信息,确保特征提取充分。2014年GoogleNet[11]发布,其中Inception Module历经了V1、V2、V3、V4等多个版本的发展。在V1中提出了不同尺寸卷积核并联运行,其后的拼接处理意味着不同尺度特征的融合,提高了模块对特征图多尺度信息的挖掘能力(后面几个版本的模块都一直沿用了该项操作)。2017年Deeplabv3[12]网络提出空洞空间金字塔池化模块,扩大了网络的感受野,使得算法在图像分类性能上大大提升。2018年Li[13]等人提出PAN(Pyramid Attention Network, PAN)网络,其构建的特征金字塔注意力模块(Feature Pyramid Attention,FPA)采用池化加卷积的并联操作,提升了不同尺度目标物的整体分割效果。受上述模型的启发,本文设计了空洞空间金字塔卷积模块ASPC,如图2所示。

图2 空洞空间金字塔卷积模块

Fig.2 Atrous spatial pyramid convolution block

该模块使用不同空洞率的3×3卷积核,提取各尺度的语义信息。首先,空洞卷积通过改变空洞率(dilation)参数,形成不同大小的感受野。以本模型中空洞率为5的3×3卷积核为例,卷积核中纵横两点之间插入4个零值,使得卷积后的感受野变成11×11。同理,空洞率为1和3时,分别表示不插零值和插入2个零值,相对应的感受野是3×3和7×7。并联运行后,三个通道的卷积结果进行拼接融合,最后输出的语义信息则包含了上一层特征图的三种尺度信息,提升了算法对安检图片多尺度信息的挖掘能力。其次,空洞卷积本身可以提高模型的分类性能,如上述分析所示,增加了插值操作的卷积核感受野变大,模型在做判断时可以参考更多的特征图信息,从而降低误分类现象。但是Chen[12]等人研究发现,当特征图尺寸较小时,使用较大空洞率的卷积会造成真实语义信息没有被充分利用,导致小尺寸目标的分割精细度变差。所以,本模型只在特征提取的前两阶段使用ASPC模块,以防止上述情况的发生。

2.2 注意力监督下采样

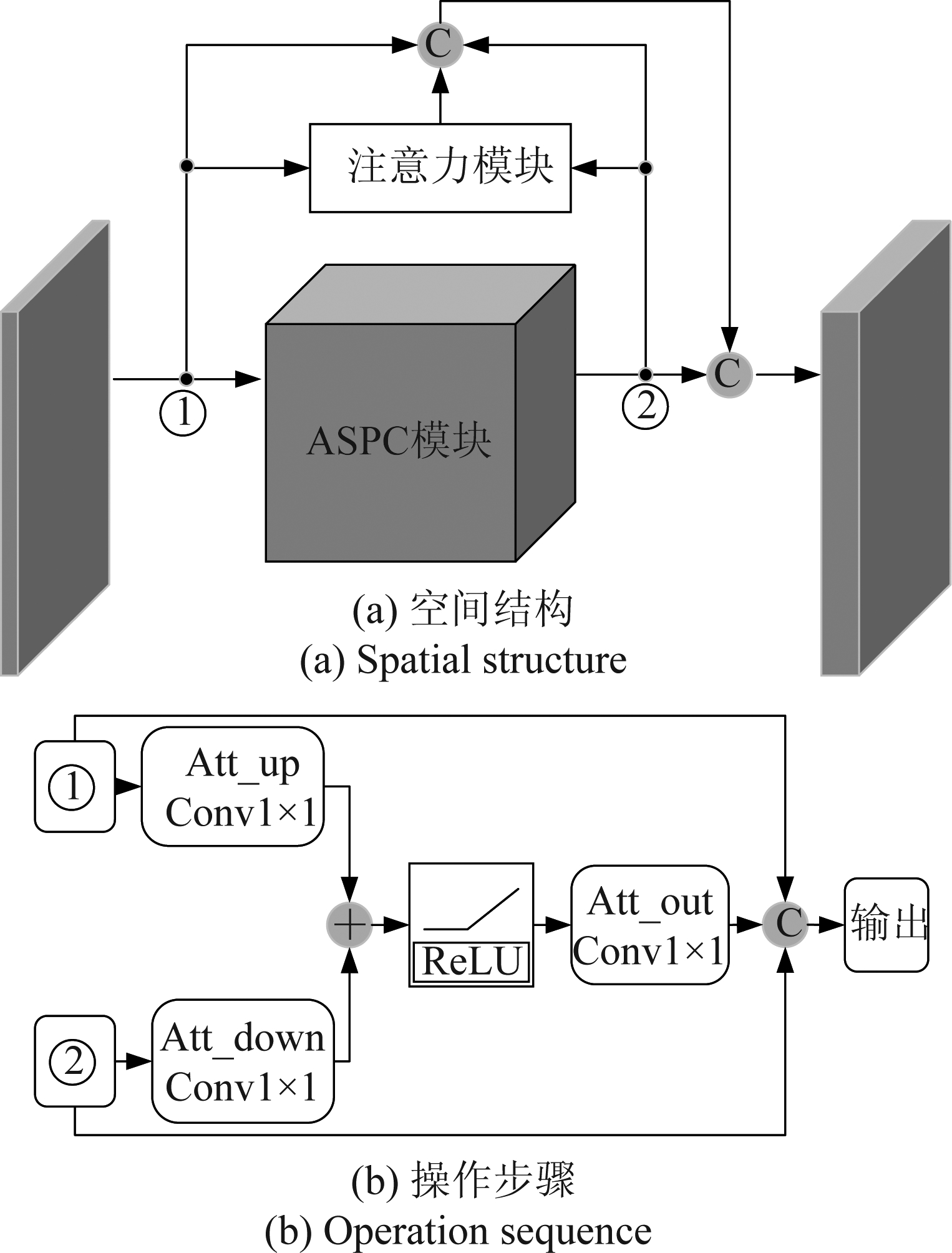

计算机视觉中注意力机制的基本思想就是让系统学会注意力,能够忽略无关信息而关注重点信息,由此可以提升编码器特征提取能力。注意力机制可以粗分类成硬注意力(Hard-attention)和软注意力(Soft-attention)。硬注意力本质是0或1的判定,表明哪些区域是被注意的,哪些是不被关注的。图像裁剪(image cropping)就是硬注意力在图像处理领域最被大众熟知的应用。软注意力本质是[0,1]区间连续分布问题,通过选择性地忽略部分信息来对其余信息进行重新加权聚合计算。硬注意力与软注意力的主要区别在于硬注意力不可微分,主要通过增强学习来完成训练,而软注意力可微分,可以通过计算梯度并且双向传播来学习得到相应的权重。本文引入的注意力模块(软注意力),如图3所示。

图3 注意力模块

Fig.3 Attention module

模型引入注意力机制用于监督ASPC模块的特征提取。首先,从图3(a)的空间结构可看出,注意力模块的输入分为两部分,其一是上层语义信息(①),其二是经过ASPC模块处理后的语义信息(②),ASPC模块的特征提取结果会间接影响注意力模块的输出。由于空间注意力本身可微,网络可根据损失函数计算梯度来起到反馈作用,此时ASPC模块既受到模型损失函数的监督,又间接受到附加注意力模块的监督。同时,增加了①和②的两条绕过注意力模块的支路,方便梯度流的反向传播。其次,如图3(b)的操作步骤所示,为了提升注意力模块的鲁棒性,本模型在卷积操作之后还增加了非线性激活处理(ReLU函数)。结合第三章消融实验结果可以看出,注意力机制的引入可以进一步提升模块的特征提取能力,使最终的分割结果变得更好。

2.3 逐级上采样

编码结束后,解码器将通过上采样的一系列操作恢复特征图尺寸,最后输出与原图大小一致的语义分割图。

计算机视觉中上采样操作通常有三种,分别是:双线性插值、转置卷积、反池化。1)在数学上,双线性插值是两个变量的插值函数的线性插值扩展,其核心思想是在两个方向分别进行一次线性插值,双线性插值在目前的语义分割网络中使用较多,该方法不需要进行学习,运行速度快,操作简单。2)从运算过程来看,转置卷积是卷积的逆操作,即反向实现尺寸扩大,但是该方法有参数需要进行学习(与卷积相似),运行速度较慢。3)在池化阶段记录最大池化在对应卷积核中的坐标,到反池化时将一个元素根据卷积核进行放大,并依据记录的坐标将元素填写进去,其他位置补0。反池化也不需要学习,但使用不多, SegNet和DeconvNet在其模型中有使用过[14]。综合比较后,本文采用了双线性插值的上采样方法,如图1所示。

另一方面,为了充分利用编码器提取的各层语义信息,受U-Net网络的启发,本模型采用逐级上采样的方式,将各特征层输出的特征图进行复制融合处理。而这种连接方式使得网络对下采样过程的监管变得多样化,Densenet[15]网络已经证明了这种深度监控所带来的性能提升。此外,为了减少网络的参数量,提高算法的运算速度,模型中还加入了1×1的卷积,用以实现通道降维,减少运算量。通过上述过程,特征图可以恢复到原图大小并输出语义分割图。

3 实验结果及分析

3.1 评估指标

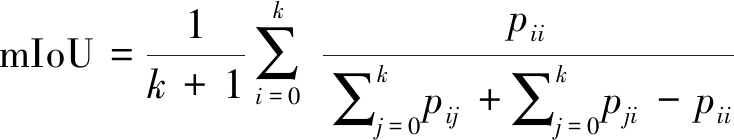

为了验证本文提出算法的分割效果,实验选择平均交并比(mean intersection over union, mIoU)和处理单张图片平均所用时间(Time)作为评估指标。mIoU反映了模型的分割精细度,是主要参考指标,Time反映了模型的运行速度。平均交并比表示模型预测值与标签值相同的数量和模型预测值及标签值相加的数量相比,即预测值和真实值的交集比上预测值和真实值的并集,公式如下所示。

(1)

式中:n表示标签种类数,Apred表示模型预测值,Atrue表示标签值。

(2)

式中:k表示标签种类(加1是包含空类)。pij表示真实值是i预测值为j的数量(像素点的数量),pji则表示真实值是j预测值为i的数量,因为i=j时分母处计算了两次,所以要减去一个pii。

3.2 实验环境及数据集

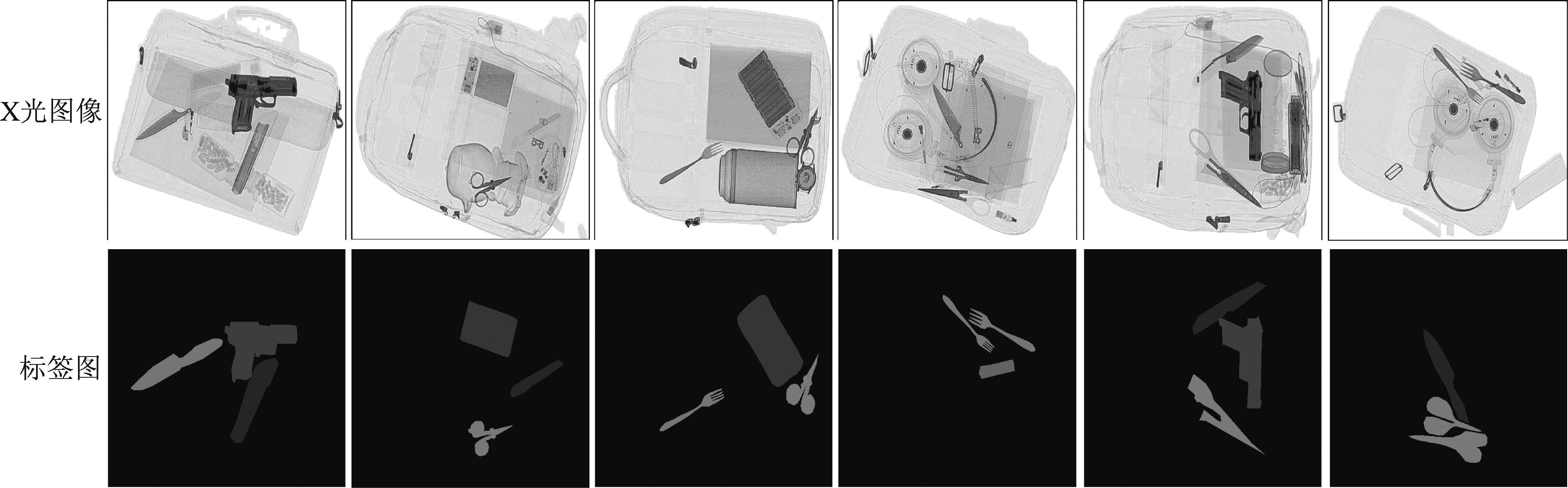

本文所有实验在NVIDIA单块GTX1080Ti型号GPU上进行。初始学习率均为0.0001,迭代次数epochs统一设置为100。实验所需的是安检图像数据集,但是目前没有公开的用于语义分割训练的安检图像数据库。本实验所使用的数据集由课题组自行采集并标注,是基于语义分割任务的专用安检图像数据集,含有7个语义类别的像素级标签:充电宝、打火机、水果刀、叉子、枪支、钳子以及剪刀(如图4所示)。数据集由3570张包含多目标违禁品的安检图片组成,根据大量实验总结,训练集和测试集比例设置为8∶2可以得到较理想的实验效果(训练集2857张,测试集713张)。但现有图片数量用于神经网络训练,仍不足,本文在实验前做了旋转、翻转、裁剪等图像增强处理,扩充了实际参与训练的图片数量。

图4 数据集示例

Fig.4 Examples of images in datasets

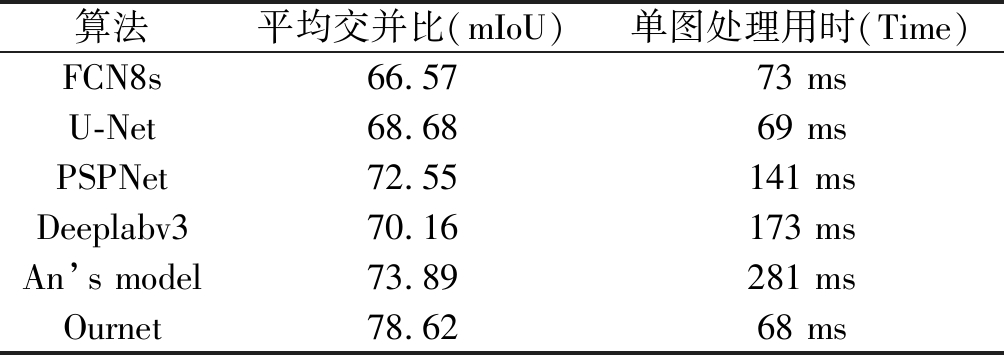

3.3 对比实验

语义分割网络从FCN之后开始兴起,之后的U-Net、Deeplab等高性能分割网络被广泛应用于自动驾驶及场景理解等领域。为了验证本文提出的算法在多目标违禁品识别任务中的性能,本环节将与其他四组公开算法进行对比。1)与同样采用VGG结构作下采样的FCN8s网络对比,该方法在FCN算法系列中分割精细度最高,利用跳跃连接的方式将8倍下采样的特征图与上采样4倍的特征图融合,最后采用反卷积操作将融合后的特征图尺寸扩大8倍,获得语义分割图。2)与同样采用编码解码结构的U-Net网络对比,该方法在医学图像分割任务中表现优异,模型结构简洁对称,而特征融合的操作更是极大地提升了算法的分割精细度。3)与采用金字塔池化及场景解析网络的PSPNet[16]算法对比,该方法是关注全局信息挖掘的代表性算法,在pascalvoc公开数据集上有不错的分割表现。4)与采用空洞空间金字塔池化模块的Deeplabv3网络对比,该方法将空洞卷积与金字塔池化结构相结合,进一步提升了分割网络多尺度信息挖掘能力。

此外,在安检违禁品识别领域,An等人在2019年针对单目标违禁品识别提出了第一种语义分割算法,本文称为An’s model。该方法将通道注意力机制引入高精度语义分割网络,增加了基础网络编码器的监督路径,从而提升了模型的分割精细度。本环节还增加了本文算法与An’s model的对比实验,以验证本文提出的方法在面临多目标违禁品识别任务时具备更优越的性能。(单图处理用时表示算法处理单张图片平均所用时间,实验中Ournet表示本文提出的算法)

结合表1可知,FCN8s及U-Net两种算法在mIoU指标上的得分相对较低,从图5的分割结果来看,分割精细度较差,甚至会出现漏检误检现象,但是网络参数量相对比较少,运行速度较快,单张图片的平均处理时间FCN8s用时73 ms,U-Net用时69 ms。而PSPNet和Deeplabv3这两类网络深度较深的算法在mIoU指标上得分相对较高,且结合图5可以看出整体的分割精细度较好,但对小尺寸目标物的分割效果略显不理想,另外由于增加了网络深度,模型的运算量加大,PSPNet和Deeplabv3处理单张图片平均用时分别为141 ms和173 ms。其次,作为公开的安检违禁品识别算法An’s model,在针对多目标违禁品识别任务时,依旧保持较高的分割精度,其mIoU指标得分73.89,但由于巨大的网络参数量,该算法的运行速度缓慢,单张图片的平均处理时长为281 ms。综合比较,本文提出的算法在mIoU指标上获得78.62分,在面对多目标违禁品识别任务时,该方法分割精细度较高,处理单张图片平均用时为68 ms。

图5 对比实验分割结果

Fig.5 The segmentation results of contrast experiment

表1 对比实验结果

Tab.1 Results of contrast experiment

算法平均交并比(mIoU)单图处理用时(Time)FCN8s66.5773 msU-Net68.6869 msPSPNet72.55141 msDeeplabv370.16173 msAn’s model73.89281 msOurnet78.6268 ms

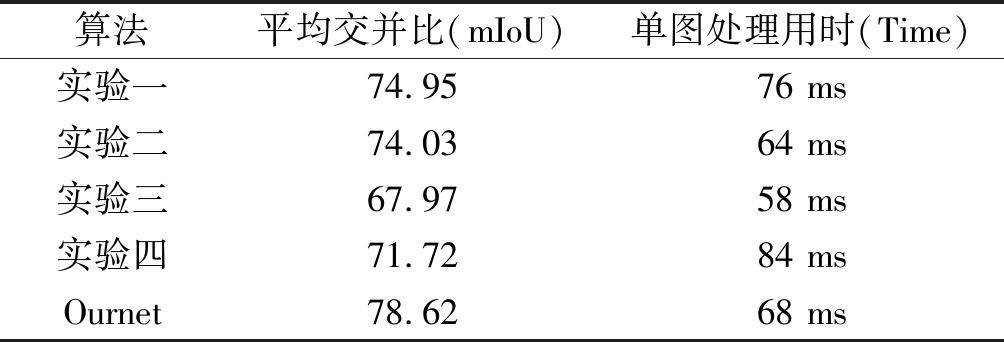

3.4 消融实验

针对多目标违禁品识别任务,本文依据安检图像色彩单调且表面纹理缺失的特点,设计使用ASPC模块用以多尺度挖掘浅层语义信息,引入注意力机制来监督模块的特征提取过程,同时为了方便梯度流的反向传播,增加了两条绕过注意力模块的支路。为了验证上述策略的有效性,本环节共设计了4组消融实验。

(1)实验一:取消绕过注意力模块的两条支部,为了验证增加支路确实更有利于梯度流的反向传播,间接提升算法的分割精细度;

(2)实验二:取消注意力模块,减少ASPC模块的监督路径,为了验证注意力机制的引入确实可以监督ASPC模块的特征提取;

(3)实验三:减少ASPC模块,编码器采用VGG16的普通卷积框架,为了验证空洞空间金字塔卷积在多尺度信息挖掘上确实优于普通卷积;

(4)实验四:增加ASPC模块数量,替代VGG16框架的前6层普通卷积,为了验证小尺寸特征图不适宜使用空洞率较大的空洞卷积。

表2 消融实验结果

Tab.2 Results of ablation experiment

算法平均交并比(mIoU)单图处理用时(Time)实验一74.9576 ms实验二74.0364 ms实验三67.9758 ms实验四71.7284 msOurnet78.6268 ms

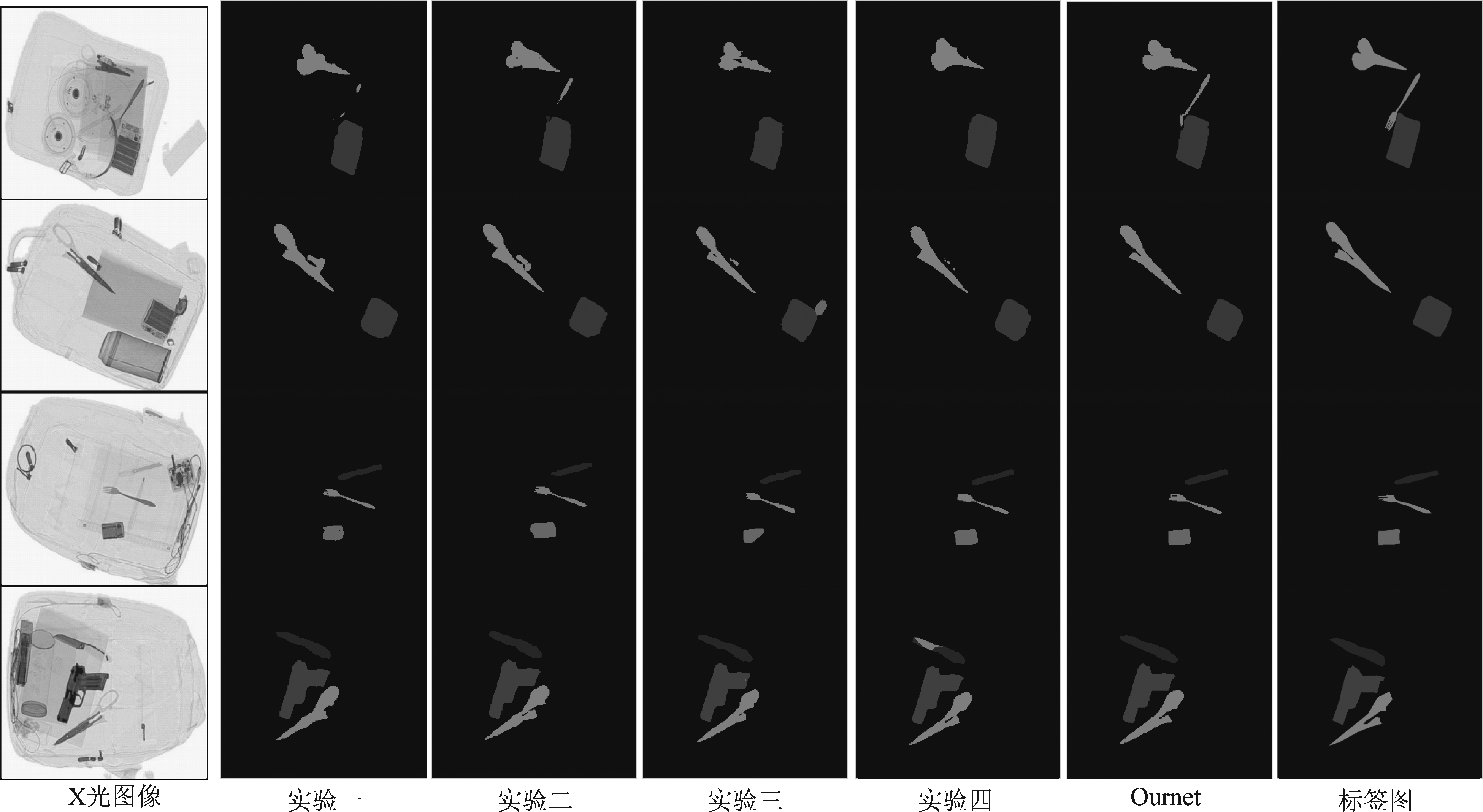

对比表2中实验一和Ournet的结果可知,增加注意力模块的边线支路可以提升最终的分割精细度(上升4.9%)。实验二中该模型的mIoU指标得分是74.03,相较于Ournet同比下降了5.8%,分割结果与实验一相近。实验三中取消ASPC模块,mIoU指标得分67.97,且存在部分的误检现象。实验四中包含6个ASPC模块, mIoU为71.72,整体下降了8.8%。实验三和四也共同反映了VGG16浅层卷积操作被ASPC模块取代时,ASPC层次过少则效果不明显,过多的层次则会出现较大空洞率的卷积造成真实语义信息没有被充分利用,导致小尺寸目标的分割精细度变差,故取四层的效果更好。综合上述消融实验结果可得,针对多目标违禁品识别任务,本文提出的算法结构设计合理有效。

图6 消融实验分割结果

Fig.6 The segmentation results of ablation experiment

4 结论

针对多目标安检违禁品识别问题,本文提出了一种基于语义分割技术的识别算法。该算法设计了空洞空间金字塔卷积模块ASPC,并用于浅层语义信息的多尺度挖掘,提升编码环节的特征提取能力。其次引入注意力机制监督ASPC模块的特征提取过程,间接改善算法的最终分割精细度。最后,本文在下采样阶段使用1×1卷积降低特征图维度,减少模型后续计算量,提高了运行速度。第三章的对比实验结果表明,传统的语义分割算法直接用于处理多目标安检图像,其分割效果及运行速度都不理想,而本文算法在尺寸不一且目标多样化的违禁品识别过程中具有良好的分割表现(mIoU得分为78.62,Time为68 ms)。此外,本文算法采用的backbone为VGG16,相比于resnet深层网络,其参数量更少,为后期安检图像实时性语义分割研究做了基础铺垫。希望本文的工作能够促进智能化安检的发展,给后来的研究人员以启发。

[1] Mery D, Svec E, Arias M, et al. Modern Computer Vision Techniques for X-Ray Testing in Baggage Inspection[C]∥Systems Man and Cybernetics, 2017: 682- 692.

[2] Roomi M, Rajashankarii R. Detection of Concealed Weapons in X-ray Images Using Fuzzy k-nn[J]. International Journal of Computer Science, Engineering and Information Technology, 2012, 2 (2): 187-196.

[3] Turcsany D, Mouton A, Breckon T P. Improving Feature-based Object Recognition for X-ray Baggage Security Screening using Primed Visual Words[C]∥ICIT, 2013: 1140-1145.

[4] Akcay S, Kundegorski M E, Willcocks C G, et al. Using Deep Convolutional Neural Network Architectures for Object Classification and Detection within X-ray Baggage Security Imagery[J]. IEEE Transactions on Information Forensics and Security, 2018, 13(9): 2203-2215.

[5] Liu J, Leng X, Liu Y, et al. Deep Convolutional Neural Network Based Object Detector for X-Ray Baggage Security Imagery[C]∥International Conference on Tools with Artificial Intelligence, 2019: 1-5.

[6] Long J, Shelhamer E, Darrell T. Fully Convolutional Networks for Semantic Segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2014: 640- 651.

[7] Xu M, Zhang H, Yang J, et al. Prohibited Item Detection in Airport X-Ray Security Images via Attention Mechanism Based CNN[C]∥Chinese Conference on Pattern Recognition, 2018: 429- 439.

[8] An J, Zhang H, Zhu Y, et al. Semantic Segmentation for Prohibited Items in Baggage Inspection[C]∥International Conference on Intelligent Science and Big Data Engineering, 2019: 495-505.

[9] Ronneberger O, Fischer P, Brox T. U-Net: Convolutional Networks for Biomedical Image Segmentation[C]∥Medical Image Computing and Computer-Assisted Intervention(MICCAI), 2015: 234-241.

[10] Lin M, Chen Q, Yan S, et al. Network In Network[C]∥International Conference on Learning Representations, 2014: 1-10.

[11] Szegedy C, Liu W, Jia Y, et al. Going Deeper with Convolutions[C]∥Computer Vision and Pattern Recognition, 2015: 1-9.

[12] Chen L, Papandreou G, Schroff F, et al. Rethinking Atrous Convolution for Semantic Image Segmentation[J]. arXiv: Computer Vision and Pattern Recognition, 2017: 1-14.

[13] Li H, Xiong P, An J, et al. Pyramid Attention Network for Semantic Segmentation[J]. arXiv: Computer Vision and Pattern Recognition, 2018: 1-13.

[14] Zeiler M D, Fergus R. Visualizing and Understanding Convolutional Networks[C]∥European Conference on Computer Vision, 2014: 818- 833.

[15] Huang G, Liu Z, Der Maaten L V, et al. Densely Connected Convolutional Networks[C]∥Computer Vision and Pattern Recognition, 2017: 2261-2269.

[16] Zhao H, Shi J, Qi X, et al. Pyramid Scene Parsing Network[C]∥Computer Vision and Pattern Recognition, 2017: 6230- 6239.