1 引言

人体动作识别在智能视频监控、人机交互、视频检索和虚拟现实等方面都有广泛的应用前景[1],因此受到了越来越多研究者的重视。通常人体动作识别有3D骨骼点序列、深度图、红外数据、RGB和光流这几种输入模态,对应不同的输入模态有各自的研究方法。其中RGB视频最易获取,容易被应用于实际场景中,因此这方面的研究较多。但基于RGB视频的动作识别有很多难点,比如其过多地依赖场景信息,受光照变化、背景杂波和物体遮挡的影响严重,传统算法在此方面的识别效果较差。

近年来,随着深度学习的兴起,深度卷积神经网络在计算机视觉,自然语言处理等领域均得到广泛应用。研究发现,深度卷积神经网络可以表示复杂非线性的函数关系,与传统手工提取特征的方式相比,它能进行更抽象的特征描述,因此卷积神经网络(Convolutional Neural Network, CNN)模型在图像分类任务中取得了良好的识别结果。与静态的图像相比,视频序列不仅包含二维的空间信息还包含时序信息,因此直接将二维卷积神经网络应用于基于视频的人体动作识别具有一定局限性。

为了更好地捕获长时序的运动信息,本文提出了基于语义特征立方体切片的人体动作识别模型,利用特征图立方体的多维度切片来建模人体动作的时空特征。同时设计了特征融合模块融合多维度切片的特征,并对其使用KaiMing初始化方式,加快了模型的训练过程。该模型挖掘了更多视频中的时序信息,从而提高了动作识别的准确率。

2 相关工作

2.1 人体动作识别的典型模型

基于CNN的人体动作识别主要有两大类模型。

其一是双流卷积神经网络模型[2],它在网络结构上分为两个通道,一个是空间流卷积神经网络,其输入是从视频中提取的单帧RGB图,用于提取空间信息;另一个是时间流卷积神经网络,其输入是由两张RGB图片经计算得到的光流图片,用于提取时间信息。Christoph等人[3-4]在双流网络的基础上探究两个通道的残差连接方式,以实现两个通道间的信息交互。Wang等[5-6]对视频进行稀疏采样,提出了时序分割网络(Temporal Segment Networks,TSN)。Rohit等人[7]采用局部聚合动作描述符来融合时间流和空间流的动作特征。Kwon H等[8]通过长时序融合池化操作将帧级别的特征转化为人体动作的视频级表示。文献[9]通过密集连接块实现双流网络表观和运动特征的交互,并且采用知识蒸馏模块融合时空特征。文献[10]用ResNeXt构建空间流网络,用TVnet进行光流估计并堆叠BN-Inception形成时间流网络,从而构建了端到端的时空双流融合网络。基于双流的人体动作识别模型虽然网络结构较简单,但需要先提取光流序列,用于在线视频理解时有一定困难。

动作识别的另一个模型是3D卷积神经网络模型[11-12],它是用3D卷积核作用于时序上连续几帧的一个区域,从而建模动作的时序信息。文献[13]将二维的Inception骨干网络改为3D形式进行动作识别,文献[14]则以残差结构为基础构造了多种3D卷积网络,均取得不错的识别结果。但是3D-CNN的缺点是网络参数量大,计算成本高,网络不易收敛[6,15]。

不管是双流网络的光流通道,还是3D-CNN的第三个维度,其核心思想都是在更好的提取时序信息。

2.2 基于切片操作的视频处理方式

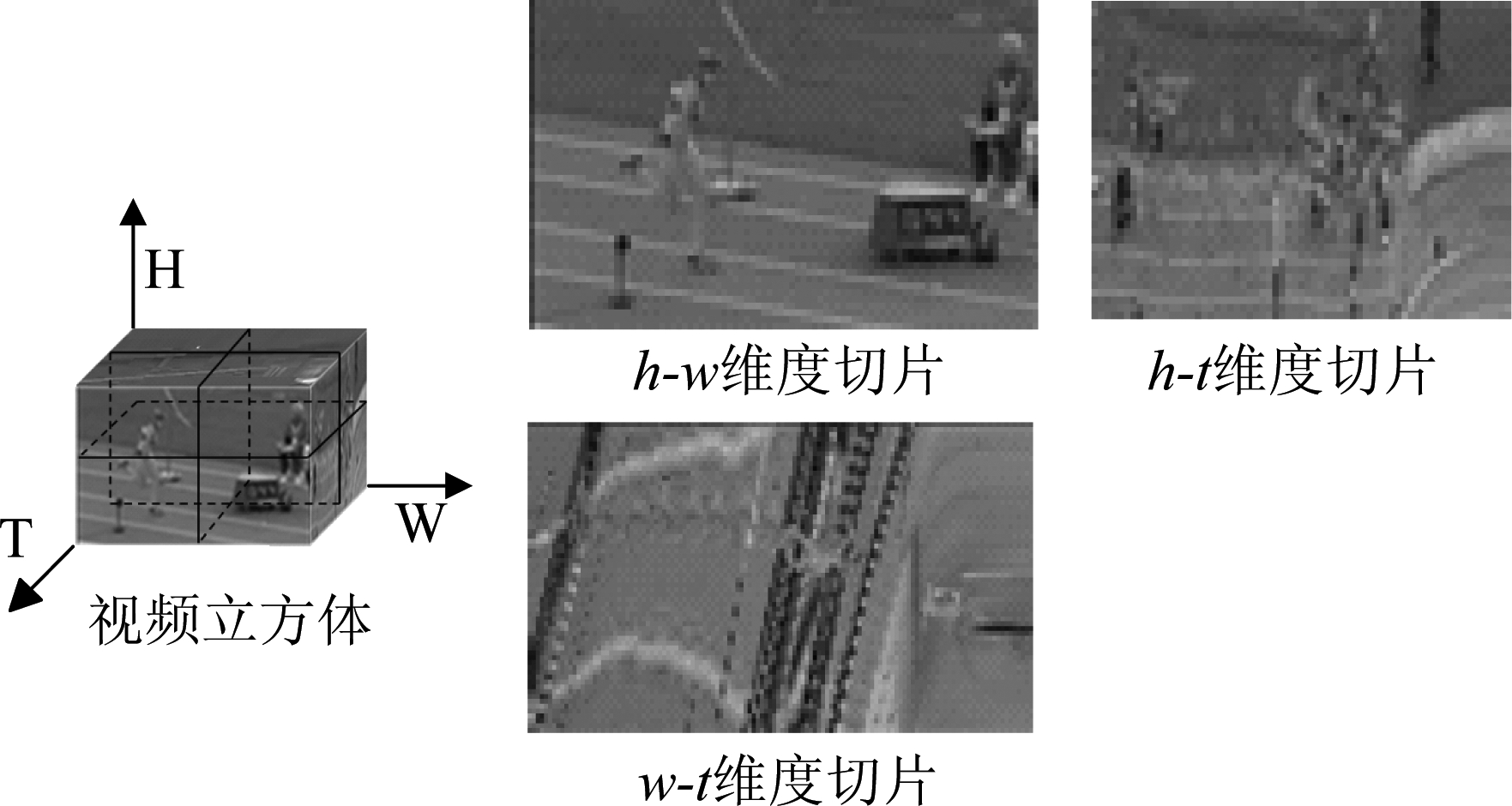

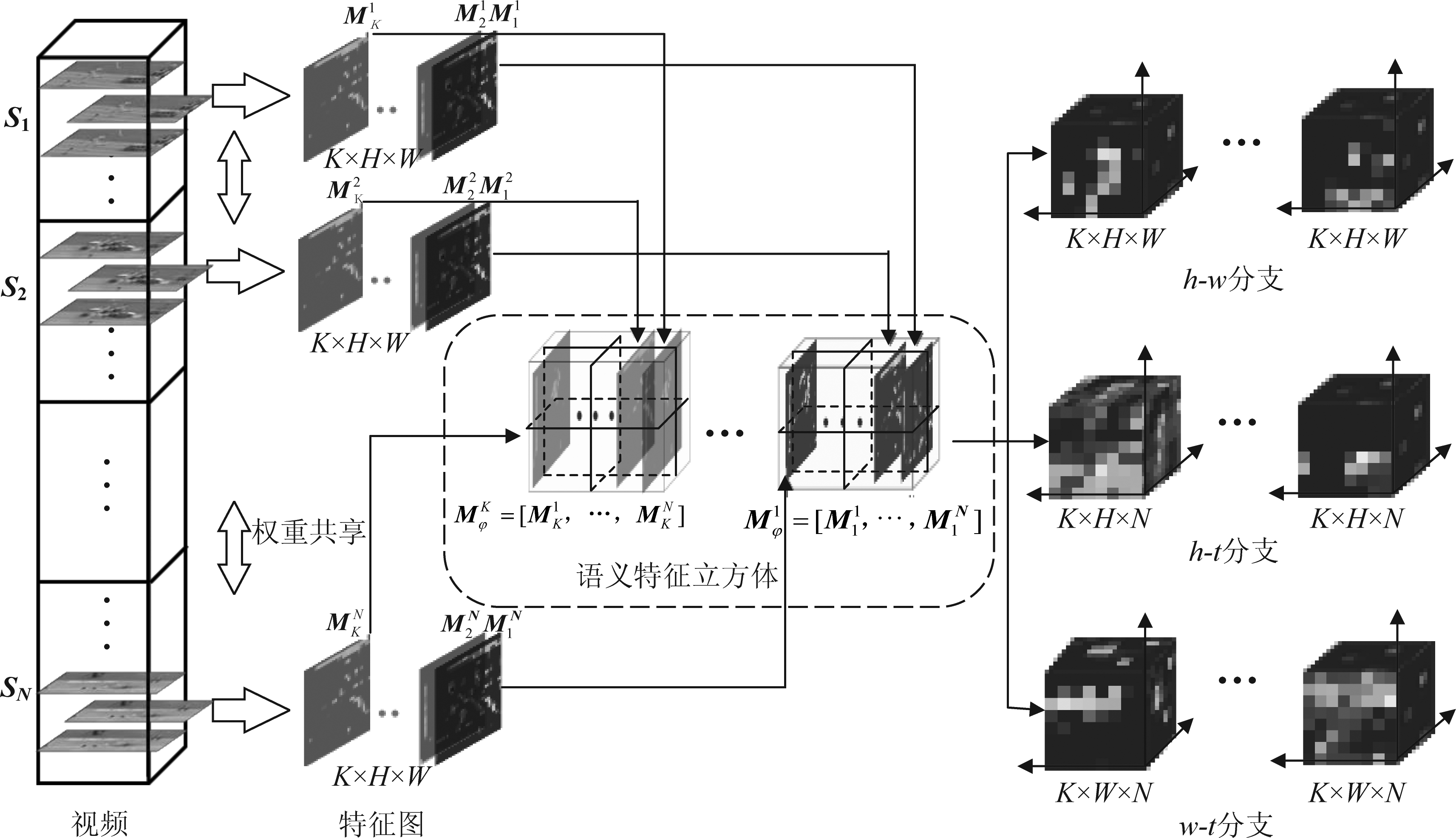

一般来讲,视频是通过在时间维度上提取成一帧帧的图片处理的,这些图片在时序上堆叠,可以看作是时空中的立方体,通常送入网络的是h-w维度的切片,如图1所示,而先前的研究表明,另外两个h-t和w-t维度的切片也可以提取到动作的表观和运动特征[16-17]。不同于h-w维度的图只包含空间上的表观信息,h-t和w-t维度的图片拥有整个视频完整时序序列的信息,尽管这两个维度的图片比较抽象,只可以隐约观察到运动的轨迹,但后续的实验可以证明它们包含丰富的运动信息并有助于提高识别效果。然而这样直接对视频做三个维度切片处理的方法,非常受限于切片的位置,随机的切片可能只涉及背景信息而非运动目标。

图1 视频立方体及在三个维度的切片图

Fig.1 Video volume and its slices of three views

针对此问题,受文献[15]在研究人群属性识别时所用方法的启发,提出了基于语义特征立方体切片的人体动作识别方法,与直接对视频数据进行切片处理的方法相比,由深度卷积神经网络得到的特征立方体聚合了视频中更多有效信息,一定程度上滤除了与识别结果无关的背景信息,因此对其进行切片可以有效获取动作的时序信息。然而文献[15]将每个维度的切片直接拼接,并转化为一维特征向量送入到全连接层,这样简单的拼接无法很好的融合三个分支的特征,而且将所有特征图直接展开为一维向量送入到全连接层还会大大增加了网络的参数量。本文改进后设计了一个时空特征融合模块来更好的融合h-w,h-t和w-t三个维度切片后的特征图,并可以学习到三个分支的权重分配,从而实现了网络的端到端训练。

3 基于语义特征立方体切片的人体动作识别网络设计

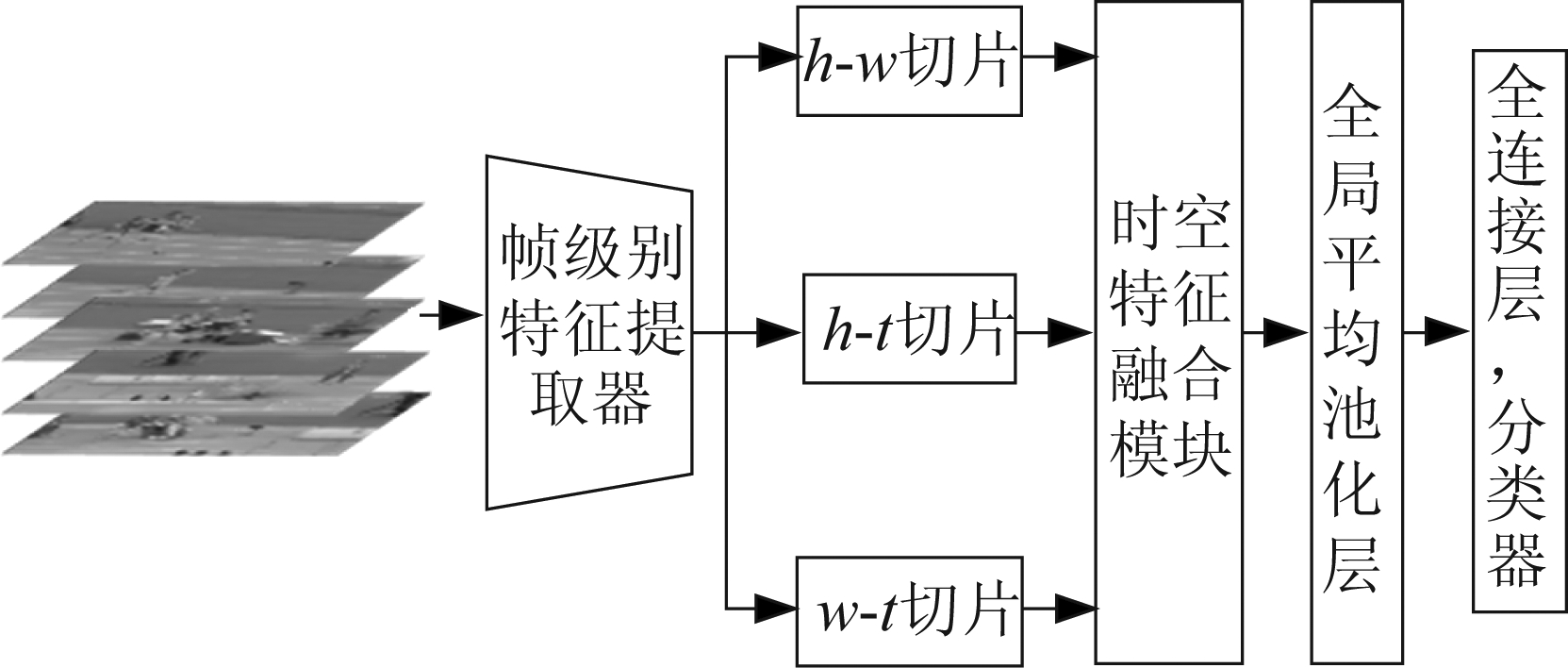

本文提出的网络模型主要由三个部分组成,如图2所示。通过骨干网络初步提取视频序列中的动作信息,将得到的语义特征立方体在三个维度上切片并进行深层次的时空特征提取,然后融合三个分支的特征,并采用softmax分类器得到视频动作的分类结果。

图2 整体网络框架图

Fig.2 The architecture of the network

3.1 帧级别特征提取器

假设一个任意输入视频序列V,根据文献[5]TSN网络中对视频的处理方式,将其在时序上等比例地分割为N个片段,从N个片段中随机抽取一帧图片,则网络模型的输入表示为{T1,T2,…,TN}。由于一个视频相邻帧之间的信息十分相近,这种稀疏采样的方式有助于去除冗余信息,减小输入数据量,并在整个训练过程中尽可能应用到所有的视频帧,有助于提高模型的鲁棒性。

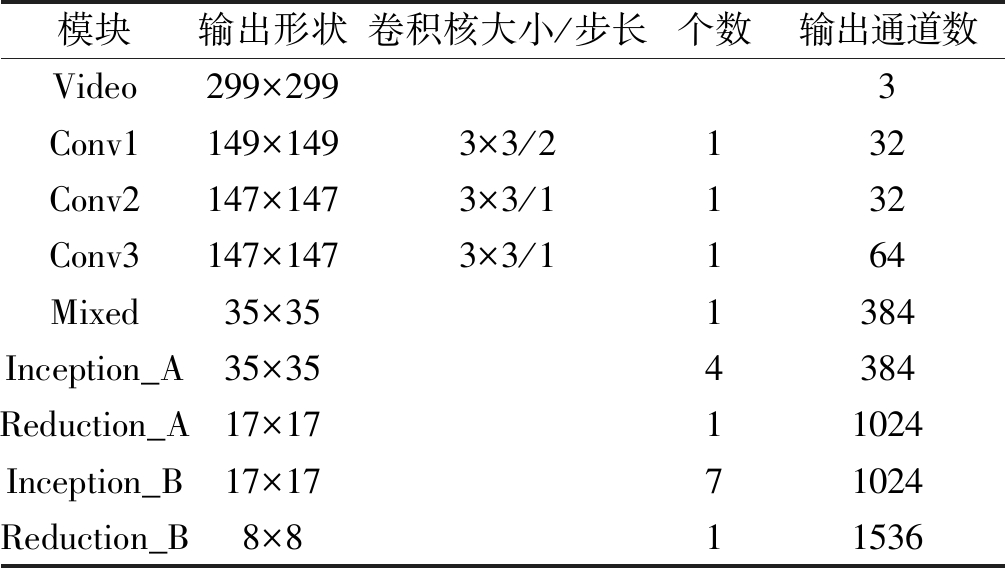

对于稀疏采样后的N个视频帧图片,选用InceptionV4[18]的部分网络进行人体动作表观信息的特征提取,该帧级别特征提取器的网络结构如表1所示,其中输出形状对应于特征图的宽度和高度。InceptionV4沿用了之前的inception思想增加网络宽度,同样使用了BN层,另外采用Inception_A、Inception_B和Inception_C模块,它们在使用中不改变特征图的大小,因此引入专用的缩减块(reduction block)用在inception模块之间实现特征图尺寸的缩减。

表1 帧级别特征提取器网络结构

Tab.1 Frame-level feature extractor

模块输出形状卷积核大小/步长个数输出通道数Video299×2993Conv1149×1493×3/2132Conv2147×1473×3/1132Conv3147×1473×3/1164Mixed35×351384Inception_A35×354384Reduction_A17×1711024Inception_B17×1771024Reduction_B8×811536

3.2 语义特征立方体切片

输入视频经特征提取后得到的特征图只包含空间上的语义信息,为了更好的提取视频中的时序信息,本文提出了语义特征立方体切片模块。如图3所示,时刻t对应的特征图表示为![]() 其构成的特征图立方体大小为K×H×W,其中K为特征图的数量,取决于特征提取器的卷积核的数目,H和W分别是特征图的高和宽。根据文献[19]所述,在深层网络中,每一个卷积核可以提取到图像中一个特定目标的信息,也就是相同通道的特征图对应于一种高级语义信息。因此,将上述特征图按通道重新组合,得到K个语义特征立方体,如第一个通道的特征立方体可表示为

其构成的特征图立方体大小为K×H×W,其中K为特征图的数量,取决于特征提取器的卷积核的数目,H和W分别是特征图的高和宽。根据文献[19]所述,在深层网络中,每一个卷积核可以提取到图像中一个特定目标的信息,也就是相同通道的特征图对应于一种高级语义信息。因此,将上述特征图按通道重新组合,得到K个语义特征立方体,如第一个通道的特征立方体可表示为![]() 其大小为N×H×W。为了方便处理,网络中使用一个自适应池化层使得每个分支的N=H=W。接着将这些特征立方体在h-w,h-t和w-t三个维度进行切片,如图3所示,然后通过转换维度的方式得到三个维度下的特征图立方体,以h-t分支为例,得到W个特征立方体,每个立方体的大小为K×H×N。根据前面的描述,由于N=H=W,因此得到三个分支的特征立方体个数及大小完全相同。并且不难发现,其中h-w分支中的特征立方体主要包括动作的表观信息,而h-t和w-t两个分支中的特征立方体自然地包含人体动作的时序信息,因此语义特征立方体切片的方式有助于动作时序特征的提取。

其大小为N×H×W。为了方便处理,网络中使用一个自适应池化层使得每个分支的N=H=W。接着将这些特征立方体在h-w,h-t和w-t三个维度进行切片,如图3所示,然后通过转换维度的方式得到三个维度下的特征图立方体,以h-t分支为例,得到W个特征立方体,每个立方体的大小为K×H×N。根据前面的描述,由于N=H=W,因此得到三个分支的特征立方体个数及大小完全相同。并且不难发现,其中h-w分支中的特征立方体主要包括动作的表观信息,而h-t和w-t两个分支中的特征立方体自然地包含人体动作的时序信息,因此语义特征立方体切片的方式有助于动作时序特征的提取。

图3 语义特征立方体切片示意图

Fig.3 Sketch map of slicing semantic feature cuboid

语义特征立方体切片之所以在骨干网络的Reduction_B模块之后进行,是因为深层的CNN网络提取的特征具有更好的抽象能力和高级语义信息,可以区分发生动作的不同人体部位,并对形变和物体遮挡具有更好的鲁棒性。

随后采用InceptionV4的3个Inception_C模块学习h-w,h-t和w-t三个分支中每个特征立方体的二维时空特征,并且使用权重共享的方式,不会额外增加网络的参数量。

根据上述描述可知,以InceptionV4作为骨干网络时,此时得到的三个分支的输出均为8×1536×8×8。随后用一个1×1卷积层进行通道降维,使通道数由1536变为384,再将前两个通道串联为一个通道,则输出通道数变为8×384,即每个分支网络的输出为3072×8×8。

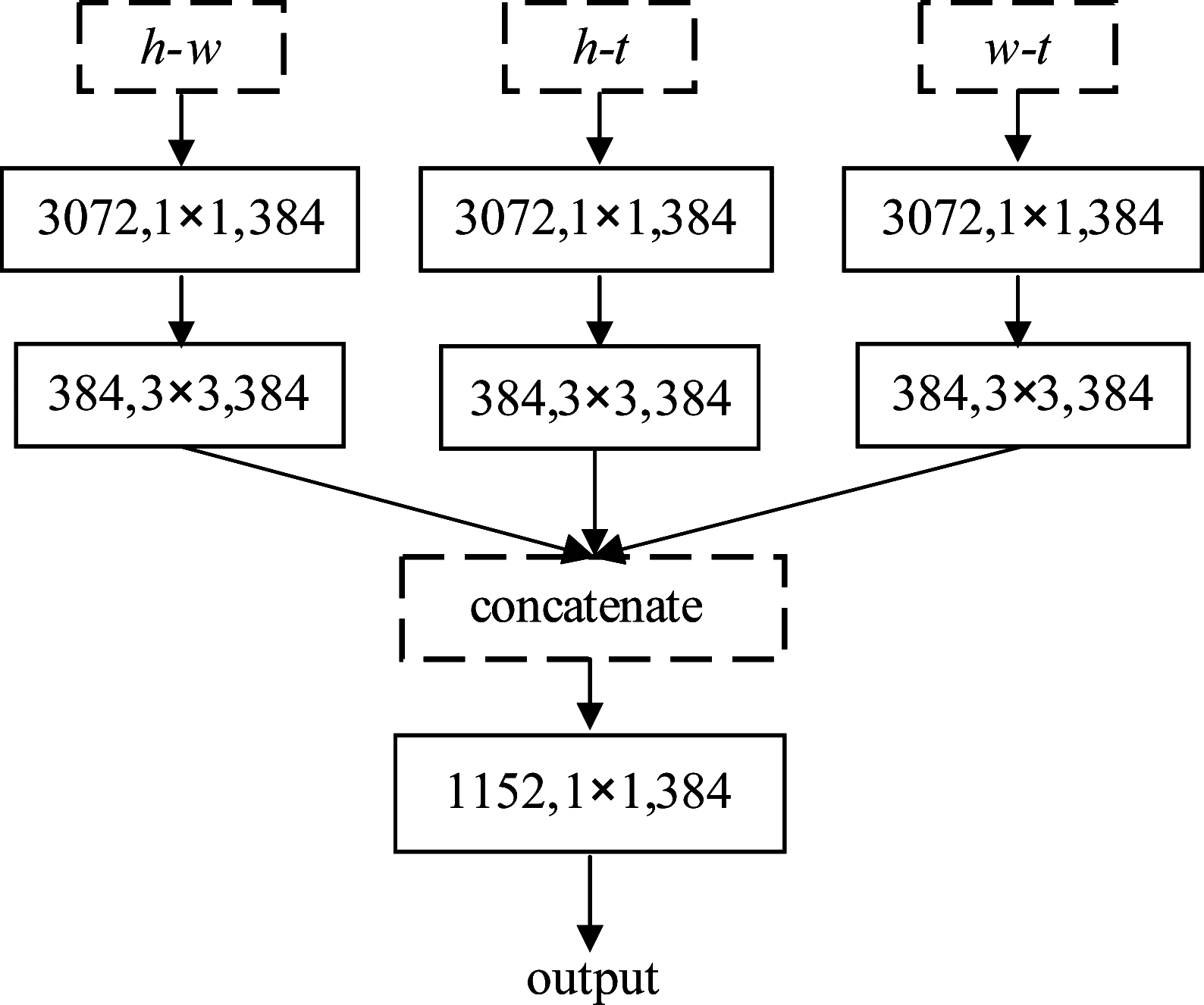

3.3 时空特征融合模块

为了从特征层面对h-w,h-t和w-t三个分支中的时空特征进行融合,设计了一个时空特征融合模块,该模块借鉴了ResNeXt[20]的设计方法,其网络结构如图4所示。首先用1×1的卷积构成每个分支的瓶颈结构,该卷积层有两个作用,其一是进行跨通道的信息交互,由于每一个卷积核是对前一层所有通道的特征图做计算得到一张特征图,以h-t分支为例,1×1卷积融合了上一层多个特征图,使网络学习到通道间的相关信息;其二是限制下一层输入通道的数目,从而降低网络的计算成本。随后用一个不改变通道数目的3×3卷积层提取一张特征图像素间的相关信息,实验证明这种将通道间相关信息和特征图像素间相关信息解耦学习的方式,可以在不影响模型表达能力的情况下大大减少参数数量和计算量。每一个1×1卷积层和3×3卷积层之后都用一个批归一化(Batch Normalize, BN)层[21],使网络层输出的数据仍保持标准正态分布,这样可以大大提高网络的训练速度。同时这些卷积层以ReLU作为非线性激活函数,提高人体动作识别模型的表达能力。

图4 时空特征融合模块

Fig.4 Spatiotemporal feature fusion module

接着利用卷积层融合三个分支的时空特征,函数表达式为yconv=fconv(xa,xb,xc),通过融合三个分支的特征图xa,xb,xc得到输出特征图yconv,经过前面特征提取网络的前向传播可知xa,xb,xc特征图尺寸均为H×W,通道数目均为D,因此首先沿通道维度d在特征图的同一像素点位置i, j级联三个分支的特征图,具体表示为

(1)

其中y∈RH×W×3D。

随后是利用一组卷积核f∈R1×1×3D×D和偏重b∈RD作用于级联后的特征图,表示为

yconv=ycat*f+b

(2)

式(2)可以建模xa,xb,xc特征图的加权求和。单个卷积核f的维度是1×1×3D,即为三个分支的特征图在同一像素点的权重取值。在网络优化的过程中卷积核f会自动得到最佳的权值分配,而不需要设置超参数。因此网络可以协同地学习三个分支的时空特征,同时也将动作的帧级别表示转化为视频级表示。以这种方式,网络实现了人体动作时空特征的端到端学习。

除了卷积融合外,实验中还尝试了以下几种融合方式:

(1)直接级联。与图4相比,该融合方式去掉了最后一层卷积,仅仅对三个分支的特征图进行级联,如式(1)所示,级联后的特征图有3D个通道。

(2)最大值池化。该方式是沿通道d在特征图xa,xb,xc的同一空间位置i, j取最大值,具体表示为:

(3)

其中y∈RH×W×D。

(3)最小值池化。与最大值池化类似,数学表达式为:

(4)

其中y∈RH×W×D。

(4)平均池化。它是沿通道d对特征图xa,xb,xc的同一空间位置i, j求和后取平均,表示为:

(5)

其中y∈RH×W×D。

4 实验与结果分析

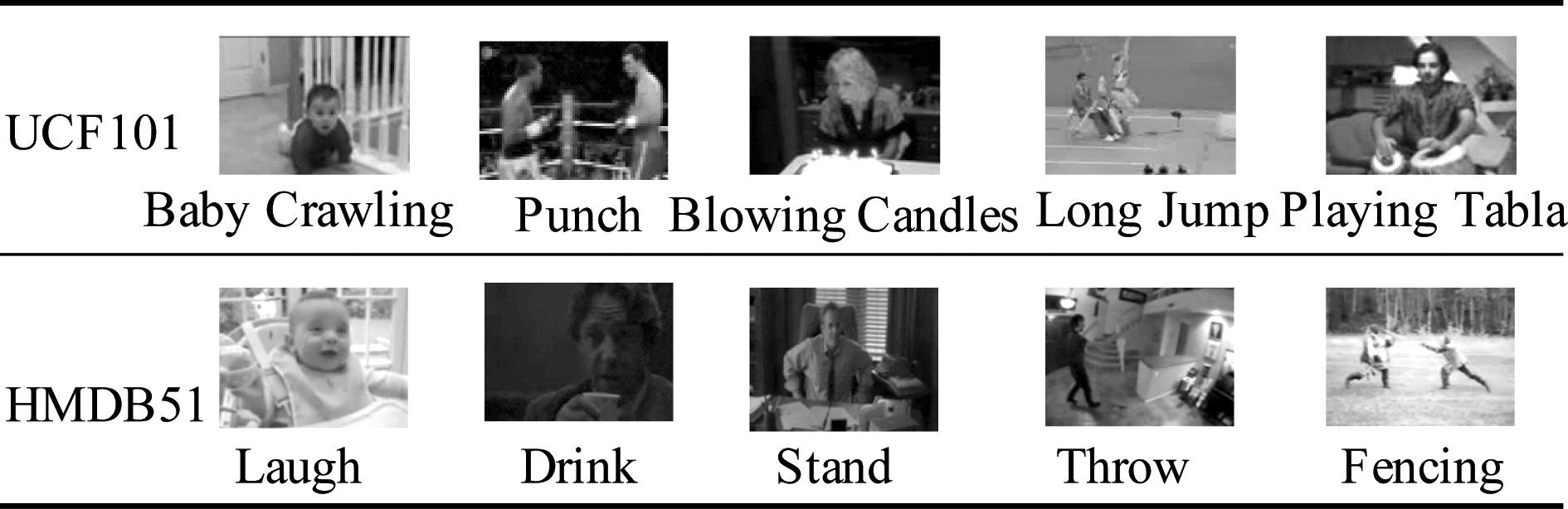

4.1 实验数据集

本文实验采用的是两个典型的人体动作识别数据集:UCF101和HMDB51。UCF101数据集由YouTube收集,共有13320个视频,其中包含101类动作。这些动作可大体分为五个大类:人体动作、人与人互动、人与物体互动、体育运动及乐器演奏,每类动作由25个人完成,每人完成4~7个动作,来自同一人的动作具有一些相同的特征。同时,UCF101数据集的动作具有一定多样性,表现为相机的运动、物体的外观和姿态、物体的比例尺、杂乱的背景及光照条件都有很大的变化,因此是一个具有挑战性的数据集。HMDB51数据集共有6849个视频,视频多来源于商业电影及Google等网络视频库,它代表了各种不同的光照条件和环境,更接近于实际场景。该数据集分为51个动作类别,每个动作类别至少包含101个视频剪辑,这些动作包括面部动作、面部与物体的操作、人的身体动作、人与物体交互动作以及人与人的交互动作。图5针对两个视频数据集中每一大类动作列举一个典型示例图。这两个数据集中的视频分辨率均为320*240。

图5 UCF101和HMDB51数据集中部分动作示例图

Fig.5 Examples of action images in UCF101 and HMDB51

在实验中,数据集中的视频被分为训练集和测试集,比例约为7∶3。UCF101和HMDB51均有三种训练集/测试集分割方式,将人体动作识别模型在三种分割方式下的平均识别准确率作为模型的最终评估标准。

4.2 网络模型训练4.2.1 模型初始化

将上述设计的网络模型应用于人体动作识别中,同时使用了不同的网络输入模态来提高模型的识别效果。具体来讲,输入数据除了有从视频中直接提取的RGB图像帧以外,还有由RGB图像计算得到的光流数据。另外卷积神经网络在训练时,为提高网络的收敛速度通常会赋予初始化权重,本文的初始化方案分为以下两个部分。

其一是骨干网络的初始化。以InceptionV4作为特征提取的骨干网络,对于RGB数据,加载其在ImageNet上的预训练模型作为初始化权重。ImageNet数据集是目前最大的图像分类数据集,对它进行预训练得到的网络模型可以描述图像颜色、轮廓和纹理等表观特征,且具有较好的泛化能力。以这样的预训练模型作为特征提取的初始化权重有助于加快网络的训练速度。当输入为光流数据时,其初始化方式参考了TSN网络中提到的方法,将光流序列离散到0~255区间,对RGB三个通道的模型权重取平均作为光流每一通道的预训练权重,这样可以有效减少训练中的过拟合现象。

其次是时空特征融合模块的初始化。该模块采用了Conv-BN-ReLU的网络结构,不同于tanh等关于0对称的激活函数采用Xavier[22]初始化方式,ReLU函数在负半轴值为0,因此本文采用了专门针对ReLU函数的Kaiming[23]初始化方式。由于在网络传播过程中,激活值的方差逐层递减,这使得反向传播的梯度也逐层递减,为了避免梯度消失的问题,Kaiming初始化要求正向传播时状态值的方差保持不变。对于任意第l层卷积层,其输出响应表示为:

yl=Wlxl+bl

(6)

其中x表示卷积层的输入,W和b分别为卷积的权重和偏重,y是卷积的输出。Kaiming初始化的条件是:

![]() nlVar[wl]=1

nlVar[wl]=1

(7)

其中nl表示输入的神经元个数,wl为单个卷积核的权重,这表示初始化的权重应满足均值为0,方差为![]() 的高斯分布。

的高斯分布。

4.2.2 损失函数

网络模型在正向传播时,第i个样本对于第k个类型的判别分数为sk,经softmax分类器其输出为

(8)

训练中采用交叉熵损失函数,表示为

(9)

其中y是真实的标签,N为样本总数,K为总类别数。

4.3 实验设置

实验所用操作系统为Ubuntu16.04,使用Pytorch深度学习框架,设置3个GTX 2080 Ti GPU并行训练人体动作识别模型。本文优化算法采用小批量的随机梯度下降(mini-batch stochastic gradient descent),批处理的大小(batchsize)设置为12,动量值设为0.9,初始的学习率为10-3。实验中设置最多训练80轮,当迭代训练40轮时,将学习率降为10-4,迭代训练到60轮时,学习率降为10-5。实验中由于硬件条件限制,batchsize设置的较小,因此采取每4个批次进行一次参数更新的训练策略,这样做有助于加快模型收敛。

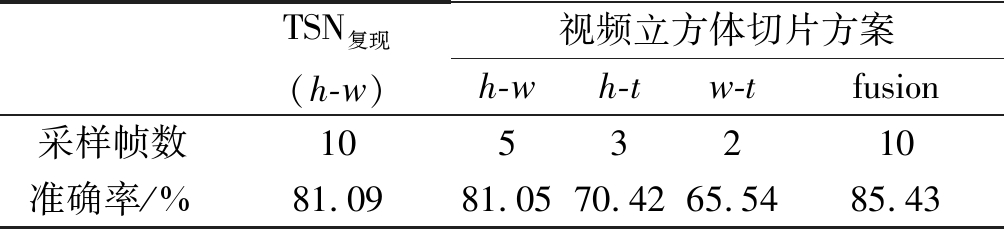

首先以UCF101的第一种分割方式的数据(split 1)作为实验训练集和测试集,按图1所示方法,直接从视频中分别提取h-w,h-t和w-t三个维度的切片5、3、2帧,并参照TSN网络的实验设置,以RGB作为输入数据,以BNInception作为骨干网络分别训练三个动作识别模型,按三个模型的识别准确率作为置信度进行决策融合,即对测试集中视频的最终判别分数向量为:

S=a1·Shw+a2·Sht+a3·Swt

(10)

其中Shw,Sht,Swt是分别以h-w,h-t和w-t维度的视频帧作为输入时模型的判别分数,a1,a2,a3为单个模型的识别准确率,这里分别取0.81,0.7和0.66,由此得到最终的识别准确率如表2所示。在其他条件不变的前提下,与只沿时间维度提取同样帧数的RGB图作为输入相比,其准确率有显著提升。这说明,对视频在三种维度上进行切片的处理方式确实提取到了更多人体动作的信息。

表2 基于视频立方体切片的实验结果

Tab.2 Results based on slicing video volume

TSN复现(h-w)视频立方体切片方案h-wh-tw-tfusion采样帧数1053210准确率/%81.0981.0570.4265.5485.43

上述实验证实了在三个维度进行切片的视频处理方式对人体动作识别有一定的效果。受此启发,本文的核心方案是以Inception-V4作为骨干网络,并对特征提取后的语义特征立方体进行逐像素的切片处理。按文中3.3所述,表3比较了时空融合模块的不同融合方式对实验的影响。

表3 时空特征融合模块不同融合方式的实验结果对比

Tab.3 Comparison of different fusion methods of spatiotemporal feature fusion module

融合方式参数量准确率/%直接级联49.4M83.2最大值池化49.3M82.3最小值池化49.3M80.1平均池化49.3M81.8卷积融合49.7M85.5

其中最大值/最小值池化和平均池化都不引入额外的参数,所以这三种方式参数量最小。平均池化相当于以1∶1∶1的比例融合三个分支的特征,但其准确率较低,这说明了三个分支的特征对识别结果的贡献不同。直接级联的融合方式得到特征的通道数是池化的3倍,因此参数量更多。卷积融合的方式参数量比其他几种的稍多,但识别准确率最高,由此证明了通过网络去学习三个分支时空特征的权重分配更为合理。

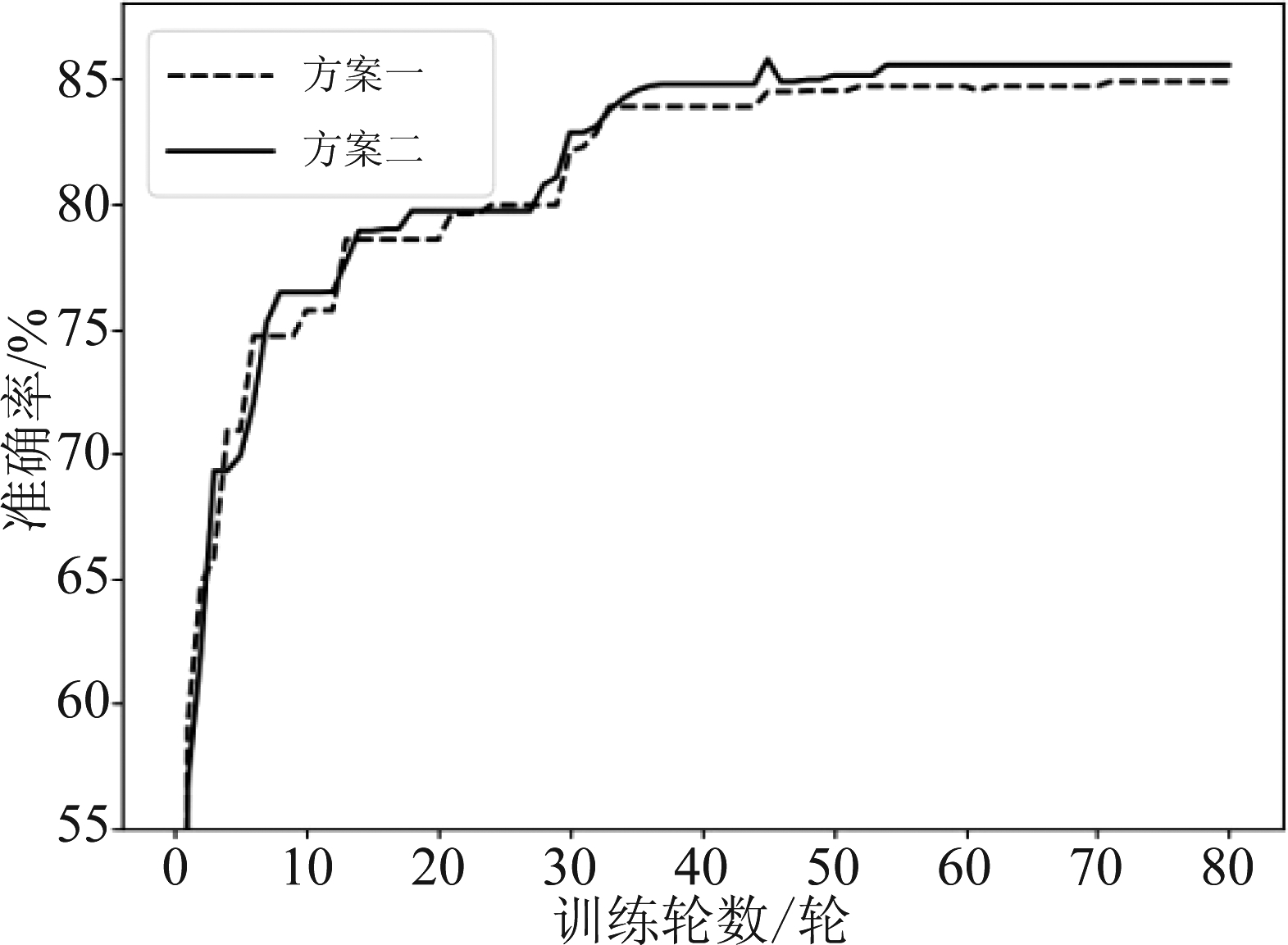

图6直观展示了时空特征融合模块的两种不同初始化方式对实验的影响。方案一网络结构如图4所示,仅使用卷积层并用Xavier方式对其初始化,方案二则在所有卷积层后面加入BN层,以ReLU函数作为网络层的激活函数,并采用了Kaiming初始化方式。实验中每训练一轮,对模型进行一次验证,图6展示的是模型在验证时的识别准确率。从图中不难发现,方案二(图中实线)仅用55轮就得到了最优模型,说明BN层的添加确实加快了网络的收敛速度,另外方案二的ReLU函数增加了网络的非线性,并匹配使用了合适的初始化方式,使人体动作识别的准确率与方案一(图中虚线)相比有所提高。

图6 时空特征融合模块不同初始化方式的验证结果对比

Fig.6 Comparison of different initialization methods of spatiotemporal feature fusion module

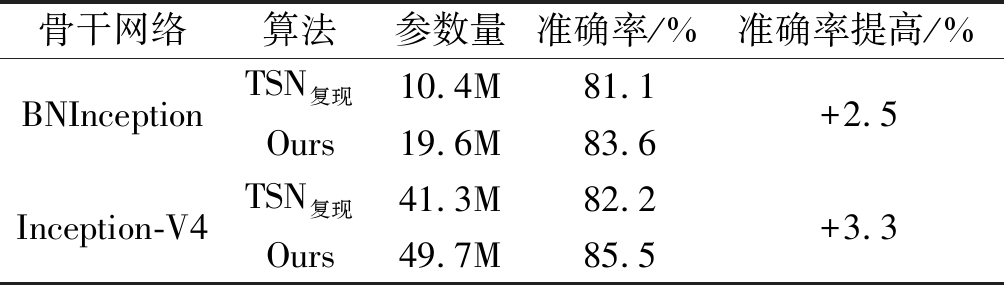

4.4 实验结果分析

本文以TSN网络模型为基准进行改进,其中特征立方体切片模块只涉及维度转换,并不增加多余的网络结构,而时空特征融合模块结构较简单且添加在骨干网络的末尾。表4是以8帧RGB图片作为输入,比较了TSN网络和本文所提模型的网络参数量及在UCF101数据集(split 1)上的识别准确率。当以BNInception作为骨干网络时,特征立方体切片及融合模块放在Inception_5B模块之后。可以发现,在骨干网络相同的情况下,本文模型没有明显增加网络参数量,但识别准确率有了显著提升。

表4 TSN网络与本文网络的识别准确率及参数量对比

Tab.4 Comparison of action recognition accuracy and parameters between TSN and our model

骨干网络算法参数量准确率/%准确率提高/%BNInceptionTSN复现10.4M81.1Ours19.6M83.6+2.5Inception-V4TSN复现41.3M82.2Ours49.7M85.5+3.3

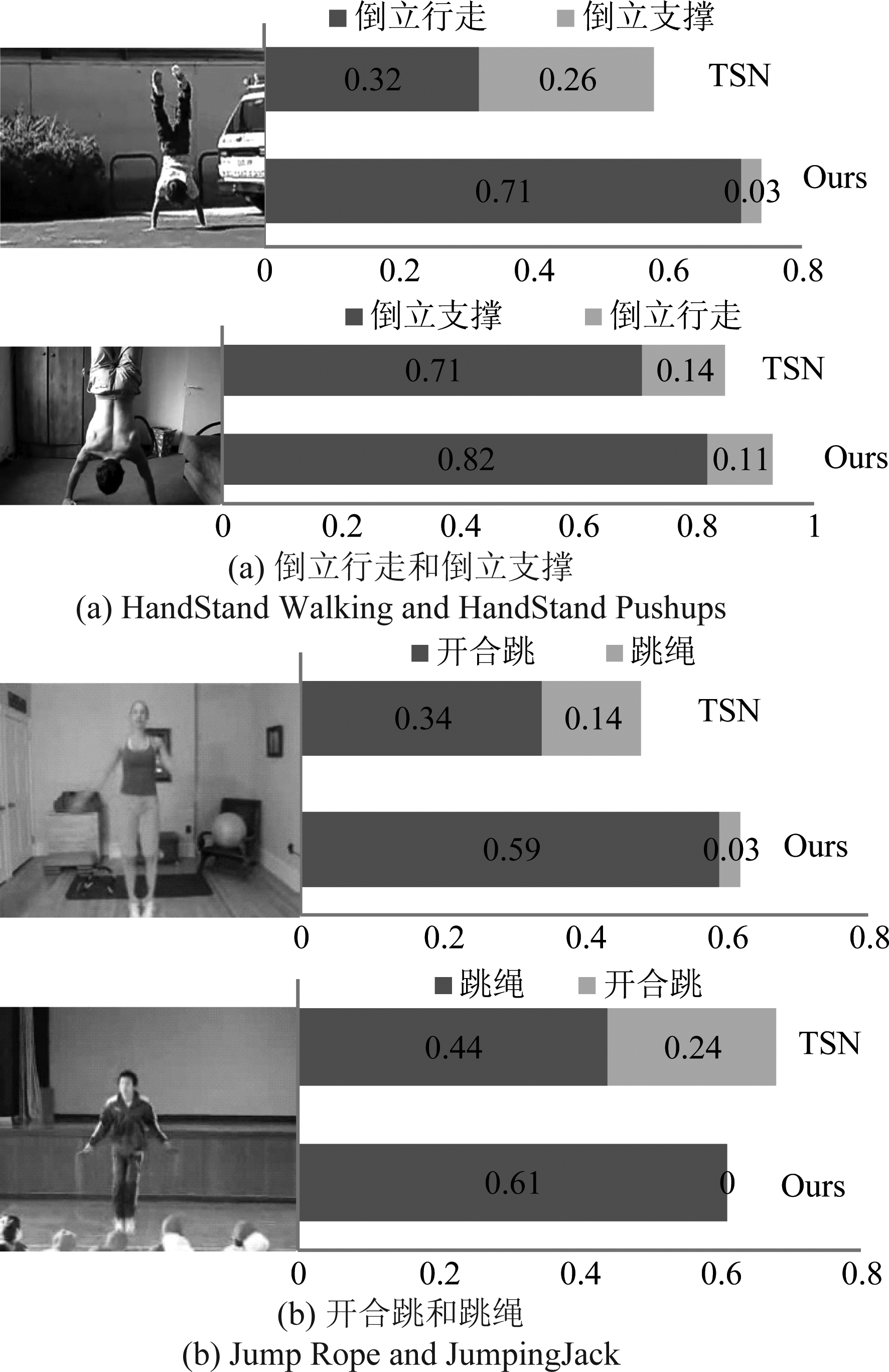

图7 两组易混淆动作的识别结果对比

Fig.7 Comparison of recognition results of two groups of easily confused actions

图7比较了TSN网络和本文网络模型对两组易混淆动作的识别结果,其中(a)倒立行走和倒立支撑为一组,(b)开合跳和跳绳为一组,深色为动作的真实标签,浅色为被误判的动作类别。以图7(a)的倒立行走动作为例,TSN网络将该动作识别正确的概率为32%,识别为相近的倒立撑动作的概率为26%,而本文网络模型几乎不会将其识别为倒立支撑。从表观信息来看这两个动作较为相似,TSN网络易将二者混淆,而本文网络模型由于学习到了更多的时序信息,使两个动作的特征类间分离,从运动信息上区分开这一组易混淆动作,提高了人体动作识别的准确率。另一组(b)开合跳和跳绳动作同理,这说明对语义特征立方体的切片操作确实提取到了更多的人体动作信息,尤其是时序上的信息。

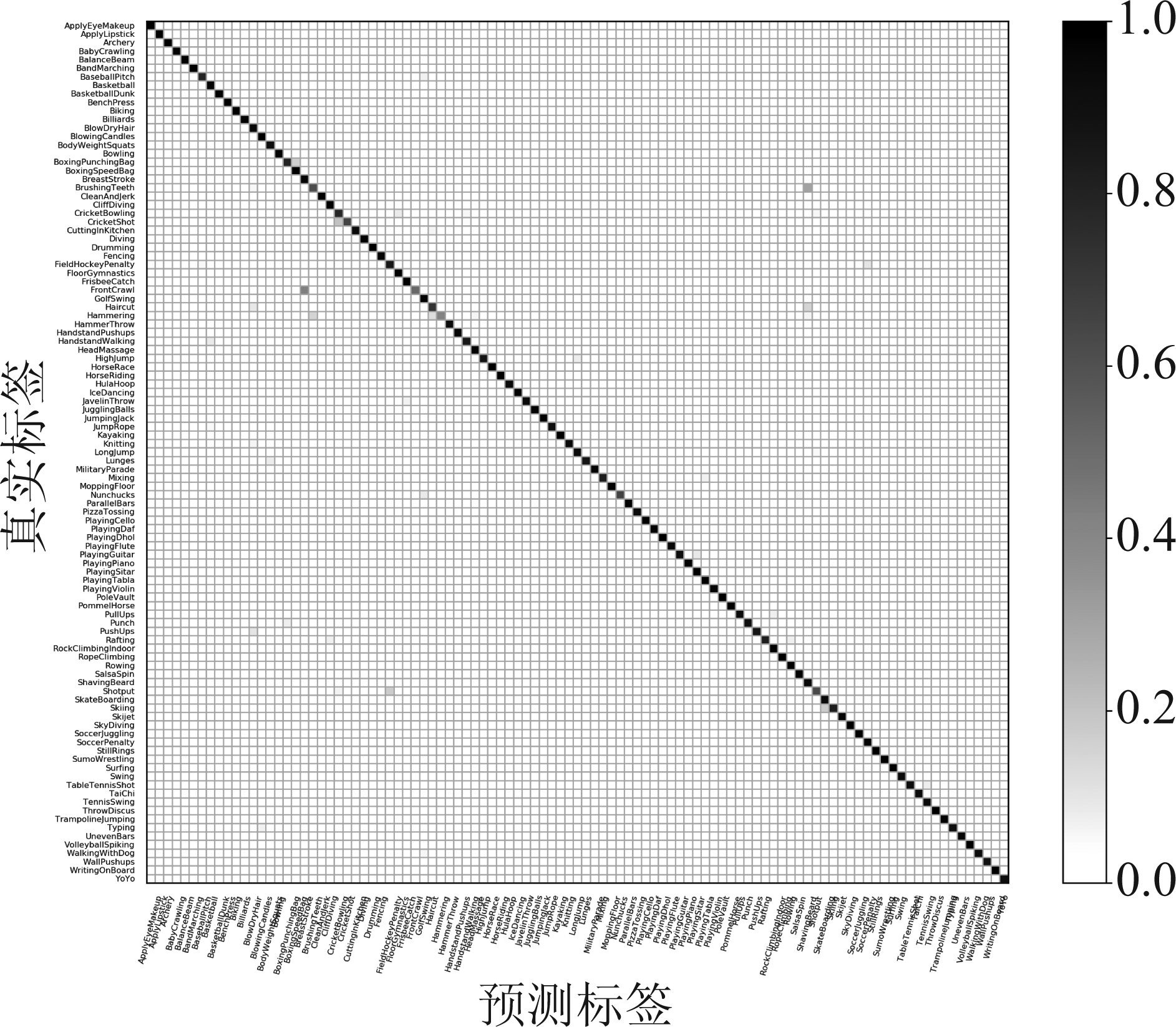

最后以RGB和光流分别作为动作识别模型的输入数据进行训练,两个模型以1∶1的比例进行决策层融合,得到最终的动作识别结果,模型对UCF101数据集(split 1)各个类别的识别结果混淆矩阵如图8所示,横轴为网络预测的人体动作的类别标签,纵轴为101类真实标签,斜对角线上类交叉块的位置表示识别正确,其颜色越深表示模型对该类别的样本识别准确率越高。

图8 UCF101数据集(split 1)动作识别结果混淆矩阵

Fig.8 The Confusion Matrix of action recognition on UCF101 dataset(split 1)

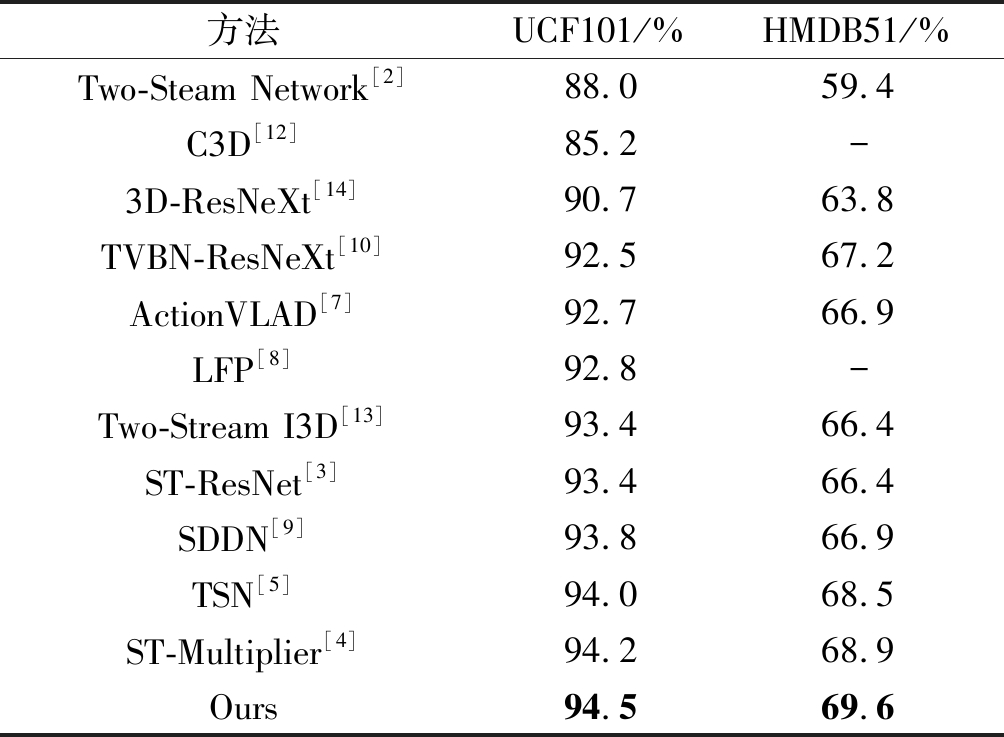

以RGB和光流作为输入数据,模型在UCF101和HMDB51数据集三种不同分割方式下的平均识别准确率如表5所示,说明本文模型的识别准确率相比于其他双流网络和3D卷积神经网络都有一定优势,验证了该方法的有效性。

表5 不同模型的人体动作识别准确率对比

Tab.5 Action recognition accuracy comparison of different models

方法UCF101/%HMDB51/%Two-Steam Network[2]88.059.4C3D[12]85.2-3D-ResNeXt[14]90.763.8TVBN-ResNeXt[10]92.567.2ActionVLAD[7]92.766.9LFP[8]92.8-Two-Stream I3D[13]93.466.4ST-ResNet[3]93.466.4SDDN[9]93.866.9TSN[5]94.068.5ST-Multiplier[4]94.268.9Ours94.569.6

5 结论

本文针对人体动作识别中难以捕获长时间运动信息的问题,提出了基于语义特征立方体切片的方法,提取高层语义信息中人体动作的时序特征,并设计时空特征融合模块,实现了网络的端到端学习。本文设计的模型在公开数据集UCF101和HMDB51上进行实验,均取得了较好的识别效果,验证了本文方法对人体动作识别的有效性。实验中由于条件限制,本文的骨干网络只加载了在ImageNet数据集上的预训练模型,若选用在大型人体动作视频数据集Kinetics上的预训练模型,还可以进一步提高人体动作识别的准确率。

[1] 朱红蕾, 朱昶胜, 徐志刚. 人体行为识别数据集研究进展[J]. 自动化学报, 2018, 44(6): 978-1004.

Zhu Honglei, Zhu Changsheng, Xu Zhigang. Research Advances on Human Activity Recognition Datasets[J]. Acta Automatica Sinica, 2018, 44(6): 978-1004.(in Chinese)

[2] Simonyan K, Zisserman A. Two-stream convolutional networks for action recognition in videos[J]. Advances in Neural Information Processing Systems, 2014, 1(4): 568-576.

[3] Feichtenhofer C, Pinz A, Wildes R P. Spatiotemporal Residual Networks for Video Action Recognition[J]. Advances in Neural Information Processing Systems, 2016, 0: 3476-3484.

[4] Feichtenhofer C, Pinz A, Wildes R P. Spatiotemporal Multiplier Networks for Video Action Recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Honolulu: IEEE Press, 2017: 7445-7454.

[5] Wang L, Xiong Y, Wang Z, et al. Temporal segment networks: towards good practices for deep action recognition[C]∥European Conference on Computer Vision(ECCV). Cham: Springer Press, 2016: 20-36.

[6] Wang L, Xiong Y, Wang Z, et al. Temporal Segment Networks for Action Recognition in Videos[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2019, 41(11): 2740-2755.

[7] Girdhar R, Ramanan D, Gupta A, et al. ActionVLAD: Learning spatio-temporal aggregation for action classification[C]∥IEEE Conference on Computer Vision & Pattern Recognition(CVPR). Honolulu: IEEE Press, 2017: 3165-3174.

[8] Kwon H, Kim Y, Lee J S, et al. First Person Action Recognition via Two-stream ConvNet with Long-term Fusion Pooling[J]. Pattern Recognition Letters, 2018, 112: 161-167.

[9] Hao W, Zhang Z. Spatiotemporal distilled dense-connectivity network for video action recognition[J]. Pattern Recognition Letters, 2019, 92: 13-24.

[10] 胡正平, 张瑞雪, 张璇, 等. TVBN-ResNeXt: 解决视频分类的端到端时空双流融合网络[J]. 信号处理, 2020, 36(1): 58- 66.

Hu Zhengping, Zhang Ruixue, Zhang Xuan, et al. TVBN-ResNeXt: End-to-End Fusion of Space-Time Two-Stream Convolution Network for Video Classification[J]. Journal of Signal Processing, 2020, 36(1): 58- 66.(in Chinese)

[11] Ji S, Xu W, Yang M, et al. 3D Convolutional Neural Networks for Human Action Recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(1): 221-231.

[12] Tran D, Bourdev L, Fergus R, et al. Learning Spatiotemporal Features with 3D Convolutional Networks[C]∥International Conference on Computer Vision(ICCV). Washington DC: IEEE Press, 2015: 4489- 4497.

[13] Carreira J, Zisserman A. Quo Vadis, Action recognition? A new model and the kinetics dataset[C]∥IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Honolulu: IEEE Press, 2017: 4724- 4733.

[14] Hara K, Kataoka H, Satoh Y. Can Spatiotemporal 3D CNNs Retrace the History of 2D CNNs and ImageNet?[C]∥IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Salt Lake City: IEEE Press, 2018: 6546- 6555.

[15] Shao J, Loy C C, Kang K, et al. Slicing Convolutional Neural Network for Crowd Video Understanding[C]∥IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Las Vegas: IEEE Press, 2016: 5620-5628.

[16] Ngo C W, Pong T C, Zhang H J. Motion analysis and segmentation through spatio-temporal slices processing[J]. IEEE Transactions on Image Processing, 2003, 12(3): 341-355.

[17] Ricquebourg Y, Bouthemy P. Real-time tracking of moving persons by exploiting spatio-temporal image slices[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2000, 22(8): 797- 808.

[18] Szegedy C, Ioffe S, Vanhoucke V. Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning[C]∥AAAI Conference on Artificial Intelligence(AAAI). Phoenix: AAAI Press, 2017: 4278- 4284.

[19] Wang L, Ouyang W, Wang X, et al. Visual Tracking with Fully Convolutional Networks[C]∥International Conference on Computer Vision(ICCV). Santiage: IEEE Press, 2015: 3119-3127.

[20] Xie S, Girshick R, Doll r P, et al. Aggregated Residual Transformations for Deep Neural Networks[C]∥Computer Vision and Pattern Recognition(CVPR). Honolulu: IEEE Press, 2016: 5987-5995.

r P, et al. Aggregated Residual Transformations for Deep Neural Networks[C]∥Computer Vision and Pattern Recognition(CVPR). Honolulu: IEEE Press, 2016: 5987-5995.

[21] Ioffe S, Szegedy C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]∥International Conference on Machine Learning(ICML). Lille: ICML Press, 2015: 448- 456.

[22] Xavier Glorot, Yoshua Bengio. Understanding the difficulty of training deep feedforward neural networks[J]. Journal of Machine Learning Research-Proceedings Track, 2010, 9: 249-256.

[23] He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification[C]∥International Conference on Computer Vision(ICCV). Santiage: IEEE Press, 2015: 1026-1034.