1 引言

合成孔径雷达是一种采用较长电磁波的有源传感系统,能够穿透土壤和植被,对云层覆盖不敏感,具有全球昼夜感知能力[1],被广泛采用在地表结构监测、海洋环境探测和军事目标识别等领域。随着合成孔径雷达技术的快速发展,越来越多的SAR数据可公开获取,大量未标注SAR数据需要解译。SAR自动目标识别(Automatic Target Recognition,ATR)是一种解译SAR图像的重要技术,可有效提高SAR图像的利用效率。有别于自然光学图像,SAR图像充斥着散斑噪声和特有的几何畸变特征,给SAR ATR技术带来了挑战。除此之外,SAR图像的标签难以获取,存在着大量小样本数据,提高小样本数据集的利用效率也是研究的重点。

针对SAR图像的成像特性,大量新颖有效的SAR ATR算法被相继提出。文献[2]引入了一种基于字典学习和联合动态稀疏表示的SAR图像识别方法,该方法提高了识别速度和准确性。文献[3]提出了一种类相关性非局部均值算法,通过在经过主成分分析变换后的SAR数据集上应用该算法,成功的降低了散斑噪声对图像变化检测的影响。文献[4]使用随机森林和集成分类器来平均灰度共生矩阵的SAR图像纹理特征,展示了SAR图像在多相景观中鉴别可可农林和过渡林的潜力。文献[5]提出了一种基于二维主成分分析与正则化约束的随机配置网络的SAR图像目标识别方法,实验证明该方法能够获得较高的识别准确率。以上通过图像空间、形状、纹理等信息构建的传统特征提取方法严重依赖繁琐的手工设计,资源消耗巨大,无法满足高效解译SAR图像的需求。

随着硬件设备的不断改善和大数据时代的来临,深度学习的相关技术进入了发展的快车道,并成功的应用在自然图像分类、目标检测和细粒度分割等热门领域[6]。CNN是深度学习中最常见的算法之一,基于CNN改进的各种模型在自然图像处理的诸多领域上取得了突破,同样也被成功的应用在SAR图像分类任务上。文献[7]利用单层卷积层提取了SAR目标图像特征,并成功的对随机采样的图像块进行训练。文献[8]提出了一种稀疏连接的全卷积网络结构,缓解了在训练有限SAR数据时出现的过拟合现象。文献[9]采用三种数据增强策略来解决 MSTAR数据集中存在的目标平移、随机散斑噪声和姿态缺失的问题,实验结果证明了该方法的有效性。文献[10]提出了一种新颖的高速网络单元,实验证明由高速网络单元构建的网络能够在小样本SAR数据集上获得良好的识别结果。文献[11]通过生成多视角 SAR 数据进行数据扩充,并将扩充后的SAR数据喂入具有多输入并行网络拓扑结构的CNN中进行识别。文献[12]将迁移学习和基于滤波的模型剪枝方法相结合,用以提高SAR识别算法的识别速度和降低识别设备的存储成本。文献[13]通过将原始极化SAR特征参数集上筛选出的最优特征输入CNN,从而学习极化SAR图像的多层特征信息。文献[14]将CNN和支持向量机(Support Vector Machine,SVM)相结合,并利用改进的损失函数训练网络,通过实验证明了该方法在SAR图像识别上的有效性。尽管基于CNN的SAR ATR算法在识别性能上获得了突破,但是在SAR图像识别领域仍然存在着诸多挑战,包括:(1)SAR图像充斥着散斑噪声,难以提取具有代表性的特征,影响最终模型的分类结果;(2)CNN的分类效果严重依赖大量带标注的SAR数据,没有直接针对小样本数据集设计高效的CNN模型;(3)CNN的参数量巨大,加大了网络的空间复杂度,不利于SAR识别设备的进一步开发。

针对以上问题,本文设计了一种结合自注意力机制和多尺度特征融合的SAR图像分类网络。首先,将自注意力机制[15]融入到轻量的幽灵模块[16]中,设计出全新的自注意力幽灵模块来替换经典的卷积操作,该模块突出的优势是能够高效的获取目标的显著特征。其次,使用不同配置的幽灵模块进行瓶颈层的构建,通过在堆叠的瓶颈层间引入多尺度特征和通道混洗单元构建整体网络,该方式极大的促进了特征复用和信息融合。然后,运用知识蒸馏对整体网络进行压缩,获取参数量可观的高效SAR图像分类学生网络。最后,在标准工作条件(Standard Operating Conditions,SOC)下采集的十类MSTAR数据集、扩展工作条件(Extended Operating Conditions,EOC)下采集的两种配置的MSTAR数据集和不同工作条件下分别采样的小样本MSTAR数据集上进行了验证,实验结果表明,该方法能够有效的处理多种配置下的SAR图像目标识别任务。

2 相关工作

2.1 卷积神经网络

CNN是包含一个或多个卷积运算操作且具有深度结构的前馈神经网络,实现了将输入映射到输出的转换。随着深度学习的快速发展,CNN也有了新的形态。GoogleNet[17]首先提出了Inception结构,增加了网络对多尺度的适应性。ResNet[18]提出了残差结构和瓶颈层结构,解决了深度网络的退化问题。Xception[19]提出了深度可分离卷积操作,首先通过深度卷积(Depthwise Convolution,DW)对每个通道的特征图进行单独的卷积操作,再通过逐点卷积对输出的特征进行跨通道卷积操作,该操作相比于普通卷积操作降低了大量参数量。空洞卷积[20]通过在卷积核之间插入孔洞,实现了在不增长参数量的情况下增大感受野。ShuffleNetv2[21]将通道混洗和分离操作合并成新的通道混洗单元,促进了不同通道间的信息流通。SENet[22]通过建立通道之间的注意力机制,提升了模型对通道特征的敏感性。除了高效的网络结构和轻量卷积操作的设计之外,知识蒸馏[23]被提出用作CNN的压缩方法,实现了浅层CNN性能的提升。以上工作极大的促进了深度学习的发展,并被成功应用于多个领域。

2.2 自注意力机制

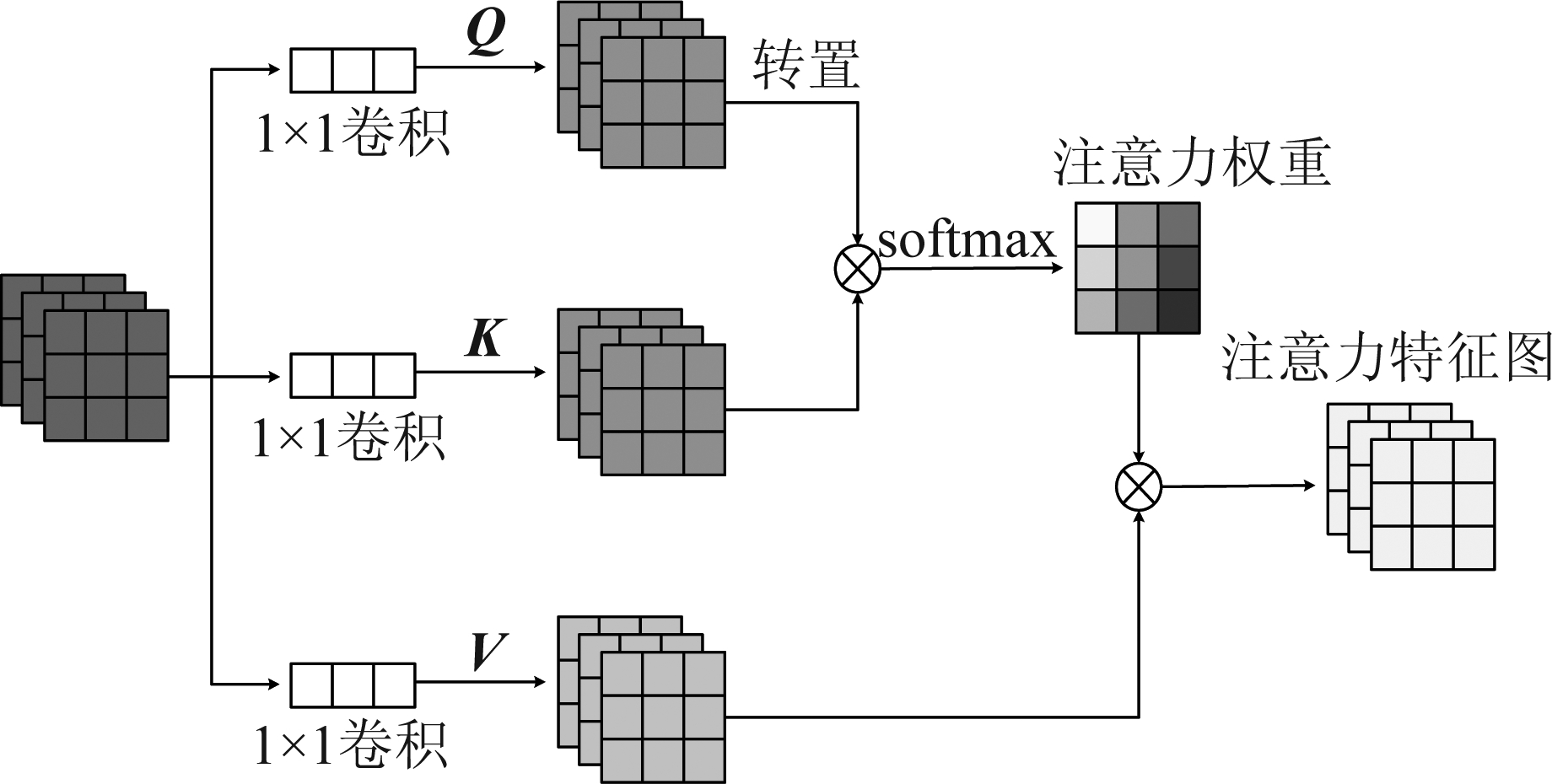

深度学习中的注意力机制来源于人类视觉的注意力机制,即分配更多的精力在感兴趣的位置,从而忽略一些不重要的信息。自注意力机制本质上是一种软注意力,即利用相关特征学习权重分布,并将学习到的特征分布施加到原来的特征之上,被广泛应用于自然语言处理和图像识别领域。如图1所示,自注意力结构自上而下分为query、key和value三支分路。

图1 自注意力机制

Fig.1 Self-attention mechanism

本文中用Q表示query矩阵,用K表示key矩阵,用V表示value矩阵,且Q、K和V保持一致,对所有的V∈Rc×h×w。具体来说,第一步通过点积计算query中的样本和key中的每个样本的相似度,得到权重:

(1)

上式中,qj表示Q中的第j个行向量,T表示转置操作。

第二步对相似度进行归一化:

(2)

上式中,kc表示K中的第c个行向量,经过softmax函数得到每一行归一化后的注意力权重,即为wj1,wj2,…,wjc。

第三步将注意力权重加权到对应的value上,得到最后的注意力:

(3)

对于每一个qj都可得到一个注意力,则对所有的V所获得的注意力可表示为:

Attention(V)=soft max(QΤK)V

(4)

3 本文方法

本节将幽灵模块进行改进,并将自注意力机制与改进的幽灵模块相结合,设计出一种自注意力幽灵模块。此外,使用不同配置的幽灵模块和通道混洗单元搭建了高效的瓶颈单元,再在多个瓶颈单元间引入了多尺度特征,以此构建了自注意力多尺度特征融合的SAR图像识别网络。最后,介绍了知识蒸馏在本文中的应用。

3.1 自注意力幽灵模块

相比于普通卷积,幽灵模块中采用了深度卷积,使得参数量大大减小,因此幽灵模块是一个轻量高效的模块。幽灵模块分为三部分,第一部分采用逐点卷积操作生成本征特征图,第二部分对本征特征图运用3×3深度卷积操作生成对应的相似特征图,因其类似本征特征图的幻影,故称其为幽灵特征图。第三部分将本征特征图和幽灵特征图进行拼接作为最终的输出。产生的幽灵特征图可看作是对本征特征图的一种增强实现,因此本文通过增加一层5×5深度卷积层来获取更加丰富的特征信息。如图2(a)所示,将两个不同尺寸的深度卷积层产生的幽灵特征图进行融合,最后再和本征特征图进行拼接作为输出,称改进的模块为双幽灵模块。

图2 两种改进的幽灵模块

Fig.2 Two improved ghost modules

卷积层的局部连接特性可以使网络的参数量大大减少,但是需要累积很多层之后才能把整个图像不同部分的区域关联起来。自注意力机制减少了对外部信息的依赖,通过在原始特征图上施加加权的注意力,从而得到特征图中任意两个位置的全局依赖关系。如图2(b)所示,在改进的双幽灵模块中添加图1所示的自注意力机制,构造全新的自注意力幽灵模块。自注意力幽灵模块中,首先将产生的本征特征图施加自注意力机制,使得输出的新特征能够获得不同特征内部的相关性。其次,对新特征进行双深度卷积操作,该操作使得网络能够获取更加丰富的特征信息。最后,将获取自注意力权重的新特征恒等映射到双重深度卷积操作后的输出上,该操作有助于信息的传递。包含以上操作的自注意力幽灵模块可以有效的提取SAR图像特征,从而提高SAR图像分类任务的识别准确率。

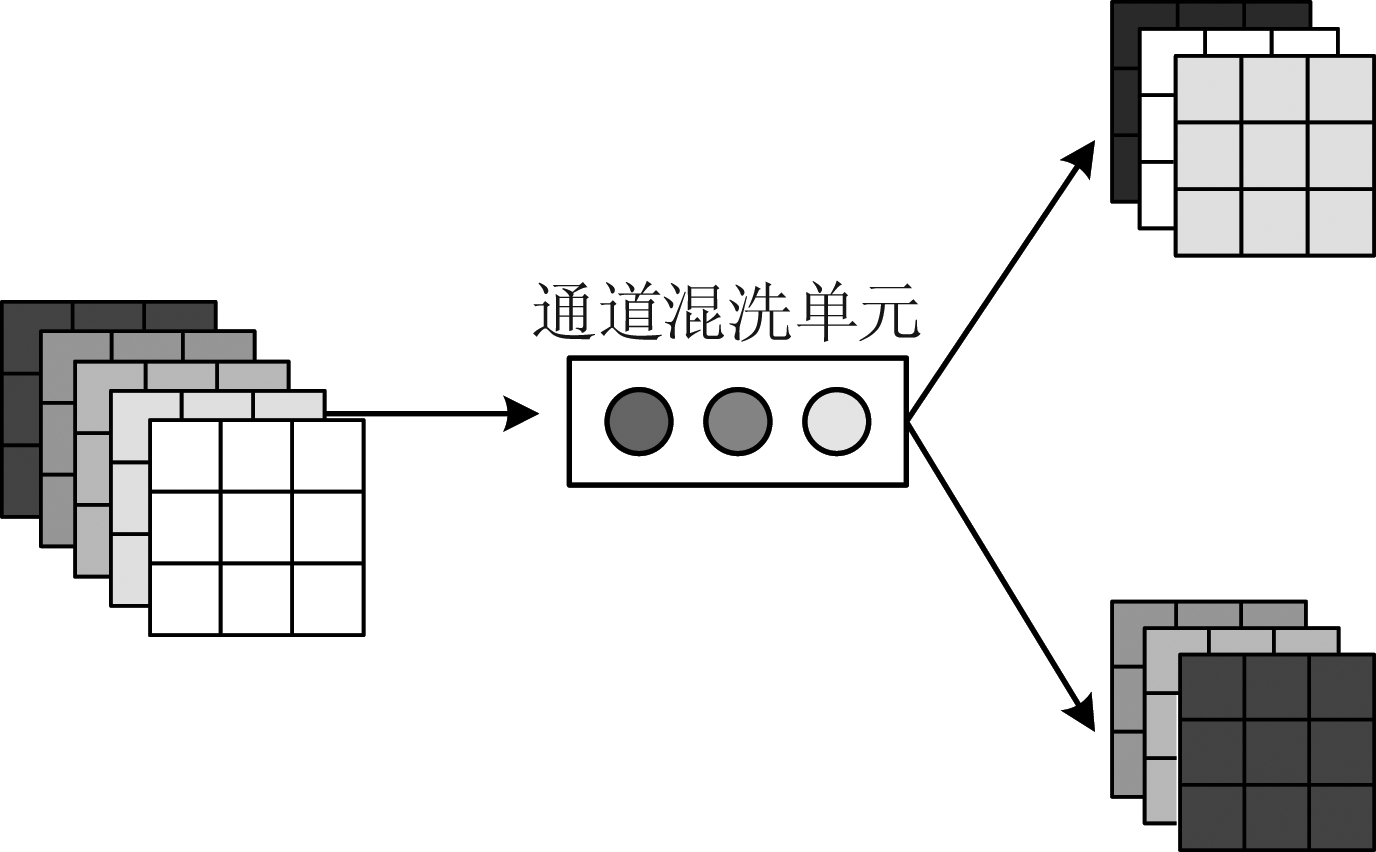

3.2 构建瓶颈单元

为了解决分组卷积中某个确定通道的输出仅仅取决于输入通道的一部分的限制,ShuffleNetv2提出了通道混洗单元,该单元极大的促进了通道间的信息流通,增加了信息表达能力。由于自注意力幽灵模块采用深度卷积构建,深度卷积是分组卷积的一种特殊形式,因此本文在构建的网络中引入了通道混洗单元。如图3所示,通道混洗单元包括两部分,第一部分将上一层输入的多个特征图进行通道混洗,第二部分将混洗后的特征图进行二均等分离操作。

图3 通道混洗单元操作

Fig.3 Channel shuffle unit operation

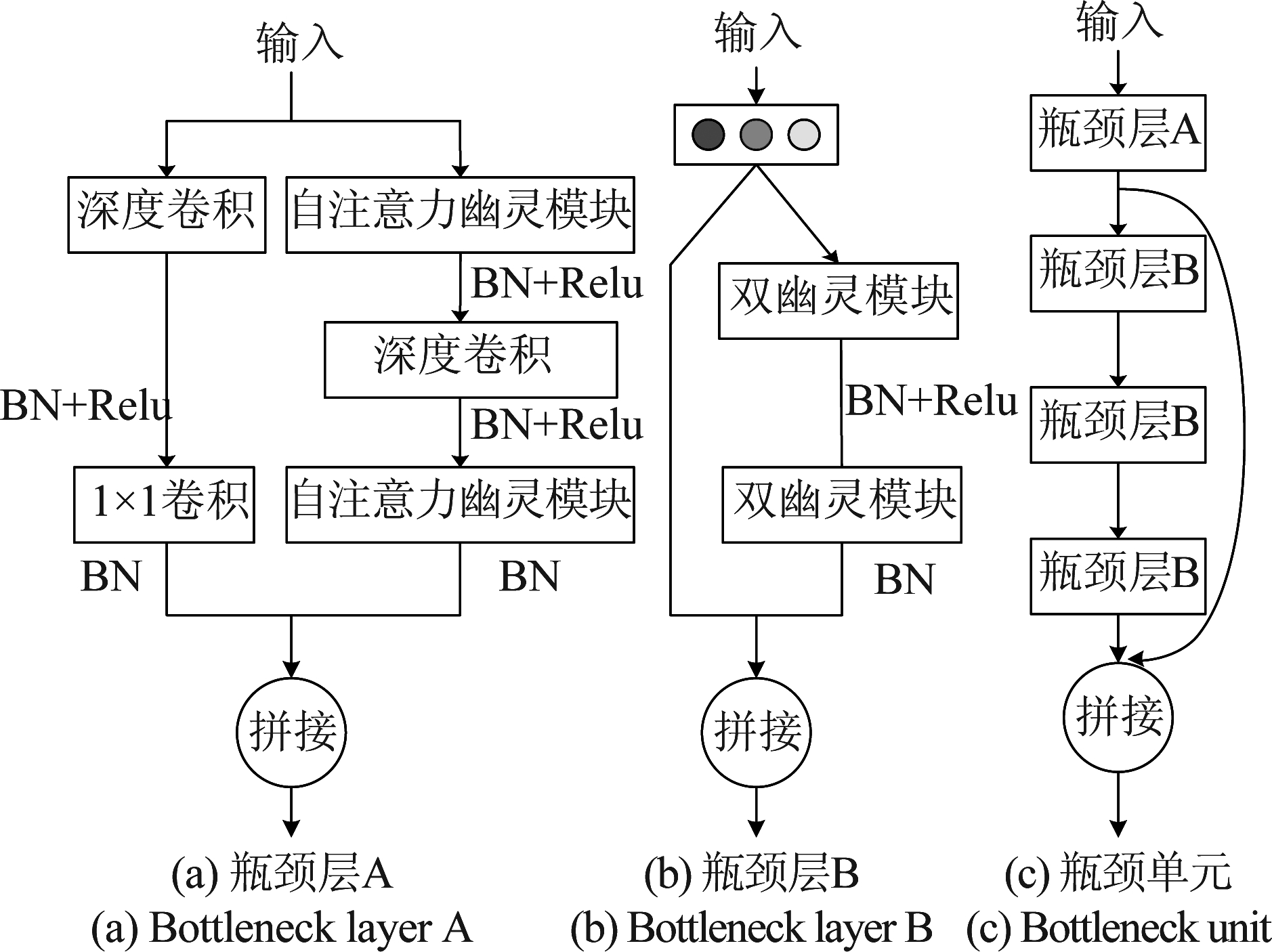

残差结构和瓶颈层结构的提出,解决了深度模型的性能退化问题,因此本文参考这两种结构,使用深度卷积、双幽灵模块和自注意力幽灵模块等构建高效的瓶颈层结构。如图4(a)所示,瓶颈层A采用类似结构,右边分支将自注意力幽灵模块、步伐间隔为2的深度卷积层和自注意力幽灵模块进行串联,实现了特征的降维和通道的增加。左边分支使用一个步伐间隔为2的深度卷积和逐点卷积级联,保证了与右边分支特征维度一致,从而最后实现左右分支的拼接。如图4(b)所示,瓶颈层B首先采用通道混洗单元,实现了将上层特征图的通道混洗和均等分离的操作。将平分后的特征图分别送入左右支路,右边支路为两个步伐间隔为1的双幽灵模块串联组成,左边为短接支路,最后将两个支路进行拼接。如图4(c)所示,本文将一个瓶颈层A和三个瓶颈层B组合在一起,称为一组瓶颈单元。

图4 不同结构的瓶颈层及瓶颈单元

Fig.4 Bottleneck layers and units of different structures

图5 整体网络结构图

Fig.5 Overall network structure diagram

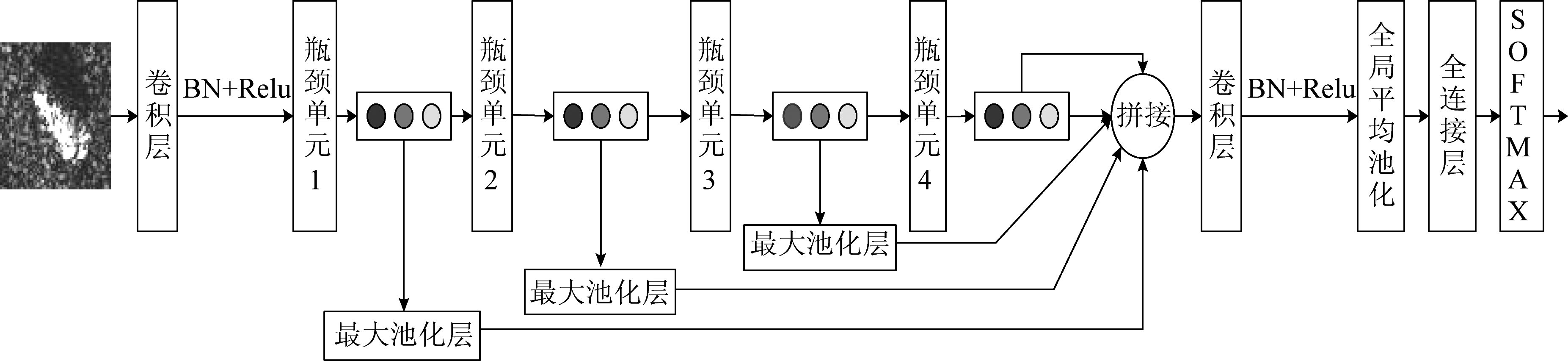

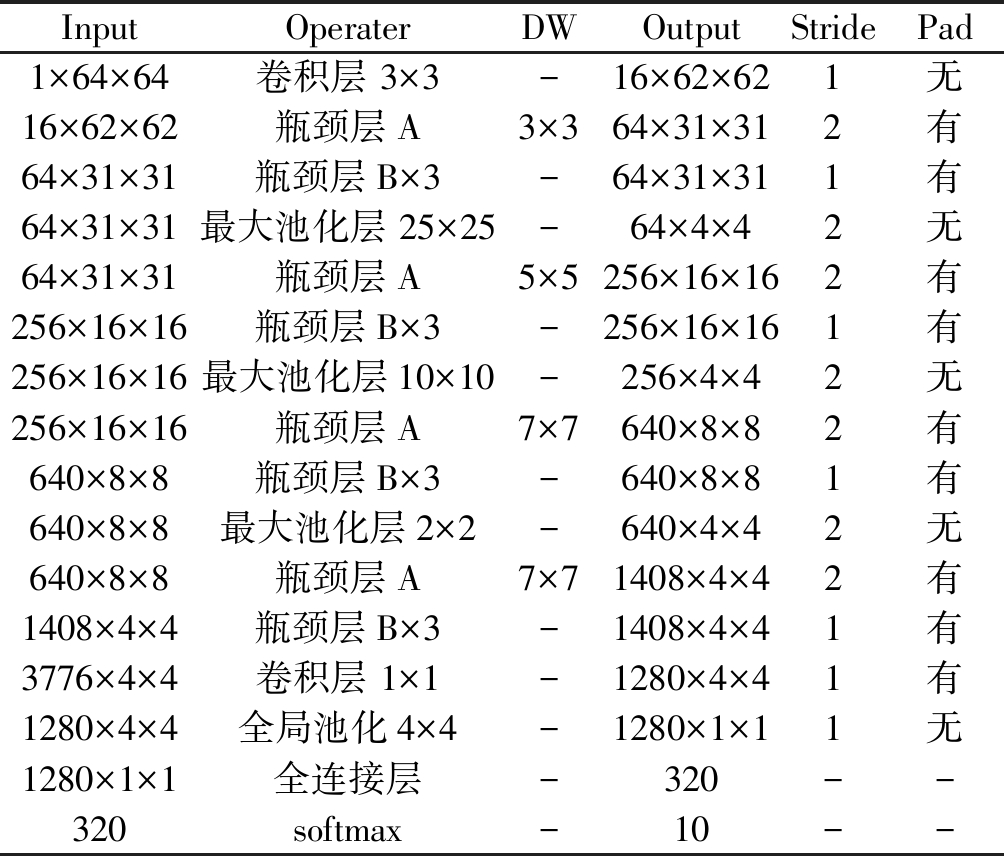

3.3 整体网络结构

如图5所示,首先将输入喂入一个3×3大小的卷积层,该卷积层的卷积步伐间隔为1,无填充操作,后接BN[24]结构和Relu激活函数。其次,分四个阶段构建网络,每个阶段即为一组瓶颈单元,并在每组瓶颈单元的末尾再添加一个通道混洗单元,由此引出多尺度特征。随后将引出的多尺度特征分别经过一个最大池化层,直接将网络不同瓶颈单元的特征维度保持一致。然后,将拼接后的特征输入到全局平均池化层进行空间信息的求和,并输入到下一个全连接层中。最后,依次接入dropout层和分类层完成最终的SAR图像分类任务。需要说明的是在四个瓶颈层A中的深度卷积采用了不同尺寸的卷积核,分别为3×3、5×5、7×7和7×7,这样有利于获取不同大小的感受野。除此之外,前两个最大池化层采用超大的下采样尺度,用以提取不同阶段最显著的特征,这可以降低卷积层对位置的敏感性。整体网络结构如表1所示。

表1 整体网络结构表

Tab.1 Overall network structure parameters

InputOperaterDWOutputStridePad1×64×64卷积层 3×3 -16×62×621无16×62×62瓶颈层A3×364×31×312有64×31×31瓶颈层B×3-64×31×311有64×31×31最大池化层 25×25-64×4×42无64×31×31瓶颈层A5×5256×16×162有256×16×16瓶颈层B×3-256×16×161有256×16×16最大池化层10×10-256×4×42无256×16×16瓶颈层A7×7640×8×82有640×8×8瓶颈层B×3-640×8×81有640×8×8最大池化层2×2-640×4×42无640×8×8瓶颈层A7×71408×4×42有1408×4×4瓶颈层B×3-1408×4×41有3776×4×4卷积层 1×1 -1280×4×41有1280×4×4全局池化4×4-1280×1×11无1280×1×1全连接层-320--320softmax-10--

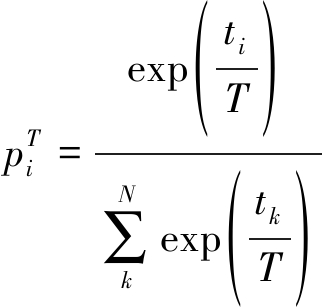

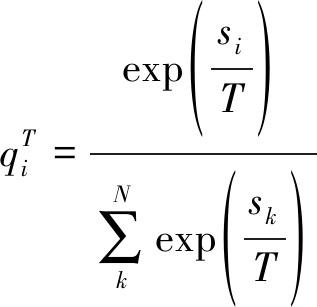

3.4 知识蒸馏

知识蒸馏是将一个性能强大且复杂的模型学习到的知识作为先验,并将该先验知识传递到重新设计的轻量模型中,以此提升轻量模型的性能。通常称性能强大且复杂的模型为教师网络,重新设计的简单轻量模型为学生网络。

知识蒸馏在softmax函数中添加温度参数值T,通过控制T的取值来使教师网络产生更加平滑的概率值,称之为软目标。

(5)

(6)

公式(5)和(6)所示分别为教师网络和学生网络在温度值为T下的softmax输出第i类上的概率值,其中ti和si分别为教师网络和学生网络未经归一化的概率值。

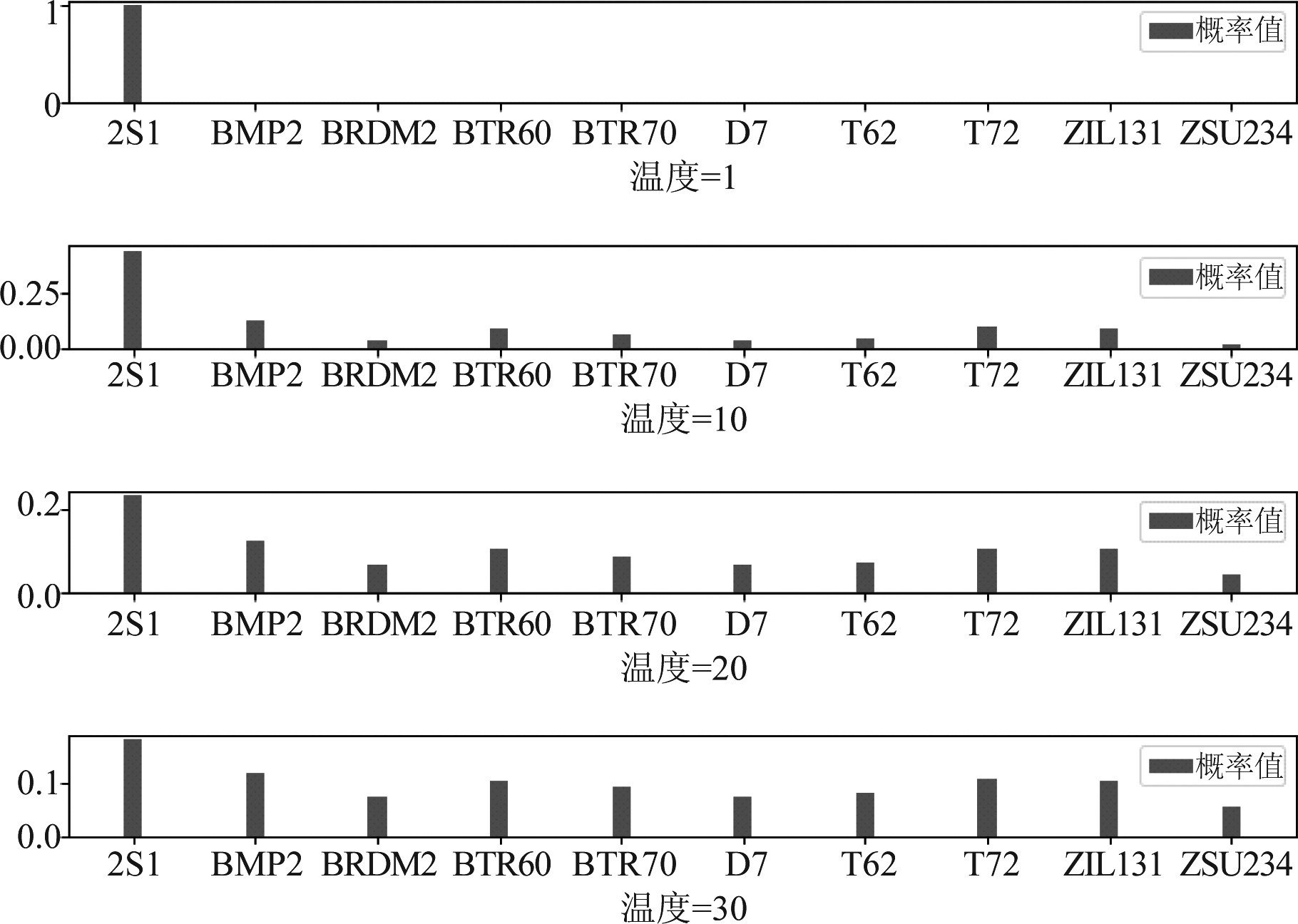

学生网络的训练分为两步进行计算,第一步是让学生网络以同样的T值去学习软目标的结构分布特征。第二步是将T值设置为1,从而让学生网络正常的拟合硬目标。如图6所示,随着温度上升,软目标的分布更加均匀,相比于硬目标可提供更多的信息和更小的梯度方差,在知识蒸馏过程中传递的这些丰富信息被称为暗知识,暗知识使学生网络可以用更少的数据进行训练。

图6 可视化暗知识

Fig.6 Visualize dark knowledge

![]()

(7)

(8)

学生网络中的损失函数由两部分组成,第一部分采用KL散度作为学习软目标的损失函数,如公式(7)所示,当教师网络和学生网络的概率分布越接近,KL散度的值越小,由此可将KL散度作为损失函数的计算策略。第二部分采用公式(8)所示的交叉熵损失作为学生网络学习硬目标的损失函数,其中cj表示标签的真值,![]() 表示温度取值为1时的学生网络输出的概率值。如公式(9)所示,通过将两部分的损失函数进行相加获得总损失函数,再根据梯度下降更新参数,式中α表示比例系数,用以控制两个损失函数的占比。

表示温度取值为1时的学生网络输出的概率值。如公式(9)所示,通过将两部分的损失函数进行相加获得总损失函数,再根据梯度下降更新参数,式中α表示比例系数,用以控制两个损失函数的占比。

Loss=αKL+(1-α)CE

(9)

4 实验结果与分析

4.1 数据集介绍

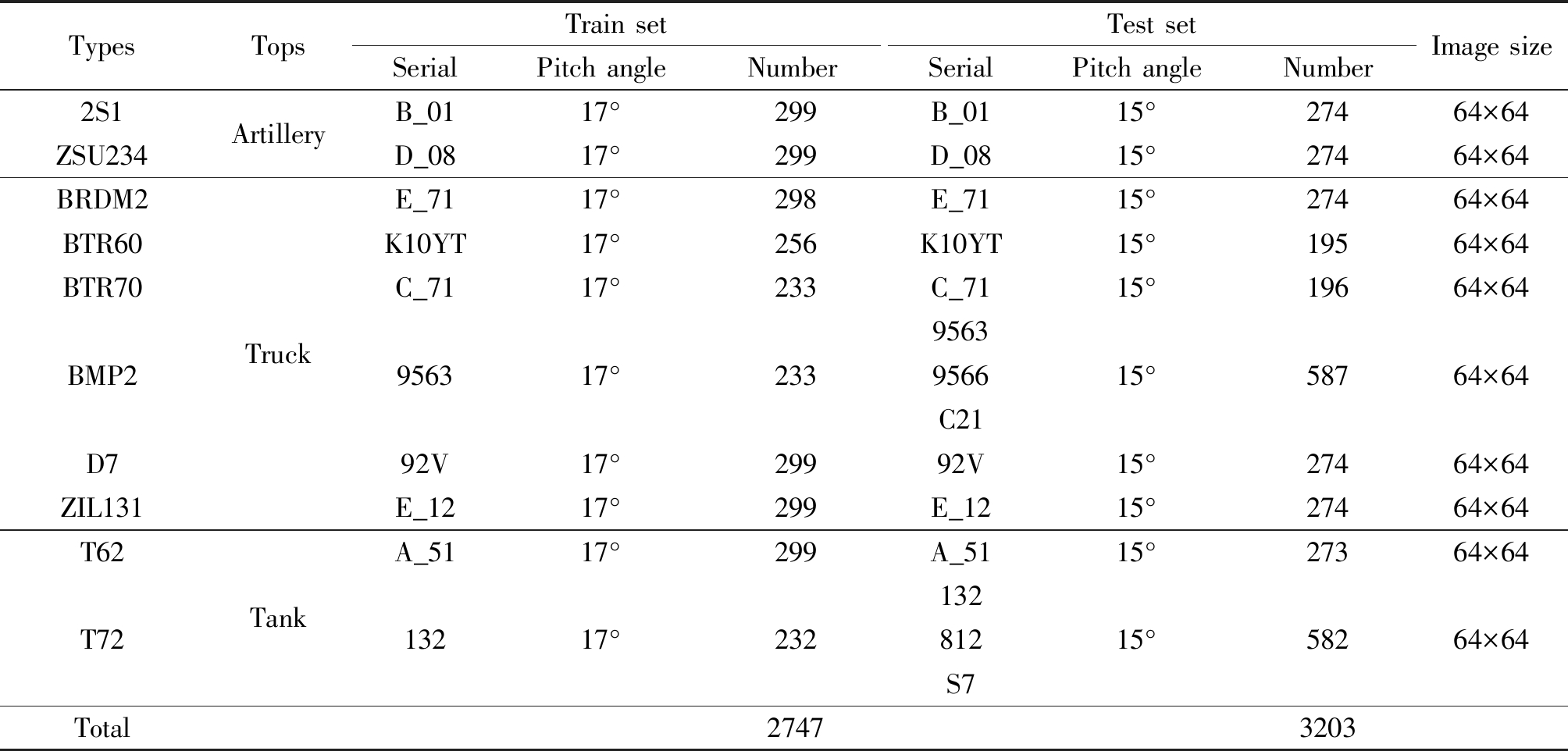

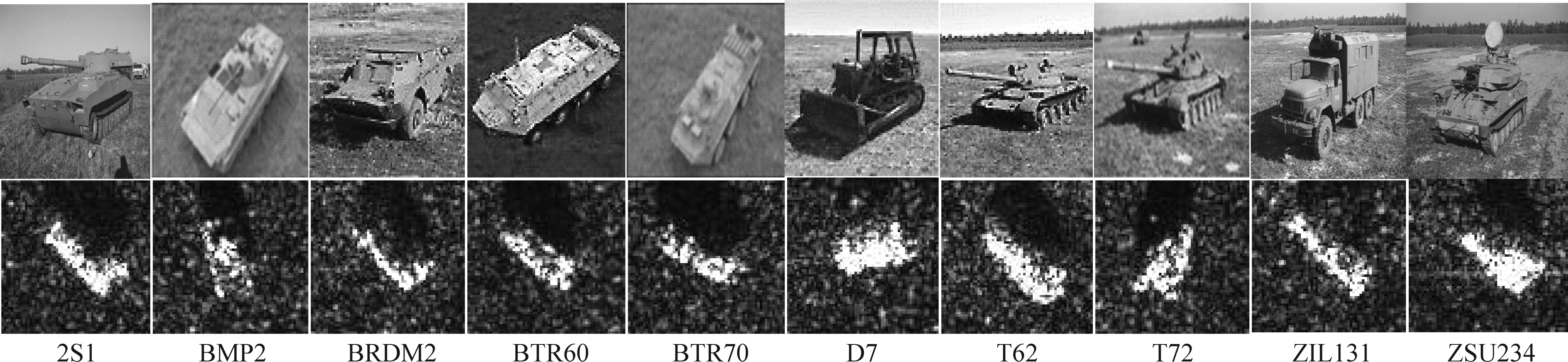

为展示本文算法在SAR目标图像识别任务上的性能,采用美国国防高等研究计划署支持的MSTAR数据集进行统一实验验证,该数据集包含多种车辆目标在各个俯仰角下获取到的SAR目标图像。SOC下采集的MSTAR数据集共包含十类地面目标,包含火炮类(2S1,ZSU234),装甲车类(BRDM2,BTR60,BTR70,BMP2,D7,ZIL131)和坦克类(T62,T72),其中装甲车类中的BMP2包含三类变体(9563,9566,C21),坦克类中的T72包含三类变体(132,812,S7)。SOC工作条件下的十类MSTAR数据集中的训练集和测试集图像的俯仰角分别是17°和15°,训练集中的BMP2只包含9563系列,T72只包含132系列,而对应的测试集中的BMP2和T72包含所有的三类变体,因此SOC下十类MSTAR数据集能够考验网络识别变体的能力。具体的SOC数据集配置如表2所示,光学目标图像和对应的SAR目标图像如图7所示。

表2 SOC下10类MSTAR数据集配置

Tab.2 10-class MSTAR dataset under SOC

TypesTopsTrain setSerialPitch angleNumberTest setSerialPitch angleNumberImage size2S1ZSU234BRDM2BTR60BTR70BMP2D7ZIL131T62T72TotalArtilleryTruckTankB_01D_08E_71K10YTC_71956392VE_12A_5113217°17°17°17°17°17°17°17°17°17°2992992982562332332992992992322747B_01D_08E_71K10YTC_7195639566C2192VE_12A_51132812S715°15°15°15°15°15°15°15°15°15°274274274195196587274274273582320364×6464×6464×6464×6464×6464×6464×6464×6464×6464×64

图7 MSTAR数据集图片示例

Fig.7 MSTAR dataset picture example

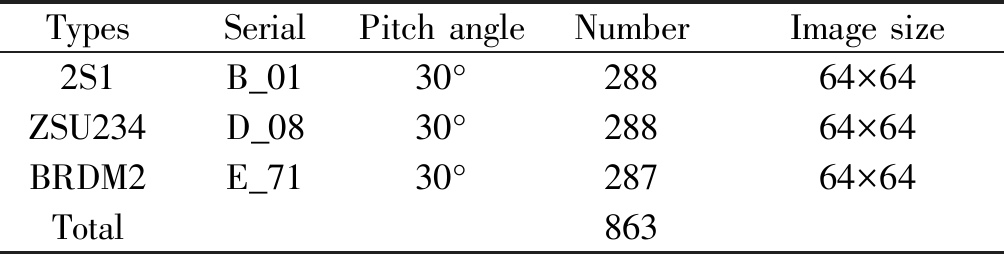

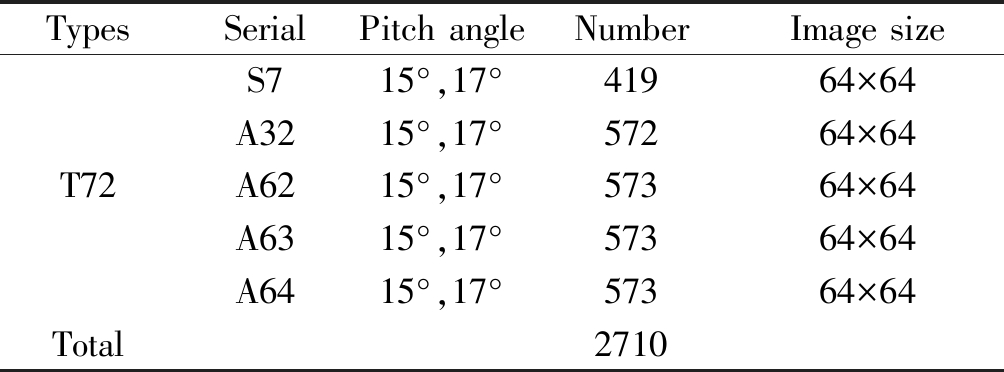

EOC下采集的数据集包含EOC-1和EOC-2两种实验配置。其中EOC-1下采集包含2S1,ZSU234和BRDM2三个型号目标的大俯仰角MSTAR数据集,该数据集中的训练集和测试集图像的俯仰角分别是17°和30°,训练集的目标选自表2中的对应类别。俯仰角差别过大可导致相同姿态的同一个目标呈现有较明显的区别表征,增加了识别的难度,具体的EOC-1数据集配置如表3所示。EOC-2下采集包含BMP2,BRDM2,BTR70和T72四个型号的目标,其中训练集图像的俯仰角是17°,目标选自表2中的对应类别。测试集图像的俯仰角是15°和17°,但测试集目标T72中包含多种不同变体型号且与训练集T72中的变体型号132不一致。训练集与测试集样本中目标表征的区别使得测试集的T72样本容易被识别为其他目标,因此增加了算法识别的难度,具体的EOC-2数据集配置如表4所示。

表3 EOC-1下MSTAR数据集配置

Tab.3 MSTAR dataset under EOC-1

TypesSerialPitch angleNumberImage size2S1B_0130°28864×64ZSU234D_0830°28864×64BRDM2E_7130°28764×64Total863

表4 EOC-2下MSTAR数据集配置

Tab.4 MSTAR dataset under EOC-2

TypesSerialPitch angleNumberImage sizeS715°,17°41964×64A3215°,17°57264×64T72A6215°,17°57364×64A6315°,17°57364×64A6415°,17°57364×64Total2710

4.2 实验环境及参数配置

本文所有实验都在硬件配置为Nvidia GeForce RTX 2080(8GB)显卡和RAM为32GB的计算机上运行。所有实验的编译环境统一为Ubuntu 18.04系统,采用Pytorch深度学习框架进行训练。实验采用SGD优化器,共训练150轮,初始学习率设为0.001,最后10轮学习率设为0.0005,dropout层的丢弃率设为0.2。本文所有配置的数据集均将训练集按照3∶1的比例重新划分成训练集和验证集,测试集保持不变,并使用分类正确概率(Percentage of Correction Classification,PCC)统计各目标和总体目标的识别结果。

4.3 网络结构分析

为探究最佳的网络结构设置和自注意力幽灵 模块的性能,我们对不同结构和数量的瓶颈单元在SOC数据集上进行测试,并且对网络中包含自注意力幽灵模块的部分层进行了特征可视化。

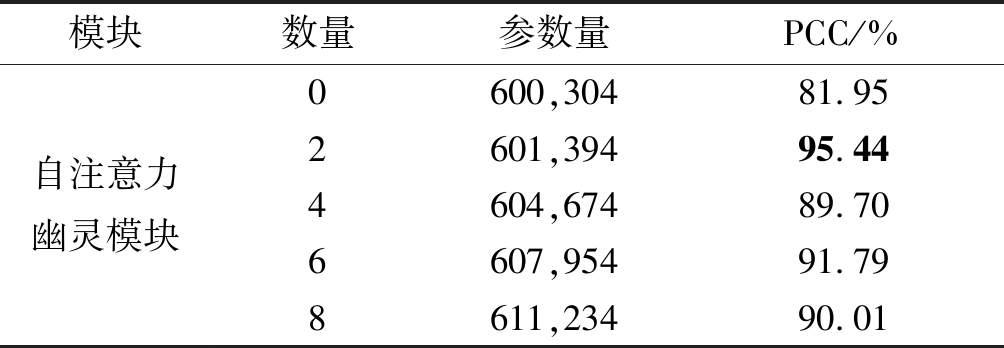

4.3.1 配置不同数量的瓶颈层结构验证

本文构建了两种瓶颈层结构,瓶颈层A主要由两个自注意力幽灵模块构成,瓶颈层B由两个双幽灵模块构成。为了比较自注意力幽灵模块对网络结构的影响,只取第一组瓶颈单元构建网络,通过将第一组瓶颈单元中各瓶颈层内的模块逐层改设为自注意力幽灵模块进行实验。实验结果如表5所示,当第一个瓶颈层采用自注意力幽灵模块时的性能最高,说明自注意力幽灵模块的使用不是越多越好。除此之外,自注意力机制中存在多次运算,频繁使用自注意力幽灵模块会导致网络的计算复杂度快速增长。综上,本文网络每组瓶颈单元只在第一个瓶颈层中使用自注意力幽灵模块,其余三个瓶颈层中使用双幽灵模块。

表5 嵌入不同数量的自注意力幽灵模块的性能比较

Tab.5 Effect of numbers of self-attention ghost modules

模块数量参数量PCC/%自注意力幽灵模块0600,30481.952601,39495.444604,67489.706607,95491.798611,23490.01

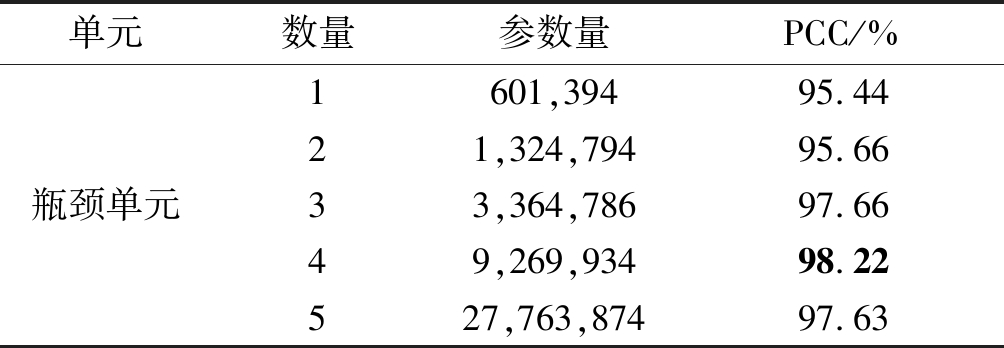

4.3.2 配置不同组数的瓶颈单元验证

本文构建的网络以四个瓶颈层为一组瓶颈单元,通过使用不同组数的瓶颈单元搭建网络。为探究网络的最佳性能,对配置不同组数瓶颈单元的网络性能进行比较。如表6所示,采用一组瓶颈单元的正确分类概率就达到了95.44%,采用四组瓶颈单元的正确分类概率达到了最高的98.22%,但参数量增长了十倍以上。以上说明瓶颈单元有助于提高网络的分类性能,但每组瓶颈单元的参数量十分巨大。为获取最高的识别性能,本文所构造的网络采用四组瓶颈单元。

表6 配置不同组数瓶颈单元的性能比较

Tab.6 Effect of groups of bottleneck units

单元数量参数量PCC/%瓶颈单元1601,39495.4421,324,79495.6633,364,78697.6649,269,93498.22527,763,87497.63

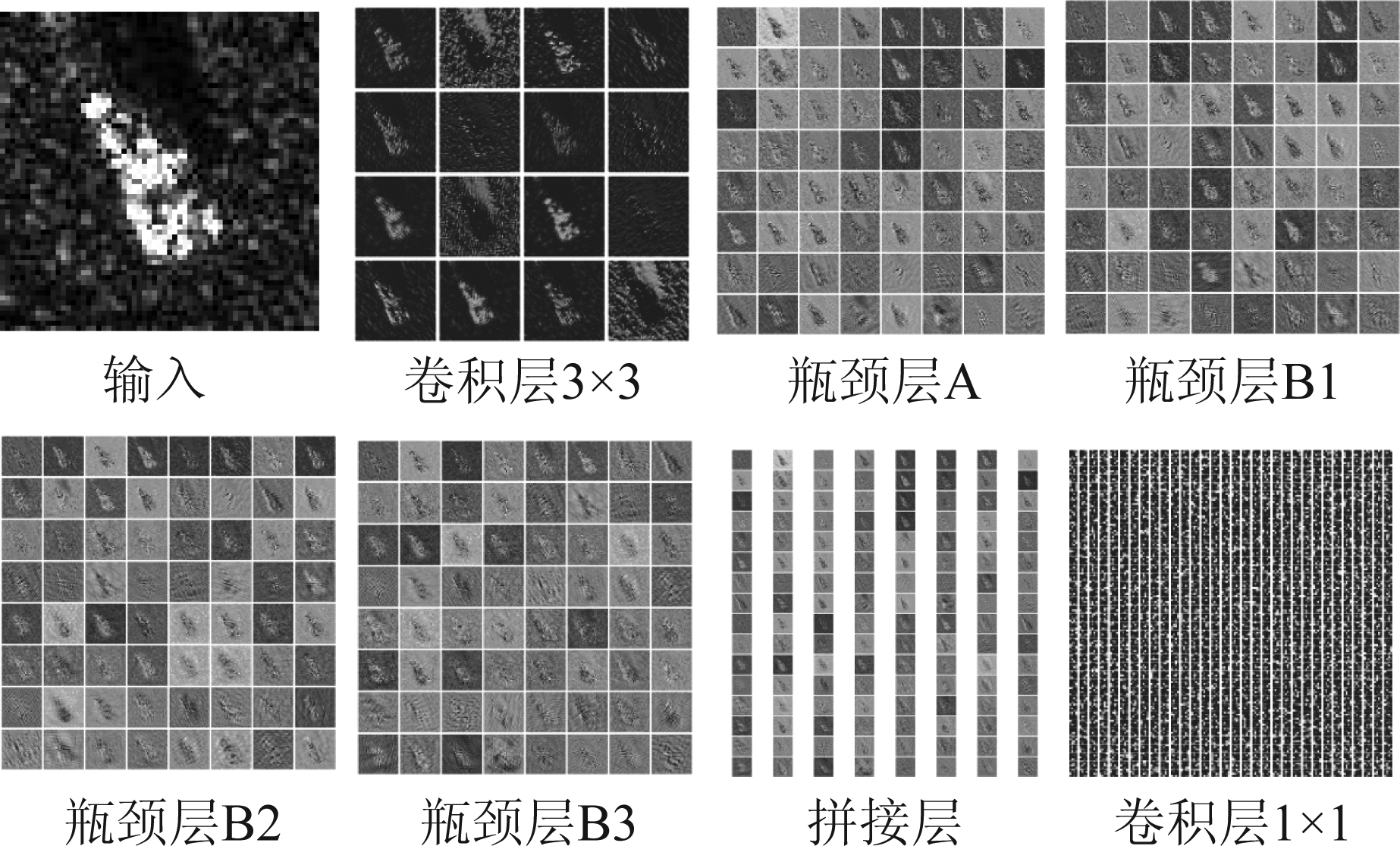

4.3.3 网络特征可视化

可视化手段可以将网络各个层级的输出特征显式的展现出来,这种方式有利于学者以清晰的视角观察到网络内部学习到的信息。下图为本文所提网络对目标2S1的可视化结果,由于空间限制,只展示第一层卷积层、第一个瓶颈单元各层(包括瓶颈层A、三个瓶颈层B和瓶颈单元拼接层)和最后一层卷积层的输出。从图8可以直观的看出,目标图片通过包含自注意力幽灵模块的瓶颈层A和包含双幽灵模块的瓶颈层B后提取的稳健特征。

图8 网络特征可视化

Fig.8 Network feature visualization

4.4 SOC实验4.4.1 SOC混淆矩阵

混淆矩阵是分类模型常用的评判指标,可直观的反应模型在各个类别上的表现,表7为网络在SOC下采集的MSTAR数据集上得出的混淆矩阵。通过表7可看出,本文提出的网路在含有变体的BMP2和T72两个系列目标中均取得了超过96%以上的分类正确概率,说明网络具有良好的识别变体的能力。除此之外,本文网络在BRDM2、BTR70和D7上取得了100%的分类正确概率,并且取得了98.22%的总体分类正确概率,说明了本文网络在SOC数据集上具有优越的识别性能。

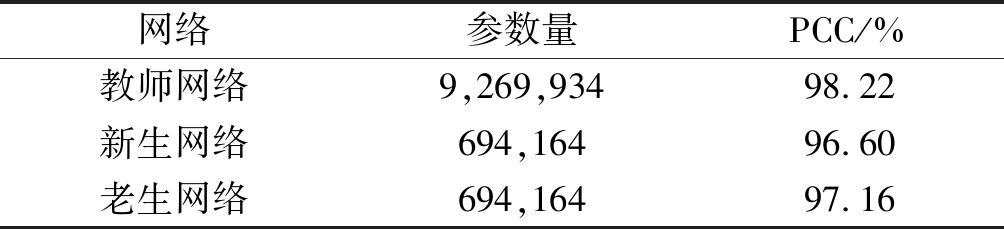

4.4.2 知识蒸馏在SOC数据集上的应用

本文所提网络在SOC下采集的十类MSTAR数据集上取得了良好识别结果,但是参数量达到了百万级,这不利于高效的SAR图像识别系统开发。知识蒸馏是有效的模型压缩方法,本文中所使用的教师网络是3.3节所提出的网络,学生网络是对教师网络进行结构缩减,首先只取每组瓶颈单元的前两个瓶颈层构建网络,其次拿掉网络结构中最后一个卷积层和全连接层,最后将所有卷积层的输出通道数减到原来的一半。本文中将未经知识蒸馏操作直接训练的学生网络称为新生网络,将经过知识蒸馏后的学生网络称为老生网络。知识蒸馏中存在温度值T和比例系数α两个超参数,T值用以控制教师网络输出概率值的软化程度,α值用以调节老生网络中KL散度和交叉熵损失函数的比重,本文选取T=30,α=0.6作为实验参数。如表8所示,新生网络的参数量较教师网络降低了十倍以上,因保留了教师网络中的主体结构,其在SOC数据集上的识别结果仍能达到96.60%。再经过知识蒸馏后的老生网络获得了97.16%的识别性能,说明了知识蒸馏可有效帮助设计轻量高效的SAR图像识别网络。

表7 SOC实验的混淆矩阵

Tab.7 Confusion matrix of experiments under SOC

Target2S1BMP2BRDM2BTR60BTR70D7T62T72ZIL131ZSU234PCC/%2S127300010000099.64BMP245680531060096.76BRDM2002740000000100BTR60113216940005188.67BTR70000019600000100D7000002740000100T6200000027120099.27T7212 002015760098.97ZIL13100000000273199.64ZSU23400000200027299.27Total----------98.22

表8 知识蒸馏在SOC数据集上的应用

Tab.8 Application of Knowledge Distillation under SOC

网络参数量PCC/%教师网络9,269,93498.22新生网络694,16496.60老生网络694,16497.16

4.4.3 其他网络在SOC数据集上的性能对比

深度学习中经典的CNN在光学图像识别上取得了成功,为充分的比较各个方法之间的性能,本文选取具有代表性的四个方法进行了比较。如表9所示,VGG16是图像识别任务中常用的基架网络,取得了94.91%的SAR图像分类正确概率。ResNet50使用了具有残差结构的深层网络,其分类正确概率达到了90.82%。Shufflenetv2提出的高效通道混洗操作,极大的促进了不同通道间的信息交流,最终的SAR图像识别准确度也突破了90%。SENet通过显式的建模通道之间的相互关系,学习了通道之间的相关性,但在SOC下的SAR图像识别任务效果不佳。由此可见,在光学图像识别任务上取得不错效果的经典CNN不一定在SAR图像识别任务上也取得类似的效果,并且这些经典的CNN与本文所提出的相关方法在SAR图像识别性能上均存在明显的差距。除此之外,本文还对面向SAR图像识别任务的相关方法进行了研究比较。基于SVM[25]和SRC[26]的SAR图像识别方法通过对提取的80维主成分分析的特征进行分类,分别获得了94.32%和93.67%的识别准确度。A-ConvNet[8]是一种基于CNN的SAR图像识别方法,该方法减少了自由参数的数量,取得了不错的识别准确度。Region Matching[27]提出了一种二值形态操作的目标区域匹配方案,通过对SAR图像不同结构的相似性元素进行融合,进一步调高了SAR图像识别的准确度。ASC Matching[28]提出了一种属性散射中心(attributed scattering center,ASC)的匹配方法,并用该方法在SAR图像分类任务上取得了不错的结果。文献[29]提出了一种将ASC和二值目标区域相结合的SAR图像识别方法,该方法避免了传统ASC匹配问题。文献[30]提出了一种基于原生SAR图像互补部分的联合稀疏表示方法,该方法最终取得了97.38%的识别准确度。尽管以上基于SAR图像识别任务开发的方法均取得了不错的效果,但本文提出的方法仍达到了最高的识别准确度,充分展示了本文方法在解决SOC下的SAR目标图像识别任务上的有效性。

表9 各方法在SOC数据集上的性能比较

Tab.9 Performance comparison of various methods under SOC

方法VGG16ResNet50SENetShufflenetv2教师网络新生网络老生网络PCC/%94.9190.8279.4990.2098.2296.6097.16方法SVM[25]SRC[26]A-ConvNet[8]Region Matching[27]ASC Matching[28]文献[29]文献[30] PCC/%94.3293.6797.5294.6895.3097.2297.38

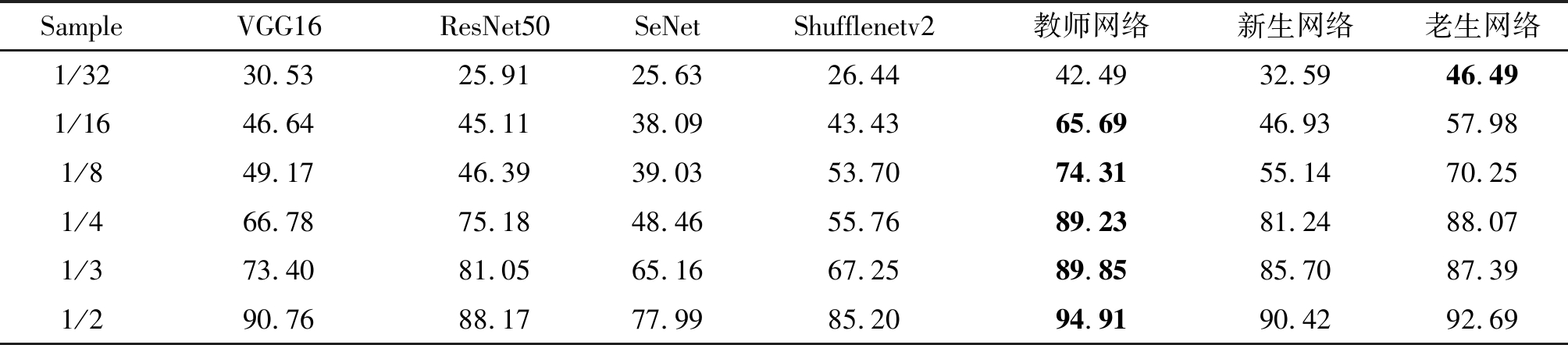

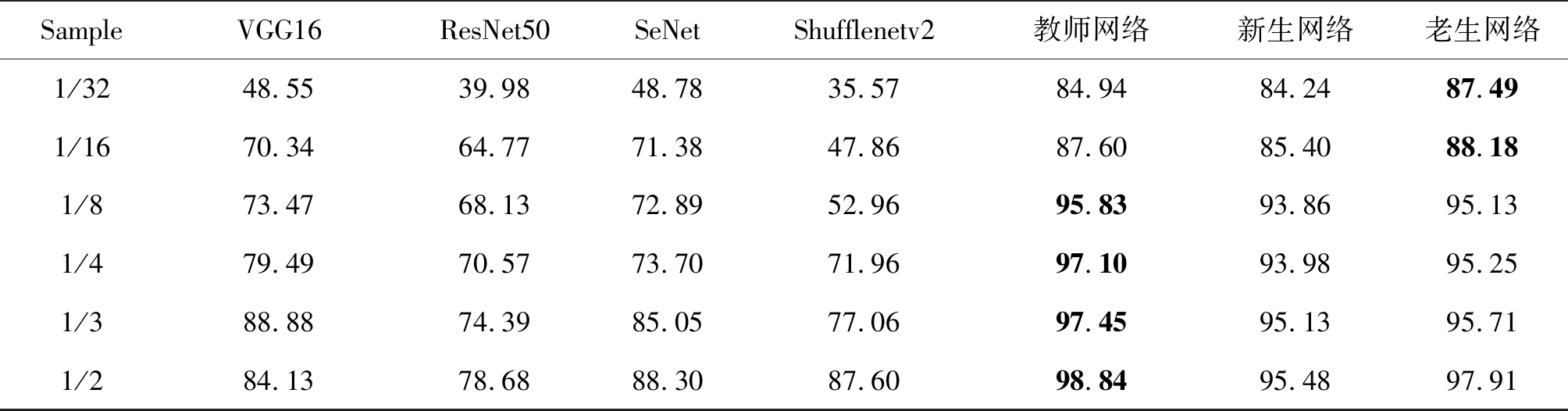

4.4.4 经典CNN在SOC小样本数据集上的性能比较

在数据充足的情况下,CNN在各类图像识别任务上都取得了较好的识别精度,因此也在SAR图像识别任务中得到广泛应用。然而,SAR场景下的带标注数据难以大量获取,CNN直接在小样本SAR数据集上的识别效果并不理想。除此之外,SAR目标图像充满散斑噪声,CNN难以提取关键特征,导致模型的鲁棒性较差。针对以上问题,本节通过比较本文方法和其他经典CNN在SOC小样本数据集上的性能,从而探究各网络在小样本数据上的鲁棒性。首先,将SOC下的十类MSTAR数据集的训练集按比例随机抽取数据,组成不同数量的SAR小样本数据集。其次,再将抽取的不同比例的小样本SAR数据集按照3∶1的比例划分成训练集和验证集。最后,测试集采用SOC下完备的十类MSTAR数据集的测试集,以此构建最终的六个不同比例的SAR小样本数据集。如表10所示,本文所提的网络在SOC小样本数据集上的识别性能均高于其他四个经典CNN,说明本文所提网络在小样本数据具有很好的鲁棒性。除此之外,在最少的1/32的SOC小样本数据集上,老生网络的性能优于教师网络,这是因为浅层网络能够更好的拟合小样本数据,同时知识蒸馏所提供的包含丰富信息的软标签使得浅层网络获得了类似正则化的效果,在训练较少的样本时,弥补了数据不足对浅层网络训练产生的影响。

表10 各方法在SOC小样本数据集上的性能比较

Tab.10 Performance comparison of SOC small samples by various methods

SampleVGG16ResNet50SeNetShufflenetv2教师网络新生网络老生网络1/3230.5325.9125.6326.4442.4932.5946.491/1646.6445.1138.0943.4365.6946.9357.981/849.1746.3939.0353.7074.3155.1470.251/466.7875.1848.4655.7689.2381.2488.071/373.4081.0565.1667.2589.8585.7087.391/290.7688.1777.9985.2094.9190.4292.69

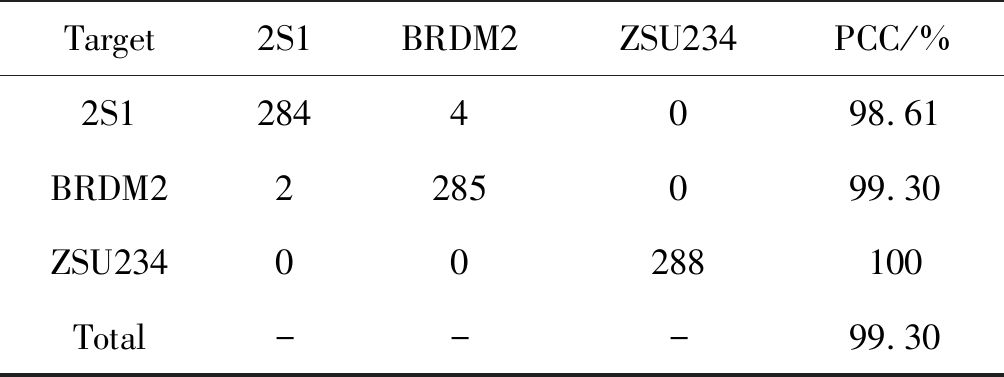

4.5 EOC实验4.5.1 EOC混淆矩阵

SAR目标在不同俯仰角下可能呈现较大的形态差异,这是现实场景下SAR图像识别任务面临的问题之一。本节为了进一步探究所提网络在大俯仰角变化下的性能表现,采用表3所示的EOC-1数据集进行验证,其中训练集的俯仰角为17°,测试集的俯仰角为30°。如表11所示,所有类别的分类正确概率均超过了98%,总体分类正确概率达到了99.30%,说明本文所提网络在大俯仰角变化下的SAR图像识别任务上具有良好的鲁棒性。

表11 EOC-1下的混淆矩阵

Tab.11 Confusion matrix of experiments under EOC-1

Target2S1BRDM2ZSU234PCC/%2S12844098.61BRDM22285099.30ZSU23400288100Total---99.30

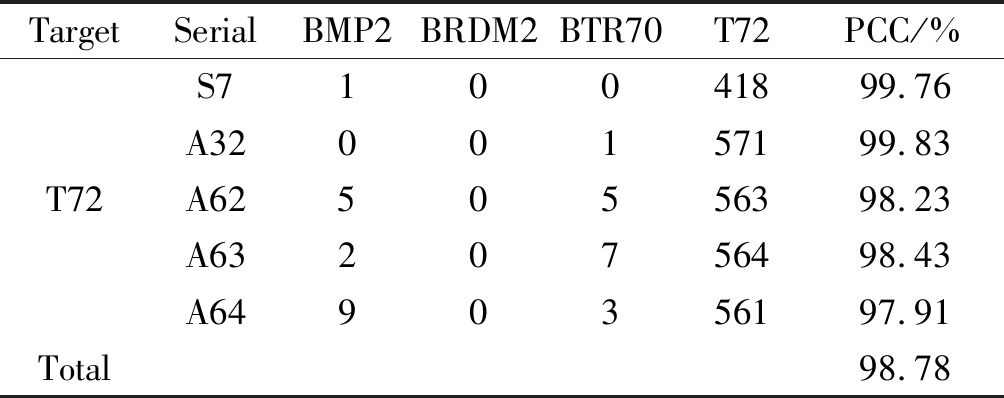

属于同一类别但型号不同的变体目标具有相似的物理构型,但是局部的构件差别使其各自的表征有所区别,这会导致目标样本容易被识别成其他类别。本节为了探究所提网络在数据集配置变化下的鲁棒性,采用表4所示的EOC-2数据集进行验证。如表12所示,本文所提网络的总体分类正确概率达到了98.78%,并十分准确的对T72和BRDM2进行了分类,分类结果符合在这四类目标中T72和BRDM2间的外观差异最大的基本事实,表面本文所提网络在数据集配置变化下的SAR图像识别任务上也具有不错的鲁棒性。

表12 EOC-2下的混淆矩阵

Tab.12 Confusion matrix of experiments under EOC-2

TargetSerialBMP2BRDM2BTR70T72PCC/%S710041899.76A3200157199.83T72A6250556398.23A6320756498.43A6490356197.91Total98.78

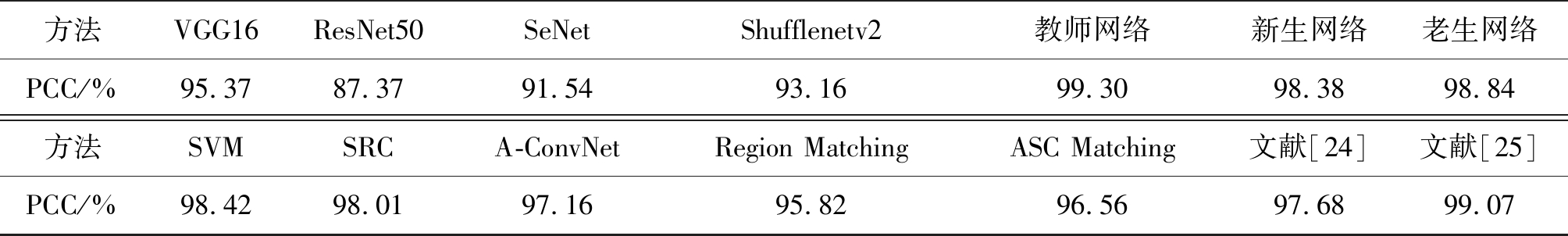

4.5.2 其他网络在EOC-1数据集上的性能对比

如表13所示,本文所提网络在EOC-1数据集上取得了99.30%的分类正确概率,由于新生网络保留了教师网络的主体结构,其分类正确概率也达到了98.38%,经过知识蒸馏后的老生网络的分类正确概率达到了98.84%。相较于其他方法,本文所提方法在EOC-1数据集上仍然具有优势,进一步说明了本文所提方法在大俯仰角变化下的SAR图像识别任务上具有良好的鲁棒性。

4.5.3 经典CNN在EOC-1小样本数据集上的性能比较

为进一步验证本文所提方法在EOC-1小样本数据集上的性能,本文按比例抽取表3所示的EOC-1数据集中的训练集,以EOC-1数据集中的测试集作为EOC-1小样本数据集中的测试集,以此构建不同比例的EOC-1小样本数据集。相对于SOC小样本数据集,EOC-1小样本数据集的数量更少,因此不同方法在EOC-1小样本数据集上的性能更能体现其在训练少量SAR图像样本时的鲁棒性。如表14所示,本文所提方法在EOC-1小样本数据集的性能均大幅高于其他经典CNN,并且知识蒸馏后的老生网络在1/16和1/32的EOC-1小样本数据集上的性能超越了教师网络,这进一步说明了在训练样本极少的情况下,经过知识蒸馏后的浅层网络能够获得性能上的突破。

表13 各方法在EOC-1数据集上的性能比较

Tab.13 Performance comparison of various methods under EOC-1

方法VGG16ResNet50SeNetShufflenetv2教师网络新生网络老生网络PCC/%95.3787.3791.5493.1699.3098.3898.84方法SVMSRCA-ConvNetRegion MatchingASC Matching文献[24]文献[25] PCC/%98.4298.0197.1695.8296.5697.6899.07

表14 EOC-1小样本数据集性能比较

Tab.14 Performance comparison of EOC-1 small samples by various methods

SampleVGG16ResNet50SeNetShufflenetv2教师网络新生网络老生网络1/3248.5539.9848.7835.5784.9484.2487.491/1670.3464.7771.3847.8687.6085.4088.181/873.4768.1372.8952.9695.8393.8695.131/479.4970.5773.7071.9697.1093.9895.251/388.8874.3985.0577.0697.4595.1395.711/284.1378.6888.3087.6098.8495.4897.91

5 结论

针对SAR图像识别任务中的难点问题,本文设计了一个基于自注意力机制的多尺度特征融合的卷积神经网络。将自注意力机制与幽灵模块融合构建全新的自注意力幽灵模块,用以提取SAR图像的显著特征。联合自注意力幽灵模块、双幽灵模块和通道混洗单元构建高效的瓶颈单元,用以提取不同层次的特征信息。通过在不同层次的瓶颈单元之间插入通道混洗单元引入多尺度信息,实现了网络跨通道、跨层级的信息交互。使用知识蒸馏技术对设计的网络结构进行压缩,构建轻量高效的SAR图像识别网络。实验结果显示,本文方法在SOC和EOC下采集的MSTAR数据集均取得了超越主流SAR图像识别方法的准确率,证明了本文方法的有效性。除此之外,本文方法在不同工作条件下采集的小样本MSTAR数据集上也取得了不错的识别效果,证明本文在小样本数据集上具有良好的鲁棒性。

[1] Castellazzi P, Doody T, Peeters L. Towards monitoring groundwater-dependent ecosystems using synthetic aperture radar imagery[J]. Hydrological Processes, 2019, 33 (25): 3239-3250.

[2] Sun Y, Du L, Wang Y, et al. SAR Automatic Target Recognition Based on Dictionary Learning and Joint Dynamic Sparse Representation[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13 (12): 1777-1781.

[3] Jia M, Wang L. Novel class-relativity non-local means with principal component analysis for multitemporal SAR image change detection[J]. International Journal of Remote Sensing, 2018, 39 (4): 1068-1091.

[4] Numbisi F N, Coillie F, De Wulf R. Delineation of Cocoa Agroforests Using Multiseason Sentinel-1 SAR Images: A Low Grey Level Range Reduces Uncertainties in GLCM Texture-Based Mapping[J]. International Journal of Geo Information, 2019, 8 (4): 179-204.

[5] 王彦平, 张艺博, 李洋, 等. 基于2DPCA-SCN正则化的SAR图像目标识别方法[J]. 信号处理, 2019, 35(5): 802- 808.

Wang Yanping, Zhang Yibo, Li Yang, et al. Target Recognition Method Based on 2DPCA-SCN Regularization for SAR Images[J]. Journal of Signal Processing, 2019, 35(5): 802- 808.(in Chinese)

[6] Pouyanfar S, Sadiq S, Yan Y, et al. A Survey on Deep Learning: Algorithms, Techniques, and Applications[J]. ACM Computing Surveys, 2018, 51 (5): 1-36.

[7] Chen S, Wang H. SAR target recognition based on deep learning[C]∥2014 International Conference on Data Science and Advanced Analytics (DSAA). IEEE, 2015: 541-547.

[8] Chen S, Wang H, Xu F, et al. Target Classification Using the Deep Convolutional Networks for SAR Images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(8): 4806- 4817.

[9] Ding J, Chen B, Liu H, et al. Convolutional Neural Network With Data Augmentation for SAR Target Recognition[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13(3): 364-368.

[10] Lin Z, Ji K, Kang M, et al. Deep Convolutional Highway Unit Network for SAR Target Classification With Limited Labeled Training Data[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(7): 1091-1095.

[11] Pei J, Huang Y, Huo W, et al. SAR Automatic Target Recognition Based on Multiview Deep Learning Framework[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56 (4): 2196-2210.

[12] Zhong C, Mu X, He X, et al. SAR Target Image Classification Based on Transfer Learning and Model Compression[J]. IEEE Geoscience and Remote Sensing Letters, 2019, 16(3): 412- 416.

[13] 韩萍, 孙丹丹. 特征选择与深度学习相结合的极化SAR图像分类[J]. 信号处理, 2019, 35(6): 972-978.

Han Ping, Sun Dandan. Classification of Polarimetric SAR Image with Feature Selection and Deep Learning[J]. Journal of Signal Processing, 2019, 35(6): 972-978.(in Chinese)

[14] Gao F, Huang T, Sun J, et al. A New Algorithm of SAR Image Target Recognition Based on Improved Deep Convolutional Neural Network[J]. Cognitive Computation, 2019, 11 (6): 809-824.

[15] Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[C]∥In Advances in Neural Information Processing Systems, 2017: 5998- 6008.

[16] Han K, Wang Y, Tian Q, et al. GhostNet: More Features from Cheap Operations[J]. The IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020: 1580-1589.

[17] Szegedy C, Liu W, Jia Y, et al. Going Deeper with Convolutions[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2015: 1-9.

[18] He K, Zhang X, Ren S, et al. Deep Residual Learning for Image Recognition[C]∥The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2016: 770-778.

[19] Chollet F. Xception: Deep Learning with Depthwise Separable Convolutions[C]∥The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 1251-1258.

[20] Chen L C, Papandreou G, Kokkinos I, et al. DeepLab: Semantic Image Segmentation with Deep Convolutional Nets, Atrous Convolution, and Fully Connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40 (4): 834- 848.

[21] Ma N, Zhang X, Zheng H, et al. ShuffleNet V2: Practical Guidelines for Efficient CNN Architecture Design[C]∥The European Conference on Computer Vision (ECCV), 2018: 116-131.

[22] Hu J, Shen L, Sun G, et al. Squeeze-and-Excitation Networks[C]∥Computer Vision and Pattern Recognition, 2018: 7132-7141.

[23] Hinton G, Vinyals O, Dean J. Distilling the Knowledge in a Neural Network[J]. Computer Science, 2015, 14 (7): 38-39.

[24] Ioffe S, Szegedy C. Batch normalization: Accelerating deep network training by reducing internal covariate shift[C]∥Proceedings of the 32nd International Conference on Machine Learning, 2015: 448- 456.

[25] Zhao Q, Principe J. Support Vector Machines For Synthetic Aperture Radar Automatic Target Recognition[J]. IEEE Transactions on Aerospace and Electronic Systems, 2001, 37 (2): 643- 654.

[26] Song H, Ji K, Zhang Y, et al. Sparse Representation-Based SAR Image Target Classification on the 10-Class MSTAR Data Set[J]. Applied Sciences, 2016, 6 (1): 26-36.

[27] Ding B, Wen G, Ma C, et al. Target recognition in synthetic aperture radar images using binary morphological operations[J]. Journal of Applied Remote Sensing, 2016, 10 (4): 046006-046020.

[28] Ding B, Wen G, Huang X, et al. Target recognition in synthetic aperture radar images via matching of attributed scattering centers[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2017, 10 (7): 3334-3347.

[29] Tan J, Fan X, Wang S, et al. Target Recognition of SAR Images via Matching Attributed Scattering Centers with Binary Target Region[J]. Sensors, 2018, 18 (9): 3019-3037.

[30] Miao S, Liu X. Joint sparse representation of complementary components in SAR images for robust target recognition[J]. Journal of Electromagnetic Waves and Applications, 2019, 33 (7): 882- 896.