1 引言

随着第五代(Five generation, 5G)移动通信、人工智能(Artificial intelligence, AI)、移动边缘计算和物联网 (Internet of things, IoT)的快速发展,无线通信网络不仅规模成倍增长,而且需要满足多样化的业务需求、支持差异化的设备和应用,导致无线系统愈来愈复杂。利用以机器学习(Machine learning, ML)为代表的AI技术,有望以低成本设计和高效运营无线网络。近几年,ML技术已被引入到各种无线网络的设计中,例如蜂窝网、无线局域网、智能电网、能量采集网络等[1],涉及无线网络中的物理层、介质访问控制层、数据链路层和应用层[2],用于解决无线通信的信息预测和多域资源管理等问题。

在无线接入网(Radio access network, RAN)中实现ML不仅可以利用无线边缘的计算、存储资源及感知能力,实现在线决策、网络自治、提升网络的服务能力以及接入用户的服务体验,还能使移动终端支持各种智能应用,因此被称为“无线边缘ML”或“无线边缘智能”1。

1无线边缘ML是实现无线边缘智能的一种方式。考虑到目前ML是人工智能领域最活跃的方向,因此本文的无线边缘智能指的是无线边缘ML。

本文综述无线边缘ML的研究现状,第二节介绍面向无线边缘的ML,包括无线边缘ML的特点、主要应用、典型学习方法和性能潜力,以及两种降低训练开销的方法;第三节介绍面向无线边缘的联邦学习,包括联邦学习的应用现状和适用范围,以及在降低开销和个性化学习方向的研究进展和存在的问题;第四节对全文进行总结。

2 面向无线边缘的机器学习

2.1 无线边缘ML的特点

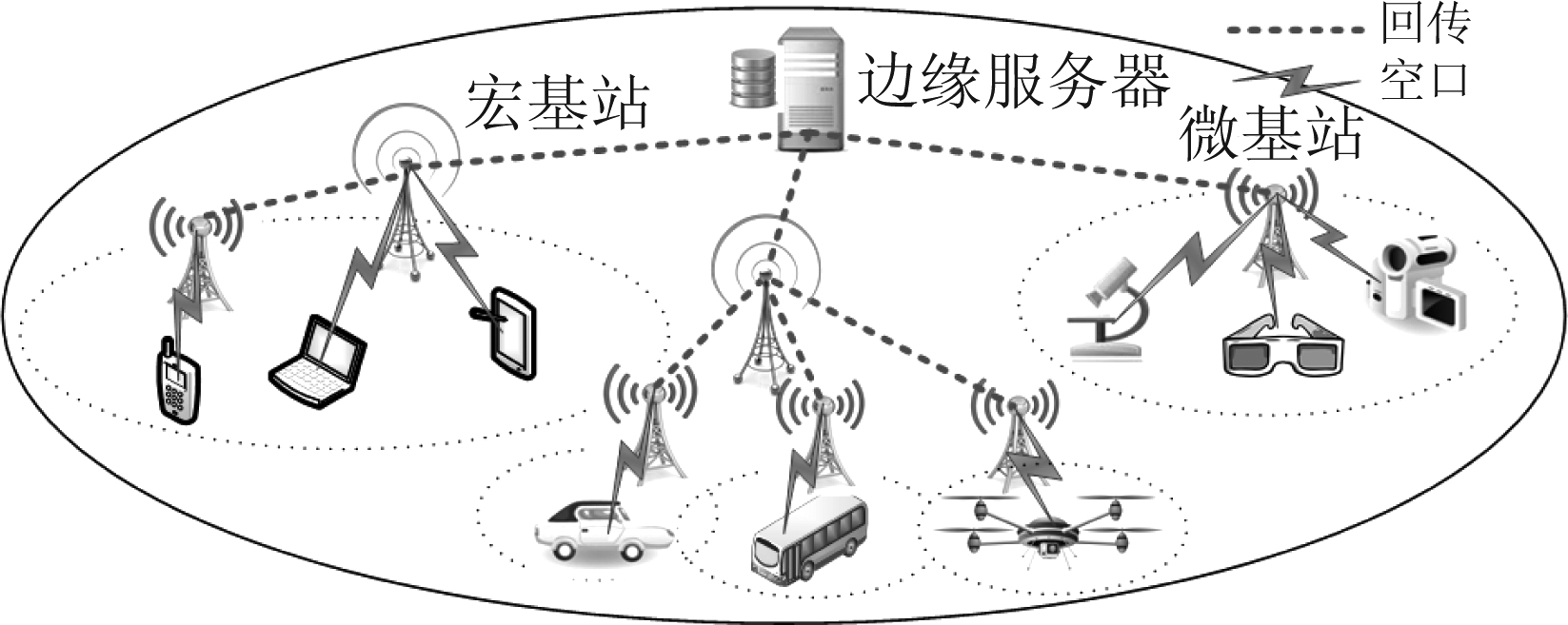

图1给出了无线边缘智能的网络架构,无线边缘ML有下面四个特点:

图1 无线边缘智能的网络架构

Fig.1 Network architecture of wireless Edge Intelligence

1)如图1所示,RAN中有移动终端、基站、边缘服务器等各种节点,这些节点不仅提供ML所需要的计算能力,还能采集到丰富的数据用于训练ML模型。移动终端可获取测量报告、用户使用的习惯、位置和移动轨迹、终端类型以及电池余量等数据;基站可获得信道状态信息(Channel state information, CSI)、接收信号强度、网络繁忙程度、干扰环境、资源占用率等数据;边缘服务器不仅可采集与计算负载、存储占用、等待处理的任务队列状态等数据,还能获得一些应用级的数据,如反映内容流行分布、个人喜好等内容分发业务的数据,以及视频点播、文件下载、视频会议、语音等业务的用户服务质量等[3]。

2)在无线边缘网络中,多用户、多基站之间往往存在干扰和资源使用冲突,需要对多个边缘节点的通信策略或资源分配进行联合优化。在进行联合优化决策时,我们把存在冲突的节点称为“边缘节点”,管理边缘节点的称为“中心节点”。在图1中,中心节点可以是服务多用户的基站、覆盖多个微小区的宏基站、连接多个宏/微基站的边缘服务器等,边缘节点可以是宏/微基站、智能手机、车辆、无人机、及其他IoT设备等。无线边缘网络能够在不同的节点上训练ML并利用训练好的ML模型进行决策,表1列出了三种常用的训练和决策方式。当采用不同的训练和决策方式时,ML的性能和复杂度不同。

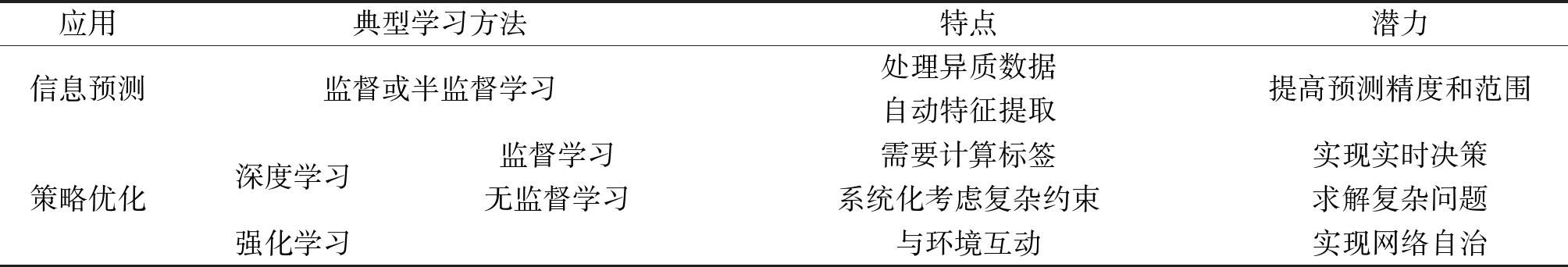

表1 边缘ML中的决策和训练方法

Tab.1 Decision-making and training methods in edge ML

训练和决策方式中心节点边缘节点集中式训练、集中式决策训练+决策-集中式训练、分布式决策训练决策分布式训练、分布式决策-训练+决策

尽管智能手机和IoT设备的计算和存储能力相对于以往已有很大的提升,但受到能耗、计算和存储的限制,能够部署的ML参数规模有限[4],因此无线边缘需要轻量级的ML模型。

3)无线边缘ML需要考虑无线网络的动态性和无线信道的开放性。首先,无线网络环境非平稳,用户加入或离开网络、发出新的业务请求、用户移动都会导致网络的动态变化。为了及时响应网络的动态变化,边缘ML不仅需要具有实时决策的能力,往往还需要具有在线学习的能力,对ML模型的训练时间和代价提出严格的要求[5]。其次,无线链路中存在的干扰和衰落不可避免地降低通信质量,从而影响边缘ML的学习精度和收敛速度[6],因此边缘ML需要在各种不确定环境中具有鲁棒性。

4)随着无人机、增强现实或虚拟现实(Virtual reality, VR)以及自动驾驶等新型设备和高风险应用的出现,传统集中式的ML已经不能满足超可靠低延迟通信(Ultra-reliable and low latency communication, URLLC)和计算的要求,需要高可靠、分布式的无线边缘ML。

2.2 典型应用和方法

机器学习在无线边缘网络中的两大类典型应用为信息预测[7]和策略优化[8]。

为了提升无线系统性能,需要预测的信息包括与无线网络和环境变化有关的信息,例如CSI、干扰功率、数据率、网络负载和资源占用率等;还有与用户行为有关的信息,例如用户位置和移动轨迹[9]、用户喜好、及文件流行度等。利用预测的信息可以应对高速移动环境下的信道过时问题,例如预测CSI能提高大规模多天线(Massive multiple input multiple output, Massive MIMO)系统的传输性能[10],还能使无线通信网络从“被动式”转变为“主动式”,例如利用未来的网络负载、数据率、用户轨迹优化预测资源分配能充分利用网络资源[11],利用未来的文件流行度和用户偏好优化主动缓存策略能错峰传输并提升用户体验[12]。

除了利用ML预测信息从而设计高效的通信策略,还可以用ML直接优化通信策略,包括编码调制、波束成形、资源分配、用户调度、用户接入、基站休眠、移动性管理、负载均衡、缓存策略、计算卸载和切片管理等[2,8,13-14]。其中,一类典型的应用是重新设计物理层,例如基于自编码器(Auto-encoder, AE)的物理层收发机联合设计[15];另一类是优化无线策略,例如基于深度神经网络(Deep neural network, DNN)学习优化(learn to optimize)[16]可以降低在线决策阶段的计算复杂度。

信息预测主要采用的ML方法是深度学习,包括监督学习或半监督学习。深度学习可处理异质数据并自动提取特征,与基于模型的传统预测方法或传统机器学习方法相比能提高预测精度和范围。

策略优化主要采用的ML方法包括深度学习和强化学习,其中深度学习还分为监督学习和无监督学习。监督学习先求解优化问题得到训练标签,再利用DNN学习所优化的变量或函数与环境参数的关系,存在的问题是生成大量标签需要消耗计算资源且性能依赖于标签的质量。无监督学习直接根据无线策略的优化目标来训练神经网络[17-19],避免了监督学习中求解标签的计算开销并能系统化地控制学习过程以满足无线优化问题中的复杂约束。强化学习通过与环境交互的方式来学习所优化的变量或函数与环境参数的关系,最大化综合考虑了当前奖励和未来奖励在内的长期回报,可用于系统模型未知的场景。

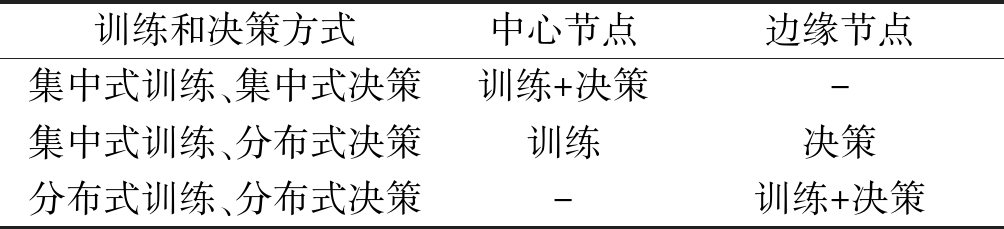

表2列出了这两类应用的典型学习方法、特点和潜力。

与传统基于数值优化的决策方法相比,采用ML主要有以下潜力。一是能降低在线计算复杂度,从而实现实时决策;二是能求解无线资源管理中的非凸、组合优化等复杂问题,从而提高网络性能;三是从获取的数据中学习网络环境,从而能适应新任务和环境变化、实现网络自治[20]。

尽管在ML的传统应用中训练开销也是很大的问题,由于无线边缘ML需要适应时变的网络且部署在能量和计算能力受限的边缘节点,更需要降低ML模型的训练复杂度、即样本复杂度和计算复杂度,其中样本复杂度指达到给定的学习目标所需要的训练样本数,计算复杂度指在给定的训练数据集上达到学习目标所需要的计算量。

目前,在无线通信领域中降低训练复杂度主要有方法级和系统级这两种思路,前者在ML中引入通信领域中的模型或知识,后者在无线网络中采用合适的决策和训练方法。

2.3 知识与数据联合驱动的ML

传统AI领域往往缺少数学模型,而在无线通信领域中,对系统、信号和信道已建立了大量的数学模型,例如数据率、信干噪比、能耗与环境参数的关系等。知识与数据联合驱动的ML把这些数学模型或一些先验知识引入到ML中,从而降低训练复杂度、加速学习过程或提升学习性能[13,21]。目前,通过把知识引入到无线边缘智能来降低训练复杂度的思路主要包括避免训练标签、减少待学习变量,以及提供训练初值等。

表2 无线边缘ML的应用和典型学习方法

Tab.2 Main applications and typical learning methods for wireless edge ML

应用典型学习方法特点潜力信息预测监督或半监督学习处理异质数据自动特征提取提高预测精度和范围策略优化深度学习监督学习无监督学习强化学习 需要计算标签系统化考虑复杂约束与环境互动实现实时决策求解复杂问题实现网络自治

1)避免训练标签

当通过监督学习来优化策略时,需要先求解原优化问题以获得训练标签,再通过ML来学习优化策略。无监督学习直接把无线策略的优化目标作为学习的损失函数[17-18],从而避免额外计算标签的过程。当优化问题的目标函数与待优化变量间存在显式的数学关系时,利用所推导出的梯度引导学习过程可以加快收敛。

文献[17]提出了以无监督方式训练DNN的方法,学习跨层优化时常见的泛函优化问题;文献[18]提出了无监督DNN,学习无线网络中普遍存在的参数优化问题;文献[19]进一步把这种学习方法扩展到了难以得到目标函数的无模型场景中。

2)减少待学习变量

利用通信系统的数学模型或某些先验知识可以减少DNN中需要学习的变量数。

在优化策略时,可以利用ML求解优化算法中的关键模块而非整个算法。例如,无线资源优化中的用户接入、子载波分配等问题是整数规划,可以利用分支定界法求解;分支定界时的剪枝策略是影响求解复杂度的关键,若优化了剪枝策略,就可有效降低求解的搜索空间。文献[22]利用DNN来学习剪枝策略而非整个分支定界法,从而降低了样本复杂度。

在对无线资源分配和传输策略进行优化时,DNN的模型参数个数往往随着小区数、用户数、天线数等网络规模急剧增长,导致很高的训练样本复杂度。文献[23]利用无线通信问题中一种广泛存在的先验知识——置换等价性来降低DNN中模型参数的个数,从而降低训练复杂度。

在强化学习中,引入模型可直接得到一些变量与环境参数的关系,减少需要与环境交互来学习的变量个数,从而加快收敛过程。文献[24]在学习由即时奖励和未来奖励组成的回报时,发现即时奖励与部分环境参数之间存在数学模型,不必再从环境中去学习,利用了这个模型即能加快学习速度。

3)提供训练初值

选择一个好的初值对加快学习的收敛过程有重要的影响。目前大多数研究只采用了一些启发式或随机初始化的策略。文献[13]提供了一种有效降低训练复杂度的方法,利用近似模型对DNN进行粗略的训练,随后再使用少量的真实数据精调模型参数。文献[25]引入了一个简单的路径损耗模型来辅助DNN训练,提高了路径损耗的预测精度。文献[26]采用次优策略作为强化学习策略网络的初值,加快了学习的收敛过程。

2.4 典型的决策和训练方式

下面比较在采用ML的无线边缘网络中常用的决策和训练方式。

1)决策方式

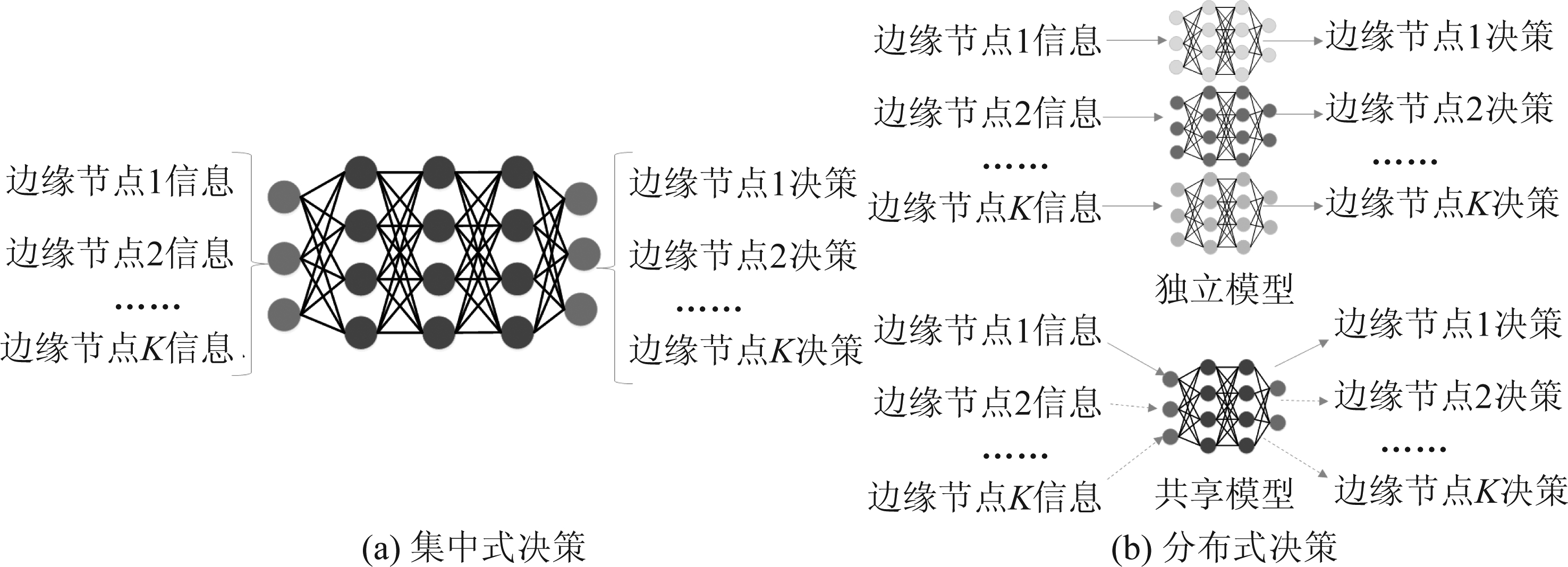

如图2所示,典型的决策方式包括“集中式决策”和“分布式决策”,前者由中心节点得到所有边缘节点的策略,如图2(a)所示;而后者在各个边缘节点分别得到各自的策略,如图2(b)所示。在分布式策略中,不同节点的ML模型可以不同、称为“独立模型”,也可以相同、称为“共享模型”。

图2 集中式决策和分布式决策

Fig.2 Centralized decision-making vs distributed decision-making

为了实现集中式决策,中心节点需要收集所有边缘节点的信息(即全局信息)来确定所有节点的策略。而在实现分布式决策时,边缘节点只需要根据各自的信息(即局部信息)来确定各自的策略。为了提升分布式策略的性能,每个边缘节点还可以与其他节点交换少量信息,此时中心节点主要用于协调信息交换。

对于集中式决策,常用的ML方法包括监督学习[16]、无监督学习[18]和单代理强化学习[27]。对于分布式决策,常用的ML方法包括无监督学习[28]和多代理强化学习(Multi agent reinforcement learning, MARL)[29]。

集中式决策和分布式决策方式主要在以下几方面有所不同:

计算开销:集中式决策联合优化多个节点的策略,其ML模型参数的个数一般随着节点数增加,训练复杂度高;而分布式决策只考虑每个节点自己的策略,模型参数相对较少。

通信开销:集中式决策需要收集所有节点的信息,通信开销大;而分布式决策利用本地信息,只需要与其他节点交换少量的信息甚至不交换信息,通信开销小。

规模扩展:当边缘节点个数发生变化时,一般需要重新学习进行集中式决策的ML模型;而分布式决策能适应网络节点数的动态变化,无需重新学习。

决策性能:集中式决策收集所有节点的信息来优化策略,能获得全局最优的性能。

响应时间:集中式决策需要先把节点信息传给中心节点,等中心节点做完决策后下发给边缘节点,决策响应时间长,难以满足低延迟业务的需求;而分布式决策直接在本地进行决策,决策响应时间短。

从上面的比较可见,分布式决策具有可扩展性强、决策响应时间短、计算和通信开销低等优点,适用于网络环境变化快、对时延和通信开销要求高的场景,目前主要用于认知无线电、车联网[29]、自组织网络[20]等中。

2)训练方式

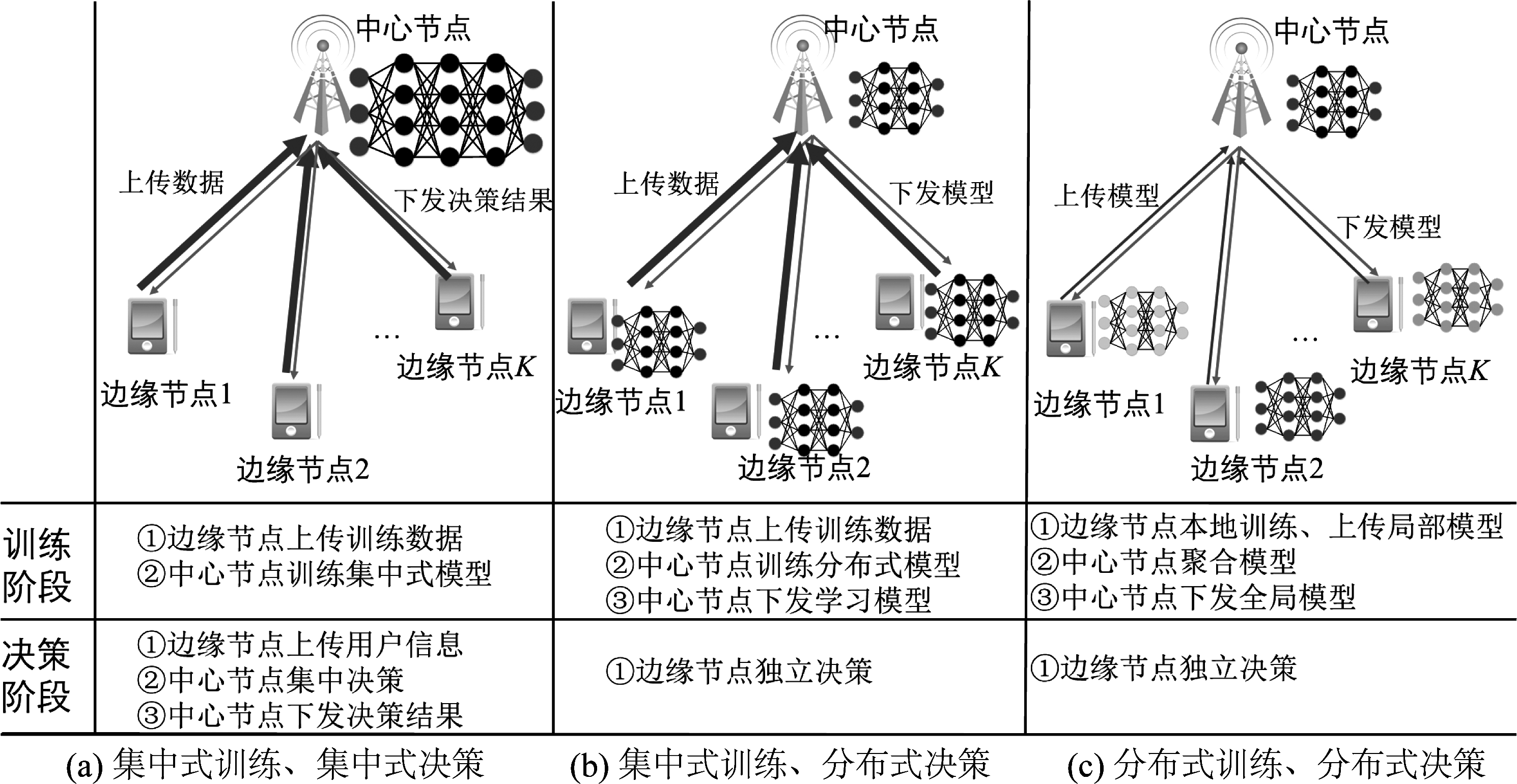

当中心节点拥有决策所需的全部数据时,可采用“集中式训练、集中式决策”。当边缘节点能获取决策所需要的数据时,可采用表1中所列出的三种训练和决策方式,具体实现过程如图3所示。

集中式训练、集中式决策:如图3(a)所示,在训练阶段,边缘节点把本地获取的数据上传给中心节点,由中心节点训练用于决策的ML模型。在决策阶段,边缘节点把数据或信息上传给中心节点,中心节点根据所有边缘节点的信息进行决策,然后再把决策结果下发给各个边缘节点。对于集中式决策,只能采用集中式训练。

集中式训练、分布式决策:对于分布式决策,可以采用集中式训练[28,30]。如图3(b)所示,在训练阶段,边缘节点把本地数据上传给中心节点,由中心节点为所有节点训练一个共享模型,再把训练好的ML模型下发给边缘节点。在决策阶段,边缘节点直接根据本地信息或与其他节点交换的少量信息进行独立决策。

分布式训练、分布式决策:在集中式训练过程中,上传数据不仅有泄露用户隐私的风险,还将产生额外的通信开销。由于这些数据只在训练阶段使用,人们开始反思是否有必要把这种只用一次又十分敏感的数据从边缘节点“搬运”到中心节点[6]。文献[31]提出的联邦学习提供了一种分布式训练框架。如图3(c)所示,每个边缘节点根据本地数据训练局部模型,再把局部模型的参数或梯度上传给中心节点;中心节点合并所有边缘节点的局部模型得到全局模型,并把全局模型下发给边缘节点进行下一轮学习。通过在边缘节点和中心节点之间进行多轮次的通信和迭代,全局模型可以达到与集中式训练相近的性能[32]。在学习过程中数据始终保存在本地,保障了边缘节点的数据隐私和安全。

图3 不同决策和训练方法的实现过程

Fig.3 Procedure of different decision-making and training methods

集中式训练和分布式训练方式主要在以下几方面有所不同:

计算开销:集中式训练的主要计算任务集中在中心节点;而分布式训练充分利用边缘节点的存储和计算能力,分担了中心节点的计算负担,容易扩展系统的规模。

通信开销:集中式训练需要上传数据,通信开销取决于数据集的大小;而分布式训练需要交换模型,并需要多轮次甚至上千轮次的通信,因此通信开销与模型大小、通信轮次、节点个数等因素有关。传输模型未必比传输数据的通信开销小,哪种训练方式更节省开销与压缩数据或模型的方法有关。

数据分布:对于移动终端,由于设备的活跃度不同,收集数据的数量不同;对于IoT设备,由于采集数据时地理位置、数据采集分辨率的不同,收集数据的质量不同。这些不同导致了不同边缘节点上的数据分布差异可能很大,即不同节点的数据具有非统计独立同分布(independent and identically distributed, IID)特性。非IID特性会影响分布式训练的学习性能、收敛速度和通信开销。而集中式训练收集所有用户的数据进行学习,不受非IID特性的影响。

设备差异:边缘节点由于硬件设施、接入网络和可用电量的变化,导致每个设备的存储、计算和通信能力各不相同,使得不同边缘节点学习的局部模型可能存在较大的性能差异。而在集中式训练中,边缘节点只起到存储和传输数据的作用,模型性能不受用户设备差异的影响。

模型性能:边缘节点数据的非IID特性在一定程度上也是由用户特征造成的,当用户本身有较大的差异时,基于集中式训练获得的共享模型性能反而不能优于根据每个用户本地数据训练的局部模型。“个性化联邦学习”[33-34]利用本地数据的差异性,在训练全局模型的同时为每个边缘节点独立训练个性化的模型,做到“千人千面”,来提升用户体验。

从上面的比较可见,分布式训练具有保护隐私、个性化学习的优势,但也受到数据分布、设备差异性的影响,与集中式训练相比是否能够降低通信开销还需要具体问题具体分析。分布式训练主要用于解决分布式决策问题,而分布式决策(而非分布式训练)具有低延迟的优势。

在考虑ML的无线边缘网络中,不同的信息预测或策略优化问题可以通过选择合适的决策和训练方法从系统级降低训练复杂度和提升学习性能。早期关于ML的研究主要考虑“集中式训练、集中式决策”。随着边缘网络规模的不断增长以及新型低延迟业务的需求,研究者开始关注“分布式训练、分布式决策”。下面讨论一种典型的分布式训练方法——联邦学习。

3 面向无线边缘的联邦学习

最近,联邦学习受到广泛的关注,已经有不少的文献综述了联邦学习在无线通信领域中的机遇、挑战及其解决方法[35-38]。文献[38]检索了2016年01月01日到2020年01月31日间的1074篇论文,筛选出231篇论文(包括ACM Digital Library论文22篇、IEEE Xplorer论文74篇、ScienceDirect论文4篇,Springer Link论文17篇、ArXiv论文106篇和谷歌学术论文8篇)进行了深入总结,采用大数据分析的方法系统地分析了联邦学习在传统AI中应用的研究现状,回答了以下几个核心问题:

动机:现有文献应用联邦学习的两大动机是保护数据隐私(62%)和提高通信效率(23%)。

应用:联邦学习主要用于个人医疗或金融数据、手机记录文本等对隐私敏感的数据,数据类型包括图像数据(49%)、结构化数据(21%)和文本数据(14%)等。考虑客户端数据分布非IID的文献(24%)、IID的文献(23%),以及两种情况都考虑的文献(13%)。

挑战:联邦学习最大的五个挑战包括通信开销(21%)、数据异质性(13%)、节点异构性(13%)、数据安全(13%)和客户端安全(12%)。

策略:解决联邦学习挑战的主要策略包括模型压缩与聚合(34%)、训练管理(10%)、激励机制(7%)、隐私保护方法(7%)和资源管理(6%)等。

指标:评价采用联邦学习的系统的指标主要包括学习性能、系统性能、通信成本、计算成本和系统运行时间等。

3.1 联邦学习在无线边缘的应用

下面介绍利用联邦学习进行信息预测和分布式决策来提升无线边缘网络性能的现有文献,主要动机是保护隐私和降低通信开销。

1)保护个人隐私

在信息预测中应用联邦学习的主要动机是保护个人隐私,常用于预测文件流行度[39]、用户喜好[40- 41]以及用户位置[42]。

预测用户偏好往往需要用到诸如对某个内容的请求次数、用户年龄、职业和地理位置等隐私敏感的信息[43]。为了避免用户向基站上传用户喜好数据时泄露用户隐私,文献[39]在设计主动缓存策略时利用联邦学习在基站端合成文件流行度。基于联邦学习,文献[40]研究了协作缓存网络中的用户请求模型,文献[41]研究了雾无线接入网中的内容流行度预测问题。

在面向VR的资源分配问题中,当用户的身体移动阻挡无线链路时,可能会因信道质量变差导致信息传输延迟。为了最小化对VR用户的服务中断,文献[42]在联邦学习框架下用回声状态网络预测用户的位置和方向,从而优化用户接入策略。

2)降低通信开销

即使训练数据不涉及隐私,也可以采用联邦学习来降低通信开销。文献[44]考虑车联网的资源分配,为了降低估计队列状态信息拖尾分布时的训练开销,车辆用户用本地保存的数据来训练模型,仅把更新的模型参数上传到路边单元;研究表明,联邦学习在获得与集中式训练相接近性能的同时降低了通信开销,车辆用户数越多,通信开销降低得也越多。

在Massive MIMO系统中,为了适应信道的变化需要实时估计信道。文献[45]考虑到集中式训练传输数据的通信开销大,采用联邦学习。研究表明,集中式训练的通信开销随着天线数成比例增加,而联邦学习的通信开销只与学习模型的大小有关,与天线数无关。当天线数较小时,集中式训练开销更低;当天线数增大时,集中式训练的通信开销超过联邦学习;当天线数为100时,联邦学习能把通信开销降低16倍。

为了降低通信开销,文献[46]在分布式功率控制问题中采用联邦学习来训练基于Actor-Critic的MARL模型,引入Wasserstein生成对抗网络应对数据的非IID分布问题。文献[35]提出了把联邦学习与MARL相结合的框架,在优化缓存策略和计算分流策略的同时降低训练和决策阶段的通信开销。针对IoT的计算分流任务,文献[47]也通过把联邦学习与MARL相结合来降低通信开销。

3.2 联邦学习的适用场景

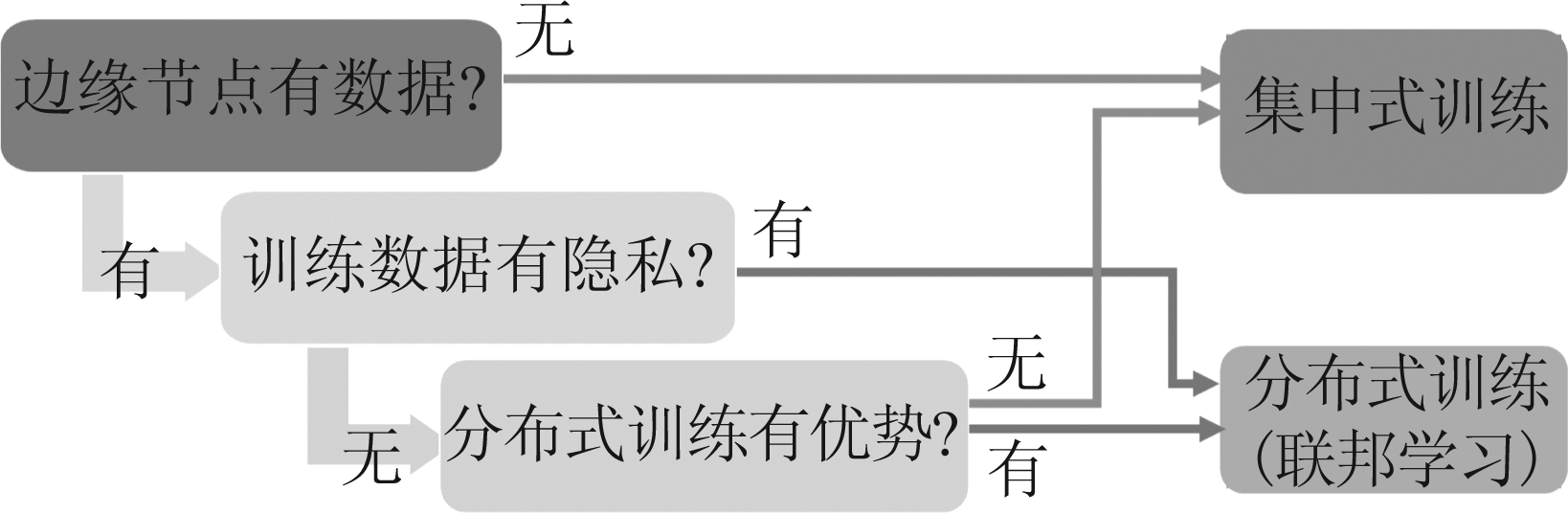

现有研究已经表明了联邦学习用于无线边缘网络中的潜力,下面讨论在哪些应用场景能采用联邦学习来训练。如图4所示,在应用联邦学习之前需要考虑以下三个问题:边缘节点是否有数据?训练数据是否涉及隐私?分布式训练是否有优势?

图4 联邦学习在无线边缘ML的适用范围

Fig.4 Scope of federated learning for wireless edge ML

1)边缘节点是否有数据

在无线边缘能否应用联邦学习,首先取决于边缘节点是否能获取数据。有些数据可在中心节点获得,有些可在边缘节点获得;还有些数据在中心和边缘都可获得,由于不同节点获取数据的代价不同,因此需要判断什么场景适合应用联邦学习。

下面以一个Massive MIMO系统对高速移动用户的信道预测问题为例说明适合考虑联邦学习的场景。

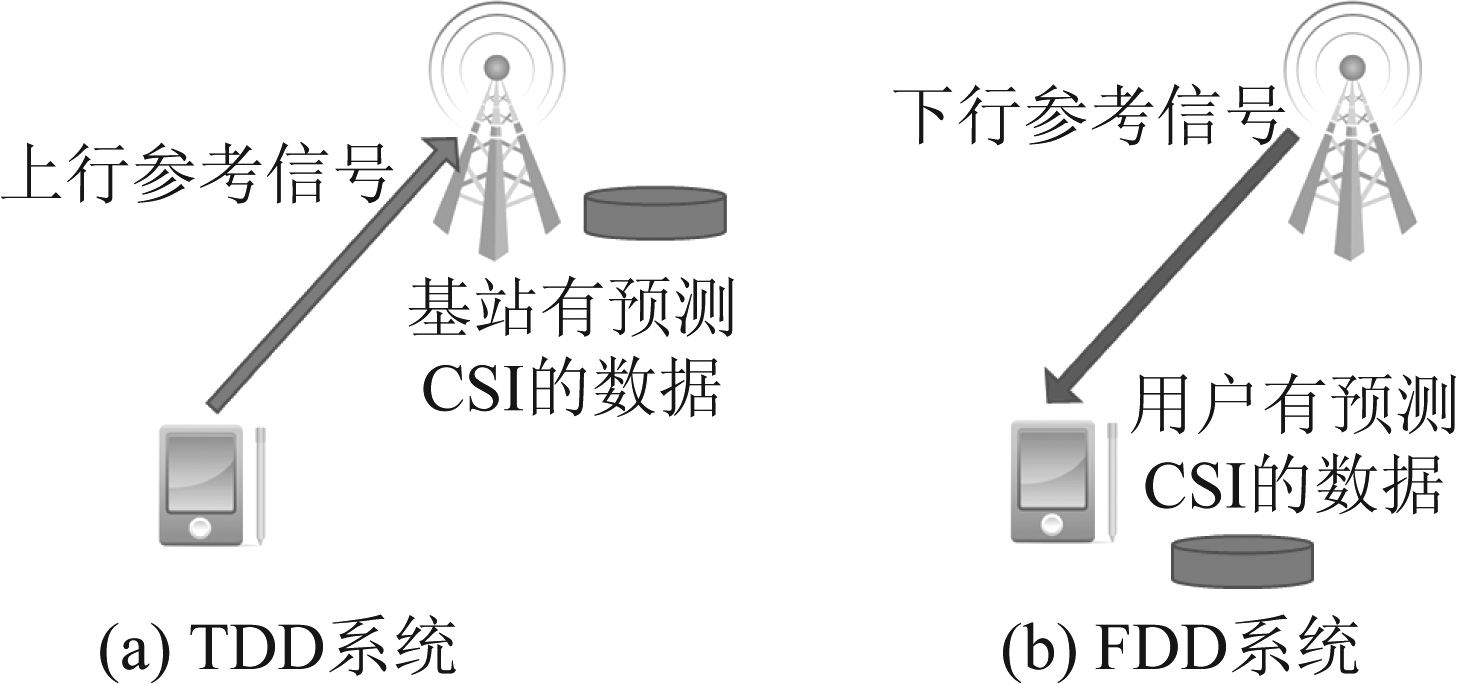

为了避免Massive MIMO系统因为CSI过时而导致性能急剧下降,需要基于未来的CSI来设计波束成形向量[10]。为了预测CSI,需要记录多个时隙的CSI。在时分双工(Time division duplex, TDD)系统中,利用上下行信道的互易性,基站可以利用上行参考信号估计CSI,而用户基于下行参考信号只能估计经过预编码后的等效信道,如图5(a)所示。基站有预测信道所需的数据,而用户没有,因此不适于采用联邦学习。频分双工(Frequency division duplex, FDD)系统需要在用户端估计CSI,如图5(b)所示。用户有预测信道所需的数据,而基站没有,因此可以在用户端应用联邦学习训练预测信道的模型。

这个例子说明,同样在Massive MIMO系统中预测信道,由于双工方式导致获取所需训练数据的位置不同,可采用的训练方法也不同。

图5 Massive MIMO系统的CSI预测

Fig.5 CSI prediction for Massive MIMO system

2)数据是否涉及隐私

尽管提出联邦学习的最早动机是保护隐私,并且文献[38]的统计结果表明62%的现有文献考虑联邦学习的动机是保护隐私,但是保护隐私未必是在无线通信系统中应用联邦学习的主要动机。首先,关于联邦学习的研究主要分为跨数据孤岛和跨设备的联邦学习这两大类[48]。跨数据孤岛的联邦学习主要研究如何在保护数据安全和隐私的条件下打破不同行业、组织、机构的数据壁垒,常用的方法包括横向联邦学习、纵向联邦学习和迁移联邦学习。跨设备的联邦学习重点研究如何在不同边缘节点上进行协作学习,充分利用边缘节点的计算和存储能力来释放边缘计算和边缘数据的潜力。在无线边缘网络中主要应用的是跨设备的联邦学习。其次,目前很多关于联邦学习的文献对隐私假设过于严格,很多无线通信中的数据并不涉及隐私,在有些场景中用户甚至有意愿共享数据来获得更好的用户体验[49]。在无线边缘应用联邦学习时,需要识别什么数据涉及隐私问题。

在5G网络中存在数据隐私、位置隐私和身份隐私[50],其中数据隐私涉及无线网络在为用户提供按需服务时可能存储和使用的私人数据,如用户访问的流媒体、医疗保健和银行等关键应用程序生成的隐私敏感数据;位置隐私涉及政府、娱乐、交通、医疗、食品配送等基于位置的服务记录的用户数据;身份隐私涉及设备、系统、用户身份等数据。当所需要的训练数据涉及以上隐私时,例如移动轨迹预测、用户喜好预测,必需采用联邦学习。

而在图5(b)所示的例子中,由于CSI不涉及隐私信息,预测CSI的ML模型既可以在用户端采用联邦学习进行训练,也可以让用户把收集到的CSI数据反馈给基站,由基站进行集中式训练。在这样的场景中,是否应用联邦学习还需要判断与集中式训练相比,分布式训练有哪些独特的优势。

3)分布式训练是否有优势

首先,集中式训练上传训练所需的数据,联邦学习上传ML模型,由于模型相对而言易于压缩,因此联邦学习有降低通信开销的潜力。

其次,当数据分布非IID时,联邦学习能为用户训练个性化的模型,提升用户体验。从图3(b)可见,集中式训练为所有节点训练出一个全局模型、即图2(b)中的共享模型。当边缘节点使用共享模型时,尽管训练数据来自所有用户,而推理数据来自单个用户。当用户之间数据分布差异不大时,训练数据和推理数据的分布是匹配的,因此全局模型能够提供较好的性能。否则,用户采用全局模型时性能并不理想。从图3(c)可见,在分布式训练时,除了中心节点聚合全局模型之外,每个边缘节点根据本地数据训练局部模型。当用户之间数据分布差异较大时,局部模型可能会优于全局模型[34]。全局模型具有较好的泛化能力,而局部模型符合用户个人特征,个性化联邦学习旨在把两者的优势结合起来,为用户提供泛化能力强的个性化模型[51]。传统的联邦学习把数据非IID特性当作缺点,而个性化联邦学习却充分利用数据非IID特性,为每个边缘节点提供最合适的模型。

3.3 通信高效的联邦学习

自谷歌提出联邦学习之初就开始研究如何降低通信开销,文献[52]提出的联邦平均算法通过增加每轮迭代中的本地计算减少边缘节点与中心节点之间的通信频次,从而降低联邦学习的总通信开销。联邦平均是目前联邦学习框架下最常用的算法,也是许多联邦学习新算法的比较基准。

1)如何评估通信开销

现有文献评估通信开销的方式包括通信轮次、传输ML模型所占用的带宽、以及完成联邦学习所需要传输的总数据量[38]。目前在文献中考虑较多的指标是总通信开销[35,45],受单轮次训练传输的数据量和总通信轮次的影响。然而,在无线边缘网络中,如何评估联邦学习的通信开销还是一个有待研究的问题,因为要考虑联邦学习对网络和参与节点的影响。

除了利用联邦学习提升无线网络的性能,优化无线通信使移动终端能应用联邦学习实现计算机视觉等传统AI任务、即把联邦学习作为无线网络支持的一种新兴业务已经在无线领域引起了不少的关注。为了使联邦学习“业务”与其他通信业务共存,需要考虑联邦学习占用多少通信资源、以及对网络的繁忙程度产生多大的影响,与传输ML模型所占用的带宽有关;而参与节点则关心参与联邦学习所消耗的流量和能耗,与总通信开销有关。当然,不同边缘节点对流量的限制不同,例如有些节点按流量付费,有些则是按时间付费;另外,不同节点对能耗的限制也不同,有些是电池容量受限的设备,有些是车辆或者有电源支持的设备。因此,评估开销时还需要考虑用户的差异性。

现有的研究工作分别从降低单轮次通信开销和降低通信轮次两个方面来降低通信开销,而前者又包括减少单轮次需要传输的数据量和减少每轮传输ML模型所需要的通信带宽。

2)降低单轮次传输的数据量

模型压缩不仅可以减少各个通信轮次传输的数据量,还能降低计算量和存储空间。常用的模型压缩方法包括模型剪枝、参数量化、低秩分解和知识蒸馏等。

模型剪枝通过剪除部分模型参数来降低模型大小,可分为细粒度和粗粒度剪枝,细粒度剪枝通过对单个权重进行剪枝,可保持较好的模型精度,但需要专用硬件才能降低计算量;而粗粒度剪枝通过对整个通道或卷积核进行剪枝,无需专用硬件就能降低计算量,但容易导致模型精度下降。模型剪枝采用“稀疏率”来表示保留多少模型参数,也反映能够提供的模型压缩增益。常用的剪枝方法有随机剪枝[53]或基于重要性剪枝[54-55],其中重要性用模型参数值/梯度的大小、或对损失函数的影响等来衡量。文献[53]最早研究了面向联邦学习的模型压缩方法,提出结构化更新和草图更新两种策略,其中结构化更新中的随机掩码和草图更新中的降采样都采用了随机剪枝。文献[54]提出了固定稀疏率的剪枝方法,边缘节点只将一定比例幅度最大的梯度传给中心节点,把其余较小的梯度以“残差”的形式累积起来,反映到下一步的梯度更新中。研究结果表明,采用1%的稀疏率几乎没有损失性能,采用0.1%的稀疏率时性能有一定下降。文献[55]发现,当稀疏率太低时,累积的梯度残差需要等很多轮次(约500~1000次)才影响更新结果,导致更新时的梯度严重过时,从而降低收敛速度和学习性能,为此,提出了深度梯度压缩,通过对残差更新后梯度清零和预训练来降低梯度过时问题,在不降低性能的同时可提供270~600倍的压缩增益。

参数量化也是降低模型规模的常用方法。考虑数据常用32位浮点数的格式存储,因此参数量化最大能够提供32倍的压缩增益。文献[56]提出符号随机梯度下降(Stochastic gradient descent,SGD),在移动设备和中心服务器之间只共享梯度的符号来减少传输ML模型时的通信开销。考虑到ML模型的梯度一般维度很高,文献[57]研究了一种基于低维Grassmannian码本的分层矢量量化方案来降低通信开销。

模型剪枝与参数量化相结合可以进一步提高压缩增益[53,58- 61]。文献[53]在草图更新策略中引入了随机旋转和概率量化,能够把模型压缩两个数量级,但使模型精度下降30%。文献[58]提出了稀疏二元压缩,在稀疏化后针对非零梯度分别采用正梯度或负梯度的均值来压缩梯度的数值,采用Golomb编码压缩梯度的位置。所提出的方法可以与联邦平均相结合,与不考虑模型压缩的技术相比,在不损失性能的同时能把总通信开销降低3531倍,在允许1%性能损失的情况下能降低37208倍。文献[59]仿真比较了几种经典压缩方法在非IID数据中的性能,结果表明符号随机梯度下降[56]由于量化会放大随机梯度的噪声,导致在非IID数据中不稳定;联邦平均由于非IID数据会增加不同边缘节点的梯度差距,与在IID数据中相比存在55%的性能下降[60];而稀疏化[54]方法在非IID数据中具有较强的鲁棒性。文献[59]将[58]中的稀疏二元压缩扩展成稀疏三元压缩,提升在非IID数据中的性能。以上研究考虑的都是细粒度剪枝,文献[61]提出的联邦随机失活,属于粗粒度剪枝,可降低边缘节点的计算开销;通过结合联邦随机失活和有损压缩,可以把下行通信开销减少14倍多,把上行通信开销减少28倍多。

低秩分解通过对ML的模型参数矩阵进行低秩分解来压缩模型,二维矩阵常用奇异值分解,高维矩阵常用CP分解(Canonical Polyadic Decomposition)、Tucker分解等[62]。文献[53]中的结构化更新即通过采用矩阵低秩分解来压缩模型。

联邦蒸馏通过交换ML模型的输出而非模型参数来降低通信开销。文献[63]的仿真结果表明,联邦蒸馏虽然可以降低通信开销,但是与联邦学习相比性能有所下降,并对非IID数据敏感。为了提升联邦蒸馏的性能,该文献进一步提出了联邦数据扩充,可以在保持95%~98%精度的同时把通信开销降低26倍。在上下行无线链路容量不对称的场景中,文献[64]提出上行链路采用联邦蒸馏、下行链路采用联邦学习可以缩短收敛时间。

3)降低单轮次通信所需的通信资源

通过设计模型上传的方式,可以降低每个轮次上传局部模型时占用的通信资源。

当多个边缘节点向中心节点上传模型时,可以在正交时频资源上进行传输以避免干扰,此时,通信开销随着节点数单调增加[58]。考虑到中心节点计算的是多个节点局部模型的平均值,空中计算(AirComp)[65](也被称为模拟压缩分布式SGD[66]和宽带模拟合并[67])为联邦学习提供了一种新的模型上传方式。

空中计算借鉴了无线传感网中传感器数据融合的思想,利用无线信号天然的广播特性,让不同边缘节点同时给中心节点发送模型,使得中心节点能够直接接收多个局部模型之和。与采用正交资源的上传方式不同,AirComp把“对抗多用户干扰”转变为“利用多用户干扰”[68],所需的通信开销不随边缘节点数增加。当通信带宽或接收信噪比受限时,基于AirComp模拟调制比基于正交资源的数字调制性能更好[69]。

在实现AirComp时,边缘节点需要先对局部模型进行模拟调制、再用相同的时频资源向中心节点上传模型。由于信道衰落会影响模拟调制信号的叠加效果,因此边缘节点在发送局部模型时需要采用基于信道逆或截断信道逆的功率分配[66- 67]。AirComp要求不同边缘节点发出的信号到达中心节点的时间同步,否则,会导致局部模型在空口叠加时发生相位旋转。为了避免相位旋转在信号叠加时正负抵消,AirComp还需要各个边缘节点估计各自到中心节点的传播延迟和衰落信道的相位响应,进行预相位调整。由于预相位调整后的相位残余偏差无法在空口叠加后在接收机消除,因此需要在发射端控制各节点的相位偏差。当信号的载波频率为2 GHz时,如果把相位偏差控制在±π/2范围内,那么边缘节点的时间同步误差需要保持在±1/8 ns的精度范围内。文献[68]总结了AirComp存在的问题,包括对同步要求高、对信道估计误差敏感,且受限于中心节点只进行简单平均操作的场景。与其他模型压缩技术相结合时,AirComp可以与联邦蒸馏相结合来提高压缩增益[69],但无法与数字量化的方式相结合。

分层聚合[70-71]通过引入辅助节点(例如小基站或中继),让边缘节点先把局部模型上传到距离较近的中间节点,辅助节点再把聚合后的模型发给中心节点。边缘节点上传模型可以采用同步或异步的方式,从而降低对同步的要求。与直接在中心节点聚合的联邦学习相比,分层聚合能降低边缘节点的能耗。

4)降低通信轮次

降低通信轮次的现有方法包括增加边缘节点的迭代次数、边缘节点选择、局部模型聚合、通信与计算资源分配和训练参数设置等。

增加边缘节点迭代次数:联邦平均[52]通过增加各边缘节点本地训练时的迭代次数来降低通信轮次。与联邦平均固定本地计算的次数不同,自适应本地计算次数可以提高学习性能、加快收敛过程[72]。

边缘节点选择:在训练过程中,计算能力弱、信道质量差、数据量少、不可靠的边缘节点会导致每轮学习周期过长,因此可通过选择合适的节点提高学习的收敛速度。常用的方法包括选择计算能力较强的边缘节点[73]、选择训练数据多的边缘节点[74]、以及选择数据重要性高的边缘节点[75],其中的数据重要性同时考虑了信道质量的好坏和对梯度更新贡献的大小。

局部模型聚合:把训练损失幅度相近的梯度聚合起来可以加快收敛过程[76]。在有些应用中,边缘节点可以通过本地数据独立学习局部模型,中心节点可以直接从已经训练好的局部模型中聚合全局模型。文献[77]的研究表明,在全连接DNN中每个隐藏层单元是一个特征提取器,在完成相似任务时,对不同局部模型的相同的特征提取器进行平均可以提高全局模型的性能。但是由于神经网络的置换不变性,相同的特征提取器可能在不同局部模型中所对应的隐藏层单元位置不同,直接按照位置合并反而会降低性能。为此,该文献提出了概率联邦神经匹配,利用贝叶斯非参数机制来识别不同局部模型中相似的神经元并进行合并,所提出的方法仅需要一轮或有限轮次通信就能得到全局模型。文献[78]进一步研究了卷积神经网络和循环神经网络中的置换不变性,提出了针对更一般神经网络的联邦匹配平均。考虑到受到无线链路质量不确定的影响时联邦匹配平均算法会匹配不正确的参数,导致达到相同学习精度所需要的计算和通信开销增加,文献[79]提出了一种特征分配方法,保证在整个训练过程中匹配的特征有序排列,从而提高学习性能并降低计算和通信开销。

通信和计算资源分配:联邦学习训练的快慢受到边缘节点计算能力和数据量的影响[80]。考虑到设备的异构性,需要为边缘节点分配合适的通信时间与计算时间来提高收敛速度。由于边缘节点的电池容量受限,还需要分配合适的发射功率并考虑计算能耗。通过联合优化传输时间、发射功率和计算频率等[80- 81],可降低联邦学习的训练时间和能量消耗。

训练参数设置:联邦学习采用SGD算法来更新模型,选择更好的梯度更新方法或合适的学习率都可以提高收敛速度。文献[82]的研究结果表明,边缘节点和中心节点采用不同的学习率能改善收敛性能,采用自适应的学习率可提高联邦平均的收敛性。文献[83]发现联邦学习收敛速度慢的原因之一是只利用了一阶梯度下降,在局部模型更新引入与最新迭代有关的动量可减少通信轮次。机器学习的超参数往往需要通过反复训练来确定,在联邦学习中不适用。为此,文献[84]提出了一种基于强化学习的超参数选择方法,来加快联邦学习的收敛速度。

其他:考虑到无线网络中用户有很强的移动性,很难全部参与整个训练过程,文献[85]提出了当每轮训练中没有完成模型更新、在训练过程中不断有新节点到达、老节点离开时的解决方法,可提高收敛速度。

5)待解决的问题

虽然已经有大量关于如何降低联邦学习通信开销的研究,但是把联邦学习应用在无线边缘网络中还存在以下问题:

不同压缩方法的结合:为了有效地降低通信开销,往往需要结合多种技术,因此需要考虑不同技术之间是否存在冲突,例如参数量化方法不能与采用模拟传输的AirComp一起应用。此外,还需要考虑不同技术之间的折中关系。数据量的总压缩率取决于梯度稀疏化和时间稀疏化的乘积,其中稀疏压缩是一种实现梯度稀疏化的方法,而联邦平均是一种实现时间稀疏化的方法。文献[58]的仿真结果表明,梯度稀疏化和时间稀疏化之间存在折中关系,也就是说,为了保持学习性能,增大时间稀疏化就要降低梯度稀疏化,反之亦然。

无线信道的不可靠性:大多数文献在评估模型压缩性能时都假设可以在无线链路中无差错地传输,没有考虑到无线链路质量不可靠的影响。与未压缩的模型相比,压缩后的模型可能会对无线链路造成的传输错误更敏感。因此,在无线环境中,能够达到的有效压缩性能还未知。

无线用户的移动性:无线用户具有较强的移动性,可能无法全程参与联邦学习。在一些需要累积残差的技术中,由于用户移动导致无法有效地积累残差,从而降低模型收敛速度。因此在设计与评估模型压缩方法时,还需要考虑用户的移动特性。

无线通信任务的性能:已有文献主要评估了计算机视觉等传统AI任务的性能,用联邦学习解决无线通信问题时能够达到的压缩增益和有效的压缩方法还未知。

3.4 个性化联邦学习

1)主要方法

文献[33-34]总结了个性化联邦学习的主要技术:

联邦迁移学习:基本思想是先通过传统联邦学习训练一个全局模型,然后中心节点把全局模型下发给每个边缘节点,边缘节点利用本地数据在全局模型的基础上构建个性化模型,无需重头开始学习。利用联邦迁移学习构建个性化模型有两种方式,一种方式是对全局模型的部分层进行微调,考虑到DNN的底层往往侧重于学习公共的和底层的特征,只需对全局模型中高层参数进行微调来学习边缘节点所具有的个性化特征;另一种方式的个性化模型由基础层和个性化顶层组成,其中基础层直接用全局模型,个性化顶层用本地数据来训练。

联邦元学习:元学习研究的是如何自动实现学习过程,通过对模型进行微调可处理一批相似的学习任务,所学习的模型根据少量的新数据即可快速适应新的学习任务。联邦元学习把联邦学习与元学习相结合[86],把不同个性化模型当成元学习中的相似任务,利用本地数据来微调全局模型,从而快速学习个性化模型。

联邦多任务学习:联邦迁移学习和联邦元学习都对全局模型进行个性化微调,而联邦多任务学习则把个性化模型直接当作不同的学习任务,通过任务间的共性和差异性来为不同节点训练个性化模型[87]。多任务学习需要为每个任务建立一个模型,因此所有节点都必须参与每轮的训练。

联邦蒸馏:联邦蒸馏把边缘节点当作“学生”,并把所有其他节点的平均模型输出当作“教师”的输出,通过输出“师生”差异来为“学生”提供学习个性化模型的方向。

利用用户情境信息:将节点的个性化情境信息引入到全局模型中,就可以为节点产生个性化模型。还可以利用节点的情境信息对节点进行聚类,把相似的节点分在一组,为每组节点训练一个独立的模型,在保留个性化的同时提高模型的泛化能力[51]。

混合全局和局部数据:每个节点不只学习全局模型,还根据全局和局部数据来学习全局和局部的混合模型。

2)待解决的问题

关于个性化联邦学习的研究刚刚起步,还存在较多的问题:

学习方法的适用性:不同个性化学习方法的性能和适用场景不同,例如文献中的联邦多任务学习要求参与的节点必须参与整个训练过程,不适于移动性较强的边缘节点;联邦元学习的复杂度高,不适于计算资源有限的场景。

全局和局部学习的矛盾:优化全局模型和个性化模型时存在一定的矛盾,例如,以最大化全局目标进行训练能提升模型的泛化能力,但是会降低模型的个性化能力[86]。如何平衡学习模型的泛化和个性化能力还有待研究。

个性化模型的评估:个性化联邦学习同时提供了多个模型,如何综合评估不同模型的性能也是一个挑战。例如,有些方法能为大多数节点带来小幅度的性能提升,而有些方法能为少数节点带来大幅度的性能提升,哪种方法更好还没有一致的结论。

4 结论

机器学习已经被广泛用于无线边缘网络中的信息预测和策略优化。为了实现无线边缘智能,除了研究可解释的、具有鲁棒性的深度学习,为了适应高度动态和资源有限的移动网络,降低训练ML的复杂度至关重要。本文讨论了两种降低训练复杂度的思路,一是知识与数据联合驱动的机器学习,二是合适的训练和决策方式;进一步介绍了能够实现分布式训练、分布式决策的联邦学习,讨论了联邦学习在边缘网络中的应用场景和研究现状。尽管业界目前已经对如何利用机器学习提升无线网络性能开展了大量的研究,但是如何系统化地结合数据和知识、如何设计轻量级、小样本的深度及强化学习模型、如何进行在线训练、以及如何发挥联邦学习的潜力等方面还存在大量开放性问题有待研究。

[1] Jiang C, Zhang H, Ren Y, et al. Machine Learning Paradigms for Next-Generation Wireless Networks[J]. IEEE Wireless Communications, 2017, 24(2): 98-105.

[2] Mao Q, Hu F, Hao Q. Deep Learning for Intelligent Wireless Networks: A Comprehensive Survey[J]. IEEE Communications Surveys & Tutorials, 2018, 20(4): 2595-2621.

[3] Park C, Seo Y, Park K Y, et al. The Concept and Realization of Context-Based Content Delivery of NGSON[J]. IEEE Communications Magazine, 2012, 50(1): 74- 81.

[4] Gunduz D, de Kerret P, Sidiropoulos N D, et al. Machine Learning in the Air[J]. IEEE Journal on Selected Areas in Communications, 2019, 37(10): 2184-2199.

[5] Vazquez M A, Pallois J P, Debbah M, et al. Deploying Artificial Intelligence in the Wireless Infrastructure: the Challenges Ahead[C]∥IEEE 5G World Forum, 2019.

[6] Park J, Samarakoon S, Bennis M, et al. Wireless network intelligence at the edge[J]. Proceedings of the IEEE, 2019, 107(11): 2204-2239.

[7] Bui N, Cesana M, Hosseini S A, et al. A Survey of Anticipatory Mobile Networking: Context-Based Classification, Prediction Methodologies, and Optimization Techniques[J]. IEEE Communications Surveys & Tutorials, 2017, 19(3): 1790-1821.

[8] Liang L, Ye H, Yu G, et al. Deep Learning based Wireless Resource Allocation with Application to Vehicular Networks[J]. Proceedings of the IEEE, 2020, 108(2): 341-356.

[9] Zhang H, Dai L. Mobility Prediction: A Survey on State-of-the-Art Schemes and Future Applications[J]. IEEE Access, 2019, 7: 802- 822.

[10] Yin H, Wang H, Liu Y, et al. Addressing the Curse of Mobility in Massive MIMO with Prony-based Angular-delay Domain Channel Predictions[J]. IEEE Journal on Selected Areas in Communications, 2020, Early Access.

[11] Guo J, Yang C, Chih-Lin I. Exploiting Future Radio Resources with End-to-End Prediction by Deep Learning[J]. IEEE Access, 2018, 6: 75729-75747.

[12] Liu D, Yang C. Caching at Base Stations with Heterogeneous User Demands and Spatial Locality[J]. IEEE Transactions on Communications, 2019, 67(2): 1554-1569.

[13] Zappone A, Di Renzo M, Debbah M. Wireless Networks Design in the Era of Deep Learning: Model-Based, AI-Based, or Both?[J]. IEEE Transactions on Communications, 2019, 67(10): 7331-7376.

[14] Luong N C, Hoang D T, Gong S, et al. Applications of Deep Reinforcement Learning in Communications and Networking: A Survey[J]. IEEE Communications Surveys & Tutorials, 2019, 21(4): 3133-3174.

[15] Oshea T, Hoydis J. An Introduction to Deep Learning for the Physical Layer[J]. IEEE Transactions on Cognitive Communications & Networking, 2017, 3(4): 563-575.

[16] Sun H, Chen X, Shi Q, et al. Learning to Optimize: Training Deep Neural Networks for Interference Management[J]. IEEE Transactions on Signal Processing, 2018, 66(20): 5438-5453.

[17] Eisen M, Zhang C, Chamon L F O, et al. Learning Optimal Resource Allocations in Wireless Systems[J]. IEEE Transactions on Signal Processing, 2019, 67(10): 2775-2790.

[18] Sun C, Yang C. Learning to Optimize with Unsupervised Learning: Training Deep Neural Networks for URLLC[C]∥IEEE PIMRC, 2019.

[19] Liu D, Sun C, Yang C, et al. Optimizing Wireless Systems Using Unsupervised and Reinforced-Unsupervised Deep Learning[J]. IEEE Network, 2020, 34(4): 270-277.

[20] Klaine P V, Imran M A, Onireti O, et al. A Survey of Machine Learning Techniques Applied to Self-Organizing Cellular Networks[J]. IEEE Communications Surveys & Tutorials, 2017, 19(4): 2392-2431.

[21] He H, Jin S, Wen C K, et al. Model-driven Deep Learning for Physical Layer Communications[J]. IEEE Wireless Communications, 2019, 26(5): 77- 83.

[22] Shen Y, Shi Y, Zhang J, et al. LORM: Learning to optimize for resource management in wireless networks with few training samples[J]. IEEE Transactions on Wireless Communications, 2020, 19(1): 665- 679.

[23] Guo J, Yang C. Constructing Deep Neural Networks with a Priori Knowledge of Wireless Tasks[EB/OL]. arXiv: 2001.11355, 2020.

[24] Liu D, Zhao J, Yang C, et al. Accelerating Deep Reinforcement Learning With the Aid of a Partial Model: Power-Efficient Predictive Video Streaming[EB/OL]. arXiv: 2003.09708, 2020.

[25] Thrane J, Zibar D, Christiansen H L. Model-Aided Deep Learning Method for Path Loss Prediction in Mobile Communication Systems at 2.6 GHz[J]. IEEE Access, 2020, 8: 7925-7936.

[26] Zou Y, Xie Y, Zhang C, et al. Optimization-driven Hierarchical Deep Reinforcement Learning for Hybrid Relaying Communications[C]∥IEEE WCNC, 2020.

[27] Liang L, Ye H, Li G Y. Toward Intelligent Vehicular Networks: A Machine Learning Framework[J]. IEEE Internet of Things Journal, 2019, 6(1): 124-135.

[28] Lee H, Lee S H, Quek T Q S. Deep Learning for Distributed Optimization: Applications to Wireless Resource Management[J]. IEEE Journal on Selected Areas in Communications, 2019, 37(10): 2251-2266.

[29] Althamary I, Huang C W, Lin P. A Survey on Multi-Agent Reinforcement Learning Methods for Vehicular Networks[C]∥IEEE International Wireless Communications and Mobile Computing Conference, 2019.

[30] Li Z, Guo C. Multi-Agent Deep Reinforcement Learning based Spectrum Allocation for D2D Underlay Communications[J]. IEEE Transactions on Vehicular Technology, 2020, 69(2): 1828-1840.

[31] Mcmahan H B, Moore E, Ramage D, et al. Federated Learning of Deep Networks using Model Averaging[EB/OL]. arXiv: 1602.05629, 2016.

[32] Bonawitz K, Eichner H, Grieskamp W, et al. Towards Federated Learning at Scale: System design[EB/OL]. arXiv: 1902.01046, 2019.

[33] Kulkarni V, Kulkarni M, Pant A. Survey of Personalization Techniques for Federated Learning[EB/OL]. arXiv: 2003.08673, 2020.

[34] Wu Q, He K, Chen X. Personalized Federated Learning for Intelligent IoT Applications: A Cloud-Edge based Framework[J]. IEEE Open Journal of the Computer Society, 2020, 1: 35- 44.

[35] Wang X, Han Y, Wang C, et al. In-Edge AI: Intelligentizing Mobile Edge Computing, Caching and Communication by Federated Learning[J]. IEEE Network, 2019, 33(5): 156-165.

[36] Niknam S, Dhillon H S, Reed J H. Federated Learning for Wireless Communications: Motivation, Opportunities, and Challenges[J]. IEEE Communications Magazine, 2020, 58(6): 46-51.

[37] Lim W Y B, Luong N C, Hoang D T, et al. Federated Learning in Mobile Edge Networks: A Comprehensive Survey[J]. IEEE Communications Surveys & Tutorials, 2020, 22(3): 2031-2063.

[38] Lo S K, Lu Q, Wang C, et al. A Systematic Literature Review on Federated Machine Learning: From a Software Engineering Perspective[EB/OL]. arXiv: 2007.11354, 2020.

[39] Qi K, Yang C. Popularity Prediction with Federated Learning for Proactive Caching at Wireless Edge[C]∥IEEE WCNC, 2020.

[40] Wang X, Wang C, Li X, et al. Federated Deep Reinforcement Learning for Internet of Things with Decentralized Cooperative Edge Caching[J]. IEEE Internet of Things Journal, 2020, 7(10): 9441-9455.

[41] Wu Y, Jiang Y, Bennis M, et al. Content Popularity Prediction in Fog Radio Access Networks: A Federated Learning Based Approach[C]∥IEEE ICC, 2020.

[42] Chen M, Semiari O, Saad W, et al. Federated Echo State Learning for Minimizing Breaks in Presence in Wireless Virtual Reality Networks[J]. IEEE Transactions on Wireless Communications, 2020, 19(1): 177-191.

[43] Qian Y, Hu L, Chen J, et al. Privacy-aware Service Placement for Mobile Edge Computing via Federated Learning[J]. Information Sciences, 2019, 505: 562-570.

[44] Samarakoon S, Bennis M, Saad W, et al. Distributed Federated Learning for Ultra-Reliable Low-Latency Vehicular Communications[J]. IEEE Transactions on Communications, 2020, 68(2): 1146-1159.

[45] Elbir A M, Coleri S. Federated Learning for Channel Estimation in Conventional and IRS-Assisted Massive MIMO[EB/OL]. arXiv: 2008.10846, 2020.

[46] Yan M, Chen B, Feng G, et al. Federated Cooperation and Augmentation for Power Allocation in Decentralized Wireless Networks[J]. IEEE Access, 2020, 8: 48088- 48100.

[47] Ren J, Wang H, Hou T, et al. Federated Learning-based Computation Offloading Optimization in Edge Computing-supported Internet of Things[J]. IEEE Access, 2019, 7: 69194- 69201.

[48] Kairouz P, McMahan H B, Avent B, et al. Advances and Open Problems in Federated Learning[EB/OL]. arXiv: 1912.04977, 2019.

[49] Hosseinalipour S, Brinton C G, Aggarwal V, et al. From Federated Learning to Fog Learning: Towards Large-Scale Distributed Machine Learning in Heterogeneous Wireless Networks[EB/OL]. arXiv: 2006.03594, 2020.

[50] Kumar T, Liyanage M, Ahmad I, et al. User Privacy, Identity and Trust in 5G[M]. A Comprehensive Guide to 5G Security, 2018.

[51] Mansour Y, Mohri M, Ro J, et al. Three Approaches for Personalization with Applications to Federated Learning[J]. Computer Science, 2020.

[52] Mcmahan H B, Moore E, Ramage D, et al. Communication-Efficient Learning of Deep Networks from Decentralized Data[C]∥International Conference on Artificial Intelligence and Statistics, 2017.

[53] Konen J, Mcmahan H B, Yu F X, et al. Federated Learning: Strategies for Improving Communication Efficiency[C]∥International Conference on Learning Representations, 2018.

[54] Aji A F, Heafield K. Sparse communication for distributed gradient descent[C]∥Conference on Empirical Methods in Natural Language Processing, 2017.

[55] Lin Y, Han S, Mao H, et al. Deep Gradient Compression: Reducing the Communication Bandwidth for Distributed Training[C]∥International Conference on Learning Representations, 2018.

[56] Bernstein J, Wang Y, Azizzadenesheli K, et al. signSGD: Compressed optimisation for non-convex problems[C]∥Proceedings of Machine Learning Research, 2018.

[57] Du Y, Yang S, Huang K. High-Dimensional Stochastic Gradient Quantization for Communication-Efficient Edge Learning[J]. IEEE Transactions on Signal Processing, 2020, 68: 2128-2142.

[58] Sattler F, Wiedemann S, Müller, Klaus-Robert, et al. Sparse Binary Compression: Towards Distributed Deep Learning with minimal Communication[C]∥International Joint Conference on Neural Networks, 2019.

[59] Sattler F, Wiedemann S, Müller, Klaus-Robert, et al. Robust and Communication-Efficient Federated Learning from Non-IID Data[J]. IEEE Transactions on Neural Network Learning System, 2020, 31(9): 3400-3413.

[60] Zhao Y, Li M, Lai L, et al. Federated Learning with Non-iid Data[EB/OL]. arXiv: 1806.00582, 2018.

[61] Caldas S, Konecny J, McMahan H B, et al. Expanding the Reach of Federated Learning by Reducing Client Resource Requirements[EB/OL]. arXiv: 1812.07210, 2018.

[62] Rabanser S, Shchur O, Gunnemann S. Introduction to Tensor Decompositions and Their Applications in Machine Learning[EB/OL]. arXiv: 1711.10781, 2017.

[63] Jeong E, Oh S, Kim H, et al. Communication-Efficient On-Device Machine Learning: Federated Distillation and Augmentation under Non-IID Private Data[C]∥Conference on Neural Information Processing Systems, 2018.

[64] Oh S, Park J, Jeong E, et al. Mix2FLD: Downlink Federated Learning After Uplink Federated Distillation With Two-Way Mixup[J]. IEEE Communications Letters, 2020, 24(10): 2211-2215.

[65] Yang K, Jiang T, Shi Y, et al. Federated Learning via Over-the-air Computation[J]. IEEE Transactions on Wireless Communications, 2020, 19(3): 2022-2035.

[66] Amiri M M, Gunduz D. Federated Learning over Wireless Fading Channels[J]. IEEE Transactions on Wireless Communications, 2020, 19(5): 3546-3557.

[67] Zhu G, Wang Y, Huang K. Broadband Analog Aggregation for Low-Latency Federated Edge Learning[J]. IEEE Transactions on Wireless Communications, 2020, 19(1): 491-506.

[68] Zhu G, Liu D, Du Y, et al. Toward an Intelligent Edge: Wireless Communication Meets Machine Learning[J]. IEEE Communications Magazine, 2020, 58(1): 19-25.

[69] Ahn J H, Simeone O, Kang J. Wireless Federated Distillation for Distributed Edge Learning with Heterogeneous Data[C]∥IEEE PIMRC, 2019.

[70] Liu L, Zhang J, Song S H, et al. Client-Edge-Cloud Hierarchical Federated Learning[C]∥IEEE ICC, 2020.

[71] Hosseinalipour S, Azam S S, Brinton C G, et al. Multi-Stage Hybrid Federated Learning over Large-Scale Wireless Fog Networks[EB/OL]. arXiv: 2007.09511, 2020.

[72] Wang S, Tuor T, Salonidis T, et al. Adaptive Federated Learning in Resource Constrained Edge Computing Systems[J]. IEEE Journal on Selected Areas in Communications, 2019, 37(6): 1205-1221.

[73] Nishio T, Yonetani R. Client Selection for Federated Learning with Heterogeneous Resources in Mobile Edge[C]∥IEEE ICC, 2019.

[74] Wang C, Yang Y, Zhou P. Towards Efficient Scheduling of Federated Mobile Devices under Computational and Statistical Heterogeneity[EB/OL]. arXiv: 2005.12326, 2020.

[75] Ren J, He Y, Wen D, et al. Scheduling for Cellular Federated Edge Learning with Importance and Channel Awareness[J]. IEEE Transactions on Wireless Communications, 2020, Early Access.

[76] Dimitriadis D, Kumatani K, Gmyr R, et al. Federated Transfer Learning with Dynamic Gradient Aggregation[EB/OL]. arXiv: 2008.02452, 2020.

[77] Yurochkin M, Agarwal M, Ghosh S, et al. Bayesian Nonparametric Federated Learning of Neural Networks[C]∥International Conference on Machine Learning, 2019.

[78] Wang H, Yurochkin M, Sun Y, et al. Federated Learning with Matched Averaging[C]∥International Conference on Learning Representations, 2020.

[79] Yu F, Zhang W, Qin Z, et al. Heterogeneous Federated Learning[EB/OL]. arXiv: 2008.06767, 2020.

[80] Tran N H, Bao W, Zomaya A, et al. Federated Learning over Wireless Networks: Optimization Model Design and Analysis[C]∥IEEE INFOCOM, 2019.

[81] Anh T T, Luong N C, Niyato D, et al. Efficient Training Management for Mobile Crowd-Machine Learning: A Deep Reinforcement Learning Approach[J]. IEEE Wireless Communications Lett., 2019, 8(5): 1345-1348.

[82] Charles Z, Konecny J. On the Outsized Importance of Learning Rates in Local Update Methods[EB/OL]. arXiv: 2007.00878, 2020.

[83] Liu W, Chen L, Chen Y, et al. Accelerating Federated Learning via Momentum Gradient Descent[J]. IEEE Transactions on Parallel and Distributed Systems, 2020, 31(8): 1754-1766.

[84] Mostafa H. Robust Federated Learning Through Representation Matching and Adaptive Hyper-parameters[EB/OL]. arXiv: 1912.13075, 2019.

[85] Ruan Y, Zhang X, Liang S C, et al. Towards Flexible Device Participation in Federated Learning for Non-IID Data[EB/OL]. arXiv: 2006.06954, 2020.

[86] Jiang Y, Konen J, Rush K, et al. Improving Federated Learning Personalization via Model Agnostic Meta Learning[EB/OL]. arXiv: 1909.12488, 2019.

[87] Smith V, Chiang C K, Sanjabi M, et al. Federated Multi-Task Learning[EB/OL]. arXiv: 1705.10467, 2017.