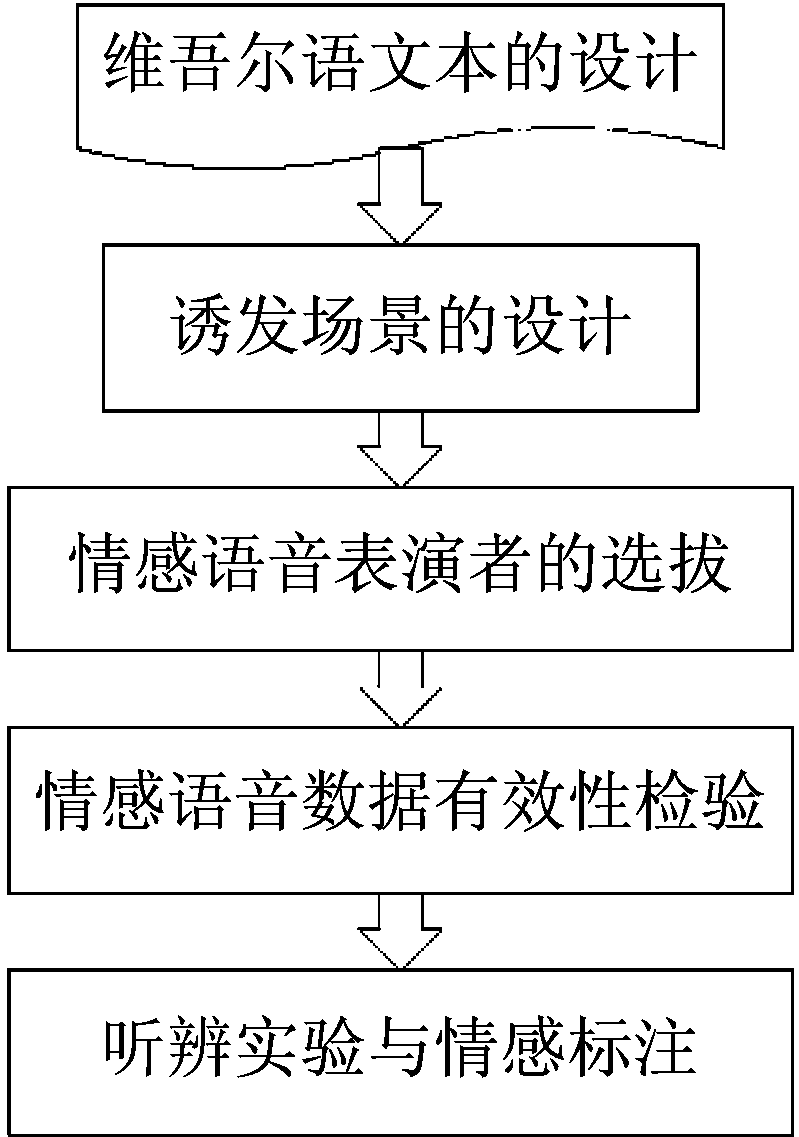

图1 情感语音数据的采集流程

Fig.1 Emotional speech data collection flow

Reference format: Tashpolat Nizamidin, Liang Ruiyu, Xie Yue, et al. Atomic Representation Based Emotion Recognition from Uyghur Speech[J]. Journal of Signal Processing, 2020, 36(1): 9-17. DOI: 10.16798/j.issn.1003- 0530.2020.01.002.

在许多机器学习问题中,尤其是那些涉及现实世界的应用中,研究人员必须处理高维数据或高维特征的数据[1]。不幸的是,由于计算限制,处理如此大的特征空间可能是不切实际的。因此,在保持原始特征空间的相关信息的同时,探索可以方便计算的替代方法就至关重要。许多人机交互任务中都有这种需求。

上个世纪70年代以来情感计算受到了众多学者的重视。情感计算是一门多学科交叉的研究领域,如认知科学、心理科学等[2]。语音情感是人类彼此之间情感交流最方便、最直接的手段之一,更多的研究人员开始探究语音情感识别任务。语音情感识别是计算辅助语言学的重要子领域,专注于利用抽象地语音表征来分类或预测人类的一系列情感行为[3]。从语音信号中识别情感类别在许多真实场景里被应用,包括人机交互[4],儿童自闭症的诊断与治疗,安全驾驶等[5]。

最近几年研究者们提出了各种情感识别算法,包括基于传统机器学习的算法,基于深度学习的人工神经网络算法,还有基于图模型(Graph embeding)的特征维数约简算法等[6]。其中,传统机器学习的算法在解决训练数据集数量较小的高维度分类任务上效果较好,也比较适合于语音情感识别[7]。王治平等人提出了基于支持向量机的语音情感识别[8]。利用支持向量机把提取的情感特征参数使用非线性的核函数映射到高维空间,从而构建最优分类超平面实现情感类型的识别。张明阳等人提出了结合数据场情感空间和混合蛙跳算法的连续语音情感变化趋势检测[9],利用情感特征量模拟数据场粒子,用势能函数描述粒子之间的相互作用。然后运用混合蛙跳算法技术,用青蛙个体来模拟情感状态变化过程中的情感特征量,得到情感变化的趋势。徐新洲等人提出了结合子空间学习和极端学习机的语音情感识别[10],利用极限学习机进行维数约简,提出了一种基于谱回归的子空间学习与极限学习机相结合的新框架,有助于提取出情感语音的有效成分。

模式识别领域内“基于表示分类”(Representation based classification)的方法在过去几年中引起了研究者们浓厚的兴趣[11]。对于一个新的测试样本y, 表示分类首先通过约束字典学习到一个y的表示向量,将利用表示向量把新样本y赋给最小重构残差的类别。本文提出了一种采用原子表示模型(Atomic Representation)[12]的语音情感识别算法。通过引入一个新的条件,称为原子分类条件。在这种条件下,对正确识别新的语音情感样本有较好的效果。现有的基于表示分类的算法以稀疏表示的方法为主,而提出的算法可以结合稀疏表示模型和其他的表示模型。通过原子表示模型对情感特征空间建模。该算法能放宽适用条件的范围,将表示模型适应语音情感识别任务。

目前的研究工作主要分析和识别英语、汉语、德语等大语种。亦缺少国内少数民族语言的语音情感识别研究[13]。国外公开发布的语音情感数据库有英语、德语、丹麦语、日语等语种,如Belfast情感数据库[14]、柏林EMO-DB德语情感语音库[15]、FAU AIBO儿童德语情感语音库[16]等。国内除了汉语普通话以外还没有研究者公布对国内少数民族语言语音情感识别的研究,亦缺少维吾尔语、蒙古语或者藏语情感数据库。

为了填补国内少数民族语言语音情感领域的研究空白,录制并建立了一个维吾尔语语音情感数据库。该数据库中包含六种基本情感,如,高兴、生气、难过、平静、惊讶、害怕等。维吾尔语和汉语语音在情感的表达上有所不同,文献[17]中对现代汉语-维吾尔语语气词进行对比研究,两种语言语气词分布位置都有差异。文本对维吾尔语语音信号中的情感特征进行语音情感特征分析。在语法结构上,维吾尔语是“主-宾-动”型结构。维吾尔语包括单元音8个,辅音24个,每个音节至少有一个元音。维吾尔语是黏着性语言,元音弱化现象比较突出。与汉语不同的是,维吾尔语里没有声调变化。

有效的表示情感特征对语音情感识别效果影响较大,因此本文中采用基于原子表示模型的语音情感识别算法对维吾尔语语音情感样本进行建模。在维吾尔语情感语音中提取情感特征,用原子表示模型对这些提取的情感特征空间进行建模,在构建好的情感空间模型中选出最逼近的情感类别,从而达到情感预测的目的。

语音情感数据库对语音情感识别任务是至关重要的,语音情感数据集质量的好坏,对于情感特征的提取、情感模型的建立等各方面都影响比较大。因此,我们录制并建立了一个维吾尔语语音情感数据集,其流程如图1所示。

图1 情感语音数据的采集流程

Fig.1 Emotional speech data collection flow

首先准备了没有情感偏向性的10条维吾尔语句子。然后母语为维吾尔语的10名男性和10名女性被录制人员参与录制。被录制人员年龄在20岁到40岁之间,在校表演系学生为主,维吾尔语口语流利。

该情感数据库包含了六种基本的情感类别,如,高兴、平静、生气、害怕、惊讶和伤心等,因此,该语音情感数据库有1200条情感语音组成(10个句子*20名录制者*6类情感)。这六类跟国内外的公开数据库的情感类别基本一致,这样可以在今后的研究中跟已有的公开库进行跨库的语音情感识别研究。

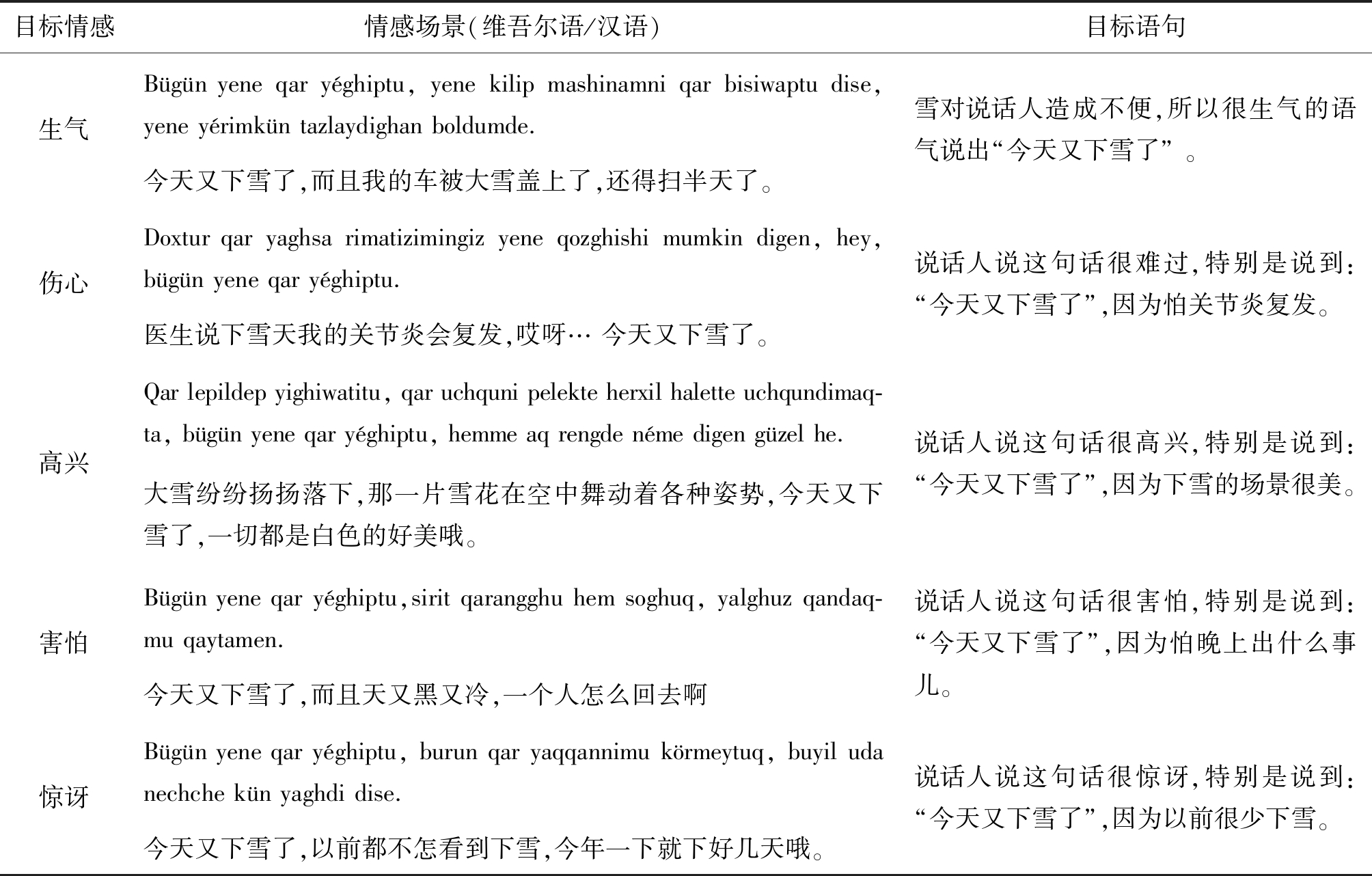

在数据库录制时,为了得到预设类别的情感语音,我们使用一些帮助情感表演逼真性的辅助手段(让表演者观看后诱发相应情感的影视频、音乐,使得表演者处于兴奋或悲哀等情感状态)。如表2所示。表演者根据上下文情景,通过激发相应的情绪进行表演录制。我们可以看出,通过这些辅助手段可以得到自然度较高的情感语音,能够得到更可信的情感识别和情感特征分析结果。

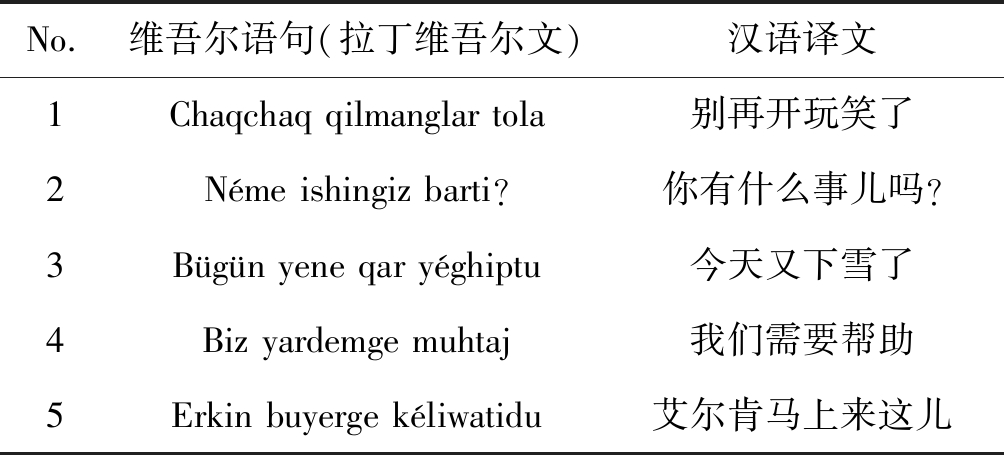

表1 维吾尔语文本语句

Tab.1 Uyghur text

No.维吾尔语句(拉丁维吾尔文)汉语译文1Chaqchaq qilmanglar tola别再开玩笑了2Néme ishingiz barti?你有什么事儿吗?3Bügün yene qar yéghiptu今天又下雪了4Biz yardemge muhtaj我们需要帮助5Erkin buyerge kéliwatidu艾尔肯马上来这儿

表2 情感场景诱发

Tab.2 Emotional induction scenario

目标情感情感场景(维吾尔语/汉语)目标语句生气Bügünyeneqaryéghiptu,yenekilipmashinamniqarbisiwaptudise,yeneyérimküntazlaydighanboldumde.今天又下雪了,而且我的车被大雪盖上了,还得扫半天了。雪对说话人造成不便,所以很生气的语气说出“今天又下雪了”。伤心Doxturqaryaghsarimatizimingizyeneqozghishimumkindigen,hey,bügünyeneqaryéghiptu.医生说下雪天我的关节炎会复发,哎呀…今天又下雪了。说话人说这句话很难过,特别是说到:“今天又下雪了”,因为怕关节炎复发。高兴Qarlepildepyighiwatitu,qaruchqunipelekteherxilhaletteuchqundimaq-ta,bügünyeneqaryéghiptu,hemmeaqrengdenémedigengüzelhe.大雪纷纷扬扬落下,那一片雪花在空中舞动着各种姿势,今天又下雪了,一切都是白色的好美哦。说话人说这句话很高兴,特别是说到:“今天又下雪了”,因为下雪的场景很美。害怕Bügünyeneqaryéghiptu,siritqarangghuhemsoghuq,yalghuzqandaq-muqaytamen.今天又下雪了,而且天又黑又冷,一个人怎么回去啊说话人说这句话很害怕,特别是说到:“今天又下雪了”,因为怕晚上出什么事儿。惊讶Bügünyeneqaryéghiptu,burunqaryaqqannimukörmeytuq,buyiludanechchekünyaghdidise.今天又下雪了,以前都不怎看到下雪,今年一下就下好几天哦。说话人说这句话很惊讶,特别是说到:“今天又下雪了”,因为以前很少下雪。

情感数据库的录制在无人的教室内进行。使用的录音装置包括:高配置的计算机1台、SONY牌录音笔一支、一只高音质的耳机。采用精度为16位、采用频率为44.1 kHz、语音储存为PCM编码的wav格式。录制过程中根据情感语音的自然度和音质,对效果较差的语音进行重录。

情感特征的选择对语音情感识别任务影响较大,提取何种特征是目前该领域至关重要的步骤之一。

语音信号是一个非平稳的时变信号。因此,不能套用适用于平稳信号的处理或分析方法。但是在一个短时间段内(10 ms~30 ms),其特性基本保持不变,又可以看作是一个准平稳过程。所以在分析语音信号时,大多采用短时分帧技术进行分析:将语音信号分成一个个长度在10 ms~30 ms的时间段,每一段称为一帧,在帧内按照平稳信号分析法进行分析和提取特征参数。

在本文中,对所录制的语音分帧时,加窗用的是汉明窗(Hamming Window)。在加窗时为了到达平滑过渡的效果,各个帧之间的叠加部分设为帧长度的1/2。

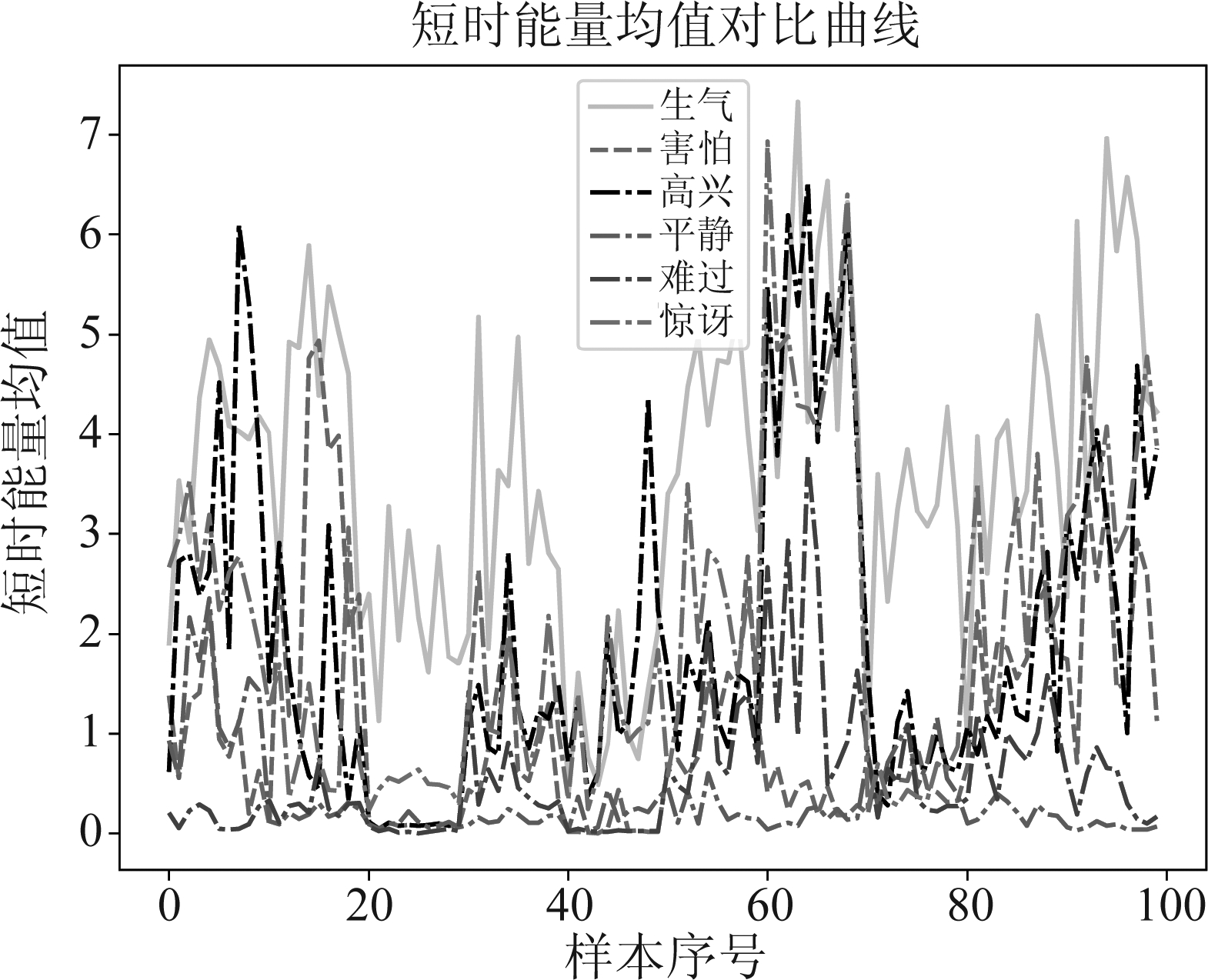

下面我们对维吾尔语情感语音提取短时能量,短时过零率,基因周期和响度等几种重要韵律特征并针对各个情感类别进行对比分析。

(1)短时能量

语音信号的短时能量E0计算如下:

(1)

其中sw(n)为加窗语音信号。

短时能量对不同语音所表达的情感具有较强的区分性, 人也同样会有这种感觉,就是当我们生气或者惊讶时,说话的音量就越大,而当我们悲哀或伤心时,往往说话的音量就越低。在语音情感领域,这些特点都是重要的研究对象。

维吾尔语六种情感语音的短时能量均值对比曲线如图2所示。从短时能量对比图中我们可以发现维吾尔语情感语音的特点,生气状态下的样本短时能量比平静、害怕和难过状态下的短时能量值更大。高兴状态下的短时能量样本多数情况下也比平静状态下的短时能量更大。所以短时能量对各情感类别之间具有一定的区分性。

图2 六类维吾尔语情感语音的短时能量对比图

Fig.2 The six types of Uyghur emotional speech short time energy comparison chart

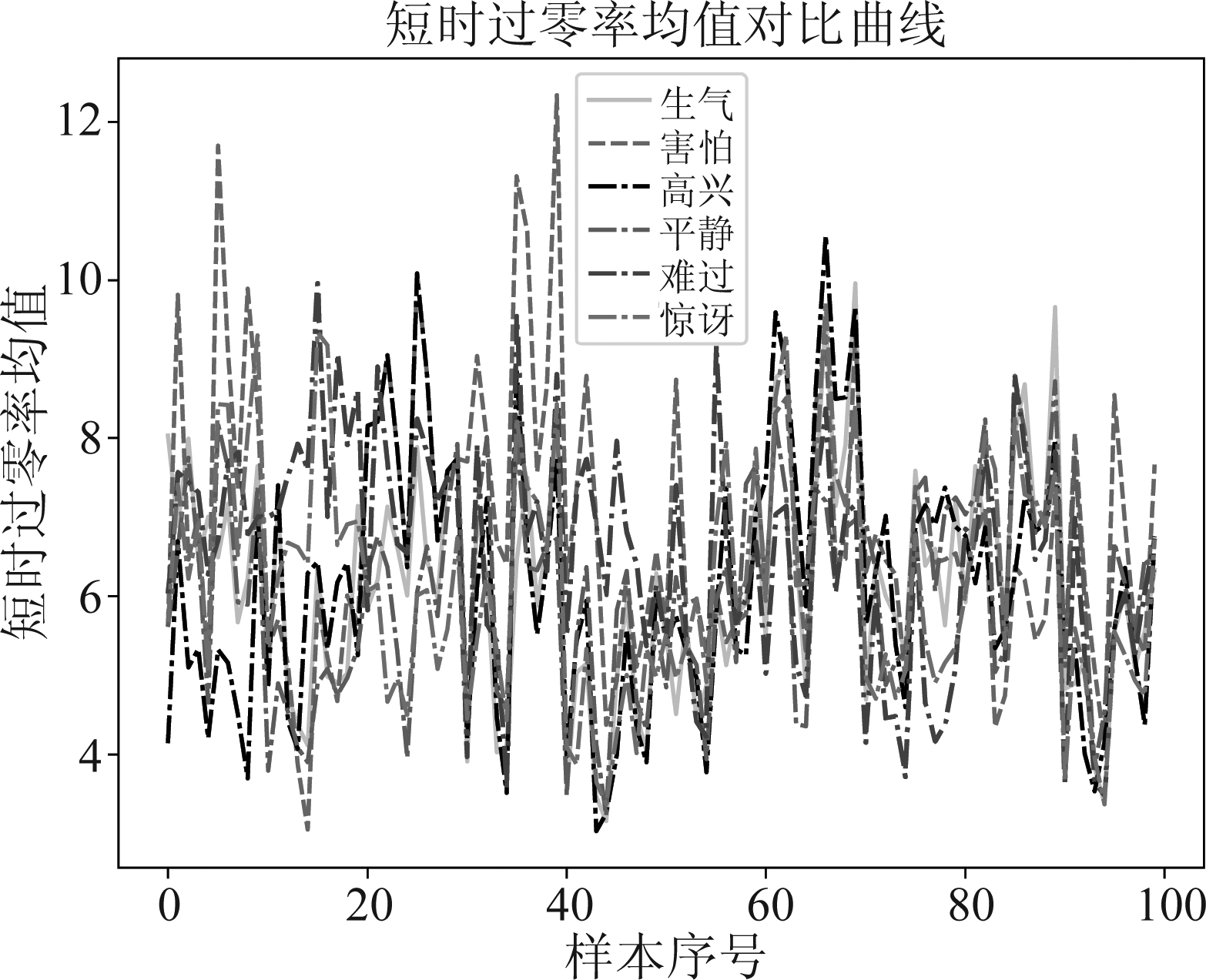

(2)短时过零率

短时过零率是指语音信号中一帧语音波形与横轴(零电平)相交的次数。对于模拟语音信号而言,时域波形穿过时间轴称为过零;而对于数字化的语音信号,如果毗连的采样值幅度正负值替换则意味着过零。因此,采样值变更正负值的次数称为过零率。

定义语音信号xn(m)的短时过零率Zn为:

(2)

式中,sgn[·]是符号函数,即:

(3)

六类维吾尔语情感语音信号的过零率均值统计曲线如下图3所示。从图中能够看出来,短时过零率特征对于维吾尔语情感语音的区分性作用比短时能量特征差一些。害怕情感状态下的样本过零率值多数情况下是比平静状态下的样本值高。对于其他类情感区分性不高。

图3 六类维吾尔语情感语音的过零率均值统计曲线

Fig.3 The six types of Uyghur emotional speech zero cross rates comparison chart

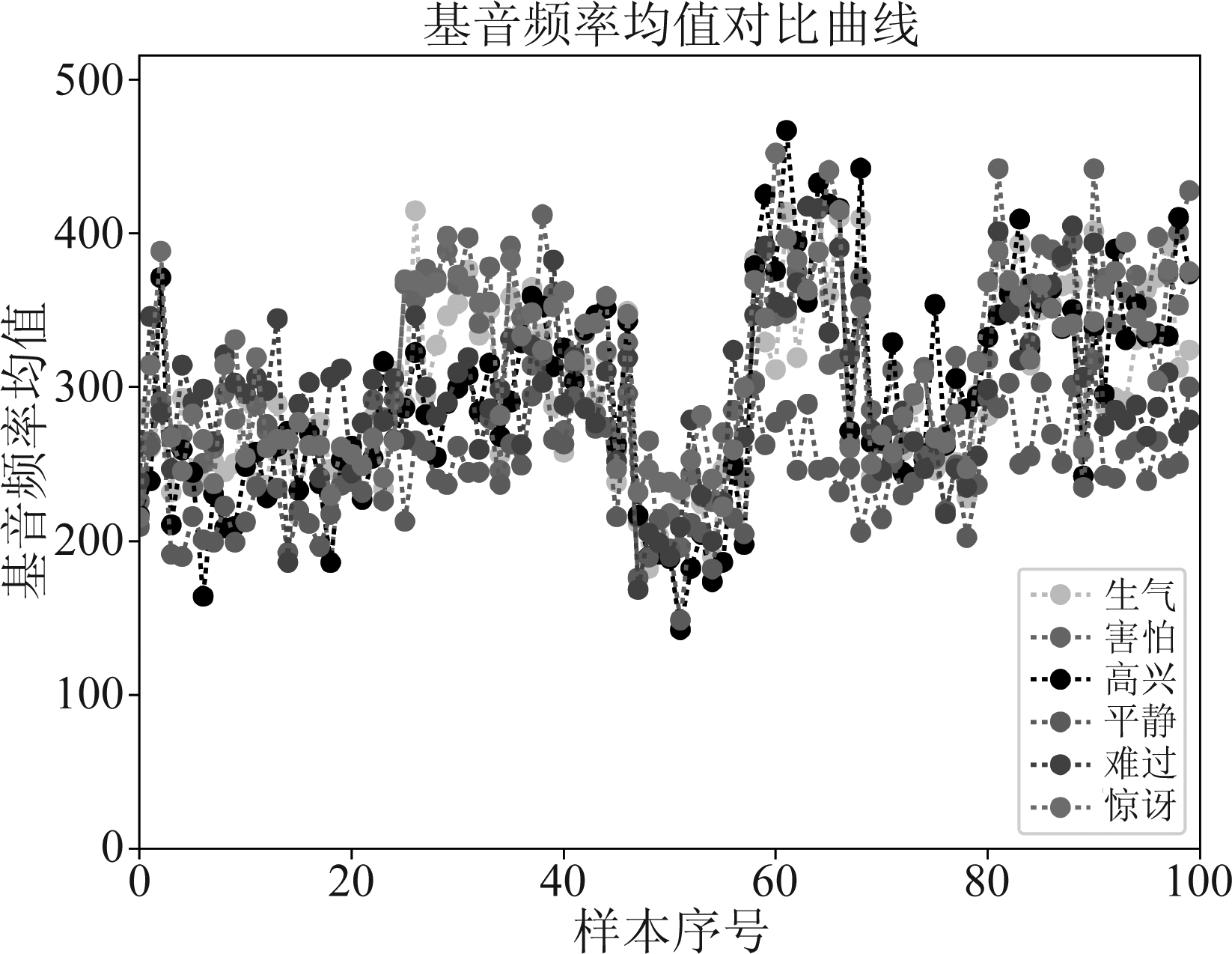

图4 六类维吾尔语情感语音的基音频率均值统计曲线

Fig.4 The six types of Uyghur emotional speech pitch frequency comparison chart

(3)基音周期

本文中,我们针对维吾尔语情感语音分析了基音频率特征。而且,我们使用了同一个句子在六种情感下表演所获得的语音,所以不存在音位不同所导致的偏差,其如图4所示。从图中能够看出来,基音频率会随着情感状态的变化而变化。因此,可以把基音频率作为有效的语音情感特征进行分析。通过观察各个情感类别下的基音频率均值曲线图可以看到,比起平静状态而言,生气和害怕情感下维吾尔语情感语音的基音频率值较大。

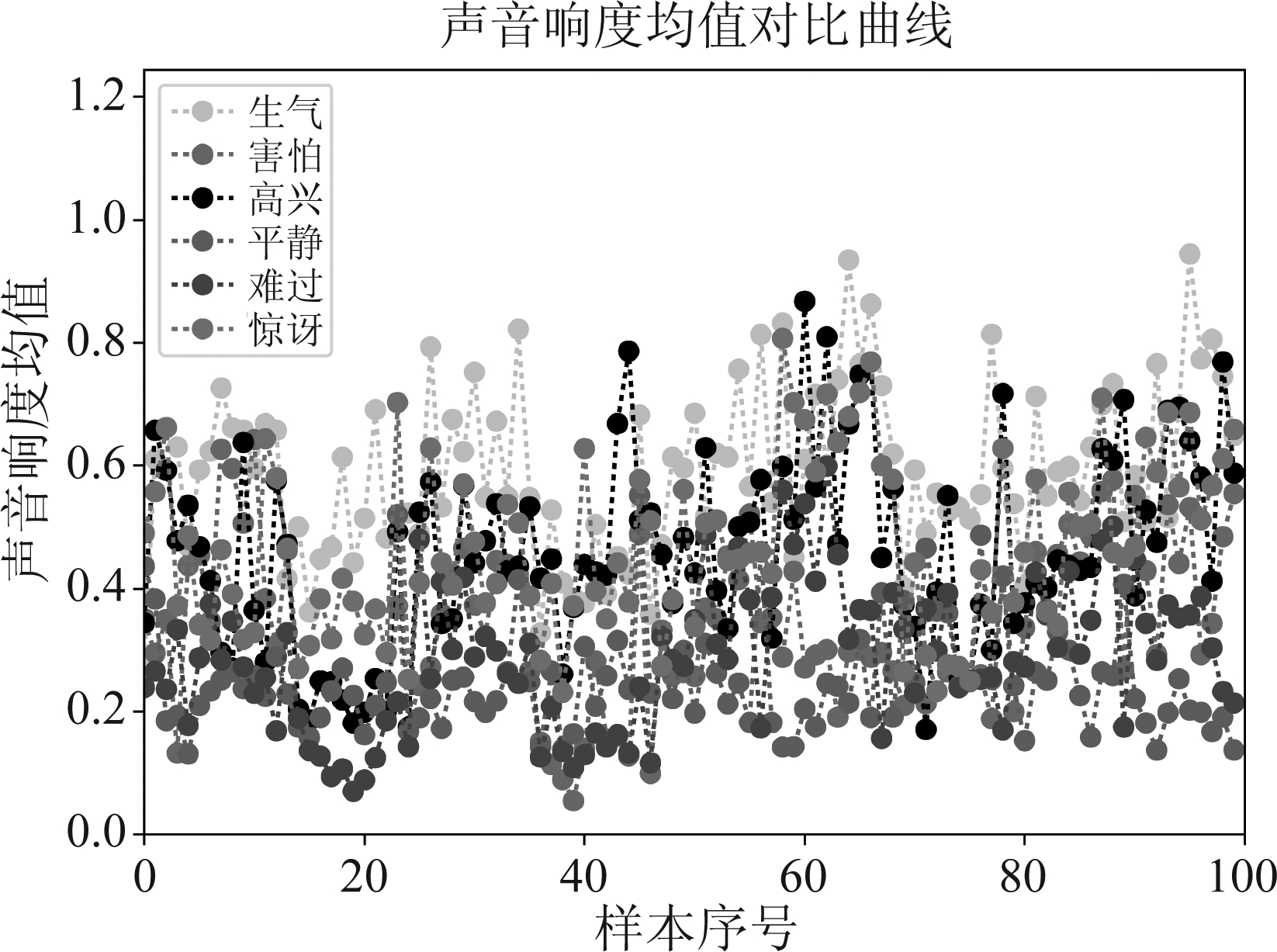

(4)响度

响度(loudness)描述的是声音的响亮程度,表示人耳对声音的主观感受,因此不同的情感语音的响度也有所差异,其如图5所示。从图中能够看出来,维吾尔语情感语音中生气情感的响度值曲线在平静情感和难过情感的响度值曲线上方。说明维吾尔语情感语音中响度特征对于区分生气和平静、难过而言是有效的。

图5 六类维吾尔语情感语音的响度均值统计曲线

Fig.5 The six types of Uyghur emotional speech loudness comparison chart

总的来说,单个特征来区分情感状态效果还是比较差,因此通过多维特征来表示情感状态效果明显好于单个特征。

基于表示模型的分类方法、如基于稀疏表示的分类方法最近在模式识别领域引起了的极大兴趣,而且获得了较好的效果。因此本文中采用基于原子表示(Atomic Representation)的语音情感识别算法对维吾尔语语音情感样本进行建模。

首先介绍原子范数的概念,A为一个原子集合,对于矩阵x的原子范数定义如式(4)所示

‖x‖A:=inf{t>0:x∈t·conv(A)}

(4)

其中conv(A)是A的凸包,原子范数是一个由A中的向量构成的一个凸包,通过整体的尺度变换使得x恰好落入t·conv(A)中,把最后的尺度变换t作为原子范数‖x‖A的值。如果原子集合是中心对称,我们就可以得到式(5)

(5)

其中ca为原子加权系数,对偶范数定义为

(6)

其中〈x,a〉=tr(xTa),tr(·)表示矩阵的迹。

原子表示矩阵的通过公式(7)得到

(7)

对于K类的情感分类中,![]() 表示由第k类已标注样本组成的矩阵(nk为第k类的样本总数,m为情感语音样本的特征维度)。总样本集由矩阵S=[S1,S2,...,SK]∈Rm×n表示,其中n为情感样本总数。原子表示向量为x*=[x1,...,xk,...,xK]∈Rn,其中xk=[x1,...,xnk]∈Rnk。给定情感语音样本训练集S的条件下,情感识别的目的是把测试情感样本y∈

表示由第k类已标注样本组成的矩阵(nk为第k类的样本总数,m为情感语音样本的特征维度)。总样本集由矩阵S=[S1,S2,...,SK]∈Rm×n表示,其中n为情感样本总数。原子表示向量为x*=[x1,...,xk,...,xK]∈Rn,其中xk=[x1,...,xnk]∈Rnk。给定情感语音样本训练集S的条件下,情感识别的目的是把测试情感样本y∈ m正确分类到预期的情感类别。

m正确分类到预期的情感类别。

现在我们介绍本文提出的基于原子表示模型的维吾尔语语音情感识别算法。给定一个测试维吾尔语情感样本y,首先通过公式(7)计算表示向量x*。然后我们对每个情感类别分别计算类别相关的残差函数rk(y)=‖y-Sδk(x*)‖2,k∈K。δk(x*)函数中仅保留与第k个情感类别相关的列,其余列都设为0,由稀疏向量δk(x*)=[0,...,xk,...,0]∈Rn表示,目的是通过每个类别相关的原子表示系数来逼近新的样本,再通过残差函数值最小的作为新测试样本的情感类别归属。

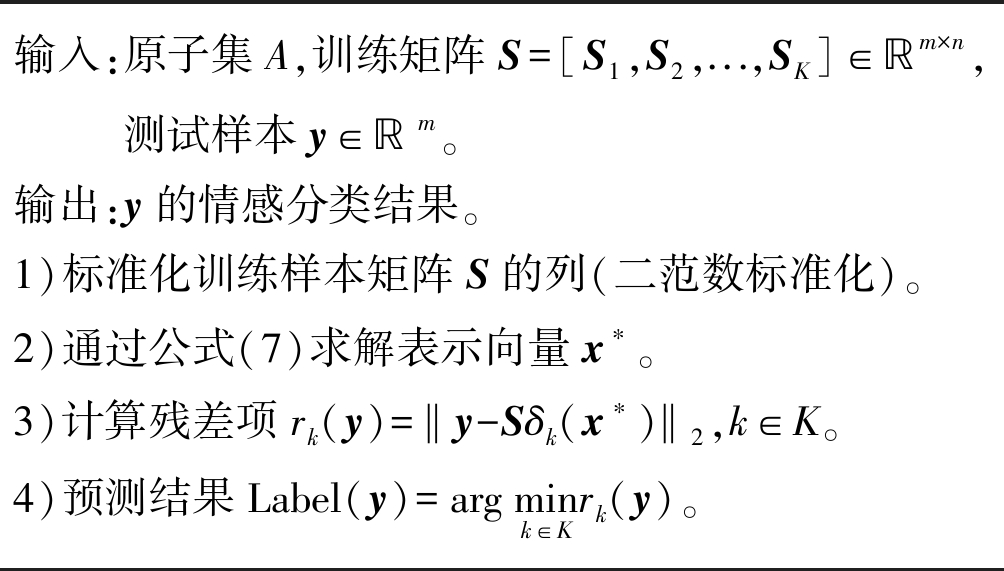

算法1 基于原子表示模型的维吾尔语语音情感识别算法实现步骤如下:

输入:原子集A,训练矩阵S=[S1,S2,...,SK]∈ℝm×n,测试样本y∈ℝm。输出:y的情感分类结果。1)标准化训练样本矩阵S的列(二范数标准化)。2)通过公式(7)求解表示向量x∗。3)计算残差项rk(y)=‖y-Sδk(x∗)‖2,k∈K。4)预测结果Label(y)=argmink∈Krk(y)。

该方法的关键假设是各个语音情感类别的样本集都位于一个线性子空间中。如果每个情感类别的样本数量足够,则测试情感样本y位于训练样本的线性跨度内,再通过残差函数来判断新的样本属于哪一情感类别。

本节我们利用ADMM(Alternating Direction Method of Multipliers)算法来实现目标函数的最优化。

算法2 基于ADMM算法的原子表示模型优化算法

输入:原子集A,训练矩阵S=[S1,S2,...,Snk]∈ℝm×nk,测试样本y∈ℝm,优化参数ρ。输出:最佳表示向量x∗。初始化:t=0,x(0)=0,z(0)=0,(0)=0,μ=10-1,ε=10-7,Tmax=105。优化目标:minx∈ℝnL(y-Sx)+ρ‖x‖A,其中L(·)是通用差损函数。1)插入辅助向量z来重构优化目标:minx,z∈ℝnL(y-Sx)+ρ‖x‖A,s.t.x=z。2)增广拉格朗日函数:L(x,z,)=L(y-Sx)+ρ‖z‖A+μ2x-z+μ22+h()。其中,h()=12μ‖‖22是与x和z相互独立的函数,μ>0是惩罚参数。3)固定z和对L(x,z,)求导更新x:x∗=argminxL(y-Sx)+μ2x-z+μ22。4)损失函数为LMSE(·)=12‖·‖22时,那么x∗有解析解:x∗=(STS-μI)-1(STy+μz-)。5)固定x和来更新z:minzL(x,z,)=minz12z-x+μ()2+ρμ‖z‖A。6)最优解可以写成如下形式:z(t+1)=∏A (x(t+1)+(t)μ;ρμ)。其中,∏A(x,γ)=argminz12‖z-x‖22+γ‖z‖A。7)固定x和z来更新:(t+1)=(t)+μ(x(t+1)-z(t+1))。8)循环结束的收敛条件为:‖x(t+1)-z(t+1)‖〠<ε且‖x(t+1)-x(t)‖〠<ε。其中ε的选择对情感识别影响较大。9)步骤8满足条件时结束循环。

语音情感分类实验所用的数据库为有1200个情感语音的维吾尔语情感语音数据库,该情感数据库是20名母语为维吾尔语的表演录制而收集的,其中有10名男性和10名女性。我们选择6种情感进行录制,即高兴、生气、害怕、平静、惊讶、难过,每个表演者对每种情感类别录10句话,总共1200条语音(6*20*10)。

我们把数据集按3∶1的比例分成训练集和测试集,即900条语音为训练集、300条语音为测试集。为了进行交叉验证实验,我们又把训练集分成三块,即每一块为300条语音,这样就可以跟测试集300条语音替换实现交叉验证的目的。

实验采用openSMILE工具包提取的情感特征,提取988个特征,包括基频包络的平方回归误差、LSP3的偏斜度、基频一阶导数的均值、MFCC5的峭度、MFCC9一阶导数线性回归的斜率、MFCC11的最小值、LSP7一阶导数的均值、强度的方差、基频包络的均值、过零率的最大值等等。

用所提出的原子表示的情感识别方法进行语音情感识别时,将利用最小重构残差把新样本赋予残差值最小的类别,即:

(8)

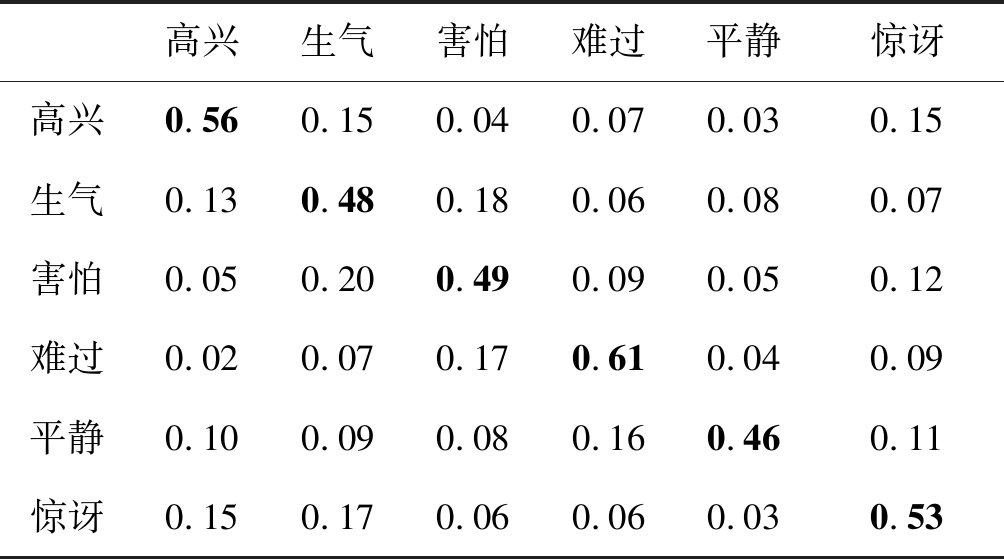

将把原子表示的算法同传统的基于SVM的情感识别方法作对比,两批实验我们都用相同的训练集和测试集数据,两种方法所得到的实验结果的混淆矩阵如表3和表4所示。

表3 基于SVM的情感识别结果混淆矩阵

Tab.3 The confusion matrix of SVM based result

高兴生气害怕难过平静惊讶高兴0.560.150.040.070.030.15生气0.130.480.180.060.080.07害怕0.050.200.490.090.050.12难过0.020.070.170.610.040.09平静0.100.090.080.160.460.11惊讶0.150.170.060.060.030.53

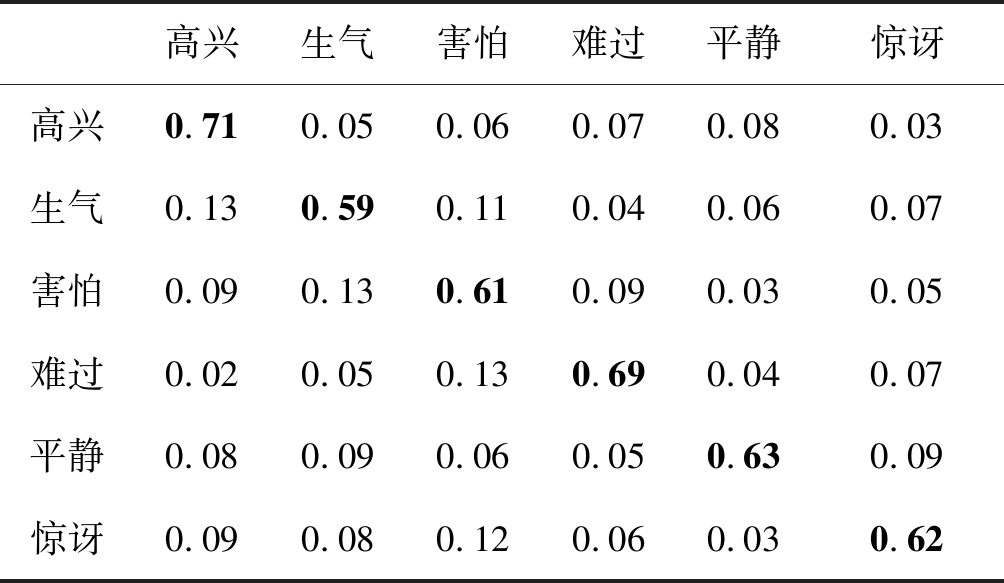

表4 所提出算法的情感识别结果混淆矩阵

Tab.4 The confusion matrix of proposed method result

高兴生气害怕难过平静惊讶高兴0.710.050.060.070.080.03生气0.130.590.110.040.060.07害怕0.090.130.610.090.030.05难过0.020.050.130.690.040.07平静0.080.090.060.050.630.09惊讶0.090.080.120.060.030.62

从表可以看出,基于支持向量机(Support Vector Machine)SVM的情感识别算法的平均识别率为52.2%,其中核函数选择了径向基核函数(RBF), 惩罚因子C=100,核参数p1=0.02。所提出算法的平均识别率为64.2%,该方法识别效率上有较大改进。维吾尔语语音情感数据下基于SVM的分类算法把生气情感分类为害怕的错误率较高,达到了18%,并且把难过情感分类为害怕情感的错误率达到了17%,惊讶情感分类为高兴情感达到了17%,高兴情感分类为惊讶也达到了15%。总的来说,错误率还是比较高,而所提出的基于原子表示的算法整体上提高了正确率,因此错误率自然也降低。

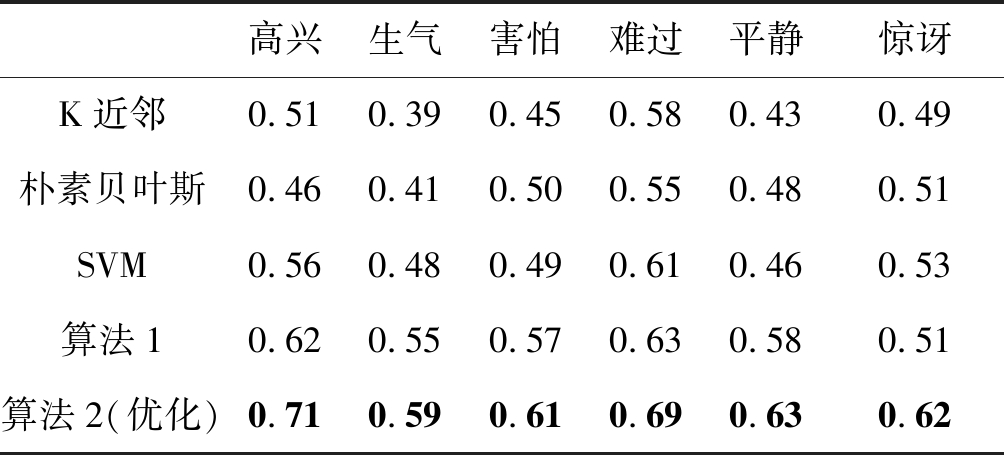

下面我们把提出的算法跟几个传统的算法进行比较,如表5所示。在维吾尔语情感语音库上提出算法的识别效果明显优于传统的算法,如K近邻、朴素贝叶斯和SVM等。而且优化后的算法2识别效率也高于算法1,总的识别率达到64.17%。

表5 所提出算法与传统算法对比

Tab.5 The comparison of proposed method and traditional method

高兴生气害怕难过平静惊讶K近邻0.510.390.450.580.430.49朴素贝叶斯0.460.410.500.550.480.51SVM0.560.480.490.610.460.53算法10.620.550.570.630.580.51算法2(优化)0.710.590.610.690.630.62

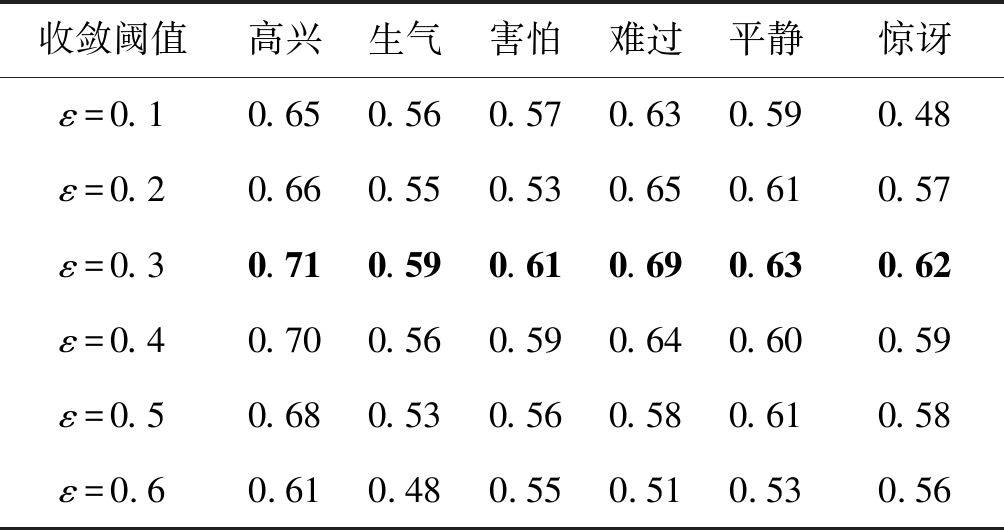

收敛条件的阈值ε对语音情感识别率的影响是比较大的,我们通过对比实验选择了效果最佳的阈值ε,当ε=0.3时维吾尔语语音情感识别的结果为最佳,ε值较大或较小时识别率效果都不是最佳,因为ε过大时收敛条件过于松散将把不同的情感类别识别为同一类,如果ε过小时收敛条件过于严格将把较相似的情感类别归为不同的类别,如表6所示。

表6 收敛阈值ε对比实验

Tab.6 The comparison of convergence Threshold ε

收敛阈值高兴生气害怕难过平静惊讶ε=0.10.650.560.570.630.590.48ε=0.20.660.550.530.650.610.57ε=0.30.710.590.610.690.630.62ε=0.40.700.560.590.640.600.59ε=0.50.680.530.560.580.610.58ε=0.60.610.480.550.510.530.56

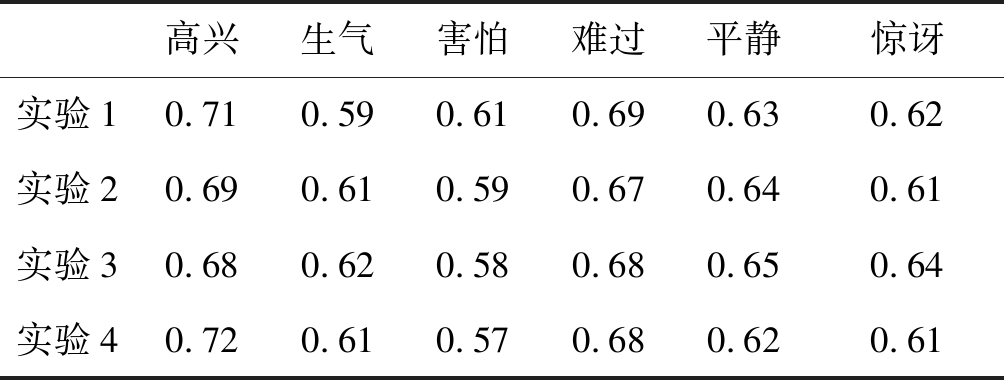

为了情感识别实验结果的鲁棒性我们做了四次交叉验证实验。交叉验证实验结果如下表7所示。从表可以看出交叉验证实验结果都比较接近,说明实验结果是可靠的。

表7 交叉验证实验

Tab.7 The cross validation experiments

高兴生气害怕难过平静惊讶实验10.710.590.610.690.630.62实验20.690.610.590.670.640.61实验30.680.620.580.680.650.64实验40.720.610.570.680.620.61

由于我们录制的数据库样本数量有限,语音的内容也比较单一,文本内容的不同可能会影响识别率,因此我在将来的研究工作把本文的方法在更大的语音情感数据库上验证。还有进一步扩充该维吾尔语语音情感数据库,将参与人数和文本设计更多样化,使得提出的方法更具有泛化能力和普适性。

语音情感识别是人机交互领域内所必须的重要技术,近期也出现了很多种语言的语音情感识别研究。为了填补国内少数民族语言语音情感识别研究的空白,采集了维吾尔语语音情感数据库,提出了原子表示模型的分类算法实现了维吾尔语语音情感识别。表示模型的分类方法、如基于稀疏表示的分类方法最近在模式识别领域引起了的极大兴趣,而且获得了较好的效果。该算法比较有效的表示维吾尔语情感特征空间,对维吾尔语语音情感特征空间进行建模。通过对识别结果的分析与对比,提出的方法确实可行有效,比传统算法的性能有所提升。在今后的研究中,可以进一步的探讨跨语言的语音情感识别问题。

[1] Schuller B. Speech analysis in the big data era[C]∥Text, Speech, and Dialogue. New York, NY, USA: Springer, 2015: 3-11.

[2] Schuller B, Batliner A. Computational Paralinguistics: Emotion, Affect and Personality in Speech and Language Processing[M]. John Wiley& Sons, 2013.

[3] Zeng Z, Pantic M, Roisman G I, et al. A survey of affect recognition methods: Audio, visual, and spontaneous expressions[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2009, 31(1): 39-58.

[4] 陈婧, 李海峰, 马琳, 等. 多粒度特征融合的维度语音情感识别方法[J]. 信号处理, 2017, 33(3): 374-382.

Chen Jing, Li Haifeng, Ma Lin, et al. Multi-granularity Feature Fusion for Dimensional Speech Emotion Recognition[J]. Journal of Signal Processing, 2017, 33(3): 374-382.(in Chinese)

[5] Schuller B, Steidl S, Batliner A, et al. The INTERSPEECH 2013 computational paralinguistics challenge: Social signals, conflict, emotion, autism[C]∥in Proc. Annual Conference of the International Speech Communication Association (INTERSPEECH). Lyon, France: ISCA, 2013: 148-152.

[6] 李超, 赵文萍, 赵子平. 多视角判别分析的情感识别[J]. 信号处理, 2018, 34(8): 998-1007.

Li Chao, Zhao Wenping, Zhao Ziping. Multi-view Discriminant Analysis for Emotion Recognition[J]. Journal of Signal Processing, 2018, 34(8): 998-1007.(in Chinese)

[7] 张昕然, 巨晓正, 宋鹏, 等. 用于跨库语音情感识别的DBN特征融合方法[J]. 信号处理, 2017, 33(5): 649- 660.

Zhang Xinran, Ju Xiaozheng, Song Peng, et al. Feature Fusion Based on DBN for Cross-Corpus Speech Emotion Recognition[J]. Journal of Signal Processing, 2017, 33(5): 649- 660.(in Chinese)

[8] 王治平, 赵力, 邹采荣. 基于支持向量机的语音情感识别[J]. 东南大学学报(英文版), 2003(4): 307-310.

Wang Zhiping, Zhao Li, Zou Cairong. Support vector machines for emotion recognition in Chinese speech[J]. Journal of Southeast University, 2003(4): 307-310.(in Chinese)

[9] 张明阳, 查诚, 塔什甫拉提·尼扎木丁, 等. 结合数据场情感空间和混合蛙跳算法的连续语音情感变化趋势检测[J]. 声学学报, 2019, 44(1): 12-19.

Zhang Mingyang, Zha Cheng, Tashpolat Nizamidin, et al. Continuous Speech Emotion Trend Detection Based on Data Field Emotion Space and Shuffled Frog-leaping Algorithm[J]. Acta Acustica, 2019, 44(1): 12-19.(in Chinese)

[10] Xu X, Deng J, Coutinho E, et al. Connecting Subspace Learning and Extreme Learning Machine in Speech Emotion Recognition[J]. IEEE Transactions on Multimedia, 2019, 21(3): 795- 808.

[11] Wright J, Yang A, Ganesh A, et al. Robust face recognition via sparse representation[J]. IEEE Trans. Pattern Analysis and Machine Intelligence, 2019, 32(2): 210-227.

[12] Wang Y, Tang Y Y, Li L, et al. Atomic Representation-based Classification: Theory, Algorithm and Applications[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 17(1): 1-1.

[13] 罗武骏, 黄程韦, 查诚, 等. 越南语语音情感特征分析与识别[J]. 信号处理, 2013, 29(10): 1423-1432.

LA Vutuan, Huang Chengwei, Zha Cheng, et al. Emotional Feature Analysis and Recognition from Vietnamese Speech[J]. Journal of Signal Processing, 2013, 29(10): 1423-1432.(in Chinese)

[14] Mcgilloway S, Cowie R, Douglas-cowie e, et al. Approaching automatic recognition of emotion from voice: a rough benchmark[C]∥proceedings of the ISCA Tutorial and Research Workshop (ITRW) on Speech and Emotion, 2000.

[15] Burkhardt F, Paeschke A, Rolfes M, et al. A database of German emotional speech[C]∥Proceedings of the Interspeech, 2005.

[16] Steidl S. Automatic classification of emotion related user states in spontaneous children’s speech[M]. University of Erlangen-Nuremberg Erlangen, Germany, 2009.

[17] 郑燕. 维吾尔语与汉语情态表达对比研究——从“反观”的角度[J]. 语言与翻译, 2018, 18(3): 36- 41.

Zheng Yan. Comparative Study of Modal Expressions in Uyghur and Chinese—From the perspective of reflection[J]. Language and Translation, 2018, 18(3): 36- 41.(in Chinese)

塔什甫拉提·尼扎木丁 男, 1988年生, 东南大学博士研究生, 主要研究方向为语音情感识别。

E-mail: tashifulati@seu.edu.cn

梁瑞宇 男, 1978 年生, 江苏徐州人。2012年毕业于东南大学, 获博士学位, 现为南京工程学院副教授, 主要研究方向为语音信号处理。

E-mail: lly1711@163.com

谢 跃 男, 1991年生, 东南大学博士研究生, 主要研究方向为语音情感识别。

E-mail: 230169046@seu.edu.cn

赵 力(通讯作者) 男, 1958 年生, 东南大学信息科学与工程学院教授, 博士生导师。主要研究方向为语音信号处理、图像信号处理。

E-mail: zhaoli@seu.edu.cn