Reference format: Lin Qi, Chen Jing, Zeng Huanqiang, et al. Video Super-Resolution Method Based on Multi-Scale Characteristics Residual Learning Convolutional Neural Network[J]. Journal of Signal Processing, 2020, 36(1): 50-57. DOI: 10.16798/j.issn.1003- 0530.2020.01.007.

随着显示设备技术的发展,超高清电视需要分辨率为4K(3840×2160)和8K(7680×4320)的高清视频,但是现在能达到如此高分辨率的视频比较稀缺。因此,从低分辨率视频重建出高分辨率高清视频的算法变得越来越重要。视频超分辨率技术在航空、医学和电子监控等诸多领域均有广泛应用。近年来,随着深度学习以及卷积神经网络在计算机视觉领域中的广泛运用,基于深度神经网络的新一代图像重建算法开始表现出卓越的性能,基于卷积神经网络的视频超分辨率技术也成为了研究的热点。

视频超分辨率技术的关键主要是建立低分辨率视频和高分辨率视频之间的映射关系,这不是图像超分辨技术的简单移植,面临许多的挑战,比如信息的丢失、空间翻转和移位,冗余的帧间信息和如何对视频帧间的复杂的运动进行精确建模等[1]。因此在重建过程中需要着力解决的问题包括:如何准确匹配帧间信息、运动估计和方位估计、运动模糊、充分利用时空相关性等。

基于贝叶斯框架[2]的视频超分辨率重建是一种经典的方法,它采用了分层块匹配方法或者复杂的光流算法来估计运动场,能够处理包含具有复杂运动的真实场景视频。为了解决运动模糊的问题,Ma等人[3]在基于贝叶斯框架的基础上引入时间相对度的概念,去除了严重模糊的像素,用来处理产生运动模糊的视频,并且实现了较理想的实验效果。这些传统的经典方法采用手工提取特征的方法,手工提取合适的特征对网络的训练起关键性作用。但是传统的方法对合适特征的选取困难且繁琐,受限于传统算法的计算能力,传统视频超分辨率重建研究陷入了瓶颈。

随着深度学习及卷积神经网络在计算机视觉领域的广泛运用,视频超分辨率的研究逐步深入,并表现出较经典方法更优的性能。廖等人[4]采用不同的光流方法生成高分辨率的视频帧,再通过卷积神经网络(Convolutional Neural Network,CNN)将它们聚合从而实现视频的重建。刘等人[5- 6]采用对准整流光流的方法,提出了一个时间自适应网络来生成高分辨率的视频帧,并且可以在不同的时间尺度下自适应地将它们聚合。Jose等人[7]提出高效的亚像素卷积网络(Video Efficient Sub-pixel Convolution Network,VESPCN),并采用早期融合(early fusion)、慢融合(slow fusion)和3D卷积分别在网络的不同部分合并时间信息有效地将图像超分辨率扩展到视频超分辨率。同时作者还提出一种基于多尺度空间变换网络的密集帧间运动补偿的有效方法,所提出的端到端的可训练运动补偿视频超分辨率算法,有效地利用了时间冗余,提高了重建精度,同时保持了一定的实时速度。文献[8]提出一种增强型的视频超分辨率网络(Enhanced Video Super-Resolution,EVSR)[8],这个网络可以从端到端学习相连帧之间的空域和时域的相关性,隐式地捕获连续帧之间的运动关系,而不需要传统视频超分辨率方法中的显式运动补偿过程,网络结合采用残差连接skip-connection来预测高频细节。Huang等人[9]考虑到递归神经网络(Recurrent Neural Networks,RNNs)可以很好地对视频序列间的时间依赖性进行建模,提出了双向递归卷积网络。该网络包括前向递归网络和后向递归网络,这两个网络采用相同的时间步长且共享权重,提高帧间相关性建模精度的同时不会大规模增加网络参数,从而实现快速的高质量重建。

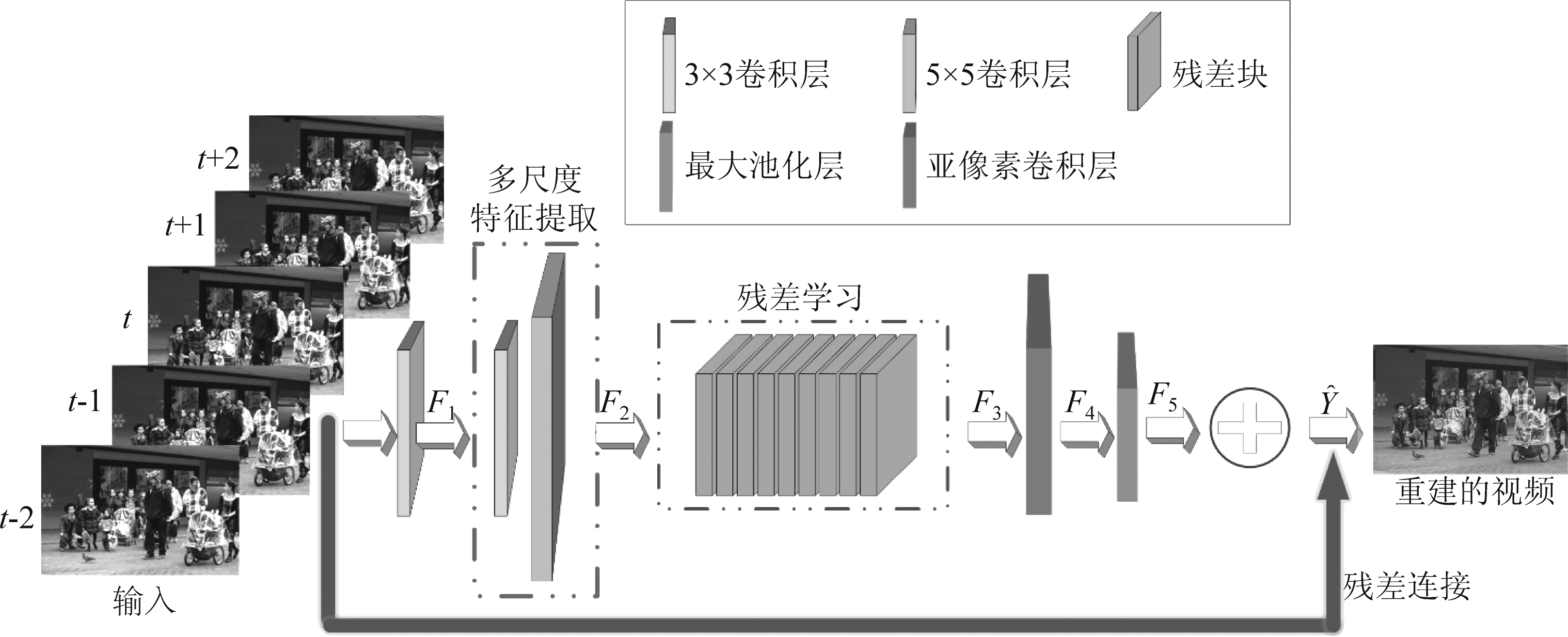

为了充分利用不同尺度下视频的时空相关性并在重建时恢复更多的细节信息,本文提出一个基于多尺度特征残差学习卷积神经网络的视频超分辨率方法。这一网络的基本思想是先用双三次插值将低分辨率视频帧插值到目标分辨率,将相连的五个视频帧作为网络的输入,进行多尺度特征残差学习以重建高质量细节信息并融合重建中间帧,每次重建连续的五帧,直到重建出整个视频。多尺度特征残差学习卷积神经网络结构由四部分组成,分别为:多尺度特征提取、残差学习、亚像素卷积层、残差连接(skip-connection)。具体地说,输入预处理后的五个连续的帧进入卷积神经网络,第一阶段是通过两个不同大小的卷积核进行多尺度特征提取,第二阶段是经过残差学习对第一阶段提取的特征进行残差学习,第三阶段是进入亚像素卷积层进行多通道像素的周期筛选,最后一个阶段是将输入网络的中间帧与第三阶段的输出进行残差连接(skip-connection)。

本文剩余的部分安排如下:第2节介绍基于多尺度特征残差学习卷积神经网络的视频超分辨率方法;第3节介绍实验设置、实验结果及结果分析;第4节给出结论。

在输入网络之前,先将低分辨率视频通过双三次插值获得目标分辨率的视频。

如图1所示,所提出的网络主要由四大部分构成,分别为多尺度特征提取、残差学习、亚像素卷积层以及残差连接(skip-connection)。具体分析如下:

(1)多尺度特征提取

如图1所示,五个经过预处理的连续视频帧作为输入,第一层卷积层的输入通道数是5,输出通道数是64,卷积核大小为3,卷积神经网络的第一层的特征图可以如下表示:

F1(X)=MAX(0,W1*X+B1)

(1)

其中X是输入,W1是第一层滤波器,B1是第一层的偏置。F1表示的是第一卷积层的特征图,*表示卷积运算。

通常,CNN要求输入的图像尺寸是固定的,这一限制导致了利用CNN提取的特征是单一尺度的,而且3×3的卷积核能学习到的局部特征不明显,需要通过一定的数据积累才能达到较高的准确率。考虑到不同的卷积核具有不同的感受视野,本文在网络设计的时候分别采用一个3×3的卷积核和一个5×5的卷积核对输入的五个连续的视频帧进行特征提取。由于5×5的卷积核识别效率高,准确率上升速度快,因此本网络能高效又准确地学习不同尺度的图像的特征。网络中,两个不同大小的卷积核是平行运算的,最后将两个卷积层的特征图直接进行级联。因此,CNN第二层的特征图表示如下:

(2)

其中,F21(X)和F22(X)分别是卷积核大小为3和卷积核大小为5的特征图,F2(X)是经过级联后的特征图。

图1 网络框架流程图

Fig.1 Flow chart of the proposed network

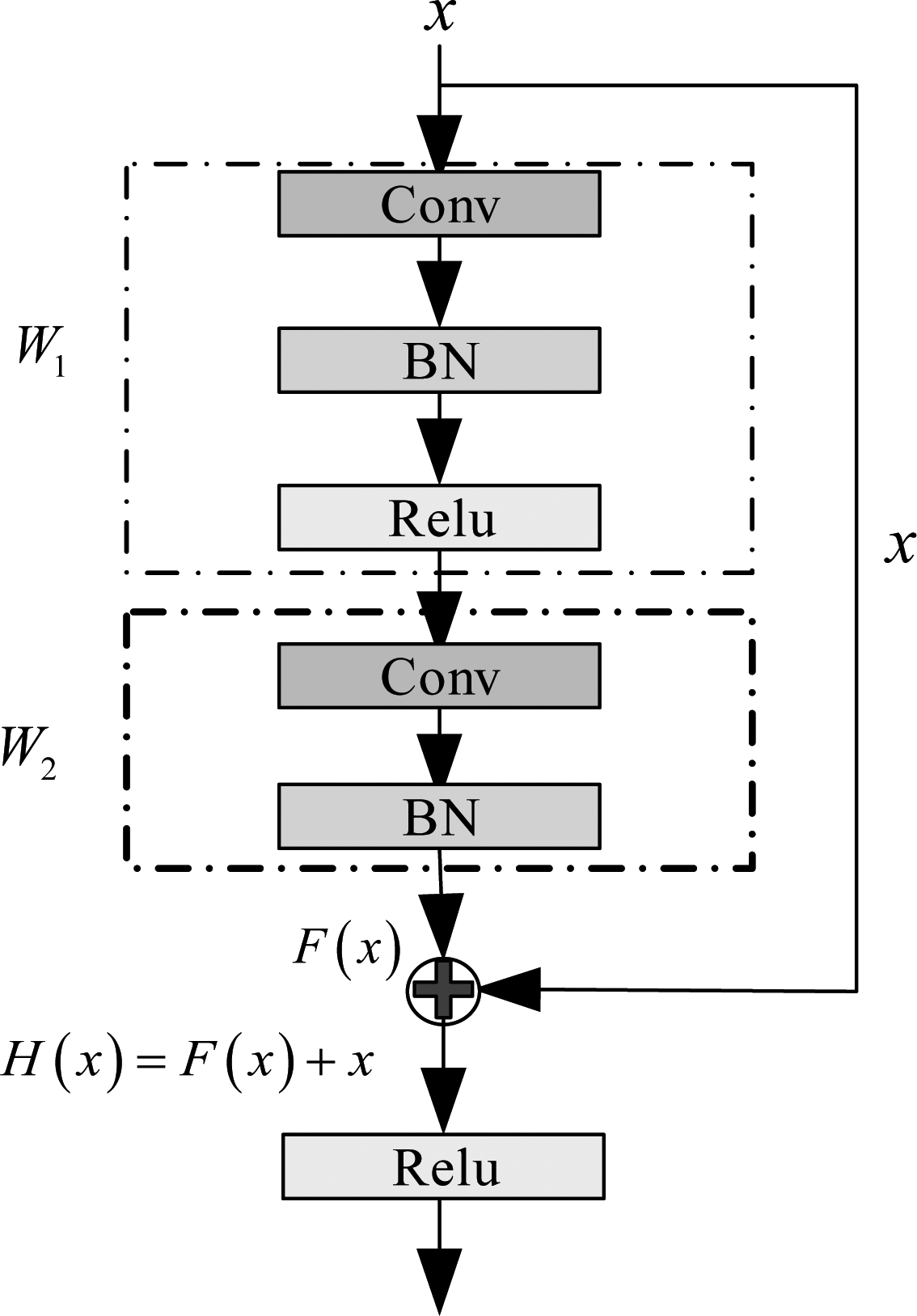

(2)残差学习

深度学习网络的深度对最后实现的等效果具有很大的影响,并不是网络设计得越深越好。常规的平坦网络随着网络深度的加深,梯度消失的现象会越明显,网络的训练结果会变差。而当网络的深度不够又无法明显提升网络的学习效果。为了解决加深网络的情况下梯度消失的问题,何等人提出了残差学习[10]。

残差学习网络的基本思想如图2所示,其中Conv是卷积层,BN是批处理归一化层,Relu是非线性激活函数层。假设输入为x,经由网络学习之后的输出设为H(x),残差设为F(x),Wi表示第i层卷积层的权重,σ表示非线性函数Relu,残差学习的数学表达如下:

F(x)=W2σ(W1x)

(3)

H(x)=F(x)+x

(4)

残差学习的目的是为了使输出和输入残差F(x)尽可能趋近于0从而实现同等映射,这表示即使网络极深,但是此时网络的权重训练已经达到最优,剩下的网络层数不会使网络的学习精度下降。因此,我们将每两层卷积组成一个残差块,每一层的卷积层的输入和输出通道都为64,均采用3×3的卷积核。实验证明,本文方法采取九个残差块组成的残差学习时实现了较好的结果。

图2 残差学习基本思想

Fig.2 The idea of residual learning

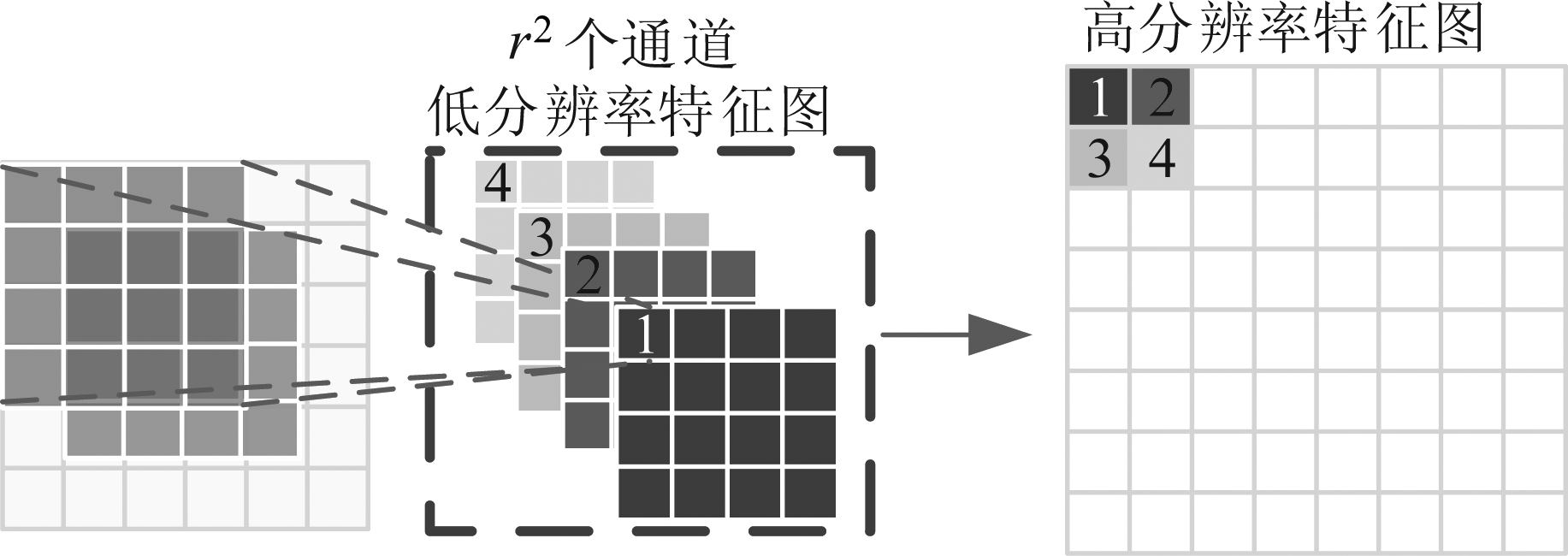

(3)亚像素卷积层

如图3所示,亚像素卷积层[11]的本质是将r2(r是缩放因子)个通道的低分辨率特征,按照特定的位置,周期性地插入到高分辨率图像中。此时r2个通道的低分辨率特征图为H×W×C×r2,将r2个特征图重新进行排列组合得到的高分辨率特征图为rH×rW×C。

图3 亚像素卷积层

Fig.3 Sub-pixel convolutional neural network

其中,H、W、C分别表示特征图的长、宽和通道数。亚像素卷积数学表达式如下所示:

IHR=PS(WL*FL-1+BL)

(5)

其中IHR表示输出的高分辨率图,PS代表周期变换算子,WL表示第L层的滤波器,FL-1表示第L-1层的输出的特征图,BL表示第L层的偏置。

(4)残差连接(Skip-Connection)

深度神经网络在网络层数较深时不仅容易遇到梯度爆炸和梯度消失等问题,而且训练时的收敛速度也会随之变慢。为了解决梯度爆炸/消失和收敛速度慢的问题,残差学习中的skip-connection[10]不仅能加快训练的收敛速度而且可以改善网络实现的性能。值得注意的是,亚像素卷积层学习后的特征图与输入网络的中间帧(t帧)进行skip-connection操作时,应确保两者的大小一致。经过亚像素卷积层后的图像进行上采样,为了与输入的中间帧相连,需对最大池化层进行下采样。因此,网络的最后一层的输出结果如下公式所示:

F5(X)=down(F4(X))

(6)

(7)

其中,down表示最大池化层的下采样,![]() 表示网络输出的视频重建结果。

表示网络输出的视频重建结果。

选取分辨率为4K的India和Myanma视频[12](合称为IndMya),从中提取120个场景,每个场景包括五个连续视频帧,使用MATLAB将原始视频下采样为960×540的分辨率。从提取出的场景中再分为112个场景用于训练,8个场景用于测试。训练数据和测试数据没有重复的场景,这是为了体现出网络的泛化性能。同时还选取vid4[15]作为另一个测试集来验证训练的网络的泛化能力。vid4包括city(704×576)、foliage(720×480)、walk(720×480)和calendar(720×576)四个视频。每个视频包含31个场景,每个场景也包括五个相邻的帧。所有的数据集都使用MATLAB进行双三次插值预处理再输入卷积神经网络学习。为了提高计算的效率,在训练的时候,将每个场景的每一帧以步长36分为48×48像素大小的图像块作为输入,因此总共有60000个图像块。

采用Adam优化函数来优化网络,并且Adam的优化动量设置为0.9,权重衰减设置为10-6,初始化的学习率为10-3。本文所提方法实验测试的硬件环境为搭配Intel(R)Xenon(R)CPU(2.60GHz)、内存32GB、配置NVIDIA GeForce GTX 1080 Ti GPU的计算机。软件环境为32位Windows 7操作系统,Pytorch框架和Matlab R2014a。

峰值信噪比(Peak Signal to Noise Ratio, PSNR)被广泛用作评价有损压缩质量的指标。PSNR与均方差(Mean Square Error, MSE)有一定的相关性。当网络的输出与真实图像之间的均方差越小时,PSNR的值越高,说明实现的效果越好。PSNR的定义如下所示:

(8)

(9)

其中y表示真实图像,![]() 表示输出图像,s是最大可能像素值(s取255)。

表示输出图像,s是最大可能像素值(s取255)。

同时,为了解决在相同的PSNR情况下呈现不同的质量感知的问题,采取了考虑人眼视觉感知结构相似性指数(Structural Similarity Index, SSIM)评价指标,它常用来衡量两幅图像之间的相似度。SSIM取值范围是[0,1],数值越大表示图像失真越小,算法性能越好。定义为:

(10)

其中uy和![]() 和

和![]() 以及

以及![]() 分别表示图像y和

分别表示图像y和![]() 的均值,标准差以及交叉协方差,其中c1和c2是常数,通常c1=(0.01s)2,c2=(0.03s)2,s表示的是最大可能像素值,在本文中s取255。

的均值,标准差以及交叉协方差,其中c1和c2是常数,通常c1=(0.01s)2,c2=(0.03s)2,s表示的是最大可能像素值,在本文中s取255。

为了使网络能进行更好的学习并且实现更佳的性能,采用了多任务学习[13]的方法来训练网络,尽可能地使人们对网络输出结果的视觉感知更接近于真实图像,这就需要同时优化MSE和SSIM,因此,网络的损失函数如下所示:

L=αMSE+(1-α)(1-SSIM)

(11)

其中,L是损失函数,α是常数,根据实验参数设置,将α设置为0.9。

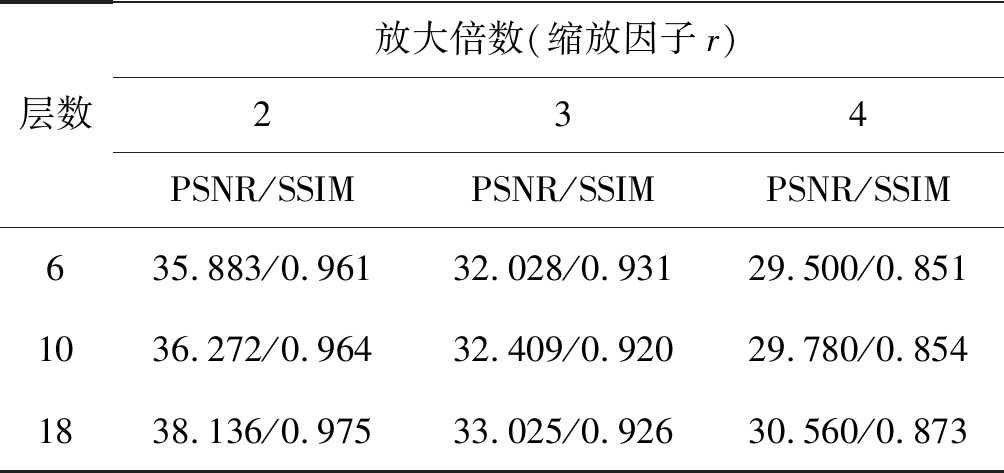

在保证除残差学习深度之外的参数不变的前提下,本文使用不同深度的残差学习训练网络。在深度分别为6,10和18的设置下对测试集IndMya的测试结果如表1所示。从表中可以看出,当残差学习的深度增加时,PSNR和SSIM也随之增加,这是因为超分辨率是学习低分辨率和高分辨率特征之间的非线性映射,随着网络的深度增加可以学习到不同层次的特征,因此模型可以提高推断出新像素的准确性。但是,随着网络深度的增加,在保持数据复杂性不变时PSNR和SSIM趋于饱和,对硬件设备的要求也会随着提高,因此要选择合适的网络深度实现较好的性能。经过网络深度和算法性能的比较测试,本文采用18层的残差学习进行实验。

表1 IndMya测试集在不同层数网络中的性能比较(PSNR(dB)/SSIM)

Tab.1 Performance comparisons on IndMya test sets at different network depths (PSNR(dB)/SSIM)

层数放大倍数(缩放因子r)234PSNR/SSIMPSNR/SSIMPSNR/SSIM635.883/0.96132.028/0.93129.500/0.8511036.272/0.96432.409/0.92029.780/0.8541838.136/0.97533.025/0.92630.560/0.873

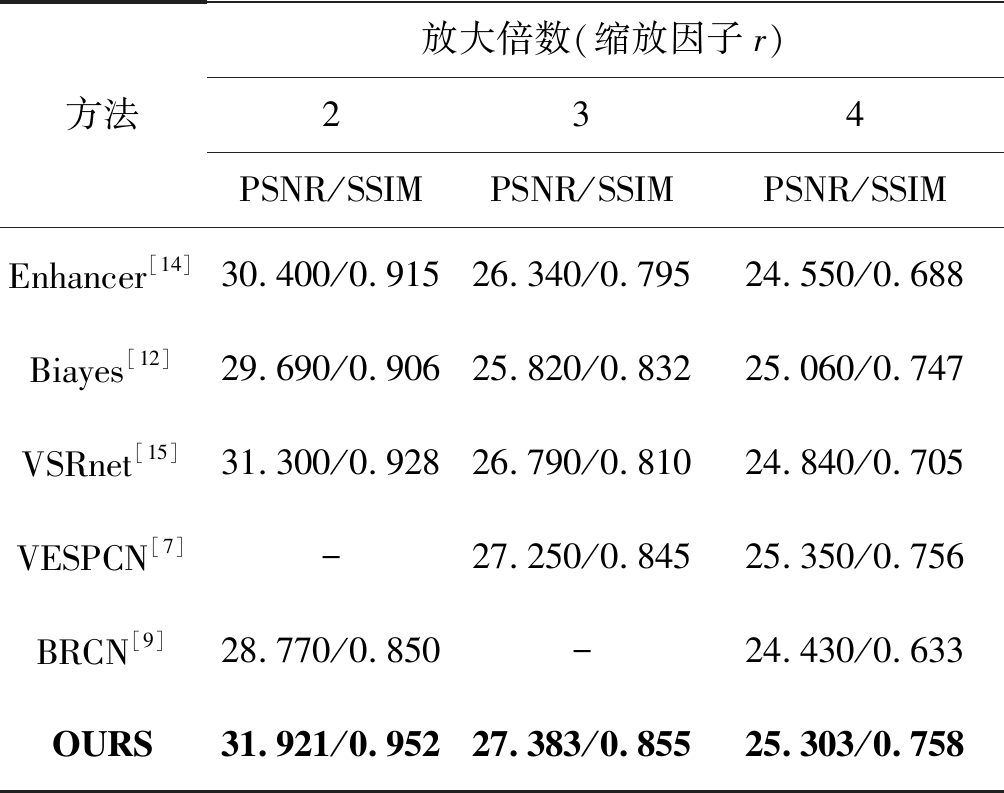

我们将本方法的实验结果与文献[12]、[14]、[15]等视频超分辨率方法做比较。为了公平比较,所有方法采用测试集vid4,客观结果比较如表2所示,主观比较结果呈现在图4和图5。

表2 vid4数据集的平均PSNR(dB)和SSIM的比较

Tab.2 Comparisons of average PSNR (dB) and SSIM on vid4 dataset

方法放大倍数(缩放因子r)234PSNR/SSIMPSNR/SSIMPSNR/SSIMEnhancer[14]30.400/0.91526.340/0.79524.550/0.688Biayes[12]29.690/0.90625.820/0.83225.060/0.747VSRnet[15]31.300/0.92826.790/0.81024.840/0.705VESPCN[7]-27.250/0.84525.350/0.756BRCN[9]28.770/0.850-24.430/0.633OURS31.921/0.95227.383/0.85525.303/0.758

从表2中可以看出,本文所提方法在放大倍数为2、3和4时与Biayes[12]、Enhancer[14]、VSRnet[15]等算法相比较,PSNR和SSIM分别改善3.151 dB和0.102、1.563 dB和0.06以及0.753 dB和0.125。虽然视频超分辨率重建的质量会随着放大倍数的增加而下降,但与Enhancer[14]、Biayes[12]、VSRnet[15]等算法比较,本文的结果仍较好。这主要有以下两个原因:(1)本文采用了多尺度网络提取特征,从而网络能够学习不同感受野的特征,恢复出较多丢失的细节。(2)本文采用了残差学习,使网络具有更强的泛化性能,学习到了不同层次的残差特征,因此能重建出高质量的纹理和结构信息。

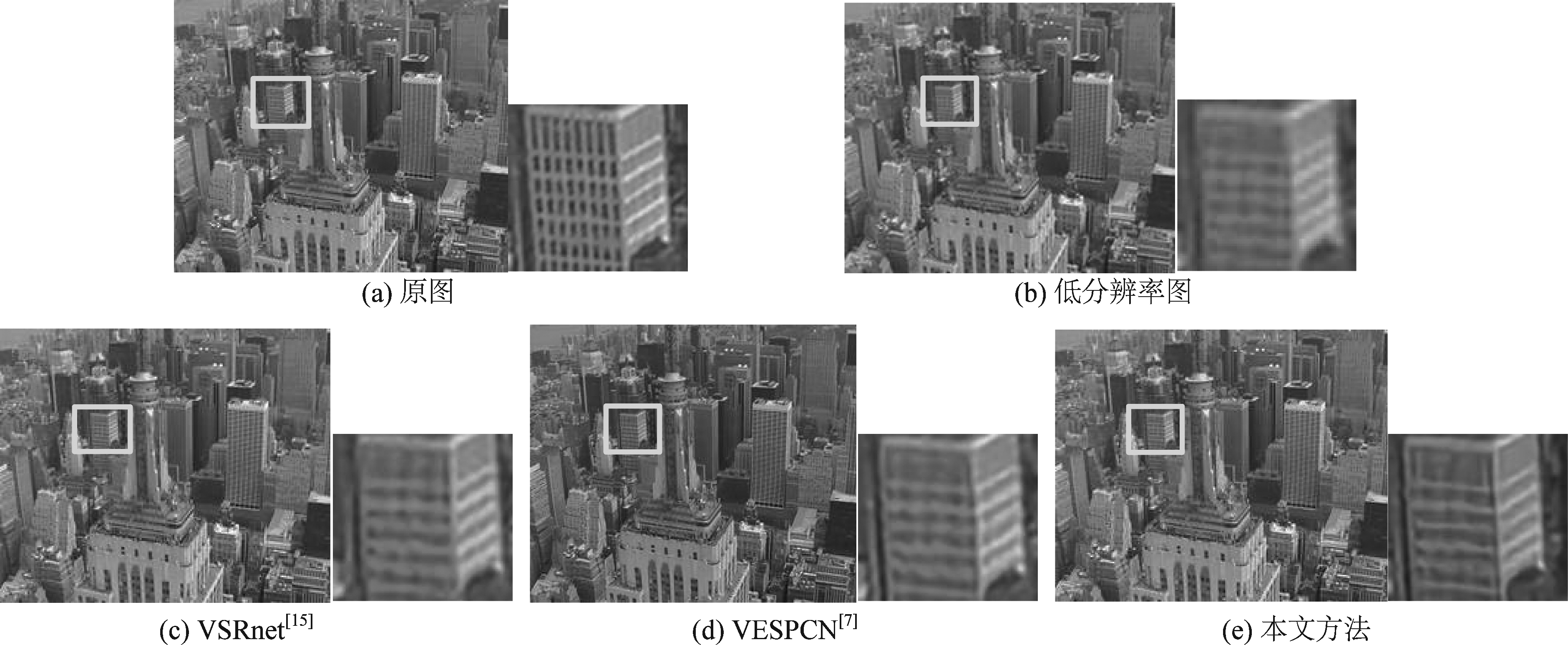

图4和图5展示了本文方法和文献[15]VSRnet、文献[7]VESPCN两种算法对测试集vid4中的“city”序列和“walk”序列超分辨率重建后的主观效果对比。对红框表示的区域进行放大对比,突显细节纹理的比较。

从图4中的建筑物的顶层的分隔柱可以观察出VSRnet[15]算法的重建效果最为模糊,本文算法的重建效果略优于VESPCN[7]算法。从图5中帽檐的褶皱痕以及帽子白色的棱角细节区域可以看出,本文所提的算法重建后的帽檐褶皱痕较VESPCN[7]和VSRnet[15]两种算法的重建效果明显和清晰。仔细观察帽檐的白色棱角区域,VESPCN[7]和VSRnet[15]均产生了边缘伪像,棱角形状和大小都产生了与原图相比较明显的区别。而本文算法重建出的棱角形状与大小最接近原图。这体现了本文算法可以恢复较多高频细节,有效地减少了边缘模糊的现象。

图4 本文方法与其他方法对vid4数据集中“city”视频以3倍系数进行超分辨率重建结果的主观质量比较

Fig.4 Subjective comparison of the proposed method and the state of the art video super-resolution methods for “city” video on the vid4 dataset, the super-resolution coefficient is 3

图5 本文方法与其他方法对vid4数据集中“walk”视频以3倍系数进行超分辨率重建结果的主观质量比较

Fig.5 Subjective comparison of the proposed method and the state of the art video super-resolution methods for “city” video on the vid4 dataset, the super-resolution coefficient is 3

本文提出了一种基于多尺度特征残差学习卷积神经网络的视频超分辨率重建方法。所提方法将由双三次插值预处理后的连续五帧视频输入卷积神经网络进行多尺度特征残差学习,重建中间帧,每次重建连续五帧,直到重建出整个高分辨率视频。基于多尺度特征残差学习卷积神经网络可以提取视频不同尺度下的特征,结合残差学习恢复出高质量的重建视频。实验结果表明,本文所提出的算法在性能上较其他基于学习的视频超分辨率方法在平均性能指标上有了一定的提升(PSNR+3.151 dB, SSIM+0.102),主观结果比较也体现了本算法在提高分辨率的同时保留了更多的高频信息并有效地减少了边缘模糊的现象。

[1] 刘村, 李元祥, 周拥军, 等. 基于卷积神经网络的视频图像超分辨率重建方法[J]. 计算机应用研究, 2019, 36(4): 1256-1260.

Liu Cun, Li Yuanxiang, Zhou Yongjun, et al. Video image super-resolution reconstruction method based on convolutional neural network[J]. Application Research of Computers, 2019, 36(4): 1256-1260.(in Chinese)

[2] 覃凤清, 何小海, 陈为龙, 等. 一种基于子像素配准视频超分辨率重建方法[J]. 光电子·激光, 2009, 20(7): 972-976.

Tan Fengqing, He Xiaohai, Chen Weilong, et al. Video super-resolution based on sub-pixel registration[J]. Photoelectron·Laser, 2009, 20(7): 972-976.(in Chinese)

[3] Ma Ziyang, Liao Renjie, Tao Xin, et al. Handling motion blur in multi-frame super-resolution[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 5224-5232.

[4] Liao Renjie, Tao Xin, Li Ruiyu, et al. Video super resolution via deep draft-ensemble learning[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2015: 531-539.

[5] Liu Ding, Wang Zhaowang, Fan Yuchen, et al. Learning temporal dynamics for video super-resolution: A deep learning approach[J]. IEEE Transactions on Image Processing, 2018, 27(7): 3432-3445.

[6] Liu Ding, Wang Zhaowang, Fan Yuchen, et al. Robust video super-resolution with learned temporal dynamics[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 2507-2515.

[7] Caballero Jose, Ledig Christian, Aitken Andrew, et al. Real-time video super-resolution with spatial-temporal networks and motion compensation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 4778- 4787.

[8] Wang Wenjun, Ren Chao, He Xiaohai, et al. Video super-resolution via residual learning[J]. IEEE Access, 2018, 6: 23767-23777.

[9] Huang Yan, Wang Wei, Wang Liang. Video super resolution via bidirectional recurrent convolutional networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 40(4): 1015-1028.

[10] Kim Jiwon, Kwon Lee Jung, Mu Lee Kyoung. Accurate image super-resolution using very deep convolutional networks[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1646-1654.

[11] Shi Wenzhe, Caballero Jose, Husz r Ferenc, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1874-1883.

r Ferenc, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1874-1883.

[12] Liu Ce, Sun Deqing. On Bayesian adaptive video super resolution[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 36(2): 346-360.

[13] Ruder S. An overview of multi-task learning in deep neural networks[J]. ArXiv preprint arXiv: 1706.05098, 2017.

[14] Video enhancer.[Online]. Available: http:∥www.infognition.com/videoenhancer/.Version 1.9.10.2014.

[15] Kappeler Armin, Yoo Seunghwan, Dai Qiqin, et al. Video super-resolution with convolutional neural networks[J]. IEEE Transactions on Computational Imaging, 2016, 2(2): 109-122.

林 琦 女, 1996年生, 福建松溪人。华侨大学信息科学与工程学院硕士研究生, 主要研究方向为图像和视频处理。

E-mail: 904449688@qq.com

陈 婧 女, 1980年生, 福建厦门人, 华侨大学信息科学与工程学院副教授, 博士学位, 主要研究方向为图像和视频处理。

E-mail: chenjing8005@hqu.edu.cn

曾焕强 男, 1984年生, 福建惠安人, 华侨大学信息科学与工程学院教授, 博士学位, IEEE高级会员。主要研究方向为视频编码、图像处理、计算机视觉。

E-mail: zeng0043@hqu.edu.cn

朱建清 男, 1987年生, 福建莆田人。华侨大学工学院副教授, 博士学位, 主要研究方向为模式识别与机器视觉。

E-mail: jqzhu@hqu.edu.cn

蔡灿辉 男, 1954年生, 福建泉州人。华侨大学工学院教授, 博士。IEEE高级会员, 信号处理编委会委员, 电子学会高级会员。近年主要研究方向为图像处理、数字视频、模式识别、多媒体通信等。

E-mail: chcai@hqu.edu.cn