1 引言

行人再识别[1]是智能视频监控的核心问题,该问题可描述为:在监控系统中,利用计算机视觉技术判断摄像设备捕获的图像或者视频序列中是否存在某一特定行人。然而,由于姿势、遮挡、光照强度等内外部因素的影响,同一行人的外观常常会发生较大变化[2-3],这大大增加了跨视域行人匹配的难度。目前,行人再识别研究主要基于特征表示、度量学习两个角度展开工作。

特征表示方面,仅仅基于单帧图像提取行人表观特征会导致运动信息的损失,因此基于视频序列提取运动信息逐渐成为新的关注点[4]。一般,行人服装、配饰或鞋子颜色等表观特征存在相似的情况,相对地,步态和行走周期则是较为独特的区分性特征。基于此,一些研究者提出利用步态信息进行行人再识别[5],该类方法通过辨别行人行走步态之间的细微差别来区分不同身份信息。进一步地,人体不同区域的协方差也可以描述视频帧之间的空间关系,部分研究者利用时空分布图标记行人视频帧之间的时间-空间稳定区域,标记区域后再提取特征。Cong等[6]尝试将归一化的表观特征结合视频序列的流行几何特征,构建在空间上更为紧凑的特征描述子。上述方法大都基于视频帧的空间信息提取特征,注重空间联系,为寻找新的解决方法,提取视频帧之间的时间线索成为又一关注点。2014年,文献[7]利用光流能量分布图检测行人的行走周期,并使用时空梯度方向直方图(Histogram of Oriented 3D Gradient, HOG3D)[8]描述行人运动特征。2017年,文献[9]基于此构建双流多速率递归神经网络,首先提取视频帧包含的空间和时间特征,经过正则化操作后融合,最后输入到多速率循环网络中。事实上,提取HOG3D特征或利用双流网络提取时空信息,目的都是基于视频提取鲁棒的时空特征,但训练提取时空特征的深度网络以大规模行人数据集为前提,并且训练时间一般较长。

度量学习方法[10]在行人再识别研究中也有着广泛应用。针对不同摄像头间存在的视图差异,文献[11]为克服该差异提出交叉视图二次判别分析(Cross-view Quadratic Discriminant Analysis, XQDA)模型,该模型首先将特征投影到低维子空间,然后对特征进行线性判别分析(Linear Discriminant Analysis, LDA)[12],最终在子空间中通过KISSME(Keep It Simple and Straight forward Metric Learning, KISSME)[13]方法学习一个距离度量函数。Zeng等[14]提出利用松弛标签空间变换方法从共同特征中学习两个半耦合字典,进而使用一对变换矩阵,将共同特征空间和松弛标签空间的编码系数联系起来,以捕捉不同视域中同一行人的内在关系。同样,类似的通用视图方法着重量化不同视域下的行人共性特征,并没有进行跨摄像机视图的特征分布对齐。

考虑到文献[7]并没有充分利用所有视频帧,导致了一定程度的时间信息丢失。本文为充分利用视频中包含的行人运动信息,在文献[7]基础上作出改进,特征提取时,基于所有视频帧提取HOG3D特征,并与表观特征结合作为行人的时空特征描述子;然后在度量学习时,结合边际费希尔分析MFA(Marginal Fisher Analysis)[15]算法进行视频特征的自适应特征增强[16],将原始特征转换至视图通用特征关联更为紧密的增强空间,最后计算欧式距离和排序,大大提高对视频特征的判别性。

2 时空特征结合相机关联自适应特征增强的行人再识别

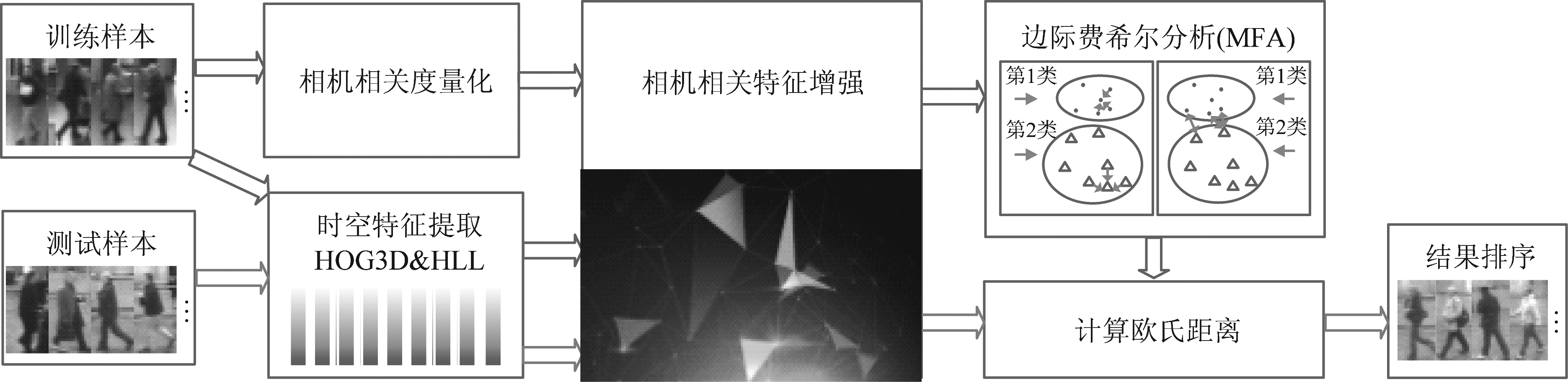

完整行人再识别模型示意图如图1所示。

2.1 特征提取

本算法在图像水平提取颜色空间HIS、LUV颜色直方图以及纹理LBP特征(以下表示为HLL),在视频水平提取HOG3D特征。区别于静态图像中的HOG特征,HOG3D特征在x、y、t三个方向上同时提取梯度直方图,包含丰富的时间梯度信息。

2.1.1 表观特征(HLL)提取

颜色和纹理是描述行人图像的重要视觉特征,在目前提出的颜色空间模型中,RGB[17]是实际应用中最常见的一种,但其视觉空间不均匀、空间距离并不能表示视觉上的颜色相似性。因此本文采用在其基础上改进的HIS颜色直方图特征,HIS具有本身颜色参量间相关性较小、对环境变化的惰性更强等特点,更适于进行机器视觉的图像描述。另外还采用LUV颜色描述机制和局部二值模式LBP特征,LUV是由CIE制定的一种色彩模式,颜色空间比RGB大,并且完全以数字化方式描述人的视觉感受而与图像采集设备无关。局部二值模式LBP是纹理描述中最具代表性的特征,该特征对于角度旋转、光线明暗变化等都有较强的鲁棒性。

图1 行人再识别模型示意图

Fig.1 Schematic of person re-id model

提取表观特征时首先将视频帧图像进行128×48归一化处理,使用滑动子窗口进行分块处理,且为进一步提高表观特征的表现力,块与块之间在水平和垂直方向上均有50%重叠;然后在每个特征兴趣块内提取LBP纹理特征,并计算HIS、LUV颜色通道的平均值,最后进行取均值操作得到鲁棒性更强的表观特征。

2.1.2 时空特征(HOG3D)提取

在静态图像水平,描述形状最常用的代表性特征是梯度方向直方图(Histogram of Oriented Gradient, HOG),HOG在边缘和局部形状检测方面都有着广泛应用。由于本文算法基于视频提取特征,因此与静态图像中的HOG特征不同,在HOG3D的提取过程中,将基于兴趣点周围提取梯度方向直方图的多边形变为基于兴趣块周围提取时空梯度方向直方图的多面体。数学几何中,各个面都一致的理想多面体有四面体、六面体、八面体、十二面体和二十面体,静态图像中的HOG特征最常用的量化基元是八边形,一个完整ds的提取过程如图2所示。

图2 一个完整ds的提取过程

Fig.2 The extraction of ds

首先,在检测到的人体兴趣点(x,y,t)周围建立一个长、宽、高分别是h、w、l的立方体Q,如图(a)所示。根据文献[8]可知,h=w=σ×σ0且l=τ×τ0(其中σ是空间兴趣点检测时获取的空间尺度,τ是时间尺度)。立方体确定之后,在区域Q(x-w/2:x+w/2;y-h/2:y+h/2;t-l/2:t+l/2)中继续分块,视频空间被分成M×M×N个部分,也叫单元,将每一个单元记为ci(i=1,2,3,…,M2N),并如图(b)所示,以S=2将ci进一步分成S3=8个子区域,每个子区域被记为bj(j=1,2,3,…,S3)。接下来,计算bj内所有点方向量化后的每个方向的梯度![]() 这里以十二面体为例进行方向投影。十二面体每个面的中心坐标表示为P=(p1,p2,…,p12)T,具体到每个面pi=(0,±1,±φ),(±1,±φ,0),(±φ,0,±1),其中

这里以十二面体为例进行方向投影。十二面体每个面的中心坐标表示为P=(p1,p2,…,p12)T,具体到每个面pi=(0,±1,±φ),(±1,±φ,0),(±φ,0,±1),其中![]() 利用公式

利用公式![]() 得到bj内所有点的映射结果

得到bj内所有点的映射结果![]() 得到的

得到的![]() 经过阈值选择变成qj。最后,对ci单元内的8个子区域所对应的qj求和得到hi,再将所有M2N个单元的hi顺序排列,组成HOG3D的一个完整描述子ds=(h1,h2,…,hM2N)T。

经过阈值选择变成qj。最后,对ci单元内的8个子区域所对应的qj求和得到hi,再将所有M2N个单元的hi顺序排列,组成HOG3D的一个完整描述子ds=(h1,h2,…,hM2N)T。

本算法中使用的时空HOG3D特征的具体提取过程是,为了从人体头部、躯干、手臂、双腿部位获取更多的空间特征,首先将某行人的所有视频帧图像在空间上分成3×5个特征提取单元Q,水平方向相邻每两个单元之间有50%的空间重叠;然后在每个特征提取单元中,将视频图像块分成M×M×N个c,并利用上述计算过程得到每个视频图像块对应的ds;最后,将所有特征提取单元Q对应的ds级联,形成该行人最终的时空特征向量。实验中取M=5,N=4,每个hi对应维度是20,相应的每个ds维度是2000,那么将12个特征提取单元对应的所有ds经L2正则化,级联之后便得到某行人最终的时空特征向量。

2.2 相机关联自适应特征增强2.2.1 特征增强的作用

在特征增强中,特征映射函数ρs(x)=[xT,xT,(Οd)T]T(源域)和ρt(x)=[xT,(Οd)T,xT]T(目标域)被广泛应用于齐次域自适应问题,x表示样本特征,Οd表示所有元素都为零的d列矩阵,d表示特征维度,上标T表示矩阵转置,其实质是将原始特征转换到增强空间中,增加来自相同域的数据间的关联性。对于行人再识别问题,由于其特有的交叉视图的匹配特性,增加来自相同域的数据之间的相似性是不必要的,但将不同相机视图数据映射到同一增强空间,理论上也可以增加来自相同行人ID的数据间的相似性。在信号传输领域的特征增强应用中,零填充技术是一种广泛应用的技术,为进一步引入相机关联自适应特征增强,下节先对零填充技术原理作介绍。

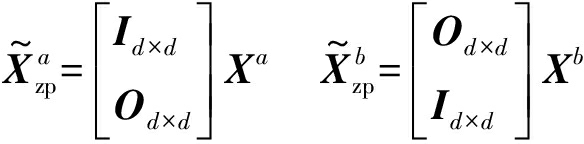

2.2.2 零填充

零填充方法的定义为:

(1)

其中![]() 和

和![]() 分别表示摄像头A和B对应特征列向量。

分别表示摄像头A和B对应特征列向量。![]() 和

和![]() 表示的是特征增强后的特征向量;na和nb分别表示来自摄像头A和B的样本数量,Id×d和Od×d分别表示d×d维的单位矩阵和零矩阵。

表示的是特征增强后的特征向量;na和nb分别表示来自摄像头A和B的样本数量,Id×d和Od×d分别表示d×d维的单位矩阵和零矩阵。

2.2.3 特征增强后的匹配过程

经过增强的特征![]() 不失一般性,本节以学习子空间为例说明特征增强后的再识别过程。

不失一般性,本节以学习子空间为例说明特征增强后的再识别过程。

判别分析目的一般是寻找最优投影空间![]() (其中m为子空间维数),使原始特征经过

(其中m为子空间维数),使原始特征经过![]() 投影(其中φ∈{a,b}且

投影(其中φ∈{a,b}且![]() 指增强后的特征)后,可以根据通用欧氏距离对不同行人身份进行区分以完成再识别任务。具体来说,投影空间中的目标函数可以表示为:

指增强后的特征)后,可以根据通用欧氏距离对不同行人身份进行区分以完成再识别任务。具体来说,投影空间中的目标函数可以表示为:

(2)

其中![]() 且

且![]() 是来自摄像头A和B的级联特征。

是来自摄像头A和B的级联特征。![]() 可以被分解为以下两个部分:

可以被分解为以下两个部分:

(3)

其中![]() 和

和![]() 分别表示来自摄像头A和B的特征投影子空间,这是因为基于零填充的特征增强(公式(1)),存在如下变换:

分别表示来自摄像头A和B的特征投影子空间,这是因为基于零填充的特征增强(公式(1)),存在如下变换:

(4)

换言之,零填充后的特征可供通用视图算法同时学习两个特定视图的子模型,其中![]() 对应摄像头A的视图,

对应摄像头A的视图,![]() 对应摄像头B的视图[18],该类方法可以更好地对齐交叉视图的特征数据分布[19]。

对应摄像头B的视图[18],该类方法可以更好地对齐交叉视图的特征数据分布[19]。

显然,零填充通过分别优化特定视图的子模型独立地处理每个摄像机视图的特征数据,可以更好地量化任意摄像机视图的特征失真。但不可避免地,减小了不同视图数据之间的相关性,这反而可能降低模型在捕捉视图间特征变化和提取视图共性特征方面的性能。

2.3 相机关联自适应特征增强-MFA

为突破零填充的限制,本文采用基于相机关联自适应特征增强方法,该操作可以将相机视图之间的共有信息自适应地嵌入到增强空间中,同时保证单个摄像机视图的特征失真量化能力。本节将对相机关联自适应特征增强与MFA算法的结合过程做详细介绍。

2.3.1 相机关联度计算

相机关联自适应特征增强主要进行以下两个步骤:首先自动量化不同摄像机视图之间的共有信息,其次根据量化的视图共有信息进行自适应特征增强。

来自摄像头A和B的视频特征分别为Xa和Xb,利用源角度测量两个相机视图之间的相关性ω,首先通过主成分分析(Principal Component Analysis, PCA)得到视频特征的线性子空间,Ga∈Rna×r为Xa对应子空间,Gb∈Rnb×r为Xb对应子空间,r表示子空间的特征维数。Ga和Gb可以被看作格拉斯曼流形上的某两个数据点,根据源角度定义两个流形点集合之间的相似度 两个子空间中某两个数据点的源角度被定义为:

两个子空间中某两个数据点的源角度被定义为:

(5)

其中span(·)表示由特征列向量张成而得的子空间。源角度的几何解释为两个子空间的角度余弦cos(θk),由此估计相机数据点的关联度ω为:

(6)

其中cos(θk)利用奇异值分解(Singular Value Decomposition, SVD)计算:

(Ga)TGb=Qcos(Θ)VT

(7)

cos(Θ)=diag(cos(θ1),cos(θ2),…,cos(θr)),Q=[q1,q2,…,qr],且V=[v1,v2,…,vr]。

2.3.2 自适应特征增强

将相机关联度ω进一步引入特征增强中,零填充公式(1)变换为:

(8)

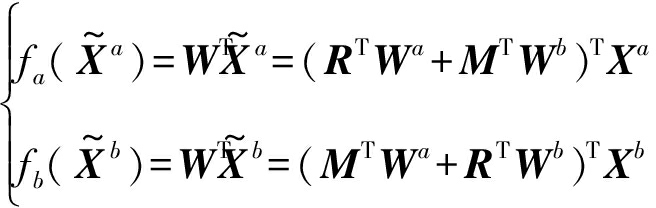

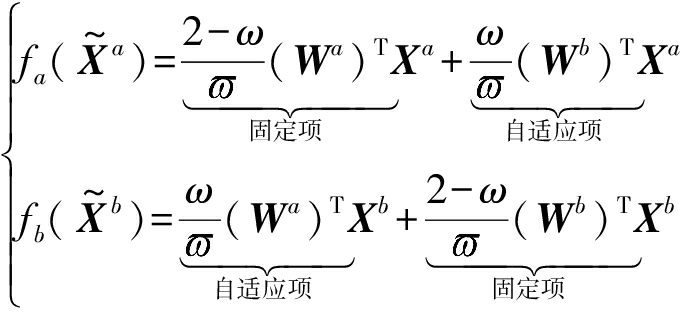

其中R和M为d×d增广矩阵,如此一来,零填充可以看作是公式(8)中,当R=Id×d且M=Od×d时的特殊情况。利用经典判别分析算法,在特征增强空间中学习一个匹配优化模型W=[(Wa)T,(Wb)T]T,相应地,特征增强过程的映射函数表示为:

(9)

利用相机关联度ω自适应估计而得的增广矩阵R和M的一般表达形式为:

(10)

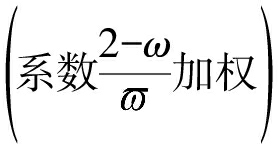

基于相机关联系数ω定义![]()

![]() 为正则项,M描述两相机之间的视图共性而R描述两相机的视图特性,当ω=0时表示两个相机视图之间的关联度为0;当ω=1时,R=M表示两个相机视图之间的关联度为最大,相应地学习而得的特殊视图子空间也将会完全一致。结合公式(10)的定义,公式(9)可以进一步表示为:

为正则项,M描述两相机之间的视图共性而R描述两相机的视图特性,当ω=0时表示两个相机视图之间的关联度为0;当ω=1时,R=M表示两个相机视图之间的关联度为最大,相应地学习而得的特殊视图子空间也将会完全一致。结合公式(10)的定义,公式(9)可以进一步表示为:

(11)

显然,每个相机视图的映射特征取决于各自的子模型 以及另一子模型

以及另一子模型 因此,相机关联自适应特征增强方法实现了视图共性和视图特性之间的判别性信息的联合表示。

因此,相机关联自适应特征增强方法实现了视图共性和视图特性之间的判别性信息的联合表示。

2.3.3 相机视图差异正则化

如公式(9)所示,相机视图之间的转换并不独立,而存在某种联系。为对不同子模型间的相互关系作补充(基于公式(9))的同时进行正则化(基于公式(3)和(11)),引入摄像机视图偏差正则项来约束子模型:

γ=‖Wa-Wb‖2

(12)

该相机视图差异正则项可以与岭回归联系到一起定义为:

γ=‖Wa-Wb‖2+ηridgetr(WTW)

=(1+ηridge)tr(WTCW)

(13)

其中![]() 定义的是跟踪函数,而ηridge 是岭回归和正则项之间的权衡参数,在公式(2)的基础上,目标函数进一步变化为:

定义的是跟踪函数,而ηridge 是岭回归和正则项之间的权衡参数,在公式(2)的基础上,目标函数进一步变化为:

(14)

其中λ控制正则项的影响程度。当![]() 时,矩阵C为正定,可以被分解为:

时,矩阵C为正定,可以被分解为:

C=PΛΛT

(15)

其中Λ是一个对角矩阵且PPT=PTP=I,因此同样存在着PTCP=Λ。通过定义

(16)

可以得到:

WTCW=HTH

(17)

因此公式(14)可以进一步变为:

(18)

定义所有视角的数据转换矩阵如下:

(19)

将公式(19)称为相机视图差异正则化特征矩阵,公式(18)的目标函数表示进一步简化为:

(20)

2.3.4 特征增强与MFA的结合

具体来说,在行人再识别问题中一般认为每一个行人ID对应一个类,即同一行人ID的所有图像组成一个同类样本集。当给定训练数据X=[Xa,Xb]=[x1,x2,…,xn](n=na+nb),首先将它们转换为![]() 通过求解MFA优化问题获得矩阵

通过求解MFA优化问题获得矩阵![]()

(21)

其中固有项Ac中的元素![]() 当

当![]() 或者

或者![]() 时值为1,其他情况下均为0,其中

时值为1,其他情况下均为0,其中![]() 表示样本xi在相同类别中的k1个最近邻指标的集合,惩罚项Ap中的元素

表示样本xi在相同类别中的k1个最近邻指标的集合,惩罚项Ap中的元素![]() 当(i, j)∈Pk2(yi)或者(i, j)∈Pk2(yj)时值为1,其他情况下均为0。其中yi和yj分别表示样本i和j的类别标签,Pk2(yi)表示{(i, j),yi≠yj}中k2个距离最近的数据对,最后利用公式(16)得到W。

当(i, j)∈Pk2(yi)或者(i, j)∈Pk2(yj)时值为1,其他情况下均为0。其中yi和yj分别表示样本i和j的类别标签,Pk2(yi)表示{(i, j),yi≠yj}中k2个距离最近的数据对,最后利用公式(16)得到W。

3 模型框架及算法流程

从训练数据中学习到模型(W或U)后,可以将其应用于行人再识别框架中。首先,进行特征增强以将所有原始特征{x}变换到相机关联特征增强空间![]() 其次,通过计算测试集中的某行人

其次,通过计算测试集中的某行人![]() 与候选集中所有行人特征

与候选集中所有行人特征![]() 在学习到的空间中的欧式距离

在学习到的空间中的欧式距离![]() 最后将从候选集中查询到的行人根据欧氏距离大小排序,生成排序列表。本文提出的行人再识别框图如图3所示。

最后将从候选集中查询到的行人根据欧氏距离大小排序,生成排序列表。本文提出的行人再识别框图如图3所示。

相机关联自适应特征增强-MFA算法流程如下所示:

(1)输入带标签的训练特征数据Xa和Xb;

(2)评估相机关联系数ω;

(3)计算特征增强矩阵R和M;

(4)将原始特征X转换为增强后的特征![]()

(5)得到相机视图差异正则项;

(6)得到相机视图差异正则项与岭回归的融合正则项;

(7)将矩阵C分解为P和Λ;

(8)将增强矩阵![]() 进一步转化为正则项

进一步转化为正则项![]()

(9)根据MFA算法计算得到![]()

(10)利用P、Λ以及![]() 计算得到W;

计算得到W;

(11)输出增强矩阵R和M,映射矩阵![]()

4 实验仿真

本算法实验在两个视频行人数据集PRID 2011和iLIDS-VID中进行。PRID 2011数据集包含从两个静止摄像头中采集的视频对,摄像机A记录了385个行人的视频信息,摄像机B记录了749个行人的视频信息,其中同时被摄像机A、B采集到的行人有200个,每个行人的视频子集中包含的视频帧数从5到675不等。为保证时空特征的有效性,实验筛选出178个视频帧数超过27帧的行人视频子集,该数据集中的所有视频均是在非拥挤且少遮挡的户外环境下拍摄,每个人都有丰富的行走姿势图像,部分行人视频帧示例如图4所示。

iLIDS-VID数据集中包含随机抽取的300个行人的600个视频子集,每个行人对应的有来自两个不同摄像头的两个视频子集,视频帧数从23到192不等。与PRID 2011相比,iLIDS-VID是在机场大厅由CCTV网络中的多机位相机拍摄,因此光线和摄像角度变化多样、背景复杂且遮挡不规则,部分行人视频帧示例如图5所示。

实验将行人视频特征一半用于训练,一半用于测试,重复10次得到平均性能,最后采用累积匹配特性(Cumulative Match Characteristic, CMC)曲线和Rank-N表格对算法性能进行评测,CMC曲线是指在行人候选集中搜索查询行人时,排序并计算排在前r个搜索结果中查找到待查寻行人的概率。

图3 时空特征结合相机关联自适应特征增强-MFA的行人再识别框图

Fig.3 The flow chart of person re-id based on spatial-temporal features and camera-correlation feature augmentation-MFA

图4 PRID 2011数据集行人视频帧示例

Fig.4 Video frame examples of PRID 2011 set

图5 iLIDS-VID数据集行人视频帧示例

Fig.5 Video frame examples of iLIDS-VID set

4.1 PRID 2011数据集

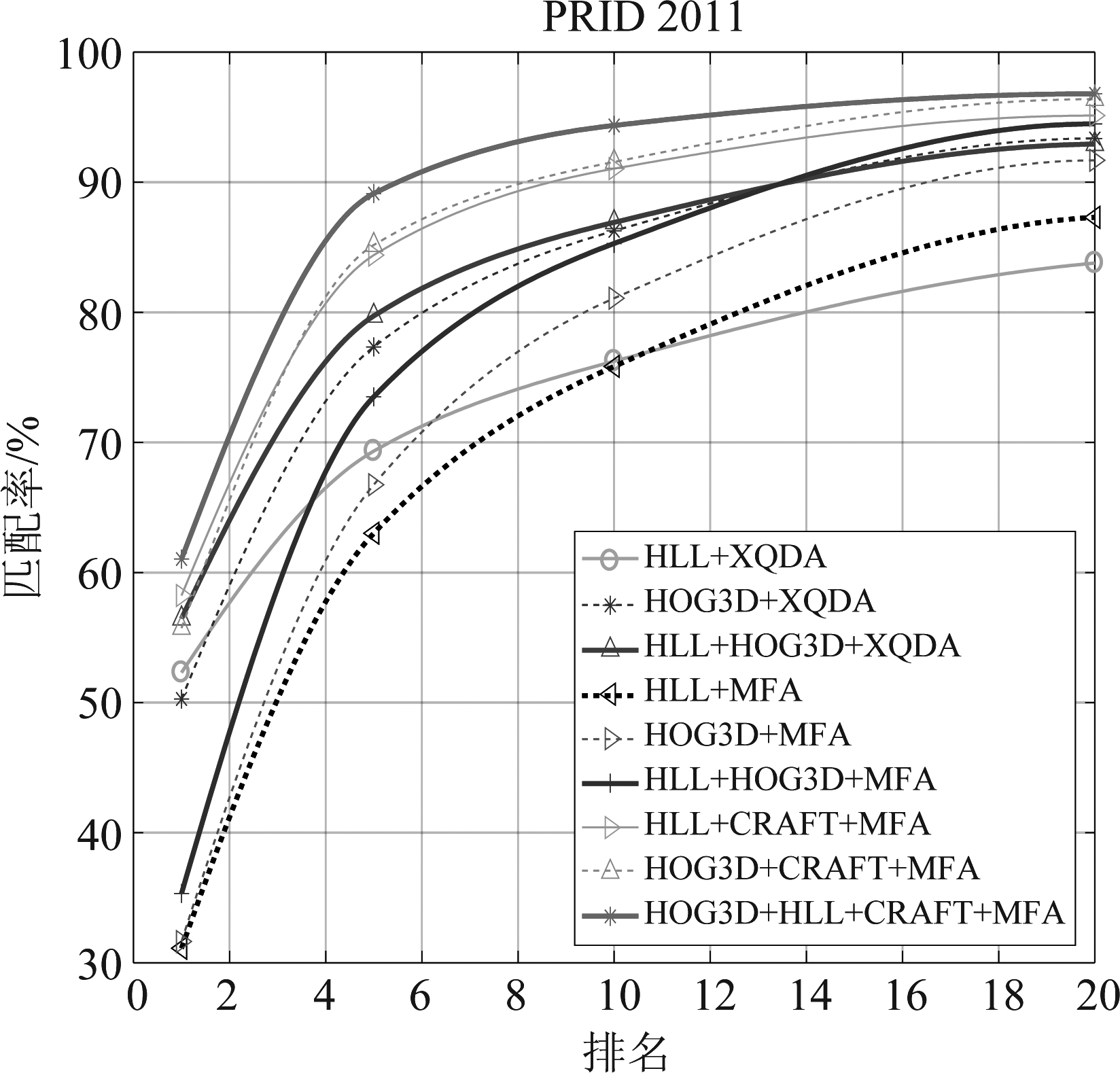

在PRID 2011中进行两个实验,第1个实验分为只提取表观特征HLL、只提取时空特征HOG3D以及同时提取表观特征HLL和HOG3D三组,并且分别在组内将本文采用的相机关联自适应特征增强-MFA(以下简称CRAFT+MFA)与XQDA、MFA两种经典方法作比,实验结果如表1所示,CMC曲线评测结果如图所示。需要说明的是,由于本组实验结果较多,为清晰观察出识别率的变化趋势,特将曲线纵坐标设置为30开始。

图6 PRID 2011数据集中的实验1 CMC曲线

Fig.6 CMC Curves of experiment 1 on PRID 2011 database

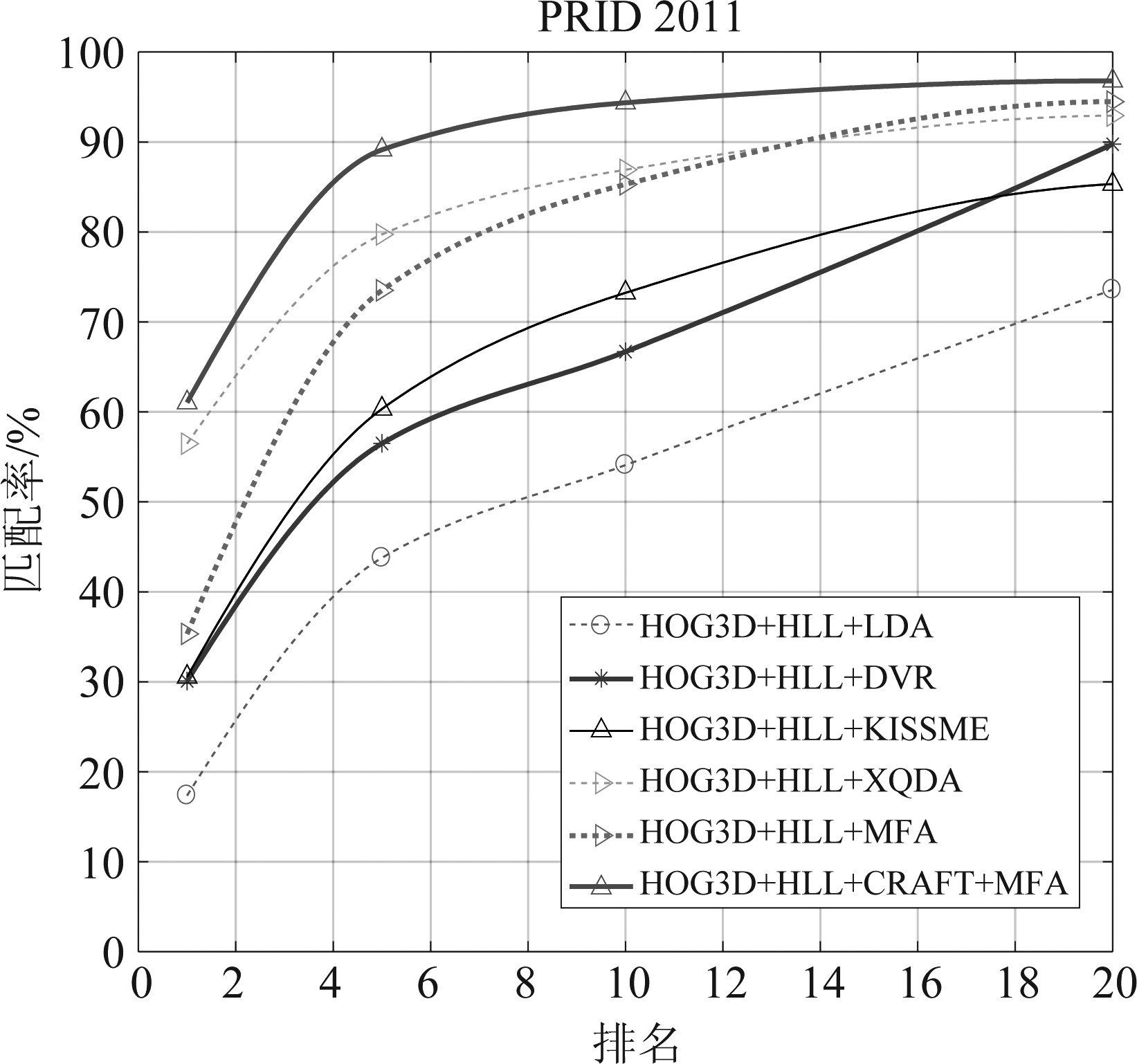

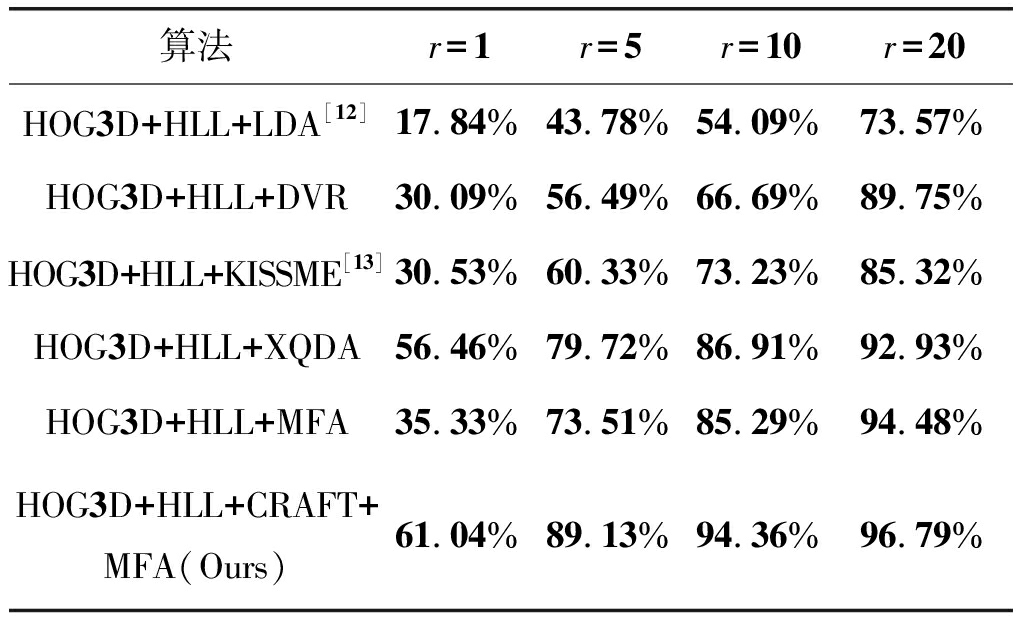

在PRID 2011中进行的第2组实验将HLL+HOG3D特征与几种经典度量方法结合,说明该特征描述子有效性的同时,得出CRAFT+MFA的性能优越性,实验结果如表2所示,CMC曲线测评结果如图7所示。

由PRID 2011数据集中的两组实验结果可知:

(1)将HOG3D+HLL作为特征描述子比单HOG3D或单HLL更为有效;

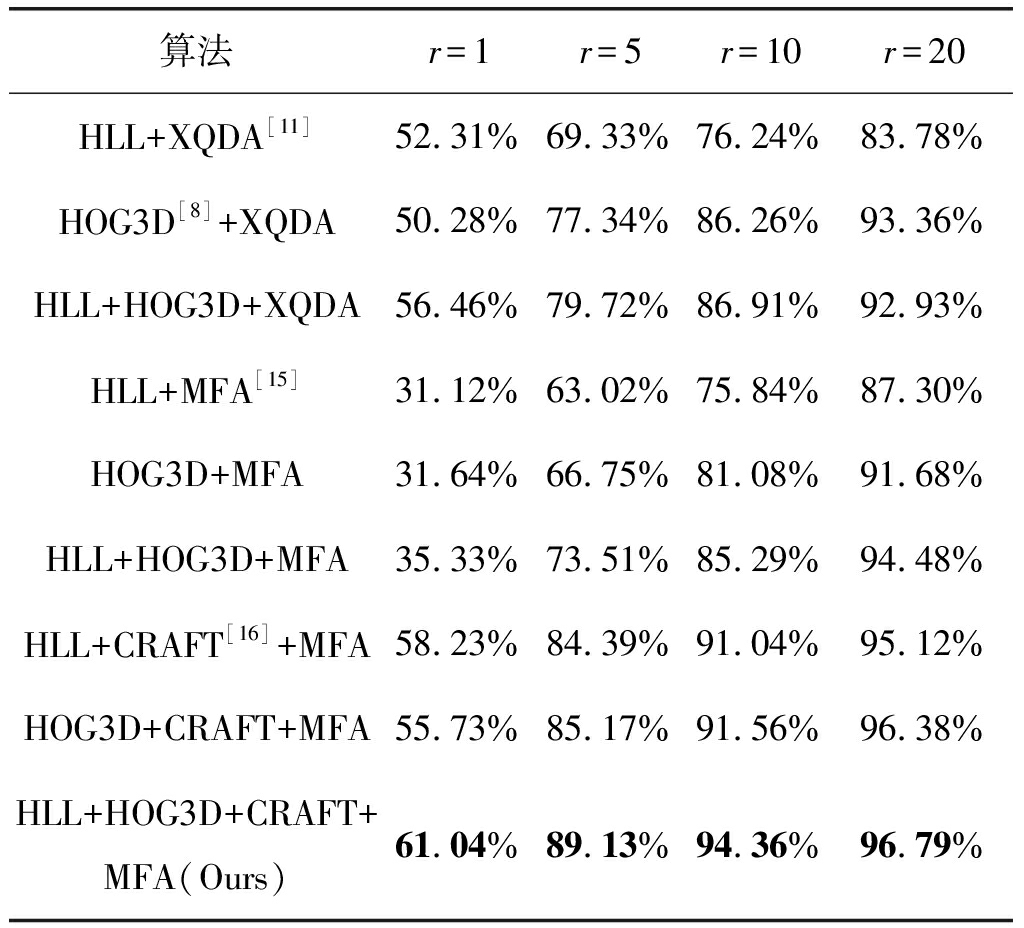

表1 PRID 2011数据集中实验1结果

Tab.1 Comparison to other algorithms of experiment 1 on PRID 2011 database

算法r=1r=5r=10r=20HLL+XQDA[11]52.31%69.33%76.24%83.78%HOG3D[8]+XQDA50.28%77.34%86.26%93.36%HLL+HOG3D+XQDA56.46%79.72%86.91%92.93%HLL+MFA[15]31.12%63.02%75.84%87.30%HOG3D+MFA31.64%66.75%81.08%91.68%HLL+HOG3D+MFA35.33%73.51%85.29%94.48%HLL+CRAFT[16]+MFA58.23%84.39%91.04%95.12%HOG3D+CRAFT+MFA55.73%85.17%91.56%96.38%HLL+HOG3D+CRAFT+MFA(Ours)61.04%89.13%94.36%96.79%

图7 PRID 2011数据集中实验2 CMC曲线

Fig.7 CMC Curves of experiment 2 on PRID 2011 database

(2)单独使用表观特征HLL组合与单独使用HOG3D特征得到的匹配结果相差不大,这说明在行人视频帧数量足够的前提下,只提取时空特征HOG3D也可以完成基本的识别任务;

(3)不论单独使用HLL特征、HOG3D特征或将两者结合,与行人再识别经典度量方法的对比可以看出,CRAFT-MFA算法得到的最终行人再识别效果都是最优秀的;

(4)由第2组实验结果可以看出,本文提出的特征提取机制在经典度量学习算法中的性能表现相差较大,这恰恰说明提取视频中包含的行人运动信息后,系统整体性能的提高需要具有强判别力的子空间或距离函数,否则会得到与一般表观特征相近或更差的匹配结果。

表2 PRID 2011数据集中实验2结果

Tab.2 Comparison to other algorithms of experiment 2 on PRID 2011 database

算法r=1r=5r=10r=20HOG3D+HLL+LDA[12]17.84%43.78%54.09%73.57%HOG3D+HLL+DVR30.09%56.49%66.69%89.75%HOG3D+HLL+KISSME[13]30.53%60.33%73.23%85.32%HOG3D+HLL+XQDA56.46%79.72%86.91%92.93%HOG3D+HLL+MFA35.33%73.51%85.29%94.48%HOG3D+HLL+CRAFT+MFA(Ours)61.04%89.13%94.36%96.79%

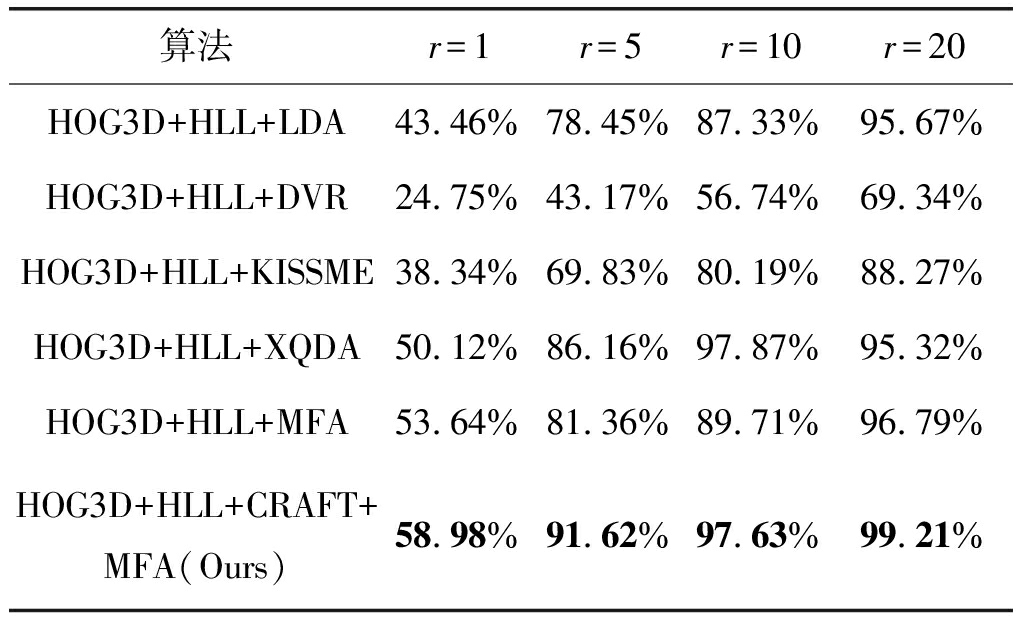

4.2 iLIDS-VID数据集

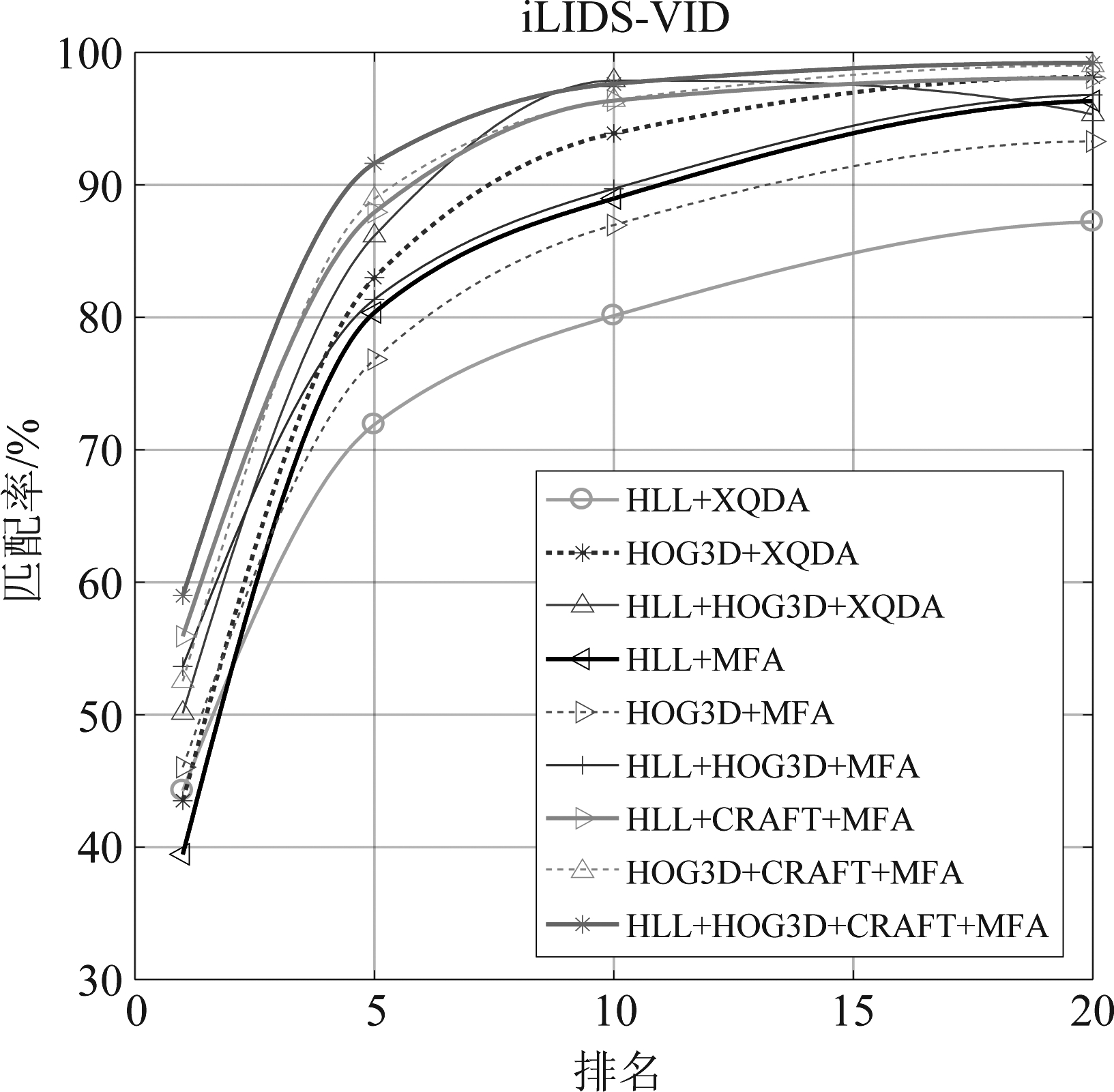

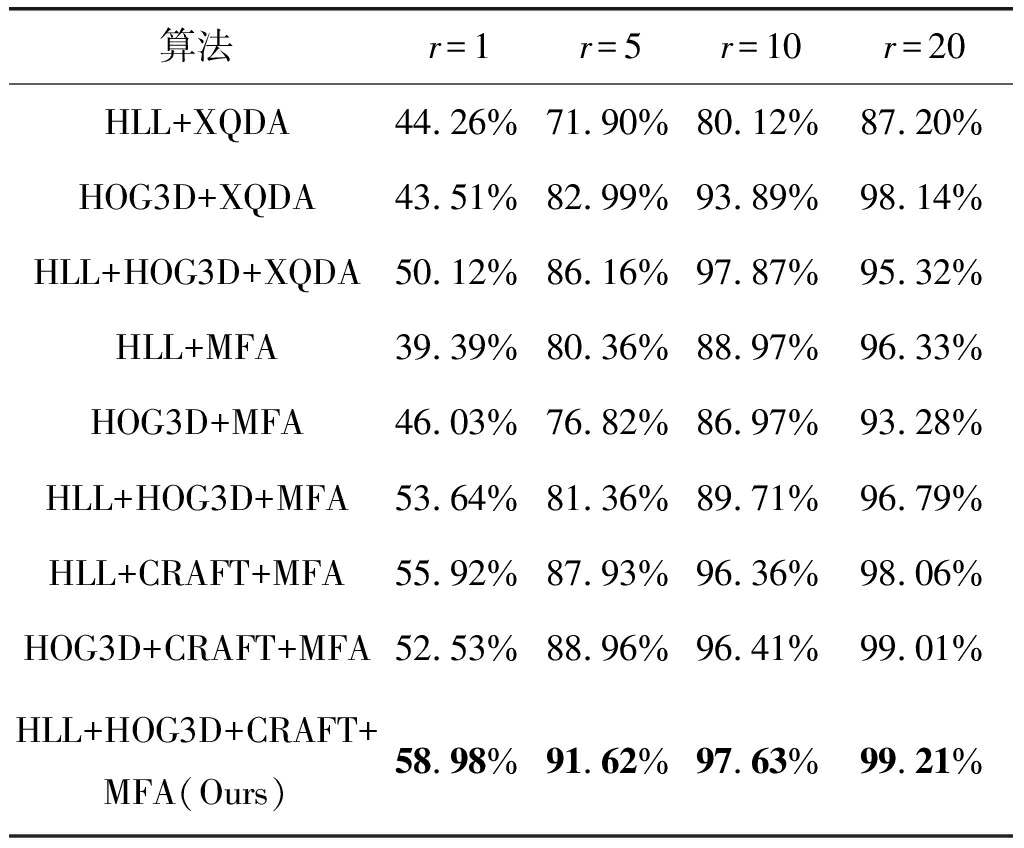

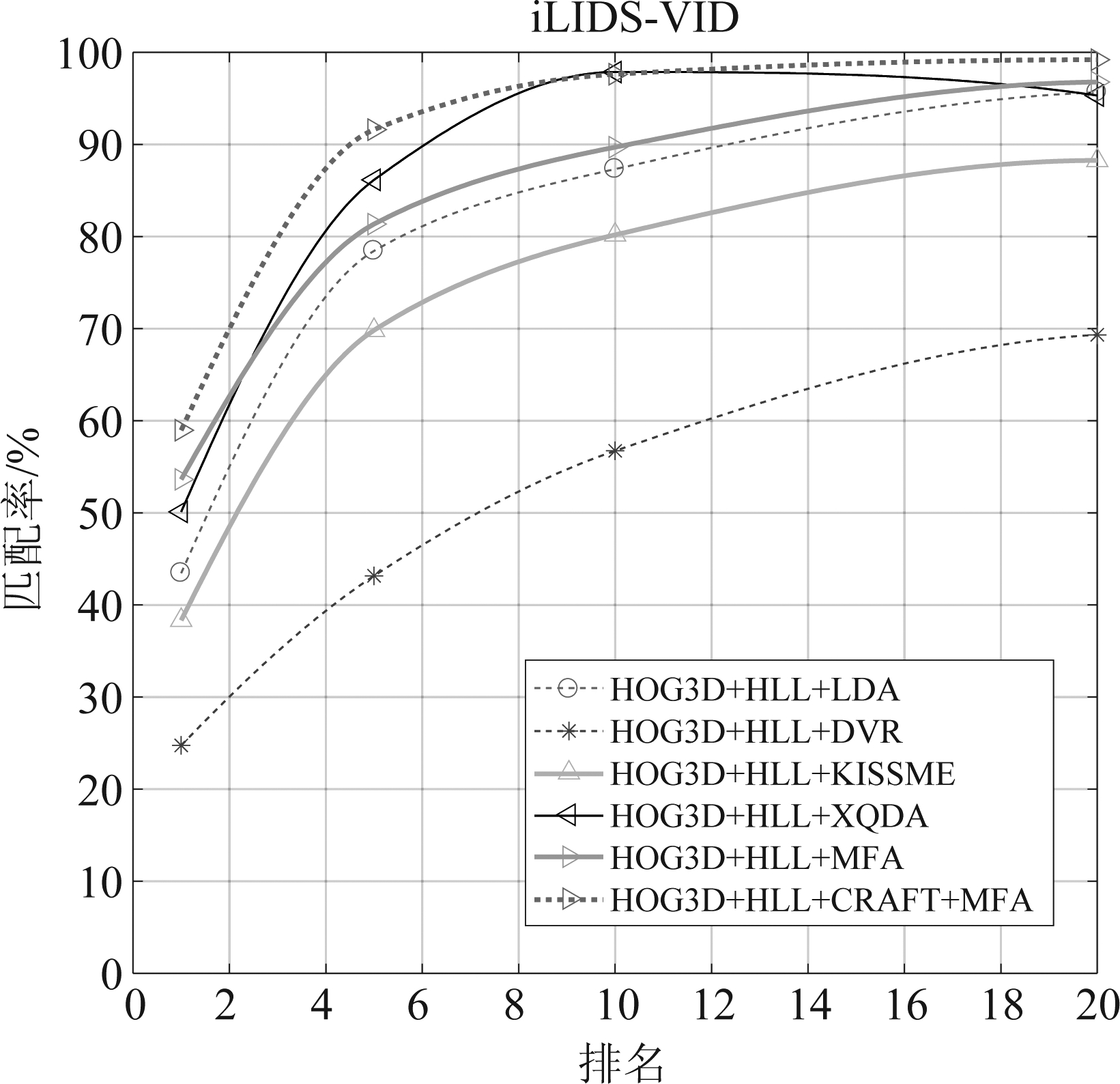

在iLIDS-VID中的实验与PRID 2011中的实验设置和过程均相同,相应的实验1结果如表3所示,CMC曲线评测结果如图8所示;实验2的结果如表4所示,CMC曲线评测结果如图9所示。第1组实验结果的CMC曲线图纵坐标也设置为30开始。

由iLIDS-VID数据集中的实验可得出与PRID 2011数据集中实验相似的结果。不同的是,由于iLIDS-VID数据集中的图像背景比PRID 2011数据集普遍更复杂,特征之间的类内变化较大,因此在iLIDS-VID数据集中代表真正再识别能力的Rank-1比在PRID 2011数据集中表现稍差,但时空表观特征的有效性不容忽视。

图8 iLIDS-VID数据集中实验1 CMC曲线

Fig.8 CMC Curves of experiment 1 on iLIDS-VID database

表3 iLIDS-VID数据集中实验1结果

Tab.3 Comparison to other algorithms of experiment 1 on iLIDS-VID database

算法r=1r=5r=10r=20HLL+XQDA44.26%71.90%80.12%87.20%HOG3D+XQDA43.51%82.99%93.89%98.14%HLL+HOG3D+XQDA50.12%86.16%97.87%95.32%HLL+MFA39.39%80.36%88.97%96.33%HOG3D+MFA46.03%76.82%86.97%93.28%HLL+HOG3D+MFA53.64%81.36%89.71%96.79%HLL+CRAFT+MFA55.92%87.93%96.36%98.06%HOG3D+CRAFT+MFA52.53%88.96%96.41%99.01%HLL+HOG3D+CRAFT+MFA(Ours)58.98%91.62%97.63%99.21%

除了最终识别率,实验还特意记录了算法耗时。相对于一般度量方法,CRAFT-MFA耗时稍多,但只要针对训练样本学习完毕,最终匹配率的计算速度很快。耗时稍多的原因是,相机关联自适应特征增强的实质是在度量方法的基础上,对特征进行变换,算法复杂度大于一般度量方法,但是由于算法本身涉及的数学计算量并不大,多出的运算耗时可以当做模型性能提升的小小代价。若要降低特征增强多出的运算耗时,可以从降低特征维度或提高硬件运算速度两方面着手解决,这部分内容还有待进一步探究。

图9 iLIDS-VID数据集中实验2 CMC曲线

Fig.9 CMC Curves of experiment 2 on iLIDS-VID database

表4 iLIDS-VID数据集中实验2结果

Tab.4 Comparison to other algorithms of experiment 2 on iLIDS-VID database

算法r=1r=5r=10r=20HOG3D+HLL+LDA43.46%78.45%87.33%95.67%HOG3D+HLL+DVR24.75%43.17%56.74%69.34%HOG3D+HLL+KISSME38.34%69.83%80.19%88.27%HOG3D+HLL+XQDA50.12%86.16%97.87%95.32%HOG3D+HLL+MFA53.64%81.36%89.71%96.79%HOG3D+HLL+CRAFT+MFA(Ours)58.98%91.62%97.63%99.21%

5 结论

为解决由于图像背景干扰而不能提取鲁棒性行人特征的问题,本文提出时空特征结合相机关联自适应特征增强的视频行人再识别模型。设计基于HOG3D和表观特征的特征提取机制,在视频水平提取包含丰富运动信息的时空特征HOG3D,然后结合有效的传统颜色空间直方图和纹理特征,得到表现力优秀的特征描述子;在距离度量阶段针对行人再识别中存在的视图差异问题,进行跨摄像机视图的特征对齐,在MFA基础上进行相机关联自适应特征增强,使得在增强后的特征空间中,图像共性特征之间关联更加紧密,特性特征之间的区分性更加明显,随后再进行欧氏距离度量和匹配结果排序,大大提高了对视频特征的区分性。最终实验结果显示该行人再识别算法基于视频提取了丰富的时间信息,采用的相机关联自适应特征增强-MFA方法也成功克服了视频特征间存在的视图差异问题,进一步提高了行人再识别匹配率,对基于视频的行人再识别研究具有借鉴意义。

[1] Gong Shaogang, Cristani M, Yan Shuicheng, et al. Person re-identification[M]. Springer London, Springer-Verlag London, 2014: 1-21.

[2] Zheng Liang, Yang Yi, Hauptmann A, et al. Person re-identification: past, resent and future[C]∥arXiv: 1610.02984, 2016.

[3] Zhao Rui, Ouyang Wanli, Wang Xiaogang. Learning mid-level filters for person re-identification[C]∥IEEE Computer Society Conference on Computer Vision and Pattern Recognition, Columbus, OH, USA, 2014: 144-151.

[4] Lee H, Jung M, Tani J. Recognition of visually perceived compositional human actions by multiple spatio-temporal scales recurrent neural networks[J]. IEEE Transactions on Cognitive and Developmental Systems, 2017, PP(99): 1-1.

[5] Zhang Liyan, Kalashnikov D V, Mehrotra S, et al. Context-based person identification framework for smart video surveillance[J]. Machine Vision &Applications, 2014, 25(7): 1711-1725.

[6] Truongcong N, Achard C, Khoudour L, et al. Video sequences association for people re-identification across multiple non-overlapping cameras[C]∥International Conference on Image Analysis and Processing, Vietri sul Mare, Italy, 2009: 179-189.

[7] Wang Taiqing, Gong Shaogang, Zhu Xiatian, et al. Person re-identification by video ranking[C]∥European Conference on Computer Vision, Zurich, Switzerland, 2014: 688-703.

[8] Klaser A, Marszalek M, Schmid C. A spatio-temporal descriptor based on 3d-gradients[J]. BMVC 2008-19th British Machine Vision Conference, British Machine Vision Association, 2008, 275: 1-10.

[9] Zeng Zhiqiang, Li Zhihui, Cheng De, et al. Two-stream multi-rate recurrent neural network for video-based pedestrian re-identification[J]. IEEE Transactions on Industrial Informatics, 2017: 1-1.

[10] 胡正平, 陈俊岭, 王蒙, 等. 深层融合度量子空间学习稀疏特征提取算法[J]. 信号处理, 2017, 33(6): 845- 854.

Hu Zhengping, Chen Junling, Wang Meng, et al. Sparse Feature Extraction Model Based on Multi-layered Deep Metric Subspace Learning[J]. Journal of Signal Processing, 2017, 33(6): 845- 854.(in Chinese)

[11] Liao Shengcai, Hu Yang, Zhu Xiangyu, et al. Person re-identification by local maximal occurrence representation and metric learning[C]∥IEEE Conference on Computer Vision and Pattern Recognition, Boston, United Station, 2015: 2197-2206.

[12] Martinel Niki, Das Abir, Micheloni Christina, et al. Re-identification in the function space of feature warps[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(8): 1629-1642.

[13] Prosser B, Zheng Weishi, Gong Shaogang, et al. Person re-identification by support vector ranking[C]∥21st British Machine Vision Conference, Aberystwyth, United Kingdom, 2010: 21.1-21.11.

[14] Sun Lingchuan, Jiang Zhuqing, Song Hongchao, et al. Semi-coupled dictionary learning with relaxation label space transformation for video-based person re-identification[J]. Institute of Electrical and Electronics Engineers Inc, 2018, 6: 12587-12597.

[15] Yan Shuicheng, Xu Dong, Zhang Benyu, et al. Graph embedding and extensions: a general framework for dimensionality reduction[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2007, 29(1): 40-51.

[16] Chen Yingcong, Zhu Xiatian, Zheng Weishi, et al. Person re-Identification by camera correlation aware feature augmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(2): 392- 408.

[17] Saghafi M A, Hussain A, Saad Mohammad H M, et al. Appearance-based methods in re-identification: a brief review[C]∥IEEE International Colloquium on Signal Processing and ITS Applications, Melaka Malaysia, 2012: 404- 408.

[18] An L, Kafai M, Yang Songfan, et al. Person re-identification with reference descriptor[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2016, 26(4): 776-787.

[19] Chen Yingcong, Zheng Weishi, Yuen Pong C, et al. An asymmetric distance model for cross-view feature mapping in person re-identification[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2017, 27(8): 1661-1675.