1 引言

图像融合是信息融合的一个重要分支,它将来自不同传感器关于某个场景的多源多幅图像,或单一传感器多次获取的图像,按照某种规则,融合成一幅新的图像,以便对该场景进行更为准确和全面的描述[1]。

红外与可见光图像融合是图像融合的一个研究热点。可见光图像根据物体的反射特性成像,分辨率高,图像质量好,包含丰富的场景细节信息,但是在低光照、夜晚或者是目标物体被遮挡的情况下,可见光图像捕捉不到目标信息。而红外图像是根据物体的红外辐射特性成像,能够捕获到低光照条件下或者隐藏的目标,但它对场景的亮度信息变化不敏感,导致图像成像质量较差,并且缺少场景的细节信息。将红外与可见光图像进行融合,能有效综合红外图像的目标识别能力和可见光图像丰富的场景细节信息,增强成像质量,减少冗余信息,从而提高在复杂环境下正确进行目标检测和识别的能力。红外与可见光融合图像对场景精确、可靠和互补的描述,使其被广泛地应用于军事侦察[2]、工业应用[3]、医学成像[4]等领域。

最近几十年来,针对红外与可见光图像融合提出了大量算法,通常可以分为两类:基于多尺度分解的融合方法和基于区域的融合方法。基于多尺度分解的融合方法实质是:首先利用多尺度分解方法将空间上重叠的特征分解到不同的尺度空间上,然后不同尺度上的分离特征即使占有相同的空间范围,也可以有效地进行融合。融合结果更加符合人类视觉感知效果。目前,大量的多尺度分解方法被应用于图像融合领域,诸如金字塔、小波变换、曲波变换、轮廓波变换等。除此之外,还有一些新的多尺度分解方法如非下采样轮廓波变换、非下采样剪切波变换和其他一些分解方法。基于多尺度分解的融合方法的巨大成功已经证实了尺度分离在图像融合过程中的重要性。尽管如此,基于多尺度分解的图像融合方法,融合结果容易出现模糊,丢失大量图像视觉信息,会影响融合图像的视觉质量。另外,基于多尺度分解方法选择分解层数困难。一方面,为保证从源图像中提取足够的空间细节信息,分解层数不能太小。另一方面,当分解层数较大时,低通子带的一个系数对融合图像的大量像素都有影响,因此,低通子带的一个小的错误将引起严重的人工效应。此外,当分解层数变大时,高通子带的融合结果对噪声和误配准更加敏感,当源图像没有准确配准时,分解层数不能太大。因此,分解层数的选择要在能够提取足够多的空间细节信息和算法能克服误配准两个方面折中[5]。

红外图像对具有明显红外辐射信息的目标敏感,这些目标具有显著的特征,因此,基于区域的红外与可见光图像融合方法通过分割或图像显著性技术获得显著区域或显著图,红外图像中的显著性信息可以直接融合到最终图像中,以保证尽可能多地保留红外信息。基于区域的融合方法最关键的步骤是如何准确地提取红外图像中的显著性区域。基于区域的融合方法将红外图像的目标区域和可见光图像的细节信息融合到最终结果中,是一种有效的方法[6]。但是这类算法很难获得精准的分割结果,导致融合效果不理想。

不管是哪一类方法,都应该考虑以下两个问题[7]:(1)如何有效地从输入源图像中提取图像信息,这是影响图像融合质量的关键因素;(2)如何合理地将来自不同信息源的信息融合到最终的融合图像中。为解决上述两个问题,融合方法应该具备以下能力:(1)能够提取不同图像的互补信息,如红外图像的热辐射信息和可见光图像的细节信息,这主要依赖于图像表示算法表示图像结构信息的分辨率;(2)能够将来自不同源图像的互补信息准确地融合到融合图像中,这主要依赖于融合规则;(3)融合过程不应引入任何可能分散或误导人类观察者或任何后续图像处理任务的人工效应或不一致之处。

为此,根据上述思想,本文提出了一种新的红外与可见光图像融合方法。首先,为有效提取图像特征,提出一种基于高斯滤波器的图像分解方法,将源图像分解为粗略尺度信息和边缘纹理细节信息;为有效地提取红外目标特征,对红外图像的边缘纹理细节信息利用OTSU多阈值分割算法进行进一步分解,分解为目标区域、过渡区域和背景区域。根据上述分解结果确定各分解子信息的融合权重,以有效地将红外目标特征注入到可见光图像中。实验结果表明,本文方法能有效地提取红外目标特征,实现在融合图像中凸显红外目标的同时尽可能多地保留可见光图像的纹理细节信息。

2 红外目标特征提取

2.1 基于高斯滤波的图像分解方法

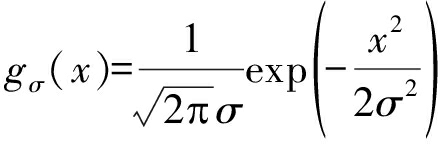

高斯滤波器是一种线性平滑滤波,能够有效地抑制噪声、平滑图像,被广泛地应用于图像处理领域。以gσ表示标准偏差为σ的高斯函数,可写为:

(1)

则原始图像I在某点p处的高斯滤波定义如下:

(2)

式中,Ip,Iq为图像I中坐标分别为p和q的像素点灰度值;σs为对应高斯函数的标准差;Ω为滤波子窗口;![]() 为滤波器归一化系数。高斯滤波器在滤波过程中并没有考虑邻近像素灰度值的影响,因此,会将部分边缘信息也一齐滤除掉。显然,被高斯滤波器滤除的图像边缘纹理细节信息可通过如下公式计算得到:

为滤波器归一化系数。高斯滤波器在滤波过程中并没有考虑邻近像素灰度值的影响,因此,会将部分边缘信息也一齐滤除掉。显然,被高斯滤波器滤除的图像边缘纹理细节信息可通过如下公式计算得到:

D(I)=I-G(I)

(3)

图1给出了红外图像的分解效果图。图1(a)为“Camp”红外图像,图1(b)为高斯滤波后图像,我们将其称为图像的粗略尺度信息。图1(c)为图像的边缘纹理细节信息。其中边缘纹理细节信息表示为其绝对值形式|D(IR)|。从图中可以看出红外图像中的人物、房屋和树木等目标信息主要反映在边缘纹理细节信息中,从图1(c)中仔细观察可以发现,在目标人物周边有很明显的“光晕”现象,这是由于在运算过程中目标周边有大量的负值像素点造成的,这一部信息相当于噪声,会严重影响融合图像质量,所以必须要对D(IR)进行去“光晕”分解:

D(IR)positive=(abs(D(IR))+D(IR))/2

(4)

D(IR)negative=D(IR)-D(IR)positive

(5)

式中,D(IR)positive表示去“光晕”分解之后的正值图像,如图1(d)所示,D(IR)negative表示目标周边的“光晕”图像,如图1(e)所示,这里表示为其绝对值形式|D(IR)negative|,图1( f )给出了D(IR)positive的二值化图像。

2.2 红外目标特征提取

利用OTSU多阈值分割算法对正值图像进行分割,为了进一步缩短计算时间,提高算法效率对D(IR)positive进行二值化处理:

(6)

BW(IR)=BW.*IR

(7)

可以得到其二值化图像如图1( f )所示。

以BW(IR)作为多阈值分割算法的输入,对其进行分割。由于BW(IR)仍含有噪声,引入高斯滤波器,对BW(IR)进行区域平滑,降噪,以提高OTSU多阈值分割算法的精度。高斯滤波另外一个重要的作用是如果σs取值较小,核宽ω适当,高斯滤波器可等效为均值滤波器。那么对BW(IR)进行高斯滤波后,图像中的灰度值将发生改变。参数σs越大,BW(IR)整体灰度均值分布比较均匀。参数σs越小,BW(IR)图像整体灰度均值分布基本不会发生剧烈变化。本文算法σs取值范围为[0.1,4],高斯核宽ω=5。

图1 “UN Camp”红外图像分解效果图

Fig.1 The decomposition results of the “UN Camp” infrared image

为了充分发挥OTSU多阈值分割算法的优势,以及高斯滤波器的两大作用。在这二者的基础上提出精准的红外图像区域分割算法,具体步骤如下:

(1)以BW(IR)图像作为算法的输入。

(2)引入高斯滤波器对BW(IR)图像进行图像滤波,其中σs取值范围为[0.1,4],高斯核宽ω=5。σs以0.1为间隔从0.1一直取样到4,这样可以得到一组高斯滤波后的图像。

(3)对高斯滤波后的图像Gσs(BW(IR))利用OTSU多阈值分割算法进行分割,分割出四类图像区域即:目标区域![]() 目标边缘区域

目标边缘区域![]() 过渡区域

过渡区域![]() 和背景区域

和背景区域![]()

(4)对每一幅图像的分割阈值用不同的颜色进行标记,目标区域用红色标记,目标边缘区域用绿色标记,过渡区域用黄色标记,背景区域用蓝色标记。颜色标记后可以生成伪彩色图像。

(5)按颜色提取图像中的不同区域,提取每一幅伪彩色图像的红色目标区域![]() 计算每一个σs所对应的伪色彩图像中红色区域的面积S。σs=0.1时,伪色彩图像中红色区域即为目标区域

计算每一个σs所对应的伪色彩图像中红色区域的面积S。σs=0.1时,伪色彩图像中红色区域即为目标区域![]() 当红色区域的面积取得最大值时,对应目标区域

当红色区域的面积取得最大值时,对应目标区域![]() 和过渡区域

和过渡区域![]() 的叠加,于是有以下关系:

的叠加,于是有以下关系:

(8)

(9)

式中,![]()

(6)为了尽可能保留目标区域的边缘,利用Canny边缘检测算子对![]() 的二值图像进行边缘提取得到

的二值图像进行边缘提取得到![]() 的边缘

的边缘![]() 两个区域相加并对其进行图像形态学处理,将其中的空洞进行填充可以得到最终的目标区域

两个区域相加并对其进行图像形态学处理,将其中的空洞进行填充可以得到最终的目标区域![]()

(7)利用以下公式可以得到图像的过渡区域和背景区域:

(10)

(11)

如图2所示,图2(a)~(c)分别为目标区域![]() 过渡区域

过渡区域![]() 背景区域

背景区域![]() 的二值化图像;图2(d)~( f )为伪彩色图像以及分割后的伪彩色图像,其中图2(d)、(e)为颜色聚类标记的伪色彩图像。图2( f )为从图2(e)中提取红色目标区域后的图像。

的二值化图像;图2(d)~( f )为伪彩色图像以及分割后的伪彩色图像,其中图2(d)、(e)为颜色聚类标记的伪色彩图像。图2( f )为从图2(e)中提取红色目标区域后的图像。

图2 红外图像分割结果

Fig.2 The segmented results of the infrared image

3 分解子信息融合

由精确的红外目标分割算法得到![]() 和

和![]() 为了最大程度地保留红外图像中的目标完整性,我们分别利用

为了最大程度地保留红外图像中的目标完整性,我们分别利用![]() 和

和![]() 对IR和|D(IR)|进行图像分割,分别得到分割后的图像区域

对IR和|D(IR)|进行图像分割,分别得到分割后的图像区域![]() 和

和![]()

(12)

(13)

为了将重要的红外信息注入到可见光图像,利用改进的巴特沃斯高通滤波器对图像分割区域进行灰度值调整。

3.1 巴特沃斯高通滤波器

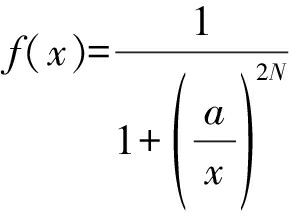

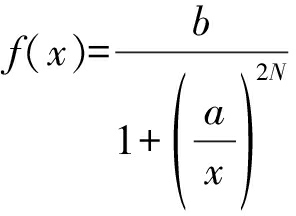

巴特沃斯高通滤波器表达式为:

(14)

式中,a为通带截止频率,N为滤波器的阶数,x为信号的频率(频率采用归一化的频率,即x∈[0,1])。对巴特沃斯高通滤波曲线进行改进,引入一个新的曲线参数b,对曲线的参数从图像区域调整的角度进行重新定义:定义曲线参数a为图像区域灰度截止系数,参数b为图像区域灰度放大系数,N为放大曲线的陡增系数。

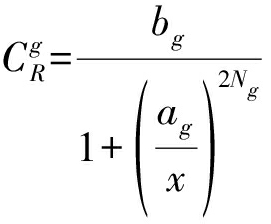

改进后的巴特沃斯高通滤波曲线表达式为:

(15)

其中,a∈(0,1],b∈(0,2],N∈(0,+ )。

)。

图像区域灰度截止系数a越大,注入可见光图像中的红外信息就越少;a越小,注入可见光图像中的红外信息就越多。图像区域灰度放大系数b越大,注入可见光图像中的红外目标区域越亮;b越小,注入可见光图像中的红外目标区域越暗;为了符合人类视觉感知,一般b取1。N为放大曲线的陡增系数,N一般取4。

3.2 红外目标区域灰度调整

分割后的图像区域![]() 和

和![]() 图像灰度值已调整到[0,1]之间)。以图像区域灰度值作为x,利用改进后的巴特沃斯高通滤波曲线对图像区域进行灰度调整,得到调整后的目标区域

图像灰度值已调整到[0,1]之间)。以图像区域灰度值作为x,利用改进后的巴特沃斯高通滤波曲线对图像区域进行灰度调整,得到调整后的目标区域![]() 调整后的过渡区域

调整后的过渡区域![]()

(16)

(17)

其中参数设置如下,一般取![]()

通过改进的巴特沃斯高通滤波曲线,对区域的灰度值进行区域滤波,分别得到调整后的目标区域![]() 调整后的过渡区域

调整后的过渡区域![]() 区域滤波后的图像,去除了对应的红外图像区域的图像细节模糊性质,继承了对应的区域高灰度强度的特性。

区域滤波后的图像,去除了对应的红外图像区域的图像细节模糊性质,继承了对应的区域高灰度强度的特性。

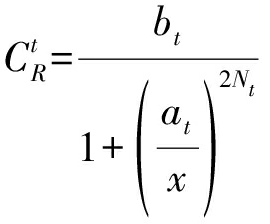

3.3 融合权重构建

利用![]() 和

和![]() 构造图像融合权重。

构造图像融合权重。

(18)

W1=gσ1*W0

(19)

W2=gσ2*W0

(20)

式中,W1和W2分别表示红外图像的边缘纹理细节信息和粗略尺度信息的融合权重。高斯函数gσ1、gσ2用来对权重系数进行平滑处理,使其适应不同子信息的融合,其中σ1=1,σ2=2。

3.4 图像融合

令DF和GF分别表示红外和可见光图像中各子信息的加权融合结果,其计算公式分别为:

GF=W2×G(IR)+(1-W2)×G(IV)

(21)

DF=W1×D(IR)+(1-W1)×D(IV)

(22)

最终的融合图像IF为:

IF=DF+GF

(23)

4 实验结果与分析

4.1 实验设置

为了验证本文方法的有效性,针对常用图像集从主观评价和客观评价两个方面对本文方法进行验证。同时,将本文方法与一些有代表性的图像融合方法进行对比分析。如图3所示,本文选取12组常用的红外与可见光图像作为测试图像集。同时,将本文方法与4个具有代表性的图像融合方法作比较,包括基于DTCWT的图像融合方法,基于NSCT的图像融合方法,文献[7]提出的基于双边和高斯滤波混合多尺度分解的图像融合方法(本文将该方法简记为Hybrid-MSD),以及文献[9]提出的基于红外特征提取和视觉信息保留的图像融合方法(本文将该方法简记为Zhang’s method)。

图3 实验用测试图像集

Fig.3 The testing image set

此外,在文献[8]中,作者通过调整正则化参数提供了他们融合方法的两个版本:λ=30,λ=3000(近似λ→ )。在本文实验中,两种版本的实验方法都被用来进行对比分析,为了表述方便,两个版本的实验方法分别简记为Hybrid-MSD-v1和Hybrid-MSD-v2。

)。在本文实验中,两种版本的实验方法都被用来进行对比分析,为了表述方便,两个版本的实验方法分别简记为Hybrid-MSD-v1和Hybrid-MSD-v2。

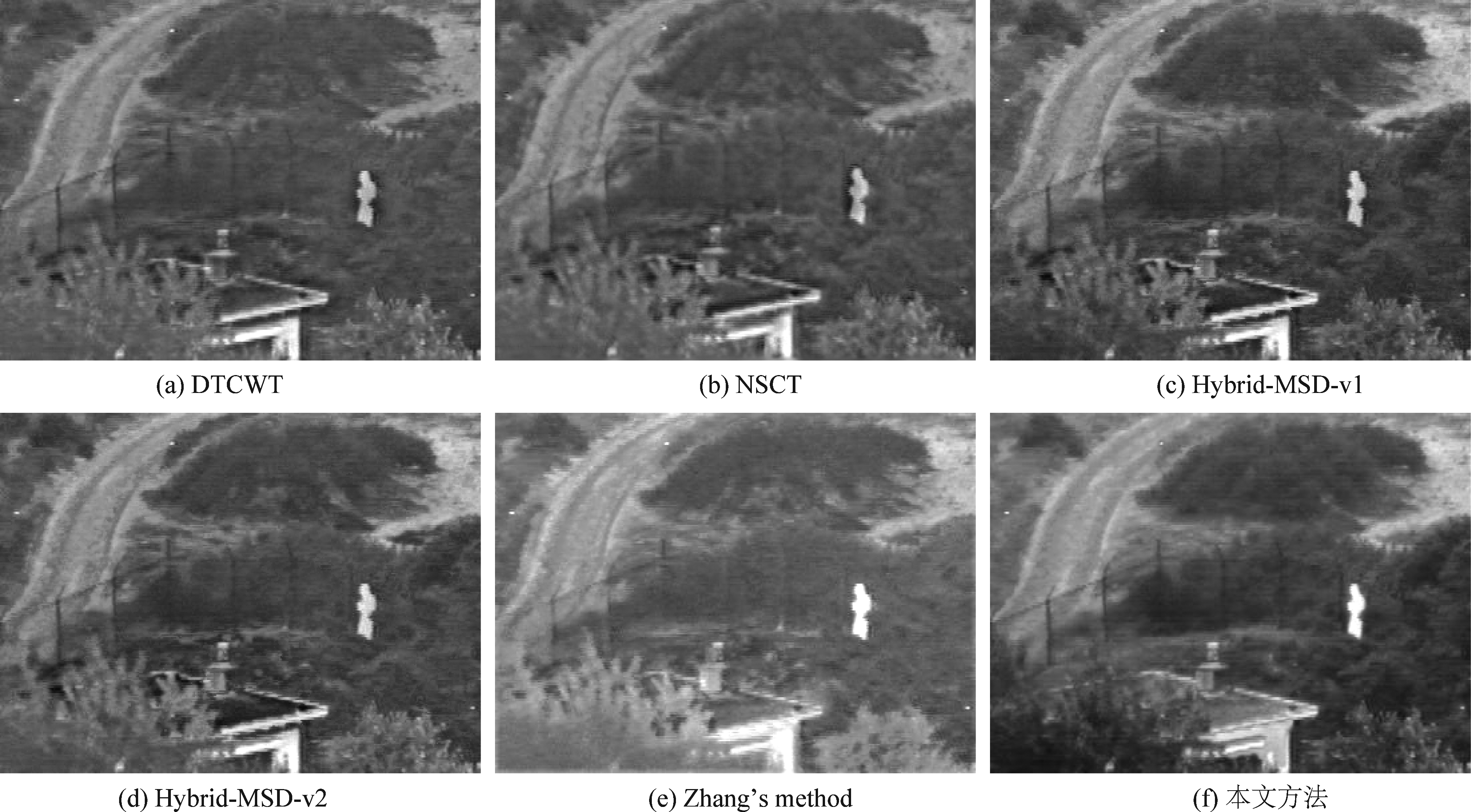

图4~6给出了试验中三组有代表性的融合图像。图4给出了不同融合方法关于“Camp”源图像的融合结果。从图4可以看出,以上方法都成功地将红外与可见光图像融合,融合图像包含目标和场景信息。仔细观察可以发现,基于DTCWT和NSCT的图像融合方法,红外目标不突出,同时融合图像丢失了大量的光谱信息,例如左侧底部的树木部分。Hybrid-MSD-v1和Hybrid-MSD-v2能较好地提取红外目标,其融合效果要明显优于前两种方法,Hybrid-MSD-v1相较于Hybrid-MSD-v2更好地保留了场景信息,更加符合人类视觉感知效果。Zhang’s method更好地突出了目标信息,对于场景细节信息保留不充分,看上去“过度曝光”。从图4( f )中,可以看出本文方法视觉效果更好,源图像中几乎所有的有用信息都被注入到融合图像中,同时有效地去除了融合过程中产生的虚影效应。比较发现本文方法不仅对比度高,目标更突出,同时包含丰富的光谱信息,更好地保留了边缘等细节信息。

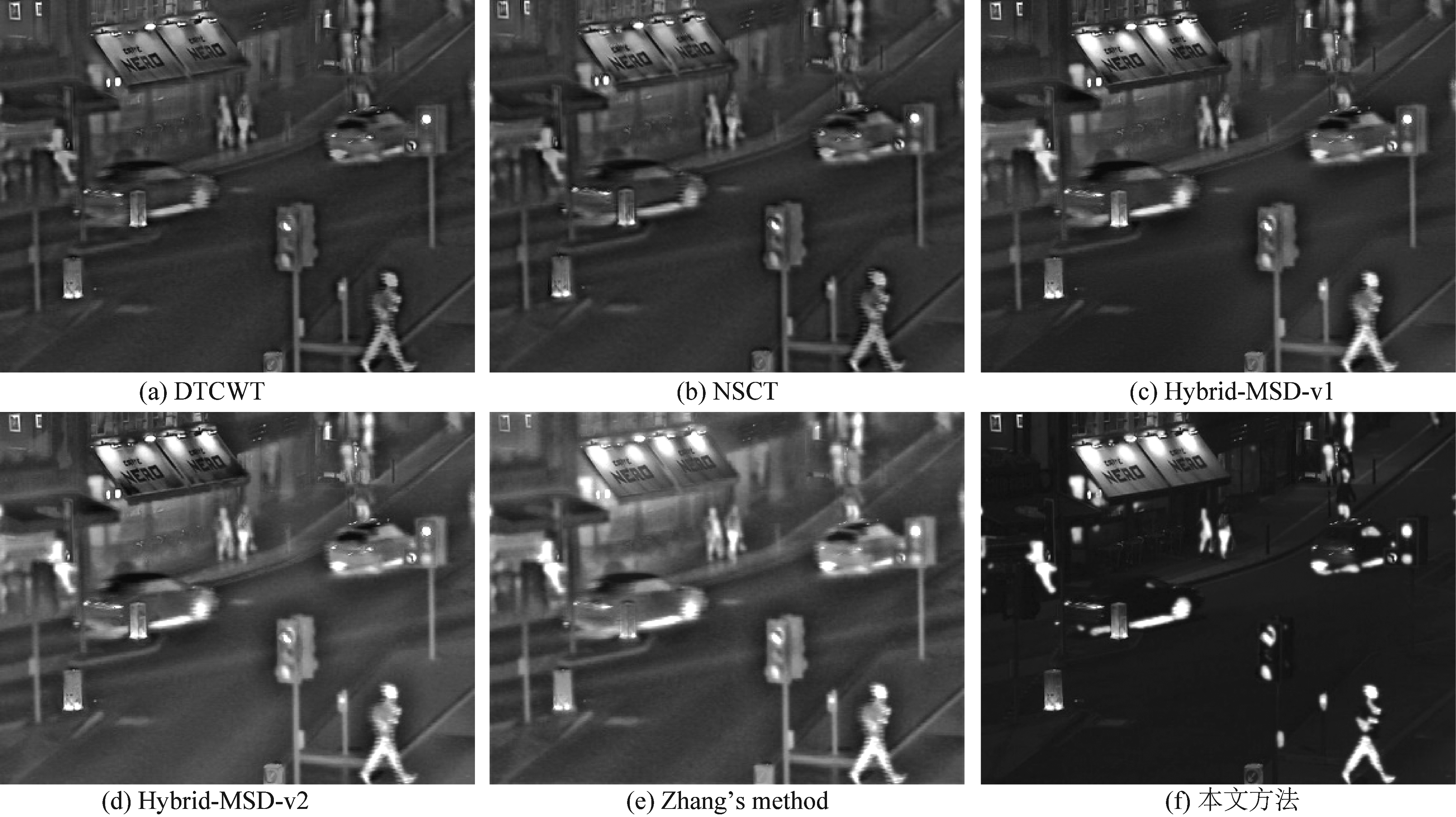

图5给出了源图像“Road”的融合结果,从图6(a)和(b)可以看出DTCWT和NSCT两种方法成功地将红外与可见光图像进行融合,但融合图像对比度低,视觉效果差。Hybrid-MSD和Zhang’s method的方法表现要优于以上两种方法,Hybrid-MSD-v2和Zhang’s method相较于Hybrid-MSD-v1将更多的红外光谱信息注入到融合图像中,导致融合图像中一些区域过亮,以至于图像细节信息丢失。从图5( f )可以看出,本文方法有效地将红外信息注入到可见光图像中,在突出红外目标特征的同时有效地保留了可见光图像丰富的场景细节信息,获得了较好的视觉效果。

图6给出了不同方法关于“Trees4917”源图像的融合结果。从图6(a)和(b)可以看出, DTCWT和NSCT两种融合方法融合图像背景区域受到红外光谱信息的严重破坏,源图像中的树木、道路等背景信息在融合图像中难以辨认。Hybrid-MSD、Zhang’s method和本文方法要明显优于以上两种方法,Hybrid-MSD-v1、Zhang’s method和本文方法相较于Hybrid-MSD-v2保留了更多的场景细节信息,Zhang’s method在有效保留场景细节信息的同时,更好地突出了红外目标信息,如融合图像中的行人目标,获得了更好地视觉效果。为作进一步的对比分析,图7给出了本文方法在其余9组源图像上的融合结果。

图4 “Camp”源图像融合结果

Fig.4 The fusion results of “Camp” source images

图5 “Road”源图像融合结果

Fig.5 The fusion results of “Road” source images

图6 “Trees4917”源图像融合结果

Fig.6 The fusion results of “Trees4917” source images

图7 本文方法在其他9组源图像上的融合结果

Fig.7 The fusion results of the proposed method on the other 9 groups of images

通过实验可以发现,本文方法利用高斯滤波器将源图像分解为粗略尺度信息和边缘纹理细节信息,同时对红外图像的边缘纹理细节信息进行去“光晕”分解,在此基础上进一步利用OTSU多阈值分割算法对红外图像进行分割,可以有效地将红外信息注入到可见光图像中,使得最终的融合图像既能突出红外目标信息,同时保留尽可能多的纹理细节信息,更符合人类视觉感知效果。

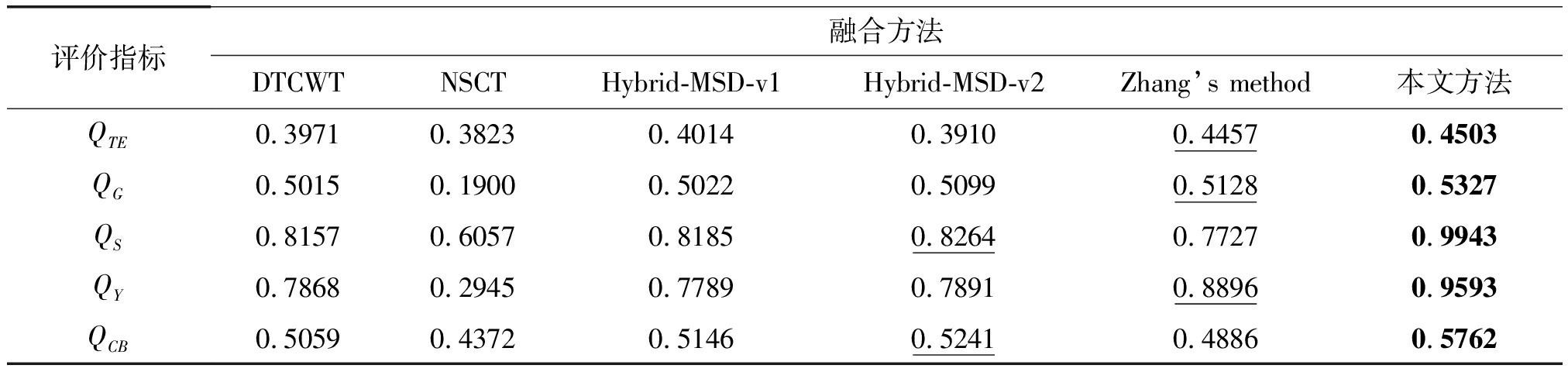

4.2 客观评价

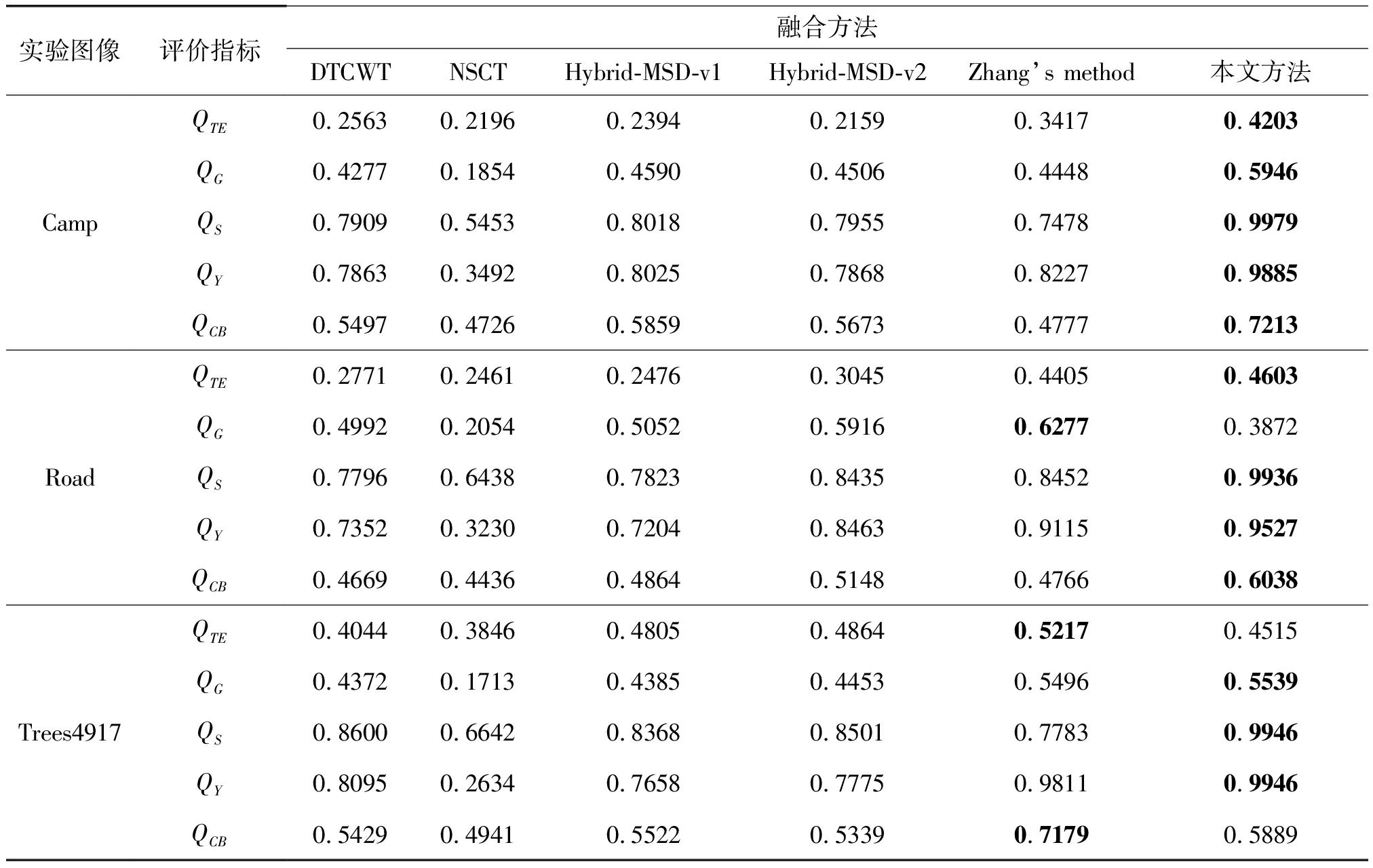

在图像融合任务中,由于没有参考图像,图像融合的客观评价不是一件容易的工作。应用多种评价指标进行整体评价被普遍认为是一种合理的方法。在试验中,采用了五种常用的红外与可见光图像融合评价指标进行定量评价。它们是基于Tsallis熵的评价指标QTE[10]、基于梯度的评价指标QG[11]、基于图像结构相似度的评价指标QS[12]和QY[13]、以及基于人类视觉感知启发的评价指标QCB[14]。

QTE衡量的是源图像中的原始信息在融合图像中的保留效果,其值越大表示融合图像保留源图像的信息越多,融合图像质量越好;QG计算的是源图像的边缘信息成功地注入到融合图像中的效果,其值越大说明源图像中的边缘信息注入到融合图像中的越多,图像融合质量越好;QS和QY测量的是融合图像保留源图像结构信息的效果,其值越大表明图像融合质量越好;QCB展示了人类视觉感知的良好预测性能,其值越大表示融合图像越符合人类的视觉感知,融合图像质量越好。

表1给出了以上三组实验的客观评价指标,从表中可以看出,本文方法在“Camp”源图像上五个客观评价指标都获得了最好的结果;在 “Road”原图像上除指标QG,在其余四个评价指标上都获得了最大值;在“Trees4917”原图像上,本文方法在QG、QS和QY三个指标上获得最大值,在指标上QCB获得第二好的得分,说明本文方法在以上三组实验上要优于现有的图像融合方法。表2给出了12组源图像的整体客观评价指标,对于每一个评价指标计算每个方法对12组源图像的平均得分。粗体显示的值分别表示所有方法中最好的得分。从表2可以看出,本文方法在所有五个评价指标中都获得最佳性能,表明本文方法整体上要优于其他融合方法。

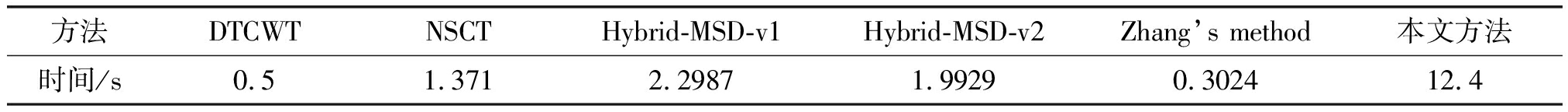

表3给出了不同方法在大小为360×270源图像上的运行时间,所有比较的方法都是在MATLAB平台上运行的,计算机配置为Intel i3- 4150处理器和4GB内存。结果表明,我们的算法运行效率还有待进一步提高,但随着计算能力的提高,算法的运行效率也会提高。

表1 不同方法在三组测试图像上的客观评价指标

Tab.1 Objective assessment of different methods for the three test images

实验图像评价指标融合方法DTCWTNSCTHybrid-MSD-v1Hybrid-MSD-v2Zhang’s method本文方法CampQTE0.25630.21960.23940.21590.34170.4203QG0.42770.18540.45900.45060.44480.5946QS0.79090.54530.80180.79550.74780.9979QY0.78630.34920.80250.78680.82270.9885QCB0.54970.47260.58590.56730.47770.7213RoadQTE0.27710.24610.24760.30450.44050.4603QG0.49920.20540.50520.59160.62770.3872QS0.77960.64380.78230.84350.84520.9936QY0.73520.32300.72040.84630.91150.9527QCB0.46690.44360.48640.51480.47660.6038Trees4917QTE0.40440.38460.48050.48640.52170.4515QG0.43720.17130.43850.44530.54960.5539QS0.86000.66420.83680.85010.77830.9946QY0.80950.26340.76580.77750.98110.9946QCB0.54290.49410.55220.53390.71790.5889

表2 不同融合方法在所有源图像上的整体客观评价指标

Tab.2 Objective assessment of different methods on the whole source images

评价指标融合方法DTCWTNSCTHybrid-MSD-v1Hybrid-MSD-v2Zhang’s method本文方法QTE0.39710.38230.40140.39100.44570.4503QG0.50150.19000.50220.50990.51280.5327QS0.81570.60570.81850.82640.77270.9943QY0.78680.29450.77890.78910.88960.9593QCB0.50590.43720.51460.52410.48860.5762

表3 不同融合方法运行时间比较

Tab.3 Running time comparison of different methods

方法DTCWTNSCTHybrid-MSD-v1Hybrid-MSD-v2Zhang’s method本文方法时间/s0.51.3712.29871.99290.302412.4

5 结论

近年来,图像融合逐渐成为一个研究热点问题,而红外与可见光图像融合是图像融合的重要组成部分。传统的图像融合方法由于不能有效地提取红外目标信息,最终的融合图像往往整体较为模糊、对比度不高、边缘细节保留不充分,为此,本文提出一种基于红外特征提取的红外与可见光图像融合方法。利用高斯滤波和OTSU将红外图像分解为目标区域、过渡区域和背景区域,并以此确定各分解子信息的融合权重,有效提取了红外图像的目标信息,同时保留了可见光图像的背景和纹理细节信息。实验结果表明,本文方法无论是在主观视觉还是客观评价指标上都要优于目前常用的有代表性的融合方法。

[1] Jin X, Jiang Q, Yao S, et al. A Survey of Infrared and Visual Image Fusion Methods[J]. Infrared Physics & Technology, 2017, 85: 478-501.

[2] Feng Z J, Zhang X L, Yuan L Y, et al. Infrared target detection and location for visual surveillance using fusion scheme of visible and infrared images[J]. Math. Problems Eng, 2013, 3: 831- 842.

[3] Eisler K, Homma C, Goldammer M, et al. Fusion of visual and infrared thermography images for advanced assessment in nondestructive testing[J]. Rev. Sci. Instrum. 2013, 84: 1-5.

[4] Hanna B V, Gorbach A M, Gage F A, et al. Intraoperative assessment of critical biliary structures with visible range/infrared image fusion[J]. J.Am.Coll.Surg., 2008, 206(3): 1227-1231.

[5] Liu Y, Liu S, Wang Z. A general framework for image fusion based on multi-scale transform and sparse representation[J]. Information Fusion, 2015, 24: 147-164.

[6] Cui G, Feng H, Xu Z, et al. Detail preserved fusion of visible and infrared images using regional saliency extraction and multi-scale image decomposition[J]. Optics Communications, 2015, 341: 199-209.

[7] Wang J, Peng J, Feng X, et al. Fusion method for infrared and visible images by using non-negative sparse representation[J]. Infrared Physics & Technology, 2014, 67: 477- 489.

[8] Zhou Z, Wang B, Li S, et al. Perceptual fusion of infrared and visible images through a hybrid multi-scale decomposition with Gaussian and bilateral filters[J]. Information Fusion, 2016, 30: 15-26.

[9] Zhang Y, Zhang L, Bai X, et al. Infrared and Visual Image Fusion through Infrared Feature Extraction and Visual Information Preservation[J]. Infrared Physics & Technology, 2017, 83: 227-237.

[10] Cvejic N, Canagarajah C N, Bull D R. Image fusion metric based on mutual information and Tsallis entropy[J]. Electronics Letters, 2006, 42(11): 626- 627.

[11] Xydeas C S, Petrovic V. Objective image fusion performance measure[J]. Military Technical Courier, 2000, 56(2): 181-193.

[12] Piella G, Heijmans H. A new quality metric for image fusion[C]∥International Conference on Image Processing, 2003.

[13] Li S, Hong R, Wu X. A novel similarity based quality metric for image fusion[C]∥International Conference on Audio, Language and Image Processing, 2008: 167-172.

[14] Liu Z, Blasch E, Xue Z, et al. Objective Assessment of Multiresolution Image Fusion Algorithms for Context Enhancement in Night Vision: A Comparative Study[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2011, 34(1): 94-109.