1 引言

语音是人与人之间最自然、最快捷、最有效的交互方式之一。在人工智能的浪潮下,实现人与机器间流畅的语音交流成为人们追求的目标,而语音识别技术则是实现该目标的关键技术之一。完善的人机交互要求计算机理解用户的情绪和意图,从而给予不同的反馈和支持[1],实现这一目的首先要求计算机能够准确的识别出说话人的情感,因此语音情感识别在人机交互中具有重要的意义。目前,语音情感识别在服务业、医疗、教育等领域已经得到广泛的应用。

最早的真正意义上的语音情感识别相关研究出现在20世纪80年代中期,开创了使用声学统计特征进行情感分类的先河[2]。早期的语音情感识别往往提取低级特征用来训练分类模型,例如支持向量机、隐马尔科夫模型等[3-4];也有一些研究者针对每一种情感训练一个高斯-隐马尔科夫混合模型,并在测试阶段将话语分类为可能性最大的情感标签[5]。近年来,随着机器学习技术的应用和发展,许多研究者开始使用基于神经网络的分类器来进行各类语音识别任务。其中深度神经网络(Deep Neural Network, DNN)、卷积神经网络(Convolutional Neural Network, CNN)、循环神经网络(Recurrent Neural Network, RNN)、生成对抗网络(Generative Adversarial Network, GAN)等网络模型在各类识别任务中得到了广泛的应用并取得了很好的效果。Burget R等[6]使用深度神经网络对柏林库中的三类情感语音进行情感分类,将语句分为20 ms的帧后,对每一帧进行上下文无关的分类,在测试集上取得了77.51%的帧准确率和96.97%的语句准确率;Huang Z等[7]通过卷积神经网络对语谱图进行特征提取,最后通过支持向量机进行分类,并在SAVEE, EMO-DB等四个数据集上进行了模型验证。然而由于训练数据有限,基于神经网络的分类器普遍存在泛化误差[8]。为了减少泛化误差,迁移学习中的多任务学习[9]被引入到神经网络的研究中。多任务学习的多个任务并行训练可以使神经网络学习到更多共享特征,从而获得更好的泛化性能。已有一些研究者将多任务学习运用到语音情感识别领域中。Xia R, Liu Y[10]基于深度置信网络(Deep Belief Network, DBN)提出了一个多任务学习框架,主任务为情感类别,辅助任务为两种情感属性activation和valence的离散分类或线性预测,最后通过支持向量机进行分类;Kim N K, Lee J等[11]使用卷积神经网络结合多任务学习对说话人情感进行分类,使用三个相关任务辅助情感识别主任务并取得了较单一任务更好的分类效果。在现有的多任务语音情感识别研究中,大多数采用DNN或CNN来提取特征和进行分类,且往往选择情感的属性作为情感识别的相关任务。

本文在前人研究的基础上提出了一种基于多任务学习和循环神经网络的语音情感识别算法,将说话人情感识别作为主任务,说话人性别识别、说话人身份识别作为辅助任务,三个任务同时在神经网络中进行训练,通过共享隐层网络参数以学习共享特征,从而达到更好的情感识别效果。算法通过共享层和属性依赖层分别提取共享特征和独有特征,以最大化模型的分类性能。

2 相关研究

2.1 循环神经网络

循环神经网络是一种隐层具有自连接关系的神经网络,网络的自连接特性使其对序列数据上下文的依赖关系具有天然的描述能力[12]。循环神经网络通过自连接来记忆之前的信息,并对后面节点的输出产生影响,因此在处理时序数据时比全连接网络和卷积神经网络有着更好的表达能力。RNN节点通过当前时刻的状态来计算该时刻的输出,而当前时刻的状态由上一时刻的状态和当前时刻的输入共同决定,从而达到记忆之前信息的效果。

在普通的RNN模型中,若时间跨度较长则会出现“长期依赖”问题,即随着时间的延长梯度将逐渐消失,造成某一时刻的输入对后续时刻的影响会越来越小直至消失。因此普通的RNN模型无法很好的表示时序数据中长距离的依赖关系[13]。为了解决此类问题,往往采用长短时记忆单元(Long-Short term memory, LSTM)或GRU(Gated Recurrent Unit)网络。

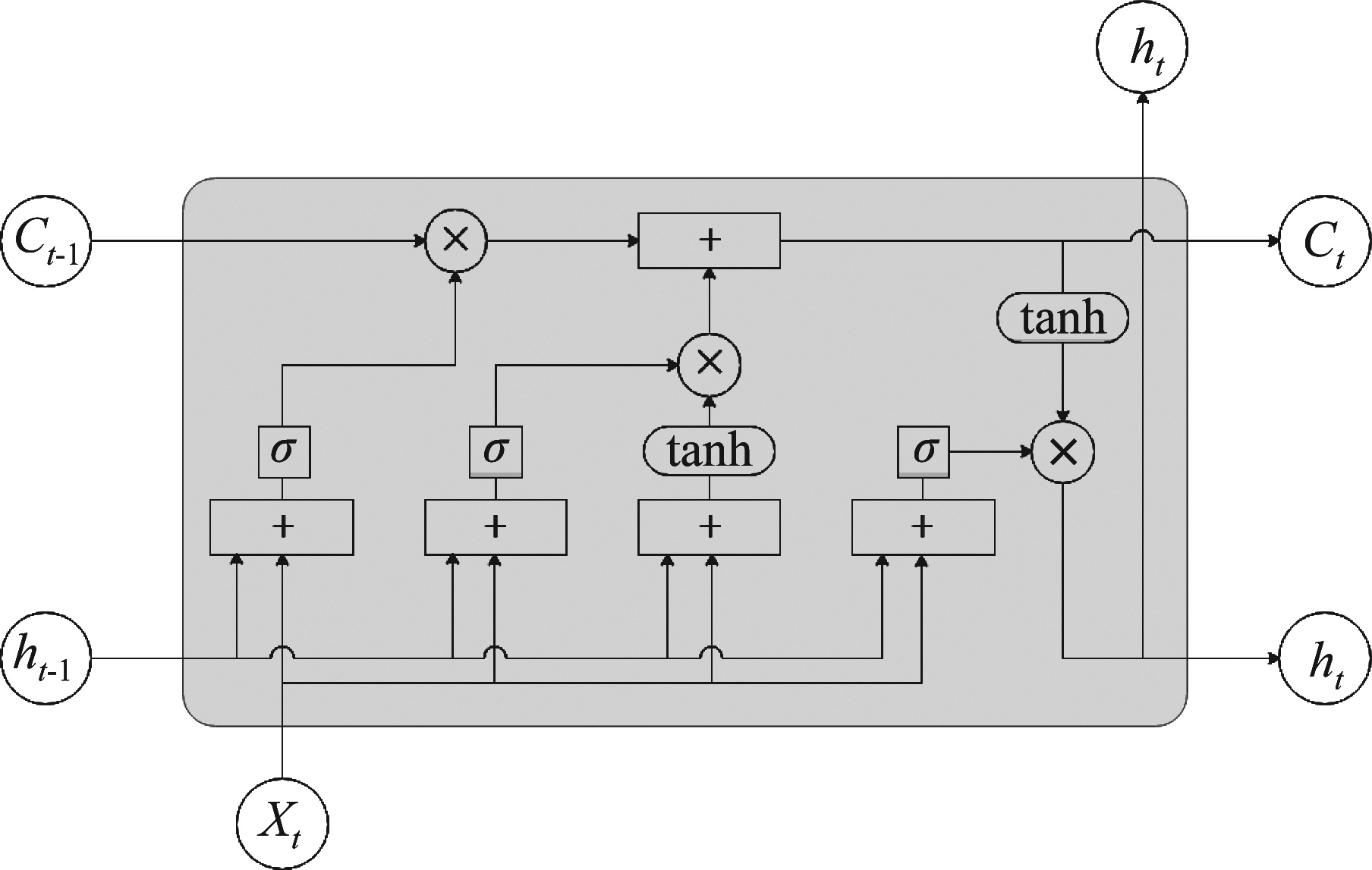

LSTM模型如图1所示。LSTM使用三个“门”计算即遗忘门、输入门和输出门来控制不同时刻的状态和输出。每个LSTM节点包含三个输入,即上一时刻的节点状态ct-1、上一时刻的节点输出ht-1和当前时刻的输入xt。其输入输出间的关系可由式(1)~(6)表示。

图1 LSTM节点模型

Fig.1 LSTM model

ft=σ(Wfxt+Ufht-1+bf)

(1)

it=σ(Wixt+Uiht-1+bi)

(2)

(3)

(4)

ot=σ(Woxt+Uoht-1+bo)

(5)

ht=ot*tanh(ct)

(6)

其中, ft为忘记门,用来计算上一时刻的节点状态ct-1中哪些信息需要舍弃;ot为输出门,用来计算当前节点状态ct要输出多少作为节点的输出ht;输入门分为两部分it和![]() 用来计算保留多少当前时刻的输入xt到当前时刻的节点状态ct;σ为激活函数,W和U为权重矩阵,b为偏置项。由于三个“门”结构的存在,LSTM在反向传播的过程中可以很好的解决梯度消失问题。

用来计算保留多少当前时刻的输入xt到当前时刻的节点状态ct;σ为激活函数,W和U为权重矩阵,b为偏置项。由于三个“门”结构的存在,LSTM在反向传播的过程中可以很好的解决梯度消失问题。

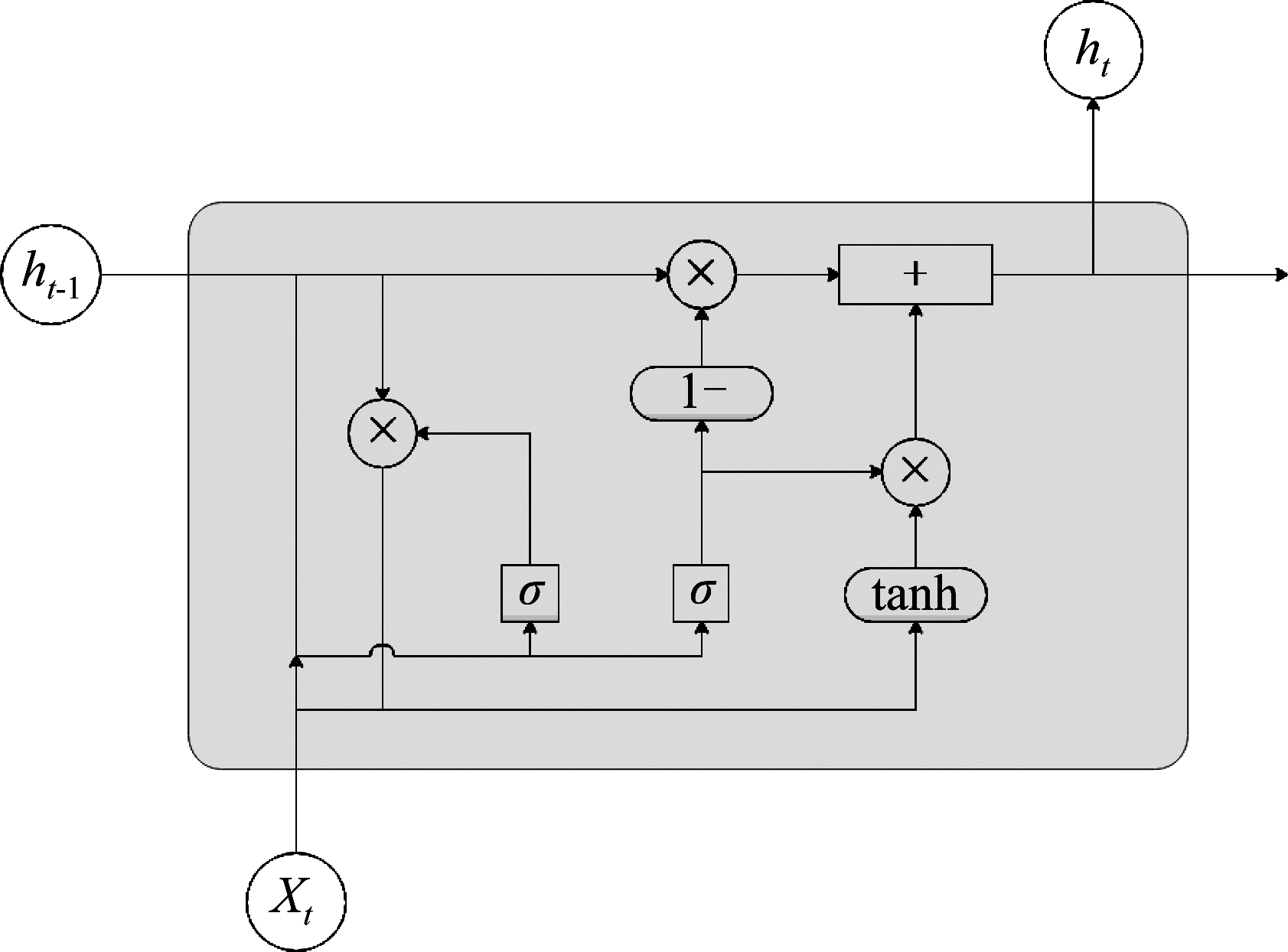

GRU是LSTM的一种变体[14],其结构和输入输出关系式如图2和式(7)~(10)所示。GRU和LSTM有类似原理,其将LSTM的三个门简化为两个门:更新门zt用来控制包含过去时刻信息的前一时刻状态信息ht-1流入到当前状态ht中的程度;重置门rt用来控制节点忽略前一时刻的状态信息ht-1的程度。重置门有利于捕捉时序数据中短期的依赖关系,更新门有利于捕捉时序数据中长期的依赖关系,因此可以应对循环神经网络中的“长期依赖”问题。GRU相对于LSTM来说结构更加简单,训练速度更快,参数更少因此更容易收敛。在很多训练任务上尤其是数据集不算特别大的情况下,GRU和LSTM的性能几乎没有差别。

zt=σ(Wzxt+Uzht-1+bz)

(7)

rt=σ(Wrxt+Urht-1+br)

(8)

(9)

(10)

图2 GRU节点模型

Fig.2 GRU model

2.2 多任务学习

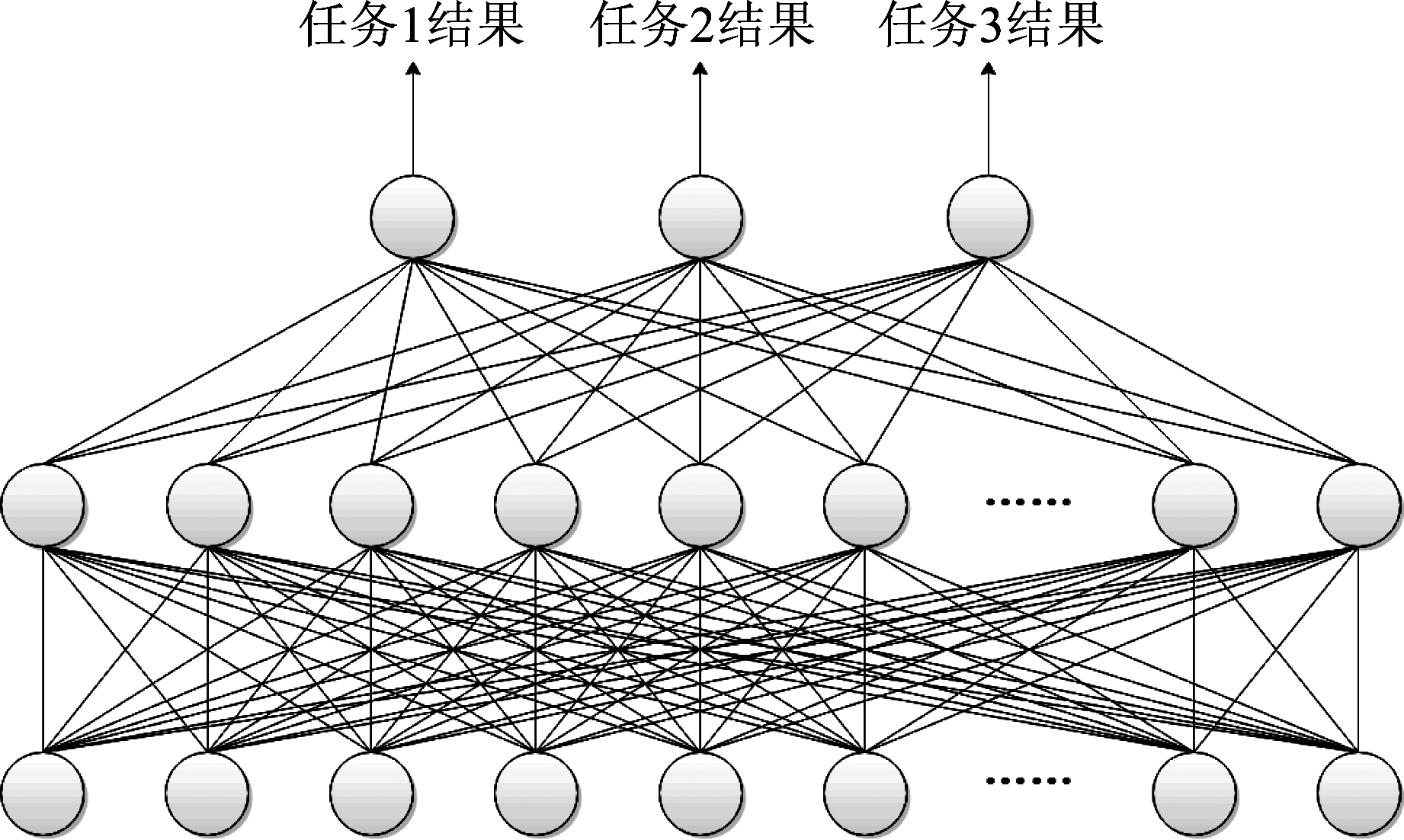

现实中很多问题之间有着或多或少的联系,如果独立的看待一个个的问题,往往会忽略问题之间所存在的关联信息,为了解决这个问题,研究者们提出了多任务学习(Multi-task learning, MTL)。多任务学习是迁移学习算法的一种,本质上是一种归纳迁移机制,利用隐含在多个相关任务中的特定信息来提高泛化能力[15]。在神经网络中,往往通过使用共享表示并行训练多个相关任务来实现多任务学习。额外任务的信息有助于网络学到更好的内部表示,使得神经网络能够通过共享隐层学习到更多共享特征,来提升各个任务的性能,提高泛化能力。同时,由于多任务学习在相关任务间共享网络参数,在对多个任务进行预测或分类时,训练所需的数据量和模型参数的数量都将明显减少,使模型更加高效。常规的多任务学习结构如图3所示,共享隐层中所有任务共享网络参数,随后在输出层中各任务的分类结果分别被输出。

图3 常规多任务学习结构

Fig.3 Multi-task learning structure

多任务学习有多种形式,例如联合学习(joint learning)、自主学习(learning to learn)和带有辅助任务的学习(learning with auxiliary task),其本质都为同时优化多个损失函数。其中带有辅助任务的学习往往设立一个主任务,将其余任务设置为辅助任务,并行训练所有任务使主任务达到更好的性能。主任务和辅助任务的主要区别为任务自身的损失函数占模型总的损失函数的比重的大小。

3 采用MTL-RNN的语音情感识别算法

对于语音情感识别,首先要考虑的是情感的描述模型。以往的研究中主要有两种分类方式,分别是离散情感模型和维度情感模型[16]。离散情感模型把情感分为特定的几类情感,如happy, sad, anger, surprise, neutral等;维度情感模型认为情感没有严格的界限,应该用连续的空间维度来表示,每一个空间维度都代表着情感的一个心理学属性,维度的数值大小反映了情感在相应维度上表现出的强度[2]。两种情感模型各有优劣,前者有较大局限性,但结果较为简单明确;后者描述能力更强,但模型复杂度较高,且没有统一的定义方式。本文采用离散情感模型作为情感描述模型。

随后是特征的选择和提取。语音情感识别与其他语音识别项目类似,主要有以基频、能量为主的韵律学特征;以梅尔频率倒谱系数(MFCC)、线性预测倒谱系数(LPCC)为主的谱特征以及其他特征如i-vector等。本文采用应用较为普遍的MFCC特征。

在MTL模型的构建上,本文采用了文献[16]中所提出的带有属性依赖层的MTL算法思想,在互相连接、共享权值的共享隐层后额外添加了任务间相互独立的属性依赖层,使得网络在学习多个任务共享特征的同时允许每个子任务在属性依赖层独自优化以提升性能。与文献[16]中的简单二层全连接网络不同,本文采用RNN作为共享层,全连接网络作为属性依赖层。

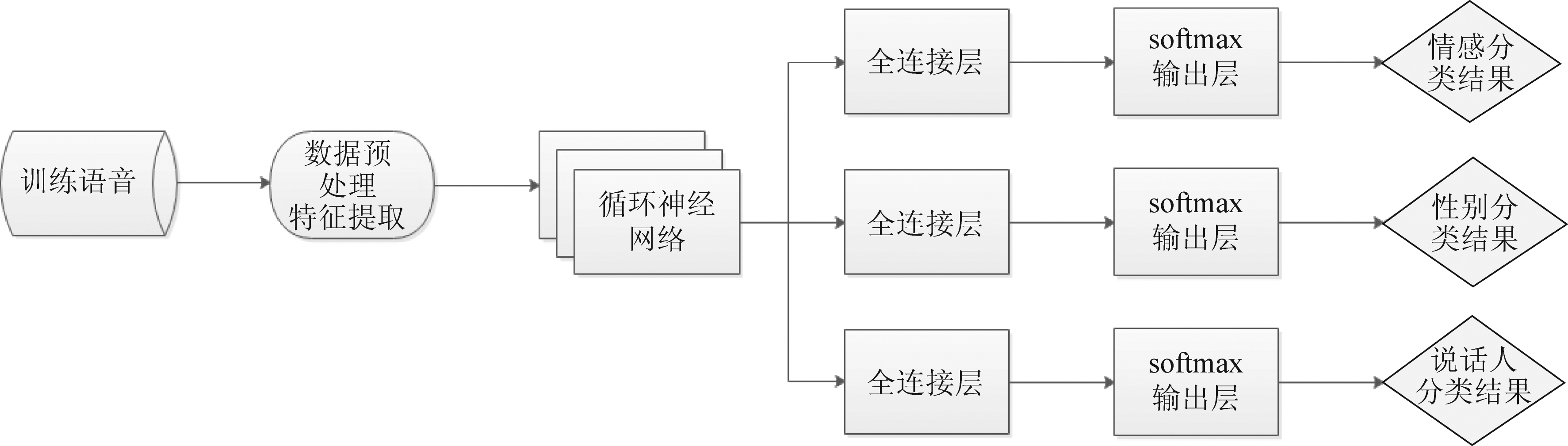

如前文所述,现有的研究中大多采用 DNN或CNN网络以及选择情感的属性作为辅助任务。在前人研究的基础上,本文提出了一种基于MTL-RNN的语音情感识别算法,采用了适合处理连续语音数据的循环神经网络,结合具有属性依赖层的多任务学习结构,通过性别识别、身份识别两个辅助任务,对语音进行离散情绪的分类。关于辅助任务的选取,首先,情绪状态被认为是性别依赖的,已有研究表明特定于某种性别的情感分类器的性能优于不分性别的情感分类器[17];其次,不同说话人对相同情感的表达必然存在着共同和不同的部分,对说话人身份的确定可以帮助理解其中不同的部分,有助于说话人情感的确定。因此性别识别和身份识别这两项任务为情感识别的相关任务,本文选取这两项任务作为辅助任务。

算法流程如图4所示。首先,将输入语音进行预处理以及提取特征。先使用语音活动检测器(VAD)消除实验语音中多余的静音部分;随后对语音信号以16 kHz重采样后再进行分帧,帧长为512个采样点,帧叠为256点;接着将每一帧乘以汉明窗,并进行快速傅里叶变换;接下来通过mel滤波器组、计算对数能量、经过离散余弦变换(DCT)后得到13阶的梅尔倒谱系数;最后将13维的MFCC、13维的一阶差分、13维的二阶差分以及帧能量作为一帧的40维MFCC特征。随后将得到的MFCC特征向量,按时间顺序,每帧为一个时间步,输入到共享层中,这里使用三层循环神经网络作为共享层,使用GRU作为基本单元,每层512个节点。第一层和第二层输出全部时间上的序列到下一层,第三层输出最后一个时间步的结果并将其输入到属性依赖层中。属性依赖层由三个单独的全连接层组成,各有512个节点,分别将结果输出到三个单独的softmax输出层中,最后输出三个任务的分类结果。在训练阶段,将训练集以批次为单位送入神经网络中训练,将输出层输出的分类结果与训练语句的分类标签做比较并计算损失,随后使用优化器对损失函数进行优化,更新网络权重,更新完毕后进行下一批次的训练。

图4 MTL-RNN算法流程图

Fig.4 MTL-RNN algorithm diagram

本文采用交叉熵函数作为损失函数,总的损失函数可以表示为。

losstotal=αlossemo+βlossgen+γlossspe

(11)

其中lossemo、lossgen、lossspe分别为语音情感识别、性别识别、说话人识别的损失函数,由下式计算得出:

(12)

其中yi目标值,![]() 为神经网络输出的预测值,P为该任务的类别总数。α、β、γ为权重系数,三者的和为1。权重系数的取值在仿真实验中通过验证集进行调试和确定。

为神经网络输出的预测值,P为该任务的类别总数。α、β、γ为权重系数,三者的和为1。权重系数的取值在仿真实验中通过验证集进行调试和确定。

在测试阶段,以同样的方式对测试集提取特征然后输入到网络中,得到输出结果后与测试语句的分类标签进行比较,并输出测试结果。

4 实验结果分析

4.1 实验环境设置

本文的仿真实验首先使用了中国科学院自动化所录制的CASIA汉语情感语料库。该语料库由四个演员(两男两女)录制而成,包括六种情感,分别为生气(anger)、害怕(fear)、开心(happy)、中性(neutral)、悲伤(sad)、惊讶(surprise)。每个说话人每种情感有300条相同文本的语句,共7200条语句。仿真中将实验数据按照6∶2∶2的比例分为训练集、验证集和测试集。训练集用来训练模型,验证集用来对模型中的各项超参数进行选择,测试集用来评估模型性能。由于CASIA中说话人数量较少,为使本文模型性能更具有说服力,且为体现模型在不同语种的语音数据上的性能表现,本文还在阿拉伯语的情感语料库King Saud University Emotions(KSU)上进行了仿真实验。实验使用了该语料库中的第二组语音数据,其由14个演员(7男7女)录制而成,包括五种情感,分别为生气(anger)、开心(happy)、中性(neutral)、悲伤(sad)、惊讶(surprise)。每个说话人每种情感有24条语句,共1680条。仿真中同样将实验数据按比例分为训练集、验证集和测试集。

本文采用基于python实现的librosa语音信号处理工具对语音数据进行预处理和MFCC特征的提取。网络采用小批次ADAM(mini-batch ADAM)优化算法对损失函数进行优化,批次(batch)大小为50;每50个批次测试一次每项任务、每种情感分别在训练集和测试集上的准确率;网络除输出softmax层采用softmax函数作为激活函数以外,其余层均采用tanh函数作为激活函数;设定基础学习率为0.001,学习率按照0.99的系数每50个批次衰减一次;网络除输出层以外均采用了0.5的dropout以减少过拟合。实验在python环境下进行,使用python中的GPU版tensorflow框架进行训练和测试。

关于模型中权重系数的取值,本文在验证集上对其进行确定。由于情感识别为主任务,故其权重值应大于两项辅助任务。实验首先取0.5,0.25,0.25作为初始值,对网络进行训练,在验证集上测试网络性能。然后依次调整权重值并在验证集上测试,最终寻找到使模型在验证集上取得最高识别率时相对应的权重值。经过实验,得到α、β、γ的取值为0.5,0.15,0.35。

为体现本文提出的MTL-RNN算法的性能,除对本文所提出的模型进行实验外,分别设计了四组对比实验,对比实验中均使用相同的40维MFCC特征:

(1)为体现RNN对与时间连续数据的处理能力,设计全连接网络对比实验FCN,使用层数、节点数与本文模型相同的多任务全连接网络对情感、性别、说话人三项分类任务进行分类。

(2)为体现多任务学习相较于单任务学习在性能上的提升,设计单任务对比实验STL-RNN,在其他超参数、语音库保持相同的前提下,对说话人情感这一项单独的任务进行分类。

(3)为体现属性依赖层的作用,设计对比实验Only-RNN,构建没有属性依赖层的多任务循环神经网络进行实验,比较结果。

(4)为体现属性依赖层和共享层的区别,设计对比实验Share-RNN,将原算法中的属性依赖层更改为全连接共享层,由该层输出到softmax输出层得到三个任务的分类结果,并保持其他超参数不变,对比实验结果。

4.2 实验结果分析

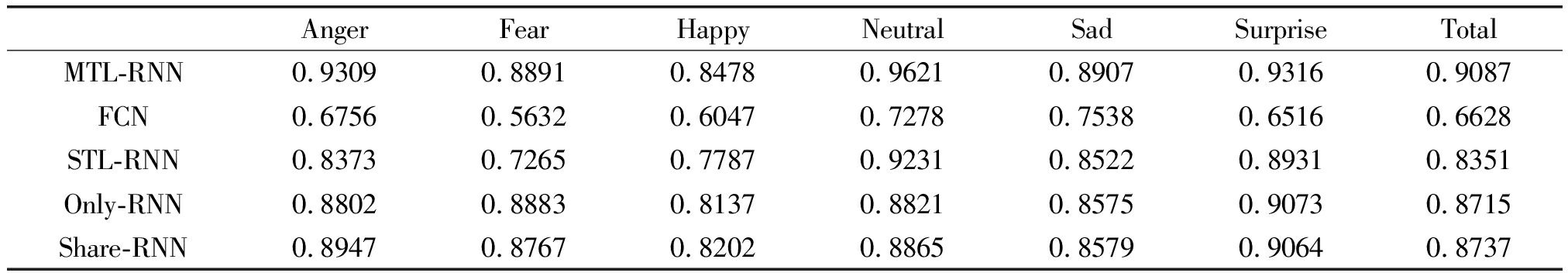

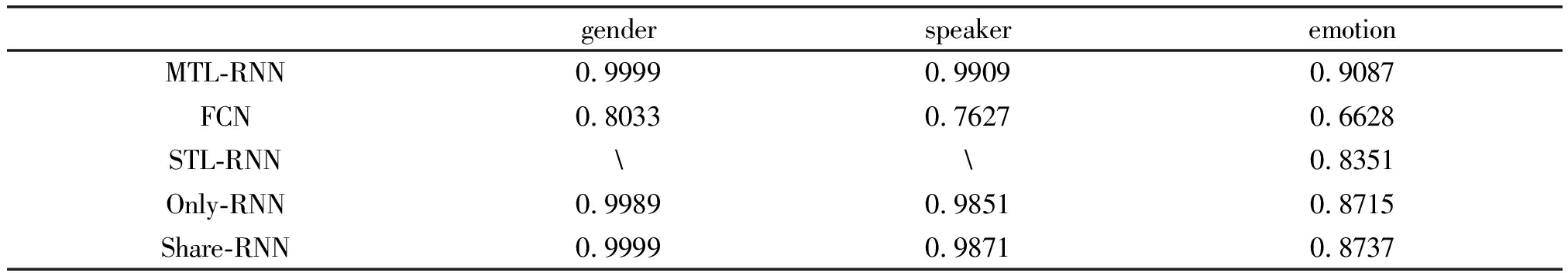

表1和表2显示了各算法在CASIA语音库上的每种情感识别率和每项任务识别率。由表1可以看出,本文提出的MTL-RNN算法达到了90.87%的情感识别平均准确率,六种情感的识别准确率较为平均,其中happy较低,neutral较高,相较于各对比实验均取得了不同程度的识别准确率提升。其中,由于单纯的多任务全连接网络并未有任何特殊结构或其他分类器,而是仅将提取的MFCC特征用全连接网络进行分类,故其识别率较低;基于RNN的几个网络均有较高的识别率,说明RNN对于连续语音数据的描述能力明显强于普通的全连接网络;MTL-RNN模型对于STL-RNN模型的识别率提升说明了带有辅助任务的多任务学习有效的提升了主任务的性能,以及选择说话人性别识别、身份识别作为情感识别的辅助任务是有效的;Share-RNN模型和only-RNN模型在总识别率上几乎没有差别,说明在训练数据有限的情况下,在RNN共享层之后加上一层全连接共享层对于本实验语音库上的模型性能基本没有影响;MTL-RNN模型对于Only-RNN和Share-RNN模型的识别率提升说明了RNN共享层之后的属性依赖层强化了模型对每项任务的学习,提升了模型的性能。由表2可以看出,在三项任务的识别率上MTL-RNN相较于各对比实验均有提升。但由于CASIA库说话人只有4个,因此各项基于RNN的实验在性别识别的识别率上均趋于百分之百,说话人识别的识别率也接近百分之九十九,因而在两项辅助任务的识别率数据上参考价值有限。

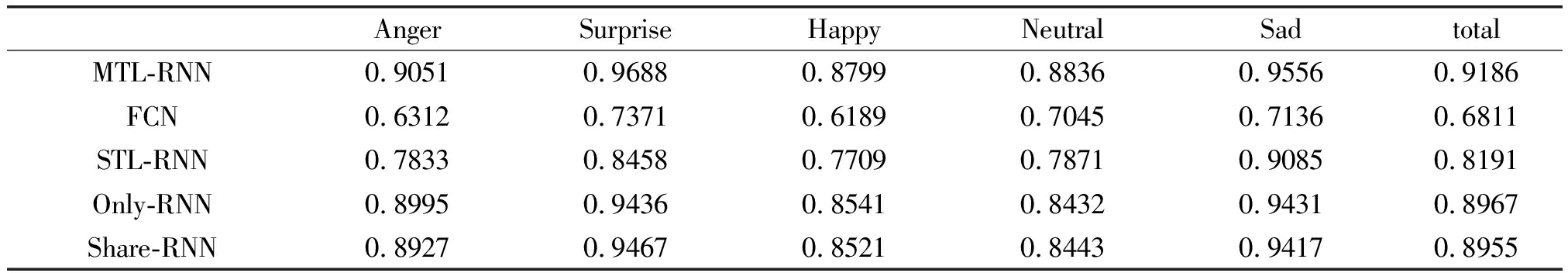

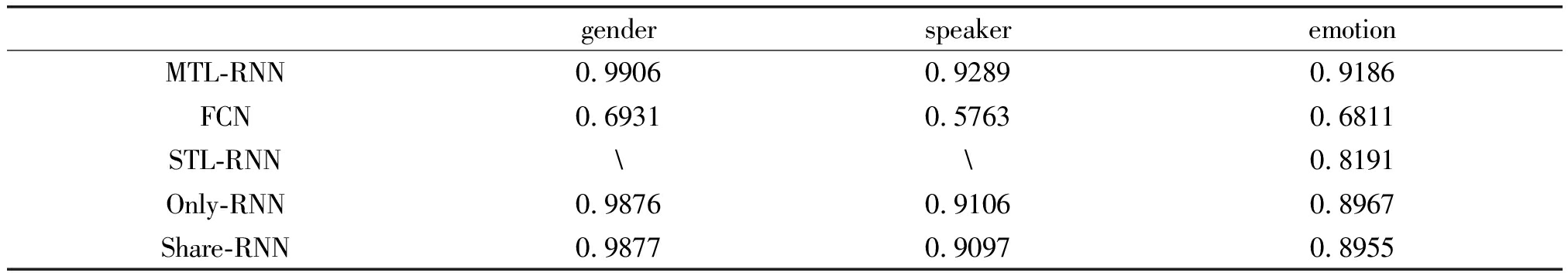

表3和表4示出了各算法在KSU语音库上的每种情感识别率和每项任务识别率。由表3可以看出,在KSU语音库上MTL-RNN模型达到了91.86%的情感识别准确率。与CASIA库上类似,其相较于各对比实验均有不同程度的性能提升,表明本文的MTL-RNN模型对于不同语种的语音数据均有良好的性能表现。由表4可以看出,由于KSU库中说话人数量的大幅增加,MTL-RNN模型对于性别和说话人的识别率相较于CASIA库的结果有了明显降低;同时,MTL-RNN模型对于性别和说话人的识别率相较于各对比实验的提升也更加明显;另一方面,由于KSU语音库的数据量较少,MTL-RNN模型的情感识别率较Only-RNN和Share-RNN模型的提升相对于CASIA库有所降低。

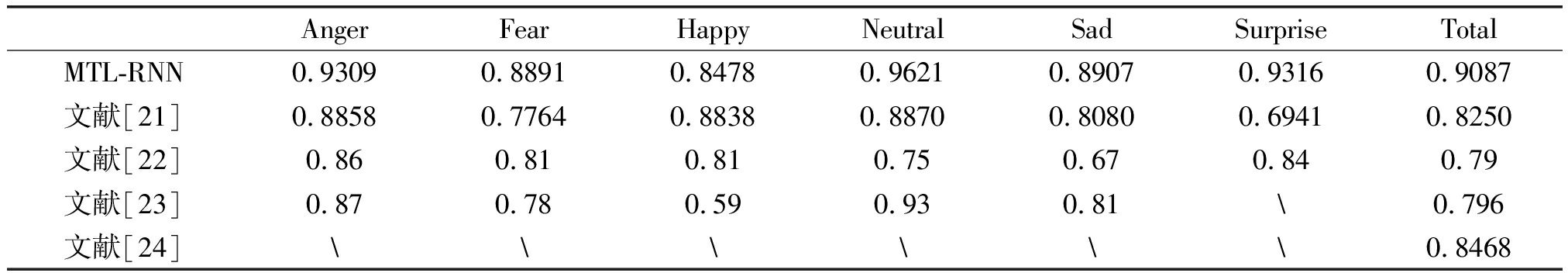

为进一步体现本文所提出的MTL-RNN模型的性能,将本文的仿真结果与其他同样使用CASIA语音库进行语音情感识别仿真的文献中的仿真结果进行比较。文献[21]使用BLSTM对变长数据进行处理、提取特征和进行情感识别;文献[22]使用傅里叶参数和SVM作为分类器对六种情感类别进行情感识别;文献[23]利用CNN从声谱图中提取特征,进行五种情感类别的识别;文献[24]使用CNN作为特征提取器,结合随机森林对六种情感进行识别。对比结果如表5所示。可以看出,本文提出的模型除了在happy上比文献[21]略低外,其余各项情感的识别准确率以及总识别率上均好于其他文献中的算法模型。

表1 CASIA每种情感识别率

Tab.1 Emotion recognition rate in CASIA

AngerFearHappyNeutralSadSurpriseTotalMTL-RNN0.93090.88910.84780.96210.89070.93160.9087FCN0.67560.56320.60470.72780.75380.65160.6628STL-RNN0.83730.72650.77870.92310.85220.89310.8351Only-RNN0.88020.88830.81370.88210.85750.90730.8715Share-RNN0.89470.87670.82020.88650.85790.90640.8737

表2 CASIA每项任务识别率

Tab.2 Task recognition rate in CASIA

genderspeakeremotionMTL-RNN0.99990.99090.9087FCN0.80330.76270.6628STL-RNN\\0.8351Only-RNN0.99890.98510.8715Share-RNN0.99990.98710.8737

表3 KSU每种情感识别率

Tab.3 Emotion recognition rate in KSU

AngerSurpriseHappyNeutralSadtotalMTL-RNN0.90510.96880.87990.88360.95560.9186FCN0.63120.73710.61890.70450.71360.6811STL-RNN0.78330.84580.77090.78710.90850.8191Only-RNN0.89950.94360.85410.84320.94310.8967Share-RNN0.89270.94670.85210.84430.94170.8955

表4 KSU每项任务识别率

Tab.4 Task recognition rate in KSU

genderspeakeremotionMTL-RNN0.99060.92890.9186FCN0.69310.57630.6811STL-RNN\\0.8191Only-RNN0.98760.91060.8967Share-RNN0.98770.90970.8955

表5 仿真结果对比

Tab.5 Comparison of simulation results

AngerFearHappyNeutralSadSurpriseTotalMTL-RNN0.93090.88910.84780.96210.89070.93160.9087文献[21]0.88580.77640.88380.88700.80800.69410.8250文献[22]0.860.810.810.750.670.840.79文献[23]0.870.780.590.930.81\0.796文献[24]\\\\\\0.8468

综上所述,本文提出的MTL-RNN算法模型具有较好的语音情感识别性能,对于主任务和辅助任务的性能均有一定程度的提升,且对于语种和说话人的个性因素有较好的鲁棒性。

5 结论

本文提出了一种采用多任务学习和循环神经网络的语音情感识别算法,将说话人情感识别作为主任务,说话人性别识别、说话人身份识别作为辅助任务,网络通过使用RNN共享层和全连接属性依赖层的结构,在多个任务共同学习跨任务的共享表示的同时使每个子任务能够独自优化以提高模型整体性能。本文通过在CASIA和KSU两个语音情感数据库中的实验证明了提出的MTL-RNN算法在汉语和阿拉伯语、较少说话人和较多说话人的场景下均有较好的识别性能。由于实验数据库大小的限制,本文的系统模型仍然较为简单;同时本文使用的特征是较为普遍的MFCC。因此在未来的工作中,首先要使用更大规模的语料数据库,从而增加模型的隐层层数、节点数量、模型复杂度,评估模型性能;其次在特征选择方面,希望能够找到更好的、更适合模型的特征,例如加入卷积神经网络和生成对抗网络进行特征提取等,以取得更好的分类效果。

[1] 赵力, 黄程韦. 实用语音情感识别中的若干关键技术[J]. 数据采集与处理, 2014, 29(2): 157-170.

Zhao L, Huang C W. Key Technologies in Practical Speech Emotion Recognition[J]. Journal of Data Acquisition and Processing, 2014, 29(2): 157-170.(in Chinese)

[2] 韩文静, 李海峰, 阮华斌, 等. 语音情感识别研究进展综述[J]. 软件学报, 2014, 25(1): 37-50.

Han W J, Li H F, Ruan H B, et al. Review on Speech Emotion Recognition[J]. Journal of Software, 2014, 25(1): 37-50.(in Chinese)

[3] Lin Y L, Wei G. Speech emotion recognition based on HMM and SVM[C]∥International Conference on Machine Learning and Cybernetics. IEEE, 2005: 4898- 4901 Vol.8.

[4] Hu H, Xu M X, Wu W. GMM Supervector Based SVM with Spectral Features for Speech Emotion Recognition[C]∥IEEE International Conference on Acoustics, Speech and Signal Processing. IEEE, 2007: IV- 413-IV- 416.

[5] Schuller B, Rigoll G, Lang M. Hidden Markov model-based speech emotion recognition[C]∥International Conference on Multimedia and Expo, 2003. ICME’03. Proceedings. IEEE, 2003: I- 401- 4 vol.1.

[6] Har r P, Burget R, Dutta M K. Speech emotion recognition with deep learning[C]∥International Conference on Signal Processing and Integrated Networks. IEEE, 2017: 137-140.

r P, Burget R, Dutta M K. Speech emotion recognition with deep learning[C]∥International Conference on Signal Processing and Integrated Networks. IEEE, 2017: 137-140.

[7] Huang Z, Dong M, Mao Q, et al. Speech Emotion Recognition Using CNN[C]∥Acm International Conference on Multimedia. ACM, 2014: 801- 804.

[8] Srivastava N, Hinton G, Krizhevsky A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. Journal of Machine Learning Research, 2014, 15(1): 1929-1958.

[9] Caruana R A. Multitask Learning: A Knowledge-Based Source of Inductive Bias[J]. Machine Learning Proceedings, 1993, 10(1): 41- 48.

[10] Xia R, Liu Y. A Multi-Task Learning Framework for Emotion Recognition Using 2D Continuous Space[M]. IEEE Computer Society Press, 2017.

[11] Kim N K, Lee J, Ha H K, et al. Speech emotion recognition based on multi-task learning using a convolutional neural network[C]∥Asia-Pacific Signal and Information Processing Association Summit and Conference, 2017: 704-707.

[12] Hochreiter S, Schmidhuber J. Long short-term memory[J]. Neural Computation, 1997, 9(8): 1735-1780.

[13] Bengio Y, Simard P, Frasconi P. Learning long-term dependencies with gradient descent is difficult[J]. IEEE Transactions on Neural Networks, 1994, 5(2): 157-166.

[14] Chung J, Gulcehre C, Cho K H, et al. Empirical Evaluation of Gated Recurrent Neural Networks on Sequence Modeling[J]. Eprint Arxiv, 2014.

[15] Caruana R. Multitask Learning[J]. Machine Learning, 1997, 28(1): 41-75.

[16] Parthasarathy S, Busso C. Jointly Predicting Arousal, Valence and Dominance with Multi-Task Learning[C]∥INTERSPEECH, 2017: 1103-1107.

[17] Sciarrone A, Delfino A, Marchese M, et al. Gender-Driven Emotion Recognition Through Speech Signals For Ambient Intelligence Applications[J]. IEEE Transactions on Emerging Topics in Computing, 2014, 1(2): 244-257.

[18] Zhang Y, Liu Y, Weninger F, et al. Multi-task deep neural network with shared hidden layers: Breaking down the wall between emotion representations[C]∥IEEE International Conference on Acoustics, Speech and Signal Processing. IEEE, 2017: 4990- 4994.

[19] Chen D, Mak K W. Multitask learning of deep neural networks for low-resource speech recognition[J]. IEEE/ACM Transactions on Audio Speech & Language Processing, 2015, 23(7): 1172-1183.

[20] Chang J, Scherer S. Learning representations of emotional speech with deep convolutional generative adversarial networks[C]∥IEEE International Conference on Acoustics, Speech and Signal Processing. IEEE, 2017: 2746-2750.

[21] Yue X, Zhu F, Wang J, et al. Long-short term memory for emotional recognition with variable length speech[C]∥First Asian Conference on Affective Computing and Intelligent Interaction, 2018.

[22] Wang K, An N, Li B N, et al. Speech Emotion Recognition Using Fourier Parameters[J]. IEEE Transactions on Affective Computing, 2015, 6(1): 69-75.

[23] 路婷婷. 基于语音和人脸表情的多模态情感识别算法研究[D]. 西安:西北大学, 2018.

Lu T T. Research on Multi-modal Emotion Recognition Algorithm Based on Speech and Face Expression[D]. Xi’an: Northwest University, 2018.(in Chinese)

[24] 郑丽. 语音情感识别及其在服务机器人中的应用研究[D]. 长春:东北师范大学, 2018.

Zheng L. Research on Speech Emotion Recognition and Its Application in the Service Robot[D]. Changchun:Northeast Normal University, 2018.(in Chinese)