1 引言

从被噪声污染的信号中恢复出目标语音,提高语音的质量和可懂度是语音增强的主要目标。语音增强技术被广泛应用在移动通信、语音识别、听觉辅助设备中,是语音信号处理领域的一个重要分支。基于信号和噪声的分布特性,众多语音增强方法被相继提出,代表性的有谱减法、维纳滤波法、统计模型估计[1]等。这些方法在平稳噪声环境下取得了较好的效果。针对传统方法的局限性,尽管一些新的方法被学者们相继提出[2-3],然而在非平稳噪声和低信噪比环境下的单通道语音增强一直是语音信号处理的一个难点。

近些年来,得益于计算机处理能力的提高和机器学习算法的发展,神经网络突破了早期浅层网络在训练数据和网络规模的限制,在计算机视觉、语音信号处理等多个领域得到了迅速发展。在语音增强方面,作为数据驱动的方法,基于深度学习的方法直接由数据驱动,不需要对信号和噪声的分布做先验假设,在非平稳噪声处理中显示出极大的优势。Xu等[4]提出了基于深度神经网络(Deep Neural Network,DNN)的自回归语音增强方法,实现带噪语音的对数能量谱到目标语音对数能量谱的直接映射。Wang等人[5]提出的利用神经网络进行掩蔽估计的方法,将带噪语音的多种声学特征拼接成一个长向量作为网络的输入,听觉Gammatone域的理想浮值掩蔽作为网络的目标输出,将语音增强问题转化为时频单元的分类问题。Huang等人[6]利用深度循环网络(Deep Recurrent Neural Network, DRNN)的动态时序建模能力,提出基于时频掩蔽估计和DRNN联合优化的语噪分离方法。传统的基于前馈神经网络(Forward Neural Network,FNN)的增强方法为了充分利用语音的上下文信息,一般是将相邻帧的时频特征拼接成一个长向量作为网络的输入,原时频结构中相邻的时频单元将会位于长向量的不同位置,相对位置的改变会增大网络对语音中的相关性结构进行建模的难度,深度循环神经网络虽然利用循环连接或者存储和门结构单元对语音信号的长短时序相关性进行建模,但同样对时频域的相关性未能很好的利用。卷积神经网络(Conventional Neural Network,CNN)受生物视觉皮层的感知机理的启发,其局部感知和权值共享特性可以对信号局部相关信息进行建模,同时能够极大减少网络模型的参数数量,在计算机视觉和语音识别领域得到了广泛的应用。

传统CNN网络在卷积层之后会接上若干个全连接层, 将卷积层产生的特征图映射成一个一维的长向量,从而丢失了相邻时间上的相关信息。全卷积网络(Fully Convolutional Network,FCN)将传统卷积网络后面的全连接层换成了卷积层,通过反卷积使输出可以保持和输入相同的大小,保留了原始输入中的结构信息[7]。文献[8]对经典的全卷积网络进行改进,提出了一种基于U-Net的全卷积编解码网络结构,通过在上采样层对特征图进行拼接增加特征图数量,将上下文信息传递到更高分辨率层,在细胞边缘检测竞赛中取得了最优的结果。文献[9]提出将全卷积编解码框架用于图像复原,编码层和解码层结构对称,并借鉴了highway networks和残差网络的思想,在编解码对应层之间引入跳跃连接(skip connections),将卷积层的特征图信息传递到对应的反卷积层,用于恢复原始图像。

语音信号在经过短时傅里叶变换后(Short Time Fourier Transform,STFT)后的语谱图在时间和频率两个维度上有着和图像类似的二维表示。语音信号浊音段的时域波形呈现出的准周期特性和短时功率谱具有共振峰结构,表明语音信号在时域和频域上存在着局部相关性,因此可以利用CNN对语音信号的二维时频表示来建模。但过去几年将CNN用于语音增强的研究还比较少。其中,文献[10]提出了memory efficient的冗余卷积编解码增强方法,可在参数量减少68倍和12倍的情况下得到与FNN和RNN接近甚至较好的增强效果。文献[11]将用于图像风格转换的生成对抗网络结构[12]直接应用于语音增强,将深度编解码结构应用在生成器中,但全卷积编解码网络在语音增强中的应用研究的还比较缺乏。

受文献[9]工作的启发,本文将深度全卷积编解码框架应用在语音增强中。在网络中引入跳跃连接,可以有效解决深度网络训练中出现的梯度消失问题,本文对两种典型skip connections的形式,即特征融合相加和特征拼接对语音增强效果的影响展开了研究。

损失函数是网络的重要组成部分。目前大部分基于神经网络的谱映射语音增强算法都是基于最小均方误差(Minimum Mean Square Error,MMSE)准则,通过反向传播误差更新网络参数。经过DNN方法增强后的语音特别是在高频部分会存在噪声冗余,出现过平滑的现象。文献[3]采用全局均衡方差方法来解决经DNN增强后语音频谱出现的过平滑问题。近些年来在图像处理任务中,研究者发现基于L1范数的损失函数要优于L2范数因为它引入较小的模糊。文献[11]将这一用于图像处理的结论直接用在GAN的生成器中用于语音增强。为了更好地验证结论在语音增强方面的有效性,文献[13]对比了基于L1范数和L2范数的损失函数在传统FCN网络中和生成对抗网络中对语音增强性能的影响。本文我们将这一研究扩展到深度全卷积编解码网络中,研究两种不同的跳跃连接方式下,不同损失函数对语音增强性能的影响。

本文内容安排如下:第2节描述深度卷积编解码框架,第3节是基于深度卷积编解码网络的语音增强,仿真实验和结果分析在第4节给出,第5节总结全文。

2 深度全卷积编解码网络

2.1 卷积编解码网络

编解码网络是一种灵活的框架模型,由编码器(端、层)和解码器(端、层)组成,可以根据需要灵活地应用到无监督或者有监督任务中,通常用于网络预训练、高维原始数据降维、特征提取及数据压缩、生成等。编码器和解码器可以根据不同任务选取FCN、CNN、RNN等不同的网络模型。本文利用CNN的局部感知和权值共享特性,将深度全卷积编解码网络用于语音增强。一方面,语音信号浊音段的时域波形具有相似性,呈现出准周期特性,经过STFT后的短时功率谱具有共振峰结构,表明语音信号在时域和频域上存在着局部相关性[14]。传统神经网络将相邻帧的时频特征拼接成一个长向量作为网络的输入,相对位置的改变会增大网络对语音中的相关性结构进行建模的难度。同时人耳在嘈杂的背景噪声中选择目标语音时,能对任意声音极快地做出反应,并不需要关注过去的其他人声或噪音,降噪本身应当是一个局部化的处理,这一点和语音识别、机器翻译等任务是不同的。而卷积神经网络具有局部感知特性,网络中的每个神经元只需要和前一层的部分神经元相连,同时,卷积神经网络的权值共享特性使每个滤波器特征图权重相同,这样会使网络的参数量大量减少,提升模型的鲁棒性。

编码端由多个卷积层组成,每个卷积层包括卷积滤波、批量标准化、池化、非线性变换操作组成。解码端和编码端结构对应,由反卷积、上采样、批量标准化、非线性变换操作组成。将该结构应用到语音增强,将带噪语音的时频特征作为网络的输入,在编码端利用卷积网络对带噪语谱中的局部典型性结构进行建模,提取高层语音特征,同时逐层抑制背景噪声的影响。在解码端,通过反卷积层由编码端提取到的高层语音特征信息逐层恢复语音细节成分,重构语音信号。

2.2 跳跃连接

在神经网络中引入跳跃连接,最早是为了解决在训练中随着网络深度的增加,出现梯度消失,导致网络训练困难的问题。本文借鉴文献[9]的思想,在编解码部分对应层之间引入跳跃连接。一方面可以将误差直接传递到低层,使网络的训练更有效,还有一个重要的作用是可以对信号的细节信息进行补偿。随着网络层数的增加,由于逐层的卷积、池化等操作会导致信号的主要结构特征被提取,而一些局部的细节信息丢失,特别是随着网络层数的加深,有可能会产生解码端无法由编码端得到的高层信息恢复目标信号的细节信息的问题。而编码端的特征图包含了信号的大量细节信息,通过引入跳跃连接将编码端的特征图信息由卷积层传递到对应反卷积层,可以有助于恢复目标信号的细节信息。

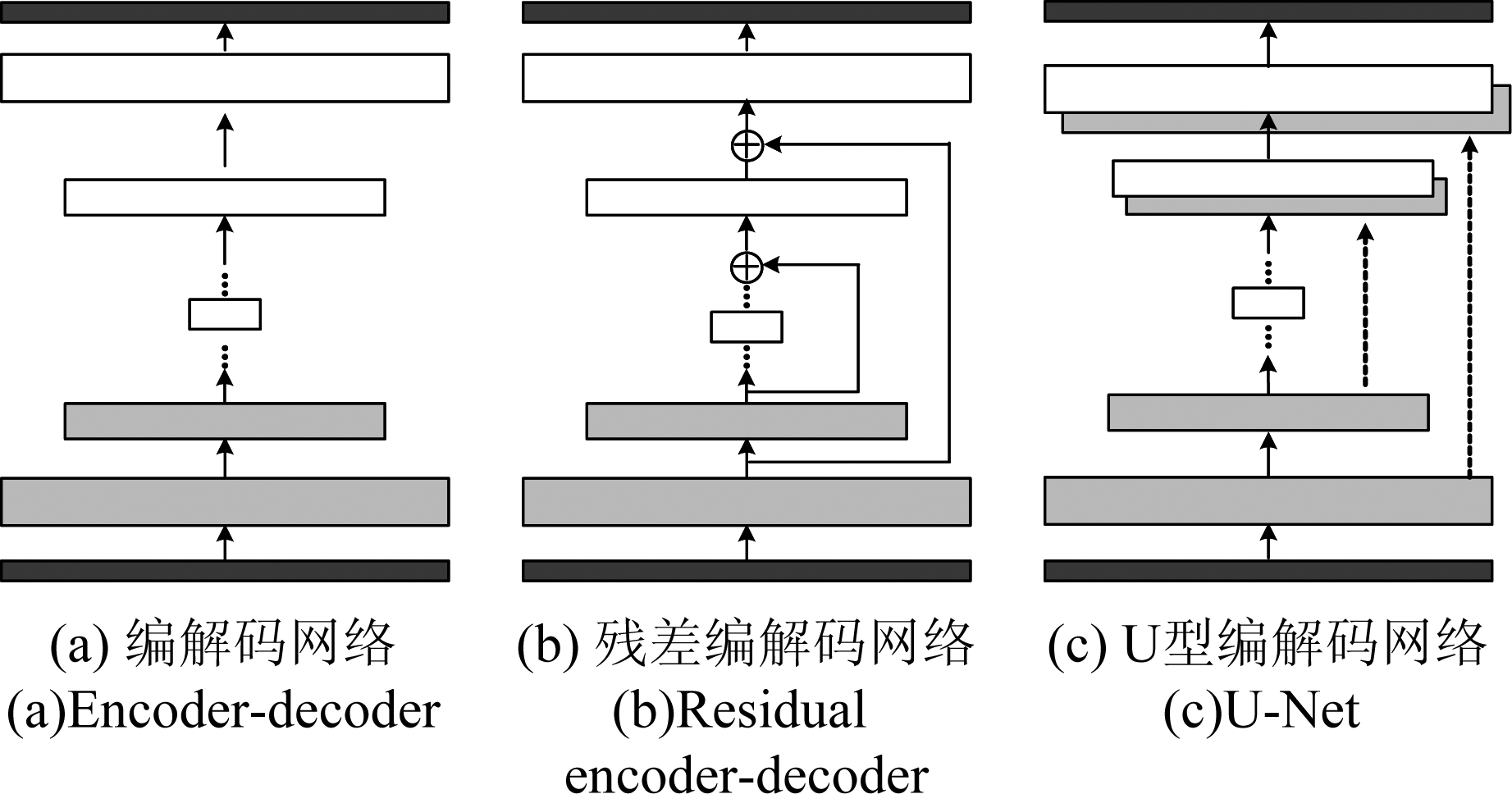

本文采用的编解码网络结构如图1所示。图1(a)为无跳跃连接的编解码网络结构,图1(b)图为残差编解码网络。与文献[9]结构相似,类似于Resnet [15]网络中的恒等映射,将使得数据在不同网络层之间传递,将原始的输入Y和目标映射X的优化拟合问题转换为输入和目标之间残差函数F(Y)=Y-X的优化问题。图1(b)中的‘+’号表示直接进行元素级相加而保持特征图层数不变,即将卷积层的特征映射以元素方式传递到对应反卷积层,并与反卷积特征映射按元素求和并传递到下一层。与图1(b)中将特征图元素求和再传递到下一层不同,图1(c)是将编码端的特征层传递到对应解码端的特征图并进行拼接,进行通道的合并,从而充分利用特征图信息。

图1 编解码网络结构图

Fig.1 Architecture of the encoder-decoder network

3 基于深度全卷积编解码网络的语音增强

设Y(m,k)、X(m,k)、N(m,k)分别为带噪语音、目标语音及加性背景噪声在时刻m和频点k的STFT幅度谱,且满足:

Y(m,k)=X(m,k)+N(m,k)

(1)

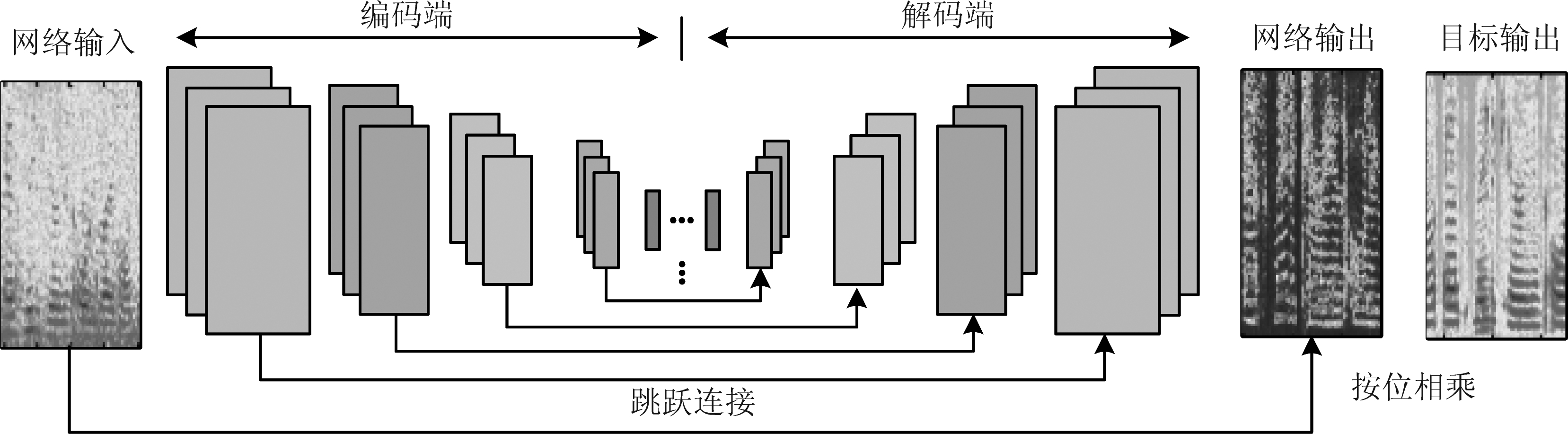

其中,m={1,2,…,Ω}和k={1,2,…,K}分别代表频率和时间,在下文中,我们省略频率和时间索引,简记为Y、X和N。将第2节介绍的深度卷积编解码网络用于语音增强,方法框架如图2所示:将带噪语音在时域进行分帧加窗后经STFT变换得到带噪语音信号的二维时频表示作为网络的输入,在编码端利用卷积网络对带噪语谱中的典型结构特征进行建模,提取语音特征,同时逐层抑制背景噪声的影响。在解码端通过反卷积层由提取的特征信息逐层恢复语音成分。编解码网络均由卷积层组成,不使用池化层和全连接层。在编解码对应层之间引入跳跃连接,以减少由于卷积操作导致的低层细节信息丢失的问题,从而更好的恢复目标语音的时频特征。反卷积层的输出为带噪语音的时频掩蔽值或者时频增益,由带噪语音的幅度谱联合反卷积层的输出即可得到纯净语音的谱估计值。

损失函数是网络的重要组成部分,目前大部分基于神经网络的谱映射语音增强算法都是基于MMSE准则,本文分别考虑了基于L1范数和L2范数的损失函数训练网络对语音增强性能的影响,其对应的损失函数如式(2)和式(3)所示。

L1(X,Y;Θ)=‖f(Y,Θ)⊗Y-X‖1

(2)

L2(X,Y;Θ)=‖f(Y,Θ)⊗Y-X‖2

(3)

式中,Y代表带噪语音的时频特征输入,Θ 代表网络参数,由权重矩阵和偏置矩阵组成, f(X,Θ)代表网络的输出,可以理解为掩蔽估计或者增益估计, f(Y,Θ)⊗Y 代表目标语音的时频特征估计,⊗代表矩阵元素按位相乘。‖·‖1表示网络估计和目标语音真值之间距离绝对值之和, ‖·‖2表示网络估计和目标语音真值之间的距离绝对值的平方和的开方。

图2 基于全卷积编解码网络的语音增强

Fig.2 Fully convolutional encoder-decoder network for speech enhancement

4 实验仿真及性能分析

4.1 数据集和评价指标

本文实验中,从TIMIT语音库[16]训练集中随机选取200句纯净语音,测试集中选取20句纯净语音,从NOISEX-92标准噪声库[17]中选取3平稳噪声和3种非平稳噪声。按照文献[4]的方法对噪声进行分段分别用于训练和测试。按文献[14]的方法对训练和测试用纯净语音按照不同的信噪比添加噪声分别生成7200句带噪语音作为训练集, 480句带噪语音作为测试集。

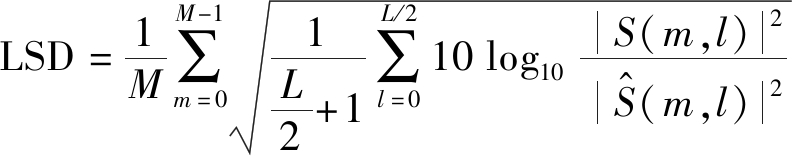

感知语音质量(Perceptual Evaluation of Speech Quality, PESQ)[18]、短时客观可懂度(Short-time objective intelligibility, STOI)[19]和对数谱距离(Log-Spectral Distance, LSD)[20]是被广泛采用的衡量语音增强性能的客观评价指标。PESQ得分结果与主观听觉测试得分具有很高的相关度。与PESQ评估方法侧重于评估处理语音的总体质量不同,STOI得分主要用于评估语音的可懂度。 LSD是衡量纯净语音和增强语音之间的对数谱失真,其值与语音质量成反比,越小的值表示增强后语音的谱失真越小,其计算公式为:

(4)

其中M是一段语音总的信号帧数,S(m,k)和![]() 分别为纯净语音和增强后语音经过短时傅里叶变换后的第m帧的第l个频谱分量。

分别为纯净语音和增强后语音经过短时傅里叶变换后的第m帧的第l个频谱分量。

4.2 基线方法和参数设置

为了验证本文所提方法的有效性,本文选取基于DNN的自回归语音增强方法[4](简记为DNN-LAS)作为基线方法,对比Encoder-decoder全卷积网络(简记为En-De-Net)和引入两种跳跃连接后的全卷积编解码网络(分别简记为Res-Net和U-Net)的语音增强效果,同时通过实验分析对比利用L1和L2两种损失函数训练网络对语音增强性能的影响。

为了降低网络模型的复杂度,减少训练参数的数量,将训练集和测试集中的语句均下采样至8000 Hz。帧长取32 ms,帧移8 ms,对语句进行256点的STFT变换,获得语音信号在二维时频域的特征表示。在DNN-LAS方法中,网络由输入层、输出层和3个隐藏层组成,隐藏层节点数设为1024。网络的输入为带噪语音当前帧联合相邻2帧的对数幅度谱特征,网络的输出目标为当前帧对应的纯净语音的对数幅度谱特征。隐层选取ReLU作为激活函数[21],输出层选取线性激活函数。在实验中En-De-Net和Res-Net及U-Net网络结构相同,均为全连接卷积编解码网络,不包含全连接层和池化层,三种结构的卷积滤波器大小和数量一致。网络的输入和输出均为128帧129维的时频表示。网络由11个卷积层组成,每个卷积层由卷积(反卷积)、批量规范化和非线性激活组成。卷积滤波器大小均为5×5,数量分别取为16-32- 64-128-256-512-256-128- 64-32-16,卷积步长取2×2,选取Leaky ReLUs非线性激活函数。Dropout值取为0.2,在训练时按照dropout比率丢弃网络结点,增加网络的泛化性和鲁棒性,在测试时不进行dropout操作。其中DNN-LAS和En-De-Net均是基于L2范数损失函数反向传播误差训练网络参数。为了衡量L1范数用于损失函数对语音增强性能的影响,我们在U-Net和Res-Net网络增加了基于L1损失函数对网络进行训练的对比实验。

4.3 实验结果和分析

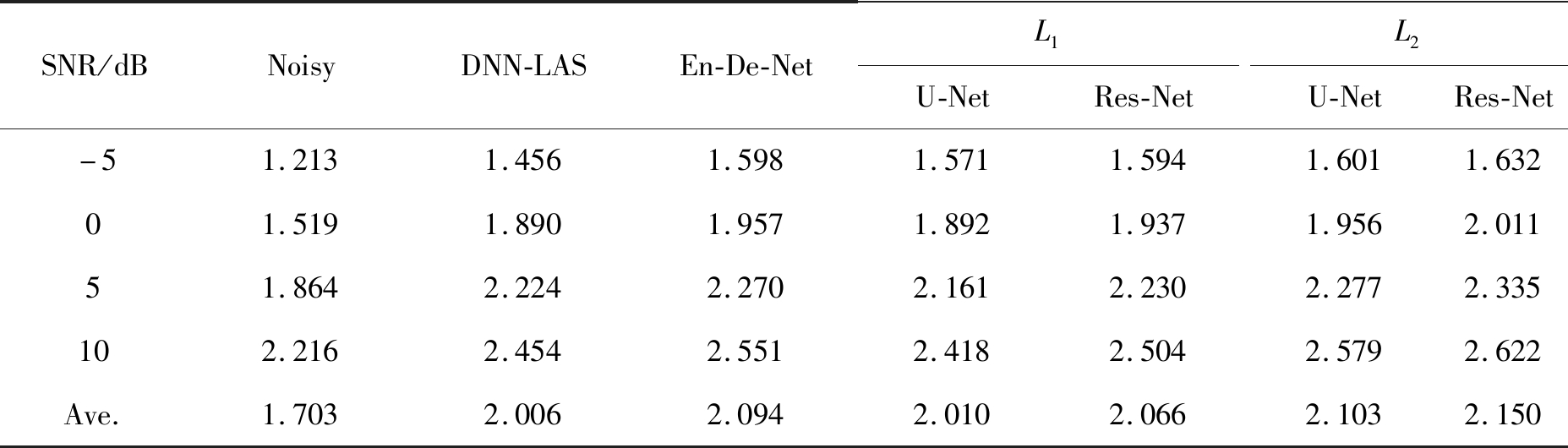

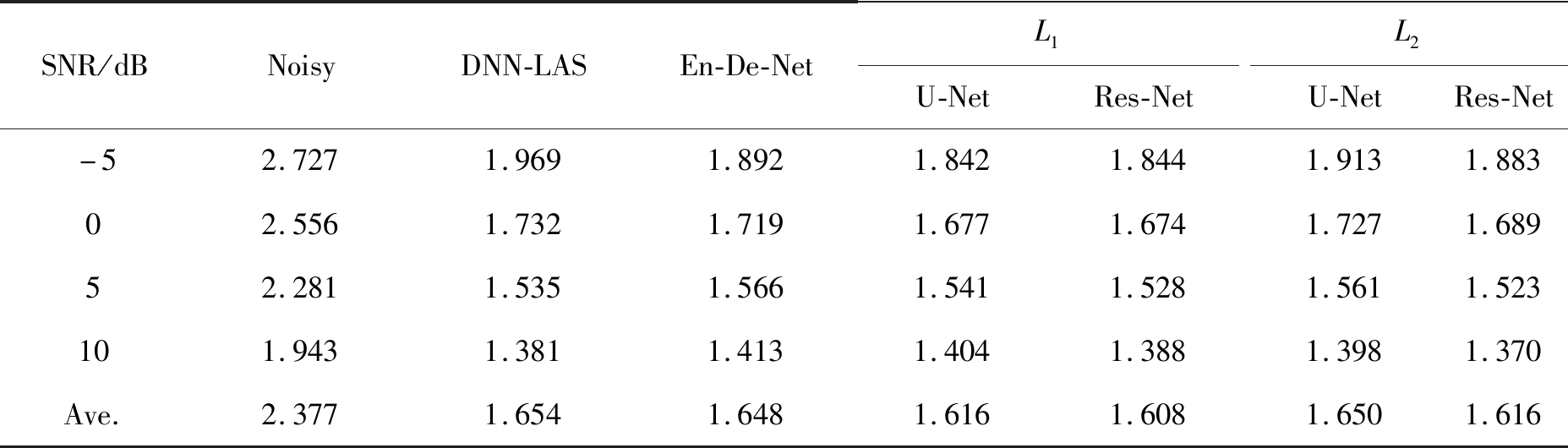

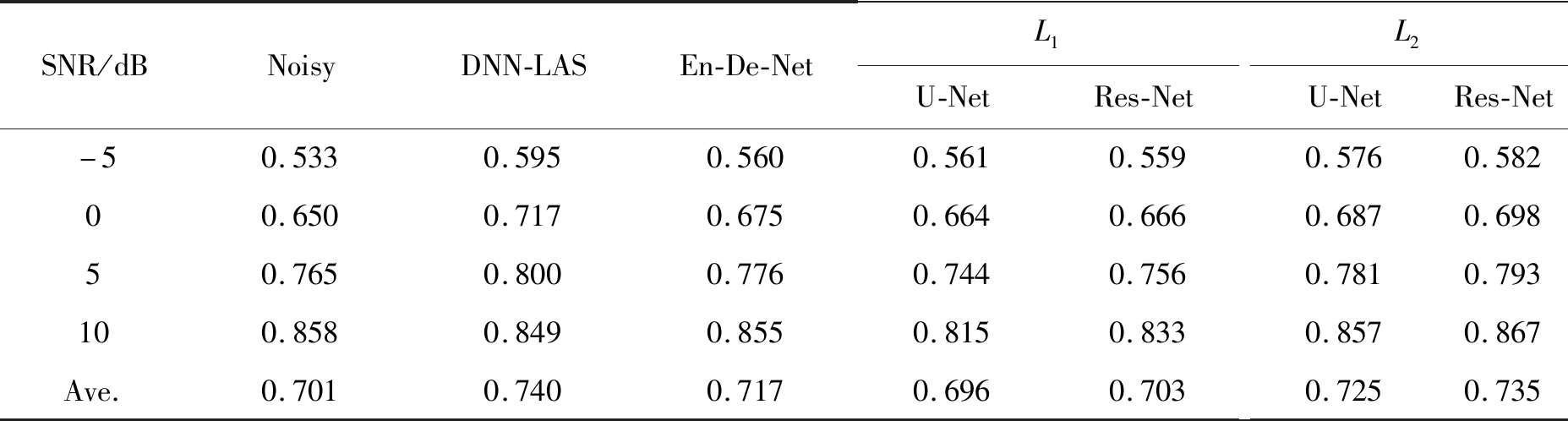

表1、表2和表3分别给出了480句测试语句经不同网络结构增强后的PESQ、LSD和STOI得分。由表1可以看出,经全连接卷积编解码网络增强后语音的感知质量在各种SNRs下均优于DNN-LAS方法。 在L1 范数损失函数下,两种带跳跃连接的PESQ均低于L2 范数损失函数下不带跳跃连接的全卷积编解码网络,Res-Net的性能略低于En-De-Net,高于U-net结构。在L2 范数损失函数下,带跳跃连接的U-Net的增强性能略高于En-De-Net,而Res-Net网络在各个SNRs下的语音感知质量得分最优。此结果表明,在相同损失函数下,引入跳跃连接可以有效提升语音的感知质量。由表2可以看出,在低SNRs下(5 dB以下),经L1 范数损失函数训练的网络得到的增强语音的对数谱失真要低于经L2 范数损失函数训练的网络。在5 dB以上,En-De-Net网络及U-Net网络引入的谱失真要高于传统的基于谱映射的全连接神经网络。总的来说,基于L1 范数损失函数训练的Res-Net网络的谱失真最小,L1 范数损失函数下的U-Net和L2 范数损失函数下的Res-Net的谱失真接近。在低SNRs下跳跃连接的引入在两种损失函数下均会带来谱失真的减小,随着SNR的增加,情况相反。我们认为是跳跃连接在较高SNR的情况下,引入的噪声的成分要高于细节信息,导致谱失真的增加。由表3给出的不同方法在不同SNR下的STOI值可以看出,在较低信噪比下,基于DNN-LAS的方法对语音可懂度的变化很小,几乎没有改变,而基于全卷积编解码会降低语音的可懂度。这也说明在低信噪比下,基于DNN-LAS和全卷积编解码神经网络的方法对可懂度的提升较为明显,但后者的幅度要小于前者。随着信噪比的提高,特别是在10 dB下,基于在全卷积编解码网络框架下对可懂度的提升要优于DNN-LAS方法,基于L1范数误差准则,以特征图拼接和融合相加的跳跃连接结构反而会降低语音的可懂度。

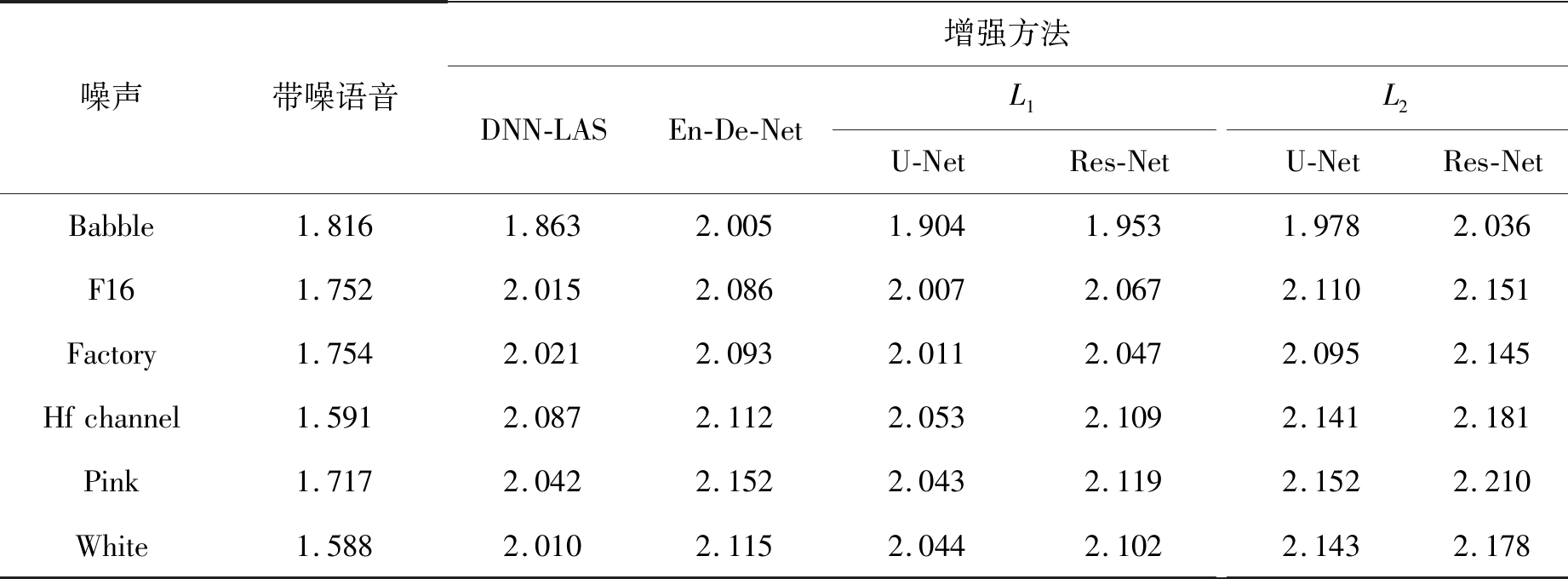

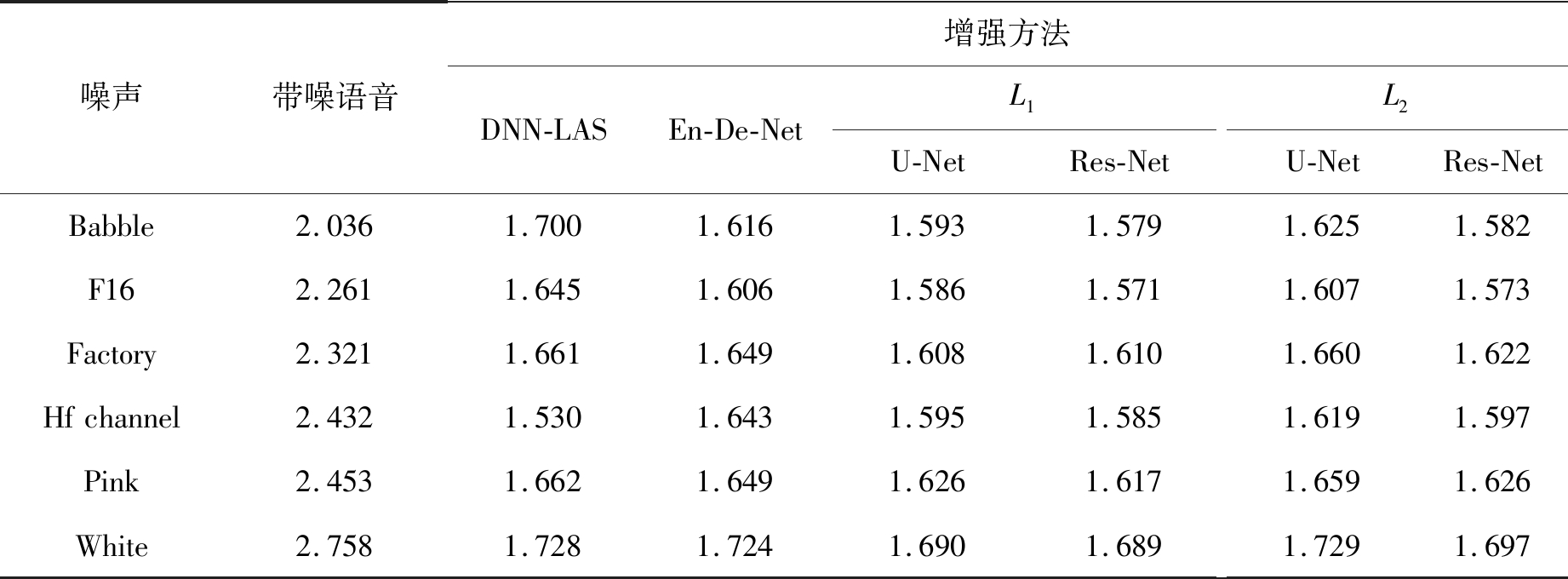

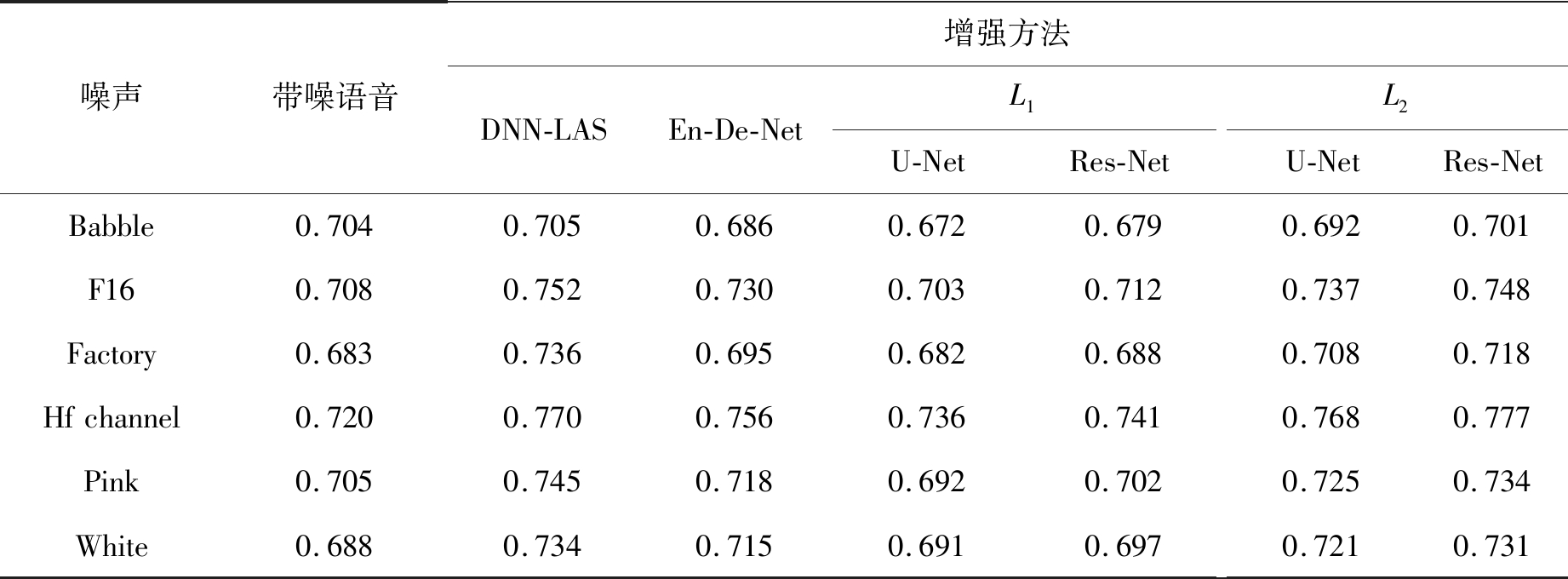

表4、表5和表6分别给出了实验中6种噪声在-5、0、5和10 dB经过不同增强方法处理后的PESQ、LSD和STOI的得分均值。由表4可以看出,在平稳噪声和非平稳噪声类型下,基于En-De-Net网络的增强方法的PESQ得分均高于DNN-LAS方法。在L1 范数损失函数下,仅在Babble噪声和White噪声类型下,U-Net网络的感知质量略高于DNN-LAS方法,在其他情况的感知质量得分最低。在L2 损失函数下,带跳跃连接的编解码网络的语音感知质量得分要高于DNN-LAS和En-De-Net方法,以特征图融合相加的跳跃连接方式对语音感知质量的提升要优于特征图拼接的跳跃连接方式。由表5可以看出,除了在Hf channel噪声类型下,基于卷积编解码网络增强后的语音的谱失真均要高于基于DNN-LAS方法,在编解码网络结构中引入跳跃连接会减少语音的谱失真,通过L1 范数损失函数训练的网络的谱失真要低于经过L2 范数损失函数训练的网络。以特征图融合相加的跳跃连接方式对语音谱失真的减少要优于特征图拼接的跳跃连接方式。 由表6给出的不同方法在不同SNR下的STOI值可以看出,在Babble噪声下,基于DNN-LAS的方法对语音可懂度的变化很小,几乎没有改变,而基于全卷积编解码会降低语音的可懂度。这也说明在Babble噪声下,可懂度的提升较为困难。在其他几种平稳和非平稳噪声下,基于DNN-LAS的语音增强方法对可懂度的提升要优于全卷积编解码神经网络框架。而在全卷积编解码网络框架下,基于最小均方误差准则,以特征图融合相加的跳跃连接方式对语音可懂度的提升要优于无跳跃连接和以L1范数作为误差准则的方法。

表1 不同方法在不同SNR下的PESQ值

Tab.1 PESQ score of different methods under different SNRs

SNR/dBNoisyDNN-LASEn-De-NetL1U-NetRes-NetL2U-NetRes-Net-51.2131.4561.5981.5711.5941.6011.63201.5191.8901.9571.8921.9371.9562.01151.8642.2242.2702.1612.2302.2772.335102.2162.4542.5512.4182.5042.5792.622Ave.1.7032.0062.0942.0102.0662.1032.150

表2 不同方法在不同SNR下的LSD值

Tab.2 LSD score of different methods under different SNRs

SNR/dBNoisyDNN-LASEn-De-NetL1U-NetRes-NetL2U-NetRes-Net-52.7271.9691.8921.8421.8441.9131.88302.5561.7321.7191.6771.6741.7271.68952.2811.5351.5661.5411.5281.5611.523101.9431.3811.4131.4041.3881.3981.370Ave.2.3771.6541.6481.6161.6081.6501.616

表3 不同方法在不同SNR下的STOI值

Tab.3 STOI score of different methods under different SNRs

SNR/dBNoisyDNN-LASEn-De-NetL1U-NetRes-NetL2U-NetRes-Net-50.5330.5950.5600.5610.5590.5760.58200.6500.7170.6750.6640.6660.6870.69850.7650.8000.7760.7440.7560.7810.793100.8580.8490.8550.8150.8330.8570.867Ave.0.7010.7400.7170.6960.7030.7250.735

表4 不同噪声在不同增强方法下的PESQ值

Tab.4 PESQ score of different types of noise under different enhancement methods

噪声带噪语音增强方法DNN-LASEn-De-NetL1U-NetRes-NetL2U-NetRes-NetBabble1.8161.8632.0051.9041.9531.9782.036F161.7522.0152.0862.0072.0672.1102.151Factory1.7542.0212.0932.0112.0472.0952.145Hfchannel1.5912.0872.1122.0532.1092.1412.181Pink1.7172.0422.1522.0432.1192.1522.210White1.5882.0102.1152.0442.1022.1432.178

表5 不同噪声在不同增强方法下的LSD值

Tab.5 LSD score of different types of noise under different enhancement methods

噪声带噪语音增强方法DNN-LASEn-De-NetL1U-NetRes-NetL2U-NetRes-NetBabble2.0361.7001.6161.5931.5791.6251.582F162.2611.6451.6061.5861.5711.6071.573Factory2.3211.6611.6491.6081.6101.6601.622Hfchannel2.4321.5301.6431.5951.5851.6191.597Pink2.4531.6621.6491.6261.6171.6591.626White2.7581.7281.7241.6901.6891.7291.697

表6 不同噪声在不同增强方法下的STOI值

Tab.6 STOI score of different types of noise under different enhancement methods

噪声带噪语音增强方法DNN-LASEn-De-NetL1U-NetRes-NetL2U-NetRes-NetBabble0.7040.7050.6860.6720.6790.6920.701F160.7080.7520.7300.7030.7120.7370.748Factory0.6830.7360.6950.6820.6880.7080.718Hfchannel0.7200.7700.7560.7360.7410.7680.777Pink0.7050.7450.7180.6920.7020.7250.734White0.6880.7340.7150.6910.6970.7210.731

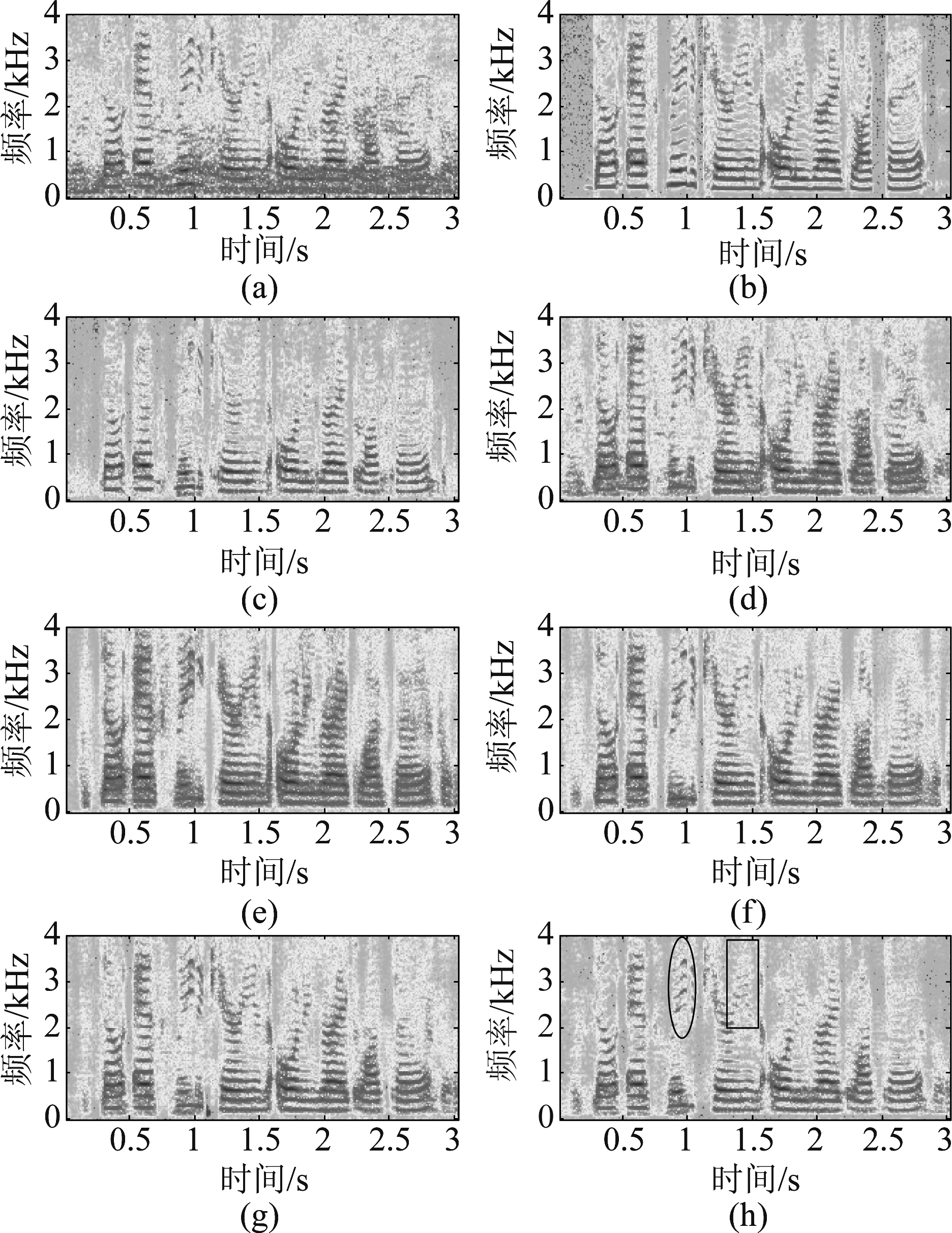

图3 语音语谱图.(a)被5 dB Factory噪声污染的带噪语音;(b)纯净语音;(c)经DNN-LAS方法增强的语音;(d)经En-De-Net方法增强的语音;(e)基于L1损失函数经U-Net方法增强的语音;(f)基于L1损失函数经Res-Net方法增强的语音;(g)基于L2损失函数经U-Net方法增强的语音;(h)基于L2损失函数经Res-Net方法增强的语音

Fig.3 Spectrograms of (a) noisy speech corrupted by 5 dB factory noise;(b) clean speech;(c) enhanced by DNN-LAS;(d)enhanced by En-De-Net;(e) enhanced by U-Net with L1 loss;(f) enhanced by Res-Net with L1 loss;(g)enhanced by U-Net with L2 loss;(h) enhanced by Res-Net with L2 loss

表1至表6从数据上给出了不同网络结构的语音增强性能。为了更直观的理解,图3给出了一段被5 dB Factory噪声污染后的语音经不同的增强方法处理后的语音语谱图。由图3(c)可以看出,经过DNN-LAS增强方法处理后,大部分噪声成分得到了抑制,在低频部分语音成分较好的得到了恢复,但在高频部分存在一些细节成分的缺失。经En-De-Net方法处理后,在高、低频部分语音的结构信息得到了恢复,但是存在频谱模糊的现象,我们分析应该是由高层特征信息通过上采样恢复语音细节信息引入的。图3(e)和图3(f)分在是在L1 损失函数下,在图3(d)结构的基础上引入两种跳跃连接方式得到的,和图3(d)相比,在较好的保留了高低频结构信息的基础上,对噪声的抑制略有提升。图3(g)和图3(h)分别是在L2 损失函数下,在图3(d)结构的基础上引入两种跳跃连接方式得到的,与DNN-LAS方法相比,低频结构信息都得到了较好的恢复,由图中框图部分可以看出,在高频细节成分的恢复要优于DNN-LAS方法,和L1损失函数相比,尽管噪声成分得到了较好的抑制,但在高频细节结构上还有部分未能很好的恢复。

5 结论

本文将深度全卷积编解码网络用于语音增强,针对编解码过程中出现细节信息缺失的问题,提出一种将特征图融合和特征图拼接两种跳跃连接方式引入到编解码网络对应层之间的语音增强方法。同时对比了在基于L1和L2两种损失函数的训练方法对语音感知质量和谱失真的影响。实验结果表明,基于特征图融合相加的跳跃连接方法能获得较好的语音感知质量。基于L1损失函数训练的方法在语音高频部分成分的恢复要优于基于L2损失函数的训练方法。

[1] Loizou P C. Speech enhancement: Theory and practice[M]. Boca Raton, FL, USA: CRC Press 2007.

[2] 李轶南, 张雄伟, 曾理, 等. 改进的稀疏字典学习单通道语音增强算法[J]. 信号处理, 2014, 30(1): 44-50.

Li Yinan, Zhang Xiongwei, Zeng Li, et al. An improved monaural speech enhancement algorithm based on sparse dictionary learning[J]. Journal of Signal Processing, 2014, 30(1): 44-50.(in Chinese)

[3] 胡永刚, 张雄伟, 邹霞, 等. 改进的非负矩阵分解语音增强算法[J]. 信号处理, 2015, 31(9): 1117-1123.

Hu Yonggang, Zhang Xiongwei, Zou Xia, et al. Improved nonnegative matrix factorization based speech enhancement algorithm[J]. Journal of Signal Processing, 2015, 31(9): 1117-1123.(in Chinese)

[4] Xu Y, Du J, Dai L R, et al. A regression approach to speech enhancement based on deep neural networks[J]. IEEE/ACM Trans. on Audio, Speech, and Language Processing, 2015, 23(1): 7-19.

[5] Wang Y X, Narayanan A, Wang D L. On training targets for supervised speech separation[J]. IEEE/ACM Trans. on Audio, Speech, and Language Processing, 2014, 22(12): 1849-1858.

[6] Huang P S, Kim M, Hasegawa-Johnson M, et al. Joint optimization of masks and deep recurrent neural networks for monaural source separation[J]. IEEE/ACM Trans. on Audio Speech and Language Processing, 2015, 23(12): 2136-2147.

[7] Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640- 651.

[8] Ronneberger O, Fischer P, Brox T. U-net: Convolutional networks for biomedical image segmentation[C]∥International Conference on Medical Image Computing and Computer-Assisted Intervention. Berlin: Springer, 2015: 234-241.

[9] Mao X J, Shen C, Yang Y B. Image de-noising using very deep fully convolutional encoder-decoder networks with symmetric skip Connections[C]∥Proceedings of the 30th Conference on Neural Information Processing Systems(NIPS). NY: Curran Associates, 2016.

[10] Park S R, Lee J. A fully convolutional neural network for speech enhancement[C]∥Processing of the 18th Annual Conference of the International Speech Communication Association. Stockholm, Sweden, International Speech Communication Association (ISCA) Press, 2017: 1993-1997.

[11] Michelsanti D, Tan Z H. Conditional generative adversarial networks for speech enhancement and noise-robust speaker verification[C]∥Processing of the 18th Annual Conference of the International Speech Communication Association. Stockholm, Sweden, International Speech Communication Association (ISCA) Press, 2017: 2008-2012.

[12] Isola P, Zhu J Y, Zhou T H, et al. Image-to-image translation with conditional adversarial networks[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). NJ: IEEE, 2017: 5967-5976.

[13] Pandey A, Wang D L. On adversarial training and loss functions for speech enhancement[C]∥Proceedings of the 43nd IEEE International Conference on Acoustics, Speech, and Signal Processing. Piscataway, NJ: IEEE, 2018: 5074-5078.

[14] 时文华, 倪永婧, 张雄伟, 等. 联合稀疏非负矩阵分解和神经网络的语音增强[J]. 计算机研究与发展, 2018, 55(11): 2430-2438.

Shi Wenhua, Ni Yongjing, Zhang Xiongwei, et al. Deep neural network based monaural speech enhancement with sparse non-negative matrix factorization[J]. Journal of Computer Research and Development, 2018, 55(11): 2430-2438.(in Chinese)

[15] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), NJ: IEEE, 2016: 770-778.

[16] Zue V, Seneff S, Glass J. Speech database development at MIT: TIMIT and beyond[J]. Speech Commun., 1990, 9(4): 351-356.

[17] Varga A, Steeneken H J M. Assessment for automatic speech recognition: II. NOISEX-92: A database and an experiment to study the effect of additive noise on speech recognition systems[J]. Speech Communication, 1993, 12(3): 247-251.

[18] Rix A, Beerends J, Hollier M P, et al. Perceptual evalulation of speech quality (PESQ): An objective method for end-to-end speech quality assessment of narrowband telephone networks and speech codecs[C]∥Proceedings of the 26th IEEE International Conference on Acoustics, Speech, and Signal Processing. Piscataway, NJ: IEEE, 2001: 749-752.

[19] Taal C H, Hendriks R C, Heusdens R, et al. An algorithm for intelligibility prediction of time-frequency weighted noisy speech[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2011, 19(7): 2125-2136.

[20] Du J, Huo Q. A speech enhancement approach using piecewise linear approximation of an explicit model of environment distortions[C]∥Proceedings of the 33rd IEEE International Conference on Acoustics, Speech, and Signal Processing. Piscataway, NJ: IEEE, 2008: 4721- 4724.

[21] Andrew L M, Awni Y H, Andrew Y N. Rectifier nonlinearities improve neural network acoustic models[C]∥Proceedings of the 30th International Conference on Machine Learning (JMLR: W&CP). Brookline, MA: Microtome Publishing, 2013: 315-323.