1 引言

无线边缘缓存不仅可以缓解回传链路受限的问题以满足爆炸性增长的移动数据流量,而且可以降低传输延时、提升用户体验[1-2]。很多研究[3-5]表明,对于缓存容量受限的无线边缘节点,主动缓存的性能远优于被动缓存策略。这得益于“二八定律”,即网络中绝大多数的请求来自少量流行的文件,如果利用有限的缓存资源缓存了这些流行文件,则相对于没有缓存的系统会带来非常大的性能增益;小区越小、增益越大[6]。然而,达到这种性能增益的前提是能够准确预测用户未来的请求行为。

由于无线边缘用户较少、且用户移动性很强,预测用户的群体行为或个体行为都十分困难。一个可能的解决方案是,在一个能覆盖多个小区的中心处理器[7]观测并收集所覆盖区域内所有用户的历史请求数据,周期性地预测用户未来的个体请求行为[8],而后可以把个体行为合成为流行度分布[1],也可以直接根据用户个体行为优化缓存策略[8-9]。对于缓存策略优化,用户的群体行为一般指的是文件的流行度分布,即一个区域内所有用户对各文件的请求概率;而用户的个体行为则包括各用户对各文件的请求概率、用户活跃度和请求的空间局部性[9]。

鉴于在流行度分布已知时主动边缘缓存具有很大的性能潜力,最近业界开始研究流行度未知时的缓存策略。文献[3]基于深度强化学习优化主动缓存策略使长期命中率最高。文献[4]采用K近邻和迁移学习预测流行度分布、并设计了一种主动协作缓存策略。文献[5]提出了一种在线学习算法预测流行度分布、并更新缓存的文件。上述研究工作的结果表明,主动缓存策略优于被动缓存。不过,这些工作都是基于独立参考模型合成的静态请求数据评估缓存性能,假设文件库大小不变且流行度分布不会发生变化。文献[10]基于一个最近提出的散粒噪声模型研究了内容流行度的时空动态特性对基站端缓存性能的影响。文献[11]考虑了流行度分布在时间和空间上的相关性,利用强化学习寻找最优的缓存策略,并根据马尔可夫决策过程合成请求数据评估所提出的策略。文献[8,12-13]考虑了一个在推荐系统领域里常用的MovieLens数据集[14],通过人为地把用户评分转化为用户请求评估所提出算法的性能。虽然MovieLens数据集的评分数据带有时间戳(秒级),但是用户的评分行为很难反映其请求行为。例如,用户可能在观看影片很久之后才提交评分,或在同一时刻提交对多部影片的评分(在MovieLens 1M数据集中,有的用户在一天内给出了超过1000个评分!)。文献[1,8]分别采用蜂窝网络的实测数据集和MovieLens数据集,采用协同过滤学习群体或个体用户行为。具体而言,文献[8]利用概率潜在语义分析以无监督的方式学习个体用户的请求概率及其活跃度,文献[1]通过矩阵补全的方法以有监督的方式学习局部流行度分布。为了保证用于训练模型的数据集与用于测试的数据集统计独立同分布,基于协同过滤的学习方法没有利用请求记录中的时间信息,导致其实际上并不能预测优化主动缓存策略时所需要的行为信息——未来短期(即下一个缓存更新间隔,下文简称为“更新间隔”)内的用户请求行为。

本文尝试回答以下问题:(1)主动缓存策略是否一定优于被动缓存?(2)预测用户行为的不确定性来自哪些因素,对主动缓存的性能有多大影响?为此,我们考虑一个在局部区域内每秒记录的用户请求视频文件次数的实测数据集,采用神经网络预测用户在下一个更新间隔内的个体和群体请求行为,然后根据预测的用户请求行为对宏基站和微基站端的最优主动缓存策略性能进行评估,并与一个典型的被动缓存策略——最近最少使用(Least Recently Used, LRU)策略[15]进行比较。研究结果表明,当采用实测数据集时,LRU优于主动缓存,且在宏小区的性能增益更大;而当采用合成的静态数据集时,评估的结果与已有文献一致,即主动缓存优于LRU策略。

本文的主要贡献如下:(1)采用神经网络预测用户在下一个缓存更新间隔内的个体和群体行为;(2)基于实测数据集,预测用户请求行为并比较主动缓存策略与LRU的性能,分析小区数、缓存更新间隔和观测窗长度对主动缓存性能的影响;(3)分析预测不确定性的来源和对主动缓存策略的影响。

2 基于用户行为的缓存策略优化

2.1 系统模型

考虑一个由Nb个基站、Nu个用户组成的无线边缘缓存网络,其中每个基站都可以缓存Nc个文件、并通过容量受限的回传链路与核心网相连。核心网中部署的中心处理器负责观测和记录用户发出请求行为的历史数据,并对缓存所需的用户行为信息进行预测。每个基站有M根天线,采用迫零波束赋形以相等的功率服务M个单天线用户。

当用户发起请求时接入距离最近的基站(称为本地基站),如果所请求的文件不在本地基站,则经回传链路获取该文件。为了避免来自相邻基站的强小区间干扰,相邻基站采用不同的频段。

为了适应用户对内容需求的差异性和发出请求时的空间局部性,每个基站可以采用不同的策略缓存文件。令第b个基站的缓存策略为cb=[c1b,…,cNfb](b=1,…,Nb),其中,cf b∈{0,1},cf b=1表示第b个基站缓存第f个文件,否则不缓存该文件,Nf为文件库的大小。每个基站在网络闲时根据缓存策略周期性地(如每隔1天或几个小时)更新缓存(即优化策略)。

当第u个用户从本地基站b下载文件时,其接收信干噪比为:

(1)

其中,P为基站的发射功率,hub和rub=‖xu-yb‖分别为第b个基站与第u个用户间的信道增益与欧式距离,xu=(xu1,xu2)、yb=(yb1,yb2)分别为第u个用户和第b个基站的坐标位置,α是路径损耗因子,σ2为噪声功率,Φb表示与基站b同一频段的基站集合。考虑瑞利衰落信道,则hub服从Gamma分布,即hub~ (M, 1/M)。

(M, 1/M)。

2.2 用户的个体和群体行为

对于无线边缘缓存,用户的个体行为信息包括用户的请求概率、活跃度和请求的空间局部性[9]。第u个用户的请求概率可表示为qu=[qu1,…,quNf],其中quf∈[0,1]表示第f个文件被第u个用户请求的概率。第u个用户的活跃度可以表示为νu,是指某一个请求由第u个用户发出的概率。第u个用户的请求空间局部性可以表示为au=[au1,…,auNb],其中,aub表示第u个用户发出请求时位于第b个小区的概率。

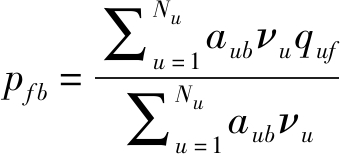

用户的群体行为信息体现为局部流行度分布,即一个小区内各文件被小区内所有用户请求的概率分布,可以由上述用户个体的行为信息表示为:

(2)

其中,分母![]() 表示第b个小区接收到一个请求的概率。

表示第b个小区接收到一个请求的概率。

2.3 问题建模和求解

采用成功分流概率作为性能指标,定义为用户请求的文件缓存在本地基站、且可以被成功传输(即用户端的接收信干噪比大于给定门限γ0)的概率,可以表示为:

(3)

其中, xu{·}表示对用户位置取期望。根据全概率公式,用户u的成功传输概率可以表示为:

xu{·}表示对用户位置取期望。根据全概率公式,用户u的成功传输概率可以表示为:

(4)

其中,![]()

|Sb|表示第b个小区Sb的面积。一旦基站的拓扑和网络的配置参数给定,不难通过数值方法计算出成功传输概率。由于对用户位置取了平均,成功传输概率与用户u无关。那么,使成功分流概率最大的缓存策略优化问题可以描述如下:

![]()

![]() ∀b,

∀b,

0≤cf b≤1,∀f,b

(5)

如果已知用户的个体行为信息,则通过求解上述优化问题,不难得出最优的缓存策略是根据![]() 在第b个基站缓存最流行的Nc个文件。由于

在第b个基站缓存最流行的Nc个文件。由于![]() 与pf b成正比,且比例系数

与pf b成正比,且比例系数![]() 只与第b个基站有关,因此最优的缓存策略就是根据用户请求概率等个体行为信息由式(2)合成的局部流行度分布缓存最流行的文件。可见,如果已知用户的群体行为信息,则当用户就近接入本地基站时,各基站根据局部流行度分布缓存本小区最流行的Nc个文件即可实现最优缓存。

只与第b个基站有关,因此最优的缓存策略就是根据用户请求概率等个体行为信息由式(2)合成的局部流行度分布缓存最流行的文件。可见,如果已知用户的群体行为信息,则当用户就近接入本地基站时,各基站根据局部流行度分布缓存本小区最流行的Nc个文件即可实现最优缓存。

3 预测用户请求概率和局部流行度

为了实现第2节的主动缓存策略,需要预测用户在下一个更新间隔内的个体或群体行为。

本节考虑多层感知机(Multilayer Perceptron,MLP)[16],通过有监督的方式学习用户行为。与用户请求概率相比,用户活跃度和请求的空间局部性通常变化比较缓慢,更容易预测。为了分析用户请求概率的预测不确定性对主动缓存的影响,假设未来短期内的用户活跃度和请求空间局部性可以被准确预测。由于不同的缓存更新间隔内被请求的文件集合不同,根据每个间隔内的请求数计算文件被请求的概率预测局部流行度分布的性能很差,因此,我们预测一个文件在下一个缓存更新间隔内被请求的次数(称为局部流行度)。用局部流行度除以对所有文件总请求数的预测值,即可得到优化缓存策略所需的局部流行度分布。

在每个更新间隔开始时,中心处理器根据过去一段观测时间内的请求数据预测下一个更新间隔内每个用户的请求概率或每个文件的局部流行度。当预测用户请求概率时,考虑到用户请求文件行为的相似性,可以训练一个用户共享的MLP,其思想与推荐系统中的协同过滤类似。当预测文件流行度时,为了降低预测大量文件的训练复杂度,可以训练一个文件共享的MLP。

3.1 多层感知机的结构

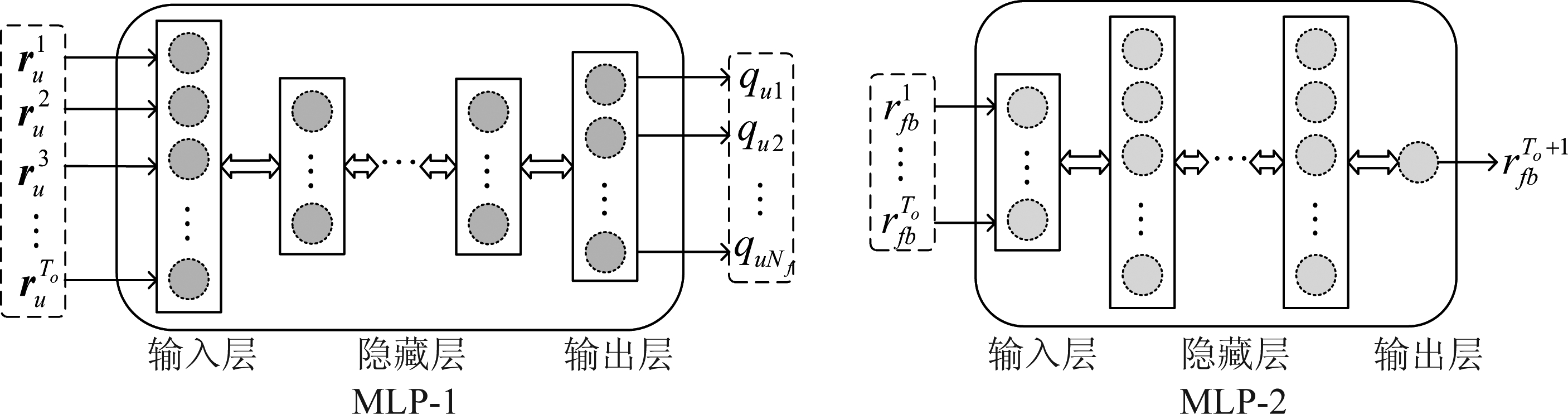

考虑两个神经网络,MLP-1和MLP-2,分别预测用户请求概率和局部流行度,如图1所示。

每个网络都包含输入层、隐藏层和输出层。隐藏层的激活函数为ReLU函数,即y=max(x,0)。为了能够直接输出一个概率分布,MLP-1网络输出层的激活函数为softmax函数,即![]() 为了能够输出一个非负的数值,MLP-2网络输出层的激活函数为softplus函数,即y=log(1+ex)[16]。

为了能够输出一个非负的数值,MLP-2网络输出层的激活函数为softplus函数,即y=log(1+ex)[16]。

令每个更新间隔的长度为Tu,观测窗长度为To个更新间隔。MLP-1用于预测一个用户在下一个更新间隔内的请求概率分布,与该用户在观测窗内对文件库中各文件的请求数有关。MLP-1的输入为观测窗内每个更新间隔内一个用户对文件库中各文件的请求数,输出为该用户在第To+1个更新间隔内的请求概率分布。具体地,输入为![]() 其中,

其中,![]() 表示在第t个更新间隔内第u个用户对第f个文件的历史请求数,期望的输出y1=qu=[qu1,…,quNf]为第u个用户的请求概率分布。x1与y1构成了数据集中的一个样本。期望输出y1中的元素quf可以估计为第u个用户在第To+1个更新间隔内对第f个文件的请求数与该用户在这个间隔内发出的总请求数之比。更新间隔Tu越短,用户在Tu内发出的请求数越少,则每个样本的输入数据越稀疏、期望输出估计得越不准。

表示在第t个更新间隔内第u个用户对第f个文件的历史请求数,期望的输出y1=qu=[qu1,…,quNf]为第u个用户的请求概率分布。x1与y1构成了数据集中的一个样本。期望输出y1中的元素quf可以估计为第u个用户在第To+1个更新间隔内对第f个文件的请求数与该用户在这个间隔内发出的总请求数之比。更新间隔Tu越短,用户在Tu内发出的请求数越少,则每个样本的输入数据越稀疏、期望输出估计得越不准。

图1 预测用户请求概率和局部文件流行度的神经网络

Fig.1 Structures of neural networks for predicting user’s request probability and local popularity

MLP-2用于预测一个文件在下一个更新间隔内一个小区的流行度。MLP-2的输入为观测窗内每个更新间隔内一个文件在第b个小区被请求的次数,输出为该文件在第To+1个更新间隔内在该小区被请求的次数。具体地,输入为![]() 期望的输出

期望的输出![]() 其中,

其中,![]() 表示在第t个更新间隔内第f个文件在第b个小区被请求的次数。

表示在第t个更新间隔内第f个文件在第b个小区被请求的次数。

3.2 训练和预测阶段

在xk和yk的上角标加上(n)以表示第n个样本,用![]() 表示MLP-k(k=1,2)网络的训练集,其中,Nk=|Dk|。

表示MLP-k(k=1,2)网络的训练集,其中,Nk=|Dk|。

在离线训练阶段,由于MLP-1网络输出的是一个概率分布,故使MLP-1的输出与期望输出之间的交叉熵与正则化项构成的代价函数最小[16],由于MLP-2网络输出的是一个数,故使MLP-2的输出与期望输出之间的均方误差与正则化项构成的代价函数最小[16],即:

(6)

(7)

其中,![]() 为一个Lk层的MLP-k网络的权重矩阵,

为一个Lk层的MLP-k网络的权重矩阵,![]() 为MLP-k网络的偏置向量,

为MLP-k网络的偏置向量,![]() 或

或![]() 是训练样本中的期望输出,

是训练样本中的期望输出,![]() 或

或![]() 是输入

是输入![]() 后MLP-k的输出值,加入正则化项是为了降低过拟合,ν是正则化项的系数。在训练过程中,采用小批量梯度下降算法,通过反向传播算法优化Wk和bk,并通过Adam[17]算法自适应地调整学习率。为了进一步降低过拟合,将采用提前终止技术[16]。

后MLP-k的输出值,加入正则化项是为了降低过拟合,ν是正则化项的系数。在训练过程中,采用小批量梯度下降算法,通过反向传播算法优化Wk和bk,并通过Adam[17]算法自适应地调整学习率。为了进一步降低过拟合,将采用提前终止技术[16]。

在预测阶段,当每个更新间隔开始时,依次输入每个用户的历史请求数据![]() 到MLP-1的输入层,MLP-1依次输出每个用户在下一个更新间隔内请求概率分布的预测值;依次输入每个文件在一个小区的历史请求数据

到MLP-1的输入层,MLP-1依次输出每个用户在下一个更新间隔内请求概率分布的预测值;依次输入每个文件在一个小区的历史请求数据![]() 到MLP-2的输入层,MLP-2依次输出每个文件在下一个更新间隔内在该小区请求数的预测值。

到MLP-2的输入层,MLP-2依次输出每个文件在下一个更新间隔内在该小区请求数的预测值。

4 仿真与分析结果

本节利用实测数据集对基于用户行为预测优化的主动缓存策略进行性能评估,并与LRU策略进行比较。首先根据原始的请求数据产生MLP-1和MLP-2的训练和测试样本,然后分析小区数、更新间隔和观测窗长度对不同缓存策略的影响。为了与现有文献的结论进行比较,最后采用合成的静态数据集比较不同的缓存策略。

考虑以下三种主动缓存策略:

1)基于神经网络预测用户请求概率(图例为“主动缓存(UP)”):根据长度为To的观测窗内的历史请求数据,通过MLP-1预测在第To+1个更新间隔内所有“活跃用户”的请求概率,其中“活跃用户”定义为在第To+1个更新间隔内发出请求的用户,然后根据问题(5)的优化结果、即根据用户个体行为合成的局部流行度分布在每个基站缓存最流行的文件,其中假设用户活跃度和请求空间局部性能被准确预测,活跃度计算为一个用户在第To+1个更新间隔内发出的请求数与总请求数之比,请求空间局部性为一个用户在To+1个更新间隔内在各小区发出的请求数与该用户发出的总请求数之比。

2)基于神经网络预测局部流行度(图例为“主动缓存(NN)”):根据在观测窗内的历史请求数据,通过MLP-2预测所有观测窗内被请求的文件在第To+1个更新间隔内在各小区的请求数。

3)基于累计增长方法预测局部流行度[18](图例为“主动缓存(CG)”):这种简单的流行度预测方法的思想是假设文件的请求过程平稳。若在观测窗内对文件m发起的总请求数为Nm(To),则该文件的平均历史请求到达率为Nm(To)/To,将其当作未来请求到达率,即可得到第To+1个更新间隔内的请求数。

当采用LRU策略时,对于每个新到达的请求,如果所请求的文件没有被缓存,则基站通过回传链路把该文件下载到缓存设备中;如果缓存空间已满,则基站先删除最不常用、即最长时间内未被请求的文件。

4.1 仿真系统设置

为了分析小区半径对主动与被动缓存性能的影响,分别考虑一个由半径为250 m的六边形宏小区和7个由半径为250/3 m的六边形微小区覆盖的区域,两个区域的面积近似相等。宏基站和微基站的发射功率分别为46 dBm和30 dBm[19]。为了公平地比较两种网络的缓存性能,需要保证传输资源和缓存资源相同,因此宏、微基站的发射天线数M分别设置为7和1、缓存容量分别为Nc和Nc/7。路径损耗分别建模为35.3+37.6 log(dub)dB和30.6+36.7log(dub)dB[20],其中,dub表示用户u到基站b的距离,接收机的噪声功率σ2为-95 dBm,信干噪比门限γ0为0 dB。

如果没有特殊说明,下面将考虑7个微小区构成的微小区网络,主动缓存的更新间隔Tu为12个小时,观测窗长度To为5个更新间隔(即60个小时),整个区域(一个宏小区或7个微小区)的总缓存容量Nc为98个文件,约为下面所考虑文件库大小的4%。

4.2 数据集及预处理方法

所采用的实测数据集来自一个校园网的请求数据,记录了2 km2的区域内所有匿名用户在2016年8月至2016年11月中86天内每一秒对中国最大的视频点播网站之一——优酷的请求历史。由于在设计主动缓存策略时更关心活跃用户对流行文件的请求数据,因此从原始数据集中筛除了大量不活跃用户和不流行文件(首先筛除了总请求数少于10个的文件,然后筛除了总请求数少于86且发起请求的天数少于24天的用户,即保留了平均每天至少请求一次且平均每周至少两天发起请求的用户),处理后的数据集包含Nu=151个用户对Nf=2416个文件发起的总共25758个请求。对于这个处理后的数据集,平均请求到达率为300个请求/天、流行度分布参数为0.53、用户活跃度的Zipf分布参数为0.5、用户间的平均余弦相似度[8]为0.14。由于该数据集不包含发起请求时用户的位置信息,为了反映用户请求的空间局部性,仿真中设每个用户请求的空间局部性服从参数为1的Zipf分布[9],但各用户对请求位置的倾向性不同(例如,当考虑微小区网络时,用户1可能倾向于在第一个微小区发出请求,而用户2则更倾向于在第7个微小区发出请求)。根据各用户请求的空间局部性,在预处理后的数据集中人为地添加请求的位置信息,具体地,对于数据集中的任意一个请求,根据发起请求用户的空间局部性随机生成该用户发起请求的小区。这样,数据集中的每个请求都包含以下四种信息:发起请求的用户编号、请求的文件编号、请求的时间(秒级)、发起请求的小区。

为了与现有文献[3-5]的结论进行比较,我们也合成一个静态数据集。为了与实测数据集公平地进行比较,在所考虑的一个宏小区(或7个微小区)覆盖区域内的用户数、文件库大小、平均请求到达率、流行度、请求的空间局部性、用户活跃度、用户间相似度都与上述处理后的实测数据集相同,然后通过[9]中提出的算法生成用户请求概率,并根据用户个体行为的统计信息产生86天的请求数据。

4.3 样本生成与神经网络超参数

首先给出MLP-1网络的训练和测试样本生成方法。根据主动缓存的更新间隔Tu,把86天划分为Ns个不重叠的更新间隔。对于每个用户,根据观测窗长度To和更新间隔Tu,通过每次把观测窗平移一个更新间隔,可以依次产生Ns-To个样本,其中,观测窗内的请求数据作为每个样本的输入,第To+1更新间隔内的请求数据用来计算该样本的期望输出,因此,最多可以产生Nu(Ns-To)个样本。为了便于评估一个更新间隔内的缓存性能,需要同时获取所有用户在该更新间隔及相应观测窗内的请求数据,因此,一旦一个用户的某个样本被选为测试样本,那么其他所有用户在对应时间内产生的样本都应该放入测试集中。如图2所示,3个用户应该同时把第5个更新间隔内的请求数作为期望输出的样本放入测试集中,以便于评估这个更新间隔内的缓存性能。

图2 生成测试集

Fig.2 Generating test set

在仿真中把成功分流概率计算为在Ttest个更新间隔内所有基站成功分流的请求数与总请求数之比。采用5折交叉验证的方法,把所有样本随机地划分为5个大小相似的互斥子集,然后取5次评估结果的均值作为最终的结果。

值得注意的是,由于不活跃的用户在观测窗内或下一个更新间隔内很可能不发出任何请求,导致所产生样本的输入或期望输出为0,这些样本无法用于训练,因此对上述产生的训练集和测试集进行进一步的处理,从训练集和测试集中筛除这些无效的样本。

MLP-2网络的样本生成方法与MLP-1相似,但有以下两个不同之处:首先,为了预测局部流行度,每个被请求的文件在任何一个小区内的请求数都可以通过平移观测窗产生Ns-To个样本,因此最多可以产生NfNb(Ns-To)个样本;其次,由于训练过程损失函数是均方误差,因此即使所产生的样本期望输出为0,仍然可以利用该样本进行训练。

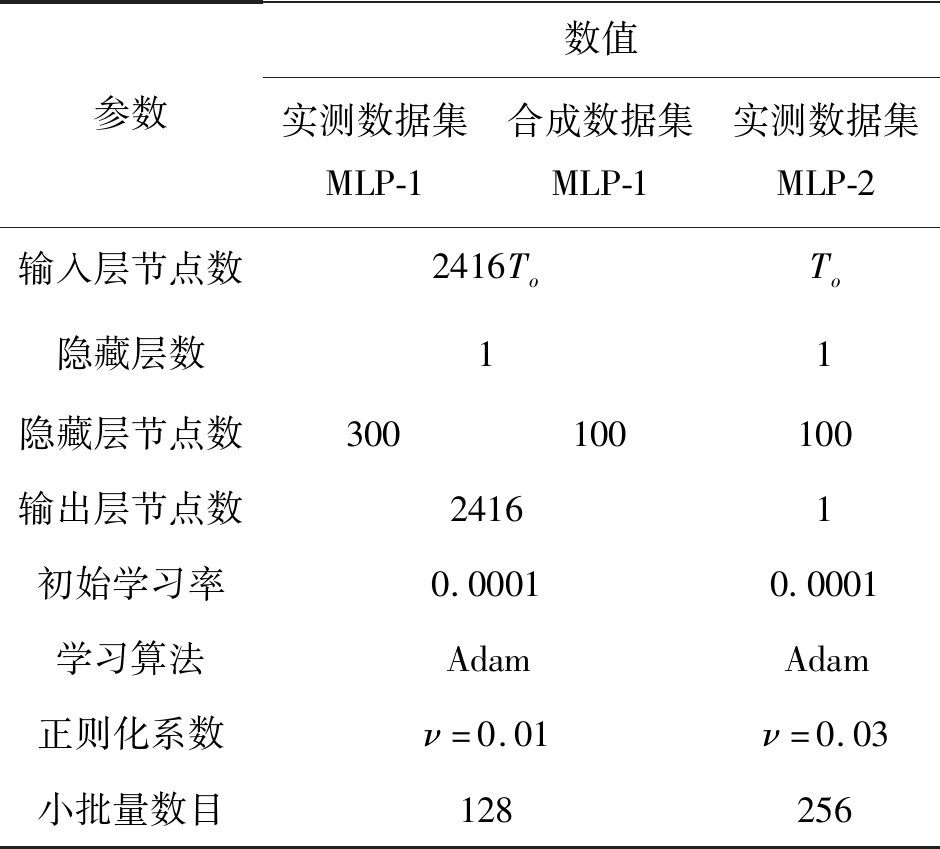

表1列出了精调两个MLP网络后的超参数。

表1 精调的MLP的超参数

Tab.1 Fine-tuned MLP hyper-parameters

参数数值实测数据集MLP-1合成数据集MLP-1实测数据集MLP-2输入层节点数2416ToTo隐藏层数11隐藏层节点数300100100输出层节点数24161初始学习率0.00010.0001学习算法AdamAdam正则化系数ν=0.01ν=0.03小批量数目128256

从表1可以看出,所有训练好的MLP都只有一个隐藏层(与文献[21]一致),但隐藏层节点数较多。继续增加隐藏层数目(即增加神经网络的深度)反而会导致性能下降。

4.4 仿真结果

下面首先采用实测数据集比较三种主动缓存策略与LRU策略的性能,并分析小区数对四种策略的影响,然后评估了在微小区网络中根据局部和全局(覆盖7个微小区的范围)流行度缓存对缓存性能的影响。

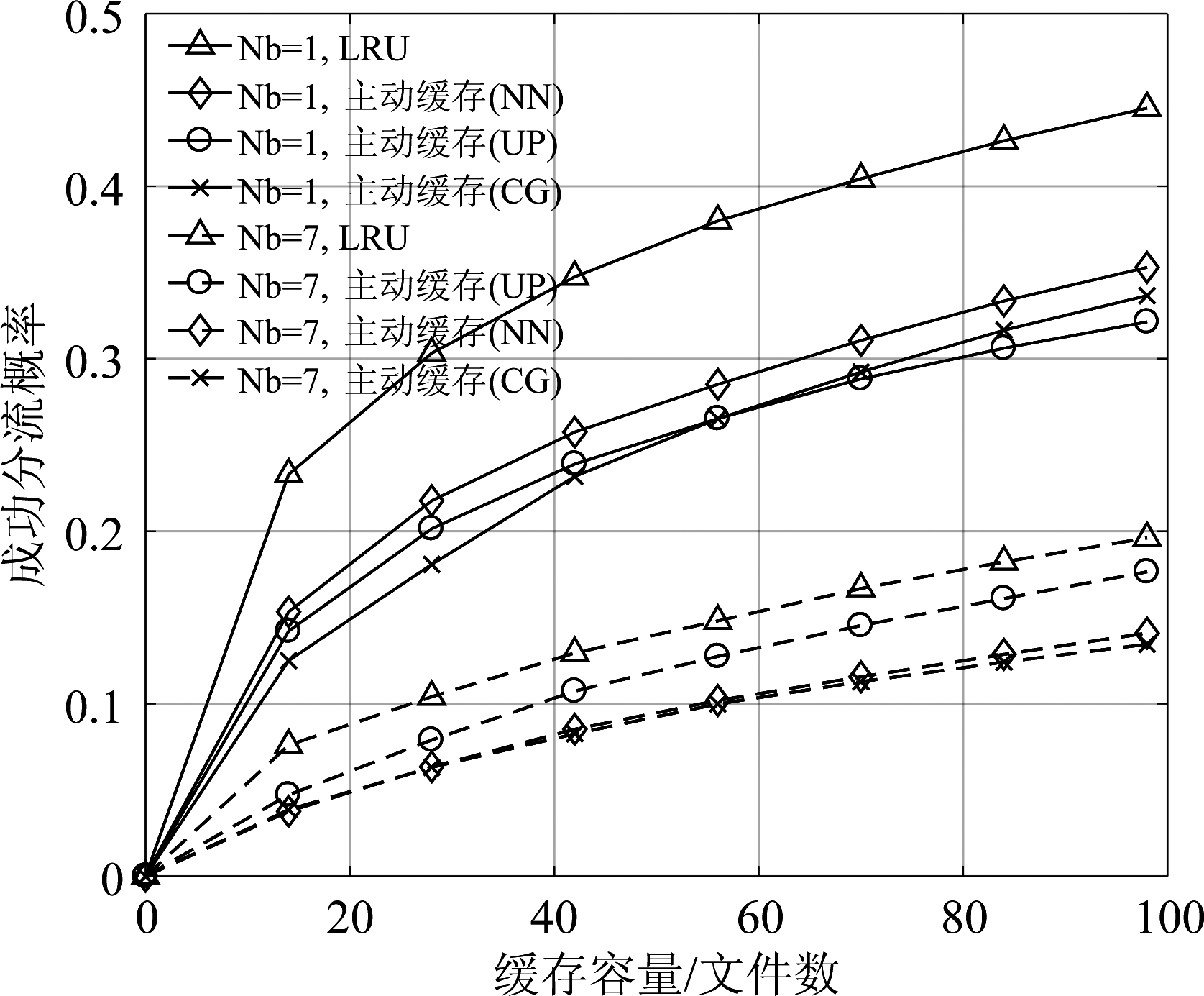

图3(a)给出了部署一个宏小区和1个微小区时不同缓存策略的性能。可以看出,基于神经网络预测局部流行度时主动缓存始终优于基于累计增长方法时的策略,但在微小区网络中两种策略的性能十分接近,这是因为在一个微小区内对文件发出请求的用户少、故对每个文件的请求数都很少,导致神经网络的输入十分稀疏,无法实现更好的预测。在宏小区网络中,基于神经网络预测局部流行度的主动缓存策略性能最好;而在微小区网络中,先预测个人请求概率再合成流行度分布的方法性能优于另外两种预测方法,因为预测个人请求概率时采用一个用户在七个微小区构成的整个区域内的请求历史,降低了神经网络输入的稀疏性。

图3(a) 小区半径的影响

Fig.3(a) Impact of cell radius

图3(b) 局部流行度的影响(Nb=7)

Fig.3(b) Impact of local popularity(Nb=7)

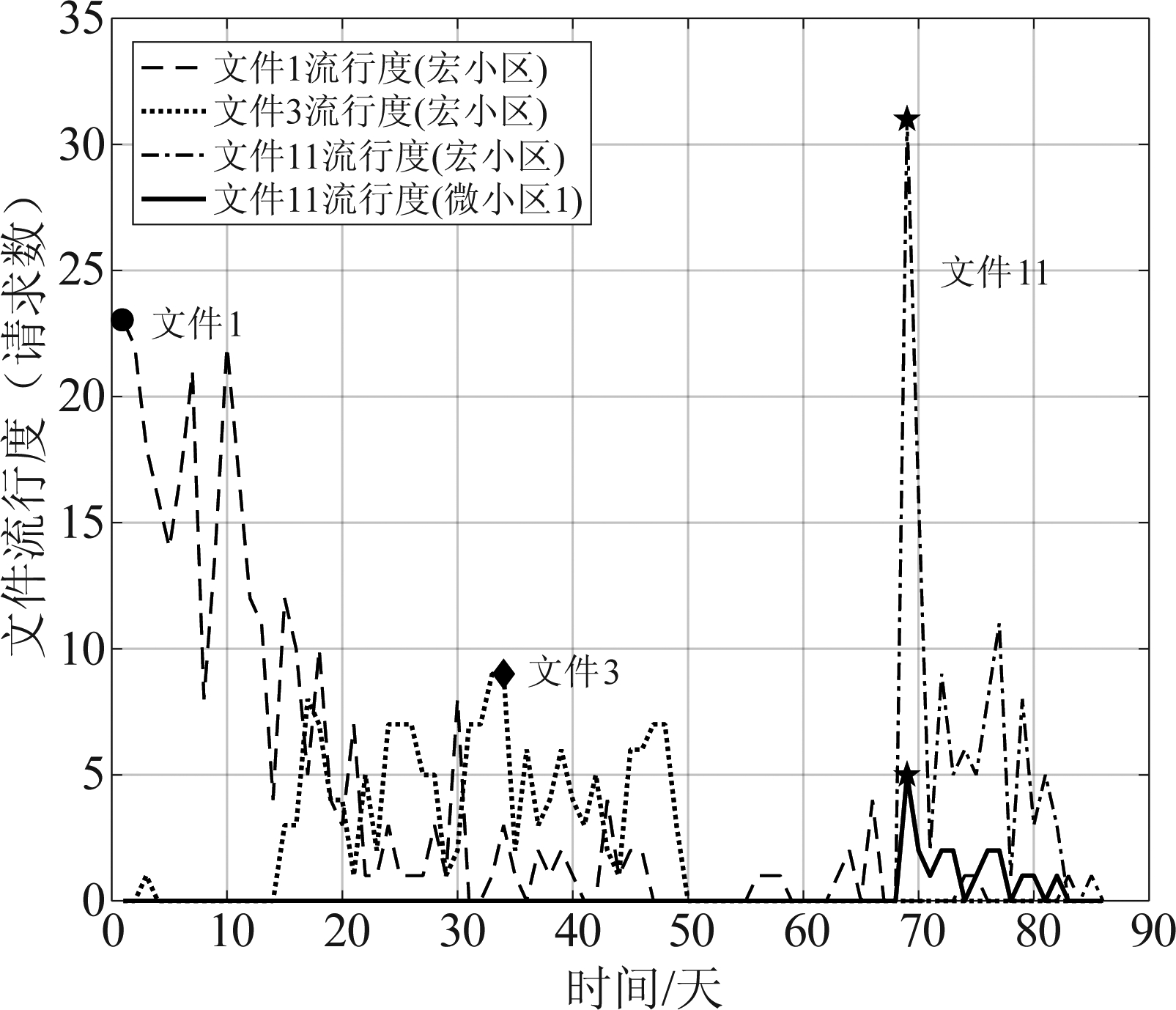

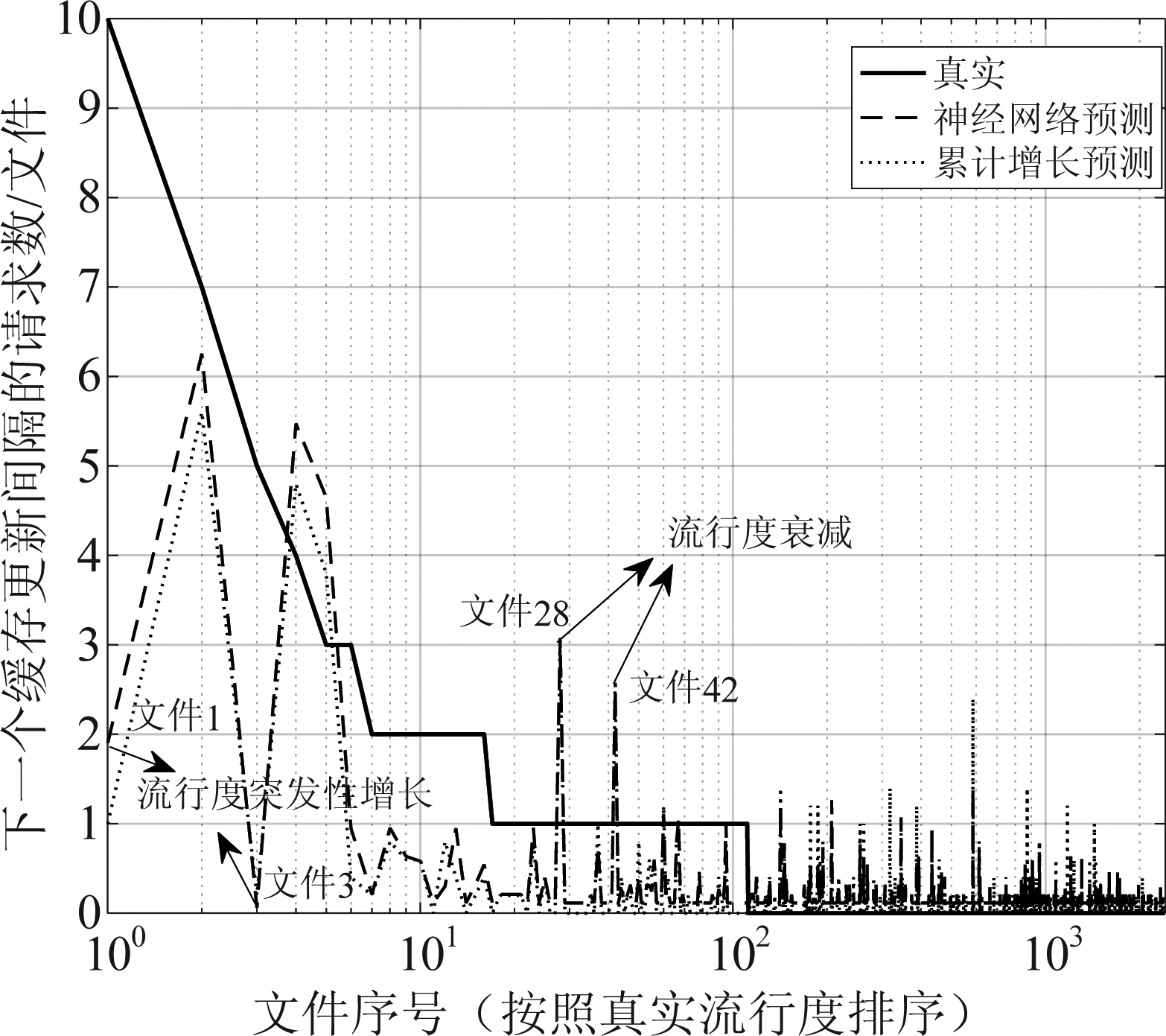

不管是部署宏小区还是微小区,LRU的性能都优于三种主动缓存策略,但在微小区网络中增益较小。我们猜测这是因为在该实测数据集中请求的时间局部性(即一个小区内所有用户对一个文件的请求集中发生在一段较短的时间内[15])很强, LRU能更好地捕捉时间局部性,而由于无线边缘的请求到达率较低,预测用户在下一个缓存间隔内的请求概率或者局部流行度都有很大的不确定性。下面分别通过图4(a)和图4(b)证实上述猜测,其中考虑了实测数据集,且To=5Tu,Tu=12小时。

图4(a) 文件流行度的时变特性

Fig.4(a) Popularity varies over time in the real dataset

图4(b) 文件流行度预测的不确定性(Nb=1)

Fig.4(b) Uncertainty of predicting popularity(Nb=1)

图4(a)给出了该实测数据集中三个流行文件每天被请求的次数随时间的变化规律。观察宏小区的流行度可以看出,这三个文件的请求都具有很强的时间局部性,其中,用户对文件11的请求有很强的猝发性(即用户对一个文件的请求数突发性增长,这可能是多种内在或外在因素导致的,例如,一个电影刚上映[22]。观察该实测数据集可以发现,在最流行的前20个文件中猝发性强的文件占55%)。对于这些很可能是最新上传的文件,很难根据历史请求数据准确预测用户对这些文件的请求概率,因此大大降低了主动缓存的性能。

图4(b)以预测宏小区文件流行度为例,给出了一个更新间隔内2416个文件真实和预测的流行度。可以看出,流行度预测的不确定性非常大,加性误差难以刻画这种不确定性。通过分析发现,预测主要包括以下三个方面的不确定性:1)下一个更新间隔内新到达的文件在观测窗内没有被请求,导致不被缓存,即“漏警”。通过统计测试集中Ttest个更新间隔内的总请求数和“漏警”文件的请求数,发现“漏警”文件的请求数约为总请求数的40%,这意味着即使缓存容量与文件库大小相等,主动缓存策略也只能达到60%的命中率。2)一个过去流行的文件被观测到,但是在下一个缓存更新间隔内没有被请求,即“虚警”,缓存这些文件会造成缓存资源的浪费(图4(b)中文件序号较大的一部分文件虽然没有被请求,但由于预测的流行度较高、很可能被缓存)。3)一个文件在观测窗和下一个更新间隔内都被请求,但是由于一些文件的流行度变化很剧烈,会造成较大的预测误差(如图4(b)的文件1和3,在下一个缓存更新间隔内的请求数发生了突发性增长,神经网络方法预测的相对误差分别为80%和100%),导致流行度的排序发生非常大的改变,当缓存容量较小时,一些流行的文件由于预测的流行度较低可能没有被缓存,如文件3,而一些不流行的文件由于预测的流行度较高可能被缓存,如文件28和文件42。以上三个因素大大降低了主动缓存的性能。为了充分发掘主动缓存的潜力并降低流行度预测不确定性造成的性能损失,混合主动和被动缓存有可能是一种有效的策略,即预留一部分缓存资源被动缓存新到达的文件(即“漏警”文件)或未被主动缓存的文件,其余缓存资源基于预测的流行度主动缓存。考虑宏小区网络,主动缓存策略基于神经网络预测局部流行度,被动缓存策略采用LRU策略。仿真结果表明,混合主动与被动缓存策略明显优于主动缓存策略的性能,当主动和被动缓存的缓存资源分配最优、且被动缓存所有未被主动缓存的文件时,混合缓存的性能优于LRU策略。这是因为预留的被动缓存资源既可以缓存“漏警”文件、又可以缓存未来可能流行的文件,以降低预测不确定性对主动缓存性能的影响。受篇幅的限制,本文没有提供该结果。

从图3(a)还可以发现,当在该区域内部署7个微小区时,与只部署一个宏小区相比,LRU相对于主动缓存的增益明显减小(总缓存容量为98个文件时,相对于“主动缓存(UP)”的增益从39%降低到11%)。这是因为当小区数增加时,每个小区内的请求到达率降低,从图4(a)可以看出,对于本文所考虑的用户请求空间局部性,文件请求的猝发性也随之减弱,如文件11在微小区1请求的猝发性已经大大减弱,从而降低了LRU相对于主动缓存的增益。另外,随着小区数的增加,主动缓存和LRU策略的成功分流概率都随之下降。这是因为在用户就近接入和总缓存容量不变的前提下,当小区数增多时,不同的基站很有可能缓存相同的文件,导致整个区域的缓存效率降低。由于用户发起请求位置的数据是根据Zipf分布合成的,本文也考虑了Zipf分布参数对微小区场景下成功分流概率的影响。仿真结果表明该参数对各种策略的性能影响不大,不会改变不同策略的性能之间的优劣关系。同样,受篇幅的限制,本文没有提供该结果。

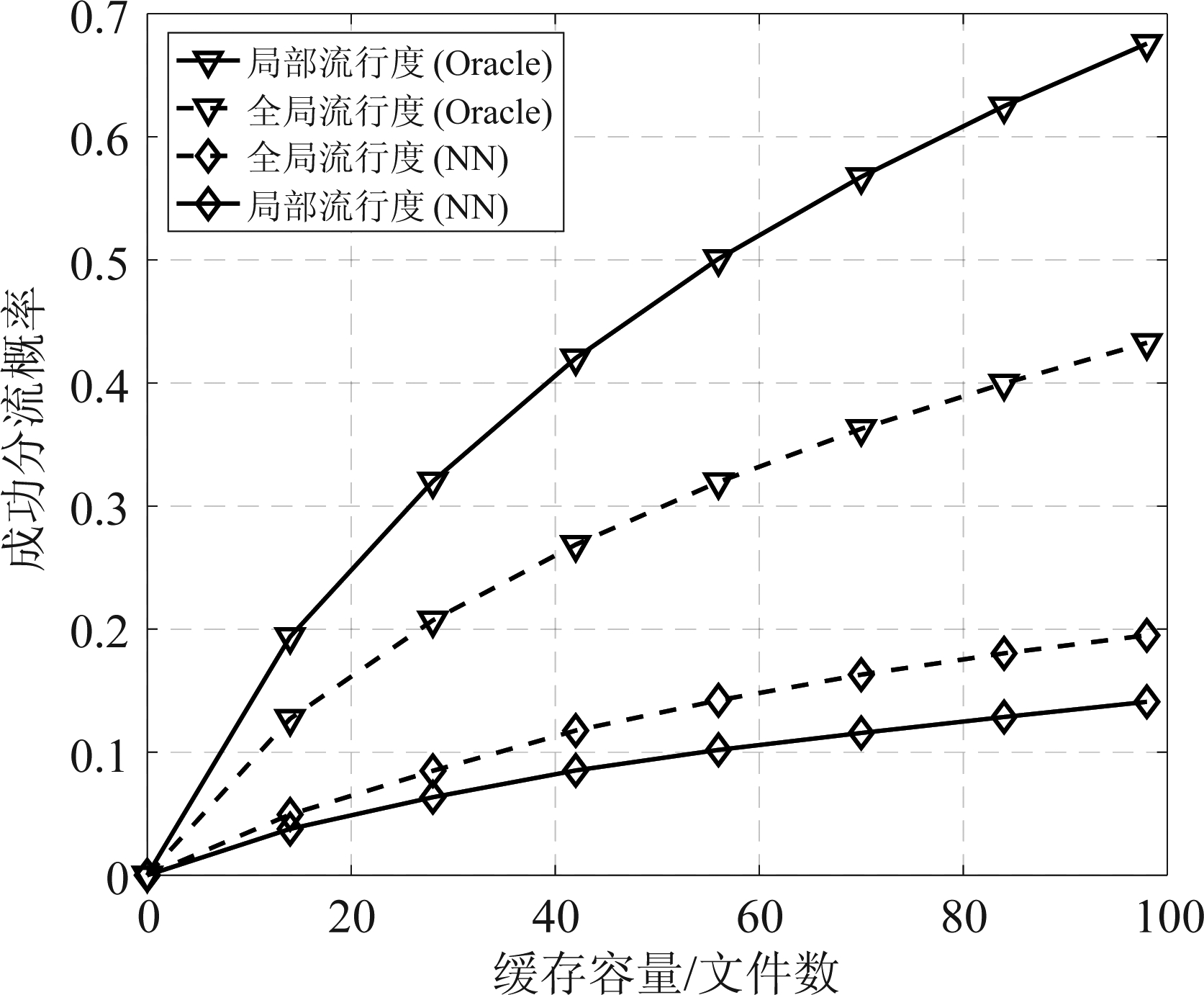

图3(b)给出了在7个微小区网络中,根据预测的局部和全局流行度缓存(以基于神经网络预测流行度的方法为例,图例为“NN”)与根据下个更新间隔内真实的局部和全局流行度缓存(图例为“Oracle”)对缓存性能的影响。可以看出,当不存在预测不确定时,根据真实的局部流行度在各微小区缓存的性能明显优于根据真实的全局流行度在所有微小区缓存相同的最流行文件。这是因为基于局部流行度缓存时考虑到了各微小区流行度的差异性,通过在各微小区缓存不同的文件以实现更优的性能。然而,一旦存在预测不确定性,基于局部流行度缓存的性能更差。这是因为在一个微小区内观测到的请求数远小于在7个微小区内观测到的请求数(经统计发现,在本文采用的预处理后的实测数据集中,平均每个微小区每天仅能观测到43个请求,甚至少于平均每天活跃的文件数(平均每天约138个文件被请求)),造成预测局部流行度相比预测全局流行度存在更大的不确定性,因此,即使根据预测的全局流行度在所有微小区缓存相同的文件,也能实现更优的性能。

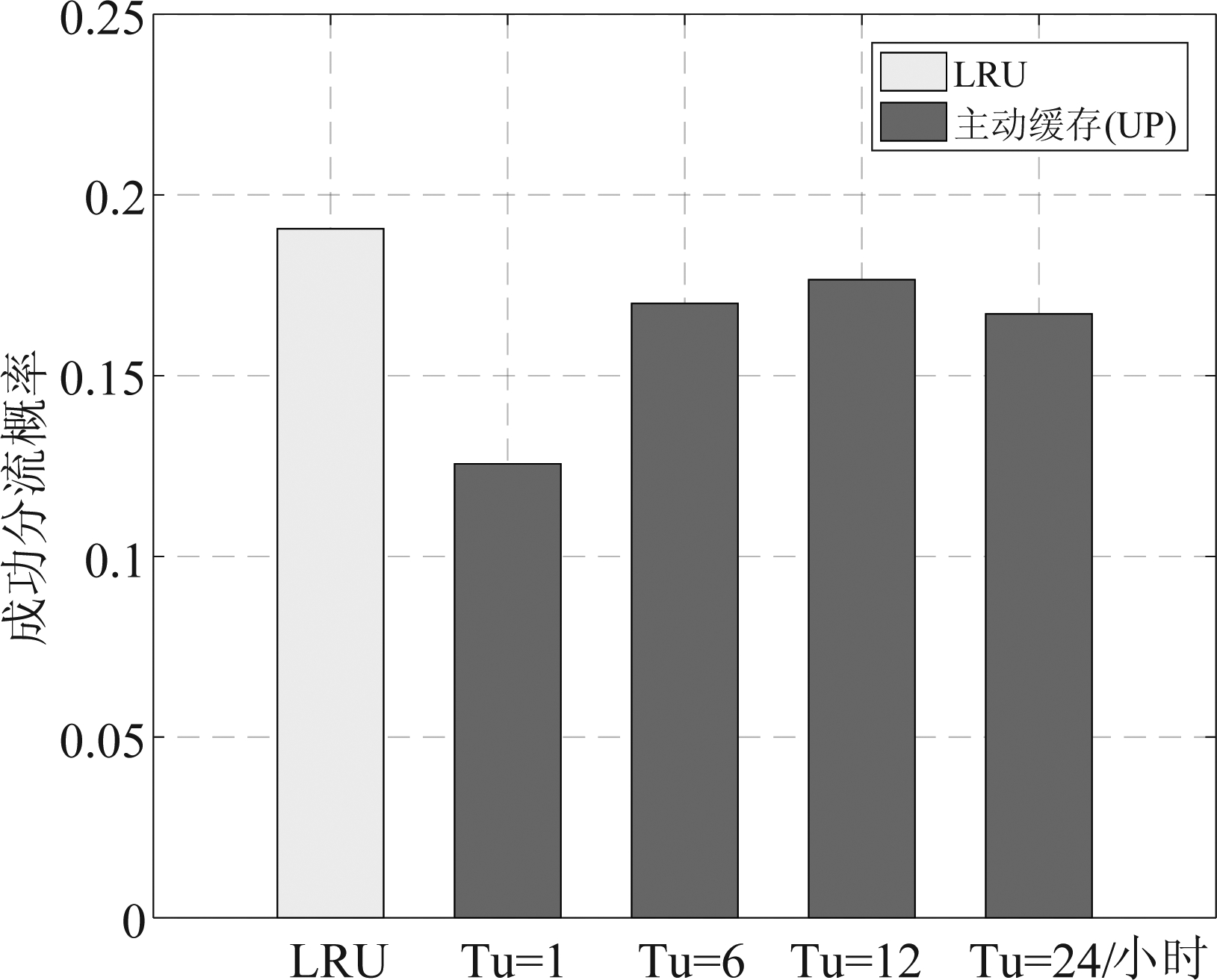

下面分析了在微小区网络中更新间隔和观测窗长度对主动缓存性能的影响。为了更清晰地展示出结果,后续仿真只给出在微小区网络中最好的主动缓存策略(即基于神经网络预测用户请求概率)。

图5给出了主动缓存策略的成功分流概率随更新间隔的变化,并与LRU策略进行比较。可以看出,随着更新间隔的增加,主动缓存策略的性能先增加后减小,更新间隔为12小时时性能最好,但仍略差于LRU策略。这是因为当更新间隔较小时,每个间隔内的总请求数很少,每个训练样本的输入数据更加稀疏,且无法准确估计用户在下一个更新间隔内的请求概率,导致监督训练的标签(期望输出)质量很差;而当更新间隔较大时,主动缓存策略难以捕捉流行度的动态变化,从而导致性能下降。

图5 更新间隔的影响

Fig.5 Impact of update duration

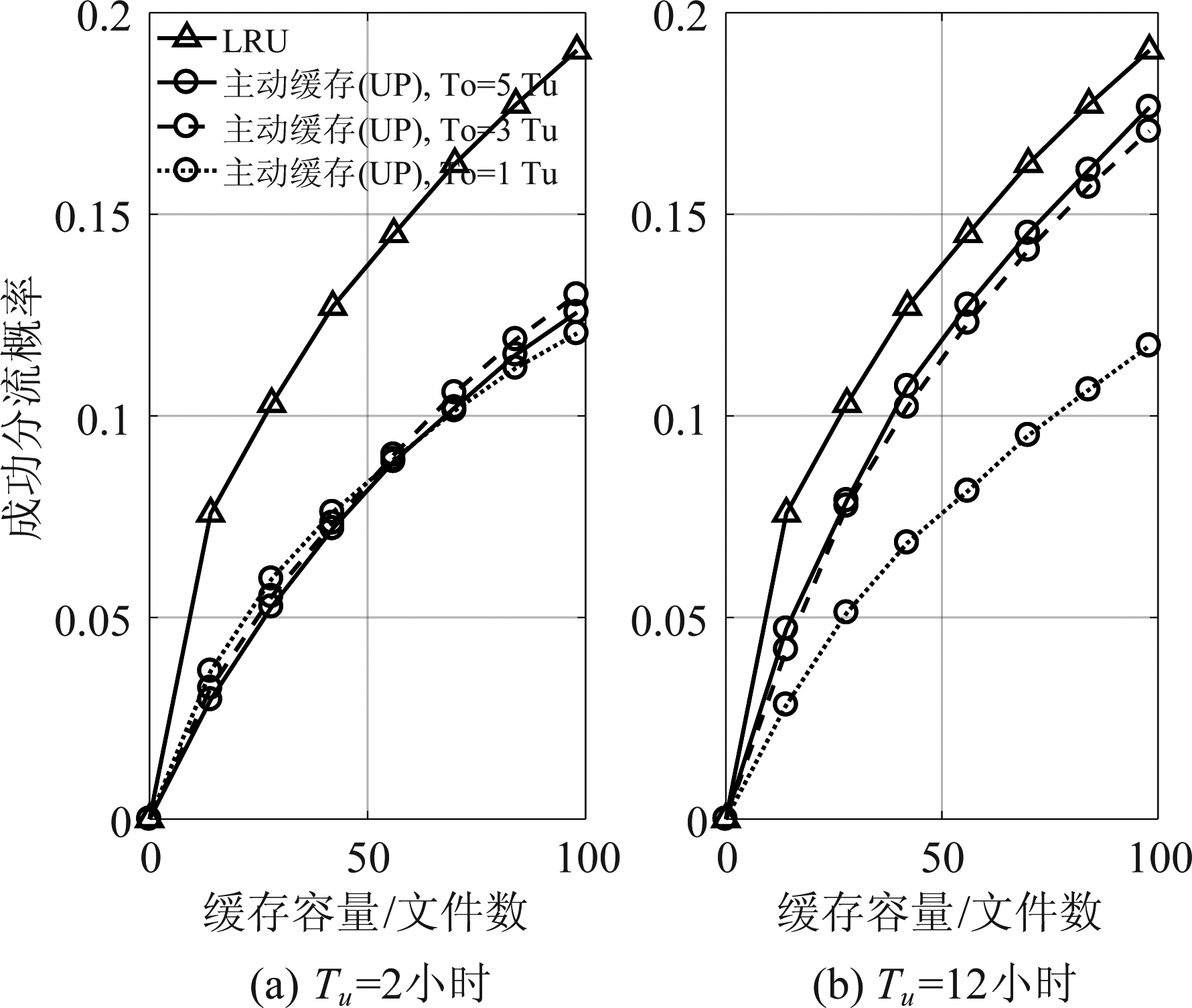

图6(a)和(b)分别给出了当更新间隔不同时观测窗长度的影响。可以看出,当更新间隔较短时(2小时),即使增加观测窗长度,主动缓存的性能也没有提升,这很可能是由于样本的质量较差,即使增加观测的历史数据也难以减小预测的不确定性。相比之下,当更新间隔较大时(12小时),随着观测窗长度的增加,主动缓存的性能逐渐变好,然后收敛。

图6 观测窗长度的影响

Fig.6 Impact of duration of observation window

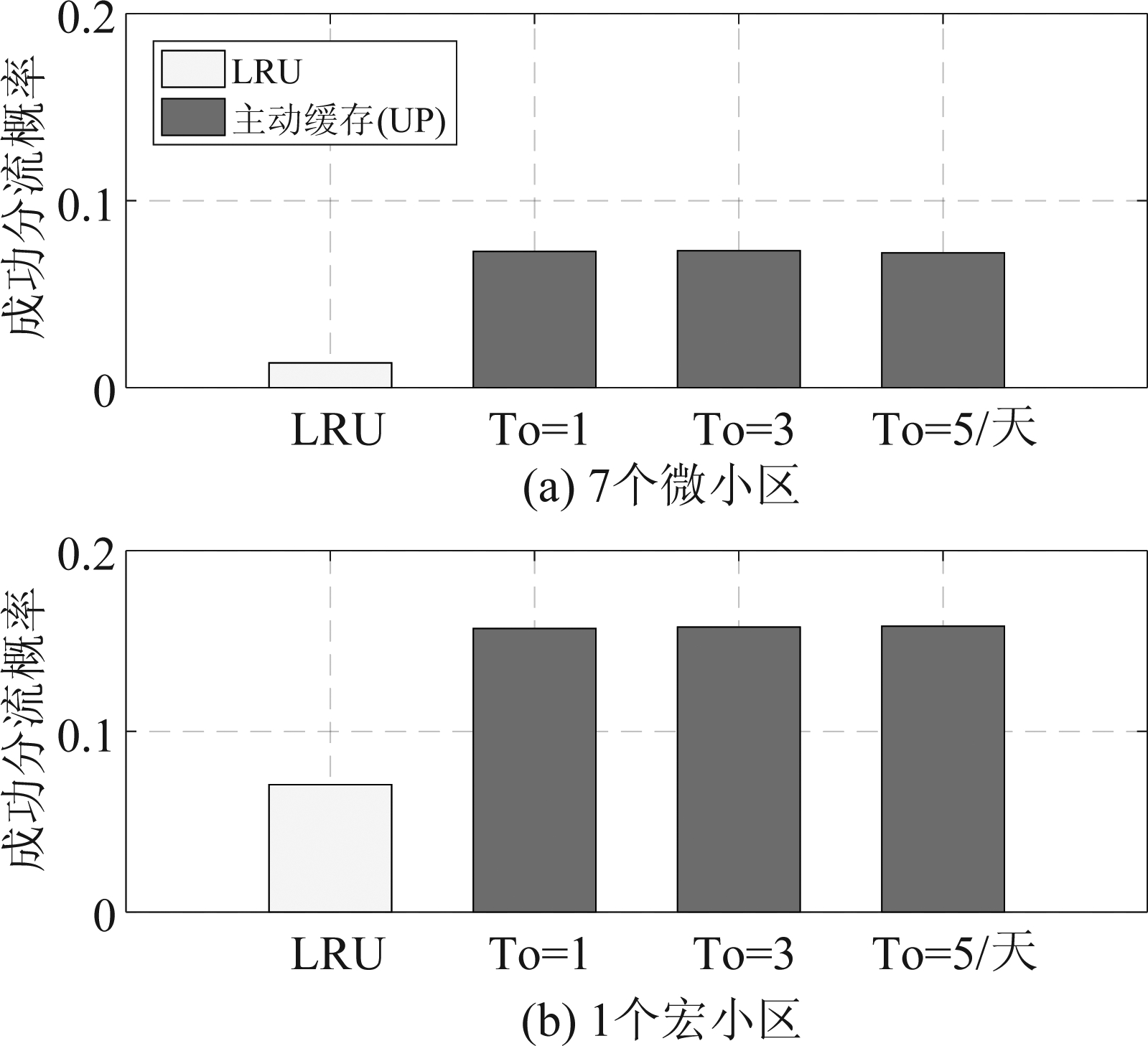

最后比较采用合成的静态数据集时不同网络拓扑下主动缓存与LRU策略的性能。如图7(a)和(b)所示。

图7 两种缓存策略的性能比较(Tu=1天,Nc=98)

Fig.7 Performance comparison of two caching policies(Tu=1 day, Nc=98)

可以看出,当采用合成的静态数据集时,LRU的性能远差于主动缓存的性能(与文献[3-5]一致),这是一方面是因为没有请求的时间局部性,另一方面是因为更容易准确预测用户请求概率。另外,观测窗长度对主动缓存策略的性能影响很小,只观测过去一天的历史请求数据就足以实现较好的性能。

5 结论

本文基于一个在局部区域收集的实测数据集预测了下一个缓存更新间隔内的用户请求概率和局部流行度,并根据预测的用户请求行为在基站端主动缓存以最大化网络的成功分流概率。通过与LRU这种典型的被动缓存策略进行比较,发现基于学习的主动缓存策略的性能劣于LRU,当所考虑区域内部署更多的小区、缓存更新间隔为半天、且观测窗较长时,主动缓存与LRU策略的性能差异减小。通过观察实测数据集中文件流行度的时变特性,发现请求具有很强的时间局部性和猝发性,导致流行度预测的不确定性来源于漏警、虚警以及加性误差三个因素,在不同程度上降低了主动缓存的性能。然而,当考虑合成的静态数据集时,基于学习的主动缓存策略性能明显优于LRU,与已有工作的结论一致。本文的研究结果是在采用多层感知机、基于一个特定的实测视频数据集时得到的。如果采用先进的循环神经网络、基于有视频内容信息、用户年龄等其他更丰富特征的数据集能够有效解决预测流行度时的不确定性,那么主动边缘缓存的性能仍将优于被动缓存。

[1] Zeydan E, Bastug E, Bennis M, et al. Big data caching for networking: Moving from cloud to edge[J]. IEEE Commun. Mag., 2016, 54(9): 36- 42.

[2] Bastug E, Guenego J, Debbah M, et al. Proactive small cell networks[C]∥IEEE ICT, 2013.

[3] Zhong C, Gursoy M C, Velipasalar S, et al. A deep reinforcement learning-based framework for content caching[C]∥IEEE CISS, 2018.

[4] Hou T, Feng G, Qin S, et al. Proactive content caching by exploiting transfer learning for mobile edge computing[C]∥IEEE GLOBECOM, 2017.

[5] Tan Y, Yuan Y, Yang T, et al. Learning-based caching with unknown popularity in wireless video networks[C]∥IEEE VTC, 2017.

[6] Liu D, Yang C. Energy efficiency of downlink networks with caching at base station[J]. IEEE J. Sel. Areas Commun., 2016, 34(4): 907-922.

[7] Calabrese F D, Wang L, Ghadimi E, et al. Learning radio resource management in RANs: Framework, opportunities, and challenges[J]. IEEE Commun. Mag., 2018, 56(9): 138-145.

[8] Chen B, Yang C. Caching policy for cache-enabled D2D communications by learning user preference[J]. IEEE Trans. Commun., 2018, 66(12): 6586- 6601.

[9] Liu D, Yang C. Caching at base stations with heterogeneous user demands and spatial locality[J]. IEEE Trans. Commun., 2019, 67(2): 1554-1569.

[10] 戚凯强, 陈彬强, 杨晨阳. 内容流行分布动态性对基站端缓存性能的影响[J]. 信号处理, 2017, 33(3): 304-313.

Qi Kaiqiang, Chen Binqiang, Yang Chenyang. Impacts of Content Popularity Dynamics on the Performance of Caching at Base Stations[J]. Journal of Signal Processing, 2017, 33(3): 304-313.(in Chinese)

[11] Sadeghi A, Sheikholeslami F, Giannakis G B, et al. Optimal and scalable caching for 5G using reinforcement learning of space-time popularities[J]. IEEE J. Sel. Top. Signal Process., 2018, 12(1): 180-190.

[12] Zhang N, Zheng K, Tao M, et al. Using grouped linear prediction and accelerated reinforcement learning for online content caching[C]∥IEEE ICC, 2018.

[13] Müller S, Atan O, van der Schaar M, et al. Context-aware proactive content caching with service differentiation in wireless networks[J]. IEEE Trans. Wireless Commun., 2017, 16(2): 1024-1036.

[14] Harper F M, Konstan J A. The movielens datasets: History and context[J]. ACM Trans. Interactive Intell. Syst., 2016, 5(4): 19.

[15] Traverso S, Ahmed M, Garetto M, et al. Unravelling the impact of temporal and geographical locality in content caching systems[J]. IEEE Trans. Multimedia, 2015, 17(10): 1839-1854.

[16] Goodfellow I, Bengio Y, Courville A. Deep learning[M]. MIT Press Cambridge, 2016, vol. 1.

[17] Kingma D, Ba J. Adam: A method for stochastic optimization[J]. Computer Science, 2014.

[18] Tatar A, De Amorim M D, Fdida S, et al. A survey on predicting the popularity of web content[J]. Journal of Internet Services and Applications, 2014, 5(1): 8.

[19] Liu W, Han S, Yang C, et al. Energy efficiency comparison of massive MIMO and small cell network[C]∥IEEE GSIP, 2014.

[20] 3rd Generation Partnership Project(3GPP). Further advancements for E-UTRA physical layer aspects[R]. 3GPP TR36.814, Tech. Rep., 2010.

[21] Liu W, Zhang J, Liang Z, et al. Content popularity prediction and caching for ICN: A deep learning approach with SDN[J]. IEEE Access, 2018, 6: 5075-5089.

[22] Crane R, Sornette D. Robust dynamic classes revealed by measuring the response function of a social system[J]. Proc.Natl.Acad.Sci.U.S.A., 2008, 105(41): 15649-15653.