1 引言

人脸关键点检测,又称作人脸对齐,是计算机视觉领域中的经典问题之一。人脸关键点检测的是在给定的一张人脸图片上找到一组预先定义好的关键点,如轮廓、眼睛、嘴巴等。精确的人脸关键点定位是许多其他人脸分析人物的基础,如表情识别,3D人脸重建,姿态估计等任务。人脸关键点检测方法可以分为两大类:参数化的方法和非参数化的方法。其中参数化的方法包含主动形状模型(Active Shape Model, ASM)[1]、主动外观模型(Active Appearance Model, AAM)[2]、基于局部的方法[3-5]、基于全局的方法[6-7]等。非参数化方法则包括基于图模型方法[8-9],基于级联回归的方法[10-11]、基于深度学习的方法[12-14]等。特别是随着深度学习不断的发展,深度神经网络模型在人脸关键点检测中取得了突破性进展。

ASM算法通过一个预先构建好的形状模型来对目标对象进行处理,是一种基于点分布模型(Point Distribution Model, PDM)的算法。该方法先对所有样本形状进行归一化并对齐得到形状特征,接着为每个关键点构建关键点的局部特征,通过关键点的局部特征可以在迭代过程中寻找新的关键点位置。在人脸关键点检测中首先根据人脸的眼睛(或者嘴巴)的位置,进行简单尺度和旋转变化,以达到对齐人脸的目的;然后在对齐人脸后的各个关键点附近进行穷举搜索来匹配人脸上每个局部关键点,根据得到的关键点可以确定人脸初步形状;再根据平均人脸模型对结果进行修正,不断迭代算法直至收敛。这类算法对人脸轮廓形状有着较强的约束力,但是由于最后对每个关键点局部搜索来确定一个较优解是一个穷举过程,从而使得算法的效率较低。级联姿势回归(Cascaded Pose Regression, CPR)[10]是在2010由Dollar等人提出,该方法主要通过一系列回归器将一个指定的初始值进行逐步细化,每一个回归器都依靠前一个回归器的输出来进行调整,从而整个系统可自动的从训练样本中学习。由于每一个回归器学习能力较弱,因而对复杂场景下的关键点检测问题依旧不能很好地解决。

深度学习的发展提供了从大规模标注数据提取关键点特征的方法,从而为关键点检测开辟了新的途径。深度卷积神经网络(Deep Convolutional Network, DCNN)[15]2013年由Sun等提出,是首次将卷积神经网络应用到人脸关键点检测任务中。DCNN也采用级联回归的思想,通过多级联网络从粗到精的逐步得到精确的关键点位置。DCNN通过设计一个三层级联的CNN,来改善之前级联回归算法容易陷入局部最优解的问题。同时由于整个任务采用卷积神经网络来完成,抛弃了之前手动设计特征的方法。通过利用卷积神经网络强大的特征提取能力来自动提取人脸图片中的关键点特征。但是由于整个网络直接回归关键点坐标,会使得网络在精度达到一定程度后,无法更好的更新网络参数以获得更好的结果。Hourglass于2017年提出的Hourglass(stacked Hourglass networks for human pose estimation, Hourglass)人脸关键点检测模型[16],不仅可以通过利用2D关键点数据训练2D关键点检测模型,也可以把2D关键点标注数据转为3D数据训练3D关键点检测模型。Hourglass模型包含大量重复的网络结构,导致网络复杂,实际运行效率较低。2018年提出的SBR模型(Supervision-by-Registration, SBR)[17]是卷积姿态机(Convolutional Pose Machines, CPM)模型基础上提出的,能够利用无监督的方式来增强现有的人脸关键点检测算法。SBR实现这一方法的主要背景是基于人脸在实际视频中运动过程较为平滑,不会出现大幅度跳动的情形这一特性来实现对现有的人脸关键点检测算法的增强。相比较其他人脸关键点检测算法来提升性能多数以增大标注数据集规模的方法,SBR不需要提供任何额外的人工标注数据,通过人脸运动平滑的特性就能提升检测器的性能,尤其对视频中人脸关键点检测的稳定性要有很大提升。但是整个网络基于的基础网络结构复杂冗余,使得对算法分析验证变得十分困难。

本文针对目前Hourglass、CPM、SBR这些目前人脸关键点检测深度神经网络模型存在的结构设计上的问题,给出一个新的基于热力图回归的关键点检测网络框架。该关键点检测框架结构简单清晰,并且通过引入全局约束,对人脸关键点检测任务十分有效。实验结果显示,使用本文的精简框架能够在300-W数据集上得到比[16]和[17]等主流方法更好的结果。

2 数据与背景

2.1 人脸关键点检测数据描述

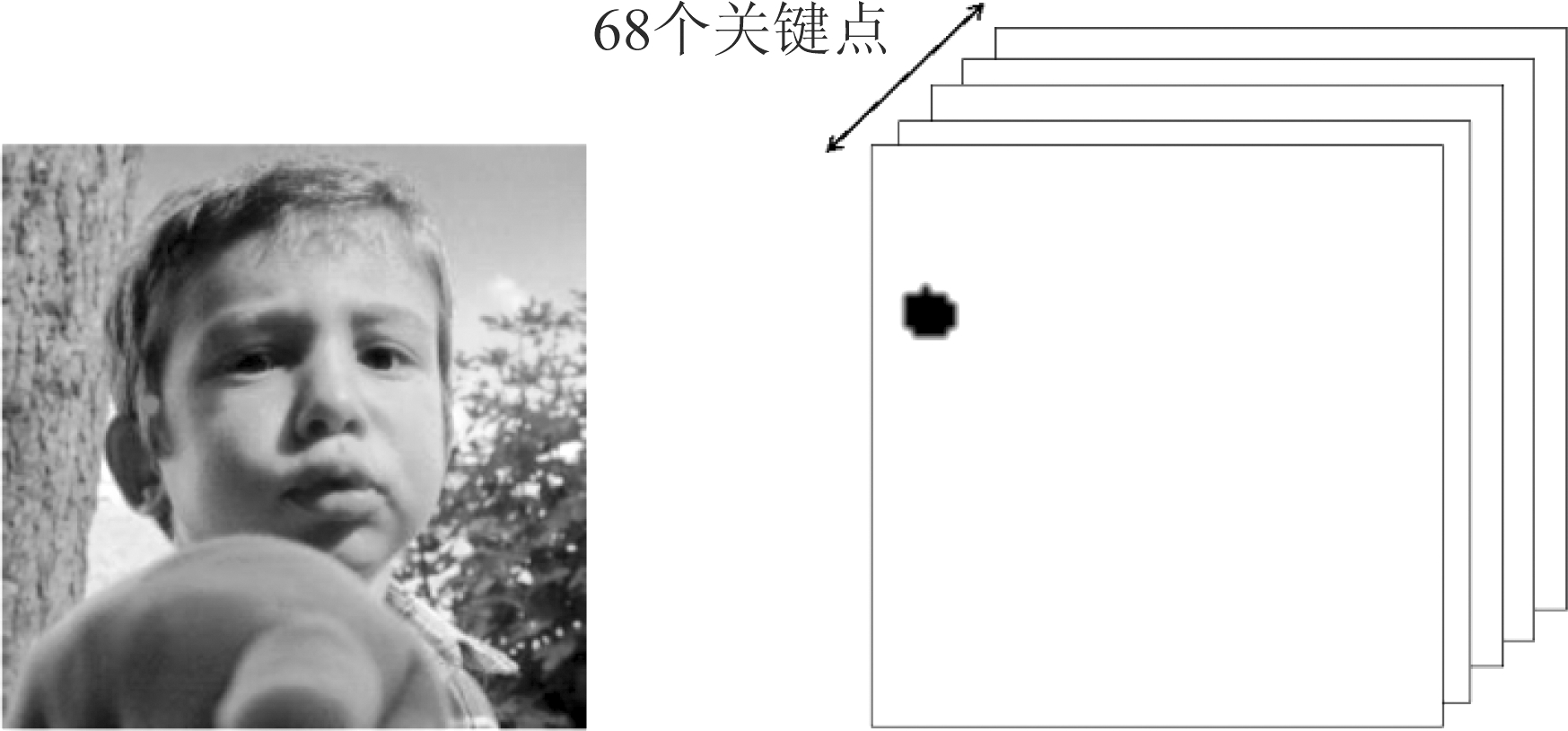

本文试验使用最具代表性的300-W(300 Faces-in-the-Wild)[18]数据集,主要包括室内和室外两类数据,其中图像均来源于其他数据集,包括LFPW、AFW、Helen、XM2VTS 和IBUG数据集。由于300-W数据集标注质量较高,并且是由多种数据集的测试集组合,整个数据集,对现有的人脸关键点检测算法具有很好地检验能力。300-W每个数据集样本都包含了68个关键点,如图1所示。

图1 300-W数据集68个关键点位置

Fig.1 68 key face points in 300-W data set

一般都将300-W数据集分成训练集和测试集两部分。整个训练集包括AFW(337张),LFPW训练集(811张)和Helen训练集(2000张)数据集,总共3184张图片,测试集则包括LFPW测试集(224张)、Helen的测试集(330张)以及IBUG数据集(135张),总计689张图片。整个测试集中包含各种背景、光照、图像质量等不同场景下的数据,其中IBUG数据由于在各种场景下都变化较大,所以测试集中又将IBUG数据集划分为Hard Subset,剩下的LFPW和Helen在一起的554张数据集则划分为Common Subset,整个测试集则称作Full set,后续实验部分也将分别对Common Subset、Hard Subset和Full Set进行测试分析。

2.2 人脸关键点检测问题描述

现在人脸关键点估计问题主要都是考虑在非受限条件下的关键点定位,即随机给定一张包含人脸的图片,通过一定的方法从中找到预先定义的人脸关键点坐标,其中人脸眼角、鼻尖、嘴角等是常见关键点。不同的任务往往对关键点数目需求不同,不同位置关键点的个数也有着不同的需求,如现在常用的人脸动画生成、人脸美妆、人脸换脸等操作仅仅只靠眼角、鼻尖和嘴角几个点往往不够,因此出现了一些定义更详细的关键点和数据集,主要包括:眉毛、眼镜、鼻子、嘴巴和轮廓几个部分,不同数据集对这几个部分定义点也不同。

下面人脸关键点检测的形式化描述:通常我们用k表示人脸关键点个数,那么k个关键点对应的坐标向量可以由式S=[x1,y1,x2,y2,…,xk,yk]T R2k表示。其中p=[xi,yi]T表示第i个人脸关键点坐标,且1≤i≤k。因此在训练模型时需要给定一张人脸,以及这张人脸的关键点真实标定标签S,训练好模型后,模型输出预测值S*。因此整个网络的目标就是尽量使得网络输出S*接近真实标定标签S,即最小化‖S*-S‖。

R2k表示。其中p=[xi,yi]T表示第i个人脸关键点坐标,且1≤i≤k。因此在训练模型时需要给定一张人脸,以及这张人脸的关键点真实标定标签S,训练好模型后,模型输出预测值S*。因此整个网络的目标就是尽量使得网络输出S*接近真实标定标签S,即最小化‖S*-S‖。

2.3 热力图的生成

整个网络通过训练来回归人脸关键点位置,但是所采用的回归方式与DCNN[15]等网络结构直接回归关键点坐标(x,y)不同,本文所采取的是利用深度学习中基于热力图(Heatmap)的人脸关键点回归方案,与热力图类似的是显著图,但是显著图描述的图像中每个像素点与周围像素的差异,差异越多,显著值越高,而热力图则描述的是关键点在每个位置上的置信度,因而两者分别适用不同的任务。通过关键点自身回归人脸关键点而不是直接回归人脸关键点坐标位置主要有两个优势:

(1)通过热力图回归可以理解整个关键点回归的过程,同时也可以可视化整个网络的“思考过程”。

(2)整个网络设计使得网络的输出是多模态的,允许多个空间位置都有一定的置信度,从而使学习更加容易。

在训练的过程中,一开始网络可能会对每个关键点输出多个位置,随着训练过程的进行,不正确位置的置信度会逐渐降低,最终只有一个最大响应度的位置得以输出。相反如果直接网络输出关键点位置,如果预测结果接近真实值,那么网络的输出与真实值直接的损失就很很小。文献[19]中指出直接回归关键点坐标是一个非线性问题,学习映射要更加困难。文献[20]也证实了回归关键点的热力图要比直接回归网络值要简单很多。

每个人脸关键点都包括一个热力图作为真实标签,训练好的网络则输出一个预测的热力图。对于300-W数据集,整个网络的输出是一个固定尺寸i*j*k的立方体,其中i=64, j=64,k=68。在训练过程中,每个关键点真实标签是一个热力图,其中热力图是在一张全0的64*64初始化热力图T,然后在T上以这个关键点位置为中心,以σ为方差放置二维高斯分布的数值生成的,具体生成过程如图2所示。

图2 热力图生成

Fig.2 Generation of heat map

整个训练样本定义为(X,y),其中y代表图片X的k个关键点。给定数据集N={X,y}以及网络的回归输出Ø,从而得到整个的训练目标为式(1)。

argmin∑(X,y)∈N∑i, j,k‖Gi, j,k(yk)-Øi, j,k(X,λ)‖2

(1)

其中λ为整个网络需要更新的权重,![]() 是用于在每个关键点yk生成热力图的二维高斯函数,其中本文中用到的σ=1。

是用于在每个关键点yk生成热力图的二维高斯函数,其中本文中用到的σ=1。

3 引入全局约束的精简人脸关键点检测网络

3.1 精简人脸关键点检测网络

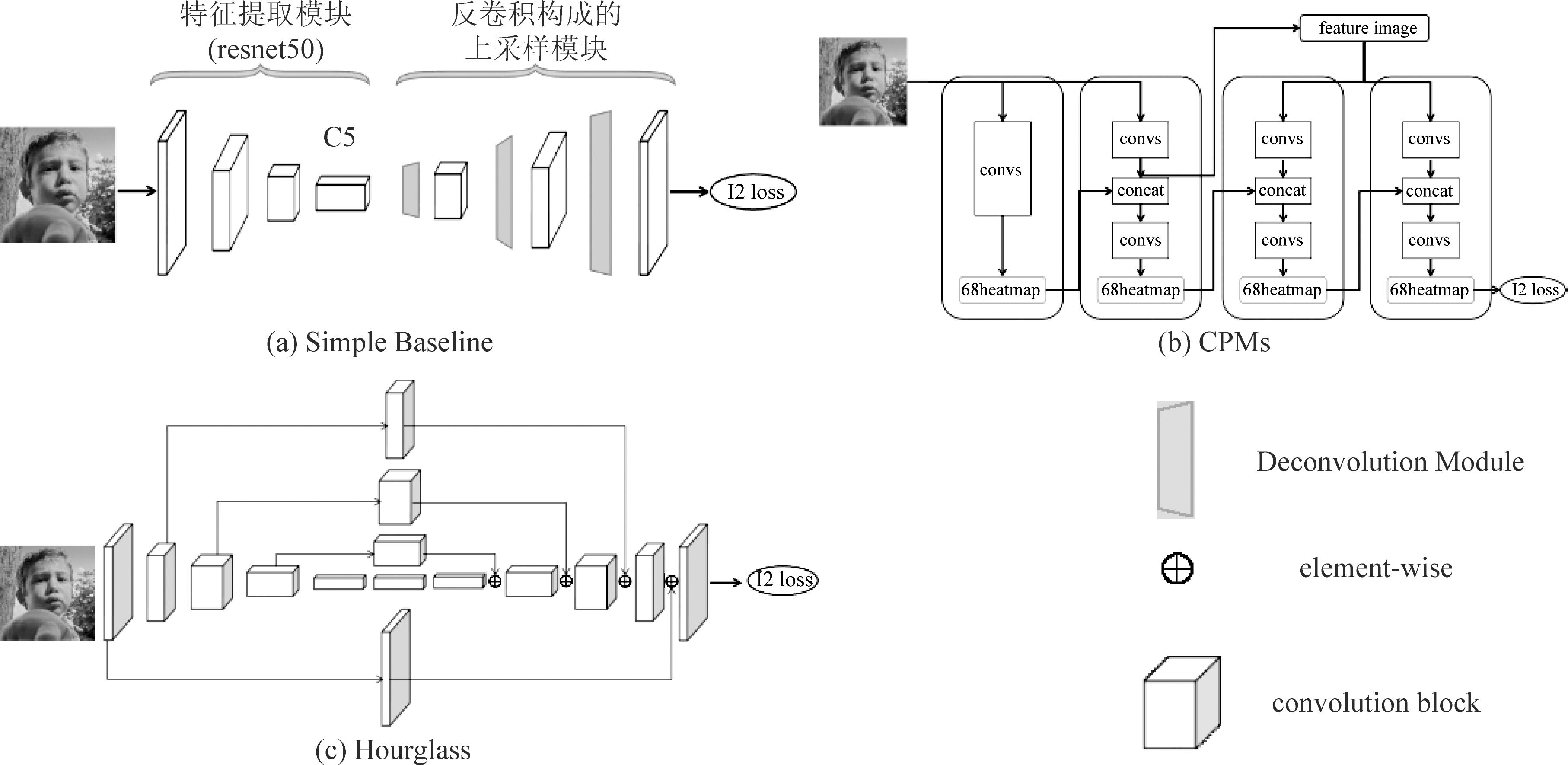

本文采用了一种原来用于人体姿态估计和跟踪的新网络结构Simple Baseline(Simple baselines for Human Pose Estimation and Tracking)[21]。这个网络结构相对于目前主流基于热力图的关键点网络结构,整个网络只包含特征提取模块和上采样模块两个网络。特征提取模块主要用于对输入图像进行特征提取,可以基于Resnet,VGG等分类网。上采样模块则只包含几层反卷积层操作来对特征提取模块输出的特征图进行放大,其中采用的反卷积层的个数主要有特征提取层对图像下采样的倍数来确定,算法中使用的反卷积层的卷积核大小为2*2。整个网络结构只包含两个部分,网络结构如图3中(a)所示。

整个网络结构相对于之前网络结构,不存在多个阶段网络结构进行叠加,从而达到对之前复杂的关键点检测网络结构的简化。Resnet50网络结构作为基础特征提取网络,同时对Resent50中的残差单元进行改进,替换为IR单元[22]。同时网络的输入多了一个注意力图(attention map)作为约束,输出多了一个预测的注意力图,通过对注意力图来进行整体人脸关键点约束。为了展现Simple baseline的简单简洁,我们把主流的关键点检测网络CPMs和Hourglass与Simple baseline三个网络结构进行统一对比,三个网络结构的对比图如图3所示。

图3 三个网络结构的对比

Fig.3 Three networks

根据图3中的网络结构,对比分析可以发现Hourglass和CPMs网络结构都太过复杂冗余,包含了重复模块,导致网络实际参数量过大,从而在实际训练过程中速度都过慢。通过增大网络参数与复杂度来提升检测精度,整个模型往往对硬件资源要求较高,效率也变低。其中CPMs与Hourglass由于都使用了多阶段的重复网络结构进行特征提取,整个网络变深,实际训练过程中往往容易出现梯度消失问题,为此训练网络过程中需要加入多阶段特征融合与中间监督的方法,以使得网络梯度消失问题得到缓解。

相反,Simple baseline网络只简单的包含了特征提取和上采样结构,整体要更加精简。其中特征提取模块可以采样VGG,Resnet等结构,本文如不做特别说明,所有实验默认基于Resnet50网络结构。利用特征提取模块后,Resnet50中C5模块最后的输出特征图相对输入缩小64倍,因此网络需要进行3次上采样,每次放大4倍,使得最终网络输出的热力图与真实标签一致,其中上采样方法可以采用双线性差值、反卷积等常用方法,本文试验过程中采用的上采样方式和Simple baseline作者采用相同的方式,利用三个反卷积层进行特征提取,每个反卷积的卷积核大小为2*2,在得到最终网络的输出后,引入一个均方误差(mean-square error, MSE),即L2 Loss。通过L2 Loss计算出真实值与预测值的差值后,利用反向传播(Back Propagation, BP)算法进行梯度回传。整个网络经过一定次数的迭代后,网络特征提取层能够提取到符合要求的特征,整个网络输出的热力图与真实热力图趋向一致。可以看出相对于CPMs,Hourglass两个网络,Simple baseline的网络结构只包括一个阶段,同时也只包含两个模块:特征提取与上采样。整个网络结构更加简单,参数量也更少,因此在实际使用过程中的速度也要相对更快。

3.2 全局约束

基于卷积神经网络的人脸关键点检测任务都只利用了卷积神经网络进行特征提取,并根据提取的特征来做基于热力图回归的人脸关键点检测。但是这种网络结构都没有考虑到人脸关键点检测任务中关键点之间具有的特殊空间结构关系。由于视觉注意模型(attention model)对于图像理解有很好的作用,因此它在图像分类[23],显着性检测[24],人体姿势估计[25]中取得了巨大成功。本文针对人脸关键点彼此之间具有相互约束,整体具有全局性,从而在整个网络基础上加入一个全局约束的注意力图。通过注意力图对整个人脸关键点检测网络进行约束,以使得整个网络输出结果更加符合人脸分布,减少离群关键点的产生。

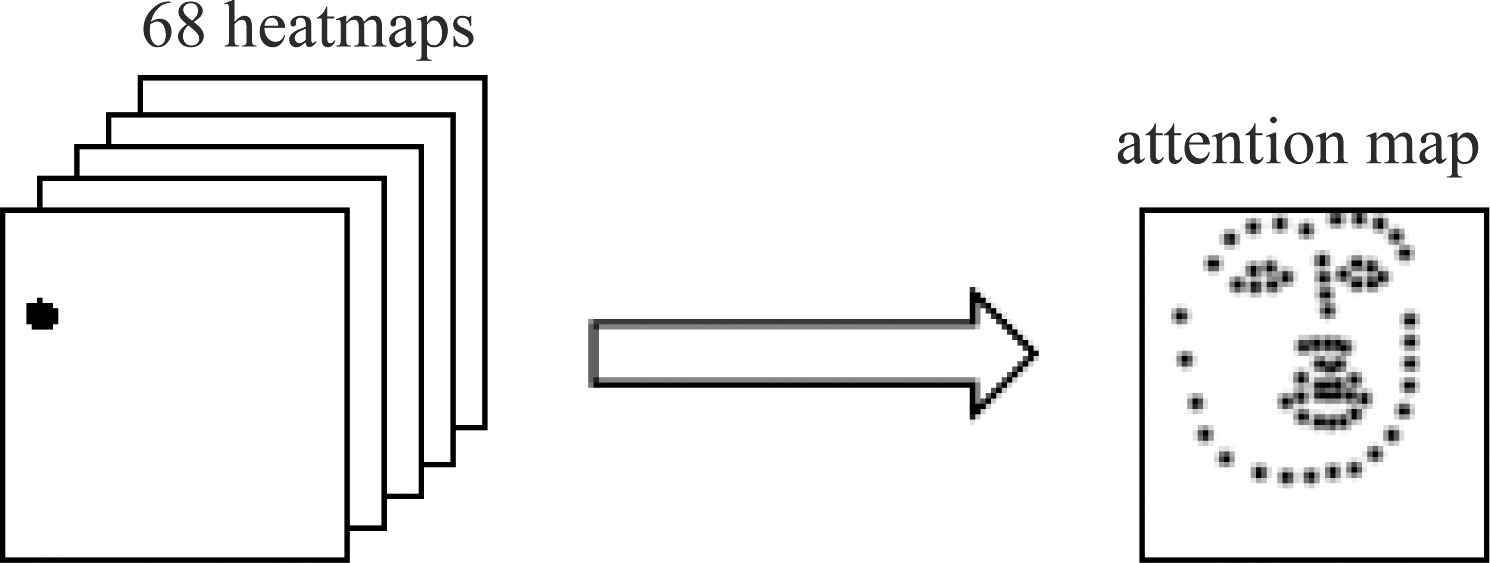

首先根据真实标注得到人脸68个人脸关键点对应的68张热力图后,再根据得到的68个热力图生成一张全局约束注意力图。这样做的策略是为了通过在一张热力图上面包含所有的人脸关键点,通过这张包含所有关键点的热力图作为网络的一个输出,来对网络施加所有人脸关键点分布的约束,而不是之前整个网络输出只是单独回归每个关键点,而没有考虑到人脸关键点分布的整体性。通过加入整张人脸所有关键点的约束,从而使得网络输出更具有整体性。其中全局约束注意力图的生成策略如图4所示。

图4 全局约束注意力图生成

Fig.4 Generation of global attention map

整个生成过程首先生成一个全零的的热力图,然后遍历68个64*64的热力图,在每个位置上取68个热力图中对应位置中的最大值赋予注意力图的对应位置上,从而得到整个注意力图。最终整个网络的输出由原来的64*64*68改为64*64*69。

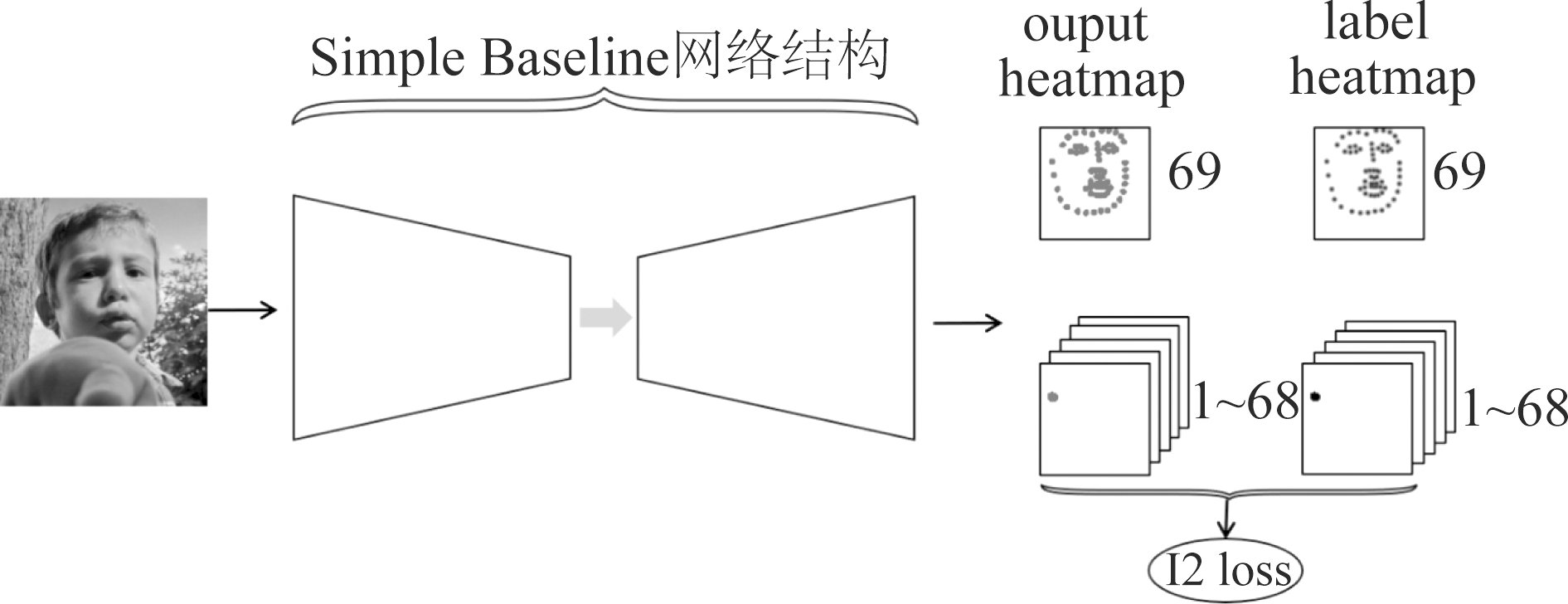

3.3 网络实现

整个网络训练包括输入人脸图片和标注过的关键点标签,其中关键点标签包括人脸68个关键点的热力图,以及68个关键点在一起得到注意力图。输入图片经过Simple Baseline的网络结构,其中Simple Baseline网络结构包括特征提取模块和上采样模块,特征提取模块主要包括IR单元,上采样模块则利用反卷积来放大特征图。最终网络的输出是69个热力图,其中1~68个热力图对应每个关键点,第69个是全局注意力图。整个网络结构如图5所示。

图5 引入全局约束的Simple Baseline网络结构

Fig.5 Single baseline network with global spatial constraint

4 实验结果

4.1 实验设置

所有的训练图片都根据300-W数据集提供的真实标注确定人脸中心点以及对应的人脸长宽来裁剪出人脸,再统一缩放到256*256大小。由于整个300-W数据集中训练集只有3148个样本,对于训练4个stage的Hourglass或者Resnet50这种大卷积神经网络远远不够,其他论文中往往会使用其他非公开数据集或者是一些公开的5点和29关键点数据集。由于本文只使用了300-W数据集,因此采用了多种数据增强对整个训练集进行扩充。数据增强方式主要包括:随机旋转,左右翻转,颜色噪声,模糊等方法。通过数据增强能够使得整个神经网络对于各种条件下的人脸图片处理有着更好的适应性,增强了模型的鲁棒性。得到数据增强后的图片数据后,在输入网络前,会对数据进行减均值除方差的白化操作,其中RGB三通道均值分别设置的是mean=[0.485,0.456,0.406],对应的方差分别是std=[0.229,0.224,0.225]。

本文神经网络的优化器选择Rmsprop,由于显存限制以及Hourglass模型参数过多的问题,整个训练集的batchsize设置为8,验证集的batchsize设置为8。整个迭代轮数为200,分别在120和160轮迭代后对网络的学习率降低10倍,网络初始学习率为0.0005。

4.2 测试分析

分别利用Hourglass,Simple Baseline网络结构训练300-W数据集,并分别在划分的测试集上进行测试,得到的实验结果与其他论文中实验结果比较如表1所示,其中表中结果都是根据归一化平均误差(Normalized Mean Error, NME)进行对比,其中NME的定义如式(2)。

(2)

其中x代表人脸的真实关键点,y代表网络预测值,d是两个外部眼角点的欧式距离,即图1中37号点和46号点之间的欧式距离。

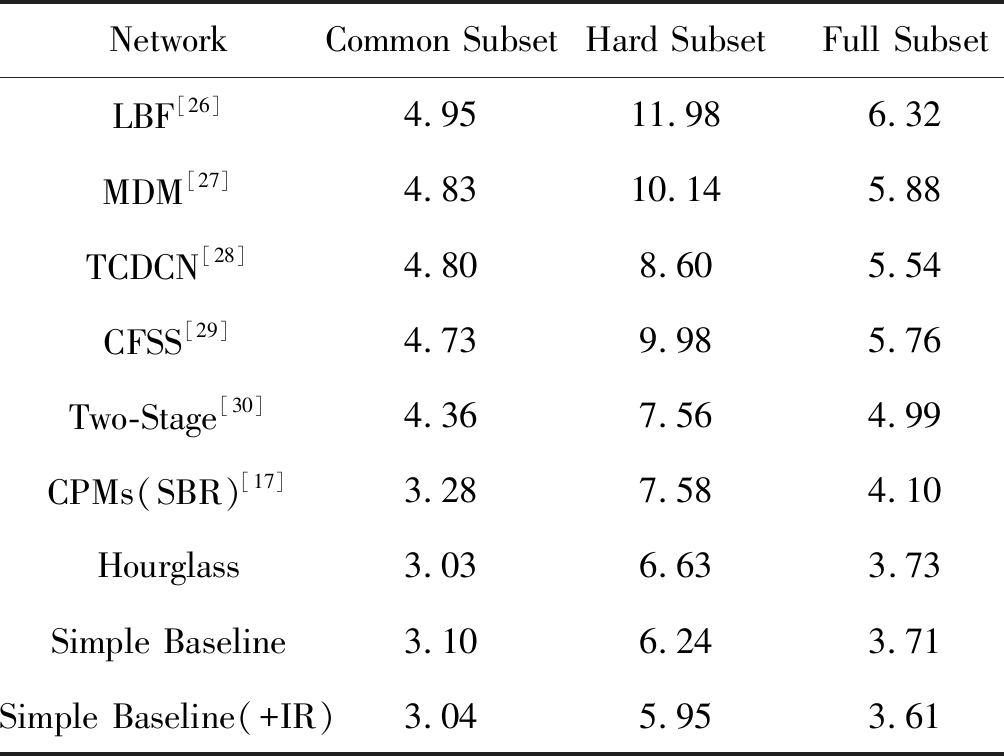

可以发现,无论是基于传统方法LBF[26],MDM[27],TCDCN[28],还是基于深度学习直接回归坐标的方法Two-Stage [30],相比于基于热力图的三种网络结构CPMs(SBR)[17]、Hourglass和Simple Baseline的结果都要差很多。基于Hourglass网络模型的输出在Common Subset上得到了最好的结果3.03。而我们的Simple Baseline网络模型在Hard Subset和Full Subset上都取得了最优结果,分别是5.95和3.61。而基于CPMs模型的SBR相对结果则要差很多,与最优结果相比,分别在Common Subset、Hard Subset和Full Subset差了0.25、1.63和0.49。因此基于热力图回归方式的人脸关键点检测要远远优于传统建模方法和基于卷积神经网络直接回归的方法。其中相较于Hourglass与CPMs两个网络结构,Simple Baseline在300-W数据集上都取得了领先或者是较好的结果,从而表明Simple Baseline这种简单的网络结构设计与复杂冗余的Hourglass、CPMs相比能够取得更好的结果,在对Resnet50中残差单元进行替换后能够取得更好的结果。

表1 300-W时上测试集NME结果(%)

Tab.1 NME in 300-W data set

NetworkCommon SubsetHard SubsetFull SubsetLBF[26]4.9511.986.32MDM[27]4.8310.145.88TCDCN[28]4.808.605.54CFSS[29]4.739.985.76Two-Stage[30]4.367.564.99CPMs(SBR)[17]3.287.584.10Hourglass3.036.633.73Simple Baseline3.106.243.71Simple Baseline(+IR)3.045.953.61

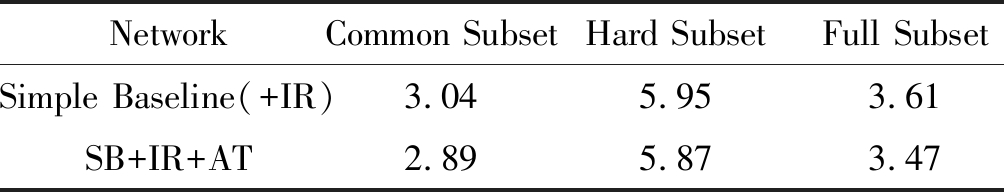

表2 引入全局约束后300-W测试集上NME(%)

Tab.2 NME in 300-W data set with and without global constraint

NetworkCommon SubsetHard SubsetFull SubsetSimple Baseline(+IR)3.045.953.61SB+IR+AT2.895.873.47

为了验证加入3.2章节中提出的全局约束在人脸关键点检测任务上的有效性,本部分同样在300-W数据集上进行了试验,结果如表2所示,本文的方法记做SB+IR+AT,本文提出的方法在300-W测试集Common Subset上的NME取得了最小值2.89,Hard Subset上取得了最小值5.87,同时在整个Full Subset上取得了最优结果3.47。从而可以验证了加入全局约束的必要性。

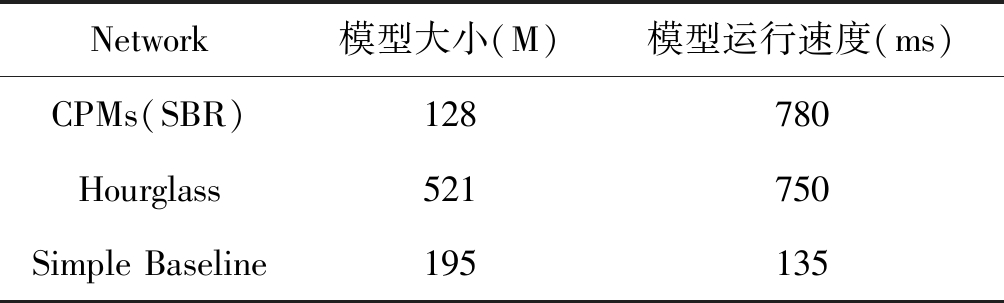

表1和表2结果对比了网络输出结果的有效性,为了验证Simple Baseline的效率,对CPMs(SBR),Hourglass和Simple Baseline三个模型大小与速度进行了测试,测试结果如表3所示。

表3 三个模型大小与速度对比

Tab.3 Running times of three different models

Network模型大小(M)模型运行速度(ms)CPMs(SBR)128780Hourglass521750Simple Baseline195135

整个测试环境是基于GPU NVIDIA-1080(8G),CPU Inter E5-2620,内存16G。从表中可以发现基于Simple Baseline的网络结构速度要远快于其他两个多阶段网络结构,只占了不到1/5。其中CPMs(SBR)网络大小要小于其他两个网络的原因是由于作者开源代码里面运行的热力图大小为32*32,相较于64*64的热力图参数量要大大减少。如果CPMs(SBR)采用同样的64*64热力图整个模型大小会迅速变大,模型速度也将更慢。由此可见本文采用的基于Simple Baseline的人脸关键点检测网络,不仅在模型结构对比中要更精简,实际运行速度与模型大小也要更小,整个网络在测试集上也取得了对比方法中的最好结果,从而证明了本文提出的算法有效性。

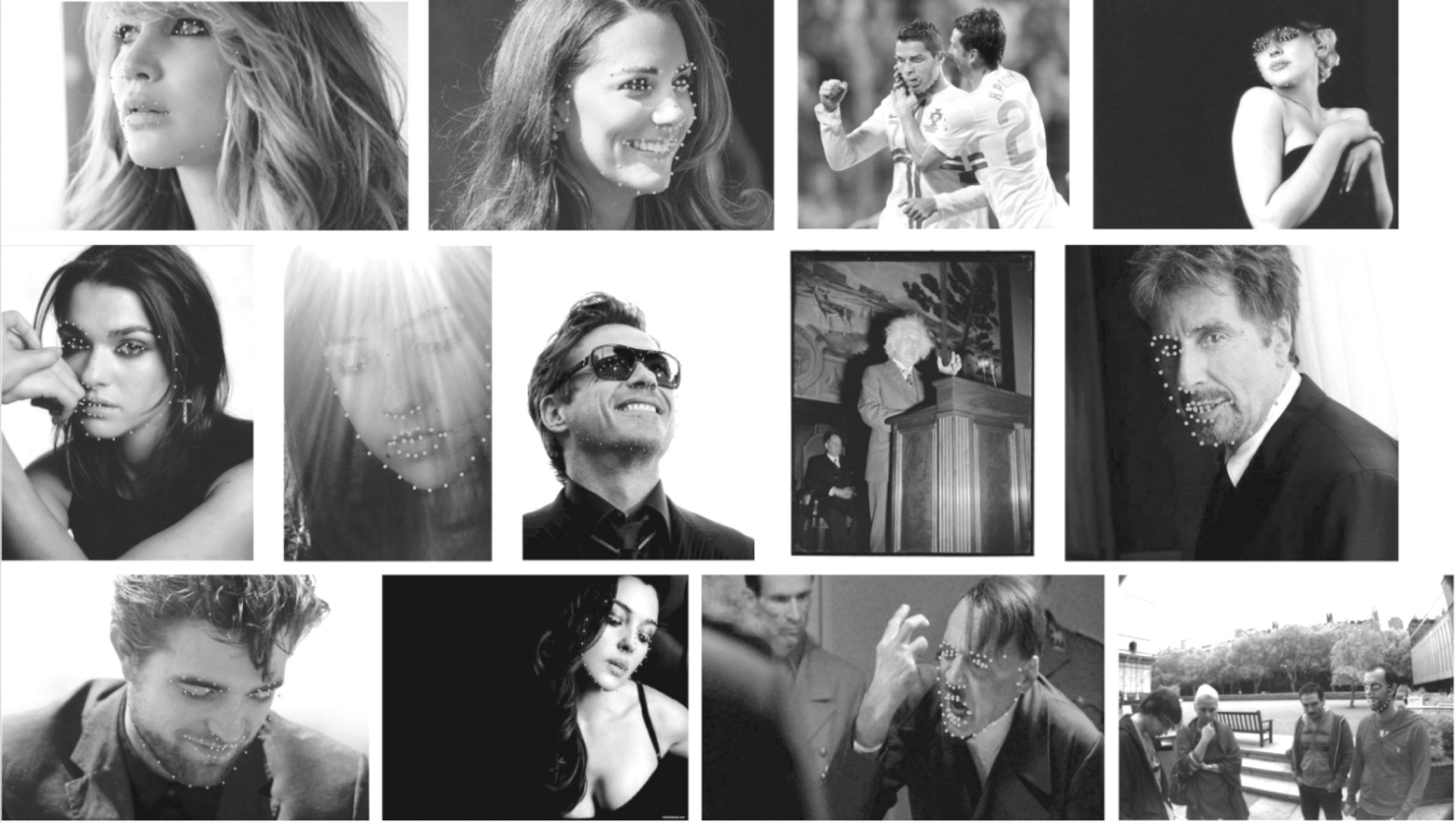

4.3 部分人脸关键点检测结果展示

本部分展示SB+IR+AT算法在一些300-W验证集上结果,分别对相对简单场景下的Common Subset和相对复杂的Hard Subset进行展示。如图6展示的是算法在测试集Common Subset的结果,

图6 算法在300-W Common Subset测试集上结果

Fig.6 Key point detection results on 300-W Common Subset

图7 算法在300-W Hard Subset测试集上结果

Fig.7 Key point detection results on 300-W Hard Subset

Common Subset相对于Hard Subset整个测试集要简单,但是也存在很多困难案例,从实际图像结果来看,整个算法对于各种场景下的人脸都得到了很好的解决。如图7展示的是算法在Hard Subset测试集上的结果,整个Hard Subset由IBUG数据集组成,整个测试集背景复杂,光照变化大,图像质量相对也较低,因此能够对算法起到很好的检测作用。从图中结果来看即使是在Hard Subset数据集上,算法对于各种条件的人脸测试图片依旧具有很好的鲁棒性,从而进一步验证了本文算法的可行性。

5 结论

本文的主要工作是研究非限定条件下的人脸关键点检测问题。本文采用了一种全新的精简网络结构,同时引入了针对所有人脸关键点的全局约束。最终在300-W数据集上取得的检测性能超出了目前典型深度神经网络检测模型,在运行速度上整个网络结果也要更快,说明本文算法的有效性。

[1] Cootes T F, Taylor C J, Cooper D H, et al. Active shape models—their training and application[J]. Computer Vision and Image Understanding, 1995, 61(1): 38-59.

[2] Edwards G J, Cootes T F, Taylor C J, et al. Face Recognition Using Active Appearance Models[C]∥European Conference on Computer Vision, 1998: 581-595.

[3] Lucey S, Wang Y, Cox M, et al. Efficient Constrained Local Model Fitting for Non-Rigid Face Alignment[J]. Image & Vision Computing, 2009, 27(12): 1804-1813.

[4] Wang Y, Lucey S, Cohn J F. Enforcing convexity for improved alignment with constrained local models[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2008: 1- 8.

[5] Saragih J M, Lucey S, Cohn J F. Deformable Model Fitting by Regularized Landmark Mean-Shift[M]. Kluwer Academic Publishers, 2011.

[6] Papandreou G, Maragos P. Adaptive and constrained algorithms for inverse compositional Active Appearance Model fitting[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2008: 1- 8.

[7] Matthews I, Baker S. Active Appearance Models Revisited[J]. International Journal of Computer Vision, 2004, 60(2): 135-164.

[8] Coughlan J M, Ferreira S J. Finding Deformable Shapes Using Loopy Belief Propagation[C]∥European Conference on Computer Vision, 2002: 453- 468.

[9] Liang L, Wen F, Xu Y Q, et al. Accurate Face Alignment using Shape Constrained Markov Network[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2006: 1313-1319.

[10] Doll r P, Welinder P, Perona P. Cascaded pose regression[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2010: 1078-1085.

r P, Welinder P, Perona P. Cascaded pose regression[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2010: 1078-1085.

[11] Wei Y. Face alignment by Explicit Shape Regression[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2012: 2887-2894.

[12] Tang X, Wang X, Luo P. Hierarchical face parsing via deep learning[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2012: 2480-2487.

[13] Wu Y, Wang Z, Ji Q. Facial Feature Tracking Under Varying Facial Expressions and Face Poses Based on Restricted Boltzmann Machines[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2013: 3452-3459.

[14] Zhang J, Shan S, Kan M, et al. Coarse-to-Fine Auto-Encoder Networks(CFAN) for Real-Time Face Alignment[C]∥European Conference on Computer Vision, 2014: 1-16.

[15] Sun Y, Wang X, Tang X. Deep Convolutional Network Cascade for Facial Point Detection[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2013: 3476-3483.

[16] Bulat A, Tzimiropoulos G. How Far are We from Solving the 2D & 3D Face Alignment Problem?(and a Dataset of 230, 000 3D Facial Landmarks)[C]∥International Conference on Computer Vision, 2017: 1021-1030.

[17] Dong X, Yu S, Weng X, et al. Supervision-by-Registration: An Unsupervised Approach to Improve the Precision of Facial Landmark Detectors[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2018: 360-368.

[18] Sagonas C, Tzimiropoulos G, Zafeiriou S, et al. 300 Faces in-the-Wild Challenge: The First Facial Landmark Localization Challenge[C]∥International Conference on Computer Vision, 2013.

[19] Tompson J, Jain A, Lecun Y, et al. Joint Training of a Convolutional Network and a Graphical Model for Human Pose Estimation[C]∥Conference and Workshop on Neural Information Processing Systems(NIPS), 2014: 1799-1807.

[20] Pfister T, Charles J, Zisserman A, et al. Flowing ConvNets for Human Pose Estimation in Videos[C]∥International Conference on Computer Vision, 2015: 1913-1921.

[21] Xiao B, Wu H, Wei Y, et al. Simple Baselines for Human Pose Estimation and Tracking[C]∥European Conference on Computer Vision, 2018: 472- 487.

[22] Deng J, Guo J, Zafeiriou S, et al. ArcFace: Additive Angular Margin Loss for Deep Face Recognition[J]. arXiv: 1801- 07698, 2018.

[23] Wang F, Jiang M, Qian C, et al. Residual Attention Network for Image Classification[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2017: 6450- 6458.

[24] Kuen J, Wang Z, Wang G, et al. Recurrent Attentional Networks for Saliency Detection[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2016: 3668-3677.

[25] Chu X, Yang W, Ouyang W, et al. Multi-context Attention for Human Pose Estimation[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2017: 5669-5678.

[26] Ren S, Cao X, Wei Y, et al. Face Alignment at 3000 FPS via Regressing Local Binary Features[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2014: 1685-1692.

[27] Trigeorgis G, Snape P, Nicolaou M A, et al. Mnemonic Descent Method: A Recurrent Process Applied for End-to-End Face Alignment[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2016: 4177- 4187.

[28] Zhang Z, Luo P, Loy C C, et al. Facial Landmark Detection by Deep Multi-task Learning[C]∥European Conference on Computer Vision, 2014: 94-108.

[29] Zhu S, Li C, Loy C C, et al. Face alignment by coarse-to-fine shape searching[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2015: 4998-5006.

[30] Lv J, Shao X, Xing J, et al. A Deep Regression Architecture with Two-Stage Re-initialization for High Performance Facial Landmark Detection[C]∥IEEE Conference on Computer Vision & Pattern Recognition, 2017: 3691-3700.