1 引言

随着现代网络和数字多媒体技术的发展,数字视频由于能直观地反映图像信息的特点,因此被广泛的应用在生活的方方面面。它作为一个重要的信息载体已经成为当今时代获取信息的主流方式并且影响着人们的生活。但是每天海量的视频数据在给人们带来方便的同时,也给视频的存储、传输和检索带来了巨大压力[1]。如何有效的管理视频以及快速的获取视频中重要的信息成为一个研究的热点。在这种背景下,以提取关键帧形成视频摘要的方法成为解决这一难题的有效途径。视频摘要主要是由提取出的能反映视频主要内容的关键帧组合而成。通过提取关键帧形成视频摘要,不仅能大大减少视频的数据量,而且能很好地将原始视频的重要信息表达出来。同时,节省了人们的检索时间,提高了视频检索的效率。

近年来,随着视频摘要技术不断发展,已经取得了很多显著的研究成果。文献[2]是基于镜头边界的关键帧提取技术。该方法首先将视频序列分割成很多个镜头,然后依次从每个镜头中选择一帧作为关键帧。这种方法对于镜头固定的视频效果比较好,但是当镜头变化比较复杂时,容易造成很大的冗余现象,导致不能准确地概括视频内容。文献[3]是基于聚类的关键帧提取技术。这种方法通过计算视频图像间的相似度,将相似度高的帧聚集在一起,使类内相似度高,类间相似度低,并从每个类内选取一帧作为关键帧。但这种方法计算量大,不仅运算时间长,而且需要提前设定好初始聚类数目和中心点。当视频内容不确定的时候,很难提前设定初始聚类数目和聚类中心。文献[4]是基于视频内容的关键帧提取技术。这种方法将图像的颜色、形状、纹理等信息作为提取关键帧的依据。根据视频内容的变化来确定要提取的关键帧数目。但缺点是,当视频的镜头变化频繁时,容易提取过多的帧,造成大量冗余。文献[5]针对AVS监控档视频的压缩域摘要进行研究,该方法对AVS码流中的运动向量进行分析,提取前景运动宏块并跟踪得到有效的运动目标轨迹,最终提取视频中的背景帧,并将其与运动目标轨迹相结合,生成摘要视频。受之启发,提出了一种HEVC压缩域的视频摘要关键帧提取方法。该方法从HEVC压缩域角度,首先,对原始视频进行编解码,在解码中以PU最小单元4×4为基准,对其不同尺寸对应的模式数分别乘以相应的权重系数,统计得到加权后的亮度预测模式数;然后,将统计得到的加权亮度模式数构建成模式特征向量,目的是为了将其作为视频帧的纹理特征用于关键帧的提取。最后利用融合ISODATA[6]方法的K-means聚类算法对模式特征向量进行聚类,在聚类结果中选取每个类内中间向量对应的帧作为候选关键帧,并计算曼哈顿距离作为衡量两帧相似性的标准对候选帧进行再次筛选,剔除冗余帧,得到最终的关键帧。

本文的贡献主要有以下4点:(1)利用HM解码时间短的优势进行HEVC帧内预测模式数的统计并将其应用于视频摘要领域。(2)在进行模式数统计的过程中,本文将PU不同尺寸对应的模式数分别乘以相应的权重系数,这样使统计得到的亮度模式数更准确地反映图像的纹理特征。(3)实践证明HEVC帧内编码中的亮度模式与图像的纹理具有相关性,因此本文将统计得到的PU块加权后的亮度模式数目构建成模式特征向量作为图像的纹理特征。(4)利用融合ISODATA方法的K-means算法用于解决K-means算法无法提前设定聚类数目K的问题。

2 研究动机

2.1 HEVC帧内预测技术

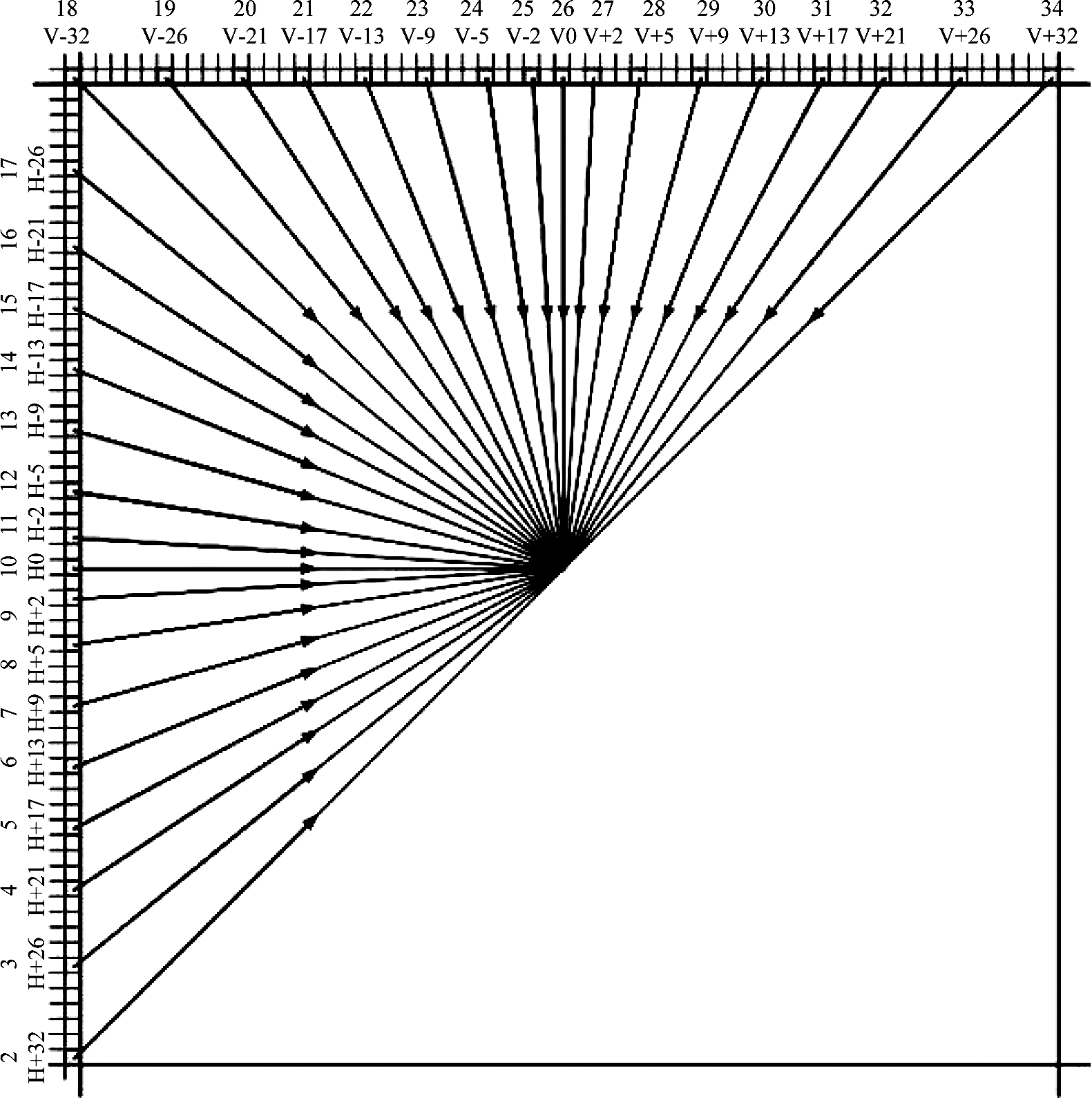

HEVC是新一代视频编解码标准,它沿用了与H.264/AVC相似的混合编码结构。但不同于H.264/AVC固定宏块的划分方式,HEVC标准采用了四叉树划分方式,分别定义了编码单元(Coding Unit, CU)、预测单元(Prediction Unit, PU)和变换单元(Transform Unit, TU)进行图像的编码、预测和变换。在HEVC帧内编码中,编码器会将每个视频图像划分为若干个编码树单元(Coding Tree Unit, CTU),并将CU作为视频编码的基本单元,且从最大尺寸[7]64×64一直递归到最小尺寸8×8。对于每个CU块划分完后,均使用PU块进行预测模式的选择。其中,PU块支持5种大小的尺寸,分别为4×4、8×8、16×16、32×32、64×64。对于帧内预测,PU只有2N×2N和N×N两种划分方式,且在最小编码单元(Smallest Coding Unit, SCU)时N×N才存在。为了提高编码效率及预测精度,HEVC在H.264/AVC的基础上增加了更多的帧内预测模式,并达到了35种,包括Planar模式、DC模式以及33种角度预测模式[8],如图1所示。

图1 HEVC的33种角度预测模式

Fig.1 33 Angle prediction models of HEVC

在HEVC的参考模型HM16.8中,为了得到PU块的最优预测模式,需要进行如下步骤实现:首先,计算PU块35种预测模式的预测残差哈达玛代价,将哈达玛代价按照递增的顺序进行排序,并选择前几个代价值小的预测模式作为组成率失真代价候选模式集,其中候选模式集中模式的个数N由PU尺寸大小决定,如表1所示。然后,判断当前PU块的左侧和上侧已编码预测单元的最有可能模式(Most Probable Mode, MPM)是否包含在候选模式集中,若没有包含,则加入候选模式集中。最后,对候选模式集中的模式进行率失真代价(Rate Distortion Cost, RD Cost)的计算,选择RD Cost值最小的模式作为最优帧内预测模式进行编码。

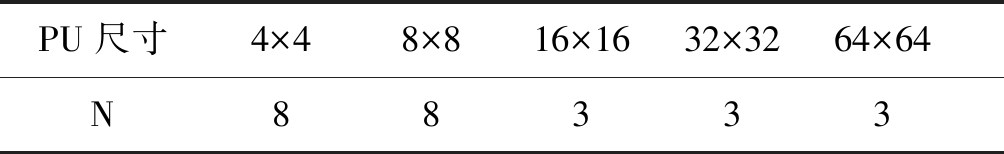

表1 不同PU尺寸的候选模式个数

Tab.1 Number of candidate modes for different PU sizes

PU尺寸4×48×816×1632×3264×64N88333

2.2 HEVC帧内预测模式与图像特征的相关性分析

为了证明帧内亮度预测模式选择与图像纹理特征具有相关性,本文从CU的划分与PU模式的选择上进行两方面分析。

图2给出了Drift Ice as a Geologic Agent, segment 8视频序列第3020帧在HM16.8编码后的四叉树划分图以及三个区域的CTU放大图[9]。区域放大图Ⅰ、Ⅱ、Ⅲ为该图像中的一个CTU,从图中可知,纹理特征变化不明显的CTU(如Ⅰ区域)较大概率的采用大尺寸的CU进行编码,纹理变化较明显的CTU(Ⅱ区域)大多数选择较小尺寸的CU进行编码。值得注意的是第Ⅲ个区域,该区域上半部分纹理变化显著采用较小尺寸进行编码,下半部分纹理平坦光滑选择较大尺寸的CU进行编码。从整个图像上也可以看出,在平坦光滑的区域(如地面,石头)大都选择大尺寸的CU进行编码,而在科研人员和石头接触面等纹理复杂的区域通常选择较小尺寸的CU进行编码。综上分析可知,CTU在进行CU编码时,其划分结果与图像本身的纹理特征有很大的相关性。

图2 第3020帧的四叉树划分图及Ⅰ、Ⅱ、Ⅲ区域放大图

Fig.2 Quadtree partition map of the 3020 frame and enlarged view of the I, II, III regions

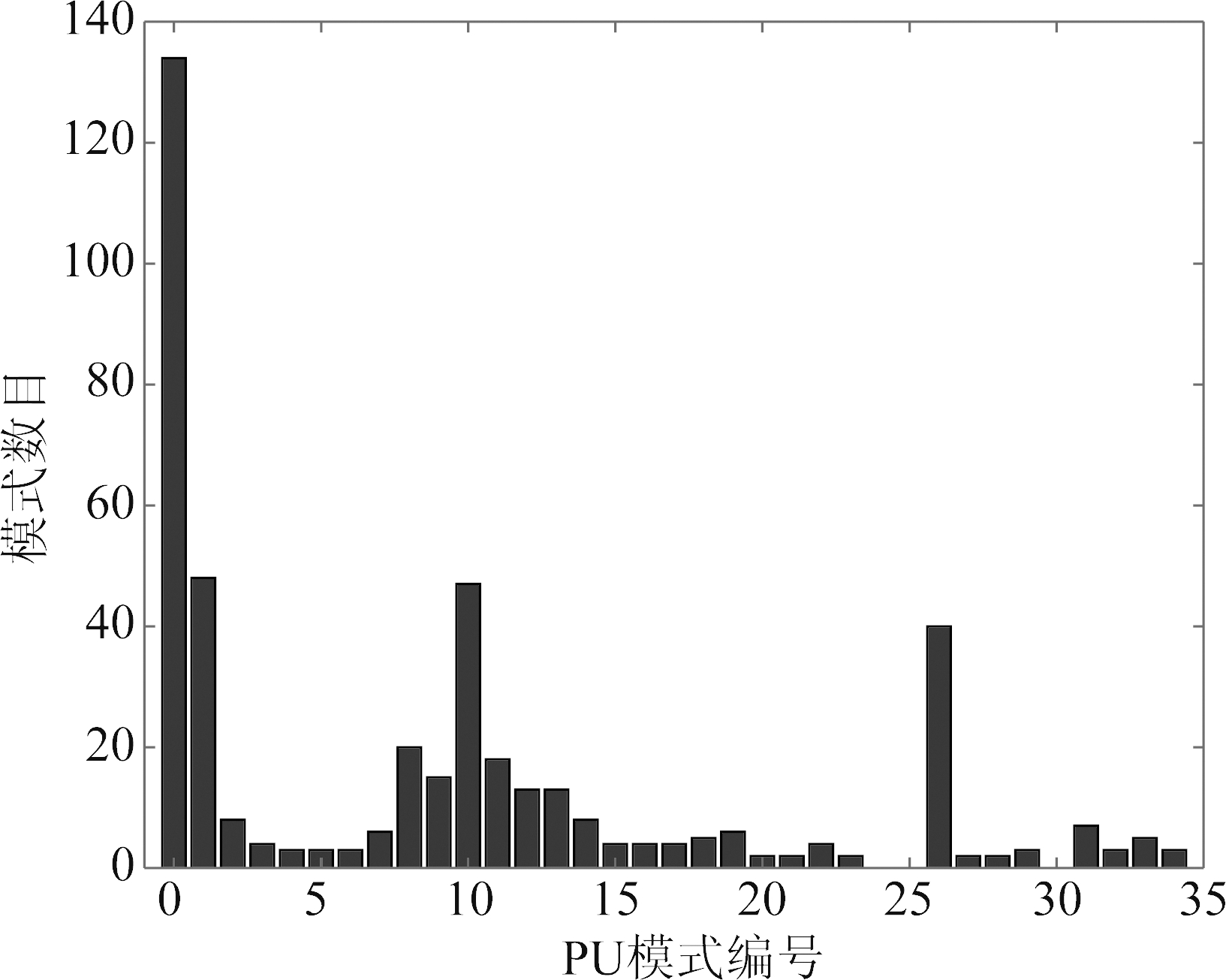

图3给出了Drift Ice as a Geologic Agent, segment 8序列第3037帧的PU最优预测模式分布图。从图中可知,编码结束后,选择0(Planar)模式数目最多,选择1(DC)模式的次之,说明了在视频经过CU划分后有较大一部分平坦区域选择大尺寸进行编码,相应的PU块会选择对应的平坦模式。此外,在33种角度预测模式的选择中,由于图像的纹理方向一般都为水平或竖直方向,因此选择预测模式10和预测模式26的比较多。上述分析表明,PU预测模式的选择大多数会根据图像的纹理方向(图中紫色箭头代表角度预测模式的方向)进行对应模式的匹配选择。因此本文通过统计单元图像PU块对应的加权亮度预测模式的数目,并将其作为该图像的纹理特征用于关键帧的提取。

图3 第3037帧的PU最优预测模式分布图

Fig.3 PU optimal prediction mode distribution of the 3037 frame

2.3 不同尺寸大小的PU块与亮度模式数的相关性分析

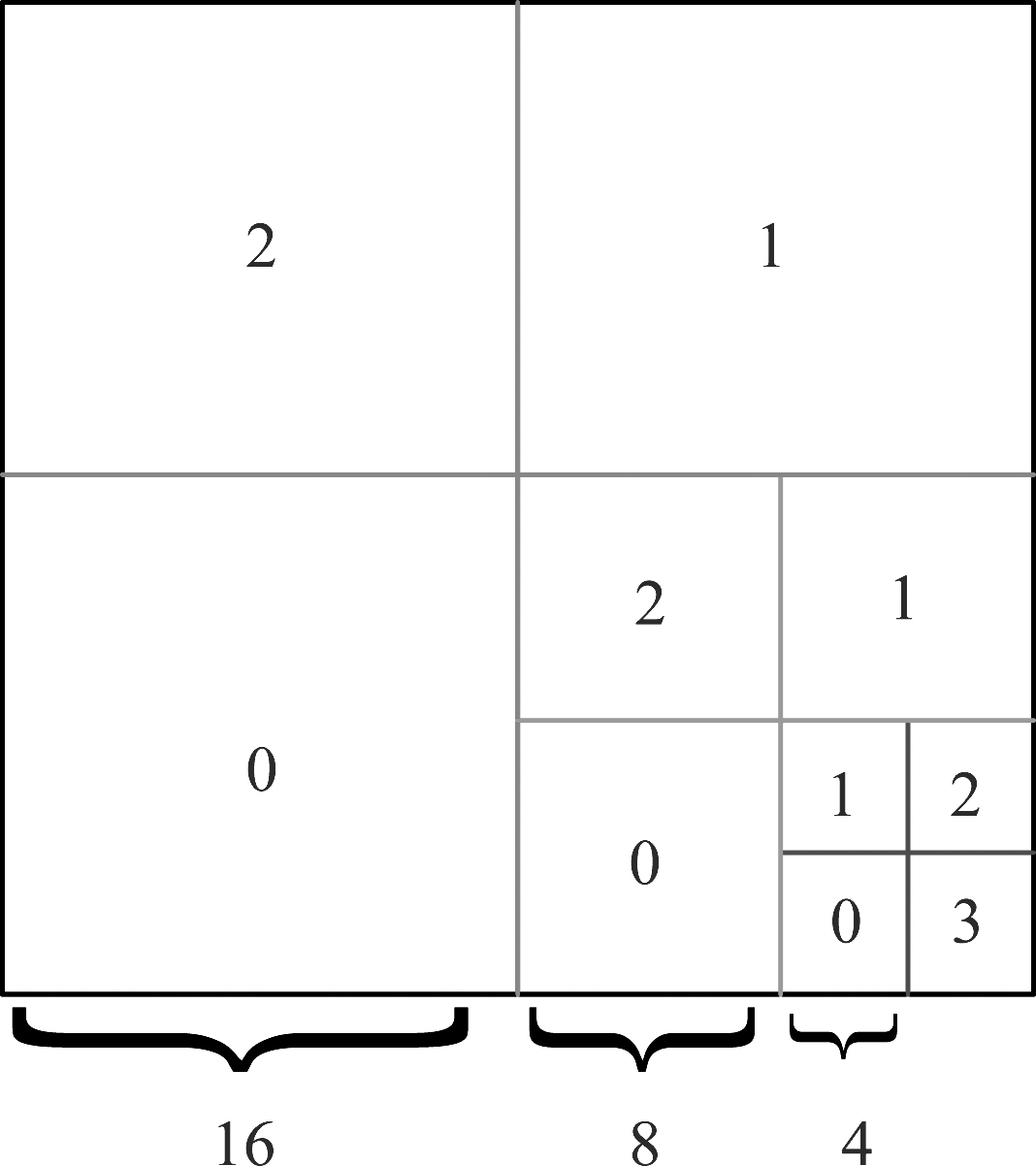

为了分析PU不同尺寸与亮度模式数的关系,图4给出了CU递归划分完后PU选择的最优预测模式分布情况。

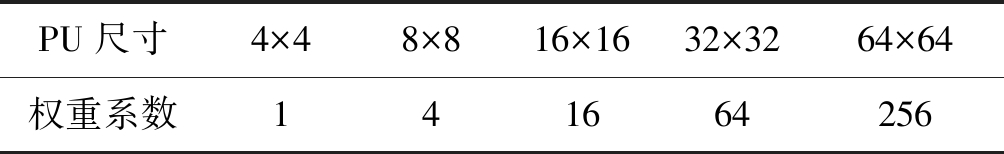

如图4,若以PU块最终选择模式0为例,PU尺寸为16×16、8×8、4×4的块均选择了0模式作为最优亮度预测模式。在进行每种亮度预测模式统计时,本文以PU最小单元4×4为基准,将对应的模式0数目乘以权重系数1;当PU尺寸为8×8时,对应模式0的数目乘以权重系数4;其他PU尺寸对应模式数目的权重系数以此类推,如表2所示,这样使得加权后的亮度模式数目更能准确地反映图像的纹理特征。

图4 PU最优预测模式分布图

Fig.4 PU optimal prediction mode distribution map

表2 PU不同尺寸对应模式数的权重系数

Tab.2 Weight coefficients of the corresponding number of PU different sizes

PU尺寸4×48×816×1632×3264×64权重系数141664256

3 提出的算法

本文所提算法的整体框架示意图如图5所示。

3.1 模式特征提取

由于参考模型HM16.8编码器会遍历测试序列中每帧图像的所有不同尺寸的CU,并根据率失真代价的大小进行PU模式的筛选,在测试序列完成编码处理后,每帧图像对应PU块选择的最优预测模式

图5 所提算法的整体框架示意图

Fig.5 Schematic diagram of the overall framework of the proposed algorithm

都会落在0~34这个预测模式区间内。因此将其选择的最优模式在解码端累加统计输出即可得到PU块的最优预测模式数目。具体步骤如下:

(1)对YUV格式的测试序列进行编码,得到编码后的文件。

(2)对编码得到的文件进行解码,在解码过程中进行加权亮度预测模式的统计。

(3)对统计得到的加权亮度预测模式数目进行数学模型的转换,得到模式特征向量。

通过统计算法可以得到每帧对应的一个35维的向量,进而对该向量进行公式(1)中数学模型的转换,得到模式特征向量。

MGn=[λ0,λ1,λ2,…,λα]

(1)

其中,MGn表示视频帧的模式特征向量,下标n表示第n个视频帧,λa(a=0,1,2,…,34)表示模式编号为a的模式数目。

3.2 自适应K-means聚类

通过3.1节算法提取出模式特征后,将对构建的模式特征向量进行聚类分析。在聚类过程中,针对传统K-means[10]算法无法提前设定聚类的数目K的问题,本文通过融合ISODATA方法,根据其能动态地对聚类结果进行“合并”“分类”的特点,得到一个比较理想的聚类数目,并将其作为传统K-means算法的初始聚类数目K,有效地解决了该问题。所提自适应K-means聚类算法,第一步利用ISODATA算法得到聚类数目K后继续执行K-means算法,在聚类结果中提取每个类内中间向量对应的帧作为候选关键帧;第二步对候选帧计算曼哈顿距离作为衡量两帧相似度的标准与阈值比较进行再次筛选,剔除冗余帧,得到最终的关键帧。具体流程如下:

3.2.1 候选关键帧的提取

假设输入n个模式特征向量样本MG{MGi| i=1,2,3,…,n},设定ISODATA算法的控制参数:每个类中最少的数目θN,样本距离分布的标准差θS、类间最小距离θC、最大迭代次数L及每次运算合并的最多对数I。其中,K表示预期的聚类数目,Nc表示实际形成的聚类数目。该算法流程如下:

(1)计算每帧的特征向量到各聚类中心的距离,并根据公式(2)将其分配到距离最小的聚类Sj中;

Dj=min(‖MG-Ci‖), i=1,2,3,…,Nc

(2)

(2)如果聚类Sj的样本数目小于等于θN,那么丢弃该类,令NC减1,重新进行聚类;

(3)重新计算聚类后的参数:

1)根据公式(3)计算新的聚类中心Cj

(3)

2)每个聚类Sj样本数据到Cj的平均距离

(4)

(4)如果![]() 那么当前类别数太少,进行分裂操作;如果Nc≥2K,那么当前类别数太多,进行合并操作;

那么当前类别数太少,进行分裂操作;如果Nc≥2K,那么当前类别数太多,进行合并操作;

(5)如果达到最大迭代次数L或者结果收敛则算法结束,输出得到聚类数目Nc,将其作为K-means的初始聚类数目K值,否则返回到第1步继续执行;

(6)执行K-means算法,随机选取Nc个样本作为初始聚类中心;

(7)计算每个特征向量到各个初始聚类中心的距离,并将其分配到距离最近的类当中,并重新计算新的聚类中心;

(8)如果均方差之和小于1,则算法终止,选取每个类内中间向量对应的帧作为候选关键帧,并将其保存在候选关键帧集合X中。否则,返回到第7步继续执行。

3.2.2 冗余帧的剔除

为了尽可能地得到全面覆盖视频内容且冗余性最小的视频摘要关键帧,本文对提取得到候选关键帧进行再次筛选,剔除冗余的帧。具体流程如下:

(1)针对上述提取的候选关键帧集X={x1,x2,…,xNC},利用集合X中的模式特征向量计算每两个候选关键帧xi与xj的曼哈顿距离d(i, j)=|xi -xj|,以此作为衡量两帧相似性的标准。

(2)设定阈值δ进行判定,如果d(i, j)<δ,那么则剔除xi,xj中的一个,反之两帧不相似,返回第(1)步继续执行。

(3)将剩余的关键帧作为最终的视频摘要关键帧。

4 实验结果与分析

4.1 实验条件与参数设置

实验测试环境为Windows10 64位操作系统的戴尔电脑,其配置为Inter Core i3- 6100(3.70 GHz)、4核CPU处理器及4 GB内存。利用HM16.8编码器在Visual Studio 2015平台上进行实验操作。其中,全I帧的量化参数设为37。

4.2 数据集与评价方式

本文算法将采用VSUMM提供的Open Video Project数据集,该数据集包含了纪录片、演讲、教育等多个类型的视频。其中,每个视频长度均在1~4分钟,格式为MPEG-1格式(本文通过FFmpeg开源计算机程序将其转换为YUV格式),像素大小为352×240,采样率30帧/每秒,且每个视频都提供了5个用户摘要。该数据集常作为客观评价的基准,被广泛用来与其他视频摘要算法进行对比,得出所提方法的性能。

视频摘要常用的评价方式包括客观评价和主观评价两种。(1)客观评价主要是利用某种评价函数进行摘要质量的比较。常用的评价函数有准确率(CUSA)、误差率(CUSE),精度(Precision)、召回率(Recall)及F-score等。(2)主观评价一般通过人为对提取的视频摘要进行打分或者评定好坏等级等方式进行评价。本文将在Open Video Project数据集上,利用精度(P)、召回率(R)及F-score(F)这套评价标准对提取的关键帧进行客观评价和评定等级的主观评价两种方式进行摘要评价。

1)客观评价方式

精度、召回率及F-score的计算公式如下:

(5)

(6)

(7)

其中,NmAS、NAS、NUS分别为匹配的关键帧数量、自动提取的关键帧数量及用户手工摘要的数量。

2)主观评价方式

本文的主观评价将从冗余率、正确率、错误率三个方面进行等级的评价。评价等级分为:很好、一般、差三个等级。其中,很好代表提取的关键帧准确率高且冗余率低,能很好地表达视频的内容。差代表提取的关键帧错误率和冗余度高,生成的视频摘要很糟糕。

4.3 客观评价结果对比与分析

4.3.1 精度、召回率和F值实验结果对比与分析

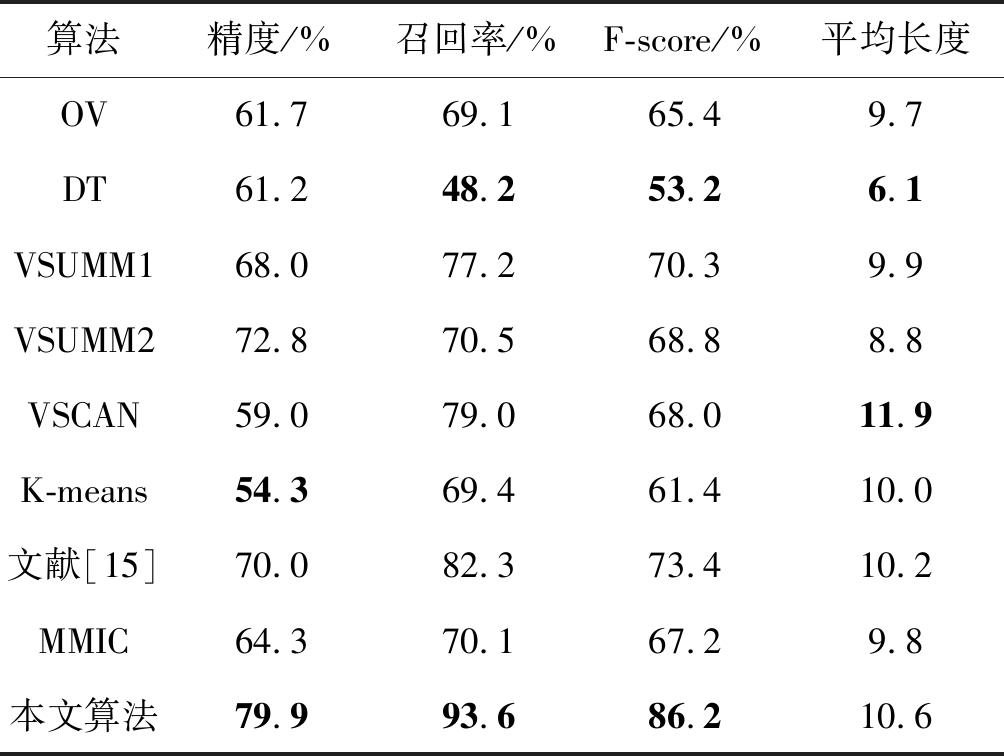

为了验证所提算法的性能,本文分别与OV[12]、DT[13]、VSUMM1[11]、VSUMM2[11]、VSCAN[14]、K-means、文献[15]及MMIC[16]等八种算法进行对比。为了保持不同对比算法结果的一致性,算法得到的所有实验数据均取平均值。

表3 不同算法的精度、召回率、F-score及平均长度的实验结果对比

Tab.3 Comparison of experimental results of precision, recall, F-score and average length of different algorithms

算法精度/%召回率/%F-score/%平均长度OV61.769.165.49.7DT61.248.253.26.1VSUMM168.077.270.39.9VSUMM272.870.568.88.8VSCAN59.079.068.011.9K-means54.369.461.410.0文献[15]70.082.373.410.2MMIC64.370.167.29.8本文算法79.993.686.210.6

表3给出了不同算法在客观评价方式为精度、召回率、F-score的实验结果对比(其中已经将每项评测指标中的最大值和最小值加粗标记)。从表3中可知,在整体性能的F-score方面,所提算法明显高于其他对比算法,达到86.2%。分别高于OV、DT、VSUMM1、VSUMM2、VSCAN、K-means、文献[15]、MMIC算法约21%、33%、16%、17%、18%、25%、13%及19%。F-score作为评价视频摘要质量的一个综合指标,F-score越高越能反映所提方法形成的视频摘要越好。由此可见,所提方法提取关键帧的整体性能优于其他视频摘要算法。单独来看,在召回率方面,所提方法同样也是最高的,达到93.6%。分别高于OV、DT、VSUMM1、VSUMM2、VSCAN、K-means、文献[15]、MMIC算法约24%、45%、16%、23%、14%、24%、11%及23%,进而说明所提方法明显优于其他对比算法。其中DT算法的召回率最低,这是由于DT算法提取的摘要长度比用户创建的摘要长度要小很多,因此导致召回率很低。在精度方面,所提方法比其他算法都要高,将近达到80%。在视频摘要的平均长度L方面,VSCAN算法的长度最长,达到11.9,所提算法次之,DT算法长度最短。所提算法之所以提取的关键帧平均长度很长,这是由于根据公式(6)可知,提取的长度L越长,才有可能提取出更多的匹配帧,进而提高算法的召回率。综上分析可知,不论从精度、召回率还是F-score上,所提方法在该套客观标准上均优于其他对比的视频摘要算法,整体上表现较好。

4.3.2 直观结果对比与分析

为了更直观的将本文算法与对比算法进行比较,图6分别给出了本文算法和其他对比算法提取测试序列A New Horizon, segment 02的摘要结果进行直观对比。

从图6可以看出,OV算法的摘要长度很短,导致很多重要帧丢失,无法表示整个视频的主要内容。与所有对比算法相比,DT算法提取的关键帧长度最短,且有冗余帧出现(红色实线方框所示),DT算法提取的4个关键帧只能表达视频的开始部分,对后面的视频内容完全没有涉及到,算法几乎没有可用的信息,不能够很好地表达出视频的内容。VSUMM1、VSUMM2、VSCAN及文献[15]算法的摘要长度适中,虽然能很好地表达视频内容,但是摘要的镜头切换角度太大。比如,VSUMM1摘要中石碑帧的丢失、VSUMM2和VSCAN摘要中飞机的起飞和离开的视频帧的丢失以及文献[15]很多关键帧的缺失等问题,导致表达出的视频内容连续性下降,不利于理解。K-means算法虽然能大概表达出视频的内容,但存在冗余帧且丢失了小屋等一些重要的关键帧。从该视频上可以看出,本文算法和MMIC算法都能较好地表达视频的内容。但在摘要内容的连续上,本文算法要优于MMIC算法。比如,摘要中图形板块的出现到划分结束以及飞机的起飞到离开片段,本文算法更详细地描述了整个过程,这样更符合用户的观看习惯。综上分析可知,提出的算法相比较于其他视频摘要算法,不仅能较好地去除冗余,而且提取的关键帧能够较好地表达出原始视频内容,整体性能优于其他视频摘要对比算法。

图6 不同算法提取A New Horizon, segment 02序列的摘要对比

Fig.6 Summarization comparison of A New Horizon, segment 02 sequence extracted by different algorithms

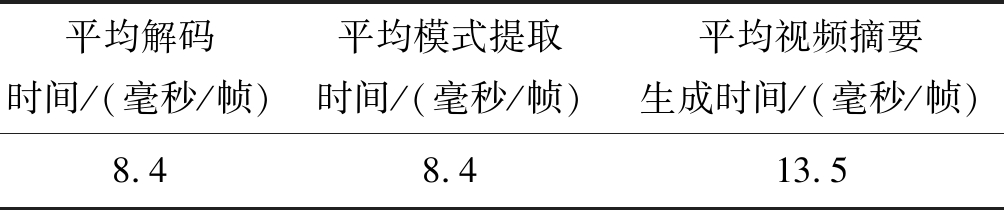

4.3.3 所提算法运行时间分析

为了进一步验证所提算法性能的优越性,本文对所提算法的运行时间进行了统计,并对统计的时间结果进行了归一化处理,如表4所示。

表4 视频摘要归一化时间参数

Tab.4 Video summarization processing normalized time specification

平均解码时间/(毫秒/帧)平均模式提取时间/(毫秒/帧)平均视频摘要生成时间/(毫秒/帧)8.48.413.5

本文所提算法的运行时间主要包括三个部分:第一部分为平均解码时间即视频编码后对编码文件进行解码的耗时约为8.4毫秒/帧;第二部分为平均模式提取时间即3.1节模式特征提取的过程,该算法在HM解码端进行亮度预测模式的统计耗时约8.4毫秒/帧;第三部分为平均视频摘要生成时间即自适应K-means聚类算法提取关键帧的运行时间约为13.5毫秒/帧。综上分析可知,所提算法提取关键帧的运行时间很快,大大节省了人们浏览、理解原始视频内容的时间。

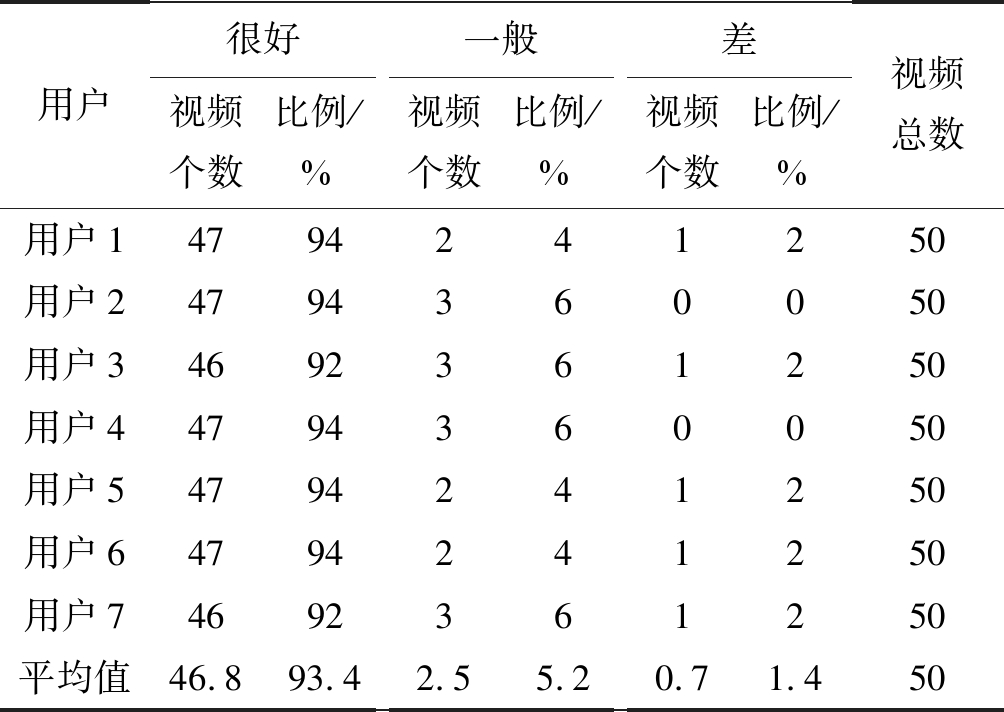

4.4 主观评价结果与分析

在主观评价方面邀请了7位用户为测试者,通过先观看原始视频,对视频内容大概了解后,再观看所提算法提取的关键帧并同时进行很好、一般、差三个等级的判定。针对Open Video Project数据集中的50段视频,所提取关键帧的主观评价结果如表5所示。

表5 用户的主观评价结果

Tab.5 Subjective evaluation results of users

用户很好视频个数比例/%一般视频个数比例/%差视频个数比例/%视频总数用户14794241250用户24794360050用户34692361250用户44794360050用户54794241250用户64794241250用户74692361250平均值46.893.42.55.20.71.450

表5给出了7位测试者的主观评价结果。从表中可以看出,50个视频摘要,用户评为很好等级的比例达到93.4%,与其93.6%的召回率基本上吻合,说明所提算法提取出的关键帧符合大多数测试者的观看意愿。算法提取的摘要关键帧被评为一般的评价个数为2.5个,占数据集的5.2%。其中,视频等级被评为差的个数为0.7,约占整个数据集的1.4%。这也说明了对于部分视频,所提算法无法很好地表达出其视频内容。综合来看,所提算法提取的关键帧符合人们的意愿,且能较好地表达出视频的主要内容。

5 结论

本文从HEVC压缩域角度,提出一种HEVC压缩域的视频摘要关键帧提取方法。该方法从HEVC压缩视频流中,利用统计得到的加权亮度模式数构建成模式特征向量作为视频帧的纹理特征。然后通过自适应K-means算法对模式特征向量进行聚类分析,在聚类结果中分别选取类内中间帧作为候选关键帧,并对候选关键帧进行冗余帧剔除,最终得到视频摘要的关键帧。实验结果表明,在相同的数据集和用户摘要为客观标准下,与其他视频摘要算法相比,该方法提取关键帧的视频摘要综合指标F-score、召回率Recall及精度Precision均最高,能较好地表示出视频的内容,进一步改善了视频摘要的质量。另外,HEVC标准中除了含有35种帧内亮度预测模式,还包含5种色度预测模式。如何融合色度预测模式来提高视频摘要的质量将成为下一步研究的重点。

[1] 王娟, 蒋兴浩, 孙锬锋. 视频摘要技术综述[J]. 中国图象图形学报, 2014, 19(12): 1685-1695.

Wang Juan, Jiang Xinghao, Sun Tanfeng. Review of video abstraction[J]. Journal of Image and Graphics, 2014, 19(12): 1685-1695.(in Chinese)

[2] Mendi E, Bayrak C. Shot boundary detection and key frame extraction using salient region detection and structural similarity[C]∥Proceedings of the 48th Annual Southeast Regional Conference. ACM, 2010: 66- 68.

[3] 白慧茹, 吕进来. 基于聚类方法改进的关键帧提取算法[J]. 计算机工程与设计, 2017, 38(7): 1929-1933.

Bai Huiru, Lv Jinlai. Improved algorithm of key frame extraction based on clustering methods[J]. Computer Engineering and Design, 2017, 38(7): 1929-1933.(in Chinese)

[4] 王宇, 汪荣贵, 杨娟. 一种新的自适应的视频关键帧提取方法[J]. 合肥工业大学学报: 自然科学版, 2016, 39(11): 1483-1487, 1542.

Wang Yu, Wang Ronggui, Yang Juan. A novel adaptive video key frame extraction method[J]. Journal of Hefei University of Technology: Natural Science, 2016, 39(11): 1483-1487, 1542.(in Chinese)

[5] 赵磊, 黄华. AVS监控档视频的压缩域摘要研究[J]. 计算机科学, 2016, 43(7): 46-50.

Zhao Lei, Huang Hua. Compressed domain synopsis research in AVS surveillance profile[J]. Computer Science, 2016, 43(7): 46-50.(in Chinese)

[6] Li Y, Zuo Y, Yang Z, et al. High quality voice conversion based on ISODATA clustering algorithm[C]∥International Conference on Intelligent Systems and Knowledge Engineering. IEEE, 2018: 1-5.

[7] 韩雪, 冯桂, 曹海燕. 3D-HEVC深度图帧内编码快速算法[J]. 信号处理, 2018, 34(6): 680- 687.

Han Xue, Feng Gui, Cao Haiyan. Efficient fast algorithm for depth map in 3D-HEVC[J]. Journal of Signal Processing, 2018, 34(6): 680- 687.(in Chinese)

[8] 杨宇航, 蔡灿辉, 王张欣. 利用纹理结构的HEVC快速帧内模式选择算法[J]. 信号处理, 2015, 31(9): 1094-1100.

Yang Yuhang, Cai Canhui, Wang Zhangxin. Fast Mode Decision for HEVC Intra Coding Using Texture Information[J]. Journal of Signal Processing, 2015, 31(9): 1094-1100.(in Chinese)

[9] 朱威, 张晗钰, 易瑶, 等. 低复杂度的HEVC帧内编码模式决策算法[J]. 小型微型计算机系统, 2017, 38(12): 2630-2636.

Zhu Wei, Zhang Hanyu, Yi Yao, et al. Low complexity mode decision algorithm for HEVC intra coding[J]. Journal of Chinese Computer Systems, 2017, 38(12): 2630-2636.(in Chinese)

[10] Tzortzis G, Likas A, Tzortzis G. The Min Max K-means clustering algorithm[J]. Pattern Recognition, 2014, 47(7): 2505-2516.

[11] Avila S, Lopes A, Luz A, et al. VSUMM: A mechanism

designed to produce static video summaries and a novel evaluation method[J]. Pattern Recognition Letters, 2011, 32(1): 56- 68.

[12] Dementhon D, Kobla V, Doermann D. Video summarization by curve simplification[C]∥ACM International Conference on Multimedia, 1999: 211-218.

[13] Mundur P, Rao Y, Yesha Y. Keyframe-based video summarization using delaunay clustering[J]. International Journal on Digital Libraries, 2006, 6(2): 219-232.

[14] Mahmoud K M, Ismail M A, Ghanem N M. VSCAN: an enhanced video summarization using density-based spatial clustering[C]∥International Conference on Image Analysis and Processing(ICIAP), 2013: 733-742.

[15] Li J T, Yao T, Ling Q, et al. Detecting shot boundary with sparse coding for video summarization[J]. Neurocomputing, 2017, 266: 66-78.

[16] 冀中, 马亚茹, 何宇清. 最大边界重要和覆盖的视频摘要方法[J]. 计算机科学与探索, 2018, 12(8): 1286-1294.

Ji Zhong, Ma Yaru, He Yuqing. Video Summarization with Maximal Marginal Importance and Coverage[J]. Journal of Frontiers of Computer Science and Technology, 2018, 12(8): 1286-1294.(in Chinese)