1 引言

近年来,在移动、车载和云平台上出现了越来越多的基于图像和视频的应用,涉及各种各样的数字屏幕内容图像(Screen Content Image, SCI),屏幕图像处理获得了越来越多的关注[1]。由于在屏幕图像采集、传输、编码和显示等各种处理过程中不可避免的各种失真可能会降低屏幕图像的视觉质量,因此,在各种屏幕图像处理应用中为其设计准确有效的质量评价方法极其重要。

目前图像质量评价(Image Quality Assessment,IQA)的方法主要分为三类:全参考型(Full-Reference,FR),半参考型(Reduced-Reference,RR)以及无参考型(No-Reference, NR)。不同类型方法有不同的应用场景。对于全参考和半参考图像质量评价都需要用到原始图像的参考信息,而无参考图像质量评价则不需要原始图像的任何信息。针对屏幕图像,研究人员在算法的设计过程中结合了人类视觉系统的特性已经提出一些全参考屏幕图像质量评价方法,如边缘相似度(Edge Similarity,ESIM)[1]、基于Gabor特征的模型(Gabor Feature-based Model,GFM)[2]和结合空域和频域边缘信息的方法[3]等,以及半参考屏幕图像质量评价方法,如基于视觉不确定性的RR-IQA[4]。然而,在现实世界中我们往往无法获得原始屏幕图像的参考信息,所以无参考屏幕图像质量评价算法的研究更加具有现实意义。

近年来,越来越多研究人员围绕无参考图像质量评价方法展开研究。Fang等[5]为NR IQA设计了一种自然场景统计模型,假设自然场景图像具有相似的统计特性, 当图像失真时这种统计特性会发生改变,通过计算统计特性的变化程度可以进行图像质量的预测。Gu等[6]通过计算图像相关特征在自回归模型中的空间参数从而设计出一种无参考自然场景图像度量方法。Zhang等[7]揉合了梯度、LOG-Gabor滤波响应、颜色等多种特征提出了综合局部质量分布的无参考图像质量评价方法。

然而,上述无参考图像质量评价方法都是针对自然图像而设计的。与自然图像不同,屏幕图像包括不同形式的视觉内容复合,如摄像机拍摄得到的自然场景以及计算机生成的文本,框图等等。无参考自然图像质量评价方法并不能很好地评价屏幕图像。针对屏幕图像,Gu等[8]通过对屏幕图像的图像复杂性、屏幕内容统计、全局亮度以及锐利细节的衡量,提出一种无参考模型SIQE。Fang等[9]结合屏幕图像的统计亮度特征和纹理特征提出了一种无参考屏幕图像质量评价方法(NRLT)。Shao等[10]提出基于稀疏表示的BLIQUP-SCI模型。该模型分别对文本和图像区域进行局部稀疏表示,以揭示屏幕图像中局部区域的不同属性,并对全局屏幕图像进行全局稀疏表示以提取全局属性,两两结合从而判断失真屏幕图像的主观质量。

为了更准确有效地评价屏幕图像质量,本文提出了一种基于特征融合的无参考屏幕图像质量评价方法。考虑到人眼对于图像边缘信息和局部纹理信息比较敏感,所提方法利用梯度方向直方图(Histogram of Gradient, HOG)和局部二值模式(Local Binary Pattern, LBP)分别描述屏幕图像的边缘信息和局部纹理,两两融合形成可同时反映屏幕图像边缘和局部纹理的融合特征向量,接着采用支持向量回归网络进行训练得到屏幕图像融合特征向量与主观质量分数的质量评价映射模型,以准确评价屏幕图像质量。实验结果表明,本文所提无参考屏幕图像质量评价方法能够较好地描述人眼对屏幕图像的主观感知度。

2 基于特征融合的无参考屏幕图像质量评价方法

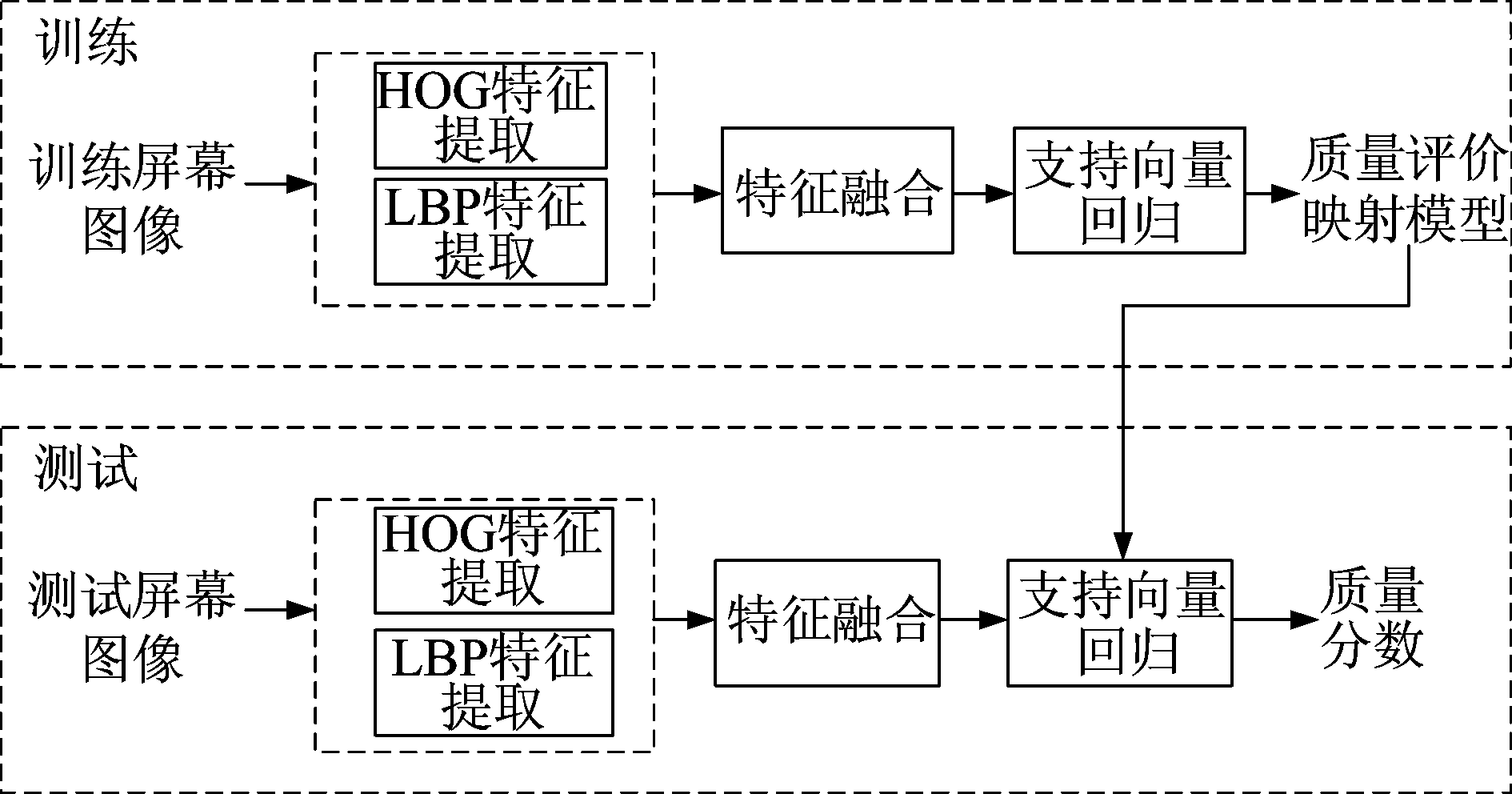

如图1所示,本文所提基于特征融合的无参考屏幕图像质量评价方法主要包括融合特征提取和质量评价映射模型计算,具体细节将在以下小节中详细介绍。

图1 基于特征融合的无参考屏幕图像质量评价方法流程图

Fig.1 Flowchart of proposed feature fusion based no reference quality assessment model for the SCI

2.1 融合特征提取

与自然图像相比,屏幕图像既包含自然场景又包含大量的图表和文字,自然而然就拥有大量边缘和局部纹理信息。考虑到人眼视觉系统对图像边缘和纹理信息感兴趣,所提方法分别通过梯度方向直方图HOG和局部二值模式LBP来提取屏幕图像的边缘和局部纹理信息,进而进行特征融合得到一个更能反映屏幕图像失真的融合特征。

1)HOG 特征提取:对于输入屏幕图像,HOG特征提取过程如下:

首先,计算屏幕图像的梯度方向和梯度幅值

(1)

(2)

其中,水平梯度Gx(x,y)和垂直梯度Gy(x,y)计算如下:

Gx(x,y)=H(x+1,y)-H(x-1,y)

(3)

Gy(x,y)=H(x,y+1)-H(x,y-1)

(4)

接着,对输入屏幕图像以16×16为统计单元计算HOG特征向量[11]:将16×16统计单元划分成不重叠的4个8×8的小单元格,采用9个Bin的直方图来统计每个8×8小单元格的梯度方向信息,接着进行串联得到相应的HOG特征向量。具体而言,对于每个小单元格,将梯度方向范围180°平均分成9个Bin,每个Bin为20°。对于小单元格中的每个像素(x,y),当其梯度方向归属于9个Bin中的角度范围,则将其对应的梯度幅值累加到该Bin以作为直方图纵轴。为了提高对亮度变化和噪声的鲁棒性,每个小单元格的梯度直方图向量B进行归一化操作:

(5)

其中ε是个取值较小的常数以确保计算可靠性。

2)LBP特征提取:对于输入屏幕图像,LBP特征提取过程如下:

首先,通过3×3局部二值模式LBP[12]来计算提取屏幕图像中每个像素的LBP特征,也就是在3×3的窗口内,以窗口中心像素为阈值,将相邻的8个像素的灰度值进行比较,若周围像素值大于中心像素值,则该像素点的位置被标记为1,否则为0。

(6)

其中![]() 表示领域样本的数量,R=1为域半径,gc为中心像素点,gp为邻域像素点,S为符号函数。

表示领域样本的数量,R=1为域半径,gc为中心像素点,gp为邻域像素点,S为符号函数。

接着,对输入屏幕图像以16×16为统计单元,根据如下公式计算每个统计单元的LBP直方图HLBP,以描述该统计单元的局部纹理信息:

(7)

其中k∈[0,K]为第k种LBP模式值,K为最大LBP模式值,![]() 为统计单元内所有像素集合。

为统计单元内所有像素集合。

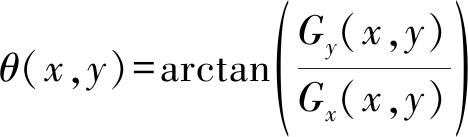

图2 特征融合示意图

Fig.2 An illustration of feature fusion

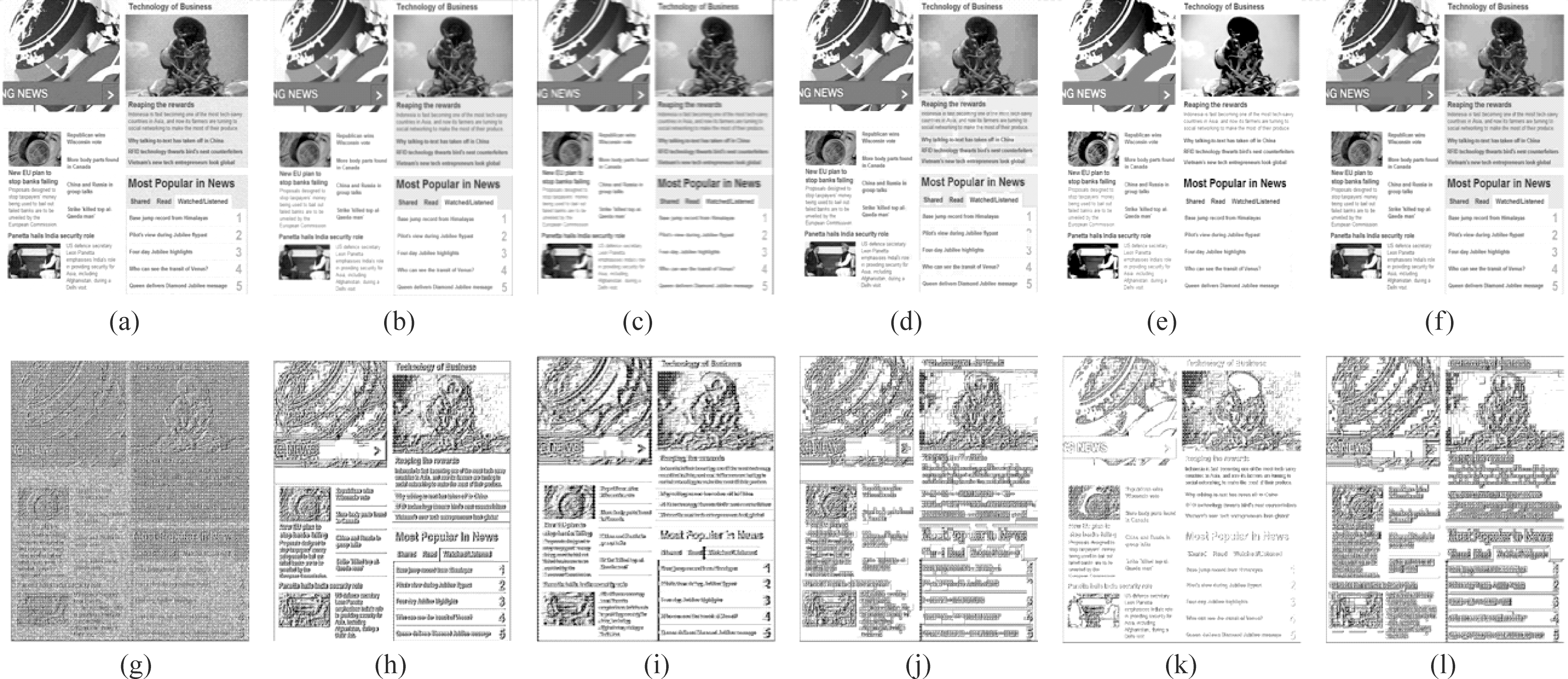

3)特征融合:考虑到HOG特征和LBP特征可以互相补充描述屏幕图像特征,本文提出一个简单有效的特征融合过程,将HOG特征向量和LBP特征向量进行串联以得到融合特征如图2所示。图3进一步展示了不同失真屏幕图像的融合特征图。由对比可得,不同类型的失真屏幕图像的融合特征图差异较大。也就是说,所提融合特征能有效地描述屏幕图像中边缘信息变化和纹理信息变化,从而有效地反应人眼对于屏幕图像失真的主观感知度。

2.2 质量评价映射模型计算

如图2所示,在训练阶段,给定训练数据集中的每一个失真屏幕图像,分别通过上述融合特征提取过程得到融合特征向量后,将失真屏幕图像的融合特征和失真屏幕图像的主观分数值输入到支持向量机(SVM)[13]进行训练得到从融合特征到主观分数的质量评价映射模型。在测试阶段,给定一张待测试失真屏幕图像,同样计算方式得到融合特征,采用训练所得质量评价映射模型,即可得到失真屏幕图像质量分数值。

图3 屏幕图像融合特征示意图: (a) 高斯噪声;(b)高斯模糊;(c)运动模糊;(d)分层式压缩失真;(e)对比度失真;(f)JPEG压缩失真;(g)~(l)为上述失真屏幕图像(a)~(f)对应的融合特征图

Fig.3 An illustration of fused feature of SCIs: (a) Gaussian noise; (b) Gaussian blur; (c) Motion blur; (d) Layer segmentation based coding; (e) Contrast change;

(f) JPEG compression; (g)~(l) are the fused feature maps of distorted SCIs (a)~(f)

3 实验结果和分析

为了测试所提方法的有效性,我们在SCI数据库SIQAD[14]和QACS[15]上进行了比较实验。SIQAD[14]数据库包含了分别从网页,幻灯片,PDF文件和数字杂志等获得的20张参考屏幕图像。每张参考图像产生7种失真类型包括高斯噪声(GN)、高斯模糊(GB)、运动模糊(MB)、对比度变化(CC)、JPEG压缩(JPEG)、JPEG2000压缩(J2K)和分层式压缩(LSC)。每种失真类型对应有7个降级级别,共产生980张失真屏幕图像。QACS[15]数据库中包含了24张参考屏幕图像,每张参考图像产生HEVC和HEVC-SCC两种压缩失真,每种失真类型对应11个降级级别,共产生492张失真屏幕图像。我们随机将两个数据库中的80%图像作为训练集,20%图像作为测试集,测试重复1000次,报告其中位数性能。此外,我们采用图像质量评价领域常用的指标来比较不同方法的性能:包括用于评估预测单调性的斯皮尔曼等级相关系数(Spearman Rank Order Correlation Coefficient,SROCC),用于评估预测精度的皮尔逊线性相关系数(Linear Pearson Correlation Coefficient,PLCC)和用于描述客观和主观得分之间偏差度的均方根误差(Root Mean Squared Error,RMSE)。性能更好的图像质量评价方法具有更高的SRCC和PLCC值,以及更低的RMSE值。

3.1 整体性能比较

在本文实验中,我们将所提方法与现有无参考图像质量评价方法进行比较,包括ILNIQE[7]、BLIQUP-SCI[10]、BQMS[16]、GWH-GLBP[17]、NIQE[18]、NRLT[9]和SIQE[8],其中BLIQUP-SCI[10]、BQMS[16]、NRLT[9]和SIQE[8]是专门针对屏幕图像而设计的无参考图像质量评级法方法。

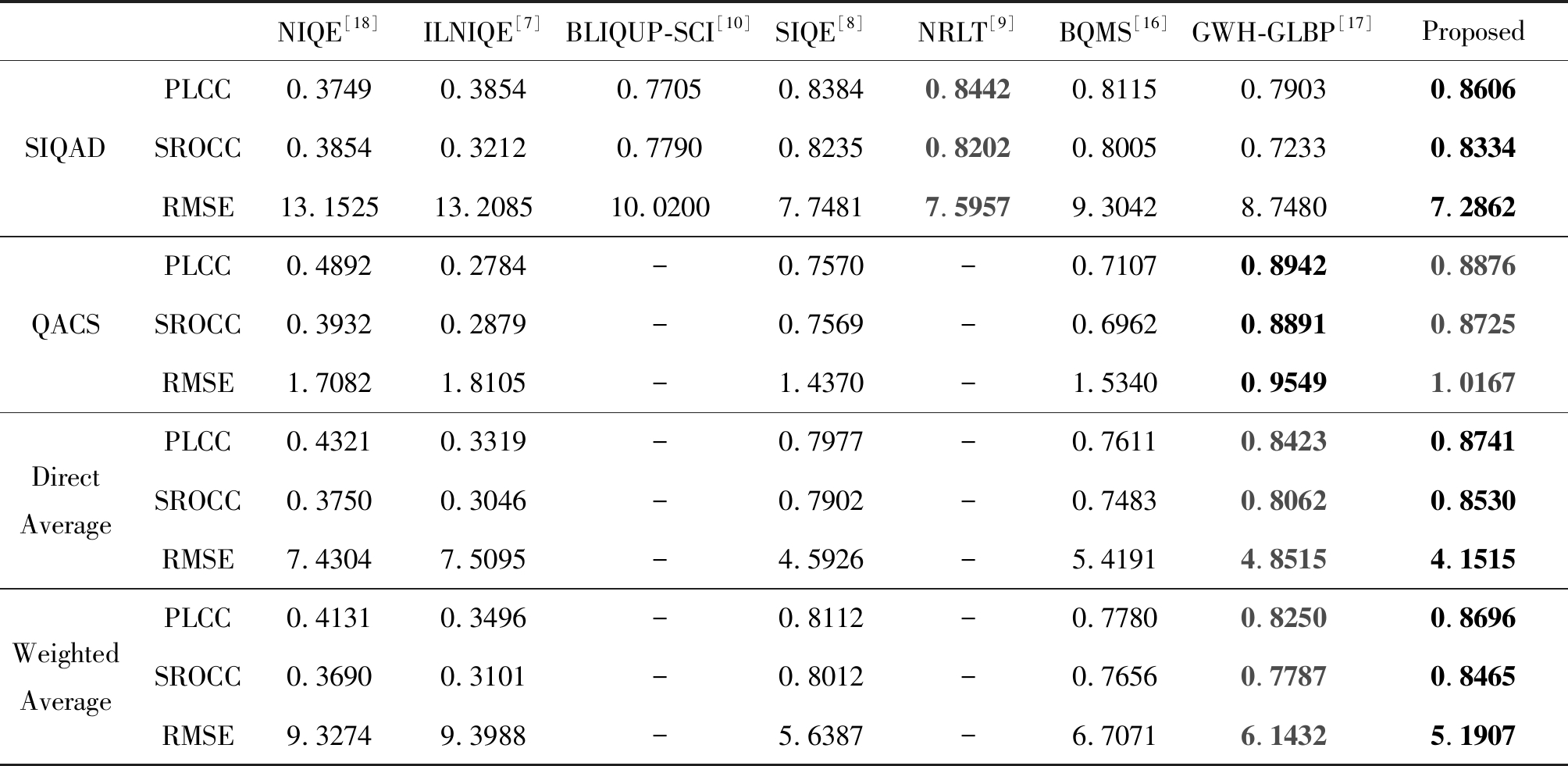

表1列出了SIQAD和QACS数据库上各种IQA模型的总体性能,其中红色和蓝色粗体标注的分别是性能最好和第二好的模型。由于BLIQUP-SCI[10]和NRLT[9]没有提供源代码所以我们无法得到这两种算法在新数据集QACS的测试结果,其在数据集SIQAD上的结果取自于原论文。通过比较表格中PLCC,SROCC,RMSE三个性能评价指标可以看出:(1)NIQE[18]和ILNIQE[7]等基于自然图像统计特性的评价方法在屏幕图像评价表现比较差,这是因为他们在设计过程中没有考虑屏幕图像的特性。(2)基于梯度信息设计的GWH-GLBP[17]可以在屏幕图像质量评价中获得较高性能,这表明梯度所反应的边缘信息可以很好地捕获屏幕图像的失真[19]。(3)在SIQAD数据库中本文所提基于特征融合的无

表1 各种无参考图像质量评价算法在数据库SIQAD和QACS中的性能比较

Tab.1 Performance Comparison among Various No Reference IQA Models on the SIQAD and the QACS Databases

NIQE[18]ILNIQE[7]BLIQUP-SCI[10]SIQE[8]NRLT[9]BQMS[16]GWH-GLBP[17]ProposedPLCC0.37490.38540.77050.83840.84420.81150.79030.8606SIQADSROCC0.38540.32120.77900.82350.82020.80050.72330.8334RMSE13.152513.208510.02007.74817.59579.30428.74807.2862PLCC0.48920.2784-0.7570-0.71070.89420.8876QACSSROCC0.39320.2879-0.7569-0.69620.88910.8725RMSE1.70821.8105-1.4370-1.53400.95491.0167PLCC0.43210.3319-0.7977-0.76110.84230.8741DirectAverageSROCC0.37500.3046-0.7902-0.74830.80620.8530RMSE7.43047.5095-4.5926-5.41914.85154.1515PLCC0.41310.3496-0.8112-0.77800.82500.8696WeightedAverageSROCC0.36900.3101-0.8012-0.76560.77870.8465RMSE9.32749.3988-5.6387-6.70716.14325.1907

参考屏幕图像质量评价方法取得最高的PLCC和SROCC值以及最低的RMSE值,说明本方法的性能优于其他现有无参考图像质量评价方法,这是因为本文方法充分考虑了屏幕图像的边缘信息和局部纹理信息。在QACS数据库中本文所提方法虽然性能第二,但几乎与GWH-GLBP[17]性能相当。

为了进一步展示在多个数据库上的综合性能比较,本文采用了两种常用的度量方法来比较不同质量评价方法在SIQAD和QACS数据库上的性能[2]。这两种平均度量方法的定义如下:

(8)

其中M=2为数据库的数量,pi代表第i个数据库(i=1,2分别对应SIQAD和QACS)上的性能指标(如PLCC、SROCC、RMSE)的值,wi为第i个数据库对应权重。对于第一个平均度量方法——直接平均法,设置w1=w2 =1。对于第二个平均度量方法——加权平均法,wi将依赖于数据库的大小,即第i个数据库上失真屏幕图像的总数是:(SIQAD为980,QACS为492)。如表1所示,在直接平均和加权平均性能比较中,本文所提方法的PLCC、SROCC得分最高,而RMSE得分最低。这意味着所提方法优于其他IQA模型。

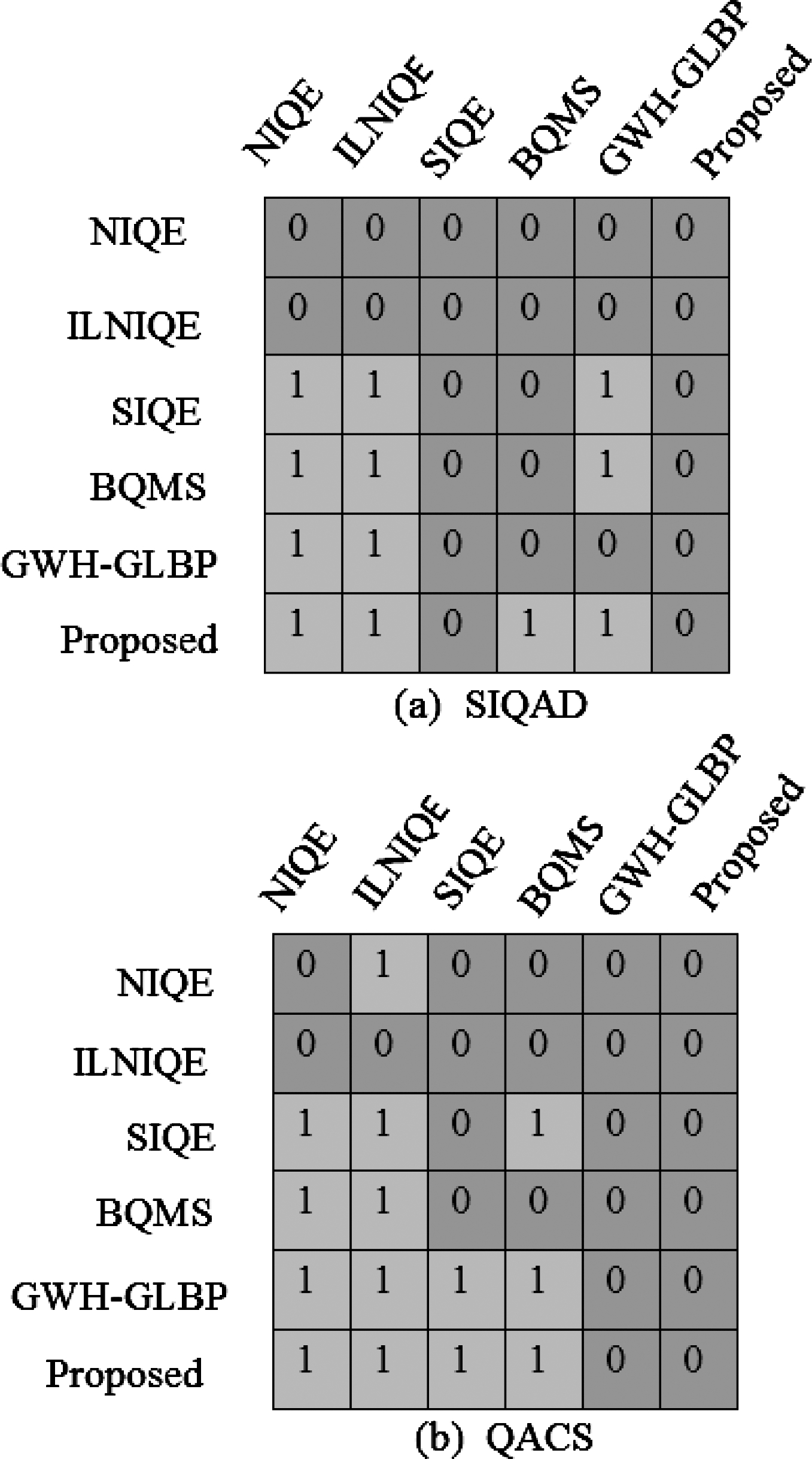

3.2 统计显著性检验

在本文中,我们采用了[20]中建议的常用F检验,通过评估两个IQA模型之间性能差异的统计显着性,以定性对比两个方法的优越性。SIQAD和QACS数据库的相应结果如图4中(a)、(b)所示。

图4 定性对比图

Fig.4 Quantitative comparison graph

其中“1”表示行中的IQA模型明显优于列中的IQA模型,“0”表示IQA模型并没有明显优于列中的模型。从图4进一步可以看出,在SIQAD和QACS数据库中,没有IQA模型比本文所提模型表现得更好。该统计显着性研究进一步表明,本文所提模型在各种IQA模型中具有最佳性能,这与表1整体性能比较的结果一致。

4 结论

考虑到屏幕图像特性,本文提出了一种基于特征融合的无参考屏幕图像质量评价方法。该方法将提取到HOG和LBP特征进行融合得到融合特征,随后采用支持向量回归得到从屏幕图像的融合特征到主观评级的质量评价映射模型,以准确评价屏幕图像。通过实验可知,本文所提方法能够更加准确地反应人类视觉特性对屏幕图像的主观质量判定。

[1] Ni Zhangkai, Zeng Huanqiang, Cai Canhui, et al. ESIM: Edge Similarity for Screen Content Image Quality Assessment[J]. IEEE Transactions on Image Processing, 2017, 26(10): 4818- 4831.

[2] Ni Zhangkai, Ma Lin, Zeng Huanqiang, et al. A Gabor Feature-Based Quality Assessment Model for the Screen Content Images[J]. IEEE Transactions on Image Processing, 2018, 27(9): 4516- 4528.

[3] 符颖, 曾焕强, 倪张凯, 等. 采用边缘信息的屏幕图像质量评价 [J]. 信号处理, 2017, 33(4): 540-545.

Fu Ying, Zeng Huanqiang, Ni Zhangkai, et al. Screen Content Image Quality Assessment Using Edge Information [J]. Journal of Signal Processing, 2017, 33(4): 540-545.(in Chinese)

[4] Wang S, Gu K, Zhang X, et al. Reduced-reference quality assessment of screen content images[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2018, 28(1): 1-14.

[5] Fang Y, Ma K, Wang Z, et al. No-reference quality assessment of contrast-distorted images based on natural scene statistics[J]. IEEE Signal Processing Letters, 2015, 22(7): 838- 842.

[6] Gu K, Zhai G, Lin W, et al. No-reference image sharpness assessment in autoregressive parameter space[J]. IEEE Transactions on Image Processing, 2015, 24(10): 3218-3231.

[7] Zhang L, Zhang L, Bovik A C. A feature-enriched completely blind image quality evaluator[J]. IEEE Transactions on Image Processing, 2015, 24(8): 2579-2591.

[8] Gu K, Zhou J, Qiao J F, et al. No-reference quality assessment of screen content pictures[J]. IEEE Transactions on Image Processing, 2017, 26(8): 4005- 4018.

[9] Fang Y, Yan J, Li L, et al. No reference quality assessment for screen content images with both local and global feature representation[J]. IEEE Transactions on Image Processing, 2018, 27(4): 1600-1610.

[10] Shao F, Gao Y, Li F, et al. Toward a blind quality predictor for screen content images[J]. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2018, 48(9): 1521-1530.

[11] Cai L, Zhu J, Zeng H, et al. Hog-assisted deep feature learning for pedestrian gender recognition[J]. Journal of the Franklin Institute, 2018, 355(4): 1991-2008.

[12] Zeng H, Chen J, Cui X, et al. Quad binary pattern and its application in mean-shift tracking[J]. Neurocomputing, 2016, 217: 3-10.

[13] Alam S, Kang M, Pyun J Y, et al. Performance of classification based on PCA, linear SVM, and Multi-kernel SVM[C]∥2016 Eighth International Conference on Ubiquitous and Future Networks(ICUFN). IEEE, 2016: 987-989.

[14] Yang H, Fang Y, Lin W, et al. Subjective quality assessment of screen content images[C]∥2014 Sixth International Workshop on Quality of Multimedia Experience(QoMEX). IEEE, 2014: 257-262.

[15] Wang S, Gu K, Zhang X, et al. Subjective and objective quality assessment of compressed screen content images[J]. IEEE Journal on Emerging and Selected Topics in Circuits and Systems, 2016, 6(4): 532-543.

[16] Gu K, Zhai G, Lin W, et al. Learning a blind quality evaluation engine of screen content images[J]. Neurocomputing, 2016, 196: 140-149.

[17] Li Q, Lin W, Fang Y. No-reference quality assessment for multiply-distorted images in gradient domain[J]. IEEE Signal Processing Letters, 2016, 23(4): 541-545.

[18] Mittal A, Soundararajan R, Bovik A C. Making a “completely blind” image quality analyzer[J]. IEEE Signal Processing Letters, 2013, 20(3): 209-212.

[19] 邢露, 曾焕强, 倪张凯, 等. 针对对比度变化的图像质量评价方法 [J]. 信号处理, 2017, 33(3):319-323.

Xing Lu, Zeng Huanqiang, Ni Zhangkai, et al. Contrast-Changed Image Quality Assessment Method [J]. Journal of Signal Processing, 2017, 33(3):319-323.(in Chinese)

[20] Xue W, Zhang L, Mou X, et al. Gradient magnitude similarity deviation: A highly efficient perceptual image quality index[J]. IEEE Transactions on Image Processing, 2014, 23(2): 684- 695.