1 引言

近年来公共安全问题日益受到关注,而人群中的异常行为严重影响着人们的生命财产安全,因此视频异常检测成为图像处理、机器视觉等相关领域的研究重点与热点。

研究人员提出多种检测方法,从特征提取角度,异常事件通常伴随目标的运动速度变化,光流作为一种有效的运动描述子被广泛应用。例如,Wang等[1]采用SL-HOF和ULGP-OF两个新颖的局部运动视频描述子提取特征,SL-HOF描述符可以捕捉时空兴趣块中三维局部区域变化的空间分布信息,ULGP-OF描述符结合纹理描述符LGP和光流,描绘前景运动时比正常HOF描述更为精确。除光流外,运动轨迹作为可靠特征提供物体的运动信息,物体的长度、像素、位置等信息也能够较好的表示。文献[2]将运动区域的短时局部轨迹(Short Local Trajectories, SLT)作为描述前景对象的超像素特征以表示运动对象的时空信息,使用隐马尔可夫模型(Hidden Markov Model, HMM)检测定义区域中异常物体或行为,在具有不同人群密度、包含遮挡的视频中能达到良好的效果。从训练数据角度,由于异常行为往往很少发生,可用于训练的异常数据较为匮乏,针对此问题,Hajananth等[3]在训练阶段采用高斯混合模型(Gaussian Mixture Model,GMM)对正常行为的光流加速度和光流梯度直方图进行聚类,在测试阶段采用基于马尔可夫随机场(Markov Random Field, MRF)的高斯混合模型(GMM-MRF)对新样本进行相似度评分估计,从而得到可靠的异常检测效果。此外,Liu等[4]采用一种可适用于多种场景下的动态更新的双字典稀疏表示方法,从只包含正常样本的训练样本集中得到正常字典,通过稀疏表示方法和正常字典对测试样本进行分类,如果分类结果为正常,则将这一特征加入到正常字典进行字典的动态更新,如果分类结果为异常,则将这一特征动态更新到异常字典中。视频异常检测与行为识别具有相似性,具体来说视频异常检测是行为识别和目标检测的融合,近年来基于骨架的人体行为识别已成为研究的热点,Yang Yanhua等人认为三维关节对不同的动作类别反应不同,且某些关节配置对于区分动作具有较强的辨别性,因此采用了多实例多任务框架用以发现关节配置与动作之间的内在联系,提高了动作识别的准确率,基于骨架关节与动作的潜在联系,提出潜在最大边缘多任务三维动作识别学习模型,通过利用骨架作为关节的中间粒度来描述动作,并应用学习模型来获得潜在骨架和动作之间的相关性[5- 6]。

近年,深度学习的发展为计算机视觉领域取得了突破性的进展,二维卷积神经网络模型是针对图像的卷积形式,只能提取到二维信息。为此,Tran等[7]提出深度3维卷积神经网络(3 Dimension Convolution Network,C3D)将视频的连续帧作为输入获得时空特征,解决了视频中的行为分类问题。Zhou等[8]使用C3D检测和定位视频中的异常行为,将整个视频中可能存在的时空兴趣块作为C3D的输入,检测异常行为及异常发生的位置。同时,Sabokrou等[9]采用级联深度网络的方法,由三维自动编码器检测出时空兴趣块送入C3D中进行训练,对异常进行快速检测和定位。卷积神经网络是有监督的算法,如何进行无监督的学习依然是个难点。为此,Mahdyar等[10]通过生成对抗网络(Generative Adversarial Nets,GAN)中生成模型和判别模型之间的博弈实现视频异常检测的无监督学习。在测试阶段将真实数据的外观表示和运动表示与正常数据进行比较,计算局部符合程度检测异常区域。深度神经网络尤其是卷积神经网络,效果显著但训练时间过长,实时性较差。因此,Roberto等[11]采用基于二进制特征行为表示的异常检测方法,首先对输入视频帧图像进行前景计算和时间梯度计算,利用时间梯度及快速分割检测探测器(Fast Accelerated Segmentation Test,FAST)检测时空兴趣点(Spatial Temporal Interest Points,STIPs),再采用二进制小波差异(Binary Wavelets Differences, BWD)对时空兴趣块进行编码,最后通过GMM快速准确检测异常事件。

本文提出基于时空深度特征的AP(affinity propagation clustering)聚类稀疏表示视频异常检测方法,针对视频序列中大量的背景信息,采用光流法对运动目标进行提取,剔除噪音的同时简化计算,针对视频场景中信息分布不均匀的情况,采用非均匀细胞结构对视频帧进行分割,保证在拥挤人群中分割出的细胞尽可能多的包含单个物体的全部信息。在字典学习中加入AP聚类方法减小字典尺寸同时降低稀疏表示对运算内存的要求。采用AP聚类对测试样本进行聚类,简化计算的同时降低稀疏表示对阈值的敏感度。

2 基于时空深度特征AP聚类的稀疏表示视频异常检测

2.1 系统组成框图

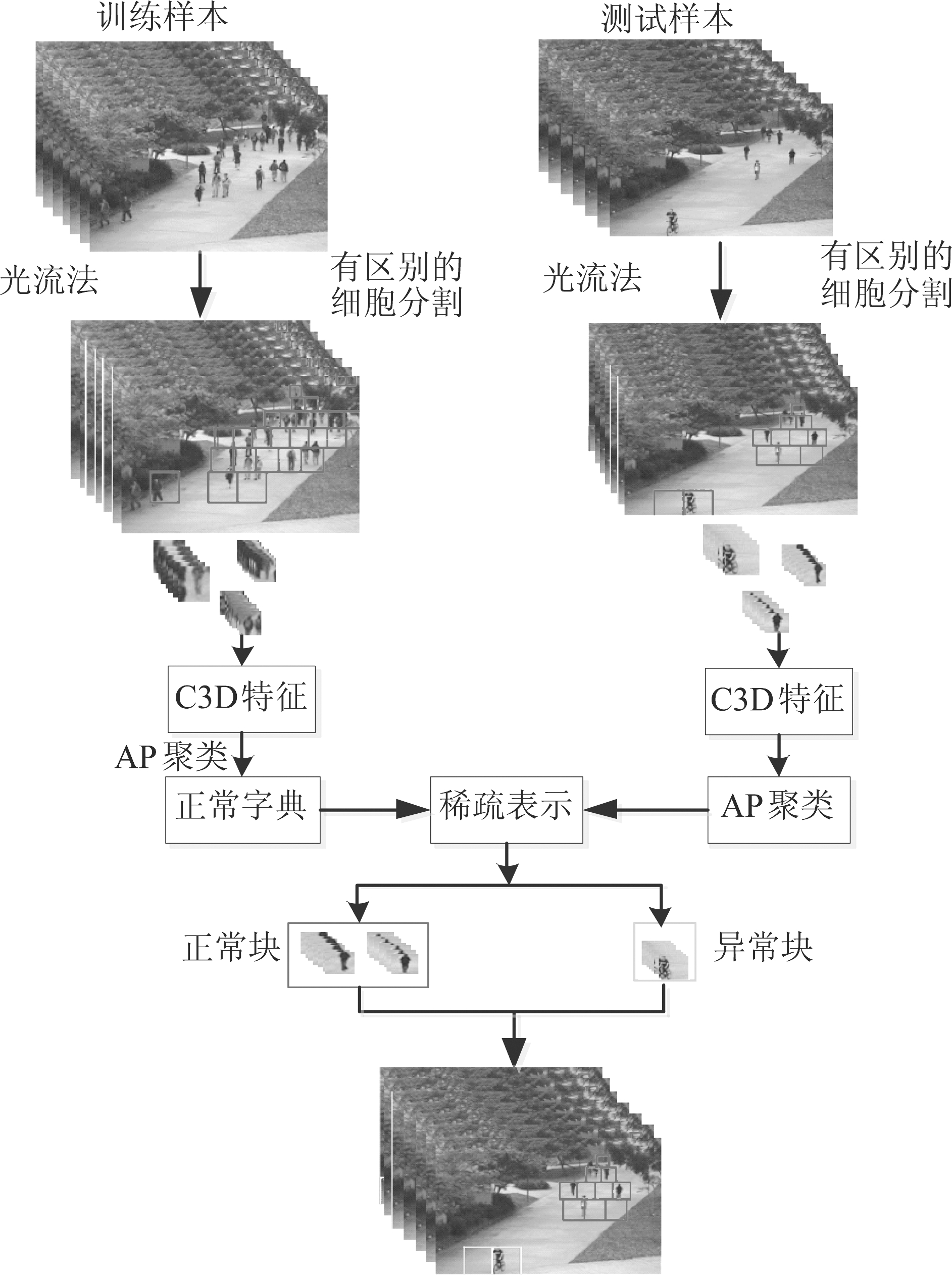

图1 本文所采用视频异常检测方法流程图

Fig.1 The flow chart of the video anomaly detection method used in this paper

图1描述了本方法的系统组成,首先对视频帧进行非均匀细胞分割,使得较大的单元格包含较多有效目标信息,结合光流算法得到运动目标所在区域的连续K(7)帧视频块,将其作为时空兴趣块,时空兴趣块经调整大小后送入C3D网络中提取时空深度特征并进行训练。在字典学习时结合AP聚类以减少正常字典维度,同时采用基于AP聚类的稀疏表示分类方法实现视频场景中异常行为的检测。仅对测试样本的AP聚类中心进行稀疏表示分类不仅可以减少相似样本的重复分类以简化计算还能降低稀疏表示分类方法对阈值的敏感度。

2.2 非均匀细胞分割

监控摄像头往往以俯瞰的方式拍摄监控视频,距离摄像头较近的物体在监控画面中处于靠下位置并占据较大面积,而距离摄像头较远的物体以较小的面积处于视频画面中的靠上位置。在提取特征时将摄像头在场景中的位置考虑在内可以显著提高异常检测性能[12]。本文针对视频场景中物体位置与物体含有信息量的关系在空间域采用互不重叠且尺寸不同的网络结构对帧画面进行划分从而实现运动目标检测。

单元格的形状始终保持长宽相等的正方形。若用yk表示第k行单元格的长宽,则第k+1行的单元格的长宽可以用公式(1)表示:

yk+1=ayk

(1)

若单元格的增长速率a恒定不变,若用Y表示图片的宽,则

(2)

此时单元格结构设置符合等比数列,即:

(3)

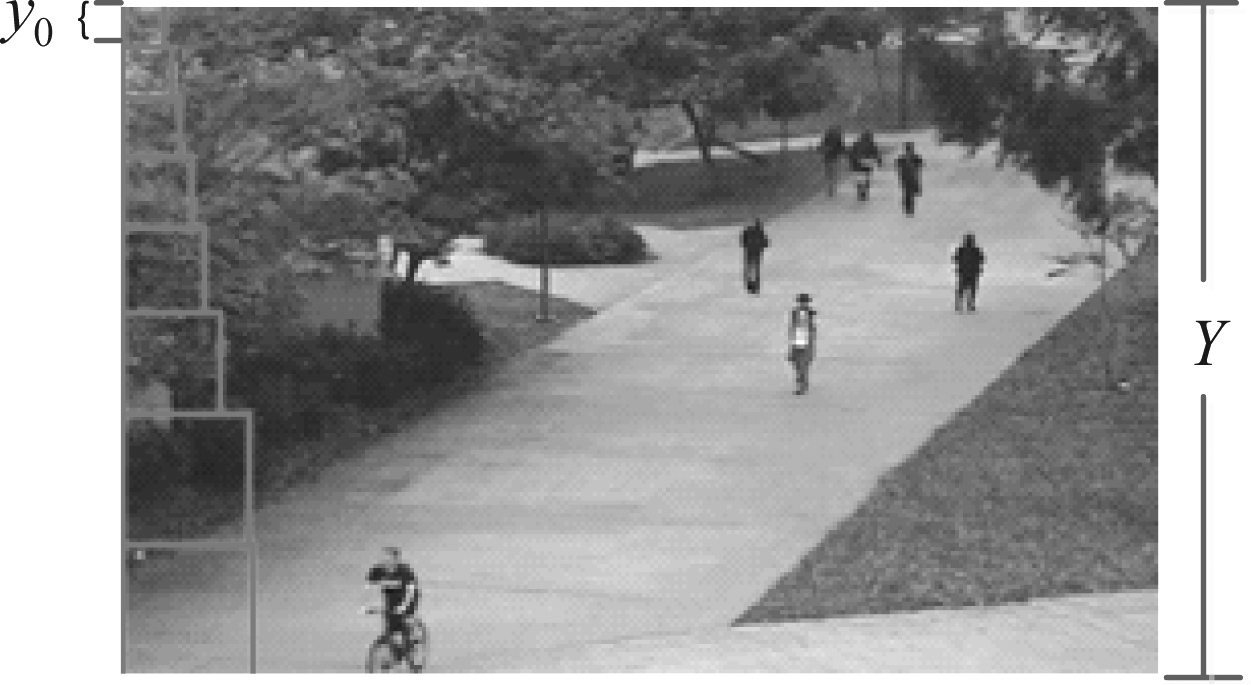

图2 非均匀细胞分割单元格结构设置原理示意图

Fig.2 Distinct cell segmentation cell structure schematic

n表示单元格共有n行,y0表示第一行单元格的大小。单元格结构设置的原理如图2所示。进行单元格结构设置时,a的值可以始终固定不变,也可以每次使用不同的值,根据图片的尺寸和运动目标大小选择合适的单元格增长速率a。单元格的设置既要满足目标的大部分信息被捕捉,也要保证从全局来讲大部分的信息被捕捉,这不仅需要选取合适的增长速度a,y0的选择也非常重要。

2.3 三维卷积神经网络(C3D)

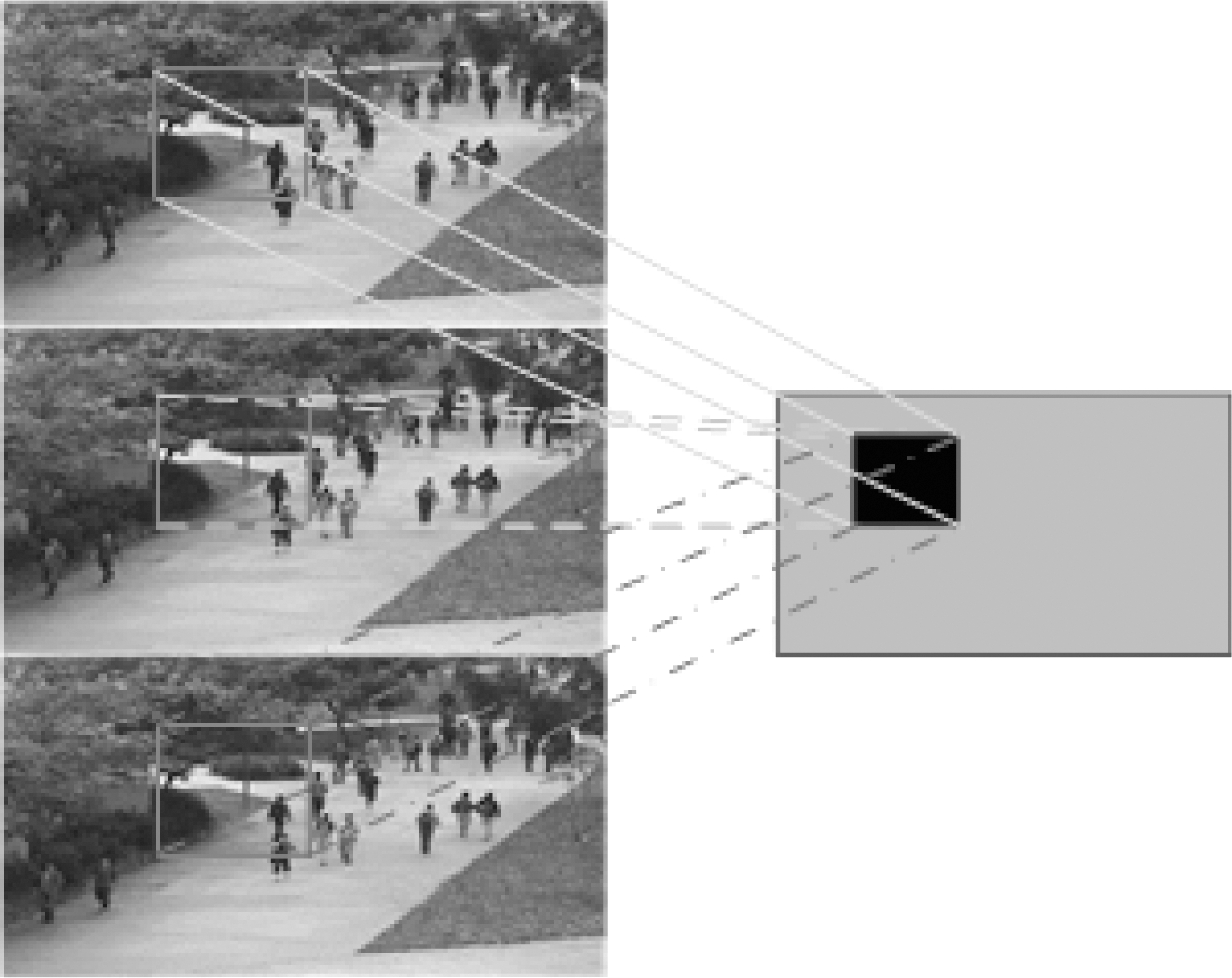

图3 C3D对图像序列(视频)采用3D卷积核进行卷积操作

Fig.3 Illusion of the spatial-temporal convolution across both spatial and temporal domains

卷积神经网络为视觉表示提供了新思路,例如文献[13]提出采用并行的双流网络分别对单张图片的空间信息和视频序列的光流图在同一网络结构中进行训练获得时空信息。但该方法的输入依旧是基于手工特征,在一定程度上制约了有效信息的提取。文献[7]提出使用C3D获得视频连续帧的时空特征,C3D采用三维卷积核在时空域的三维坐标内对视频信息进行卷积操作,符合视频本身的时空域组成,可提取到更能表示视频信息的特征。C3D对图像序列进行卷积操作如图3所示,进行卷积操作的时间维度为3,即对连续的三帧图像进行卷积操作,3D卷积是通过堆叠多个连续帧组成一个立方体,然后在立方体中运用3D卷积核。在这个结构中,卷积层中每一个特征map都会与上一层中多个邻近的连续帧相连,依此捕捉运动信息。一个卷积map的某一位置的值是通过卷积上一层的三个连续的帧的同一个位置的局部感受野得到的。CNN中的卷积操作的特征图可由下式计算得出:

aij=f(Wn*a(i-1)n+bij)

(4)

aij为由第i层中的第j个的特征图,a(i-1)n表示此时的输入由第(i-1)层得到的n个特征图,Wn为权重,*表示卷积操作,bij为此时偏置。Wn及bij的值由训练得到。三维卷积核对视频块的时空卷积运算可由下式表示:

(5)

UiViRi分别代表三维卷积核的高度宽度和时域长度,x×y×t是视频块a(i-1)n的大小。

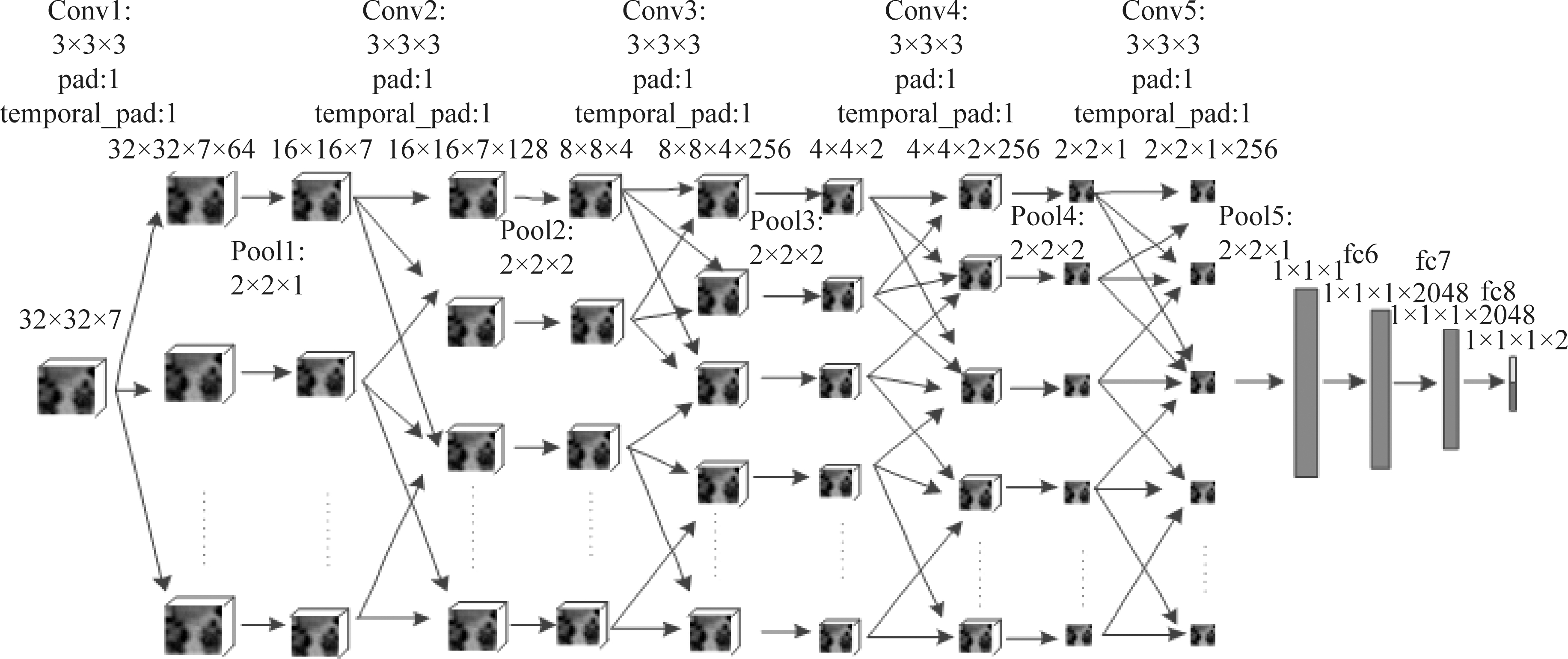

采用三维卷积神经网络进行特征提取时,所得到的三维深度特征不仅包含描述二维图像的空间深度特征还包含对于速度等进行描述的时域特征,该特征从时间域和空间域对视频块进行描述和表示,更能表示视频信息。在视频异常检测中,异常种类多样,不同的异常动作被识别需要的时间不同。过于短时间会导致动作表示不充分,但过长的时间不仅使得视频块包含的信息种类过多从而影响异常的检测还会造成网络训练时较高的数据存储代价和运行时间代价。因此,本文采用时长为K=7帧的时空兴趣块对不同的行为进行描述,在学习时空兴趣块完整的时空特征的同时,保证运动目标动作的准确表示。采用的网络框架是基于VGG-16的C3D框架,这一框架中每个卷积层都进行边缘扩充(pad),保证卷积操作的输入输出大小尺寸相同。网络框图如图4所示。本文所采用的C3D网络中,所有的池化层都采用最大值池化方式,并采用Softmax分类器。在进行CNN训练时在网络结构中采用3×3×3卷积核实现对视频序列的描述。

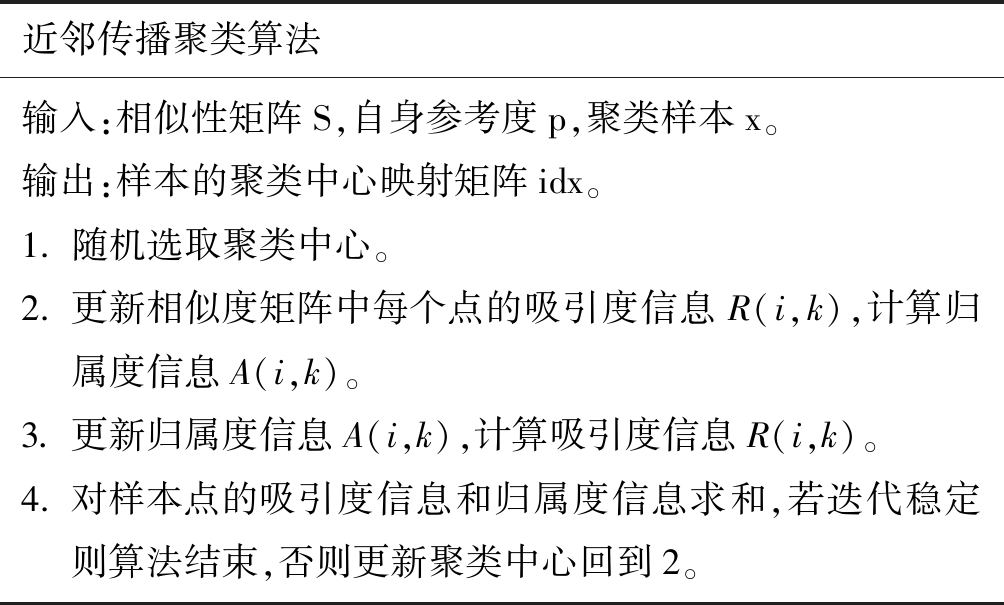

2.4 近邻传播聚类

近邻传播聚类算法(affinity propagation clustering, AP)能够在较短时间内对大规模多类别数据进行高效聚类,通过改良数据点间的相似度计算可以解决非欧空间聚类问题[14],该聚类算法无需事先指定聚类数目,相反它将所有的数据点都作为潜在的聚类中心即exemplar,而不是新生成一个聚类中心,因此该算法对数据的初始值不敏感。算法基于置信传播,在邻近节点之间传播置信信息(massage), 该信息包含吸引度信息(responsibilities)和归属度信息(avaibulities)两种,吸引度信息R(i,k)用来描述数据点k适合作为数据点i的聚类中心的程度,归属度信息A(i,k)用来描述数据点i隶属于以k点为聚类中心的聚类的可能性,两种信息计算公式如下:

图4 本文时空CNN结构

Fig.4 The spatial-temporal CNN structure used in this paper

(6)

(7)

其中A(i, j)反应除k点外其他点对i点的归属度,该值初始为0,R(i, j)反应除k外其他点对i的吸引度,即除i外其他点都在争夺i点的所有权,S(i, j)表示数据点i和点j的相似度(similarity),同理S(i,k)表示数据点i和点k的相似度。相似度一般使用欧氏距离来计算,如-‖‖,此时所有点与点的相似度值皆为负值,相似度值越大说明点与点的距离越近。R(i,k)表示数据点k成为数据点i的聚类中心的累积证明,R(i,k)值大于0,则表示数据点k成为聚类中心的能力强。算法流程如下所示。

近邻传播聚类算法输入:相似性矩阵S,自身参考度p,聚类样本x。输出:样本的聚类中心映射矩阵idx。1. 随机选取聚类中心。2. 更新相似度矩阵中每个点的吸引度信息R(i,k),计算归属度信息A(i,k)。3. 更新归属度信息A(i,k),计算吸引度信息R(i,k)。4. 对样本点的吸引度信息和归属度信息求和,若迭代稳定则算法结束,否则更新聚类中心回到2。

本文在字典学习时采用AP聚类的方法从UCSD Ped1约八万个正常样本中得到具有代表性的近3500个样本作为正常字典,如此减少正常字典维度,降低了对计算内存的要求。在采用基于AP聚类的稀疏表示分类方法实现视频场景中异常行为的检测时,对测试样本进行AP聚类将原本近13万个测试样本聚类得到约5000个具有代表性的测试样本,不仅可以减少相似样本的重复分类以简化计算还能降低稀疏表示分类方法对阈值的敏感度,该方法仅需要原本测试时间的百分之五左右,大大减少了实验时间。

2.5 基于AP聚类的稀疏表示分类

视频序列中拥挤场景的异常行为检测属于一阶分类问题,在训练集中仅包含正常样本,采用半监督的稀疏表示方法对异常进行检测时,只需训练得到有效的正常字典即可完成异常分类,即使异常行为类型增多或发生改变依旧适用,该方法相比监督方法适应性更强。在异常检测过程中对于存在大量相似样本的多达十万的测试样本,采用AP聚类的方法对计算进行简化,仅对具有代表性的测试样本进行检测,减少需要检测的测试样本个数从而减少了实验时间,同时降低了稀疏表示分类方法对阈值的敏感度。

采用稀疏表示进行分类字典学习时,首先构造合适的字典,从正常样本集合B=[b1,b2,...,bk]∈Rm×k学习到合适的字典B′=[bi1,bi2,...,bin]∈Rm×n,其中每一个向量bi∈Rm都代表一个正常样本特征,i1,i2,...,in∈{1,2,...,k}。在构造正常字典时,基于正常样本之间强大的相关性,本文中采用AP聚类的方法重构B并得到尽可能小的正常字典B′,其中B′中的每个向量皆为B中向量聚类后的聚类中心,如此B中每一个元素都可以由B′中的元素表示。

对于任一测试样本y,若能被正常字典B′线性表示,则将此样本判为正常样本,反之判为异常,稀疏表示问题可由下式计算:

(8)

其中,x=[x0,e0]T,x0∈Rn,e0∈Rm。为衡量任一测试样本y被正常字典表示的程度,引入稀疏重构代价(Sparisity Reconstruction Cost, SRC):

(9)

SRC越大表示该样本由正常字典重构的代价越大即该样本为异常样本的可能性越大。事实上,SRC函数也可以等价地映射到贝叶斯决策的框架中。从贝叶斯的观点来看,正常样本是具有较高概率的点,相反,异常样本是具有较低概率的点,可通过最大化后验概率估计正常样本,具体计算如下:

(10)

基于Sigmoid对测试样本计算由正常字典重构代价SRC得到属于正常样本的概率,计算如下式所示:

(11)

其中,u为选取的阈值,a>0,由于tab=1-tn,可得测试样本属于异常的概率:

(12)

3 实验仿真

本方法在视频异常检测数据集UCSD[15]和UMN[16]上对实验效果进行评估,并在不同评估准则下与多种算法进行效果对比。在UCSD Ped1训练集中提取了80413个正常类别的时空兴趣块,并在测试集中提取了近13万个时空兴趣块,经字典学习得到由近3500个典型正常样本组成的字典,同时通过AP聚类对约5000个测试样本进行异常行为分类从而完成视频场景中的异常行为检测。在UCSD Ped2中提取了38637个正常时空兴趣块,经字典学习得到字典大小为2053 5344,同样AP聚类将原本近四万个测试样本聚类为约6000。UMN数据集中提取正常时空兴趣块约47000个,取部分正常样本进行字典学习将字典维度降至4725。

5344,同样AP聚类将原本近四万个测试样本聚类为约6000。UMN数据集中提取正常时空兴趣块约47000个,取部分正常样本进行字典学习将字典维度降至4725。

3.1 数据库

UCSD的数据集包含两种不同子集:Ped1和Ped2,两者都是由一个安装在固定高度的摄像机俯瞰行人获得的视频。数据集的人群密度随着时间的推移而变化,在稀疏和拥挤之间不断交替。UCSD的数据集分辨率低,包含多种异常情况:自行车、滑冰、小型汽车,轮椅等,数据集的训练样本都是正常的。Ped1中包含34个用于训练的正常视频序列,36个用于测试的含有异常的视频序列。每个序列帧长为200,分辨率为158×238。人群走向大致分为走向和远离摄像头,具有一定的透视畸变。Ped2描绘人群的水平移动,包含16个正常的训练序列和12个包含异常的测试序列。每个序列帧长有120到170不等,分辨率为320×240。Ped1中的物体分辨率较低给识别造成一定的难度,而Ped2中的遮挡问题比较严重。

UMN数据集中的异常属于全局异常,主要表现为恐慌、四处逃散。总时长为4分17秒,帧速率大小为30帧/秒,每帧大小皆为320×240。UMN数据集含有室内室外三种场景下的11个视频片段,视频内容皆为前半部分是人的正常行走或游荡,从某一帧开始视频中的人开始四处逃散直至从视频画面中消失。

3.2 性能评估准则

本文采用异常检测常用的评估标准:接收机操作特性曲线(Receiver Operating Characteristic Curve,ROC)下面积AUC和等误差率EER,等误差率EER是ROC曲线上假阳性率FPR(正常行为被认为是不正常的)与假阴性率FNR(异常行为被认定为正常)相等的点即ROC曲线与ROC空间中对角线([0,1]-[1,0]连线)的交点。如果一个识别算法ROC曲线的EER越小AUC越大,则表明这个方法的性能越好。基于ROC曲线的评估标准分为三个级别,帧级准则、像素级准则和双像素级准则。

3.3 实验结果

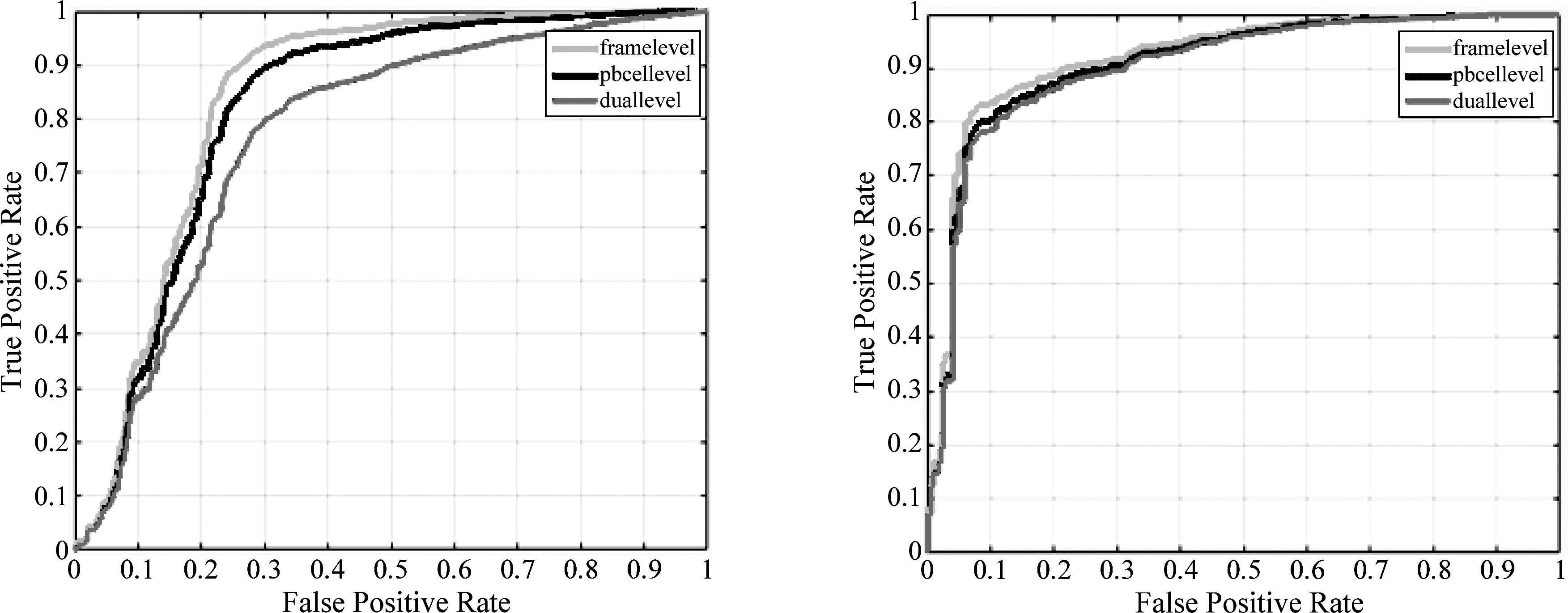

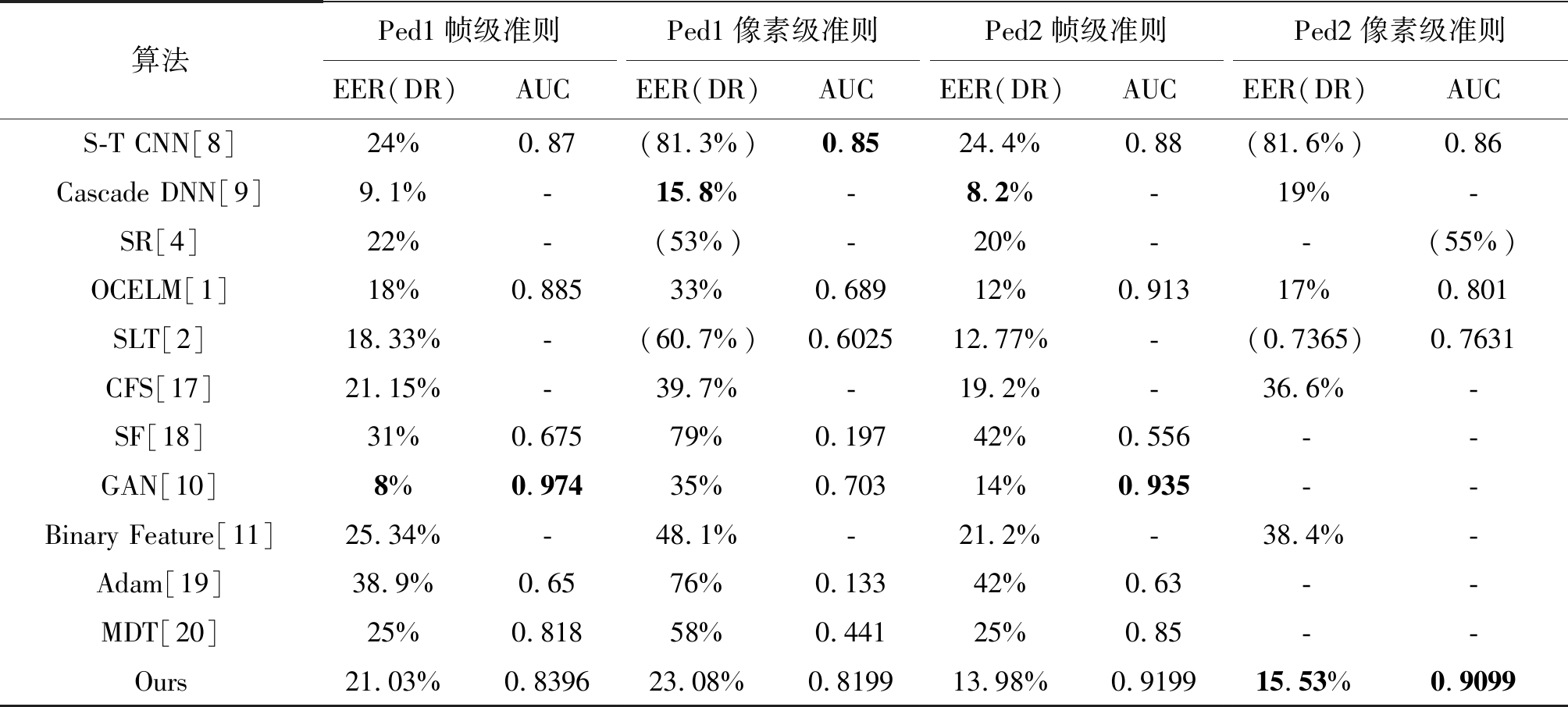

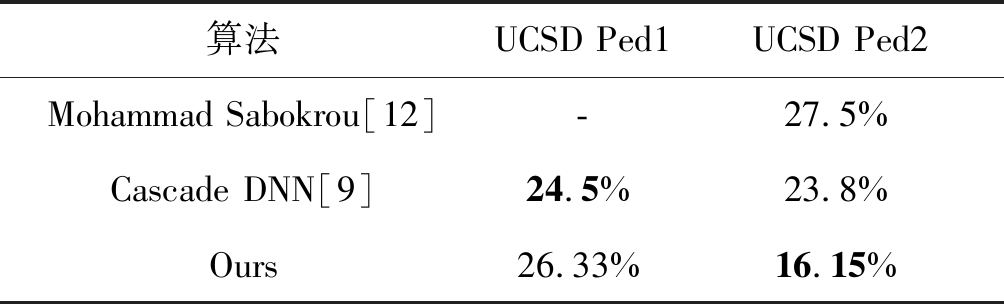

本方法能够在异常出现的时间和空间上都较为准确的进行定位。在UCSD Ped1和Ped2中的异常检测效果如图5、图6所示,其中绿色框表示运动存在的区域,红色框表示异常所在位置。ROC曲线如图7所示。在帧级与像素级准则下对UCSD 数据集中的异常检测效果同已有优秀方法的比较如表2所示,Ped1中像素级准则的EER及AUC分别落后帧级准则仅2.05%、0.0197,Ped2中像素级准则的EER及AUC分别落后帧级准则仅1.55%和0.01,像素级准则中的异常检测能力同帧级准则相比没有明显下降,表明基于C3D的AP聚类稀疏表示方法对于视频序列中的异常行为检测较为准确。像素级准则下,Ped1中AUC仅落后S-T CNN 0.0301,Ped2的AUC优于S-T CNN 0.0499。表明本方法对视频场景中的异常行为检测及定位较为准确。双像素准则下,实验效果(β=5%)比较如表2所示。Ped1中的EER是26.33%,落后Cascade DNN[9]仅1.83%,在Ped 2中的EER是16.15%,优于Cascade DNN 7.65%,优于Mohammad Sabokrou[12]11.35%。表明本方法在准确检测出拥挤场景下异常行为的同时对正常行为的误判概率也较低。

图5 UCSD Ped1 中异常检测及定位示例,绿色框表示存在运动的区域,红色框表示异常所在位置

Fig.5 Example of abnormal detection and location in UCSD Ped1 Green rectangles show the motion areas while red rectangles denote anomalies detected by our method

图6 UCSD Ped2 中异常检测及定位示例,绿色框表示存在运动的区域,红色框表示异常所在位置

Fig.6 Example of abnormal detection and location in UCSD Ped2 Green rectangles show the motion areas while red rectangles denote anomalies detected by our method

图7 本方法在UCSD数据集的ROC曲线图:左侧为Ped1中的结果,右侧为Ped2中的结果

Fig.7 ROC curves for UCSD dataset: left column: Ped 1, right column: Ped 2

表1 UCSD中帧级和像素级EER、AUC比较

Tab.1 EER and AUC for frame and pixel level comparisons on UCSD

算法Ped1帧级准则EER(DR)AUCPed1像素级准则EER(DR)AUCPed2帧级准则EER(DR)AUCPed2像素级准则EER(DR)AUCS-T CNN[8]24%0.87(81.3%)0.8524.4%0.88(81.6%)0.86Cascade DNN[9]9.1%-15.8%-8.2%-19%-SR[4]22%-(53%)-20%--(55%)OCELM[1]18%0.88533%0.68912%0.91317%0.801SLT[2]18.33%-(60.7%)0.602512.77%-(0.7365)0.7631CFS[17]21.15%-39.7%-19.2%-36.6%-SF[18]31%0.67579%0.19742%0.556--GAN[10]8%0.97435%0.70314%0.935--Binary Feature[11]25.34%-48.1%-21.2%-38.4%-Adam[19]38.9%0.6576%0.13342%0.63--MDT[20]25%0.81858%0.44125%0.85--Ours21.03%0.839623.08%0.819913.98%0.919915.53%0.9099

表2 UCSD Ped1、Ped2中双像素级EER比较

Tab.2 EER for dual pixel level comparisons on UCSD Ped1 and Ped2

算法UCSD Ped1UCSD Ped2Mohammad Sabokrou[12]-27.5%Cascade DNN[9]24.5%23.8%Ours26.33%16.15%

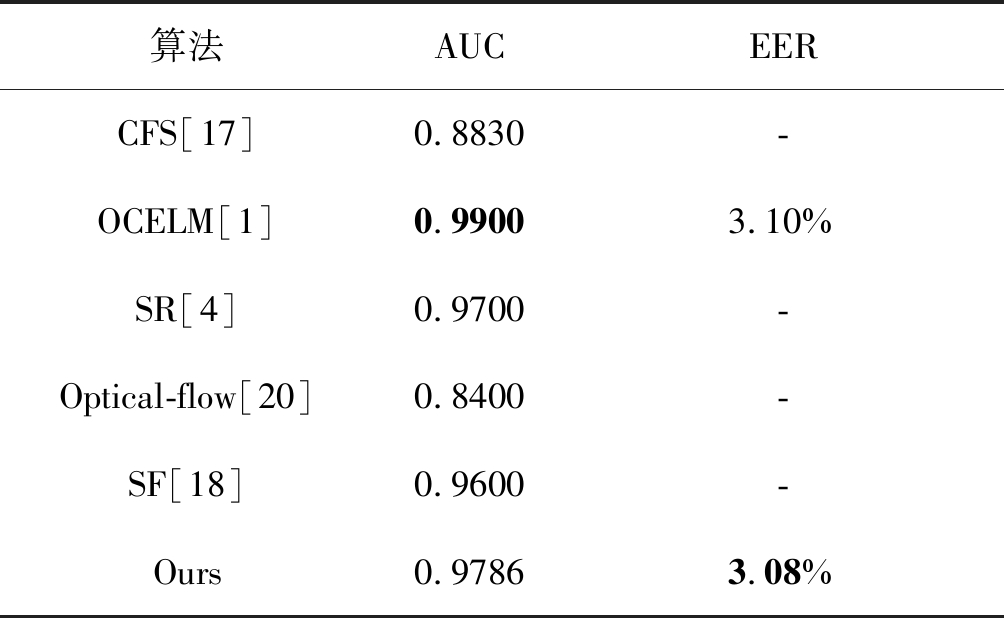

在UMN中的异常检测效果如图8所示,本方法在UMN数据集中的AUC为0.9786,EER为3.08%,与已有优秀方法的AUC、EER比较如表3所示。

表3 UMN中EER、AUC比较

Tab.3 EER and AUC for comparisons on UMN

算法AUCEERCFS[17]0.8830-OCELM[1]0.99003.10%SR[4]0.9700-Optical-flow[20]0.8400-SF[18]0.9600-Ours0.97863.08%

图8 UMN数据集中异常定位示例,红色框表示由本文方法检测出的异常存在情况

Fig.8 Example of abnormal detection and location in UMN Red rectangles show the anomalies detected by our method

4 结论

针对视频序列中大量信息分布不均匀的情况,本文采用光流法和非均匀的细胞分割获得含有运动目标的空间尺寸大小不同的时空兴趣块,调整大小为32 32

32 7后作为时空卷积神经网络C3D的输入,提取时空兴趣块的三维深度特征。在字典学习时,采用AP聚类的方法,将训练样本中具有代表性的特征作为字典,极大降低字典维度,减少稀疏表示方法对计算内存的要求。将测试样本进行AP聚类后仅对具有代表性的聚类中心进行检测,减少了需要检测的样本个数从而减少了实验时间并削减了阈值对检测效果的敏感度。实验结果表明,本文所采用的方法可以有效检测视频中的异常行为且准确率较高。

7后作为时空卷积神经网络C3D的输入,提取时空兴趣块的三维深度特征。在字典学习时,采用AP聚类的方法,将训练样本中具有代表性的特征作为字典,极大降低字典维度,减少稀疏表示方法对计算内存的要求。将测试样本进行AP聚类后仅对具有代表性的聚类中心进行检测,减少了需要检测的样本个数从而减少了实验时间并削减了阈值对检测效果的敏感度。实验结果表明,本文所采用的方法可以有效检测视频中的异常行为且准确率较高。

[1] Wang Siqi, Zhu En, Yin Jianping, et al. Video anomaly detection and localization by local motion based joint video representation and OCELM[J]. Neurocomputing, 2018, 277(2): 161-175.

[2] Biswas S, Venkatesh B R. Anomaly detection via short local trajectories[J]. Neurocomputing, 2017, 242(6): 63-72.

[3] Hajananth N, Fookes C, Denman S, et al. An mrf based abnormal event detection approach using motion and appearance features[C]∥In Advanced Video and Signal Based Surveillance(AVSS), Seoul, South Korea: IEEE, 2014: 343-348.

[4] Liu Peng, Tao Ye, Zhao Wei, et al. Abnormal crowd motion detection using double sparse representation[J]. Neurocomputing, 2017, 269(12): 3-12.

[5] Yang Yanhua, Deng Cheng, Gao Shangqian, et al. Discriminative Multi-instance Multitask Learning for 3D Action Recognition[J]. IEEE Transactions on Multimedia, 2017, 19(3): 519-529.

[6] Yang Yanhua, Deng Cheng, Tao Dapeng, et al. Latent Max-margin Multitask Learning with Skelets for 3-D Action Recognition[J]. IEEE Transactions on Cybernetics, 2017, 47(2): 439- 448.

[7] Tran D, Bourdev L, Fergus R, et al. Learning Spatiotemporal Features with 3D Convolutional Networks[C]∥IEEE International Conference on Computer Vision(ICCV), Santiago, Chile: IEEE, 2015: 4489- 4497.

[8] Zhou Shifu, Shen Wei, Zeng Dan, et al. Spatial-temporal convolutional neural networks for anomaly detection and localization in crowded scenes[J]. Signal Processing: Image Communication, 2016, 47(9): 358-368.

[9] Mohammad S, Mohsen F, Mahmood F, et al. Deep-Cascade: Cascading 3D Deep Neural Networks for Fast Anomaly Detection and Localization in Crowded Scenes[J]. IEEE Transactions on Image Processing, 2017, 26(4): 1992-2004.

[10] Ravanbakhsh M, Nabi M, Sangineto E, et al. Abnormal event detection in video using generative adversarial nets[C]∥IEEE International Conference on Image Processing(ICIP), Beijing, China: IEEE, 2017: 1577-1281.

[11] Leyva R, Sanchez V, Li Chang-Tsun. Abnormal event detection in videos using binary features[C]∥IEEE Telecommunication and Signal Processing(TSP), Barcelona, Spain: IEEE, 2017: 621- 625.

[12] Mohammad S, Mahmood F, Mojtaba H, et al. Real-Time Anomaly Detection and Localization in Crowded Scenes[C]∥IEEE Conference on Computer Vision and Pattern Recognition Workshops, CVPRW 2015 IEEE Computer Society, Boston, MA, USA: IEEE, 2015: 56- 62.

[13] Simonyan K, Zisserman A. Two-Stream Convolutional Networks for Action Recognition in Videos[C]∥Annual Conference on Neural Information Processing Systems, NIPS 2014 Montreal, QC, Canada: CVPR, 2014: 568-576.

[14] Frey B J, Dueck D. Clustering by passing messages between data points[J]. Science, 2007, 315(5814): 972-976.

[15] University of California, San Diego. UCSD Anomaly Detection Dataset[EB/OL]. http:∥www.svcl.ucsd.edu/project-s/anomaly/dataset.html. 2010-10-10.

[16] University of Minnesota. UMN abnormal events detection dataset[EB/OL]. http:∥mha.cs.umn.deu/proj_events.shtml. 2009- 4-12.

[17] Leyva R, Sanchez V, Li Chang-Tsun. Video Anomaly Detection With Compact Feature Sets for Online Performance[J]. IEEE Transactions on Image Processing, 2017, 26(7): 3463-3478.

[18] Mehran R, Oyama A, Shah M. Abnormal Crowd Behavior Detection using Social Force Model[C]∥IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Miami, FL, United states: IEEE, 2009: 935-942.

[19] Adam A, Rivlin E, Shimshoni I, et al. Robust real-time unusual event detection using multiple fixed-location monitors[J]. IEEE Transaction on Pattern Analysis and Machine Intelligence, 2008, 30(3): 555-560.

[20] Mahadevan V, Li Weixin, Bhalodia V, et al. Anomaly detection in crowded scenes[J]. Computer Vision & Pattern Recognition, 2010, 26(2): 1975-1981.