1 引言

光场图像(Light Field Image, LFI)包含有丰富的立体场景信息,记录了场景各个方向上的光线强度以及空间位置。相比较于传统成像技术,光场图像采集到的光线信息能够实现令人惊叹的成像功能,例如重聚焦和任意视角视图合成等。另外,从光场图像中导出的深度几何信息在许多图像处理与计算机视觉领域中得到了广泛应用,例如图像分割,目标识别和显著性检测[1]等。

光场是一个矢量函数,它描述了通过空间中每个点沿不同方向传播的光量。光场通常可数字化表示为四维数据,使用双平面参数化结构来表示,其中光线与角平面(s,t)和空间平面(x,y)相交。此外,目前两个主要光场成像设备是多相机阵列[2]和基于微透镜阵列的光场相机(例如Lytro[3]),可以通过在传统相机的传感器平面前插入微透镜阵列来构造LF相机,获取(s,t)及(x,y)四个参数便可以充分描述成像系统中所有光线的传播。这些成像设备在同一场景中存储大量光线冗余信息。因此,光场数据的高维度表示以及光场成像技术使得捕获到的光场图像数据量非常大。例如,对于具有7728×5368像素传感器的商用Lytro Illum光场相机,单个原始文件大小超过50 MB。相比较于传统2D图像,光场图像需要更大的存储空间和传输带宽。这也成为阻碍其实际应用的一个主要因素。

与传统相机相比,光场相机需在普通镜头(主镜头)焦距处加入一个微透镜阵列捕获场景中光线,并将捕获得到的光场图像进行一系列算法处理才能得以呈现[4]。微透镜阵列将聚焦光束发散到相机传感器上。传感器的输出被称为微透镜图像,其由微透镜产生的许多微小图像组成。小透镜图像可以进一步转换成多个子孔径图像(Sub-Aperture Image,SAI),其对应于后续应用的不同视角视图。由于光场相机中存在微透镜阵列,光场图像产生了类似圆圈的纹理,与传统自然图像具有不同的特性。然而,现有图像压缩方案,如JPEG等,主要是为自然图像设计的,并不能很好地实现光场图像高效压缩。因此,如何针对光场图像特性设计高效光场图像压缩方案成为一个迫切需要解决的问题。

考虑到基于微透镜的光场相机捕获得到的光场图像可以被分解成多个子孔径图像以更好地表达光场图像的内在结构,Olsson[5]等人研究了基于伪序列的光场图像压缩方法,并通过HEVC[6]等高效视频压缩方法进行有效压缩。Vieira[7]等人采用不同的HEVC编码配置对光场相机数据压缩性能的影响进行了研究,主要通过改变子孔径视图的排序方式,例如旋转顺序、光栅扫描顺序、之字形和U形扫描顺序等实现不同的压缩效果。Liu[8]等人将子孔径图像重新排列为伪序列,将中心视图压缩为I帧,其余视图在对称2D分层结构中设置为P帧或B帧,每个视图都分配了一个图层,较高层的视图在较低层的视图之后编码,因此可以参考低层视图对高层视图进行预测编码。与其他基于伪序列的方法相比,该方法的压缩效果有显著的改进。Chen[9]等人提出了一种视差引导的稀疏编码方法,通过选取少数关键视图重建子孔径图像矩阵。该方法只需将重建残差图、视差图以及关键视图排列成伪序列放入视频编码器编码传输,便可以在解码端恢复全部光场图像。与Liu[8]的方法相比较,Chen[9]的率失真性能得到了进一步提升。

然而,上述方法在将大量光场图像重新组织成伪序列进行视频压缩的过程中,并没有充分利用子孔径视图间的视点相关性以实现更加高效的帧间预测编码,达到尽可能去除光场图像冗余的目的。为此,本文提出了一种基于多视点伪序列的光场图像压缩方案,旨在于提高光场图像压缩性能。首先,我们充分考虑光场图像特性,选取部分子孔径视图,将其灵活重构成多视点伪序列后基于MV-HEVC[10]设计适用于多视点伪序列的预测结构进行编解码。接着,在解码端根据已解码子孔径视图通过基于自适应卷积神经网络的视频帧插值方法重建出其他未编码传输的子孔径视图。实验结果表明,与现有光场图像压缩方法相比,本文所提方法能够取得更好的压缩性能。

2 基于多视点伪序列的光场图像压缩方案

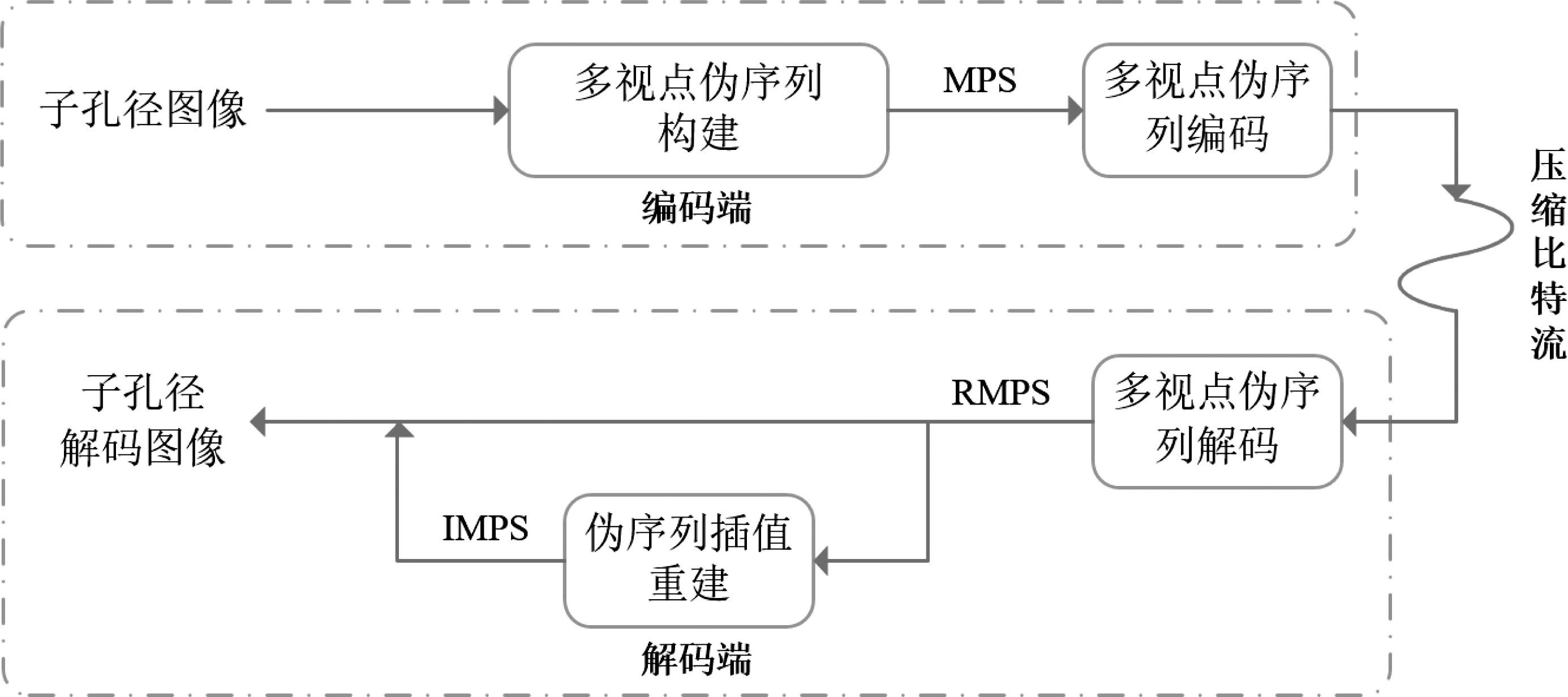

图1所示为本文所提光场图像压缩方法框图。

图1 本文所提光场图像压缩方法

Fig.1 Block diagram of the proposed LFI method

所提方法主要包括多视点伪序列构建、多视点伪序列编码以及伪序列插值重建。具体而言,所提方法首先将需要压缩的子孔径图像转换成YUV420,接着选取部分子孔径图像构建多视点伪序列(Multi-view Pesudo Sequence,MPS),进而进行多视点伪序列编码,最后在解码端基于已编码传输的多视点伪序列通过伪序列插值重建方法重建出剩余未编码传输的子孔径图像(Interpolated MPS,IMPS),从而得到全部子孔径图像。相应算法细节将在以下小节详细介绍。

2.1 多视点伪序列构建

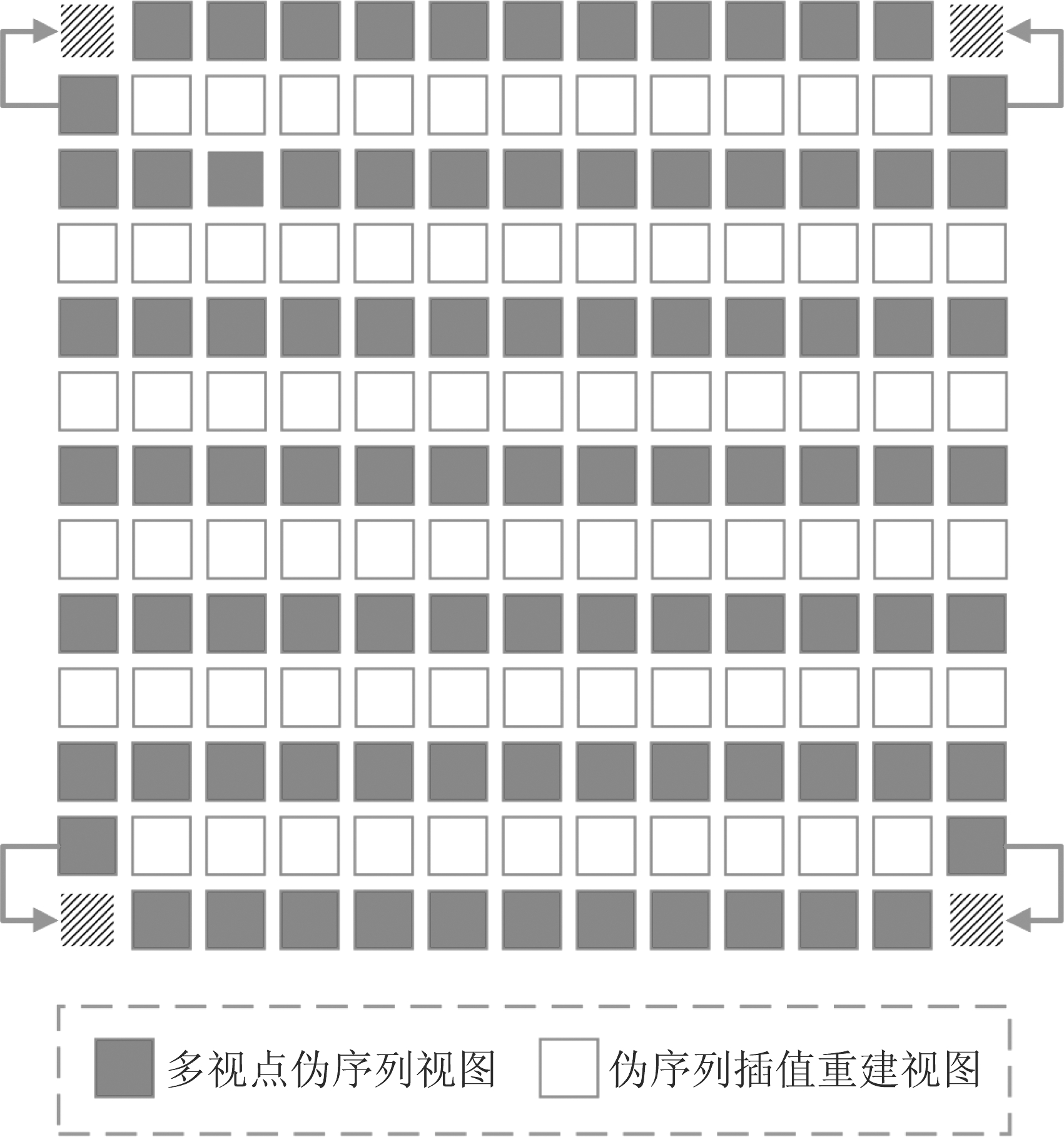

图2 子孔径图像阵列

Fig.2 Subaperture images array

光场相机获取的光场微透镜图像可以利用MATLAB光场工具箱[11]转换为15×15的2D图像阵列,如图2所示,一共由225张子孔径图像组成,每张子孔径大小为432×624,再把它们作为自然图像使用现存技术进行处理。从图2中可以观察出,相比较于中间部分,四个角落的子孔径图像更暗,而且越靠近边缘部分的子孔径图像的畸变和模糊现象越严重。因此,同其他光场图像压缩方法[8-9]一样,如图2所示,我们选取红线标识的子孔径阵列作为压缩对象,一共包含有165(13×13-4)张子孔径图像。

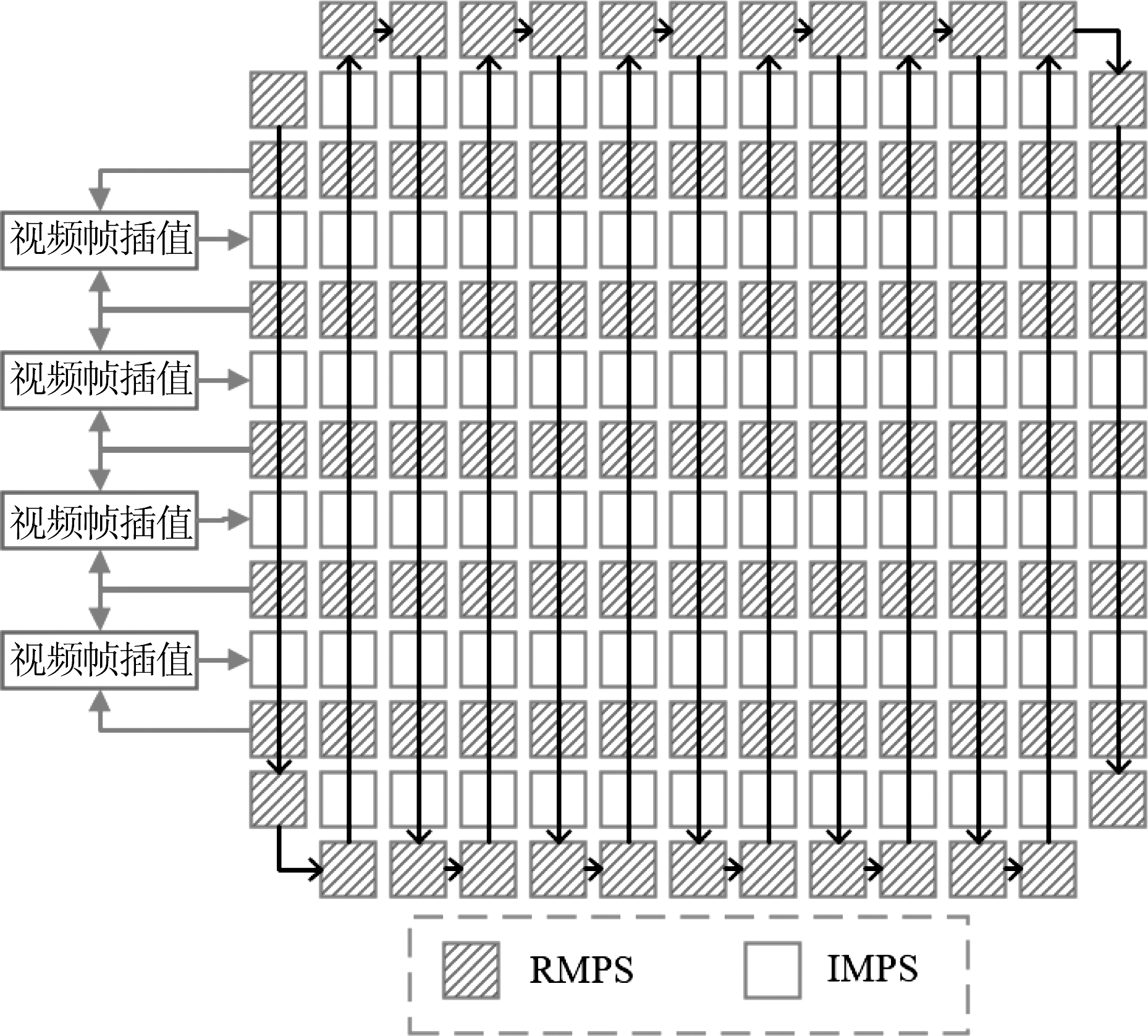

由于微透镜紧密的排列结构,相邻的两张子孔径图像之间只存在微小的水平视差或垂直视差,因此可将其视为多视点视频中同一视点或相邻视点的视频帧。进一步考虑到相邻子孔径图像之间存在强相关性,我们不需要对全部光场图像进行压缩编码,只需压缩传输部分光场图像,再利用子孔径图像之间的相关性重建出未编码传输的子孔径图像,从而节省码流,提高编码效率。基于上述考虑,我们通过隔行选取的方式选取部分子孔径图像构建了多视点伪序列。如图3所示,红色表示部分选取的子孔径图像,4个顶角子孔径图像则由相邻视点的子孔径图像直接填充,白色表示不进行编码而是在解码端基于红色已编码解码子孔径图像进行插值重建得到的子孔径图像。因此,图2所示需压缩的子孔径图像阵列可构建成如图3所示多视点伪序列,包含7个视点,且每个视点由13张子孔径图像组成。

图3 所提多视点伪序列示意图

Fig.3 The schematic of proposed multi-view pesudo-sequence

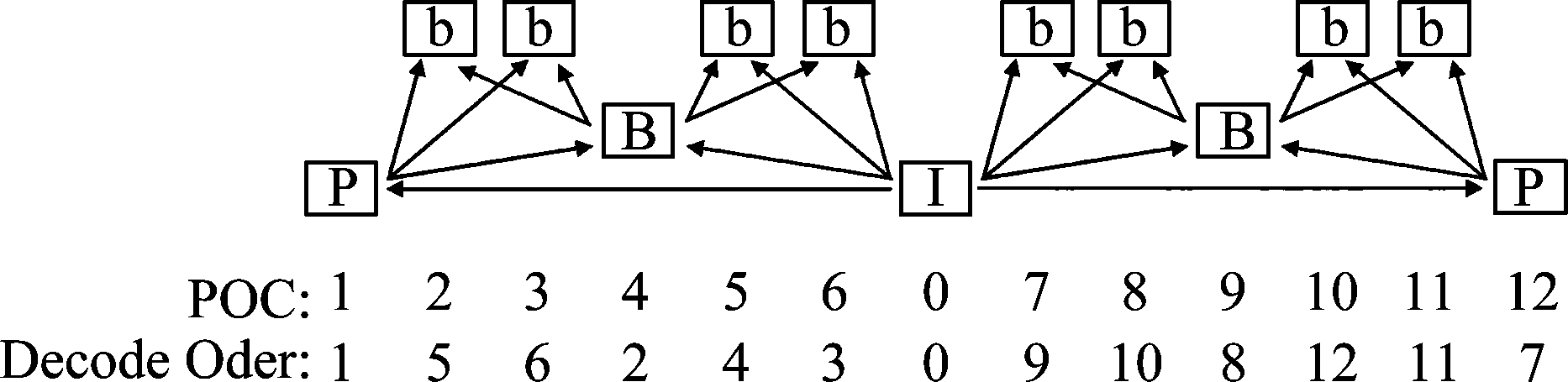

2.2 多视点伪序列编码

如图3所构建出的多视点伪序列在视点内和视点间都存在很强的相关性,也就是说相邻的子孔径图像(包括水平和垂直方向)之间具有较高的相似性。因此在进行多视点伪序列编码时,应尽可能保证使用水平或垂直位置尽可能临近的子孔径图像作为参考视图。此外,我们可以观察到靠近中心的子孔径图像之间相比较于接近边界的子孔径图像之间具有更高的相似性,因此,中心子孔径图像作为参考视图可以更好地预测其他子孔径图像。为了尽可能地去除多视点伪序列的冗余度,我们基于MV-HEVC平台,根据如上所述子孔径视图的结构特点,设计了适用于多视点伪序列的编码预测结构,如图4和图5所示。图4为多视点伪序列视点内预测结构,选取中间视图作为I帧,并基于相似性差异程度把其他视图作为P帧或B帧。图5为多视点伪序列视点间预测结构,选取中间视点为基本视点,其余视点为独立视点。独立视点视图编码时参考图像可包括视点内视图和同一时刻已编码相邻视点视图,以尽可能地去除视图内在的冗余度。

图4 多视点伪序列视点内预测结构

Fig.4 The intra-layer prediction structure of MPS

图5 多视点伪序列视点间预测结构

Fig.5 The inter-layer prediction structure of MPS

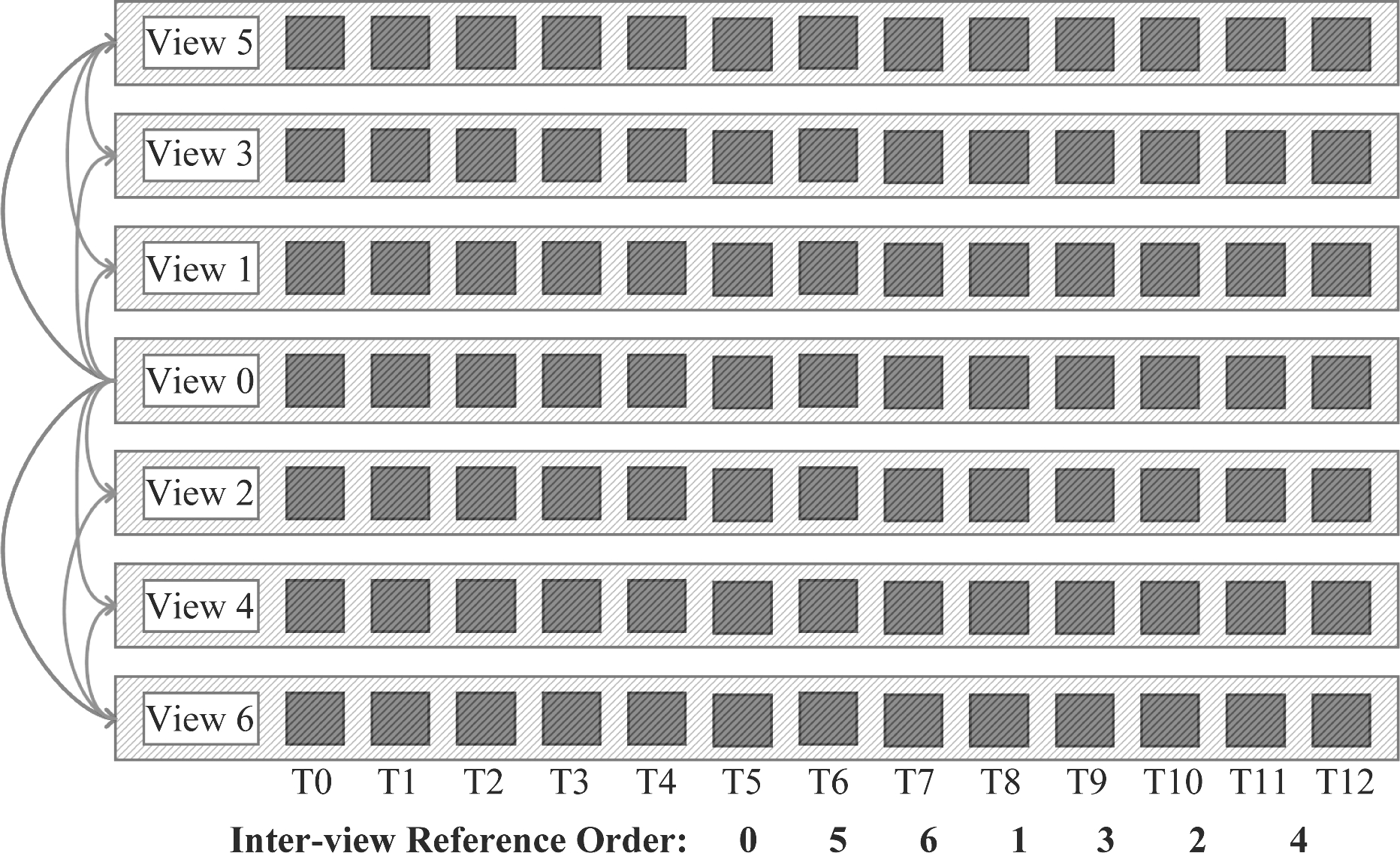

2.3 解码端伪序列插值重建

图6 伪序列插值重建

Fig.6 Interpolated multi-view pseudo sequence

如图1所示,压缩后的码流在解码端经过多视点伪序列解码后,将得到重建的多视点伪序列(Reconstructed MPS)。如图6所示,红色虚线填充部分为RMPS,空心填充部分为需要重建的未编码传输的插值伪序列(Interpolated MPS, IMPS)。具体而言,将解码后得到的RMPS按照图6箭头所示扫描顺序重新排列成伪序列,IMPS则可利用前后相邻视点的视图作为输入,采用基于自适应卷积神经网络的视频帧插值方法[12]按照箭头所示顺序进行视频帧插值重建,最终得到全部子孔径图像的重建。本文所使用的视频帧插值方法通过估计每个输出像素的空间自适应可分离卷积核并将输入帧与它们卷积以合成中间帧,将传统的基于光流的运动估计和像素合成过程合并成单个卷积过程。实验表明,该方法可以产生高质量的帧插值结果,并可以很好地处理诸如遮挡,模糊和突然亮度变化等具有挑战性的情况。

3 实验结果和分析

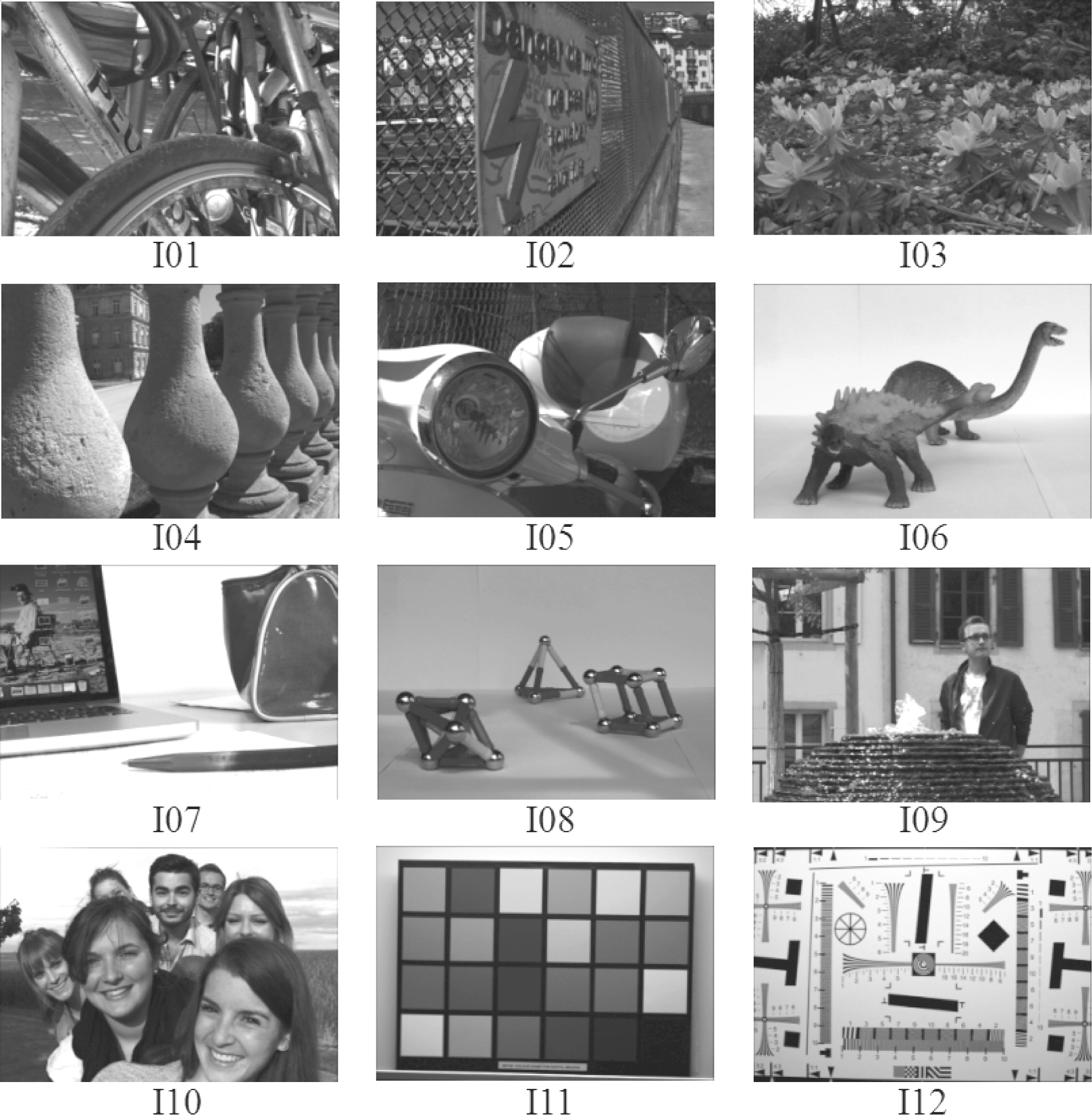

为了证明本文所提算法的有效性,我们使用已公开的LFI数据库[13]中由Lytro Illum相机拍摄得到的具有代表性的12张光场图像对本文所提算法和文献[8,9]进行比较验证,如图7所示。所使用到的平台为HTM-16.2[14]。为了检验算法性能的优劣,我们通过计算在不同压缩比特率下原始未压缩的光场图像与解码端重建光场图像之间的平均PSNR值,对所提方案的总体率失真性能进行了评估,其中原始子孔径图像和重建子孔径图像之间的平均PSNR值计算公式如下:

(1)

图7 光场图像示意图

Fig.7 Examples of LFIs

同时我们采用BD-PSNR和BD-BR值[15]来比较判断平均PSNR和Bitrate变化。

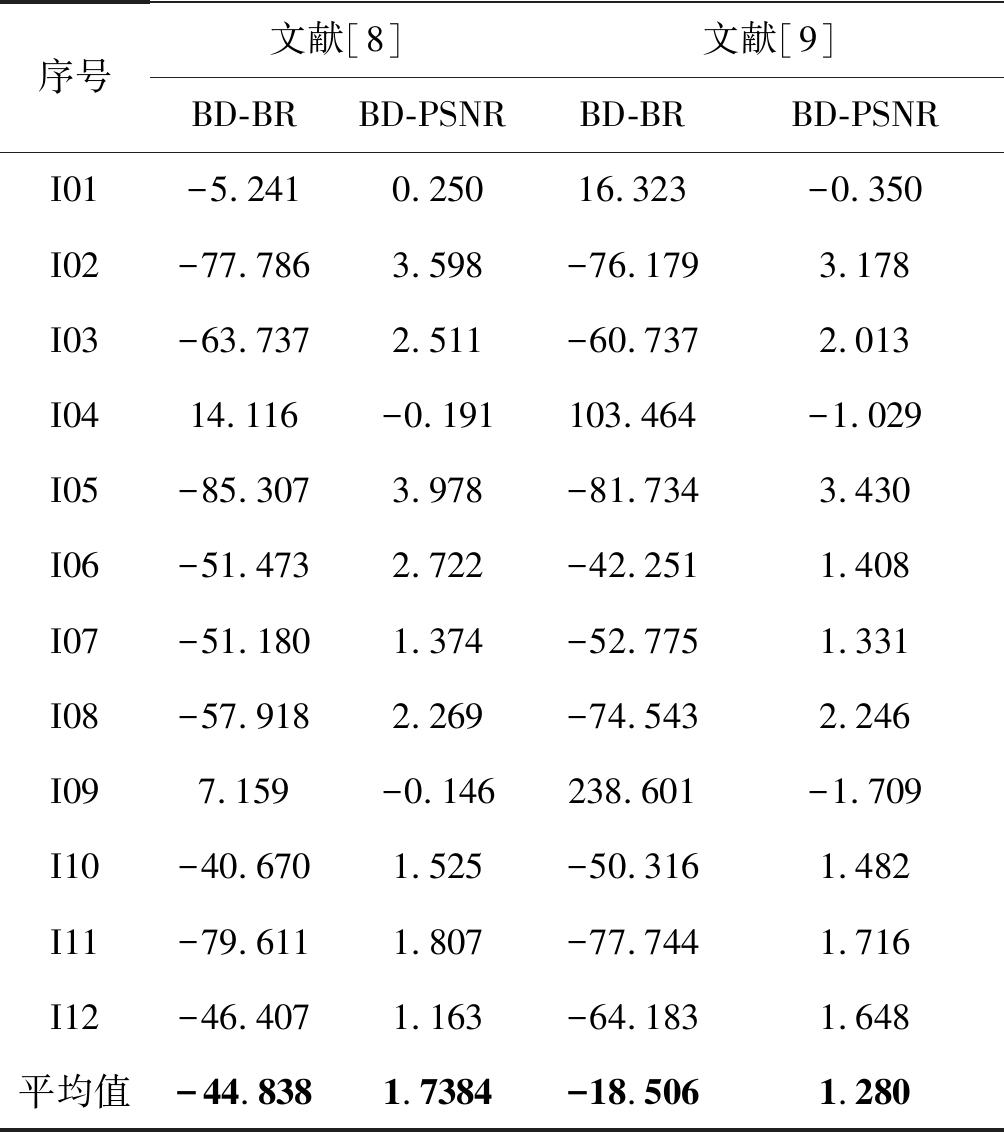

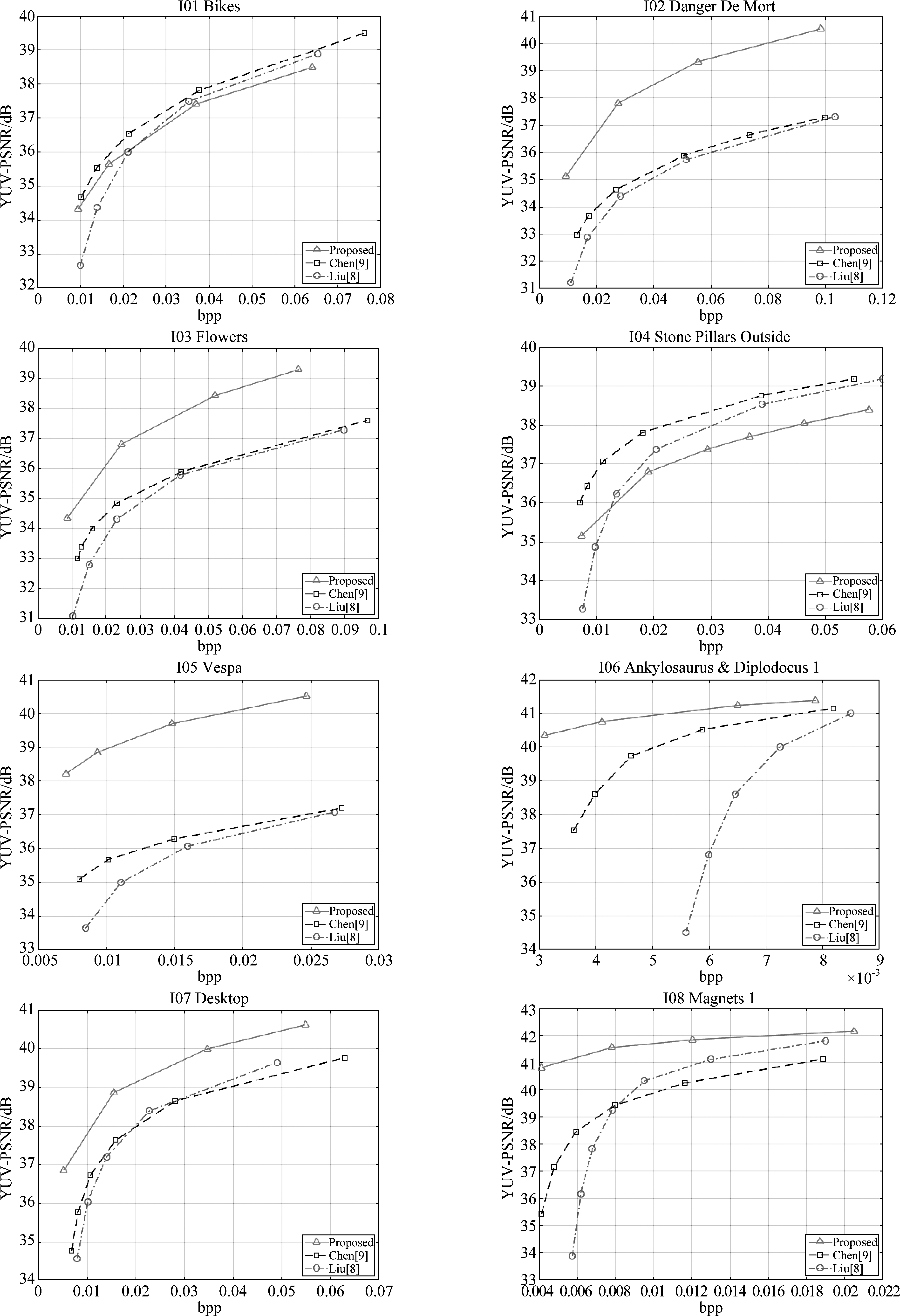

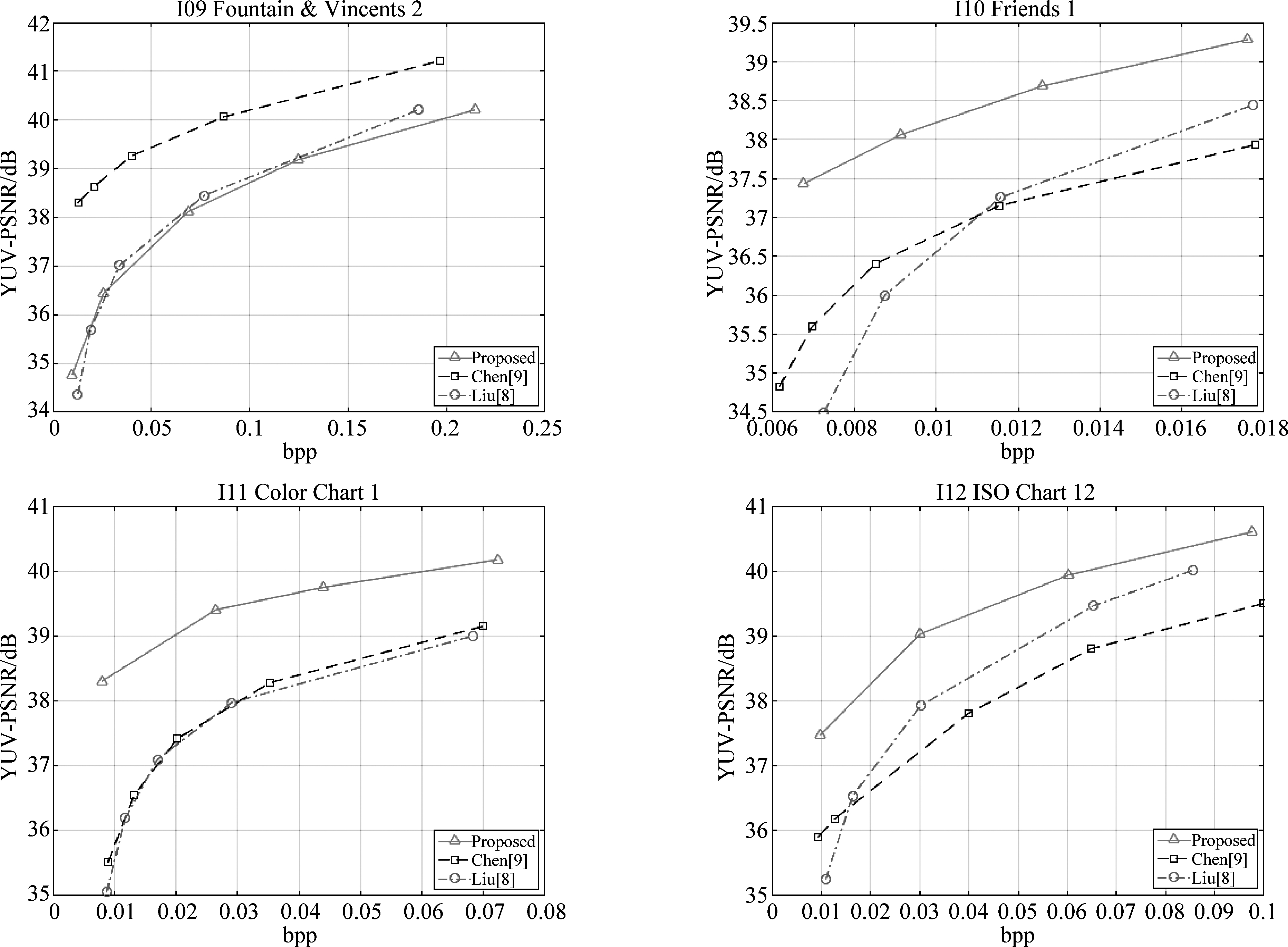

表1给出了本文所提方法分别相对于文献[8]和文献[9]的BD-PSNR和BD-BR值。与Liu[8]的方法相比,本文所提方法能够取得44.8%的平均BD-BR下降和1.73 dB的平均BD-PSNR提升。与Chen[9]的方法相比,本文所提方法实现了18.5%的平均BD-BR下降和1.28 dB的平均BD-PSNR提升。图8进一步展示了本文所提方法、Liu[8]以及Chen[9]的方案的率失真曲线,其中纵轴PSNR值由公式(1)计算得到,横轴为每像素所占比特数(bits per pixel,bpp)。从图8可以进一步看出对于大部分光场图像,本文所提方法优于最新光场图像压缩方法,文献[8]和文献[9],尤其是在低码率条件下。同时我们也注意到对于I01、I04和I09,本文所提方法性能不如另外两种方法,其原因在于解码端伪序列插值重建方法是通过广泛的视频数据训练卷积神经网络,直接应用于伪序列插值存在一定局限性。我们认为避免该局限性的方法是利用大量光场子孔径图像组成的伪序列作为训练集,训练出针对光场图像的插值卷积神经网络。综上所述,本文提出方法具有较好的光场图像压缩性能。

表1 所提方案与文献[8]、文献[9]的结果比较

Tab.1 The comparison of proposed scheme and references[8] and[9]

序号文献[8]文献[9]BD-BRBD-PSNRBD-BRBD-PSNRI01-5.2410.25016.323-0.350I02-77.7863.598-76.1793.178I03-63.7372.511-60.7372.013I0414.116-0.191103.464-1.029I05-85.3073.978-81.7343.430I06-51.4732.722-42.2511.408I07-51.1801.374-52.7751.331I08-57.9182.269-74.5432.246I097.159-0.146238.601-1.709I10-40.6701.525-50.3161.482I11-79.6111.807-77.7441.716I12-46.4071.163-64.1831.648平均值-44.8381.7384-18.5061.280

图8 率失真曲线比较

Fig.8 Comparison of rate-distortion curves

4 结论

本文提出了一种基于多视点伪序列的光场图像压缩方法。首先,本文所提方法将光场原始图像分解为子孔径图像阵列,按照其结构特点选取部分图像构建多视点伪序列,并设计相应多视点伪序列编码结构基于MV-HEVC平台进行编解码。在解码端,利用已解码子孔径图像通过伪序列插值重建方法重建出未编码子孔径图像,从而恢复出整个光场。本方法充分考虑了子孔径图像阵列的相邻视点相关性与视点内相关性,只需压缩传输部分子孔径图像便可重建出全部子孔径图像,从而大大节约了码流。实验结果表明,本文所提光场图像压缩方法具有比最新光场图像压缩方法更高的编码效率。

[1] Li N, Ye J, Ji Y, et al. Saliency detection on light field[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 2806-2813.

[2] Wilburn B, Joshi N, Vaish V, et al. High performance imaging using large camera arrays[C]∥ACM Transactions on Graphics(TOG). ACM, 2005, 24(3): 765-776.3.

[3] Ng R, Levoy M, Brédif M, et al. Light field photography with a hand-held plenoptic camera[J]. Computer Science Technical Report CSTR, 2005, 2(11): 1-11.5.

[4] 田钰, 曾焕强, 邢露, 等. 利用边缘相似度的光场图像质量评价[J]. 信号处理, 2017, 34(10): 1197-1202.

Tian Yu, Zeng Huanqiang, Xing Lu, et al. Light Field Image Quality Assessment Using Edge Similarity[J]. Journal of Signal Processing, 2017, 34(10): 1197-1202.(in Chinese)

[5] Olsson R, Sjöström M, Xu Y. Evaluation of a Combined Pre-processing and H. 264-compression Scheme for 3D Integral Images[C]∥Visual Communications and Image Processing 2007. International Society for Optics and Photonics, 2007, 6508: 65082C.1.

[6] Sullivan G J, Ohm J R, Han W J, et al. Overview of the high efficiency video coding(HEVC)standard[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2012, 22(12): 1649-1668.

[7] Vieira A, Duarte H, Perra C, et al. Data formats for high efficiency coding of lytro-illum light fields[C]∥Image Processing Theory, Tools and Applications(IPTA), 2015 International Conference on. IEEE, 2015: 494- 497.

[8] Liu D, Wang L, Li L, et al. Pseudo-sequence-based light field image compression[C]∥Multimedia & Expo Workshops(ICMEW), 2016 IEEE International Conference on. IEEE, 2016: 1- 4.

[9] Chen J, Hou J, Chau L P. Light Field Compression With Disparity-Guided Sparse Coding Based on Structural Key Views[J]. IEEE Transactions on Image Processing, 2018, 27(1): 314-324.

[10] Hannuksela M M, Yan Y, Huang X, et al. Overview of the multiview high efficiency video coding(MV-HEVC)standard[C]∥Image Processing(ICIP), 2015 IEEE International Conference on. IEEE, 2015: 2154-2158.

[11] Dansereau D G, Pizarro O, Williams S B. Decoding, calibration and rectification for lenselet-based plenoptic cameras[C]∥Proceedings of the IEEE conference on computer vision and pattern recognition, 2013: 1027-1034.

[12] Niklaus S, Mai L, Liu F. Video frame interpolation via adaptive separable convolution[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 261-270.

[13] Rerabek M, Ebrahimi T. New light field image dataset[C]∥8th International Conference on Quality of Multimedia Experience (QoMEX). 2016 (EPFL-CONF-218363).

[14] “HTM Reference Software 16.2”. https:∥hevc.hhi.fraunhofer.de/svn/svn_3DVCSoftware/.

[15] Bjontegaard G. Calculation of average PSNR differences

between RD-curves[J]. VCEG-M33, 2001.