1 引言

图像融合将来自不同传感器,在不同位置或不同时间拍摄的关于同一场景的多幅图像融合成一幅图像。融合后图像保留了源图像的互补和冗余信息,更加符合人类视觉感知效果。近年来,图像融合逐渐成为研究热点问题,红外与可见光图像融合是图像融合领域的重要组成部分。红外图像由红外传感器拍摄获得,记录不同物体的热辐射信息,可用于地物识别和地表参数反演,如隐藏目标和伪装识别等。红外图像的成像特点,可以大大减少阳光、烟雾等外部环境的影响。红外图像对具有明显红外热特性的物体和区域敏感,这些特征在可见光图像中无法表现。可见光图像根据物体的光谱反射特性成像,包含大量物体可见的边缘和细节信息,可以为人眼提供感知场景描述,并与人类视觉特征相一致。红外与可见光图像融合的目的是获得具有可见光图像中的丰富细节信息和红外图像中的有效目标区域的互补图像。因此,红外与可见光图像融合技术广泛应用于夜视成像设备,可提高人类和机器的夜视能力[1]。

根据不同的应用,研究者提出了不同的红外与可见光图像融合方法,这些方法通常可以分为三个级别:像素级、特征级和决策级[2]。基于像素级的图像融合方法是整个图像融合领域的流行研究趋势,融合图像像素由一组图像像素或在最低物理水平的其他形式的图像参数确定,因此融合图像具有最小的伪影。其中基于多尺度变换(Multiscale transform, MST)的图像融合方法最受欢迎。传统的基于MST的图像融合方法通常是那些使用金字塔[3]和小波变换[4]的方法。最近提出的融合方法可以被视为利用多尺度几何分析工具对他们的变形和扩展,诸如Curvelet变换[5]、Shearlet变换[6]和非下采样Contourlet变换[7]等。

MST方法通常会提前确定其基函数,以进行图像分析和融合。由于预定义的基函数的限制,原图像的一些重要特征(例如边缘)可能无法很好地表达和提取,从而显著地降低了融合性能。另外,基于MST的图像融合方法通常以多尺度方式实现,MST分解层数的选择变得至关重要且棘手。为确保可以从源图像中提取空间细节信息,分解层数一般要设置得大一些,在这种情况下,低通子带中的一个系数对融合图像中的大量像素具有很大的影响。因此,由源图像之间的噪声或误配准引起的低通子带中小的错误将引起严重的人工效应[8]。近年来,边缘保持滤波器成功地应用于构建图像的多尺度表示。周志强等人将高斯和双边滤波器结合在一起,提出图像的多尺度混合信息分解,并应用于红外与可见光图像融合[9];李树涛等人首次将引导滤波应用于图像融合,在多种图像融合应用中获得了较好的融合结果[10]。通常,这些方法的主要优点是他们能够准确地分离图像的纹理细节、边缘和空间结构,有利于减少融合过程中的光晕和混叠伪像,因此能够获得对人类视觉感知有益的融合结果。此外,在夜间捕获的可见光图像中的细节可见性受照明条件的影响。在不良照明条件下获得的细节通常在可见光图像中以极低的对比度显示,直接融合红外和可见光图像不会获得任何地方都具有良好可见性的融合图像。因此,对于夜视场景来说,对可见光图像进行对比度增强是十分必要的[11]。

针对以上问题,论文在融合之前,首先对可见光图像进行对比度增强,以提高融合图像的视觉效果。首先,为提高可见光图像低亮度细节的能见度,在融合之前,提出一种基于引导滤波器的动态范围压缩与线性变换相结合的自适应图像增强方法;其次,采用基于引导滤波器和高斯滤波器的多尺度融合方法,将红外图像信息有效地注入可见光图像中;最后运用非局部均值滤波对融合后的图像进行后处理,以得到效果增强的融合图像。实验结果表明,该方法能够获得较好的夜视场景增强效果。

2 基于引导滤波和线性变换的可见光图像增强算法

引导滤波器的输出是引导图像的局部线性变换,一方面引导滤波器具有良好的平滑保边能力,同时在边界处不会出现梯度反转效应;另一方面引导滤波器是基于局部线性模型的,使得其也适用于诸如图像抠图、上采样和着色等应用,其计算时间只依赖于滤波器的大小,大大提高了运行效率[12]。

基于引导滤波的图像对比度增强算法具体叙述如下[11]:假设I是被标准化为[0,255]之间的输入图像,设Ib=GFr, (I)为引导滤波器处理得到的滤波图像,将其变换到对数域,可以得到图像的基础层:

(I)为引导滤波器处理得到的滤波图像,将其变换到对数域,可以得到图像的基础层:

(1)

利用公式(2)可以得到其细节层:

(2)

在运算中,log表示自然对数运算符,ξ=1为防止出现的数值为负数。

然后,利用尺度因子β对图像![]() 进行动态范围压缩,以及利用比例因子γ对图像进行对比度的调整,整体的算法为:

进行动态范围压缩,以及利用比例因子γ对图像进行对比度的调整,整体的算法为:

(3)

当β<1时,基础层的对比度降低,其细节层的对比度不变,对图像进行动态范围压缩后再进行对比度的调整,尽管其规定的图像亮度在0~255之间,但是其处理结果也是相当可观的。

设置一个基础对比度T,然后将基础层的对比度缩小到T值附近,β可表示为:

(4)

其中![]() 和

和![]() 分别表示

分别表示![]() 图像的最大强度和最小强度,因此动态范围压缩会降低图像的对比度,设置一个比例因子γ来调节图像的对比度,在保证增强图像对比度的同时,保证不超过最大亮度,γ的定义为:

图像的最大强度和最小强度,因此动态范围压缩会降低图像的对比度,设置一个比例因子γ来调节图像的对比度,在保证增强图像对比度的同时,保证不超过最大亮度,γ的定义为:

(5)

从而,当λ>0以及β<1时,得到增强图像:

(6)

在本文实验中,引导滤波器大小设置为:r=⎣0.04max(W,H)」,其中,W和H分别是输入图像的宽和高。 设置为0.01,目标基础对比度T设置为4。

设置为0.01,目标基础对比度T设置为4。

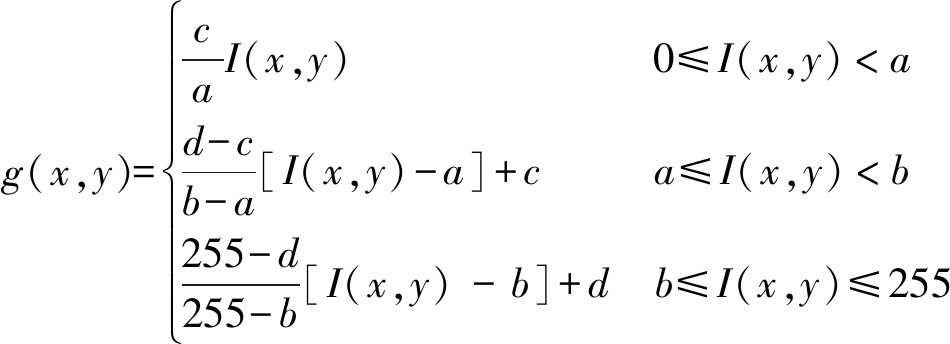

为有效突出感兴趣目标所在的灰度区间,相对抑制那些不感兴趣的灰度区间,论文利用三段线性变换对图像进一步进行增强处理。假设原图像I在[0,255]范围内,感兴趣目标的灰度范围在[a,b],使其拉伸到[c,d],对应的分段线性变换表示为:

(7)

按照这种三段线性变换,就可以把原始图像[0,a)灰度范围的像素变换到[0,c)灰度范围,把[a,b)灰度范围的像素变换到[c,d)灰度范围,把[b,255)灰度范围的像素变换到[d,255)的灰度范围。当某段直线的斜率大于1时,会拓展原始图像灰度范围,当斜率小于1时,会压缩灰度范围。本文实验中,a,b分别取50和220,c,d分别取10和240时,可以得到较好的图像增强效果。

图1 图像增强效果

Fig.1 The enhancement results of the visible image

图1给出了图像增强效果,(a)为在低照度条件下拍摄的可见光图像,(b)为基于引导滤波和动态范围压缩的图像增强效果图,(c)为本文方法图像增强效果图。从图中可以看出两种方法都能有效地对低照度条件下的图像进行增强,相比较而言本文方法可以保留更多的纹理细节信息,更加符合人类视觉感知效果。

3 基于多尺度混合信息分解的图像融合方法

3.1 图像多尺度混合信息分解方法

高斯滤波器是一种线性低通滤波器,并广泛地应用于图像处理领域。高斯滤波在滤波过程中没有考虑邻近像素灰度值的影响,因此会将部分边缘信息一起滤除掉。当 取值较小时,引导滤波图像Q(I)能够保留更多的大尺度边缘信息。假设G(I)为相应高斯滤波图像,分别通过以下减法运算,我们可以得到被滤除的小尺度纹理细节信息I(t,1)和保留在Q(I)里的边缘信息I(e,1):

取值较小时,引导滤波图像Q(I)能够保留更多的大尺度边缘信息。假设G(I)为相应高斯滤波图像,分别通过以下减法运算,我们可以得到被滤除的小尺度纹理细节信息I(t,1)和保留在Q(I)里的边缘信息I(e,1):

I(t,1)=I-Q(I)

(8)

I(e,1)=Q(I)-G(I)

(9)

将这种混合分解推广到多尺度分解方式,并将其应用到红外与可见光图像融合领域以获得较好的视觉感知效果。图2给出了一个四层的图像混合信息分解。

其中:

(10)

Q(j+1)(I)=GFrj, j(Q(j)(I),Q(j)(I))

j(Q(j)(I),Q(j)(I))

(11)

(12)

图2 图像多尺度混合信息分解框图

Fig.2 The hybrid multi-scale edge-preserving image decomposition diagram

I(t, j)=G(j-1)(I)-Q(j)(I)

(13)

I(e, j)=Q(j)(I)-G(j)(I)

(14)

Ib=G4(I)

(15)

式中,Q(0)=I,G(0)(I)=I由此可以得到相应的纹理细节层I(t, j)(j=1,2,3,4),大尺度边缘信息I(e, j)(j=1,2,3,4),以及图像的底层粗略尺度信息Ib。分解过程中相关参数设置如下:![]()

0=0.01。从最终得到的分解结果来看,大尺度边缘图层中更多反映了红外目标特征,小尺度的纹理细节更多反映了可见光的背景信息符合先前的猜想。

0=0.01。从最终得到的分解结果来看,大尺度边缘图层中更多反映了红外目标特征,小尺度的纹理细节更多反映了可见光的背景信息符合先前的猜想。

这种图像信息分解方法能够有效地将图像信息分离,并广泛运用于图像去噪、纹理增强、高动态范围压缩、色调和光照处理等,同时能够有效避免相关图像处理过程中的“光晕”现象。因此,对于分解层数的选择没有传统多尺度分解方法这么多限制,在实际应用中,为了兼顾算法效率和融合效果,一般分解层数选择为四层。

3.2 图像融合方法

对红外图像和可见光图像进行混合信息分解,得到分解后的信息。 针对小尺度、大尺度和底层粗略尺度分解信息采用不同的融合算法。通常,对于小尺度层分解信息融合,只选择顶层的分解信息(j=1)。在这个级别上的融合权重是用绝对最大选择方法确定的:

(16)

因此,在该分解层的融合信息为:

(17)

大尺度水平包括从j=2到j=n的分解水平,由于突出的红外光谱信息通常是具有突出边缘的大尺度特征,红外图像的分解边缘特征通常对应于重要的红外光谱特征,并可用于确定红外图像信息的融合权重。首先,在各个分解层上识别出重要的红外光谱特征:

(18)

接下来,对Rj进行归一化:

Pj=Rj/maxx∈Ω{Rj(x)}

(19)

然后,通过以下非线性函数进行调节,得到融合权重:

Cj=gσc*Sτ(Pj)

(20)

其中Sτ定义为:

Sτ(x)=arctan(τ x)/arctan(τ)

(21)

![]() 是一高斯函数,用于局部平滑和降低噪声。Sτ(x)(x∈[0,1])被定义为非线性单调递增函数,当τ增大时,函数值逐渐饱和到1,因此,参数τ可用于控制注入到可见光图像中的红外信息,τ越大,注入到可见光图像中的红外信息越多。通过以下公式可将图像的大尺度分解信息融合起来:

是一高斯函数,用于局部平滑和降低噪声。Sτ(x)(x∈[0,1])被定义为非线性单调递增函数,当τ增大时,函数值逐渐饱和到1,因此,参数τ可用于控制注入到可见光图像中的红外信息,τ越大,注入到可见光图像中的红外信息越多。通过以下公式可将图像的大尺度分解信息融合起来:

(22)

最后,分解的底层粗略尺度信息通过公式(23)进行融合:

(23)

其中:

Cb=gσb*Sτ(Pn)

(24)

通常,设置σb=4rn来平滑融合权重,以更好地融合图像的底层粗略尺度信息。

为了使融合图像更加符合人类视觉感知效果,同时去除融合图像中的孤立点,论文利用非局部均值滤波对融合图像进一步处理。非局部均值滤波的基本思想是:当前像素的估计值由图像中与它具有相似邻域结构的像素加权平均得到。与局部均值滤波器采用目标像素周围的一组像素的平均值来平滑图像不同,非局部均值滤波采用图像中所有像素的平均值,非局部均值滤波充分利用了图像中的冗余信息,在去噪的同时能最大程度地保持图像的细节特征。滤波后图像的清晰度更高,细节损失更少。

4 实验结果与分析

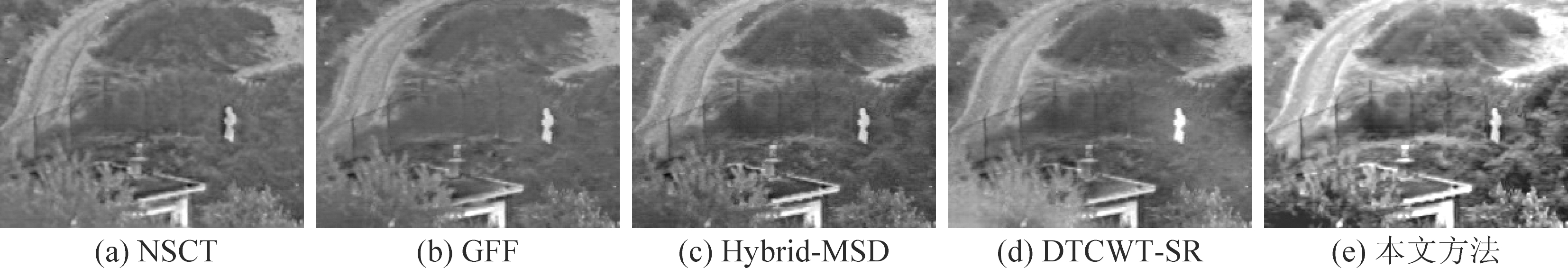

为验证本文方法的有效性,论文做了大量实验,并从主观评价和客观评价两个方面对所提算法进行实验验证,同时和目前常用的红外与可见光图像融合方法进行比较。这些方法包括基于NSCT的图像融合方法,参数设置参照文献[13]给出的针对红外与可见光图像融合的最优参数;基于引导滤波的图像融合方法(本文将该方法简记为GFF);基于双边和高斯滤波的混合多尺度分解的图像融合方法(本文将该方法简记为Hybrid-MSD);基于多尺度分解和稀疏表示相结合的图像融合方法,针对红外与可见光图像融合,多尺度分解方法为DTCWT,分解层数为4层(本文将该方法简记为DTCWT-SR)。限于篇幅,本文给出两组实验结果,实验用图像如图3所示。

图4给出了不同融合方法在“Un Camp”源图像上的融合结果。从图4(a)可以看出,基于NSCT的图像融合方法可以将红外与可见光图像有效地进行融合,但是融合图像中红外目标信息不突出,表现地比较暗,另外可见光图像中的纹理细节信息保留不充分,尤其是图像左下角和右下角的树木等信息没有有效保留。从图4(b)可以看出,GFF方法相比NSCT方法能有效地突出红外目标信息,但是它没能解决图像空间信息一致性问题,导致纹理细节信息保留不充分。相较于前两种方法,Hybrid-MSD方法在有效突出红外目标的同时,尽可能多地保留了可见光图像的纹理细节信息,更加符合人眼视觉效果。但是由于原可见光图像对比度不高,所以导致最终融合图像整体对比度较低。从图4(d)可以看出,DTCWT-SR方法整体上更加突出红外目标信息,可见光信息保留不充分。从图4(e)可以看出,本文方法不仅能有效地突出红外目标信息,还保留了可见光图像的纹理细节信息。同时,本文方法对原可见光图像进行了对比度增强,很好的提高了图像的可视性。

图5给出了不同融合方法在“Trees4906”源图像上的融合结果。针对这一组源图像,其可见光图像的对比度非常低。从图5(a)可以看出,基于NSCT的图像融合方法可以将两幅源图像融合为一幅图像,但由于可见光图像的低对比度导致融合图像整体对比度较低,很难分辨出背景信息,不利于人眼视觉感知。从图5(b)、(c)和(d)三幅图像可以看出,GFF、 Hybrid-MSD和DTCWT-SR三种方法都能有效的突出红外目标信息,但是由于可见光图像的对比度较低,导致融合图像整体对比度较低。从图5(e)可以看出,本文方法在融合之前,将可见光图像的对比度进行有效增强,融合图像整体能见度较好。同时可以发现,本文方法不仅能有效突出红外目标信息,还保留了尽可能多的纹理细节信息,更加符合人类视觉感知效果。

图3 红外与可见光源图像

Fig.3 The source infrared and visible images

图4 “Un Camp”源图像融合结果

Fig.4 Fusion results of the “Un Camp” images based on different fusion methods

图5 “Trees4906”源图像融合结果

Fig.5 Fusion results of the “Trees4906” images based on different fusion methods

表1 不同方法的融合图像客观评价指标

Tab.1 Objective assessment of different methods

实验图像评价指标融合方法NSCTGFFHybrid-MSDDTCWT-SR本文方法Un CampQMI0.19390.22890.30420.25180.366QY0.34920.84620.80250.78630.8711QCB0.47260.53840.58590.55550.6733Trees4906QMI0.26760.39460.39160.34690.4925QY0.23790.90390.77810.84200.8429QCB0.46210.46270.48730.45500.6654

为了客观评价不同方法的融合性能,本文采用三种不同的客观评价指标,包括基于信息熵的评价指标QMI[14],基于图像结构相似度的评价指标QY[15],以及基于人类视觉感知启发的评价指标QCB[16]。QMI衡量的源图像信息在融合图像中的保留效果,其值越大表示融合图像保留源图像的信息越多,融合图像质量越好;QY测量的是融合图像保留源图像结构信息的效果,其值越大表明融合图像越好。QCB展示了人类视觉感知的良好预测性能,其值越大,表明融合图像越符合人类视觉感知效果,融合图像质量越好。

表1给出了以上两组实验的客观评价指标值。表中加粗和下划线显示的值分别表示最好的和第二好的得分。从表中可以看出本文方法在“Un Camp”源图像上获得了最好的得分。在“Trees4906”源图像上本文方法在QMI和QCB两个指标上获得了最好值,在QY指标上获得了第二好的值。综合分析,本文方法整体上要优于其他融合方法。

5 结论

可见光图像对比度低,直接和红外图像进行融合,导致融合图像对比度低,图像模糊,很难分辨出背景信息,不利于进一步地应用。针对以上问题,论文提出一种基于图像对比度增强的红外与可见光图像融合方法。为提高可见光图像低亮度细节的能见度,在融合之前,利用一种基于引导滤波器的动态范围压缩与线性变换相结合的自适应图像增强方法,可以有效地对可见光图像进行对比度增强;其次,采用基于引导滤波器和高斯滤波器的多尺度融合方法,将红外图像信息有效地注入可见光图像中;最后运用非局部均值滤波对融合后的图像进行处理,以得到效果增强的融合图像,使得融合图像更加符合人类视觉感知效果。实验结果表明,该方法能够获得较好的图像融合效果,有利于进一步的应用。

[1] Jin X, Jiang Q, Yao S, et al. A Survey of Infrared and Visual Image Fusion Methods[J]. Infrared Physics & Technology, 2017, 85: 478-501.

[2] Li S, Kang X, Fang L, et al. Pixel-level image fusion: A survey of the state of the art[J]. Information Fusion, 2017, 33: 100-112.

[3] Jin H, Wang Y. A fusion method for visible and infrared images based on contrast pyramid with teaching learning based optimization[J]. Infrared Physics & Technology, 2014, 64: 134-142.

[4] Shamsafar F, Seyedarabi H, Aghagolzadeh A. Fusing the information in visible light and near-infrared images for iris recognition[J]. Machine Vision & Applications, 2014, 25(4): 881- 899.

[5] Du J, Xu L, Li Q. Visible and Infrared Video Fusion Using Uniform Discrete Curvelet Transform and Spatial-Temporal Information[J]. Chinese Journal of Electronics, 2015, 24(4): 761-766.

[6] Wang L, Li B, Tian L F. EGGDD: An explicit dependency model for multi-modal medical image fusion in shift-invariant shearlet transform domain[J]. Information Fusion, 2014, 19: 29-37.

[7] Zhao C, Guo Y, Wang Y. A fast fusion scheme for infrared and visible light images in NSCT domain[J]. Infrared Physics & Technology, 2015, 72: 266-275.

[8] Liu Y, Liu S, Wang Z. A general framework for image fusion based on multi-scale transform and sparse representation[J]. Information Fusion, 2015, 24: 147-164.

[9] Zhou Z, Wang B, Li S, et al. Perceptual fusion of infrared and visible images through a hybrid multi-scale decomposition with Gaussian and bilateral filters[J]. Information Fusion, 2016, 30: 15-26.

[10] Li S, Kang X, Hu J. Image Fusion With Guided Filtering[J]. IEEE Transactions on Image Processing, 2013, 22(7): 2864-2875.

[11] Zhou Z, Dong M, Xie X, et al. Fusion of infrared and visible images for night-vision context enhancement[J]. Applied Optics, 2016, 55(23): 6480- 6490.

[12] He K, Sun J, Tang X. Guided Image Filtering[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2013, 35(6): 1397-1409.

[13] Li S, Yang B, Hu J. Performance comparison of different multi-resolution transforms for image fusion[J]. Information Fusion, 2011, 12(2): 74- 84.

[14] Hossny M, Nahavandi S, Creighton D. Comments on ‘Information measure for performance of image fusion’[J]. Electronics Letters, 2008, 44(18): 1066-1067.

[15] Yang C, Zhang J Q, Wang X R, et al. A novel similarity based quality metric for image fusion[J]. Information Fusion, 2008, 9(2): 156-160.

[16] Chen Y, Blum R S. A new automated quality assessment algorithm for image fusion[J]. Image and Vision Computing, 2009, 27(10): 1421-1432.