1 引言

民航无线电陆空通话(简称陆空通话)是民航空管中,民航空中交通管制员(简称管制员)与飞行员管制信息交流的标准专业术语,是指令信息传递的主要通道,其准确性对于保障航空器的飞行安全极其重要[1,2]。陆空通话的规则有以下特点:(1)单词发音特殊,如,1读作幺,A读作ALPHA;(2)通话用词固定,如进近:approach,终止:terminate;(3)句式固定,飞行员与管制员之间严格按照“对方-己方-内容”的固定语法通话,如飞行员(Beijing TWR,CCA123.Request start up.),管制员(CCA123,Beijing TWR,Start up approved.)。近些年深度学习迅速发展,与之相关的算法在自然语言处理领域中被使用[3,4],在民航空中交通管制(简称民航空管)中,也使用了基于深度神经网络(Deep neural network,DNN)的语音识别方法。民航陆空通话语音识别技术的应用,不仅可以辅助管制员与飞行员训练,有助于减少民航通话语义表达错误,还可以辅助管制员工作,提高工作效率。在文献[5,6]中,使用陆空通话语音识别技术与雷达技术结合建立了ABSR系统,实验表明,通过ABSR系统提供的辅助信息,语音识别技术可以有效的减少管制员工作量,文献[7]基于语音识别工具包Kaldi[8],对陆空通话语音进行识别,实验结果表明,使用语音识别技术辅助管制员工作,可以减少飞机非计划飞行时间,提高管制效率与经济效益。文献[9]将DNN和隐马尔可夫(Hidden Markov model,HMM)相结合,利用深度神经网络非线性拟合能力,搭建了DNN/HMM模型,并在专有的陆空通话语音数据库中进行了实验,使错误率下降到了9.4%。

然而在基于DNN/HMM模型的陆空通话语音识别中,训练模型需要语音帧与音素标签对齐,为此需训练一个GMM/HMM模型作为对齐依据。而且为提高GMM/HMM模型性能,需采用不同的特征处理方法,这些处理步骤不仅增加了DNN/HMM模型的训练复杂度,还延缓了模型更新。为减少自动语音识别系统(Automatic Speech Recognition,ASR)的复杂度,前期已开展很多相关研究工作。文献[10]在DNN网络训练中使用了上下文相关的决策树,不需要GMM完成DNN/HMM模型的训练,减少了系统复杂度,但是该方法也需要进行多次语音与音素对齐处理。文献[11,12]使用时序链式连接(Connectionist Temporal Classification,CTC)[13]与递归神经网络(Recurrent Neural Networks,RNN)结合的端到端的语音识别,不需要训练GMM/HMM模型,也不需要语音帧与音素标签对齐,即可完成普通话与日常英文的语音识别任务,同时降低了系统复杂度。

本文基于陆空通话语言特点,为搭建适用于民航陆空通话,且模型训练预处理少的语音识别声学模型,提出了一种基于递归神经网络(RNN)的民航陆空通话语音识别方法。首先,本文使用双向长短时记忆网络(BiLSTM)建立了声学模型,为消除语音帧的标注需要,降低模型训练复杂度,使用CTC目标函数训练BiLSTM网络;其次,为增加模型的鲁棒性,提高语音识别率,在训练中应用了数据迁移与增强策略,得到增强的BiLSTM/CTC模型;最后,结合声学模型,词典与语言模型,实现数据库中陆空通话语音转换为文本。实验表明,该方法只需要句子级别的标注,即可在建立的数据库中完成民航陆空通话语音识别任务。

2 LSTM的基本原理

在深度学习算法中,递归神经网络(RNN)因为能够捕捉序列时间动态信息,而被应用在不同领域。理论中的RNN网络能对任意长度序列建模,但是在实际中,RNN网络的乘积关系会产生矩阵高次幂,致使网络在训练过程出现梯度消失和爆炸问题[14,15]。

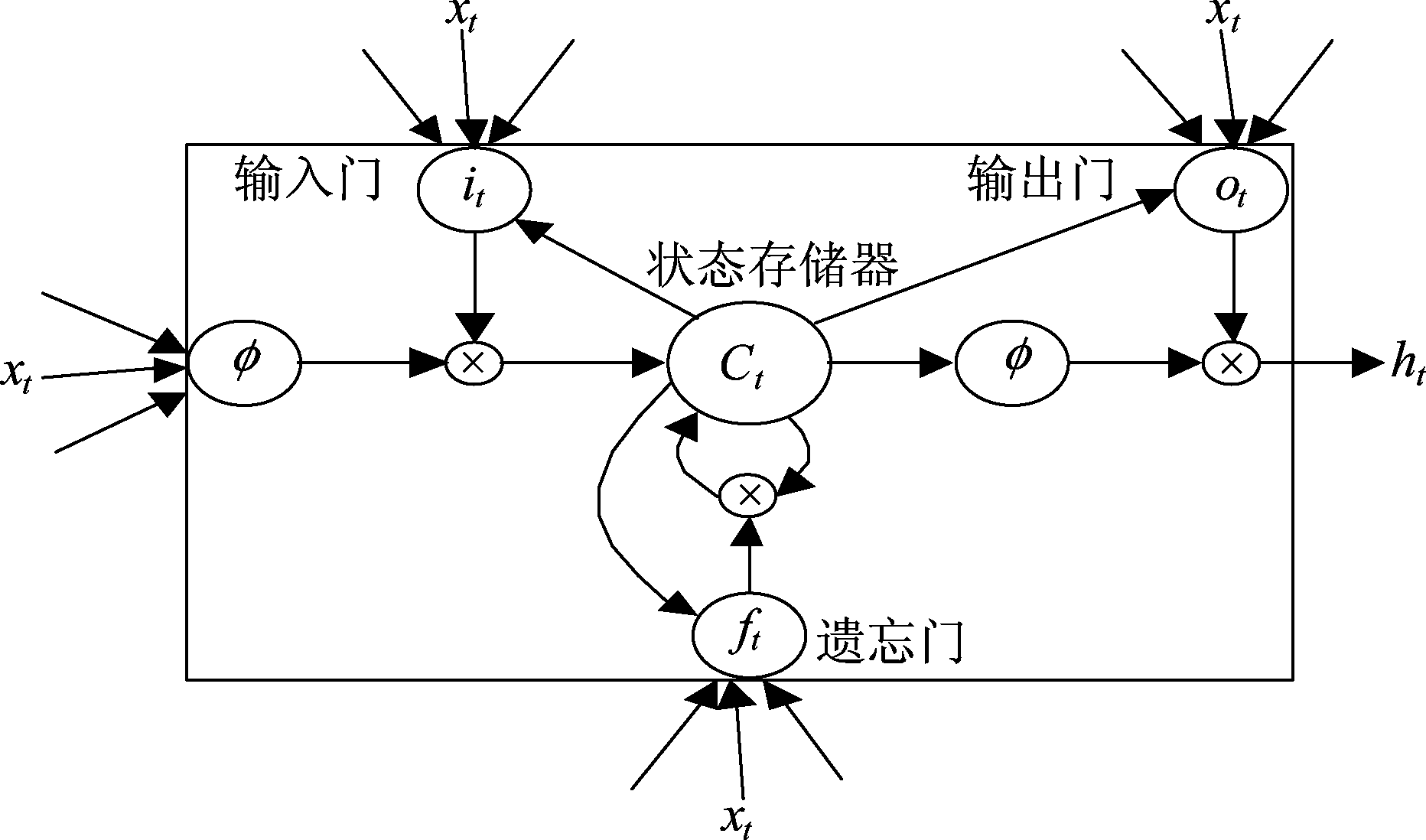

图1 LSTM记忆单元

Fig.1 Memory cell of LSTM

LSTM[16]网络是一种常见的RNN网络,其单元结构如图1所示,包含状态存储单元、输入门、遗忘门和输出门,这样的结构使得LSTM网络在训练过程中,一定程度上克服了梯度消失和爆炸问题。

对于一个输入序列X=(x1,x2,...,xT),LSTM记忆单元各部分在时刻t更新如公式(1)~(5)所示:

it=σ(Wixt+Riht-1+Pict-1+bi)

(1)

ft=σ(Wfxt+Rfht-1+Pfct-1+bf)

(2)

ct=ft⊗ct-1+it⊗f(Wcxt+Rcht-1+bc)

(3)

ot=σ(Woxt+Roht-1+Poct+bo)

(4)

ht=ot⊗φ(ct)

(5)

其中,it,ft,ot,依次表示输入门,遗忘门,输出门,xt表示t时刻的特征向量,σ(·)和φ(·)分别表示sigmoid函数和tanh函数,⊗表示点乘运算。ht表示t时刻隐藏状态,它保存着t时刻之前的所有有用信息。Ri,Rf,Rc,Ro表示单元部分与ht相连的权值矩阵,Wi,Wf,Wc,Wo表示各个门与xt相连的权值矩阵。bi,bf,bc,bo表示偏置矩阵,且只与it,ft,ot和ct相关,进行梯度计算时可以省略。在公式(3)中,ct为t时刻输出信息,ct-1为前一时刻的信息,三个门与ct-1,ct交互,使过去信息ct-1和现在信息ct参与LSTM单元序列建模。

3 基于BiLSTM/CTC的民航陆空通话声学模型

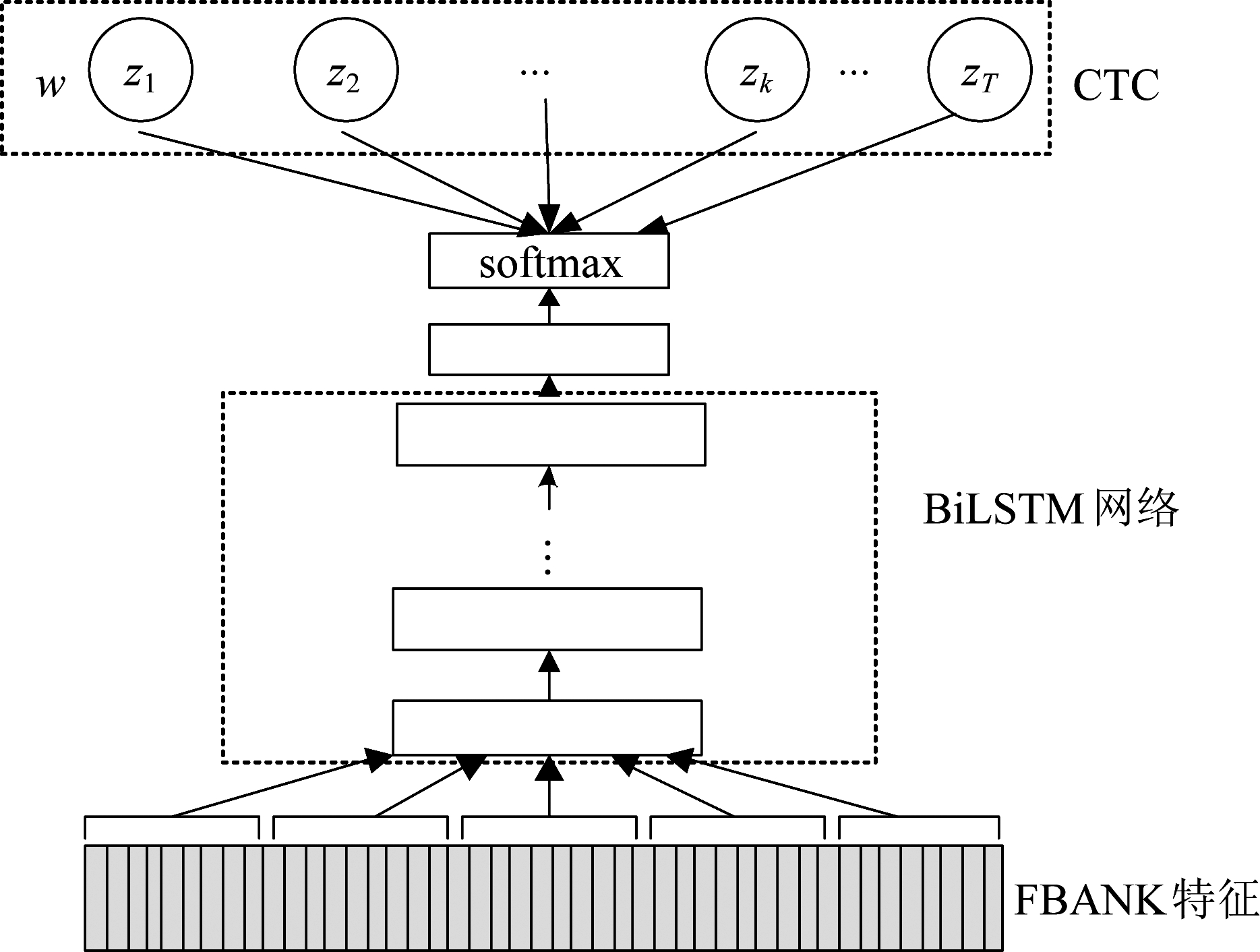

图2为陆空通话声学模型框架。实现陆空通话声学建模的过程可分为三个部分。①预处理阶段:将整个陆空通话语音信号切分为语音片帧,并提取语音帧的FBANK特征,得到特征向量;②初始网络训练阶段:BiLSTM网络的输入层以特征向量为输入,自底向上对语音信号进行语义信息提取,得到语义信息向量,然后,softmax层以此向量为输入,输出语音帧在标签集合的条件概率分布;③网络优化阶段:CTC使用softmax提供的概率分布,以最小化似然函数为目标,通过反向传播算法进行参数调优,经过多次对BiLSTM网络进行训练,最后得到适用于陆空通话语音识别的BiLSTM/CTC声学模型。

图2 BiLSTM/CTC框架原理图

Fig.2 The principle block diagram of BiLSTM/CTC

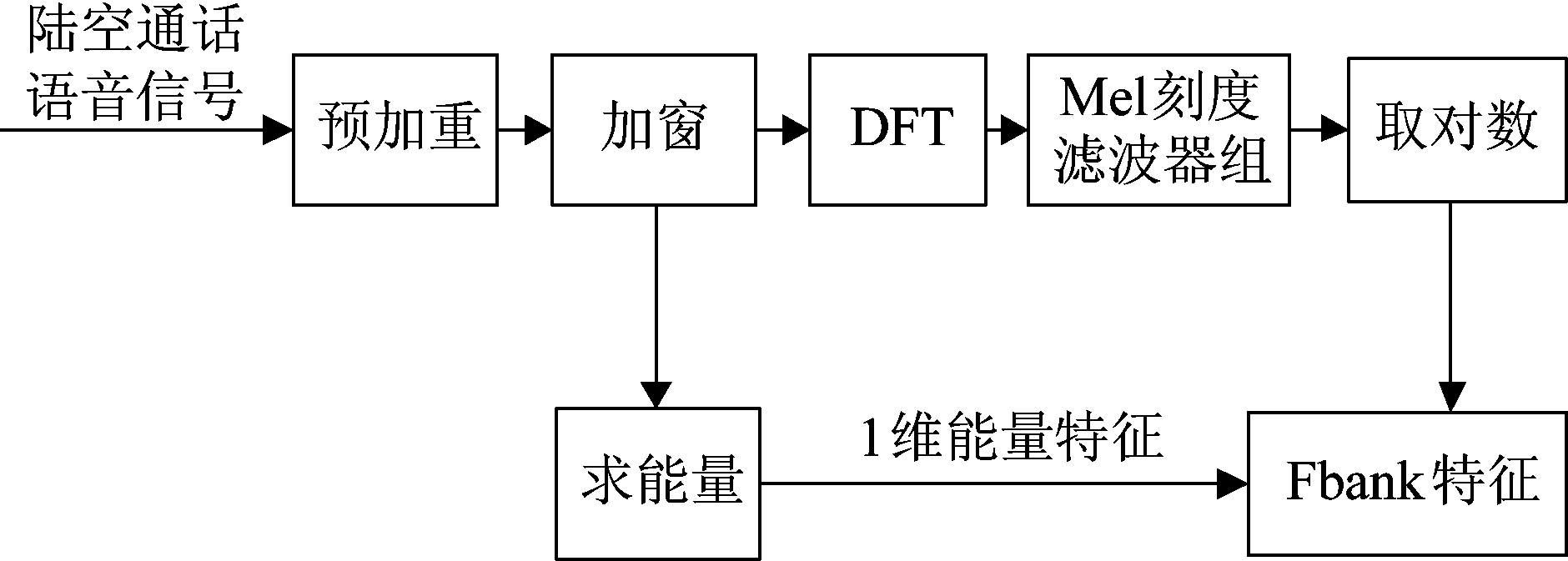

3.1 陆空通话语音特征提取

本文采用FBANK特征作为声学模型训练的输入。图3为FBANK特征提取流程。由于陆空通话具有通话时间短、语速快、语调平稳的特点,因此,调整了帧长、帧移以适应陆空通话特点。首先,设置预加重系数为0.97,以提升语音信号的高频分量;分帧过程中选取窗的大小为20 ms,帧移为10 ms,并对每帧语音进行离散傅里叶变换(DFT);然后,调整39个Mel刻度滤波器的上限与下限频率,并使用滤波器组对DFT结果提取39个输出能量,并计算能量的对数值,同时计算每个语音帧的总能量;最后,40个能量值构成一个40维的FBANK特征向量。

图3 FBANK特征提取流程

Fig.3 The flow diagram of FBANK feature extraction

3.2 BiLSTM网络

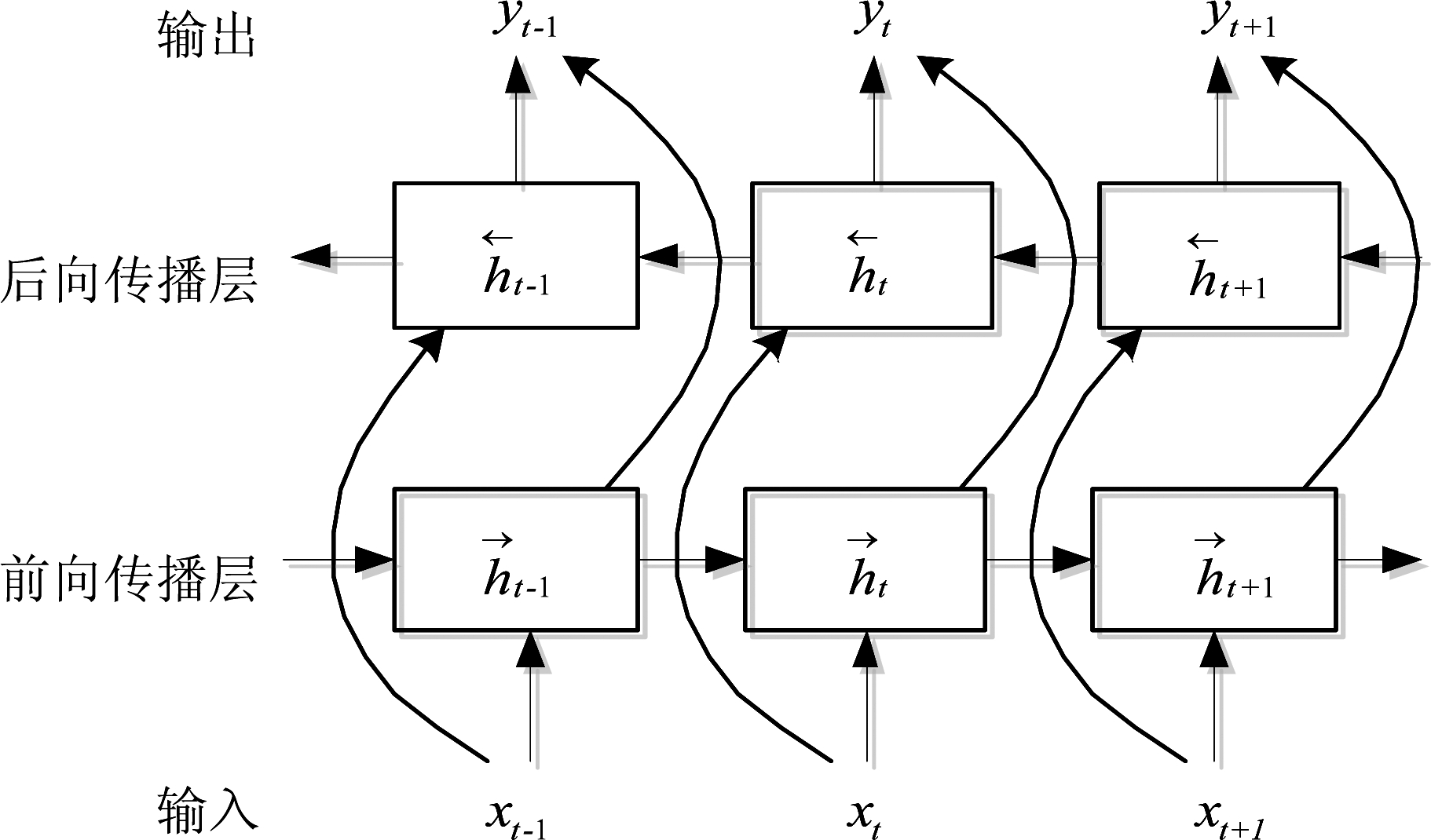

在陆空通话语音中,通话句式固定,通话内容需要管制员与飞行员预先确认,因此每个时刻通话语音与过去和未来的语音相关。为能很好的利用民航陆空通话语言规则固定,通话语音内部相关性强的特点。本文采用两个方向的LSTM层搭建BiLSTM网络[17],对陆空通话语音的过去与未来信息进行处理,实现语音序列的上下文信息建模,单层的BiLSTM结构如图4所示。

图4 BiLSTM神经网络结构

Fig.4 The structure of Bidirectional LSTM

![]()

(6)

(7)

(8)

BiLSTM网络通过公式(6)与公式(7)实现数据处理,前向传播与后向传播的LSTM层分别对通话语音的过去和未来信息进行提取与保存,其中W代表权重,H代表隐藏层的激活函数。t代表时间,t取值区间为[1,T]时可计算过去隐藏状态![]() 取值区间为[T,1]时可计算未来隐藏状态

取值区间为[T,1]时可计算未来隐藏状态![]() 层的输出向量yt可根据两个方向的隐层状态进行计算,如公式(8)所示。

层的输出向量yt可根据两个方向的隐层状态进行计算,如公式(8)所示。

3.3 时序链式连接

在语音识别中,基于监督学习的方法需要为输入序列做标签。时序链式连接(Connectionist Temporal Classification,CTC) 是BiLSTM/CTC模型的最后一层,其输出对应着整句语音的标签分布。在训练网络时,CTC不需要语音帧与标签对齐,只需要对语音序列进行句子级别标注,即可完成网络训练。

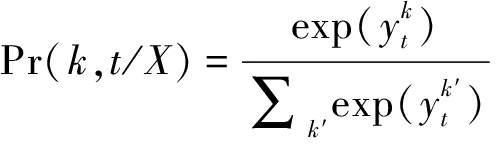

对给定一个输入序列X=(x1,x2,...,xT),其对应的标签序列为Z=(z1,z2,...,zU),且有U≤T。在模型的softmax层中,存在L+1个节点,其中L个节点代表L个标签,额外节点表示“空白”标签。如公式(9)所示,输出层的输出向量yt中每个元素经过softmax激活函数归一化,转化成一个[0,1]区间内的数值,该数值表示yt属于L+1个标签集合中第k个标签的概率。

(9)

其中![]() 代表softmax层输出向量yt中第k个元素,对于一个长度为T的标签输出路径w,其似然值计算如公式(10)所示。

代表softmax层输出向量yt中第k个元素,对于一个长度为T的标签输出路径w,其似然值计算如公式(10)所示。

(10)

对于每个输入序列X,在输入序列长度范围内,若使用‘-’表示空白标签,a,b,c表示L个节点的标签,由于标签在输入序列中出现的位置不确定,将产生多个输出路径Φ(Z),例如: 路径w1(a,a,-,-,b,-,c)和路径w2(a,-,a,-,b,-,c)。对输出路径w1和 w2进行去重复标签和去“空白”标签处理,将对应同一个输出标签序列(a,b,c),其就是输入序列X对应的标签序列Z,且输出路径序列与Z标签序列存在概率求和关系,如公式(11)所示。

(11)

由于输出路径数量众多,在实际训练中,对于给定的目标序列Z,为了能将表示“空白”的标签加入到CTC的输出路径,需要将序列Z做处理。将序列的开始、结尾及每个相邻标签间加入“空白”,如序列(a,b,c)扩展为(-,a,-,b,-,c,-),然后使用前向后向算法[18]求解公式(11),同时以公式(12)为损失函数,计算梯度,更新参数使损失函数值最小。

LossCTC(X,Z)=-lnPr(Z*/X)

(12)

3.4 声学模型训练

在基于深度学习的语音识别中,训练数据的量及模型训练策略影响着模型性能。应用CTC训练语音识别模型,需要语音序列的句子级别标注。这一方面可以有效减少训练预处理复杂度,另一方面由于CTC是预测语音序列与标签序列的对齐,训练网络需要更多的信息,需要增加训练的数据量。本文在有限数据条件下,为提高民航陆空通话语音识别率,使用了一种基于数据迁移与增强的训练模型方法。

本文中使用英文音素作为CTC的预测标签,使用了如下两种方式进行网络训练:(1)在数据增强[19]处理中,通过改变声道长度归一化系数(VTLN)和帧移系数对语音帧进行处理,得到增强的训练数据,并使用其对网络进行训练。(2)在本文的语音识别任务中,需要选取合适的数据进行迁移[20]。公开数据集LIBRISPEECH与本文数据集都是英文数据集,在英文单词和音素组成相同,因此使用其与实验室采集数据结合,可增加网络训练数据。训练网络的具体实验步骤在文中4.4节介绍。

4 实验与分析

4.1 民航陆空通话语料库

本文根据国内民航陆空通话标准,以实际民航陆空通话录音和相关课程教材为参考,模拟国内一个民用机场的通话内容,建立了英文陆空通话数据集D1。该数据集由空管专业学生与一线工作管制员共同录制,录制人数为11名,约35个小时,录音格式为:采样率16000 Hz,WAV格式。数据集包含飞行各个阶段常用的民航陆空通话用语,在语音语速,内容,指令表达方式等方面符合实际民航陆空通话特点。实验中整个数据集被分为两部分,训练集和测试为4∶1。

在民航领域中,为管制员和飞行员口语表达的流畅和规范,国内外民航组织制定了一套无线电通话术语标准,使其明显区别于日常英文发音。在标准中,许多英文单词发音规则发生了改变,如A发Alpha音,8发AIT音等,为识别这些特殊术语,需要构造适合陆空通话发音规则的词典。本文参考日常用语英文发音词典的构建,使用英文音素为基本单元,对数据集D1的单词进行音素序列构造,得到了陆空通话中单词对应的音素组合序列的词典,为陆空通话语音识别任务提供音素到单词的映射。

4.2 语音特征实验

在深度学习语音识别领域,神经网络的训练与语音特征提取相关,本节为探究MFCC与FBANK语音特征对BiLSTM网络训练的影响,及语音特征的拼接帧数目对陆空通话语音识别率的影响,进行了语音特征实验。实验中使用的评估准则为词错误率(Word Error Rate,WER),如公式(13)所示。

×100%

(13)

本实验提取D1的40维FBANK和一阶及二阶差分的39维MFCC特征作为网络输入数据,使用4层640单元的BiLSTM网络搭建模型。在模型训练过程中,网络权重初始化区间为[-0.1,0.1],初始设置学习率为0.0004,并使用随机梯度下降算法(Stochastic Gradient descent,SGD)进行优化。在解码阶段基于加权有限状态转换器(Weighted Finite-State Transducers,WFST)[21]构建了解码搜索空间,采用Veterb算法进行最优路径搜索,并使用陆空通话文本的3-gram语言模型进行搜索空间约束,其实验结果如表1所示。

表1 N帧拼接的语音特征实验结果

Tab.1 The result of N splicing acoustic feature

NWERMFCCFBANK311.94%10.39%510.84%10.75%711.60%11.23%911.93%10.27%1112.11%10.40%1312.23%10.43%

从表1可知,拼接数目N影响着陆空通话语音识别的结果,无论在哪种方案的实验中,使用FBANK特征的词识别错误率都比MFCC特征的词识别错误率低。这是因为语音帧提取MFCC特征时增加了倒谱处理,造成语音原始信息丢失,不利于BiLSTM/CTC模型对英文陆空通话语音信号建模,而使用一定数目拼接的语音特征能使网络学习同一个音素语音帧之间的相关信息,有益于模型训练,降低了语音识别词错误率。实验结果表明,对于陆空通话语音,使用FBANK特征训练BiLSTM网络,能得到更优BiLSTM/CTC模型,并且使用9个FBANK特征拼接训练网络时,能取得最低的语音识别词错误率。

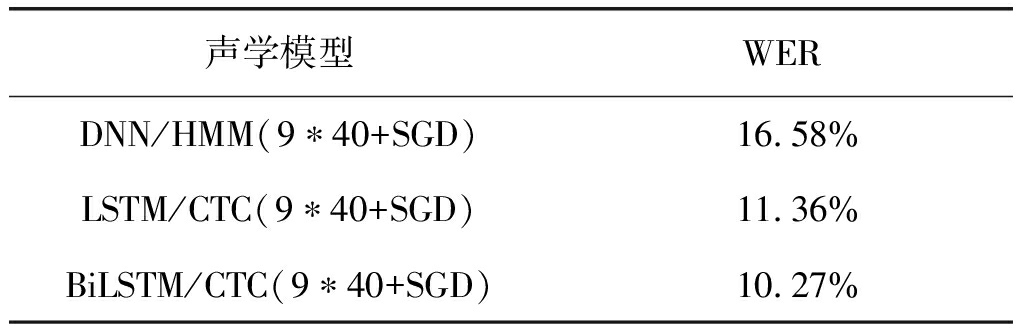

4.3 声学模型实验

在基于深度学习的语音识别技术中,声学模型是语音识别系统重要组成部分,为研究本文使用的模型对语音识别率的影响,在语音特征实验的基础上,使用9个FBANK特征拼接的向量作为网络输入,训练了3种声学模型,并比较了它们的识别结果。

表2 不同声学模型试验结果

Tab.2 The result of various acoustic model

声学模型WERDNN/HMM(9∗40+SGD) 16.58%LSTM/CTC(9∗40+SGD) 11.36%BiLSTM/CTC(9∗40+SGD) 10.27%

由表2可知,在D1测试集上,LSTM/CTC模型的词识别错误率比DNN/HMM模型低。这是因为DNN网络的同层神经元没有连接,无法进行语音序列的前后时刻信息传递,只进行了语音信号局部建模。而LSTM单元的三个门和状态存储器结构能处理语音的历史信息,并且神经元之间的相互连接,能使信息在网络中传递,有利用于网络对语音信号整体建模。 BiLSTM/CTC模型的词识别错误率比LSTM/CTC模型低,这是因为BiLSTM网络包含两个方向的LSTM层,同时考虑了未来和过去信息对当前时刻的影响,实现了更多上下文信息参与网络的声学建模,从而提升了陆空通话语音识别率。

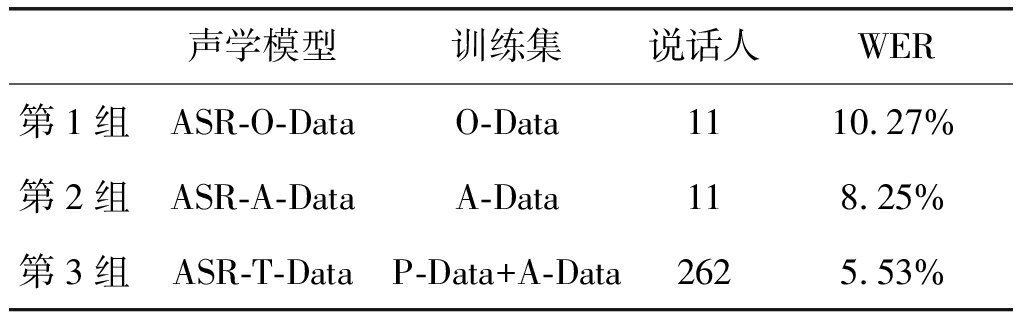

4.4 模型训练及实验结果

在深度学习中,训练数据量和模型训练方法都对模型性能有较大影响。为提升模型性能,本文采用了迁移学习与数据增强的模型训练策略,并与传统训练方法进行了对比。本节实验进行了如下3组实验,在实验中都采用9*40维的FBANK特征训练BiLSTM网络,优化方法采用SGD。

实验1 采用传统训练方法。首先,通过对D1数据集进行FBANK特征提取,得到训练集O-Data;然后,使用O-Data训练BiLSTM网络,得到模型ASR-O-Data。

实验2 采用数据增强策略。首先,对D1数据集进行数据增强,加入扰动数据,得到时长约252小时的训练集A-Data;然后,在规定的训练次数内使用A-Data训练BiLSTM/CTC模型;最后,使用A-Data中非扰动数据对BiLSTM/CTC模型进行调整训练,得到模型ASR-A-Data。

实验3 采用迁移训练策略。首先,对公开的数据集LIBRISPEECH提取语音FBANK特征,得到训练集P-Data;然后,在规定的训练次数内使用训练集P-Data训练BiLSTM网络得到模型ASR-P-Data;再对ASR-P-Data模型的最后一层进行权值随机初始化,其他层不改变,得到模型im-ASR-P-Data;最后,与实验2的训练方法一样,使用训练集A-Data训练im-ASR-P-Data,并使用A-Data非扰动数据对模型进行调整训练,得到模型ASR-T-Data。通过实验得到了不同训练方法的语音识别结果,如表3所示。

表3 训练方法的语音识别结果

Tab.3 The speech recognition result of different training way

声学模型训练集说话人WER第1组ASR-O-DataO-Data1110.27%第2组ASR-A-DataA-Data118.25%第3组ASR-T-DataP-Data+A-Data2625.53%

从表3的实验结果可以看出,在同一个测试集上,不同的训练方法对识别结果的影响不同,3组实验的词识别错误率依次减少。其中第1组为传统的训练方法,第2和第3组为使用数据迁移与增强策略训练方法。

实验2中使用数据增强方法,一方面增加了训练数据,同时也增加了语音数据扰动因素。使用其训练BiLSTM网络,不仅更加充分的训练了参数,还提升了模型对语音特征的鲁棒性。所以与第1组相比,第2组实验词识别错误率减少了2.02%。在第3组实验中,词识别错误率进一步降低了2.72%。因为陆空通话与日常英文虽有明显区别,但是LIBRISPEECH数据集与陆空通话语音数据集的声学建模单元相同,是相同英文音素。在陆空通话语音识别中,BiLSTM网络被训练作为语音帧级别的分类器,训练数据的增加,能使网络的参数训练更充分,提升了BiLSTM网络分类能力,同时,使用数据增强与迁移也增强了模型的鲁棒性,最终提高了陆空通话语音识别率。上述3组实验结果表明,数据迁移与增强训练策略可以提高BiLSTM/CTC模型的英文陆空通话语音识别率。

5 结论

本文针对民航陆空通话语言特点,提出了基于BiLSTM/CTC模型的陆空通话语音识别方法。通过语音特征实验结果分析,与MFCC特征比较,提取陆空通话语音的FBANK特征训练BiLSTM网络,能使BiLSTM/CTC模型性能更优。通过声学模型实验分析,基于相同的数据库与训练方法,BiLSTM/CTC模型的识别率比DNN/HMM模型提升了6.31%。在现有语料库上,基于迁移学习思想,通过数据增强及迁移策略,得到增强的BiLSTM/CTC模型。结合词典与语言模型,应用增强的声学模型能使陆空通话语音识别在词识别错误方面降低到5.53%。

[1] 潘卫军,吴量,陈华群,等. 空中交通无线电陆空通话错误分析[J]. 中国西部科技,2008,7(30): 1-3.

Pan Weijun,Wu Liang,Chen Huaqun,et al. Mistakes in Radio Communications Analysis Based on Statistic[J]. Science and Technology of West China,2008,7(30): 1-3.(in Chinese)

[2] Lahtinen T M,Huttunen K H,Kuronen P O,et al. Radio speech communication problems reported in a survey of military pilots[J]. Aviation Space & Environmental Medicine,2010,81(12): 1123-1127.

[3] 李华,屈丹,张文林,等. 结合全局词向量特征的循环神经网络语言模型[J]. 信号处理,2016,32(6): 715-723.

Li Hua,Qu Dan,Zhang Wenlin,et al. Recurrent Neural Network Language Model with Global Word Vector Features[J]. Journal of Signal Processing,2016,32(6): 715-723.(in Chinese)

[4] 张昕然,巨晓正,宋鹏,等. 用于跨库语音情感识别的DBN特征融合方法[J]. 信号处理,2017,33(5): 649- 660.

Zhang Xinran,Ju Xiaozheng,Song Peng,et al. Feature Fusion Based on DBN for Cross-Corpus Speech Emotion Recognition[J]. Journal of Signal Processing,2017,33(5): 649- 660.(in Chinese)

[5] Helmke H,Rataj J,Mühlhausen T,et al. Assistant-based speech recognition for ATM applications[C]∥Proceedings of the USA/FAA Air Traffic Management R&D Seminar. 11th USA/Europe Air Traffic Management Research and Development Seminar: FAA/EUROCONTROL,2015.

[6] Helmke H,Ohneiser O,Mühlhausen T,et al. Reducing controller workload with automatic speech recognition[C]∥Digital Avionics Systems Conference(DASC).2016 IEEE/AIAA 35th: IEEE,2016: 1-10.

[7] Helmke H,Ohneiser O,Buxbam J,et al. Increasing ATM Efficiency with Assistant Based Speech Recognition[C]∥Proceedings of the 13th USA/Europe Air Traffic Management Research and Development Seminar. Seattle,USA. 2017.

[8] Povey D,Ghoshal A,Boulianne G,et al. The Kaldi speech recognition toolkit[C]∥IEEE 2011 workshop on automatic speech recognition and understanding. IEEE Signal Processing Society,2011(EPFL-CONF-192584).

[9] Srinivasamurthy A,Motlicek P,Himawan I,et al. Semi-supervised Learning with Semantic Knowledge Extraction for Improved Speech Recognition in Air Traffic Control[C]∥Proceedings of Interspeech 2017. INTERSPEECH 2017: IEEE,2017: 2406-2410.

[10] Senior A,Heigold G,Bacchiani M,et al. GMM-free DNN acoustic model training[C]∥IEEE International Conference on Acoustics,Speech and Signal Processing. IEEE,2014: 5602-5606.

[11] Graves A,Jaitly N. Towards end-to-end speech recognition with recurrent neural networks[C]∥International Conference on Machine Learning. 34th International Conference on Machine learning: JMLR,2014: 1764-1772.

[12] Amodei D,Ananthanarayanan S,Anubhai R,et al. Deep speech 2: End-to-end speech recognition in english and mandarin[C]∥International Conference on Machine Learning. 2016: 173-182.

[13] Graves A,Fern ndez S,Gomez F,et al. Connectionist temporal classification: labelling unsegmented sequence data with recurrent neural networks[C]∥Proceedings of the 23rd international conference on Machine learning. ACM,2006: 369-376.

ndez S,Gomez F,et al. Connectionist temporal classification: labelling unsegmented sequence data with recurrent neural networks[C]∥Proceedings of the 23rd international conference on Machine learning. ACM,2006: 369-376.

[14] Bengio Y,Simard P,Frasconi P. Learning long-term dependencies with gradient descent is difficult[J]. IEEE Transactions on Neural Networks,2002,5(2): 157-166.

[15] Pascanu R,Mikolov T,Bengio Y. On the difficulty of training recurrent neural networks[C]∥International Conference on Machine Learning,2013: 1310-1318.

[16] Gers F A,Schraudolph N N,Schmidhuber J. Learning precise timing with LSTM recurrent networks[J]. Journal of Machine Learning Research,2002,3(Aug): 115-143.

[17] Schuster M,Paliwal K K. Bidirectional recurrent neural networks[J]. IEEE Transactions on Signal Processing,2002,45(11): 2673-2681.

[18] Graves A. Sequence Transduction with Recurrent Neural Networks[J]. Computer Science,2012,58(3): 235-242.

[19] Billa J. Improving LSTM-CTC based ASR performance in domains with limited training data[J]. arXiv preprint arXiv: 1707.00722,2017.

[20] Li S,Akita Y,Kawahara T. Semi-Supervised Acoustic Model Training by Discriminative Data Selection from Multiple ASR Systems’ Hypotheses[J]. IEEE/ACM Transactions on Audio Speech & Language Processing,2016,24(9): 1524-1534.

[21] Mohri M,Pereira F,Riley M. Weighted finite-state transducers in speech recognition[J]. Computer Speech & Language,2002,16(1): 69- 88.