1 引言

传统公交车的监控系统利用监控设备获得公交车驾驶员的监控视频,监控视频集中在监控室进行显示和存储,以便进行监督和后期查阅。但其智能化程度低,无法主动进行分析和处理,同时耗费大量的人力物力,无法对驾驶员不当行为进行重点跟踪和记录,远不能满足实际需求[1-2]。其次,这种处理太过简单,缺乏针对性,难以对大量视频数据进行检索,分析和处理,难以实现24小时不间断监控,容易引发多处报警,出现错报漏报,处理事件滞后时间长。因此,目前亟需一种智能化的视频监控系统,能够对公交车场景发生的事件进行理解和分析描述,自动定位出特定行为并进行分析识别[3]。

深度学习作为机器学习的一个研究分支受到科研机构、工业界的高度关注,在语音识别、计算机视觉等应用中不断有新算法模型被提出[4]。且性能已经远超传统方法,成为目前最主流的图像处理方法。基于卷积神经网络的特点,本文尝试将其作为手部识别的主要方式,并将人体姿态信息加入到CNN检测网络中,来约束目标的检测,从而提高手部检测框的坐标精度,生成更精确的手部回归框坐标,并在之后级联手部动作分类网络,训练出针对手部局部图片的权重以提高分类准确率,最后通过动作分类网络达到输出人体手部动作的结果,形成一个串行多阶段的手部动作检测方法。这种由基础网络,根据具体需要进行的不论单目标检测还是多目标检测,通过新增的特征来提高学习效率,优化网络超参数提升网络性能[5]可以实现对于网络的较大改善。实验结果表明,本文的方法具有良好的手部行为识别的能力,证明了其有效性。

2 相关工作

近些年来对于动作检测的研究方法主要集中在深度学习方向,用于目标检测的深度学习网络中包含了目标检测和分类任务。基于卷积神经网络的目标检测通常可分为图像输入、特征提取、特征分类、坐标回归几个阶段。在具体实现中,将这几个阶段组成在一个具体的算法中以达到对性能的优化,即输入图像到输出任务结果一步完成。针对深度神经网络结构的研究包括很多,设计更好的激活函数、损失函数等,实现可视化等,研究者在一些重大问题上进行研究。如尺度不变性问题,能够实行的方案有特征金字塔网络(Feature Pyramid Network,FPN)[6],SPP-Net[7](Spatial Pyramid Pooling)等,如退化问题,解决方案也在Residual Network[8]中被提出。

主流检测网络分为基于区域建议的目标检测框架和基于回归的目标检测框架,基于区域建议的主流目标检测框架包括Mask RCNN[9]、Fast RCNN[10]以及Faster RCNN[11],其优点是准确率较高,但是速度较慢,难以达到实时性要求。基于回归的主流目标检测框架则有YOLO[12]系列网络、SSD[13]等网络,该系列网络虽然能够达到实时效果,但是精度都有一定程度的下降。

另一方面,手部区域对于动作检测有着关键作用。在人体姿态估计中,算法网络能够基于图像重建人体关节和躯干,并适应现实中人体姿态各种多变的情况,在诸如衣服、光照等遮挡因素干扰下保持鲁棒性。对手部定位有十分大的帮助。在这个研究领域,已经有不少成熟的网络框架。2016年提出了基于CNN的单人姿态估计算法网络CPM(Convolutional Pose Machines)[14-16],2017年由Cao Z等人提出的基于CNN的多人姿态估计CMU_OPENPOSE(Realtime Multi-Person 2D Pose Estimation using Part Affinity Fields)[17]中采用了自底向上策略,它提出了对关键点关联的明确非参数表示,保证了检测的人数增多时的算法准确度。Chen Y 等人则在2018年提出了针对人体关节遮挡严重下的多目标检测算法CPN(Cascaded Pyramid Network for Multi-person Pose Estimation)[18]。另一种人体姿态检测另辟蹊径,同时考虑自顶向下、自底向上以及多尺度特征三种策略来提高人体关键点信息的提取,2016年提出的SHN(Stacked Hourglass Networks for Human Pose Estimation)[19-20]即为采用此类策略的姿态检测网络。

最后,分类任务对于手部动作检测同样重要。本文考虑在检测算法的基础上在后端增加一个轻量级分类网络,在不影响实时性的前提下有效提高动作分类效果。在完成分类任务上, VGGNet网络、Inception系列以及2015年由HE-Kaiming等人提出的ResNet[21]网络均有良好的表现,但此类网络在框架设计时朝着深度和复杂度的增加方向发展,使得网络规模复杂,且计算量巨大。2018提出的轻量级网络ShuffleNetV2[22]和在MobileNetV1[23]基础上改进的MobileNetV2则通过压缩网络同时兼顾速度与效果。

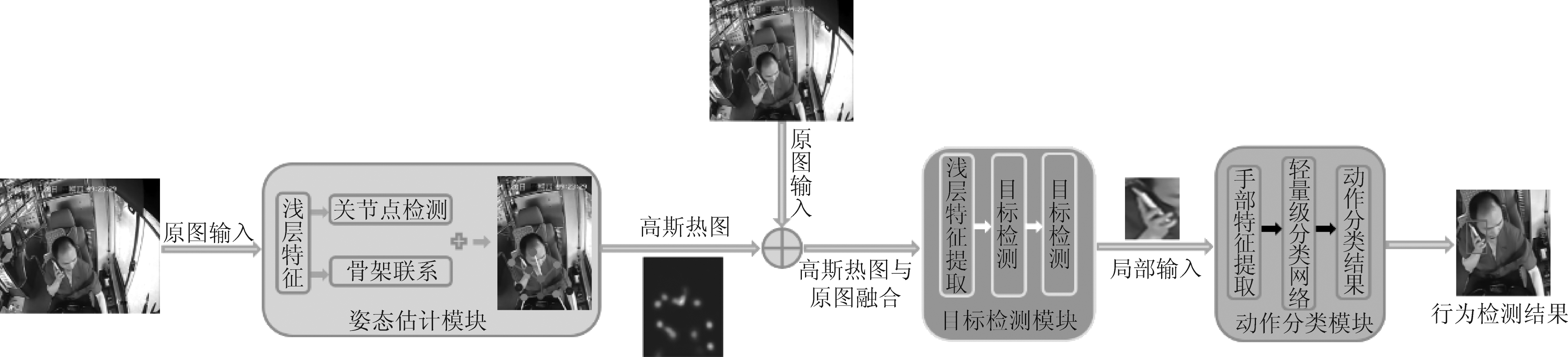

图1 手部动作检测框架图

Fig.1 Hand action detection framework

3 手部动作检测方法

3.1 总体方案

本文所设计的多阶段的手部动作检测方法根据实际要求,针对已有基于深度学习的目标检测网络对于动作检测准确性和实时性的不平衡问题,通过引入人体姿态估计网络中的关节的高斯热力图,实现对关节点的初步定位,以此来提高手部定位的精度。另一方面,区别于检测网络对全图卷积操作进行特征提取,手部的动作具有很高的独立性,不依赖环境特征和全图信息。针对这一特殊性,本文通过增加后端的轻量级分类网络来提高手部动作的分类效果。根据手部动作检测方法的需求,本文根据实现方法设计了一个多阶段的手部动作检测框架(Multi-stage Hand Motion Detection Framework,Multi-HMDF)。整体可分为三个模块,一是用于计算人体骨骼关键点高斯热图的人体姿态估计模块,二是定位手部回归框的检测模块,完成在人体关节约束情况下对人体手部的定位,三是进行手部动作分类的分类模块。其具体框架如图1所示。

3.2 人体姿态估计模块

本文所设计的手部动作检测方法强调对于手部检测的效果。人体姿态估计能够帮助提取图片中人体姿态的空间信息,增加人体关节特征输入,提高手部检测的效果。

3.2.1 设计方案

作为人体姿态估计模块的关键,其输出的热力图能够帮助实现关键点的数值坐标回归,提升目标检测模块的识别和定位精度。

对于关键坐标点的计算,argmax可作为实现算法,其计算峰值对应的索引即为坐标点,如式(1)所示,对于一个映射f:X→Y,当x取值范围为S时,argmax的结果是使得f(x)取得最大值的x点集。

(1)

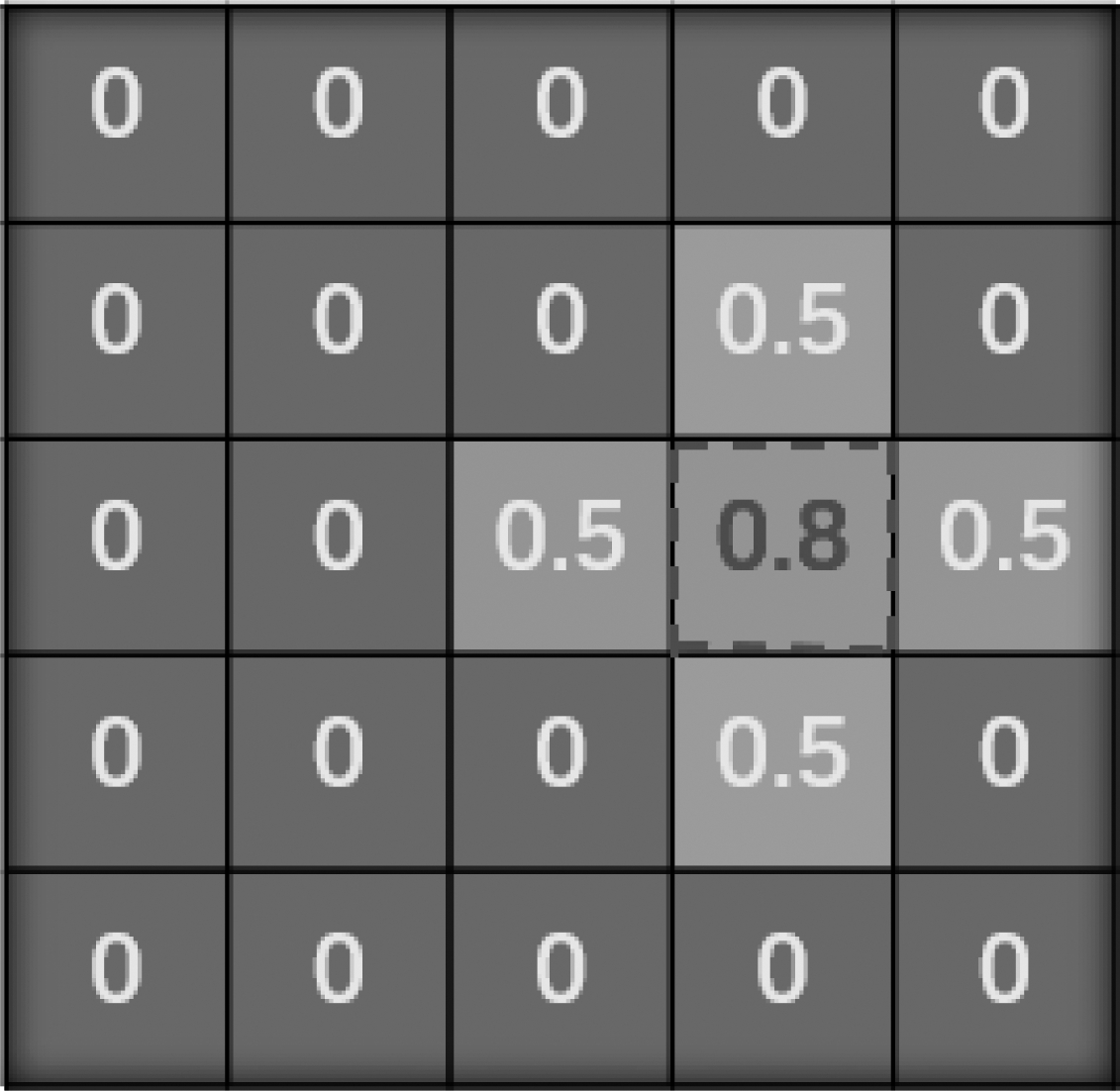

在对高斯热图进行argmax处理时,可以形象的看作图2所示,图中对应的最大值0.8的位置则是关键点激活的对应像素点。

图2 高斯热图示例

Fig.2 Examples of gauss heat maps

在人体姿态估计领域中,这是主要的关键点检测方法,本文中人体姿态估计模块的输出为高斯热图。且人体姿态估计模块对于关节提取的精确度要求较高,对手部检测结果影响较大,本文在考虑模块算法时有针对性地将关节检测率作为选择关键。

3.3 手部检测模块

作为手部动作检测方法的主要模块,检测模块要求较好的检测效果和较高的检测速度,增加的高斯热图特征输入对检测网络的输入也有更高的要求。

3.3.1 特征融合

相对于传统检测网络的输入,本文在传统图像输入的基础上增加了高斯热图的特征输入。

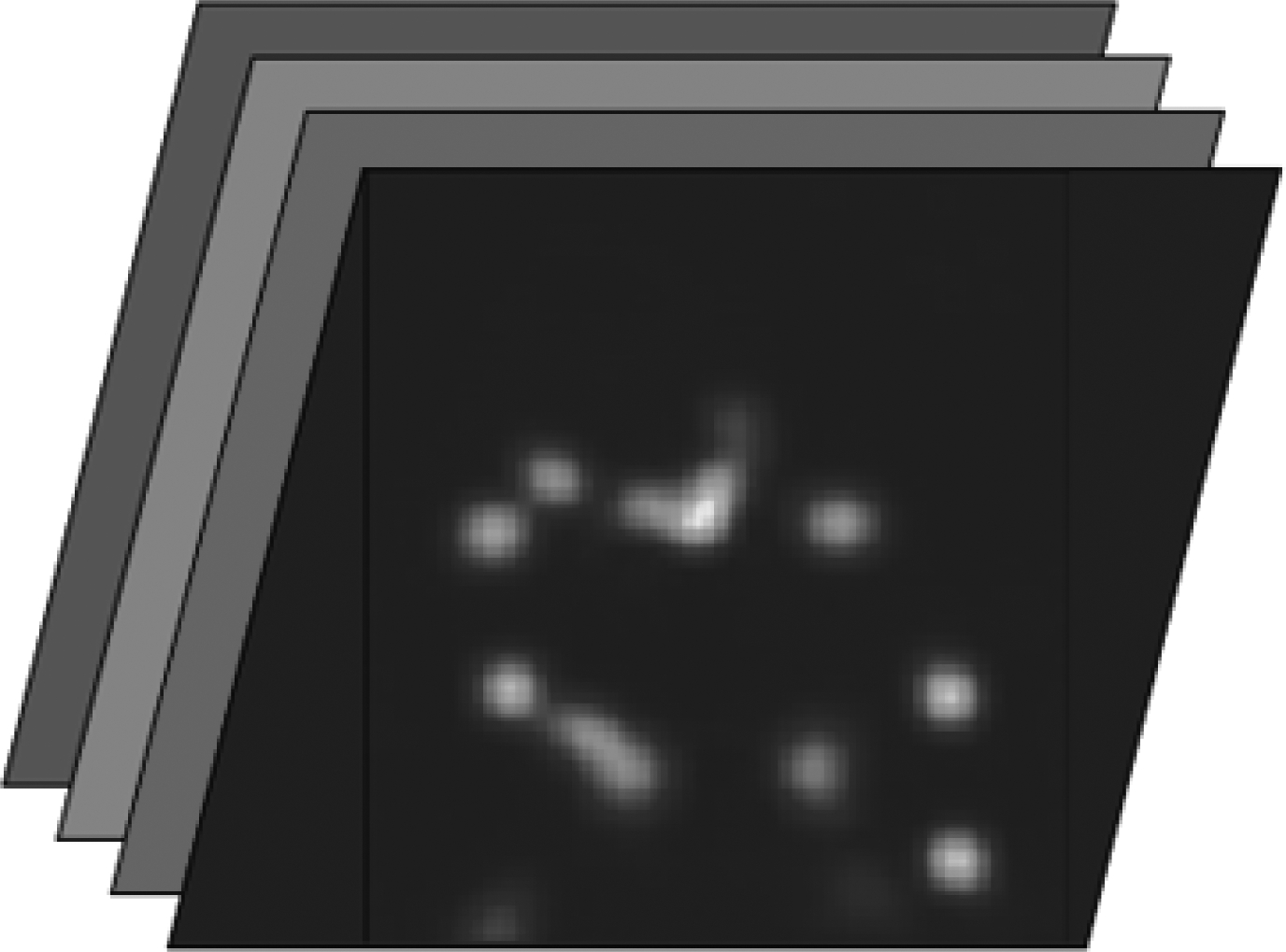

本文采用通道的叠加,在原有RGB三通道上增加 Heat Map通道,实现四通道信息融合。我们分为三步操作,通道叠加。在人体姿态检测网络生成17通道的高斯热图,通过不同通道对应位置上的概率密度线性相加将这对应17个人体关键点的高斯热图融合为单通道高斯热图;尺度变化。为使得高斯热图能够添加在原图后,高斯热图必须具有相同的尺度。这里对高斯热图进行最近邻上采样处理,这也是人体姿态估计网络(SHN)中扩大特征图尺度时采用的方法;归一化操作。高斯热图和原图需要保持归一化,即实现0-1的统一化。融合的图像信息如图3所示。

图3 融合图像

Fig.3 Fused image

3.3.2 设计方案

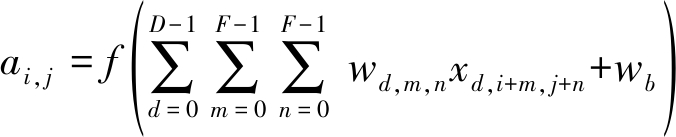

手部检测网络的设计中由于输入图像的通道数发生改变,需要重新设定网络中卷积核维度以适应改变后的输入维度。对于CNN的卷积核的维度,这里采用M*D*F*F来表示,可以理解为有M组卷积核,每组卷积核的深度表示为D,宽度和高度一般相同,表示为F。那么对于单独一组卷积核的计算公式如式(2),其中,wd,m,n表示卷积核的第d层第m行第n列的权重。每组卷积核生成一幅特征图,ai, j便是特征图第i行第j列的像素。

(2)

对于检测网络而言,通过对浅层网络中卷积核的修改可实现对输入特征的改变,其修改方式如图4所示。

图4 浅层网络结构

Fig.4 Shallow network structure

在手部检测定位任务中,由于本文方法针对驾驶员的手部不当行为进行检测,即方案对网络实现的实时性存在较高要求。在手部检测过程中,算法运行速率有较高优先级。

3.4 动作分类模块

在目标检测模块定位到手部坐标位置后,截取原图中手部局部图片并输入至动作分类模块,使得分类模块仅仅对手部局部图片进行特征提取,将网络注意力约束在手部位置,达到提高手部动作分类准确率的目的。

在本文设计方法中,三个模块是线性进行的,总体耗时为三模块耗时线性相加,分类模块的速度影响总体框架的速度。YOLO系列、SSD作为经典的目标检测算法,其本身即拥有目标分类算法部分,但在本实验中,手部动作的分类只针对输入图片中的局部进行作用,全局图片对于行为分析作用会增加冗余信息。因此,本文优先考虑压缩后的分类网络,在保证实时性的情况下,最大限度的提高分类效果。

4 实验结果与分析

4.1 实验准备4.1.1 实验数据

本文所采用的数据集由两部分组成:传统数据集和自制数据集。传统数据集使用的是MPII Human Pose数据集,本文选择其中1600张人体图片作为本文一部分数据集。其共分为20大类,且对人体的标注共有16个骨骼关节点,用数字0至15表示。图5为部分选择的MPII Human Pose数据集图片。

图5 MPII数据集部分图片

Fig.5 MPII dataset partial picture

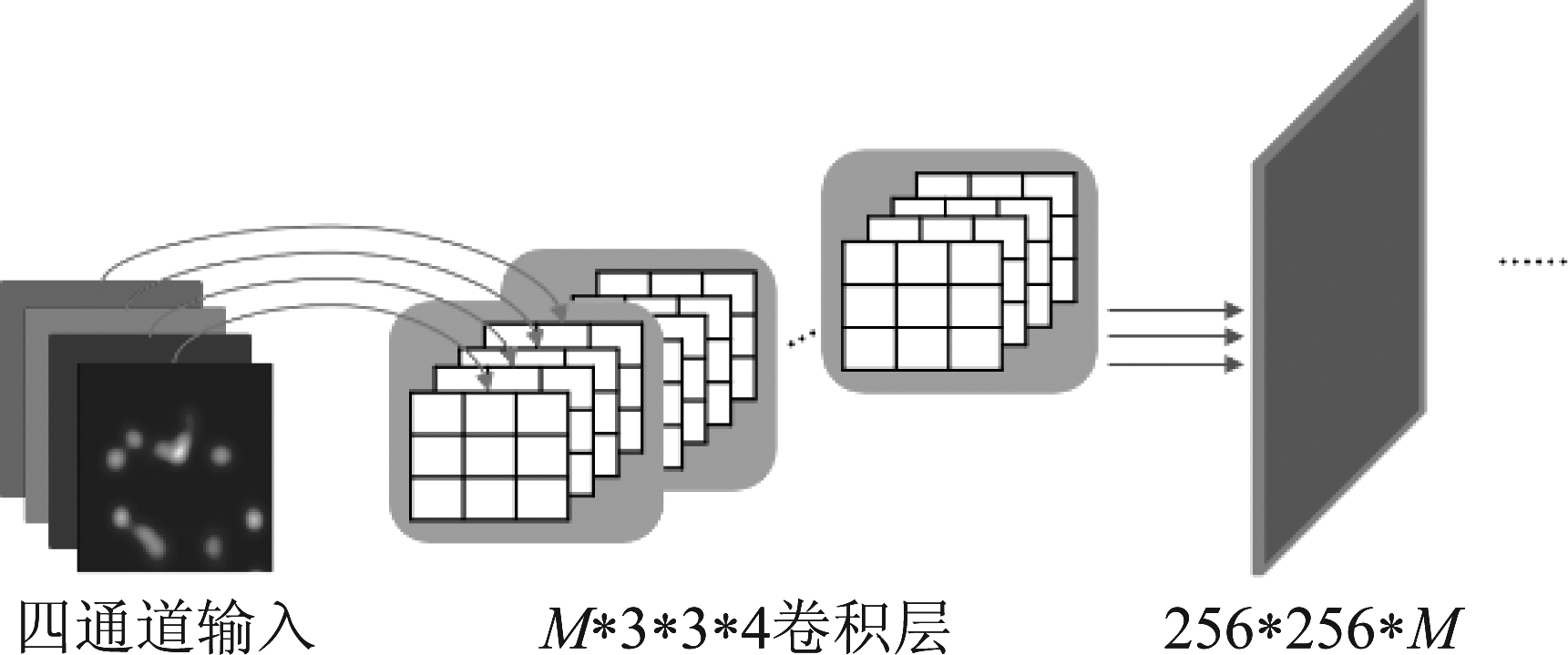

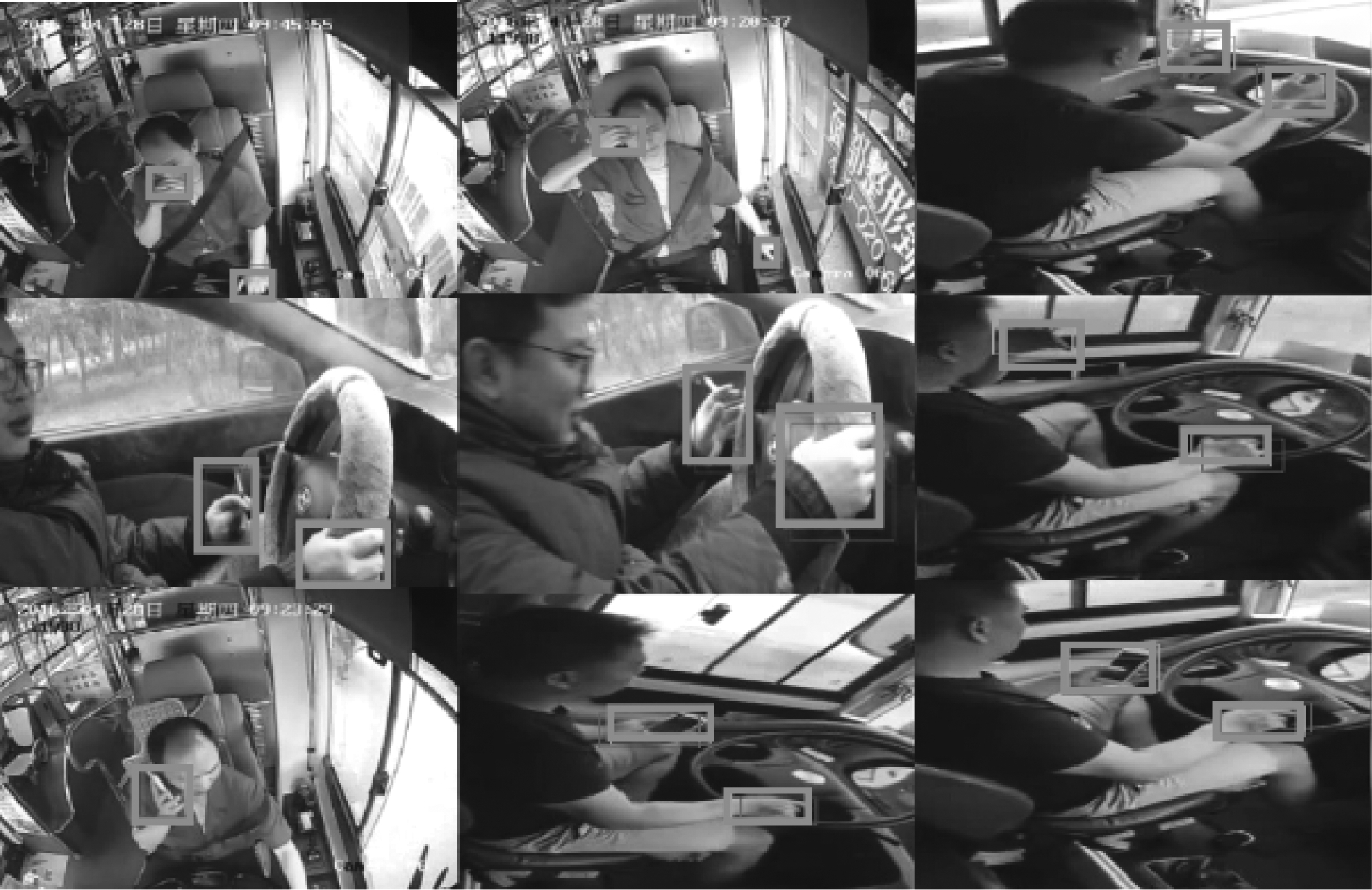

自制数据集包括人体动作数据集和手部动作数据集,自制数据集均为从公交车驾驶员的监控视频中提取。其中人体动作数据集用于手部检测和最终融合框架Multi-HMDF实验,共有1600张公交车驾驶员行驶时的图片,为驾驶员的手部动作检测提供了更为针对的数据,并对训练集进行关节标注和分类标注。数据集分为抽烟、打手机、正确驾驶三大类,其中抽烟类的图片有300张,打电话类的图片有300张,正常驾驶1000张。用于训练的图片共1280张,用于测试的图片共320张。图6为部分人体动作数据集图片。

图6 人体动作数据集部分图片

Fig.6 Pictures of human motion data set

除了人体动作数据集外,在方案的第三阶段需要完成对手部动作分类模块的选择,和人体动作数据集一样,为能获得出具有良好效果的手部动作分类网络,需要针对手部动作制作了一个手部动作数据集,数据集的图片主要是由公交车监控视频组成,均为公交车公司提供的实际监控图片,由图片中司机的手部分离出来组成手部动作数据集。手部动作数据集分为抽烟、打手机和正常驾驶三大类。数据集共2000张图片,其中抽烟类的图片有400张,打电话类的图片有400张,正常驾驶1200张。用于训练的图片共1600张,用于测试的图片共400张。部分数据集图片如图7所示。

图7 手部动作数据集部分图片

Fig.7 Some pictures of hand action data set

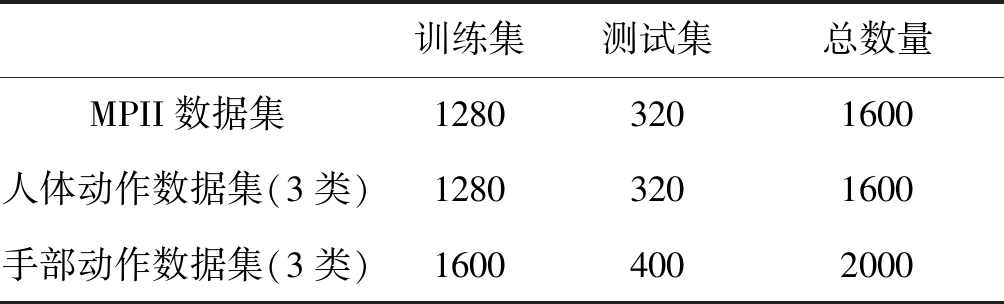

本文中所采用的数据集共5200张,其测试和训练使用的情况如表1所示。

表1 数据集及组成部分

Tab.1 Data sets and components

训练集测试集总数量MPII数据集12803201600人体动作数据集(3类)12803201600手部动作数据集(3类)16004002000

4.1.2 实验环境

本文所作实验的环境如下。实验环境搭建在Ubuntu16操作系统上,GPU为TiTan X,内存为32G,深度网络模型基于TensorFlow框架实现。

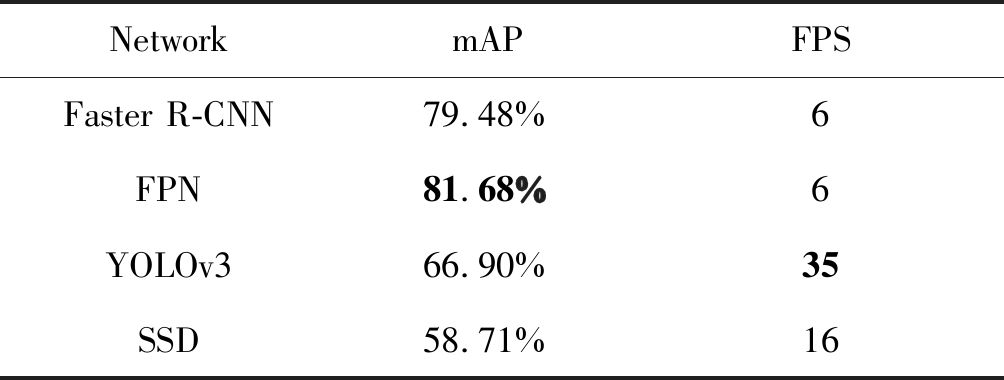

4.2 手部检测实验4.2.1 检测网络实验

检测网络实验为手部动作检测方法的关键实验,为本文选择手部检测模块的基准算法网络提供了依据,在实验过程中,本文选取YOLOv3作为检测网络的基准网络,将Faster R-CNN、SSD、FPN作为进行对比实验的网络。这里采用的数据集为共3200张的MPII数据集和人体动作数据集,其中训练集为2580张,测试集为640张。其实验结果如表2所示。

表2 检测算法手部检测精度对比

Tab.2 Comparisons of hand detection accuracy of detection algorithms

NetworkmAPFPSFaster R-CNN79.48%6FPN81.68%6YOLOv366.90%35SSD58.71%16

实验结果表明,在实验精确性上FPN网络效果最好,但FPN网络对于硬件设备要求较高,在本文所设置的硬件环境下的运行帧率仅为6,并不满足实时性的要求。在充分考虑实时性要求的前提下,YOLOv3表现出了最佳效果。综合考虑的前提下,可选择YOLOv3作为检测网络的基准算法。

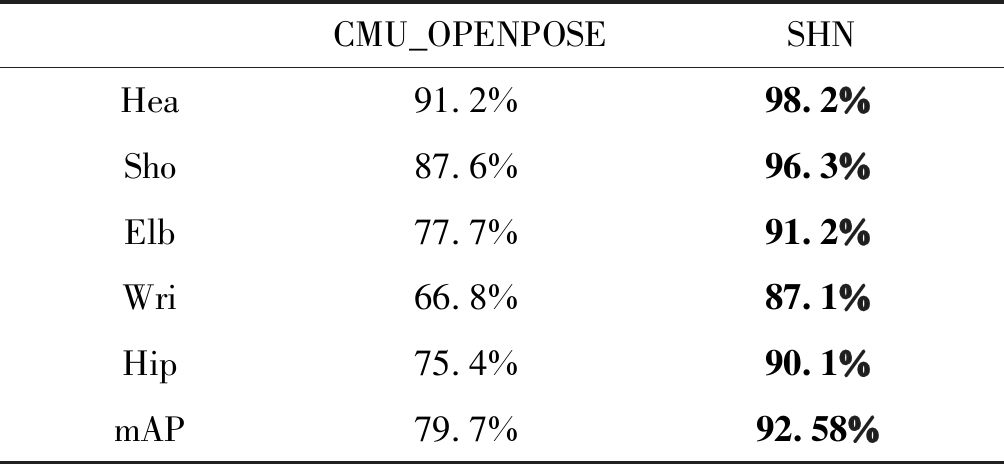

4.2.2 人体姿态估计实验

本文需要引入人体姿态估计网络中的关节的高斯热力图来提高手部检测效果,本实验选取不同姿态估计算法中对关节提取效果最佳的网络作为检测网络的前端模块。本实验选取SHN(Stacked Hourglass Networks for Human Pose Estimation)作为基础方案,并将采用自底向下策略的CMU_OPENPOSE作为对比算法,通过对头、肩、手肘、手腕、臀部五个关节的检测性能进行比较选择。采用的数据集为1600张MPII数据集和1600张人体动作数据集,实验结果如表3所示。

试验结果表明,SHN算法在关节的检测率上均高于CMU_OPENPOSE。且手腕、手肘与手部属于邻近的身体部件,手腕、手肘的定位对手部影响更大,SHN对于手腕与手肘的定位精度分别达到87.1%、91.2%,这对实现手部定位提供了帮助。且SHN的测试平均精度突破90%,能够提供具有鲁棒性的人体全局信息,可作为人体姿态检测模块中为提供高斯热力图的基准方案。

表3 关键点精度

Tab.3 Key point accuracy

CMU_OPENPOSESHNHea91.2%98.2%Sho87.6%96.3%Elb77.7%91.2%Wri66.8%87.1%Hip75.4%90.1%mAP79.7%92.58%

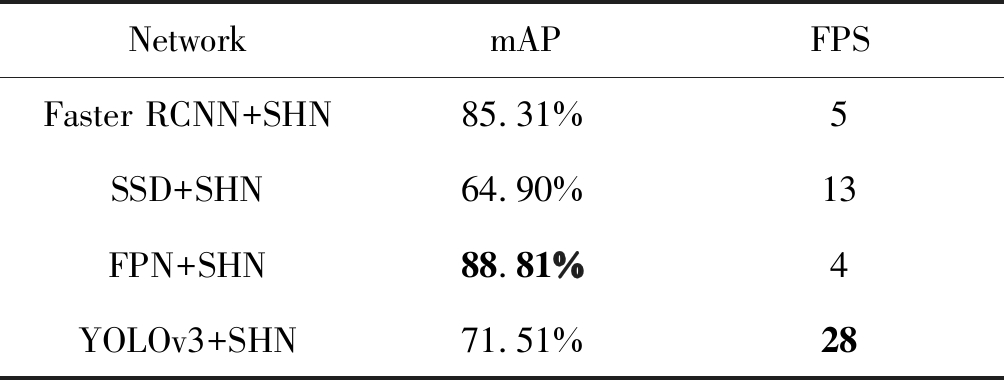

4.2.3 模块融合检测实验

本文设计的手部动作检测方法通过添加人体姿态信息来约束对目标的检测,提高检测效果。在选取基准姿态估计网络和基准目标检测网络后,本实验测试在添加高斯热力图后对于手部检测的提高。实验数据集为1600张人体动作数据集,为进行对比实验,本文使用Faster R-CNN、SSD、FPN作为实验的对比网络。实验结果如表4所示。

表4 融合检测算法手部检测精度对比

Tab.4 Comparison of hand detection accuracy of fusion detection algorithm

NetworkmAPFPSFaster RCNN+SHN85.31%5SSD+SHN64.90%13FPN+SHN88.81%4YOLOv3+SHN71.51%28

试验结果表明,在添加了姿态估计信息后,各检测算法的精度得到不同程度的提高。但由于增加的姿态估计网络,整体网络的检测速度均有所下降。在保证实时性的前提下,本文所选取的YOLOv3+SHN在基准检测网络基础上mAP有4.61%的提高。即本文所设计的姿态估计模块对目标检测效果有一定程度的提高。部分实验结果如图8所示。

图8 手部定位测试结果

Fig.8 Hand positioning test

4.3 手部动作检测实验

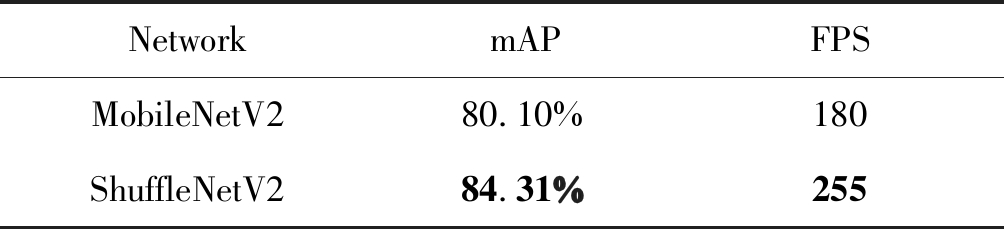

针对目标分类,本文设置的对比实验为不同轻量级分类网络对手部动作数据集分类的对比。

对比实验中,由于仅对手部动作分类进行对比实验,实验数据选择手部动作数据集,并将ShuffleNetV2作为基本网络,对比试验网络选择轻量级网络MobileNetV2,实验结果如表5所示。

表5 分类算法实验对比

Fig.5 Experimental comparison of classification algorithms

NetworkmAPFPSMobileNetV280.10%180ShuffleNetV284.31%255

根据结果,在轻量级网络中,ShuffleNetV2在速度和准确率上表现出了最佳效果,可作为本文框架中动作分类模块的基准网络。

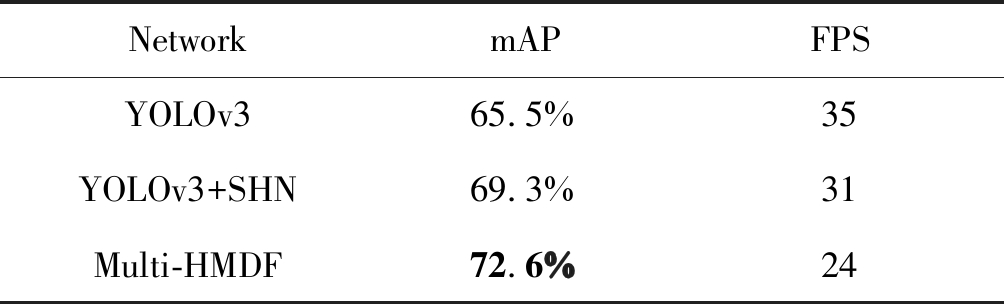

4.4 多阶段手部动作检测实验

最终实验中,根据本文所设计的动作检测方法,结合姿态估计模块和动作分类模块,以三个模块的融合算法框架(Multi-HMDF)作为基准网络,对比试验选择单独YOLOv3网络和SHN+YOLOv3网络,测试增加轻量级分类网络下对于本文框架性能的提升。实验数据为针对驾驶员动作分类的人体动作数据集。

比较三模块框架Multi-HMDF、YOLOV3+SHN算法以及单独YOLOv3算法。分类为三类打电话、抽烟、正常驾驶,在单独使用YOLOv3算法时,检测精度为65.5%,YOLOv3+SHN算法对手部动作分类达到精度69.3%,而Multi-HMDF在完成手部动作分类时的精度达到72.6%,精度相对于YOLOv3有7.2%的提升。但相应的检测速度有所下降,这表明文章采用的实验方案虽然在时间上有所下降,但能够一定程度提升手部动作的检测精度。且本文采用的Multi-HMDF算法框架速度达到24帧每秒,符合实时性的要求。

表6 融合检测算法手部动作分类精度对比

Tab.6 Comparisons of hand action detection accuracy of classify algorithms

NetworkmAPFPSYOLOv365.5%35YOLOv3+SHN69.3%31Multi-HMDF72.6%24

5 结论

针对驾驶员手部动作检测问题,本文提出了一种多阶段的手部动作检测方法。在传统目标检测的基础上加入高斯热图的策略提高目标检测的效果。并通过实验验证了该方法能够有效提升检测网络的性能,改善手部定位的效果。同时进行了手部动作检测实验,实现了目标定位阶段和目标分类阶段的改善,完成了一个由粗到细的分步式检测,一定程度提升了手部动作检测的准确率,同时基于实时性要求分析,实验方案达到24FPS。综上所述,本文所提出的一种多阶段的手部动作检测方法具有一定的应用价值,值得进一步深入研究。

[1] 朱明凌. 面向智能视频监控系统的运动目标检测与异常行为分析[D]. 中国计量学院, 2015.

Zhu Mingling. Moving target detection and abnormal behavior analysis for intelligent video monitoring system[D]. China Institute of Metrology, 2015.(in Chinese)

[2] 张宏琳. 智能视频监控中运动目标检测研究综述[J]. 科技信息, 2014(6): 227-227.

Zhang Honglin. Research review on moving target detection in intelligent video monitoring[J]. Science and Technology Information, 2014(6): 227-227.(in Chinese)

[3] 张春凤, 宋加涛, 王万良. 行为检测技术研究综述[J]. 电视技术, 2014, 38(3): 157-162.

Zhang Chunfeng, Song Jiatao, Wang Wanliang. Research review on behavior detection technology[J]. TV Technology, 2014, 38(3): 157-162.(in Chinese)

[4] 郑胤, 陈权崎, 章毓晋. 深度学习及其在目标和行为识别中的新进展[J]. 中国图像图形学报, 2014, 19(2): 175-184.

Zheng Yin, Chen Quanqi, Zhang Yujin. Deep learning and its new progress in object and behavior recognition[J]. Chinese Image and Graphics Journal, 2014, 19(2): 175-184.(in Chinese)

[5] 楼奇哲, 刘乐, 姚元. 采用卷积神经网络的海面多目标检测研究[J]. 信号处理, 2018, 34(9): 1053-1059.

Lou Qizhe, Liu Le, Yao Yuan. Research on sea surface multi-object detection using convolute on neural network[J]. Journal of Signal Processing, 2018, 34(9): 1053-1059.(in Chinese)

[6] Lin T Y, Doll r P, Girshick R, et al. Feature pyramid networks for object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 2117-2125.

r P, Girshick R, et al. Feature pyramid networks for object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 2117-2125.

[7] He K, Zhang X, Ren S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.

[8] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770-778.

[9] Kaiming H, Georgia G, Piotr D, et al. Mask R-CNN[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018: 1-1.

[10] Girshick R . Fast R-CNN[J]. Computer Science, 2015.

[11] Ren S, He K, Girshick R, et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 39(6): 1137-1149.

[12] Redmon J, Farhadi A . YOLOv3: An Incremental Improvement[J]. 2018.

[13] Liu W, Anguelov D, Erhan D, et al. SSD: Single Shot MultiBox Detector[C]∥European Conference on Computer Vision. Springer International Publishing, 2016.

[14] Wei S E, Ramakrishna V, Kanade T, et al. Convolutional pose machines[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4724- 4732.

[15] Yang Y, Ramanan D. Articulated pose estimation with flexible mixtures-of-parts[C]∥CVPR 2011. IEEE, 2011: 1385-1392.

[16] Yang Y, Ramanan D. Articulated human detection with flexible mixtures of parts[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(12): 2878-2890.

[17] Cao Z, Simon T, Wei S E, et al. Realtime multi-person 2d pose estimation using part affinity fields[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 7291-7299.

[18] Chen Y, Wang Z, Peng Y, et al. Cascaded pyramid network for multi-person pose estimation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 7103-7112.

[19] Newell A, Yang K, Deng J. Stacked hourglass networks for human pose estimation[C]∥European Conference on Computer Vision. Springer, Cham, 2016: 483- 499.

[20] Tian Y, Zitnick C L, Narasimhan S G. Exploring the spatial hierarchy of mixture models for human pose estimation[C]∥European Conference on Computer Vision. Springer, Berlin, Heidelberg, 2012: 256-269.

[21] Szegedy C, Ioffe S, Vanhoucke V, et al. Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning[J]. 2016.

[22] Ma N, Zhang X, Zheng H T, et al. Shufflenet v2: Practical guidelines for efficient cnn architecture design[C]∥Proceedings of the European Conference on Computer Vision (ECCV), 2018: 116-131.

[23] Howard A G, Zhu M, Chen B, et al. MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications[J]. 2017.