1 引言

迄今为止,高分系统已发射了高分1号宽幅、高分2号亚米全色、高分3号1米雷达、高分4号同步凝视,以及高分5号高光谱和高分6号等卫星。其中高分2号具有0.8 m的空间分辨率,在国土规划、测绘、国防安全、城市建设、林业农业、防灾减灾等各个领域[1]有广泛的应用。随着空间分辨率的提高,地物要素的更多细节被图像所记录,这给后续的计算机图像分类和特征提取处理带来更多困难[2]。

近年来,基于深度学习的语义分割方法开始成为遥感图像处理领域的一个应用热点,它通过使用大规模的数据样本来训练深度卷积网络模型,并通过该模型解决高分遥感图像中地表地貌信息的自动提取问题[3]。同时,利用深度学习可以挖掘大数据样本背景下包含的更多信息,对未知数据做出更为精准的预测。

Long在2014年提出的全卷积网络[4](Fully Convolutional Networks),调整了一般卷积网络结构,在没有全连接层的情况下能进行密集预测。全卷积网络用卷积层替换传统卷积神经网络中的全连接层,后续大部分语义分割的网络模型都采用这种结构,包括Deeplab模型。

Deeplab模型在近景图像处理领域取得了良好的结果。谷歌在行人检测中使用Deeplab模型在Pascal VOC 2012数据集中上语义分割任务上取得优秀成果。该数据集为21类目标的近景图像,其中包括11500训练样本和1400测试样本。Veeravasarapu等人在2017年[5]使用完整的Cityscapes数据集训练交通场景分类和检测任务取得的相当好的效果。Cityscapes 数据集是由普朗克研究所制作语义分割数据集[6],该数据集是城市街道场景图像,采集于不同时节的五十不同的城市。Cityscapes数据集包含 2万张粗标记样本和5千张细标记样本用于训练,1500张样本用于测试。

高分遥感图像通常有十分丰富的多元信息,如何充分利用高分图像的上下文信息,辅助图像分割,提升语义分割准确度仍是遥感图像语义分割中的难点[7],直接使用原始Deeplabv3模型对遥感图像进行多尺度目标的分割结果不够理想。针对以上问题,考虑到卷积神经网络的浅层特征包含丰富的空间信息,深层特征包含丰富的上下文信息[8]。如果能综合利用这些多层次特征,将能有效提高遥感图像的分割精度。

本文针对高分2号(GF-2)遥感影像地物要素分类应用,利用Deeplabv3网络开展语义分割方法研究;结合图像特性,从图像标注、数据扩充方式、训练网络层数、图像尺寸,样本不足情况以及网络参数设置等方面进行探究分析,对经典的DeepLabv3模型结构进行改进,并利用经预处理的高分2号影像,开展语义分割算法性能评估。文章第2节介绍基于Deeplabv3模型的语义分割方法原理,第3节介绍针对高分2号影像的模型算法改进,最后是实验结果分析。

2 卷积网络语义分割模型

基于卷积网络的语义分割的一个主要目标和研究难点是解决池化层所导致像素点丢失问题。虽然池化层能进一步提取抽象特征来增加卷积核的感受野(receptive field),但是在该过程中失去了像素的空间位置信息[9]。语义分割需要分类输出图像和输入图像有相同的分辨率和大小,因此要重新引入像素的空间位置信息[10],目前主要空洞卷积结构可以解决像素丢失问题。

2.1 空洞卷积结构

空洞卷积结构通过空洞卷积层代替了池化层,改变输入数据的采样方式,因此可以在预训练好的基础网络中顺利地使用,不需要改变网络模型的结构,也不会增加训练参数。在给定卷积核的情况下,它会增加后续卷积的感受野[11]。此卷积能够极大的扩大感受野的同时不会减小空间维度。

以3*3 的卷积核为例说明感受野的增加情况。3*3的空洞率为1卷积,和普通的卷积一样。3*3的空洞率卷积为2卷积,卷积核大小未变,只有9个实心点和卷积核发生卷积操作,其余点都为0。虽然卷积核大小只有3*3,但是卷积核的感受野已经增大到了7*7, 同理空洞率为3卷积能达到15*15的感受野。如图1所示。

图1 卷积示意图. (a) 空洞率为1, (b) 空洞率为2, (c) 空洞率为3

Fig.1 Dilation convolution diagram. (a) Dilation rate 1, (b) Dilation rate 2, (c) Dilation rate 3

空洞卷积层在不降低空间维度的前提下增大了相应的感受野[12]。代表网络有DeepLabv系列,PSPNet,RefineNet。

2.2 DeepLabv3网络基本结构

DeepLabv3 以第二代残差网络作为基础网络。残差网络含有 4个残差块。每个残差块包含不同数量的残差单元,一个标准残差单元包括2个1*1的卷积核和1个3*3的卷积核。残差公式如下(1):

F(x)=H(x)-x

(1)

其中, x和H(x)分别表示一个残差块的输入和输出。其输出与输入的差别H(x)-x,即残差F(x)[13]。

DeepLabv3为了处理多尺度的特征学习,采用空洞卷积级联和不同的空洞率(步长)并行架构的方式有效地提取多尺度信息[14]。其中最后一个残差块内使用空洞空间金字塔池化(Atrous Spatial Pyramid Pooling, ASPP)15]改进来优化网络的训练效果性能。

2.3 空洞卷积提取细节特征

由于网络中连续的池化和跨步卷积大大减小了输出特征图的空间分辨率,因此用反卷积层被使用来恢复空间分辨率。DeepLabv3使用空洞卷积代替反卷积的操作[16]。 输入信号x的空洞卷积为:

y(i)=∑x(i+k·r)*w(k)

(2)

其中,w为卷积核权重, r为空洞率,k为卷积核大小。

空洞卷积控制特征的紧凑程度。如果想要在卷积神经网络的特征图上使空间分辨率加倍[17],将降低分辨率的池化层步长设置为1来避免信号的丢失。接着,所有随后的卷积层被步长r=2的空洞卷积层代替。这就可以在不需要学习任何额外的参数的情况下得到更精细分类结果[18]。

2.4 空洞空间金字塔池化

空间金字塔池化方法实现对图像大小和不同长宽比的处理[19]。ASPP通过不同大小的空洞卷积核来对图像进行不同程度的缩放,得到相应输出的特征图,并对每个空洞率提取的特征进一步在单独的分支中进行处理[20]。ASPP部分包含两部分:一是将1*1的卷积核和3个3*3的卷积核空洞率分别为6,12,18。二是将特征图做全局平均池化来取得图像上下文信息,然后将所有分支处理好的特征连接在一起通过卷积,再融合后进行双线性上采样恢复到想要的分辨率并产生最终的分类结果[21]。

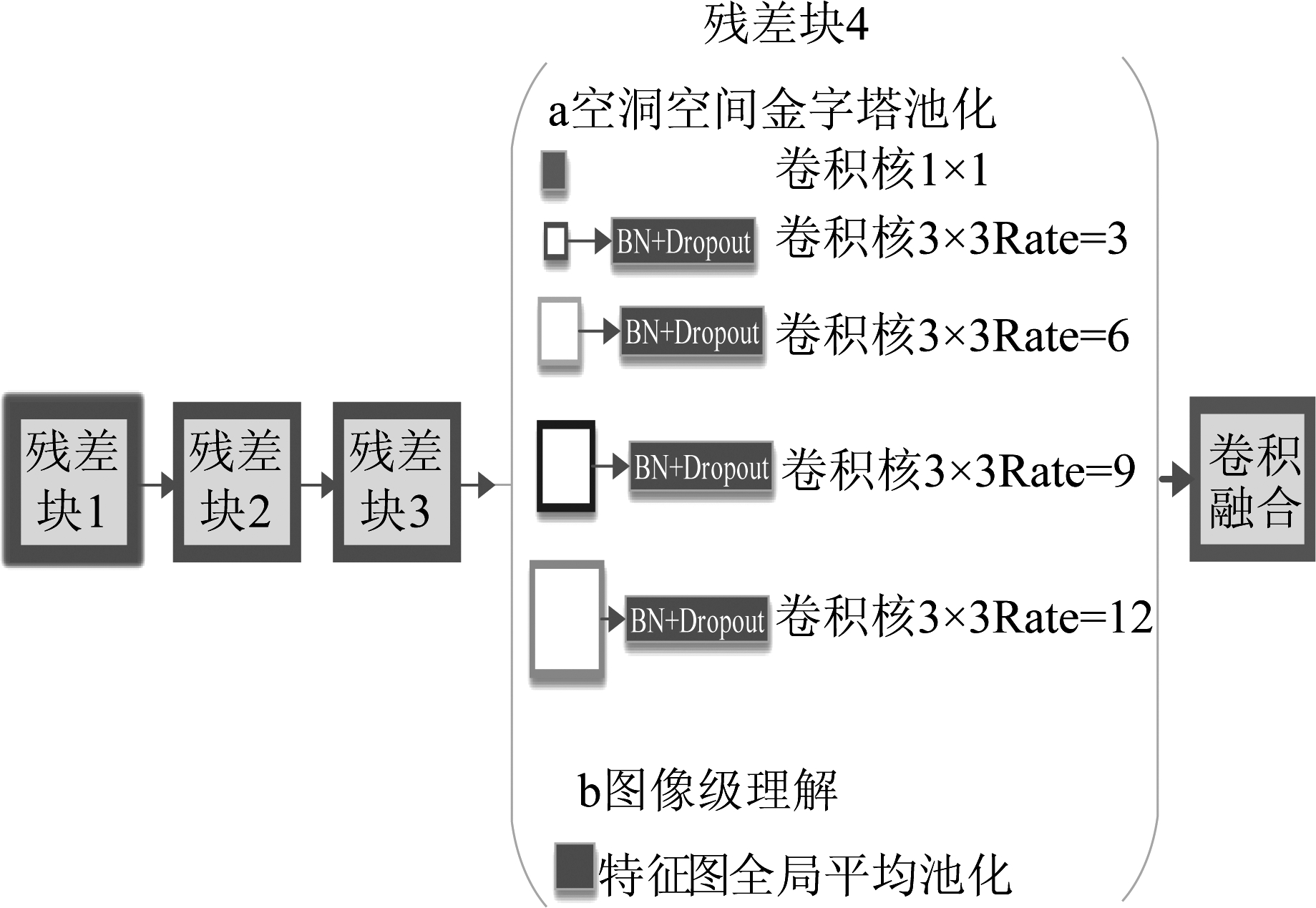

3 对DeepLabv3的改进模型

DeepLabv3原本是对近景图像处理,其分类目标是在自然场景中识别来自21个视觉对象类,直接使用原始的DeepLabv3模型处理高分遥感图像会不适用。GF-2遥感图像的地貌空间信息丰富,色彩、纹理和几何特征多样,作为背景的信息杂乱,存在同一分类目标特征离散,不同分类目标相似。而且分类目标类别的偏斜分布造成局部不均衡,不同的两个目标边界容易混叠。尤其是部分类别尺度较小造成细节信息分辨困难。因此根据GF-2遥感图像的特点对DeepLabv3模型做出改进。

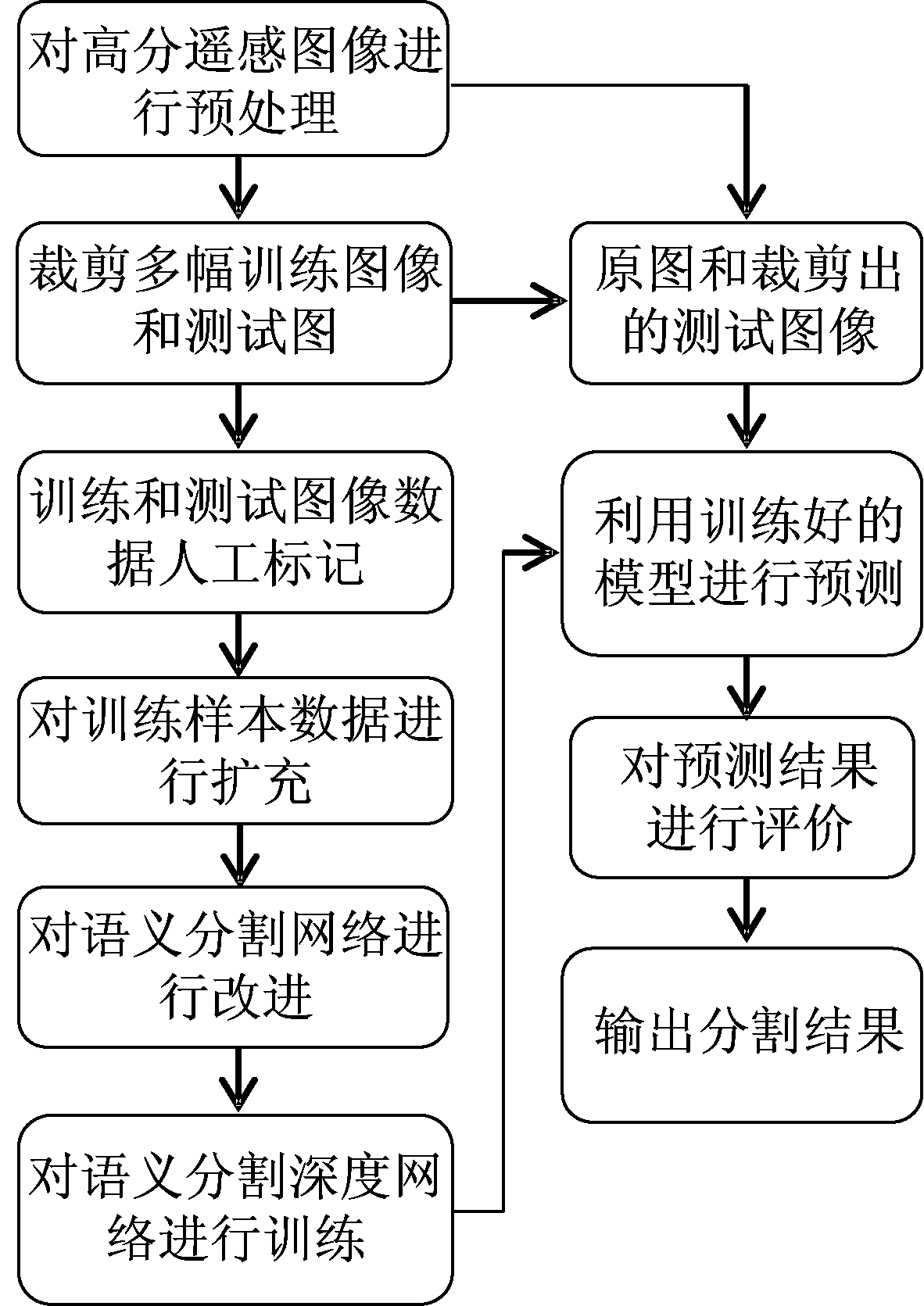

1)图像预处理和预测:改进模型处理GF-2遥感图像时需要把大图切分成小图,并且使用更多的图像处理来扩充训练样本从而提高模型训练精度。此外在预测图像时,原始DeepLabv3模型是对一张图像直接测试,而测试GF-2遥感不能直接预测因为测试遥感图像比较大,所以在预测程序中先把切成固定尺寸的小图,再用无重合的滑动窗口采样对每个图像块预测,将预测后的图像块再拼接起来得到最终的预测图像。

2)去除级联模块:原始DeepLabv3复制三次残差网络中的最后一个残差块4,并以级联的方式,使得残差块数量增到7。因为对该结构对GF-2遥感图像分类效果一般,改进模型移除级联方式。

3)空洞空间金字塔池化层结构修改:原始DeepLabv3空洞率较大,卷积核中有效的卷积权重小,会丢失部分细节信息。因此根据高分遥感图像多尺度特征调整空洞率大小,并且增加并行的空洞卷积数量,将空洞卷积的空洞率调整为3,6,9,12, 每一个空洞卷积核后连接包含Dropout结构的批量归一化(BN)层来防止过拟合,再加上一个1*1的普通卷积核。能更好地获得大范围的上下文信息从而得到更好的分类结果。

图2 改进的DeepLabv3空洞空间金字塔池化层结构

Fig.2 Improved DeepLabv3 atrous spatial pyramid pooling layer structure

4 实验与分析

实验使用Tensorflow搭建深度神经网络。实验系统为Ubuntu,使用在预训练好的残差网络为基础网络框架,GPU为NVIDIA GTX1080Ti。

图3 算法流程图

Fig.3 Algorithm of flow chart

4.1 数据集介绍

实验数据集来源于2016年郴州地区GF-2遥感影像,其地貌复杂保存有完整的原始次生林群落及南岭山脉低海拔沟谷阔叶林,森林植物资源极为丰富多样。其空间分辨率为0.8 m,该数据集原始图像具体经纬度为东经112° 623′~112° 188′,北纬26° 535′~25° 882′,波带数为3。再利用ENVI对获得的原始高分二号卫星图像进行预处理,然后使用Matlab作为数据集制作工具标注。根据其地貌特性,我们标注种类分为七类,分别是农田、森林、河流、道路、建筑和垄沟和其他类,如图4所示。

图4 matlab人工标注图像

Fig.4 Manually annotating images by matlab

4.2 图像预处理

该高分遥感卫星图像数据集包括12张训练图像和1张测试图像,尺寸为2000*2000左右。高分遥感卫星图像的图像尺寸太大,所以要对训练图像进行切分处理。另一个方面,为了避免神经网络在部分数据集中产生过拟合现象,需要对已有训练集进行数据增强和扩充。因此对于一幅高分遥感图像,将其切割成小的图像块,用作训练数据集。

1)首先根据需求把训练图像设置为特定大小输出图像。

2)然后对图像进行随机窗口采样,随机生成采样坐标,然后获取该坐标下特定大小的小图。

3)再对切分好的图像进行数据增强,随机的进行旋转和水平、垂直翻转、伽马变换、模糊、腐蚀、添加噪声,以及双线性滤波等图像变换操作,产生60000张小图。

4.3 语义分割性能评价方法

图像语义分割中通常使用以下标准来衡量算法的精度[22]。

1)Pixel Accuracy(PA,像素精度)。测试图像中正确的像素点占真值图像的总像素点的比例。

2)Mean Pixel Accuracy(MPA,均像素精度)。计算每个类内被正确分类像素数的比例,之后再求所有类的平均。

3)Mean Intersection over Union(MIoU,均交并比)。计算真值图像和预测结果图像两个集合的交集和并集之比,在每个类上计算IoU,之后平均。

4.4 网络训练与预测结果对比分析

首先对改进模型与原始DeepLabv3对比证明其改进的效果,再验证该模型有效性和泛化能力。从不同网络深度和图像输入尺寸大小对比,小样本情况下不同样本数对网络影响,和不同时相数据的是否有效识别目标这三个方面进行分析。

4.4.1 DeepLabv3网络训练与预测结果

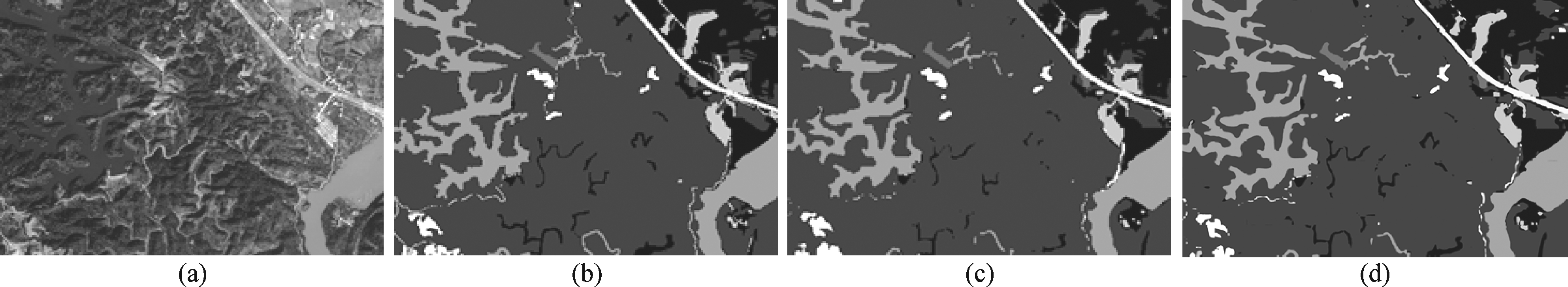

根据GF-2遥感图像的特点对改进的网络参数进行微调。基础网络选择残差网络101层(残差101):其中网络训练参数如下:其中batch norm decay=0.95, batch size=4,学习率=0.00001,权值衰减为0.0001一共进行10万次迭代,其中到4万次和8万次时学习率减少为原来的十分之一,数据集中训练和测试比例为4∶1。 然后把测试图像放入训练好的网络模型进行预测。部分实验结果如图5所示。

通过预测图像和真值图像对比可以看出,整体上能把需要分类的信息能准确分类出来,图像边界和细节上比较平滑,没有模糊和混叠。对各个像素进行分类,具有空间一致性,大面积河流,建筑物和森林都能有效识别出来。

ASPP对部分细长的目标信息不够敏感,因此该结构无法高效的提取这类目标的上下文信息。例如道路和小溪不会完全被该网络模型识别出来。空洞卷积相当稀疏滤波器,细长物体在空洞卷积中用权重位置为零来填充空白空间,因此这部分卷积结果为零,该像素点被识别为背景,导致错误的分类判决。

图5 (a) 原始图像, (b) 手工标准的真值图像, (c) 改进模型预测图像, (d) 标准模型预测图像

Fig.5 (a) Original image, (b) Ground truth image, (c) Improved model prediction image, (d) Standard model prediction image

4.4.2 改进模型与DeepLabv3对比

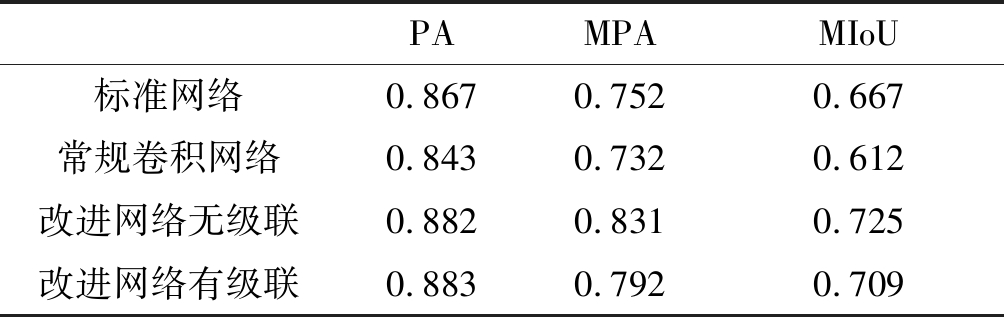

与原始的DeepLabv3相比,改进模型有五个并行的卷积结构,包括空洞率为3,6,9,12的空洞卷积核(包含加上Dropout结构的BN层)和一个1*1的常规卷积核,并且去除了级联结构。把原始DeepLabv3和改进的模型进行对比,结果如表1所示。

表1 DeepLabv3和改进模型的性能评价

Tab.1 Performance evaluation of original DeepLabv3 and improved models

PAMPAMIoU标准网络0.8670.7520.667常规卷积网络0.8430.7320.612改进网络无级联0.8820.8310.725改进网络有级联0.8830.7920.709

从表1可以看出,改进的网络和原始网络相比,各项指标性能都有提高。原始的网络采用的空洞率较大,卷积核中有效的卷积权重较小,因此不能有效提取整个图像的上下文信息。而改进的模型有更多并行的空洞卷积,从而有利于提取图像中更深层的细节信息。空洞卷积的使用是为了增加感受野,但针对遥感图像这类特征比较小的图像,空洞卷积的是否会直接跳过细节特征。使用常规卷积(空洞率全为1)的网络性能进行测试,结果发现各项指数都出现下降,可知空洞卷积对特征提取的必要性。

此外对级联方式对改进的网络是否有影响进行探究。其中MPA有四个百分点下降,MIoU有一个百分点的下降。在研究中我们发现这种连续的级联方式设计,会破坏图像的细节信息,而且要求更高计算性能和内存。去除级联模块对分类结果影响有限,以此本模型不使用级联模块。

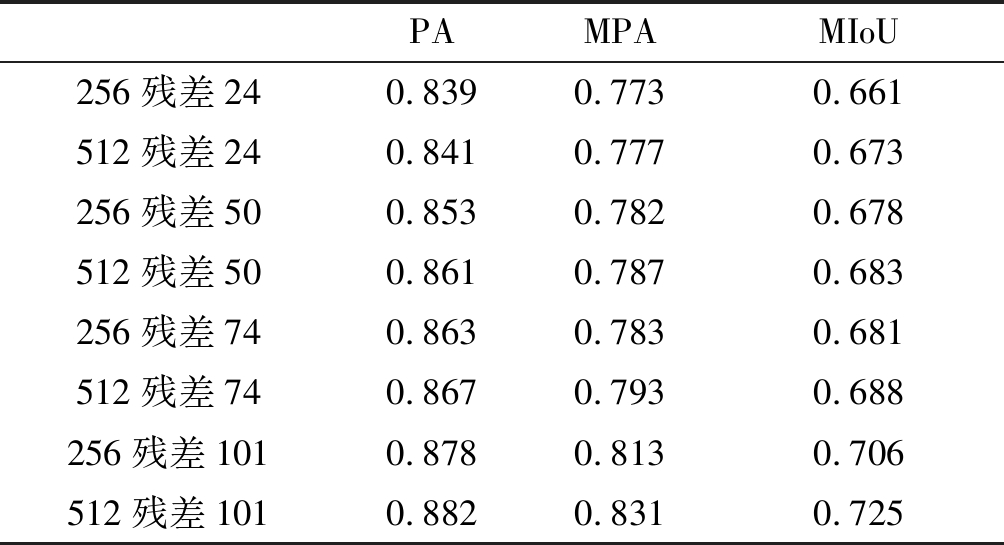

4.4.3 网络深度和输入尺寸对实验效果的影响

对数据集分别使用残差24层,残差50层, 残差74层和残差101层作为基础网络框架来训练改进的DeepLabv3,训练时输入图像大小分别为512*512和256*256。测试图像未进入神经网络中进行训练,以验证该网络模型的通用性,实验结果如表2所示。

表2 不同深度残差网络和输入大小的性能评价

Tab.2 Performance evaluation of different depth residual networks and input sizes

PAMPAMIoU256残差240.8390.7730.661512残差240.8410.7770.673256残差500.8530.7820.678512残差500.8610.7870.683256残差740.8630.7830.681512残差740.8670.7930.688256残差1010.8780.8130.706512残差1010.8820.8310.725

通过表2中的数据可以发现,基础网络为残差101,训练输入图像大小为512*512的这一组数据的各项指标最为良好。

考虑到网络模型计算的复杂度,深度也影响到全局网络模型训练的运行时间。残差101运行时间一般要比残差24多3个小时,而且网络参数中batch size大小残差24最大可设置为16,并且对电脑显卡的内存要求会降低。另一方面,在相同的基础网络框架下输入图像大小对图像质量评价影响较小。在相同基础网络上图像尺寸相对较大时,性能有一定的提升。这是因为256*256图像相对于512*512的图像来说,包含分类目标的种类一般来说会少一些。此外训练图像尺寸越大,被分割数就越少,能够降低边缘信息识别不准和拥有足够的分类目标。另一方面由于浅层的残差网络容易收敛,可能会陷入局部最优解从而不能到达最好效果。而深层的残差网络能提取特征的抽象程度越高,能够捕获更多图像细节,因此能够帮助深层的残差网络进行优化分类效果。

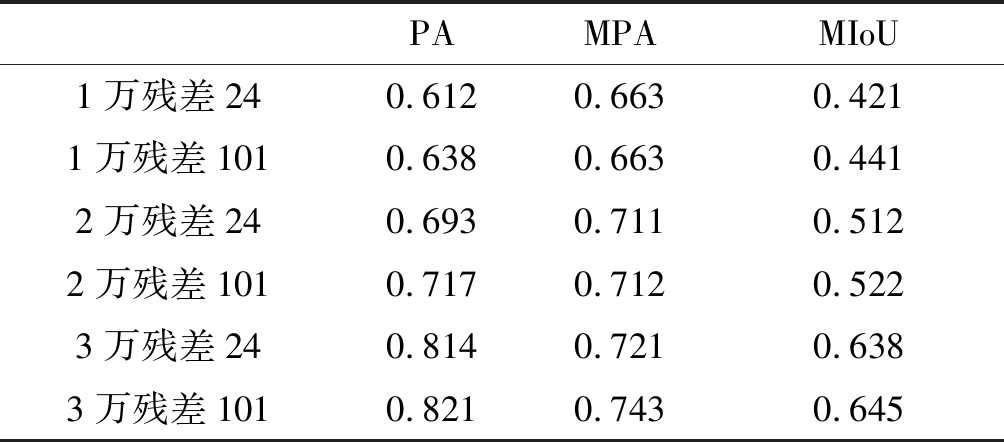

4.4.4 小样本对实验结果的影响

为了探究在训练样本不足时对该网络模型的预测结果的影响,实验对少样本情况下,网络深度对分类判决的影响进行测试。

训练样本分别为3万,2万,和1万的尺寸512*512图像,分别使用残差24和残差101进行训练,再对测试图像进行预测,结果如表3所示。

表3 小样本情况下残差24与101的性能评价

Tab.3 Performance Evaluation of Res24 and Res101

PAMPAMIoU1万残差240.6120.6630.4211万残差1010.6380.6630.4412万残差240.6930.7110.5122万残差1010.7170.7120.5223万残差240.8140.7210.6383万残差1010.8210.7430.645

在减少样本数量的情况下性能指标各方面出现下降,这是由于训练样本不足导致识别类内不同和异类相似的分类目标出现偏差。训练数目为1万张时分类效果明显下降,许多类别未能分类出来。训练数目为2万张时分类效果较1万张时有较高提升,但是和全部数据的数值有差距。训练数目为3万张能够较为接近全部数据集上训练的数值,能初步到达分类效果。

从表3可以看出,残差24和残差101的数值差距不是很大,在小样本任务中,浅层网络同样可以取得较好的分类效果,如果仅仅从运行速率上来看选择残差24层会更加适合。

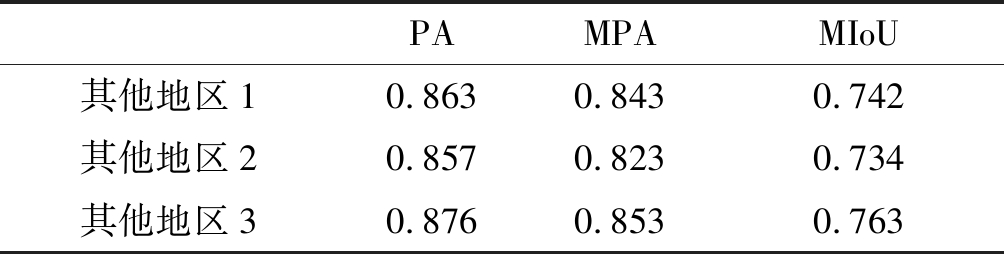

4.4.5 不同时相数据的实验结果分析

为了验证本文方法的泛化能力,实验选用不同时相的郴州数据来验证在不同数据样本中网络模型能否学习到图像类别信息。我们以郴州其他地区不同时相的图像为异构数据,采用基础网络为残差101,训练输入图像大小为512*512。

通过上述数据可知其他地区不同时相的部分评价指标MPA,MIoU比测试图像还略高,PA只是略微低于测试图像。由此可以看出该网络模型对郴州地区的高分遥感图像分类有通用性,具有较强的泛化能力。

表4 郴州其他地区不同时相的性能指标

Tab.4 Performance indicators for different phases in other parts of Chenzhou

PAMPAMIoU其他地区10.8630.8430.742其他地区20.8570.8230.734其他地区30.8760.8530.763

5 结论

本文提出一种改进的DeepLabv3网络,对郴州地区的GF-2图像进行图像语义分割。首先对原始遥感图像进行随机裁剪,再进行数据扩充预处理,然后把数据用改进模型训练,最后对测试图像进行分块预测。通过对原始模型和改进模型不同参数结果的对比研究,再分析了小样本情况下的分类效果,并通过图像语义分割性能评价来数值定量分析效果的优劣。本文改进的网络分类准确率比标准DeepLabv3网络更优,其中MIoU指标达到了72.5%,像素准确度为88.2%,实现了对GF-2图像中分类任务复杂目标的精确分割。

美中不足的是该网络模型对部分细长的目标信息不够敏感,比如道路和小溪等目标还不能完全识别,这是由于使用空洞卷积造成的。因此,下一步工作重点是提高对细长物体的识别效果。

[1] 何小飞, 邹峥嵘, 陶超. 联合显著性和多层卷积神经网络的高分影像场景分类[J]. 测绘学报, 2016, 45(9): 1073-1080.

He Xiaofei, Zou Zhengrong, Tao Chao. Combined saliency with multi-convolutional neural network for high resolution remote sensing scene classification[J]. Acta Geodaetica et Cartographica Sinica, 2016, 45(9): 1073-1080.(in Chinese)

[2] 周飞燕, 金林鹏, 董军. 卷积神经网络研究综述[J]. 计算机学报, 2017, 40(6): 1229-1251.

Zhou Feiyan, Jin Linpeng, Dong Jun. Review of convolutional neural network[J]. Chinese Journal of Computers, 2017, 40(6): 1229-1251.(in Chinese)

[3] Yang Z, Mu X, Fa Z. Scene Classification of Remote Sensing Image Based on Deep Network Grading Transferring[J]. Optik, 2018: 127-133.

[4] Long J, Shelhamer E, Darrell T. Fully Convolutional Networks for Semantic Segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2014, 39(4): 640- 651.

[5] Veeravasarapu V, Rothkopf C, Visvanathan R. Model-Driven Simulations for Computer Vision[C]∥IEEE Winter Conference on Applications of Computer Vision. IEEE, 2017: 1063-1071.

[6] Cordts M, Omran M, Ramos S, et al. The cityscapes dataset for semantic urban scene understanding[C]∥Computer Vision and Pattern Recognition. IEEE, 2016: 3213-3223.

[7] 唐玮, 赵保军, 龙腾. 基于轻量化网络的光学遥感图像飞机目标检测[J]. 信号处理, 2019, 35(5): 768-774.

Tang Wei, Zhao Baojun, Long Teng. Aircraft detection in Remote Sensing image based on Lightweight Network[J]. Journal of Signal Processing, 2019, 35(5): 768-774.(in Chinese)

[8] 安捷, 马尽文. 基于全卷积网络的遥感图像自动云检测[J]. 信号处理, 2019, 35(4): 556-562.

An Jie, Ma Jinwen. Automatic Cloud Segmentation Based on the Fully Convolutional Neural Network[J]. Journal of Signal Processing, 2019, 35(4): 556-562.(in Chinese)

[9] Yao Chuchu, Luo Xianxian, Zhao Yudan, et al. A Review on Image Classification of Remote Sensing Using Deep Learning[C]∥2017 3rd IEEE International Conference on Computer and Communications, 2017: 1947-1955.

[10] Pan B, Shi Z, Xu X. MugNet: Deep Learning for Hyperspectral Image Classification using Limited Samples[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2017: 108-119.

[11] Hamida A, Beno t A, Lambert P. Deep Learning for Semantic Segmentation of Remote Sensing Images with Rich Spectral Content[C]∥IEEE International Geoscience and Remote Sensing Symposium, 2017: 2569-2572.

t A, Lambert P. Deep Learning for Semantic Segmentation of Remote Sensing Images with Rich Spectral Content[C]∥IEEE International Geoscience and Remote Sensing Symposium, 2017: 2569-2572.

[12] Kemker R, Salvaggio C, Kanan C. Algorithms for Semantic Segmentation of Multispectral Remote Rensing Imagery Using Deep Learning[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2018: 60-77.

[13] He K, Zhang X, Ren S, et al. Identity Mappings in Deep Residual Networks[C]∥European Conference on Computer Vision(ECCV), 2016: 630- 645.

[14] Wei Xin, Guo Yajing, Gao Xin, et al. New Semantic Segmentation Model for Remote Sensing Images[C]∥2017 IEEE International Geoscience and Remote Sensing Symposium, 2017: 1776-1779.

[15] Vijay B, Alex K, Roberto C. SegNet: A Deep Convolutional Encoder-Decoder Architecture for Image Segmentation[J]. IEEE Tansactions on Pattern Analysis And Machine Intelligence, 2017,39(1): 2481-2495.

[16] Fisher Y, Koltun V. Multi-Scale Context Aggregation by Dilated Convolution[C]∥International Conference on Learning Representations (ICLR) 2016.

[17] Guosheng L, Anton M. RefineNet: Multi-Path Refinement Networks for High-Resolution Semantic Segmentation[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition, 2017: 5168-5177.

[18] Liang-Chieh C, Papandreou G, Kokkinos I, et al. Semantic Image Segmentation with Deep Convolutional Nets and Fully Connected CRFs[C]∥International Conference on Learning Representations (ICLR), 2015(4): 357-361.

[19] Zhao H, Shi J, Qi X, et al. Pyramid Scene Parsing Network[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 6230- 6239.

[20] Liang-Chieh C, Papandreou G. DeepLab: Semantic Image Segmentation with Deep Convolutional Nets, Atrous Convolution, and Fully Connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017: 834-848.

[21] Liang-Chieh C, Papandreou G, Schroff F, et al. Rethinking Atrous Convolution for Semantic Image Segmentation[J]. arXiv: 1706.05587, 2017.

[22] Garcia G, Alberto O, Sergio O, et al. A Review on Deep Learning Techniques Applied to Semantic Segmentation[J]. arXiv: 1704.06857, 2017.