1 引言

声源的方位信息对诸多智能系统具有重要价值。例如,智能摄像机可根据声源方位自动转向、基于麦克风阵列的语音增强系统可设计指向语音方位的空间滤波器、无人驾驶汽车可根据说话人方位确定语音指令的发送者,并根据外部声源方位辨识所处交通环境。通常利用麦克风阵列可以估计目标声源方位[1-3],其中麦克风阵列利用多个通道收集信号,可根据信号到达不同通道的时间差估计出声源位置,相较于单通道声源定位方法效果普遍更加精确。但由文献[4-5]可知,在一些特定的场合,单通道的声源定位方法定位效果虽然会稍逊于多通道声源定位方法,但其定位效果并不影响实际应用且更加经济适用。因此,本文仅采取单通道视频进行声源定位。本文工作受到了心理学和认知科学[6- 8]关于人类声源定位能力发现的推动,这一系列工作中的许多方法分析了视觉信息和声音定位之间的关系。文献[6]研究人类如何在日常聆听里从声音中学习不同的事件,这项研究阐明了人类如何在事件中找到视觉和声音领域之间的关系。文献[7- 8]表明,与声音相关的视觉信息提高了声源的搜索效率和定位精度。这些研究都表明,人类的声源定位能力是由视觉信息引导的,两种信息来源密切相关,人类可以无意识地学习这种能力。因此本文首先利用所设计的神经网络学习音视频之间的联系,即前文所述音视频同步的联合表达,再进一步利用学到的音视频联合信息进行声源定位。

近年来,在学习音视频同步的联合表达方面取得了重大进展[9-16]。其中文献[10-11]通过学习视觉图像来产生相应的语音信号,而文献[9]则通过学习声音来区分相应的图像场景。这些方法利用了两种模态的相关性和共现性,在使用一种模态作为基准时学习另一种模态的表示,但它们并没有将音视频信息融合。文献[12-16]将音视频信息融合从而学习音视频同步的联合表达。文献[15]考虑到视觉信息中的运动信息,在视频流特征提取过程中采用3维(Dimension,D)卷积代替传统的2D卷积。但是上述方法在进行音视频信息融合时,视频流特征在时间维度和空间维度上采用的是等价策略,不符合人类学习音视频信息的模式。例如对于一段语音视频(中间有停顿时间),在时间维度上人类更加关注有声音发出的那一段,在空间上人们更加关注人嘴部区域。因此本文引入注意力机制对视频流特征在时间维度以及空间维度进行加权,以获得更好的音视频同步的联合表达。与文献[17-18]不同,本文采用音频特征与视频特征之间的皮尔森相关系数(Pearson Correlation Coefficient,PCC)作为视觉信息的权重值,而不是采用在视频流特征上附加多层感知机的方法。这样不仅减小了需要学习参数的数量,而且突出了音频特征与视频流特征的关联性。实验结果表明,引入注意力机制的音视频特征融合可以获得更好的音视频同步的联合表达。

在视频中可视化地定位声源具有悠久的研究历史。在深度学习之前,音视频声源定位的计算方法依赖于声音和视频低级特征的同步[19],音视频的空间稀疏性[20],低维度性[21],以及人工标注的运动线索等[22-23]。本文与文献[15]类似,仅通过观看视频和收听音频,不利用任何人工设计的条件(例如运动线索等)便可有效地定位声源。本文模型通过自监督将动作与声音联系起来,并采用文献[24]中类激活图(Class Activation Map,CAM)的方法对视频中的声源进行定位,而无需明确地对声源位置进行有监督的学习。这样避免了有监督学习中标注样本数据的困难。下文将详细介绍本文所提出基于音视频同步检测的声源定位模型。

2 基于音视频同步的声源定位模型

本文通过训练所设计的网络预测视频的音频和视频流是否在时间上同步来学习音视频同步的联合表达。解决这个问题需要跨模态整合音频与视频流的低维信息。例如,为了检测人语音视频中的音频与视频流是否对齐,模型必须将嘴唇的运动与音频中的话语在时间维度上相关联。在学习音视频同步的联合表达之后,本文进一步利用CAM算法进行了相应的声源定位。下文将详细介绍所设计神经网络。

2.1 引入注意力机制的音视频同步检测模型

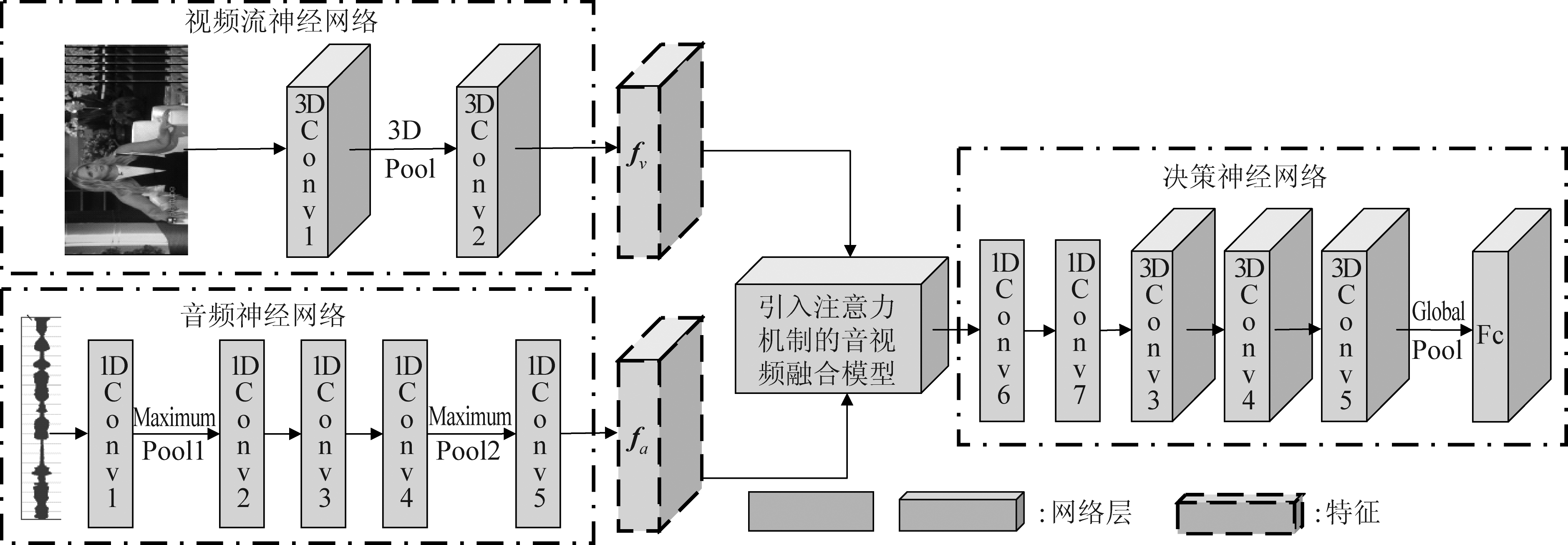

图1展示了本文设计的引入注意力机制的音视频同步检测模型。与文献[15]相同,在音视频特征融合之前,本文为音频与视频流分别设计相应的卷积神经网络(Convolutional Neural Network,CNN),以提取相应的特征。其中与传统分类网络[25-27]利用2D卷积层提取图像特征不同,本文中的视频流神经网络采用了3D卷积层[28]提取视频流当中的轮廓特征与运动特征。其次,在音频神经网络中采用1D卷积层提取音频流高维特征。随后,在音视频特征融合阶段,与文献[15]直接进行通道叠加不同,本文引入注意力机制,对视频流信息进行相应的加权,增加音频信息与视频流信息的关联性。随后如图1中决策网络部分,将获取的音视频联合特征进一步进行特征提取以判断视频流与音频是否同步。

2.1.1 音频神经网络

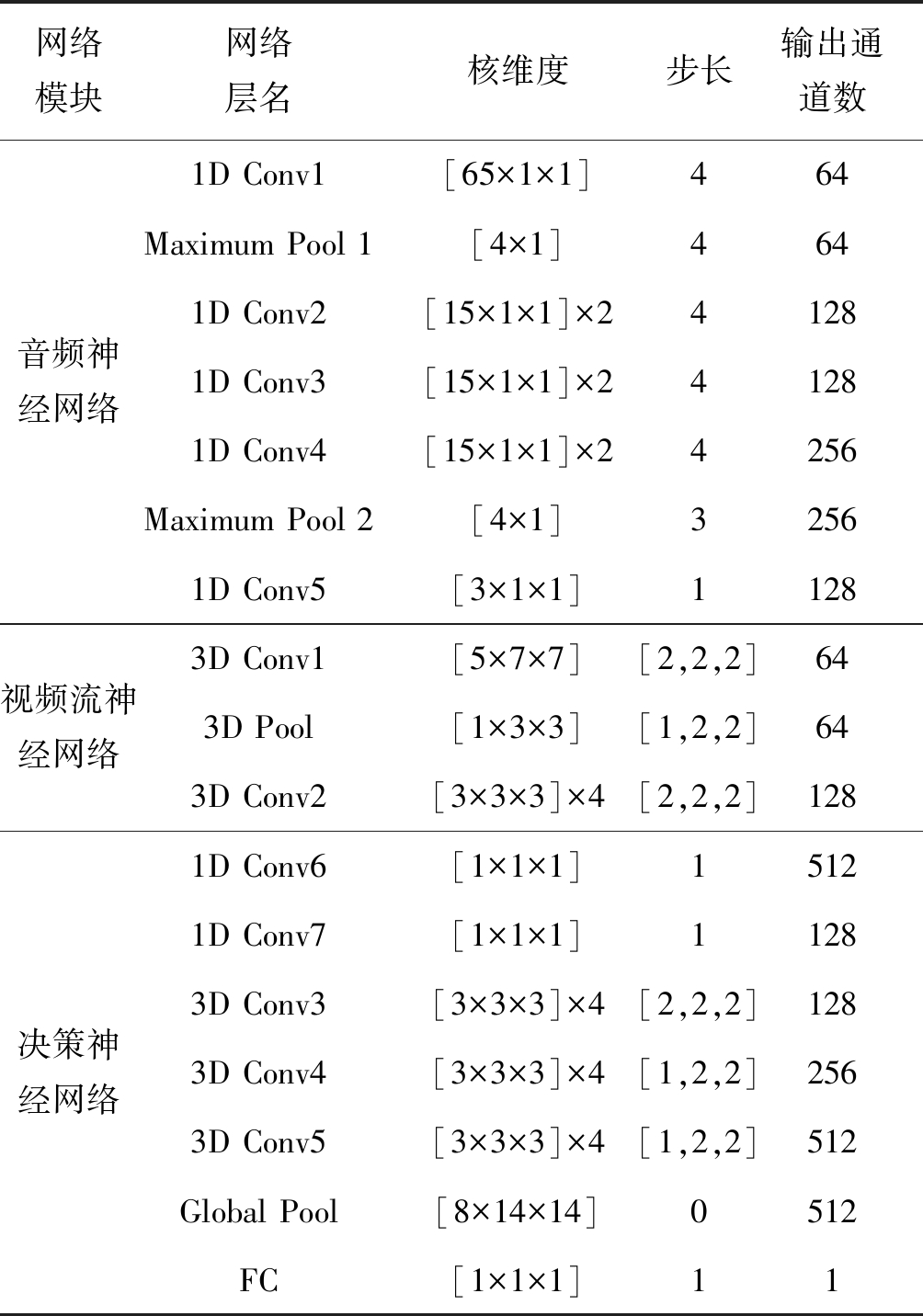

文献[6]中指出提取音频中的高维特征是学习音视频同步联合表达的重点。另外,音频信号是具有不同时间长度的1D信号。因此,如图1中音频神经网络部分,本文采用卷积(Convolution,Conv)层、线性整流单元(Rectifier Linear Unit,ReLU)和池化(Pool)层等的组合对声音信号进行高维特征的提取。本文采用4.2秒原始音频作为输入且其中一半与视频流同步,而另一半被人为地将音轨移动2.0到5.0秒(类似于文献[29])。当移动音频轨道时,应确保它与视频帧边界对齐(类似于文献[30])。本文的1D卷积层与文献[15]类似,每一个卷积层后面都紧接一个ReLU 激活函数以增加网络提取特征的非线性能力。同时采用最大池化(Maximum Pool)层,降低特征维度。所采用的卷积层以及池化层的主要参数如表1所示。在经过音频神经网络之后,所输入的音频信号可以提取维度为T×Ca的高维特征,记为fa。随后本文将获取的音频高维特征fa与视频流高维特征相交互,以获取音视频高维特征之间的相互联系。

表1 引入注意力机制的音视频同步检测模型参数

Tab.1 Parameters of the audio-visual synchronization detection model with attention mechanism

网络模块网络层名核维度步长输出通道数音频神经网络1D Conv1[65×1×1]464Maximum Pool 1[4×1]4641D Conv2[15×1×1]×241281D Conv3[15×1×1]×241281D Conv4[15×1×1]×24256Maximum Pool 2[4×1]32561D Conv5[3×1×1]1128视频流神经网络3D Conv1[5×7×7][2,2,2]643D Pool[1×3×3][1,2,2]643D Conv2[3×3×3]×4[2,2,2]128决策神经网络1D Conv6[1×1×1]15121D Conv7[1×1×1]11283D Conv3[3×3×3]×4[2,2,2]1283D Conv4[3×3×3]×4[1,2,2]2563D Conv5[3×3×3]×4[1,2,2]512Global Pool[8×14×14]0512FC[1×1×1]11

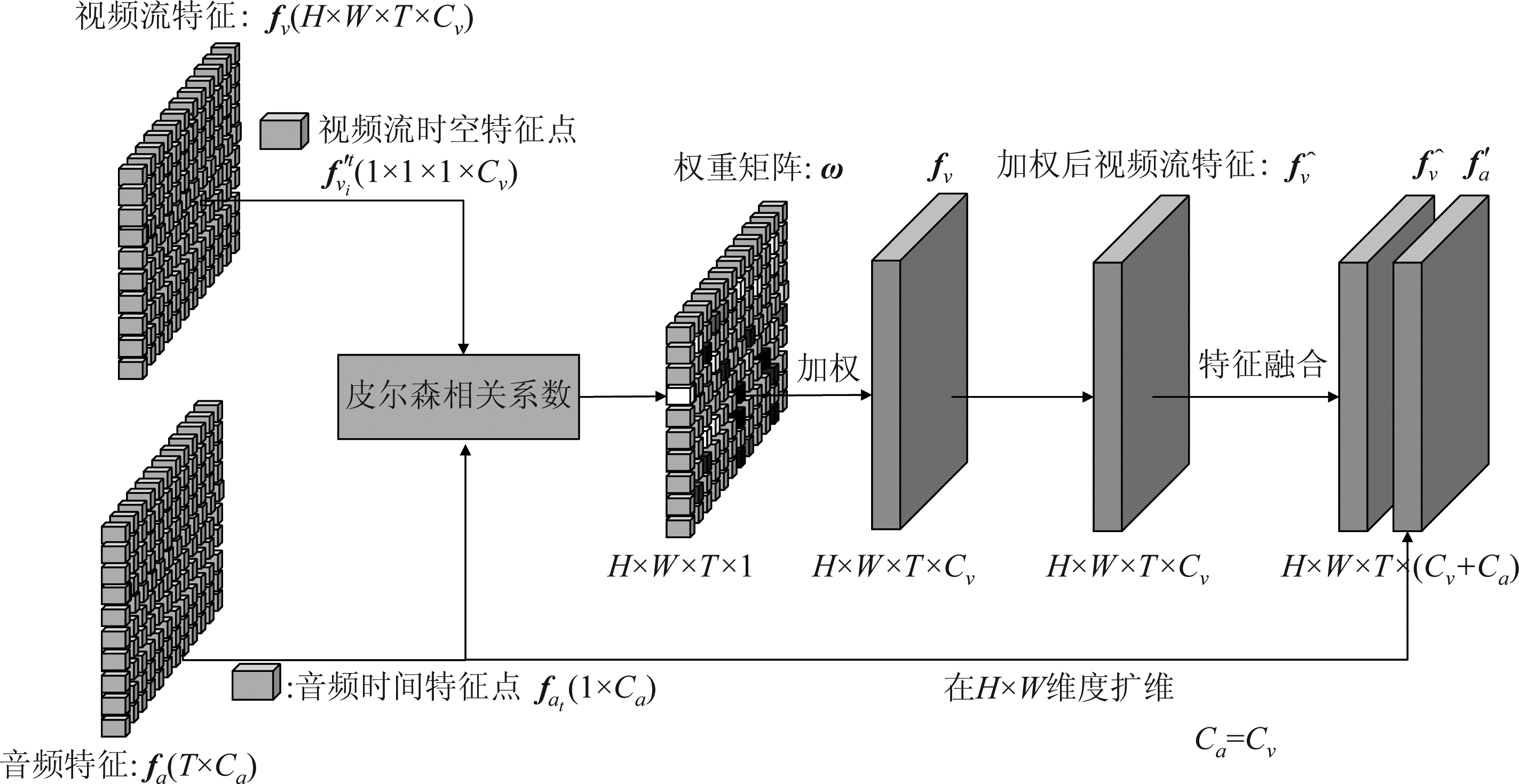

图1 引入注意力机制的音视频同步检测模型

Fig.1 Audio-visual synchronization detection model with attention mechanism

2.1.2 视频流神经网络

如图1中视频流神经网络部分所示,本文采用类似于Resnet-18模型[26]的网络构架提取视频流高维特征。但在网络设计中本文采用了类似文献[15]中膨胀3D卷积的设计,将2D卷积层替换为3D卷积层以获取视频流的运动特征。且与音频网络类似,卷积层后加入ReLU激活函数以增强网络特征提取能力,并采用3D Pool减小特征维度。视频流神经网络的具体参数如表1所示。输入视频流神经网络的是4.2秒长(本文从10秒视频中随机截取4.2秒),帧率为29.9 Hz的视频流,因此每个训练视频流都包含125帧图片。随后从256×256大小的图像中随机截取224×224并随机左右翻转,以增强网络对输入视频流的旋转不变性。在经过设计的视频流神经网络之后,所输入的视频流可以提取出维度为H×W×T×Cν的高维特征fν。其中视觉运动的时间信息包含在视频流特征的T维度,空间信息保存在H×W维度当中。

2.1.3 引入注意力机制的音视频融合模型

由前文所述,通过所设计的音频神经网络与视频流神经网络,音频信号与视频流信号可分别转化为高维特征fa与fν。文献[31]指出在给定情况下人们可以动态地,有选择地从背景环境中突出与目标更相关的部分,因此本文在将音频特征与视频流特征融合之前突出它们之间最相关的部分。在深度学习领域,我们称之为注意力机制。与文献[17-18]等利用全连接层和softmax函数来获取权重不同,本文所采用的注意力机制利用所获得的高维音频特征fa以及视频流特征fν的PCC作为每个视频流特征块的标量置信度值(时间以及空间)。而这些置信度值将作为权重用于获得视频流信息的加权平均值。随后,视频流的加权平均值![]() 将与扩维后的音频特征

将与扩维后的音频特征![]() 进行通道融合再一起传递给图1中的决策网络部分。换句话说,本文所采用的注意力模块在时间以及空间维度上对视频流高维特征的每一个块与音频高维特征进行关联性评估。因此,它对音视频特征的融合更加有利。下文将对本文研究的注意力模块进行更详细的描述。

进行通道融合再一起传递给图1中的决策网络部分。换句话说,本文所采用的注意力模块在时间以及空间维度上对视频流高维特征的每一个块与音频高维特征进行关联性评估。因此,它对音视频特征的融合更加有利。下文将对本文研究的注意力模块进行更详细的描述。

图2给出了本文所设计的引入注意力机制的音视频融合模型。由前文2.1.1节与2.1.2节可知,所获得高维音频特征fa与高维视频流特征fν的维度分别为T×Ca,H×W×T×Cν。为了计算每一个时空位置视频流高维特征与音频高维特征的关联性,本文在设计神经网络时使音频特征与视频流特征的输出通道数相同,即Ca=Cν=C。其次为了获取视频流高维特征与音频高维特征在空间位置的关联性,本文将大小为H×W×T×Cν的视频流高维特征转换为大小为M×T×Cν的![]() 其中M=W×H。对于每一个空间位置i∈{1,2,3,…,M},本文可获得大小为T×Cν的高维视频流特征

其中M=W×H。对于每一个空间位置i∈{1,2,3,…,M},本文可获得大小为T×Cν的高维视频流特征![]() 随后,为了获取高维视频流特征与音频特征在时间位置的关联性,对于每一个时间维度t∈{1,2,3,…,T},可获得维度为1×C的音频特征fat以及维度为1×C的视频流特征

随后,为了获取高维视频流特征与音频特征在时间位置的关联性,对于每一个时间维度t∈{1,2,3,…,T},可获得维度为1×C的音频特征fat以及维度为1×C的视频流特征![]() 因此,可由下式获取视频流特征与音频特征在每一个时空位置的关联性:

因此,可由下式获取视频流特征与音频特征在每一个时空位置的关联性:

图2 引入注意力机制的音视频融合模型

Fig.2 Audio-visual fusion model with attention mechanism

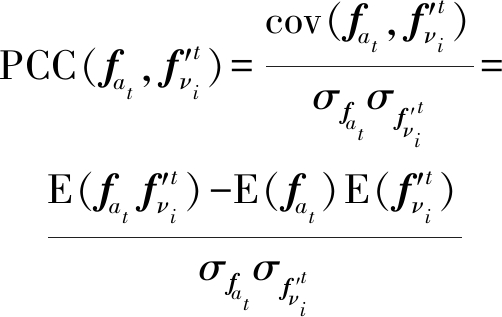

(1)

其中cov代表协方差函数,E代表求均值操作,σ代表标准差。此外,为了避免负相关情况的干扰,本文提出改进的注意力机制如下式:

(2)

采用ReLU函数将负相关系数全部置为0,从而避免相关系数求解中负相关的影响。在此,我们可以将注意力机制解释为视频流特征中某一时空点与相对应语音特征相关的概率,因此可以将所获得的相关系数作为每个时空点视频流特征的权重值。随后与文献[18]中类似,如下式所示将所获取的每个时空点权重值利用softmax函数进行归一化,获取归一化后的权重ωh,w,t:

(3)

与文献[17-18]使用多层感知机获取权重值不同,本文使用PCC不需要任何学习参数的步骤,也直观体现了两种模式特征的关联性。最终可获得维度为H×W×T的权重矩阵ω。随后,如下式所示将所获得的权重矩阵ω与视频流特征fν的每一个通道进行点乘加权,可获得加权后的视频流特征![]() 为:

为:

(4)

其中* 代表矩阵元素对应相乘。为了将![]() 与fa融合,需要fa在H×W维度上扩维得到维度为H×W×T×Ca的特征

与fa融合,需要fa在H×W维度上扩维得到维度为H×W×T×Ca的特征![]() 随后将加权后的视频流特征

随后将加权后的视频流特征![]() 与扩维后的音频特征

与扩维后的音频特征![]() 进行通道数的结合,最终可以得到维度为H×W×T×(Ca+Cν)的多模态融合特征faν。如图1所示,将融合特征faν进一步输入决策网络部分提取其高维特征并判断所输入的视频流与音频是否对齐。决策层网络先由多个1D卷积,3D卷积组成以提取faν的高维特征,随后采用全局池化(Global Pool)降低特征维度,最后通过全连接层(Full Connection,FC)输出判定音视频对齐的概率。决策网络部分的具体网络参数如表1所示。如下式所示对于这样一个二分类问题,本文采用交叉熵损失为其代价函数:

进行通道数的结合,最终可以得到维度为H×W×T×(Ca+Cν)的多模态融合特征faν。如图1所示,将融合特征faν进一步输入决策网络部分提取其高维特征并判断所输入的视频流与音频是否对齐。决策层网络先由多个1D卷积,3D卷积组成以提取faν的高维特征,随后采用全局池化(Global Pool)降低特征维度,最后通过全连接层(Full Connection,FC)输出判定音视频对齐的概率。决策网络部分的具体网络参数如表1所示。如下式所示对于这样一个二分类问题,本文采用交叉熵损失为其代价函数:

loss=-[ylog(p)+(1-y)log(1-p)]

(5)

其中y代表样本标签(正类:给定视频的视频流与音频对齐,记为1。负类:给定视频的视频流与音频不对齐,记为0), p代表预测为正的概率。在训练阶段,损失的反向传播促使视频流信息与音频信息相关联,从而可学习到音视频同步的联合表达。

2.2 基于音视频同步联合表达的声源定位

值得注意的是,视频中的声源概念存在着很大的模糊性。例如,在一个音乐家演奏的视频当中,音乐家的嘴唇,喉咙以及大号都可能被视为声音的来源。由文献[15]可知,良好的音视频同步的联合表达将有利于视频声源定位。因此,本文利用所学习到的音视频同步的联合表达定位仅仅与声音产生相关的运动,并进行可视化显示。本文采用文献[24]中的CAM方法,利用网络提取的高维特征进行视频声源定位。对于给定的视频流信号Vx,y,t,对应的音频信号At,通过本文所设计模型中的Global Pool层后可获得维度为1×C′的特征f(Vx,y,t,At)。因此,可以估计出给定视频流Vx,y,t与音频At对齐的概率如下式所示:

p(y|Vx,y,t,At)=sig{hTf(Vx,y,t,At)}

(6)

其中sig为sigmoid函数,h是如图1所示模型最后一层全连接层的参数。通过不断训练, f(Vx,y,t,At)包含着视频声源的时空信息。在音视频同步检测训练完成之后,忽略决策网络部分的Global Pool层,可获得维度为H′×W′×T′×C′的特征f′(Vx,y,t,At),其与f(Vx,y,t,At)相同也包含着视频声源的时空信息。随后通过下式可获得音视频关联性的cam(x,y,t):

cam(x,y,t)=hTf′(Vx,y,t,At)

(7)

因此音视频关联性的cam(x,y,t)是与音频特征相关联的视频流特征在不同时空位置的加权线性总和,而加权系数变为网络最后一层全连接层的系数。通过将cam(x,y,t)上采样到输入视频图像的大小,便可获得视频声源定位结果。与经典的基于互信息的方法[19-21]进行视频声源定位不同,本文采用的这种自我监督视频声源定位方法,根据学习到的后验概率p(y|Vx,y,t,At)找到提供关于潜在变量y的最多相关信息的视频流信息与音频信息。即本文先对标签y进行采样,确定对齐,然后有条件地对视频流信息Vx,y,t和音频信息At进行采样,从而达到视频声源定位的目的。

3 实验结果及分析

3.1 数据集及实验细节

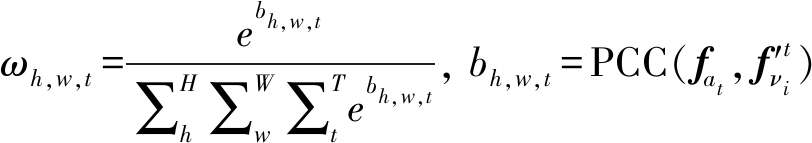

本文的训练数据采用与文献[15]相同的公共数据集AudioSet[32],我们在该数据集下选取了8000个语音视频以及1000个生活中一般场景(例如车辆引擎声、球的撞击声等)的视频以增加模型对不同声源的鲁棒性。在训练阶段,我们为所设计的网络提供4.2秒长视频(从AudioSet数据集提供的10秒长视频中随机截取4.2秒的视频)。在选取的视频当中,其中一半的视频流与音频是同步的并将其作为正样本,另一半如2.1.1节中的音频信号预处理步骤,将音轨随机移动使视频流与音频不同步作为负样本。本文训练网络的任务是区分给定的视频其视频流与音频是否同步,以学习音视频同步的联合表达。本文使用文献[15]的预训练权重进行特征提取,即将音频神经网络部分与视频流神经网络部分的参数固定,从头开始训练融合层之后的神经网络部分,批量大小为16,并训练100个阶段。本文采用二分类问题中常用的交叉熵损失函数,采取Adam优化器并将初始学习率置为1e-3。在音视频同步检测测试阶段,我们在AudioSet数据集上另外采取了2000个语音视频以及1000个其他种类视频并随机均分成两组:一组作为正样本(一共1500个),另一组如训练集数据一样移动音轨作为负样本(一共1500个)。本文采用二分类准确率(Accuracy,Acc),查准率-召回率(Precision-Recall, P-R)曲线以及受试者工作特征(Receiver Operating Characteristic, ROC)曲线测试本文所设计网络的分类准确率,并与文献[15]中的方法(本文称之为Andrew方法)进行比较。其中相关测量标准定义如下文所述,对于二分类问题的混淆矩阵如表2所示。则查准率P与召回率R分别定义为:

(8)

表2 混淆矩阵

Tab.2 Confusion matrix

预测结果真实标签 正样本负样本正样本TP(真正样本)FN(假负样本)负样本FP(假正样本)TN(真负样本)

真正类率(True Positive Rate,TPR)以及假正类率(False Positive Rate,FPR)定义为:

(9)

准确率定义为:

(10)

3.2 音视频同步检测实验结果

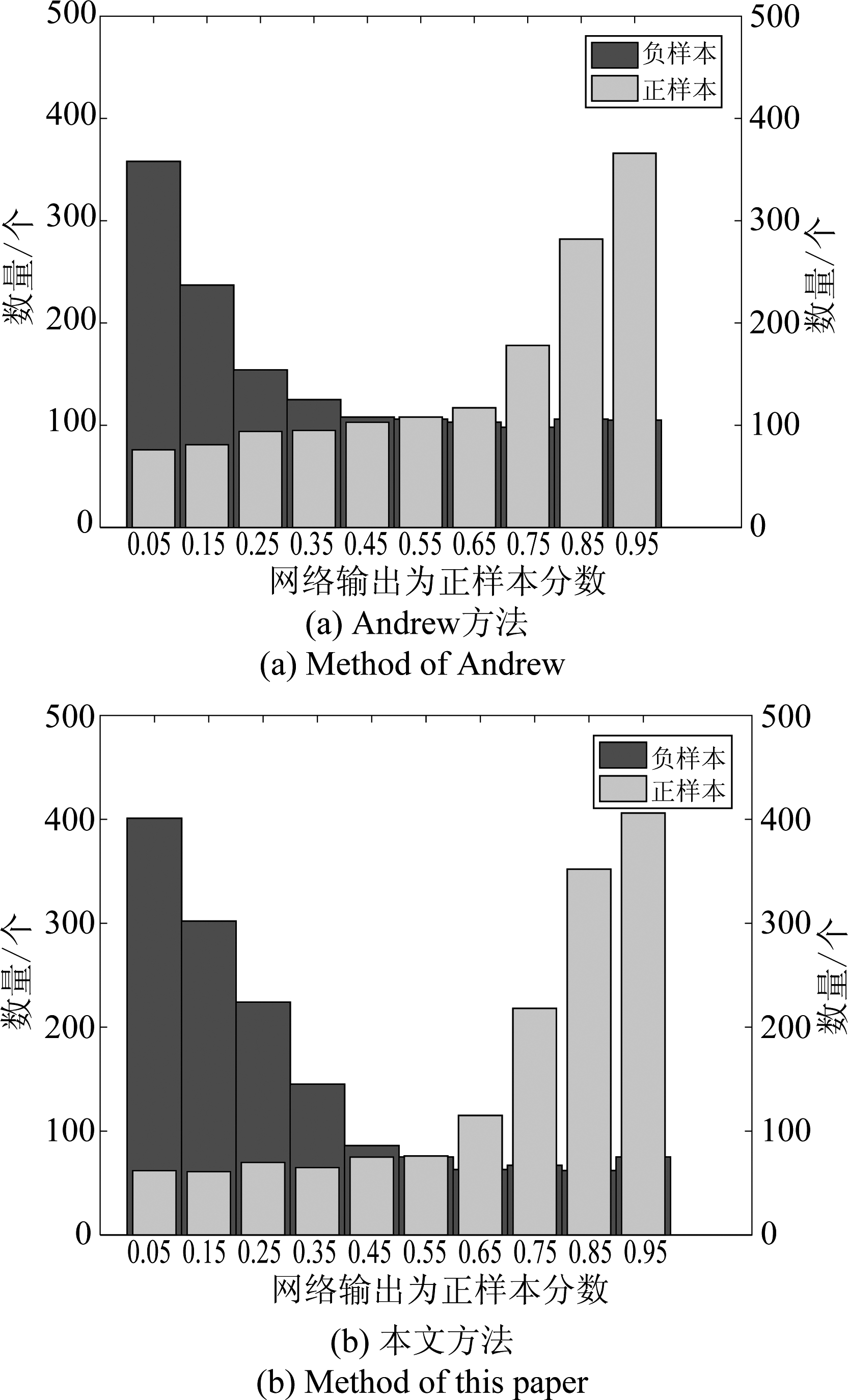

图3 不同方法的测试数据得分分布图

Fig.3 Test data score distribution of different methods

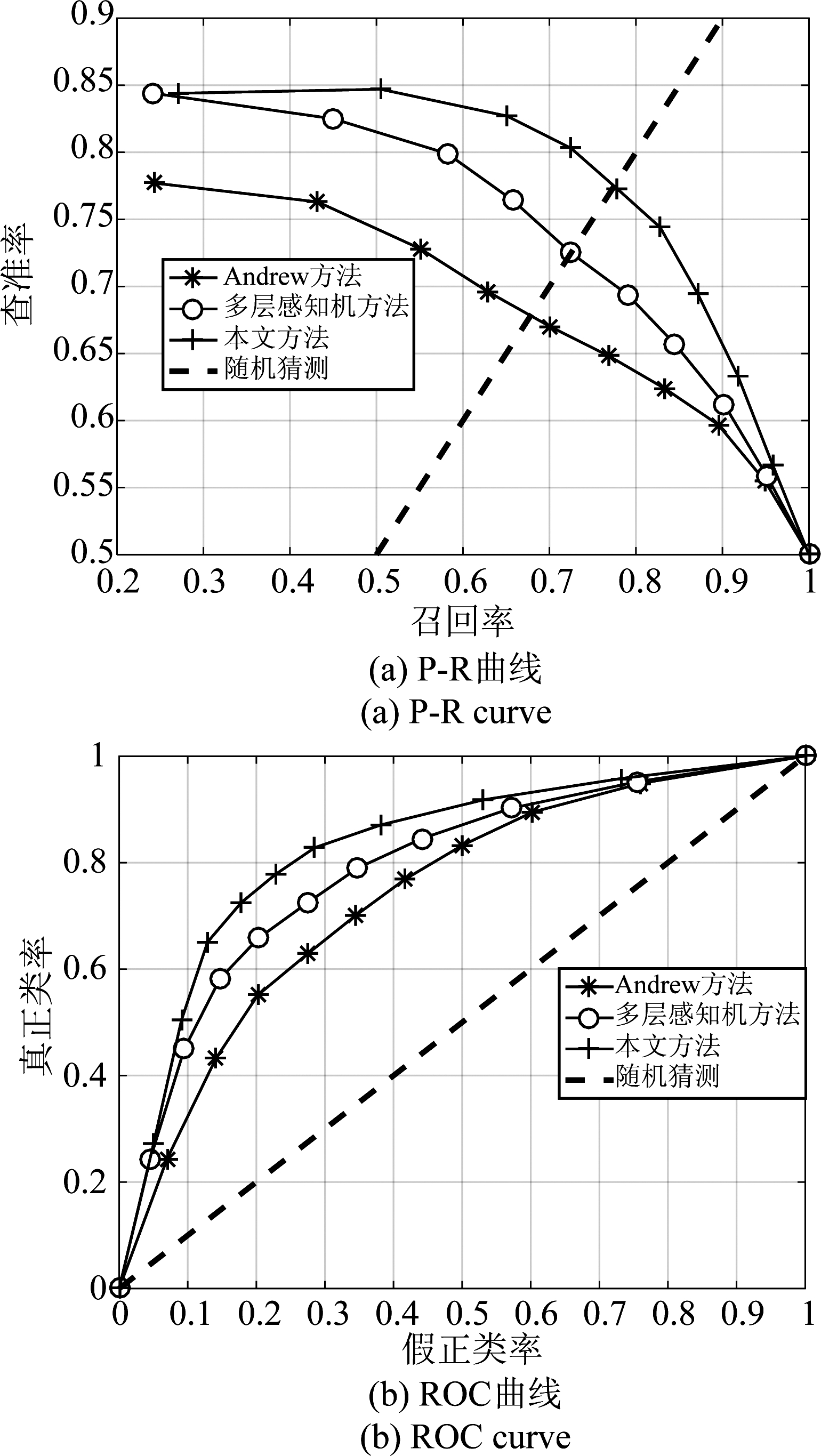

图4 不同方法的P-R曲线和ROC曲线

Fig.4 The P-R curve and ROC curve of different methods

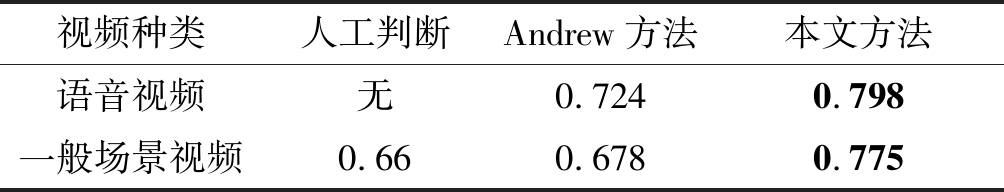

图3给出了所有测试数据通过本文提出网络以及Andrew方法网络后判定为正样本(音频与视频流同步)的得分情况。其中图3(a)代表Andrew方法的结果,图3(b)代表本文方法的结果,并且蓝色代表负样本得分情况,黄色代表正样本得分情况。图3结果显示,本文引入注意力机制进行音视频信息融合有助于更好地分离同步与非同步数据分布。通过获得的判定为正样本得分情况,可以获取相应的P-R曲线与ROC曲线。其中图4(a)为P-R曲线,图4(b)为ROC曲线。首先从图4(a)中查看平衡点(Break-Even Point,BEP)即召回率等于查准率点,可以看出,本文提出方法的BEP为0.78,而Andrew方法的BEP仅为0.68。因此,本文所提出的分类网络明显优于Andrew方法。此外本文还采用了如图4(b)ROC曲线证明本文提出网络的优越性。图4(b)结果显示,本文提出方法的ROC曲线完全包住Andrew方法的ROC曲线,因此本文提出方法的ROC曲线下面积(Area Under ROC Curve,AUC)大于Andrew方法的AUC。由此验证,本文提出方法在二分类问题上优于文献[15]中提出的方法。此外,为了验证本文所采用的注意力机制优于文献[17-18]中多层感知机方法,本文方法其他部分保持不变,而在注意力机制部分将视频流高维特征与音频高维特征的PCC换为多层感知机以此获得视频流特征的权重值,本文称之为多层感知机方法。其相应的P-R曲线与ROC曲线如图4所示,可以明显看出本文方法的BEP以及AUC均大于多层感知机方法。因此,本文采用的注意力机制要优于文献[17-18]中多层感知方法,可以更好地学习音视频同步的联合表达。表3给出了所有测试集在不同方法上的分类准确率,且门限值被设为0.5。其中第二列为文献[15]中利用人工在限定时间(15秒)内判断给定的音频与视频流是否对齐的准确率(具体实验细节可参考文献[15])。对于一般场景视频,文献[15]中指出人类的分类准确率也仅仅只有0.66。由此可见对于人类,它也是一个具有挑战的问题。表中第三列,第四列分别为Andrew方法以及本文提出方法的分类准确率。可以看出,在语音视频的分类准确率方面本文提出的方法较Andrew方法提升了7.4%。而在一般场景视频中本文方法较Andrew方法提升了9.7%。因此,本文提出的方法在不同场景都有更优秀的分类效果。

表3 不同方法测试集分类准确度

Tab.3 The test set classification accuracy of different methods

视频种类人工判断Andrew方法本文方法语音视频无0.7240.798一般场景视频0.660.6780.775

3.3 基于音视频同步的声源定位实验结果

图5 不同方法的一般场景视频声源定位可视化结果图

Fig.5 The general scene video sound source localization visualization results of different methods

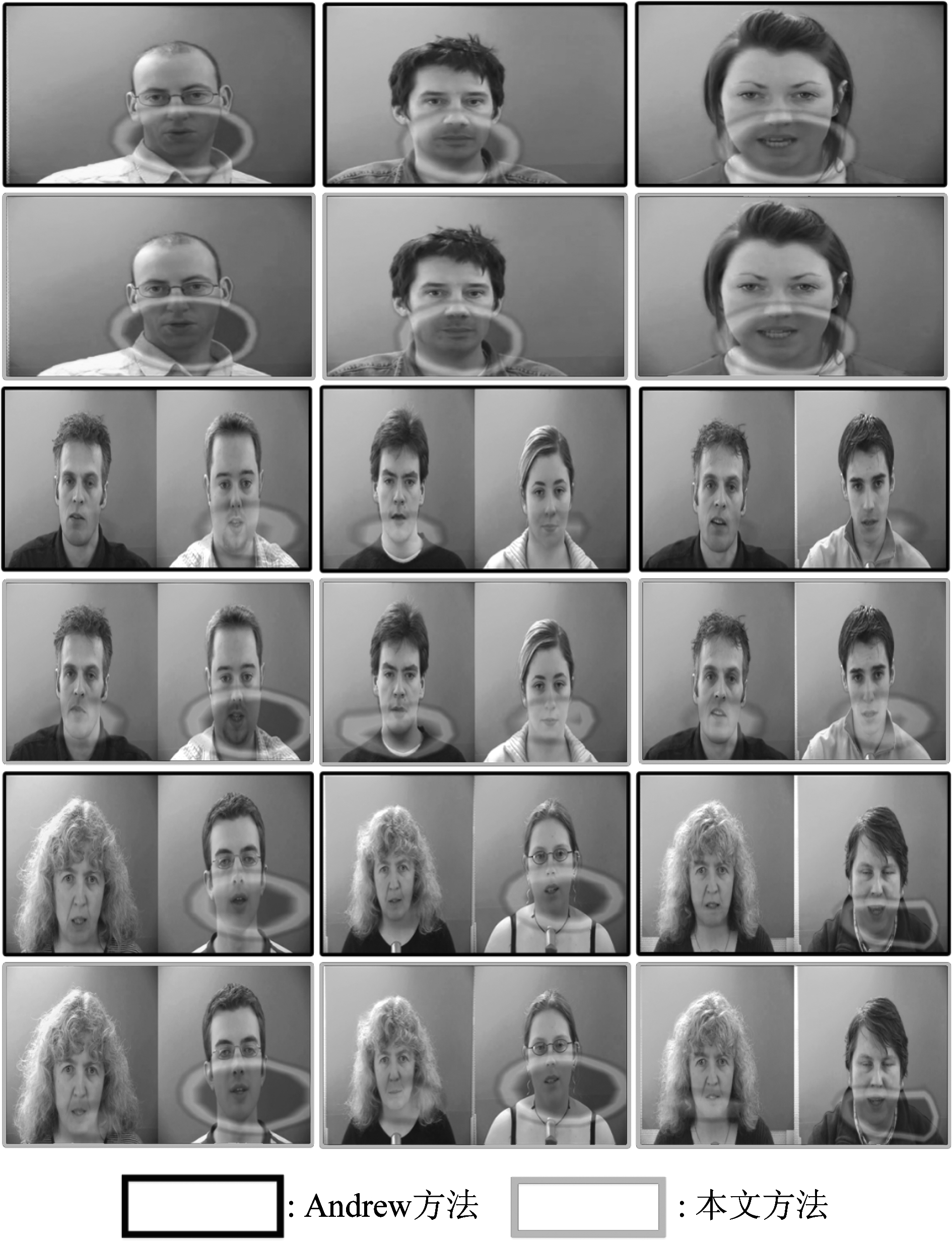

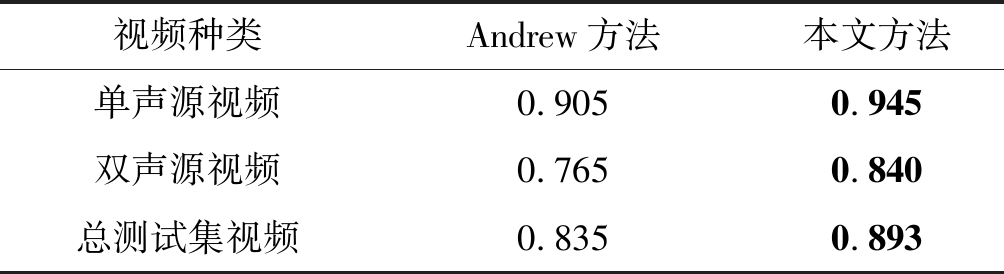

在学习了音视频同步的联合表达后,本文进一步利用所得到的信息进行视频声源定位。图5给出了不同场景视频下视频声源定位的可视化结果图。其中红色边框为基于本文设计网络视频声源定位可视化结果图,蓝色边框为基于Andrew方法的可视化结果图,两种方法给出结果图的帧数相同。在两种方法中,CAM方法所产生的热图均覆盖在声源所产生的位置。因此,可知所学习到的音视频同步联合表达有助于视频声源定位。比较给出的可视化结果图也可明显看出,相较与Andrew方法,本文的可视化结果图(红框表示)其热图定位更加精确而且所赋予的置信度也更高(热图中红色区域越深,表明为声源的概率越大)。在给出了不同生活场景的视频声源定位结果后,我们进一步关注更加具体的情况,即关于说话人的声源定位。与前文测试视频不同,在此,本文采用GRID数据集[33] 进行说话人声源定位测试,并且每个测试视频都包含一个或两个声源。图6给出了不同方法的说话人声源定位可视化结果图,其中黑色边框代表Andrew方法可视化结果图,红色边框代表本文方法的可视化结果图。图6结果指出Andrew方法在处理多个声源的情况下可能失效,仅仅定位出一个声源,而本文方法对于多声源有更好的鲁棒性。与Andrew方法相同,由于本文所采用的训练以及测试集都为无标签数据集(没有视频声源位置的真实值),对声源定位做精确的定量分析比较困难。因此,本文采用类似文献[34]中检测说话人的方法进行定量分析。我们从GRID数据集中采取了400个说话人视频,其中200个仅一个说话人(一个声源),另外200个包含两个说话人(两个声源)。对于每一个视频,所有的声源定位正确,即一个视频中所有说话人都成功被检测记为1,否则定位失败记为0(判定检测说话人标准为生成的热图必须覆盖说话人嘴部区域),所获得的统计数据如表4所示。对于单个说话人视频,Andrew方法以及本文方法都可以达到90%以上的检测率。说明音视频同步的联合表达有助于视频声源定位。而对比双声源视频,本文方法相较于Andrew方法,检测准确率提高了7.5%。由此可以看出本文方法所学习到的音视频同步的联合表达优于Andrew方法,在多声源定位方面更有优势。

图6 不同方法的说话人视频声源定位可视化结果图

Fig.6 The speaker video sound source localization visualization results of different methods

表4 不同方法的说话人检测准确率

Tab.4 The speaker detection accuracy of different methods

视频种类Andrew方法本文方法单声源视频0.9050.945双声源视频0.7650.840总测试集视频0.8350.893

4 结论

为了学习音视频同步的联合表达,目前主流方法为训练所设计的神经网络判断音频与视频流是否同步。而当前方法在将视频流高维特征与音频高维特征进行融合时,没有考虑视频流高维特征与音频高维特征在时空领域的关联性。本文采用注意力机制,并利用皮尔森相关系数获取视频流高维特征与音频高维特征相关系数作为视频流特征时空领域的权重值,从而可以得到更好的音视频同步的联合表达。利用所学习的音视频联合信息,进一步采用CAM算法进行视频声源定位。本文采用Audioset数据集进行了音视频同步检测试,实验表明采用不同的标准本文方法都可以获得更好的分类效果,即可以学习到更好的音视频同步的联合表达。同时我们在Audioset以及GRID数据集上进行了视频声源定位测试,实验结果表明本文方法相较于Andrew方法可以更准确的进行声源定位,对于多个声源也有较好的定位效果。

[1] 汤永清, 黄青华, 方勇. 基于球傅里叶变换的声源三维空间定位[J]. 信号处理, 2010, 26(5): 654- 658.

Tang Yongqing, Huang Qinghua, Fang Yong. Localization of Sound Source Based on Spherical Fourier Transformation in Three Dimension[J]. Signal Processing, 2010, 26(5): 654- 658.(in Chinese)

[2] 伊晓东, 刘庆华. 分布式圆阵空间宽带声源定位方法[J]. 信号处理, 2016, 32(4): 496-503.

Yi Xiaodong, Liu Qinghua. Localization Method of Spatial Wideband Sound Source on Distributed Circular Array[J]. Journal of Signal Processing, 2016, 32(4): 496-503.(in Chinese)

[3] 闫小媛, 吴长奇, 李家赫. 基于两级变参数滤波时延校正的声源定向[J]. 信号处理, 2012, 28(2): 270-275.

Yan Xiaoyuan, Wu Changqi, Li Jiahe. Two Stage Variable Parameter Filter TimE-Delay Correction Approach to Acoustic Source Direction[J]. Signal Processing, 2012, 28(2): 270-275.(in Chinese)

[4] Takashima R, Takiguchi T, Ariki Y. Dimensional Feature Weighting Utilizing Multiple Kernel Learning for SinglE-Channel Talker Location Discrimination Using the Acoustic Transfer Function[J]. The Journal of the Acoustical Society of America, 2013, 133(2): 891-901.

[5] Parhizkar R, ![]() I, Vetterli M. SinglE-Channel Indoor Microphone Localization[C]∥2014 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2014: 1434-1438.

I, Vetterli M. SinglE-Channel Indoor Microphone Localization[C]∥2014 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2014: 1434-1438.

[6] Gaver, William W. What in the World Do We Hear?: An Ecological Approach to Auditory Event Perception[J]. Ecological Psychology, 1993, 5(1): 1-29.

[7] Jones B, Kabanof B. Eye Movements in Auditory Space Perception[J]. Attention Perception and Psychophysics, 1975, 17(3): 241-245.

[8] Shelton B R, Searle C L. TheInfluence of Vision on the Absolute Identification of Sound-source Position[J]. Perception and Psychophysics, 1980, 28(6): 589.

[9] Aytar Y, Vondrick C, Torralba A. Soundnet: Learning Sound Representations from Unlabeled Video[C]∥Proceedings of the 30th International Conference on Neural Information Processing Systems. ACM, 2016: 892-900.

[10] Owens A, Wu J, McDermott J H, et al. Learning Sight from Sound: Ambient Sound Provides Supervision for Visual Learning[J]. International Journal of Computer Vision, 2018, 126(10): 1120-1137.

[11] Owens A, Isola P, McDermott J H, et al. Visually Indicated Sounds[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2016: 2405-2413.

[12] Matthias Solèr, Bazin J C, Wang O, et al. Suggesting Sounds for Images from Video Collections[C]∥European Conference on Computer Vision Workshops. Springer, 2016: 900-917.

[13] Aytar Y, Vondrick C, Torralba A. See, Hear, and Read: Deep Aligned Representations[J]. arXiv preprint arXiv: 1706.00932, 2017.

![]() Relja, Zisserman A. Look, Listen and Learn[C]∥2017 IEEE International Conference on Computer Vision (ICCV). IEEE, 2017: 609- 617.

Relja, Zisserman A. Look, Listen and Learn[C]∥2017 IEEE International Conference on Computer Vision (ICCV). IEEE, 2017: 609- 617.

[15] Owens A, Efros A A. Audio-visual Scene Analysis with Self-supervised Multisensory Features[C]∥European Conference on Computer Vision (ECCV). Springer, 2018: 639- 658.

[16] 黄雅婷, 石晶, 许家铭, 等. 鸡尾酒会问题与相关听觉模型的研究现状与展望[J]. 自动化学报, 2019, 45(2): 234-251.

Huang Yating, Shi Jing, Xu Jiaming, et al. Research Advances and Perspectives on the Cocktail Party Problem and Related Auditory Models[J]. Acta Automatica Sinica, 2019, 45(2): 234-251.(in Chinese)

[17] Vinyals O, Toshev A, Bengio S, et al. Show and Tell: A Neural Image Caption Generator[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2015: 3156-3164.

[18] Bahdanau D, Cho K, Bengio Y. Neural Machine Translation by Jointly Learning to Align and Translate[J]∥arXiv preprint arXiv: 1409.0473, 2014.

[19] Hershey J, Movellan J. Audio Vision: Using Audio-visual Synchrony to Locate Sounds[C]∥Advances in Neural Information Processing Systems. MIT, 2000: 813- 819.

[20] Kidron E, Schechner Y Y, Elad M. Pixels That Sound[C]∥2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2005: 88-95.

[21] Fisher J W, Darrell T, Freeman W T, et al. Learning Joint Statistical Models for Audio-Visual Fusion and Segregation[C]∥Advances in Neural Information Processing Systems. ACM, 2001: 772-778.

[22] Barzelay Z, Schechner Y Y. Harmony in Motion[C]∥IEEE Conference on Computer Vision and Pattern Recognition(CVPR). IEEE, 2007: 1- 8.

[23] Izadinia H, Saleemi I, Shah M. Multimodal Analysis for Identification and Segmentation of Moving-Sounding Objects[J]. IEEE Transactions on Multimedia, 2013, 15(2): 378-390.

[24] Zhou B, Khosla A, Lapedriza A, et al. Learning Deep Features for Discriminative Localization[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2016: 2921-2929.

[25] Haque M F, Lim H, Kang D. Object Detection Based on VGG with ResNet Network[C]∥2019 International Conference on Electronics, Information, and Communication (ICEIC). IEEE, 2019: 1-3.

[26] He K, Zhang X, Ren S, et al. Deep Residual Learning for Image Recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2016: 770-778.

[27] Szegedy C, Liu W, Jia Y, et al. Going Deeper with Convolutions[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2015: 1-9.

[28] Ji S, Xu W, Yang M, et al. 3D Convolutional Neural Networks for Human Action Recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(1): 221-231.

[29] Chung J S, Zisserman A. Out of Time: Automated Lip Synchronization in the Wild[C]∥Asian Conference on Computer Vision Workshop. Springer, 2017: 251-263.

![]() R, Zisserman A. Objects that Sound[J]. arXiv preprint arXiv: 1712.06651, 2017.

R, Zisserman A. Objects that Sound[J]. arXiv preprint arXiv: 1712.06651, 2017.

[31] Corbetta M, Shulman G L. Control of Goal-Directed and Stimulus-Driven Attention in the Brain[J]. Nature Reviews Neuroscience, 2002, 3(3): 215-229.

[32] Gemmeke J F, Ellis D P W, Freedman D, et al. Audio Set: An Ontology and Human-Labeled Dataset for Audio Events[C]∥2017 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2017: 776-780.

[33] Cooke M, Barker J, Cunningham S, et al. An Audio-Visual Corpus for Speech Perception and Automatic Speech Recognition[J]. Acoustical Society of America, 2006, 120(5): 2421-2424.

[34] Nock H J, Iyengar G, Neti C. Speaker Localization Using Audio-Visual Synchrony: an Empirical Study[C]∥International Conference on Image and Video Retrieval. Springer, 2003: 488- 499.