1 引言

近年来,由于手机和平板电脑等移动终端的广泛使用,图像、视频等多媒体内容的编辑和访问呈现个性化需求,基于内容的视频检索技术得到快速发展[1]。无线网络中,由于数据流量和浏览时间的限制,许多用户通常不直接观看整部冗长的视频节目,而选择性浏览能代表视频最重要语义信息的视频摘要[2]。因此,视频摘要以较小的数据量显示最重要的语义内容,成为移动终端最常用的视频内容浏览方式之一。通常,视频摘要主要解决两个方面的问题:其一是解决重要性语义内容的抽取问题;其二是根据用户需求或环境约束提供友好的显示方式。在重要性语义内容的抽取上,现有方法通常辅助领域知识和机器学习方法对视频流进行时域和空域分析标注,其中对于体育视频而言,首要的工作就是挖掘视频中的精彩事件片段并标注其位置和精彩度值;而在表现形式上,传统的视频摘要则主要采用事件片段选播和关键帧构成故事板两种形式[3- 4]。然而,视频片段回放仍然存在流量耗费大、编/解码复杂且浏览时间长等问题;虽然故事板能大大节约流量,但仅仅孤立地展现事件关键帧,缺乏有效的叙事逻辑,且不处理非感兴趣区域,显示效率低下。因为视频中的任意事件都有其内在的空-时逻辑关系,现有的故事板摘要技术迫切需要从叙事性和空间利用率等方面进行显示优化。

拼图作为个人图像集的摘要生成方式深受用户喜爱,其优点是能够在有限的显示区域中呈现艺术化的多图融合显示,并且保持了显著性内容的清晰可见。长期以来,各种优化的拼图生成算法受到国内外众多学者的关注。自动化拼图技术也被用于生成个人图像集封面,精选个人画面中显著度较高的内容进行艺术性地刻画和描绘[5-7]。拼图生成的优化目标包括显著性内容摆放优化、重叠区域一致性过渡优化和对象清晰性优化等优化问题[8]。拼图生成同样可以应用于视频的光盘封面制作,即提取视频文件中少量关键帧生成艺术化表现的视频内容拼图,注重显示内容的艺术效果和美感[9-10]。但现有的视频关键帧拼图算法均不考虑视频内容中蕴含的叙事逻辑结构,而叙事无关的关键帧拼图并不能帮助用户很好地理解视频内容中包含的语义事件[11],不能有效吸引用户注意或点击兴趣。本文旨在对现有拼图技术进行改进,以足球视频为例,通过挖掘足球精彩事件的叙事结构和时-空逻辑生成叙事性拼图,替代现有大型体育视频网站中常用的故事板和片段选播技术。本文深入分析足球视频中不同类型镜头的叙事效用并且建立了叙事结构模型,利用领域知识和现有足球视频分析工作在不同镜头中提取感兴趣对象并对显著区重定向,以叙事性为目标优化内容选取和拼图排列,兼顾清晰性和艺术性等目标,使得单幅图像即可较好地叙述足球比赛事件的进展过程,大大提高浏览者的观看效率,增强浏览兴趣和点击动机。

2 足球视频摘要分析

视频摘要分析的目的就是提取视频中最有代表性的语义内容。相对于其他类型视频,足球视频摘要的主要工作是抽取比赛相关的精彩事件[12]。本节在介绍现有工作基础上重点讨论精彩事件标注、镜头分类和感兴趣区域分析等方法。

2.1 足球视频叙事结构

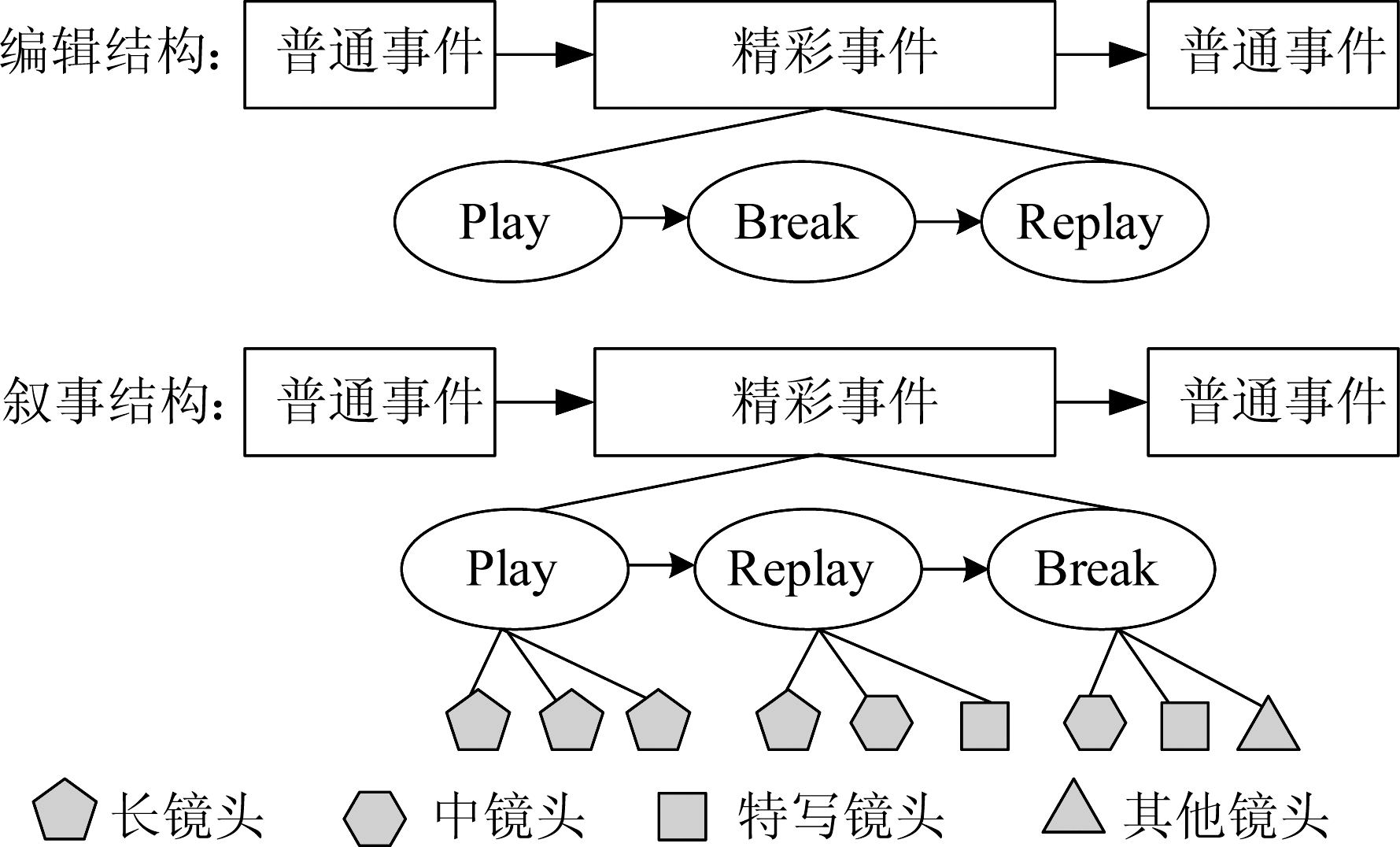

足球视频节目的叙事性整体上是为用户讲述比赛过程发生的事件,以及与这些事件相关的主体对象的动作或表情等。我们以一种分层的结构来描述足球视频的叙事性[12]。第一层叙事单元是精彩事件场景和普通比赛场景的交替出现。足球视频精彩事件是指包含进球、精彩射门等语义事件的视频片段,精彩事件的标注可以使用基于精彩度曲线和网络文本的多模精彩事件分析方法,得到标注精彩事件的精彩度值和事件关键词。第二层体现在每个事件场景又可划分为play、break和replay三个子场景,且主场景可解析为“play-[break]-[replay]”的时域序列,其中break和replay并不一定总是出现。第三层则是在每个“play|break|replay”子场景中包含的镜头序列,从这些镜头中提取关键帧即可得到生成拼图所需的基本图像集。

足球视频具有良好的编辑结构,通过事件场景内各镜头的变化分析可以得到符合时-空逻辑的叙事语义结构。通常,Play子场景主要由跟踪比赛的长镜头构成,越靠近中断场景的地方,精彩性内容越高,属于主叙事。Break子场景往往使用中镜头或特写镜头对球员表情或场内观众的情感变化进行增强描述,属于增强叙事。Replay子场景则是对比赛细节或球员动作进行补充描述,属于补充叙事。尽管视频制作时编辑者总是在精彩事件结束后插入Replay场景,但Replay场景是对Play场景的补充叙事,时序上更靠前,因此在生成拼图时,我们将Replay场景前移到Play场景和Break场景之间,如图1所示。

图1 足球视频叙事结构

Fig.1 The narrative scheme of soccer game video

2.2 镜头分类

镜头变换是视频叙事的一项重要手段。通过不同的镜头变换和“推-拉-摇-移”等操作,视频将事件发生的空间和时间细节清晰地展现在不同镜头内容中,激发观众对事件语义的理解从而产生情感共鸣。足球视频中每当精彩事件发生,拍摄者就会拉近镜头使用中镜头或特写镜头描述球员的动作和细节,甚至用回放镜头重现事件的精彩瞬间。因此,对足球视频进行镜头分类,是构建足球视频叙事语义的前提。

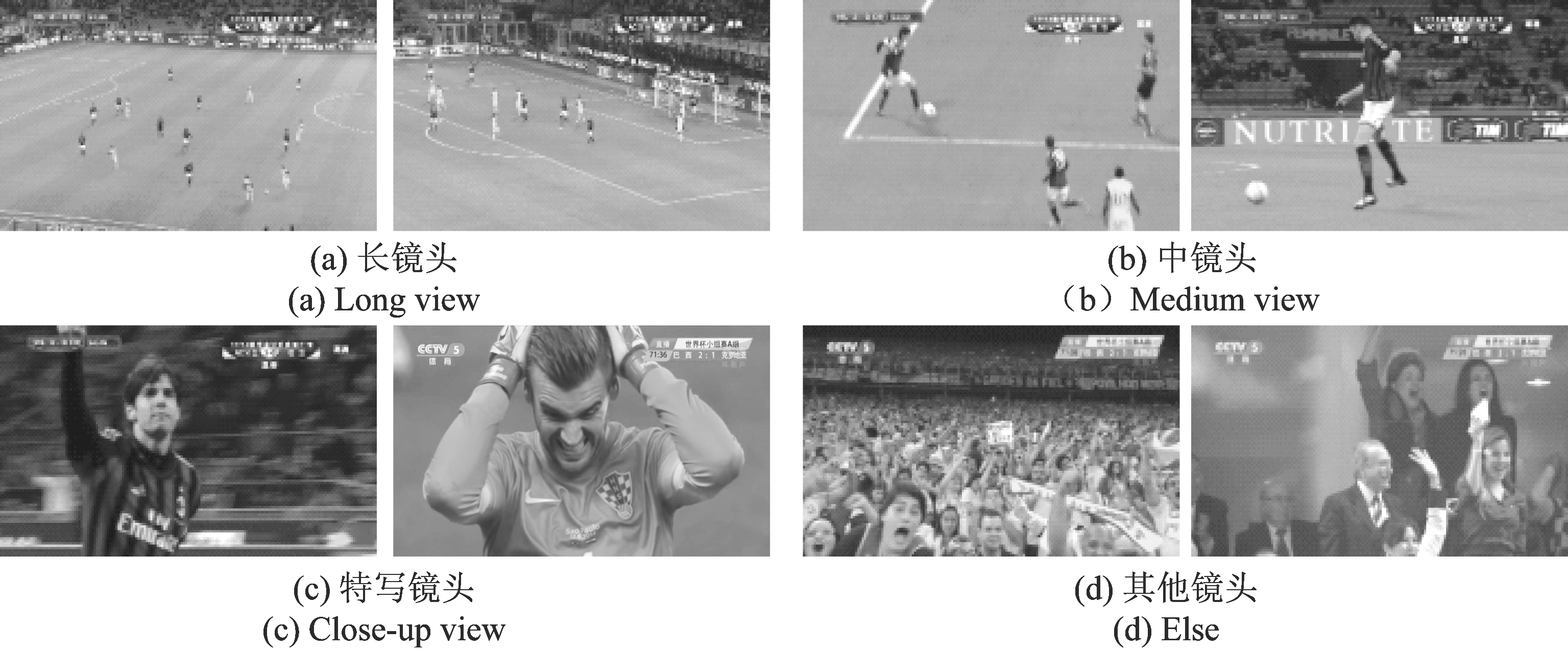

使用基于子窗口的主色率判别法[13],我们将足球视频镜头划分为长镜头、中镜头、特写镜头和场外镜头等四种类型。其中,长镜头用于叙述比赛的全过程;中镜头用于描绘运动员的特定动作如射门或铲断等;特写镜头则用于刻画比赛对象的面部表情;场外镜头则描述场外观众或非比赛对象的行为和表情,各类镜头示例如图2所示。

2.3 感兴趣对象与感兴趣区域分析

足球视频中,观众仅对不同画面中的特定对象感兴趣,而视频拍摄者把这种用户感知融合到拍摄手法中,通过不同类型的镜头变换来突出用户感兴趣对象。例如,长镜头关注足球及其周边攻防的球员,中镜头关注球员动作,特写镜头和场外镜头则关注球员面部动作,以检测到的人脸作为感兴趣中心。因此我们借鉴了通用显著性对象检测方法[17-18],提出基于镜头类型的足球视频感兴趣对象检测,进而标注出感兴趣区域(Region of Interest, ROI)及其像素显著性值的新方法。

我们以基于Viterbi的局部路径优选算法检测球位置[14-15],以基于深度卷积神经网络的多尺度人脸检测算法得到球员的正面和侧面人脸位置[16]。如图3所示,以红色圆圈出感兴趣对象中心,以感兴趣对象为中心的邻域构成感兴趣区。鉴于足球视频拍摄过程中主要使用摄像机跟拍手法,我们设计了如图3所示的权值模板对对象检测结果进行过滤,当多个对象被检测到时,只选择位置权值较大区域的对象作为感兴趣对象。

图2 足球视频镜头分类

Fig.2 The shot classifications of soccer game video

图3 各镜头中基于感兴趣对象确定感兴趣区

Fig.3 The regions of interest determined by objects of interest in different type of shots

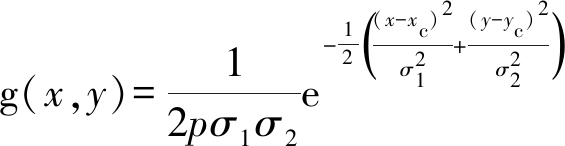

感兴趣对象被检测出来后,使用高斯模型计算感兴趣对象周边区域像素的显著值。令感兴趣对象中心为(xc, yc),感兴趣对象显著性为sc,则画面内感兴趣区域内各点的显著性值以式(1)计算:

s(x,y)=sc(xc,yc)·g(x-xc,y-yc)

(1)

其中,g(x,y)决定各像素到感兴趣对象中心点的权值,设为高斯分布函数,如式(2)所示。

(2)

3 足球视频拼图摘要算法

拼图是一种常见的艺术创作形式,通常在篇幅有限的画面中尽可能融合拼接多幅图像的显著内容和重要对象,达到一定的情感表达和艺术表现目的。与离散图像集生成拼图不同的是,视频内容在拼图生成时应该考虑视频内容本身的叙事性而构造拼图结果。传统拼图技术被用于制作视频光盘封面时,自动生成的关键帧拼图[5-10],视频帧被当作离散图像集处理,完全忽视视频的叙事性需求。Mei等提出用子镜头与场景之间的“由粗到细”分层结构[10]来呈现拼图,有助于呈现语义概念的层次关系,但还是不能有效地表达视频事件演进过程中的时-空逻辑,仍不能满足叙事呈现的目的。因此,在足球视频拼图算法中,我们定义了以叙事性为主的优化目标:

(1)叙事性

遵循精彩事件发生的时-空约束,将精彩事件的主要动作场景和人物按照时-空逻辑呈现出来,使得事件的叙事语义清晰可辨。

(2)清晰性

画面清晰,可视性强,人物和对象动作清晰可见,布局位置符合时-空逻辑,不存在混淆因果关系的画面和对象。

(3)艺术性

图像的外观表现符合艺术美学,布局合理,过滤平滑,颜色和光照保持较好的一致性。

3.1 精彩事件分析

足球视频中,拼图摘要只考虑精彩事件的叙事表达,而忽略普通比赛事件,因此,选取关键帧的第一步是根据叙事逻辑标注和抽取精彩事件。与精彩事件标注相关的方法很多,利用基于情感激励曲线和新闻文本的多模事件标注方法[19-20],我们可以得到精彩事件边界、精彩度值Ak和事件文本描述等丰富的多模语义标签。给定用户偏好的多模精彩事件抽取算法可以构建为经典的0-1背包模型。这里我们用贪心法求解,即根据事件精彩度值排序,选取大于精彩度阈值AT范围的前N个精彩事件构成集合HL{H1,H2,…,HN},如式(3)所示。

xk∈{0,1}

(3)

3.2 基于镜头语义的叙事关键帧选取策略

精彩事件被标注后,同一精彩事件中候选关键帧根据不同镜头的叙事功能确定:

(1)长镜头中最重要的叙事内容是球员的运动和进攻路径,因此拼图中呈现进攻路径最重要。长镜头中的进攻行为与足球的运动方向是一致的,因此长镜头ROI区域以足球位置为中心,只需要逐帧检测足球即可计算出长镜头中ROI区域的偏移位置。考虑到一定的漏检率,只考虑检测到足球的帧作为关键帧。同时,长镜头各帧的叙事相关性是时间上倒序的,各帧离事件结束处越近,叙事相关性越大,因此假设长镜头各候选关键帧集合为LF{lf0,lf1,lf2,…,lfNL-1},用NRL表示长镜头的叙事相关性,假设默认叙事相关性值为![]() 使用齐普夫谐函数计算叙事相关性的衰减因子,则NRL如式(4)所示。

使用齐普夫谐函数计算叙事相关性的衰减因子,则NRL如式(4)所示。

(4)

其中,NL为长镜头中所取的最大帧数,可令NL=5限制一个长镜头取帧数过多。![]() 是初始叙事相关性,通常设为1.0。

是初始叙事相关性,通常设为1.0。

(2)中镜头和特写镜头通常应用无参考图像质量评价方法[21]选取图像质量最清晰的一帧作为关键帧。但是在同一精彩事件中,中镜头和特写镜头都可能会有相似的镜头出现,因此会有较大的叙事冗余性。我们也设计了齐普夫谐函数来消除这种冗余性,具体方法就是从中镜头/特写镜头中按每镜头取一帧作为候选帧集合,再使用主色特征进行K-均值聚类,每类镜头的关键帧按照时域上的先后顺序排列,各帧叙事相关性NRX的计算方式如式(5)。

(5)

其中,![]() 为初始叙事相关性,通常设为1.0。

为初始叙事相关性,通常设为1.0。

(3)场外镜头往往也用于叙述观众情绪变化,不属于主要叙事内容,仍然使用人脸数目特征,对人脸特征数目大于1的镜头可以取一清晰关键帧,但叙事相关性只能设为![]() 为防止该类帧出现频率过大,ε可取值为0.3。

为防止该类帧出现频率过大,ε可取值为0.3。

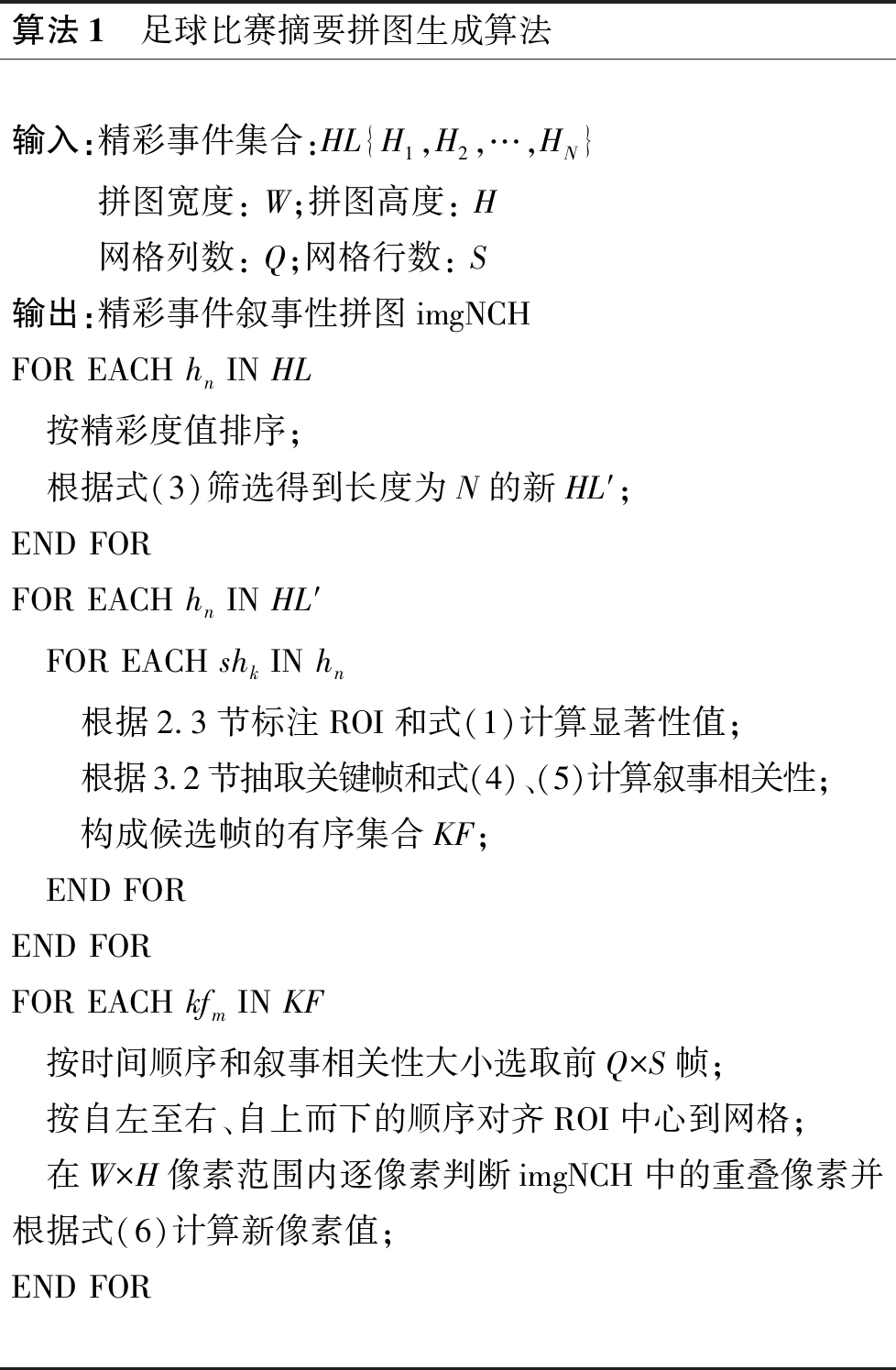

3.3 拼图摘要生成算法

当候选帧被确定后,考虑到事件发展的时间约束,本文不用随机排放算法,而使用基于网格模板的拼图排列算法,且规定网格模板自左向右,自上向下的时间先后顺序。网格模板又分为一维网格和二维网格:一维网格具有从左至右的时序关系,二维网格具有从左至右,从上至下的时序关系。当任意两个相邻区域出现重叠时,为了优化显著性高的像素值,我们使用基于显著值的α-融合策略生成重叠区像素。不失一般性,我们挑选任意相邻网格处的两帧fx和fy,首先将fx和fy感兴趣区域中心对齐相应网格中心,然后根据式(6)计算重叠区域的像素点值p(x,y):

p(x,y)=α·s(xfx,yfx)+(1-α)s(xfy,yfy)

(6)

其中,s(xfx,yfx)和s(xfy,yfy)是根据式(1)计算的fx帧和fy帧的显著值,而融合权值α的计算如式(7)。

(7)

最后,将拼图区域imgNCH定义为W×H像素,网格个数为Q×S个(一维网格时,S=1),则本文所述的足球视频拼图摘要算法包括三个优化搜索步骤,分别是搜索前N个精彩事件,搜索叙事相关性最大的候选关键帧,搜索显著性最大的拼图组合,如算法1所述。

算法1 足球比赛摘要拼图生成算法输入:精彩事件集合:HL{H1,H2,…,HN}拼图宽度: W;拼图高度: H网格列数: Q;网格行数: S输出:精彩事件叙事性拼图imgNCHFOR EACH hn IN HL 按精彩度值排序; 根据式(3)筛选得到长度为N的新HL′;END FORFOR EACH hn IN HL′ FOR EACH shk IN hn 根据2.3节标注ROI和式(1)计算显著性值; 根据3.2节抽取关键帧和式(4)、(5)计算叙事相关性; 构成候选帧的有序集合KF; END FOREND FORFOR EACH kfm IN KF 按时间顺序和叙事相关性大小选取前Q×S帧; 按自左至右、自上而下的顺序对齐ROI中心到网格; 在W×H像素范围内逐像素判断imgNCH中的重叠像素并根据式(6)计算新像素值;END FOR

4 实验结果分析

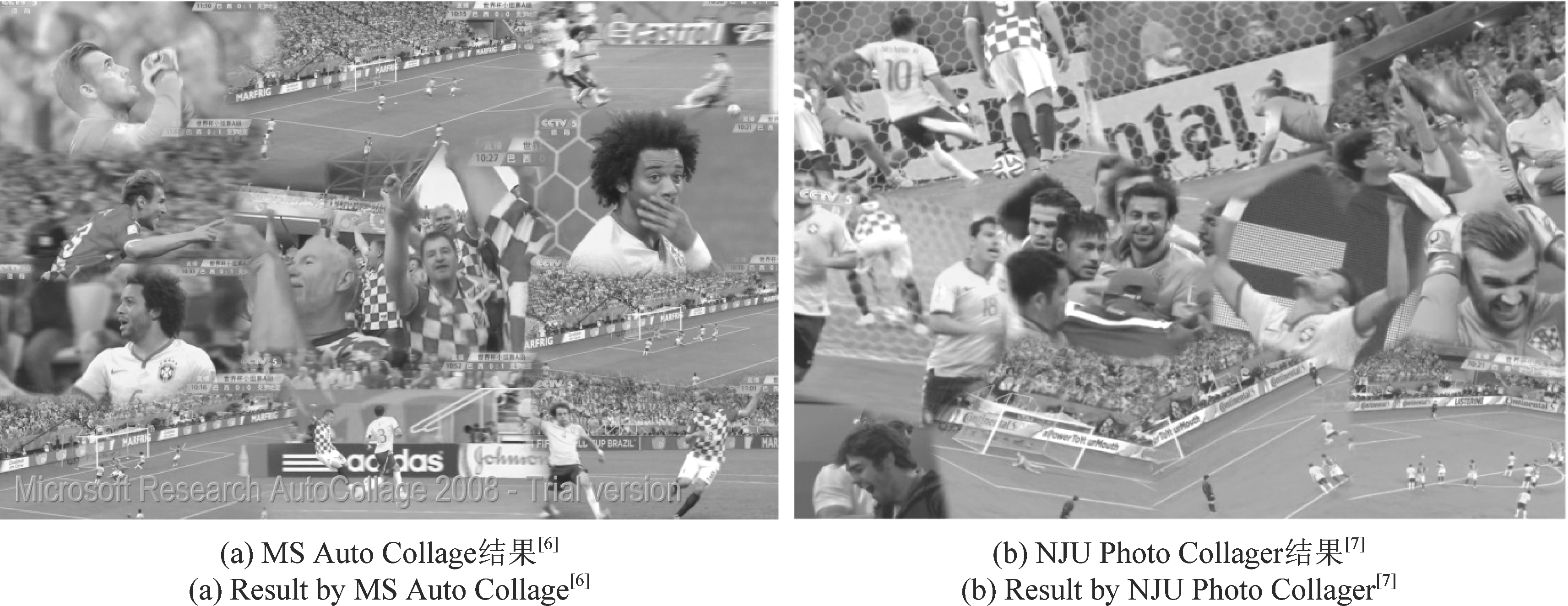

本文选取了2014年世界杯比赛中巴西vs克罗地亚录像视频作为实验数据,取最精彩的两段进球事件生成拼图摘要,并将拼图摘要与MS Auto Collage[6]和NJU Photo Collager[7]等传统随机拼图结果进行了比较分析。

4.1 拼图摘要与故事板、短视频回放比较分析

使用本文方法生成的一维叙事拼图摘要如图4所示,生成的二维叙事拼图摘要如图6所示。我们还使用部分关键帧原始图像生成了基于故事板的事件摘要,如图5所示。在生成故事板时使用了与拼图摘要相同大小的显示区域,由于所有关键帧的面积之和大于实际显示区域,导致有些叙事相关性较低的关键帧不能加入到故事板中,因此相对于故事板视频摘要,拼图摘要在保证显著性内容能够充分显示并且具有叙事逻辑性的前提下,对显示区域的需求比故事板小得多。另外,同样两段进球短视频,在新浪足球新闻频道下载各为1.29 M和5.29 M,以分辨率640×368和频率15帧/秒编码。而拼图摘要在包含一个短视频中的主要语义内容的情况下文件大小分别只有274 kB和216 kB,具有大大节约网络流量的优势。

4.2 拼图摘要与随机拼图方案比较

随机拼图软件如MS Auto Collage[6](图7(a))和NJU Photo Collager[7](图7(b))都具有很强的通用性,能够在有限的空间区域内,对任意个人图像集或视频关键帧生成结构紧凑,艺术效果丰富,图像清晰,过渡平滑的拼图封面。但是这些拼图算法均没有考虑叙事逻辑,仅仅保留了事件画面的娱乐因素和美学因素,根据显著性权值排列叙事内容,不考虑时-空约束,最后的拼图结果无法分辨究竟是如何进球以及谁进球等叙事语义。因此,传统随机拼图软件忽视了对时-空事件的叙事组织,仅仅适用于散乱图像集的摘要生成,不能直接应用于体育视频如足球视频等具有强时-空特性的节目内容生成拼图显示。

图4 本文方法生成的基于一维时序网格的叙事摘要:在有限的显示区域内容纳了较多的感兴趣区域内容,而且画面排放遵循了进球事件的先后时序,包含进球过程中双方球员的表情动作,叙事内容完整一致

Fig.4 The 1-D narrative summary produced by the proposed algorithm: More content including in the regions of interest are presented in a limit display area, while the spatial layout is coherent to temporal order of the goal event, so that narration integrity is achieved in this case

图5 传统故事板摘要:同样区域内只能排下四幅画面,内容丢失严重,叙事性差

Fig.5 Traditional storyboard based summary: Only 4 pictures are laid in the same display area, then most of key frames miss and narration ability is hurt

图6 基于二维时序网格的叙事摘要:二维网格按照从左至右,从上至下的顺序排列两次事件的感兴趣区域内容,能够清晰呈现两次进球事件的时-空对象

Fig.6 The 2-D narrative summary produced by the proposed algorithm: The content included in regions of interest is laid in display grid as the order of from left to right and from up to down, which clearly presents the temporal-spatial objects in two goal events

而我们提出的基于时序网格的叙事性拼图(图6)在产生拼图艺术效果时,不仅考虑了拼图的语义最大化,还保留了语义事件的叙事关系,每一个进球精彩事件可以按照进球的时间先后顺序呈现给用户,观众很容易就可以了解到进球者是谁,进球后双方球员的表情神态,充分保留了精彩事件内在的时序逻辑和叙事语义,因此更适合移动设备中以最短时间欣赏最多体育比赛内容的应用场景。

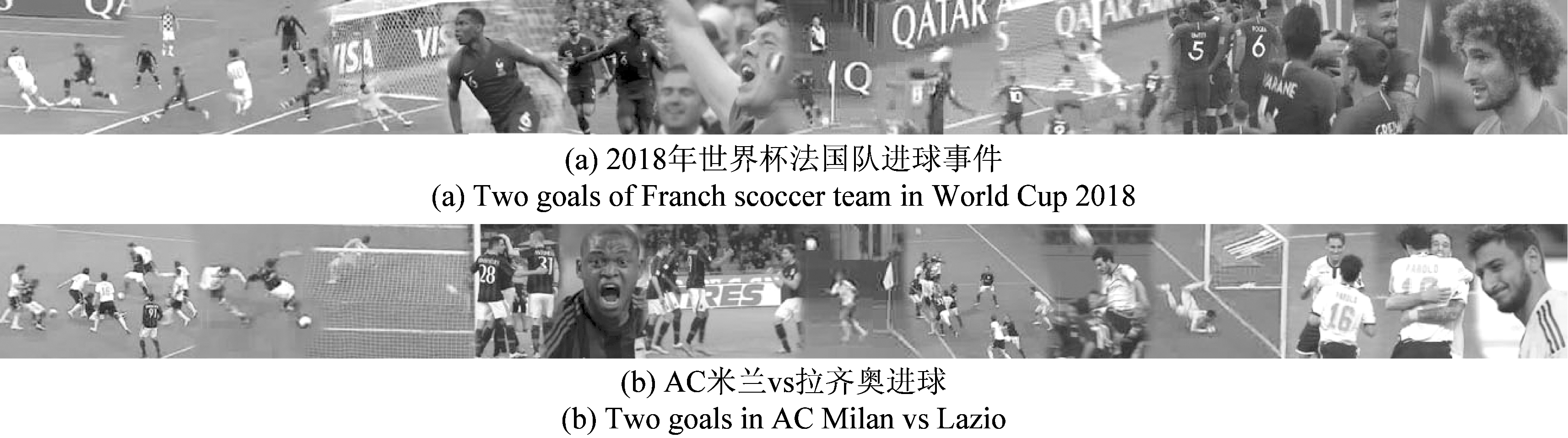

为了进一步展示本文所提叙事拼图算法的叙事效果,本文选取了2018年世界杯法国队与比利时和克罗地亚分别在半决赛和决赛期间的两次精彩进球事件生成了叙事拼图摘要(图8(a)和图9(a))。另选取了意甲联赛“AC米兰vs拉齐奥”中的两次精彩进球事件生成了叙事拼图摘要(图8(b)和图9(b))。从图8展示的一维拼图和图9展示的二维拼图我们均可以看出,本文提出的叙事拼图摘要算法能够用单幅图片较好地叙述足球比赛事件中正在发生的精彩事件。

图7 随机拼图方法生成的结果

Fig.7 The results of randomized video collage methods

图8 基于一维时序网格的叙事摘要

Fig.8 The 1-D narrative summary produced by the proposed algorithm

图9 基于二维时序网格的叙事摘要

Fig.9 The 2-D narrative summaries produced by the proposed algorithm

5 结论

当足球视频精彩事件被自动检测和提取出来后,就要在移动终端显示性能约束和网络流量约束下考虑使用何种方式呈现事件内容。本文提出的拼图摘要方法所生成的精彩事件拼图包含了丰富的语义内容和语义结构,基于领域知识提取精彩事件片段和图像感兴趣区域具有较高的准确性,基于时序网格排放语义内容保持了事件内在的叙事逻辑,最终生成的摘要拼图在浏览时间和传输效率上大大优于传统事件片段回放,在单位显示区域内包含的叙事内容大大超过故事板。本文所提出的叙事性拼图摘要算法当前只对足球视频进行了应用研究,将来还会进一步扩展到其他体育视频摘要;另外还会进一步优化显著性区域融合算法,使得本文画面质量得到进一步提高。

[1] ![]() J, Bailer W, Schoeffmann K, et al. On Influential Trends in Interactive Video Retrieval: Video Browser Showdown 2015-2017[J]. IEEE Transactions on Multimedia, 2018, 20(12): 3361-3376.

J, Bailer W, Schoeffmann K, et al. On Influential Trends in Interactive Video Retrieval: Video Browser Showdown 2015-2017[J]. IEEE Transactions on Multimedia, 2018, 20(12): 3361-3376.

[2] Yin Y, Thapliya R, Zimmermann R. Encoded Semantic Tree for Automatic User Profiling Applied to Personalized Video Summarization[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2018, 28(1): 181-192.

[3] Li X, Zhao B, Lu X. Key Frame Extraction in the Summary Space[J]. IEEE Transactions on Cybernetics, 2018, 48(6): 1923-1934.

[4] 朱树明, 王凤随, 程海鹰. HEVC压缩域的视频摘要关键帧提取方法[J]. 信号处理, 2019, 35(3): 481- 489.

Zhu Shuming, Wang Fengsui, Cheng Haiying. Video Summarization Key Frame Extraction Method for HEVC Compressed Domain[J]. Journal of Signal Processing, 2019, 35(3): 481- 489.(in Chinese)

[5] Liu Tie, Wang Jingdong, Sun Jian, et al. Picture Collage[J]. IEEE Transactions on Multimedia, 2009, 11(7): 1225-1239.

[6] Rother C, Bordeaux L, Hamadi Y, et al. Auto Collage[J]. ACM Transactions on Graphics, 2006, 25(3): 847- 852.

[7] Liu Lingjie, Zhang Hongjie, Jing Guanmei, et al. Correlation-preserving Photo Collage[J]. IEEE Transactions on Visualization and Computer Graphics, 2018, 24(6): 1956-1968.

[8] Huang H, Zhang L, Zhang H C. Arcimboldo-like Collage Using Internet Images[J]. ACM Transactions on Graphics, 2011, 30(6): 155: 1-7.

[9] Wang T, Hua X S, Liu X L, et al. Video collage: A novel Presentation of Video Sequence[C]∥IEEE ICME 2007, 2007: 1479-1482.

[10] Mei T, Yang B, Yang S Q, et al. Video Collage: Presenting a Video Sequence Using a Single Image[J]. The Visual Computer, 2009, 25(1): 39-51.

[11] Fang Fei, Yi Miao, Feng Hui, et al. Narrative Collage of Image Collections by Scene Graph Recombination[J]. IEEE Transactions on Visualization and Computer Graphics(TVCG), 2018, 24(9): 2559-2572.

[12] Wang Z, Yu J, He Y. Soccer Video Event Annotation by Synchronization of Attack-Defense Clips and Match Reports With Coarse-Grained Time Information[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2017, 27(5): 1104-1117.

[13] 于俊清, 王宁. 基于子窗口区域的足球视频镜头分类[J]. 中国图像图形学报, 2008, 13(7): 1347-1352.

Yu Junqing, Wang Ning. Shot Classification for Soccer Video Based on Sub window Region[J]. Journal of Image and Graphics, 2008, 13(7): 1347-1352.(in Chinese)

[14] Yang Ying, Li Danyang. Robust player detection and tracking in broadcast soccer video based on enhanced particle filter[J]. Journal of Visual Communication and Image Representation, 2017, 46(C): 81-94.

[15] Yu Junqing, Tang Yang, Wang Zhifang. Playfield and Ball Detection in Soccer Video[J]. Advances in Visual Computing, Springer Berlin, Heidelberg, 2007, 4842: 387-396.

[16] Yang Shuo, Xiong Yuanjun, Loy Chen Change, et al. Face Detection through Scale-Friendly Deep Convolutional Networks[EB/OL]. arXiv preprint arXiv: 1706.02863, 2017.

[17] Cong Runmin, Lei Jianjun, Fu Huazhu, et al. Review of Visual Saliency Detection with Comprehensive Information[J]. IEEE TCSVT(Early Access), 2018.

[18] Cheng M, Mitra N J, Huang X, et al. Global Contrast Based Salient Region Detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 569-582.

[19] Hu Shenghong. Personalized Content Adaptation Using Multimodal Highlights of Soccer Video[C]∥Advances in Multimedia Information Processing-PCM 2010. Lecture Notes in Computer Science, Springer, Berlin, Heidelberg, 2010, 6297: 537-548.

[20] 胡胜红, 谭生龙, 桂超, 等. 基于记分牌时间和新闻文本提取足球视频精彩事件[J]. 济南大学学报:自然科学版, 2016, 30(5): 321-327.

Hu Shenghong, Tan Shenglong, Gui Chao, et al. Based on time in scoreboard to extract soccer highlights with multi-modal analysis[J]. Journal of University of Jinan: Sci. & Tech., 2016, 30(5): 321-327.(in Chinese)

[21] 程姗, 曾焕强, 陈婧, 等. 基于特征融合的无参考屏幕图像质量评价[J]. 信号处理, 2019, 35(3): 419- 425.

Cheng Shan, Zeng Huanqiang, Chen Jing, et al. Feature fusion based no reference quality assessment for screen content image[J]. Journal of Signal Processing, 2019, 35(3): 419- 425.(in Chinese)