1 引言

信息时代下,音乐信息数量的不断增长,使得音乐信息的检索、识别、处理的需求不断增加,然而伴奏音乐与人声之间的相关性,使得伴奏和人声难以单独提取出来处理,这给音乐信息处理带来巨大的障碍。音乐信号中的人声伴奏分离作为这些技术研究的前期处理,日益受到关注,具有重要的研究价值。

近年来,许多专家对音乐分离进行过深入的研究。Li和Hsu等分别利用基音估计[1-3]来产生声音音乐模板,Li利用幅度和相位信息进一步精确估计基音[2],以此来生成更精确的模板,再利用模板将歌声从混合音乐信号中提取出来,利用音乐伴奏模板提取出音乐伴奏。Huang利用语音信号的稀疏性和音乐伴奏的低秩性质,将混合信号幅度谱分离成一个稀疏矩阵和一个低秩矩阵[4],再利用二值模板实现声乐的分离。

One N等人提出谐波与冲击源分离算法(harmonic percussive source separation, HPSS)[5]将音乐信号分离成谐波声源和冲击声源,从而实现分离音乐的目的,但在分离时,此种方法易将鼓声等打击乐误认为是歌声,从而导致无法分离出完整的伴奏音乐。Rafii等人基于音乐伴奏具有一定的周期性这个先验知识,利用节拍谱来提取背景音乐,该技术称为重复模式提取(Repeat Pattern Extraction Technology, REPET)技术[6-9],同时Rafii根据音乐伴奏的局部自相似性做了改进,提出了自适应方法[10]和利用相似矩阵[11]来提取重复背景的模型,进一步提高了分离的精确度。上述学者所研究的分离方法都可以在一定程度上分离出伴奏音乐,但是算法的鲁棒性较差,对不同的音乐片段分离效果有差异。

在音乐信息检索中,已有一些专家使用二维傅里叶变换(two Dimension Fourier Transform, 2DFT)进行歌曲识别[12-13]和音乐分割[14]。Stöter和 FabianRobert[15]等人使用2DFT变换作为输入来进行声源分离,Pishdadian等人[16]使用多分辨率2DFT库代替固定大小的2DFT模板,进一步改进了这种分离方法,上述学者的工作都集中在区分声源的不同特性(如颤音等),利用2DFT在短音频中来分离具有相同基本频率的谐波源,都需要使用2DFT来创建更复杂的滤波器组。目前,多数学者利用音乐信号的稀疏性和周期性进行音乐分离,且分离算法的鲁棒性较差,很少有文献使用2DFT变换来进行伴奏音乐分离。

基于以上分析,本文提出了基于2DFT变换的音乐伴奏分离方法。首先对单通道音乐进行二维傅里叶变换,得到音乐的声谱图,利用图像滤波的方式确定周期性峰值位置,使用矩形窗构建掩蔽矩阵提取出音乐伴奏成分,再通过逆变换的方式,恢复出伴奏的时域信号。

2 二维傅里叶变换下的单通道音乐信号

2.1 二维傅里叶变换

二维傅里叶变换(two Dimension Fourier Transform, 2DFT)是图像处理的重要工具,用来处理二维图像信息,但是单通道音乐信号是一维信号,并不能直接应用二维傅里叶变换,因此本文方法首先对单通道音乐信号进行短时傅里叶变换,得到幅度谱之后,再将幅度谱进行2DFT变换。

设Xω,τ为单声道音频信号f(t)的短时傅里叶变换(STFT),Wω,τ=|Xω,τ|为其幅度谱,其中ω和τ为表示频率和时间的变量,二维傅里叶变换表示如下:

exp(-j2πuω/M)

(1)

其中F(u,ν)表示二维傅里叶变换后的音乐信号。

2.2 二维傅里叶变换下的单通道音乐信号

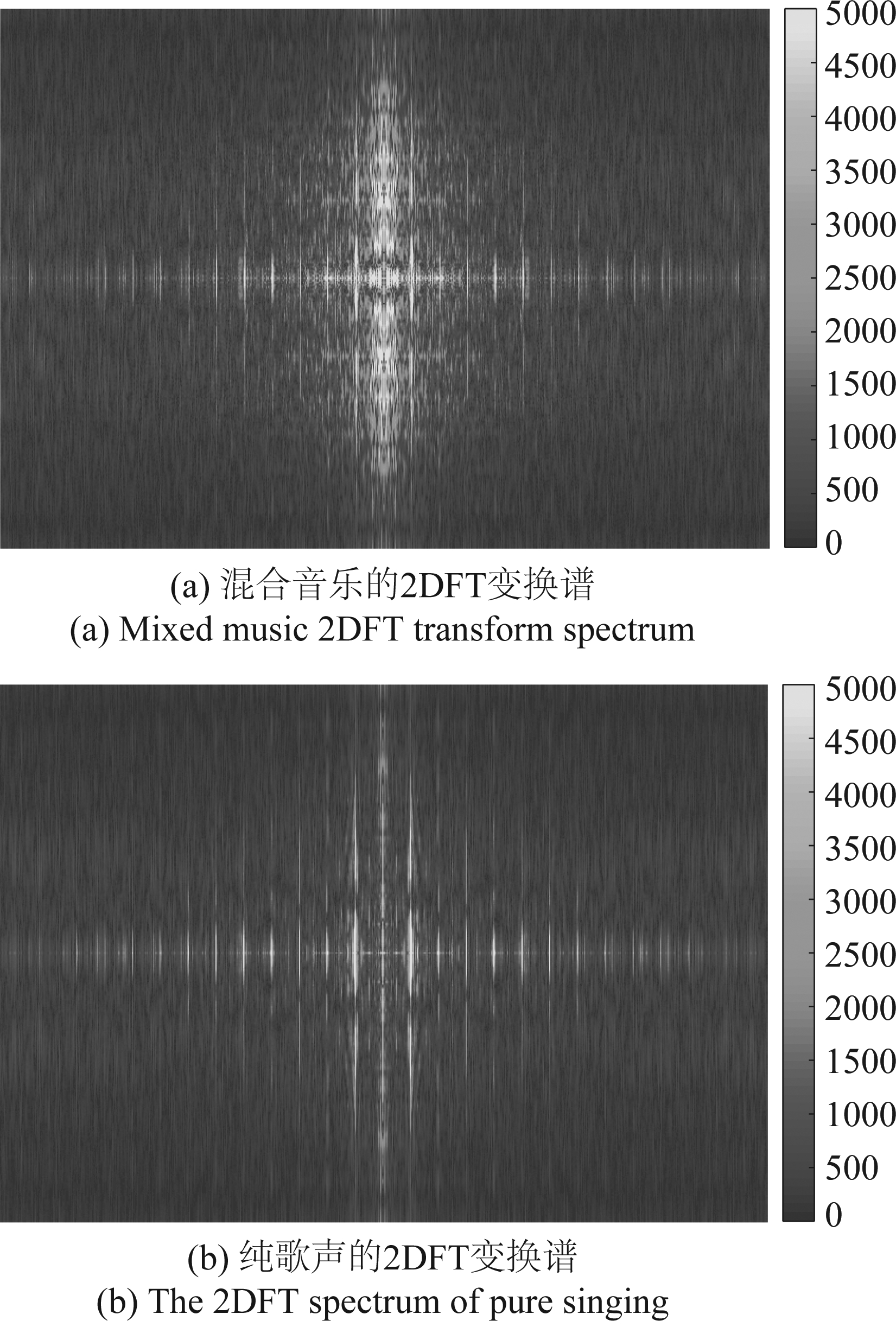

将一段音乐信号进行二维傅里叶变换之后的垂直和水平维度称为标度(scale)和速率(rate)。这些术语是从哺乳动物[17-19]的听觉系统研究中借鉴来的。在图1中,显示了混合音乐、纯歌声和纯伴奏的2DFT变换谱图。

图1 不同音乐信号的2DFT变换谱

Fig.1 2DFT transform spectrum of different music signals

由图1(b)可以看出,纯歌声的能量主要集中2DFT变换谱的中心区域,而歌声的能量则成条纹状从2DFT变换谱中心向两侧分布如图1(c)所示,混合音乐的2DFT变换谱则是纯歌声和纯音乐谱图的叠加如图1(a)所示。假如可以将混合音乐的2DFT变换谱分离成图1中(b)和(c)两图的形式,就可以分离出伴奏和歌声了。

3 基于2DFT变换的伴奏音乐分离方法

3.1 构建时频掩蔽模型

在构建时频掩蔽时,对混合音乐的2DFT变换谱沿水平方向定位峰值,将能量较高的亮条纹部分分离出来,实现歌声与伴奏分离的效果。选择峰值的方法就是将标度速率域中每个点周围的邻域内的最大值和最小值的差值和某个阈值进行比较,当差值大于阈值时,说明该邻域内存在的最大值点在能量上相比于其他点有剧烈增高,记录该点的位置,当将标度速率域内所有点做上述处理之后,保留出的所有位置点所组成的位置带即为2DFT变换谱中能量较大的亮条纹的位置。

本文方法将选取峰值的窗设置为简单的单维矩形窗,在标度方向只有一维,在速率方向上长度可变。矩形窗的长度越长,分离后的歌声容易泄露到伴奏中,反之,分离后的伴奏越容易泄露到歌声中。

2DFT变换谱中某一点表示为C=(sC,rC),N表示C点邻域矩形窗的长度,选择|F(u,ν)|的标准差γ作为判断邻域内差值的阈值, α表示矩形窗内|F(u,ν)|的变化范围,则有

(2)

歌声掩蔽矩阵可以由下面公式得出:

(3)

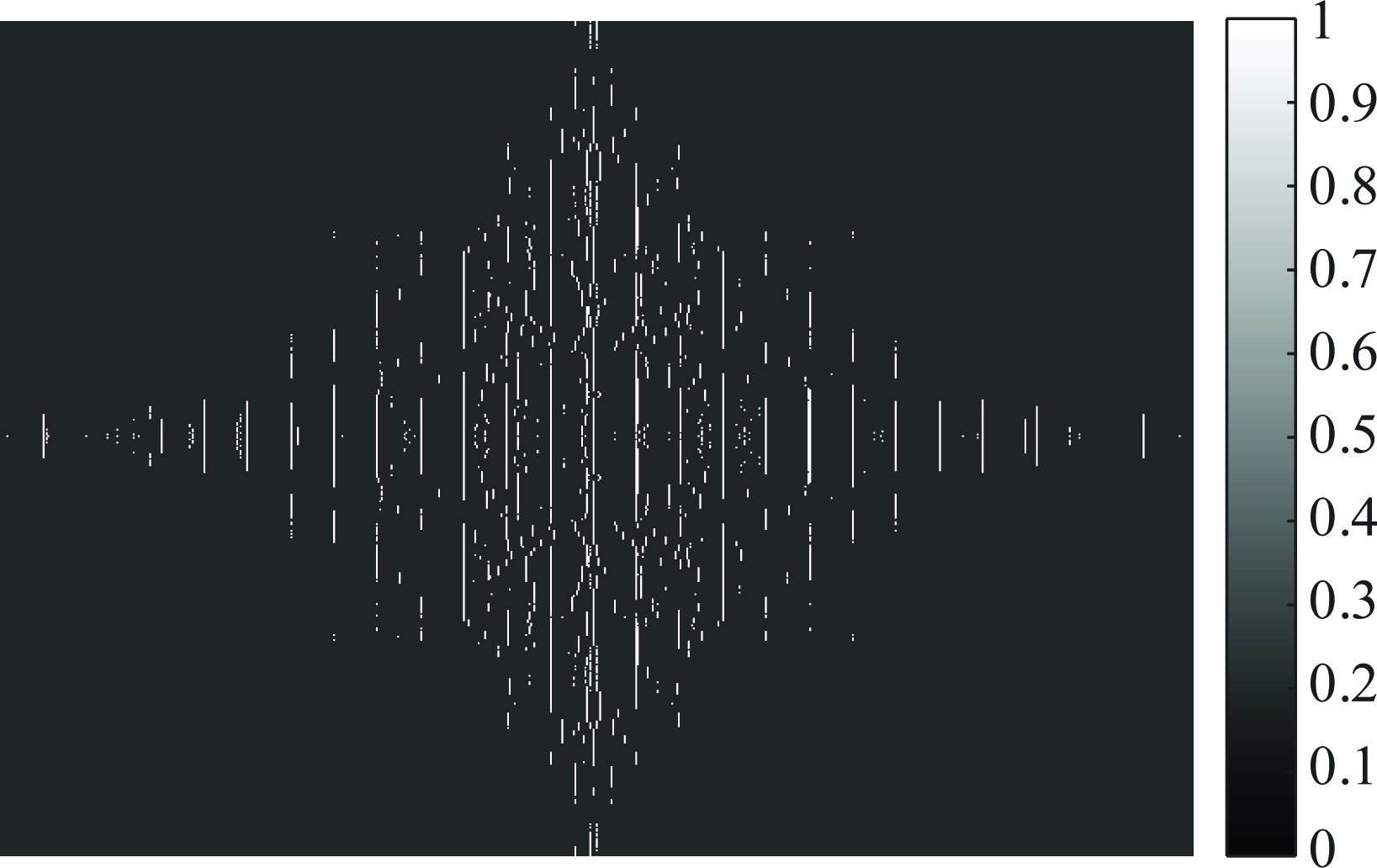

下图2为歌声的掩蔽矩阵。

图2 歌声的掩蔽矩阵

Fig.2 The masking matrix of the song

由图1中纯歌声和纯伴奏的2DFT变换谱可以看出,背景音乐的能量主要集中在谱中心带的位置,在此位置的歌声能量则比较低,因此在对掩蔽矩阵进行处理,去除中心带位置的掩蔽值,处理之后的掩蔽矩阵图如下图3所示。

图3 去除中心带之后的掩蔽矩阵

Fig.3 Remove the center band of masking matrix

背景音乐的掩蔽矩阵可通过下式计算得出:

Mbg(s,r)=1-Mfg(s,r)

(4)

3.2 利用掩蔽矩阵实现音乐伴奏分离

由歌声的掩蔽矩阵和混合音乐的2DFT变换谱,通过二维傅里叶逆变换可以得到伴奏的短时傅里叶谱,公式如下:

|Xbg(h,ν)|=IFT2D{Mbg(s,r)·F(s,r)}

(5)

|Xfg(h,ν)|=IFT2D{Mfg(s,r)·F(s,r)}

(6)

伴奏的时频掩蔽矩阵可以通过下式来计算

(7)

最后,伴奏的时域信号可以由时频掩蔽Mbg(h,ν)和混合信号的短时傅里叶谱Xfg(h,ν)得到

xbg(t)=ISTFT{Mbg(h,ν)·X(h,ν)}

(8)

其中ISTFT{·}表示短时傅里叶逆变换。

4 实验结果与分析

4.1 实验数据与性能指标

实验中的音乐数据集采用Hsu实验室公开发布的音乐数据集MIR-1K(http:∥sites.google.com/site/unvoicedsoundseparation/mir-1k[OL])。该数据集由110首中国卡拉OK歌曲所专业剪切的1000个16 kHz采样的音乐片段,其中歌声部分由业余者录制,时长为4 s~13 s。

为了定量评价2DFT变换对音乐信号的分离效果,采用Févotte盲源分离工具箱(Blind Source Separation Evaluation, BSS_EVAL)[20]来判定改进算法的性能。工具箱提供了一组旨在量化源信号与其估计之间分离的质量的度量方法,其原理是将估计信号分解如下:

(9)

其中st arg et(t)表示为估计信号中属于源信号的部分,eint erf(t)表示由其他信号源所引起的估计误差,即估计信号中属于混合信号但不符合源信号的部分,eartif(t)表示由于算法本身所产生的系统噪声误差,enoise(t)表示观测信号中包含的噪声干扰误差。

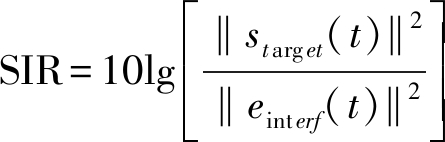

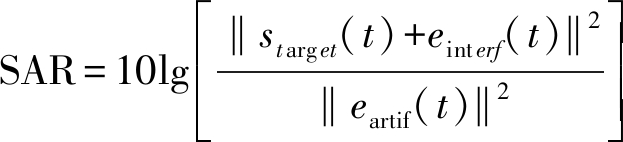

由于在大多数音乐分离中均可忽略噪声的影响,所以enoise(t)部分可以直接省去。因此本文使用以下性能指标,即信号干扰比(source-to-interference ratio,SIR),系统误差比(source-to-artifacts ratio,SAR),定义式如下:

(10)

(11)

其中SIR代表算法的分离度,SAR分别表示算法的鲁棒性, SIR和SAR的值越高,表示算法的性能越好。

4.2 实验结果与分析

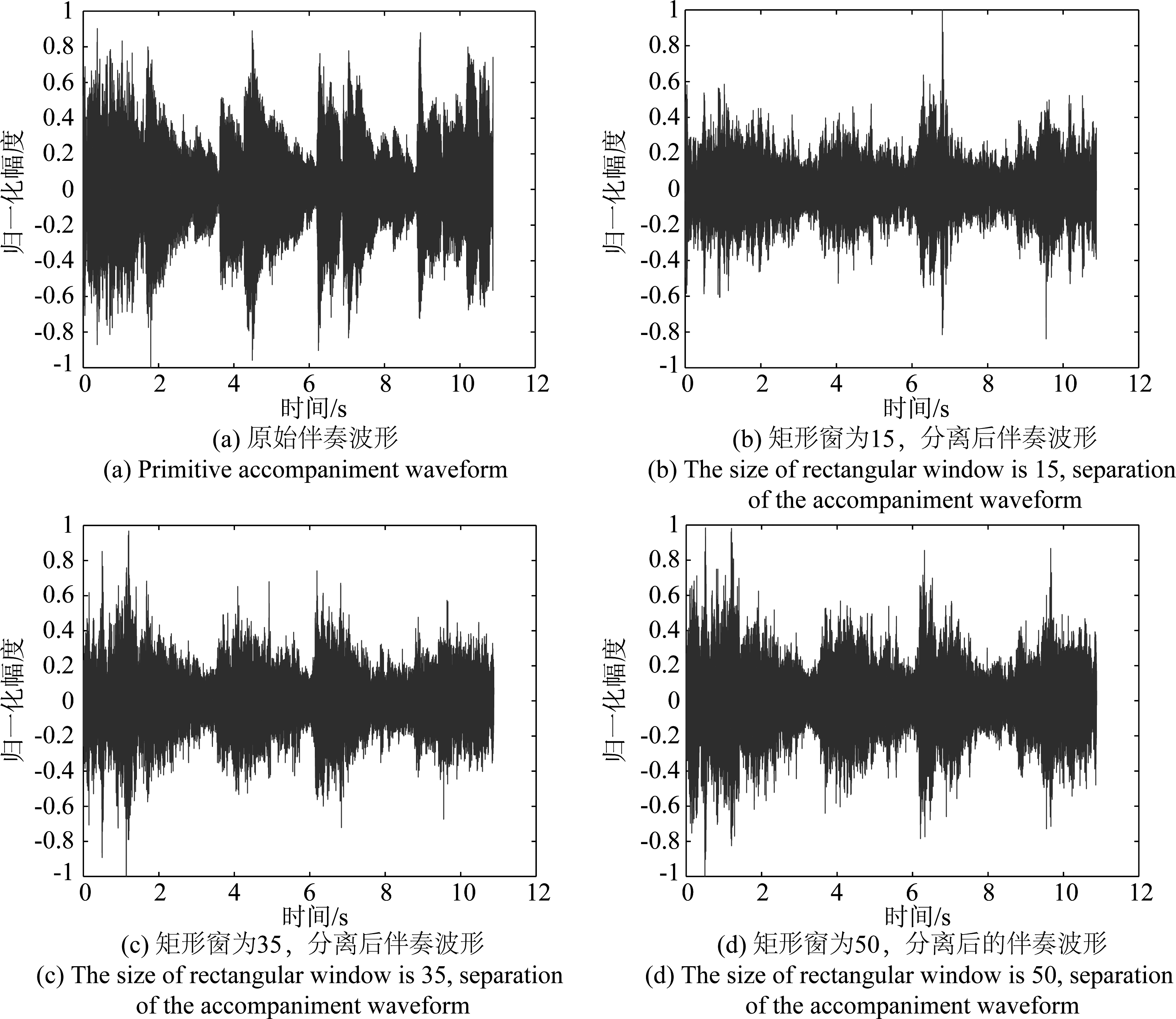

随机抽取MIR-1K中1首音乐片段geniusturtle_5_01.wav,使用本文方法进行伴奏分离,其分离前后的波形对比如图4所示。

图4 geniusturtle_5_01.wav分离前后的波形对比图

Fig.4 Comparison of waveforms before and after separation

由图4可以看出,经过分离后的伴奏和原始伴奏的波形在形状上基本一致,但是分离后的伴奏波形幅度上有削减,这是由于在矩形窗的选择上窗长太小导致的,可以通过调整矩形窗的长度来改善。

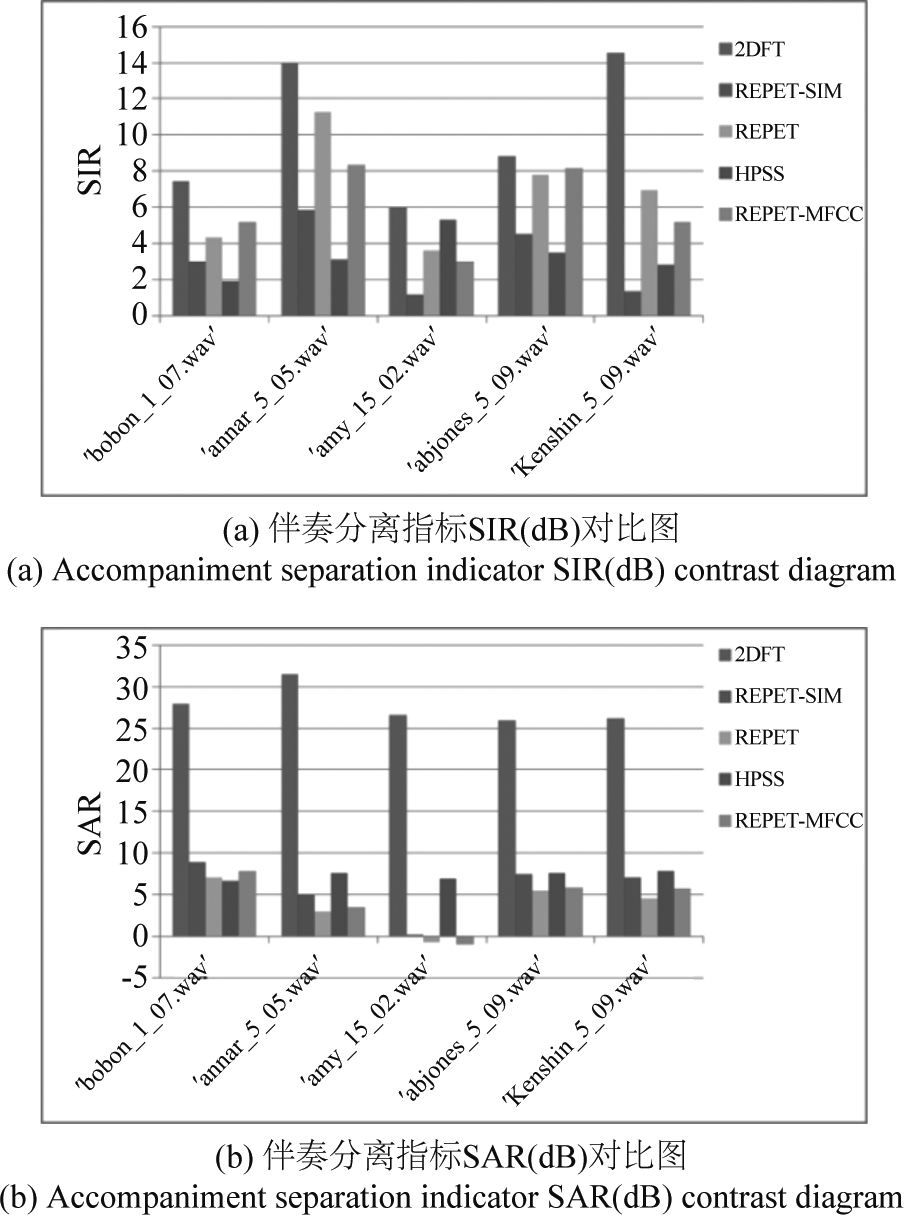

在验证本文方法能有效地分离伴奏音乐之后,接着说明本文方法的优越性,随机选取MIR-1K库中5首音乐片段进行分离后计算其SIR、SAR值(抽取到的片段为‘bobon_1_07.wav’,‘annar_5_05.wav’,‘amy_15_02.wav’,‘abjones_5_09.wav’,‘Kenshin_5_09.wav’),矩形窗长度为100,结果如图5所示。

图5 随机5首音乐片段分离性能指标对比图

Fig.5 Comparison chart of random 5 music segment separation performance indexes

由图5可以看出,在分离音乐伴奏时,本文2DFT算法在分离指标SIR、SAR上均优于HPSS和REPET及其改进算法。本文2DFT算法在SIR上比其他传统算法至少有2 dB的提升,在SAR上,本文算法保持在27 dB左右,对比其他算法提升了至少15 dB。

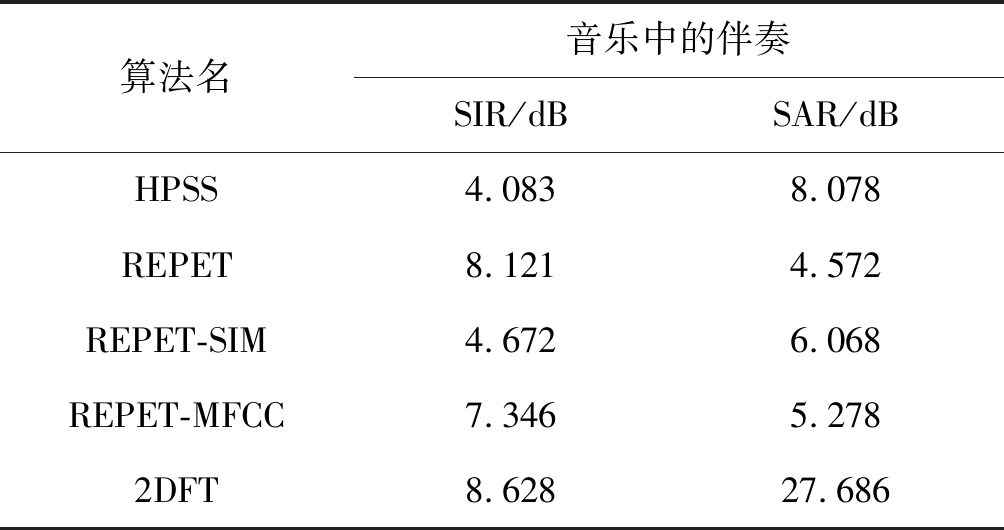

对MIR-1K中的500首音乐片段使用本文2DFT算法进行分离(矩形窗长度为100),计算其SIR、SAR平均值,并与HPSS算法、REPET及其改进算法进行比较,其结果如表1所示。

表1 MIR-1K 中500首音乐片段伴奏 分离性能比较(平均结果)

Tab.1 Comparison of the separation performance of 500 music fragments in MIR-1K (average results)

算法名音乐中的伴奏SIR/dBSAR/dBHPSS4.0838.078REPET8.1214.572REPET-SIM4.6726.068REPET-MFCC7.3465.2782DFT8.62827.686

从表1可以看出,本文2DFT算法在分离伴奏时,在SIR上比HPSS提升4 dB左右,对比REPET及其改进算法,SIR提升0.5~4 dB左右;在SAR数值上,本文算法SAR为27 dB,远优于其他算法。

5 结论

针对音乐分离中的伴奏分离,本文提出了一种基于2DFT变换的伴奏分离方法。该方法首先通过二维傅里叶变换将单维的音乐信号变成二维2DFT谱,再利用图像滤波的方式对声谱图进行处理,使用矩形窗确定能量峰值的位置,构造掩蔽矩阵提取出音乐伴奏成分,最后通过逆变换的方式,恢复出伴奏的时域信号。仿真实验表明,基于2DFT变换的音乐伴奏分离方法,不需要创建复杂的滤波器组,对比其他分离方法,分离度SIR提高0.5~4 dB左右,鲁棒性SAR提升超过15 dB,具有一定的优越性。

[1] Li Y, Wang D L. Separation of singing voice from music accompaniment for monaural recordings[J].IEEE Transactions on Audio, Speech, and Language Processing, 2007, 15(4): 1475-1487.

[2] Li Y, Woodruff J, Wang D L. Monaural musical sound separation based on pitch and common amplitude modulation[J].IEEE Transactions on Audio, Speech, and Language Processing, 2009, 17(7): 1361-1371.

[3] Hsu C L, Jang J S R. On the improvement of singing voice separation for monaural recordings using the MIR-1K dataset[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2010, 18(2): 310-319.

[4] Huang P S, Chen S D, Smaragdis P. Singing-voice separation from monaural recordings using robust principal component analysis[C]∥2012 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2012: 57- 60.

[5] One N, Miyamoto K, Roux J L, et al. Separation of a monaural audio signal into harmonic/percussive component by complementary diffusion on spectrogram[C]∥16th European Signal Processing Conference, 2008: 1- 4.

[6] Rafii Z, Pardo B. A simple music/voice separation method based on the extraction of the repeating musical structure[C]∥2011 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2011: 221-224.

[7] Rafii Z, Pardo B. Repeating pattern extraction technique (REPET): A simple method for music/voice separation[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2013, 21(1): 73- 84.

[8] 张天骐, 徐昕, 吴旺军, 等. 多反复结构模型的精确音乐分离方法[J]. 声学学报, 2016,41(1): 135-142.

Zhang Tianqi, Xu Xin, Wu Wangjun, et al. Music/vice separation based on the multi-repeating structure of mel-frequence cepstrum coefficients[J]. Acta Acustica, 2016, 41(1): 135-142.(in Chinese)

[9] Rafii Z, Pardo B. Online REPET-SIM for real-time speech enhancement[C]∥IEEE International Conference on Acoustics. IEEE, 2016.

[10]Liutkus A, Rafii Z, Badeau R. Adaptive filtering for music/voice separation exploiting the repeating musical structure[C]∥2012 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2012: 53-56.

[11]Rafii Z, Pardo B. Music/Voice Separation Using the Similarity Matrix[C]∥13th International Society for Music Information Retrieval(ISMIR), 2012: 583-588.

[12]Seetharaman P, Rafii Z, Cover song identification with 2d fourier transform sequences[C]∥2017 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2017: 616- 620

[13]Bertin-Mahieux T, Ellis D P. Large-scale cover song recognition using the 2D Fourier transform magnitude[C]∥13th International Society for Music Information Retrieval Conference, 2012.

[14]Nieto O, Bello J P. Music segment similarity using 2d-fourier magnitude coefficients[C]∥2014 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2014: 664- 668.

[15]Stöter F R, Liutkus A, Badeau R, et al. Common Fate Model for Unison source Separation[C]∥IEEE International Conference on Acoustics Speech and Signal Processing (ICASSP). IEEE, 2016: 126-130.

[16]Pishdadian F, Pardo B, Liutkus A. A multi-resolution approach to common fate-based audio separation[C]∥2017 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2017: 566-570.

[17]Chi T, Ru P, Shamma S A. Multiresolution spectrotemporal analysis of complex sounds[J]. The Journal of the Acoustical Society of America, 2005, 118(2): 887-906.

[18]Patterson R D, Allerhand M H, Giguère C. Time-domain modeling of peripheral auditory processing: A modular architecture and a software platform[J]. Journal of the Acoustical Society of America, 1995, 98(4): 1890-1894.

[19]Ru P, Shamma S A. Representation of musical timbre in the auditory cortex[J]. Journal of New Music Research, 1997, 26(2): 154-169.

[20]Vincent E, Gribonval R, Fevotte C. Performance measurement in blind audio source separation[J]. IEEE Transactions on Audio Speech & Language Processing, 2006, 14(4): 1462-1469.