1 引言

研究结果表明[1- 4],人脸平均、对称性和性二态性是影响人脸美丽研究的重要因素,但对美的普遍定义仍然难以明确。最近,研究者采用计算机视觉和机器学习方法对自动人脸美丽预测进行了深入研究[5- 8],使人脸美丽预测可广泛应用于许多方面,例如,推荐系统、图像检索和人脸美化[9]。

多数研究者通常使用手动设计特征和传统机器学习方法来进行人脸美丽预测研究。Eisenthal等[15]采用特征脸作为人脸美丽特征,使用KNN (K-Nearest Neighbor)、SVM(support vector machine)等机器学习方法进行分类。Kagian等[16]结合几何和外观特征来进行人脸美丽预测。Yan等[17]提出用于人脸美丽评价的代价敏感次序回归模型。Chiang等[18]提取三维人脸几何特征来训练模糊神经网络,并且实现了高精度。为了降低背景干扰,Gan等[19]用提取图像的纹理特征来训练浅层网络CRBM(Convolutional Restricted Boltzmann Machine),在SVM分类和回归中取得了较好结果。上述研究表明,人脸特征的提取对人脸美丽预测和分析至关重要。

近年来,卷积神经网络(Convolution Neural Network,CNN)被证明是学习人脸美丽高级特征的有效方法。Xie等[20]公布了一个包含500张图像的女性人脸美丽数据库(SCUT-FBP),并设计一个多层CNN模型;实验证明了CNN学习效果大幅度优于传统学习方法。Xu等[21]基于CNN网络,提出多种特征图像级联微调的训练方法;基于SCUT-FBP数据库的实验结果表明,多种特征图像级联微调训练法优于基于原图像训练CNN模型的方法。Jiang等[28]提出基于轻量级卷积神经网络的人脸美丽预测,通过减少网络层数和输入图像尺寸来提高模型的实时性。Fan等[29]使用深度残差网络对标签分布进行学习,将传统监督学习中的单一标签问题转换为学习标签分布问题,并以此提高预测精度。上述研究均建立在小数据库上,而Chen等[22]用大量实验说明了数据对人脸美丽模型训练的重要性;Liang等[30]新公布了一个人脸美丽数据库(SCUT-FBP5500),在原SCUT-FBP的500张人脸图像基础上扩增到5500张,证明了数据对人脸美丽模型训练的重要性。在小规模数据库上进行训练,往往会导致训练模型出现过拟合现象,从而使测试结果不理想。

综上所述,卷积神经网络在人脸美丽预测研究上具有较大优势。然而,人脸美丽预测精度仍有待提高,其主要原因包括:(1)脸部外观变化大大影响人脸美丽评价结果,例如化妆、表情等;(2)缺乏用于评估的大规模人脸美丽数据库。目前,研究者都是在各自搭建的小规模数据库上进行实验,结果不具普适性。针对这些问题,本文采用数据增强技术来扩大数据库的规模,以此解决数据不足问题。由于CNN提取的是全局特征,忽略了人脸的局部信息,而LBP算子提取的人脸图像具有局部纹理特征,通过在CNN网络中加入LBP纹理图像,学习LBP纹理图像的局部结构特征。为此,本文提出一种结合局部二值模式和卷积神经网络的人脸美丽预测新方法,以此提升人脸美丽预测精度。

2 相关工作

2.1 LBP算子

LBP是Ojala[11]提出的一种用于描述图像局部纹理特征的算子。在图像的一个3×3邻域中,以此邻域的中心像素值为阈值,将该邻域的8个像素值依次与该阈值进行比较,如果邻域的某像素值比该阈值大,则将其置为1,反之置为0。然后,将局部邻域的8个像素点通过比较后产生的“0”和“1”二进制数按一定的顺序连接起来,形成一种编码的形式。最后,将这些二进制数进行加权求和,转化为十进制数来表示该邻域中心点的LBP值。LBP算子的计算为

(1)

其中,![]() (xc,yc)为中心像素点的坐标,gp(p=0,1,…,7)表示中心邻域的8个像素值,gc为中心像素值。

(xc,yc)为中心像素点的坐标,gp(p=0,1,…,7)表示中心邻域的8个像素值,gc为中心像素值。

CNN提取的人脸美丽特征忽略了人脸的局部结构特征,而且以像素级的人脸特征图作为CNN的输入,网络会因为光照影响而学到不利的特征表达。LBP特征具有光照不变性和灰度不变性等突出优点,广泛地应用于人脸识别、纹理分析、图像分类等领域。LBP特征是一种在灰度范围内非常有效的纹理谱描述符,分类能力强,计算效率高,对单调的灰度变化具有不变性,并且能结合图像的整体特征。

2.2 卷积神经网络

卷积神经网络是一个包含输入层、卷积层、采样层、全连接层和输出层的端到端多层次网络结构;通过卷积运算逐层提取图像不同层次的语义信息,采用训练数据集来拟合调整网络的内部参数,从而实现分类特征的提取。卷积层对输入图像进行卷积运算,并加上偏置项,可获得初始特征提取的特征映射;将多个特征映射加权求和进行非线性激活函数处理,再进行池化操作,得到新的特征映射。经过多次卷积和池化操作得到从低层到高层的语义抽象,将获得的特征输入到全连接层,最终通过分类器完成分类和识别。

实际训练中无法保证训练集的高数量和高质量,通常在两个全连接层中间使用dropout函数来避免过拟合问题[10]。通过随机丢弃中间隐藏层节点,使网络处于不稳定状态,从而有效筛选出特征的关联性。因此,使用dropout函数能有效提高训练效率并解决过拟合问题,增强网络的泛化能力。

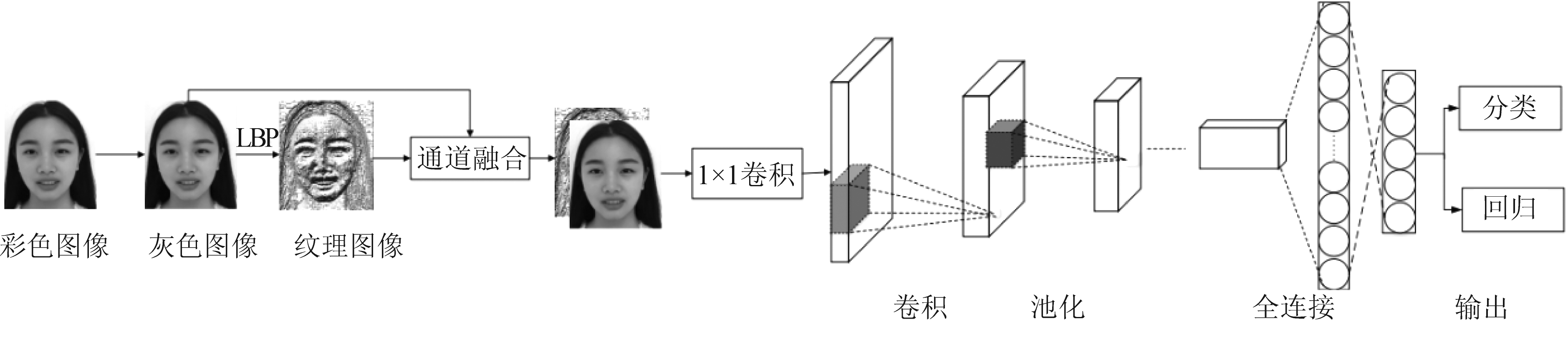

3 人脸美丽预测模型

基于局部二值模式和卷积神经网络的人脸美丽预测模型包含输入图像、通道融合、特征提取和输出结果四个部分,如图1所示。输入图像包含灰度图像和LBP纹理图像两个部分,将灰度图像和LBP纹理图像进行通道融合,融合后进行1×1卷积操作。然后,利用卷积神经网络进行特征提取。本文采用多个1×1卷积核对卷积层通道数实现升维或降维,减少训练参数的同时增加了模型深度,能有效提升网络的表达能力。最后,通过两个全连接层和损失函数进行人脸美丽预测。分类时,误差部分使用softmax损失函数进行人脸美丽等级预测;回归时,误差部分采用欧氏距离损失函数进行人脸美丽分数预测。

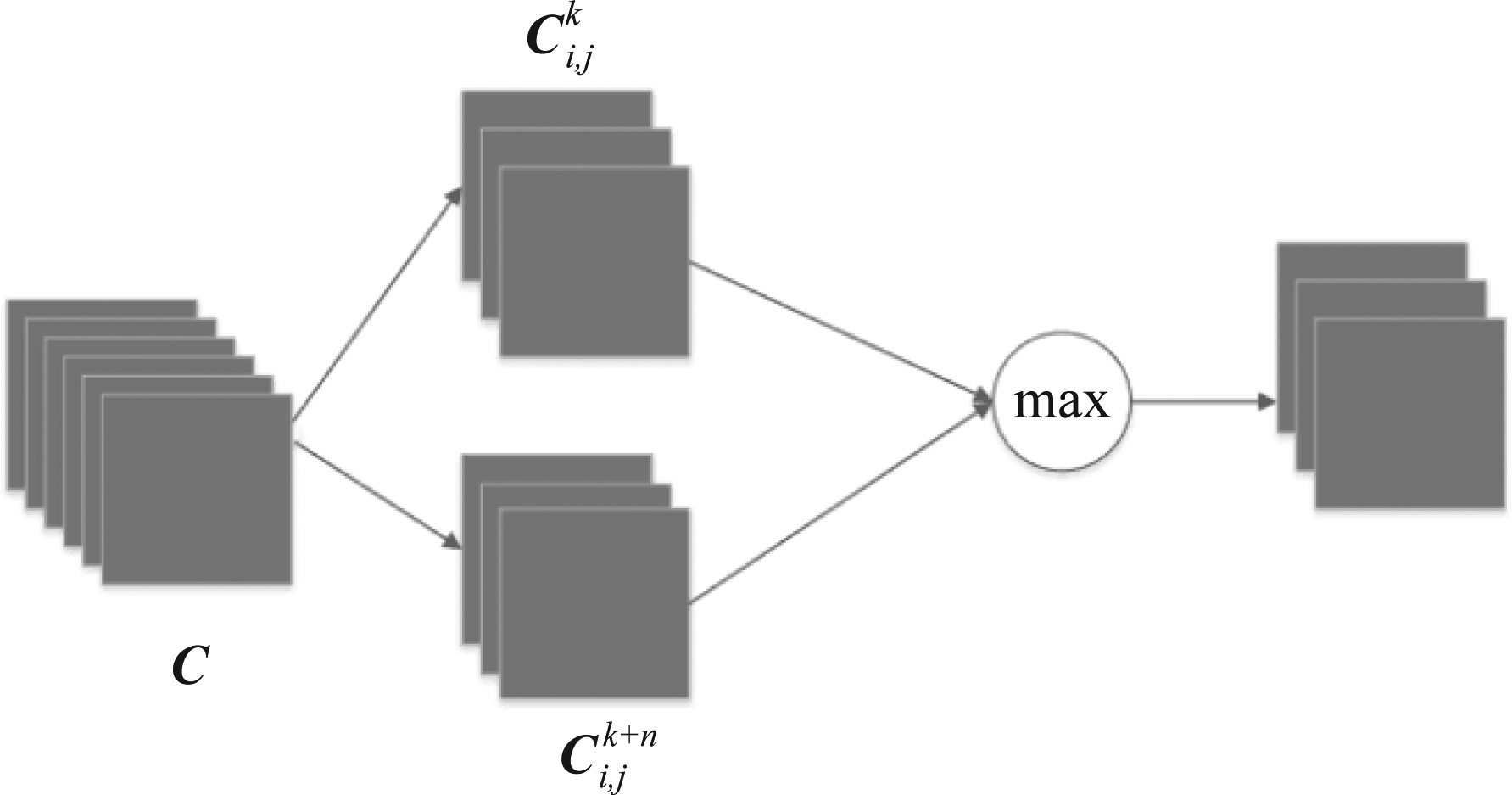

3.1 最大特征映射激活函数

为使网络提取的特征更加紧凑,增强网络的泛化能力,本文引用最大特征映射(Max-Feature-Map,MFM)激活函数。与整流线性单元(rectified linear unit,ReLU)不同,MFM通过竞争关系抑制神经元,具有特征紧凑、参数减少和速度提升的特点。

假设输出的卷积层为C∈Rh×w×2n,将C等分成两份,即![]() 如图2所示,MFM激活函数为

如图2所示,MFM激活函数为

(2)

其中,输出的卷积层个数为2n,1<i<h,1<j<w。MFM激活函数的梯度计算为

(3)

其中,1≤k′≤2n,且

(4)

MFM激活函数并不是普通的单输入、单输出函数,例如,sigmoid、ReLU,而是两个卷积的特征映射挑选节点之间的最大值。MFM激活函数采用分裂聚合法,不仅可获得紧凑的特征表示,还可实现变量选择、降维和稀疏梯度等功能。由式(3)可知,梯度被稀释为50%。此外,MFM激活函数还可当作两个卷积层间的稀疏连接,将信息稀疏地编码为一个特征空间。

图1 基于局部二值模式和卷积神经网络的人脸美丽预测模型

Fig.1 Facial beauty prediction model based on local binary pattern and convolutional neural network

图2 MFM激活函数原理图

Fig.2 MFM activation function schematic diagram

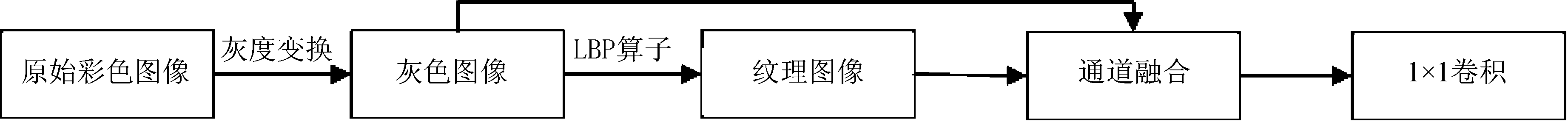

3.2 通道融合

为了提高人脸美丽预测的准确率,本文不仅学习人脸的原始图像信息,而且学习人脸的纹理图像信息。利用卷积神经网络来提取人脸图像更具结构性和层次性的美学特征,但由于其忽略了人脸的局部信息,而LBP算子提取的是局部特征,两者相结合,能学习到更有利的人脸美丽特征。灰度图像和纹理图像的融合模型如图3所示。

原始彩色图像经过灰度变换得到灰度图像;再利用LBP算子获取纹理图像,通过caffe的concat层将灰度图像和LBP纹理图像进行通道融合;然后,输入到1×1卷积层,采用1×1卷积操作进行通道特征图的线性组合,实现网络的跨通道信息组合;最后,利用卷积神经网络进行特征学习和预测。

4 实验结果与分析

4.1 人脸美丽数据库

本文在大规模亚洲女性人脸美丽数据库(LargeScale Asian Female Beauty Database, LSAFBD)上进行实验,该数据库由Gan等创建[13]。数据库搭建过程包括网络爬虫获取人脸图像、性别分类、图像剪裁和去重、以及人工评分s等。LSAFBD数据库有标签图像1万张,无标签图像8万张。图像大多为正面,但背景、姿势、年龄等均有变化。图像分为5类,其具体含义如表1所示。LSAFBD人脸美丽数据库图像标签符合高斯分布,极端美丽程度的图像少,正常颜值的图像多,与真实环境的人脸美丽程度分布一致。

由于缺少公开的大规模人脸美丽数据库,无法在其他数据库上验证所提模型算法的性能。因此,本文采用数据增强方法对LSAFBD人脸美丽数据库进行扩充。常用的数据增强方法有对齐、归一化、加噪声等,本文使用对齐和归一化方法对数据库图像进行扩充,将对齐图像和未对齐图像均作为训练集,使训练集增加了1倍。其中,训练集16000张,测试集2000张。

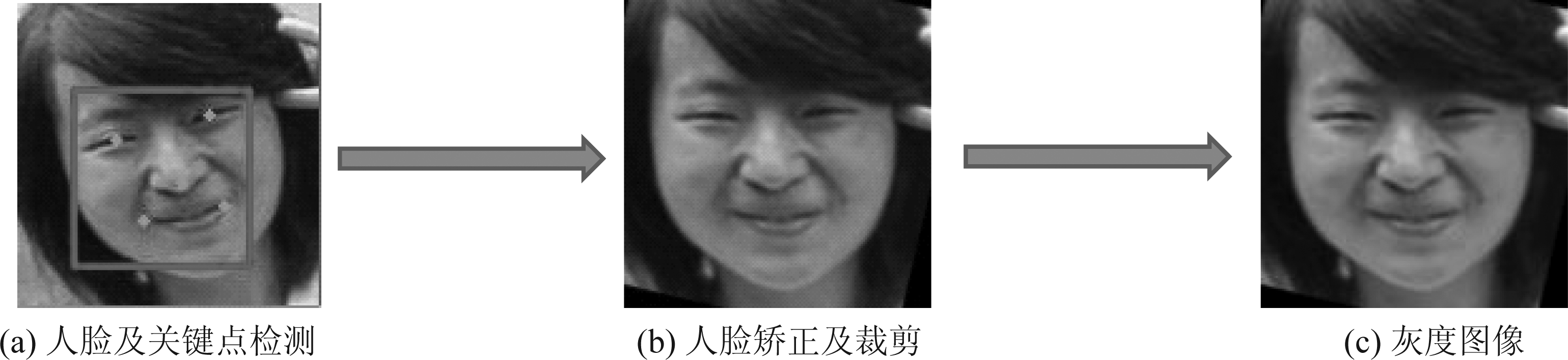

4.2 人脸图像预处理

人脸图像预处理是人脸美丽预测模型的第一步,如图4所示。首先,我们检测图像中的人脸及其关键点位置,如图4(a)所示,计算左、右眼中心关键点的连线和水平线的夹角,进行水平对齐;再把两眼的中心点与嘴巴中心点像素固定为48个像素,计算出图像的缩放比例,进行尺度归一化;然后,进行裁剪和灰度变换;最后,得到尺寸为144×144的灰度图像,如图4(c)所示。

图3 不同输入图像类型的融合模型

Fig.3 Fusion model of different input image types

表1 人脸图像美丽标签及含义

Tab.1 Facial image’s beauty label and meaning

美丽标签12345表示含义极不具有吸引力不具有吸引力一般较有吸引力极有吸引力

图4 人脸图像预处理过程

Fig.4 Face image preprocessing

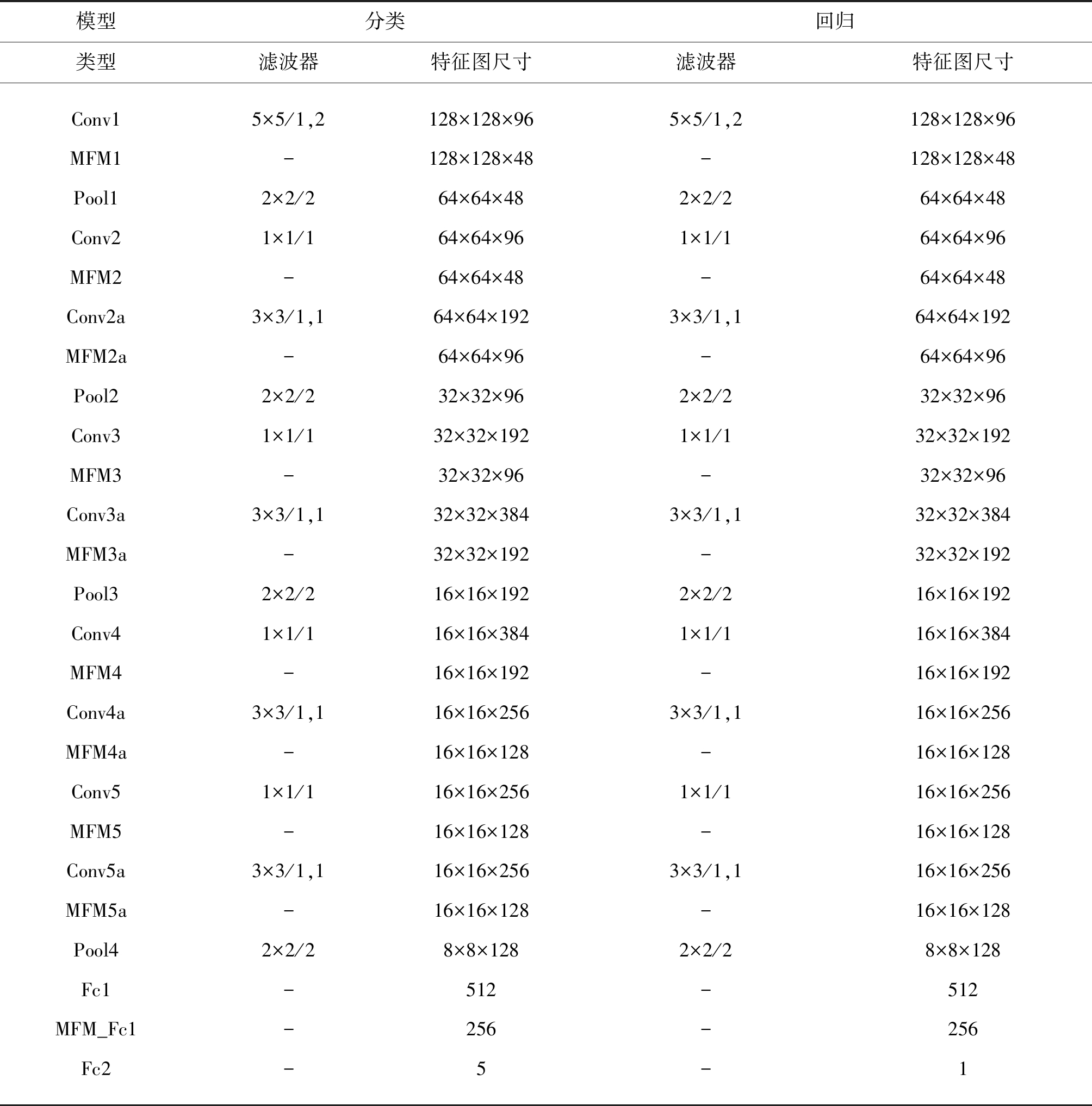

4.3 网络结构

本文采用的网络模型为Light CNN-9[12], 如表2所示。该网络模型由1个5×5卷积层、4个3×3卷积层和1×1卷积层、4个池化层、9个MFM激活层、以及2个全连接层构成。输入图像大小均为144×144,随机剪裁为128×128大小,然后将灰度图像和LBP纹理图像进行通道融合,再通过1×1卷积层进行通道特征图的线性组合,实现网络的跨通道信息组合。网络中每个卷积层后面都跟着MFM激活函数进行降维和特征选择,以获得紧凑的特征表示,每个池化层后面都跟着1×1卷积层和MFM激活函数进行升维和降维。两个全连接层中间加入dropout层和MFM激活函数用来防止出现过拟合。基于分类的人脸美丽等级预测时,FC2全连接层数为5,损失函数采用softmax;而基于回归的人脸美丽分数预测时,FC2全连接层数为1,损失函数采用欧氏距离。

表2 网络配置

Tab.2 Network configuration

模型分类回归类型滤波器特征图尺寸滤波器特征图尺寸Conv1MFM1Pool1Conv2MFM2Conv2aMFM2aPool2Conv3MFM3Conv3aMFM3aPool3Conv4MFM4Conv4aMFM4aConv5MFM5Conv5aMFM5aPool4Fc1MFM_Fc1Fc25×5/1,2-2×2/21×1/1-3×3/1,1-2×2/21×1/1-3×3/1,1-2×2/21×1/1-3×3/1,1-1×1/1-3×3/1,1-2×2/2---128×128×96128×128×4864×64×4864×64×9664×64×4864×64×19264×64×9632×32×9632×32×19232×32×9632×32×38432×32×19216×16×19216×16×38416×16×19216×16×25616×16×12816×16×25616×16×12816×16×25616×16×1288×8×12851225655×5/1,2-2×2/21×1/1-3×3/1,1-2×2/21×1/1-3×3/1,1-2×2/21×1/1-3×3/1,1-1×1/1-3×3/1,1-2×2/2---128×128×96128×128×4864×64×4864×64×9664×64×4864×64×19264×64×9632×32×9632×32×19232×32×9632×32×38432×32×19216×16×19216×16×38416×16×19216×16×25616×16×12816×16×25616×16×12816×16×25616×16×1288×8×1285122561

4.4 实验参数设置

本实验配置为Nvidia Tesla K20c的GPU,内存为24G;实验平台搭建在win 10操作系统上;深度网络模型基于caffe框架[14]实现。本实验初始学习率为0.001,权重衰减为0.0005,学习策略为“fixed”,即学习率为固定值,当训练正确率不再上升且在最大值附近震荡时,减小学习率继续训练,直到正确率不再变化。为了防止出现过拟合,两个全连接层中间加入dropout层,dropout_ratio设为0.5。

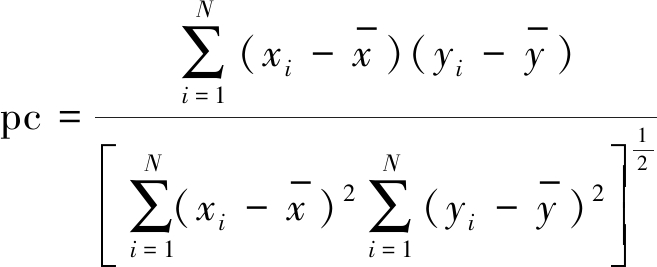

4.5 评价指标

分类测试时,采用softmax损失函数,测试结果采用分类准确率作为评价指标;回归测试时,采用欧氏距离损失函数,测试结果使用领域内通用的皮尔逊相关系数(Pearson Correlation)作为回归评价指标。人工评分值与美丽预测值的相关系数pc的计算为

(5)

其中,N表示人脸图像数,xi表示第i幅人脸图像的人工评分值,![]() 表示N幅人脸图像的人工评分均值,yi表示第i幅人脸图像的美丽预测值,

表示N幅人脸图像的人工评分均值,yi表示第i幅人脸图像的美丽预测值,![]() 表示N幅人脸图像的美丽预测均值。pc越大,相关性越强,表明回归预测更准确。

表示N幅人脸图像的美丽预测均值。pc越大,相关性越强,表明回归预测更准确。

4.6 对比实验与分析

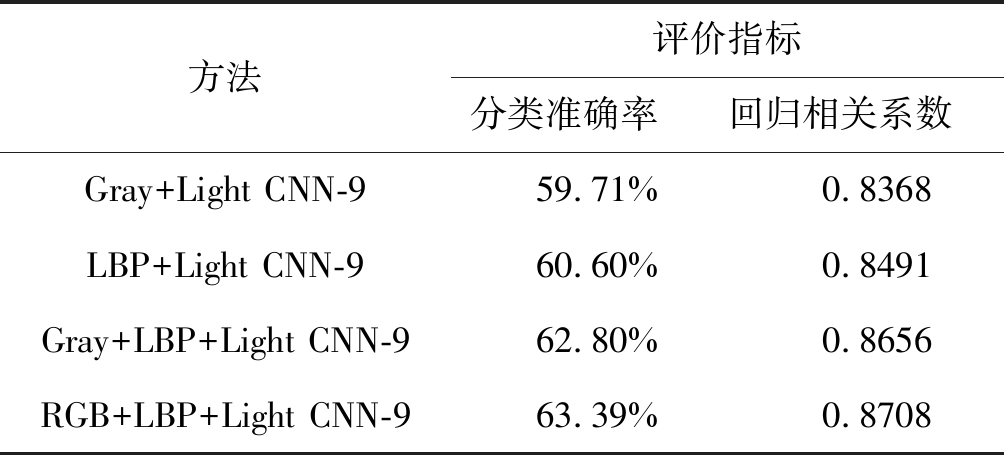

4.6.1 不同输入图像的对比

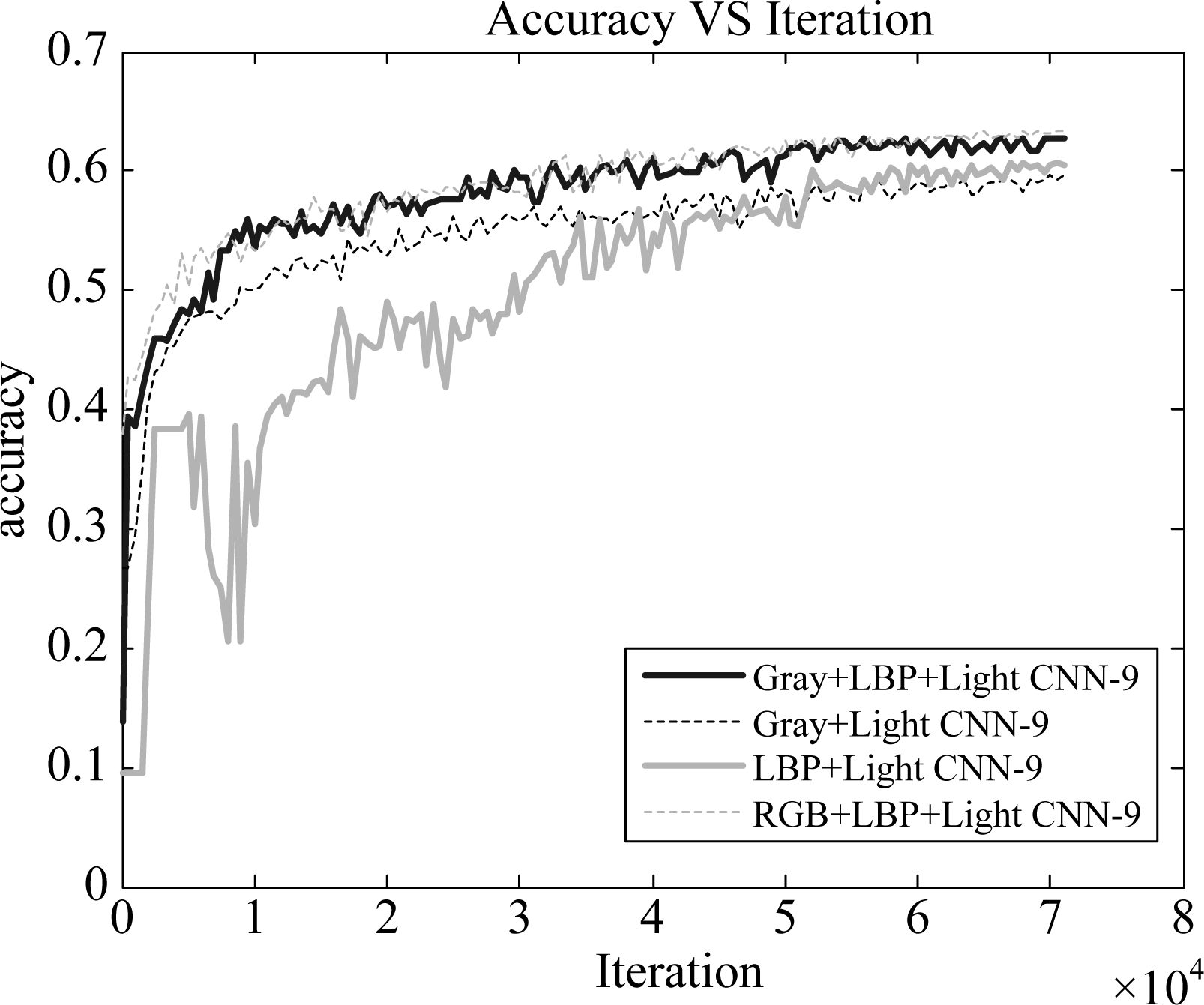

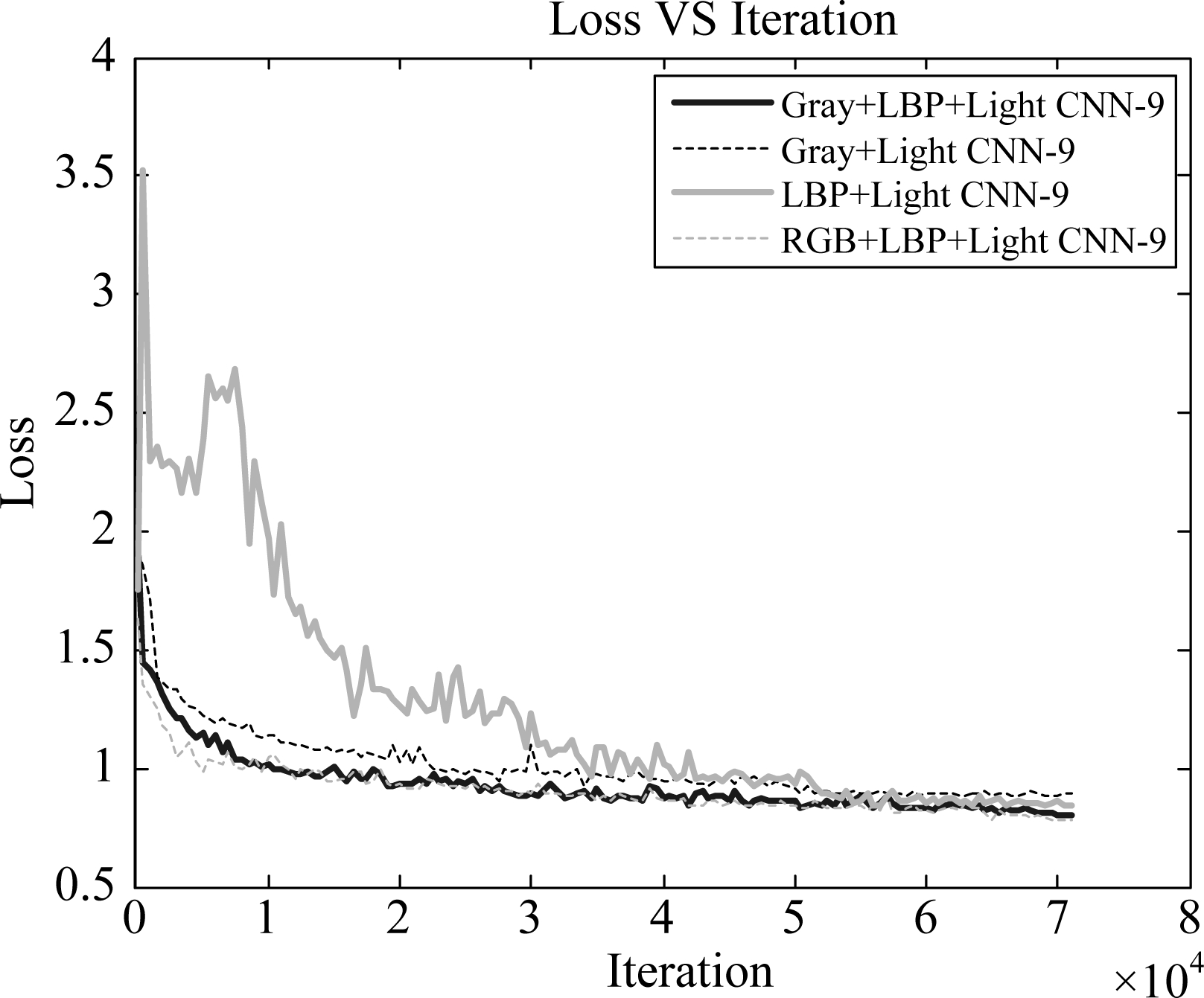

为了证明在网络中加入LBP纹理图像一起训练能提高人脸美丽预测精度,本文在LSAFBD人脸美丽数据库中进行对比实验,对人脸图像的预处理操作均使用4.2节方法,采用4.3节的卷积神经网络来训练和测试,测试结果采用分类准确率和回归相关系数作为评价指标。为了证明本文方法的有效性,本文进行了4个对比实验:使用灰度图像训练CNN网络(Gray+Light CNN-9),使用LBP纹理图像训练CNN网络(LBP+Light CNN-9),使用灰度图像和LBP纹理图像一起训练CNN网络(Gray+LBP+Light CNN-9),以及使用彩色图像和LBP纹理图像一起训练CNN网络(RGB+LBP+Light CNN-9)。其测试结果如表3所示,模型训练的测试分类准确率和损失曲线分别如图5、图6所示。

表3 基于LSAFBD人脸美丽数据库的对比实验结果

Tab.3 Contrast experimental results based on LSAFBD facial beauty database

方法评价指标分类准确率回归相关系数Gray+Light CNN-959.71%0.8368LBP+Light CNN-960.60%0.8491Gray+LBP+Light CNN-962.80%0.8656RGB+LBP+Light CNN-963.39%0.8708

图5 测试分类准确率

Fig.5 Test Classification Accuracy

图6 测试损失

Fig.6 Test Loss

从表3可知,使用LBP纹理图像作为网络的输入得到的实验效果要比使用灰度图像要好,因为将纹理图像输入到网络中进行特征学习,能减少网络对冗余信息的联想记忆,而且能学到人脸的局部美丽特征。由于纹理图像具有灰度图像不具有的特征,因此,将灰度图像和纹理图像融合输入到CNN网络中进行特征学习的效果要远远优于单独输入灰度图像或纹理图像;而彩色图像和纹理图像融合的效果优于灰度图像和纹理图像的融合,因为彩色图像为特征提取提供了丰富的颜色信息。

从图5和图6可知,随着迭代次数增加,分类准确率逐渐增加最后趋于稳定,测试损失逐步减少并趋于稳定。当网络迭代70000次后,预测准确率不再上升并且损失不再下降,网络趋于收敛;Gray+LBP+Light CNN-9方法的分类准确率为62.80%,比LBP+Light CNN-9方法的分类准确率高出2.2%,并且比Gray+Light CNN-9方法的分类准确率高出3.09%,而RGB+LBP+Light CNN-9方法的分类准确率达到最高为63.39%。

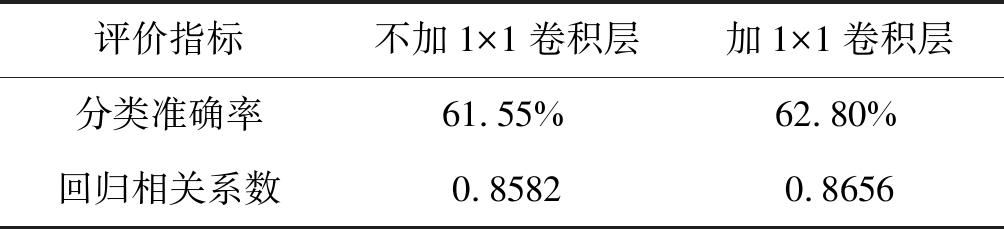

4.6.2 1×1卷积层对比实验

为了证明灰度图像和LBP纹理图像进行通道融合后加入1×1卷积层的优越性,本文在通道融合后采用加1×1卷积层和不加1×1卷积层进行了对比实验,实验结果如表4所示。实验结果表明,特征融合后加入1×1卷积层在分类和回归中都能有效提升测试结果。特征融合后加入1×1卷积层的网络分类准确率提高了1.25%,因为1×1卷积层对通道特征图进行了线性组合,实现了网络的跨通道信息组合,对后续网络进行特征学习和特征提取提供了有力的帮助。

表4 1×1卷积层的对比实验结果

Tab.4 Contrast experimental results of 1×1 convolution layer

评价指标不加1×1卷积层加1×1卷积层分类准确率61.55%62.80%回归相关系数0.85820.8656

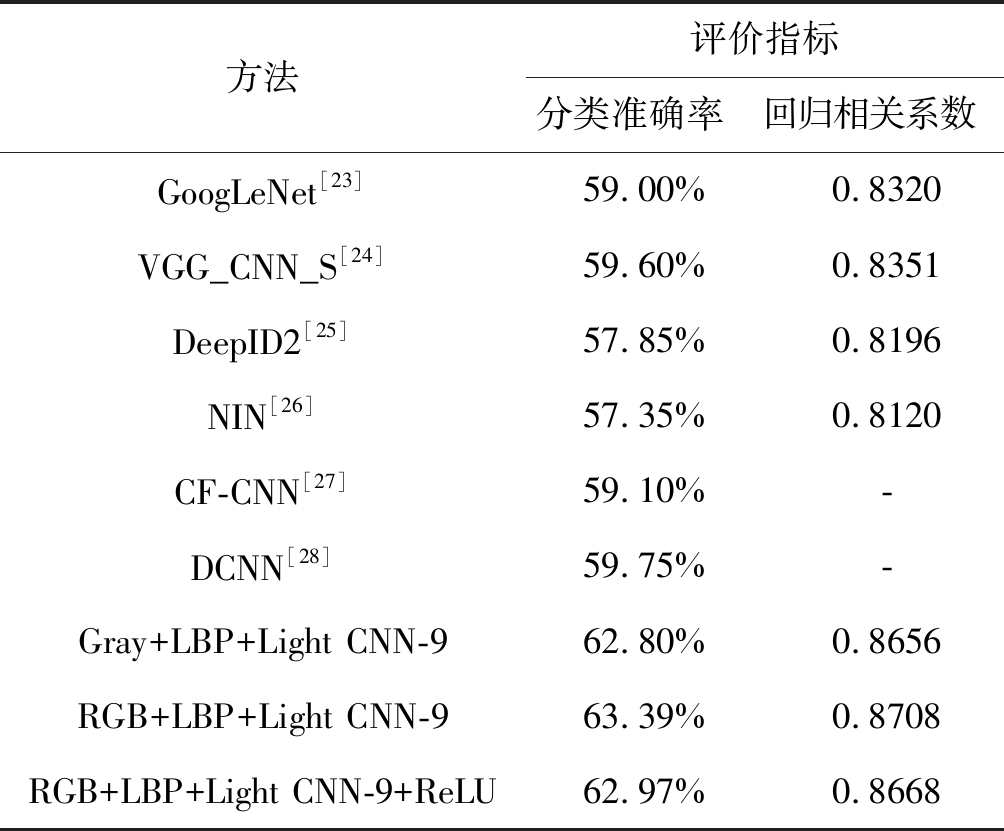

4.6.3 其他对比实验

为了证明本文所提方法适合人脸美丽预测,在LSAFBD人脸美丽数据库上使用其他网络进行人脸美丽预测实验。GoogLeNet[23]、VGG_CNN_S[24]、DeepID2[25]、NIN[26]和DCNN[28]网络的输入图像均为144×144的灰度图像,通过网络随机剪裁为128×128大小;CF-CNN[27]网络输入图像的光滑度、亮度和颜色图层进行多级微调;RGB+LBP+Light CNN-9+ReLU表示将RGB+LBP+Light CNN-9网络中的MFM激活函数替换为ReLU激活函数,其分类和回归结果如表5所示。从表5可知,RGB+LBP+Light CNN-9+ReLU方法的分类和回归结果都低于RGB+LBP+Light CNN-9的分类和回归结果,这说明MFM激活函数比ReLU激活函数更适合Light CNN-9网络。RGB+LBP+Light CNN-9、Gray+LBP+Light CNN-9方法的分类准确率分别为63.39%、62.80%,回归相关系数分别为0.8708、0.8656,而其他网络的最高分类准确率为59.60%,回归相关系数最大为0.8351。因此,不管是分类还是回归测试,本文所提方法的效果均优于其他网络,证明本文所提方法适合人脸美丽预测,并具有一定的优越性。

表5 不同CNN网络的测试结果

Tab.5 Test results of different CNN networks

方法评价指标分类准确率回归相关系数GoogLeNet[23]59.00%0.8320VGG_CNN_S[24]59.60%0.8351DeepID2[25]57.85%0.8196NIN[26]57.35%0.8120CF-CNN[27]59.10%-DCNN[28]59.75%-Gray+LBP+Light CNN-962.80%0.8656RGB+LBP+Light CNN-963.39%0.8708RGB+LBP+Light CNN-9+ReLU62.97%0.8668

5 结论

本文提出了一种LBP和CNN网络相结合的人脸美丽预测新方法。LBP算子提取的人脸图像具有局部纹理特征和光照不变性,通过在CNN网络中加入LBP纹理图像,学习LBP图像的局部结构特征,使网络提取更具结构性和层次性的人脸美学特征。在输入图像进行通道融合后,使用1×1卷积层对通道特征图进行线性组合,实现网络跨通道的交互和信息整合。网络中使用多个1×1卷积层实现升维或降维,减少训练参数的同时增加模型的深度,提升网络的表达能力。实验结果表明,人脸美丽研究更适合采用回归方法,并且本文所提方法优于其他模型的人脸美丽预测算法,可广泛应用于人脸识别、图像分类等领域。

人脸吸引力受颜色、纹理、几何形状等多种因素影响,本文仅探讨了灰度图像、彩色图像和纹理图像的结合对人脸美丽预测的影响。后续将探究彩色图像、纹理图像以及几何形状的结合。

[1] Rhodes G, Yoshikawa S, Clark A, et al. Attractiveness of facial averageness and symmetry in non-Western cultures: In search of biologically based standards of beauty[J]. Perception, 2001, 30(5): 611- 625.

[2] Deng Z, Zhang Z. Event-related complexity analysis and its application in the detection of facial attractiveness[J]. International Journal of Neural Systems, 2014, 24(07):

1450026.

[3] Grammer K, Fink B, M ller A P, et al. Darwinian aesthetics: sexual selection and the biology of beauty[J]. Biological Reviews, 2010, 78(3): 385- 407.

ller A P, et al. Darwinian aesthetics: sexual selection and the biology of beauty[J]. Biological Reviews, 2010, 78(3): 385- 407.

[4] Valentine T, Darling S, Donnelly M. Why are average faces attractive? The effect of view and averageness on the attractiveness of female faces[J]. Psychonomic Bulletin & Review, 2004, 11(3): 482- 487.

[5] Mao H, Jin L, Du M. Automatic Classification of Chinese Female Facial Beauty Using Support Vector Machine[C]∥Proceedings of the IEEE International Conference on Systems, Man and Cybernetics, San Antonio, TX, USA, 11-14 October 2009. IEEE, 2009: 4842- 4846.

[6] Kalayci S, Ekenel H, Gunes H. Automatic analysis of facial attractiveness from video[C]∥IEEE International Conference on Image Processing. IEEE, 2015: 4191- 4195.

[7] Fan J, Chau K, Wan X, et al. Prediction of facial attractiveness from facial proportions[J]. Pattern Recognition, 2012, 45(6): 2326-2334.

[8] Zhang D, Zhao Q, Chen F. Quantitative analysis of human facial beauty using geometric features[J]. Pattern Recognition, 2011, 44(4): 940-950.

[9] Liang L, Jin L, Li X. Facial Skin Beautification Using Adaptive Region-Aware Masks[J]. IEEE Transactions on Cybernetics, 2017, 44(12): 2600-2612.

[10] Srivastava N, Hinton G, Krizhevsky A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. Journal of Machine Learning Research, 2014, 15(1): 1929-1958.

[11] Ojala T, Pietikäinen M, Mäenpää T. Multiresolution Gray-Scale and Rotation Invariant Texture Classification with Local Binary Patterns[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2002, 24(7): 971-987.

[12] Wu X, He R, Sun Z, et al. A Light CNN for Deep Face Representation with Noisy Labels[J]. IEEE Transactions on Information Forensics & Security, 2017, PP(99): 1-1.

[13] Gan J, Zhai Y, Wang B. Unconstrained Facial Beauty Prediction Based on Multi-scale K-Means[J]. Chinese Journal of Electronics, 2017, 26(3): 548-556.

[14] Jia, Yangqing, Shelhamer, et al. Caffe: Convolutional Architecture for Fast Feature Embedding[C]∥In Proc. 22nd ACM Int. Conf. Multimedia, 2014: 675- 678.

[15] Eisenthal Y, Dror G, Ruppin E. Facial attractiveness: beauty and the machine[J]. Neural Computation, 2006, 18(1): 119-142.

[16] Kagian A, Dror G, Leyvand T. A Humanlike Predictor of Facial Attractiveness[C]∥Advances in Neural Information Processing Systems 19, Proceedings of the Twentieth Conference on Neural Information Processing Systems, Vancouver, British Columbia, Canada, December. DBLP, 2006: 649- 656.

[17] Yan H. Cost-sensitive ordinal regression for fully automatic facial beauty assessment[J]. Neurocomputing, 2014, 129(5): 334-342.

[18] Chiang W, Lin H, Huang C, et al. The cluster assessment of facial attractiveness using fuzzy neural network classifier based on 3D Moiré features[J]. Pattern Recognition, 2014, 47(3): 1249-1260.

[19] Gan J, Li L, Zhai Y, et al. Deep self-taught learning for facial beauty prediction[J]. Neurocomputing, 2014, 144(1): 295-303.

[20] Xie D, Liang L, Jin L, et al. SCUT-FBP: A Benchmark Dataset for Facial Beauty Perception[C]∥IEEE International Conference on Systems, Man, and Cybernetics. IEEE, 2015: 1821-1826.

[21] Xu J, Jin L, Liang L, et al. A new humanlike facial attractiveness predictor with cascaded fine-tuning deep learning model[J]. Computer Science, 2015, 70(1): 45-79.

[22] Chen F, Xiao X, Zhang D. Data-Driven Facial Beauty Analysis: Prediction, Retrieval and Manipulation[M]. Springer International Publishing, 2016: 1-1.

[23] Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]∥IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2015: 1-9.

[24] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[C]∥In ICLR,2015.

[25] Sun Y, Chen Y, Wang X, et al. Deep learning face representation by joint identification-verification[C]∥Quebec, Canada: Neural Information Processing Systems, 2014: 1988-1996.

[26] Lin M, Chen Q, Yan S. Network In Network[C]∥In ICLR, 2014.

[27] 许杰. 基于深度学习的人脸美丽吸引力预测[D]. 广州: 华南理工大学, 2017.

Xu Jie. Prediction of facial beauty attractiveness based on deep learning[D]. Guangzhou: South China University of Technology, 2017.(in Chinese)

[28] 姜开永, 甘俊英, 谭海英.基于深度学习的人脸美丽预测模型及其应用[J]. 五邑大学学报: 自然科学版, 2018, 32(2): 45-52.

Jiang Kaiyong, Gan Junying, Tan Haiying. Face beauty prediction model and application based on deep learning[J]. Journal of Wuyi University: Natural Science Edition, 2018, 32(2): 45-52.(in Chinese)

[29] Fan Y, Liu S, Li B, et al. Label Distribution-Based Facial Attractiveness Computation by Deep Residual Learning[J]. IEEE Transactions on Multimedia, 2016, PP(99): 1-1.

[30] Liang L, Lin L, Jin L, et al. SCUT-FBP5500: A Diverse Benchmark Dataset for Multi-Paradigm Facial Beauty Prediction[J]. Computer Vision and Pattern Recognition, 2018.