1 引言

在过去十多年里,视频中的行为识别研究由于应用广泛得到了越来越多的关注。文献[1-2]对近年来的行为识别研究取得的进展做了总结,目前对于简单场景下的单人行为识别问题已经基本解决,但仍然存在着许多开放课题,譬如复杂场景下的行为识别、交互行为的识别以及群体行为等亟待进一步研究[3-5]。

自Sivic等[6]将文本分析中的单词包模型(Bag of words)引入到目标识别的研究中以后,在计算机视觉领域得到了广泛的应用。单词包模型虽然简单,但在目标识别、跟踪以及行为识别和探测方面均取得了较好的性能。当然,其缺陷是很明显的,由于忽视了视觉单词间的空间和时间关系,该模型的判别力相应受到影响。另一方面,由于普遍采用矢量量化,造成了量化损失,这不可避免地影响到视觉单词的判别性。

近来,源自文本分析的主题模型被引入到计算机视觉的研究中,Li等[7]首先将概率隐含语义分析模型(pLSA: probabilistic latent semantic analysis)以及隐含狄利克雷指派模型(LDA: latent Dirichlet allocation)引入到静态图像的场景理解中,在此基础上Niebles等[8]在视频的行为识别中应用pLSA模型取得了较好的性能。在此之后,有许多研究者致力于改进主题模型,以提升分类精度。Shang等[9]扩展了LDA模型以建模人脸表情的动态模型。文献[10]采用动态主题模型以挖掘视频中的行为模式。上述文献均在提取底层特征后,采用K均值聚类形成码本,然后采用矢量量化的方法对特征进行编码,将某一特征赋予与其距离最近的聚类中心(一般是欧氏距离)。Chatfield等[11]分析比较了各类特征编码方法以及池化方法(pooling)在静态图像中目标识别的性能,实验证明软分配、稀疏编码等明显优于矢量量化。

主题模型将视频或者图片的单词包表示作为输入,这使得特征的编码与归一化方法影响模型的表示能力。目前,还没有文献讨论在主题模型下,各类编码与归一化方法对于分类性能的影响。

本文考察了归一化方法和编码方法对于概率隐含语义分析模型的分类性能的影响,在KTH和UT-interaction数据库上的实验结果表明,分类性能一定程度上依赖于合适的编码和归一化方法组合。在前期工作的基础上[12],我们还探讨了采用主成份分析方法预处理原始特征对于最终分类性能的作用。

2 评估框架

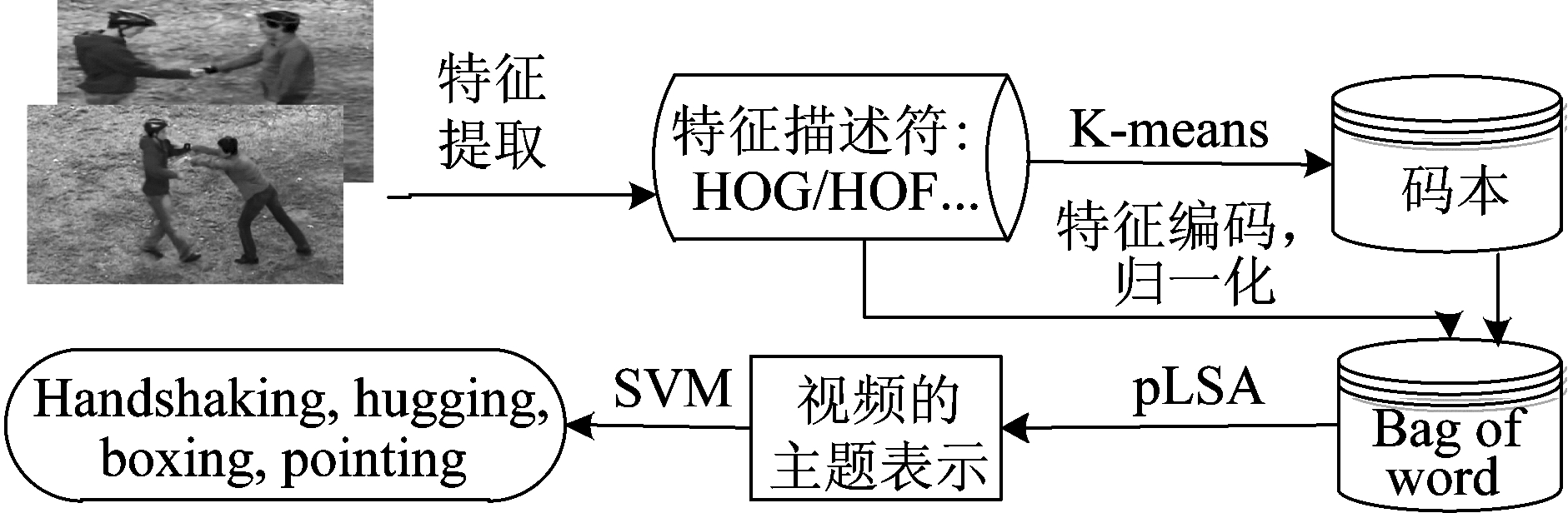

如图1所示,我们的评估方法流程包含以下过程:首先,从视频中提取底层特征,采用诸如HOG/HOF等描述符来表示特征;然后,应用k-means算法形成码本;将所有特征编码并归一化,经求和池化得到每个视频的单词包表示;通过EM算法学习主题分布模型;最后得到每个视频的主题概率分布表示,应用SVM进行分类识别。

图1 评估流程图

Fig.1 The pipeline of our evaluation framework

2.1 特征提取和表示

特征的提取与表示是各类识别任务的第一步,对于识别的性能提升具有关键性的作用。目前在视频中的行为识别研究中用得最多的特征提取方法为时空特征点(STIPs: spatio-temporal interest points)[13]和轨迹特征[14],在多个数据库上,这两类方法都取得了优越的性能。本文中采用了这两类方法提取视频的特征,以下给出了简短的介绍。

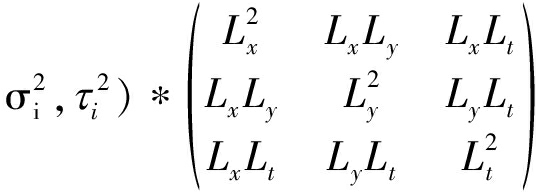

Laptev等[15]把Harris角点探测器扩展到了3维视频中,首先计算一个二阶矩矩阵:

μ=g(.;

(1)

在公式(1)中,g(.![]() 为高斯核函数,Lξ=∂ξ(g*f),

为高斯核函数,Lξ=∂ξ(g*f),  为视频的灰度值函数,σi,τi分别为空间尺度和时间尺度因子。然后通过局域最大化H=det(μ)-κtrace3(μ)定位兴趣点。实验中我们采用了文献[15]的代码,缺省参数κ=0.0005,σ2=4,8,16,32,64,128,τ2=2,4。然后计算每一个点的4-bin梯度直方图(HOG: histogram of gradient)、5-bin 光流直方图(HOF: histogram of optic flow)描述符,串联起来组成162维的梯度光流直方图(HNF: histogram of gradient and optic flow)描述符。

为视频的灰度值函数,σi,τi分别为空间尺度和时间尺度因子。然后通过局域最大化H=det(μ)-κtrace3(μ)定位兴趣点。实验中我们采用了文献[15]的代码,缺省参数κ=0.0005,σ2=4,8,16,32,64,128,τ2=2,4。然后计算每一个点的4-bin梯度直方图(HOG: histogram of gradient)、5-bin 光流直方图(HOF: histogram of optic flow)描述符,串联起来组成162维的梯度光流直方图(HNF: histogram of gradient and optic flow)描述符。

正如Wang等[14]指出的,视频的2维空间域与时间域的特性是截然不同的,所以跟踪时间域的特征点相比较于探测时空兴趣点是一个更好的选择。受图像识别中密集采样取得的成就所启发,他们采用了密集采样的轨迹而不是KLT跟踪器(Kanade-Lucas-Tomasi Feature Tracker)来捕捉运动信息。通过跟踪密集采样的特征点,多尺度的密集轨迹被提取了出来。在光流场ω中,第t帧的采样点Pt=(xt, yt) 通过中值滤波器被跟踪到第t+1帧。

(2)

其中,M是滤波核函数,![]() 是(xt, yt)的近似位置。

是(xt, yt)的近似位置。

由于需要跟踪密集采样的大量的兴趣点,密集轨迹方法[14]在计算和内存耗费上代价较高,Peng等[16]提出了基于运动边界的采样策略修正了密集轨迹方法,通过计算相邻两帧的光流梯度得到运动边界图,去除不在运动前景中的点,在不损害判别性的前提下,大大降低了轨迹的数量。实验中我们采用文献[16]的方法跟踪轨迹,然后提取5类描述符:shape(30维),HOG(96维), HOF(108维), MBH(motion boundary histogram, 192维), HNF(204维)。

2.2 特征编码与归一化

在单词包模型中应用最广的特征编码方法为矢量量化(Vector quantization),通过K均值聚类等方法得到码本后,采用最近邻方法找到与待编码特征距离最近的码字作为该特征的编码。

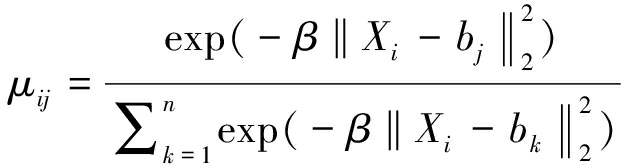

与矢量量化不同,软分配编码[17](Soft Assignment)根据每个特征与每一个聚类中心的距离得到一个表示其归属某一聚类的程度的因子μij:

(3)

很明显,上述方法需要计算特征点与所有聚类中心的距离,这无疑是很耗时的。为了减少计算量,文献[18]提出了局域软分配编码方法(LSA: Localized Soft Assignment),只考虑特征点的k个最近邻的单词进行编码,而把特征点与其他单词的距离设为无穷大,其中k经验值为5,如果k为1,则退化为矢量量化方法了。

文献[18]指出,池化方法对于性能有显著影响,一般而言,最大池化配合稀疏编码方法很有效。本文采用主题模型建模视觉单词的共现模式,而最大池化后直方图只能表明该码字是否出现过,没有出现频率等信息,因而本文不考虑最大池化方法。在实验中,采用求和池化,将视频的所有特征的编码直接相加,得到每个视频的特征直方图表示。

在视频中行为识别的研究中,通常归一化方法对于性能的影响一直被忽视。Peronnin等[19]采用指数归一化和 2归一化结合Fisher核方法在图像分类中取得了较好的识别率,说明选择合适的归一化方法可助益于性能的提升。在本文中,我们比较了5种归一化方法,设特征F维数为K,第k维为fk,

2归一化结合Fisher核方法在图像分类中取得了较好的识别率,说明选择合适的归一化方法可助益于性能的提升。在本文中,我们比较了5种归一化方法,设特征F维数为K,第k维为fk,

1归一化:

1归一化:

(4)

2归一化:

2归一化:

(5)

指数归一化:

fk=sign(fk)|fk|α

(6)

其中α经验值为0.5。

指数加  1归一化(P

1归一化(P 1-norm),指数加

1-norm),指数加 2归一化(P

2归一化(P 2-norm),则分别为指数归一化后再进行

2-norm),则分别为指数归一化后再进行 1/

1/ 2归一化。

2归一化。

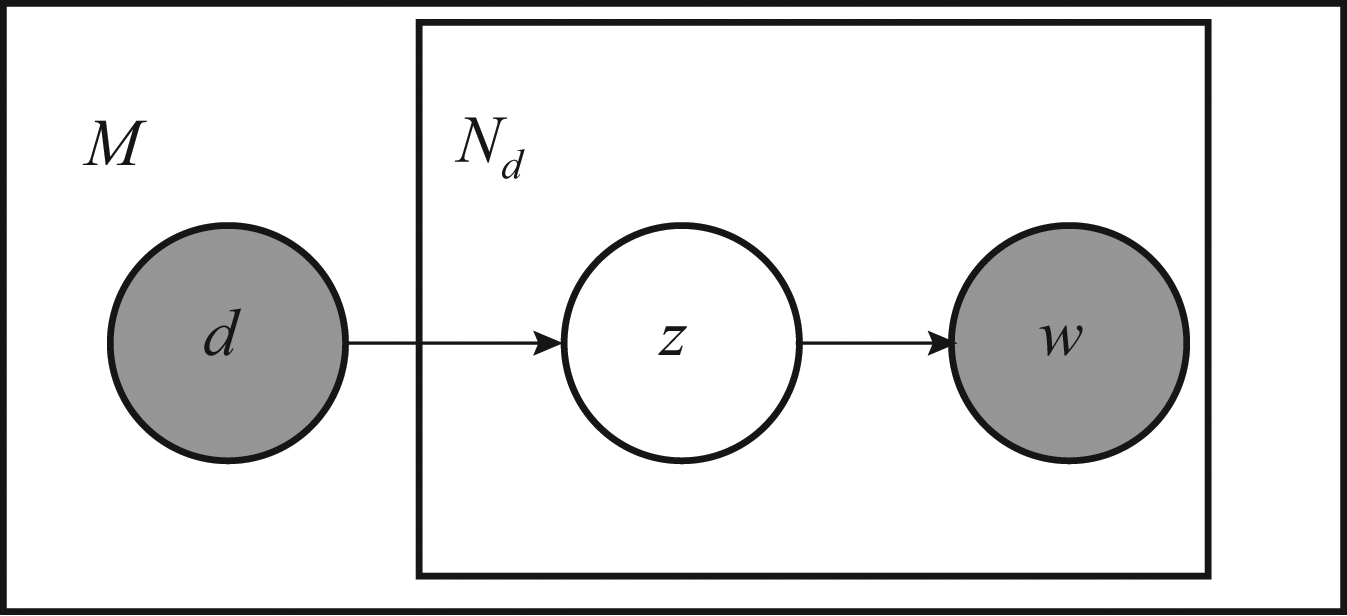

图2 pLSA模型。其中d表示视频,![]() 是视频中的视觉单词,均为观测变量。

是视频中的视觉单词,均为观测变量。![]() 是主题,为隐变量。视频数据集的大小为M,视频d中的单词数目为Nd

是主题,为隐变量。视频数据集的大小为M,视频d中的单词数目为Nd

Fig.2 pLSA model. Observed random variables are shaded and unobserved ones are unshaded. d represents video, ![]() is visual word in d, and

is visual word in d, and ![]() is topic among words. The size of

is topic among words. The size of

videos is M, and the number of words in d is Nd

2.3 概率隐含语义分析模型

概率隐含语义分析模型是针对文档数据的分析提出来的。在视频中的行为识别语境下,整个视频数据库即对应文档集合,每段视频样本对应于一个文档,视觉特征即为单词,通过该模型建模视觉单词间的共现模式,然后以视频的主题概率分布作为语义的高层表示。假定数据库有M个视频序列,码本大小为V,主题为![]() 如图2所示的图模型的联合概率分布为:

如图2所示的图模型的联合概率分布为:

(7)

其中,![]()

根据最大似然准则,利用EM算法通过最大化似然函数![]() 求得主题对单词的分布

求得主题对单词的分布![]() 进而得到视频的高层语义表示:主题概率分布

进而得到视频的高层语义表示:主题概率分布![]()

(8)

其中![]() 是单词频率,即视频d中

是单词频率,即视频d中![]() 出现的次数。文献[8]将行为类别数对应于主题数,一个主题对应一类行为。本文所提方法与其区别是,主题不对应行为,而是表示单词间的共现模式,将视频表示为主题的概率分布,最后利用线性SVM进行分类识别。

出现的次数。文献[8]将行为类别数对应于主题数,一个主题对应一类行为。本文所提方法与其区别是,主题不对应行为,而是表示单词间的共现模式,将视频表示为主题的概率分布,最后利用线性SVM进行分类识别。

3 实验结果与分析

在视频中的行为识别中,数据库中视频样本间的差异,包括尺度、光照、拍摄背景以及拍摄视角的不同等,大幅增加了准确识别行为类别的难度。实验中我们采用了两个数据库:KTH数据库和UT-interaction数据库。其中,KTH数据库是较早提出也是引用最高的数据库之一,背景相对比较简单,所包含的视频均为单人行为,在四个不同场景下25个人完成的6类动作共计599个视频样本,视频拍摄时的相机固定,拍摄视角不变,但视频样本中包含了尺度变化、衣着变化和光照变化。UT-interaction 数据库,包含有6类人人交互的动作:shaking hands, pointing, hugging, pushing, kicking, punching,总共120段样本,视频拍摄时的视角变化较大,尤其是数据集2,包含了更多的相机运动,部分视频中还有无干系的行人,这给分类识别带来了很大的困难。由于样本有限且类内差异大,UT-interaction数据库中的行为分类是个很困难的任务[20-21]。

实验中,采用了时空兴趣点和轨迹特征。为公平起见,码本的大小均设为1000,采用线性SVM进行分类识别。实验硬件环境为Intel core(TM)i5,内存4G,软件平台采用Matlab2013b。

3.1 KTH数据库上的实验

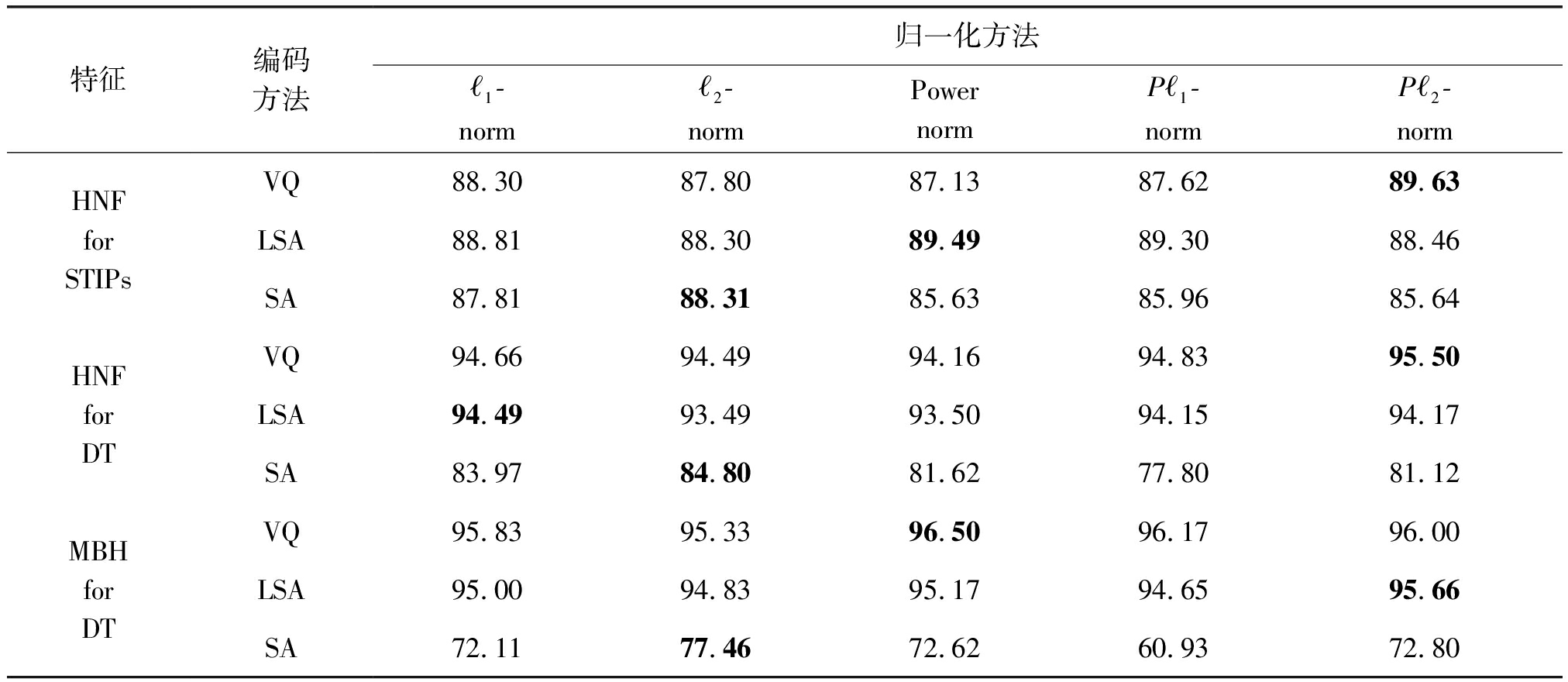

实验采用留一组法进行,在每一轮实验中,用24组视频做训练,利用所得模型测试最后一组,然后平均25轮实验的分类精度。如表1所示,矢量量化和局域软分配得到的结果相差不多。指数归一化、指数加 2归一化加强了矢量量化和局域软分配的识别能力,而软分配则更适合与

2归一化加强了矢量量化和局域软分配的识别能力,而软分配则更适合与 2归一化匹配。归因于密集轨迹的判别力,当采用矢量量化和局域软分配编码时,轨迹比时空兴趣点的分类精度提高了大约6个百分点。与此相反,当采用软分配编码时,采用时空兴趣点时得到的结果更好一些。对码本中的每一个单词,软分配编码根据特征与单词的距离分配因子,这平滑了特征间的差异,从而降低了特征的判别性,尤其是当采用MBH描述符时。我们采用时空兴趣点特征得到的分类精度为89.63%,比文献[8]的结果提高了6个百分点。可以合理地假设,相似的行为具有相似的特征和主题分布。很明显,用混合主题概率分布描述行为优于把一个主题对应于一类行为的方法。主题模型的一个优势是可以把主题视为一个中层的语义特征,然后用主题来描述更复杂的行为。在不同的行为中,不可避免的存在相似的形体动作,例如拳击和拍手都有着类似的上肢运动。因此不同的行为分享相同的主题,每个特定的行为拥有自己的主题分布,这增强了特征的判别性。

2归一化匹配。归因于密集轨迹的判别力,当采用矢量量化和局域软分配编码时,轨迹比时空兴趣点的分类精度提高了大约6个百分点。与此相反,当采用软分配编码时,采用时空兴趣点时得到的结果更好一些。对码本中的每一个单词,软分配编码根据特征与单词的距离分配因子,这平滑了特征间的差异,从而降低了特征的判别性,尤其是当采用MBH描述符时。我们采用时空兴趣点特征得到的分类精度为89.63%,比文献[8]的结果提高了6个百分点。可以合理地假设,相似的行为具有相似的特征和主题分布。很明显,用混合主题概率分布描述行为优于把一个主题对应于一类行为的方法。主题模型的一个优势是可以把主题视为一个中层的语义特征,然后用主题来描述更复杂的行为。在不同的行为中,不可避免的存在相似的形体动作,例如拳击和拍手都有着类似的上肢运动。因此不同的行为分享相同的主题,每个特定的行为拥有自己的主题分布,这增强了特征的判别性。

表1 在KTH数据库中不同编码和归一化方法的分类结果(%)

Tab.1 Comparison of different encoding and normalization methods in KTH (%)

特征编码方法归一化方法ℓ1-normℓ2-normPowernormPℓ1-normPℓ2-normHNF for STIPsVQ88.3087.8087.1387.6289.63LSA88.8188.3089.4989.3088.46SA87.8188.3185.6385.9685.64HNF for DTVQ94.6694.4994.1694.8395.50LSA94.4993.4993.5094.1594.17SA83.9784.8081.6277.8081.12MBH for DTVQ95.8395.3396.5096.1796.00LSA95.0094.8395.1794.6595.66SA72.1177.4672.6260.9372.80

3.2 UT-interaction数据库上的实验

UT-interaction数据库分为两个数据集,其中数据集1是在停车场拍摄的,而数据集2是在有风的草地场景下拍摄的,比较而言,数据集2包含有更多的相机抖动。文献[22]中综合比较了各类方法的性能,其中在数据集1上,最好的结果为88%,数据集2上为77%。两个数据集的结果相差11%,由此可见由于背景噪声、拍摄视角和相机抖动的原因使得数据集2的识别要困难的多。实验中参照文献[22]中的设置,采用10折叠的留一组法,平均10轮后的结果作为最终的识别结果。

3.2.1 采用时空兴趣点的实验结果

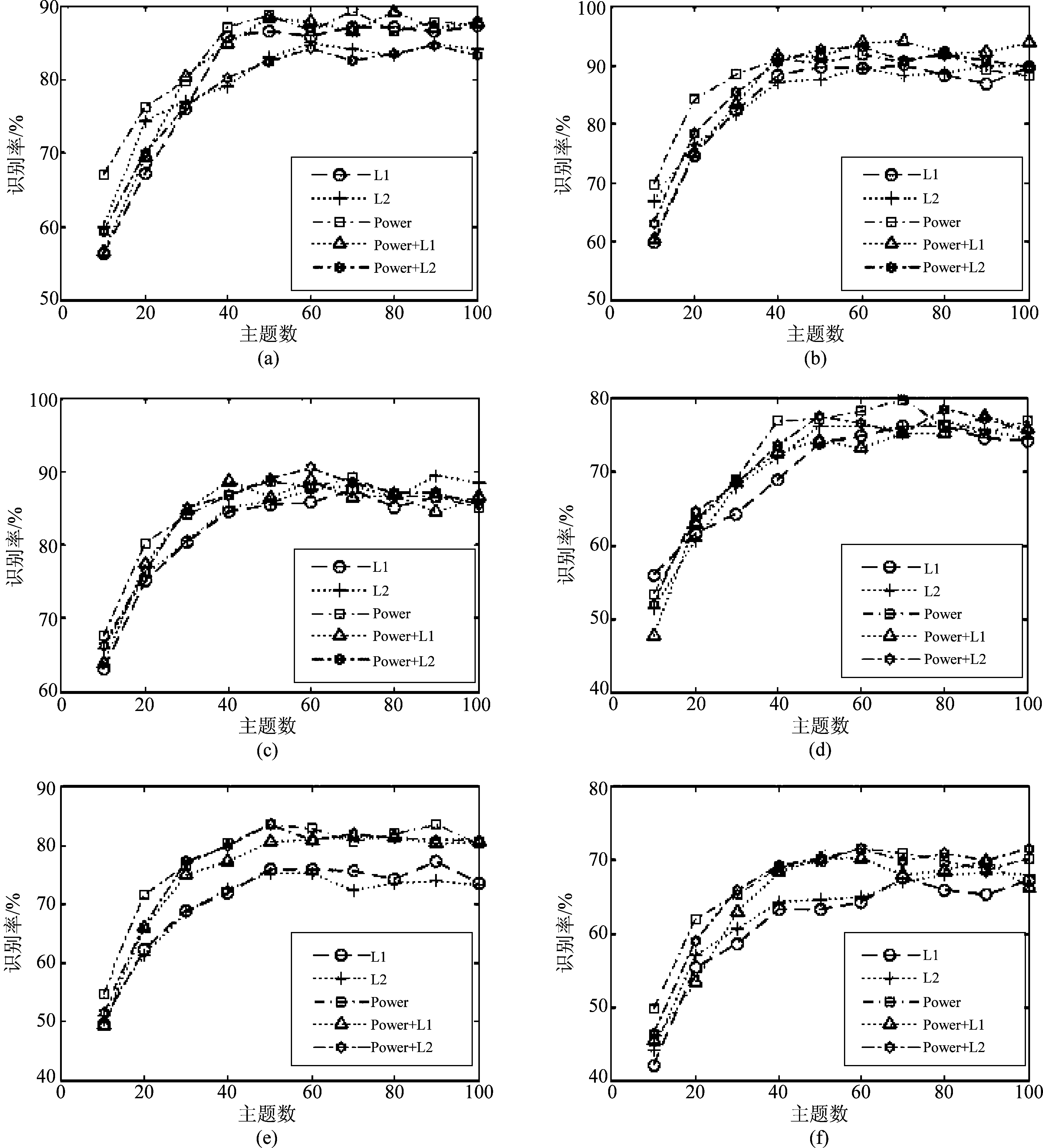

实验结果如图3所示,在三种编码方法中局域软分配编码取得了最高的准确度。在数据集1中,软分配和矢量量化的结果类似。而在数据集2上,软分配的结果比矢量量化最大下降了10个百分点,这可能归因于两个数据集不同的复杂度。在两个数据集上的精确度最高分别为94.24%、83.67%,这比文献[22]的结果分别提升了6.24、6.67个百分点。需要特别指出的是,在数据集1上的结果接近于当前最好的结果。当主题数目大约是行为类别数的10倍时,性能达到最高,这与数据库的复杂度有关。当行为的复杂度提升时,需要有更多的主题来描述视频中行为的细节。

图3 UT-interaction数据库中不同的编码和归一化方法性能比较,采用STIPs特征,描述符为HNF。其中(a)~(c),(d)~(f)是在数据集1和数据集2上分别采用VQ,LSA, SA得到的结果

Fig.3 Comparison of different encoding and normalization with HNF of STIPs on UT-interaction sets.(a)~(c), (d)~(f) are results on UT-set1 and set2 respectively using VQ, LSA and SA

局域软分配是软分配的一个简化,从计算的角度而言,局域软分配在矢量量化和软分配之间取了一个折衷,只计算与最近邻的几个中心的距离,却得到了更好的性能,这说明将某个特征关联到几个近邻中心比关联所有的聚类中心更能提升其判别性,这也是与预期相符的,与某特征距离较远的聚类中心,与该特征的相关性可忽略不计,而软分配编码却为其分配了一个不为零的系数,从而模糊了其特质。

3.2.2 采用轨迹特征的实验结果

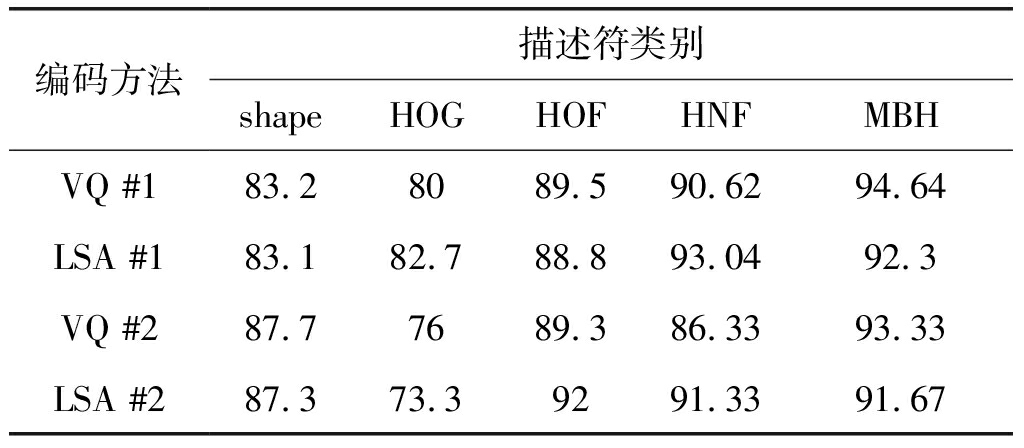

实验中我们首先比较了轨迹5类不同的描述符的性能。其中矢量量化和 1归一化结合,局域软分配和指数加

1归一化结合,局域软分配和指数加 2归一化相结合。由表2可以看出,MBH和HNF要优于shape,HOG,HOF,这与文献[14, 16]所得结论是相符的。一般而言,多个特征级联会优于单个特征的性能,HNF将HOG,HOF链接起来,联合了两类描述符的优势,性能有了较大提升。MBH最初是用于人体探测的,通过独立的计算光流在水平和垂直方向上的梯度,可移除局域的相机运动而保留了光流场的局部变化信息,因而其对相机运动更具有鲁棒性,也更有判别性。接下来的实验将只采用HNF和MBH描述符。

2归一化相结合。由表2可以看出,MBH和HNF要优于shape,HOG,HOF,这与文献[14, 16]所得结论是相符的。一般而言,多个特征级联会优于单个特征的性能,HNF将HOG,HOF链接起来,联合了两类描述符的优势,性能有了较大提升。MBH最初是用于人体探测的,通过独立的计算光流在水平和垂直方向上的梯度,可移除局域的相机运动而保留了光流场的局部变化信息,因而其对相机运动更具有鲁棒性,也更有判别性。接下来的实验将只采用HNF和MBH描述符。

表2 轨迹特征不同的描述符间的比较。#1和#2分别表示数据集1和数据集2上的结果

Tab.2 Comparison of different descriptors for dense trajectories.#1 and #2 denote results on set1 and set2 respectively

编码方法描述符类别shapeHOGHOFHNFMBHVQ #183.28089.590.6294.64LSA #183.182.788.893.0492.3VQ #287.77689.386.3393.33LSA #287.373.39291.3391.67

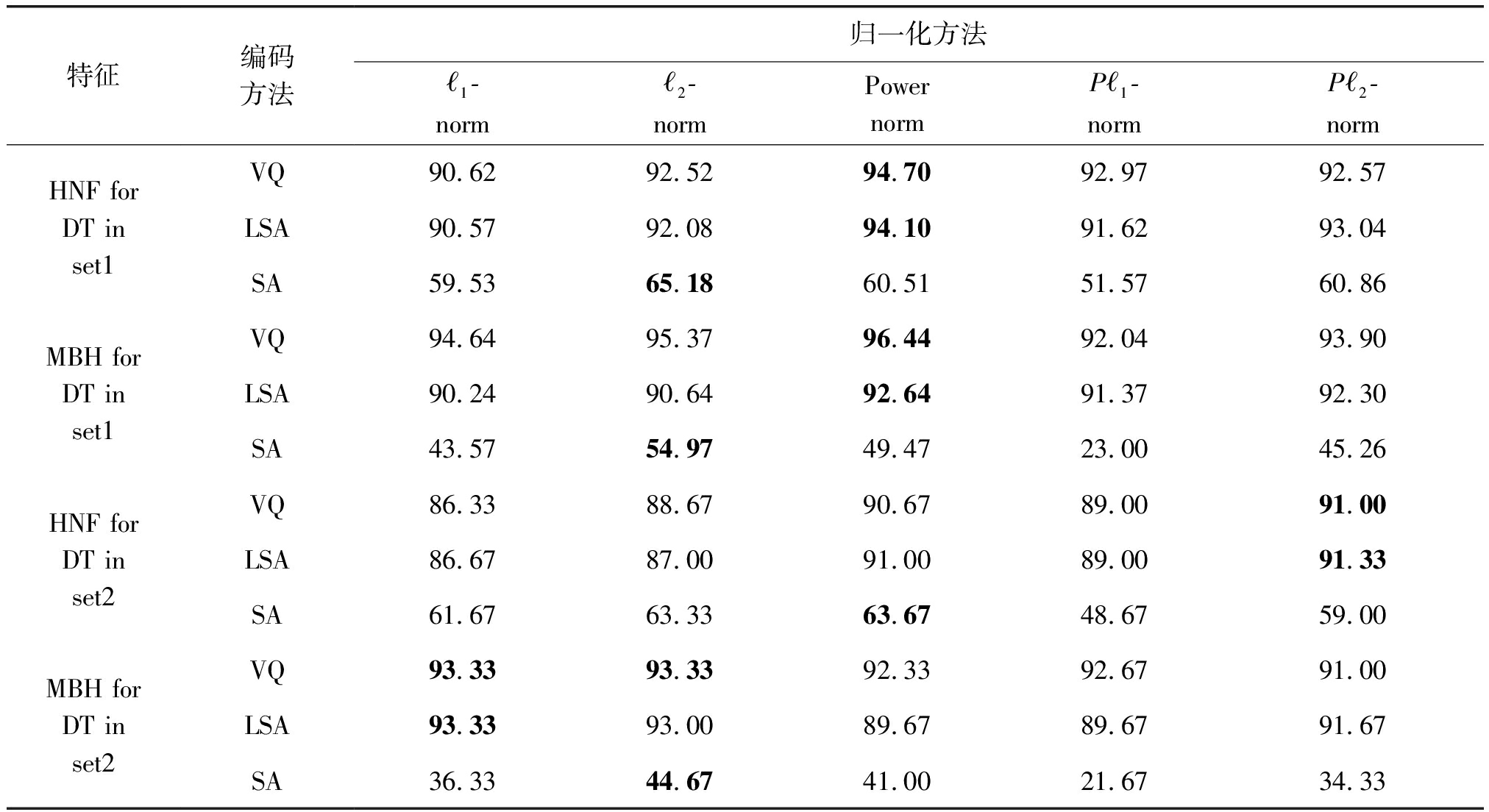

表3 UT-interaction数据库中不同的编码和归一化方法的性能比较(%),主题数为100

Tab.3 Comparison of different encoding and normalization methods in UT (%). The number of topics is 100

特征编码方法归一化方法ℓ1-normℓ2-normPowernormPℓ1-normPℓ2-normHNF for DT in set1VQ90.6292.5294.7092.9792.57LSA90.5792.0894.1091.6293.04SA59.5365.1860.5151.5760.86MBH for DT in set1VQ94.6495.3796.4492.0493.90LSA90.2490.6492.6491.3792.30SA43.5754.9749.4723.0045.26HNF for DT in set2VQ86.3388.6790.6789.0091.00LSA86.6787.0091.0089.0091.33SA61.6763.3363.6748.6759.00MBH for DT in set2VQ93.3393.3392.3392.6791.00LSA93.3393.0089.6789.6791.67SA36.3344.6741.0021.6734.33

在表3中,我们比较了不同编码方法结合归一化方法的性能。当采用HNF描述符时,矢量量化和局域软分配性能相差很小。与此相反,采用MBH描述符时,局域软分配编码相比矢量量化而言弱化了特征的判别性,这在数据集1上更明显。需要着重指出的是,归一化方法对于分类性能有着显著的影响,最大可相差5个百分点。

3.2.3 主成份分析预处理特征对性能的影响

以上实验中,所有的特征均未作预处理。Jegou等[23-24]指出,主成份分析(PCA)通过选择子空间的解耦的正交基向量,最小化了降维产生的信息损失,在静态图像识别的实验表明,对原始特征作PCA预处理,降低了特征的维度的同时,还提高了识别精度。受此启发,我们比较了不同的PCA维度下的行为分类结果。

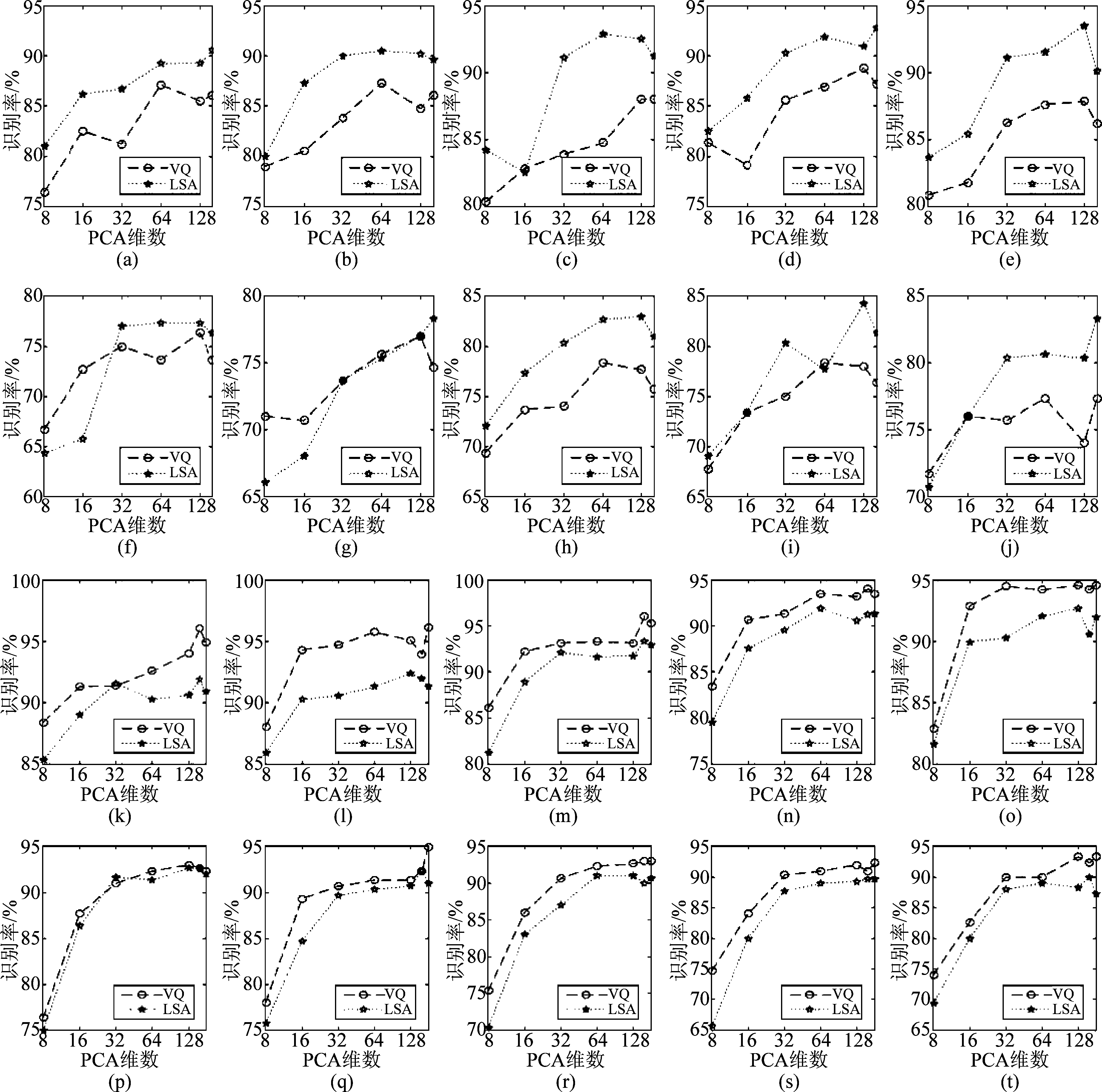

如图4所示,很明显,当PCA维数很低,如小于16时,识别率受到影响较大,但在维数达到32以后,识别率的变化趋缓,也就是说,当PCA降维到32时,保留了原来特征的大部分信息。大多数情况下,随着维数增大,识别率在达到最高值后有下降的趋势。

当特征为STIPs时,采用LSA编码所得分类精度明显高于VQ;而当特征为DT时,则正好相反,VQ更高一些,但是,LSA和VQ两者的差距明显缩小。对于数据集1,采用STIPs和DT得到的最好的结果分别是93.57%、96.1%,均接近于未作PCA预处理时的结果。值得注意的是,在数据集2上,我们分别得到了84.33%、95%的分类准确度,高于未作PCA预处理时0.66、1.67个百分点。由于数据集2上的特征包含有更多的噪声,采用PCA后在一定程度上抑制了噪声的影响,因此提升了识别率。而数据集1上背景相对单一,PCA降低了特征的维度,而噪声的抑制不足以弥补特征的信息损失,性能稍有降低。

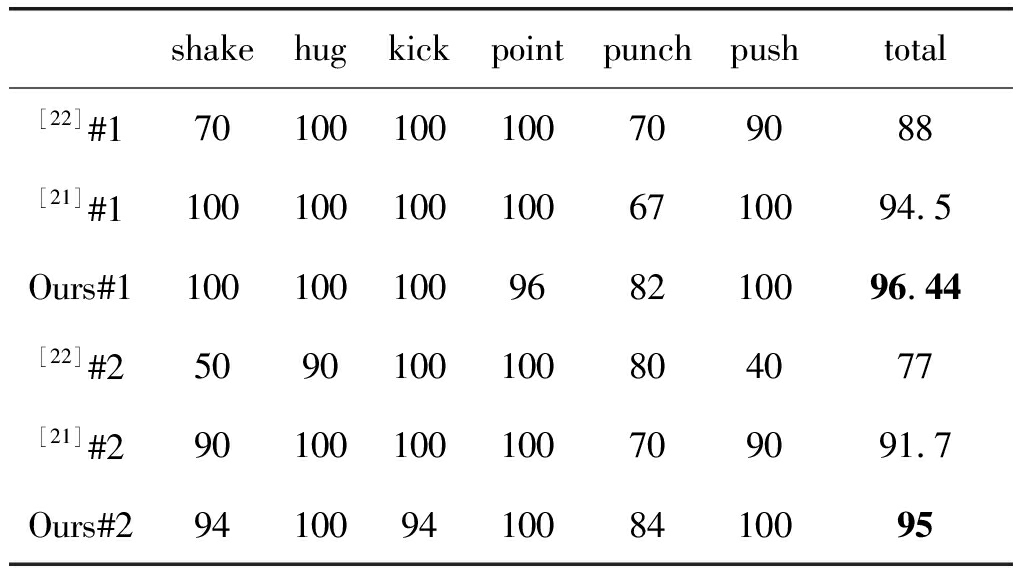

在表4中我们与其他文献的性能做了比较,在数据集1和数据集2上分别高于当前最好的性能1.94、3.3个百分点。值得指出的是,文献[21]在数据集2上联合了HOG,HOF,shape,MBH等四类描述符才取得了91.7%的准确度,而我们的实验中是独立采用了MBH、HNF两类描述符。

表4 与其他文献的比较结果(%)。#1和 #2 分别表示数据集1和数据集2上的结果

Tab.4 Comparison of our approach with the state-of-the-art(%).#1 and #2 denote results on set1 and set2 respectively

shakehugkickpointpunchpushtotal[22]#170100100100709088[21]#11001001001006710094.5Ours#1100100100968210096.44[22]#25090100100804077[21]#290100100100709091.7Ours#294100941008410095

3.3 分析

上述实验结果表明,在采用时空特征点的HNF描述符时,局域软分配可获得优于矢量量化和软分配的性能。尤其是在UT-interaction数据库中,效能提升显著,这说明在样本少,特征点稀疏的情况下,挖掘特征间的共现模式尤为重要。正如上节所示,密集轨迹相比时空兴趣点描述力更强,但我们的方法可以缩小两者的差距,尤其是在UT-interaction数据集1上,两者精度接近相等。

在采用轨迹特征的实验中,多数情况下指数归一化/指数加 2归一化提升了矢量量化和局域软分配的判别力,而软分配更倾向于和

2归一化提升了矢量量化和局域软分配的判别力,而软分配更倾向于和 2归一化结合在一起。局域软分配在一定程度上平滑了特征间的差异,这轻微地减弱了轨迹的判别性。而软分配过度的模糊编码导致了分类性能的急剧下降,其中MBH较之HNF下降更快,这可归因于MBH具有更高的判别力且对于特征间的平滑更敏感。

2归一化结合在一起。局域软分配在一定程度上平滑了特征间的差异,这轻微地减弱了轨迹的判别性。而软分配过度的模糊编码导致了分类性能的急剧下降,其中MBH较之HNF下降更快,这可归因于MBH具有更高的判别力且对于特征间的平滑更敏感。

不同的归一化方法选择,对矢量量化和局域软分配而言最大可以产生5个百分点的差距,而对于软分配最大可达到30个百分点。从实验结果看,密集轨迹较之时空兴趣点更易受到归一化方法的影响。

采用主成份分析方法预处理原始特征,对于提升识别的性能有重要影响。主成份分析将原始特征向特征分量上投影,客观上可以一定程度的抑制噪声,但与此同时,不可避免的带来信息的损失。这两方面的影响相互抵消,如果噪声成分大,抑制噪声取得的效用大,则带来识别率的上升,而信息损失效应大,相应的性能有所下降。另一方面,由于密集采样特征的性能优越,需要处理的特征数越来越多,尤其是对于视频信号来讲,计算量尤其大。而如果采用PCA预处理原始特征,将特征维数大幅降低而又保留大部分信息致使分类性能下降不多,这将大大降低计算量,提升反应速度,对于需要实时处理信号的应用而言,意义重大。

图4 不同的PCA维度下的分类精度对照图。其中第一、二行为UT-interaction数据集1和2采用STIPs时的结果,

第三、四行为采用轨迹特征时的结果。每一列分别对应 1归一化、

1归一化、 2归一化、 指数归一化、 指数加

2归一化、 指数归一化、 指数加 2归一化(P

2归一化(P 2-norm)、 指数加

2-norm)、 指数加 1归一化(P

1归一化(P 1-norm)

1-norm)

Fig.4 Comparison of different PCA dimension. The first row and second are results of set1 and set2 with STIPs respectively, and the third row and fourth are of set1 and set2 with DT. Each column is corresponding one normalization method, such as  1-norm,

1-norm,  2-norm, power-norm, P

2-norm, power-norm, P 2-norm and P

2-norm and P 1-norm

1-norm

主题模型能够挖掘出隐含于众多特征点间的共现模式,这可以看作是中间层的语义描述符,以此来表示视频中的行为,增强了特征的判别性。由于我们采用了标准的单词包框架,没有纳入任何特征点的时空信息,所以我们还不能确定挖掘出的隐主题对应的实际的元动作,但无疑,这类高于底层特征的高层语义,有效提升了识别性能。如何引入特征的时间以及空间信息到模型中,有待于进一步的研究。

4 结论

为了提升概率隐含语义分析模型在行为识别中的分类精度,本文详细考察了编码和归一化方法对于性能的影响,实验表明合适的编码和归一化方法组合将显著改进模型的分类性能,在UT-interaction数据库的两个数据集上取得了当前最好的性能。另外,我们还检验了主成份分析预处理原始特征对于性能的影响,当原始特征包含有较多的噪声时分类性能甚至有所提升。接下来的研究将放在如何把隐主题和元动作,即不同肢体运动联系起来。

[1] Asadi-Aghbolaghi M, Clapés A, Bellantonio M, et al. Deep learning for action and gesture recognition in image sequences: A survey[M]. Gesture recognition. Springer, 2017: 539-578.

[2] Herath S, Harandi M, Porikli F. Going deeper into action recognition: A survey[J]. Image and Vision Computing, 2017,60: 4-21.

[3] 周同驰, 徐勤军, 周琳, 等. 基于有效轨迹和多重方向模式的行为识别[J]. 信号处理, 2016,32(5): 519-527.

Zhou Tongchi, Xu Qinjun, Zhou Lin, et al. Action Recognition Based on Valid Trajectories and Multiple Directional Patterns[J]. Journal of Signal Processing, 2016,32(5): 519-527.(in Chinese)

[4] 岑翼刚, 王文强, 李昂, 等. 显著性光流直方图字典表示的群体异常事件检测[J]. 信号处理, 2017,33(3): 330-337.

Cen Yigang, Wang Wenqiang, Li Ang, et al. Dictionary Representation for Group Anomaly Event Detection Based on the Histograms of Salience Optical Flow[J]. Journal of Signal Processing, 2017,33(3): 330-337.(in Chinese)

[5] 柳晶晶, 陶华伟, 罗琳, 等. 梯度直方图和光流特征融合的视频图像异常行为检测算法[J]. 信号处理, 2016,32(1): 1-7.

Liu Jingjing, Tao Huawei, Luo Lin, et al. Video Anomaly Detection algorithm combined with Histogram of Oriented Gradients and Optical Flow[J]. Journal of Signal Processing, 2016,32(1): 1-7.(in Chinese)

[6] Sivic J, Zisserman A. Video google: A text retrieval approach to object matching in videos[C]∥in Computer Vision, 2003 Proceedings Ninth IEEE International Conference on, 2003: 1470-1477.

[7] Li F-F, Perona P. A bayesian hierarchical model for learning natural scene categories[C]∥in Computer Vision and Pattern Recognition, 2005 IEEE Computer Society Conference on, 2005, 2: 524-531.

[8] Niebles J C, Li F-F. A hierarchical model of shape and appearance for human action classification[C]∥in Computer Vision and Pattern Recognition, 2007 CVPR'07 IEEE Conference on, 2007: 1- 8.

[9] Shang L, Chan K-P. A temporal latent topic model for facial expression recognition[M]. KIMMEL R, KLETTE R, SUGIMOTO A. Computer vision-accv 2010. Springer Berlin Heidelberg, 2011: 51- 63.

[10] Hospedales T, Gong S, Xiang T. Video behaviour mining using a dynamic topic model[J]. International Journal of Computer Vision, 2012,98(3): 303-323.

[11] Chatfield K, Lempitsky V S, Vedaldi A, et al. The devil is in the details: An evaluation of recent feature encoding methods[C]∥in BMVC, 2011, 2(4): 1- 8.

[12] Xu Q, Zhou T, Zhou L, et al. Exploring encoding and normalization methods on probabilistic latent semantic analysis model for action recognition[C]∥in 2016 8th International Conference on Wireless Communications & Signal Processing (WCSP), 2016: 1-5.

[13] Laptev I, Marszalek M, Schmid C, et al. Learning realistic human actions from movies[C]∥in Computer Vision and Pattern Recognition, 2008 IEEE Conference on, 2008: 1- 8.

[14] Wang H, Klaser A, Schmid C, et al. Action recognition by dense trajectories[C]∥in Computer Vision and Pattern Recognition (CVPR), 2011 IEEE Conference on, 2011: 3169-3176.

[15] Laptev I. On space-time interest points[J]. International Journal of Computer Vision, 2005,64(2-3): 107-123.

[16] Peng X, Qiao Y, Peng Q, et al. Exploring motion boundary based sampling and spatial-temporal context descriptors for action recognition[C]∥in Proc BMVC, 2013: 1-11.

[17] Gemert J, Geusebroek J-M, Veenman C, et al. Kernel codebooks for scene categorization[M]. FORSYTH D, TORR P, ZISSERMAN A. Computer vision-eccv 2008. Springer Berlin Heidelberg, 2008: 696-709.

[18] Liu L, Wang L, Liu X. In defense of soft-assignment coding[C]∥in Computer Vision (ICCV), 2011 IEEE International Conference on, 2011: 2486-2493.

[19] Perronnin F, S nchez J, Mensink T. Improving the fisher kernel for large-scale image classification[M]. Computer Vision-eccv 2010. Springer, 2010: 143-156.

nchez J, Mensink T. Improving the fisher kernel for large-scale image classification[M]. Computer Vision-eccv 2010. Springer, 2010: 143-156.

[20] Ji X, Wang C, Zuo X, et al. Multiple feature voting based human interaction recognition[J]. Int J Signal Process Image Process Pattern Recognit, 2016,9(1): 323-334.

[21] Peng X, Wu X, Peng Q, et al. Exploring dense trajectory feature and encoding methods for human interaction recognition[C]∥in Proceedings of the Fifth International Conference on Internet Multimedia Computing and Service, 2013: 23-27: ACM.

[22] Ryoo M S, Chen C-C, Aggarwal J K, et al. An overview of contest on semantic description of human activities (sdha) 2010[M]. ÜNAY D, ÇATALTEPE Z, AKSOY S. Recognizing Patterns in Signals, Speech, Images and Videos. Springer Berlin Heidelberg, 2010: 270-285.

[23] Jégou H, Chum O. Negative evidences and co-occurences in image retrieval: The benefit of pca and whitening[M]. Computer Vision-eccv 2012. Springer, 2012: 774-787.

[24] Jégou H, Douze M, Schmid C, et al. Aggregating local descriptors into a compact image representation[C]∥in Computer Vision and Pattern Recognition (CVPR), 2010 IEEE Conference on, 2010: 3304-3311.